Detection of yarn hairiness combining microscopic vision and attention mechanism

-

摘要: 毛羽瑕疵由于尺寸微小,极易发生漏检和误检,是化纤丝饼检测中的难点。为了准确高效地检测丝饼的外观瑕疵,搭建了基于显微视觉的毛羽瑕疵图像采集平台,提出加入注意力机制和特征融合的瑕疵检测算法(CenterNet-CBAM)。采集了毛羽和断线两类易混淆的目标图像,构建基于CenterNet-CBAM的目标检测模型,并与CenterNet、YOLOv4、Faster R-CNN、SSD四种目标检测算法进行比较。实验结果表明,工业显微相机能有效获取毛羽特征,CenterNet-CBAM在毛羽、断线两类目标的实验检测结果的准确率分别为94.00%和93.57%,召回率分别为86.75%和92.16%,AP值分别为92.93%和92.91%,两类mAP值均为92.92%,优于其他算法,验证了实验方法的有效性。Abstract: Broken ends of yarns are difficult to detect due to their small features, which are easily overlooked and confused. To detect defects accurately and efficiently in the appearance of polyester yarn packages, an image acquisition platform with a microscopic camera was designed, and a defect detection algorithm (CenterNet-CBAM) with an attention mechanism and feature fusion was proposed. Two types of confusing target images, yarn hairiness, and broken ends were collected to design an objective model of CenterNet-CBAM, which was compared with four other object detection algorithms, CenterNet, YOLOv4, Faster R-CNN, and SSD. The results show that the industrial microscope camera can acquire the feature of yarn hairiness. The precision of CenterNet-CBAM for yarn hairiness and broken ends is 94.00% and 93.57%, the recall rates are 86.75% and 92.16%, AP values are 92.93% and 92.91%, respectively, and the mAP values are 92.92%. Better results in defect detection compared to other algorithms demonstrate the validity of the experiment method.

-

我国是世界第一的化纤生产大国,2020年我国化纤产量为6126.5万吨,同比增长4.1%,出口化纤产品总量466.06万吨,已成为国民经济的重要支柱。化纤丝饼由丝束在卷绕机控制下绕纸筒卷装形成[1]。毛羽是衡量化纤质量的重要指标之一,其成因通常包括机械原因造成的毛羽以及浮游毛羽[2]。过多的毛羽导致化纤质量下降,从而影响织物的强度、外观光洁度、手感滑爽程度等。

丝饼出库前的质检主要通过工人使用手电筒照亮丝饼肉眼观察,并根据瑕疵数量进行丝饼质量分级。目前,人工检测存在一些问题:1)质检员评价标准存在主观差异,影响了检测的准确率[3];2)车间环境噪声大、温度和湿度高,不适宜工人长期工作[4];3)检测过程需要反复弯腰、蹲起、转动手电筒,质检员易产生疲劳,从而引起误检[5];4)疫情导致劳动力成本不断增加、招工难度进一步加大[6]。可见,在工业4.0时代,人工检测丝饼的方式难以满足化纤生产企业智能制造的发展需求。因此,亟待一种更加智能、高效的瑕疵检测方法, 使得丝饼瑕疵在流水线中就能被快速、准确地识别,大幅提高生产效率,节省成本。

目前,毛羽智能检测面临以下两个难点:1)细小的毛羽特征属于微米级,普通相机很难抓取到毛羽图像,易导致漏检;2)毛羽和断线不易分辨,易造成错检。针对以上问题,本文提出一种基于工业显微相机的图像获取方法,以及结合注意力机制、特征融合和CenterNet的毛羽目标检测算法CenterNet-CBAM。通过与CenterNet、YOLOv4、Faster R-CNN、SSD四种目标检测算法的实验结果相比,验证了该方法在区分毛羽和断线方面具有更好的效果。

1. 相关工作

1.1 图像处理的织物瑕疵检测现状

瑕疵检测是涤纶丝饼生产过程中必不可少的环节。长期以来相关企业和科研机构针对传统图像识别方法进行了大量研究,取得了可观的研究成果。但是基于图像处理的瑕疵检测方法仍存在以下问题:1)在对图片进行预处理的过程中,由于图片背景会随着背景纹理的变化而发生改变,导致算法需要针对特定应用场景重新开发,系统通用性、鲁棒性较差;2)在提取特征时,如纱线表面纤维的方向等[7]难以直接被观察到的抽象变量,通常利用Gabor滤波[8]、双边滤波[9]等方法进行处理,给开发过程带来困难,进而对检测的准确性产生影响;3)选择图片特征时,需要针对不同的瑕疵类型对图片中的尺寸、形状、纹理等多种缺陷特征进行人工提取,工作量较大[10]。

1.2 毛羽瑕疵目标检测现状

目标检测的任务是找出图像中所有需要被检出的对象,确定其类别和位置。Ren等[11]提出的two-stage算法Faster R-CNN是瑕疵检测任务中的典型算法;车翔玖等[12]采用Faster R-CNN调整区域推荐网络在布匹瑕疵检测中取得了良好效果。Redmon等[13]提出分类和定位在一个步骤中完成的YOLO算法;唐有赟等[14]将深度可分离卷积与YOLO模型相结合,织物瑕疵识别准确率达到95.8%。布匹瑕疵与毛羽瑕疵相似,可以将Faster R-CNN和YOLO应用到丝饼表面毛羽的检测中。

丝饼表面瑕疵主要包括毛羽、油污、绊丝、成型不良等,而断线是未捻入丝饼的丝束尾端,不属于表面瑕疵。为了实现丝饼表面瑕疵的智能检测,王泽霞等[15]利用最大池化层代替全连接层对AlexNet网络进行轻量化改进,检测对象集中在油污等特征明显的瑕疵上,未对微小的毛羽瑕疵进行检测。针对这一问题,张君扬等[16]在SSD[17]中加入反卷积和特征融合对丝饼各类毛羽瑕疵检测,但未区分毛羽和断线。

1.3 显微视觉

显微视觉系统是借助显微镜或者显微镜头构成的视觉系统[18]。经过显微镜头放大后,显微相机采集的图像称为显微图像。显微镜放大倍数高,采集图像清晰,能够有效观察微观结构,常应用于医学[19]、IC制造、微机电系统装配等领域。在纤维检测领域,路凯等[20]结合显微视觉鉴别羊毛和羊绒,识别正确率为86%。

毛羽锚框尺寸小,且长宽差距大,通用的锚框尺寸不能适应,是典型的小目标检测任务[21]。小目标检测是目标检测中的关键挑战之一[22]。文献[23]将低分辨率图像反卷积至高分辨率,获得了更多的细节;文献[24]提出了视觉空间注意网络VSA-Net,通过加入检测目标所在环境提升小物体检测准确率,增加上下文信息实现特征的补充;文献[25]通过4个尺度的特征层进行融合提升整体目标的检测准确率,避免随着网络加深造成的细节特征丢失,增加浅层细节信息便于小物体检测。2019年,Zhou等[26]提出的CenterNet算法采用无先验框的检测方法,只负责预测物体的中心点,所以没有尺寸限制,在抽雄期玉米雄蕊、糖尿病视网膜病变[27]等小物体检测上展现优势。通过CenterNet检测毛羽等小目标,可为化纤丝饼表面瑕疵检测提供新的途径。

1.4 注意力机制

经典卷积主要集中在空间局部特征提取上,未对全局及通道图像信息进行筛选。为了在捕获画面中更重要特征信息的同时避免信息过载,提高任务处理的效率和准确性,许多国内外学者[28]利用神经网络产生注意力,突出重点信息并弱化次要信息,逐渐在图像领域成为研究热点。

机器视觉中的注意力机制分为两种,软注意力机制和强注意力机制。其中,软注意力机制通过神经网络梯度计算得到注意力的权重,主要有两种:一种是空间注意力机制,另外一种是通道注意力机制,以SE模块(squeeze-and-excitation module)[29]为代表。空间与通道注意力机制结合的CBAM(convolutional block attention module),能够提高网络的学习效果。在热轧钢板表面缺陷检测[30]和织物疵点检测[25]中,嵌入CBAM注意力机制能有效提升图像分类的效果,经消融实验显示,加入CBAM的ResNet50网络Top-1 Error下降约2%。如果将CBAM与目标检测算法相结合,有望进一步提升毛羽瑕疵检测的准确率。

2. 本文方法

2.1 显微视觉检测平台

2.1.1 视觉检测系统设计

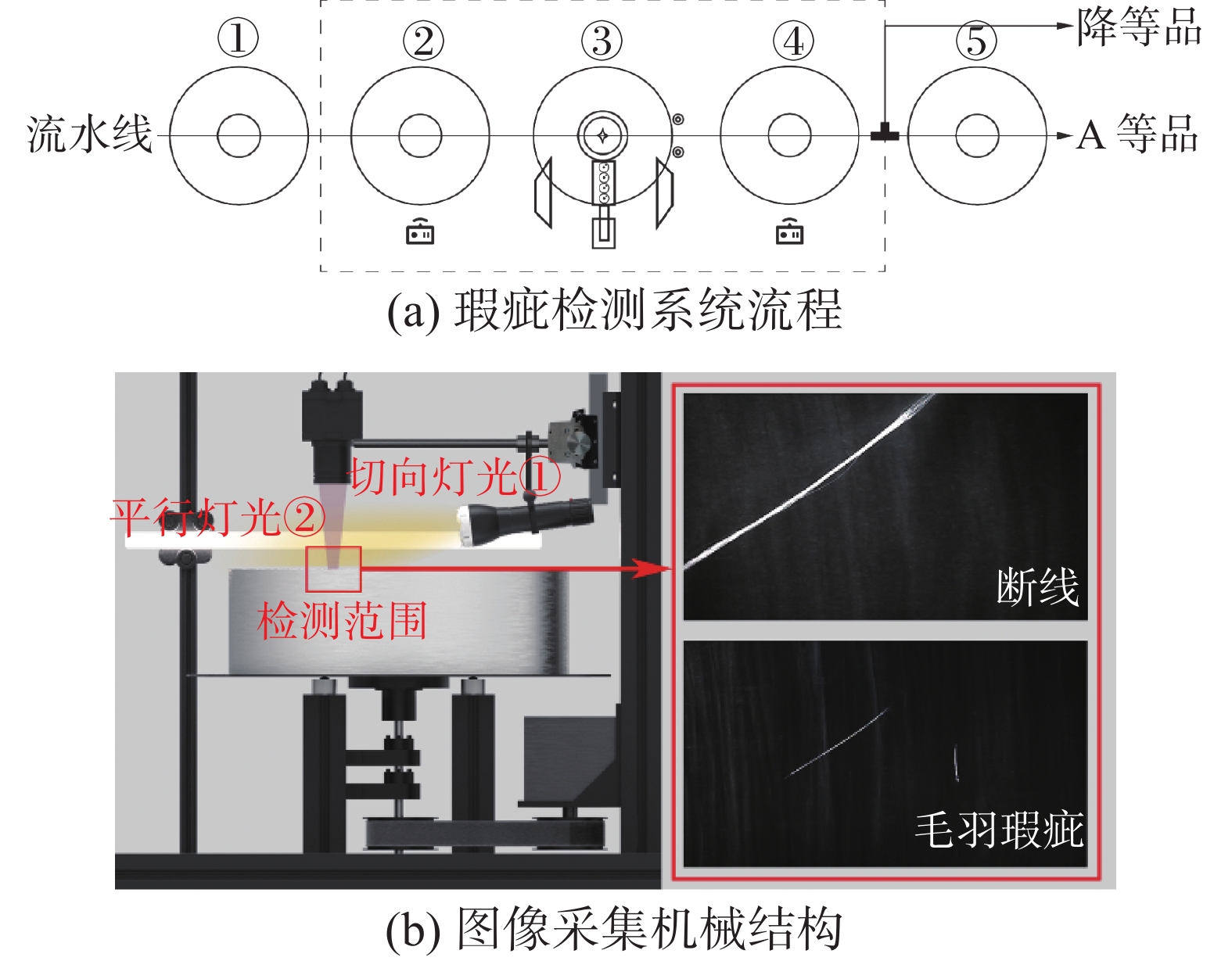

开发了表面缺陷检测系统,将丝饼放置于流水线上,共分为5个状态,如图1所示。

状态1:丝饼在流水线上,处于待检测状态。

状态2:丝饼进入检测机构,激光传感器检测到丝饼,止动气缸弹出。

状态3:丝饼停在检测位,底部电机旋转,工业显微相机开始检测,丝杆在前后方向上进行调节,改变拍摄范围,最终覆盖丝饼表面。

状态4:激光传感器检测到丝饼后,分流气缸根据丝饼瑕疵检测结果进行分流,分为A等品和降等品。

状态5:A等品随流水线进入包装环节。

在特定角度提供光源照亮毛羽瑕疵,弱化丝饼表面反光对缺陷特征产生的影响,获取如图2所示特征亮、背景暗的图片。下面将通过实验确定最佳相机安装位置及机器视觉光源配置。

2.1.2 显微相机

选择焦距f = 60 mm的显微镜头,画面大小控制为可拍摄到瑕疵的最大画幅。根据表1所示镜头参数,表2所示相机参数调节拍摄距离,改变拍摄视野。

表 1 显微镜头参数Table 1 Microscope lens parameters性能参数 参数 光学放大倍数 1.2~1.8 像素 1920×1080 视野范围/mm 2.4~36 工作距离/mm 55~285 帧率/f·s−1 30 图像格式 BMP/JPG 接口 C接口 产品尺寸/mm Φ40×100 表 2 CMOS相机参数Table 2 CMOS camera parameters性能参数 参数 传感器 CMOS 1/2.7'' OV2701 Sensor 像素 1920×1080 靶面尺寸/mm2 5.270×3.960 帧率/f·s−1 30 接口 C接口 产品尺寸/mm3 35×37×37 目标检测过程中要求检测的毛羽直径为3

$ {\text{μm}} $ ,经灯光照射后特征放大,实际尺寸为30$ {\text{μm}} $ 。将最小检测像素数Pmin设为2。水平和竖直方向的最大检测尺寸如式(1)、(2)所示:$$ {V_h} = \frac{{{R_h} \times P}}{{{P_{{\text{min}}}}}} = 28.8{\text{ mm}} $$ (1) $$ {V_v} = \frac{{{R_v} \times P}}{{{P_{{\text{min}}}}}} = 16.2{\text{ mm}} $$ (2) 式中:

$ {V_h} $ 、${V_v}$ 分别为水平视野和竖直视野,表示画面所拍摄的尺寸;$ {R_h} $ 、${R_v}$ 分别为水平和垂直视野分辨率;$P$ 为像素。物距$u$ 和像距$v$ 的算法如式(3)、(4)所示,由此可知被检瑕疵的物距为387.89 mm。$$ \frac{1}{u} = \frac{1}{f} - \frac{1}{v} $$ (3) $$ u = \frac{{v \times {V_h}}}{{{C_h}}} $$ (4) 式中:f为焦距;Ch为COMS设备的高度。电子、光学、显示器放大倍率计算公式为

$$ {M_d} = \frac{{{S_h}}}{{{C_h}}} = {\text{60}}{\text{.15}}x $$ $$ {M_o} = \frac{{{C_h}}}{{{V_h}}} = 0.18x $$ $$ {M_m} = {M_d} \times {M_o}{\text{ = 11}}{\text{.01}}x $$ 式中:

$ {M_d} $ 为电子放大倍率,表示COMS设备连接至15.6寸显示屏上成像后的放大倍率;$ {M_o} $ 为光学放大倍率,表示芯片尺寸与视野尺寸的比值;$ {M_m} $ 为显示器放大倍率,表示被拍物体通过镜头和相机成像后显示在显示器上的放大倍数。2.2 瑕疵检测算法模型

2.2.1 瑕疵检测算法框架

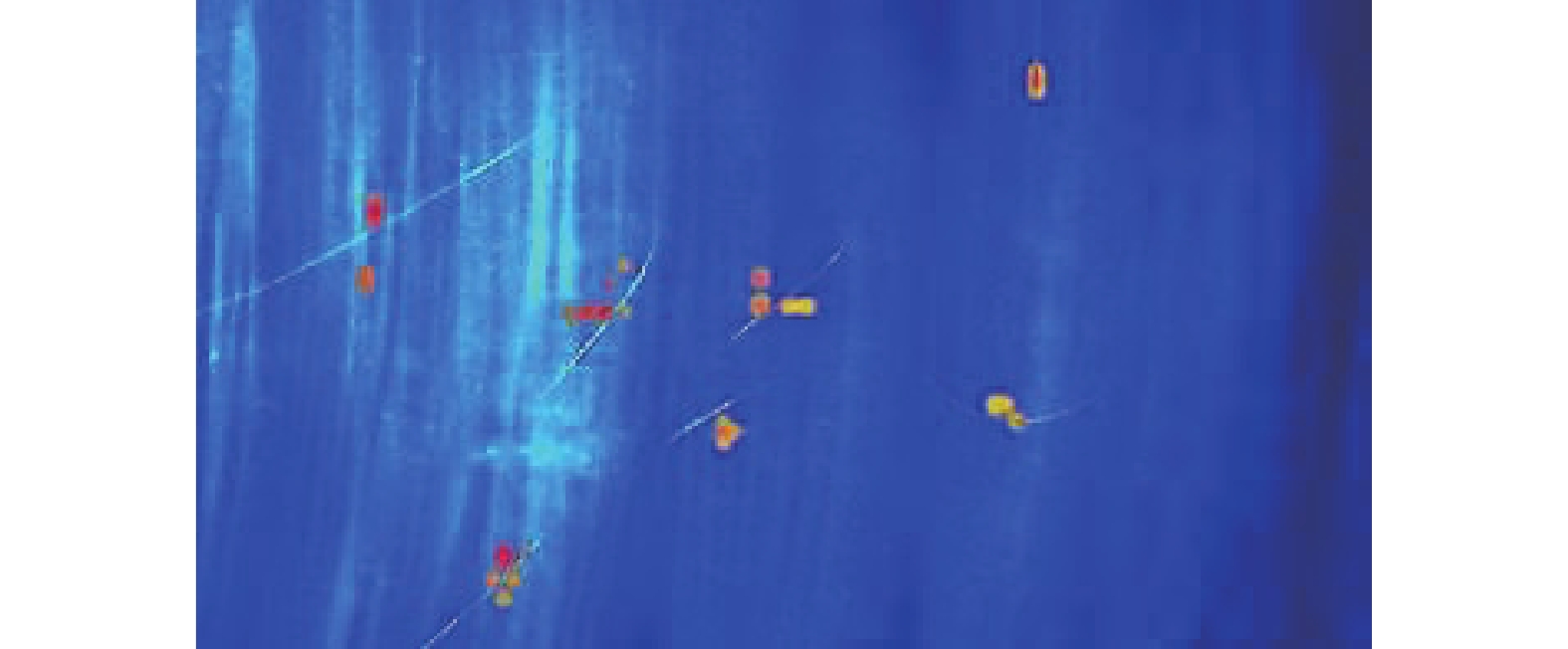

本文提出的CenterNet-CBAM模型框架如图3所示。断线和毛羽的特征为中间粗,两边细,与CenterNet-CBAM的热力图识别机制相对应,即中心点特征明显,边缘特征较弱。图像传入卷积网络得到热力图,热力图峰值点即中心点,通过中心点和宽高预测,准确定位中心点位置和预测框的大小。

本文提出的CenterNet-CBAM算法特点如下:

1)无损图像预处理。本次任务属于小目标检测,目标物体所占用的像素为2,原图尺寸为1920×1080×3,经各项同性缩放生成与原图近似的图像1920×1088×3输入特征提取网络,使图片在卷积操作过程中能够取整。

2)加入注意力机制和特征融合的卷积特征提取。使用Resnet50特征提取网络,通过5次的卷积操作将图片中的信息转化为特征数组,为避免随着网络加深造成的细节特征丢失,将上采样特征与下采样特征融合,实现将底层的目标位置信息引入高层神经网络结构。在conv1的最大池化层后和Resnet50特征提取网络conv5后引入CBAM模块。

3)加入NMS的二次特征解码。CenterNet的非极大抑制选取特征点与其周围的8个点之间最大值,本次目标为线状特征,容易产生多个中心点效果,如图4所示,后处理过程加入NMS,防止同一目标的复检。

2.2.2 瑕疵检测算法流程

1)将尺寸为1920×1080×3图像输入Resnet50网络结构中,经过conv1和conv2的最大池化层,输出作为特征图F。

2)经通道注意力模块,特征图F经过平均池化(AvgPool)、最大池化(MaxPool)和激活函数相加接sigmoid得到

$M_C(F) $ ,如式(5)所示:$$ \begin{gathered} {M_C}(F) = \sigma ({\text{MLP(Avgpool(}}F{\text{)) + }} {\text{MLP(Maxpool(}}F{\text{)))}} =\\ \sigma ({W_{\text{1}}}{\text{(}}{W_{\text{0}}}{\text{(}}F_{{\text{avg}}}^{\text{c}}{\text{)) + }}{W_{\text{1}}}{\text{(}}{W_{\text{0}}}{\text{(}}F_{{\text{max}}}^{\text{c}}{\text{))}}) \\ \end{gathered} $$ (5) 式中:

$\sigma ( \cdot )$ 为sigmoid激活函数;MLP(·)为两层的神经网络;权重为${W_0} \in {R^{C/(r \times C)}}$ ,${W_1} \in {R^{C \times C/r}}$ ,且权重共享,R为Relu激活函数,r为缩减率,C为通道;$ F_{{\text{avg}}}^{\text{c}} $ 为平均池化;$ F_{{\text{max}}}^{\text{c}} $ 为最大池化。MC与输入特征图F相乘,得到完成通道注意力操作的特征图

$F'$ :$$ F' = {M_C}(F) \times F $$ (6) 通过空间注意力模块,特征图

$F'$ 分别进行单通道的AvgPool、MaxPool、7×7卷积层和激活函数处理,得出权值$ {M_S}(F') $ ;$ {M_S}(F') $ 与特征图$F'$ 相乘得到缩放后的新特征图$F''$ 。$$ \begin{gathered} {M_S}({F'}) = \sigma \left({f^{7 \times 7}}{\text{(AvgPool(}}{F'}{\text{);MaxPool(}}{F'}{\text{))}}\right)= \\ \sigma \left({f^{7 \times 7}}{\text{(}}\left[ {{F'}_{{\rm{ avg}}}^s;{F'}_{\rm{ max} }^s} \right]\right) \\ \end{gathered} $$ (7) $$ F'' = {M_S}(F') \times F' $$ (8) 式中:f为卷积操作;[ ; ]为拼接操作;

${F'}_{{\rm{ avg}}}^{\text{s}}$ 为每个通道上的平均池化;${F'}_{{\rm{ max}}}^{\text{s}}$ 为每个通道上的最大池化;7×7为卷积核大小。3)将新特征图

$F''$ 经conv2、conv3得到240×136×512的特征层;经conv4得到120×68×1024的特征层;经conv5得到60×34×2048的特征层;最后接入CBAM模块,计算过程如式(6)、(7)、(8)所示,输出后特征尺寸保持不变。4)利用初步特征获得高分辨率特征图,通过3次反卷积进行上采样,尺寸分别为120×68×256、240×136×128、480×272×64,分别与特征提取过程中的输出特征

$F$ 、$F'$ 、$F''$ 进行特征融合。5)从提取特征中获取预测结果,这个特征层相当于将整个图片划分成480×272个区域,每个区域存在一个特征点,如果某个物体的中心落在这个区域,那么就由这个特征点来确定。

6)利用特征层进行3次卷积获得热力图预测、中心点预测和宽高预测结果。

7)预测结果解码,热力图预测,输出尺寸为480×272×2,其中最后一维代表断线和毛羽两类瑕疵,预测是否有物体存在以及物体的种类;中心点预测结果为480×272×2,代表物体中心距离热力点偏移的距离;宽高预测输出结果为480×272×2,代表当前这个特征点对应的预测框的宽和高。

2.2.3 损失函数

损失计算分为3个部分,最终损失值为

$$ {L_{\det }} = {L_k} + {\lambda _{{\text{size}}}}{L_{{\text{size}}}} + {\lambda _{{\text{off}}}}{L_{{\text{off}}}} $$ (9) 式中:

${L_{\det }}$ 为CenterNet的损失函数;${L_k}$ 为热力图损失;${L_{{\text{size}}}}$ 为宽、高损失;${L_{{\text{off}}}}$ 为中心点偏移量损失;${\lambda _{{\text{size}}}}$ 和${\lambda _{{\text{off}}}}$ 为常数,分别为0.1和1。2.2.4 评价指标

本文采用精确度(precision)、召回率(recall)、AP值和mAP值作为模型的评价指标:

$$ P = \frac{{{\text{TP}}}}{{{\text{TP + FP}}}} $$ (10) $$ R = \frac{{{\text{TP}}}}{{{\text{TP + FN}}}} $$ (11) $$ {\text{AP}} = \int_0^1 {{p_{{\text{smooth}}}}(R){\text{d}}} R $$ (12) $$ {\text{mAP}} = \dfrac{{\displaystyle\sum\limits_{i = 1}^k {{\text{A}}{{\text{P}}_i}} }}{k} $$ (13) 式中:

$P$ 为精确度;$R$ 为召回率;TP为正确检测框;FP为误检框;FN为漏检框;$ {p_{{\text{smooth}}}}\left( R \right) $ 为对P-R曲线进行平滑处理;$ {\text{d}}R $ 表示用积分的方式计算平滑P-R曲线下方的面积;mAP代表断线和毛羽两个类别的AP均值。3. 毛羽瑕疵的显微视觉检测实验

待检测丝饼外径为425 mm,内径为140 mm,厚度为123 mm,丝束缠绕在纸筒上,产品材质为预取向丝,是拉伸丝和变形丝的基础原料。表面光滑高亮,主体颜色为白色。由于毛羽、断线瑕疵属于高反光物体,对光源敏感,通过光源照射,被测产品瑕疵部分会产生高亮,与背景环境差异明显。为避免拍摄环境中的杂光和倒影,搭建了全黑拍摄的图像采集实验平台。

3.1 显微视觉光源实验

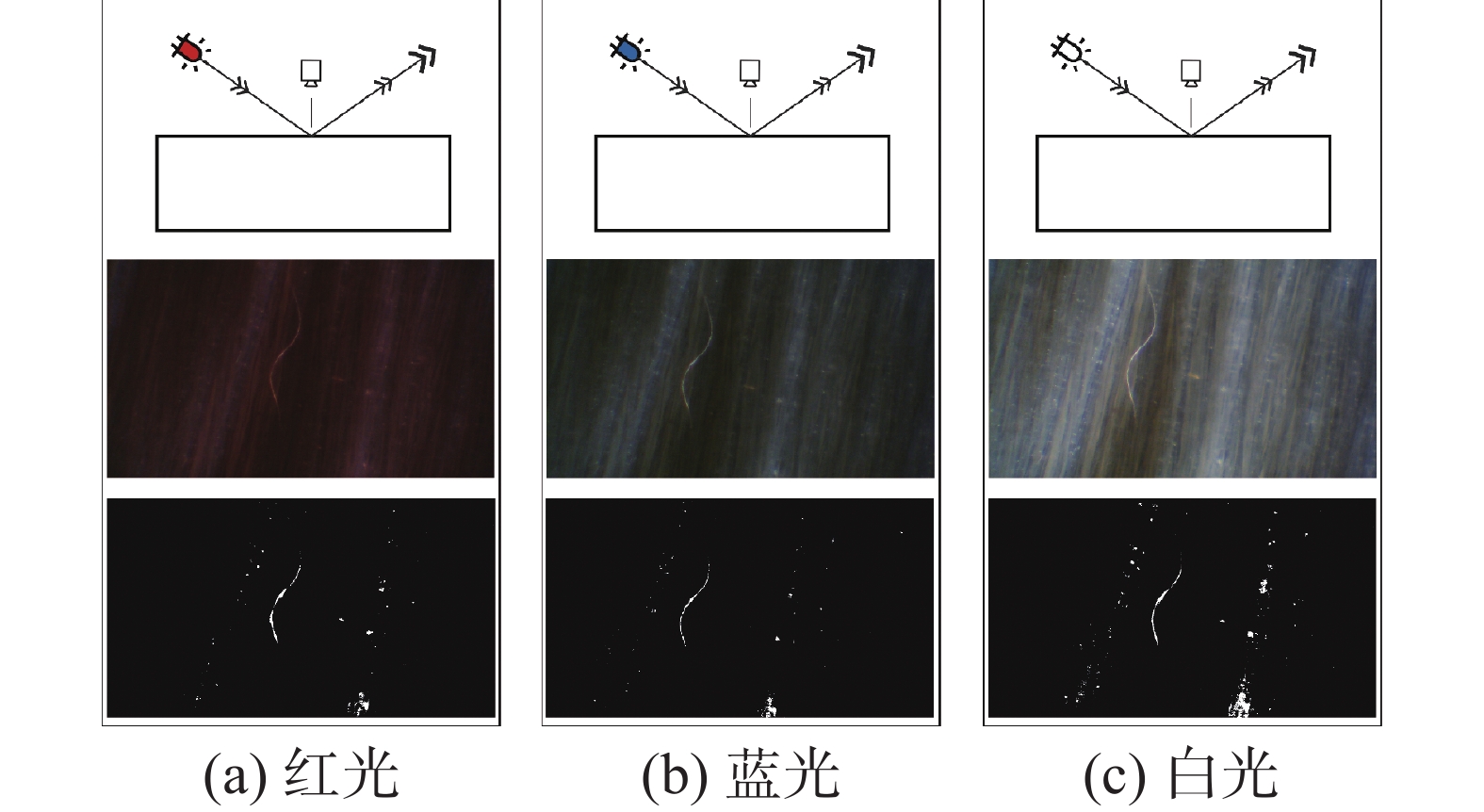

在控制其他条件不变情况下,对比不同光照下的产品照明效果,如图5所示。

经对比处理后的二值化图像可以得出,产品在高亮灯光照射下拍摄效果更好,目标瑕疵更加清晰。当灯光过亮时,背景中形成亮点,导致图像均匀性差。当灯光较弱时,瑕疵特征不明显,不利于检测。

对比不同颜色灯光对照射效果的影响,3种色彩下调节RGB通道阈值形成的二值化图像差别不明显。产品表面为白色,当使用彩色灯光照亮物体时,产品表面反射了所有的彩色光而呈现统一的颜色,瑕疵特征对色彩影响不敏感,由此可知光源波长对检测效果产生影响不显著,如图6所示。

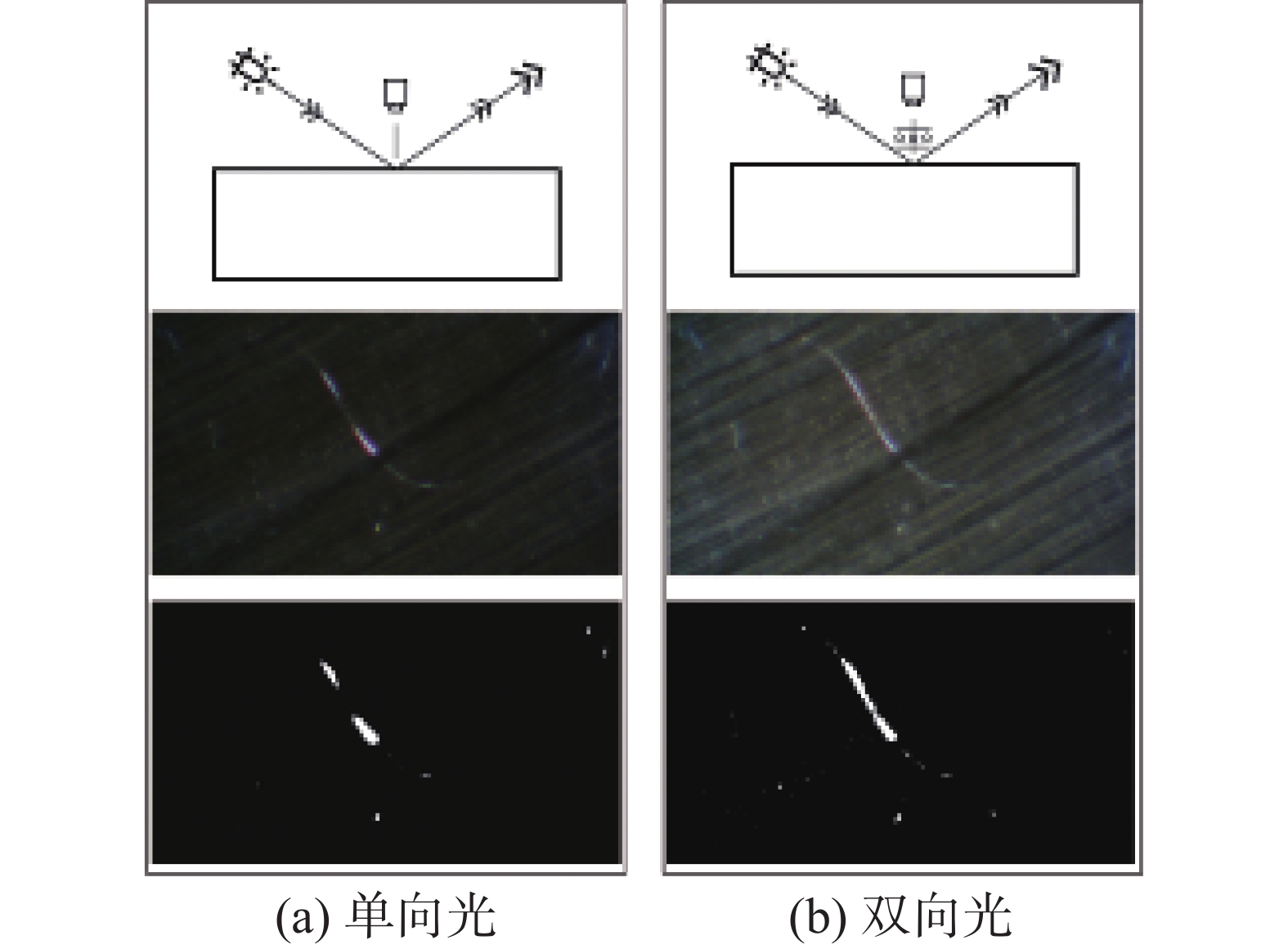

对比两种照明方式对成像效果的影响,明场照明需要用光源直接照射被测物,暗场照明则是通过被测物反射或者衍射的光线来观测。光照的目的是提高对比度,突出目标对象,以便提取出其轮廓等物理特征。由于暗场入射光束有较大的倾斜角,当在黑暗的视野照明,即使很细的磨损也很容易识别,如图7所示。

灯光数量对于瑕疵成像的影响,单向光照亮的毛羽范围有限,毛羽特征连贯性差。加入垂直于切线的新灯光后,照亮范围变大,毛羽整体更加连贯,边缘更加明显,如图8所示。

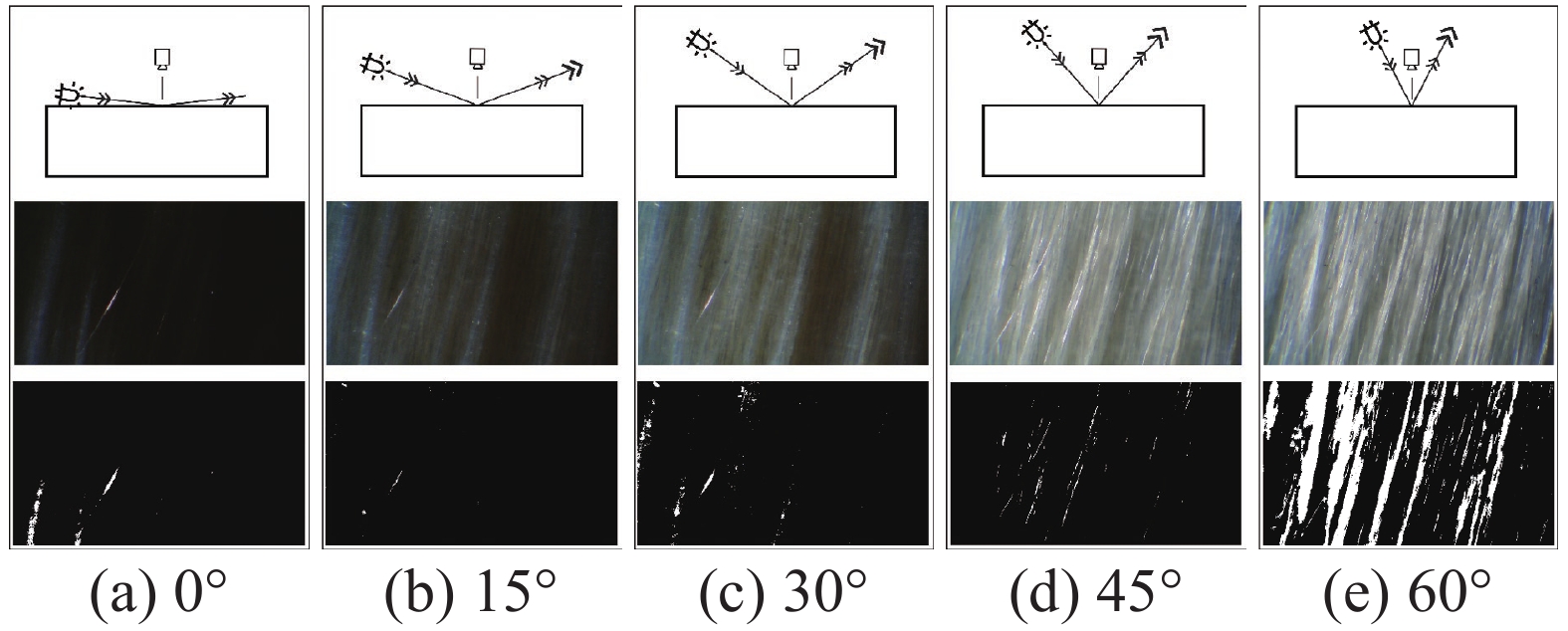

通过不同角度下的打光效果对比,二值化图像处理,发现光源在15°位置的照射效果最佳,如图9所示。

结合上述实验,组合出最佳的拍摄条件。在黑色背景下,结合两个白色光源进行打光时成像效果最优。光源1即白色LED光源沿与丝饼表面夹角15°的方向打光,打光位置在显微镜正下方,照亮与丝线方向垂直的毛羽;侧面的白色LED光源2照亮与丝线方向平行的毛羽,如图10所示。在这种情况下,被测丝饼成像轮廓更清晰,特征突出,对比度更高。

毛羽图像经过人工标注,将瑕疵类别划分为断线、毛羽两种,分类标准根据被检瑕疵直径确定。标注完毕后,选择Pascal VOC导出形式。

按照丝饼的瑕疵类型,将工业显微相机采集的图像进行筛选,除去失焦、过曝等成像不良的样本,将最终的有效图像划分为3种,分别为带有断线、毛羽和无瑕疵的图像,合计1614张,如表3所示,选择8∶1∶1的训练集、验证集、测试集配比。

表 3 采集图像数量Table 3 Number of images acquired张 数据集 断线 毛羽 无瑕疵 总计 样本数 501 543 570 1614 3.2 算法对比实验

实验对比了CenterNet、YOLOv4、Faster R-CNN、SSD四种网络选出最优算法,均使用预训练模型,训练参数如表4所示。

表 4 4种算法训练参数Table 4 Training parameters of four algorithms训练阶段 Epoch Batch_size Learning_rate 冻结阶段 500 8 1×10−3 解冻阶段 1500 8 1×10−4 针对最优的CenterNet进行优化,在Resnet50网络中加入CBAM模块和特征融合。训练参数如表5所示。

表 5 CenterNet-CBAM训练参数Table 5 CenterNet-CBAM training parametersEpoch Batch_size Learning_rate 2000 8 1×10−4 这些网络模型均在Ubuntu(9.3.0)系统上进行训练,使用GPU加速。系统硬件为Intel(R) Core (TM) i5-10600KF CPU @ 4.10 GHz和 32 GB RAM,NVIDIA GeForce RTX3090 24 GB。编程语言为 Python3.6,主要使用pytorch平台。

4. 结果与讨论

4.1 CenterNet-CBAM识别结果

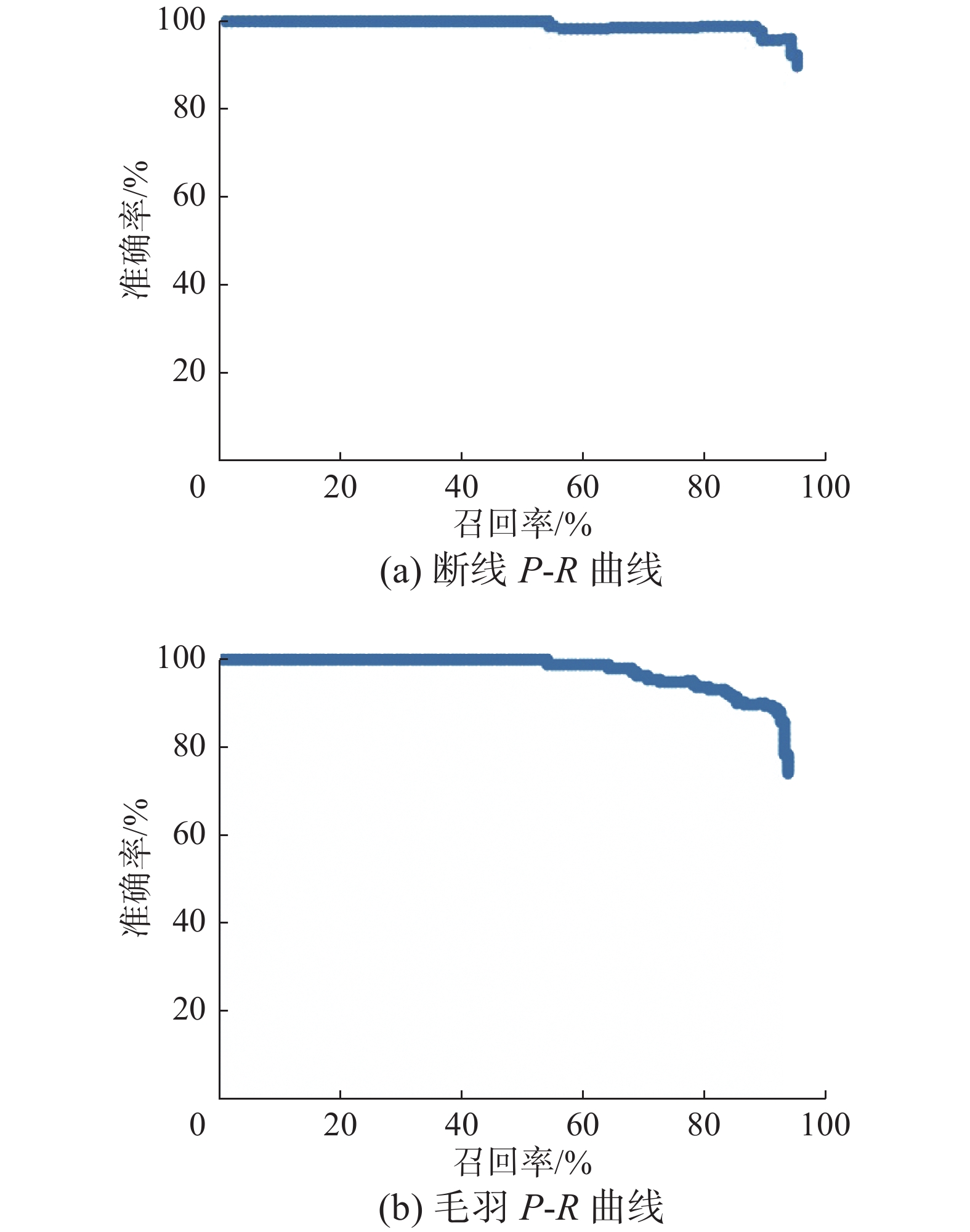

CenterNet-CBAM的实验结果如表6所示,mAP为92.95%,如图11所示。随着召回率的提高,毛羽和断线的准确率下降不明显。

表 6 CenterNet-CBAM模型的识别结果Table 6 Identification results of CenterNet-CBAM% 数据集 R P AP (mAP) 断线 94.12 93.20 93.94 毛羽 86.09 90.28 91.96 全部瑕疵 90.11 91.74 92.95 4.2 CenterNet的识别结果

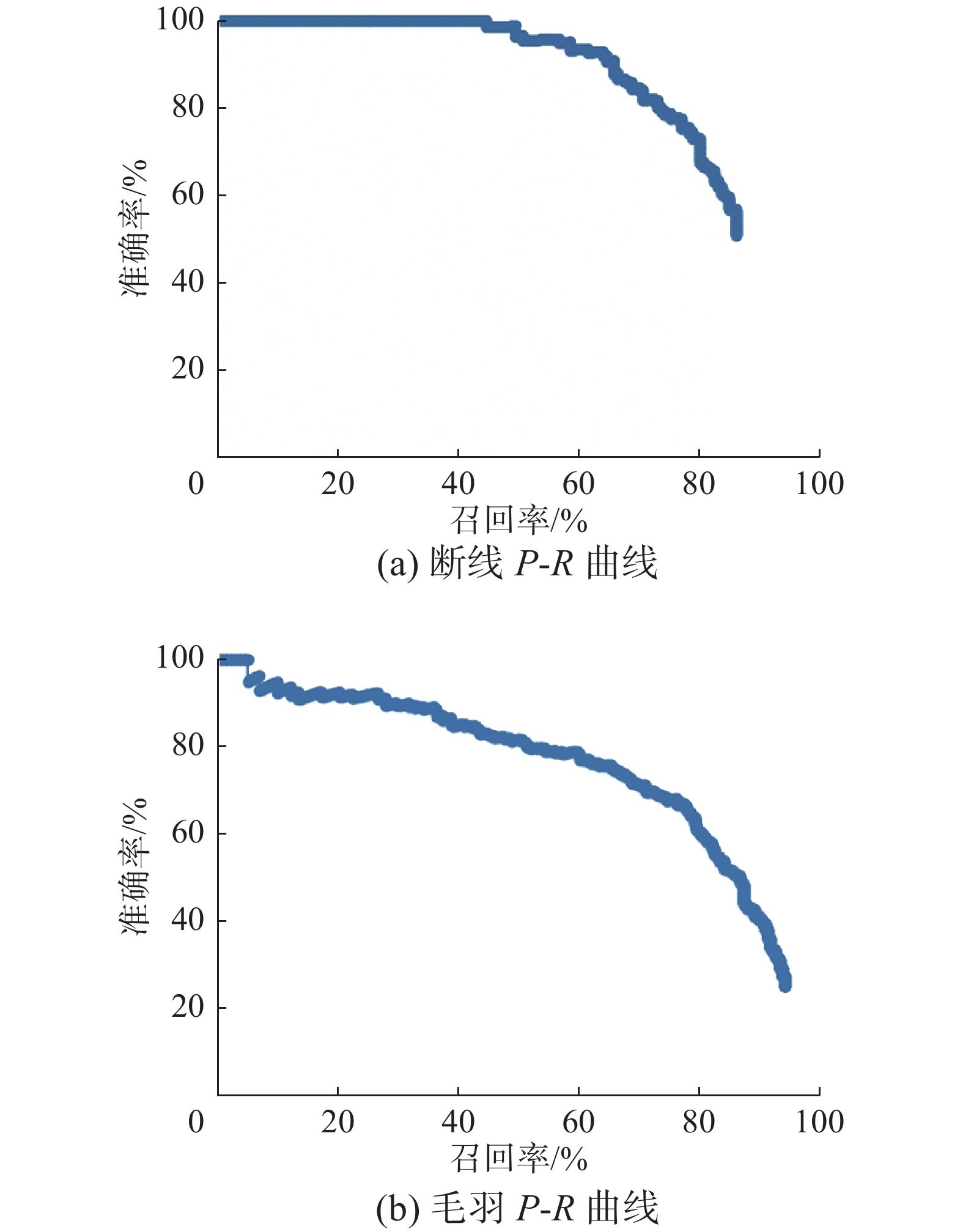

CenterNet的实验结果如表7所示。模型中断线AP值最高,为92.13%,毛羽特征识别准确率略低。准确率随召回率下降速度慢,如图12所示。结合断线和毛羽的特点,CenterNet检测目标选框的中间特征明显,边缘特征稀疏,取得了较好的识别效果。

表 7 CenterNet模型的识别结果Table 7 Identification results of CenterNet% 数据集 R P AP (mAP) 断线 91.43 92.36 92.13 毛羽 78.79 89.86 86.42 全部瑕疵 85.11 91.11 89.28 4.3 YOLOv4识别结果

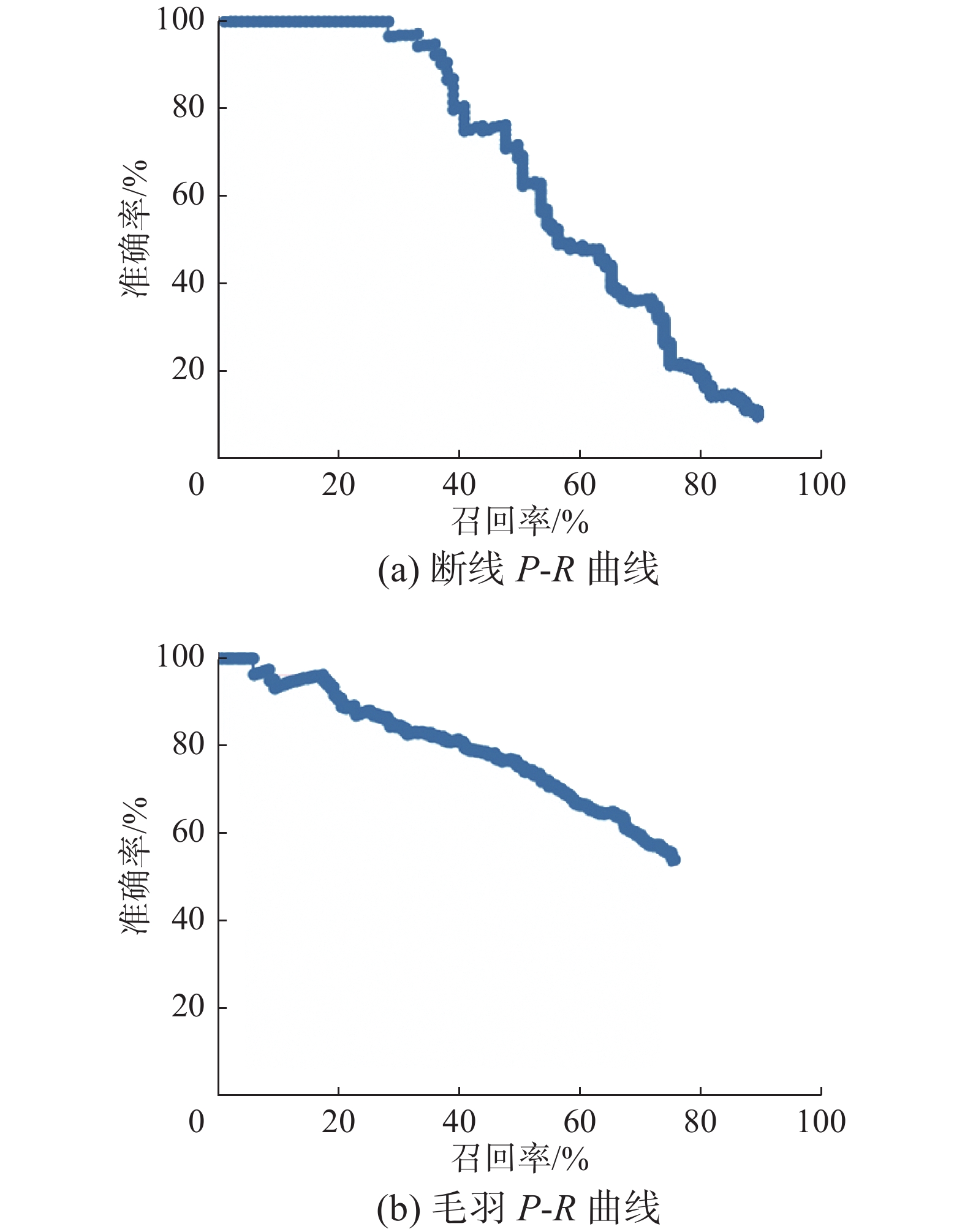

YOLOv4实验结果如表8所示,毛羽召回率对准确率变化敏感,如图13所示。YOLO采用了预定义候选区的方法,通过将图片划分为网格,在此实验中难以完整地覆盖整个画面,在小目标识别的召回率上表现不佳。

表 8 YOLOv4模型的识别结果Table 8 Identification results of YOLOv4% 数据集 R P AP (mAP) 断线 59.78 75.35 80.15 毛羽 58.35 80.00 74.38 全部瑕疵 59.07 77.68 77.27 4.4 Faster R-CNN识别结果

Faster R-CNN实验结果如表9所示,随着召回率的上升,算法的精确率下降较快,召回率最大值为76.41%,如图14所示。此实验中,该算法在特征提取完成后,目标特征图高度抽象,特征信息较少。定位目标时使用固定目标框,对于毛羽、断线这类形态不规则小物体效果不佳。

表 9 Faster R-CNN模型的识别结果Table 9 Identification results of Faster R-CNN% 数据集 R P AP (mAP) 断线 68.24 85.93 74.83 毛羽 54.73 72.11 61.03 全部瑕疵 61.49 79.02 67.93 4.5 SSD识别结果

SSD实验结果如表10所示,SSD模型对断线和毛羽的识别率较低,断线的精确率随着召回率的上升快速下降,如图15所示。需要人工设置预选框的最大值、最小值和宽高比值。而对于毛羽、断线这类识别目标来说,比例和位置都有较强的随机性。

表 10 SSD模型的识别结果Table 10 Identification results of SSD% 数据集 R P AP (mAP) 断线 58.25 48.39 60.64 毛羽 28.90 53.85 40.63 全部瑕疵 43.58 51.12 50.63 4.6 实验结果讨论

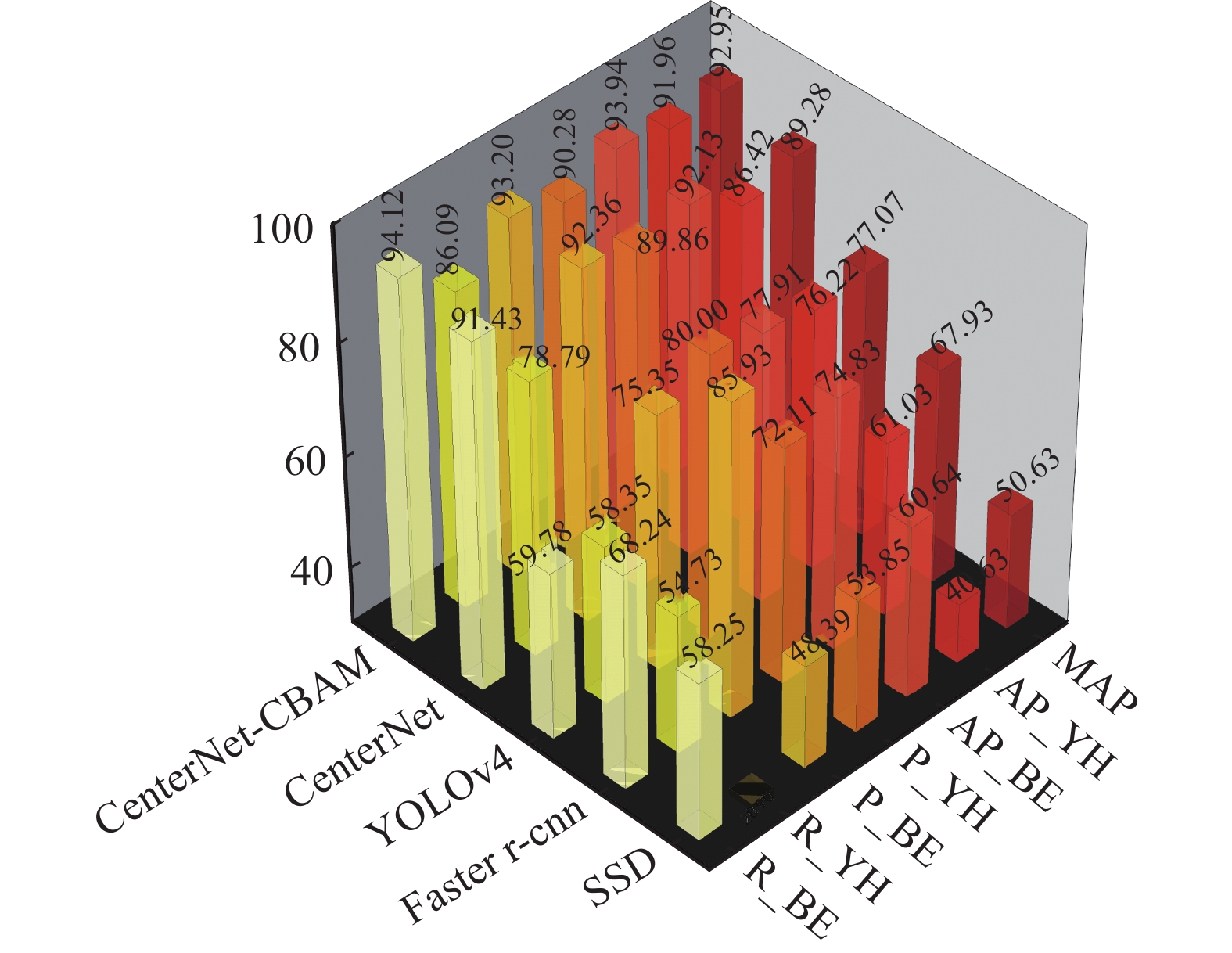

在被检测的两类目标中,断线由于特征更加明显,在准确率和召回率、AP值上均优于毛羽,YOLOv4、Faster R-CNN和SSD算法目标检测算法使用先验框,即先在图片上设定大量的先验框,网络的预测结果会对先验框进行调整获得预测框,受到被检物体尺寸的限制,对小物体检测效果不佳。CenterNet-CBAM得到的瑕疵置信度和IOU值都较高;CenterNet中出现了部分目标未被检出的情况;YOLOv4对于毛羽瑕疵出现了错检的情况,部分毛羽被检测为断线;Faster R-CNN的识别结果出现了错检和复检的情况;而SSD的识别置信度较低,且有漏检问题。综合比较过后发现CenterNet-CBAM算法识别效果最佳,如图16所示。

在CenterNet-CBAM、 CenterNet、YOLOv4、Faster R-CNN、SSD五种算法中,mAP值最高的是CenterNet-CBAM算法,达92.95%,如图17所示。CenterNet网络中加入CBAM后,加强提取任务相关的特征,抑制任务无关的特征,重新定义每个通道和空间特征的重要性,以较小的开销达到提升网络性能、提高模型识别率和加快模型收敛速度的效果。通过加入特征融合,强化了特征图的细节信息,提高了小目标检测能力。实验结果表明,嵌入CBAM注意力机制和特征融合的CenterNet算法在准确率和召回率上有提升,相较于其他算法,本算法有更高的识别率,可以为化纤丝饼生产提供精准的检测服务。

本文实验也存在一定的局限性:1)单个相机的拍摄范围有限,后期选用多相机阵列式组合可以提高采样率;2)实验后可以将毛羽进行进一步分类,通过更加精细的分类,有助于丝饼的分级工作,出现频率较高的瑕疵类型归因为设备故障,克服了传统的人工检测方式具有的滞后性,准确及时地根据缺陷类型来排除生产故障;3)后续研究将进一步更新模型,使用目标检测中的非卷积算法ViT (vision transformer)等进行计算。

5. 结束语

本文提出面向丝饼微小毛羽的检测方法,通过搭建图像采集平台构建丝饼瑕疵数据集,使用放大镜头检测微小物体特性,获得新的丝饼瑕疵图像。将注意力机制加入丝饼检测算法当中,mAP值达到92.95%,对比多种算法检测结果后,验证CenterNet-CBAM在准确率、召回率上均有更好的表现,验证了所提出的智能视觉检测系统的有效性。

-

表 1 显微镜头参数

Table 1 Microscope lens parameters

性能参数 参数 光学放大倍数 1.2~1.8 像素 1920×1080 视野范围/mm 2.4~36 工作距离/mm 55~285 帧率/f·s−1 30 图像格式 BMP/JPG 接口 C接口 产品尺寸/mm Φ40×100 表 2 CMOS相机参数

Table 2 CMOS camera parameters

性能参数 参数 传感器 CMOS 1/2.7'' OV2701 Sensor 像素 1920×1080 靶面尺寸/mm2 5.270×3.960 帧率/f·s−1 30 接口 C接口 产品尺寸/mm3 35×37×37 表 3 采集图像数量

Table 3 Number of images acquired

张 数据集 断线 毛羽 无瑕疵 总计 样本数 501 543 570 1614 表 4 4种算法训练参数

Table 4 Training parameters of four algorithms

训练阶段 Epoch Batch_size Learning_rate 冻结阶段 500 8 1×10−3 解冻阶段 1500 8 1×10−4 表 5 CenterNet-CBAM训练参数

Table 5 CenterNet-CBAM training parameters

Epoch Batch_size Learning_rate 2000 8 1×10−4 表 6 CenterNet-CBAM模型的识别结果

Table 6 Identification results of CenterNet-CBAM

% 数据集 R P AP (mAP) 断线 94.12 93.20 93.94 毛羽 86.09 90.28 91.96 全部瑕疵 90.11 91.74 92.95 表 7 CenterNet模型的识别结果

Table 7 Identification results of CenterNet

% 数据集 R P AP (mAP) 断线 91.43 92.36 92.13 毛羽 78.79 89.86 86.42 全部瑕疵 85.11 91.11 89.28 表 8 YOLOv4模型的识别结果

Table 8 Identification results of YOLOv4

% 数据集 R P AP (mAP) 断线 59.78 75.35 80.15 毛羽 58.35 80.00 74.38 全部瑕疵 59.07 77.68 77.27 表 9 Faster R-CNN模型的识别结果

Table 9 Identification results of Faster R-CNN

% 数据集 R P AP (mAP) 断线 68.24 85.93 74.83 毛羽 54.73 72.11 61.03 全部瑕疵 61.49 79.02 67.93 表 10 SSD模型的识别结果

Table 10 Identification results of SSD

% 数据集 R P AP (mAP) 断线 58.25 48.39 60.64 毛羽 28.90 53.85 40.63 全部瑕疵 43.58 51.12 50.63 -

[1] 孙建奎, 王勃. 165dtex/36f涤纶FDY绊丝产生原因分析及对策[J]. 合成纤维, 2021, 50(10): 4–7. doi: 10.16090/j.cnki.hcxw.2021.10.006 SUN Jiankui, WANG Bo. Discussion on the causes and countermeasures of overthrown yarn with 165 dtex/36 f polyester FDY[J]. Synthetic fiber in China, 2021, 50(10): 4–7. doi: 10.16090/j.cnki.hcxw.2021.10.006 [2] 赵博. 减少纯化纤纱毛羽的研究与探讨[J]. 化纤与纺织技术, 2007, 36(4): 11–15. doi: 10.3969/j.issn.1672-500X.2007.04.005 ZHAO Bo. Discussion and research of reducing the pure chemical fibre yarn hairiness[J]. Chemical fiber & textile technology, 2007, 36(4): 11–15. doi: 10.3969/j.issn.1672-500X.2007.04.005 [3] ARENTS J, GREITANS M. Smart industrial robot control trends, challenges and opportunities within manufacturing[J]. Applied sciences, 2022, 12(2): 937. doi: 10.3390/app12020937 [4] TOUNSADI H, METARFI Y, TALEB M, et al. Impact of chemical substances used in textile industry on the employee's health: Epidemiological study[J]. Ecotoxicology and environmental safety, 2020, 197: 110594. doi: 10.1016/j.ecoenv.2020.110594 [5] RASMUSSE J. Human error mechanisms in complex work environments[J]. Reliability engineering & system safety, 1988, 22(1/2/3/4): 155–167. [6] ACEMOGLU D, RESTREPO P. The race between man and machine: implications of technology for growth, factor shares, and employment[J]. American economic review, 2018, 108(6): 1488–1542. doi: 10.1257/aer.20160696 [7] FABIJAŃSKA A, JACKOWSKA-STRUMIŁŁO L. Image processing and analysis algorithms for yarn hairiness determination[J]. Machine vision and applications, 2012, 23(3): 527–540. doi: 10.1007/s00138-012-0411-y [8] BISSI L, BARUFFA G, PLACIDI P, et al. Patch based yarn defect detection using Gabor filters[C]//2012 IEEE International Instrumentation and Measurement Technology Conference Proceedings. Graz: IEEE, 2012: 240−244. [9] 李东洁, 郭帅, 杨柳. 基于改进图像阈值分割算法的纱线疵点检测[J]. 纺织学报, 2021, 42(3): 82–88. doi: 10.13475/j.fzxb.20200700407 LI Dongjie, GUO Shuai, YANG Liu. Yarn defect detection based on improved image threshold segmentation algorithm[J]. Journal of textile research, 2021, 42(3): 82–88. doi: 10.13475/j.fzxb.20200700407 [10] 李彦, 朱凌云. 基于图像处理的纽扣轮廓瑕疵检测[J]. 东华大学学报(自然科学版), 2021, 47(4): 69–74,134. doi: 10.19886/j.cnki.dhdz.2020.0082 LI Yan, ZHU Lingyun. Detection of button contour defects based on image processing[J]. Journal of Donghua University (natural science edition), 2021, 47(4): 69–74,134. doi: 10.19886/j.cnki.dhdz.2020.0082 [11] REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(6): 1137–1149. doi: 10.1109/TPAMI.2016.2577031 [12] 车翔玖, 刘华罗, 邵庆彬. 基于Fast RCNN改进的布匹瑕疵识别算法[J]. 吉林大学学报(工学版), 2019, 49(6): 2038–2044. CHE Xiangjiu, LIU Hualuo, SHAO Qingbin. Fabric defect recognition algorithm based on improved Fast RCNN[J]. Journal of Jilin University (engineering and technology edition), 2019, 49(6): 2038–2044. [13] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 779−788. [14] 唐有赟, 盛晓伟, 徐洋, 等. 基于轻量级模型的经编布瑕疵在线检测算法[J]. 东华大学学报(自然科学版), 2020, 46(6): 922–928. TANG Youyun, SHENG Xiaowei, XU Yang, et al. Online defect detection algorithm of warp knitting fabric based on lightweight model[J]. Journal of Donghua University (natural science edition), 2020, 46(6): 922–928. [15] 王泽霞, 陈革, 陈振中. 基于改进卷积神经网络的化纤丝饼表面缺陷识别[J]. 纺织学报, 2020, 41(4): 39–44. doi: 10.13475/j.fzxb.20190500406 WANG Zexia, CHEN Ge, CHEN Zhenzhong. Surface defect recognition of chemical fiber yarn packages based on improved convolutional neural network[J]. Journal of textile research, 2020, 41(4): 39–44. doi: 10.13475/j.fzxb.20190500406 [16] 张君扬, 景军锋. 应用激光三角测量法的化纤丝饼毛羽检测[J]. 西安工程大学学报, 2020, 34(3): 19–25. doi: 10.13338/j.issn.1674-649x.2020.03.004 ZHANG Junyang, JING Junfeng. Hairiness detection of chemical fiber DTY packages using laser triangulation[J]. Journal of Xi'an Polytechnic University, 2020, 34(3): 19–25. doi: 10.13338/j.issn.1674-649x.2020.03.004 [17] LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: single shot MultiBox detector[M]//Computer Vision-ECCV 2016. Cham: Springer International Publishing, 2016: 21−37. [18] 徐德. 显微视觉测量与控制[M]. 北京: 国防工业出版社, 2014. [19] GESSERT N, BENGS M, WITTIG L, et al. Deep transfer learning methods for colon cancer classification in confocal laser microscopy images[J]. International journal of computer assisted radiology and surgery, 2019, 14(11): 1837–1845. doi: 10.1007/s11548-019-02004-1 [20] 路凯, 钟跃崎, 朱俊平, 等. 基于视觉词袋模型的羊绒与羊毛快速鉴别方法[J]. 纺织学报, 2017, 38(7): 130–134,141. doi: 10.13475/j.fzxb.20160606906 LU Kai, ZHONG Yueqi, ZHU Junping, et al. Rapid identification method of cashmere and wool based on bag-of-visual-word[J]. Journal of textile research, 2017, 38(7): 130–134,141. doi: 10.13475/j.fzxb.20160606906 [21] KISANTAL M, WOJNA Z, MURAWSKI J, et al. Augmentation for small object detection[EB/OL].(2019−04−16)[2021−12−15].https://arxiv.org/abs/1902.07296v1. [22] TONG Kang, WU Yiquan, ZHOU Fei. Recent advances in small object detection based on deep learning: a review[J]. Image and vision computing, 2020, 97: 103910. doi: 10.1016/j.imavis.2020.103910 [23] MA Xinshu, LI Xiaohuan, TANG Xin, et al. Deconvolution Feature Fusion for traffic signs detection in 5G driven unmanned vehicle[J]. Physical communication, 2021, 47: 101375. doi: 10.1016/j.phycom.2021.101375 [24] HAN Chaojun, SHEN Fumin, LIU Li, et al. Visual spatial attention network for relationship detection[C]//MM’18: Proceedings of the 26th ACM International Conference on Multimedia. New York: ACM, 2018: 510−518. [25] 赵文清, 周震东, 翟永杰. 基于反卷积和特征融合的SSD小目标检测算法[J]. 智能系统学报, 2020, 15(2): 310–316. doi: 10.11992/tis.201905035 ZHAO Wenqing, ZHOU Zhendong, ZHAI Yongjie. SSD small target detection algorithm based on deconvolution and feature fusion[J]. CAAI transactions on intelligent systems, 2020, 15(2): 310–316. doi: 10.11992/tis.201905035 [26] ZHOU XINGYI, WANG DEQUAN, KRÄHENBÜHL P. Objects as points[EB/OL].(2019−02−19)[2021−12−15]. https://arxiv.org/abs/1904.07850. [27] NAZIR T, NAWAZ M, RASHID J, et al. Detection of diabetic eye disease from retinal images using a deep learning based CenterNet model[J]. Sensors (Basel, Switzerland), 2021, 21(16): 5283. doi: 10.3390/s21165283 [28] 张宸嘉, 朱磊, 俞璐. 卷积神经网络中的注意力机制综述[J]. 计算机工程与应用, 2021, 57(20): 64–72. ZHANG Chenjia, ZHU Lei, YU Lu. Review of attention mechanism in convolutional neural networks[J]. Computer engineering and applications, 2021, 57(20): 64–72. [29] HU Jie, SHEN Li, SUN Gang. Squeeze-and-excitation networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 7132−7141. [30] 江培营, 陶青川, 艾梦琴. 基于注意力机制和深度学习的钢板表面缺陷图像分类[J]. 计算机应用与软件, 2021, 38(9): 214–219. doi: 10.3969/j.issn.1000-386x.2021.09.033 JIANG Peiying, TAO Qingchuan, AI Mengqin. Steel surface defect image classification based on attention mechanism and deep learning[J]. Computer applications and software, 2021, 38(9): 214–219. doi: 10.3969/j.issn.1000-386x.2021.09.033

下载:

下载: