2. 清华大学 北京信息科学与技术国家研究中心,北京 100084;

3. 清华大学 自动化系,北京 100084;

4. 涿溪脑与智能研究所,浙江 杭州 311121;

5. 京东集团,北京 100176

2. Beijing National Research Center for Information Science and Technology, Tsinghua University, Beijing 100084, China;

3. Department of Automation, Tsinghua University, Beijing 100084, China;

4. Zhuoxi Institute of Brain and Intelligence, Hangzhou 311121, China;

5. Jd.Com, Inc, Beijing 100176, China

随着社交媒体的空前发展,互联网上积累了大量的用户数据,比如图像、文本、语音等。利用这些跨模态数据挖掘用户需求,提升产品服务,成为了工业界的迫切需求之一。跨模态图像文本检索是实现跨模态数据挖掘的关键技术之一。它旨在探索图像和文本之间的对应关系,实现图像和文本的跨模态信息理解,以及文本检索图像或图像检索文本的智能服务。图像和文本的跨模态检索在实际社交媒体领域有广泛的技术应用价值,比如在人机交互、商业化广告文案推荐以及内容推荐等领域,因此吸引了众多研究人员的注意力。

在实际场景中,跨模态图像文本检索面临两大挑战:1)不同模态数据的异质性阻碍了模型学习到优异的跨模态表示;2)视觉和语言之间关联丰富而复杂,准确挖掘两者的对应关系十分困难。为了解决以上挑战,前人工作提出了特征嵌入表示技术来联合学习图像和文本的特征。Wang等[1]使用双视图网络分别将图像和文本映射到共享嵌入空间中,然后采用一个保结构的双向目标函数来优化网络。Faghri等[2]提出使用难负例来增强嵌入空间的学习,实现了性能的显著性提升。然而特征嵌入表示方法将图像和文本信息映射到统一的向量空间中,忽视了图像和文本信息的复杂性,以及两者之间信息关联的多样性和复杂性。近年来,研究人员提出了许多方法来挖掘图像和文本之间的细粒度的跨模态关联信息。Karpathy等[3]将图像中的每个区域与文本中的每个单词对齐,提出了一种基于片段的匹配方法。Nam等[4]使用注意力机制[5]和记忆机制来动态探索图像和文本之间的微妙交互。Lee等[6]提出了一种堆叠交叉注意力模型,称为SCAN,取得了先进的图像文本检索性能。

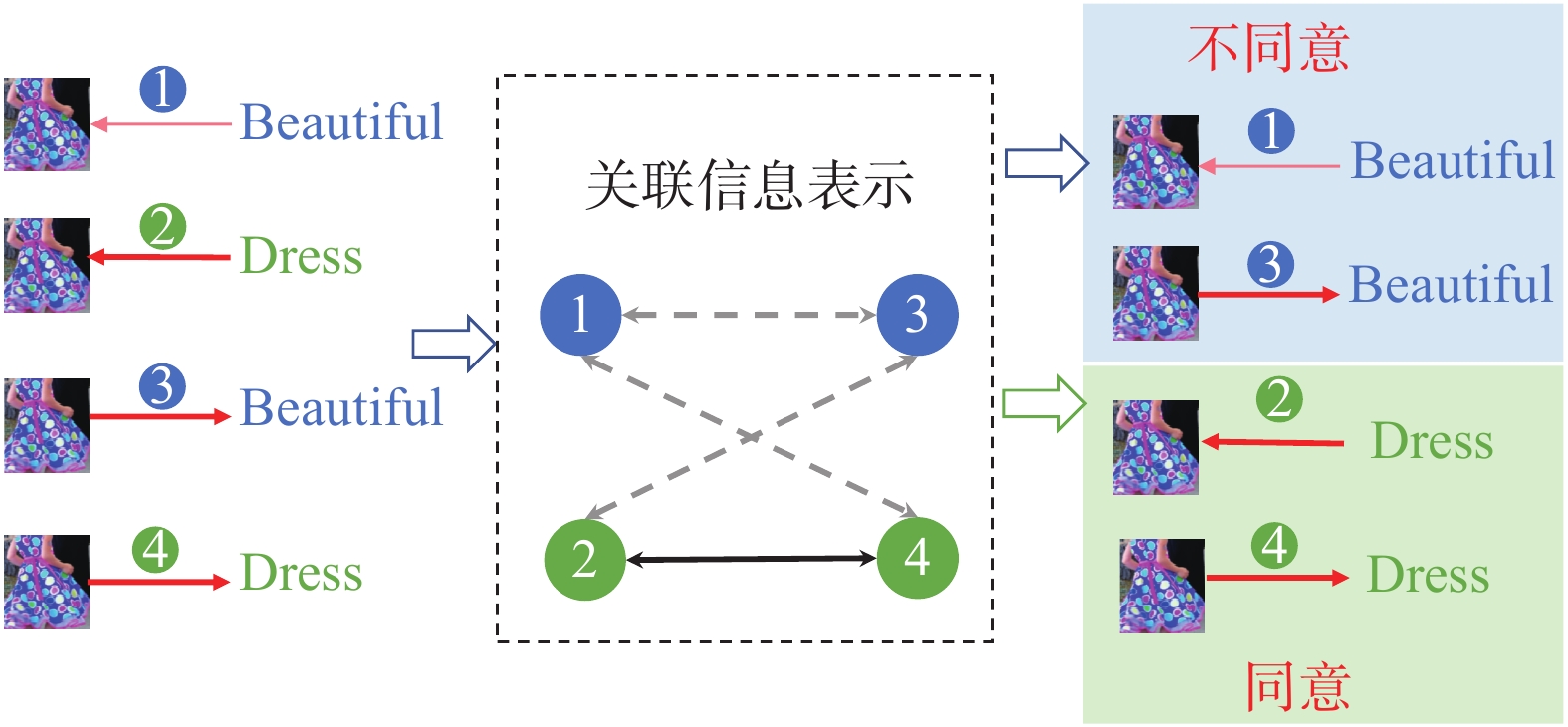

1 本文工作SCAN的成功很好地展示了细粒度跨模态关联关系挖掘的优势。然而,这种方式依靠注意力来实现片段(即区域和单词)之间的匹配,只关注两者的一阶关系,并不能反映两种不同匹配方式之间的一致性。具体来说,SCAN分别用注意力构建了区域−单词和单词−区域的两种对齐方式,其中区域−单词是计算所有单词跟给定区域的相似性得分,并经过规范化操作得到相似性分布,同样地,单词−区域是计算所有区域跟给定单词的规范化后的相似性得分。由于规范化操作,单词和区域的相似性度量在两种对齐方式中会得到不一样的得分,使得出现不同的情况。比如在图1中,在区域−单词匹配方式中,和区域r2最相关的词是dress,而和beautiful的相关性较弱,而在单词−区域匹配方式中,区域r2却是和beautiful最相关的区域。这种矛盾说明了两种方式不一致的问题。

|

Download:

|

| 图 1 对齐不一致问题 Fig. 1 Inconsistent alignment problem | |

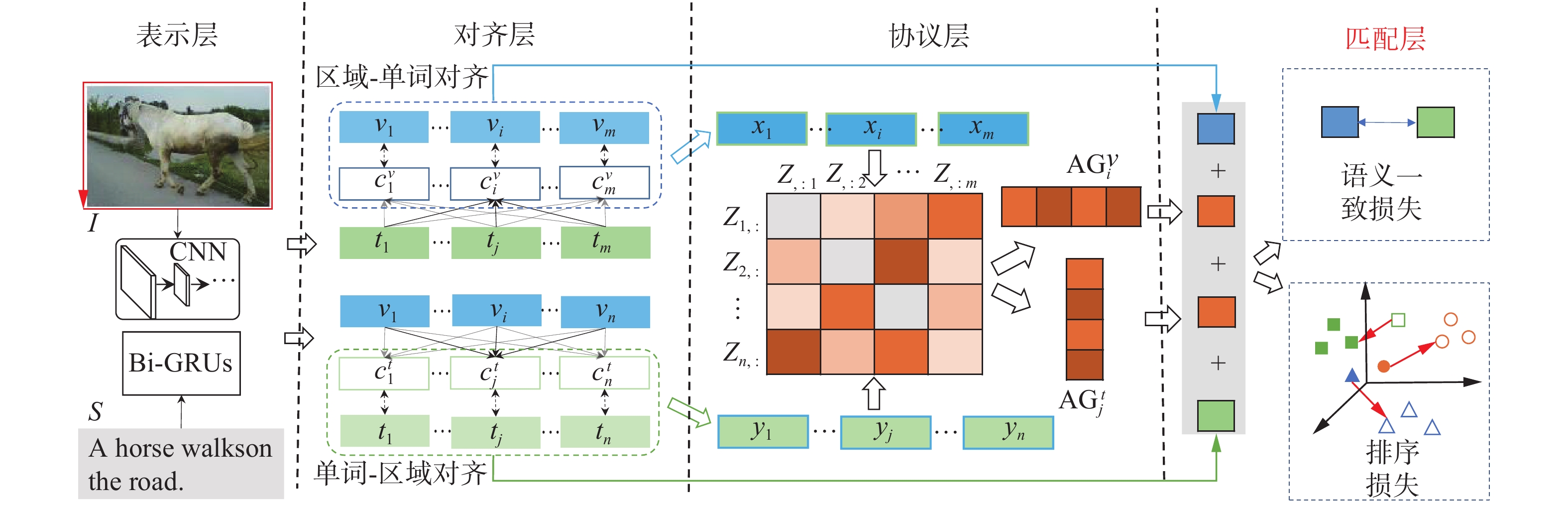

本文旨在充分挖掘不同对齐方式的一致性信息,来增强跨模态图像和文本的匹配准确性。本文提出了一种一致性协议匹配的方法(matching with agreement,MAG),如图2所示,在使用注意力机制得到对齐上下文特征后,构建了区域−单词关联信息表示和单词−区域关联信息表示,并在此基础上,提出关联信息一致性协议的匹配策略,提升图像和文本的跨模态检索性能。

|

Download:

|

| 图 2 一致性协议匹配 Fig. 2 Matching with agreement | |

所提出的一致性协议匹配(MAG)方法包含4个层,即表示层、对齐层、协议层和匹配层。其中,在表示层,本文使用卷积神经网络(convolutional neural network, CNN)和循环神经网络(recurrent neural network, RNN)分别提取了图像区域和单词的特征;在对齐层,使用注意力机制得到区域−单词对齐和单词−区域对齐;接着在协议层中,两种不同的对齐可以通过融合注意力机制里的上下文特征得到关联信息表示,并采用竞争性投票的方案得到对齐一致性得分;最后在匹配层通过聚合不同的匹配线索,获得图像文本对之间的相似性。

本文在两个大型的跨模态图像文本检索的基准数据集(Flickr30K和MS COCO)上进行了大量的实验,实验结果表明,相比于一系列先进的跨模态图像文本检索基线模型,本文提出的一致性协议匹配方法在两个数据集上都具有显著的性能优势,进一步的模型分析和实例分析很好地验证了所提出方法的有效性和优越性。

2 相关工作跨模态图像文本检索的相关工作通常使用深度神经网络来避免使用手工制作的特征。它们可以大致分为两类:基于嵌入的方法和基于细粒度对齐的方法。

基于嵌入的方法通常学习一个共享的嵌入空间,并通过计算嵌入空间中图像和文本特征之间的距离来估计图像和文本之间的相似性。Frome等[7]尝试通过CNN[8] 和Skip-Gram 模型[9]来学习跨模态表示。类似地,Kiros等[10]采用 CNN来提取视觉特征,并采用门循环单元 (gated recurrent unit, GRU)[11] 来提取文本特征。Faghri等[2]提出了一种难负例挖掘的三元组损失函数,取得了显著的性能提升,并成为跨模态图像文本检索领域广泛使用的目标函数。

基于细粒度对齐的方法旨在探索图像和文本之间潜在的细粒度对应关系。Karpathy等[3]将图像和文本的片段对齐到公共空间中,并通过聚合局部对齐来计算图像和文本的全局相似度。Niu等[12]提出了一种分层模型,其中图像和文本通过分层策略实现实例到特征的全局和局部联合映射。Lee等[6]提出了一个堆叠交叉注意力模型,旨在发现图像区域和文本词之间的完整潜在对齐,并在多个基准数据集上实现先进的性能。

3 一致性协议匹配本节讨论所提出的一致性协议匹配方法,如图3所示。

|

Download:

|

| 图 3 一致性协议匹配方法框架 Fig. 3 Framework of the proposed MAG method | |

在表示层,本文的目标是在潜在共享特征空间中对图像和文本的信息进行特征表达,以估计它们之间的相似性。给定一个包含

具体来说,给定图像

| $ {v_i} = {W_v}{f_i} + {b_v} $ | (1) |

式中:

给定有

| $ \mathop \to \limits_{{{\boldsymbol{h}}_j}} = \mathop \to \limits_{{\text{GRU}}} \left( {{{\boldsymbol{e}}_j},\mathop \to \limits_{{{\boldsymbol{h}}_{j - 1}}} } \right);\mathop \leftarrow \limits_{{{\boldsymbol{h}}_j}} = \mathop \leftarrow \limits_{{\text{GRU}}} \left( {{{\boldsymbol{e}}_j},\mathop \leftarrow \limits_{{{\boldsymbol{h}}_{j + 1}}} } \right) $ | (2) |

式中

对齐层旨在探索视觉信息和文本信息之间的细粒度关联关系。和前人工作[14]一样,我们采用双向注意力机制将图像中的区域和文本中的单词巧妙地对齐。具体来说,给定图像特征

| $ {\boldsymbol{A}}_{ij}=\frac{{{\boldsymbol{v}}}_{i}{}^{{\rm{T}}}{{\boldsymbol{t}}}_{j}}{\Vert {{\boldsymbol{v}}}_{i}\Vert \cdot \Vert {{\boldsymbol{t}}}_{j}\Vert },\quad \forall i\in \left[1,m\right],\forall j\in \left[1,n\right] $ | (3) |

这里,本文用余弦距离来度量两个向量间的相似性,向量上标表示向量转置。

| $ {c}_{i}^{t}={\displaystyle\sum _{j=1}^{n}}{\alpha }_{ij}{{\boldsymbol{t}}}_{j},\quad{\alpha }_{ij}=\frac{\text{exp}\left(\lambda {a}_{ij}\right)}{{{\displaystyle \sum }}_{k}\text{exp}\left(\lambda {a}_{ik}\right)} $ | (4) |

式中:

| $ {a_{ij}} = {{\sigma ({{\boldsymbol{A}}_{ij}})} \mathord{\left/ {\vphantom {{\sigma ({A_{ij}})} {\sqrt {\mathop \sum \nolimits_k \sigma {{\left( {{A_{kj}}} \right)}^2}} }}} \right. } {\sqrt {\mathop \sum_k \sigma {{\left( {{{\boldsymbol{A}}_{kj}}} \right)}^2}} }} $ | (5) |

同理,可以为每个单词计算它对应的图像上下文特征:

| $ {c}_{j}^{v}={\displaystyle\sum _{i=1}^{m}}{\beta }_{ij}{{\boldsymbol{v}}}_{i},\quad{\beta }_{ij}=\frac{\text{exp}\left(\lambda {b}_{ij}\right)}{{{\displaystyle \sum _{k}}}\text{exp}\left(\lambda {b}_{kj}\right)} $ | (6) |

式中:

| $ {b_{ij}} = \frac{{\sigma \left( {{{\boldsymbol{A}}_{ij}}} \right)}}{{\sqrt {\mathop {\displaystyle\sum_k} \sigma {{\left( {{{\boldsymbol{A}}_{ik}}} \right)}^2}} }} $ | (7) |

和Chen等[14]工作一样,给定一个图像文本对

| $ {F_{{\text{aln}}}}\left( {I,S} \right) = \frac{1}{m}\mathop \sum \limits_i^m \frac{{{\boldsymbol{v}}_i{}^{\rm{T}}c_i^t}}{{\left\| {{{\boldsymbol{v}}_i}} \right\| \cdot \left\| {{{c}}_i^{\rm{t}}} \right\|}} + \frac{1}{n}\mathop \sum \limits_j^n \frac{{{\boldsymbol{t}}_j{}^{\rm{T}}c_j^v}}{{\left\| {{{\boldsymbol{t}}_j}} \right\| \cdot \left\| {c_j^v} \right\|}} $ | (8) |

因为

从式(4)和式(6)可以看出,对齐层利用相似性矩阵

具体来说,首先定义对齐操作的特征表示为每个区域或者单词和其对应上下文特征的加和:

| $ {{\boldsymbol{x}}_i} = {{\boldsymbol{v}}_i} + {\boldsymbol{c}}_i^t,\quad{{\boldsymbol{y}}_j} = {{\boldsymbol{t}}_j} + {\boldsymbol{c}}_j^v $ | (9) |

式中:

其次,使用余弦距离来衡量两种对齐特征的相似性:

| $ {Z_{ij}} = \frac{{{\boldsymbol{x}}_i^T{{\boldsymbol{y}}_j}}}{{\left\| {{{\boldsymbol{x}}_i}} \right\| \cdot \left\| {{{\boldsymbol{y}}_j}} \right\|}},\quad\forall i \in \left[ {1,m} \right],\forall j \in [1,n] $ | (10) |

式中:

为了鼓励一致性的局部对齐(即区域−单词对齐和单词−区域对齐)能够在后续计算图像和文本的相似性过程中被赋予更高的重要性,本文对

| $ {\text{AG}}_i^v = \mathop {\max }\limits_j {Z_{ij}},\quad{\text{AG}}_j^t = \mathop {\max }\limits_i {Z_{ij}} $ | (11) |

按行取最值可以让每个单词−区域对齐互相竞争,胜者跟区域−单词对齐

最后,本文将所有的协议得分进行平均,得到图像和文本的协议分数:

| $ {F_{{\text{agr}}}}\left( {I,S} \right) = \frac{1}{m}\mathop \sum \limits_i^m {\text{AG}}_i^v + \frac{1}{n}\mathop \sum \limits_j^n {\text{AG}}_j^t $ | (12) |

对比对齐分数(见式(8)),协议分数

匹配层的目的是累积所有匹配线索以估计图像和文本之间的相似性。本文将对齐层的对齐分数和协议层的协议分数结合起来计算给定图像–文本对

| $ F\left( {I,S} \right) = {F_{{\text{aln}}}}\left( {I,S} \right) + {F_{{\text{agr}}}}\left( {I,S} \right) $ | (13) |

训练时,本文采用Faghri等[2]提出的基于难负例的三元组排序损失函数来训练模型:

| $ \begin{gathered} {\mathcal{L}_{{\text{rank}}}}(I,S) = {\left[ {\varDelta - F\left( {I,S} \right) + F\left( {I,S'} \right)} \right]_ + } + \hfill \\ \quad \quad \quad \quad {\left[ { - F\left( {I,S} \right) + F\left( {I',S} \right)} \right]_ + } \hfill \\ \end{gathered} $ | (14) |

式中:

此外,考虑到在协议层中本文希望能够挖掘更多的一致性对齐来增强对图像和文本相似性的度量,为此本文采用Chen等[14]的方法引入语义一致性损失函数:

| $ {\mathcal{L}_{{\text{aln}}}}\left( {I,S} \right) = {\left( {\frac{1}{m}\mathop \sum \limits_i^m \frac{{v_i^{\rm{T}}c_i^t}}{{\left\| {{v_i}} \right\| \cdot \left\| {c_i^t} \right\|}} - \frac{1}{n}\mathop \sum \limits_j^n \frac{{t_j^{\rm{T}}c_j^v}}{{\left\| {{t_j}} \right\| \cdot \left\| {c_j^v} \right\|}}} \right)^2} $ | (15) |

在训练过程中,从数据集中采样一批次图像文本对进行训练,即

| $ \mathcal{L} = \mathop \sum \limits_k^{{N_b}} {\mathcal{L}_{{\text{rank}}}}\left( {{I_k},{S_k}} \right) + {\lambda _{{\text{aln}}}}\mathop \sum \limits_{k,l}^{{N_b}} {\mathcal{L}_{{\text{aln}}}}\left( {{I_k},{S_l}} \right) $ | (16) |

式中

1) 数据集。本文采用了两个跨模态图像文本标准基线数据集来验证所提出的一致性协议匹配方法。①Flickr30K[15]。这个数据集由31000张图片组成,每张图片都至少标注了5个英文文本。本文采用29000张图片作为训练集,1000张图片作为验证集,剩下的1000张图片作为测试集,这也是标准的数据划分。②MSCOCO[16]。COCO数据集大概有123000张图片,每张图片标注了至少5个英文句子。和前人工作[1] 一样,本文将123 287张图片划分为113 287、5 000和5000,分别构成了训练集、验证集和测试集。为了能够公平地评价模型的结果以及跟别人的工作进行对比,本文同时展示在5000张测试图片上的整体性能(用MS COCO(5K)表示)以及5次实验(每次1000张图片(用MS COCO(1K)表示)的平均值。

2) 评价指标。本文进行了图像检索文本和文本检索图像两类不同的检索任务,采用前K召回率(R@K)来评测两种跨模态检索性能,并且和前人的工作进行对比。具体来说,本文展示R@1、R@5和R@10的结果,并且,跟Chen等[14]的工作一样,本文将所有的指标加起来来综合评价模型的性能,该指标用R@sum表示。

3) 实现细节。本文使用Pytorch1.0[17]来实现所提出的方法。在构建模型时,本文将图像区域特征的维度设置为1024。Bi-GRU的隐藏向量的维度也是1024,使得图像区域特征和单词特征的维度一致。训练过程中,三元组损失函数中的排序间隔设置为0.2,即式(14)中的

为了验证所提出的一致性协议匹配方法的先进性,本文引入了目前相关的先进的跨模态图像文本检索方法,并在Flickr30K和MS COCO两个数据集上都进行了模型对比。本文对比的基线模型有DVSA[3]、VSE++[2]、DPC[19]、SCO[20]、SCAN[6]、PFAN[21]、PVSE[22]和SC[14]。其中,SCAN、PFAN、PVSE和SC跟本文一样,都是致力于挖掘图像和文本之间的细粒度跨模态关联来提升跨模态检索性能。表1、2、3分别给出了本文的方法和基线模型在Flickr30K和MS COCO上的对比结果,其中,表格中第1列中带*标记的方法表示该结果是采用模型集成的结果,“—”表示该结果未在原始论文中给出。

| 表 1 Flickr30K上对比结果 Tab.1 Comparison with state-of-the-art methods on Flickr30K |

| 表 2 MS COCO(1K)上对比结果 Tab.2 Comparison with state-of-the-art methods on MS COCO(1K) |

| 表 3 MS COCO(5K)上对比结果 Tab.3 Comparison with state-of-the-art methods on MS COCO(5K) |

从表1、2、3中可以看到,本文提出的一致性协议匹配方法在两个数据集上都取得了比基线模型更优异的跨模态图像文本检索性能。具体来说,1)在Flickr30K上,本文的MAG*取得了比最好的基线模型SC*更好的性能,特别是在图像检索文本任务的R@1上提高了4.7%,在文本检索图像的R@1上取得了0.3%的性能提升,整体上提升了8.7%(R@sum);2)在MS COCO(1K)中,本文的MAG*获得了更先进的性能,与 SC* 相比,本文的MAG*在图像检索文本任务的R@1上可以获得76.1%的召回率,提高了2.3%,在文本检索图像任务的R@1上,MAG*取得了60.6%的性能,提升了0.7%;3)在MS COCO(5K)中,本文的MAG*在大多数评价指标上也获得了优于最佳基线SCAN*的卓越性能。相比于SCAN*,MAG*在图像检索文本任务上最多可以获得3.7%(R@1)的性能提升,整体提升3%。这些结果证明了所提出的一致性匹配方法的有效性。

4.3 模块分析本节对所提出的一致性协议匹配方法中的重要因素进行分析。首先分析匹配层中语义一致性损失的作用。语义一致性损失可以驱动两个独立注意力模块的对齐保持一致,有助于后续基于协议的匹配过程。因此,本文通过调节式(16)中的

| 表 4 语义一致性损失函数的影响 Tab.4 Effect of the semantic consistency objective |

本文接着对图像和文本的相似性度量进行分析。为了观察所提出的协议层的影响,本文通过逐步擦除

本文对模型进行进一步的实例分析。在图4中,本文展示了两个实例,在每个可视化示例中,分别在左侧和右侧的图像展示了给定文本中的两个单词(分别用蓝色和绿色标记)及其在图像区域上的注意力结果,这种注意力结果可以被看作是单词–区域对齐。对于中间的图像,本文展示了一个显著性区域跟文本中单词的注意力结果,这可以看作是区域–单词对齐。这里用红色的双向箭头表示两种对齐之间的一致性得分。

| 表 5 协议层的影响 Tab.5 Effect of the agreement layer |

|

Download:

|

| 图 4 一致性协议匹配实例分析 Fig. 4 Examples of the proposed MAG method | |

可以看到,在两个单词–区域对齐(左和右)中,对应的词都与红色框中的区域高度相关。而在区域–单词对齐(中间)中,左侧的单词与区域的相关性更高,导致左侧的对齐一致性得分高于右侧。例如,在图4(a)中,左边和右边的图像中的注意力结果表明“Baseball”和“incoming”都与红框中的区域有很强的相关性。然而,中间的图像显示红色区域与单词“Baseball”的相关性高于单词“incoming”,使得左侧单词–区域对齐和中间区域–单词对齐之间的一致性得分更高。未来,本文将继续在跨模态行人再识别[23-24],跨模态哈希检索[25]等其他跨模态任务挖掘这种关联一致性问题,并将本文的方法进行应用扩展,促进跨模态学习的发展。

5 结束语本文针对跨模态图像文本任务提出了一种一致性协议匹配方法。与之前的工作一样,首先使用注意力机制充分探索了图像中区域和文本中单词之间的单词–区域和区域–单词的对齐方式,接着提出跨模态协议来估计对齐的一致性。本文将协议的推导过程实例化为模型的协议层,并采用了一种新颖的竞争性投票方案,为细粒度跨模态关联关系提供强有力的协议准则,促进模型对图像文本之间的相似性的准确建模。本文在两个基准数据集(Flickr30K和MS COCO)上进行了广泛的实验。实验结果表明,本文提出的方法取得了先进的跨模态图像文本检索性能,很好地验证了方法的有效性。

| [1] |

WANG Liwei, LI Yin, LAZEBNIK S. Learning deep structure-preserving image-text embeddings[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, USA, 2016: 5005−5013.

( 0) 0)

|

| [2] |

FAGHRI F, FLEET D J, KIROS J R, et al. VSE++: Improving visual-semantic embeddings with hard negatives[EB/OL]. (2018-07-29)[2021-07-30] https://arxiv.org/pdf/1707.05612.

( 0) 0)

|

| [3] |

KARPATHY A, LI Feifei. Deep visual-semantic alignments for generating image descriptions[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 3128−3137.

( 0) 0)

|

| [4] |

NAM H, HA J W, KIM J. Dual attention networks for multimodal reasoning and matching[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 2156−2164.

( 0) 0)

|

| [5] |

XU K, BA J, KIROS R, et al. Show, attend and tell: Neural image caption generation with visual attention[C]//International Conference on Machine Learning. Sydney, Australia, 2015: 2048−2057.

( 0) 0)

|

| [6] |

LEE K H, CHEN Xi, HUA Gang, et al. Stacked cross attention for image-text matching[M]//FERRARI V, HEBERT M, SMINCHISESCU C, et al. Proceedings of the 15th European Conference on Computer Vision-ECCV 2018. Munich, Germany: Springer, 2018: 201−216.

( 0) 0)

|

| [7] |

FROME A, CORRADO G S, SHLENS J, et al. DeViSE: A deep visual-semantic embedding model[C]//Proceedings of the 26th International Conference on Neural Information Processing Systems. Nevada, USA, 2013: 2121–2129.

( 0) 0)

|

| [8] |

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. (2015-04-10). https://arxiv.org/pdf/1409.1556.

( 0) 0)

|

| [9] |

MIKOLOV T, CHEN Kai, CORRADO G, et al. Efficient estimation of word representations in vector space[EB/OL]. (2013-09-07)[2021-07-30] https://arxiv.org/pdf/1301.3781.

( 0) 0)

|

| [10] |

KIROS R, SALAKHUTDINOV R, ZEMEL R S. Unifying visual-semantic embeddings with multimodal neural language models[EB/OL]. (2014-11-10). https://arxiv.org/pdf/1411.2539.

( 0) 0)

|

| [11] |

CHUNG J, GULCEHRE C, CHO K, et al. Empirical evaluation of gated recurrent neural networks on sequence modeling[EB/OL]. (2014-12-11)[2021-07-30] https://arxiv.org/pdf/1412.3555.

( 0) 0)

|

| [12] |

NIU Zhenxing, ZHOU Mo, WANG Le, et al. Hierarchical multimodal LSTM for dense visual-semantic embedding[C]//2017 IEEE International Conference on Computer Vision. Venice, Italy, 2017: 1899−1907.

( 0) 0)

|

| [13] |

REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[C]//Proceedings of the 28th International Conference on Neural Information Processing Systems. Montreal, Canada, 2015: 91−99.

( 0) 0)

|

| [14] |

CHEN Hui, DING Guiguang, LIN Zijia, et al. Cross-modal image-text retrieval with semantic consistency[C]//Proceedings of the 27th ACM International Conference on Multimedia. Nice, French, 2019: 1749−1757.

( 0) 0)

|

| [15] |

YOUNG P, LAI A, HODOSH M, et al. From image descriptions to visual denotations: New similarity metrics for semantic inference over event descriptions[J]. Transactions of the association for computational linguistics, 2014, 2(1): 67-78. DOI:10.1162/tacl_a_00166 ( 0) 0)

|

| [16] |

LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft coco: Common objects in context[C]//13th European Conference on Computer Vision-ECCV 2014. Zurich, Switzerland, 2014: 740−755.

( 0) 0)

|

| [17] |

PASZKE A, GROSS S, CHINTALA S, et al. Automatic differentiation in PyTorch[C]//31st Conference on Neural Information Processing Systems. Long Beach, USA, 2017.

( 0) 0)

|

| [18] |

KINGMA D P, BA J L. Adam: A method for stochastic optimization[EB/OL]. (2015-04-23)[2021-08-01] https://arxiv.org/pdf/1412.6980.

( 0) 0)

|

| [19] |

ZHENG Zhedong, ZHENG Liang, GARRETT M, et al. Dual-path convolutional image-text embeddings with instance loss[J]. ACM transactions on multimedia computing, communications, and applications, 2020, 16(2): 51.

( 0) 0)

|

| [20] |

HUANG Yan, WANG Wei, WANG Liang. Instance-aware image and sentence matching with selective multimodal LSTM[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Hawaii, USA, 2017: 2310−2318.

( 0) 0)

|

| [21] |

WANG Yaxiong, YANG Hao, QIAN Xueming, et al. Position focused attention network for image-text matching[C]//Proceedings of the Twenty-Eighth International Joint Conference on Artificial Intelligence. Macao, China, 2019: 3792−3798.

( 0) 0)

|

| [22] |

SONG Yale, SOLEYMANI M. Polysemous visual-semantic embedding for cross-modal retrieval[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, USA, 2019.

( 0) 0)

|

| [23] |

陈丹, 李永忠, 于沛泽, 等. 跨模态行人重识别研究与展望[J]. 计算机系统应用, 2020, 29(10): 20-28. CHEN Dan, LI Yongzhong, YU Peizhe, et al. Research and prospect of cross modality person re-identification[J]. Computer systems & applications, 2020, 29(10): 20-28. (  0) 0)

|

| [24] |

刘天瑜, 刘正熙. 跨模态行人重识别研究综述[J]. 现代计算机, 2021, 27(7): 135-139. LIU Tianyu, LIU Zhengxi. Overview of cross modality person Re-identification research[J]. Modern computer, 2021, 27(7): 135-139. (  0) 0)

|

| [25] |

姚伟娜. 基于深度哈希算法的图像—文本跨模态检索研究[D]. 北京: 北京交通大学, 2018. YAO Weina. Image-text cross-modal retrieval based on deep hashing method[D]. Beijing: Beijing Jiaotong University, 2018. (  0) 0)

|

2021, Vol. 16

2021, Vol. 16