Development of a robot arm control system using motor imagery electroencephalography and electrooculography

-

摘要: 脑机接口(brain computer interface, BCI)旨在通过脑电信号与外部设备通信,以实现对外部设备的控制。针对目前脑机接口系统中混合多种复杂生理电信号,并且输出控制指令较少的问题,本文提出融合运动想象(motor imagery, MI)脑电与眼电信号方法扩充控制指令的轻量级机械臂控制系统。该系统分阶段融合脑电和眼电信号两种生物信号,使用双次眼电作为任务开关,运动想象脑电信号控制机械臂运动,单次眼电控制阶段切换,实现了二分类运动想象生成多种控制指令,完成了对机械臂的连续控制。其中运动想象脑电信号使用提升小波变换(lifting wavelet transform, LWT)和共空间模式(common spatial pattern, CSP)结合的方法提取特征,并采用支持向量机(support vector machines, SVM)进行分类;眼电信号通过分析无意识眼电和有意识眼电的峰值来设置阈值进行区分。为了验证系统的可行性,设计了一项脑控机械臂自主服药实验,通过在线实验测试,被试通过使用脑电信号和眼电信号实现了机械臂控制,并完成了服药流程,有利于进一步推广脑机接口技术的实际应用。Abstract: A brain computer interface (BCI) aims to control external devices by communicating with them via brain electroencephalography (EEG) signals. To tackle the issue of complex mixed multiple physiological electrical signals and low output control instructions in BCI systems, a lightweight robot arm control system that integrates motion imagery (MI) and electrooculography (EOG) signals was proposed to expand the control instructions. In this system, two biological EEG and EOG signals were integrated gradually. Robot arm movement was controlled by MI using double EOG as the task switch, and the control stages were switched by single EOG. The dichotomous MI generated a variety of control instructions, completing continuous control over the robot arm. MI EEG signals are extracted using lifting wavelet transform coupled with common spatial patterns and classified using support vector machines. The EOG signals were distinguished by analyzing the peak values of unconscious and conscious EOG set to a specific threshold. To verify the feasibility of this system, this study designed an autonomous drug-taking experiment. In the experiment, the subjects completed the drug-taking process using the BCI system with the robotic arm control, which is conducive to further promoting the practical application of BCI technology.

-

脑机接口(brain computer interface,BCI)是一种不依赖于外围神经和肌肉组织组成的传输通路的通信系统技术,旨在直接通过人类或动物的大脑与外部设备相连接,通过对采集的脑电数据进行分析,识别出人或动物的思维,生成控制指令,实现大脑对外部设备的直接控制[1-2]。近几年来,基于BCI的控制系统引起了研究人员的广泛关注,其在残疾人辅助设备上表现突出,如脑控机械臂、脑控轮椅、康复机器人等。

随着技术的发展,基于非侵入式脑机接口的机械臂控制成为研究热点。对于控制机械臂的脑电信号的提取,目前主流的实验范式是运动想象(motor imagery, MI)和稳态视觉诱发(steady-state visual-evoked potentials, SSVEP)。例如,Zhang等[3]提出了一种基于异步MI的脑驱动机械臂抓取系统,通过MI控制机械臂向3个方向(左、右、前)移动,成功控制机械臂在规避障碍物的同时抓取物体。Zhu等[4]提出了一种基于15个目标类别的SSVEP系统,设计了基于EOG(electrooculography)的开关,使用3次眨眼来激活或关闭基于SSVEP的闪烁,成功地完成了操作机械臂来抓取、举起和移动目标物体。但是,SSVEP是一种诱发脑电,需要外部刺激,因此要求被试长时间地关注电脑屏幕,容易引起视觉疲劳,而MI是一种自发脑电,是大脑的一种主观运动意图,由被试自主决定,更具有主观性,因此备受脑机接口研究领域的欢迎。

目前基于MI的机械臂控制系统主要有两类:单一脑电控制系统和混合脑电控制系统。单一脑电控制系统只使用MI实现对机械臂的控制,因此要获得更多控制指令,需要采用多分类。例如:徐宝国等[5]开发了基于MI四分类的机械臂二维连续控制系统,实现了对四个方向上的目标抓取。Jeong等[6]提出了一种基于CNN-BiLSTM(convolution neural network-bidirectional long short-term memory network)深度学习框架的脑控机械臂系统,从MI脑电图中解码了用户关于手臂在三维多方向(左、右、前、后、上、下)的直观意向,被试成功完成了在三维空间上的物体抓取和自饮。Li等[7]提出了一种用于在整个工作空间中执行串行机械臂运动的BCI系统,采用小世界神经网络对基于MI的5种大脑状态进行分类,控制策略采用6条二元命令实现机械臂在三维笛卡尔空间中的运动控制。混合脑电控制系统指的是混合多种脑电任务对机械臂进行控制,例如Rakshit等[8]开发了基于MI、SSVEP和P300的混合BCI机械臂控制系统,在该系统中,利用LED的闪烁来诱发SSVEP进行机械臂连杆选择,使用MI实现已选连杆的运动,最后用末端执行器过目标时的刺激来产生P300进行反馈,实现了精准定位目标物体。Gao等[9]开发了一种结合MI、EMG(electromyogram)和SSVEP的机械臂控制系统,采用MI作为单刀双掷脑开关(single-pole double throw brain switch, SPDTBS),通过将SPDTBS与基于4级SSEVP相结合,实现了对机械臂运动的三维控制,此外,还检测了咬牙状态的EMG,并将其作为中断器用于初始化SPDTBS语句,参与这项研究的被试成功地通过操纵机械臂写出了单词“HI”。Bhattacharyya等[10]提出了一种利用MI、P300和误差相关电位(ErRP)对机械臂进行定位的脑控系统,该系统中MI用于移动或旋转机器人手臂,P300用来停止机械臂运动,使用ErRP来判定MI解码器是否对输入信号进行了错误分类或机器人连杆端是否越过了目标位置,然后通过调整连杆位置实现对机械臂的精准控制。

综上,虽然目前基于MI的机械臂控制系统已取得了不少成就,但是仍存在二分类MI无法获取更多的控制指令,多分类MI分类准确率低,混合几种脑电信号来执行更多的任务又会给用户造成负担等问题。本研究以控制过程简单,控制完全靠自发,为被试减少负担为目的,设计了基于二分类运动想象脑电与眼电信号融合的机械臂控制系统。首先,对采集的运动想象脑电数据做离线分析,在预处理后,提取提升小波变换(lifting wavelet transform, LWT)8~32 Hz的小波系数作为共空间模式(common spatial pattern, CSP)的输入,通过空间滤波矩阵得到特征向量,并使用支持向量机(support vector machines, SVM)得到离线分类模型。然后,将离线眼电数据滤波处理后,对比无意识眼电和有意识眼电的峰值设定眼电阈值。最后,利用离线分类模型和眼电阈值搭建机械臂在线控制系统,该系统通过分阶段的方式来实现机械臂控制,将整个流程分为几个阶段,用单次眼电切换至下一阶段,在各个阶段左右手运动想象生成不同的控制指令。

本文为了进一步验证该系统的可行性设计了一项自主服药实验,该实验过程分为3个阶段:抓取阶段、服药阶段、药瓶回收阶段。被试通过双次眼电来控制任务的开始,单次眼电用来进入下一任务阶段。在第一阶段,想象左右手运动控制机械臂左右转动,当达到物品位置时通过单次眼电进行抓取;然后,使用单次眼电进入第二阶段,在此阶段想象左右手运动控制着机械爪的翻转;最后,进入第三阶段,再次通过单次眼电来进行药瓶回收,机械臂复位到初态。

1. 系统设计

1.1 系统结构

融合运动想象脑电和眼电信号的机械臂控制系统需要实现脑电和眼电信号采集、运动想象脑电特征提取和分类、指令传递和机械臂控制等功能。其中信号采集,采用的是Brain Products公司的actiCHamp放大器,将采集的数据通过TCP/IP协议发送给客户端计算机。由客户端计算机对传来的实时数据经判断为任务态后进行特征提取和分类,并将分类结果转化为控制命令,再将控制命令发送给机械臂的控制单元,由控制单元对机械臂进行控制,控制单元是由Arduino和蓝牙模块组成。系统结构如图1所示。

1.2 诱发实验

运动想象范式的实验流程设计如图2所示,使用E-prime软件进行设计实现。在实验开始前屏幕将显示实验开始界面,该界面简要描述了实验任务。在确认被试准备好之后,按下空格键开始本次实验。实验开始时有2 s缓冲时间,2 s后屏幕上出现加号提示,持续1 s,提醒被试1 s后进入任务阶段,在3 s时屏幕上会随机出现向左或向右的箭头,被试根据箭头的方向想象哪侧手动,即左箭头想象左手运动,右箭头想象右手运动,想象时间持续4 s,接着为3 s的休息时间,休息结束后进行下一次实验。在实验过程中,被试尽量减少头部晃动、眨眼、肢体运动等。整个实验共分为10组,每组包含了10次实验,共采集了200个数据,左右手分别100个。眼电实验设计跟脑电类似,不同之处在于将其中的左右箭头提示更换为数字“1”和“2”,“1”表示眨眼一次,“2”表示眨眼两次。眼电实验共分为3组,每组进行20次实验,共采集60个数据,单双次眨眼各30个。

在本研究中,采用Brain Products公司的actiCHamp脑电放大器和32导脑电帽,根据国际标准的10~20导联系统,采集了大脑皮层Fz、FC5、FC1、C3、CP5、CP1、Pz、CP6、CP2、C4、Cz、FC6、FC2共13个通道数据用于运动想象分析,同时也采集水平眼电HEOG和垂直眼电VEOG数据用于眼电分析,如图3所示。所有采集的数据都以TP9为参考电极,前额处接地,所有电极的阻抗均保持在10 kΩ以下,采样频率设置为1000 Hz。

有9名健康志愿者参与了本次实验,均为男性,右利手,年龄在20~30岁,在此之前均没有类似实验经历。本实验经通过校伦理委员会审核,在进行实验前对被试进行了实验过程讲解,告诉被试本次实验采集的是大脑头皮电,对人体无害,并在征得被试同意后,签署了《实验同意书》。

2. 脑电及眼电信号处理

2.1 脑电信号处理

研究表明,在进行运动想象时,大脑在运动感觉区域会产生明显的事件相关同步电位(event-related synchronization, ERS)和事件相关去同步电位(event-related desynchronization, ERD)现象[11]。ERD是当人们做单侧肢体运动时,大脑对侧感觉运动皮层的μ节律(8~12 Hz)和β节律(14~30 Hz)的幅度会明显减小。ERS是指在运动结束后感觉运动皮层的μ节律和β节律的幅度会明显增加。在运动想象中只进行肢体的想象运动,而不进行实际的运动,同样会产生事件相关同步和事件相关去同步现象[12]。比如,想象左手运动时,对侧的脑区的运动感觉皮层会产生ERD现象,相应的同侧的运动感觉皮层会产生ERS现象。运动想象的ERD/ERS现象是判断左右手运动想象的重要依据。

2.1.1 预处理和特征提取

本文预处理过程包括降采样、滤波、标准化、数据切片。首先对原始数据降采样到250 Hz;然后经过多次实验,发现使用4阶巴特沃斯滤波器得到的7~32 Hz频段脑电数据效果最佳;再对数据进行0-1标准化处理;最后进行数据切片。因被试通过视觉刺激接受并处理信息需要一定的时间,故本文选取实验流程(图2)中的4~6 s数据进行运动想象分析。

特征提取采用小波变换(wavelet transform, WT)和共空间模式结合的方法。CSP能够得到针对明确被试的可辨的空间滤波,但是由于想象时时域信息之间的差异很小,很难通过时域数据找到全局最优投影矩阵,根据ERD/ERS,μ节律和β节律的频率值差异更明显,因此基于频率值的最优投影矩阵更容易训练[13]。小波变换是一种时频分析方法,小波系数更具有时频信息,本文在使用CSP提取特征前,先提取小波分解后的小波系数,再用小波系数作为CSP的输入。

小波变换是常见的脑电信号处理方法,对于脑电信号这种非平稳性信号来说,是一种理想的时频分析工具。但是传统的小波变换在小波构造和时频转化上占用大量系统资源,且时耗大。因此本文使用继承第一代小波多分辨率特性的二代小波变换,提升小波变换。LWT相比于传统小波变换不依赖于傅里叶变换,且不需要占用大量系统资源,运算速度快,对于反变换也很容易从正变换得到[14]。

2.1.2 共空间模式

共同空间模式算法的基本原理是利用矩阵的对角化,找到一组最优空间滤波器进行投影,使得两类信号的方差值差异最大化,从而得到具有较高区分度的特征向量[15-16]。

脑电实验数据是一个

$ N \times T $ 的矩阵${\boldsymbol{X}}$ ,其中N为通道数,T为单个通道的采样点数。则归一化的协方差矩阵可表示为$$ {{\boldsymbol{R}}_i} = \frac{{{{\boldsymbol{X}}_i}{{\boldsymbol{X}}_i}^{\text{T}}}}{{{\text{trace}}({{\boldsymbol{X}}_i}{{\boldsymbol{X}}_i}^{\text{T}})}}\begin{array}{*{20}{c}} {}&{} \end{array}(i = 1,2) $$ 式中:

$ {{\boldsymbol{R}}_1} $ 、$ {{\boldsymbol{R}}_2} $ 分别表示左右手的归一化协方差矩阵;$ {{\boldsymbol{X}}_i} $ 表示标签为i的脑电数据。混合空间协方差矩阵可表示为$$ {{\boldsymbol{R}}_C} = {\overline {\boldsymbol{R}} _1} + {\overline {\boldsymbol{R}} _2} $$ 式中:

$ {\overline {\boldsymbol{R}} _1} $ 、$ {\overline {\boldsymbol{R}} _2} $ 分别表示左右手的平均协方差矩阵。$ {{\boldsymbol{R}}_C} $ 经特征值分解可得$ {{\boldsymbol{R}}_C} = {{\boldsymbol{U}}_C}{{\boldsymbol{\lambda }}_C}{\boldsymbol{U}}_C^{\text{T}} $ ,将特征值按降序排序,特征向量也相对应地进行排列。白化变换为$$ {\boldsymbol{P}} = \sqrt {{\boldsymbol{\lambda }}_C^{ - 1}} {\boldsymbol{U}}_C^{\text{T}} $$ 经过白化后

$ {{\boldsymbol{R}}_1} $ 、$ {{\boldsymbol{R}}_2} $ 再进行如下变换可得$$ {{\boldsymbol{S}}_1} = {\boldsymbol{P}}{{\boldsymbol{R}}_1}{{\boldsymbol{P}}^{\text{T}}},{{\boldsymbol{S}}_2} = {\boldsymbol{P}}{{\boldsymbol{R}}_2}{{\boldsymbol{P}}^{\text{T}}} $$ 式中:

$ {{\boldsymbol{S}}_1} $ 和$ {{\boldsymbol{S}}_2} $ 有共同的特征向量${\boldsymbol{B}}$ ,对其做主分量分解,则有$ {{\boldsymbol{S}}_1} = {\boldsymbol{B}}{{\boldsymbol{\lambda }}_1}{{\boldsymbol{B}}^{\text{T}}} $ ,$ {{\boldsymbol{S}}_2} = {\boldsymbol{B}}{{\boldsymbol{\lambda }}_2}{{\boldsymbol{B}}^{\text{T}}} $ ,且$ {{\boldsymbol{\lambda }}_1} + {{\boldsymbol{\lambda }}_2} = {\boldsymbol{I}} $ 。因为左右手两类矩阵的特征值相加总是为1,则$ {{\boldsymbol{S}}_1} $ 最大特征值所对应的特征向量使$ {{\boldsymbol{S}}_2} $ 有最小特征值,反之亦然。选取特征向量${\boldsymbol{B}}$ 的前$ m(m < N/2) $ 列和后m列后获得投影矩阵可表示为$$ {\boldsymbol{W}} = {{\boldsymbol{B}}^{\text{T}}}{\boldsymbol{P}} $$ (1) 2.1.3 LWT-CSP

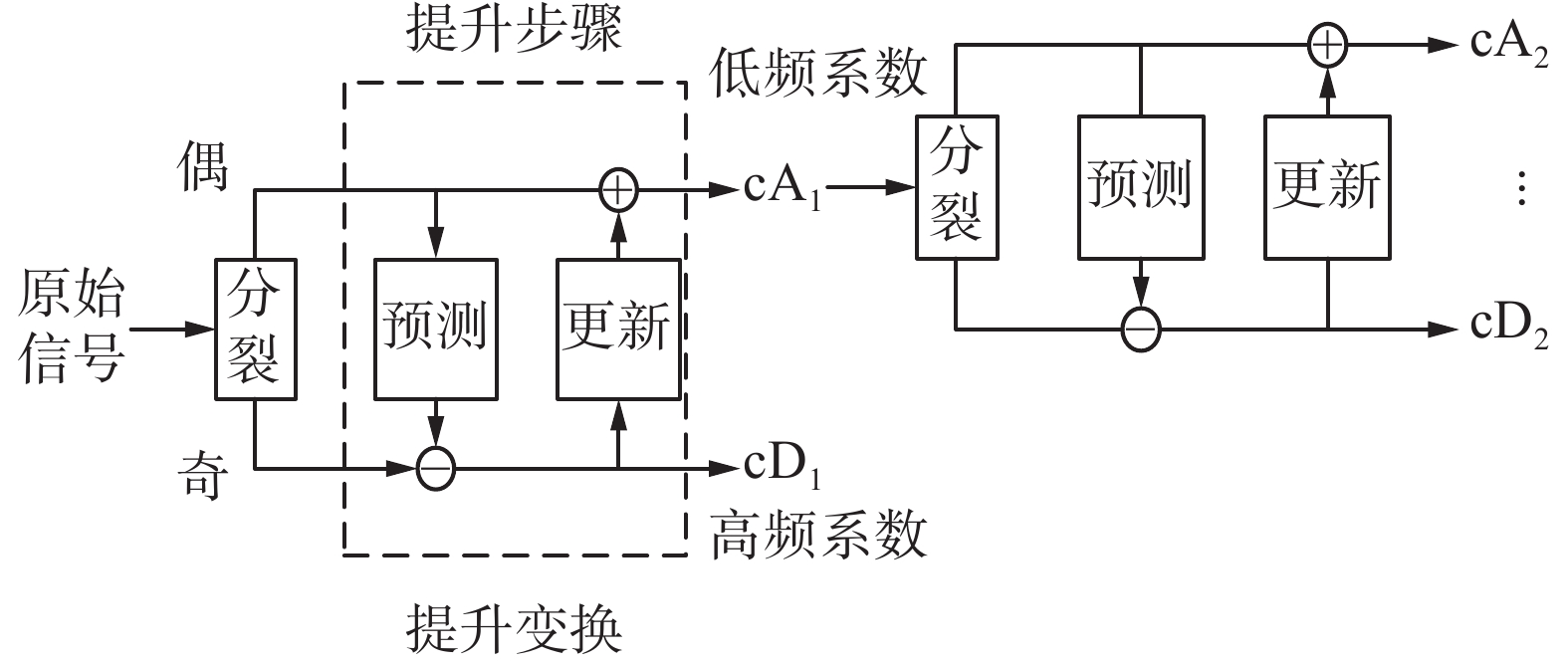

提升小波变换分为3个过程:分裂、预测、更新[17]。分解过程如图4所示。

1)分裂。将原始信号分裂为偶数序列和数序列。

$$ S_i^0{\text{ }} = {\text{ }}{X_{2i}} $$ $$ D_i^0{\text{ }} = {\text{ }}{X_{2i + 1}} $$ 2)预测。用偶数序列来预测其周围的奇数序列,奇数序列的实际值与通过偶数序列预测出来的预测值的差值对应于原始信号的高频系数。

$$ D_i^1{\text{ }} = {\text{ }}D_i^0 - {\text{ }}(S_i^0{\text{ }} + S_{i + 1}^0{\text{ }})/2{\text{ }} $$ 3)更新。通过奇数序列的预测值来更新偶数序列,得到原始信号的低频部分。

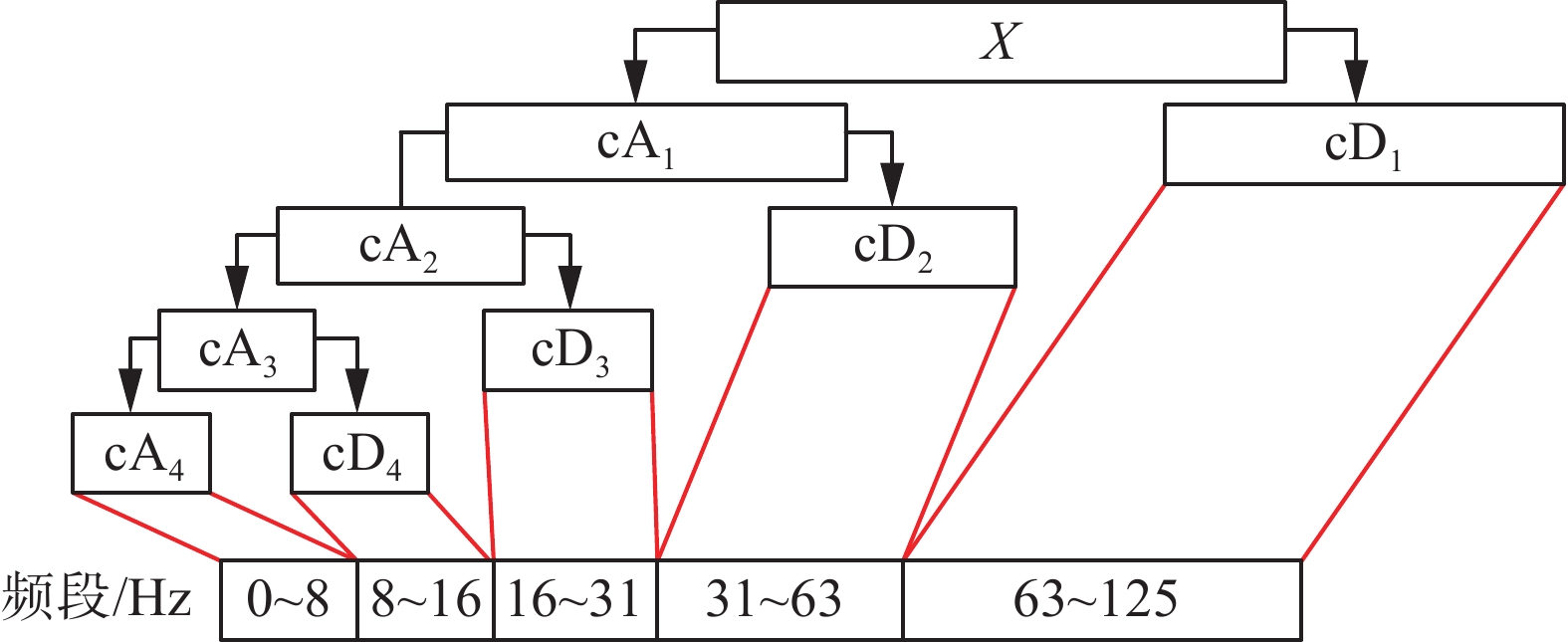

$$ S_i^1 = S_i^0 + (D_{i + 1}^1 + D_i^1{\text{ }})/4{\text{ }} $$ 通过以上3个步骤可以将原始信号的高低频分离开来。本文预处理后数据的采样频率为250 Hz,根据奈奎斯特采样定理信号的有效频率为125 Hz,因此采用了4层小波分解,如图5所示,将原始信号分为了5个频段,分别为0~8 Hz,8~16 Hz,16~31 Hz,31~63 Hz,63~125 Hz。预处理时cD1、cD2和cA4频段已被滤除,故不做考虑。上文提及运动想象ERD/ERS现象在μ节律和β节律的表现最为明显,在4层小波分解后的细节系数cD4和cD3刚好对应μ节律和β节律。因此提取了细节系数cD4和cD3构建矩阵

${\boldsymbol{E}}$ 作为CSP的输入,由式(1)求出空间滤波矩阵${\boldsymbol{W}}$ ,小波系数矩阵${\boldsymbol{E}}$ 可变换为$ {{\boldsymbol{Z}}_i} = {\boldsymbol{WE}} $ ,空间域特征向量由式(2)求出:$$ {{\boldsymbol{f}}_i} = \log \left( {\dfrac{{{{\rm{var}}} ({{\boldsymbol{Z}}_i})}}{{\displaystyle\sum\limits_{i = 1}^{2m} {{{\rm{var}}} ({{\boldsymbol{Z}}_i})} }}} \right) $$ (2) 2.1.4 分类方法

对于二分类问题来说支持向量机是非常优秀的分类器,通过非线性映射找到一个超平面来分割两类数据,使得能够最小化分类错误的同时最大化分类边界[18]。支持向量机对异常数据具有鲁棒性以及很好的泛化能力。

对于非线性问题来说,可将其从原始空间映射到更高维的空间,使得样本在这个空间中线性可分。脑电信号是非线性信号,本文使用核SVM来进行分类[19]。

设分类超平面方程为

$ x \cdot \omega + b = 0 $ ,则在m维空间中,使得对线性可分的样本集$({x_i},{y_i}),i = 1,2, \cdots ,n, x \in {R^m},y \in \{ + 1, - 1\}$ ,满足:$$ \mathop {\min }\limits_{\omega ,b} \frac{1}{2}{\left\| \omega \right\|^2} $$ $$ {\text{s}}{\text{.t}}{\text{.}} {y_i}({\omega ^t} \cdot {x_i} + b) - 1 \geqslant 0,\;\;i = 1, 2,\cdots ,n $$ 使用核函数得到对偶问题:

$$ \mathop {\max }\limits_\alpha \sum\limits_{i = 1}^n {{\alpha _i}} - \frac{1}{2}\sum\limits_{i = 1}^n {\sum\limits_{j = 1}^n {{\alpha _i}{\alpha _j}{y_i}{y_j}\kappa ({x_i},{x_j})} } $$ $$ {\text{s}}{\text{.t}}{\text{.}} \sum\limits_{i = 1}^n {{\alpha _i}{y_i} = 0,{\alpha _i} \geqslant 0,\;\;i = 1,2, \cdots ,n} $$ 式中

$ \kappa ({x_i},{x_j}) $ 是核函数。2.2 眼电信号处理

眼电信号具有易采集、波峰大易识别、单次眨眼和多次眨眼易区分等特点。因此,本文将眼电信号与脑电信号结合实现对机械臂的控制。为了实现在线控制时任务状态的检测,本文设计了双次眨眼当作发送控制指令的开关。当被试想要控制机械臂运动时,通过双次眨眼发送控制指令给Arduino单片机,此时蜂鸣器响起,被试根据实际情况做相应的任务,并通过上位机转化为机械臂控制指令,通过蓝牙传输给单片机,实现机械臂控制。

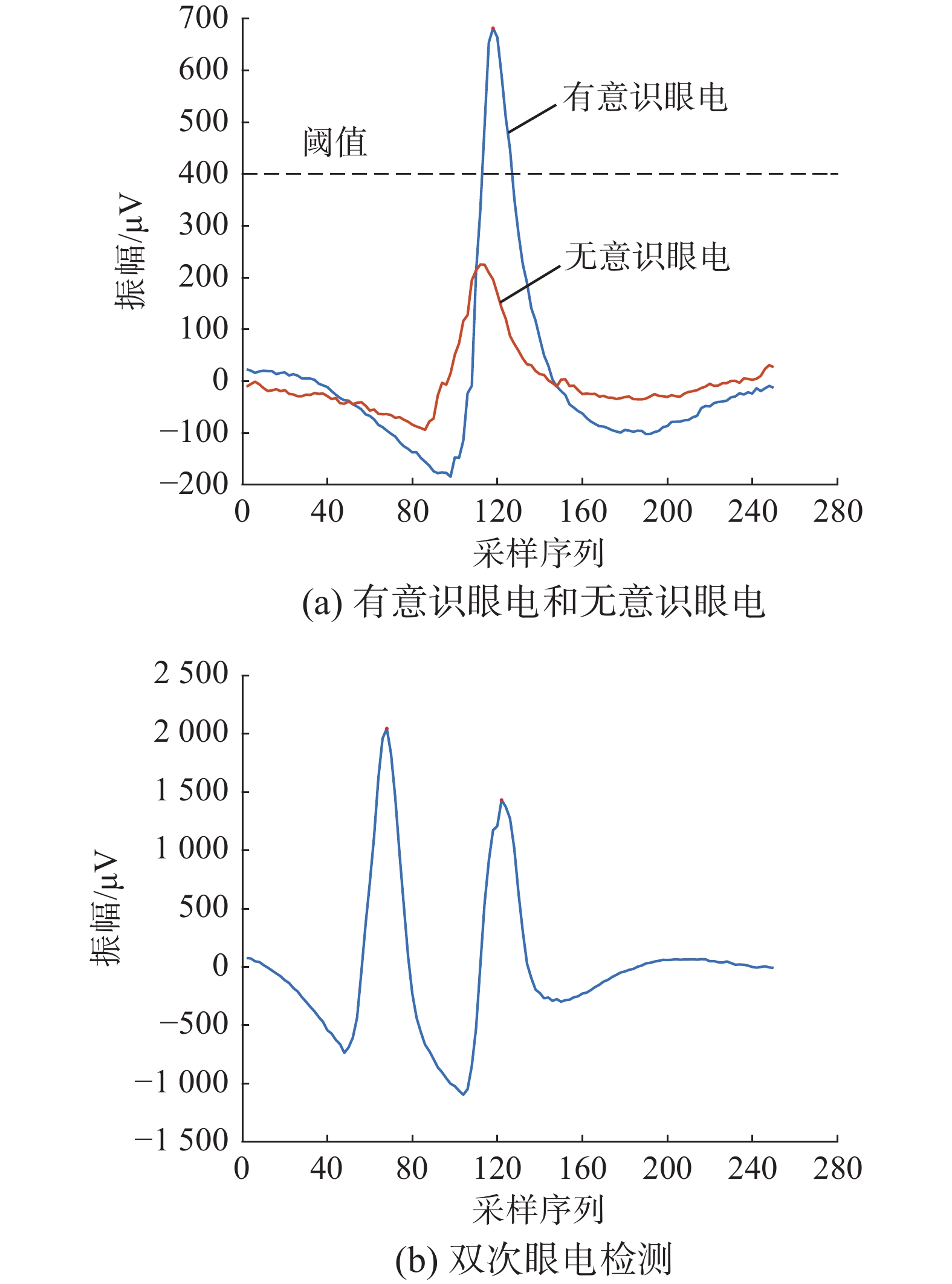

本文采集了水平眼电和垂直眼电数据,采集位置如图6所示。通过对比发现水平眼电的波峰更明显,故采用水平眼电来实现脑控机械臂系统。首先将采集的4 s眼电数据进行1~40 Hz的带通滤波,再对其进行降采样为62.5 Hz,通过检测波峰的个数来实现对眨眼次数的检测。如图7(a)所示,为被试1的一次眼电实验中有意识眨眼和无意识眨眼产生的眼电,可以看到有意识的眨眼比无意识的眨眼峰值更高,因此可以通过设定阈值的方式过滤无意识眼电,图7(b)为该被试一次双次眨眼产生的眼电,可以看到通过前面得到的眼电阈值可以检测出双次眼电。

3. 在线实验及结果分析

3.1 在线实验

在线实验分为两个部分:在线测试实验和自主服药实验。在线测试实验是将离线实验的脑电任务和眼电任务结合在一起。根据运动想象的离线模型和眼电阈值,可以得到在线准确率。在持续5 min的实验中,采集左右手数据各10个,单次眼电和双次眼电各5个,共进行4次。

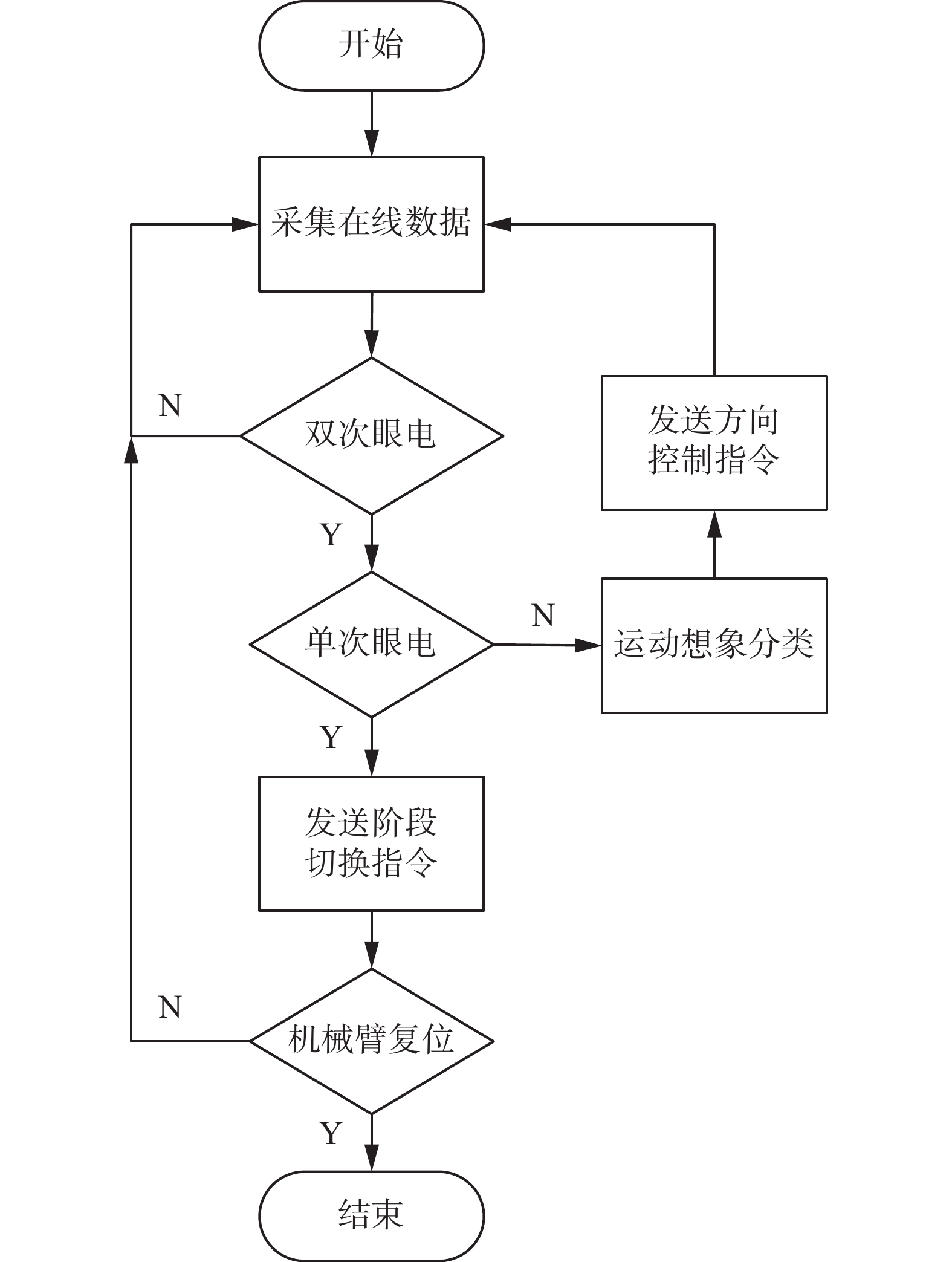

在自主服药实验时,BCI系统不再产生任务提示,任务的执行种类是由被试根据实际情况主动决定并发起的。为了使BCI系统能够进行连续工作,区分任务态和空闲态是很重要的[20],本研究使用双次眼电当作发送指令的开关,从而达到区分的效果。当被试欲控制机械臂时,眨两次眼后,蜂鸣器响起,被试执行控制任务,上位机分析脑电或眼电信号后发送控制指令给下位机,下位机控制机械臂做相应的运动。控制流程如图8所示。单纯的左右手运动想象只能产生两个控制指令,本文使用单次眼电来辅助完成自主服药工作。

本文将整个服药过程分为3个阶段。第一阶段,抓取阶段,如图9(a)~(c)所示,此阶段通过运动想象控制机械臂左右转,即想象左手运动机械臂左转,想象右手运动机械臂右转。根据实验场景,本文设置该阶段左转距离是右转的一半,可以通过左转来调节机械臂的位置,以便更精确定位物体。如图9(c)所示,当定位物体后,利用单次眼电发送抓取指令,机械臂夹爪移动到药瓶位置抓取药瓶。再次利用单次眼电发送切换状态指令,进入第二个阶段,服药阶段,此时机械臂转动到被试面前,如图9(d)、(e)所示,在此阶段想象左手控制机械臂夹爪向被试方向翻转,想象右手恰好相反,在被试服完药后,通过单次眼电进入下一个阶段,药瓶回收阶段。在此阶段,夹带着空药瓶的机械臂会转动到指定的废弃药品回收处,如图9(f)所示,在执行未出错的情况下,夹持药瓶的机械夹爪停留在图中垃圾桶上方,再次发送单次眼电指令,机械爪松开药瓶,将其放入垃圾桶中,并复位到初始状态。

3.2 实验结果分析

3.2.1 离线实验结果分析

离线运动想象数据采用分类准确率和Kappa值作为评判标准[21]。分类准确率是采用5折交叉验证来计算的。Kappa值是用于预测结果和实际结果一致性的评判。Kappa值介于0~1,0表示分类结果是随机造成的,1表示预测结果和实际结果完全一致。Kappa计算公式为

$$ k = \frac{{{p_o} - {p_e}}}{{1 - {p_e}}} $$ 式中:

$ {p_o} $ 为分类正确率;$ {p_e} $ 表示为$$ {p_e} = \frac{{{a_1} \times {b_1} + {a_2} \times {b_2} + \cdots+{a_i} \times {b_i}}}{{n \times n}} $$ 式中

$ {a_i} $ 和$ {b_i} $ 分别代表第i类真实样本和预测样本个数。Kappa值可分为5个等级:0.0~0.20代表极低的一致性;0.21~0.40代表一般的一致性;0.41~0.60代表中等的一致性;0.61~0.80代表高度的一致性;0.81~1代表几乎完全一致[14]。

针对在线控制系统,不光要考虑准确率,还要考虑到实时性,因此多数机械臂控制系统采用传统的特征提取方法提取脑电信号特征。例如:文献[1, 8]使用了传统的CSP提取特征;文献[10, 22]使用自回归模型(autoregressive model, AR)提取特征。表1为本文自采数据在7种特征提取方法下使用SVM分类的分类准确率,表2为对应的Kappa值。可以看到,在使用LWT-CSP提取的特征下9名被试运动想象的平均准确率为76.5%,高于其他的6种方法,平均Kappa值为0.53,达到了中等一致性。其中有3名被试的准确率超过了80%,被试5甚至达到了91%的分类准确率,Kappa值为0.82,达到了几乎完全一致。从表1、2还可以看到,改进的CSP算法比传统的CSP算法取得了更好的平均分类准确率,本文所使用的LWT-CSP方法与在运动想象表现较好的滤波器组共空间模式(filter bank common sptial pattern, FBCSP)方法[23]对比,取得了更佳的效果;第二代小波提升小波LWT比第一代小波离散小波变换(discrete wavelet transform, DWT)[24]取得了更好的平均分类准确率和Kappa值,同样本文所使用的LWT-CSP也比使用DWT-CSP的方法取得了更佳的效果。

表 1 运动想象分类准确率Table 1 Classification accuracy of motor imagery% 被试 LWT-CSP CSP AR LWT DWT DWT-CSP FBCSP 被试1 69.4 65.6 62.5 65.63 68.8 66.9 68.1 被试2 70.5 68.5 71.5 70.0 67.5 68.5 69.0 被试3 72.0 65.5 66.5 67.5 65.0 70.5 74.0 被试4 76.0 73.5 68.0 72.5 72.5 76.5 74.5 被试5 91.0 90.0 85.0 77.5 75.0 89.0 88.5 被试6 82.0 78.5 72.5 75.0 77.5 78.5 80.5 被试7 70.0 67.0 65.0 65.0 62.5 70.0 69.0 被试8 84.5 82.5 77.5 72.5 72.5 83.0 85.5 被试9 73.0 70.0 69.0 67.5 65.0 70.5 72.0 平均准确率 76.5 73.5 70.8 70.3 69.6 74.8 75.7 表 2 Kappa值Table 2 Kappa value被试 LWT-CSP CSP AR LWT DWT DWT-CSP FBCSP 被试1 0.39 0.30 0.26 0.33 0.39 0.34 0.36 被试2 0.40 0.36 0.42 0.40 0.38 0.37 0.38 被试3 0.44 0.31 0.33 0.37 0.30 0.41 0.47 被试4 0.51 0.47 0.35 0.45 0.46 0.53 0.49 被试5 0.82 0.80 0.69 0.54 0.50 0.78 0.77 被试6 0.64 0.57 0.45 0.50 0.55 0.57 0.59 续表 2 被试 LWT-CSP CSP AR LWT DWT DWT-CSP FBCSP 被试7 0.40 0.34 0.29 0.33 0.30 0.40 0.38 被试8 0.69 0.65 0.54 0.45 0.45 0.66 0.71 被试9 0.45 0.40 0.37 0.35 0.30 0.41 0.43 平均值 0.53 0.47 0.41 0.41 0.40 0.50 0.51 对采集的原始眼电数据提取任务范围内的单次眼电和双次眼电以及任务范围外被试的无意识眼电。通过比较单次眼电跟无意识眼电峰值可以找出一个阈值,在过滤掉无意识眼电的同时检测出有意识的眼电。通过对离线眼电数据的分析发现在降采样到62.5Hz后两次眼电的峰值间的间隔数不会小于10,因此设定峰值间的最小间隔为10。分析9个被试的眼电发现无意眼电的峰值都小于400,而有意识眼电峰值远大于400,因此设峰值阈值为400。

3.2.2 在线实验结果分析

对于实时BCI系统来说,在线数据不能像离线数据一样从分类正确率和Kappa值来进行评价,结合本研究的具体情况,选用分类正确率和有效识别率(identification rate, IR)作为在线数据的评价指标,IR定义为某种思维状态被正确识别的数目与该状态的总数的比值[25]。

$$ {\text{IR}}_{{\rm{left}}}=\dfrac{m_{{\rm{left}}}}{N_{{\rm{left}}}} $$ $$ {\text{IR}}_{{\rm{right}}}=\dfrac{m_{{\rm{right}}}}{N_{{\rm{right}}}} $$ 式中:

$m_{{\rm{left}}} $ 为左手运动想象被正确识别的数目;$N_{{\rm{left}}} $ 为左手运动想象总数;$m_{{\rm{right}}} $ 为右手运动想象被正确识别的数目;$N_{{\rm{right}}} $ 为右手运动想象总数。在线测试结果如表3所示,除被试5和8之外,其他被试的分类准确率都比离线时低,而被试5和8正好是离线准确率最高的两名被试。被试8的左右手有效识别率相同,而被试5的左右手有效识别率差距超过10%,表明了被试5在想象时对于左手的精准度是相对高的,而对于右手的想象控制是低于左手的,被试8对左右手的把控是均衡的。

表 3 运动想象在线准确率Table 3 Online classification accuracy of motor imagery% 被试 IRleft IRright 平均 被试1 65.0 60.0 62.5 被试2 65.0 60.0 62.5 被试3 65.0 65.0 65.0 被试4 10.0 90.0 50.0 被试5 100.0 87.5 93.8 被试6 77.5 72.5 75.0 被试7 62.5 60.0 61.2 被试8 95.0 95.0 95.0 被试9 100.0 10.0 55.0 从表3中可以看出,除被试4和被试9以外其他被试的IRleft和IRright差距不大,而被试4和9的IRleft和IRright差距过大。分析实验过程,可能产生较大差异的原因有:首先是被试自身,因为离线数据采集和在线测试不在同一时间段,被试可能会存在不同时间脑电信号差距很大的情况;其次通过对被试实验后的情绪分析,发现两名被试都有出现睡眠不足的情况;最后在实验流程方面,因为两次实验配戴的脑电帽大小不一置导致电极位置会有细微区别。

眼电的在线准确率如表4所示,只有被试6和被试9的眼电准确率比较差,其余被试的眼电准确率都在90%以上,被试3甚至可以达到100%。在线实验过程中发现,眼电识别准确率可以通过短暂的训练得到大幅度提高,在实验开始初期由于被试不适应或是不熟悉眨眼的力度和频率,导致前期的眼电准确率较低,在经过两组实验后,被试掌握了眨眼力度和频率,眼电准确率明显提升,甚至接近于100%。

表 4 眼电在线准确率Table 4 Online accuracy of the electrooculogram% 被试 单次眼电 双次眼电 平均 被试1 90 90 90 被试2 95 100 97.5 被试3 100 100 100 被试4 100 90 95 被试5 95 100 97.5 被试6 80 90 85 被试7 100 90 95 被试8 90 100 95 被试9 80 80 80 结合运动想象脑电和眼电的在线测试结果,选取被试5和被试8进行自主服药实验。如表5所示,为被试5和被试8在线自主服药实验中发送的控制指令个数和错误识别个数,其中也包括双次眼电开关指令。被试5错误识别的3个指令分别为2个单次眼电指令和1个想象右手指令,被试8是单次眼电指令和想象左手指令。本实验设置在单次眼电识别错误时不发送控制指令给机械臂,因此机械臂不会有任何动作,被试只需要重复发送识别错误的指令即可。被试5在抓取阶段识别想象右手为左手控制指令,因抓取阶段机械臂左转是右转的一半,因此被试5通过发送一次左手指令和一次右手指令回到出错之前的状态。被试8在服药阶段想象左手出错,被识别为想象右手,导致机械臂夹爪向远离被试方向翻转,只需要发送一次左手指令就能回到出错前的状态。被试5和8都在发现指令错误的情况下调整自身状态,成功地在第2次发送正确的指令,并最终完成自主服药实验。

表 5 指令发送个数和错误识别个数Table 5 Number of instruction sendings and error recognitions被试 指令发送个数 错误识别个数 被试5 28 3 被试8 24 2 4. 结束语

本文实现了由脑电和眼电信号控制机械臂运动的脑机接口系统。该系统融合脑电和眼电并通过划分阶段的方式实现对机械臂的连续控制,即被试通过双次眼电控制任务的开始,根据实际情况执行特定任务。在执行任务过程中检测到运动想象脑电信号时,检测程序发送方向控制指令,使机械臂执行该阶段对应的动作;当检测到单次眼电时,检测程序发送切换指令进入下一阶段。为了验证本系统的实用性,本文设计了一项自主服药实验,通过在线测试实验,验证了本文算法对脑电信号识别准确率最高可达90%,被试能顺利通过本系统在不使用任何肢体的情况下实现自主服药,证明了本系统的有效性。在后续的工作中,可对本系统进行改进,使其能够应用在更多的场景中。

-

表 1 运动想象分类准确率

Table 1 Classification accuracy of motor imagery

% 被试 LWT-CSP CSP AR LWT DWT DWT-CSP FBCSP 被试1 69.4 65.6 62.5 65.63 68.8 66.9 68.1 被试2 70.5 68.5 71.5 70.0 67.5 68.5 69.0 被试3 72.0 65.5 66.5 67.5 65.0 70.5 74.0 被试4 76.0 73.5 68.0 72.5 72.5 76.5 74.5 被试5 91.0 90.0 85.0 77.5 75.0 89.0 88.5 被试6 82.0 78.5 72.5 75.0 77.5 78.5 80.5 被试7 70.0 67.0 65.0 65.0 62.5 70.0 69.0 被试8 84.5 82.5 77.5 72.5 72.5 83.0 85.5 被试9 73.0 70.0 69.0 67.5 65.0 70.5 72.0 平均准确率 76.5 73.5 70.8 70.3 69.6 74.8 75.7 表 2 Kappa值

Table 2 Kappa value

被试 LWT-CSP CSP AR LWT DWT DWT-CSP FBCSP 被试1 0.39 0.30 0.26 0.33 0.39 0.34 0.36 被试2 0.40 0.36 0.42 0.40 0.38 0.37 0.38 被试3 0.44 0.31 0.33 0.37 0.30 0.41 0.47 被试4 0.51 0.47 0.35 0.45 0.46 0.53 0.49 被试5 0.82 0.80 0.69 0.54 0.50 0.78 0.77 被试6 0.64 0.57 0.45 0.50 0.55 0.57 0.59 续表 2 被试 LWT-CSP CSP AR LWT DWT DWT-CSP FBCSP 被试7 0.40 0.34 0.29 0.33 0.30 0.40 0.38 被试8 0.69 0.65 0.54 0.45 0.45 0.66 0.71 被试9 0.45 0.40 0.37 0.35 0.30 0.41 0.43 平均值 0.53 0.47 0.41 0.41 0.40 0.50 0.51 表 3 运动想象在线准确率

Table 3 Online classification accuracy of motor imagery

% 被试 IRleft IRright 平均 被试1 65.0 60.0 62.5 被试2 65.0 60.0 62.5 被试3 65.0 65.0 65.0 被试4 10.0 90.0 50.0 被试5 100.0 87.5 93.8 被试6 77.5 72.5 75.0 被试7 62.5 60.0 61.2 被试8 95.0 95.0 95.0 被试9 100.0 10.0 55.0 表 4 眼电在线准确率

Table 4 Online accuracy of the electrooculogram

% 被试 单次眼电 双次眼电 平均 被试1 90 90 90 被试2 95 100 97.5 被试3 100 100 100 被试4 100 90 95 被试5 95 100 97.5 被试6 80 90 85 被试7 100 90 95 被试8 90 100 95 被试9 80 80 80 表 5 指令发送个数和错误识别个数

Table 5 Number of instruction sendings and error recognitions

被试 指令发送个数 错误识别个数 被试5 28 3 被试8 24 2 -

[1] 尹锐, 曹勇, 姜劲, 等. 基于运动想象脑机接口的外骨骼控制系统研究[J]. 航天医学与医学工程, 2020, 33(3): 208–213. doi: 10.16289/j.cnki.1002-0837.2020.03.004 YIN Rui, CAO Yong, JIANG Jin, et al. Design and implementation of exoskeleton control system based on motor imagery brain computer interface[J]. Space medicine & medical engineering, 2020, 33(3): 208–213. doi: 10.16289/j.cnki.1002-0837.2020.03.004 [2] 王斐, 张育中, 宁廷会, 等. 脑–机接口研究进展[J]. 智能系统学报, 2011, 6(3): 189–199. doi: 10.3969/j.issn.1673-4785.2011.03.001 WANG Fei, ZHANG Yuzhong, NING Tinghui, et al. Research progress in a brain-computer interface[J]. CAAI transactions on intelligent systems, 2011, 6(3): 189–199. doi: 10.3969/j.issn.1673-4785.2011.03.001 [3] ZHANG Wenchang, SUN Fuchun, WU Hang, et al. Asynchronous brain-computer interface shared control of robotic grasping[J]. Tsinghua science and technology, 2019, 24(3): 360–370. doi: 10.26599/TST.2018.9010111 [4] ZHU Yuanlu, LI Ying, LU Jinling, et al. A hybrid BCI based on SSVEP and EOG for robotic arm control[J]. Frontiers in neurorobotics, 2020, 14: 583641. doi: 10.3389/fnbot.2020.583641 [5] 徐宝国, 何小杭, 魏智唯, 等. 基于运动想象脑电的机器人连续控制系统研究[J]. 仪器仪表学报, 2018, 39(9): 10–19. doi: 10.19650/j.cnki.cjsi.J1803518 XU Baoguo, HE Xiaohang, WEI Zhiwei, et al. Research on continuous control system for robot based on motor imagery EEG[J]. Chinese journal of scientific instrument, 2018, 39(9): 10–19. doi: 10.19650/j.cnki.cjsi.J1803518 [6] JEONG J H, SHIM K H, KIM D J, et al. Brain-controlled robotic arm system based on multi-directional CNN-BiLSTM network using EEG signals[J]. IEEE transactions on neural systems and rehabilitation engineering, 2020, 28(5): 1226–1238. doi: 10.1109/TNSRE.2020.2981659 [7] LI Ting, HONG Jun, ZHANG Jinhua, et al. Brain-machine interface control of a manipulator using small-world neural network and shared control strategy[J]. Journal of neuroscience methods, 2014, 224: 26–38. doi: 10.1016/j.jneumeth.2013.11.015 [8] RAKSHIT A, KONAR A, NAGAR A K. A hybrid brain-computer interface for closed-loop position control of a robot arm[J]. IEEE/CAA journal of automatica sinica, 2020, 7(5): 1344–1360. doi: 10.1109/JAS.2020.1003336 [9] GAO Qiang, DOU Lixiang, BELKACEM A N, et al. Noninvasive electroencephalogram based control of a robotic arm for writing task using hybrid BCI system[J]. BioMed research international, 2017, 2017: 8316485. [10] BHATTACHARYYA S, KONAR A, TIBAREWALA D N. Motor imagery, P300 and error-related EEG-based robot arm movement control for rehabilitation purpose[J]. Medical & biological engineering & computing, 2014, 52(12): 1007–1017. [11] 李丹妮. 基于运动想象脑电信号的特征提取和分类算法研究[D]. 重庆: 重庆邮电大学, 2019. LI Danni. Research on feature extraction and classification algorithm of EEG based on motor imagery[D]. Chongqing: Chongqing University of Posts and Telecommunications, 2019. [12] 张晓楠, 刘建平. Graz-脑机接口研究概述[J]. 智能系统学报, 2013, 8(5): 395–399. doi: 10.3969/j.issn.1673-4785.201304055 ZHANG Xiaonan, LIU Jianping. Summary on the research for Graz-brain-computer interface[J]. CAAI transactions on intelligent systems, 2013, 8(5): 395–399. doi: 10.3969/j.issn.1673-4785.201304055 [13] BAI Xiaoping, WANG Xiangzhou, ZHENG Shuhua, et al. The offline feature extraction of four-class motor imagery EEG based on ICA and Wavelet-CSP[C]//Proceedings of the 33rd Chinese Control Conference. Nanjing: IEEE, 2014: 7189−7194. [14] 邓欣, 龙灿, 米建勋, 等. 基于多域特征与随机子空间集成的脑电分类[J]. 系统仿真学报, 2020, 32(9): 1787–1798. doi: 10.16182/j.issn1004731x.joss.19-0038 DENG Xin, LONG Can, MI Jianxun, et al. EEG classification based on multi-domain features and random subspace ensemble[J]. Journal of system simulation, 2020, 32(9): 1787–1798. doi: 10.16182/j.issn1004731x.joss.19-0038 [15] 刘柯, 张孝, 李沛洋, 等. 基于脑功能网络和共空间模式分析的脑电情绪识别[J]. 计算机应用研究, 2021, 38(5): 1344–1349. doi: 10.19734/j.issn.1001-3695.2020.07.0181 LIU Ke, ZHANG Xiao, LI Peiyang, et al. EEG emotion recognition based on common spatial pattern of brain functional network[J]. Application research of computers, 2021, 38(5): 1344–1349. doi: 10.19734/j.issn.1001-3695.2020.07.0181 [16] YIN Xu, MENG Ming, SHE Qingshan, et al. Optimal channel-based sparse time-frequency blocks common spatial pattern feature extraction method for motor imagery classification[J]. Mathematical biosciences and engineering:MBE, 2021, 18(4): 4247–4263. doi: 10.3934/mbe.2021213 [17] SWELDENS W. The lifting scheme: a custom-design construction of biorthogonal wavelets[J]. Applied and computational harmonic analysis, 1996, 3(2): 186–200. doi: 10.1006/acha.1996.0015 [18] 罗志增, 鲁先举, 周莹. 基于脑功能网络和样本熵的脑电信号特征提取[J]. 电子与信息学报, 2021, 43(2): 412–418. doi: 10.11999/JEIT191015 LUO Zhizeng, LU Xianju, ZHOU Ying. EEG feature extraction based on brain function network and sample entropy[J]. Journal of electronics & information technology, 2021, 43(2): 412–418. doi: 10.11999/JEIT191015 [19] 杨建平, 刘明华, 吕敬祥, 等. 低觉醒脑电识别与唤醒的可穿戴系统研究[J]. 智能系统学报, 2019, 14(4): 787–792. doi: 10.11992/tis.201806047 YANG Jianping, LIU Minghua, LYU Jingxiang, et al. A wearable system to recognize and awaken low-arousal state[J]. CAAI transactions on intelligent systems, 2019, 14(4): 787–792. doi: 10.11992/tis.201806047 [20] 伍广腾. 基于运动想象的脑—机接口在线异步系统研究[D]. 哈尔滨: 哈尔滨工业大学, 2018. WU Guangteng. Research on online asynchronous brain-computer interface system based on motor imagery[D]. Harbin: Harbin Institute of Technology, 2018. [21] 孟建军, 盛鑫军, 姚林, 等. 基于共空域频谱模式的少通道运动想象分类[J]. 中国生物医学工程学报, 2013, 32(5): 553–561. doi: 10.3969/j.issn.0258-8021.2013.05.07 MENG Jianjun, SHENG Xinjun, YAO Lin, et al. Common spatial spectral pattern for motor imagery tasks in small channel configuration[J]. Chinese journal of biomedical engineering, 2013, 32(5): 553–561. doi: 10.3969/j.issn.0258-8021.2013.05.07 [22] BHATTACHARYYA S, KONAR A, TIBAREWALA D N. Motor imagery and error related potential induced position control of a robotic arm[J]. IEEE/CAA journal of automatica sinica, 2017, 4(4): 639–650. doi: 10.1109/JAS.2017.7510616 [23] DENG Xin, ZHANG Boxian, YU Nian, et al. Advanced TSGL-EEGNet for motor imagery EEG-based brain-computer interfaces[J]. IEEE access, 2021, 9: 25118–25130. [24] LI Ninghan, LIU Yongze. Multi-domain feature extraction method of motor imagery EEG signal based on DWT and CSP[C]//Thirteenth international conference on signal processing systems (ICSPS 2021).Shanghai: SPIE, 2022: 286−291. [25] 周鹏. 基于运动想象的脑机接口的研究[D]. 天津: 天津大学, 2007. ZHOU Peng. The research of brain-computer interface based on motor imagery[D]. Tianjin: Tianjin University, 2007.

下载:

下载: