A multi-fitting decoupling detection method for transmission lines based on external knowledge

-

摘要: 为了有效解决输电线路多金具检测过程中存在的目标密集和目标间相互遮挡的问题,提出了融合外部知识的多目标解耦检测方法(external knowledge decoupling R-CNN, EKD R-CNN)。首先通过深入分析金具数据集的领域规则和图像信息,提取出共现和空间知识;然后使用图神经网络方法建立共现和空间知识推理模型,将外部知识进行实例化表达;最后使用解耦模块将金具检测任务以非耦合的方式进行训练和学习。在实验阶段,对具有14类金具的数据集,进行多种定性和定量实验。对比实验表明,EKD R-CNN的检测效果优于其他先进目标检测模型,与原有基线模型相比,准确率提高6.6%;定性实验表明算法能够解决目标遮挡的问题,实现密集目标的检测;消融实验表明,每种模块对模型的检测效果均有一定的提升。Abstract: This paper proposes a multi-object decoupling detection method based on external knowledge (EKD R-CNN) to effectively solve the problems of object density and mutual occlusion in the process of multi-fitting detection of transmission lines. First, the domain rules and image information of the fittings datasets are deeply analyzed to extract the co-occurrence and spatial knowledge; then, graph neural network methods are used to build co-occurrence and spatial knowledge reasoning models, to instantiate and express external knowledge; finally, the decoupling module is employed to train and learn the fittings detection task in an uncoupled way. Multiple qualitative and quantitative experiments are conducted on datasets with 14 types of fittings in the experiment phase. The contrast experiment shows that the detection effect of EKD R-CNN is better than that of other advanced object detection models and that compared with the original baseline model, the detection accuracy of the algorithm is increased by 6.6%; the qualitative experiments suggest that the proposed algorithm can solve the problem of object occlusion, and the ablation experiment indicates that each module improves the detection effect of the model to a certain extent.

-

近年来,随着电力系统规模和城市建设的不断发展,输电线路逐渐覆盖了苛刻的环境和复杂地形的区域[1]。输电线路是电力系统的重要组成部分。金具是输电线路中广泛使用的铁制或铝制金属附件,种类繁多,功能多样,主要用于支持、固定、接续裸导线、导体及绝缘子等[2]。因此输电线路的安全保障的重要环节就是对输电线路金具的运维和保障。当前输电线路运维方式主要依靠无人机航拍获得金具图像,凭借着基于机器视觉的图像处理技术对航拍图像和视频自动化处理[3]。对于输电线路金具目标精确定位和识别是对金具运行状态研判的前提,因此综合检测多类金具算法的研究具有极高价值[4]。

输电线路部件的识别与检测任务引起了众多学者的关注。传统图像处理方法通过设计目标特征将图像识别任务进行多阶段处理。文献[5]利用对形状的特征描述,实现了对绝缘子轮廓的识别。文献[6-8]实现了基于形态学特征的输电线路部件的特征提取与识别。文献[9-10]通过特征提取、图像分割分别实现了对于绝缘子及防振锤的定位和识别。传统图像处理方法需要多阶段处理图像特征,操作步骤繁琐且冗余,而且传统算法一般只能针对单一目标和缺陷进行识别,难以投入实际应用。基于机器学习方法使用人工特征提取以及多种机器学习算法相结合的方法进行金具识别。文献[11]通过聚合复频域特征以及多尺度通道特征,实现防震锤的检测,该算法在一定程度上提高了在复杂背景下对防震锤检测的精度。文献[12]提出利用层次模型提取多目标之间的约束关系,并提出了多向判别路径的方法,实现了防震锤目标的状态研判。机器学习算法需要人工构建目标特征,并且容易受到各种复杂外部环境的影响,因此在检测性能上仍有很大的提升空间。与以上两种方法相比,深度学习方法通过端到端的方法自主学习图像特征,具有操作简单,特征提取能力强的优点。文献[13]基于Faster R-CNN模型对电力部件进行检测,通过调整卷积神经网络(convolutional neural networks, CNN)的卷积核大小以及图像增强方法,在一定程度上提高了模型的检测精度;文献[14]使用YOLOv3模型对目标进行分解和聚合实现了对航拍图像中绝缘子的识别和定位。上述工作主要是从航拍图像本身特征出发,针对目前的深度学习模型做适应性研究,然而仅研究图像特征并不能较好地解决金具检测本身存在的目标密集问题。

由于金具在输电线路结构中承担着连接、接续以及保护的功能,因此在输电线路中广泛存在着多种金具相互连接的现象,从而导致无人机航拍图像数据中金具目标密集以及金具间相互遮挡的问题,当前关于输电线路智能巡检的研究工作的检测目标大多为单类金具目标图像,不适用在多金具检测的场景中。

本文面向多金具目标检测需求,针对由于目标密集导致金具之间存在相互遮挡的问题,提出了融合外部知识的多金具解耦检测模型(external knowledge decouping R-CNN, EKD R-CNN),通过深入挖掘金具目标间共现与空间关系,使用图学习方法增强被遮挡金具的视觉特征,促进知识的实例化表达,并使用解耦模块将分类和回归任务分离训练,从而提高金具检测的性能。

1. 相关工作

1.1 融入知识的深度学习模型

在计算机视觉任务中,图像本身含有丰富的语义知识和常识知识,图像中的对象与对象之间往往会存在某种联系,近些年来,一些基于深度学习的方法已经尝试将这些关系信息利用到计算机视觉任务中,例如目标检测、视觉推理和场景图生成等任务。Hu等[15]提出目标关系网络,使用自注意力机制对目标之间关系进行建模,通过寻找目标细节特性的相似关系来增强视觉特征。Chen等[16]通过空间记忆网络 (spatial memory network, SMN)提取空间模式,实现了实例级上下文和目标关系的建模。Zeng等[17]提出了一种新颖的门控双向网络(gated bi-directional net, GBDNet),使用门控机制将信息在不同的区域之间进行传递,从而整合局部和全局上下文的视觉特征。翟永杰等[18]从金具之间的共现连接出发,统计对象与对象之间的共现频率作为显式外部知识,首次将共现知识引入到输电线路金具目标检测模型中。

1.2 图神经网络模型

对于引入外部知识的目标检测模型,如何将抽象知识实例化并融合进端到端网络中是该类模型的研究重点。Jiang等[19]提出了有监督的图学习网络模型,使用了一种知识路由的方式将外部知识融入到深度模型中。另外基于拓扑结构实现图结构数据学习与推理的图神经网络的提出为上述问题提供了解决办法。图神经网络(graph neural networks, GNNs)[20]是在递归神经网络的基础上首次提出的,用于处理以图结构数据的表示和学习。受CNN架构成功的启发,Defferrard[21]设计了图卷积架构,将卷积运算从传统数据(图像或网格)推广到图形数据。Bruna等[22]提出了第一个基于谱卷积的图神经网络模型,并在谱图理论的基础上发展了图的卷积运算。后来,Defferrard等[21]通过使用切比雪夫多项式定义滤波,扩展了谱CNN的快速局部化卷积。Kipf等[23]通过简化谱图卷积的一阶近似模型,正式提出了GCN的概念,从而得到了更有效的滤波操作。Veličković等[24]将注意力机制应用到图神经网络聚合邻居的操作中,提出了对节点特征敏感的图注意力机制(graph attention network, GAT)。图注意力机制能够关注节点之间的相似度,从而增加一种有效的边权重。

1.3 基于解耦原理的目标检测模型

目标检测是一种分类和回归的多任务学习问题,然而大多数目标检测模型都是共享头部检测网络同时进行分类和边界框回归的任务,往往存在两种任务相互影响的问题,Jiang等[25]首先提出了这个问题:生成较好分类分数的视觉特征无法同时生成精度较高的边界框,候选框的分类置信度与定位置信度存在偏差,因此文中提出了新的检测网络IoU-Net生成定位置信度来学习预测候选框,获取位置更精确的回归框,并将定位回归问题作为优化任务进行处理,从而实现了更精确的检测效果。Wu等[26]提出了Double-Head网络将分类和定位分成两个任务,采用了不同的分支检测网络进行训练,通过实验证明了FC-head对于空间具有敏感性,适合处理图像的识别和分类任务,而Conv-head更适合对目标框的定位和回归任务。Song等[27]针对分类和回归任务不对齐的问题,提出了任务感知空间解耦算子(task-aware spatial disentanglement, TSD)来处理任务冲突问题,并进一步提出了渐进约束方法来弥补TSD和经典检测器网络的差距,通过实验证明了两个任务分支都均能提高分类和定位的精度。

2. 输电线路金具特点

2.1 共现特点

在架空输电线路的设计和建造过程中,为了达到标准的电气要求和安装规范,输电线路金具往往具有一定的组合规则和结构。如图1所示,由提包式悬垂线夹、u型挂环、联板和均压环组成单联悬垂结构;由提包式悬垂线夹、联板和重锤组成防舞动结构;由提包式悬垂线夹、联板和均压环组成V型悬垂结构;由锲型耐张线夹、联板、调整板和屏蔽环组成均压屏蔽环结构。

由于金具之间存在的固定组合结构,因此根据金具与金具之间的共现知识辅助模型进行检测。具体来说,由于金具在识别的过程中,受到复杂背景的影响,一些金具由于尺寸较小经常会隐匿在自然环境或者其他部件中,受到复杂背景问题的影响较大,仅仅依靠图像的特征对金具进行识别是比较困难的。根据输电线路金具之间的组合规则,构建共现关系连接矩阵,形成共现知识,通过识别一些比较容易检测的大尺寸金具,再借助金具之间的共现知识,从而推理出隐匿在密集目标中的难以识别的金具。因此共现知识能够有效地提高金具检测任务中的识别分类问题。

2.2 空间结构特点

在金具航拍图像中,由于多类金具的尺寸较小,并且连接金具和接续金具需要连接各种电气元件,因此金具数据集中的目标分布密集,存在相互遮挡的问题。图1展示了金具结构具有一定的组合规则,属于同一种结构的金具能够给通过共现知识进行互相的推理和识别,但共现知识推理模型能够促进深度模型识别金具类别,并不能更好地辅助模型进行定位。金具与金具之间由于一些固定组合结构的原因会导致相互遮挡,而这种在空间位置上的遮挡关系可以作为一种上下文信息来辅助模型进行定位。比如在防舞动结构中,重锤作为增加绝缘子串垂直荷重或防止导线振动的防护金具,往往3个及以上的提包式悬垂线夹与导线连接,现有金具检测数据集中大部分的重锤目标的标注框中都包含了部分提包式悬垂线夹目标,并且提包式悬垂线夹的目标框往往会均匀分布在重锤目标的四周。因此金具与金具之间的空间关系信息能够辅助模型进行目标定位。

3. 研究方法

本文总体网络架构如图2所示,首先将金具航拍图像作为输入,通过卷积神经网络提取基础特征,通过区域建议网络模块(RPN)从基础特征中得到的区域建议框。然后从航拍图像数据集中提取出共现知识和空间知识,并分别引入到共现和空间知识推理模块中。之后,将这些外部知识通过映射的方式进行实例化作为图结构的边,将RPN模块得到的区域建议框作为节点,构成拓扑关系图,并使用对应的图学习方法进行知识推理。最后将知识推理模块生成的增强特征层输入到解耦模块中,解耦模块使用分类和回归框检测器分别进行金具识别和定位任务。

3.1 共现推理模块

3.1.1 共现知识提取

HKRM模型[19]基于常识知识提取了提取物体间的共现信息,但是该模型认为物体之间的共现信息是对等的,而这种对等共现信息并不能适用于样本分布不平衡的数据中。本文在构建金具目标的共现知识时充分考虑了物体本身的出现频率,以条件概率的方式有效表达金具目标之间的共现知识。

首先,本文统计了每种金具与其他金具在同一张图片中共同出现的频率,得到了共现频率矩阵

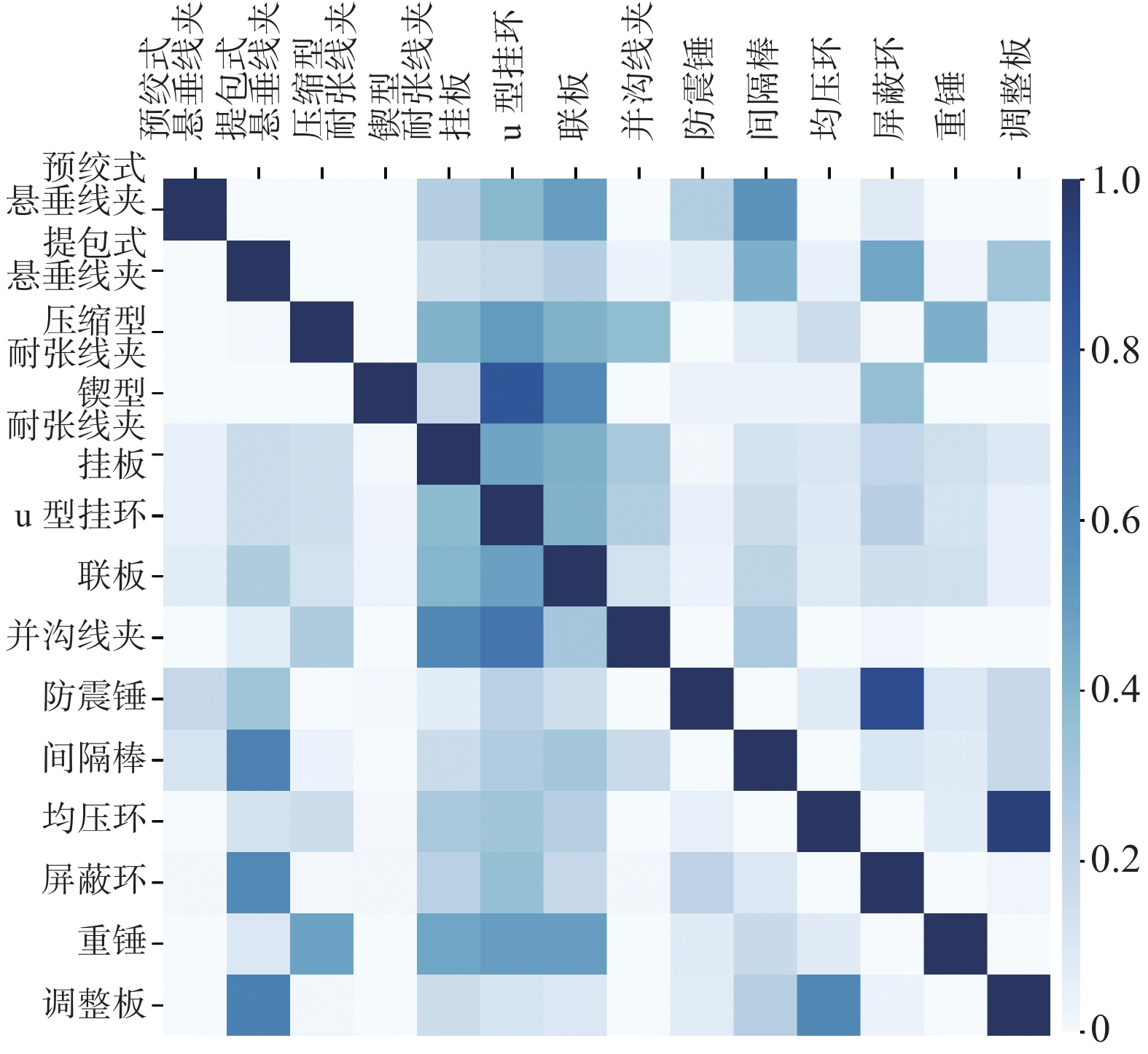

${\boldsymbol{N}} \in {{\bf{R}}^{C \times C}}$ ,其中$ C $ 为总类别个数,如图3所示。之后计算每两种目标之间的共现概率,使用条件概率来表示,即$ P(\left. {{f_A}} \right|{f_B}) $ ,计算公式如下:$$ P(\left. {{f_A}} \right|{f_B}){{ = }}\dfrac{{P({f_A},{f_B})}}{{P({f_B})}} = \dfrac{{{N_{({f_A},{f_B})}}/{N_{\rm all}}}}{{{N_{{f_B}}}/{N_{\rm all}}}} = \dfrac{{{N_{({f_A},{f_B})}}}}{{{N_{{f_B}}}}} $$ (1) 式中:

$ {N_{({f_A},{f_B})}} $ 为两金具同时出现的次数;$ {N_{{f_B}}} $ 为金具$ {f_B} $ 出现的次数;$ {N_{\rm all}} $ 为所有图片的个数。因此对共现频率矩阵进行归一化得到共现概率矩阵,共现概率矩阵的热点图如图3所示。3.1.2 共现推理模块

翟永杰等[18]提出了一种有监督的图学习方法进行共现知识的实例化表达和推理,然而这种方法把图学习任务当作回归问题进行处理,使用L1范式来计算节点之间的相似度,对目标与目标之间的共现关系进行有监督的训练,并没有真正学习到拓扑关系图的图结构特征。因此本文使用对节点特征更敏感的GAT来学习图结构的特征,使用图神经网络进行图推理的过程中,节点的信息能够通过边进行传递,从而对图中节点之间的依赖关系进行建模。

具体实现流程如图1中的共现知识推理模块,首先设

$ f = \{ {f_i}\} _{i = 1}^{{N_r}} $ ,${f_i} \in {{\bf{R}}^{{D_b}}}$ 为是从骨干网络中提取出的高维特征,其中$ {D_b} $ 为base feature的维度,通过线性变换操作$ z = \phi ({{f}}) $ 将视觉特征$ f $ 转化为区域关系图的节点特征$ z = \{ {z_i}\} _{i = 1}^{{N_r}} $ ,${z_i} \in {{\bf{R}}^{{D_z}}}$ ,$ {D_z} $ 为图节点特征的维度,引入这种图节点特征,能够使模块能够更深化表达视觉空间中的共现关系。为了深度学习模型能够充分表达金具共现知识,本文使用了对节点特征敏感的图注意力机制对共现关系图结构进行建模。图注意力机制的图卷积形式定义为

$$ {{\boldsymbol{X}}^{l + 1}} = \sigma \left( {\sum\limits_{{v_j} \in {N_{{v_i}}}} {{\alpha _{ij}}{{\boldsymbol{W}}^l}{{\boldsymbol{X}}^l}} } \right) $$ (2) 式中:图卷积网络的输入和输出分别是

${{\boldsymbol{X}}^l}$ 和${{\boldsymbol{X}}^{l + 1}}$ ,${{\boldsymbol{X}}^{l + 1}} \in {{\bf{R}}^{D_t^{(l + 1)}}}$ ,$ \sigma $ 为LeakyReLU激活函数,$ {\alpha _{ij}} $ 为注意力权重,${{\boldsymbol{W}}^l} \in {{\bf{R}}^{D_t^{(l + 1)} \times D_t^{(l)}}}$ 为第l层节点特征变换的权重参数。设中心节点为

$ {v_i} $ ,则邻居节点$ {v_j} $ 到$ {v_i} $ 的权重系数为$$ {{\boldsymbol{e}}_{ij}} = {\boldsymbol{a}}({\boldsymbol{W}}{{\boldsymbol{X}}_i},{\boldsymbol{W}}{{\boldsymbol{X}}_j}) $$ (3) 其中

${{\boldsymbol{e}}_{ij}}$ 是计算两个节点相关度的函数,本文按照文献[24]的做法,定义这一种神经网络层进行相关度计算,最终本文的权重系数计算公式为$$ {{\boldsymbol{e}}_{ij}} = \sigma ({{\boldsymbol{a}}^{\text{T}}}[{\boldsymbol{W}}{{\boldsymbol{X}}_i}||{\boldsymbol{W}}{{\boldsymbol{X}}_j}]) $$ (4) 其中参数

${\boldsymbol{a}} \in {{\bf{R}}^{2D_t^{(l)}}}$ ,为了更有效地分配权重,本文将所有邻居节点的相关度进行归一化处理,具体形式为softmax归一化:$$ {\alpha _{ij}} = \dfrac{{\exp (\sigma ({{\boldsymbol{a}}^{\text{T}}}[{\boldsymbol{W}}{{\boldsymbol{X}}_i}||{\boldsymbol{W}}{{\boldsymbol{X}}_j}]))}}{{\displaystyle\sum\nolimits_{{v_j} \in {N_{{v_i}}}} {\exp (\sigma ({{\boldsymbol{a}}^{\text{T}}}[{\boldsymbol{W}}{{\boldsymbol{X}}_i}||{\boldsymbol{W}}{{\boldsymbol{X}}_j}]))} }} $$ (5) 为了更进一步提升图注意力层的表达能力,本文加入了多头注意力机制,使用了K组相互独立的注意力层,然后将其进行级联:

$$ X_i^{l + 1} = ||_{k = 1}^K\sigma \left(\displaystyle\sum\nolimits_{{v_j} \in N({v_i})} \alpha _{ij}^{(k)}{W^{(k)}}X_j^l\right) $$ (6) 式中:||表示级联操作;

$ \alpha _{ij}^{(k)} $ 是第k组注意力机制计算出的权重系数;$ {W^{(k)}} $ 是对应的学习参数。多个彼此独立的注意力机制层,使模型能够将注意力的分配集中在中心节点与相邻节点之间的多处相干的特征上,从而学习到效果更好的增强特征。3.2 空间推理模块

3.2.1 空间知识提取

当金具之间存在遮挡时,其目标框之间会存在交叉和重叠的现象,因此,目标框与目标框之间的交并比(intersection over union, IoU)的大小能够反映出金具之间的遮挡关系。比如在单联悬垂结构和防舞动结构中,联板和重锤往往与提包式悬垂线夹相连,使目标框有交叉;在均压屏蔽结构中,由于屏蔽环的尺寸较大,因此屏蔽环的目标框往往会覆盖着联板、挂板、u型挂环以及耐张线夹等金具的目标框。具体的知识提取方式就是统计金具数据集中各个类别之间的目标框的IoU,IoU的计算公式如下:

$$ {\rm IoU }= \frac{{A \cap B}}{{A \cup B}} $$ (7) 通过计算电力部件数据集中各个类别目标框的IoU均值,得到C×C的IoU空间关系矩阵,其中,C为类别个数。

3.2.2 空间推理模块

为了有效表达空间重叠知识,本文构建了空间推理模块如图1所示,与共现推理模块类似,首先将类别之间的关系进行映射,得到区域建议框之间的关系,得到了

$ {\varepsilon _s} $ 图结构。为了使模型能够针对不同的图像目标自适应地获取空间信息,本文引入了图卷积网络(graph convolutional network, GCN)模块对空间知识进行图推理学习,对于GCN模型来说,它更注重学习拓扑图的结构,其中GCN模块的输入是区域建议框的特征向量${\boldsymbol{X}} \in {{\bf{R}}^{{N_r} \times {D_b}}}$ 。最后使用全连接的方式,将输出的两种图结构特征向量进行融合,生成空间知识增强特征层。对于图卷积模块,给定一个图信号

${\boldsymbol{x}}\in {\bf R}^{N}$ ,拉普拉斯矩阵可以表示为${\boldsymbol{L}} = {{\boldsymbol{I}}_N} - {{\boldsymbol{D}}^{ - 1/2}}{{\boldsymbol{AD}}^{ - 1/2}}$ ,其中A是邻接矩阵,D是度矩阵,图卷积等价于x与滤波核g在频谱域中的乘积,并在此基础上进行傅里叶变换,图卷积的矩阵向量形式可以表示如下:$$ \begin{gathered} {\boldsymbol{x}}*{{\boldsymbol{g}}_\theta } = {{\boldsymbol{UG}}_\theta }({\boldsymbol{\varLambda}} ){{\boldsymbol{U}}^{\rm{T}}}{\boldsymbol{x}} = {{\boldsymbol{G}}_\theta }({\boldsymbol{U\varLambda}} {{\boldsymbol{U}}^{\rm{T}}}){\boldsymbol{x}} = {{\boldsymbol{G}}_\theta }({\boldsymbol{L}}){\boldsymbol{x}} \end{gathered} $$ (8) 式中:

$ \boldsymbol U $ 是度矩阵,它的列向量是${\boldsymbol{L}} = {\boldsymbol{U\varLambda }}{{\boldsymbol{U}}^{\rm{T}}}$ 特征分解之后的特征值,${{\boldsymbol{G}}_\theta }({\boldsymbol{L}})$ 是一个对角矩阵,对象元素是由函数特征值$ \theta $ 参数化,在此基础上,根据图拉普拉斯的切比雪夫展开,可以得到$$ {\boldsymbol{x}} * {{\boldsymbol{g}}_\theta } \approx \theta ({{\boldsymbol{I}}_N} + {{\boldsymbol{D}}^{ - 1/2}}{{\boldsymbol{AD}}^{ - 1/2}}){\boldsymbol{x}} $$ (9) 式(9)表示图卷积的一阶近似形式,最终可以得到图卷积网络的一般形式:

$$ {{\boldsymbol{X}}^{l + 1}} = \sigma ({\tilde {\boldsymbol A}} {{\boldsymbol{X}}^l}{{\boldsymbol{W}}^l}) $$ (10) 式中:

$\tilde {\boldsymbol{A}}$ 是带有自连接的标准化邻接矩阵;${{\boldsymbol{X}}^l}$ 和${{\boldsymbol{X}}^{l + 1}}$ 分别是图卷积的输入和输出;${\boldsymbol W}^{l}$ 是学习到的权重矩阵。图卷积网络通过邻接矩阵在节点之间传播信息,挖掘出目标框之间的空间关系信息,从而辅助模型对目标进行定位和回归。3.3 解耦检测模块

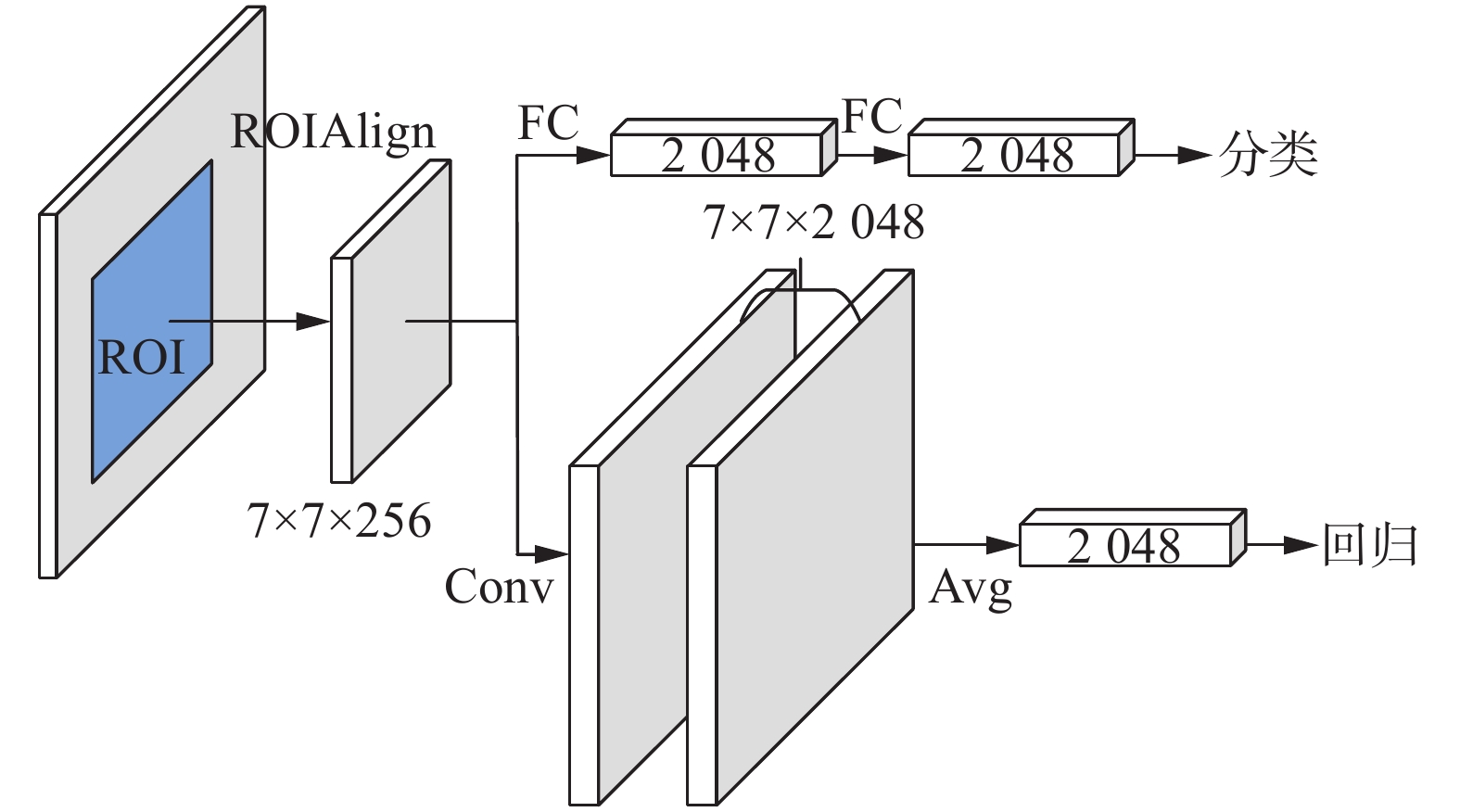

为了使模型更准确地表达出融入的外部共现和空间知识,本文使用了解耦检测模块来替代Faster-RCNN中的头部检测网络,具体网络结构如图1所示。解耦检测模块将目标检测任务分为两种任务进行学习,分别是:1)分类任务:区分背景中的前景候选对象并分配对应的类别标签;2)回归定位任务:通过最大化检测结果与真值框的IoU来回归一组系数。受到Wu等[26]的启发,本文结合两种头部检测网络的优点,即使用对类别信息更敏感的卷积层网络(Conv-head)识别金具的类别,使用对空间信息更敏感的全连接层网络(FC-head)实现金具的回归和定位。

解耦模块具体的网络结构如图4所示,将RPN阶段产生区域建议框分别输入到两个头部检测网络中,其中FC-head是由两个全连接层的全连接层组成,Conv-head由两个残差卷积层组成,将两个网络输出的结果分别于对应的共现和空间增强特征层进行级联,最终实现金具的分类和回归。

4. 实验结果及分析

本文选取了14类金具作为实验对象,其中训练集与测试集样本图像分别为1092和363张,共包含9101个金具目标。本文所述模型使用的软硬件参数以及训练阶段参数如表1所示。

表 1 设备和训练参数Table 1 Equipment and training parameters设备/参数 版本号/具体数值 显卡 NVIDIA RTX3090 操作系统 Ubuntu18.04.5 LTS 编程环境 Python3.8、Pytorch1.8 参数优化方法 SGD 学习率 0.002 学习率衰减轮次 8 学习率衰减比例/% 10 训练最大轮次 20 在测试阶段采用了平均精度均值(mean average precision, mAP)对模型进行总体的评估。

平均精度计算公式如式(11)和(12):

$${\rm{AP}} = \frac{1}{{11}}\sum\limits_{r \in \{ 0.0,\cdots,1.0\} } {\mathop {\max }\limits_{\tilde r \geqslant r} p(\tilde r)} $$ (11) $$mAP = \frac{1}{{|{Q_R}|}}\sum\limits_{q \in {Q_R}} {AP(q)} $$ (12) 其中AP表示每一类的平均识别精度,对该类的检测结果按照得分从高到低排序后,计算前n个检测框的正确率和召回率,

$\mathop {\max }\limits_{\tilde r \ge r} p(\tilde r) $ 表示超过r的召回率对应的最大的正确值,AP为从0.0~1.0的11个召回率对应的最大正确率的平均值。而mAP是所有类AP的平均值,QR代表物体的类别数。在与先进模型的对比过程中,使用COCO评价指标从多角度对本文模型进行评估。本文模型是以Faster R-CNN模型[28]为础框架模型,融合外部知识以及增加解耦检测模块进行针对性的改进。

4.1 消融实验

为了证明本文模型中每个模块的有效性,本文设计了两组消融实验:1)证明知识模块的有效性:在基线模型的基础上,分别增加两种知识,并使用非解耦的方式进行检测;2)证明解耦模块的有效性:在基线模型的基础上,只用解耦模块进行检测。最终检测结果如表2所示。其中基线模型使用Faster RCNN实现;模型1在基线模型的基础上增加解耦模块;模型2在基线模型的基础上单独使用共现知识推理模块;模型3在基线模型的基础上单独使用空间推理模块;模型4在基线模型的基础上使用两种知识推理模块共同作用。

表 2 消融实验结果Table 2 Ablation test resultss% 方法 共现知识 空间知识 解耦模块 AP50 基线模型 69.1 模型1 √ 71.4 模型2 √ 73.0 模型3 √ 73.2 模型4 √ √ 74.6 本文模型 √ √ √ 75.7 从表2可以看出,增加相应的知识推理模块都能提高模型的检测准确率,与基线模型相比,分别使用共现模块和空间模块能够使AP50提高3.9%和4.2%,而同时使用两种知识推理模块比单独使用某一种知识模块能够获得更好的效果,两种知识模块的引入能够使AP50提升5.5%,这是由于共现和空间模块是针对不同的任务进行改进的,同时改善模型的分类和定位才能获得更好的检测效果。其中,AP50的定义是IoU阈值为0.5的mAP值。另外,在基线模型的基础上只增加解耦模块能够使AP50提升2.3%,另外使用解耦知识模块的模型比不使用解耦知识模块的模型的AP50指标高1%,这是因为将分类和回归作为两个任务进行处理,同时也证明了解耦模块的有效性。表3为14类金具的AP测试结果对比。从表3可以看出,本文模型对于绝大多数金具的检测效果都有一定的提升,其中对于u型挂环、联板、压缩性耐张线夹以及调整板的检测效果有显著的提升。由于这4类金具往往与其他金具密集连接,并且在共现概率矩阵中与其他金具的共现概率也较为突出。因此通过共现和空间知识的引入和表达能够显著提高这类金具的检测效果。

表 3 融合外部知识的解耦检测推理网络检测结果Table 3 Decoupled detection inference network detection results combining external knowledge算法 预绞式悬垂线夹 提包式悬垂线夹 挂板 u型挂环 联板 并沟线夹 防震锤 基线算法/% 80.8 86.41 57.91 57.43 34.31 33.17 71.24 改进算法/% 83.31 89.47 55.07 73.72 48.71 60.83 70.89 算法 压缩型耐张线夹 锲型耐张线夹 间隔棒 均压环 屏蔽环 重锤 调整板 基线算法/% 47.98 79.20 75.70 89.37 97.71 97.95 58.53 改进算法/% 64.96 80.73 77.31 89.11 97.29 97.93 70.9 4.2 模型检测结果可视化对比实验

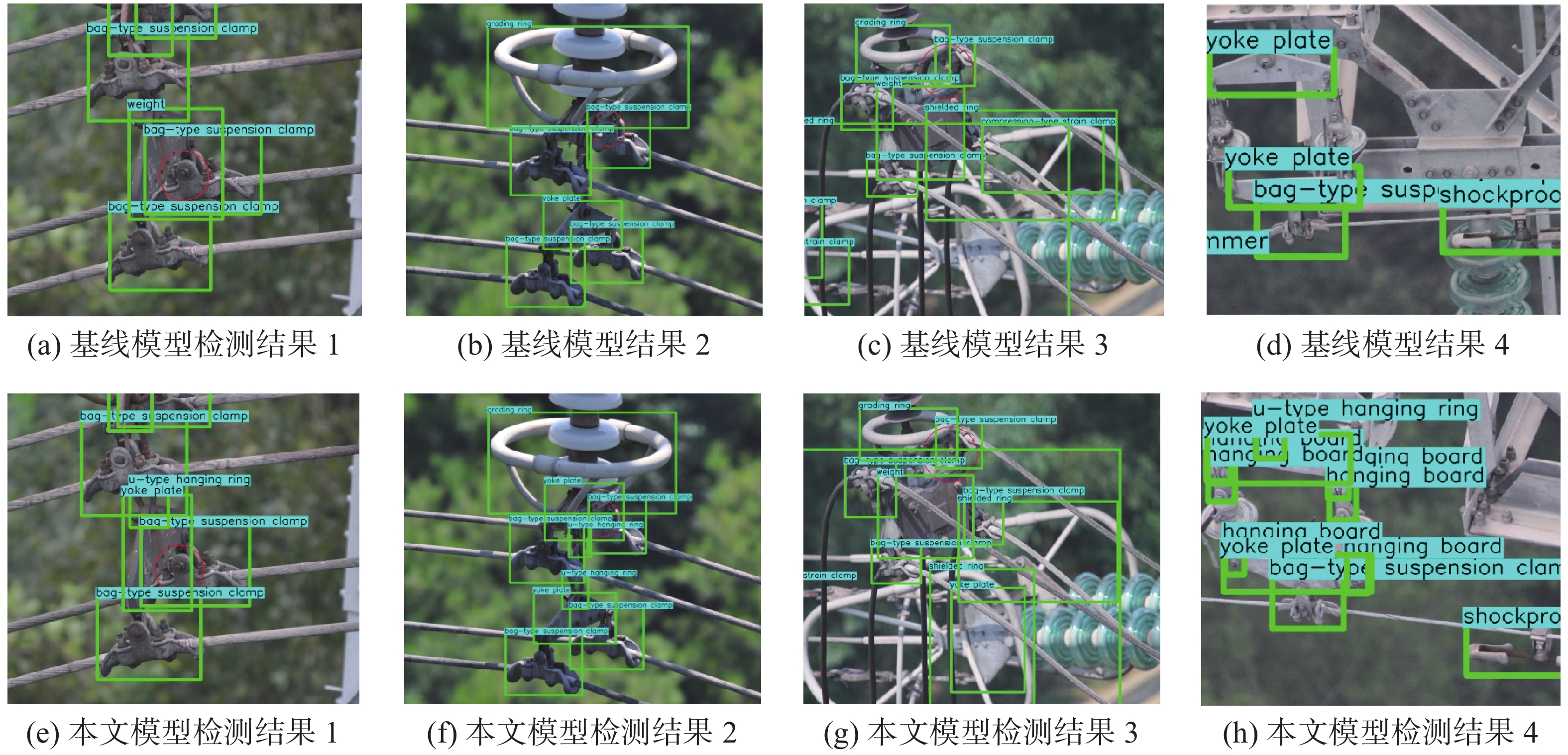

为了定性地分析本文模型的检测效果,图5显示了本文所述模型与基线模型进行分析对比,图5(a)、(b)中的金具属于单联悬垂结构,在基线模型的检测结果中,受到目标之间的相互遮挡,一些较难检测的金具比如u型挂环,均未检测出来,并且在图5(a)中,基线模型把联板误检为重锤。而在本文模型检测结果图5(e)、(f)中,由于共现知识的融入,模型能够检测出同属于单联悬垂结构的u型挂环,也能够正确地识别出联板。在图5(c)中,目标遮挡的问题更严重,导致基线模型无法识别对提包式悬垂线夹和屏蔽环下方的联板。在图5(g)中,本文模型能够正确识别出“隐藏”的提包式悬垂线夹和联板,同时由于空间知识的引入,使得目标的定位也更加准确。从图5(d)、(h)中可以看出,本文模型对于一些连接较为密集的难检测的小型金具也能够得到较好的检测效果。

4.3 与先进模型对比实验

为了验证本文模型的先进性,本文在金具数据集上实现了多种目标检测模型,分别与SSD512[29]、RetinaNet[30]、Baseline模型[28]、YOLOv4[31]、集成知识模块的HKRM[19]以及翟永杰等[18]进行了比较,测试结果如表4所示。

表 4 与先进检测算法性能对比Table 4 Performance comparisons with advanced detection algorithms% 方法 AP50-95 AP50 AP75 APS APM APL AR1 AR10 AR100 ARS ARM ARL SSD[29] 24.7 51.0 17.5 16.7 31.2 25.8 22.8 35.8 35.9 21.5 35.8 28.9 RetinaNet[30] 29.3 61.3 21.0 19.9 37.8 31.4 27.4 40.4 40.4 25.5 42.6 33.3 Baseline[28] 32.5 69.1 27.8 20.9 44.0 48.6 25.4 39.2 39.2 26.8 51.0 52.0 YOLOv4[31] 33.0 61.7 33.0 20.4 37.1 30.8 25.5 39.4 39.6 26.0 42.5 34.0 HKRM[19] 37.8 64.1 38.0 23.1 42.5 35.0 29.0 44.7 44.9 29.7 48.1 38.3 翟永杰等[18] 37.9 65.5 37.2 22.9 44.3 34.4 28.9 45.3 45.4 29.5 49.9 39.5 EKD R-CNN 42.2 75.7 43.2 31.7 52.9 48.3 31.0 50.0 50.1 38.5 59.2 54.2 从表4中可以看出,基线模型的AP50指标为69.1%,本文模型的AP50指标为75.7%,与基线模型相比,本文模型的检测效果提高了6.6%。另外与其他先进模型进行对比,本文模型在COCO评价指标上与其他模型相比均有较大的提升。其中在COCO评价指标中APS和ARS代表对图像中的小尺寸目标的检测效果,表4 中的测试结果显示,APS和ARS提升效果高于其他指标,这表明由于共现知识和空间知识的引入,模型同样能够应对小型金具的目标密集问题,从而提升总体的检测效果。

5. 结束语

针对输电线路航拍图像中广泛存在的金具目标密集和相互遮挡的问题,本文提出了融合多种外部知识的解耦检测方法。首先通过对金具数据集进行挖掘和分析,提取出金具之间的共现知识和空间知识,使用图神经网络建立知识推理模型,将外部知识与模型进行融合,然后将分类任务和回归任务解耦分离,使用解耦检测模块分别得到金具的类别和回归框的位置。实验结果表明,本文模型能够有效解决目标密集问题,对输电线路多金具数据集的检测效果优于其他先进模型。本文使用多元化的外部知识来改善金具的检测效果,为输电线路设备部件智能巡检技术提供了新的思路。

下一步工作可以从图像本身的场景知识以及内部的隐含信息入手,研究更具体的知识表达形式。另外视觉特征与知识模块特征的特征融合方法还存在进一步研究的空间。

-

表 1 设备和训练参数

Table 1 Equipment and training parameters

设备/参数 版本号/具体数值 显卡 NVIDIA RTX3090 操作系统 Ubuntu18.04.5 LTS 编程环境 Python3.8、Pytorch1.8 参数优化方法 SGD 学习率 0.002 学习率衰减轮次 8 学习率衰减比例/% 10 训练最大轮次 20 表 2 消融实验结果

Table 2 Ablation test resultss

% 方法 共现知识 空间知识 解耦模块 AP50 基线模型 69.1 模型1 √ 71.4 模型2 √ 73.0 模型3 √ 73.2 模型4 √ √ 74.6 本文模型 √ √ √ 75.7 表 3 融合外部知识的解耦检测推理网络检测结果

Table 3 Decoupled detection inference network detection results combining external knowledge

算法 预绞式悬垂线夹 提包式悬垂线夹 挂板 u型挂环 联板 并沟线夹 防震锤 基线算法/% 80.8 86.41 57.91 57.43 34.31 33.17 71.24 改进算法/% 83.31 89.47 55.07 73.72 48.71 60.83 70.89 算法 压缩型耐张线夹 锲型耐张线夹 间隔棒 均压环 屏蔽环 重锤 调整板 基线算法/% 47.98 79.20 75.70 89.37 97.71 97.95 58.53 改进算法/% 64.96 80.73 77.31 89.11 97.29 97.93 70.9 表 4 与先进检测算法性能对比

Table 4 Performance comparisons with advanced detection algorithms

% 方法 AP50-95 AP50 AP75 APS APM APL AR1 AR10 AR100 ARS ARM ARL SSD[29] 24.7 51.0 17.5 16.7 31.2 25.8 22.8 35.8 35.9 21.5 35.8 28.9 RetinaNet[30] 29.3 61.3 21.0 19.9 37.8 31.4 27.4 40.4 40.4 25.5 42.6 33.3 Baseline[28] 32.5 69.1 27.8 20.9 44.0 48.6 25.4 39.2 39.2 26.8 51.0 52.0 YOLOv4[31] 33.0 61.7 33.0 20.4 37.1 30.8 25.5 39.4 39.6 26.0 42.5 34.0 HKRM[19] 37.8 64.1 38.0 23.1 42.5 35.0 29.0 44.7 44.9 29.7 48.1 38.3 翟永杰等[18] 37.9 65.5 37.2 22.9 44.3 34.4 28.9 45.3 45.4 29.5 49.9 39.5 EKD R-CNN 42.2 75.7 43.2 31.7 52.9 48.3 31.0 50.0 50.1 38.5 59.2 54.2 -

[1] POURNARAS E, ESPEJO-URIBE J. Self-repairable smart grids via online coordination of smart transformers[J]. IEEE transactions on industrial informatics, 2017, 13(4): 1783–1793. doi: 10.1109/TII.2016.2625041 [2] SADYKOVA D, PERNEBAYEVA D, BAGHERI M, et al. IN-YOLO: real-time detection of outdoor high voltage insulators using UAV imaging[J]. IEEE transactions on power delivery, 2020, 35(3): 1599–1601. doi: 10.1109/TPWRD.2019.2944741 [3] 赵文清, 程幸福, 赵振兵, 等. 注意力机制和Faster RCNN相结合的绝缘子识别[J]. 智能系统学报, 2020, 15(1): 92–98. doi: 10.11992/tis.201907023 ZHAO Wenqing, CHENG Xingfu, ZHAO Zhenbing, et al. Insulator recognition based on attention mechanism and Faster RCNN[J]. CAAI transactions on intelligent systems, 2020, 15(1): 92–98. doi: 10.11992/tis.201907023 [4] 赵振兵, 翟永杰, 张珂. 电力视觉技术[M]. 北京: 中国电力出版社, 2020. [5] FANG Ting, JIN Xin, HU Xingliu, et al. A fast insulator-contour-detection-algorithm on power transmission lines images[J]. Applied mechanics and materials, 2012, 201/202: 337–343. doi: 10.4028/www.scientific.net/AMM.201-202.337 [6] 黄宵宁, 张真良. 直升机巡检航拍图像中绝缘子图像的提取算法[J]. 电网技术, 2010, 34(1): 194–197. HUANG Xiaoning, ZHANG Zhenliang. A method to extract insulator image from aerial image of helicopter patrol[J]. Power system technology, 2010, 34(1): 194–197. [7] WU Qinggang, AN Jubai. An active contour model based on texture distribution for extracting inhomogeneous insulators from aerial images[J]. IEEE transactions on geoscience and remote sensing, 2014, 52(6): 3613–3626. doi: 10.1109/TGRS.2013.2274101 [8] 金立军, 胡娟, 闫书佳. 基于图像的高压输电线间隔棒故障诊断方法[J]. 高电压技术, 2013, 39(5): 1040–1045. doi: 10.3969/j.issn.1003-6520.2013.05.003 JIN Lijun, HU Juan, YAN Shujia. Method of spacer fault diagnose on transmission line based on image procession[J]. High voltage engineering, 2013, 39(5): 1040–1045. doi: 10.3969/j.issn.1003-6520.2013.05.003 [9] 王万国, 张晶晶, 韩军, 等. 基于无人机图像的输电线断股与异物缺陷检测方法[J]. 计算机应用, 2015, 35(8): 2404–2408. doi: 10.11772/j.issn.1001-9081.2015.08.2404 WANG Wanguo, ZHANG Jingjing, HAN Jun, et al. Broken strand and foreign body fault detection method for power transmission line based on unmanned aerial vehicle image[J]. Journal of computer applications, 2015, 35(8): 2404–2408. doi: 10.11772/j.issn.1001-9081.2015.08.2404 [10] 胡彩石, 吴功平, 曹珩, 等. 高压输电线路巡线机器人障碍物视觉检测识别研究[J]. 传感技术学报, 2008, 21(12): 2092–2096. doi: 10.3969/j.issn.1004-1699.2008.12.028 HU Caishi, WU Gongping, CAO Heng, et al. Research of obstacle recognition based on vision for high voltage transmission line inspection robot[J]. Chinese journal of sensors and actuators, 2008, 21(12): 2092–2096. doi: 10.3969/j.issn.1004-1699.2008.12.028 [11] 张东, 邱翔, 曹成功, 等. 结合聚合通道和复频域特征的防震锤检测算法[J]. 计算机技术与发展, 2020, 30(3): 147–151. doi: 10.3969/j.issn.1673-629X.2020.03.028 ZHANG Dong, QIU Xiang, CAO Chenggong, et al. An vibration damper detection algorithm combined with aggregation channel and complex frequency domain features[J]. Computer technology and development, 2020, 30(3): 147–151. doi: 10.3969/j.issn.1673-629X.2020.03.028 [12] 付晶, 邵瑰玮, 吴亮, 等. 利用层次模型进行训练学习的线路设备缺陷检测方法[J]. 高电压技术, 2017, 43(1): 266–275. FU Jing, SHAO Guiwei, WU Liang, et al. Defect detection of line facility using hierarchical model with learning algorithm[J]. High voltage engineering, 2017, 43(1): 266–275. [13] 汤踊, 韩军, 魏文力, 等. 深度学习在输电线路中部件识别与缺陷检测的研究[J]. 电子测量技术, 2018, 41(6): 60–65. TANG Yong, HAN Jun, WEI Wenli, et al. Research on part recognition and defect detection of trainsmission line in deep learning[J]. Electronic measurement technology, 2018, 41(6): 60–65. [14] 高强, 廉启旺. 航拍图像中绝缘子目标检测的研究[J]. 电测与仪表, 2019, 56(5): 119–123. GAO Qiang, LIAN Qiwang. Research on target detection of insulator in aerial image[J]. Electrical measurement & instrumentation, 2019, 56(5): 119–123. [15] HU Han, GU Jiayuan, ZHANG Zheng, et al. Relation networks for object detection[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, IEEE, 2018: 3588−3597. [16] CHEN Xinlei, GUPTA A. Spatial memory for context reasoning in object detection[C]//2017 IEEE International Conference on Computer Vision. Venice, IEEE, 2017: 4106−4116. [17] ZENG X, OUYANG Wanli, YANG Bin, et al. Gated bi-directional cnn for object detection[C]//European conference on computer vision. Springer, Cham, 2016: 354−369. [18] 翟永杰, 杨旭, 赵振兵, 等. 融合共现推理的Faster R-CNN输电线路金具检测[J]. 智能系统学报, 2021, 16(2): 237–246. doi: 10.11992/tis.202012023 ZHAI Yongjie, YANG Xu, ZHAO Zhenbing, et al. Integrating co-occurrence reasoning for Faster R-CNN transmission line fitting detection[J]. CAAI transactions on intelligent systems, 2021, 16(2): 237–246. doi: 10.11992/tis.202012023 [19] JIANG CHENHAN, XU HANG, LIANG XIANGDAN, et al. Hybrid knowledge routed modules for large-scale object detection[EB/OL]. (2018−10−30)[2021−01−01].https://arxiv.org/abs/1810.12681. [20] GORI M, MONFARDINI G, SCARSELLI F. A new model for learning in graph domains[C]//Proceedings of 2005 IEEE International Joint Conference on Neural Networks. Montreal, IEEE, 2005: 729−734. [21] DEFFERRARD M, BRESSON X, VANDERGHEYNST P. Convolutional neural networks on graphs with fast localized spectral filtering[C]//Proceedings of the 30th International Conference on Neural Information Processing Systems. Red Hook, Curran Associates Inc., 2016: 3844−3852. [22] BRUNA J, ZAREMBA W, SZLAM A, et al. Spectral networks and locally connected networks on graphs[EB/OL]. (2014−05−21)[2020−12−12].https://arxiv.org/abs/1312.6203. [23] KIPF T N, WELLING M. Semi-supervised classification with graph convolutional networks[EB/OL]. (2016−12−09)[2020−11−30].https://arxiv.org/abs/1609.02907. [24] VELIČKOVIĆ P, CUCURULL G, CASANOVA A, et al. Graph attention networks[EB/OL]. (2018−02−04)[2020−10−01].https://arxiv.org/abs/1710.10903. [25] JIANG Borui, LUO Ruixuan, MAO Jiayuan, et al. Acquisition of Localization Confidence for Accurate Object Detection[C]//European Conference on Computer Vision. Cham: Springer, 2018: 816−832. [26] WU Yue, CHEN Yinpeng, YUAN Lu, et al. Rethinking classification and localization for object detection[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, IEEE, 2020: 10183−10192. [27] SONG Guanglu, LIU Yu, WANG Xiaogang. Revisiting the sibling head in object detector[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, IEEE, 2020: 11560−11569. [28] REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(6): 1137–1149. doi: 10.1109/TPAMI.2016.2577031 [29] LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: single shot MultiBox detector[M]//Computer Vision – ECCV 2016. Cham: Springer International Publishing, 2016: 21−37. [30] LIN T Y, GOYAL P, GIRSHICK R, et al. Focal loss for dense object detection[C]//Proceedings of the IEEE international conference on computer vision. 2017: 2980−2988. [31] BOCHKOVSKIY A, WANG C Y, LIAO H Y M. YOLOv4: optimal speed and accuracy of object detection[EB/OL]. (2020−04−23)[2021−01−10].https://arxiv.org/abs/2004.10934.

下载:

下载: