Image amplification for temperature value image based on cyclic cross-correlation coefficient CGAN

-

摘要: 针对变电设备红外图像温度值样本少、不均衡等问题,本文提出了一种基于循环互相关系数的条件生成对抗网络(conditional generative adversarial network, CGAN)温度值图像扩增方法。根据图像相似度提出了循环互相关系数,改进了CGAN模型的损失函数;使用改进后的CGAN模型在原始温度值图像数据集的基础上进行图像扩增,得到了包含11种标签的新数据集;采用卷积神经网络对传统图像扩增方法、原始CGAN模型和改进的CGAN模型扩增的图像进行对比和测试。结果表明,改进的CGAN模型收敛速度更快,训练过程稳定,扩增的图像轮廓清晰、细节丰富,客观评价指标最高,温度值识别准确率达到99.4%,实现了图像扩增的目的。Abstract: To solve the problems of small sample size and imbalance of infrared image for substation equipment, a temperature image amplification method based on cyclic cross-correlation coefficient conditional generative adversarial network (CGAN) is proposed. The cyclic cross-correlation coefficient is proposed according to the image similarity, which improves the loss function of CGAN. Then the improved CGAN is used to amplify the original temperature image data set, establishing a new data set containing 11 labels. Then, the traditional image amplification method, the original CGAN and the improved CGAN are compared using the convolution neural network (CNN). The experiment demonstrate that the proposed CGAN model has faster convergence speed and stable training process, and the generated images have clear contour and rich details. The objective evaluation index of the proposed method is the largest, and the recognition accuracy of temperature value reaches 99.4%, which realizes the purpose of the image amplification.

-

变电设备是电能输送的重要组成部分,由于长期暴露在复杂的环境中,容易产生裂缝、老化、腐蚀等缺陷,引起变电设备温度异常,影响电力系统的稳定性[1-2]。基于红外图像的缺陷检测技术能够根据变电设备的热效应特点判断是否存在缺陷,具有操作简单、检测时间快、灵敏度高等优点[3]。因此,通过识别红外图像中的温度值,能够快速筛选出缺陷,并方便统计和记录。在实际巡检过程中,由于变电设备检测的周期较长、温度变化不确定性高,采集的红外图像温度值样本较少,存在数据集不平衡问题,无法满足模型的训练要求[4-5]。

针对此问题,图像扩增技术通过增加训练集数量,可以有效缓解训练时产生的过拟合和梯度下降现象[6-7]。近年来,研究学者们对基于机器学习技术的图像扩增方法进行了大量研究[8-10]。Goodfellow等[11]受博弈论思想的影响率先提出了生成对抗网络(generative adversarial network, GAN),通过生成器和判别器的对抗训练,不断学习样本的数据分布。Han等[12]提出了一种基于改进GAN的遥感图像生成方法,采用沃瑟斯坦距离测量生成分布与真实分布间的差异,解决了训练过程中梯度消失等问题。Song等[13]将GAN输入噪声限制为二进制,并且采用多任务和无监督方式将图像转换成二进制编码同时进行图像压缩和检索。Guo等[14]在判别器中加入对比度增强操作,并将原始GAN的多层感知层替换为深度卷积神经网络,增强了图像细节和特征提取能力。这些方法虽然能够有效地增加样本数量,但是针对真实场景中的复杂背景图像缺乏特征分析,无法保证生成图像的质量。

为扩增变电设备温度值图像并提高生成图像质量,本文提出了基于循环互相关系数的CGAN温度值图像扩增方法。提出了一种循环互相关系数改进原始CGAN模型的损失函数,实现了数据集的扩增,在提高生成图像质量的同时解决了原始CGAN模型训练过程不稳定和过拟合的问题;在此基础上,通过对比实验验证了模型的有效性,实现了红外图像中温度值的高效准确识别,为后期的性能分析和故障诊断提供大量的红外温度值数据。

1. 条件生成对抗网络

条件生成对抗网络(conditional generative adversarial network, CGAN)通过输入随机噪声和标签信息来引导数据的生成过程[15-16],由生成器(generator, G)和判别器(discriminator, D)组成。生成器G生成具有标签特征的样本,判别器D用于区分生成样本与真实样本[17]。

CGAN模型的损失函数包括生成器和判别器两部分,如式(1)所示,目标函数如式(2)所示,在样本数据小的情况下,CGAN采用随机噪声作为基础生成的图像会存在若干畸形图像,这会直接影响损伤函数的计算结果,使得CGAN无法收敛,模型的稳定性较差[18]。

$$ \left\{ \begin{aligned} &{L_{\boldsymbol{G}}} = - \frac{1}{n}\sum\limits_{i = 1}^n {\log {\boldsymbol{D}}\left( {{{\boldsymbol{G}}_{{{\boldsymbol{Z}}_i},y}}} \right)} \\ &{L_{\boldsymbol{D}}} = - \frac{1}{m}\sum\limits_{j = 1}^m {\log {\boldsymbol{D}}\left( {{{\boldsymbol{R}}_{j,y}}} \right)} - \frac{1}{n}\sum\limits_{i = 1}^n {\log \left[ {1 - {\boldsymbol{D}}\left( {{{\boldsymbol{G}}_{{{\boldsymbol{Z}}_i},y}}} \right)} \right]} \end{aligned} \right. $$ (1) $$ \begin{aligned} \mathop {\min }\limits_{\boldsymbol{G}} \mathop {\max }\limits_{\boldsymbol{D}} {\boldsymbol{V}}\left( {{\boldsymbol{D}},{\boldsymbol{G}}} \right) = {{\boldsymbol{E}}_{{\boldsymbol{R}} \sim {{\boldsymbol{P}}_{\boldsymbol{R}}}}}\left[ {\log {\boldsymbol{D}}\left( {{{\boldsymbol{R}}_y}} \right)} \right] + \\ {{\boldsymbol{E}}_{{\boldsymbol{z}} \sim {{\boldsymbol{P}}_{\boldsymbol{G}}}}}\left\{ {\log \left[ {1 - {\boldsymbol{D}}\left( {{{\boldsymbol{G}}_y}} \right)} \right]} \right\}\quad\quad\quad\quad \end{aligned} $$ (2) 式中:m,n分别表示真实图像和生成图像数量;Zi表示第i张噪声;

${{\boldsymbol{G}}_{{{\boldsymbol{Z}}_i},y}}$ 表示标签为y的第i张生成图像;Rj,y表示标签为y的第j张真实图像,表示标签为y的生成图像;Ry表示标签为y的真实图像;PR、PG分别表示真实图像集和生成图像集;D表示判别网络的判别结果。2. 基于改进CGAN的图像扩增方法

2.1 基于循环互相关系数的改进损失函数

2.1.1 循环互相关系数

相关系数反映两张图像间的相关程度,相关系数越大,表明两张图像越相似[19]。相关系数的计算如式(3)所示。由于两张图像间的相关系数存在较大的偶然性,本文提出一种循环互相关系数δ,用于表征不同标签图像间的相关性,提高生成图像质量和多样性。其中,δ取值范围为[0,1],数值越大表明图像之间越相似,其计算过程如图1所示。

$$ \begin{aligned} {\delta _{{{\boldsymbol{V}}_1}{\rm{, }}{{\boldsymbol{V}}_2}}} = \frac{{\displaystyle\sum\limits_{i = 1}^n {\displaystyle\sum\limits_{j = 1}^m {{{\boldsymbol{V}}_1}(i,j) \cdot {{\boldsymbol{V}}_2}(i,j)} } }}{{\sqrt {{\delta _{{{\boldsymbol{V}}_1},{{\boldsymbol{V}}_1}}}} \times \sqrt {{\delta _{{{\boldsymbol{V}}_2},{{\boldsymbol{V}}_2}}}} }}\\ {\delta _{{{\boldsymbol{V}}_1}{\rm{, }}{{\boldsymbol{V}}_1}}} = \displaystyle\sum\limits_{i = 1}^n {\displaystyle\sum\limits_{j = 1}^m {{{\boldsymbol{V}}_1}(i,j) \cdot {{\boldsymbol{V}}_1}(i,j)} } \\ {\delta _{{{\boldsymbol{V}}_2}{\rm{, }}{{\boldsymbol{V}}_2}}} = \displaystyle\sum\limits_{i = 1}^n {\displaystyle\sum\limits_{j = 1}^m {{{\boldsymbol{V}}_2}(i,j) \cdot {{\boldsymbol{V}}_2}(i,j)} } \end{aligned} $$ (3) 式中:i,j表示像素点的位置;m,n是图像长和宽。

设标签A图像为VA1,VA2,…,VAn,标签B图像为VB1,VB2,…,VBm,当计算标签A和标签B的循环互相关系数

${\delta _{{{\boldsymbol{A}}_1}{\text{, }}{{\boldsymbol{B}}_1}}}$ 时,其计算过程为:从标签A中取出图像VA1,分别计算VA1与标签B中图像VB1,VB2,…,VBm的相关系数,即${\delta _{{{\boldsymbol{A}}_1}{\text{, }}{{\boldsymbol{B}}_m}}}$ ,${\delta _{{{\boldsymbol{A}}_2}{\text{, }}{{\boldsymbol{B}}}}}$ ,…,${\delta _{{{\boldsymbol{A}}_1}{\text{, }}{\boldsymbol{B}}}}$ ,将其平均值作为图像VA1与标签B的相关系数$ {\delta _{{A_2}{\text{, }}B}} $ ;以此类推,分别计算VA2,VA3,…,VAn与标签B的相关系数${\delta _{{{\boldsymbol{A}}_n}{\text{, }}{\boldsymbol{B}}}}$ ,$ {\delta _{{{\boldsymbol{A}}_{n-1}}{\text{, }}{\boldsymbol{B}}}} $ ,…,${\delta _{{\boldsymbol{A}}{\text{, }}{\boldsymbol{B}}}}$ ;最后计算所有标签A图像与标签B中相关系数的平均值,得到最终的循环互相关系数,如式(4):$$ \begin{array}{l} {\delta _{{{\boldsymbol{A}}_i}{\rm{, }}{\boldsymbol{B}}}} = \displaystyle\sum\limits_{j = 1}^m {\dfrac{{{\delta _{{{\boldsymbol{A}}_i}{\rm{, }}{{\boldsymbol{B}}_j}}}}}{m}} \\ {\delta _{{\boldsymbol{A}}{\rm{, }}{\boldsymbol{B}}}} = \displaystyle\sum\limits_{i = 1}^n {\dfrac{{{\delta _{{{\boldsymbol{A}}_i}{\rm{, }}{\boldsymbol{B}}}}}}{n}} \end{array} $$ (4) 式中:n、m分别是标签A和标签B图像的数量。

2.1.2 改进的损失函数

为了提高生成图像质量,基于循环互相关系数改进生成器和判别器的损失函数,如式(5),目标函数如式(6):

$$ \left\{ \begin{aligned} {L_{\boldsymbol{G}}}_\delta = & - \frac{1}{n}\displaystyle\sum\limits_{i = 1}^n {\log \left[ {{\delta _{{\boldsymbol{G}}\left( {{z_i}\left| {\rm{y}} \right.} \right),{\rm{y}}}} \times {\boldsymbol{D}}\left( {{{\boldsymbol{G}}_{{z_i},y}}} \right)} \right]} \\ {L_{\boldsymbol{D}}}_\delta = & - \frac{1}{m}\displaystyle\sum\limits_{j = 1}^m {\log \left( {{\delta _{{{\boldsymbol{R}}_{j,y}},{\rm{y}}}} \times {\boldsymbol{D}}\left( {{{\boldsymbol{R}}_{j,y}}} \right)} \right)} -\\ & \frac{1}{n}\displaystyle\sum\limits_{i = 1}^n {\log \left[ {1 - {\delta _{{{\boldsymbol{G}}_{{z_i},y}}}} \times {\boldsymbol{D}}\left( {{{\boldsymbol{G}}_{{z_i},y}}} \right)} \right]} \end{aligned} \right. $$ (5) $$ \begin{aligned} \mathop {\min }\limits_{\boldsymbol{G}} \mathop {\max }\limits_{\boldsymbol{D}} {\boldsymbol{V}}\left( {{{\boldsymbol{D}}},{\boldsymbol{G}}} \right) = {{\boldsymbol{E}}_{x \sim {P_R}}}\left[ {\log \left( {{\delta _{{{\boldsymbol{R}}_{j,y}},{\rm{y}}}} \times {\boldsymbol{D}}\left( {{{\boldsymbol{R}}_y}} \right)} \right)} \right] + \\ {{{\boldsymbol{E}}}_{z \sim {P_G}}}\left\{ {\log \left[ {1 - {\delta _{{{\boldsymbol{G}}_{{z_i},y}},{\rm{y}}}} \times {\boldsymbol{D}}\left( {{{\boldsymbol{G}}_{{z_i},y}}} \right)} \right]} \right\}\quad\quad\quad\quad \end{aligned} $$ (6) 式中:

${\delta _{{{\boldsymbol{R}}_{j,y}},{\text{y}}}}$ 表示标签y的第i张生成图像与各标签图像的最大循环互相关系数;${\delta _{{{\boldsymbol{V}}_1},y}}$ 表示标签y的第j张真实图像与各标签图像的最大循环互相关系数。当图像V1输入到判别器D后,计算此图像与各标签图像(y1, y2, …, y11)的循环互相关系数,取其最大值。当此图像实际为真实标签的图像时,则

${\delta _{{{\boldsymbol{V}}_1},{\boldsymbol{y}}}}$ 趋于1;当此图像实际为假标签的图像时,则$\delta_{{\boldsymbol{v}}_{1}, {\boldsymbol{y}}}$ 趋于0,从而纠正了判别器将假判断为真和将真判断为假的情况。此外,为了减少判别器D的识别效果对生成器G的影响,更好地平衡生成器G和判别器D的训练过程,随机将一定比例的真实图像判别结果进行随机翻转操作,从而降低判别器的准确率并提升生成器的训练效果,解决过拟合现象。2.2 网络设计

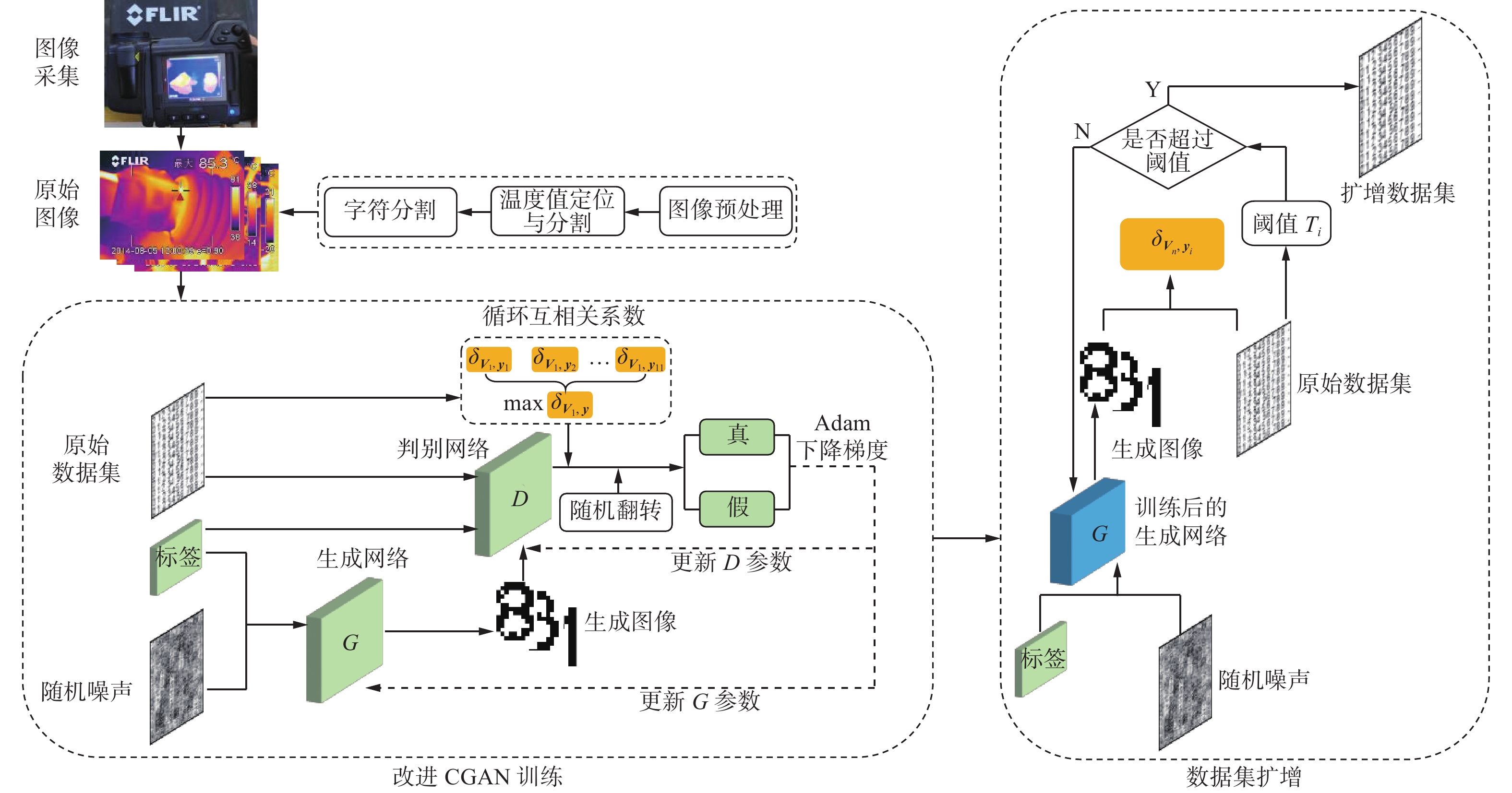

本文的生成器网络和判别器网络结构如图2所示,训练过程如下。

1) 将随机噪声和标签输入到生成器G中得到生成图像,固定判别器D,分别计算生成图像与11种标签图像的循环互相关系数,选取上述循环互相关系数的最大值改进损失函数,优化生成器G参数;

2) 接着固定生成器G,同时将生成图像、真实图像和标签输入到判别器D中,判断图像的真假,并根据图像与11种标签图像的循环互相关系数最大值改进损失函数;

3) 将结果反馈到生成器G和判别器D中,更新参数,反复执行上述步骤,使两者损失函数达到平衡,减少了生成图像与标签不匹配的情况。

在图像扩增时,将原始数据集中各标签内的循环互相关系数的平均值作为阈值,当生成图像与对应标签图像之间的循环互相关系数超过此阈值时输出图像,确保生成图像的质量,进而搭建新的数据集。

2.3 算法流程

本文提出的基于循环互相关系数的CGAN温度值图像扩增方法流程如图3所示,由4个部分组成。

1)图像采集。采用红外热成像仪采集不同类型的变电设备图像,如绝缘子、高压套管、避雷器和转换开关等。

2) 构建原始温度值图像数据集。首先对采集的图像进行预处理,并基于轮廓和位置信息准确定位温度值区域并进行分割,最终得到包含数字“0~9”和符号“–”共11种标签的原始温度值图像数据集。

3) 训练改进的CGAN网络。将随机噪声和标签同时输入到生成器网络中得到生成图像,将原始数据集和生成图像输入到判别器网络中,结合循环相关系数判别图像真假,经过一定比例随机翻转后进行对抗训练,更新网络参数,直至达到平衡。

4) 构建新温度值图像数据集。利用训练好的改进CGAN网络生成图像,结合循环相关系数提高生成图像质量,最终建立新的温度值图像数据集。

3. 实验环境与原始数据集

变电设备红外图像采用FLIR红外成像仪拍摄,像素为320×240。硬件配置为Intel(R)Core(TM)i5-10400F@2.90 GHz,16.0 GB RAM,NVIDIA GTX 2060,软件为MATLAB 2020b。实验中设置学习率为0.000 2、梯度衰减系数为0.5、平方梯度衰减因子为0.999、运行200×27代,激活函数(leaky rectified linear units, Leaky ReLU) 斜率为0.2,采用自适应矩估计优化器(adaptive moment estimation, Adam)更新网络参数,单次批量处理32张图像。网络结构参数设置见表1。

表 1 网络参数设置Table 1 Network parameter setting层 层类型 生成器网络 判别器网络 输入特征 神经元数 输出特征 输入特征 神经元数 输出特征 0 输入层 噪声100×32 100×32 图像256×32 256×32 标签32 标签32 1 全连接层FC1 100×32 256×100 256×32 256×32 1 024×256 1 024×32 2 激活层A1 256×32 256×32 1024×32 1 024×32 3 全连接层FC2 256×32 512×256 512×32 1024×32 512×1 024 512×32 4 激活层A2 512×32 512×32 512×32 512×32 续表 1 层 层类型 生成器网络 判别器网络 输入特征 神经元数 输出特征 输入特征 神经元数 输出特征 5 全连接层FC3 512×32 1 024×512 1 024×32 512×32 256×512 256×32 6 激活层A3 1 024×32 1 024×32 256×32 256×32 7 全连接层FC4 1 024×32 256×1 024 256×32 256×32 1×256 1×32 8 激活层A4 256×32 256×32 1×32 1×32 由于红外图像中通常包含设备水印、树木、建筑物等复杂背景[20],直接对红外图像识别容易检测错误,因此需要进行图像预处理,包括二值化处理、图像分割、温度值提取等。预处理结果如图4所示。随机选取150张变电设备红外图像进行预处理,一共得到876张温度值图像,根据温度值特点将图像分成11个标签,分别是数字“0~9”和符号“–”,并建立原始温度值图像数据集,如表2所示。分析可知原数据集存在样本数量小、分配不均衡特点。

表 2 原始温度值图像数据集Table 2 Original temperature image data set标签 数量 标签 数量 – 20 5 49 0 60 6 38 1 149 7 46 2 179 8 36 3 184 9 43 4 72 / / 4. 分析与讨论

4.1 生成图像结果

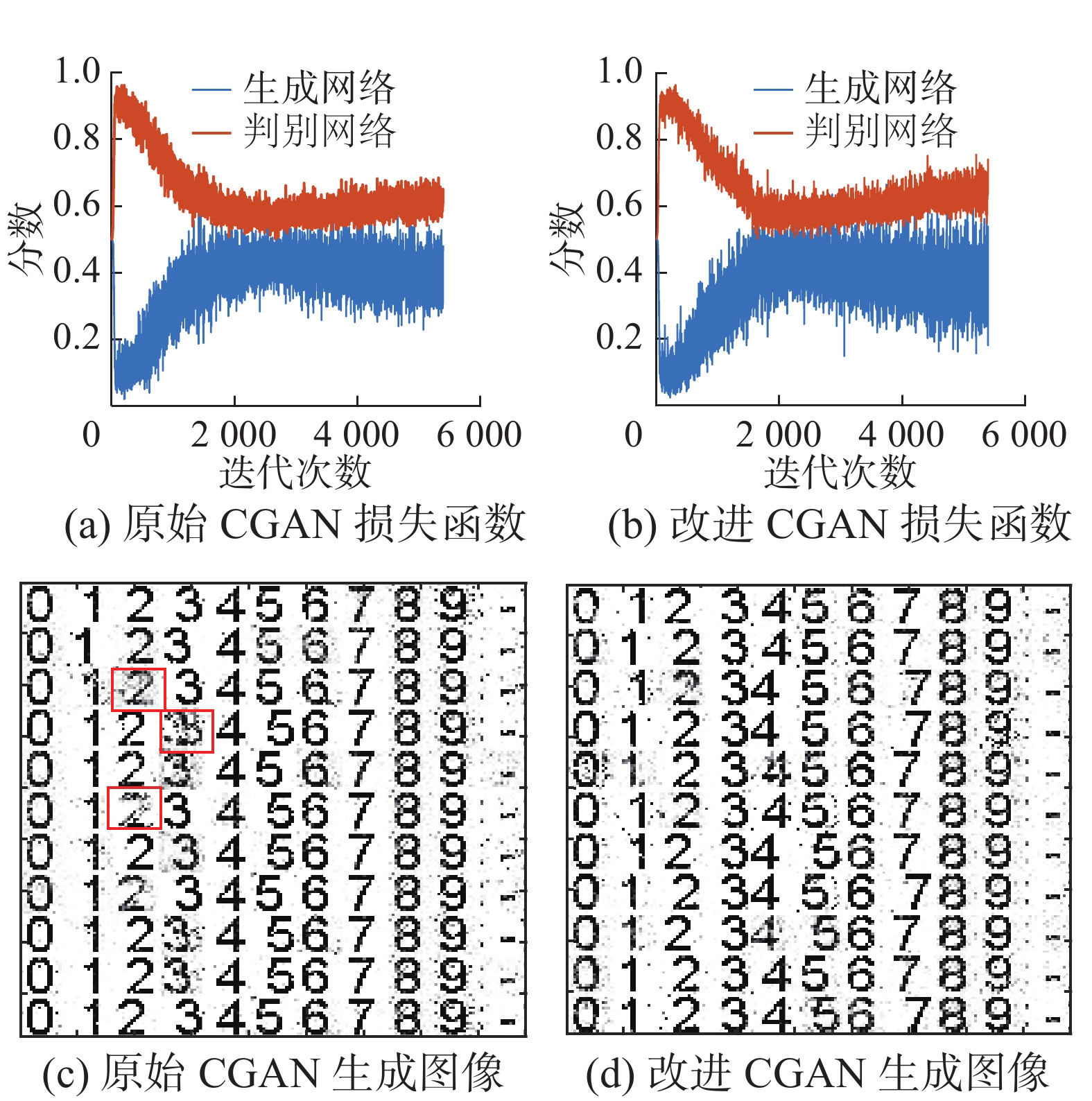

采用改进的CGAN模型能够根据标签生成对应的图像,扩增后的变电设备温度值数据集共有2200张,数字“0~9”和符号“–”各有200张。为了验证改进CGAN模型的有效性,与原始CGAN模型损失函数曲线和生成图像进行对比,结果如图5所示。可以看出,原始CGAN的损失函数在初期震荡较大,表明初期生成的样本质量较差,随着训练次数的增加,生成器和判别器网络相互对抗,图像质量不断上升,在2000次训练后开始达到平衡,但生成图像存在较大的偶然性,部分数据不清晰、边缘模糊,存在异常结果,从而导致生成数据集的质量较差。改进的CGAN结合了循环互相关系数,在1800次迭代后达到了平衡,训练过程较稳定,波动较小,且生成图像比较清晰、无异常结果,轮廓细节更清晰,整体图像质量较好。

为了验证循环互相关系数的有效性,计算上述数据集中各标签图像间的循环互相关系数,结果如表3所示。可以看出,相同标签图像的循环相关系数超过0.90,而不同标签之间的循环相关系数比较小,因此循环相关系数能够区分各标签图像,进而提高生成图像的质量。

4.2 客观质量评价

为了评价生成图像的质量,结合客观质量评价方法进行分析。客观质量评价方法主要包括全参考指标、部分参考指标和无参考指标[21-22]。本文选取峰值信噪比(peak-signal to noise ratio, PSNR)和结构相似度(structure similarity, SSIM)两种全参考指标对生成图像进行质量评价。PSNR是基于图像像素统计的指标,通过计算图像之间的像素误差的全局大小来评价图像质量,PSNR值越大表明图像生成效果越好[23]。SSIM是基于结构信息的指标,从亮度、对比度、结构综合评价图像相似性,更符合人眼视觉系统特性[24],SSIM值越大,生成图像质量越好。

表 3 11种标签的循环互相关系数Table 3 Cyclic cross-correlation coefficients of 11 labels标签 − 0 1 2 3 4 5 6 7 8 9 − 0.951 0.295 0.245 0.541 0.128 0.083 0.606 0.662 0.323 0.655 0.674 0 0.295 0.914 0.470 0.376 0.313 0.425 0.310 0.284 0.473 0.232 0.286 1 0.245 0.470 0.962 0.284 0.263 0.325 0.259 0.231 0.385 0.199 0.237 2 0.541 0.376 0.284 0.945 0.235 0.157 0.406 0.420 0.522 0.509 0.562 3 0.128 0.313 0.263 0.235 0.936 0.111 0.092 0.028 0.254 0.001 0.052 4 0.128 0.313 0.263 0.235 0.678 0.922 0.092 0.028 0.254 0.001 0.052 5 0.606 0.310 0.259 0.406 0.092 0.109 0.947 0.735 0.369 0.607 0.560 6 0.662 0.284 0.231 0.420 0.028 0.104 0.735 0.935 0.284 0.699 0.571 7 0.323 0.473 0.385 0.522 0.254 0.334 0.369 0.284 0.947 0.277 0.335 8 0.655 0.232 0.199 0.509 0.001 0.049 0.607 0.699 0.277 0.951 0.698 9 0.674 0.286 0.237 0.562 0.052 0.068 0.560 0.571 0.335 0.698 0.904 为了验证改进的CGAN模型的有效性,将本文算法与传统的图像扩增方法和原始的CGAN模型进行对比。传统的图像扩增方法包括图像旋转、缩放、翻转等[25]。分别计算3种方法生成图像的PSNR和SSIM值,得到11种标签客观评价指标,结果如表4所示。

表 4 不同图像扩增方法的客观评价指标Table 4 Objective evaluation index of different methods标签 传统方法 原始CGAN 改进CGAN PSNR SSIM PSNR SSIM PSNR SSIM − 30.326 0.761 32.399 0.828 34.336 0.839 0 31.995 0.650 35.053 0.751 36.001 0.863 1 33.838 0.756 33.992 0.783 36.928 0.820 2 30.846 0.279 29.470 0.532 32.192 0.574 3 30.273 0.582 30.404 0.707 34.836 0.816 续表 4 标签 传统方法 原始CGAN 改进CGAN PSNR SSIM PSNR SSIM PSNR SSIM 4 30.773 0.507 30.343 0.566 31.599 0.677 5 30.522 0.747 29.926 0.742 33.244 0.894 6 30.317 0.806 31.324 0.717 33.728 0.808 7 31.690 0.504 32.080 0.561 33.616 0.617 8 31.232 0.727 29.051 0.842 33.557 0.853 9 30.930 0.577 31.688 0.700 31.943 0.706 从表4可以看出,基于改进CGAN模型的图像扩增方法在PSNR和SSIM指标上数值最大,生成图像质量更好,证明了改进CGAN模型的有效性。原始CGAN模型在加入循环互相关系数改进损失函数后,生成图像质量得到明显提升。例如,相比于原始的CGAN模型,数字“5”的PSNR值提高了11.1%,SSIM值提高20.5%,改进后的CGAN模型更能有效地控制生成图像的质量,与原始图像像素分布更接近,图像失真更小。

4.3 温度值识别对比

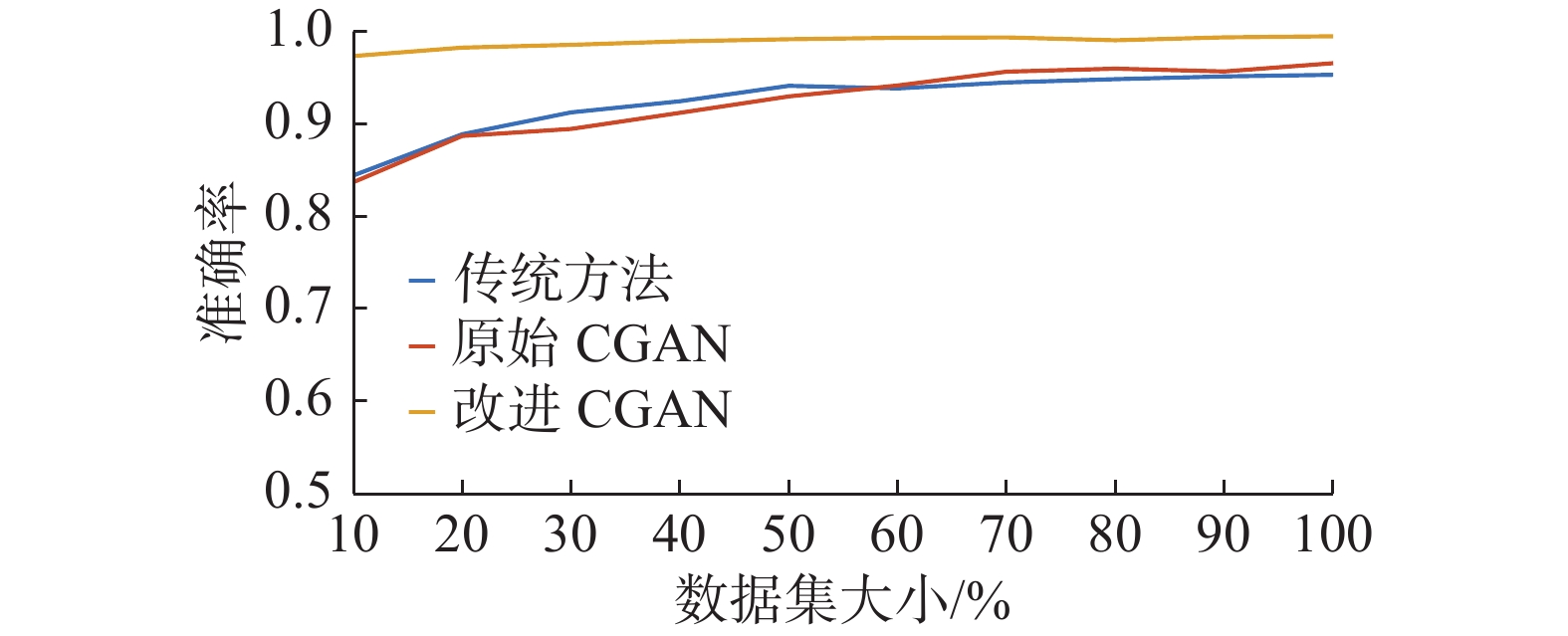

为了验证温度值图像扩增质量对识别准确率的影响,将上述3种方法生成的2 200张图像按照7:3的比例随机分配为训练集和测试集,采用卷积神经网络(convolution neural network, CNN)进行温度值识别,并采用10倍交叉检验法进行验证,结果如图6所示。此外,为了验证图像扩增数量对识别准确率的影响,分析识别准确率随样本数量变化的情况,结果如图7所示。

从图6可以看出,与传统的图像扩增方法相比,基于改进CGAN的图像扩增方法识别效果更好,11种标签的准确率均有大幅度提升。相比于原始的CGAN模型,对于容易识别错误的标签“0”、“3”、“6”、“−”等,识别的准确率分别为87.12%、87.22%、94.41%和93.62%,表明扩增后的温度值图像数据集能够提高温度值识别的准确率,满足训练和测试的样本要求。

从图7可以看出,随着生成样本数量的不断增加,3种方法的识别准确率均得到有效提升,当样本数量达到2 200张时,本文方法的准确率达到了99.4%,表明数据集的大小会影响识别的准确率,扩增温度值图像数据集具有重要意义。

5. 结束语

本文针对变电设备红外图像中温度值图像数据集样本少、分布不均衡的问题,在分析温度值图像特征的基础上,提出了一种基于循环互相关系数的CGAN温度值图像扩增方法,通过计算循环互相关系数改进损失函数,提高生成图像的质量。经过生成器网络和判别器网络之间的对抗训练,生成图像清晰、细节信息丰富的温度值图像。本文方法在迭代次数达到1 800次时更快地达到纳什平衡,训练过程平稳。与传统方法和原始CGAN模型相比,本文方法生成图像的PSNR和SSIM值均达到最大,有效提高了生成图像的质量,图像轮廓清晰,与原始图像之间有更高的相似性;采用CNN模型对扩增后的数据集进行温度识别,本文方法的准确率最高,达到99.4%。此外,随着生成图像样本数量的增加,模型识别的准确率得到有效提升,对小样本数据集扩增具有重要意义,提高了图像之间的匹配度,为后续的缺陷检测做充分准备。

-

表 1 网络参数设置

Table 1 Network parameter setting

层 层类型 生成器网络 判别器网络 输入特征 神经元数 输出特征 输入特征 神经元数 输出特征 0 输入层 噪声100×32 100×32 图像256×32 256×32 标签32 标签32 1 全连接层FC1 100×32 256×100 256×32 256×32 1 024×256 1 024×32 2 激活层A1 256×32 256×32 1024×32 1 024×32 3 全连接层FC2 256×32 512×256 512×32 1024×32 512×1 024 512×32 4 激活层A2 512×32 512×32 512×32 512×32 续表 1 层 层类型 生成器网络 判别器网络 输入特征 神经元数 输出特征 输入特征 神经元数 输出特征 5 全连接层FC3 512×32 1 024×512 1 024×32 512×32 256×512 256×32 6 激活层A3 1 024×32 1 024×32 256×32 256×32 7 全连接层FC4 1 024×32 256×1 024 256×32 256×32 1×256 1×32 8 激活层A4 256×32 256×32 1×32 1×32 表 2 原始温度值图像数据集

Table 2 Original temperature image data set

标签 数量 标签 数量 – 20 5 49 0 60 6 38 1 149 7 46 2 179 8 36 3 184 9 43 4 72 / / 表 3 11种标签的循环互相关系数

Table 3 Cyclic cross-correlation coefficients of 11 labels

标签 − 0 1 2 3 4 5 6 7 8 9 − 0.951 0.295 0.245 0.541 0.128 0.083 0.606 0.662 0.323 0.655 0.674 0 0.295 0.914 0.470 0.376 0.313 0.425 0.310 0.284 0.473 0.232 0.286 1 0.245 0.470 0.962 0.284 0.263 0.325 0.259 0.231 0.385 0.199 0.237 2 0.541 0.376 0.284 0.945 0.235 0.157 0.406 0.420 0.522 0.509 0.562 3 0.128 0.313 0.263 0.235 0.936 0.111 0.092 0.028 0.254 0.001 0.052 4 0.128 0.313 0.263 0.235 0.678 0.922 0.092 0.028 0.254 0.001 0.052 5 0.606 0.310 0.259 0.406 0.092 0.109 0.947 0.735 0.369 0.607 0.560 6 0.662 0.284 0.231 0.420 0.028 0.104 0.735 0.935 0.284 0.699 0.571 7 0.323 0.473 0.385 0.522 0.254 0.334 0.369 0.284 0.947 0.277 0.335 8 0.655 0.232 0.199 0.509 0.001 0.049 0.607 0.699 0.277 0.951 0.698 9 0.674 0.286 0.237 0.562 0.052 0.068 0.560 0.571 0.335 0.698 0.904 表 4 不同图像扩增方法的客观评价指标

Table 4 Objective evaluation index of different methods

标签 传统方法 原始CGAN 改进CGAN PSNR SSIM PSNR SSIM PSNR SSIM − 30.326 0.761 32.399 0.828 34.336 0.839 0 31.995 0.650 35.053 0.751 36.001 0.863 1 33.838 0.756 33.992 0.783 36.928 0.820 2 30.846 0.279 29.470 0.532 32.192 0.574 3 30.273 0.582 30.404 0.707 34.836 0.816 续表 4 标签 传统方法 原始CGAN 改进CGAN PSNR SSIM PSNR SSIM PSNR SSIM 4 30.773 0.507 30.343 0.566 31.599 0.677 5 30.522 0.747 29.926 0.742 33.244 0.894 6 30.317 0.806 31.324 0.717 33.728 0.808 7 31.690 0.504 32.080 0.561 33.616 0.617 8 31.232 0.727 29.051 0.842 33.557 0.853 9 30.930 0.577 31.688 0.700 31.943 0.706 -

[1] 蒲天骄, 乔骥, 韩笑, 等. 人工智能技术在电力设备运维检修中的研究及应用[J]. 高电压技术, 2020, 46(2): 369–383. PU Tianjiao, QIAO Ji, HAN Xiao, et al. Research and application of artificial intelligence in operation and maintenance for power equipment[J]. High voltage engineering, 2020, 46(2): 369–383. [2] CHEN Junwen, LIU Zhigang, WANG Hongrui, et al. Automatic defect detection of fasteners on the catenary support device using deep convolutional neural network[J]. IEEE transactions on instrumentation and measurement, 2018, 67(2): 257–269. [3] 王有元, 李后英, 梁玄鸿, 等. 基于红外图像的变电设备热缺陷自调整残差网络诊断模型[J]. 高电压技术, 2020, 46(9): 3000–3007. WANG Youyuan, LI Houying, LIANG Xuanhong, et al. Self-adjusting residual network diagnosis model for substation equipment thermal defects based on infrared image[J]. High voltage engineering, 2020, 46(9): 3000–3007. [4] 何佳美. 基于生成对抗网络的电力设备图像扩充模型及算法研究[D]. 成都: 电子科技大学, 2020: 1–60. HE Jiamei. Research on image expansion model and algorithm of power equipment based on generative adversarial network[D]. Chengdu: University of Electronic Science and Technology of China, 2020: 1–60. [5] 黄锐勇, 戴美胜, 郑跃斌, 等. 电力设备红外图像缺陷检测[J]. 中国电力, 2021, 54(2): 147–155. HUANG Ruiyong, DAI Meisheng, ZHENG Yuebin, et al. Defect detection of power equipment by infrared image[J]. Electric power, 2021, 54(2): 147–155. [6] CAO Xinhua, LI Taihao, LI Hongli, et al. A robust parameter-free thresholding method for image segmentation[J]. IEEE access, 2018, 7: 3448–3458. [7] 毕晓君, 潘梦迪. 基于生成对抗网络的机载遥感图像超分辨率重建[J]. 智能系统学报, 2020, 15(1): 74–83. BI Xiaojun, PAN Mengdi. Super-resolution reconstruction of airborne remote sensing images based on the generative adversarial networks[J]. CAAI transactions on intelligent systems, 2020, 15(1): 74–83. [8] REN Fuji, LIU Wenjie, WU Guoqing. Feature reuse residual networks for insect pest recognition[J]. IEEE access, 2019, 7: 122758–122768. [9] HUANG Zhong, REN Fuji. Facial expression recognition based on multi-regional D-S evidences theory fusion[J]. IEEJ transactions on electrical and electronic engineering, 2017, 12(2): 251–261. [10] YI Zili, CHEN Zhiqin, CAI Hao, et al. BSD-GAN: branched generative adversarial network for scale-disentangled representation learning and image synthesis[J]. IEEE transactions on image processing, 2020, 29: 9073–9083. [11] GOODFELLO I J, POUGET ABADIE J, MIRZA M, et al. Generative adversarial networks[J]. Communications of the ACM. 2020, 63(11): 139–144. [12] HAN Wei, WANG Lizhe, FENG Ruyi, et al. Sample generation based on a supervised wasserstein generative adversarial network for high-resolution remote-sensing scene classification[J]. Information sciences, 2020, 539: 177–194. [13] SONG Jingkuan, HE Tao, GAO Lianli, et al. Unified binary generative adversarial network for image retrieval and compression[J]. International journal of computer vision, 2020, 128(8): 2243–2264. [14] GUO Runyuan, LIU Han, XIE Guo, et al. Weld defect detection from imbalanced radiographic images based on contrast enhancement conditional generative adversarial network and transfer learning[J]. IEEE sensors journal, 2021, 21(9): 10844–10853. [15] LI Jiaosheng, LI Yuhui, LI Ju, et al. Single exposure optical image watermarking using a cGAN network[J]. IEEE photonics journal, 2021, 13(2): 6900111. [16] 黄远, 白琮, 李宏凯, 等. 基于条件生成对抗网络的图像描述生成方法[J]. 计算机辅助设计与图形学学报, 2020, 32(6): 911–918. HUANG Yuan, BAI Cong, LI Hongkai, et al. Image captioning based on conditional generative adversarial Nets[J]. Journal of Computer-aided design & computer graphics, 2020, 32(6): 911–918. [17] 于文家, 丁世飞. 基于自注意力机制的条件生成对抗网络[J]. 计算机科学, 2021, 48(1): 241–246. YU Wenjia, DING Shifei. Conditional generative adversarial network based on self-attention mechanism[J]. Computer science, 2021, 48(1): 241–246. [18] 陈佛计, 朱枫, 吴清潇, 等. 生成对抗网络及其在图像生成中的应用研究综述[J]. 计算机学报, 2021, 44(2): 347–369. CHEN Foji, ZHU Feng, WU Qingxiao, et al. A survey about image generation with generative adversarial nets[J]. Chinese journal of computers, 2021, 44(2): 347–369. [19] 朱奇光, 张朋珍, 李昊立, 等. 基于全局和局部特征融合的图像匹配算法研究[J]. 仪器仪表学报, 2016, 37(1): 170–176. ZHU Qiguang, ZHANG Pengzhen, LI Haoli, et al. Investigation on the image matching algorithm based on global and local feature fusion[J]. Chinese journal of scientific instrument, 2016, 37(1): 170–176. [20] TANG Fashuai, GAO Qi, DU Zongzhan. Algorithm of object localization applied on high-voltage power transmission lines based on line stereo matching[J]. Optical engineering, 2021, 60(2): 023101. [21] 曹玉东, 蔡希彪. 基于增强型对抗学习的无参考图像质量评价算法[J]. 计算机应用, 2020, 40(11): 3166–3171. CAO Yudong, CAI Xibiao. No-reference image quality assessment algorithm with enhanced adversarial learning[J]. Journal of computer applications, 2020, 40(11): 3166–3171. [22] 方玉明, 眭相杰, 鄢杰斌, 等. 无参考图像质量评价研究进展[J]. 中国图象图形学报, 2021, 26(2): 265–286. FANG Yuming, SUI Xiangjie, YAN Jiebin, et al. Progress in no-reference image quality assessment[J]. Journal of image and graphics, 2021, 26(2): 265–286. [23] 王耀领, 王宏琦, 许滔. CGAN样本生成的遥感图像飞机识别[J]. 中国图象图形学报, 2021, 26(3): 663–673. WANG Yaoling, WANG Hongqi, XU Tao. Aircraft recognition of remote sensing image based on sample generated by CGAN[J]. Journal of image and graphics, 2021, 26(3): 663–673. [24] 王伟, 刘辉, 杨俊安. 一种特征字典映射的图像盲评价方法研究[J]. 智能系统学报, 2018, 13(6): 989–993. WANG Wei, LIU Hui, YANG Jun’an. Blind quality evaluation with image features codebook mapping[J]. CAAI transactions on intelligent systems, 2018, 13(6): 989–993. [25] 祝钧桃, 姚光乐, 张葛祥, 等. 深度神经网络的小样本学习综述[J]. 计算机工程与应用, 2021, 57(7): 22–33. ZHU Juntao, YAO Guangle, ZHANG Gexiang, et al. Survey of few shot learning of deep neural network[J]. Computer engineering and applications, 2021, 57(7): 22–33.

下载:

下载: