水雷目标检测对于排除航道上的危险、保障战舰和货船的安全通行具有特别重要的意义。由于声波作用距离远,侧扫声呐、前视声呐等各种声呐设备是当前水雷目标探测主要采用的装备。侧扫声呐基于声学散射原理来探测海底地貌和凸起物体[1],接收到的回波经过处理后以瀑布图像的形式显示,可以获得海底地貌和障碍物等重要信息。

水雷目标的探测和识别,当前仍然依赖人工对声呐获取的图像进行判读,效率较低,难以适应潜航器大面积智能、快速扫雷的需求。如何实现水雷目标的精确检测,是亟待解决的难题[2]。水雷目标的自动检测通常分为两步:第一步首先检测出所有可能的疑似水雷目标,侧扫声呐图像分割方法[3-4]能够区分目标高亮区、阴影区和背景混响区,可用于标记所有可疑水雷目标;第二步,对每个目标进行特征提取和判别,判断其是否属于水雷目标。

在深度学习兴起之前,传统的检测方法大多使用先验知识或数据驱动的方法来识别类水雷目标,通过从目标中提取的特征信息与训练数据进行比较,当两者的相似度非常高时,这些方法可以有较高的精度[5]。Bryner等[6]提出一种形状先验知识指导的主动轮廓跟踪方法提取声呐图像中的目标轮廓进而实现目标分割。Raquel等[7]提出一种基于分类的声呐图像水底目标检测系统中最优特征级的设计方法,通过对感兴趣区域的分割完成目标高亮及阴影区域的分割。Cho等[8]尝试通过多角度水雷目标模拟和模板匹配来提高识别精度。Sawas提出了无先验知识的局部特征描述子,如采用Haar-like特征[9]识别水雷。

以上检测方法中使用人工提取特征的方式并配合支持向量机、boosting等不同的分类器[10]进行检测分类,这样的方法对于特定的任务有较好的性能,但是人工提取特征需要专业的知识,成本较高且泛化能力有限。当训练数据不平衡时,必须仔细地选择特征并反复调整分类器,识别率很难达到实用要求。相较于传统的识别方法,深度学习在特征提取方面有着突出优势,其通过多层抽象学习到目标的数据表征,从而省去了人工提取特征的麻烦。自深度学习方法提出以来,卷积神经网络在大样本数据集的光学图像的目标识别已经取得了较大成功[11],然而对水下小样本数据的水雷等水下目标识别还存在较大问题。由于水下实验困难、实验代价较大,获取的水雷目标样本严重不足。因此,直接采用小样本数据集对深度神经网络进行训练得到的模型存在突出的过拟合问题,泛化能力往往非常差,难以实际应用。

针对上述水雷目标检测与识别中的问题,提出使用样本仿真的方法来增广数据,同时结合迁移学习的方法来解决水下图像样本数据不足的问题,并基于深层卷积神经网络进行检测,最终通过有效的目标检测模型实现侧扫声呐图像水雷目标的检测与识别,为水雷目标检测提供有益借鉴。

1 侧扫声呐目标图像仿真 1.1 样本仿真由于实验困难和经济成本等因素,水雷目标声呐图像获取困难,难以得到充分的真实样本数据。因此,我们首先考虑通过仿真计算的方法建立声呐模型,对水雷目标进行仿真,以增广样本数据集。水下目标受距离和高度的影响,在图像上占像素点的面积不同,通过对不同高度和距离下的目标进行仿真,可以增广出一组高度和距离均不同的目标图像。同时,由于水下声呐成像时受到海底混响的影响,我们要在模型中加入背景混响模型,从而增广出含有不同背景混响的水雷目标声呐图像,以此提升仿真数据对不同混响背景下目标检测的鲁棒性。

声呐图像是目标回波的强度图像,一般亮色代表回波强,暗色代表回波弱,被遮挡区域不产生回波,因此仿真的样本最终也以灰度图像形式输出。

1.2 仿真数学模型水雷目标的几何形态较为简单、规则,因此对水雷目标的仿真可以设计出准确的仿真模型,通过目标阴影生成仿真计算得到水雷目标图像的亮区与暗区,并经过背景模拟与灰度调整得到最终的水雷目标仿真图。

设声呐点为P,距离海底高度为H,

|

Download:

|

| 图 1 目标阴影生成仿真原理 Fig. 1 Simulation schematic diagram of shadow generation of target | |

亮区两侧的坐标表达式如下:

| $\left\{ \begin{array}{l} {\left( {x - a} \right)^2} + {\left( {y - b} \right)^2} = {r^2} \\ y = \dfrac{{\left( {p - a} \right)\left( {q - b} \right) \pm r\sqrt {{{\left( {p - a} \right)}^2} + {{\left( {q - b} \right)}^2} - {r^2}} }}{{{{\left( {p - a} \right)}^2} - {r^2}}}\left( {x - p} \right) + q \end{array} \right.$ | (1) |

暗区两侧的坐标表达式如下:

| $y = \frac{{\left( {p - a} \right)\left( {q - b} \right) \pm r\sqrt {{{\left( {p - a} \right)}^2} + {{\left( {q - b} \right)}^2} - {r^2}} }}{{{{\left( {p - a} \right)}^2} - {r^2}}}\left( {x - p} \right) + q$ | (2) |

式(1)中,p, q为声呐点坐标;a, b为模拟目标横截面中心;r为模拟目标半径;式(2)中当y=0时即可得到目标暗区部分范围。

海底的不平整性和底质的非均匀性会产生海底混响,它是一个无规则的随机过程,导致声呐图像背景噪声较强。研究表明,声呐图像的海底混响背景的灰度级服从Weibull分布,通过对Weibull模型中参数取值不同可以得到多种不同的背景分布,如式(3)所示:

| $f(x;\lambda ,k) = \dfrac{k}{\lambda }{\left(\dfrac{x}{\lambda }\right)^{k - 1}}{{\rm{e}}^{ - (x/\lambda )}}$ | (3) |

式中:x是随机变量,

通过对Weibull分布模型的自由度参数进行不同取值,得到不同强度的背景混响。部分水雷目标图像的仿真结果如图2所示。

|

Download:

|

| 图 2 水雷目标样本仿真结果 Fig. 2 Mine sample simulation results | |

Faster R-CNN是“Fast R-CNN+RPN”的系统[12],基本结构如图3所示,是一种交替优化网络,可以使两个卷积网络实现共享,通过两个训练网络相互协调来对目标进行检测。Faster R-CNN抛弃了传统的滑动窗口和SS方法(selective search),直接使用RPN生成候选框。RPN网络能够从输入的特征图产生前景候选框和前景框的位置偏移,并且也能加快生成候选框的速度。Fast R-CNN主要负责边框回归及分类,与RPN的特征共享有效提高了检测精度和检测效率。

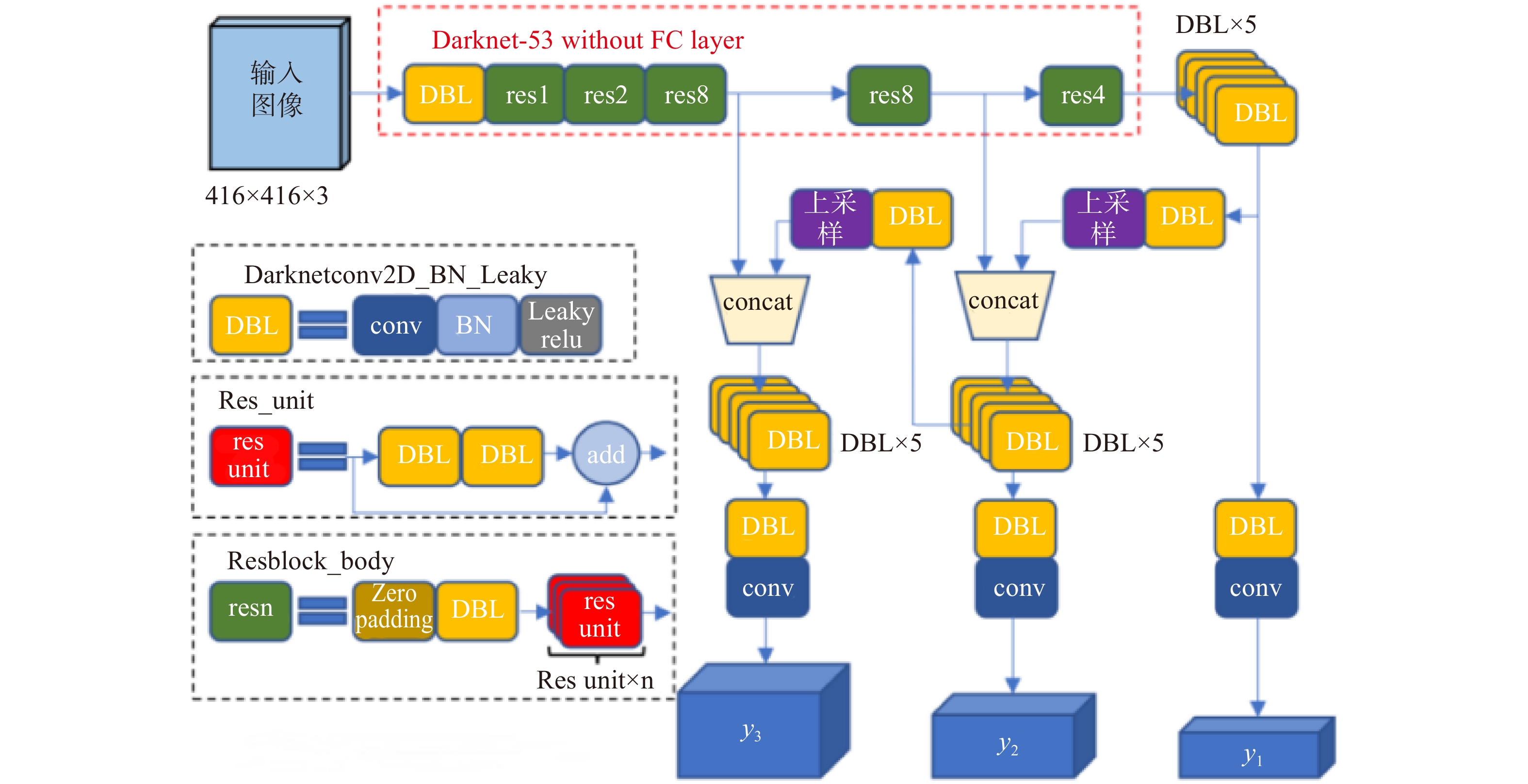

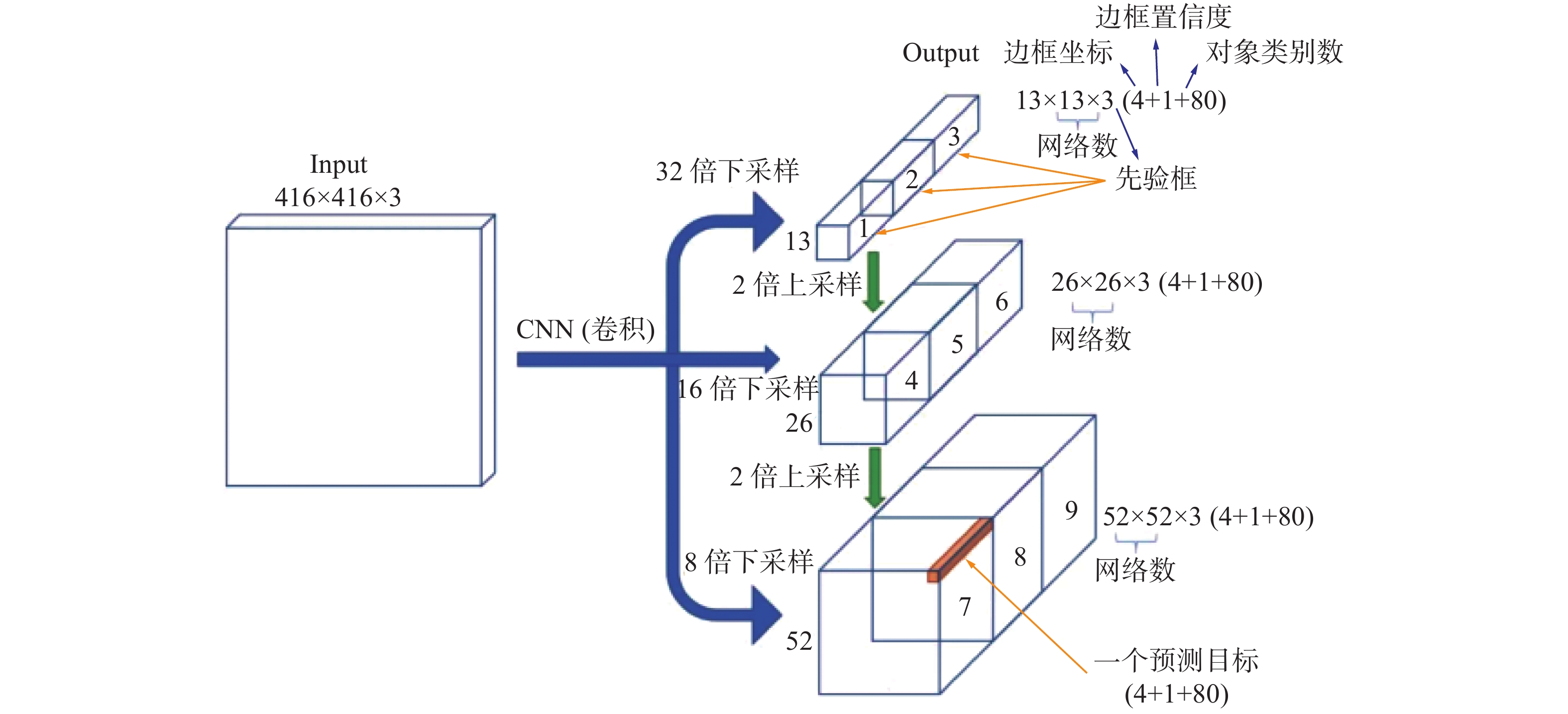

YOLOv3是YOLO系列第三版,是基于回归的深度卷积神经网络[13],其模型结构如图4所示。YOLOv3速度快,并且能发挥多核处理器和GPU并行运算的功能。除此以外,YOLOv3会对图像的全局区域进行训练,能够更好地区分目标和背景,因此在中小尺寸的目标检测上准确率较高。YOLOv3的主干网络由全连接卷积层构成,采用多标签的方式替代了之前的softmax单标签方式。YOLOv3同时具有多尺度检测的优势,在3种不同的特征尺度上进行检测可以适应更多的检测识别任务。

|

Download:

|

| 图 3 Faster R-CNN模型结构 Fig. 3 Structure of the Faster R-CNN model | |

SSD是一种单阶段的物体检测算法[14],其模型结构如图5所示。SSD的核心设计理念是采用多尺度特征图做预测,并通过卷积或池化降低特征图大小,使用较大的特征图来检测较小的目标,相反较小的特征图用于检测较大的目标。SSD具有回归功能,通过卷积在不同的特征图上提取检测结果。SSD还借鉴了Faster R-CNN中锚点的理念,通过尺度及长宽比各不相同的先验框来生成预测的边界框,一定程度上减少了训练难度。

研究表明,Faster R-CNN、SSD和YOLOv3这3种方法在检测速度和精度上都有较好的表现,因此文中使用这3种方式进行水雷目标检测并对比检测结果。

|

Download:

|

| 图 4 YOLOv3模型结构 Fig. 4 Structure of the YOLOv3 model | |

|

Download:

|

| 图 5 SSD模型结构 Fig. 5 Structure of the SSD model | |

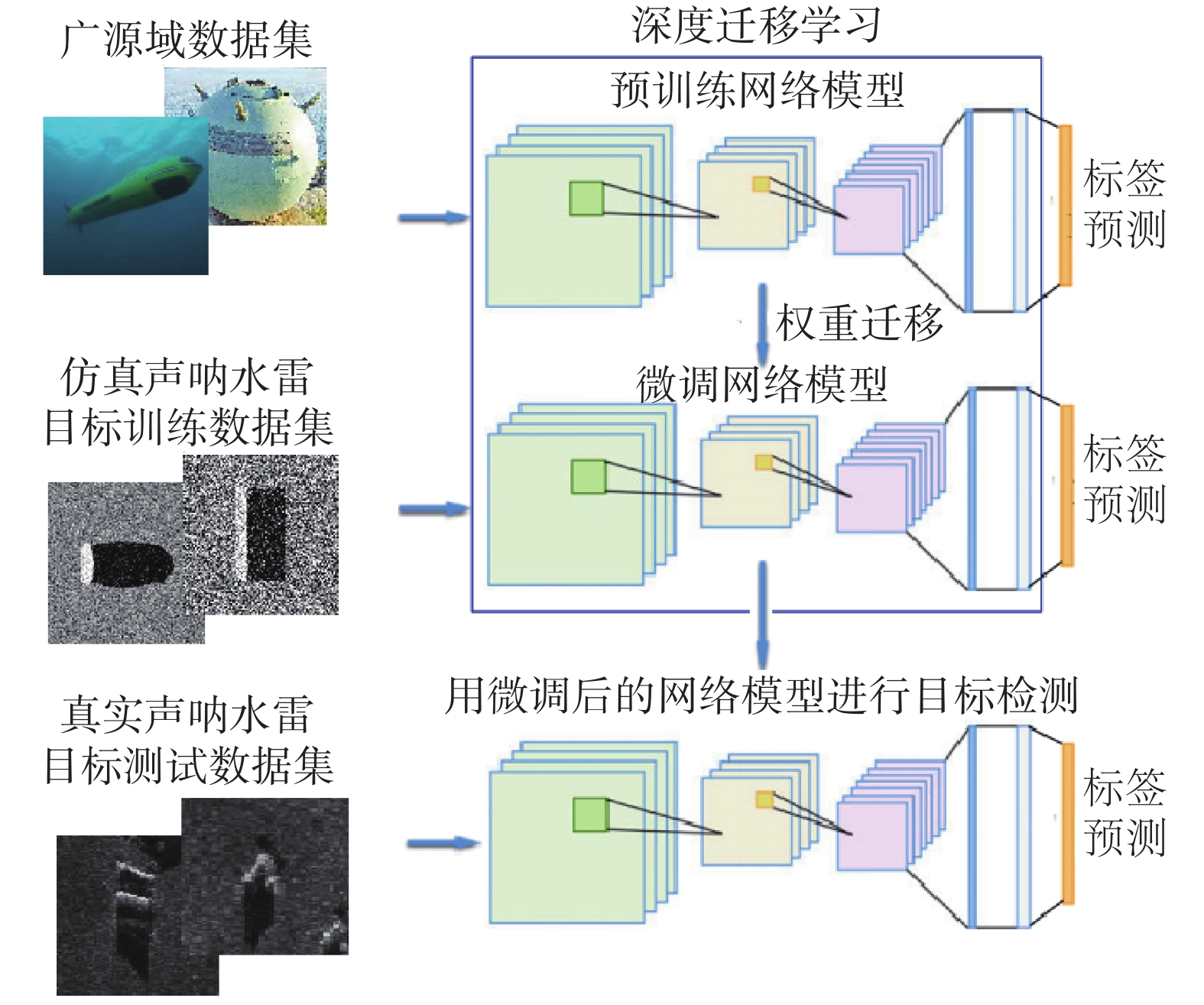

深度学习通常需要数千张样本数据,预训练配合参数调整是目前深度学习中主要的参数学习方式[15],通常会采用广源域数据集ImageNet对模型进行预训练以初始化模型参数。在样本数据较少的情况下我们可以采用迁移学习的方式将知识从源域转移到目标域以此来克服数据不足的困难,文中所使用的结合样本仿真的迁移学习过程如图6所示。

|

Download:

|

| 图 6 迁移学习过程 Fig. 6 Process of transfer learning | |

根据源域和目标域之间的关系,迁移学习方法可以分为四大类[16]:基于实例的迁移、基于特征的迁移、基于参数/模型的迁移和基于关系的迁移。基于模型的深度迁移学习是最普遍的一种,大量研究表明,从源域中的大型基准数据集中学习的预训练模型比直接迁移学习更有效[17-18],原因是基于模型的深度迁移学习的一大优势是深层网络的中低级特征对不同的任务是通用的[19]。

2.3 神经网络训练策略为了弥补样本数量的不足及提高图像检测的精度,使用迁移学习的方式将仿真数据作为样本数据集对网络进行训练,以此实现对真实数据的检测与识别。

具体的训练步骤如下:

1)使用ImageNet数据集对VGG16、Darknet53进行预训练,以得到一个较合理的初始参数。经过预训练的网络对图像的边缘、纹理等底层信息敏感,具备对图像特征的表达能力。因为网络的底层卷积提取的中低级特征对不同的任务通用,所以可使用大数据集来预训练网络。

2)将通过仿真获取的样本数据集对步骤1)中预训练好的网络进行更深一步的训练,因为预训练模型对低层特征的能力较强,可以固定底层卷积的参数,将高层卷积部分继续训练,经过微调可以较快达到最优值。

3)训练完成后对网络的检测效果进行测试,使用真实的声呐样本进行检测与识别,比较不同方法在训练时间、平均精度以及查准率和查全率上的区别。如果准确率能够达到识别任务的要求,则可以将训练好的网络用于该应用中。

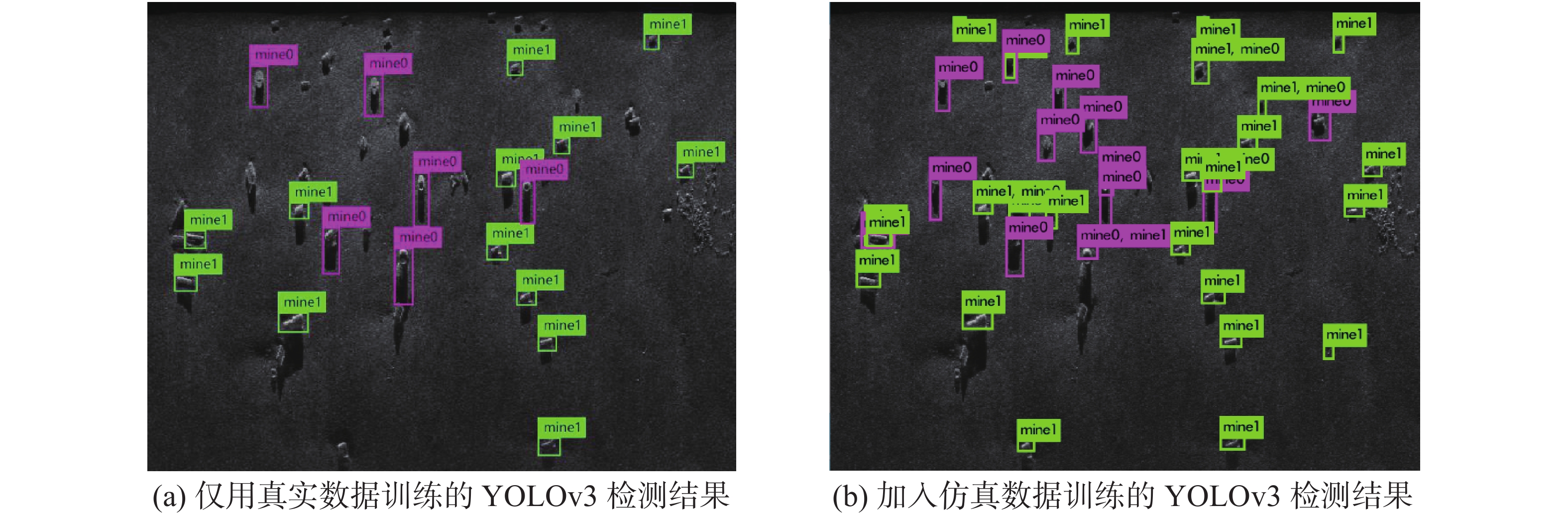

3 目标检测试验结果与分析 3.1 水雷目标仿真样本数据集准备首先采用样本仿真方法得到1000个目标仿真图像,仿真的水雷目标为球状、柱状两种形状类型,背景假定为平坦的海底;然后加入真实的水雷目标声呐图像200张;利用图像标注工具labelImg手动标注水雷目标并以xml格式保存。从数据集中随机选取200张,总共标注473个样本,作为交叉验证集;剩余的1000张总共标注2342个样本作为训练集。柱状水雷目标的类别设置为mine0,球状水雷目标的类别设置为mine1。

3.2 水雷目标声呐图像测试集检测结果用真实的声呐图像对训练好的网络进行检测,一方面验证迁移学习的可行性,另一方面对三种网络的检测结果进行无偏估计。为验证所提出方法的有效性,同时使用样本仿真训练数据和迁移学习。

将训练数据集送入卷积神经网络中进行训练,首先由输入层输入训练数据,经过多层卷积后得到深层次的特征图;然后通过激活函数加入非线性因素;再通过池化层压缩得到的特征图,以突出主要的特征并减少检测模型的计算量;最后通过全连接层连接所有特征,并输出到分类器中进行分类。图7为YOLOv3算法流程的总体框图。

训练检测模型与检测水雷目标时的参数设置和训练时长见表1,不同方法检测的mAP结果见表2。

网络在检测结果输出前根据设定的阈值判断是正样本还是伪样本,结果小于阈值的目标丢弃,结果大于阈值的目标则保留。表1中的阈值为多次训练与检测后根据结果选取的最优值。

使用基于Haar-like特征的Adaboost水下目标检测方法对侧扫声呐图像水雷目标数据集中检测准确率为79%,这说明传统的特征提取方法对于噪声较强的水下目标检测的鲁棒性较差。使用Faster R-CNN和YOLOv3两种目标检测方法的准确率均比该传统目标检测方法有显著提升(准确率提升了约12%)。YOLOv3由于深度和结构不同,并且大量使用了残差的跳层链接,很大程度上加快了训练与检测的速度。Faster R-CNN网络相对YOLOv3来说耗时稍长,但准确率相近。SSD网络的检测效果并不理想,原因是其训练网络的深度不够,无法有效地提取到样本中的关键信息。

|

Download:

|

| 图 7 YOLOv3算法流程框图 Fig. 7 Block diagram of YOLOv3 | |

| 表 1 网络训练与检测参数、时间 Tab.1 Network training and detection parameters, time |

| 表 2 不同方法水雷图像测试集检测mAP结果 Tab.2 Detection of mAP results from underwater mine image test set by different methods |

图8和图9分别为YOLOv3网络和Faster R-CNN网络在不同测试数据下的最终检测结果:图8(a)和图9(a)是仅使用真实数据进行训练和检测的效果,图8(b)和图9(b)则是结合了真实数据和仿真数据进行训练和检测的效果。可以看到同时使用真实数据和仿真数据进行训练对检测效果的提升比较明显,即使是在噪声干扰较大,背景与目标边缘较模糊的条件下,YOLOv3网络和Faster R-CNN仍然能够比较准确地检测出水雷目标。实验结果表明,样本仿真结合迁移学习的方法能够有效提升基于深度学习的水雷目标检测准确率,相比传统的检测方法检测效果提升明显。而且,随着水雷目标的仿真数据和真实数据的增多,深度卷积神经网络具有继续提高检测精度的优势,对水雷目标检测具有重要的意义。

|

Download:

|

| 图 8 YOLOv3检测结果 Fig. 8 Detection results of YOLOv3 | |

|

Download:

|

| 图 9 Faster R-CNN检测结果 Fig. 9 Detection results of Faster R-CNN | |

本文实现了水雷目标声呐图像仿真,扩增了数据集,为水下数据获取难度高、成本大的问题提供了一个切实可行的解决方案;同时,基于深度卷积神经网络的特征提取优势,结合样本仿真和迁移学习提升了深度学习的准确性,避免了深度学习对小样本学习不足的问题。实验结果表明,在样本仿真和迁移学习的基础上,YOLOv3对水雷目标的检测精度更高,速度更快。这一实验结果为水雷目标的检测提供了重要的借鉴。本文仿真的水雷形状规则,并假设海底平坦,在面对复杂地形环境和不规则目标的任务时有一定的局限性。下一步的工作将继续提高仿真模型的复杂度和适应性,同时考虑其他数据生成方式,例如基于生成式对抗网络的数据生成方式,以进一步提升检测精度。此外,由于迁移学习的本质是利用不同任务之间的相关性,在预训练模型的基础上冻结部分网络并对参数做精细的调优,因此,如何结合强化学习进行更细致的参数训练并对网络结构进行更加深入的调整,也需要进一步深入考虑。

| [1] |

KUMAR N, MITRA U, NARAYANAN S. Robust object classification in underwater sidescan sonar images by using reliability-aware fusion of shadow features[J]. IEEE journal of oceanic engineering, 2015, 40(3): 592-606. DOI:10.1109/JOE.2014.2344971 ( 0) 0)

|

| [2] |

BARNGROVER C, ALTHOFF A, DEGUZMAN P, et al. A brain-computer interface (BCI) for the detection of mine-like objects in sidescan sonar imagery[J]. IEEE journal of oceanic engineering, 2016, 41(1): 123-138. DOI:10.1109/JOE.2015.2408471 ( 0) 0)

|

| [3] |

ACOSTA G G, VILLAR S A. Accumulated CA-CFAR process in 2-D for online object detection from sidescan sonar data[J]. IEEE journal of oceanic engineering, 2015, 40(3): 558-569. DOI:10.1109/JOE.2014.2356951 ( 0) 0)

|

| [4] |

BARNGROVER C, KASTNER R, BELONGIE S. Semisynthetic versus real-world sonar training data for the classification of mine-like objects[J]. IEEE journal of oceanic engineering, 2015, 40(1): 48-56. DOI:10.1109/JOE.2013.2291634 ( 0) 0)

|

| [5] |

DANIEL S, Le LEANNEC F, ROUX C, et al. Side-scan sonar image matching[J]. IEEE journal of oceanic engineering, 1998, 23(3): 254-259. ( 0) 0)

|

| [6] |

BRYNER D, SRIVASTAVA A, HUYNH Q. Elastic shapes models for improving segmentation of object boundaries in synthetic aperture sonar images[J]. Computer vision and image understanding, 2013, 117(12): 1695-1710. DOI:10.1016/j.cviu.2013.07.001 ( 0) 0)

|

| [7] |

FANDOS R, ZOUBIR A M. Optimal feature set for automatic detection and classification of underwater objects in SAS images[J]. IEEE journal of selected topics in signal processing, 2011, 5(3): 454-468. DOI:10.1109/JSTSP.2010.2093868 ( 0) 0)

|

| [8] |

CHO H, GU J, YU S C. Robust sonar-based underwater object recognition against angle-of-view variation[J]. IEEE sensors journal, 2016, 16(4): 1013-1025. DOI:10.1109/JSEN.2015.2496945 ( 0) 0)

|

| [9] |

SAWAS J, PETILLOT Y, PAILHAS Y. Cascade of boosted classifiers for rapid detection of underwater objects[C]//Proceedings of the European Conference on Underwater Acoustics. [S.l.]2010, 10: 1−8.

( 0) 0)

|

| [10] |

FEI Tai, KRAUS D, ZOUBIR A M. Contributions to automatic target recognition systems for underwater mine classification[J]. IEEE transactions on geoscience and remote sensing, 2015, 53(1): 505-518. DOI:10.1109/TGRS.2014.2324971 ( 0) 0)

|

| [11] |

SUN Yi, WANG Xiaogang, TANG Xiaoou. Deep learning face representation from predicting 10, 000 classes[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, USA, 2014: 1891−1898.

( 0) 0)

|

| [12] |

REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 ( 0) 0)

|

| [13] |

REDMON J, FARHADI A. YOLOv3: an incremental improvement [J]. arXiv e-prints arXiv: 1804.02767, 2018.

( 0) 0)

|

| [14] |

LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: single shot multibox detector[J]. arXiv preprint arXiv: 1512.02325, 2016.

( 0) 0)

|

| [15] |

YOSINSKI J, CLUNE J, BENGIO Y, et al. How transferable are features in deep neural networks?[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal, Canada, 2014: 3320−3328.

( 0) 0)

|

| [16] |

PAN S J, YANG Qiang. A survey on transfer learning[J]. IEEE transactions on knowledge and data engineering, 2010, 22(10): 1345-1359. DOI:10.1109/TKDE.2009.191 ( 0) 0)

|

| [17] |

WANG Yuanyuan, WANG Chao, ZHANG Hong, et al. A SAR dataset of ship detection for deep learning under complex backgrounds[J]. Remote sensing, 2019, 11(7): 765. DOI:10.3390/rs11070765 ( 0) 0)

|

| [18] |

HUO Guanying, WU Ziyin, LI Jiabiao. Underwater object classification in sidescan sonar images using deep transfer learning and semisynthetic training data[J]. IEEE access, 2020, 8: 47407-47418. DOI:10.1109/ACCESS.2020.2978880 ( 0) 0)

|

| [19] |

OQUAB M, BOTTOU L, LAPTEV L, et al. Learning and transferring mid-Level image representations using convolutional neural networks[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, USA, 2014: 1717−1724.

( 0) 0)

|

2021, Vol. 16

2021, Vol. 16