2. 中央民族大学 信息工程学院,北京 100081

2. School of Information Engineering, Minzu University of China, Beijing 100081, China

行人重识别是利用计算机视觉技术来判断无视角交叠摄像头间是否存在相同行人的技术。行人重识别技术作为提升智能监控系统自动化程度的关键技术已经成为研究热点,该技术常与行人检测与跟踪技术结合,广泛用于智能视频监控与公共安防的刑侦工作等。目前,深度学习理论[1]在各个领域都大放异彩,现在行人重识别领域[2]最优秀的模型都是基于深度学习的方法。

基于深度学习的行人重识别方法主要分为2大类,有监督学习的行人重识别[3-4]和无监督学习的行人重识别[5-8]。有监督学习需要大量的标注样本指导模型训练,由于实际应用中样本标注的成本十分昂贵,无监督学习的行人重识别方法不需要大量的有标签样本,因此无监督方法更具有实际应用价值。无监督方法较有监督方法更难实现,源域和目标域间的差异性过大是目前该领域需要解决的问题。截止到目前,对于无监督行人重识别,国外研究刚刚起步,而在国内还属于研究空白。因此,无监督学习的行人重识别方法研究具有重大意义。

目前,无监督行人重识别的研究工作中,均使用有标签源域数据对模型进行预训练,用无标签的目标域数据对模型进行正式训练以及测试。但是,研究中存在域间差异性过大问题,大幅度影响模型的识别率。2017年,Zhong等[5]首次提出域连接性学习方法构建源域和目标域之间的联系,该方法一定程度上构建了源域与目标域之间的特征空间关系,但没有有效解决域间巨大差异性问题。图像风格转换(image style transfer)是将图像按照参考风格图像进行转换, 最终得到某种特定风格的目标图像的技术,该技术常被应用于图像处理及视频处理,也是无监督行人重识别领域的重要辅助技术。2018年,Deng等[7]提出一种用于无监督行人重识别的风格转换模型(similarity preserving cycleconsistent generative adversarial network, SPGAN),该模型以循环生成对抗网络(cycle-consistent adversarial networks, CycleGAN)[9]为基础框架,引入以目标域的身份作为约束的损失函数,辅助生成器生成目标域风格的行人图片;另外,该模型加入孪生网络(siamese network, SiaNet)以及对应的一致性损失函数,保证行人图片经过转换后其相关身份信息不丢失。但是,SPGAN模型的生成器存在特征转换尺度单一,且特征信息传递效率低的问题,导致其风格转换效果不佳。2019年,Fu等[8]提出一种基于聚类方法的无监督行人重识别模型(self-similarity grouping, SSG),通过对行人特征进行聚类操作寻找目标域数据间的相似性来对特征进行分类,并按照类别赋予行人特征不同的伪标签,最后利用伪标签进行有监督学习,取得了较好的效果。但是SSG模型主要通过挖掘目标域数据间的相似性来降低域间差异性过大的影响,而没有从根本上减小域间差异性,导致模型能力受限。

目前无监督行人重识别领域中,没有工作通过将基于图像生成的风格转换模型引入到基于聚类方法的无监督行人重识别模型中,来降低域间巨大差异性对聚类方法模型性能的影响。为了提升聚类方法无监督行人重识别模型的性能,本文针对SSG模型存在源域和目标域之间差异性较大问题,提出一种基于风格转换的无监督聚类行人重识别方法。首先,将无监督行人重识别领域的风格转换模型SPGAN引入SSG模型中,减少两域间差异性对网络识别效果的影响;然后,针对引入的SPGAN模型的生成器特征转换尺度单一以及特征信息传递效率低的缺点进行改进,提升SPGAN模型的风格转换效果,进一步减少域间差异性对SSG模型的影响,提升SSG网络的识别效果。

1 基于风格转换的无监督聚类行人重识别本文通过提出一种基于风格转换的无监督聚类行人重识别方法,减少域间巨大差异性对模型性能的影响。该方法包含以下2个改进:1)将无监督行人重识别领域的风格转换模型—SPGAN引入到基于聚类方法的无监督行人重识别模型—SSG中,通过风格转换方法降低域间差异性对SSG模型识别率的影响;2)为进一步减小域间巨大差异性的影响,对SPGAN进行改进,通过改进其生成器,解决生成器中特征转换尺度单一以及特征信息传递效率低的问题,提升SPGAN模型的风格转换效果,进一步降低域间差异性对SSG模型识别率的影响。

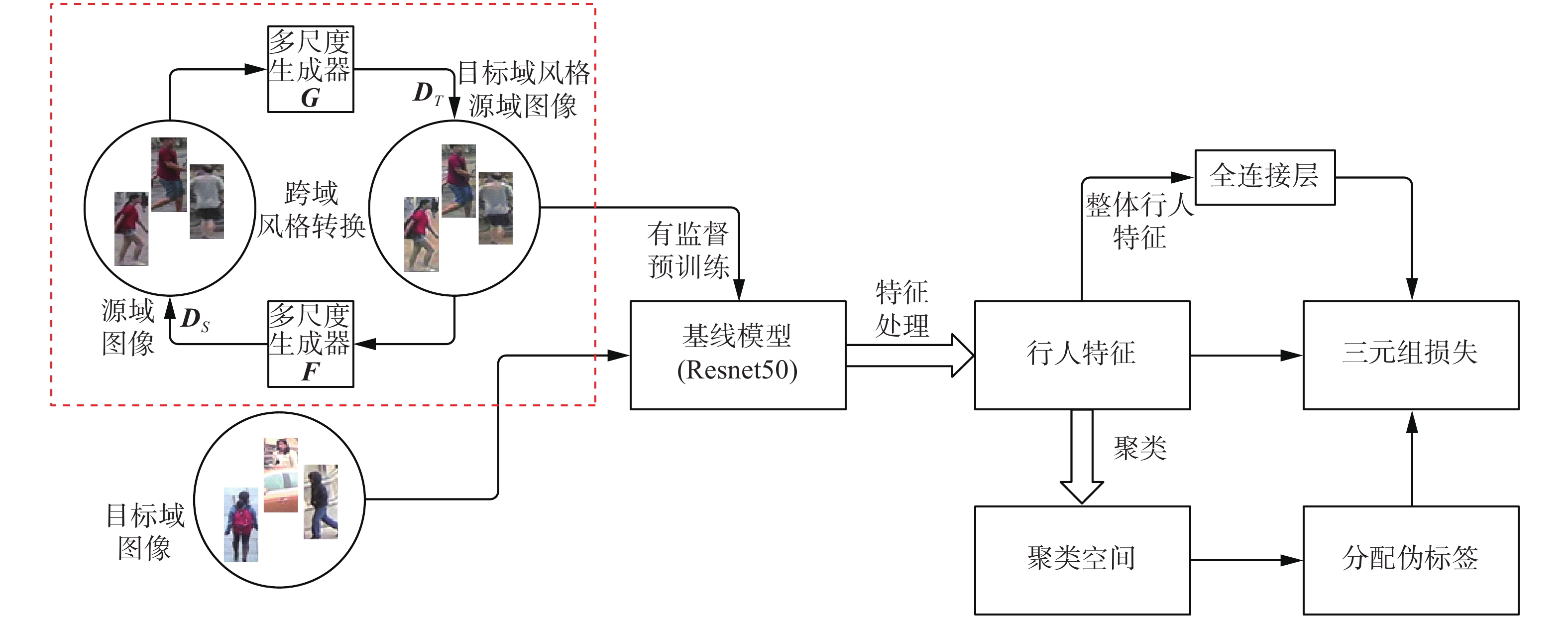

本文提出的整体模型如图1所示,首先,通过基于多尺度特征转换的风格转换模型对源域图像进行风格转换,利用转换图像替代原来的源域图像对模型进行预训练,然后使用聚类方法对目标域数据进行聚类并分配标签,再通过正式训练对预训练模型进行微调。

1.1 基于风格转换的SSG模型无监督聚类的行人重识别模型SSG通过对网络提取的特征进行聚类,并按照聚类结果为它们分配伪标签来训练模型。SSG方法的具体步骤如下:1)使用源域数据预训练Baseline模型;2)将目标域数据输入Baseline模型提取特征;3)通过聚类算法对行人特征进行聚类,并分配伪标签;4)利用带有伪标签的行人特征训练模型。

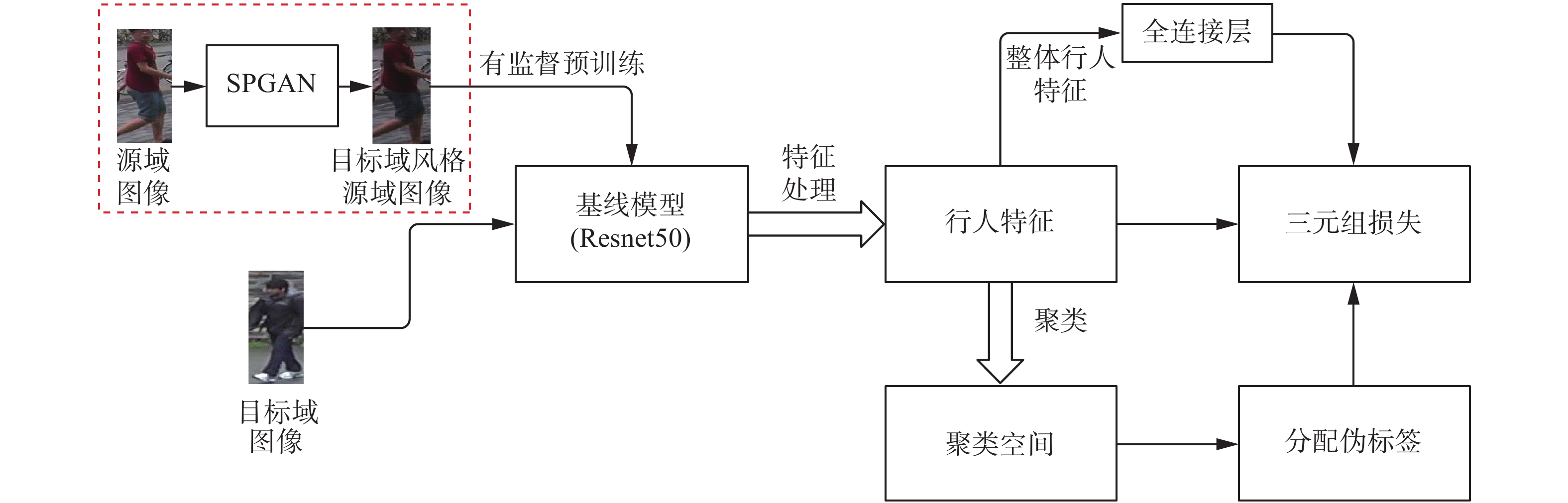

域间差异性过大导致模型最终识别率的下降是目前无监督行人重识别领域的一个重大问题,SSG模型通过聚类方法挖掘目标域数据间的相似性降低源域和目标域间差异性过大对识别率带来的影响。由于Baseline模型使用源域数据进行预训练,挖掘目标域数据间相似性仅可以侧面降低域间差异性对模型识别率的影响。为了进一步降低域间差异性过大对SSG模型的影响,本文将风格转换模型SPGAN引入到 SSG模型中。所提出的基于风格转换的SSG模型如图2所示。

|

Download:

|

| 图 1 基于风格转换的聚类无监督行人重识别模型 Fig. 1 Clustering approach based on style transfer for unsupervised person re-identification model | |

|

Download:

|

| 图 2 基于风格转换的SSG模型 Fig. 2 SSG model based on style transfer | |

首先,利用SPGAN模型对行人重识别的源域及目标域数据集进行风格转换,在光照、分辨率以及相机风格方面,得到更接近目标域风格的有标签数据集;利用转换后源域数据集预训练以ResNet50[10]为基础框架的Baseline模型,得到一个更加适应于目标域的Baseline模型。利用新的Baseline模型对无标签数据进行特征提取,每个行人的特征被提取后复制为2份,一份作为整体行人特征

将3组特征向量分别通过基于密度的聚类方法 (density-based spatial clustering of applications with noise)[11]进行聚类操作,3组特征向量分别进行分类,根据不同组不同类别为每个行人图像分配标签

在新数据集上使用三元组损失函数(batch-hard triplet loss)[12]损失函数对Baseline模型进行微调训练,该损失函数可表示为

| $\begin{split} {L_{{\rm{triplet}}}} =& \displaystyle\sum\limits_{i = 1}^P {\displaystyle\sum\limits_{a = 1}^K {\left[ a \right.{\rm{ + }} {\mathop {\max }\limits_{p = 1,2,\cdots, K} \left\| {x_a^{(i)} - {{\left. {x_p^{(i)}} \right\|}_2}} \right.}} } - \\ &{\mathop {\min }\limits_{\scriptstyle{p = 1,2,\cdots, K}\hfill\atop {\scriptstyle{j = 1,2,\cdots, p}\hfill\atop \scriptstyle{j \ne i}\hfill}} {{\left\| {x_a^{(i)} - \left. {x_p^{(i)}} \right\|} \right.}_2}}{]_ + } \end{split}$ | (1) |

式中:

| $ \begin{array}{l}{L}_{{\rm{ssg}}}={L}_{i}({{f}}_{t},{y}_{t})+{L}_{{\rm{triple}}}({{f}}_{t\_{\rm{up}}},{y}_{t\_{\rm{up}}})+\\ {L}_{{\rm{triple}}}({{f}}_{t\_{\rm{low}}},{y}_{t\_{\rm{low}}})+{L}_{{\rm{triple}}}({{f}}_{{\rm{te}}},{y}_{t})\end{array}$ | (2) |

式中:

SPGAN网络是一个用于无监督行人重识别的风格转换网络,它以CycleGAN为基础框架,首先,通过2个镜像对称的生成对抗网络(generative adversarial network, GAN)形成一个环形网络,来进行图像的风格转换;其次,加入了新的损失函数,该损失函数以目标域的身份作为约束,辅助生成器去生成目标域风格的行人图片;另外,该模型为了保证行人图片转换过程中不丢失图片身份相关的信息,加入了孪生网络SiaNet以及对应的一致性损失函数,保证行人图片经过转换后其相关身份信息不丢失。本文提出的基于多尺度特征转换的风格转换模型由多尺度特征转换的生成器、判别器以及SiaNet网络组成。

1.2.1 多尺度特征转换的生成器模型SPGAN的生成器是编码器−转换器−解码器体系结构,其编码器的作用是提取输入图像的特征信息;其转换器由原始残差块组成,作用是将源域的输入图像特征转换为接近于目标域图像风格的特征;其解码器的作用是将特征向量进行复原。但是该生成器存在一些问题,首先,由于编码器下采样和解码器的上采样过程中,通过的特征具有尺度和位置不变性,而且在SPGAN的生成器中,只在一个尺度上使用原始残差块,只有最低层的特征信息可以进行特征的转换,这样尺度单一的特征信息转换会导致部分信息的丢失以及网络学习功能的下降;其次,由于原始残差块的结构原因,特征信息在通过最低层的原始残差块时,原始残差块限制可以通过瓶颈的信息,这样会限制网络学习的功能。针对上述问题,本文对SPGAN的生成器进行改进。

改进的生成器模型如图3所示,ReLU为线性整流函数,Tanh为双曲正切函数。

|

Download:

|

| 图 3 改进生成器模型 Fig. 3 Improved generator model | |

首先,采用一种改进残差块模块[13],替换原来承担转换作用的原始残差块。原始残差块如图4(a)所示,其结构顺序一般为:使用Conv + BN + ReLU + Conv + BN模式作为侧边分支的模式,特征通过侧边分支与原来的特征相加,再通过ReLU层传递信息。改进残差块如图4(b),该模块与原始残差块相比,改变了原有的结构顺序,改进残差块采用BN + ReLU + Conv + BN + ReLU + Conv模式作为侧边分支,特征通过侧边分支直接与原特征相加。将主干的ReLU层直接放到侧边分支中,并且改变其排列顺序,将ReLU和BN层作为权重层的预激活层,这种结构有利于更多的特征信息通过,保证特征信息在传递过程中更好地防止特征信息丢失,且生成器更易于训练;其次,针对生成器结构中特征转换尺度单一问题,本文将改进残差块引入到生成器上采样及下采样的对应层中,在此结构中,生成器在上采样以及下采样过程中均有改进残差块承担特征信息转换作用,在防止特征信息在传递过程中丢失的前提下,形成一个多尺度特征转换的生成器,一定程度上解决了原始SPGAN在下采样和上采样过程中特征信息无法进行多尺度转换以及特征信息丢失的问题,提升生成器网络的学习性能,进一步提升改进模型在风格转换上的效果。

|

Download:

|

| 图 4 生成器残差块示意 Fig. 4 Schematic diagram of generator residuals | |

本文的判别器属于卷积网络,判别器将图像作为输入对其进行特征提取,通过判别提取特征的真假来预测输入图像是原始图像还是生成图像。

1.2.3 SiaNet网络SiaNet网络通过利用Contrastive Loss[14]进行监督训练,通过训练,SiaNet网络将风格转换后的图片与其转换前图片拉近,将风格迁移后的图片与目标数据集中的其他图片推远,这样可以保证行人的ID信息不变。

1.2.4 损失函数该部分模型包含2个生成器—判别器对,分别是

| $ \begin{array}{c}{L}_{{\rm{Tadv}}}(G,{D}_{T},{p}_{x},{p}_{y})={E}_{y\sim {p}_{y}}\left[{\left({D}_{T}\left(y\right)-1\right)}^{2}\right]+\\ {E}_{x\sim {p}_{x}}\left[{\left({D}_{T}\left(G\left(x\right)\right)\right)}^{2}\right]\end{array}$ | (3) |

式中

对于生成器

| $ \begin{split}{L}_{{\rm{Sadv}}}(F,{D}_{S},{p}_{y},{p}_{x})=&{E}_{x\sim {p}_{x}}\left[{\left({D}_{S}\left(x\right)-1\right)}^{2}\right]+\\ & {E}_{y\sim {p}_{y}}\left[{\left({D}_{S}\left(F\left(y\right)\right)\right)}^{2}\right]\end{split}$ | (4) |

由于没有成对数据进行训练,本模型通过使用正向转换以及反向转换的循环后恢复原始图像,以减少可能的映射函数空间,其循环一致性损失函数可表示为

| $ \begin{split}{L}_{{\rm{cyc}}}(G,F)=&{E}_{x\sim {p}_{x}}\left[\Vert F{\left(G\left(x\right)-x\right)\Vert }_{1}\right]+\\ &{E}_{y\sim {p}_{y}}\left[\Vert G{\left(F\left(y\right)-y\right)\Vert }_{1}\right]\end{split}$ | (5) |

除了使用对抗损失函数以及循环一致性损失函数,为了保证生成器生成图像的稳定性,本模型还使用目标域身份约束作为图像——图像转换的辅助方法,该身份约束损失函数可表示为

| $ \begin{split}{L}_{{\rm{ide}}}(G,F,{p}_{x},{p}_{y})=&{E}_{x\sim {p}_{x}}\Vert F{\left(x\right)-x\Vert }_{1}+\\ &{E}_{y\sim {p}_{y}}\Vert G{\left(y\right)-y\Vert }_{1}\end{split}$ | (6) |

该部分模型的整体损失函数可表示为

| ${L_{{\rm{sp}}}} = {L_{{\rm{Tadv}}}} + {L_{{\rm{Sadv}}}} + {\lambda _1}{L_{{\rm{cyc}}}} + {\lambda _2}{L_{{\rm{ide}}}} + {\lambda _3}{L_{{\rm{con}}}}$ | (7) |

其中,

本实验的硬件环境配置为Intel©CoreTMi7 9 700K 64位处理器,采用2个GeForce GTX 2080 Ti GPU进行运算加速,操作系统为64位Ubuntu 16.04,采用基于python3.6以及Pytorch 1.0.0完成程序编程。

基于多尺度特征转换的风格转换模型的迭代次数为15,批量大小为8;基于风格转换的无监督聚类行人重识别模型的迭代次数为30,每次迭代包括70个epoch,批量大小为128。

2.2 数据集设置本文采用目前无监督行人重识别领域常用的公开数据集Market1501[15]以及Duke-MTMC-reID[16]进行实验。文献[17-19]模型均需要使用源域数据进行模型预训练,然后使用目标域数据进行正式训练及测试,本文数据集的设置与目前无监督行人重识别采用的数据集设置标准一致。

2.3 仿真实验与结果分析实验从有效性实验以及与主流模型的对比实验2个方面对模型效果进行验证。在实验测试中,将测试集分为查询集与候选集,针对每个查询行人图像计算其余所有候选图像的距离并按照距离大小从小到大的顺序对候选图像排序。实验采用无监督行人重识别通用的累积匹配特性 (cumulative match characteristic curve, CMC)中的Rank-1、Rank-5、Rank-10以及平均精度(mAP)作为评价指标。

2.3.1 算法有效性验证实验为了验证所提出的模型的有效性,实验在与目前无监督行人重识别工作一致的2种通用跨域设定上进行实验。它们分别是以Market1501为源域,在Duke-MTMC-reID上进行无监督实验;以Duke-MTMC-reID为源域,在Market1501进行无监督实验。

首先,对2.1节提出的改进算法——基于风格转换的SSG模型进行实验。实验对该模型进行有效性实验验证。实验结果如表1所示。

| 表 1 改进SSG有效性实验验证结果 Tab.1 Results of improved SSG verification experiment |

表1中的数据为模型在目标域上进行测试的结果,表中的模型均使用源域数据进行预训练,使用目标域数据进行正式训练及测试。从表中可以看出,将SPGAN模型引入到SSG模型中后,其识别效果优于SSG模型,在以Duke-MTMC-reID数据集为目标域的测试实验中,仅有Rank-5指标低于SSG模型0.2%,其他指标均有不同幅度提升。实验结果证明该部分实验的有效性。

同时,实验结果说明无监督聚类的行人重识别模型性能受到源域和目标域差异性过大带来的影响,SSG模型通过聚类方法挖掘目标域数据间的相似性,只能降低部分域间差异性对模型识别效果的影响。因此,本部分实验证明引入风格转换进一步降低域间差异性带来的影响是有必要的。

接下来,对改进的风格转换模型——基于多尺度特征转换的行人重识别风格转换模型—SPGAN+进行有效性实验。SPGAN+图片转换效果及对比效果如图5、6所示,实验结果如表2所示。

|

Download:

|

| 图 5 原数据集抽样图片和SPGAN+转换的抽样图片 Fig. 5 Sample images of original data and transferred data using the SPGAN+ | |

|

Download:

|

| 图 6 图像转换的抽样图像 Fig. 6 Visual examples of image-image translation. | |

| 表 2 改进SPGAN有效性实验验证结果 Tab.2 Results of improved SPGAN verification experiment |

图5为原数据集抽样图片和SPGAN+转换的抽样图片。由图5可以看出,本文模型在两域间的风格转换上达到较好效果,经过SPGAN+模型转换后的源域图片风格明显接近于目标域图片风格,实验证明,改进的风格转换模型在视觉效果上的有效性。

图6中,图6(a)表示原数据集的随机选取图片,图6(b)表示使用SPGAN模型将源域图像转换为目标域图像的随机选取图片,图6(c)表示使用本文改进的SPGAN+模型将源域图像转换为目标域图像的随机选取图片。经过对比,可以看出使用SPGAN+模型进行风格转换后的图像相比SPGAN模型更接近于目标域风格。

从视觉效果上来说,SPGAN+模型的风格转换效果优于SPGAN模型,也说明通过本文方法改进了生成器中特征转换尺度单一及特征信息传递效率低下问题,明显提升该模型的生成器的学习性能,提升模型风格转换的视觉效果。

表2中,Baseline表示直接使用源域数据源训练的Baseline模型在目标域上进行测试的实验结果,SPGAN表示首先将源域图像通过SPGAN模型转换成目标域风格的图像,然后训练Baseline模型,在目标域上进行测试实验;SPGAN+代表本文的改进行人重识别风格转换模型,首先将源域图像通过SPGAN+模型转换成目标域风格的图像,然后训练Baseline模型,并在目标域上进行测试的实验结果。由表2可知,本实验改进的SPGAN+模型的性能有较好提升,在以Market1501以及Duke-MTMC-reID数据集为目标域的测试中,改进模型的各项实验指标均有较好的提升,验证了改进的SPGAN+模型的有效性。

实验结果说明,SPGAN模型的生成器中,其生成器结构存在特征转换尺度单一的缺点,且其承担转换作用的原始残差块存在信息传递效率低和限制可以通过瓶颈的特征信息的缺点,导致生成器的学习性能不佳,使SPGAN模型在风格转换上不能达到较好效果。因此,本部分实验证明本文改进算法SPGAN+的生成器通过解决转换尺度单一以及特征传递效率低下的问题可以让该模型得到更好的域间风格转换效果。

最后,进行基于风格转换的无监督聚类行人重识别算法的实验。实验对整体模型与SSG以及第1部分实验进行有效性对比验证。实验结果如表3所示。

| 表 3 改进SSG有效性实验验证结果 Tab.3 Results of improved SSG verification experiment |

表3中,SSG+SPGAN表示本实验通过将SPGAN引入到SSG模型中进行实验的结果;SSG+SPGAN+表示本实验通过将SPGAN+引入到SSG模型中进行实验的结果。由表3可知,将风格转换模型SPGAN以及SPGAN+分别引入到SSG模型中,最终识别效果均好于只使用SSG模型的识别效果;SSG+SPGAN与SSG+SPGAN+实验结果,后者在性能上优于前者,后者的识别率仅在以Duke-MTMC-reID为目标域的实验中,其rank-1略低于前者,其他项识别效率均高于前者。

这部分实验说明,针对SPGAN模型生成器转换尺度单一以及特征信息传递效率低的问题的改进,在整体模型中对模型最终识别率存在提升效果,进一步验证了改进风格转换模型SPGAN+的有效性以及整体模型的有效性。

2.3.2 本文算法与主流算法对比实验实验对目前各个方向最先进的基于上下文呈现的行人重识别网络(context rendering network, CR-GAN)[17]、基于存储器的领域自适应的行人重识别(exemplar memory for domain adaptive person re-identification, ECN)[18]、于深度软多标签参考学习的行人重识别(deep soft multilabel reference learning, MAR)[19]和SSG进行对比,实验结果如表4所示。

| 表 4 本文算法与先进无监督行人重识别算法结果对比 Tab.4 Comparison of the results between our algorithm and the advanced unsupervised person re-identification algorithms |

在表4中,“—”表示对应方法未在数据集上实现。由表4可知,本实验提出的方法相较于其他主流方法,本实验的方法仅在Duke-MTMC-reID数据集的rank-5上略低于MAR,其他指标均取得了最高精度,说明本文算法优于上述对比算法。

3 结束语首先,本文发现基于聚类的无监督行人重识别算法—SSG中源域和目标域之间数据分布的差异性是影响模型性能的重要因素,而减小域间风格差异性的方法可以降低该问题对SSG 模型识别效果的影响。其次,本文发现引入的SPGAN模型的生成器存在特征转换尺度单一以及特征信息传递效率较低的问题,该问题影响SPGAN模型的风格转换效果,降低整体模型的识别率,通过实现特征的多分辨率尺度转换,并且提升生成器特征传递效率,可以提升SPGAN 模型的风格转换效果,进一步提升最终识别效果。在目前无监督行人重识别领域使用的通用数据集设定上,对本实验提出的算法进行验证,本文实验结果表明,将SPGAN引入到SSG模型中后,模型识别效果得到提升;对引入的SPGAN模型生成器进行改进,提升其转换性能,模型的识别效果得到进一步提升。

无监督聚类行人重识别模型 SSG 中使用的聚类方法还存在一些问题,提升 SSG 模型中对特征聚类的准确度是今后需要完善的工作 。

| [1] |

刘帅师, 程曦, 郭文燕, 等. 深度学习方法研究新进展[J]. 智能系统学报, 2016, 11(5): 567-577. LIU Shuaishi, CHENG Xi, GUO Wenyan, et al. Progress report on new research in deep learning[J]. CAAI transactions on intelligent systems, 2016, 11(5): 567-577. DOI:10.11992/tis.201511028 (  0) 0)

|

| [2] |

宋婉茹, 赵晴晴, 陈昌红, 等. 行人重识别研究综述[J]. 智能系统学报, 2017, 12(6): 770-780. SONG Wanru, ZHAO Qingqing, CHEN Changhong, et al. Survey on pedestrian re-identification research[J]. CAAI transactions on intelligent systems, 2017, 12(6): 770-780. DOI:10.11992/tis.201706084 (  0) 0)

|

| [3] |

GENG Mengyue, WANG Yaowei, XIANG Tao, et al. Deep transfer learning for person re-identification[J]. arXiv preprint arXiv: 1611.05244, 2016: 00007480.

( 0) 0)

|

| [4] |

LI Wei, ZHAO Rui, XIAO Tong, et al. Deepreid: deep filter pairing neural network for person re-identification[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA, 2014: 152−159.

( 0) 0)

|

| [5] |

ZHONG Zhun, ZHENG Liang, LI Shaozi, et al. Generalizing a person retrieval model hetero- and homogeneously[C]//Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich, Germany, 2018: 176−192.

( 0) 0)

|

| [6] |

PENG Peixi, XIANG Tao, WANG Yaowei, et al. Unsupervised cross-dataset transfer learning for person re-identification[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA, 2016: 1306−1315.

( 0) 0)

|

| [7] |

DENG Weijian, ZHENG Liang, YE Qixiang, et al. Image-image domain adaptation with preserved self-similarity and domain-dissimilarity for person re-identification[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA, 2018: 994−1003.

( 0) 0)

|

| [8] |

FU Yang, WEI Yunchao, WANG Guanshuo, et al. Self-similarity grouping: a simple unsupervised cross domain adaptation approach for person re-identification[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Seoul, Korea (South), 2019: 6111−6120.

( 0) 0)

|

| [9] |

ZHU Junyan, PARK T, ISOLA P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice, Italy, 2017: 2242−2251.

( 0) 0)

|

| [10] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA, 2016: 770−778.

( 0) 0)

|

| [11] |

ESTER M, KRIEGEL H P, SANDER J, et al. A density-based algorithm for discovering clusters in large spatial databases with noise[C]//Proceedings of the Second International Conference on Knowledge Discovery and Data Mining. Portland, Oregon, USA, 1996: 226−231.

( 0) 0)

|

| [12] |

HERMANS A, BEYER L, LEIBE B. In defense of the triplet loss for person re-identification[J]. arXiv preprint arXiv: 1703.07737, 2017.

( 0) 0)

|

| [13] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Identity mappings in deep residual networks[C]//14th European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 630−645.

( 0) 0)

|

| [14] |

HADSELL R, CHOPRA S, LECUN Y. Dimensionality reduction by learning an invariant mapping[C]//2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition . New York, NY, USA, 2006: 1735−1742.

( 0) 0)

|

| [15] |

ZHENG Liang, SHEN Liyue, TIAN Lu, et al. Scalable person re-identification: a benchmark[C]//Proceedings of the IEEE International Conference on Computer Vision. Santiago, Chile, 2015: 1116−1124.

( 0) 0)

|

| [16] |

RISTANI E, SOLERA F, ZOU R, et al. Performance measures and a data set for multi-target, multi-camera tracking[C]//European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 17−35.

( 0) 0)

|

| [17] |

CHEN Yanbei, ZHU Xiatian, GONG Shaogang. Instance-guided context rendering for cross-domain person re-identification[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Seoul, Korea (South), 2019: 232−242.

( 0) 0)

|

| [18] |

ZHONG Zhun, ZHENG Liang, LUO Zhiming, et al. Invariance matters: exemplar memory for domain adaptive person re-identification[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, CA, USA, 2019: 598−607.

( 0) 0)

|

| [19] |

YU Hongxing, ZHENG Weishi, WU Ancong, et al. Unsupervised person re-identification by soft multilabel learning[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, CA, USA, 2019: 2143−2152.

( 0) 0)

|

2021, Vol. 16

2021, Vol. 16