2. 中国科学院 沈阳自动化研究所,辽宁 沈阳 110016;

3. 中国科学院 网络化控制系统重点实验室,辽宁 沈阳 110016;

4. 中国科学院 机器人与智能制造创新研究院,辽宁 沈阳 110169

2. Shenyang Institute of Automation, Chinese Academy of Sciences, Shenyang 110016, China;

3. Key Laboratory of Networked Control Systems, Chinese Academy of Sciences, Shenyang 110016, China;

4. Institutes for Robotics and Intelligent Manufacturing, Chinese Academy of Sciences, Shenyang 110169, China

人类在日常生活中可以不间断地处理大量获取来自外界的信息,如在高速公路上驾驶汽车,或在拥挤的街道上行走。在认知科学中,人们一致认为,人类可以高效地处理面临的大量数据是由于我们能够优先考虑视觉场景的某些方面,而忽视其他方面。这是人类的一种视觉注意力机制,是一种认知过程,通过选择相关信息,过滤掉不相关的刺激,使人类能够解析大量的视觉数据,从而在有限的资源下实现性能的最大化[1]。机器人虽然做不到人类这样,但这种视觉注意力机制是值得机器人自主定位导航借鉴的。

国内外学者开展了很多通过主动特征选择提高视觉SLAM和视觉里程计性能的研究。Ouerhani等[2]利用注意的路标点构建拓扑地图,在导航过程中,利用相同的视觉注意模型检测最突出的视觉特征,与注意的路标点相匹配获取特征点。Newman等[3]考虑一个装备了相机和激光测距仪的机器人,并利用基于外观的视觉显著性概念进行特征选择,提高SLAM回环检测的稳定性,在室内环境中可以很好地检测到回环(大约100 m)。Sola等[4]指出尽管许多特征可能在机器人环境的给定视图中可见,只有少数这样的特征是估计机器人的位置和方向所必需的。它们利用共视性作为标准,自动选择特征最优集。Frintrop等[5]使用注意力框架进行特征选择和主动视角控制,能够克服使用相对较小视野的单目视觉SLAM系统的一些限制,提高姿态估计的准确性。该特征选择系统是基于VOCUS模型的[5],其包含一个自底向上的注意力系统(根据特征外观计算显著性),还包含一个自顶向下的机制(考虑任务性能)。Hochdorfer等[6]提出了一种基于区域覆盖的特征点评级和选择机制,解决了随着特征数量不断增加,运算资源占用率越来越高的问题,为SLAM算法在服务机器人整个生命周期中的应用,甚至在不同的环境中的应用做出了贡献。Strasdat等[7]提出了一种基于强化学习方法的特征选择,减轻了机器人在SLAM建图中的计算负担。Shi等[8]提出了一种特征选择方法来提高SLAM中数据关联的鲁棒性,防止了不好的特征被初始化,更好地保证了SLAM估计的一致性。Cvisic等[9]通过稳定的特征选择加速了立体视觉里程计的计算,减少了SLAM轨迹漂移,该特征选择是基于统分的(将特征均匀地分布在整个图像中)和基于外观的排名。最近在计算机视觉领域的研究表明利用注意力机制可以减少神经网络的计算负担。Mnih等[10]通过引入瞥见的概念,减少了使用递归神经网络进行目标检测和跟踪的步骤,可以在图像感兴趣的区域提供更高的分辨率。文献[11]是最早使用信息理论结构来推理视觉特征的论文之一,提出了一个基于模型的跟踪问题,在该问题中,运动相机的状态必须通过对已知特征的观察来估计。

视觉SLAM在面对快速变动场景时,由于缺乏可跟踪特征,基于视觉的感知技术往往会失败。这是一个众所周知的问题,在文献中经常被讨论(例如,见文献[12-13])。本文基于环境和相机运动状态的相互关联性而产生的特征效用,引入预测机制,利用注意力和预测选择特征来减少跟踪特征的丢失,通过滤去那些将丢失在视野中的特征点,增加SLAM系统的稳定性,特征选择器知道机器人的意图(未来的运动),并相应地选择更有可能出现在未来视野中的特征,可以用更少的含信息多的特征点来提高优化效率。

1 注意力和预测机制本文提出的注意力和预测机制是从当前帧检测到的特征

|

Download:

|

| 图 1 整体流程 Fig. 1 Whole process | |

为了最大限度地提高运动估计的性能,特征子集应该最多具有

| $ \mathop {\max }\limits_{{\boldsymbol{S}} \subset {\boldsymbol{F}}} \;f({\boldsymbol{S}}), \;\left| {\boldsymbol{S}} \right| \leqslant \kappa $ | (1) |

这个问题的解决依赖于度量方程

本文的方法受Carlone等[16]的启发,文中提出了两种量化特征子集可行性的度量,最小特征值

| $ \begin{array}{l} {f_{\det }}(S) = \log \det ({{\boldsymbol{\varOmega}} _{k:k + H}}({\boldsymbol{S}})) = \log \det \left(\displaystyle\sum\limits_{l \in S} {{p_l}} {{\boldsymbol{\varDelta}} _l}\right) \end{array} $ | (2) |

式中:

|

Download:

|

| 图 2 时间轴 Fig. 2 Time line | |

本文使用带有延迟求值[17]的贪婪算法[18]选择

算法1 带有延迟求值的贪婪算法

1)输入

2) for循环

3)计算

4)根据上界值对特征点进行降序排序,

5)初始化,

6) for循环

7)如果

8)如果

9)

本文使用线性测量模型,它简化了非线性透视投影模型,并且可以进行有效的计算。为此,必须将像素测量表示为想要估计的未知状态的线性函数。假设

| $ {{\boldsymbol{u}}_{hl}} \times ({\left( {{\boldsymbol{R}}_{{\text{cam}},h}^W} \right)^{\text{T}}}(p_l^W - {\boldsymbol{t}}_{{\text{cam}},h}^W)) = {{\bf{0}}_3} $ | (3) |

式中:

|

Download:

|

| 图 3 向量共线 Fig. 3 Vector collinear | |

将时间段内每个时刻的状态定义为

| $ f(\varphi ,{\boldsymbol{t}}) = f(\hat \varphi ,\hat {\boldsymbol{t}}) + \frac{{\partial f}}{{\partial \varphi }}{|_{(\hat \varphi ,\hat {\boldsymbol{t}})}}(\varphi - \hat \varphi ) + \frac{{\partial f}}{{\partial t}}{|_{(\hat \varphi ,\hat {\boldsymbol{t}})}}({\boldsymbol{t}} - \hat {\boldsymbol{t}}) $ | (4) |

式中:

第

| $ {{\boldsymbol{\varDelta}} _l} = {{\boldsymbol{A}}^{\rm T}}{\boldsymbol{A}} $ | (5) |

| $ {\boldsymbol{A}} = \left[ {\begin{array}{*{20}{c}} {{{\boldsymbol{U}}_{kl}}{{({{\hat {\boldsymbol{R}}}_k}{{\boldsymbol{p}}_l})}^ \wedge }}& \cdots &{ - {{\boldsymbol{U}}_{kl}}} \\ \vdots &{}& \vdots \\ {{{\boldsymbol{U}}_{(k + H)l}}{{({{\hat {\boldsymbol{R}}}_{k + H}}{{\boldsymbol{p}}_l})}^ \wedge }}& \cdots &{ - {{\boldsymbol{U}}_{(k + H)l}}} \end{array}} \right] $ | (6) |

最后将其用在贪婪算法中。

2 实验分析为了测试本文的方法,使用EuRoC数据集[22],该数据集是使用一个配备了视觉惯性[23]传感器的AscTech Firefly六旋翼飞行器采集的,其包含简单场景和复杂场景。在本文中,使用收集自一个工厂大厅环境的数据集MH01-easy、MH02-easy、MH03-medium、MH04-difficult、MH05-difficult,随着场景复杂度提高,飞行器速度依次递增且有更多的急转弯。为了更好地说明算法的效果,对比了ORB-SLAM2[24]和Random两种情况,ORB-SLAM2是不添加本文算法的SLAM系统,Random是一种在ORB-SLAM2选择好特征点的帧上随机地选择跟本文算法同样数量特征点的情况。使用ATE(绝对轨迹误差)中的RMSE(均方根误差),即

|

Download:

|

| 图 4 ORB-SLAM2、Random和本文算法的表现 Fig. 4 Performance of ORB-SLAM2、Random and our algorithm | |

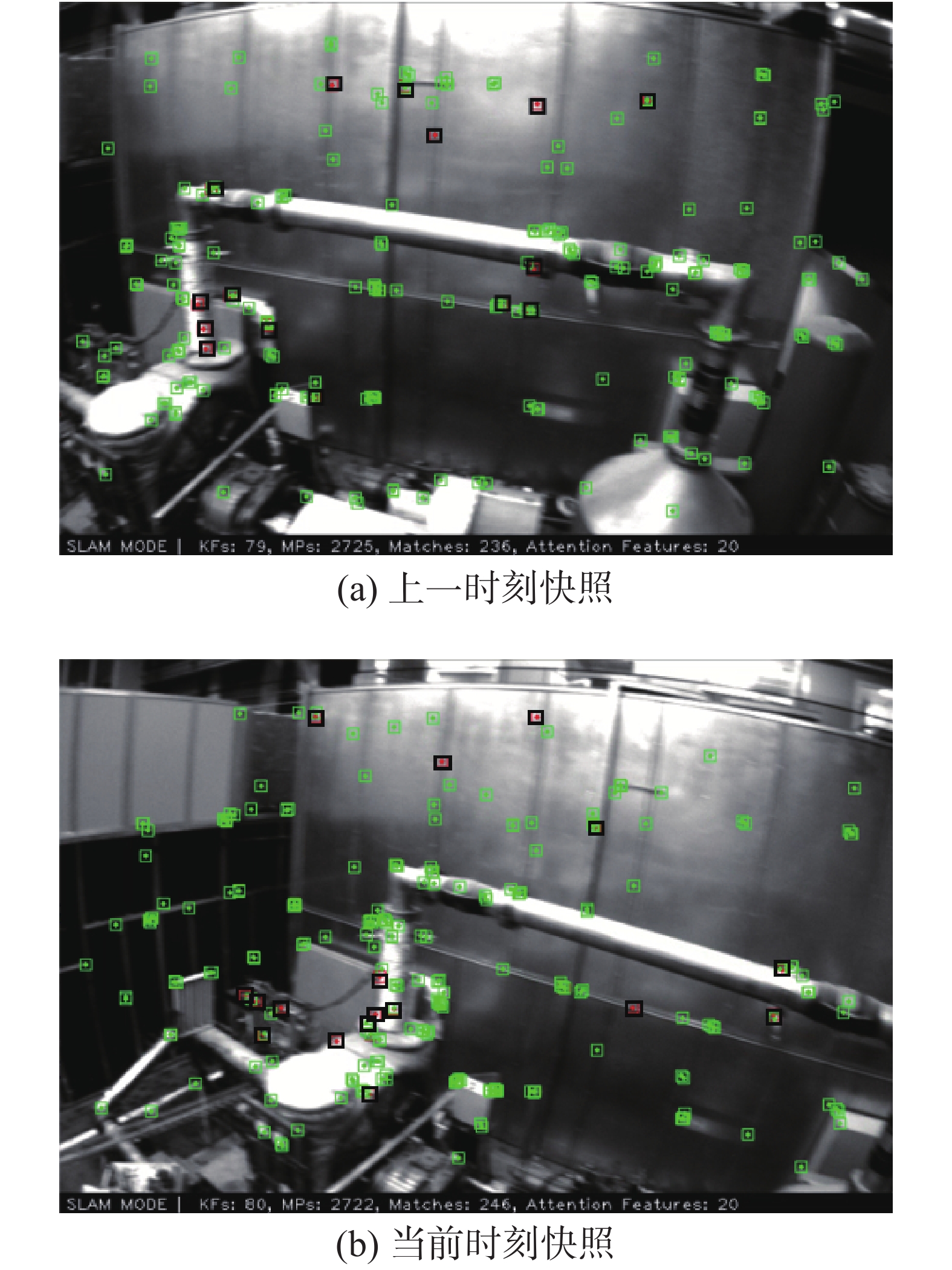

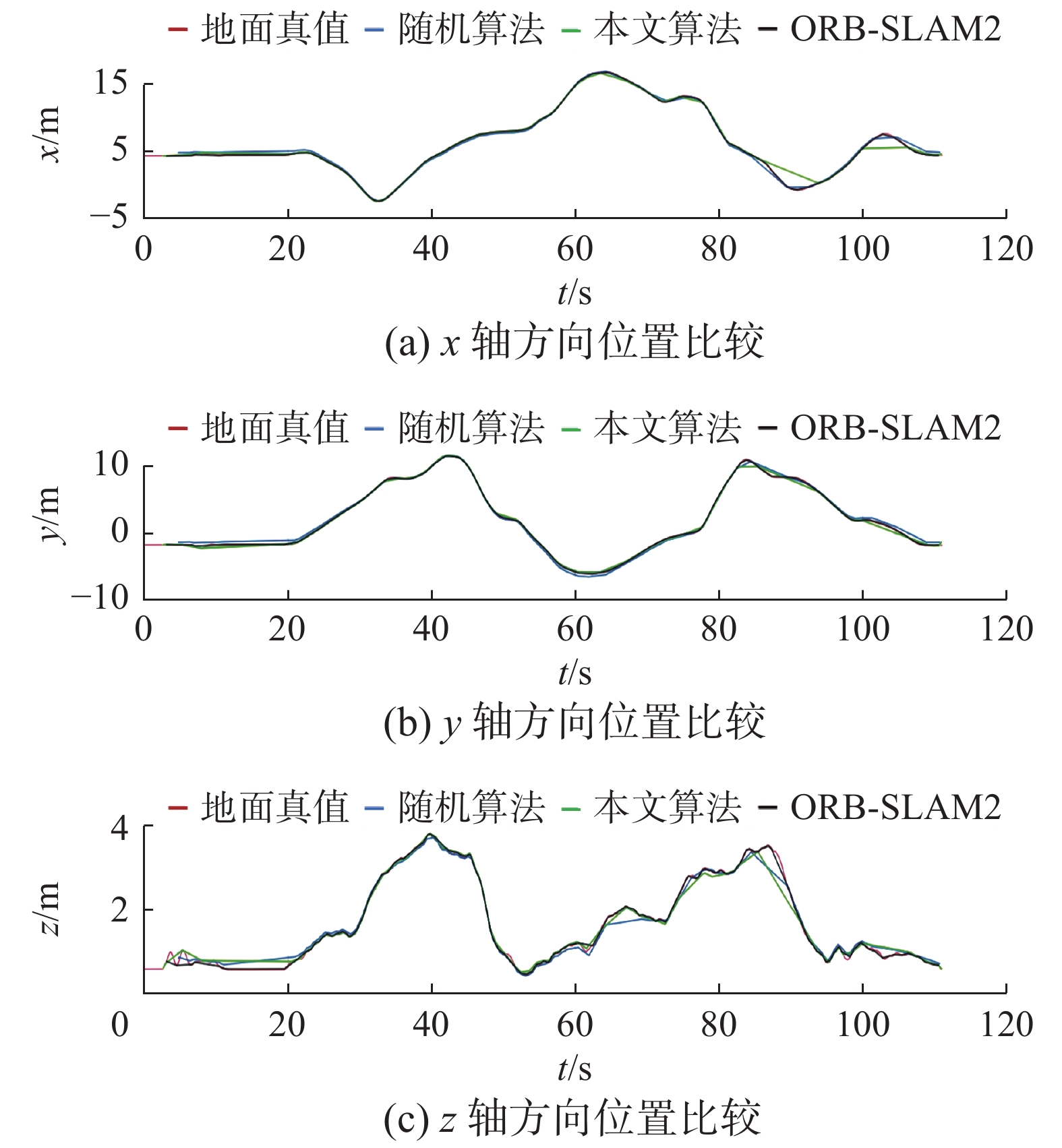

为了更好地理解所提出方法所带来的性能提升,在图5按时间顺序给出了生成的一些快照。每个子图显示了关键帧中待选择特征(绿色方块)和选择的特征(加粗黑色方块)。这些关键帧是MH03-medium数据集向左急转弯时获取的。注意到两幅图选择的特征大部分都集中在画面左侧,也就是相机急转弯的方向,随着相机的运动这些特征更有可能保持在视野中。这是因为,本文所提出的注意力和预测机制充分利用了平台的即时运动信息。在图6中给出了ORB-SLAM2、Random和本文算法运行在MH05-difficult的轨迹图。从图6中都可以看出,本文的算法虽然没有ORB-SLAM2跟地面真值贴合度那么高,但却明显优于Random。

|

Download:

|

| 图 5 本文算法向左急转弯时的快照 Fig. 5 Snapshot of our algorithm during a sharp left turn | |

|

Download:

|

| 图 6 ORB-SLAM2、Random和本文算法的轨迹 Fig. 6 Trajectory of ORB-SLAM2, Random, and our algorithm | |

本文提出的注意力和预测机制保留了前端检测到的含信息最丰富的视觉特征,并将其反馈给估计后端。该机制的特点:1)本质上具有预测性,能够感知机器人未来的运动,并据此选择特征。正如我们在实验中看到的,在急转弯和快速变动的情况下能确保定位的准确性。2)它具有贪婪性,利用带有延迟求值的贪婪算法保证了logdet度量的次优性。本文在EuRoC工厂大厅环境数据集中进行了大量特征选择实验,实验结果表明本文加入的注意力和预测的特征选择算法对SLAM系统性能影响很大,使用很少的特征点也能达到定位的精度要求。

以后的研究中,将进一步研究如何联合优化视觉和IMU,以提高注意力和预测机制的稳定性和适应性。

| [1] |

CARRASCO M. Visual attention: The past 25 years[J]. Vision research, 2011, 51(13): 1484-1525. DOI:10.1016/j.visres.2011.04.012 ( 0) 0)

|

| [2] |

OUERHANI N, BUR A, HÜGLI H. Visual attention-based robot self-localization[C]//Proceedings of the European Conference on Mobile Robotics. Ancona, Italy, 2005: 8−13.

( 0) 0)

|

| [3] |

NEWMAN P, HO K. SLAM-loop closing with visually salient features[C]//IEEE International Conference on Robotics and Automation. Barcelona, Spain, 2005: 635−642.

( 0) 0)

|

| [4] |

SALA P, SIM R, SHOKOUFANDEH A, et al. Landmark selection for vision-based navigation[J]. IEEE transactions on robotics, 2006, 22(2): 334-349. DOI:10.1109/TRO.2005.861480 ( 0) 0)

|

| [5] |

FRINTROP S, JENSFELT P. Attentional landmarks and active gaze control for visual SLAM[J]. IEEE transactions on robotics, 2008, 24(5): 1054-1065. DOI:10.1109/TRO.2008.2004977 ( 0) 0)

|

| [6] |

HOCHDORFER S, SCHLEGEL C. Landmark rating and selection according to localization coverage: addressing the challenge of lifelong operation of SLAM in service robots[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems. St. Louis, USA, 2009: 382−387.

( 0) 0)

|

| [7] |

STRASDAT H, STACHNISS C, BURGARD W. Which landmark is useful? Learning selection policies for navigation in unknown environments[C]//2009 IEEE International Conference on Robotics and Automation. Kobe, Japan, 2009: 1410−1415.

( 0) 0)

|

| [8] |

SHI Zongying, LIU Zhibin, WU Xianliang, et al. Feature selection for reliable data association in visual SLAM[J]. Machine vision and applications, 2013, 24(4): 667-682. DOI:10.1007/s00138-012-0440-6 ( 0) 0)

|

| [9] |

CVIŠIĆ I, PETROVIĆ I. Stereo odometry based on careful feature selection and tracking[C]//European Conference on Mobile Robots. Lincoln, UK, 2015: 1−6.

( 0) 0)

|

| [10] |

MNIH V, HEESS N, GRAVES A, et al. Recurrent models of visual attention[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal, Canada, 2014: 2204−2212.

( 0) 0)

|

| [11] |

DAVISON A J. Active search for real-time vision[C]//Tenth IEEE International Conference on Computer Vision. Beijing, China, 2005: 66−73.

( 0) 0)

|

| [12] |

SHEN Shaojie, MULGAONKAR Y, MICHAEL N, et al. Vision-based state estimation and trajectory control towards high-speed flight with a quadrotor[C]//Proceedings of Robotics: Science and Systems X. Berlin, Germany, 2013: 865−878.

( 0) 0)

|

| [13] |

FALANGA D, MUEGGLER E, FAESSLER M, et al. Aggressive quadrotor flight through narrow gaps with onboard sensing and computing using active vision[C]//IEEE International Conference on Robotics and Automation. Singapore, Singapore, 2017: 5774−5781.

( 0) 0)

|

| [14] |

BIAN Fang, KEMPE D, GOVINDAN R. Utility-based sensor selection[C]//5th International Conference on Information Processing in Sensor Networks. Nashville, USA, 2006: 11−18.

( 0) 0)

|

| [15] |

SHAMAIAH M, BANERJEE S, VIKALO H. Greedy sensor selection: leveraging submodularity[C]//49th IEEE Conference on Decision and Control. Atlanta, USA, 2010: 2572−2577.

( 0) 0)

|

| [16] |

CARLONE L, KARAMAN S. Attention and anticipation in fast visual-inertial navigation[C]//2017 IEEE International Conference on Robotics and Automation (ICRA). Singapore, Singapore, 2017: 3886−3893.

( 0) 0)

|

| [17] |

JOHNSSON T. Efficient compilation of lazy evaluation[C]//Proceedings of the 1984 SIGPLAN symposium on Compiler construction. Montreal, Canada, 1984: 58−69.

( 0) 0)

|

| [18] |

常友渠, 肖贵元, 曾敏. 贪婪算法的探讨与研究[J]. 重庆电力高等专科学校学报, 2008, 13(3): 40-42. CHANG Youqu, XIAO Guiyuan, ZENG Ming. Discussion and research on greedy algorithm[J]. Journal of Chongqing Electric Power College, 2008, 13(3): 40-42. DOI:10.3969/j.issn.1008-8032.2008.03.011 (  0) 0)

|

| [19] |

赵军圣, 庄光明, 王增桂. 最大似然估计方法介绍[J]. 长春理工大学学报, 2010(6): 53-54. ZHAO Junsheng, ZHUANG Guangming, WANG Zenggui. Introduction to maximum likelihood estimation method[J]. Journal of Changchun University of Science and Technology, 2010(6): 53-54. (  0) 0)

|

| [20] |

LANCASTER T. The covariance matrix of the information matrix test[J]. Econometrica, 1984, 52(4): 1051-1053. DOI:10.2307/1911198 ( 0) 0)

|

| [21] |

同济大学. 高等数学. 北京: 高等教育出版社, 2001.8.

( 0) 0)

|

| [22] |

BURRI M, NIKOLIC J, GOHL P, et al. The EuRoC micro aerial vehicle datasets[J]. The international journal of robotics research, 2016, 35(10): 1157-1163. DOI:10.1177/0278364915620033 ( 0) 0)

|

| [23] |

ESSER P, DAWES H, COLLETT J, et al. IMU: inertial sensing of vertical CoM movement[J]. Journal of biomechanics, 2009, 42(10): 1578-1581. DOI:10.1016/j.jbiomech.2009.03.049 ( 0) 0)

|

| [24] |

MUR-ARTAL R, TARDÓS J D. ORB-SLAM2: an open-source SLAM system for monocular, stereo, and RGB-D cameras[J]. IEEE transactions on robotics, 2017, 33(5): 1255-1262. DOI:10.1109/TRO.2017.2705103 ( 0) 0)

|

| [25] |

STURM J, ENGELHARD N, ENDRES F, et al. A benchmark for the evaluation of RGB-D SLAM systems[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Vilamoura-Algarve, Portugal, 2012: 573−580.

( 0) 0)

|

2021, Vol. 16

2021, Vol. 16