粗糙集理论是当今知识发现领域的一个研究热点,决策粗糙集模型[1-2]是粗糙集理论的重要研究分支,由于决策粗糙集在处理噪声数据方面具有较好的泛化性能[2],因此目前已广泛应用于机器学习[3-4]、图像处理[5]和数据挖掘[6]等诸多领域。

早期的决策粗糙集建立在完备离散型的信息系统上,在其基础上,学者们进一步地提出了多种扩展的粗糙集模型,例如Liu等[7]将决策粗糙集推广至不完备信息系统,提出一种改进的不完备决策粗糙集模型;Sun等[8]在粗糙模糊集下提出了相应的决策粗糙集模型;Dou等[9]基于多个代价的策略,提出了多代价的决策粗糙集模型;在数值型的数据集方面,Li等[10]将邻域关系融入决策粗糙集模型中,提出了邻域决策粗糙集模型,该模型进一步提升了决策粗糙集的适用范围。

然而现实环境下的数据不总是静止不变的,而是时刻处于动态更新之中,为了提高粗糙集模型在动态数据下的处理效率,学者们对其提出了多种增量式的模型和算法[11-13]。在决策粗糙集等模型中,学者们同样提出了多种增量式更新算法。例如,Zhang等[14]针对属性值动态变化情形提出了相应的增量式更新算法;针对流计算环境,Xu等[15]提出了对象在线增加和减少时的增量式更新算法;Chen等[16]利用集合更新的方法设计出了决策粗糙集的增量式更新算法;赵小龙等[17]针对数值型信息系统,研究了邻域粒化条件熵随对象增加和减少时的增量式更新,并进一步地提出了对应的增量式属性约简算法;杨臻等[18]研究了混合型信息系统下对象变化时概率的增量式更新,并进一步地提出了变精度粗糙集模型的增量式更新;Luo等[19]通过矩阵方法构造出了决策粗糙集的增量式更新算法。然而所提出的这些增量式更新算法仅局限于离散数据环境下的决策粗糙集模型,针对邻域型的决策粗糙集还未有相关研究。

论域中对象的增加和减少是信息系统最为常见的一种变化形式,本文将针对这类问题进行邻域决策粗糙集的增量式更新研究。邻域决策粗糙集通过邻域关系来对数值型数据进行信息粒化[10],而对其进行增量式计算时必然涉及邻域类的更新计算,邻域关系不同于传统的等价关系和容差关系,其增量式计算的复杂程度要更高。在文献[18]中,杨臻等通过单个对象逐步迭代的方式去处理混合型信息系统变精度粗糙集模型的增量式更新,使得问题的处理方式简便高效。由于决策粗糙集与变精度粗糙集有一定的相似性,因此本文将借鉴文献[18]中关于变精度粗糙集模型的增量式更新研究思路与方法,构造出邻域决策粗糙集的增量式更新模型。文中首先分别研究论域中增加和减少一个对象时,近似集与邻域类之间概率的变化规律,然后根据这种规律来构造单个对象变化时模型上下近似集的增量式更新,最后在单个对象变化的基础上,通过逐步迭代的方式设计了对象批量变化时的增量式更新算法。实验分析表明,所提出的算法具有较高的增量式更新性能,适用于动态数据环境下邻域决策粗糙集模型的动态更新。

1 邻域决策粗糙集模型粗糙集理论中,数据集表示为信息系统

Yao等[1-2]提出的决策粗糙集仅应用于离散型的信息系统,Li等将邻域关系引入传统的决策粗糙集模型中,提出了邻域决策粗糙集[10]。

定义1[10] 设邻域型信息系统

| $N_A^\delta = \{ (x,y) \in U \times U\left| {{\Delta _A}(x,y) \leqslant \delta } \right.\} $ |

式中:

| ${\Delta _A}(x,y) = {\left( {\sum_{\forall a \in A} {|a(x) - a(y){|^k}} } \right)^{{1 / k}}}$ |

给定邻域信息系统的邻域关系,可以进一步得到每个对象在该邻域关系下的邻域类。

定义2[10] 设邻域型信息系统

| ${\delta _A}(x) = \{ y \in U|(x,y) \in N_A^\delta \} $ |

可以看出,对象

在邻域决策粗糙集中,给定状态集

1)

2)

3)

基于最小化决策代价的原则,那么有

1)

2)

3)

通常决策代价满足关系

1)当

2)当

3)当

这里的

| $\alpha = \frac{{{\lambda _{PN}} - {\lambda _{BN}}}}{{({\lambda _{PN}} - {\lambda _{BN}}) + ({\lambda _{BP}} - {\lambda _{PP}})}}$ |

| $\beta = \frac{{{\lambda _{BN}} - {\lambda _{NN}}}}{{({\lambda _{BN}} - {\lambda _{NN}}) + ({\lambda _{NP}} - {\lambda _{BP}})}}$ |

| $\gamma = \frac{{{\lambda _{PN}} - {\lambda _{NN}}}}{{({\lambda _{PN}} - {\lambda _{NN}}) + ({\lambda _{NP}} - {\lambda _{PP}})}}$ |

进一步地,若

1)当

2)当

3)当

因此基于上述决策判别条件,我们可以进一步得到邻域决策粗糙集的上下近似集的定义。

定义3[10] 设邻域型信息系统

| $\underline N _A^{(\alpha ,\beta )}(X) = \{ x \in U|P(X|{\delta _A}(x)) > \alpha \} $ |

| $\overline N _A^{(\alpha ,\beta )}(X) = \{ x \in U|P(X|{\delta _A}(x)) \geqslant \beta \} $ |

式中:

| $P(X|{\delta _A}(x)) = \dfrac{{|{\delta _A}(x) \cap X|}}{{|{\delta _A}(x)|}}$ |

由于现实环境下数据集的动态性,传统的模型和算法不再有效,针对该问题,本节将提出一种论域变化时邻域决策粗糙集模型的增量式更新方法。

定义3已经表明,当信息系统的决策代价已经确定时,则邻域决策粗糙集中的阈值

数据集论域中对象的增加和减少往往都是批量的,而这些批量的变化可以分解成对象的一个一个依次变化,每次只考虑数据集中一个对象增加或减少时的增量式更新问题,然后逐步对多个对象进行迭代,这样可以简化问题的处理[12, 17-18]。根据这一思想,构造了本文模型的增量式更新方法。

2.1 论域中对象增加时模型的增量式更新在邻域决策粗糙集中,研究增量式更新的关键是上下近似区域的更新问题,由于阈值

定理1[18] 设邻域型信息系统

1)

| $P({X^ + }|\delta _A^{{U^ + }}(x)) \geqslant P(X|\delta _A^U(x));$ |

| $P({Y^ + }|\delta _A^{{U^ + }}(x)) < P(Y|\delta _A^U(x)).$ |

2)

| $P({X^ + }|\delta _A^{{U^ + }}(x)) = P(X|\delta _A^U(x));$ |

| $P({Y^ + }|\delta _A^{{U^ + }}(x)) = P(Y|\delta _A^U(x)).$ |

定理1给出信息系统论域

定理2 设邻域型信息系统

| $ \begin{aligned} 1)\underline N _A^{(\alpha ,\beta )}&({X^ + }) = \underline N _A^{(\alpha ,\beta )}(X) \cup \\ &\{ x \in \delta _A^{{U^ + }}({x^ + }) - \underline N _A^{(\alpha ,\beta )}(X)|P({X^ + }|\delta _A^{{U^ + }}(x)) > \alpha \} \end{aligned} $ |

| $ \begin{aligned} 2)\underline N _A^{(\alpha ,\beta )}&({Y^ + }) = (\underline N _A^{(\alpha ,\beta )}(Y) - \\ &\{ x \in \underline N _A^{(\alpha ,\beta )}(Y) \cap \delta _A^{{U^ + }}({x^ + })|P({Y^ + }|\delta _A^{{U^ + }}(x)) \leqslant \alpha \} ) \cup \\ &\{ x \in \{ {x^ + }\} |P({Y^ + }|\delta _A^{{U^ + }}(x)) > \alpha \} \end{aligned} $ |

证明 1)对于

对于

| $P({X^ + }|\delta _A^{{U^ + }}(x)) = P(X|\delta _A^U(x)) > \alpha $ |

同样有

对于

若

| $P({X^ + }|\delta _A^{{U^ + }}(x)) \geqslant P(X|\delta _A^U(x))$ |

而

| $\begin{split} \underline N _A^{(\alpha ,\beta )}({X^ + }) = \underline N _A^{(\alpha ,\beta )}(X) \cup \quad\quad\quad\\ \{ x \in \delta _A^{{U^ + }}({x^ + }) - \underline N _A^{(\alpha ,\beta )}(X)|P({X^ + }|\delta _A^{{U^ + }}(x)) > \alpha \} \\ \end{split} $ |

即1)成立。

2)对于

| $P({Y^ + }|\delta _A^{{U^ + }}(x)) < P(Y|\delta _A^U(x)) \leqslant \alpha $ |

当

| $P({Y^ + }|\delta _A^{{U^ + }}(x)) = P(Y|\delta _A^U(x)) \leqslant \alpha $ |

因此

对于

因此

当

| $P({Y^ + }|\delta _A^{{U^ + }}(x)) = P(Y|\delta _A^U(x)) > \alpha $ |

即

| $\begin{split} \underline N _A^{(\alpha ,\beta )}({Y^ + }) = (\underline N _A^{(\alpha ,\beta )}(Y) - \quad\quad\quad\quad \\ \{ x \in \underline N _A^{(\alpha ,\beta )}(Y) \cap \delta _A^{{U^ + }}({x^ + })|P({Y^ + }|\delta _A^{{U^ + }}(x)) \leqslant \alpha \} ) \cup \\ \{ x \in \{ {x^ + }\} |P({Y^ + }|\delta _A^{{U^ + }}(x)) > \alpha \} \quad\quad \quad \\ \end{split} $ |

定理2证明完毕。

定理2表明,当信息系统增加一个对象后,新的邻域决策粗糙下近似集变化呈现一定的规律,例如从

类似于定理2的研究方法,接下来可以进一步得到上近似集的增量式更新。

定理3 设邻域型信息系统

| $\begin{split} 1)\overline N _A^{(\alpha ,\beta )}&({X^ + }) = \overline N _A^{(\alpha ,\beta )}(X) \cup \\ &\{ x \in \delta _A^{{U^ + }}({x^ + }) - \overline N _A^{(\alpha ,\beta )}(X)|P({X^ + }|\delta _A^{{U^ + }}(x)) \geqslant \beta \} \\ \end{split} $ |

| $\begin{split} 2)\overline N _A^{(\alpha ,\beta )}&({Y^ + }) = (\overline N _A^{(\alpha ,\beta )}(Y) - \\ &\{ x \in \overline N _A^{(\alpha ,\beta )}(Y) \cap \delta _A^{{U^ + }}({x^ + })|P({Y^ + }|\delta _A^{{U^ + }}(x)) < \beta \} ) \cup \\ &\{ x \in \{ {x^ + }\} |P({Y^ + }|\delta _A^{{U^ + }}(x)) \geqslant \beta \} \\ \end{split} $ |

证明 证明过程同定理2。

定理3类似于定理2,更新上近似集时也只需要针对部分对象集进行计算便可完成,例如从

定理2和定理3分别给出当邻域信息系统增加一个对象时,邻域决策粗糙上下近似的增量式更新问题,当信息系统通过增加多个对象,可以根据定理2和定理3逐步进行迭代,直至完成最终的更新。

2.2 论域中对象减少时模型的增量式更新类似于第2.1节中研究方法,本节将进一步提出论域中对象减少时模型的增量式更新,首先分析对象减少时概率的变化关系。

定理4[18] 设邻域型信息系统

1)

| $P({X^ - }|\delta _A^{{U^ - }}(x)) \leqslant P(X|\delta _A^U(x))$ |

| $P({Y^ - }|\delta _A^{{U^ - }}(x)) > P(Y|\delta _A^U(x))$ |

2)

| $P({X^ - }|\delta _A^{{U^ - }}(x)) = P(X|\delta _A^U(x))$ |

| $P({Y^ - }|\delta _A^{{U^ - }}(x)) = P(Y|\delta _A^U(x))$ |

定理4给出信息系统论域

定理5 设邻域型信息系统

| $\begin{split} 1)\underline N _A^{(\alpha ,\beta )}&({X^ - }) = \underline N _A^{(\alpha ,\beta )}(X) - \{ x \in \underline N _A^{(\alpha ,\beta )}(X) \cap \\ &(\delta _A^U({x^ - }) - \{ {x^ - }\} )|P({X^ - }|\delta _A^{{U^ - }}(x)) \leqslant \alpha \} \quad\quad\quad\quad\quad \\ \end{split} $ |

| $\begin{split} 2)\underline N _A^{(\alpha ,\beta )}&({Y^ - }) = \underline N _A^{(\alpha ,\beta )}(Y) \cup \\ &\{ x \in \delta _A^U({x^ - }) - \{ {x^ - }\} - \underline N _A^{(\alpha ,\beta )}(Y)|P({Y^ - }|\delta _A^{{U^ - }}(x) > \alpha \} \\ \end{split} $ |

证明 1)对于

| $P({X^ - }|\delta _A^{{U^ - }}(x)) \leqslant P(X|\delta _A^U(x))$ |

由于

若对象满足

对于

| $P({X^ - }|\delta _A^{{U^ - }}(x)) \leqslant P(X|\delta _A^U(x)) \leqslant \alpha .$ |

因此

若对象满足

2)对于

| $P({Y^ - }|\delta _A^{{U^ - }}(x)) > P(Y|\delta _A^U(x)) > \alpha $ |

若对象满足

| $P({Y^ - }|\delta _A^{{U^ - }}(x)) = P(Y|\delta _A^U(x)) > \alpha $ |

因此

对于

| $P({Y^ - }|\delta _A^{{U^ - }}(x)) > P(Y|\delta _A^U(x)),P(Y|\delta _A^U(x)) \leqslant \alpha $ |

此时不能直接确定

若对象

| $P({Y^ - }|\delta _A^{{U^ - }}(x)) = P(Y|\delta _A^U(x)) \leqslant \alpha $ |

即

因此只需要计算对象集

定理5证明完毕。

定理5表明,当邻域型信息系统移除一个对象

定理6 设邻域型信息系统

| $\begin{split} 1)\overline N _A^{(\alpha ,\beta )}({X^ - }) = &\overline N _A^{(\alpha ,\beta )}(X) - \{ x \in \overline N _A^{(\alpha ,\beta )}(X) \cap \\ &(\delta _A^U({x^ - }) - \{ {x^ - }\} )|P({X^ - }|\delta _A^{{U^ - }}(x)) < \beta \} \quad\quad \\ \end{split} $ |

| $\begin{split} 2)\overline N _A^{(\alpha ,\beta )}&({Y^ - }) = \overline N _A^{(\alpha ,\beta )}(Y) \cup \\ &\{ x \in \delta _A^U({x^ - }) - \{ {x^ - }\} - \overline N _A^{(\alpha ,\beta )}(Y)|P({Y^ - }|\delta _A^{{U^ - }}(x) \geqslant \beta \} \\ \end{split} $ |

证明 1)根据定理5的证明结果,对于

2)根据定理5的证明结果,对于

定理6与定理5类似,只需要在原先上近似集

定理5和定理6分别给出当邻域型信息系统移除一个对象时上下近似集的增量式更新问题,当信息系统同时移除多个对象时,可以根据定理5和定理6逐步进行迭代,直至完成最终的更新。

3 邻域决策粗糙集更新算法根据本文所提出的增量式更新方法,接下来将进一步提出对应的邻域决策粗糙集增量式更新算法,具体如算法1和算法2所示。

算法1 论域增加时邻域决策粗糙集的增量式更新算法

输入 1)邻域型信息系统

2)信息系统增加对象集

输出 新的近似集

1)将初始时的信息系统

2)对于

3)计算对象

4)重复迭代计算步骤2)~3)。

5)令

| $ \begin{array}{l} \underline N _A^{(\alpha ,\beta )}({X^ + }) = \underline N _A^{(\alpha ,\beta )}({X^{(s)}});\\ \overline N _A^{(\alpha ,\beta )}({X^ + }) = \overline N _A^{(\alpha ,\beta )}({X^{(s)}}). \end{array} $ |

返回

算法2 论域减少时邻域决策粗糙集的增量式更新算法

输入 1)邻域型信息系统

2)信息系统减少对象集

输出 新的近似集

1)将初始时的信息系统

2)对于

3)计算对象

4)重复迭代计算步骤2)~3)

5)令

| $ \begin{array}{l} \underline N _A^{(\alpha ,\beta )}({X^ - }) = \underline N _A^{(\alpha ,\beta )}({X^{(t)}});\\ \overline N _A^{(\alpha ,\beta )}({X^ - }) = \overline N _A^{(\alpha ,\beta )}({X^{(t)}}). \end{array} $ |

返回

在算法1所示的增量式计算过程中,每次在更新前信息系统的上下近似基础上进一步计算新的上下近似集,并且定理2和定理3已经表明,只需要计算新增对象的邻域类,便可以完成最终的更新,而不必去计算其他对象的邻域类,这样大大减少了重复的计算量,提高了更新的效率,因此整个算法1和算法2的时间复杂度可表示为

为了验证所提出增量式更新算法的有效性,将通过实验比较的方式进行验证。本实验主要将文中所提出的增量式更新算法与传统的非增量更新算法对同一组数据集进行动态更新计算,通过比较他们的动态更新效率来验证算法的有效性,其中表1所示的是实验中所使用的数据集,这些数据集均来源于UCI数据集库,其中数据集的各个属性均为数值类型。整个实验所运行的硬件环境为Intel Core G4560 3.5 GHz处理器和DDR4 8 GB内存。

表1所示的均为静态的数据集,为了模拟数据集动态变化的情形,本实验采用其他学者常用的处理方法[11-12, 17-18],即让数据集按照论域平均分成多个对象集,然后通过将这些对象集逐渐进行合并,达到了数据集论域动态增加的效果,将原始论域逐渐对这些对象集进行移除,便达到了数据集论域动态的减少。本实验将论域平均分成9个部分,这样可以构造出数据集的8次动态更新。实验中将数据集的决策类作为邻域决策粗糙集的近似对象集,即计算数据集每个决策类的上下近似增量式更新。实验中每个数据集的属性值均进行归一化处理,并且统一设定邻域半径

| 表 1 实验数据集 Tab.1 Experimental data set |

图1为各个数据集论域增加时增量式更新算法(算法1)与非增量式更新算法计算邻域决策粗糙集的时间比较结果,非增量式更新算法采用文献[10]提出的算法。

在图1所示的实验结果中,增量式算法的更新用时大幅度低于非增量式算法,并且随着数据集更新次数的增多,两类算法的差距不断增大。这主要是由于非增量式更新算法在进行模型的更新时,每次均基于完整的论域进行计算,产生的时间会越来越多。对于增量式更新算法,随着数据集论域的增大,更新所需的时间较少且增长的速率较为缓慢,这主要是由于增量式更新算法采用增量式的方法进行更新计算,每次均在前一次更新的结果上进行进一步更新,这样避免了原有对象的重复计算,大幅度提高更新效率,因此增量式算法更加高效。

|

Download:

|

| 图 1 论域增加时两类算法的更新用时比较 Fig. 1 Comparison of update time of two algorithms when universe is added | |

图2展示的是各个数据集论域减少时,增量式更新算法(算法2)与非增量式更新算法计算邻域决策粗糙集的时间比较结果,非增量式更新算法同样采用文献[10]提出的算法。

在图2所示的实验结果中,可以发现增量式更新算法的更新用时同样大幅度低于非增量式更新算法,对于非增量式更新算法,随着数据集论域的逐渐减少,其更新模型的用时也是逐渐减小,这主要是由于非增量式更新算法在进行更新时,对完整论域进行计算,因此随着论域的减少,非增量式算法的计算量也大幅度减小,产生的时间会越来越少,但是整体还是高于增量式算法。对于增量式更新算法,随着数据集论域的减小,其整体更新用时始终处于一个较低的水平,并且随着更新次数增加,更新用时也是逐渐减小的。这主要是由于增量式更新算法采用增量式的方法进行更新计算,在前一次更新结果的基础上计算后一次结果,由于论域逐渐减少,则更新时间会更加的少,从而效率远高于非增量式算法。

|

Download:

|

| 图 2 论域减少时两类算法的更新用时比较 Fig. 2 Comparison of update time of two algorithms when universe is reduced | |

综合图1和图2的实验结果,可以看出本文所提出的增量式更新算法的更新效率均大幅度高于传统的非增量式算法,并且所提出的算法随数据集论域变化的影响较小,这说明了本文所提出的增量式更新算法具有很高的优越性。

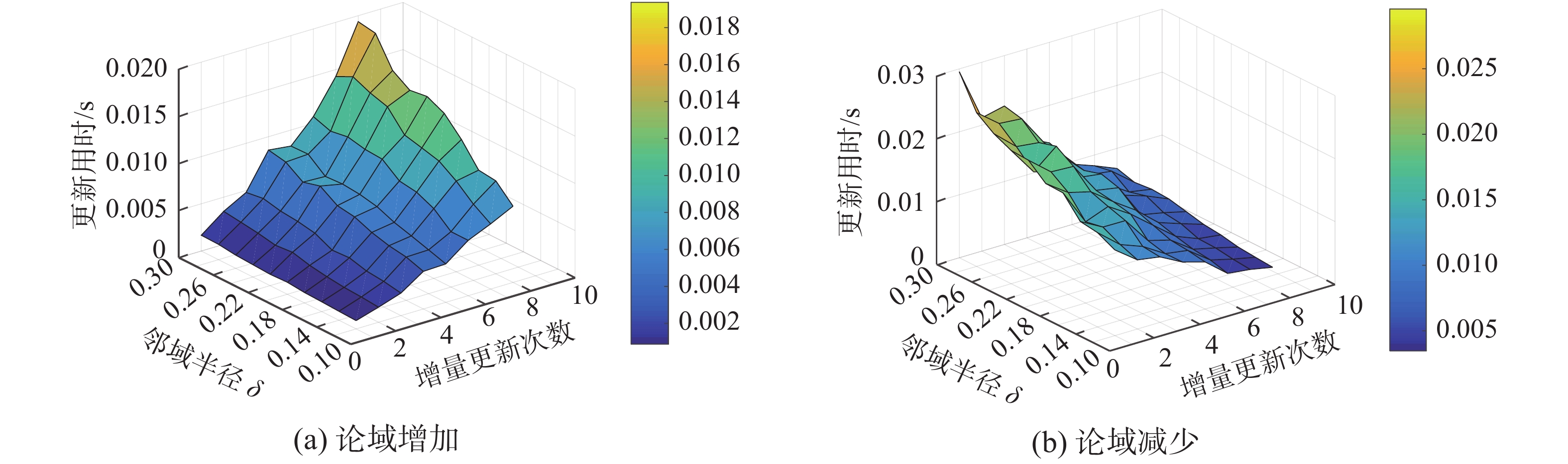

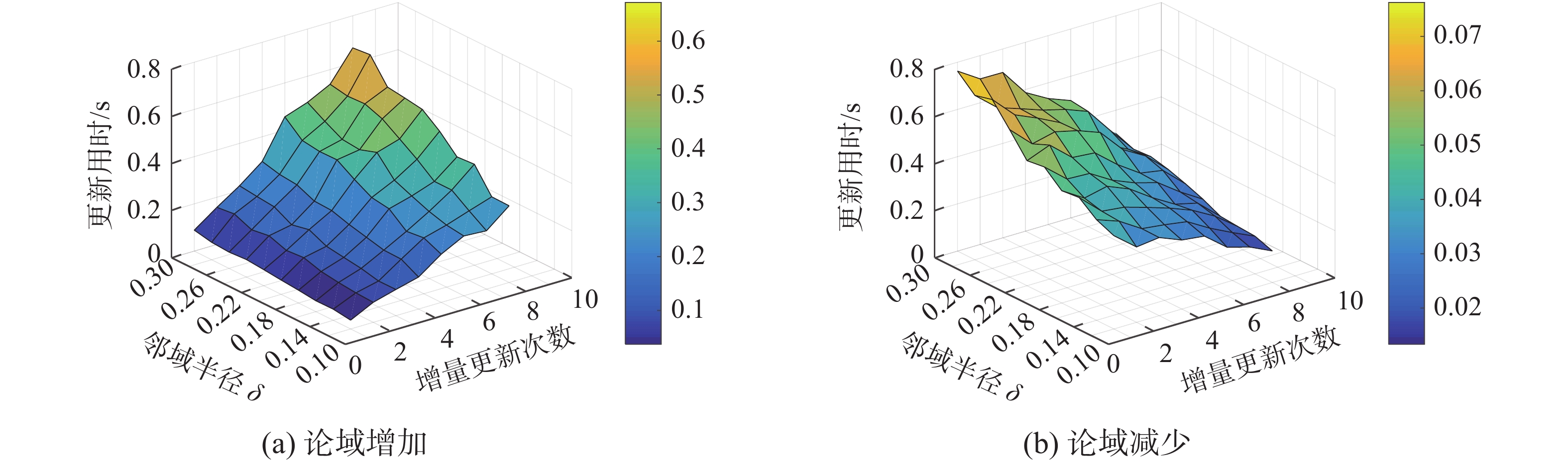

另一方面,在本文所提出的邻域决策粗糙集增量式更新算法中,有3个重要的参数,分别为邻域半径

图3~6所示的是部分数据集在不用邻域半径

通过图3~6的结果可以看出,随着邻域半径的逐渐增大,增量式更新算法的更新用时是逐渐增大的,这主要是由于本文所提出的增量更新算法,计算新论域下的模型时,需要计算变化对象的邻域类,并基于这些邻域类进行更新计算,而邻域半径的增大无疑会增加邻域类中对象的数量,因此计算量会增加,从而展现出了图3~6的结果,但是对比图1和图2,这种增量式算法的用时仍然大幅度小于非增量式算法。

|

Download:

|

| 图 3 数据集pima在不同邻域半径下算法更新用时比较 Fig. 3 Comparison of algorithm updating time of pima data set under different neighborhood radius | |

|

Download:

|

| 图 4 数据集wdbc在不同邻域半径下算法更新用时比较 Fig. 4 Comparison of algorithm updating time of wdbc data set under different neighborhood radius | |

|

Download:

|

| 图 5 数据集biodeg在不同邻域半径下算法更新用时比较 Fig. 5 Comparison of algorithm updating time of biodeg data set under different neighborhood radius | |

|

Download:

|

| 图 6 数据集musk在不同邻域半径下算法更新用时比较 Fig. 6 Comparison of algorithm updating time of musk data set under different neighborhood radius | |

邻域决策粗糙集是传统决策粗糙集的重要拓展,针对现实环境下数据集的动态性,本文提出一种论域动态变化时的邻域决策粗糙集增量式更新算法。本文首先研究了论域中单个对象变化时,模型的增量式更新问题,然后以单个对象变化为基础,通过迭代方式完成对象批量变化时的增量式更新问题,实验分析表明,所提出的增量式算法在更新动态数据时,其效率大幅度高于非增量式算法,且增量式算法的更新时间受论域对象变化的影响较小,因此说明了所提出的增量式更新算法具有很高的优越性,从而也进一步推动了决策粗糙集在实际环境下的应用。在本文研究成果的基础上,接下来可以进一步在邻域决策粗糙集的增量式属性约简问题上进行探索。

| [1] |

YAO Yiyu. Three-way decisions with probabilistic rough sets[J]. Information sciences, 2010, 180(3): 341-353. DOI:10.1016/j.ins.2009.09.021 ( 0) 0)

|

| [2] |

YAO Yiyu. The superiority of three-way decisions in probabilistic rough set models[J]. Information sciences, 2011, 181(6): 1080-1096. DOI:10.1016/j.ins.2010.11.019 ( 0) 0)

|

| [3] |

陈家俊, 徐华丽, 魏赟. 多重代价多粒度决策粗糙集模型研究[J]. 计算机科学与探索, 2018, 12(5): 839-850. CHEN Jiajun, XU Huali, WEI Yun. Multi-cost based multi-granulation decision-theoretic rough set model[J]. Journal of frontiers of computer science and technology, 2018, 12(5): 839-850. DOI:10.3778/j.issn.1673-9418.1705019 (  0) 0)

|

| [4] |

JIA Xiuyi, LI Weiwei, SHANG Lin. A multiphase cost-sensitive learning method based on the multiclass three-way decision-theoretic rough set model[J]. Information sciences, 2019, 485: 248-262. DOI:10.1016/j.ins.2019.01.067 ( 0) 0)

|

| [5] |

张婷, 张红云, 王真. 基于三支决策粗糙集的迭代量化的图像检索算法[J]. 南京大学学报(自然科学版), 2018, 54(4): 714-724. ZHANG Ting, ZHANG Hongyun, WANG Zhen. image retrieval: Iterative quantization based on saliency detection and three-way decision based rough sets[J]. Journal of Nanjing University (natural sciences edition), 2018, 54(4): 714-724. (  0) 0)

|

| [6] |

ZHAO Xuerong, HU Baoqing. Three-way decisions with decision-theoretic rough sets in multiset-valued information tables[J]. Information sciences, 2020, 507: 684-699. DOI:10.1016/j.ins.2018.08.024 ( 0) 0)

|

| [7] |

LIU Dun, LIANG Decui, WANG Changchun. A novel three-way decision model based on incomplete information system[J]. Knowledge-based systems, 2016, 91: 32-45. DOI:10.1016/j.knosys.2015.07.036 ( 0) 0)

|

| [8] |

SUN Bingzhen, MA Weimin, ZHAO Haiyan. Decision-theoretic rough fuzzy set model and application[J]. Information sciences, 2014, 283: 180-196. DOI:10.1016/j.ins.2014.06.045 ( 0) 0)

|

| [9] |

DOU Huili, YANG Xibei, SONG Xiaoning, et al. Decision-theoretic rough set: a multicost strategy[J]. Knowledge-based systems, 2016, 91: 71-83. DOI:10.1016/j.knosys.2015.09.011 ( 0) 0)

|

| [10] |

LI Weiwei, HUANG Zhiqiu, JIA Xiuyi, et al. Neighborhood based decision-theoretic rough set models[J]. International journal of approximate reasoning, 2016, 69: 1-17. DOI:10.1016/j.ijar.2015.11.005 ( 0) 0)

|

| [11] |

SHU Wenhao, QIAN Wenbin, XIE Yonghong. Incremental approaches for feature selection from dynamic data with the variation of multiple objects[J]. Knowledge-based systems, 2019, 163: 320-331. DOI:10.1016/j.knosys.2018.08.028 ( 0) 0)

|

| [12] |

段海玲, 王光琼. 一种高效的复杂信息系统增量式属性约简[J]. 华南理工大学学报(自然科学版), 2019, 47(6): 18-30. DUAN Hailing, WANG Guangqiong. An efficient incremental attribute reduction for complex information systems[J]. Journal of South China University of Technology (natural science edition), 2019, 47(6): 18-30. (  0) 0)

|

| [13] |

HU Chengxiang, ZHANG Li, WANG Bangjun, et al. Incremental updating knowledge in neighborhood multigranulation rough sets under dynamic granular structures[J]. Knowledge-based systems, 2019, 163: 811-829. DOI:10.1016/j.knosys.2018.10.010 ( 0) 0)

|

| [14] |

ZHANG Qinghua, LV Gongxun, CHEN Yuhong, et al. A dynamic three-way decision model based on the updating of attribute values[J]. Knowledge-based systems, 2018, 142: 71-84. DOI:10.1016/j.knosys.2017.11.026 ( 0) 0)

|

| [15] |

XU Jianfeng, MIAO Duoqian, ZHANG Yuanjian, et al. A three-way decisions model with probabilistic rough sets for stream computing[J]. International journal of approximate reasoning, 2017, 88: 1-22. DOI:10.1016/j.ijar.2017.05.001 ( 0) 0)

|

| [16] |

CHEN Hongmei, LI Tianrui, LUO Chuan, et al. A decision-theoretic rough set approach for dynamic data mining[J]. IEEE transactions on fuzzy systems, 2015, 23(6): 1958-1970. DOI:10.1109/TFUZZ.2014.2387877 ( 0) 0)

|

| [17] |

赵小龙, 杨燕. 基于邻域粒化条件熵的增量式属性约简算法[J]. 控制与决策, 2019, 34(10): 2061-2072. ZHAO Xiaolong, YANG Yan. Incremental attribute reduction algorithm based on neighborhood granulation conditional entropy[J]. Control and decision, 2019, 34(10): 2061-2072. (  0) 0)

|

| [18] |

杨臻, 邱保志. 混合信息系统的动态变精度粗糙集模型[J]. 控制与决策, 2020, 35(2): 297-308. YANG Zhen, QIU Baozhi. Dynamic variable precision rough set model of mixed information system[J]. Control and decision, 2020, 35(2): 297-308. (  0) 0)

|

| [19] |

LUO Chuan, LI Tianrui, ZHANG Yi, et al. Matrix approach to decision-theoretic rough sets for evolving data[J]. Knowledge-based systems, 2016, 99: 123-134. DOI:10.1016/j.knosys.2016.01.042 ( 0) 0)

|

2021, Vol. 16

2021, Vol. 16