2. 道路交通安全公安部重点实验室,江苏 无锡 214151;

3. 常州大学 信息科学与工程学院,江苏 常州 213164

2. Laboratory of Ministry of Public Security for Road Traffic Safety, Wuxi 214151, China;

3. School of Information Science and Engineering, Changzhou University, Changzhou 213164, China

近年来,深度学习进入蓬勃发展时代,以深度学习为基础的图像识别[1-3]虽然识别准确率高,但往往对硬件设备要求严格,具有训练时间长达数周、样本量需求过大等不足之处。与之相比,基于稀疏表示的图像识别训练简单、对噪声有强鲁棒性,逐渐应用在社会安全、经济工程等领域。

字典学习的目的是通过训练样本图片,习得可以表示给定信号的字典和编码,共分为有监督和无监督两种情况。经典的无监督字典学习如KSVD[4]算法,可以有效解决高维矩阵求解问题,广泛应用于图像重建及图像压缩领域。而有监督字典学习多应用于图像识别领域,如人脸识别、表情识别等。根据字典原子和训练标签之间的相关性,有监督字典学习可分为类共享字典学习、类别特色字典学习、混合字典学习3类。

类共享字典学习如文献[5-7]等,字典和稀疏编码由所有训练样本共同构造,单个字典原子可表示全体数据类别。Zhang等[8]以KSVD算法为基础,在保证字典识别能力的基础上引入分类误差,提高线性分类器的分类能力。Jiang等[9]在其基础上,增加标签一致性术语,提出标签一致性KSVD (LCKSVD)算法。Mairal等[10]提出了任务驱动的字典学习框架。类共享字典在保留表示数据共性的同时丢失字典原子和类标签之间的关系,忽视了类别之间的差异性。

类别特色字典学习如文献[11-13]等,每个字典原子对应一类标签信息,通过类特定误差进行分类。Wright等[14]提出基于稀疏表示的分类框架(sparse representation based classification,SRC),自此,类别特色字典广泛应用于人脸分类器设计中。Sprechmann等[15]为每一类分别学习稀疏表示字典,Ramirez等[16]提出了一种结构非相干字典学习模型,通过最小化字典的相干项来提高字典的学习效率。Yang等[17]提出了Fisher判别字典学习(fisher discrimination dictionary learning, FDDL),其中表示残差和表示系数都实现了判别信息。2018年,Wang等[18]结合字典学习和局部约束思想,提出FDDLLCSRC方法。同年,Li等[19]在FDDL基础上提出IKCFDDL算法,在字典学习基础上增添K均值聚类思想,提升算法运行效率。

混合字典即结合类共享字典与类别特色字典。Deng等[20]提出了基于扩展稀疏表示的分类方法(extended SRC: undersampled face recognition via intraclass variant dictionary,ESRC),在学习类别特色字典的同时构造类内差异字典,即共享字典。受ESRC算法启发,2015年Li等[21]提出SCSDL算法,2017年提出CSICVDL算法[22],提取不同类别样本中数据共性提升字典辨别力。这些混合字典学习方法在人脸识别方面表现良好,然而,在对于噪声、异常值和遮挡等干扰情况时处理能力较差。

除上述问题以外,由于样本数量受限,传统字典学习习得的字典鲁棒性差,不能完全表示数据组成的共性、特殊性、干扰性。针对此种情况,本文提出一种新的稀疏综合字典学习的小样本人脸识别模型(SCDL)。SCDL模型包括混合特色字典、扩充干扰字典以及低秩字典3项。将类共享字典与类别特色字典以及Fisher准则整合至混合特色字典模型中,在提取不同数据特殊性的同时捕捉数据之间的共性,利用扩充干扰字典和低秩字典增强模型对异常情况(如遮挡、噪声等)的处理能力。最后,本文针对模型提出一种新的分类策略,并在受限AR人脸数据库、YaleB人脸数据库和非受限LFW人脸数据库进行实验,结果表明本文算法不仅可以取得较高分类率,并且在面对遮挡、噪声等异常情况时较其余算法有更好的识别力和鲁棒性。

1 相关工作设定训练数据集

| ${ A} = \left\{ {{A_1},{A_2}, \cdots ,{A_K}} \right\} \in {{\bf R}^{m \times N}} $ |

测试数据集合

| ${ Y} = \left\{ {{Y_1},{Y_2}, \cdots, {Y_K}} \right\} \in {{\bf R}^{m \times {N_1}}} $ |

式中:

稀疏表示(SRC)针对测试集

| $\left[ {\begin{array}{*{20}{c}} {\hat a} \\ {\hat b} \end{array}} \right]{\rm{ = }}\arg \mathop {\min }\limits_{a,b} \left\{ {\left\| {{ y} - \left[ {A,D} \right]\left[ {\begin{array}{*{20}{c}} a \\ b \end{array}} \right]} \right\|_2^2 + \lambda {{\left\| {\left[ {\begin{array}{*{20}{c}} a \\ b \end{array}} \right]} \right\|}_1}} \right\}$ |

ESRC模型分为重构误差项与正则项两部分,正则化参数

类别字典学习为每类数据单独学习一个子字典,即习得的字典

| $\mathop {\min }\limits_{\left\{ {{{ D}_i},{{ X}_i}} \right\}} {\left\{ {\left\| {{{ A}_i} - {{ D}_i}{{ X}_i}} \right\|_F^2 + \lambda {{\left\| {{{ X}_i}} \right\|}_1}} \right\}_{}}{\kern 1pt} {\rm{s.t.}}{\left\| {{{ d}_j}} \right\|_2} = 1,\forall j{\kern 1pt} {\kern 1pt} {\kern 1pt} $ |

对于单个测试样本

Fisher判别准则以投影思想为核心,目的是使同类样本尽可能集中的同时,异类样本尽可能疏散。

假定

| ${{ u}_i} = \frac{1}{{{n_i}}}\sum\limits_{{x_k} \in {{ X}_i}} {{{ x}_k}} $ |

可定义类内散度矩阵

| ${{ S}_W} = \sum\limits_{i = 1}^K {\sum\limits_{{x_k} \in {X_i}} {\left( {{{ x}_k} - {{ u}_i}} \right)} } {\left( {{{ x}_k} - {{ u}_i}} \right)^{\rm{{\rm T}}}}$ |

| ${{ S}_B} = \sum\limits_{i = 1}^K {{n_i}\left( {{{ u}_i} - {{ u}_0}} \right)} {\left( {{{ u}_i} - {{ u}_0}} \right)^{\rm{T}}}$ |

稀疏综合字典学习分类方法包括训练和测试两大步骤,分为扩充干扰字典、混合特色字典、低秩字典三大部分,采用分步优化方法求解,充分提取数据之间的共性、特殊性、干扰性。

2.1 扩充干扰特色字典 2.1.1 扩充干扰字典模型对于一张图片

|

Download:

|

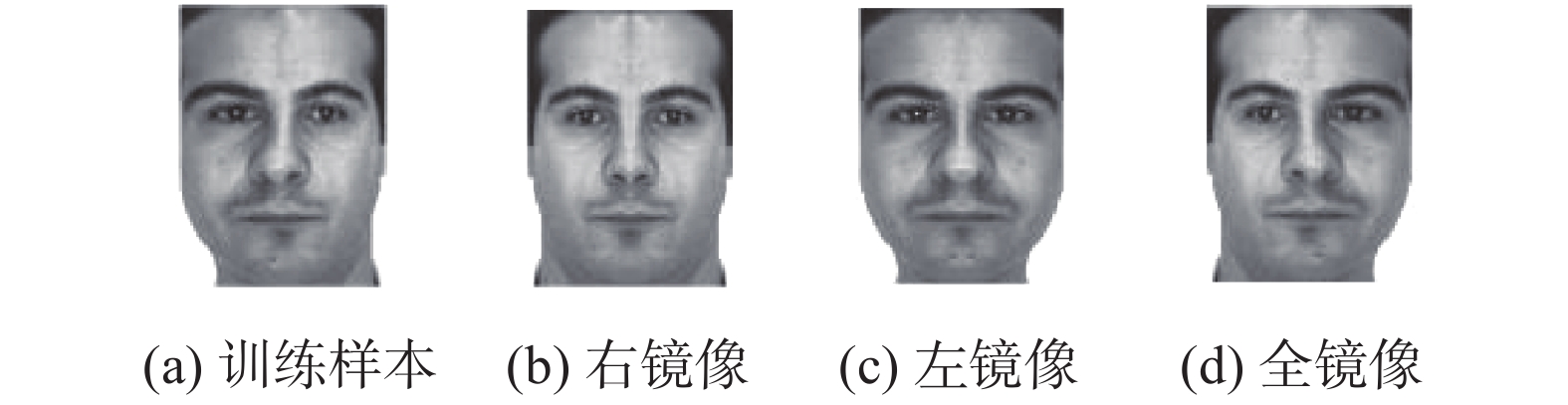

| 图 1 镜像图片 Fig. 1 Mirror image | |

以

集合

| ${J_{\left( {{{ D}_b},{ B}} \right)}} \!=\! \arg \mathop {\min }\limits_{\left( {{{ D}_b},{ B}} \right)} \left\{ \begin{gathered} g\left( {{ A}',{{ D}_b},{ B}} \right) \!+\! {\lambda _1}{\left\| { B} \right\|_1} \!+\! {\lambda _2}f\left( {{ B},{{ D}_b}} \right) \end{gathered} \right\}$ | (1) |

模型分为重构误差项、稀疏保证项和判别系数项3部分,其中,

| $g\left( {{ A}',{{ D}_b},{ B}} \right) = \left\| {{{{ A}'}_i} - {{ D}_b}{{ B}_i}} \right\|_F^2 + \left\| {{{{ A}'}_i} - {{ D}_{bi}}{{ B}_i}^i} \right\|_F^2$ |

式中:

为了提高编码识别力,增添编码约束项

| $ {{ D}_{bi - }} = [{D_{b1}}\quad {D_{b2}}\quad \cdots \quad {D_{bi - 1}}\quad{D_{bi + 1}}\quad \cdots \quad{D_{bK}}] $ |

表示字典中除了

最终,

| $f\left( {{ B},{{ D}_b}} \right) = {\rm{tr}}({{ S}_W}({ B}) - {{ S}_B}({ B})){\rm{ + }}\left\| {{{ D}_{bi}}^{\rm{T}}{{ D}_{bi - }}} \right\|_F^2$ |

式中:

目标函数(1)的完整形式为

| $\begin{gathered}{J_{\left( {{{ D}_b},{ B}} \right)}}\! =\! \arg \mathop {\min }\limits_{\left( {{{ D}_b},{ B}} \right)} \left\{\begin{gathered} \left\| {{{{ A}'}_i} \!-\! {{ D}_b}{{ B}_i}} \right\|_F^2 \!+\! \left\| {{{{ A}'}_i} \!-\! {{ D}_{bi}}{{ B}_i}^i} \right\|_F^2 + {\lambda _1}{\left\| { B} \right\|_1} \!+\end{gathered}\right.\\ \left.{\lambda _2}\left( \begin{gathered} {\rm{tr}}({{ S}_W}(B) - {{ S}_B}(B)) {\rm{ + }}\left\| {{{ D}_{bi}}^{\rm T}{{ D}_{bi - }}} \right\|_F^2 \end{gathered} \right) \right\} \end{gathered}$ |

式(1)为非凸函数,其优化过程如下所示:

1) 初始化字典

将字典原子初始化为训练数据

2) 保证字典

目标函数转化为

| $Q\left( {{{ B}_i}} \right) = \arg \mathop {\min }\limits_{{B_i}} \left\{ {\theta \left( {{{{ A}'}_i},{{ D}_{bi}},{{ B}_i}} \right) + 2\gamma {{\left\| {{{ B}_i}} \right\|}_1}} \right\}$ | (2) |

使用文献[27]中的方法求解稀疏编码

| $\begin{gathered} \theta \left( {{{{ A}'}_i},{{ D}_{bi}},{{ B}_i}} \right) = \left\| {{{{ A}'}_i} - {{ D}_b}{{ B}_i}} \right\|_F^2 + \\ {\rm{ }} \left\| {{{{ A}'}_i} - {{ D}_{bi}}{{ B}_i}^i} \right\|_F^2 +{\lambda _2}f\left( {{ B},{{ D}_b}} \right) \\ \end{gathered} $ |

3) 保证稀疏编码

本文逐个更新

目标函数可转化为

| $\begin{gathered} {{ D}_{bi}} = \arg \mathop {\min }\limits_{{D_{bi}}} \left\| {\hat { A} - {{ D}_b}_i{{ X}_i}} \right\|_F^2 + \left\| {{{{ A}'}_i} - {{ D}_{bi}}{ B}_i^i} \right\|_F^2 + \left\| {{ D}_{bi}^{\rm T}{{ D}_{bi - }}} \right\|_F^2{\rm{ }}\\ {\rm{s.t.}}{\left\| {{{ D}_{bi}}\left( {:,j} \right)} \right\|_2} = 1,\forall i,j \\ \end{gathered} $ |

其中

| $\begin{gathered} {{ D}_{bi}} = \arg \mathop {\min }\limits_{{D_{bi}}} \left\| {{{ {\varLambda}} _i} - {{ D}_{bi}}{{ Z}_i}} \right\|_F^2 + \left\| {{ D}_{bi}^{\rm T}{{ D}_{bi - }}} \right\|_F^2\\{{\rm{ }}{\rm{s.t.}}{{\left\| {{{ D}_{bi}}\left( {:,j} \right)} \right\|}_2} = 1,\forall i,j} \end{gathered} $ |

其中

设

| $d_{bi}^k = \arg \mathop {\min }\limits_{d_{bi}^k} \left\{ \begin{gathered} g\left( {d_{bi}^k} \right) = \left\| {{{\hat { {\varLambda}} }_i} - { d}_{bi}^k{z_{\left( k \right)}}} \right\|_F^2 + \left\| {{ d}_{bi}^{{k^{\rm{T}}}}{{ D}_{bi - }}} \right\|_F^2 \\ \end{gathered} \right\}$ | (3) |

令

| ${ d}_{bi}^k = {\left( {\left( {{{ D}_{bi - }}} \right){{\left( {{{ D}_{bi - }}} \right)}^{\rm{T}}} + \left\| {{z_{\left( k \right)}}} \right\|_2^2{ I}} \right)^{ - 1}}{\hat { {\varLambda}} _i}{{ z}^{\rm{T}}}_{\left( k \right)}$ |

将得到的

4)重复2)和3),直到前后两次的函数

扩充干扰字典算法总体实现步骤如下:

输入 训练样本

输出 字典

1)初始化字典

2)固定字典

3)固定稀疏编码

4)重复2)和3),直到前后两次的函数的值满足判断条件为止。

2.2 混合特色字典 2.2.1 混合特色字典模型对于训练集

| $\begin{gathered} J({{ D}_c},{ D},{ C},{ X}) = \mathop {\arg \min }\limits_{{D_c},D,C,X} \Bigg\{ \left\| {{{ A}_i} - { D}_c{{ C}_i} - {{ D}_i}{ X}_i^i} \right\|_F^2 +\\ {\lambda _1}\left( {{{\left\| { C} \right\|}_1} + {{\left\| { X} \right\|}_1}} \right) \Bigg\} + {\lambda _2}\left( {{\rm{tr}}\left( {{{ S}_w}\left( X \right) - {{ S}_B}\left( X \right)} \right)} \right) \end{gathered} $ | (4) |

式(4)为非凸函数,其优化过程如下所示:

1) 初始化字典

将训练数据

2) 保证字典

更新

| $Q\left( {{{ X}_i}^i} \right) = \arg \mathop {\min }\limits_{{{ X}_i}} \left\{ {{\theta _1}\left( {{{ A}_i},{{ D}_i},{{ X}_i}} \right) + 2\gamma {{\left\| {{{ X}_i}^i} \right\|}_1}} \right\}$ | (5) |

其中,

| $ \begin{gathered} {\theta _1}\left( {{ X}_i^i} \right) = \left\| {{{ A}_i} - {{ D}_c}{{ C}_i} - {{ D}_i}{ X}_i^i} \right\|_F^2 + {\lambda _2}{\rm {tr}}\left( {{{ S}_w}\left( X \right) - {{ S}_B}\left( X \right)} \right) \end{gathered}$ |

更新

| $Q\left( {{{ C}_i}} \right) = \arg \mathop {\min }\limits_{{{ C}_i}} \left\{ {\left\| {{{ A}_i} - {{ D}_c}{{ C}_i} - {{ D}_i}{ X}_i^i} \right\|_F^2 + 2\gamma {{\left\| {{{ C}_i}} \right\|}_1}} \right\}$ | (6) |

3) 以章节2.1.2为例,固定稀疏编码

4) 重复2)和3),直到前后两次的函数

混合特色字典算法总体实现步骤如下:

输入 训练样本

输出 字典

1)初始化字典

2)固定字典

3)固定稀疏编码

4)重复2)和3),直到前后两次的函数的值满足判断条件为止。

2.3 低秩字典 2.3.1 低秩字典模型在人脸识别中,假设扰动分量只占图像特征的一小部分,即图像的稀疏分量,使用矩阵低秩分解[28]方法从图像中提取干扰成分(如噪声、孤立点和遮挡)。

| $\mathop {\min }\limits_{{\varGamma _j},{E_j}} {\rm{rank}}({\varGamma _j}) + r{\left\| {{E_j}} \right\|_0}{\rm{ }}{\rm{s.t.}}{G_j} = {\varGamma _j} + {E_j}$ |

以如图2所示,取图片低秩分量

| $J({{ D}_p}{\rm{,}}{ P}) = \arg \min \left\{ {\left\| {{ E} - {{ D}_p}{{ P}_i}} \right\| + {\lambda _1}{{\left\| { P} \right\|}_1}} \right\}$ | (7) |

式(7)为非凸函数,其优化过程如下所示:

1) 初始化字典

将字典原子初始化为训练数据

|

Download:

|

| 图 2 原图及低秩分量 Fig. 2 Original graph and low rank components | |

2) 保证字典

| $Q\left( {{{ P}_i}} \right) = \arg \mathop {\min }\limits_{{P_i}} \left\{ {\left\| {{{ E}_i} - {{ D}_p}{{ P}_i}} \right\|_F^2 + 2\gamma {{\left\| {{{ P}_i}} \right\|}_1}} \right\}$ |

3)以章节2.1.2为例,固定稀疏编码

4)重复2)和3),直到前后两次的函数的值满足判断条件为止。

低秩字典优化算法总体实现步骤如下:

输入 训练样本

输出 字典和稀疏系数

1)初始化字典

2)固定字典

3)固定稀疏编码

4)重复2)和3),直到前后两次的函数的值满足判断条件为止。

2.4 分类策略本文提出全局分类策略如下:

| $\left[\! {\begin{array}{*{20}{c}} {{{\hat x}_{\rm{1}}}} \\ {{{\hat x}_{\rm{2}}}} \\ {{{\hat x}_{\rm{3}}}} \\ {{{\hat x}_{\rm{4}}}} \end{array}}\! \right] = \mathop {\arg \min }\limits_{{x_{\rm{1}}},{x_{\rm{2}}},{x_{\rm{3}}},{x_{\rm{4}}}} \left\{ {\left\| {{ y} - \left[ \!{{{ D}_c},{ D},{{ D}_b},{{ D}_p}} \! \right]\left[\! {\begin{array}{*{20}{c}} {{x_{\rm{1}}}} \\ {{x_{\rm{2}}}} \\ {{x_{\rm{3}}}} \\ {{x_{\rm{4}}}} \end{array}}\! \right]} \right\|_2^2 + {\lambda _1}{{\left\| {\begin{array}{*{20}{c}} {{x_{\rm{1}}}} \\ {{x_{\rm{2}}}} \\ {{x_{\rm{3}}}} \\ {{x_{\rm{4}}}} \end{array}} \right\|}_1}} \right\}$ |

测试样本

| ${e_i} = \left\| {{ y} - \left[ {{{ D}_c},{ D},{{ D}_b},{{ D}_p}} \right]\left[ {\begin{array}{*{20}{c}} {{{\hat x}_{\rm{1}}}} \\ {{{\hat x}_{\rm{2}}}} \\ {{{\hat x}_{\rm{3}}}} \\ {{{\hat x}_{\rm{4}}}} \end{array}} \right]} \right\|_2^2$ | (8) |

于是

| $\operatorname{identify} ({ y}) = \arg {\min _i}\{ {{ e}_i}\} $ | (9) |

稀疏综合字典学习的小样本人脸识别算法分为3个子算法,利用训练数据

|

Download:

|

| 图 3 算法流程 Fig. 3 Algorithm flowchart | |

稀疏综合字典学习的小样本人脸识别算法总体实现步骤如下:

输入 训练样本

输出 分类标签。

1)利用训练数据

2)利用训练数据

3)利用辅助数据

4)利用式(8)、(9)得到样本标签。

3 实验结果及分析 3.1 实验平台和参数设置本文实验环境为64位Window 10操作系统,内存32 GB,Intel(R) Xeon(R) CPU E5-2620 v4 @ 2.10 GHz,并用MatlabR2016b软件编程实现。

实验选取AR人脸数据库、YaleB人脸数据库、LFW人脸数据库进行实验,多次实验取平均值。图像都经过标准化处理,比较算法包括SRC、FDDL、CRC、ESRC、SVGDL和CSICVDL、SCSDL、FDDLLCSRC、LKCFDDL。

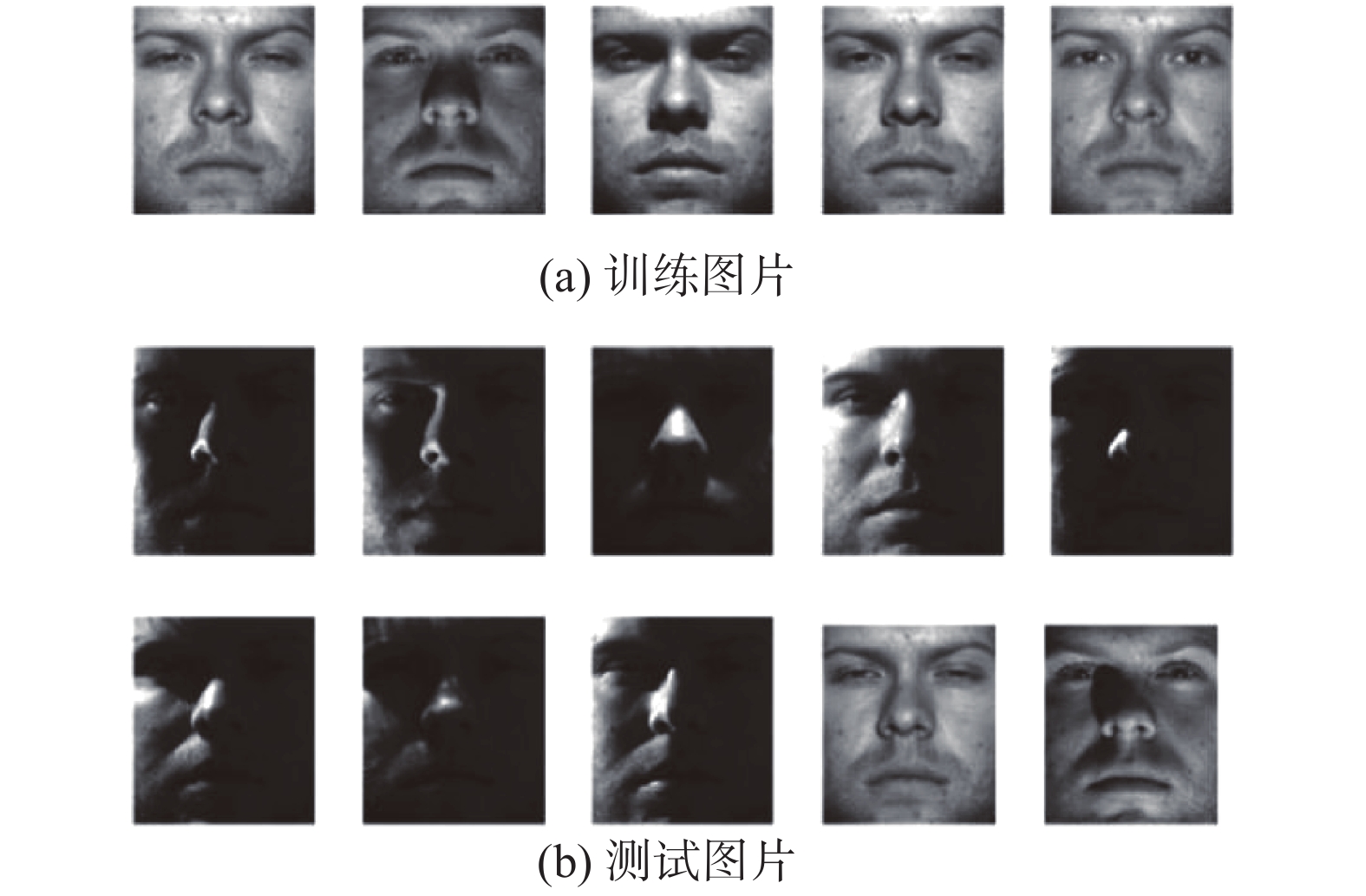

3.2 AR数据库实验本文在AR人脸数据库上设计两个实验方案,实验1随机选取100人,每人26张图片分为5个集合,训练集合选取两张标准人脸,其余按特点分为4个集合,作为不同的测试集。如图4所示,集合

|

Download:

|

| 图 4 AR人脸数据库样本(1) Fig. 4 Cropped face samples of AR database (1) | |

在具体实现过程中,随机选取80人用于训练扩充干扰字典和混合特色字典,其余20个人用于训练低秩字典。首先将数据集下采样为

| 表 1 算法在AR库上的实验结果 Tab.1 Accuracy of different methods on Experiment1 of AR database |

从表1可知,FDDL算法识别率高于SRC、CRC算法,说明提取数据特殊性的重要性,FDDLLCSRC、IKCFDDL算法在面对光照、表情变化时实验效果良好,然而对数据存在遮挡异常时处理效果欠缺。而CSICVDL、SCSDL、本文算法识别率高于FDDL、LKCFDDL等,说明了在提取特殊性之外,捕捉数据共性的必要性。本文算法性能较稳定,混合特色字典提取了数据共性和特殊性,低秩字典、扩充干扰字典增强算法鲁棒性和容错能力,在所有集合都能达到最高识别率。

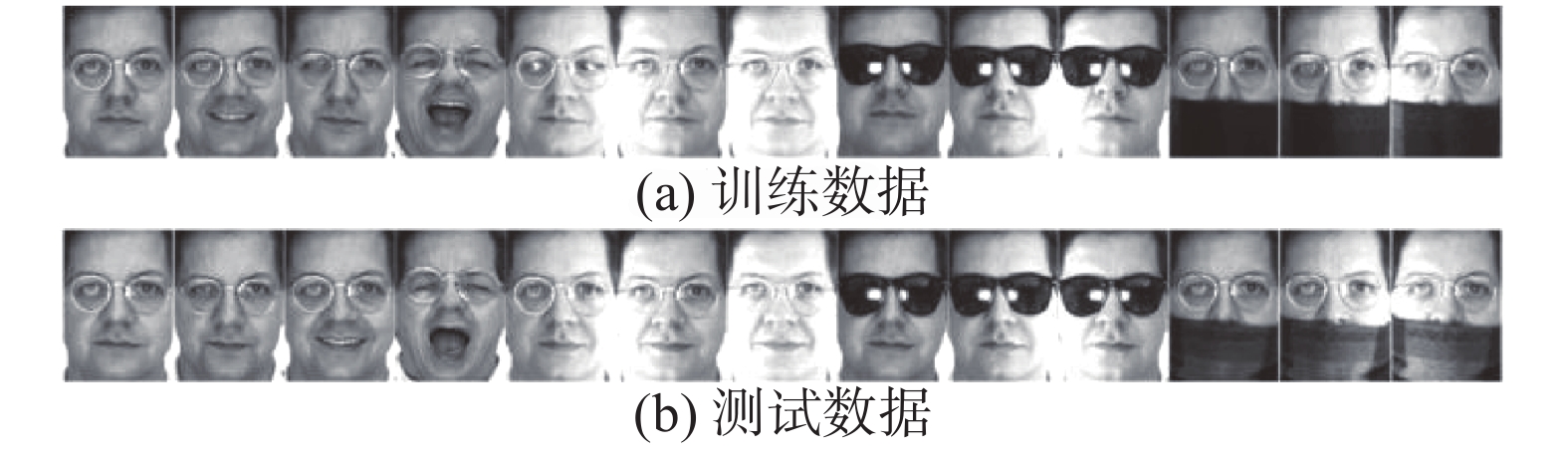

为探究本文算法对遮挡、光照、异常等情况的综合处理能力,如图5所示,实验2选取每人两张正常状态下的人脸图片作为训练集,将围巾遮挡、墨镜遮挡作为测试集合。

|

Download:

|

| 图 5 AR人脸数据库样本(2) Fig. 5 Cropped face samples of AR database(2) | |

将数据集下采样为

|

Download:

|

| 图 6 AR人脸数据库识别率 Fig. 6 Accuracy of different methods on Experiment1 of AR database | |

本文在The extended Yale B 人脸数据库上设计两个实验。实验1中,每人随机选取5图片训练,其余图片进行测试。图7表示其中一个训练样本和部分测试样本。

|

Download:

|

| 图 7 YaleB人脸数据库样本 Fig. 7 Cropped face samples of YaleB database | |

在具体实验时,选取30个人训练扩充干扰字典和混合特色字典,其余8个人用于训练低秩字典。将数据分别降维至

| 表 2 算法在Yale B database库上的实验结果 Tab.2 Accuracy of different methods on Experiment1 of Yale B database |

从表2可以看出,本文算法识别率高于其他算法,并随着维数增多而增高。

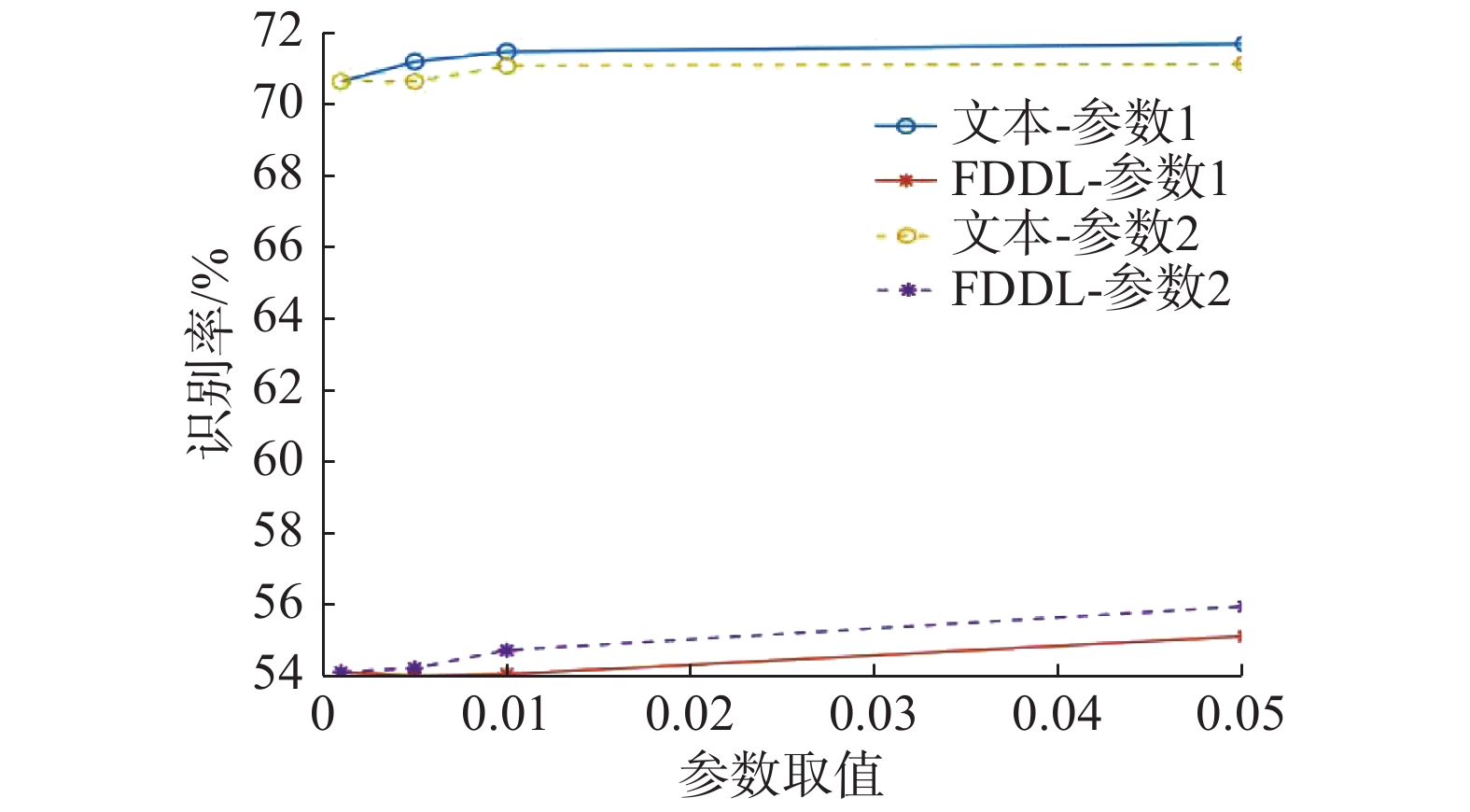

为探究各算法鲁棒性,实验2赋予算法不同的参数值,参数1与参数2 分别取值{0.001, 0.005, 0.01, 0.05},参数1限制正则化项对识别率的影响,参数2限制稀疏编码对识别率的影响,实验结果如图8所示,本文算法与FDDL算法识别率随参数1、2的取值增大而增大,并最终达到稳定,本文算法识别率随参数改变的波动小,趋于平缓,鲁棒性强。

|

Download:

|

| 图 8 参数对YaleB人脸数据库识别率的影响 Fig. 8 The parameter analysis on the YaleB database | |

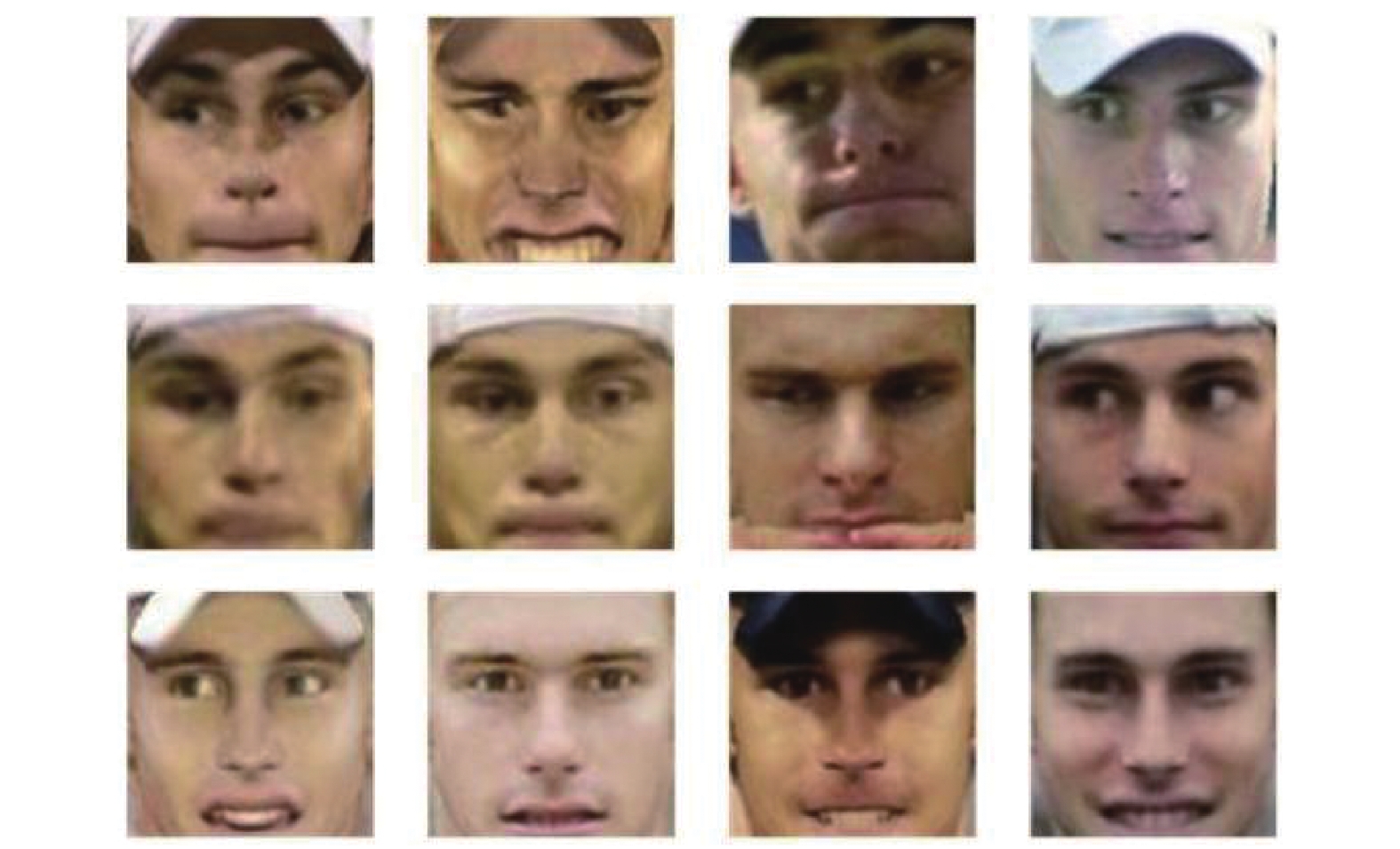

本文在非受限人脸数据库LFW设计两次实验,如图9所示,利用3d校正补齐因转向、遮挡而缺失的特征信息。

实验一,选取单人图片数量大于10张的158人作为实验数据。在具体实验时,选取148个人训练扩充干扰字典和混合特色字典,其余10个人用于训练低秩字典。如图10所示,随机选取每人10张图片,5张图片作为训练集,其余为测试集。将数据分别将至{50, 100, 150, 200, 250}维,各算法在各维度上的识别率如表3所示。

|

Download:

|

| 图 9 校正 LFW人脸数据库 Fig. 9 Correction of LFW Face Database | |

|

Download:

|

| 图 10 LFW人脸数据库样本 Fig. 10 Cropped face samples of LFW database | |

| 表 3 算法在LFW database库上的实验结果 Tab.3 Accuracy of different methods on Experiment1 of LFW database |

如表3所示,多数情况下算法的识别率随维数增多而升高,本文算法优于其他算法,但识别率整体不高,这可能是因为前期校正造成的信息损失。

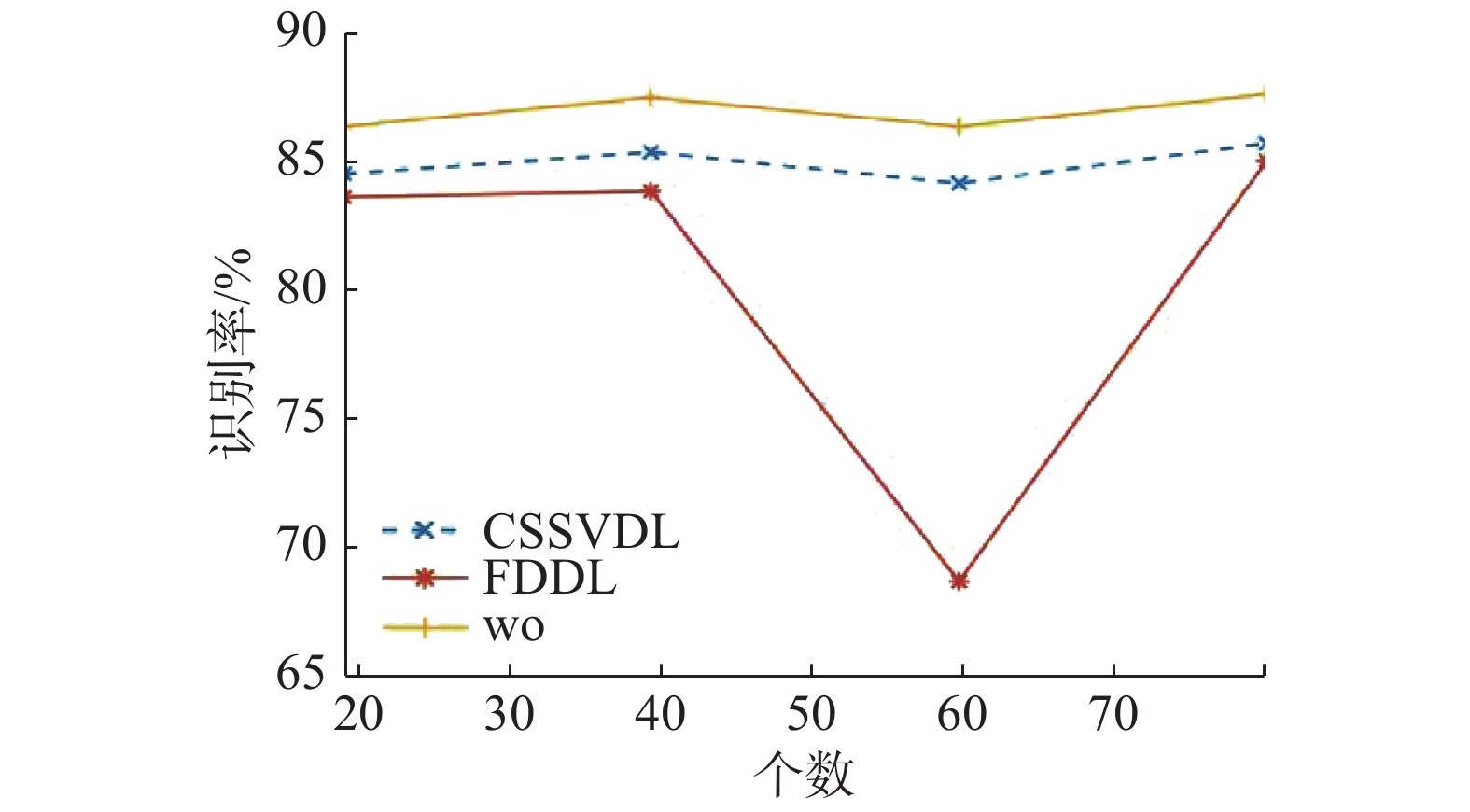

为验证低秩字典对算法影响,实验2随机挑选19、39、59、79个人作为低秩字典训练数据及CSSVDL类内差异字典辅助数据,与基础FDDL算法、包含辅助字典的CSSVDL算法进行对比,各算法在各集合上的识别率如图11所示。

|

Download:

|

| 图 11 LFW人脸数据库识别率 Fig. 11 Accuracy of different methods on experiment1 of LFW database | |

从图11可知,随着构筑类内差异字典的辅助数据增加,CSSVDL算法的识别率大致增加。随着构筑低秩字典训练数据增加,本文算法识别率大致增加。本文算法、CSSVDL算法、FDDL算法在59人实验中识别率均受个别样本选择影响下降,本文算法和CSSVDL由于辅助数据捕捉数据共性,较FDDL算法有更好的鲁棒性。在非受限人脸数据库LFW上,本文算法分类效果最优。

3.5 算法评价 3.5.1 复杂度分析本文算法复杂度分为扩充干扰字典、混合特色字典、低秩字典3个部分计算,每部分又分为更新稀疏编码和更新字典两步骤。

以扩充干扰字典为例,设训练样本个数为

扩充干扰字典总复杂度为

| $n{ O}\left( {{q^2}{n^r}} \right) + \sum\nolimits_j {{n_j}{ O}(2nq)} $ |

为探究算法运行效率,本文设计实验。如图12所示,实验1取AR数据库80人,每人前13张图片训练,其余图片进行测试。

|

Download:

|

| 图 12 AR实验 Fig. 12 Experiment on AR | |

实验2选取YALE数据库,如图13所示,每人前2张人脸图像为训练集,剩余9张为测试图像。随机选取5人作为辅助数据,数据库其余人数作为训练和测试数据,算法运行时间及实验结果如表4所示。

|

Download:

|

| 图 13 YALE实验 Fig. 13 Experiment on YALE | |

| 表 4 AR及YALE库实验 Tab.4 Experiment on AR and YALE |

综合表4可以看出,本文算法、CSSVDL算法、SCSDL算法由于辅助数据的构建,虽然算法识别率提高,但算法运行时间也随之增加。两实验中本文算法识别率最高,且运行时间小于CSSVDL算法、SCSDL算法,证明本文算法具有更高的性价比。

4 结束语本文提出稀疏综合字典模型,加入Fisher判别准则,学习混合特色字典提取数据共性和特殊性,学习扩充干扰字典与低秩字典提取数据异常、干扰性,分别在AR、YaleB、LFW等人脸库上进行实验。实验表明,在小样本训练情境下,即使测试样本与训练样本存在较大差异如表情变化、遮挡等,本文仍能保持较好的性能。在实际应用中还需进一步探讨算法对训练样本的依赖性以及算法的稳定性。

| [1] |

OH B S, TOH K A, TEOH A B J, et al. An analytic Gabor feedforward network for single-sample and pose-invariant face recognition[J]. IEEE transactions on image processing, 2018, 27(6): 2791-2805. DOI:10.1109/TIP.2018.2809040 ( 0) 0)

|

| [2] |

ZHANG Ni, YAN Yan, CHEN Si, et al. Multi-label learning based deep transfer neural network for facial attribute classification[J]. Pattern recognition, 2018, 80: 225-240. DOI:10.1016/j.patcog.2018.03.018 ( 0) 0)

|

| [3] |

冉鹏, 王灵, 李昕, 等. 改进Softmax分类器的深度卷积神经网络及其在人脸识别中的应用[J]. 上海大学学报(自然科学版), 2018, 24(3): 352-366. RAN Peng, WANG Ling, LI Xin, et al. Improved Softmax classifier for deep convolution neural networks and its application in face recognition[J]. Journal of Shanghai University (Natural Science), 2018, 24(3): 352-366. (  0) 0)

|

| [4] |

AHARON M, ELAD M, BRUCKSTEIN A. K-SVD: an algorithm for designing overcomplete dictionaries for sparse representation[J]. IEEE transactions on signal processing, 2006, 54(11): 4311-4322. DOI:10.1109/TSP.2006.881199 ( 0) 0)

|

| [5] |

YANG Meng, CHANG Heyou, LUO Weixin. Discriminative analysis-synthesis dictionary learning for image classification[J]. Neurocomputing, 2017, 219: 404-411. DOI:10.1016/j.neucom.2016.09.037 ( 0) 0)

|

| [6] |

SHEKHAR S, PATEL V M, CHELLAPPA R. Analysis sparse coding models for image-based classification[C]//Proceedings of 2014 IEEE International Conference on Image Processing. Paris, France, 2015.

( 0) 0)

|

| [7] |

WU Fei, JING Xiaoyuan, YOU Xinge, et al. Multi-view low-rank dictionary learning for image classification[J]. Pattern recognition, 2016, 50: 143-154. DOI:10.1016/j.patcog.2015.08.012 ( 0) 0)

|

| [8] |

ZHANG Qiang, LI Baoxin. Discriminative K-SVD for dictionary learning in face recognition[C]//Proceedings of 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, CA, USA, 2010.

( 0) 0)

|

| [9] |

JIANG Zhuolin, LIN Zhe, DAVIS L S. Label consistent K-SVD: learning a discriminative dictionary for recognition[J]. IEEE transactions on pattern analysis and machine intelligence, 2013, 35(11): 2651-2664. DOI:10.1109/TPAMI.2013.88 ( 0) 0)

|

| [10] |

MAIRAL J, BACH F, PONCE J, et al. Discriminative learned dictionaries for local image analysis[C]//Proceedings of 2008 IEEE Conference on Computer Vision and Pattern Recognition. Anchorage, AK, USA, 2008.

( 0) 0)

|

| [11] |

CASTRODAD A, SAPIRO G. Sparse modeling of human actions from motion imagery[J]. International journal of computer vision, 2012, 100(1): 1-15. DOI:10.1007/s11263-012-0534-7 ( 0) 0)

|

| [12] |

王念兵, 吴秦, 梁久祯, 等. 变化字典学习与显著特征提取的单样本人脸识别[J]. 小型微型计算机系统, 2017(9). WANG Nian-bing, WU Qin, LIANG Jiu-zhen, XU Jie, ZHANG Huai. Single Sample Face Recognition via Variant Dictionary Learning and Salient Feature Extraction[J]. Journal of Chinese Computer Systems, 2017(9). DOI:10.3969/j.issn.1000-1220.2017.09.016 (  0) 0)

|

| [13] |

YANG Meng, ZHANG Lei, FENG Xiangchu, et al. Sparse representation based fisher discrimination dictionary learning for image classification[J]. International journal of computer vision, 2014, 109(3): 209-232. DOI:10.1007/s11263-014-0722-8 ( 0) 0)

|

| [14] |

WRIGHT J, YANG A Y, GANESH A, et al. Robust face recognition via sparse representation[J]. IEEE transactions on pattern analysis and machine intelligence, 2009, 31(2): 210-227. DOI:10.1109/TPAMI.2008.79 ( 0) 0)

|

| [15] |

SPRECHMANN P, SAPIRO G. Dictionary learning and sparse coding for unsupervised clustering[C]//Proceedings of 2010 IEEE International Conference on Acoustics, Speech and Signal Processing. Dallas, TX, USA, 2010: 2042−2045.

( 0) 0)

|

| [16] |

RAMIREZ I, SPRECHMANN P, SAPIRO G. Classification and clustering via dictionary learning with structured incoherence and shared features[C]//Proceedings of 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, CA, USA, 2010.

( 0) 0)

|

| [17] |

YANG Meng, ZHANG Lei, FENG Xiangchu, et al. Fisher discrimination dictionary learning for sparse representation[C]//Proceedings of 2011 IEEE International Conference on Computer Vision (ICCV). Barcelona, Spain, 2011: 543−550.

( 0) 0)

|

| [18] |

王威, 朱宗玖, 陆俊. 基于字典学习和局部约束的稀疏表示人脸识别[J]. 电脑知识与技术, 2018, 14(5): 200-202. WANG Wei, ZHU Zongjiu, LU Jun. Sparse representation for face recognition based on dictionary learning and locality constraint[J]. Computer knowledge and technology, 2018, 14(5): 200-202. (  0) 0)

|

| [19] |

黎明, 彭秀姣, 王艳. 基于改进的字典学习与稀疏表示的人脸表情识别[J]. 系统仿真学报, 2018, 30(1): 28-35, 44. LI Ming, PENG Xiujiao, WANG Yan. Facial expression recognition based on improved dictionary learning and sparse representation[J]. Journal of system simulation, 2018, 30(1): 28-35, 44. (  0) 0)

|

| [20] |

DENG Weihong, HU Jiani, GUO Jun. Extended SRC: undersampled face recognition via intraclass variant dictionary[J]. IEEE transactions on pattern analysis and machine intelligence, 2012, 34(9): 1864-1870. DOI:10.1109/TPAMI.2012.30 ( 0) 0)

|

| [21] |

LI Wenjing, LIANG Jiuzhen, WU Qin, et al. An efficient face classification method based on shared and class-specific dictionary learning[C]//Proceedings of 2015 IEEE International Conference on Image Processing (ICIP). Quebec City, QC, Canada, 2015.

( 0) 0)

|

| [22] |

LI Wenjing, LIANG Jiuzhen. Adaptive face representation via class-specific and intra-class variation dictionaries for recognition[J]. Multimedia tools and applications, 2018, 77(12): 14783-14802. DOI:10.1007/s11042-017-5062-6 ( 0) 0)

|

| [23] |

NEEDELL D, TROPP J A. CoSaMP: iterative signal recovery from incomplete and inaccurate samples[J]. Applied and computational harmonic analysis, 2009, 26(3): 301-321. DOI:10.1016/j.acha.2008.07.002 ( 0) 0)

|

| [24] |

DO T T, GAN Lu, NGUYEN N, et al. Sparsity adaptive matching pursuit algorithm for practical compressed sensing[C]//Proceedings of the 42nd Asilomar Conference on Signals, Systems and Computers. Pacific Grove, CA, USA, 2009.

( 0) 0)

|

| [25] |

TIBSHIRANI R. Regression shrinkage and selection via the lasso[J]. Journal of the royal statistical society: series B (Methodological), 1996, 58(1): 267-288. DOI:10.1111/j.2517-6161.1996.tb02080.x ( 0) 0)

|

| [26] |

EFRON B, HASTIE T, JOHNSTONE I, et al. Least angle regression[J]. Annals of statistics, 2004, 32(2): 407-499. DOI:10.1214/009053604000000067 ( 0) 0)

|

| [27] |

MAIRAL J, BACH F, PONCE J. Task-driven dictionary learning[J]. IEEE transactions on pattern analysis and machine intelligence, 2012, 34(4): 791-804. DOI:10.1109/TPAMI.2011.156 ( 0) 0)

|

| [28] |

PENG Yigang, GANESH A, WRIGHT J, et al. RASL: robust alignment by sparse and low-rank decomposition for linearly correlated images[J]. IEEE transactions on pattern analysis and machine intelligence, 2012, 34(11): 2233-2246. DOI:10.1109/TPAMI.2011.282 ( 0) 0)

|

2021, Vol. 16

2021, Vol. 16