2. 矿山数字化教育部工程研究中心,江苏 徐州 221116

2. Engineering Research Center (Ministry of Education) of Mine Digitization, Xuzhou 221116, China

支持向量机(support vector machine, SVM)[1]是由Vapnik提出的基于结构风险最小化原理的二分类分类器。其基本思想是在2个平行支持超平面之间找到最大化边界。与此同时,对于非线性分类问题,内核技巧也可以应用到SVM中。然而,SVM的计算复杂度却很高。

2007年,Jayadeva等[2]提出了孪生支持向量机(twin support vector machine, TWSVM),它为每一类构造一个超平面,使每一类样本尽可能距离本类的超平面近,而尽可能地远离另一类的超平面。TWSVM的2个非平行的超平面是通过求解2个二次规划问题(quadratic programming problems,QPPs)得到的,每个QPP的约束条件都只与一类样本有关。TWSVM不但保持了SVM的优点,而且训练速度比传统SVM要快4倍。为了进一步提升TWSVM的性能,学者们已经提出了不少改进算法,例如:孪生有界支持向量机[3](twin bounded support vector machine, TBSVM)、最小二乘孪生支持向量机[4](least square twin support vector machine, LSTWSVM)、非平行支持向量机[5](nonparallel support vector machine,NPSVM)。具体来说,LSTWSVM使用平方损失函数将TWSVM中的凸二次规划问题转化为解线性方程组,从而实现极快的训练速度。但是,LSTWSVM对噪声很敏感,因为它要求超平面与其他类的点距离恰好为1。近些年来出现了许多改进的算法。Nasiri等[6]提出了一种基于能量的LSTWSVM(energy-based least square twin support vector machine, ELS-TWSVM)模型,该模型为每一类引入一个能量因子以减少噪声的影响。马跃峰等[7]提出了一种基于全局代表点的快速最小二乘支持向量机稀疏化算法(global-representation-based sparse least squares support vector machine, GRS-LSSVM),利用数据全局代表性指标,在全部数据中,一次性地选择出其中最具有全局代表性的数据并构成稀疏化后的支持向量集,然后在此基础上求解决策超平面。吴青等[8]提出了一种最小二乘大间隔孪生支持向量机(least squares large margin twin support vector machine, LSLMTSVM),该方法在TWSVM的目标函数中引入间隔均值和间隔方差,通过优化间隔分布来获得具有更强泛化能力的模型。

实际上,在大多数分类问题中,不同的类可能有不同的结构信息。然而,传统的SVM和TWSVM都没有完全应用类中样本的分布信息。最流行的方法之一是基于假设的聚类算法[9],利用聚类算法提取类中的结构信息。例如,结构化最大边缘机(structured large margin machine, SLMM)[10]、最小最大概率机(minimax probability machine,MPM)[11]和最大最小边缘机(maxi-min margin machine,M4)[12]。但是,这些方法的计算复杂度高于经典的SVM。因此,Xue等[13]提出了一种结构正则化支持向量机(structural regularized SVM,SRSVM)。此方法将集群粒度导入到获得数据结构的正则化项。遵循SLMM和SRSVM的策略,Qi等[14]提出了一种新的结构化的TWSVM(structural twin support vector machine, S-TWSVM)。与SRSVM类似,S-TWSVM使用聚类算法提取每个类的结构信息,并将得到的结构信息引入到S-TWSVM模型中。

在本文中,受文献[6]的启发,首先对结构化的最小二乘孪生支持向量机(structural least square twin support vector machine, S-LSTWSVM)进行改进,提出了一种基于能量的结构最小二乘孪生支持向量机(energy-based structural least square twin support vector machin, ES-LSTWSVM)。为每个超平面引入能量因子,将等式约束条件转换为基于能量的形式。最后采用“多对一”的策略[15]解决多分类问题。

本文的主要贡献如下:

1) 提出了一种基于能量的结构化最小二乘孪生支持向量机;

2) 采用“多对一”的策略将提出的算法扩展到多分类问题中;

3) 选择几种有代表性的相关算法进行对比实验,在UCI数据集上的实验结果表明提出的算法具有良好的分类性能。

1 相关工作本节介绍TWSVM和S-TWSVM的数学模型。假设在

TWSVM通过训练数据集寻找2个不平行的分离超平面:

| ${{{x}}^{\rm{T}}}{{{w}}_1}{\rm{ + }}{b_1} = 0,{{{x}}^{\rm{T}}}{{{w}}_2}{\rm{ + }}{b_2} = 0$ |

它们一般通过求解下面2个二次规划问题来得到:

| $ \begin{array}{c} \min\limits_{{w_1},{b_1},{\xi _2}} \;\;\;\;\dfrac{1}{2}{({{A}}{{{w}}_1} + {{{e}}_1}{b_1})^{\rm{T}}}({{A}}{{{w}}_1} + {{{e}}_1}{b_1}) + {c_1}{{e}}_1^{\rm{T}}{\xi _2} - \\ {\rm{s}}{\rm{.t}}{\rm{.}}\;\;\;\;\;\;\;\;\; ({{B}}{{{w}}_1} + {{{e}}_2}{b_1}) \geqslant {{{e}}_2} - {\xi _2},{\xi _2} \geqslant 0 \end{array} $ |

| $ \begin{array}{c} \min\limits_{{w_2},{b_2},{\xi _1}} \;\;\;\;\;\;\dfrac{1}{2}{({{B}}{{{w}}_2} + {{{e}}_2}{b_2})^{\rm{T}}}({{B}}{{{w}}_2} + {{{e}}_2}{b_2}) + {c_2}{{e}}_1^{\rm{T}}{\xi _1}\\ {\rm{s}}{\rm{.t}}{\rm{.}}\;\;\;\;\;\;\;({{A}}{{{w}}_2} + {{{e}}_1}{b_2}) \geqslant {{{e}}_1} - {\xi _1},{\xi _1} \geqslant 0 \end{array} $ |

式中:c1、c2>0是2个惩罚参数;

TWSVM通过如下的决策函数判定新样本的类别标签:

| ${\rm{Label}}({{x}}) = \arg\min\limits_{l = 1,2} \left| {{{{x}}^{\rm{T}}}{{{w}}_l} + {b_l}} \right|$ |

首先,S-TWSVM通过“沃氏链接”(ward’s linkage)聚类算法[16]提取类内的结构信息。然后它使用2个非平行超平面来判定新数据的类别,其中每个超平面尽可能离本类数据点近,并且在目标函数中只考虑该类的结构信息,而约束条件规定该超平面要离其他类数据点至少距离为1个单位。假设通过聚类之后正类中有

| $ \begin{array}{c} \min\limits_{{w_ + },{b_ + },\xi } \begin{array}{*{20}{c}} {}&{\dfrac{1}{2}} \end{array}\left\| {{{A}}{{{w}}_ + } + {{{e}}_ + }{b_ + }} \right\|_2^2 + {c_1}{{e}}_ - ^{\rm{T}}\xi + \frac{1}{2}{c_2}(\left\| {{{{w}}_ + }} \right\|_2^2 + b_ + ^2)+ \\ \dfrac{1}{2}{c_3}{{w}}_{\rm{ + }}^{\rm{T}}{\displaystyle\sum\nolimits_ + }{{{w}}_ + } \\ {\rm{s}}{\rm{.t}}{\rm{.}}\begin{array}{*{20}{c}} {}&{ - ({{B}}{w_ + } + {{{e}}_ - }{b_ + }) + \xi \geqslant e_ -} ,\xi \geqslant 0 \end{array} \end{array} $ |

| $ \begin{array}{c} \min\limits_{{w_ - },{b_ - },\eta } \begin{array}{*{20}{c}} {}&{\dfrac{1}{2}} \end{array}\left\| {{{B}}{{{w}}_ - } + {{{e}}_ - }{b_ - }} \right\|_2^2 + {c_4}{{e}}_ + ^{\rm{T}}\eta + \frac{1}{2}{c_5}(\left\| {{{{w}}_ - }} \right\|_2^2 + b_ - ^2) + \\ \dfrac{1}{2}{c_6}{{w}}_ - ^{\rm{T}}{\displaystyle\sum\nolimits_ - }{{{w}}_ - } \\ {\rm{s}}{\rm{.t}}{\rm{.}}{\begin{array}{*{20}{c}} {}&{({{A}}{{{w}}_ - } + {{{e}}_ + }{b_ - }) + \eta \geqslant {{e}}_ +} ,\eta \geqslant 0 \end{array} } \end{array} $ |

式中:

新的数据点被分配给正类还是负类取决于得到的2个超平面

| ${\rm{Label}}({{x}}) = \arg\min\limits_{ + , - } \left\{ {\left| {{{w}}_ + ^{\rm{T}}{{x}} + {b_ + }} \right|,\left| {{{w}}_ - ^{\rm{T}}{{x}} + {b_ - }} \right|} \right\}$ |

在本节中,提出了一种基于能量的结构化孪生支持向量机(ES-LSTWSVM)。该算法主要分为2步:1)用某种聚类方法提取类内的结构信息;2)最小化每个类中各个簇之间的紧密度并将其嵌入到目标函数中。此外,利用核技巧使模型能够解决非线性可分问题。在下面的小节中,将具体讨论这些步骤。

2.1 线性 ES-LSTWSVM有很多聚类方法可被用于提取类内的结构信息,例如:k均值算法[17]、模糊聚类和密度聚类[18-21]。使用拐点图[22]来确定最佳聚类数目。聚类之后,通过计算类中各个簇的协方差矩阵将结构信息引入到优化问题中。因此,聚类之后的簇应该是紧凑的并且是球形的。鉴于此,采用Ward’s linkage聚类算法,这是一种层次聚类方法,为协方差矩阵的计算提供了基础。

假设从正类和负类中分别得到了

| $\begin{array}{c} \min\limits_{{w_ + },{b_ + },\xi } \begin{array}{*{20}{c}} {}&{\dfrac{1}{2}} \end{array}{\left\| {{{A}}{{{w}}_ + } + {{{e}}_ + }{b_ + }} \right\|^2} + \dfrac{{{c_1}}}{2}{{{\xi }}^{\rm{T}}}{{\xi }} + \\ \dfrac{{{c_2}}}{2}(\left\| {{{{w}}_ + }} \right\|_2^2 + b_ + ^2) + \dfrac{{{c_3}}}{2}{{w}}_ + ^{\rm{T}}{\displaystyle\sum\nolimits_ + }{{{w}}_ + } \\ \begin{array}{*{20}{c}} {{\rm{s}}{\rm{.t}}{\rm{.}}}&{}&{ - ({{B}}{{{w}}_ + } + {{{e}}_ - }{b_ + })} \end{array} + {{\xi }} = {{{E}}_ - } \\ \end{array} $ | (1) |

| $\begin{array}{c} \min\limits_{{w_ - },{b_ - },\eta } \begin{array}{*{20}{c}} {}&{\dfrac{1}{2}} \end{array}{\left\| {{{B}}{{{w}}_ - } + {{{e}}_ - }{b_ - }} \right\|^2} + \dfrac{{{c_4}}}{2}{{{\eta }}^{\rm{T}}}{{\eta }} + \\ \dfrac{{{c_5}}}{2}(\left\| {{{{w}}_ - }} \right\|_2^2 + b_ - ^2) + \dfrac{{{c_6}}}{2}{{w}}_ - ^{\rm{T}}{\displaystyle\sum\nolimits_ - }{{{w}}_ - } \\ \begin{array}{*{20}{c}} {{\rm{s}}{\rm{.t}}{\rm{.}}}&{}&{{{A}}{{{w}}_ - } + {{{e}}_ + }{b_ - }} + {{\eta }} = {{{E}}_ + } \end{array} \\ \end{array} $ | (2) |

式中:

将等式约束条件代入目标函数式(1)中得到:

| $\begin{array}{c} \min\limits_{{w_ + },{b_ + }} \begin{array}{*{20}{c}} {}&{\dfrac{1}{2}} \end{array}{\left\| {{{A}}{{{w}}_ + } + {{{e}}_ + }{b_ + }} \right\|^2} + \dfrac{{{c_1}}}{2}{\left\| {{{B}}{{{w}}_ + } + {{{e}}_ - }{b_ + } + {{{E}}_ - }} \right\|^2} + \\ \dfrac{{{c_2}}}{2}(\left\| {{{{w}}_ + }} \right\|_2^2 + b_ + ^2) + \dfrac{{{c_3}}}{2}{{w}}_ + ^{\rm{T}}{\displaystyle\sum\nolimits_ + }{{{w}}_ + } \\ \end{array} $ | (3) |

分别对式(3)中

| $\begin{array}{c} {{{A}}^{\rm{T}}}({{A}}{{{w}}_ + } + {{{e}}_ + }{b_ + }) + {c_1}{{{B}}^{\rm{T}}}({{B}}{{{w}}_ + } + {{{e}}_ - }{b_ + } + {{{E}}_ - }) + \\ {c_2}{{{w}}_ + } + {c_3}{\displaystyle\sum\nolimits_ + }{{{w}}_ + } = 0 \end{array} $ | (4) |

| ${{e}}_ + ^{\rm{T}}({{A}}{{{w}}_ + } + {{{e}}_ + }{b_ + }) + {c_1}{{e}}_ - ^{\rm{T}}({{B}}{{{w}}_ + } + {{{e}}_ - }{b_ + } + {{{E}}_ - }) + {c_2}{b_ + } = 0$ | (5) |

将式(4)、(5)整理成矩阵的形式为

| $\begin{aligned} & \left[ {\begin{array}{*{20}{c}} {{{{A}}^{\rm{T}}}{{A}}}&{{{{A}}^{\rm{T}}}{{{e}}_ + }} \\ {{{e}}_ + ^{\rm{T}}{{A}}}&{{{e}}_ + ^T{{{e}}_ + }} \end{array}} \right]\left[ {\begin{array}{*{20}{c}} {{{{w}}_ + }} \\ {{b_ + }} \end{array}} \right] + {c_1}\left[ {\begin{array}{*{20}{c}} {{{{B}}^{\rm{T}}}{{{B}}}}&{{{{B}}^{\rm{T}}}{{{e}}_ - }} \\ {{{e}}_ - ^{\rm{T}}{{B}}}&{{{e}}_ - ^{\rm{T}}{{{e}}_ - }} \end{array}} \right]\left[ {\begin{array}{*{20}{c}} {{{{w}}_ + }} \\ {{b_ + }} \end{array}} \right] + \\ &\quad \quad {c_1}\left[ {\begin{array}{*{20}{c}} {{{{B}}^{\rm{T}}}} \\ {{{e}}_ - ^{\rm{T}}} \end{array}} \right]{E_ - } + {c_2}\left[ {\begin{array}{*{20}{c}} {{{{w}}_ + }} \\ {{b_ + }} \end{array}} \right] + {c_3}\left[ {\begin{array}{*{20}{c}} {{\displaystyle\sum\nolimits_ + }{{{w}}_ + }} \\ 0 \end{array}} \right] = 0 \end{aligned}$ |

| $\begin{aligned} & \left[ {\begin{array}{*{20}{c}} {{{{A}}^{\rm{T}}}} \\ {{{e}}_ + ^{\rm{T}}} \end{array}} \right]\left[ {\begin{array}{*{20}{c}} {{A}}&{{{{e}}_ + }} \end{array}} \right]\left[ {\begin{array}{*{20}{c}} {{{{w}}_ + }} \\ {{b_ + }} \end{array}} \right] + {c_1}\left[ {\begin{array}{*{20}{c}} {{{{B}}^{\rm{T}}}} \\ {{{e}}_ - ^{\rm{T}}} \end{array}} \right]\left[ {\begin{array}{*{20}{c}} {{{B}}}&{{{{e}}_ - }} \end{array}} \right]\left[ {\begin{array}{*{20}{c}} {{{{w}}_ + }} \\ {{b_ + }} \end{array}} \right] + \\ & \quad \quad {c_2}\left[ {\begin{array}{*{20}{c}} {{{{w}}_ + }} \\ {{b_ + }} \end{array}} \right] + {c_3}\left[ {\begin{array}{*{20}{c}} {{\displaystyle\sum\nolimits_ + } {{{w}}_ + }} \\ 0 \end{array}} \right] = - {c_1}\left[ {\begin{array}{*{20}{c}} {{{{B}}^{\rm{T}}}} \\ {{{e}}_ - ^{\rm{T}}} \end{array}} \right]{{{E}}_ - } \end{aligned} $ |

使

| ${z_1} = \left[ {\begin{array}{*{20}{c}} {{{{w}}_ + }} \\ {{b_ + }} \end{array}} \right] = - {c_1}{({{{P}}^{\rm{T}}}{{P}} + {c_1}{{{Q}}^{\rm{T}}}{{Q}} + {c_2}I + {c_3}{\displaystyle\sum\nolimits_1})^{ - 1}}{{{Q}}^{\rm{T}}}{{{E}}_ - }$ |

同理,式(2)可表示为

| $ {z_2} = \left[ {\begin{array}{*{20}{c}} {{{{w}}_ - }} \\ {{b_ - }} \end{array}} \right] = {c_4}{({{{Q}}^{\rm{T}}}{{Q}} + {c_4}{{{P}}^{\rm{T}}}{{P}} + {c_5}I + {c_6}{\displaystyle\sum\nolimits_2})^{ - 1}}{{{P}}^{\rm{T}}}{{{E}}_ + } $ |

式中:

ES-LSTWSVM通过如下的决策函数判定新样本的类别标签:

| ${\rm{Label}}({{x}}) = \left\{ {\frac{{\left| {{{{x}}^{\rm{T}}}{{{w}}_ + } + {b_ + }} \right|}}{{\left\| {{{{w}}_ + }} \right\|}}} \right.,\left. {\frac{{\left| {{{{x}}^{\rm{T}}}{{{w}}_ - } + {b_ - }} \right|}}{{\left\| {{{{w}}_ - }} \right\|}}} \right\}$ |

对于非线性分类问题,利用核技巧进行处理。首先将原始特征空间中的数据映射到希尔伯特空间中:

由希尔伯特空间理论[23]知:

| $ {{{w}}_ + } = \sum\limits_{i = 1}^{{m_1} + {m_2}} {{{({\lambda _ + })}_i}} \varPhi ({x_i}) = \varPhi (M){\lambda _ + } $ |

| $ {{{w}}_ - } = \sum\limits_{i = 1}^{{m_1} + {m_2}} {{{({\lambda _ - })}_i}} \varPhi ({x_i}) = \varPhi (M){\lambda _ - } $ |

ES-LSTWSVM构造如下2个基于核函数的超平面:

式中:

在非线性情形下,ES-LSTWSVM可表示为

| $\begin{array}{l} \min\limits_{{w_ + },{b_ + },\xi } \begin{array}{*{20}{c}} {}&{\dfrac{1}{2}} \end{array}{\left\| {K({{A}},{{{M}}^{\rm{T}}}){\lambda _ + } + {{{e}}_ + }{b_ + }} \right\|^2} + \dfrac{{{c_1}}}{2}{{{\xi }}^{\rm{T}}}{{\xi }} + \\ \dfrac{{{c_2}}}{2}(\left\| {{{{\lambda }}_ + }} \right\|_2^2 + b_ + ^2) + \dfrac{{{c_3}}}{2}{{\lambda }}_ + ^{\rm{T}}\varPhi {({{M}})^{\rm{T}}}\displaystyle\sum\nolimits_ + ^\varPhi \varPhi ({{M}}){{{\lambda }}_ + } \\ \begin{array}{*{20}{c}} {{\rm{s}}{\rm{.t}}{\rm{.}}}&{}&{ - (K({{B}},{{{M}}^{\rm{T}}}){\lambda _ + } + {{{e}}_ - }{b_ + })}+ {{\xi }} = {{{E}}_ - } \end{array} \end{array} $ | (6) |

| $\begin{array}{l} \min\limits_{{w_ - },{b_ - },\eta } \begin{array}{*{20}{c}} {}&{\dfrac{1}{2}} \end{array}{\left\| {K({{B}},{{{M}}^{\rm{T}}}){\lambda _ - } + {{{e}}_ - }{b_ - }} \right\|^2} + \dfrac{{{c_4}}}{2}{{{\eta }}^{\rm{T}}}{{\eta }} + \\ \dfrac{{{c_5}}}{2}(\left\| {{{{\lambda }}_ - }} \right\|_2^2 + b_ - ^2) + \dfrac{{{c_6}}}{2}{{\lambda }}_ - ^{\rm{T}}\varPhi {({{M}})^{\rm{T}}}\displaystyle\sum\nolimits_ - ^\varPhi \varPhi ({{M}}){{{\lambda }}_ - } \\ \begin{array}{*{20}{c}} {{\rm{s}}{\rm{.t}}.}&{}&{(K({{A}},{{{M}}^{\rm{T}}}){{{\lambda }}_ - } + {{{e}}_ + }{b_ - })} \end{array} + {{\eta }} = {{{E}}_ + } \end{array} $ | (7) |

式中:

类似于线性情形,式(6)、(7)的解可表示为

| $\begin{array}{c} {z_1} = \left[ {\begin{array}{*{20}{c}} {{w_ + }} \\ {{b_ + }} \end{array}} \right] = \\ - {c_1}{\left( {{{P}}_\varPhi ^{\rm{T}}{{{P}}_\varPhi } + {c_1}{{{Q}}_\varPhi }^{\rm{T}}{{{Q}}_\varPhi } + {c_2}{{I}} + {c_3}\displaystyle\sum\nolimits_1^\varPhi } \right)^{ - 1}}{{{Q}}_\varPhi }^{\rm{T}}{{{E}}_ - } \end{array} $ | (8) |

| $ \begin{array} {c}{z_2} = \left[ {\begin{array}{*{20}{c}} {{w_ - }} \\ {{b_ - }} \end{array}} \right]=\\ {c_4}{\left( {{{{Q}}_\varPhi }^{\rm{T}}{{{Q}}_\varPhi } + {c_4}{{{P}}_\varPhi }^{\rm{T}}{{{P}}_\varPhi } + {c_5}{{I}} + {c_6}\displaystyle\sum\nolimits_2^\varPhi } \right)^{ - 1}}{{{P}}_\varPhi }^{\rm{T}}{{{E}}_ + } \end{array} $ |

式中:

| $\displaystyle\sum\nolimits_1^\varPhi = \left[ {\begin{array}{*{20}{c}} {\varPhi {{({{M}})}^{\rm{T}}}\displaystyle\sum\nolimits_ + ^\varPhi \varPhi ({{M}})}&0 \\ 0&0 \end{array}} \right]$ |

| $ \displaystyle\sum\nolimits_2^\varPhi = \left[ {\begin{array}{*{20}{c}} {\varPhi {{({{M}})}^{\rm{T}}}\displaystyle\sum\nolimits_ - ^\varPhi \varPhi ({{M}})}&0 \\ 0&0 \end{array}} \right]$ |

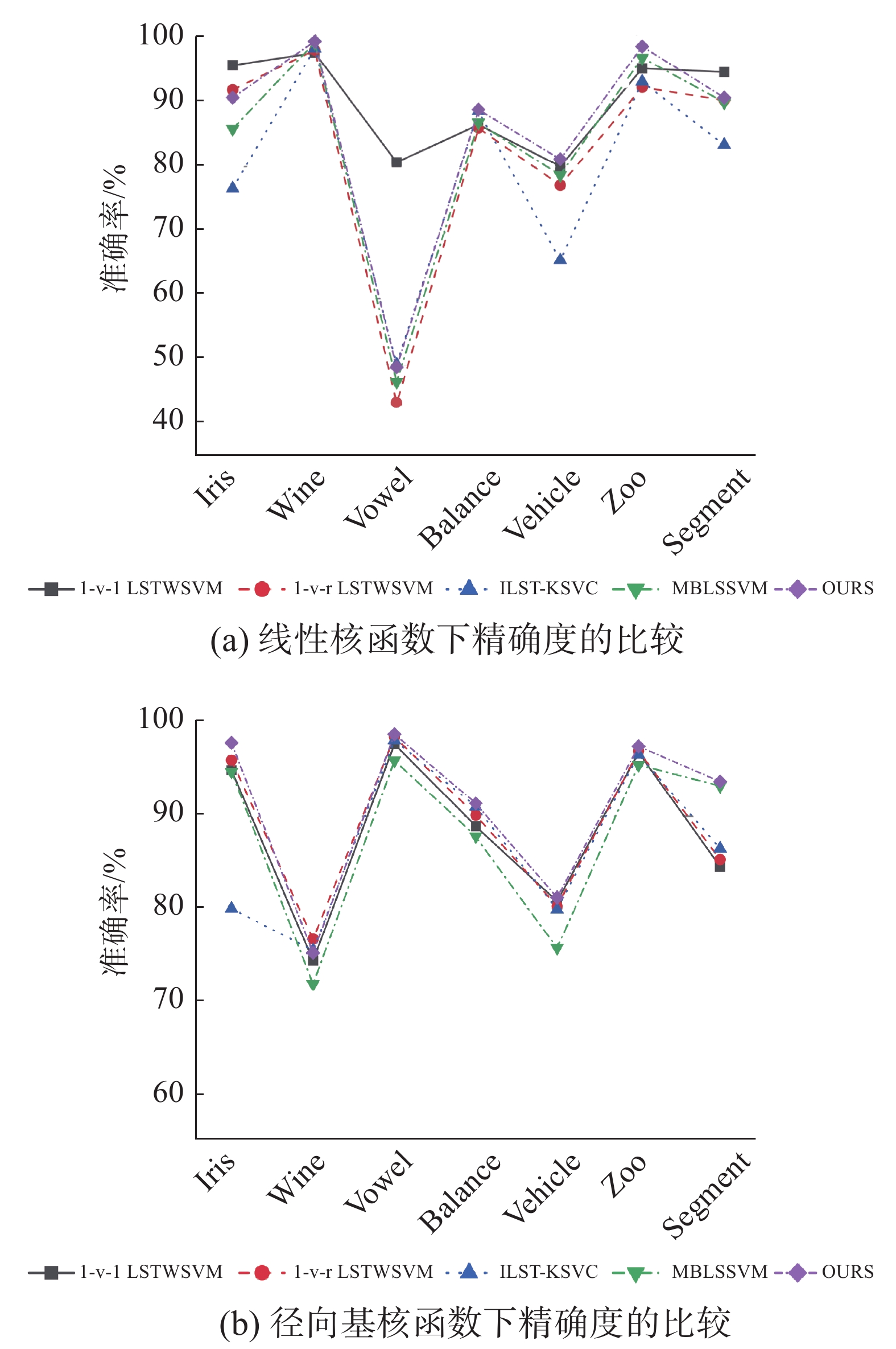

使用“多对一”的策略将ES-LSTWSVM模型扩展到多类分类中。为了证明该算法的有效性,给出了该算法在多个UCI数据集上的实验结果。在实验中,选择了“一对一” 最小二乘孪生支持向量机(1-v-1 LSTWSVM)、“一对多”最小二乘孪生支持向量机(1-v-r LSTWSVM)、改进的最小二乘孪生多分类支持向量[24]( improvements on least squares twin multi-class classification support vector machine,ILST-KSVC),多生最小二乘支持向量机[25](multiple birth least squares support vector machine,MBLSSVM)与本文算法进行比较。实验结果为10折交叉验证的平均值。在非线性情形下,使用高斯核函数

在本节中,使用UCI数据集中的Iris、Wine、Vowel、Balance、Vehicle、Zoo和Segment。这些数据集的特征如表1所示。

| 表 1 数据集的具体特征 Tab.1 The detail features of the datasets |

表2列出了上述算法在使用线性核的情况下的分类结果。表3给出了上述算法在使用高斯核的情况下的分类结果。从表2可以看出,提出的算法在Wine、Balance、Vehicle、Zoo 这4个数据集上有最高的分类精度,并且在其他数据集上也有不错的表现。从表3可以看出,所提出的算法在Iris、Vowel、Balance、Vehicle、Zoo、Segment这6个数据集上的分类准确率最高,并且在Wine数据集上也有较高的准确率。图1是对实验结果更直观的表示。

| 表 2 线性核函数下精确度的比较 Tab.2 Comparison of accuracies using linear kernel |

| 表 3 径向基核函数下精确度的比较 Tab.3 Comparison of accuracies using RBF kernel |

|

Download:

|

| 图 1 算法精确度的比较 Fig. 1 Comparison of algorithm accuracies | |

为了分析能量参数

|

Download:

|

|

图 2 能量参数

|

|

在本文中,提出了一种基于能量的结构化最小二乘孪生支持向量机,称为ES-LSTWSVM。首先使用聚类算法来获取类中的结构信息,然后为每个超平面引入能量因子,将传统TWSVM的不等式约束转换为基于能量模型的等式约束。这使得提出的ES-LSTWSVM不仅有较低的计算复杂度,而且提高了模型的泛化能力。最后,使用“多对一”策略将ES-LSTWSVM扩展到多类分类问题中。实验结果表明,所提出的算法具有良好的分类性能。

| [1] |

CORTES C, VAPNIK V N. Support-vector networks[J]. Machine learning, 1995, 20(3): 273-297. ( 0) 0)

|

| [2] |

JAYADEVA, KHEMCHANDANI R, CHANDRA S. Twin support vector machines for pattern classification[J]. IEEE transactions on pattern analysis and machine intelligence, 2007, 29(5): 905-910. DOI:10.1109/TPAMI.2007.1068 ( 0) 0)

|

| [3] |

SHAO Yuanhai, ZHANG Chunhua, WANG Xiaobo, et al. Improvements on twin support vector machines[J]. IEEE transactions on neural networks, 2011, 22(6): 962-968. DOI:10.1109/TNN.2011.2130540 ( 0) 0)

|

| [4] |

KUMAR M A, GOPAL M. Least squares twin support vector machines for pattern classification[J]. Expert systems with applications, 2009, 36(4): 7535-7543. DOI:10.1016/j.eswa.2008.09.066 ( 0) 0)

|

| [5] |

TIAN Yingjie, QI Zhiquan, JU Xuchan, et al. Nonparallel support vector machines for pattern classification[J]. IEEE transactions on cybernetics, 2014, 44(7): 1067-1079. DOI:10.1109/TCYB.2013.2279167 ( 0) 0)

|

| [6] |

NASIRI J A, CHARKARI N M, MOZAFARI K. Energy-based model of least squares twin support vector machines for human action recognition[J]. Signal processing, 2014, 104: 248-257. DOI:10.1016/j.sigpro.2014.04.010 ( 0) 0)

|

| [7] |

马跃峰, 梁循, 周小平. 一种基于全局代表点的快速最小二乘支持向量机稀疏化算法[J]. 自动化学报, 2017, 43(1): 132-141. MA Yuefeng, LIANG Xun, ZHOU Xiaoping. A fast sparse algorithm for least squares support vector machine based on global representative points[J]. Acta automatica sinica, 2017, 43(1): 132-141. (  0) 0)

|

| [8] |

吴青, 齐韶维, 孙凯悦, 等. 最小二乘大间隔孪生支持向量机[J]. 北京邮电大学学报, 2018, 41(6): 34-38. WU Qing, QI Shaowei, SUN Kaiyue, et al. Least squares large margin twin support vector machine[J]. Journal of Beijing University of Posts and Telecommunications, 2018, 41(6): 34-38. (  0) 0)

|

| [9] |

RIGOLLET P. Generalization error bounds in semi-supervised classification under the cluster assumption[J]. The journal of machine learning research, 2007, 8: 1369-1392. ( 0) 0)

|

| [10] |

YEUNG D S, WANG Defeng, NG W W Y, et al. Structured large margin machines: sensitive to data distributions[J]. Machine learning, 2007, 68(2): 171-200. DOI:10.1007/s10994-007-5015-9 ( 0) 0)

|

| [11] |

LANCKRIET G R G, EL GHAOUI L, BHATTACHARYYA C, et al. A robust minimax approach to classification[J]. The journal of machine learning research, 2002, 3: 555-582. ( 0) 0)

|

| [12] |

HUANG Kaizhu, YANG Haiqin, KING I, et al. Maxi–min margin machine: learning large margin classifiers locally and globally[J]. IEEE transactions on neural networks, 2008, 19(2): 260-272. DOI:10.1109/TNN.2007.905855 ( 0) 0)

|

| [13] |

XUE Hui, CHEN Songcan, YANG Qiang. Structural regularized support vector machine: a framework for structural large margin classifier[J]. IEEE transactions on neural networks, 2011, 22(4): 573-587. DOI:10.1109/TNN.2011.2108315 ( 0) 0)

|

| [14] |

QI Zhiquan, TIAN Yingjie, SHI Yong. Structural twin support vector machine for classification[J]. Knowledge-based systems, 2013, 43: 74-81. DOI:10.1016/j.knosys.2013.01.008 ( 0) 0)

|

| [15] |

丁世飞, 张健, 张谢锴, 等. 多分类孪生支持向量机研究进展[J]. 软件学报, 2018, 29(1): 89-108. DING Shifei, ZHANG Jian, ZHANG Xiekai, et al. Survey on multi class twin support vector machines[J]. Journal of software, 2018, 29(1): 89-108. (  0) 0)

|

| [16] |

WARD JR J H. Hierarchical grouping to optimize an objective function[J]. Journal of the American statistical association, 1963, 58(301): 236-244. DOI:10.1080/01621459.1963.10500845 ( 0) 0)

|

| [17] |

陶莹, 杨锋, 刘洋, 等. K均值聚类算法的研究与优化

[J]. 计算机技术与发展, 2018, 28(6): 90-92. TAO Ying, YANG Feng, LIU Yang, et al. Research and optimization of K-means clustering algorithm [J]. Computer technology and development, 2018, 28(6): 90-92. DOI:10.3969/j.issn.1673-629X.2018.06.020 (  0) 0)

|

| [18] |

XU Xiao, DING Shifei, DU Mingjing, et al. DPCG: an efficient density peaks clustering algorithm based on grid[J]. International journal of machine learning and cybernetics, 2018, 9(5): 743-754. DOI:10.1007/s13042-016-0603-2 ( 0) 0)

|

| [19] |

DU Mingjing, DING Shifei, XUE Yu. A robust density peaks clustering algorithm using fuzzy neighborhood[J]. International journal of machine learning and cybernetics, 2018, 9(7): 1131-1140. DOI:10.1007/s13042-017-0636-1 ( 0) 0)

|

| [20] |

XU Xiao, DING Shifei, SHI Zhongzhi. An improved density peaks clustering algorithm with fast finding cluster centers[J]. Knowledge-based systems, 2018, 158: 65-74. DOI:10.1016/j.knosys.2018.05.034 ( 0) 0)

|

| [21] |

DING Shifei, DU Mingjing, SUN Tongfeng, et al. An entropy-based density peaks clustering algorithm for mixed type data employing fuzzy neighborhood[J]. Knowledge-based systems, 2017, 133: 294-313. DOI:10.1016/j.knosys.2017.07.027 ( 0) 0)

|

| [22] |

SALVADOR S, CHAN P. Determining the number of clusters/segments in hierarchical clustering/segmentation algorithms[C]//Proceedings of the 16th IEEE International Conference on Tools with Artificial Intelligence. Boca Raton, USA, 2004.

( 0) 0)

|

| [23] |

WILLIAMS C K I. Learning with kernels: support vector machines, regularization, optimization, and beyond[J]. Journal of the American statistical association, 2003, 98(462): 489. ( 0) 0)

|

| [24] |

DE LIMA M D, COSTA N L, BARBOSA R. Improvements on least squares twin multi-class classification support vector machine[J]. Neurocomputing, 2018, 313: 196-205. DOI:10.1016/j.neucom.2018.06.040 ( 0) 0)

|

| [25] |

CHEN Sugen, WU Xiaojun. Multiple birth least squares support vector machine for multi-class classification[J]. International journal of machine learning and cybernetics, 2017, 8(6): 1731-1742. DOI:10.1007/s13042-016-0554-7 ( 0) 0)

|

2020, Vol. 15

2020, Vol. 15