2. 计算智能与智能系统北京重点实验室,北京 100124

2. Beijing Key Laboratory of Computational Intelligence and Intelligence System, Beijing 100124, China

目标检测是实现场景理解的基础,是计算机视觉领域的一项重点研究内容。自从深度卷积网络大幅度提高图像分类的准确率之后,深度卷积神经网络也广泛应用于目标检测中。虽然深度卷积神经网络在目标检测方面取得了巨大的进步,但是小目标的检测仍存在检测准确率较低的问题。

现阶段基于深度学习的目标检测算法主要分为两类,一是基于分类的目标检测方法。基于分类的目标检测算法又称为两阶段(two-stage)模型,首先选取候选区域,然后对候选区域进行分类和位置回归,最终输出检测的结果。2014年Girshick等[1]首次提出基于区域提取的R-CNN算法。2015年Girshick[2]又提出一种改进的Fast R-CNN算法,将图像经过基础网络处理之后,再传入R-CNN子网络,共享卷积运算。但Fast R-CNN在提取区域候选框时仍然使用选择性搜索算法(Selective Search[3]),增加了算法耗时,运行速度慢。针对Fast R-CNN算法的缺点,2015年Ren等[4]提出Faster R-CNN算法,用候选区域生成网络(regional proposal networks, RPN)来代替选择性搜索算法。另一类是基于回归的目标检测算法,又称为一阶段(one-stage)模型。2016年Redmon等[5]提出了新的目标检测算法YOLO(You Only Look Once)。YOLO算法将目标检测框架看作空间上的回归问题。但是YOLO算法存在定位精度、召回率等较低的问题,且对尺寸较小的物体检测效果不好,泛化能力相对较弱。为了解决YOLO算法的缺陷,2016年Liu等[6]提出SSD(single shot multiBox detector)算法,利用多层特征图进行检测。

此外,针对小目标的物体检测存在的问题,有学者提出了新的检测网络模型。2016年Bell等[7]提出一种利用感兴趣区域内外信息进行物体检测的模型(inside-outside net, ION)。2017年Lin等[8]在Faster R-CNN网络的基础上提出一种具有横向连接的特征金字塔网络(feature pyramid networks, FPN),利用多尺度特征和自上而下的结构实现目标检测。FPN只利用顶层的特征进行检测,虽然信息丰富,但是经过层层池化,很多细节特征信息会丢失,而这些信息对小目标检测具有重要意义。Fu等[9]针对SSD算法在小目标检测上存在的问题,提出一种改进的DSSD(deconvolutional single shot detector)算法,将SSD算法的基础网络更改为ResNet-101[10],增强了网络的特征提取能力,结合多尺度信息,提高了检测结果。然而,上述网络忽略了低层特征与高层特征之间的联系,并且对于不同尺度大小的物体,卷积操作的感受野是不同的,在基础网络中利用同一种大小的卷积核进行卷积运算,不能很好提取不同大小的物体的感受野信息。

针对上述问题,本文提出基于跳跃连接金字塔和全局感受野的网络结构,来融合不同尺度的高层与底层的特征信息,并利用不同大小的卷积核和不同步长的空洞卷积[11]来提取全局特征信息。实验结果表明,所提出的模型能有效改善小目标检测结果。

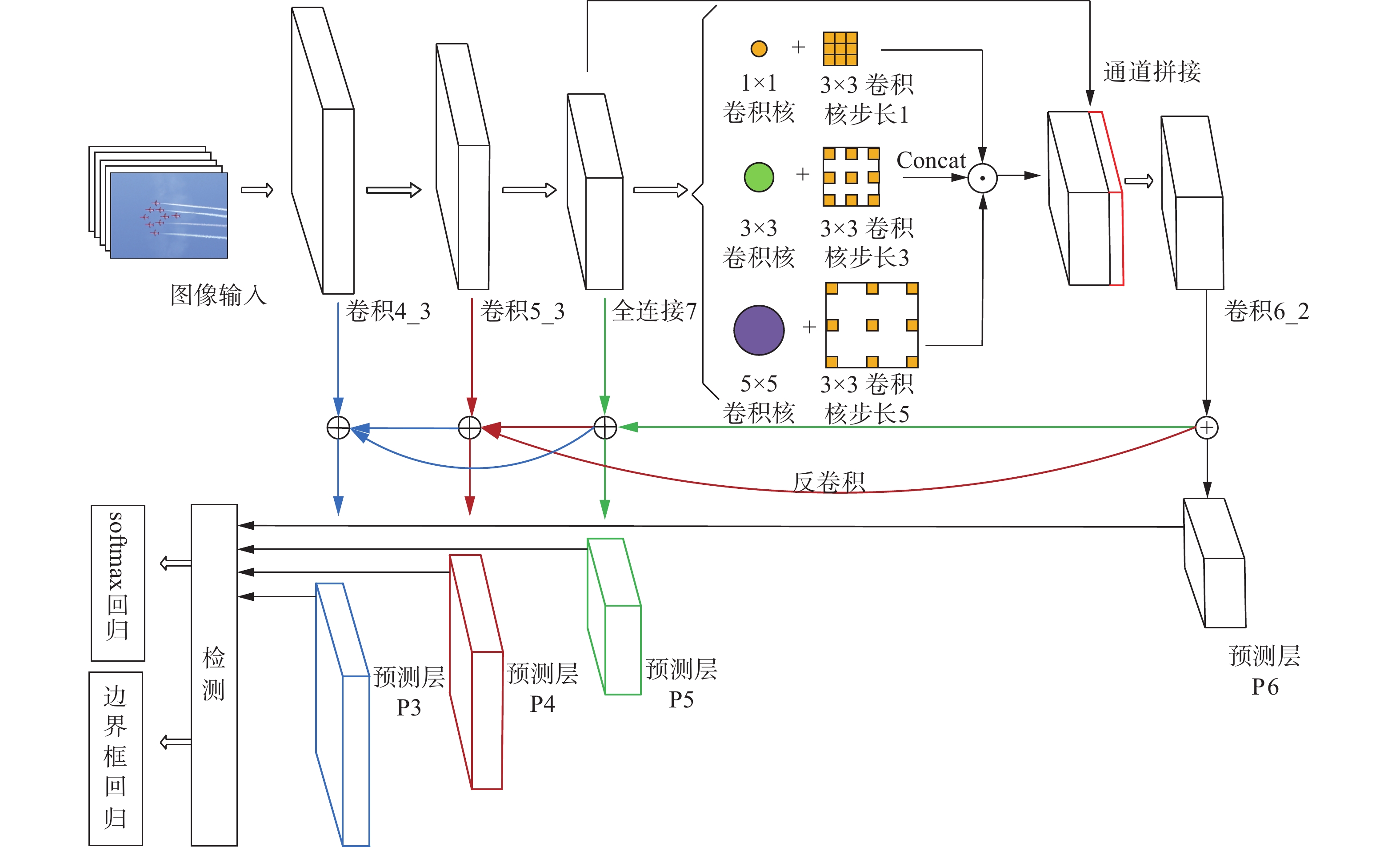

1 算法模型图1是本文提出的检测模型的整体结构图。网络模型基于前馈深度卷积网络,通过跳跃连接的金字塔(skip feature pyramid network)结构。将高层特征与低层特征相融合,在基础网络中加入全局感受野模块(global receptive field, GRF)来提取不同尺度的物体的全局特征信息。该网络模型在所有特征层中选取4层不同尺度的高层与低层特征图进行预测,在预测层产生固定数量的包围盒(anchor boxes)和相应的类别概率值,最后通过非极大值抑制(non-maximum suppression)来获得最终的预测框。

|

Download:

|

| 图 1 基于跳跃连接金字塔的小目标检测模型 Fig. 1 Title Skip feature pyramid network with global receptive field for object detection | |

为了能够清晰地展示本文提出的网络结构,只展示用于预测层的特征图,采用不同的颜色表示不同的特征层之间的融合,构建跳跃连接金字塔结构,并且提出利用全局感受野模块来提取网络全局特征信息。

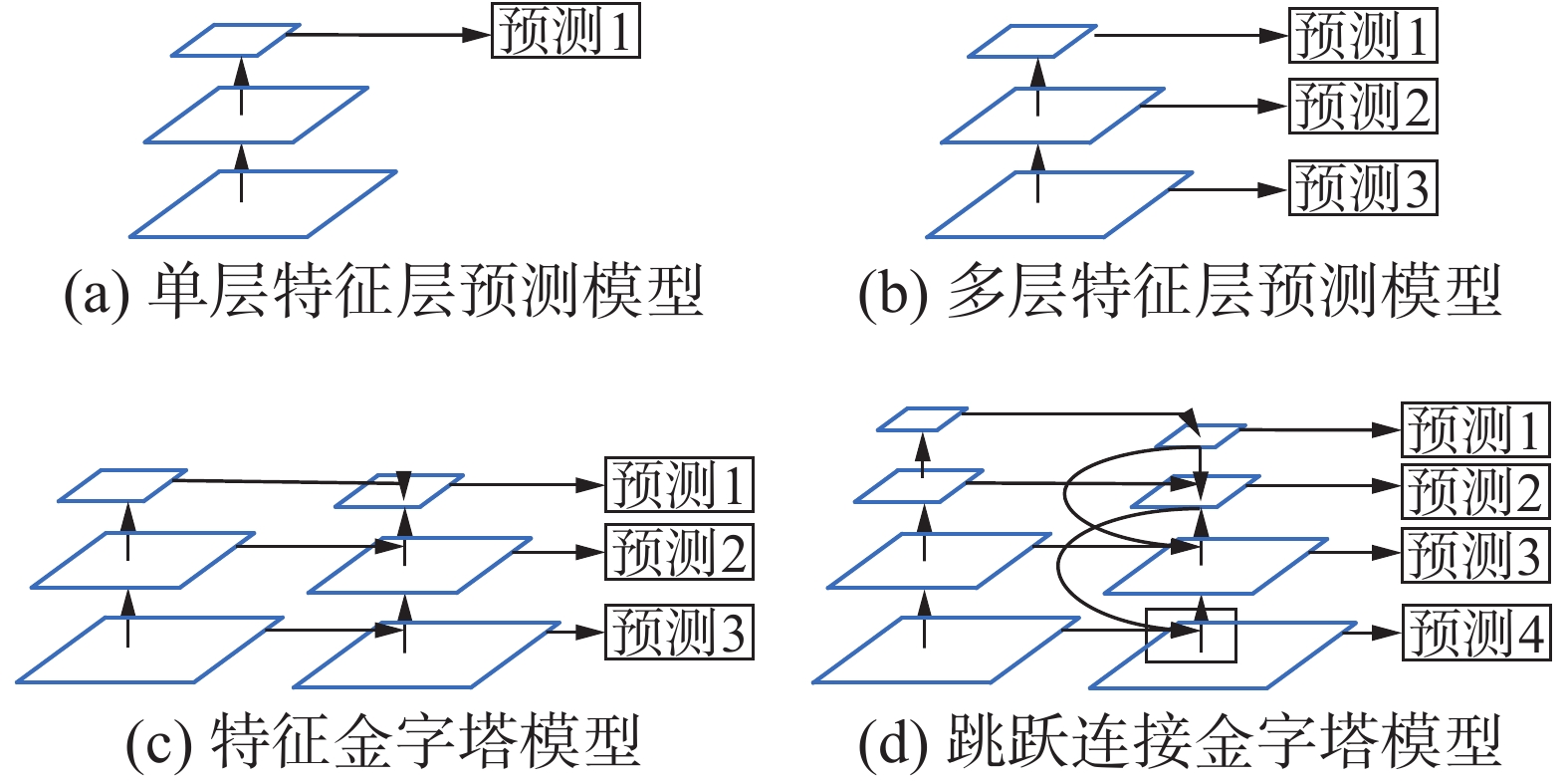

1.1 跳跃连接金字塔如图2所示,(a)~(c)为现阶段应用较多的深度网络检测结构。图2(d)为本文提出的跳跃连接金字塔网络结构。图2(a)中只利用深度网络中最后一层特征图进行预测,其中YOLO算法就是采用图2(a)的结构形式,该网络具有很高的检测速度,但是检测的准确率较低。图2(b)是对图2(a)算法结构的改进,通过在不同的尺度的高层特征上预测,有效地弥补图2(a)结构中存在的问题,改善了检测结果。图2(c)是一种自顶而下的金字塔结构模型,不仅采用不同的特征层进行预测,而且融合了相邻特征图之间的信息。但是这种结构的网络模型忽略了不同高层特征图与低层特征图之间的联系。针对上述问题,提出如图2(d)所示的跳跃金字塔结构模型,采用跳跃连接的方式,通过选择不同步长的反卷积进行上采样高层特征图,并使用逐像素求和的计算方法来融合不相邻的特征图之间的信息。

在深度卷积网络中,网络的最深层的特征图包含最多的抽象特征信息。因此利用提出跳跃金字塔结构,来融合不同的高层和低层特征图之间的信息,不仅能有效利用不同特征层之间的尺度信息,而且融合了高层特征图与低层特征图之间的细节信息。

|

Download:

|

| 图 2 不同的结构形式的预测网络 Fig. 2 Different structure of predicting network | |

跳跃连接的金字塔的细节结构如图3所示。通过选择基础网络中的高层特征图,对每一个高层特征图利用大小为

| $ o = [\frac{{i - f + 2p}}{s}] + 1 $ | (1) |

式中:

|

Download:

|

| 图 3 跳跃连接的金字塔的细节结构 Fig. 3 The detailed structure of skip feature pyramid | |

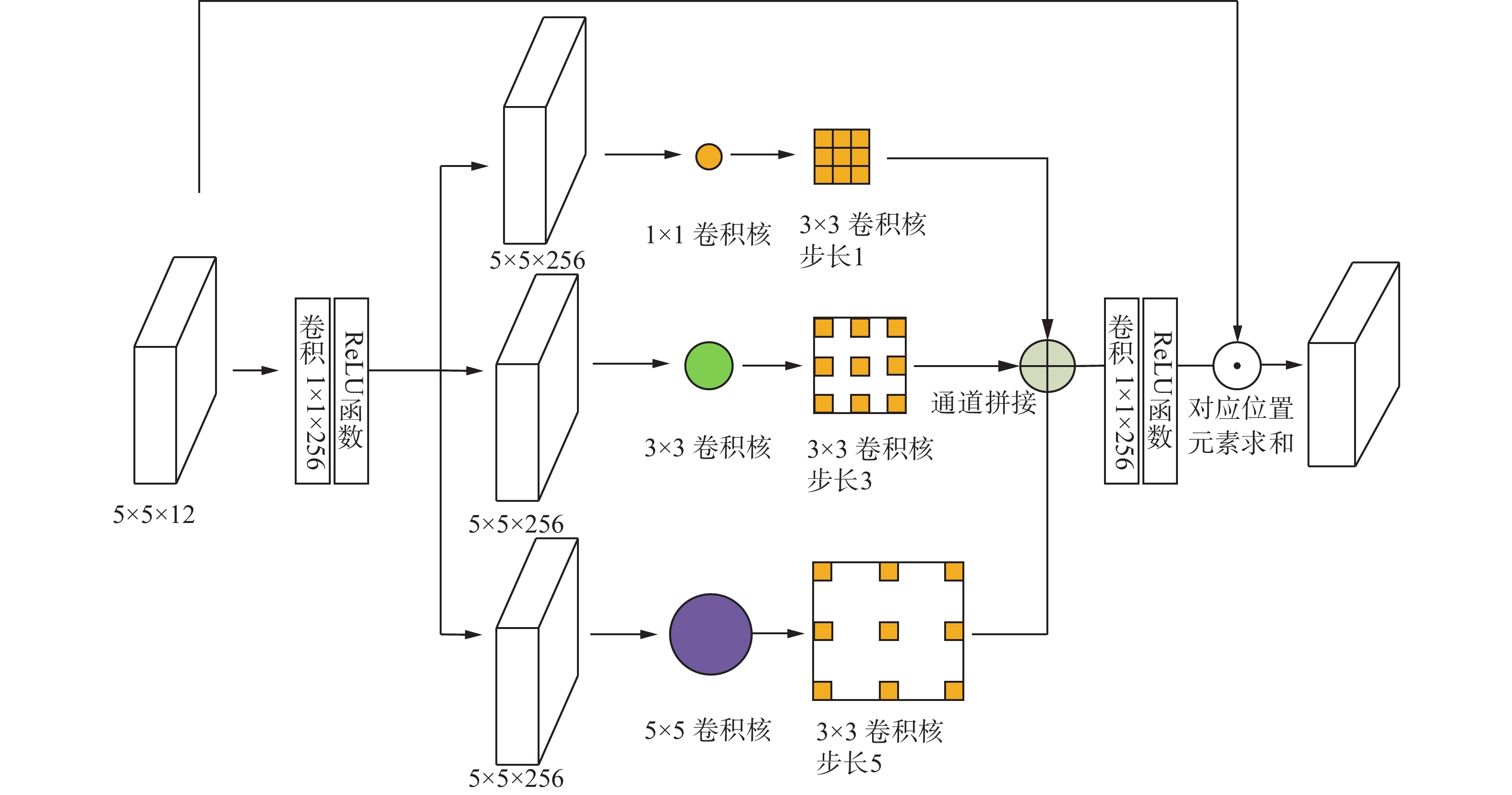

在大多数的检测模型中,多采用自上而下的结构,忽略了对于不同的大小的物体。而卷积神经网络的感受野是不同的,因此提出在网络中加入横向连接的结构,采用不同大小的卷积核和不同步长的空洞卷积来增强网络全局的感受野。与只利用一种卷积核的网络结构相比,使用不同的大小的卷积核和不同步长的空洞卷积能有效提取不同尺度大小物体的特征。首先,利用

|

Download:

|

| 图 4 全局感受野结构 Fig. 4 The network of global receptive field | |

为了更好地利用图像的特征信息,选取VGG16中4层不同尺度的特征图,每一层对应的步长分别为8、16、32、64个像素,在特征图的每个像素点采用不同大小比例的包围盒进行预测。每一层特征图,设置不同大小的比例包围盒来进行预测不同大小的物体,纵横比分别为0.5、1.0、2.0。在训练时,当包围盒与图像标注(ground truth)的重叠面积比例大于0.5时,即认为该包围盒中存在目标物体。

1.4 损失函数考虑到正负样本的数量相差较大,与SSD类似,本文采用负挖掘来解决极端的前景背景类别不平衡的问题。即在训练中,不使用所有的负样本包围盒,也不随机选择负样本包围盒,而是将负样本的损失进行排序,选择其中损失最大的负样本作为最后预测的样本,并且控制最终的正负样本比例为3∶1。与SSD不同的是,本文在进行预测之前,先对网络预测产生的包围盒进行前景和背景的二分类滤除。这样做的目的在于有效减少负样本的数量。网络的损失函数为

| $\begin{gathered} \!\!\!\!\!\!\!\!\! {{L(\{ }}{{{p}}_i}{\rm{\} ,\{ }}{{{x}}_i}{\rm{\} ,\{ }}{{{c}}_i}{\rm{\} ,\{ }}{{{t}}_i}{\rm{\} ) = }}\frac{1}{{{N_{\rm conv}}}} {\left( \sum\limits_i {l_b}({p_i},[l_i^* \geqslant 1] \right) + \sum\limits_i {[l_i^* \geqslant 1]} } \\[-1pt] \!\!\!\!\!\!\!\!\!\!\!\!\!\!\! {l_r}({x_i},g_i^*)) + \frac{1}{{{N_p}}}\left(\sum\limits_i {{l_m}} ({c_i},l_i^*) + \sum\limits_i {[l_i^* \geqslant 1]} {l_r}({t_i},g_i^*) \right) \\ \end{gathered} \!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!$ | (2) |

式中:i是每个训练批次中包围盒的索引;

| ${l_r}(x,{g^*},{l^*}) = \sum\limits_{i \in {\rm Pos}}^N {\sum\limits_{m \in \{ cx,cy,w,h\} } {[{l^*} \geqslant 1]} {\rm smoot{h_{L1}}}(x_i^m - \widehat g_j^m)} $ | (3) |

| $\widehat g_j^{cx} = (g_j^{cx} - d_i^{cx})/d_i^w{\text{,}}\;\widehat g_j^{cy} = (g_j^{cy} - d_i^{cy})/d_i^h$ | (4) |

| $\widehat g_j^w = \log (\frac{{g_j^w}}{{d_i^w}}){\text{,}}\;\widehat g_j^h = \log (\frac{{g_j^h}}{{d_i^h}})$ | (5) |

其中:

本文以VGG16[12]作为基础的特征提取网络,并且在ILSVRC CLS-LOC数据集上进行了预训练。为了验证所提出算法的有效性,分别在PASCAL VOC[13]和MS COCO[14]数据集上进行了实验。PASCAL VOC和MS COCO数据集中类别数量分别为20和80,并且每个类别都有标注信息和对应的类别信息。

2.1 PASCAL VOC在PASCAL VOC数据上,所有的算法模型都在VOC2007和VOC2012数据集上进行训练,测试在VOC2007数据集上进行测试。一共训练了140 k次,学习率不断衰减,设置0~80 k的学习率为

表1为本文的实验结果和其他网络检测结果的对比。输入图像的尺寸对模型的输出结果有较大影响。从表中可以看出,在输入图像的尺寸为

| 表 1 PASCAL VOC2007的不同网络模型的检测结果 Tab.1 Detection results on PASCAL VOC dataset |

表2为网络模型在PASCAL VOC2007测试集的不同类别平均准确率的结果。从表中可以看出,本文方法在小目标类别中的平均检测准确率明显高于其他网络模型。本文所提出的网络整体的平均准确率高于其他网络1%,其中如bird、sheep、plant等小目标比其他网络最优准确率分别高2.5%、3.2%、2.7%,证明了提出网络的有效性。

| 表 2 PASCAL VOC2007不同类别的检测结果 Tab.2 Object detection results on PASCAL VOC 2007 test set |

图5为本文的方法和SSD方法在VOC2007数据集的可视化结果对比图。第一行是SSD算法的检测结果,第二行是本文提出的检测方法的实验结果。从图中可以看出,本文方法对于图像中较小尺寸的鸟和人的检测效果明显改善,而且对于正确检测的物体的置信度也有了较大的提高。

|

Download:

|

| 图 5 在VOC2007上可视化的实验结果对比 Fig. 5 The visual comparison of experimental results on VOC2007 test | |

为了进一步验证本文提出的模型在更多类别、更多数量的数据集上的有效性,我们在MS COCO数据集上进行了实验,实验结果如表3所示。MS COCO数据集的评价指标不同于PASCAL VOC。以不同的IOU进行评价,对图像分为3个规模大小进行评价。其中AP表示准确率,AR表示召回率。APs和ARs 分别表示小目标的检测准确率和召回率,以320×320尺寸的图像为例,本文方法在小目标准确率和召回率分别高于其他最优的模型2.4%和4%。

| 表 3 MS COCO数据集检测结果 Tab.3 Object detection results on MS COCO test-dev set. |

针对小目标检测准确率较低的问题,本文提出了一种基于跳跃连接金字塔的小目标检测模型。通过跳跃连接的特征金字塔融合高层与低层特征图信息,并且利用不同大小卷积和不同步长空洞卷积的横向结构来提取全局特征信息,有效弥补因连续池化而造成的信息丢失。整个网络模型以端到端方式进行训练,并且在PASCAL VOC和MS COCO数据集上进行了实验,实验结果表明本文提出的模型在小目标的检测准确率方面明显优于其他算法模型。

| [1] |

GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Columbus, OH, USA, 2014: 580–587.

( 0) 0)

|

| [2] |

GIRSHICK R. Fast R-CNN[C]//Proceedings of 2015 IEEE International Conference on Computer Vision (ICCV). Santiago, Chile, 2015: 1440–1448.

( 0) 0)

|

| [3] |

UIJLINGS J R R, VAN DE SANDE K E A, GEVERS T, et al. Selective search for object recognition[J]. International journal of computer vision, 2013, 104(2): 154-171. DOI:10.1007/s11263-013-0620-5 ( 0) 0)

|

| [4] |

REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 ( 0) 0)

|

| [5] |

REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA, 2016: 779–788.

( 0) 0)

|

| [6] |

LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: single shot MultiBox detector[C]//Proceedings of the 14th European Conference on Computer Vision. Amsterdam, the Netherlands, 2016: 21–37.

( 0) 0)

|

| [7] |

BELL S, ZITNICK C L, BALA K, et al. Inside-outside net: detecting objects in context with skip pooling and recurrent neural networks[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA, 2016: 2874–2883.

( 0) 0)

|

| [8] |

LIN T Y, DOLLÁR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA, 2017: 936–944.

( 0) 0)

|

| [9] |

FU Chengyang, LIU Wei, RANGA A, et al. DSSD: deconvolutional single shot detector[J]. arXiv: 1701.06659, 2017.

( 0) 0)

|

| [10] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA, 2016: 770–778.

( 0) 0)

|

| [11] |

YU F, KOLTUN V. Multi-scale context aggregation by dilated convolutions[J]. arXiv:1511.07122, 2015. ( 0) 0)

|

| [12] |

SIMONYAN K, ZISSERMAN A. Very Deep Convolutional Networks for Large-Scale Image Recognition[J]. arXiv:1409.1556, 2014. ( 0) 0)

|

| [13] |

EVERINGHAM M, VAN GOOL L, WILLIAMS C K I, et al. The Pascal visual object classes (VOC) challenge[J]. International journal of computer vision, 2010, 88(2): 303-338. DOI:10.1007/s11263-009-0275-4 ( 0) 0)

|

| [14] |

LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft COCO: common objects in context[C]//Proceedings of the 13th European Conference on Computer Vision. Zurich, Switzerland, 2014: 740–755.

( 0) 0)

|

| [15] |

DAI Jifeng, LI Yi, HE Kaiming, et al. R-FCN: object detection via region-based fully convolutional networks[C]//Proceedings of the 30th International Conference on Neural Information Processing Systems. Barcelona, Spain, 2016: 379–387.

( 0) 0)

|

| [16] |

SHEN Zhiqiang, LIU Zhuang, LI Jianguo, et al. DSOD: learning deeply supervised object detectors from scratch[C]//Proceedings of 2017 IEEE International Conference on Computer Vision (ICCV). Venice, Italy, 2017: 1937–1945.

( 0) 0)

|

| [17] |

REDMON J, FARHADI A. YOLO9000: better, faster, stronger[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA, 2017: 6517–6525.

( 0) 0)

|

| [18] |

ZHOU Peng, NI Bingbing, GENG Cong, et al. Scale-transferrable object detection[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA, 2018: 528–537.

( 0) 0)

|

| [19] |

GIDARIS S, KOMODAKIS N. Object detection via a multi-region and semantic segmentation-aware CNN model[C]//Proceedings of 2015 IEEE International Conference on Computer Vision (ICCV). Santiago, Chile, 2015: 1134–1142.

( 0) 0)

|

| [20] |

HUANG Gao, LIU Zhuang, VAN DER MAATEN L, et al. Densely connected convolutional networks[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA, 2017: 2261–2269.

( 0) 0)

|

2019, Vol. 14

2019, Vol. 14