2. 国网天津市电力公司,天津 300010

2. State Grid Tianjin Electric Power Company, Tianjin 300010, China

随着我国电力行业的升级改造,更加智能的带电作业机器人成为当前的研究热点。2009年我国进行了高压带电作业机器人产品化样机的验证[1],但现有高压带电作业机器人系统一般采用主从控制方式,依然是人工手动控制[2],需要借助人眼判断目标的位置来进行操作。虽然在一定程度上提高了工作效率保护了作业人员,但在高空高压环境下依然存在巨大的安全隐患,造成无法挽回的安全和财产损失。因此,利用当前性能优良的深度学习方法代替人眼对线缆目标进行自动识别检测,研制更智能的带电作业机器人成为亟待解决的问题。

传统的目标检测方法以图像识别为基础,主要包括4个步骤:提取候选框、对每个框提取特征、图像特征分类、非极大值抑制完成框回归[3-4]。一般对图像使用穷举法选出物体可能出现的区域框,对这些区域框提取特征并使用图像识别方法分类,得到所有分类成功的区域后,通过非极大值抑制输出结果。传统方法中最成功的是基于多尺度形变部件模型(deformable part model, DPM)[5],它利用部件间的关系来描述物体,但该方法相对复杂,检测速度也较慢。所以,人工提取的特征不能适应当今的海量数据,难以应用于背景复杂的高压线缆图像数据中,且不同场景的图像往往要重新设计合适的特征,实际应用时也要依据具体情况而定,这些限制直接影响着最终的检测效果及效率。

2006 年人工智能专家Hinton 提出深度学习(deep learning, DL)概念[6],开启了人工智能领域研究深度学习的热潮。深度学习具有很强的特征学习能力,它采用逐层训练的方法缓解了传统神经网络算法在训练多层神经网络时出现的局部最优问题[7-8]。基于这些特征,深度学习在图像识别、语音识别、自然语言处理、工业过程控制等方面已显示出独特的优势。

近两年深度学习技术在目标检测领域也取得了长足的进展。与传统依赖手工设计的特征提取算法不同,深度卷积神经网络对几何变换、形变、光照具有一定程度的不变性,可以有效克服复杂场景下目标检测困难,并且可在训练数据驱动下自适应地构建特征描述,具有更高的灵活性和泛化能力。基于深度学习的目标检测主要分为基于区域建议方法和无区域建议的方法[3,9]。基于区域建议的方法是以R-CNN (Region-based convolutional neural networks)[10]为基础,在PASCAL VOC2012数据集上的检测平均精度mAP达到53.3%,较传统方法有很大的提升。此后研究者在此基础上提出了很多改进模型,如SPP-net(Spatial pyramid pooling networks)[11]、Fast R-CNN[12]等。而无区域建议的目标检测方法主要是YOLO(You only look once)[13]及其改进模型。基于区域建议的方法在精度上更具优势,而无区域建议的方法检测速度更快。基于深度学习的目标检测方法在低空目标、人体行为检测、无人机图像等领域已取得较好应用[14-16]。

本文针对带电作业机器人在复杂背景环境中线缆目标的智能检测问题,首次将Faster R-CNN模型引入到高压线缆及相关物体的目标检测任务中,根据高压线缆的特点对原始Faster R-CNN进行了改进,引入跳转连接使提取的特征更具表达能力,增加锚框数量使模型对不同尺寸目标都有较好的检测性能,最终实现了高空高压环境下各种线缆的目标检测,在精度上取得了目前最好的检测效果,并且检测速度更快,为带电作业机器人后续的操作提供了可靠的视觉支持。

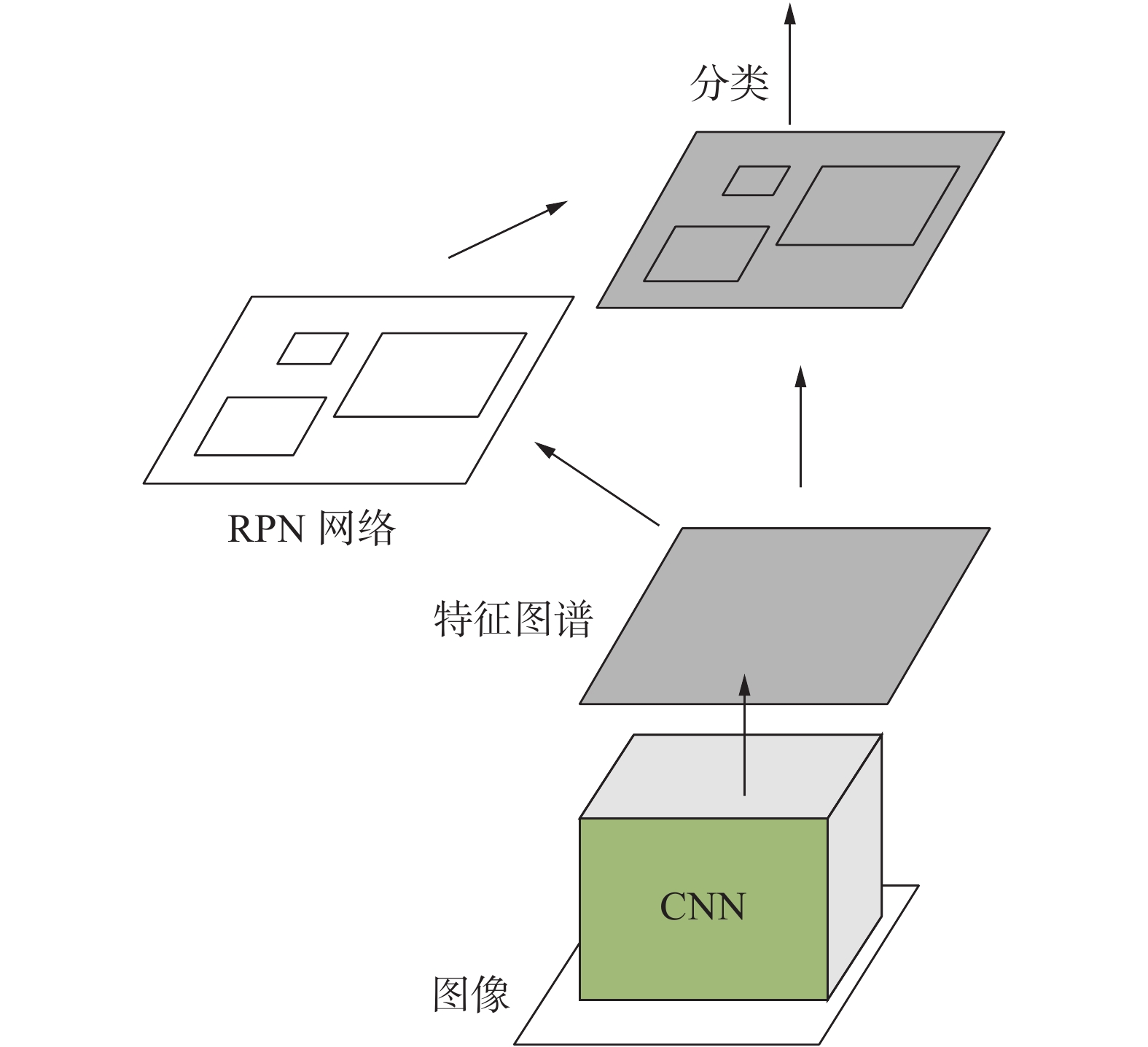

1 基于深度学习的高压线缆目标检测根据高压线缆目标检测的实际需求,本文以Faster R-CNN[17]模型为基础并提出了有效的改进策略,最终设计的模型原理框架如图1所示。它主要分为4个主要的步骤来实现:1)将整幅高压线缆图像输入深度卷积神经网络生成特征图谱;2)将特征图谱输入给区域候选网络(region proposal network, RPN)生成目标候选区域,避免了使用选择性搜索耗时长的问题,同时可以获得更加准确的定位结果;3)采用感兴趣区域池化层(region of interest, ROI)提取候选区域的特征,它可以将输入的任意尺寸的特征图谱转化成统一维度的输出向量,从而解决了卷积神经网络输入必须是固定尺寸的问题;4)利用一个多任务分类器做候选区域的位置回归,目标类别的判定采用深度学习算法精确检测出定位器的边界框位置。其中本文的改进首先在特征提取部分,引入跳转连接并调整激活层和卷积层的顺序,提高了网络提取图像高级特征的能力;其次在目标候选区域生成阶段增多锚框的种类和数量,提升对小目标检测的性能。

|

Download:

|

| 图 1 基于Faster R-CNN高压线缆目标检测框架 Fig. 1 Object detection framework of high voltage cable based on Faster R-CNN | |

卷积神经网络(convolutional neural networks, CNN)是一类包含卷积计算且具有深度结构的前馈神经网络,是深度学习中最具代表性的网络结构之一。传统的CNN网络一般包括卷积层、池化层和全连接层,随着网络层数的加深逐层提取图像的特征。一个典型是CNN结构如图2所示。

|

Download:

|

| 图 2 CNN的一般结构框架 Fig. 2 General structure of CNN | |

一般的目标检测方法都是使用选择性搜索来获取候选区域,但这种方法不仅耗时且准确率不高,因此考虑用一个卷积神经网络来进行候选区域的提取,这也就是RPN网络的核心思想。

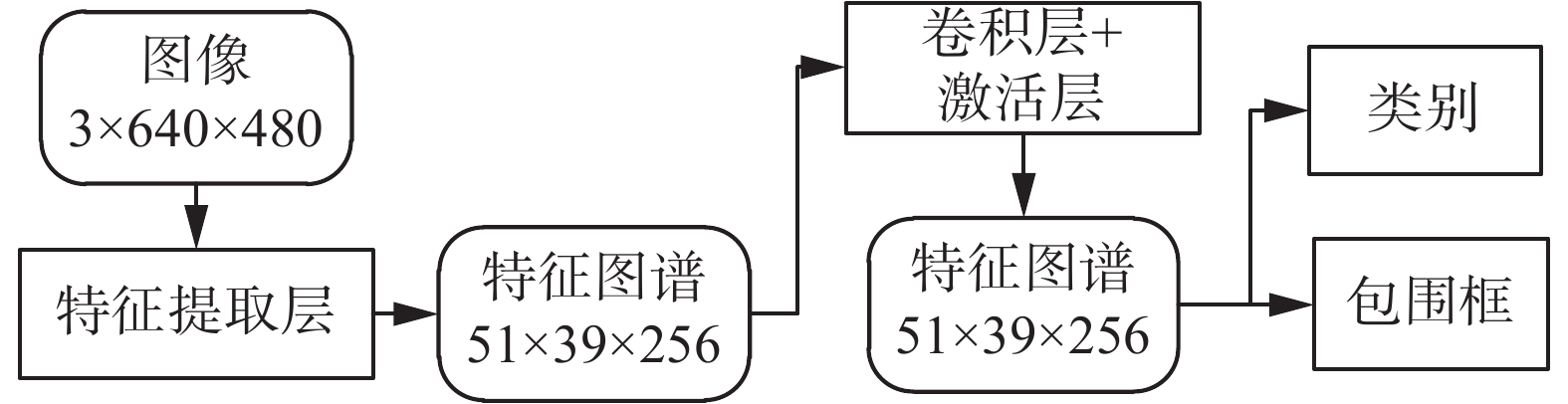

RPN的网络结构如图3所示。在RPN网络之前会用一个卷积神经网络对需要检测的图像进行特征提取,这个前置的CNN提取的特征维度为

|

Download:

|

| 图 3 RPN网络结构 Fig. 3 RPN networks structure | |

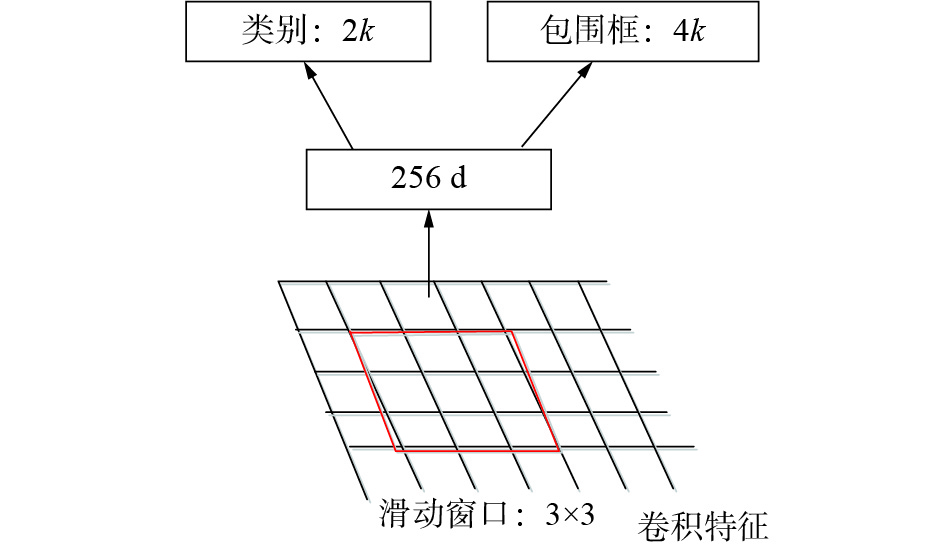

对于这

|

Download:

|

| 图 4 “锚”与网络输出的对应关系 Fig. 4 Corresponding relation between frame and network output | |

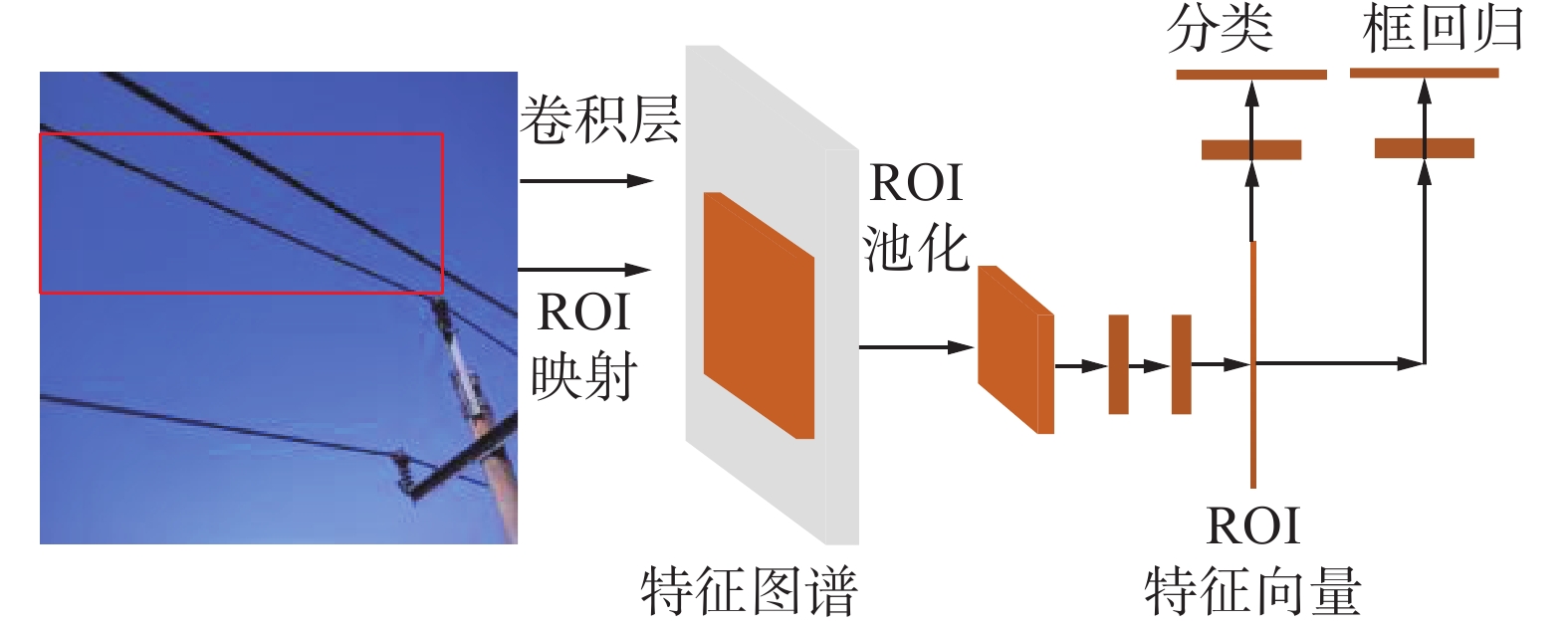

Fast R-CNN网络将特征提取和区域分类两个步骤融合在一个卷积神经网络中,不同于之前的方法是提取完每个区域的特征之后,再以传统的SVM作为分类器。这样Fast R-CNN就可以同时进行特征提取网络和分类网络的训练,从而获得更高的准确度,其网络结构如图5。

|

Download:

|

| 图 5 Fast R-CNN网络结构 Fig. 5 Fast R-CNN networks structure | |

对于待检测图像中的候选区域,将它映射到前置CNN所提取的卷积特征图谱中对应的区域,即图5中的感兴趣区域映射,这样操作是因为卷积特征图谱实际上和原始图像在位置上存在一定的对应关系,即待检测图像中的候选区域是对应在卷积特征图谱中相同的位置。然后使用ROI池化层对该区域再进行特征提取,如图6所示。ROI池化层对于不同尺寸大小的输入图像都能得到一个固定维度的输出向量。一般的卷积神经网络的输入需要固定尺寸的图像,而候选区域的尺寸是大小不一的。如果先将不同尺寸的区域缩放到统一大小再输入卷积神经网络提取特征,会降低后续的分类准确率,因此使用ROI池化层避免这个问题。

|

Download:

|

| 图 6 ROI池化层 Fig. 6 ROI pooling layer | |

为了具体阐述ROI池化层的作用,假设前置CNN输出特征图谱的宽度为

得到ROI池化层的特征向量后,分成两个分支分别送到全连接层进行分类和框回归。对于分类,如果待检测图像中有

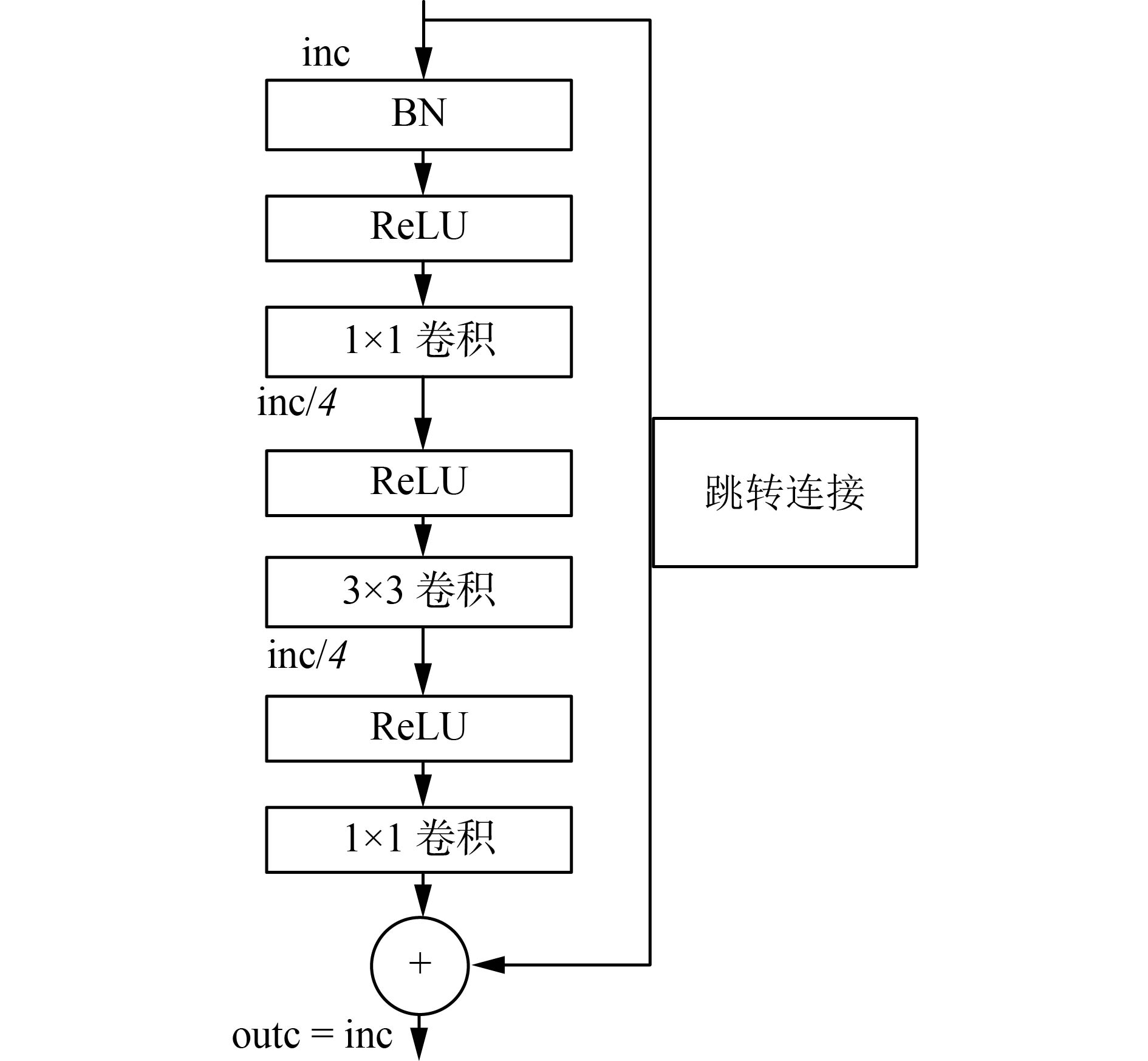

传统的卷积神经网络大多是由卷积层、池化层和全连接层组成深层网络,对于图像分类等计算机视觉任务,不断加深网络层数一般可以提高性能,但当网络加深到一定程度时,会导致梯度弥散或梯度消失,网络变得难以训练,同时导致提取的特征的语义属性减弱,对类别的判别能力变差[18-19]。为了解决这个问题,引入跳转连接,将卷积层的输入特征图谱加到输出部分,使网络具有能有效进行反传的梯度信息。同时增加

|

Download:

|

| 图 7 改进的深层网络特征提取模块 Fig. 7 Improved deep network feature extraction module | |

改进的特征提取模块降低参数的同时,也提高了网络在推理时的速度,节省了测试时间,更有利于高压线缆目标检测实际应用的需求。当使用图7的模块时,参数量为

| ${\rm{parameters}} = {\rm{inc}}\left( {{k_h}{k_w}} \right){\rm{outc}}$ | (1) |

区域候选网络中候选框的尺寸和长宽比是非常重要的超参数,它直接影响生成候选框的数量,也影响着网络对不同尺寸目标的识别能力。原始Faster R-CNN针对特征图谱上的每个“锚”,由3种长宽比和3种尺寸生成9个候选框,然后对获得的原始图片候选区域使用非极大值抑制算法删除冗余的候选区域,其中最小的尺寸为

在整个模型结构中,多任务分类器的损失函数定义为

| $\begin{aligned} & L\left( {\left\{ {{p_i}} \right\},\left\{ {{t_i}} \right\}} \right) = \frac{1}{{{N_{\rm{cls}}}}}\sum {{L_{\rm{cls}}}\left( {{p_i},p_i^ * } \right)} + \\ & \qquad\quad{\textit{λ}} \frac{1}{{{N_{\rm{reg}}}}}\sum\limits_i {p_i^ * {L_{\rm{reg}}}\left( {{t_i},t_i^*} \right)} \end{aligned} $ | (2) |

式中:

| ${L_{\rm{reg}}} = R\left( {{t_i} - t_i^*} \right)$ | (3) |

| ${L_{\rm{cls}}}\left( {{p_i},p_i^ * } \right) = - \log \left( {p_i^ * {p_i} + \left( {1 - p_i^ * } \right)\left( {1 - {p_i}} \right)} \right)$ | (4) |

式(3)中

| $R\left( x \right) = \left\{ \begin{array}{l} 0.5{x^2},\begin{array}{*{20}{c}} {}&{\left| x \right| < 1} \end{array}\\ \left| x \right| - 0.5,\begin{array}{*{20}{c}} {}&{{\text{其他}}} \end{array} \end{array} \right.$ | (5) |

为了验证本文提出的基于Faster R-CNN的高压线缆目标检测方法的有效性和先进性,首先本文生成了具有大量高压线缆图片的数据集,并将数据处理成VOC2007数据形式,主要包括采集高压线缆图像数据和标注需检测目标两个部分。

2.1.1 采集高压线缆图像数据本文使用高清摄像机采集了不同场景、天气环境下的高压线缆图像,并对其中感兴趣的目标进行了人工标签。天气环境主要分为晴天、阴天和强光3种情况,之所以将强光单独作为一类是因为强光会导致拍摄的线缆图像出现断裂的情况。高压线缆图像中的杆塔结构较复杂,有单回路结构和多回路结构,上有瓷柱,有多根线缆,线缆有时会出现重叠现象;图像背景一般都较为复杂,主要包含房屋、树木等。

2.1.2 标注检测目标对采集到的线缆图像中需要检测的目标进行了人工标签,使用LabelImg标注工具。图像中需要检测的目标有线缆与瓷柱的连接处(连接点, corner)、向右倾斜的线缆(右倾线, rline)、向左倾斜的线(左倾线, lline)和带线夹的线(线夹线, clampline)。表1中所列的数据集Data1和Data4的场景近似,Data1中的连接点只有一种情况,即横向连接;而数据集Data4中连接点有两种情况,包括横向连接和纵向连接,如图8(a)和图8(d)所示,图8(d)展示了Data4中的两种连接点。

| 表 1 不同场景的数据集 Tab.1 Test sets of five scenarios |

所有场景的数据均训练迭代10万次,采用衰减学习率,前5万代为0.001,后5万代为0.000 1。为了对比本文所提方法的有效性,对比方法为原始的Faster R-CNN。高压线缆图像尺寸为

评价指标选择目标检测中常用的平均准确率(average precision, AP),其值为P-R曲线围成的面积,其中P表示准确率、R表示召回率。P、R的计算方法如式(6)和式(7)所示:

| $P = {{\rm{TP}} / {\left( {{\rm{TP}} + {\rm{FP}}} \right)}}$ | (6) |

| $ R = {{\rm{TP}} / {\left( {{\rm{TP}} + {\rm{FN}}} \right)}} $ | (7) |

式中:TP是被正确划分为正例的个数,FP是被错误划分为正例的个数,FN是被错误划分为负例个数。mAP(mean average precision)即是所有类别的平均准确率的平均值。

实验环境为Ubuntu16.04系统,Intel Core i7-8700K和英伟达GTX 1080Ti显卡,使用TensorFlow框架进行提出算法的训练和测试。

2.3 实验结果及分析使用5种场景数据的训练集分别训练原始Faster R-CNN模型和提出的改进Faster R-CNN模型,然后在测试集上进行测试,得到各类别的平均准确率。原始Faster R-CNN的测试结果如表2所示,改进的Faster R-CNN的测试结果如表3所示。

| 表 2 原始Faster R-CNN在5种场景下测试结果 Tab.2 The test results average of original Faster R-CNN in the five scenarios |

| 表 3 改进Faster R-CNN在5种场景下测试结果 Tab.3 The test results average of improved Faster R-CNN in the five scenarios |

从测试集的实验结果可以看出,在不同天气条件环境下,原始的Faster R-CNN模型对高压线缆图像中的各类别目标检测的平均准确率均在80%以上,而mAP值均在84%以上。说明Faster R-CNN模型可以解决高压线缆目标检测任务。而改进的Faster R-CNN模型对高压线缆目标具有更好的检测性能,mAP值均在92%以上,相较原始的Faster R-CNN模型有明显提升,说明提出改进方法的有效性,且在阴天、强光和晴天背景复杂的场景下都可以较好地完成高压线缆目标检测任务。如图8是5种场景下,高压线缆目标检测结果的样例。每种场景展示了两张图像,图8(a)~(e)依次对应表1中的5种场景。

Data1、Data4和Data5数据集均为晴天下的场景中,且出现线缆重叠的情况较多,对比表2和表3中Data1、Data4两个数据集的测试结果可以看出,改进的方法对线缆的检测有较大的提升,mAP值分别提升了6%和8%,但在Data5数据集上,改进算法对左倾线的检测AP值有些小的降低。说明改进的Faster R-CNN模型可以较好解决目标遮挡的检测问题,但个别较严重的重叠情况可能无法检测。结合带电作业机器人的实际操作看,当发现重叠的线缆较多时,可以调节摄像头的方位使拍摄的图像中重叠的线缆尽量少,从而提升对线缆目标检测准确率。而且在实际应用中带电作业机器人每次总是处理单根线缆,所以重叠问题对实际操作的影响并不是很大。

在实际操作中更常见的场景是背景复杂的时候,如图8中Data2和Data5所示的场景,背景中会有大面积的房屋、树木等干扰识别的目标。但在这两个场景下,改进的Faster R-CNN模型的mAP均值93%以上。说明改进的Faster R-CNN模型在进行高压线缆目标检测时,可以较好地克服背景中包含大面积的房屋、树木等复杂场景。这一点在实际中的应用更有价值,提高了系统的适用范围,同时也验证了改进方法在进行高压线缆目标检测时的有效性。

|

Download:

|

| 图 8 5种场景下测试集的目标检测结果 Fig. 8 Detection results of test sets in five scenarios | |

改进的Faster R-CNN模型进行高压线缆目标检测时的速度与使用的硬件环境密切相关,当使用高性能的GPU如1080Ti测试时,15 f/s 的处理速度,相较于未改进算法的 12 f/s 处理速度有提升,完全能够满足带电作业机器人的实时性需求。

3 结束语针对带电作业机器人需要自动识别高空高压线缆的实际课题需求,本文结合当前在视觉领域最有效的深度学习方法,实现了一种自动识别线缆目标的方法。首先引入了Faster R-CNN模型进行特征提取,针对高压线缆图像的特点提出了两个方面的改进:在特征提取时引入跳转连接并调整卷积层、激活层的顺序,提升网络对高层语义特征的提取能力,改进候选框生成策略提升网络对连接点等小目标的检测能力。本文改进的Faster R-CNN模型展现出了针对不同天气环境、较复杂背景下的鲁棒、实时、高精度检测的优良性能,可以满足带电作业机器人视觉智能识别的技术指标。本文将深度学习方法应用于带电作业机器人的视觉识别任务中,取得了较好的精度和实时的性能,具有很高的工程应用价值。

| [1] |

赵玉良, 戚晖, 陈凡明, 等. 高压带电作业机器人专用遥控剥皮器的研制[J]. 微计算机信息, 2010, 26(32): 146-147, 119. ZHAO Yuliang, QI Hui, CHEN Fanming, et al. Design on the remote controlled electric-driving remover for live working robot[J]. Microcomputer information, 2010, 26(32): 146-147, 119. DOI:10.3969/j.issn.2095-6835.2010.32.057 (  0) 0)

|

| [2] |

王振利, 鲁守银, 李健, 等. 高压带电作业机器人视觉伺服系统[J]. 制造业自动化, 2013, 35(7): 69-72. WANG Zhenli, LU Shouyin, LI Jian, et al. Vision servo system for high-voltage live working robot[J]. Manufacturing automation, 2013, 35(7): 69-72. (  0) 0)

|

| [3] |

于进勇, 丁鹏程, 王超. 卷积神经网络在目标检测中的应用综述[J]. 计算机科学, 2018, 45(S2): 17-26. YU Jinyong, DING Pengcheng, WANG Chao. Overview: application of convolution neural network in object detection[J]. Computer science, 2018, 45(S2): 17-26. (  0) 0)

|

| [4] |

CAI Zhaowei, VASCONCELOS N. Cascade R-CNN: delving into high quality object detection[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 6154−6162.

( 0) 0)

|

| [5] |

宋焕生, 张向清, 郑宝峰, 等. 基于深度学习方法的复杂场景下车辆目标检测[J]. 计算机应用研究, 2018, 35(4): 1270-1273. SONG Huansheng, ZHANG Xiangqing, ZHENG Baofeng, et al. Vehicle detection based on deep learning in complex scene[J]. Application research of computers, 2018, 35(4): 1270-1273. DOI:10.3969/j.issn.1001-3695.2018.04.067 (  0) 0)

|

| [6] |

HINTON G E, OSINDERO S, TEH Y W. A fast learning algorithm for deep belief nets[J]. Neural computation, 2006, 18(7): 1527-1554. DOI:10.1162/neco.2006.18.7.1527 ( 0) 0)

|

| [7] |

毕晓君, 冯雪赟. 基于改进深度学习模型C-GRBM的人体行为识别[J]. 哈尔滨工程大学学报, 2018, 39(1): 156-162. BI Xiaojun, FENG Xueyun. Human action recognition based on improved depth learning model C-GRBM[J]. Journal of Harbin Engineering University, 2018, 39(1): 156-162. (  0) 0)

|

| [8] |

龙慧, 朱定局, 田娟. 深度学习在智能机器人中的应用研究综述[J]. 计算机科学, 2018, 45(S2): 43-47, 52. LONG Hui, ZHU Dingju, TIAN Juan. Research on deep learning used in intelligent robots[J]. Computer science, 2018, 45(S2): 43-47, 52. (  0) 0)

|

| [9] |

张慧, 王坤峰, 王飞跃. 深度学习在目标视觉检测中的应用进展与展望[J]. 自动化学报, 2017, 43(8): 1289-1305. ZHANG Hui, WANG Kunfeng, WANG Feiyue. Advances and perspectives on applications of deep learning in visual object detection[J]. Acta automatica sinica, 2017, 43(8): 1289-1305. (  0) 0)

|

| [10] |

GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, USA, 2014: 580−587.

( 0) 0)

|

| [11] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(9): 1904-1916. DOI:10.1109/TPAMI.2015.2389824 ( 0) 0)

|

| [12] |

GIRSHICK R. Fast R-CNN[C]//Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile: IEEE, 2015: 1440−1448.

( 0) 0)

|

| [13] |

REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 779−788.

( 0) 0)

|

| [14] |

莫宏伟, 汪海波. 基于Faster R-CNN的人体行为检测研究[J]. 智能系统学报, 2018, 13(6): 967-973. MO Hongwei, WANG Haibo. Research on human behavior detection based on Faster R-CNN[J]. CAAI transactions on intelligent systems, 2018, 13(6): 967-973. (  0) 0)

|

| [15] |

曹宇剑, 徐国明, 史国川. 基于旋转不变Faster R-CNN的低空装甲目标检测[J]. 激光与光电子学进展, 2018, 55(10): 101501. CAO Yujian, XU Guoming, SHI Guochuan. Low altitude armored target detection based on rotation invariant faster R-CNN[J]. Laser and optoelectronics progress, 2018, 55(10): 101501. (  0) 0)

|

| [16] |

魏湧明, 全吉成, 侯宇青阳. 基于YOLO v2的无人机航拍图像定位研究[J]. 激光与光电子学进展, 2017, 54(11): 111002. WEI Yongming, QUAN Jicheng, HOU Yuqingyang. Aerial image location of unmanned aerial vehicle based on YOLO v2[J]. Laser and optoelectronics progress, 2017, 54(11): 111002. (  0) 0)

|

| [17] |

REN Shaoqing, HE Kaiming, GIRSHICK R, SUN J. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 ( 0) 0)

|

| [18] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA, 2016: 770−778.

( 0) 0)

|

| [19] |

XIE Saining, GIRSHICK R, DOLLÁR P, et al. Aggregated residual transformations for deep neural networks[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 5987−5995.

( 0) 0)

|

2019, Vol. 14

2019, Vol. 14