2. 威富集团 形象认知计算联合实验室,北京 100083;

3. 中国科学院大学 微电子学院,北京 100029

2. Image Cognitive Computing Joint Lab, Wave Group, Beijing 100083, China;

3. School of Microelectronics, University of Chinese Academy of Sciences, Beijing 100029, China

近年来,计算机视觉作为一门新兴学科发展十分迅速,目标跟踪作为视频监督、分析和理解的关键技术,由于其重要的学术价值、潜在的商业价值和广泛的应用前景迅速成为计算机视觉领域研究的热点和难点,已成功应用于智能监控、机器人、医学成像及人体运动分析等人机交互领域[1-2],越来越多的学者和机构在相关方面进行了大量的研究工作,同时取得了较好的成就。然而,目标形状变化、快速运动和遮挡一直是限制目标跟踪在实际场合应用的瓶颈。

最近,KCF[3]以其高效的计算能力成功引起了众多研究者的重视和青睐,同时在目标跟踪中取得了较好的性能。该方法首次将快速Fourier变换成功应用到目标跟踪中,达到了实时跟踪的效果。然而该算法未对遮挡和快速运动中的目标跟踪作进一步处理;同时为了减少训练样本数目少的缺陷,每一帧均用于模板更新,以增强模板的检测性能,但这也使得大量的与目标无关的背景信息被加入到模板更新中,导致跟踪框漂移,目标跟踪性能下降。针对经典的KCF算法存在的问题,最新的跟踪算法主要从2个方面作改进:一种是目标特征表示的优化设计,另一种是鲁棒的分类器的设计。

1)目标新特征的优化设计方法。特征的优化设计是目标跟踪领域一个非常重要的研究线索,该方法主要致力于目标表示的设计,即通过采用机器学习方法或者深度学习方法设计表达能力更好的特征,实现目标更详细的描述。文献[4-8]对传统特征进行改进;考虑到深度学习在特征表示中的优越性,文献[9-13]采用深度卷积神经网络挖掘高层卷积特征,以增强跟踪算法的性能。文献[9]直接从预训练的深度CNN中提取若干层特征并用于学习自适应相关滤波器,保证了跟踪准确率和鲁棒性。进一步地,文献[10]提出了一种基于CNN的序列训练方法,该方法把每个通道的特征输出作为单独的跟踪器,最后将分类器的结果级联作为最后的决策输出。目标特征的优化设计方法,虽取得了一定成绩,但目标跟踪算法旨在区分出背景和目标区域,该方法所学习到的特征只表示了目标视频的底层视觉信息,未对背景作进一步约束,导致学习到的模板判别能力非常有限。因此,获取判别性好的目标特征仍是一个比较棘手的难题。

2)鲁棒的分类器的设计方法。鲁棒的分类器设计方法主要是通过建立优化机制,对需要进行模板更新的样本作限制,进一步保证了模板对于目标的检测效果。为了充分利用结构化输出的SVM能够处理复杂输出,如树、序列和集合等优势,Hare等[14]首次将该算法应用到跟踪中,大大提高了跟踪准确率。为降低计算复杂度,Ning等[15]提出了一种基于双线性结构化的SVM模型,该模型采用的特征图可达到近似非线性核的效果,因此跟踪性能得到大幅度提升,然而该算法的跟踪速度依然限制了其实际应用。因此,Wang等[16]提出了一种高置信度的模板更新策略,能尽可能地避免模板更新引入的背景信息,但目标跟踪过程中,目标往往不是一成不变的,目标状态的变化会引起当前跟踪框的置信度较小,从而导致学习到的模板无法拟合目标的变化。

以上2种方法致力于设计更复杂的特征或者分类器,在提高跟踪精度的同时,无疑大大增加了算法的复杂度,从而限制了视觉跟踪的实时性能,同时,上述方法并没有对目标的快速运动和目标遮挡作进一步的处理。

1 跟踪算法新构架本文提出了一种自适应模板更新的判别式核相关滤波跟踪新构架,如图1所示。能够判断当前跟踪状态是否正常,及时恢复丢失的目标,同时能够判断当前跟踪的目标是否发生形状变化,并制定出不同的机制恢复丢失的目标,实现了高效的目标跟踪。

|

Download:

|

| 图 1 目标跟踪新框架图示 Fig. 1 Overview of the proposed framework for visual tracking | |

为了实时监督跟踪目标是否发生形状变化或者目标丢失的情况,本文提出一种基于外观判别式分类器的跟踪质量判定标准,以判断跟踪结果的准确性,实现目标的有效跟踪。本文跟踪结果判定标准的定义和实现如下:

1)获取初始帧中目标框的初始信息。采用目标检测算法对输入帧执行目标检测,获取目标框的初始信息,包括目标所在位置以及尺寸大小。

2)构建判别式分类器的样本训练集并分配样本标签。以一定步长在目标框的周围进行稠密采样,获取与目标框大小相同的训练样本;假设样本图像所在框与目标框之间的重叠阈值为

3)提取样本的HOG特征在低维空间的特征表示,即HOG描述子。首先提取所有样本的HOG特征,然后采用PCA-net[17]的思想对HOG特征作进一步的降维处理,旨在获取更抽象且判别性更好的特征表示

4)对所有正负样本重复3),得到所有样本的低维特征表示,为当前目标学习判别模型

5)针对易混淆的训练样本,在模型学习的过程中加入类别约束,对易错分的样本进行惩罚,使得特征的类别信息更明显,判别能力更强。针对出现错分的样本:若隶属于目标的样本特征

| $s({f_{{\rm{obj}}}}, {\rm{sv}}{{\rm{m}}_1} ) - s({f_{{\rm{bgd}}}}, {\rm{sv}}{{\rm{m}}_1} ) > 0$ | (1) |

6)采用KCF获取测试帧的跟踪结果,并计算跟踪区域对应的特征

| $s {\rm{(}}f, {\rm{SV}}{{\rm{M}}_{{\rm{obj}}}} {\rm{) = max}}(s(f, {\rm{sv}}{{\rm{m}}_{i}}), i = 1, 2, \cdots , n )$ | (2) |

| $ {\rm{trk\_sta}} = \left\{ {\begin{aligned} & {{\rm{normal}} , }\qquad s{\rm{(}}f, {\rm{SVM}}_{{\rm{obj}}} {\rm{) > }}{T_{{\rm{sco}}}} \\ & {{\rm{abnormal}},} \quad { \text{其他}} \end{aligned}} \right. $ | (3) |

式中:

本节给出了一种基于极小值的模板更新策略,旨在针对性地筛选出不同形状以及与背景相似度较大的目标样本,用于对当前模板进行更新,以增强模板对于不同形状和与背景相似的正样本的泛化能力。

目标跟踪过程中,可观察到置信度呈现先下降后上升的趋势,有2种情况可以解释:1)目标形状从偏离初始模板到逐渐恢复至与模板相似,如目标的平面内旋转;2)目标形状发生变化的过程中,目标形状逐渐偏离初始模板,而背景中存在与初始模板相近的区域,导致目标所在位置框朝着背景方向漂移,如目标平面外的旋转。为了能够让模板具有较好的鲁棒性,需要同时保证图像标签为1的正样本的数量和多样性,当上述2种情况出现时表示目前样本的状态发生了变化,需要对模板及时进行更新,使得跟踪器具有更好的检测性能。因此,模板的更新条件设置为:连续多帧目标跟踪框的置信度呈现先增后减的趋势,即伴随有极小值的出现。基于这样的思想,本文基于极值的模板更新策略具体过程如下。

1)输入下一帧图像,采用KCF算法进行跟踪,获取跟踪结果的置信度。

2)重复步骤1),获取连续

| $ F = \left\{ {\begin{aligned} & {1, } \quad { {\rm{argmin}}(C) = = n - 1 }\\ & {0, } \quad { {\text{其他}} } \end{aligned}} \right. $ | (4) |

3)若

4)模板未被更新时,若极小值出现在帧

| $ {C'_{\rm{n}}} = \left\{ {\begin{aligned} & {\{ \} ,} \quad {\rm{ argmin}}(C) = = n - 1 \\ & {\{ {c_2}, {c_3}, \cdots , {c_n}\} , }\quad {\rm{argmin}}(C) = = n \\ & {\{ {c_n}\} ,} \quad {\text{其他}} \end{aligned}} \right. $ | (5) |

5)将用于模板更新的样本作为训练样本,学习新的外观判别式模型

本文提出了一种自适应模板更新的判别式核相关滤波跟踪新构架,能够实时监督目标的跟踪情况,捕捉发生旋转或者处于遮挡和快速运动的目标,并进一步设计跟踪丢失恢复机制,以保证目标实时且长期有效地跟踪,具体实施如下。

1)输入图像,并执行1.1节提出的跟踪质量判定方法,捕捉跟踪异常的情况。

2)获取跟踪异常的图像帧,利用1.2节提出的模板更新策略获取模板更新标志

3)对当前帧执行目标检测算法,若丢失目标被成功检测,则利用检测结果继续跟踪,否则认为目标被干扰物遮挡,在这种情况下,假设遮挡过程具备时长短期性和目标运动位移最小化的性质,因此,保持目标丢失前的位置不变,直到跟踪状态

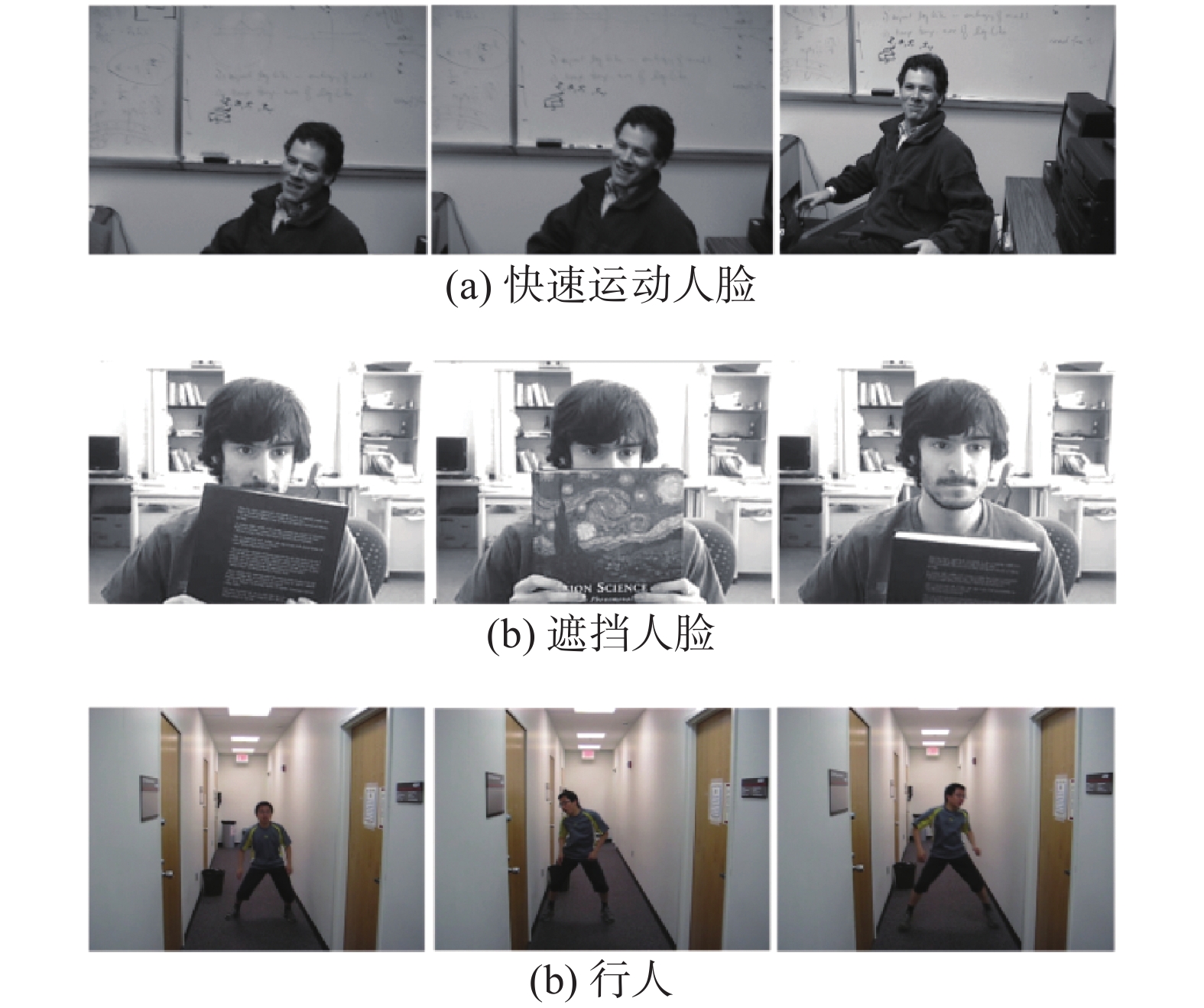

为验证提出的新框架的有效性,首先从公共数据集OTB-100[18]中选取50组视频进行测试。然后,分别选取具有旋转、快速运动和遮挡属性的视频对本文新构架的鲁棒性进行评估。图2给出了OTB-100中的部分视频帧。一次成功率和帧速率分别用于跟踪评估。一次成功率用于评估跟踪的准确率,包含跟踪精度和成功率两个指标;帧速率用于评估跟踪速度的快慢。

|

Download:

|

| 图 2 OTB-100数据库 Fig. 2 OTB-100 dataset | |

本文实验参数设置如下:1)本文提出的基于极值的自适应更新策略中,最小值存在性判断需要的帧数目

本节采用基于HOG和CN特征结合的跟踪新构架,即AU_DKCF进行测试,通过比较不同特征以验证提出的方法的有效性。表1分别列出了新构架AU_DKCF与对比算法的跟踪结果。由表1可以看出,新构架在跟踪速度和精度方面取得了较高的性能,均优于对比算法。其原因在于:新构架能够较准确判断目标是否跟踪异常,同时可进一步区别目标跟踪异常所产生的原因,并利用不同机制恢复丢失的目标,实现目标长期且准确地跟踪。AU_DKCF在采用2种手工特征结合时,跟踪速度能达到105.2 f/s,可有效实现目标的实时跟踪。

| 表 1 本文新构架和对比算法的目标跟踪结果 Tab.1 Object tracking results of proposed method and contrastive methods on OTB-50 |

本节针对具有目标形状变化、目标被遮挡和快速运动等属性的视频序列,分别进行目标跟踪测试,以验证提出的跟踪算法对于上述挑战的鲁棒性。表2给出了本文新构架和对比算法在OTB-100数据集上,对于不同属性视频的跟踪结果。由表2可以看出,本文提出的新构架对于上述挑战的有效性。

| 表 2 本文新构架对不同属性视频的跟踪结果 Tab.2 Tracking results on videos with sequence attributes % |

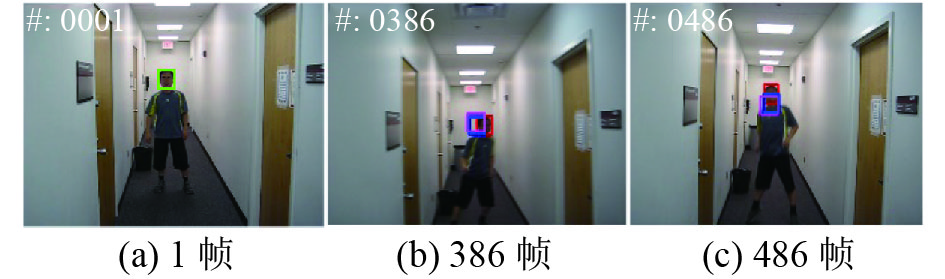

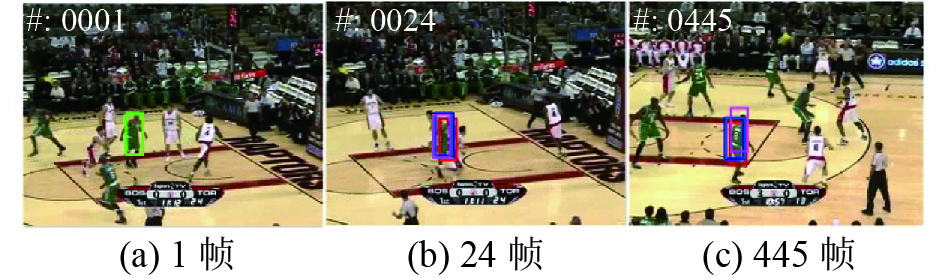

本节给出了本文新框架的跟踪可视化效果,以展示本文方法的有效性。图3~5分别给出了本文AU_DKCF和经典滤波算法(线性相关滤波DCF和核相关滤波KCF)对旋转属性的视频,快速运动属性的视频和遮挡属性的视频的跟踪结果。从图中可以观察得到,新框架在处理具备旋转挑战的视频时,获得了更优的性能。图3~5中,绿色框表示Groundruth,紫色框表示DCF,蓝色框表示KCF,红色框表示AU_DKCF。

|

Download:

|

| 图 3 足球视频的可视化跟踪结果 Fig. 3 Visualizing tracking result of soccer | |

|

Download:

|

| 图 4 行人视频的可视化跟踪结果 Fig. 4 Visualizing tracking result of boy | |

|

Download:

|

| 图 5 篮球视频的可视化跟踪结果 Fig. 5 Visualizing tracking result of basketball | |

本文在充分分析、研究和实验的基础上,取得了以下几点结论:1)提出一种基于外观判别式分类器的跟踪质量判定方法,旨在判断当前跟踪状态是否正常,以便及时恢复丢失的目标;2)提出了一种新的自适应模板更新策略,在提高跟踪速度的同时,能够判断当前跟踪的目标是否发生形状变化,以增强模板的泛化能力;3)提出一种融合跟踪质量判定和模板自适应更新的跟踪新构架,旨在实时判断当前跟踪目标所处状态,同时制定出不同的机制恢复丢失的目标,实现了高效的目标跟踪。后续作者将致力于将现有跟踪算法和深度学习结合用于安防监控中的异常行为分析、客流量统计和警戒区域报警等应用中。

| [1] |

YILMAZ A, JAVED O, SHAH M. Object tracking: a Survey[J]. ACM computing surveys, 2006, 38(4): 45-50. ( 0) 0)

|

| [2] |

CANNONS K. A review of visual tracking[R]. Technical Report CSE 2008-07. York University, Canada, 2008.

( 0) 0)

|

| [3] |

HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE transactions on pattern analysis and machine intelli-gence, 2015, 37(3): 583-596. DOI:10.1109/TPAMI.2014.2345390 ( 0) 0)

|

| [4] |

DANELLJAN F M, KHAN F S, FELSBERG M, et al. Adaptive color attributes for real-time visual track-ing[C]//Proceedings of the 20014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, USA, 2014: 1090–1097.

( 0) 0)

|

| [5] |

JIA Xu, LU Huchuan, YANG M H. Visual tracking via adaptive structural local sparse appearance mod-el[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Providence, USA, 2012: 1822–1829.

( 0) 0)

|

| [6] |

KALAL Z, MIKOLAJCZYK K, MATAS J. Track-ing-learning-detection[J]. IEEE transactions on pattern analysis and machine intelligence, 2012, 34(7): 1409-1422. DOI:10.1109/TPAMI.2011.239 ( 0) 0)

|

| [7] |

KWON J, LEE K M. Visual tracking decomposi-tion[C]//Proceedings of the 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, USA, 2010: 1269–1276.

( 0) 0)

|

| [8] |

ROSS D A, LIM J, LIN R S, et al. Incremental learning for robust visual tracking[J]. International journal of computer vision, 2008, 77(1/2/3): 125-141. ( 0) 0)

|

| [9] |

HONG S, YOU T, KWAK S, et al. Online tracking by learning discriminative saliency map with convolutional neural network[C]//Proceedings of the 32nd International Conference on Machine Learning. Lille, France, 2015: 597–606.

( 0) 0)

|

| [10] |

MA Chao, HUANG Jiabin, YANG Xiaokang, et al. Hier-archical convolutional features for visual track-ing[C]//Proceedings of the 2015 IEEE International Con-ference on Computer Vision. Santiago, Chile, 2015: 3074–3082.

( 0) 0)

|

| [11] |

QI Yuankai, ZHANG Shengping, QIN Lei, et al. Hedged deep tracking[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 4303–4311.

( 0) 0)

|

| [12] |

WANG Lijun, OUYANG Wanli, WANG Xiaogang, et al. Visual tracking with fully convolutional net-works[C]//Proceedings of the 2015 IEEE International Conference on Computer Vision. Santiago, Chile, 2015: 3119–3127.

( 0) 0)

|

| [13] |

WANG Lijun, OUYANG Wanli, WANG Xiaogang, et al. Stct: sequentially training convolutional networks for visual tracking[C]//Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 1373–1381.

( 0) 0)

|

| [14] |

HARE S, SAFFARI A, TORR P H S. Struck: structured output tracking with kernels[C]//Proceedings of the 2011 International Conference on Computer Vision. Barcelona, Spain, 2011: 263–270.

( 0) 0)

|

| [15] |

NING Jifeng, YANG Jimei, JIANG Shaojie, et al. Object tracking via dual linear structured SVM and explicit feature map[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 4266–4274.

( 0) 0)

|

| [16] |

WANG Mengmeng, LIU Yong, HUANG Zeyi. Large margin object tracking with circulant feature maps[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA, 2017: 4800–4808.

( 0) 0)

|

| [17] |

CHAN T H, JIA Kui, GAO Shenghua, et al. PCANet: a simple deep learning baseline for image classification?[J]. IEEE transactions on image processing, 2015, 24(12): 5017-5032. DOI:10.1109/TIP.2015.2475625 ( 0) 0)

|

| [18] |

WU Yi, LIM J, YANG M H. Online object tracking: a benchmark[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Portland, USA, 2013: 2411–2418.

( 0) 0)

|

| [19] |

KALAL Z, MIKOLAJCZYK K, MATAS J. Track-ing-learning-detection[J]. IEEE transactions on pattern analysis and machine intelligence, 2012, 34(7): 1409-1422. DOI:10.1109/TPAMI.2011.239 ( 0) 0)

|

| [20] |

WU Yi, SHEN Bin, LING Haibin. Online robust image alignment via iterative convex optimization[C]//Proceedings of 2012 IEEE Conference on Computer Vision and Pattern Recognition. Rhode Island, USA, 2012: 1808–1814.

( 0) 0)

|

2019, Vol. 14

2019, Vol. 14