一场重大的科技革命必以一门新学科作为标志,这门新学科又必须以一支新数学作为支撑。工业革命以牛顿力学为标志学科,以微积分作为数学支撑。信息革命以信息科学作为标志,机制主义人工智能理论[1-2]是把结构主义、功能主义和行为主义这三大流派有机统一起来的以柔性逻辑[3]包容的通用人工智能理论,是信息科学的重要发展。那么,什么是信息科学的数学支撑呢?本文对此问题的回答是,因素空间是机制主义人工智能理论的数学基础, 它是为迎接人工智能的深刻革命而作的数学准备。

信息科学与物质科学的根本差别是有没有认识主体的参与。客体是离开认识主体的存在,认识主体按其目标需求从客体信息提取语义信息,再将语义信息转化为知识,提高智能,改造主、客观世界,这就是信息科学的主要内容。因素是信息提取的导向标,是信息向知识转化的分析与融合器。信息生态的机制就是要以因素为导向,首先关注客体的形式与效用这两个方面。用目标需求从后往前倒逼,用储备的知识从前往后疏通,这样前后夹逼,所得到的语义信息就是形式与效用相统一的全信息。客体的状态千变万化,必须用因素来进行分析与综合,例如形状、大小、颜色、质量等,统称为状态因素,状态因素使人形成对事物外形的知觉。事物的内在属性也要用因素来梳理,杯子可以是日常饮具或者是保健食品容器,也可能是供人鉴赏的艺术品,不同的目标需求按效用来观察事物的内在属性,属性因素揭示事物的内在效用。状态因素与属性因素之间的结合衍生出特定的概念;因素之间的相互关联决定事物的因果,提供逻辑推理以进行决策。基于因素空间理论所建立的数据库以培植数据的方式来实现数据生态与知识生态之间的同构,用因素来组织数据,运用知识把传统的搜索技术提到一个新的高度,这些都是机制主义人工智能所需要的数学理论和方法。

1 因素空间的基本框架什么是因素?按字面来理解,因字既言本事物之所以是,亦言它事物之所以生。前者讲事物构成,后者讲因果关联。因素非因,乃因之素。雨量充沛是丰收的一个原因,但它不是因素。因素是降雨量,由它统领“洪涝”、“雨量充沛”、“雨量欠缺”和“干旱”等性状。因素通过变化来显示其影响。如果降雨量的变化不能改变丰收这一结果的话,那么雨量充沛就不是丰收的原因;降雨量之所以对古代农业那么重要,是因为它的变化既可以使大众喜迎丰收,也可以使遍地颗粒无收,这才使人们知道降雨量对粮食收成来说是多么重要的一个因素,遇到少雨就要考虑防旱。从原因到因素是人在认识上的一种升华。只有掌握因素才能找到原因,看透原因。因素是比属性高一个层次的东西,它是属性的统领,是属性之名。事物都是质与量的统一,属性是质表,因素是质根。属性被动描写事物,因素则具有启发的特质,在信息科学和人工智能的数学描述中,因素是一个特别关键的词。只有强调质根,才能找到事物和认识的成因。哲学家早已对属性下过定义,但至今仍忽视质根。属性像是珍珠,质根是串联珍珠的线头。线头一断,珍珠就洒满遍地,搜索起来格外困难。人脑是信息提取的优化结构,人脑的感觉细胞是按特征(即因素)来组织的;生命科学中所诞生的基因就是生命的质根。基因最早的英文名称是Factor,因素就是广义的基因。信息革命需要将打开生命之门的这把钥匙引向信息之门,哲理指明了因素空间乃是信息科学和人工智能对数学的期望之所在。

1.1 因素与因素空间的数学定义在数学上,因素被定义成映射,更具体一点地说,因素是一种性状映射,它把事物映射成它们的性状。

定义1[4] 设U是所要讨论的一类事物的集合,叫作论域。一个定义在论域U上的映射f: U→X(f)叫作U上的一个因素,其中X(f)是映射f所映照出来的事物性状的集合,叫作f的性状空间。

性状有两种类型,一种是连续的实数值,例如,因素身高可表示为特定的人群U上的一个映射f =

只取定量性状空间的因素叫作定量因素,只取定性性状空间的因素叫作定性因素。这样称呼仅仅是为了叙述的方便。严格来说,定性与定量是一对普遍矛盾,它们对立统一地寓于事物之中,相互转化,因素既可以定性,也可以定量,我们对任何因素都同时预备着定性与定量两种性状空间,以备相互转换。在同时出现两种性状空间的时候,我们用

定性映射决定论域的划分。设

定义2 记

因素有简单与复杂之分,所谓

定义3 设

不难证明,任给

| $X\left( F \right) = X\left( {{f_{\left( 1 \right)}}} \right) \times X\left( {{f_{\left( 2 \right)}}} \right) \times \cdots \times X\left( {{f_{\left( k \right)}}} \right)$ | (1) |

记此因素的合成运算为

| $F \cup G = {\rm{Sup}}\left\{ {F,\;G} \right\},\;F \cap G = {\rm{Inf}}\left\{ {F,\;G} \right\}$ | (2) |

定义4 记

这个定义在以前一直引用的文献[5]的基础上做了简化。

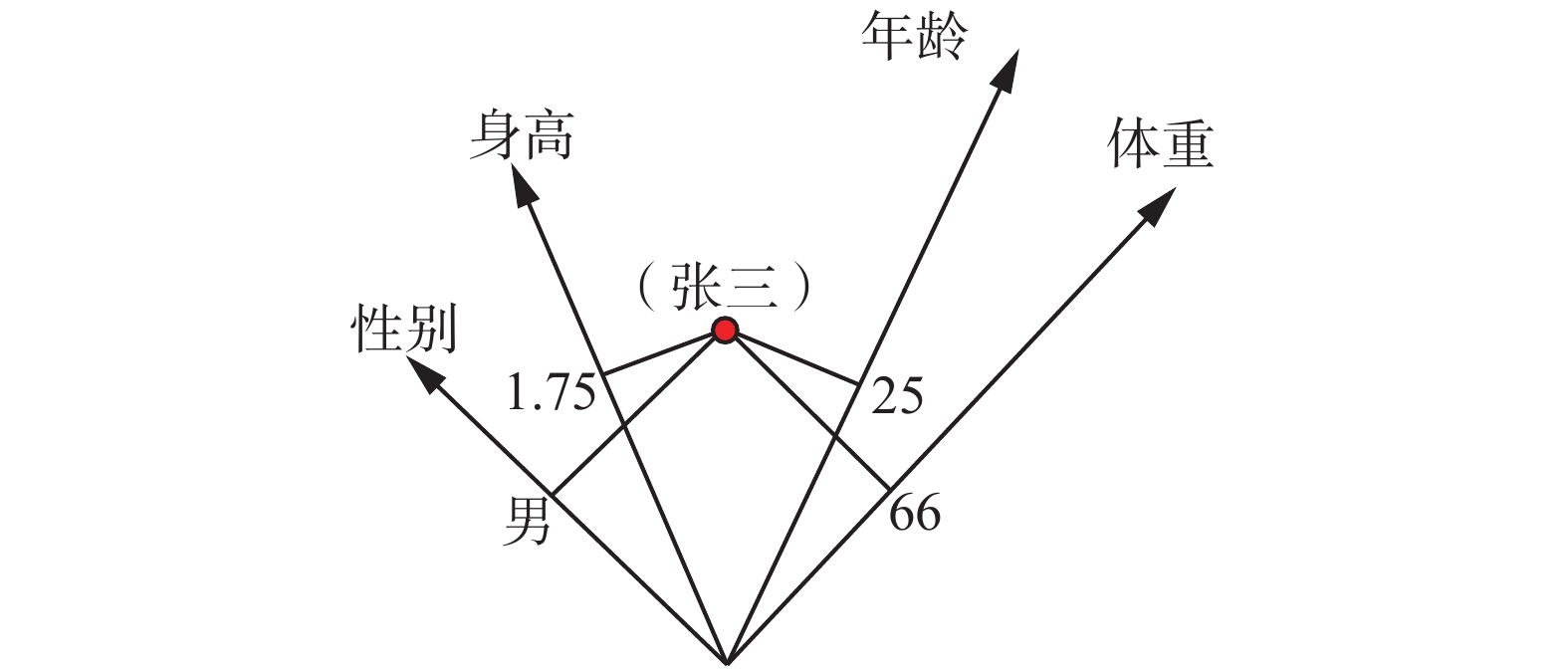

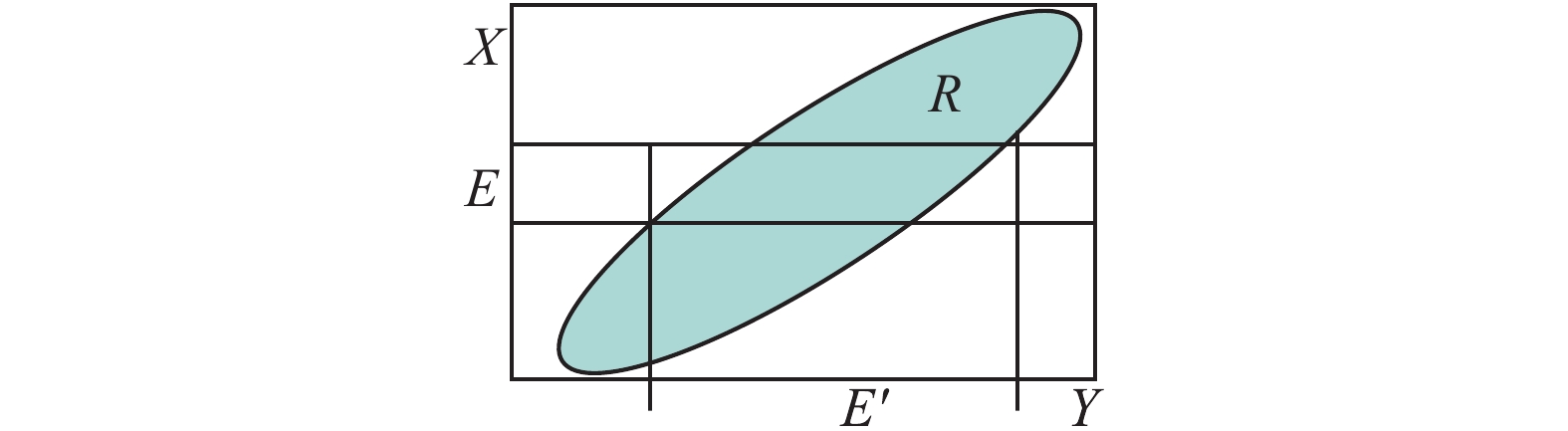

所有笛卡尔空间,例如力学的运动空间、控制论的状态空间、模式识别的特征空间等,都是性状空间。它们都可作为因素空间的特例,因素空间是笛卡尔空间的推广。如图1所示,任何事物都可以像张三这样地被映射成为性状空间中的一个点,因素空间为一般事物的描述提供了普适性的数学框架。一群对象被映射成为性状空间中的样本点集。要对这群对象分类,就必须将它们投射到因素性状空间中来进行分割。

|

Download:

|

| 图 1 张三被映射为因素空间中的一个点 Fig. 1 Mapping Zhang San mapped to a point in the factor space | |

定义5[4] 给定U上的定性因素空间

| $\left[ {\mathit{\boldsymbol{a}}} \right] = {F^{ - 1}}\left( {\mathit{\boldsymbol{a}}} \right) = \left\{ {u \in U\left| {F\left( u \right) = {\mathit{\boldsymbol{a}}}} \right.} \right\}$ | (3) |

| $\begin{array}{c}R = F\left( U \right) = \left\{ {{\mathit{\boldsymbol{a}}} = \left( {{a_1},{a_2}, \cdots ,{a_n}} \right) \in X|\exists u \in U;} \right.\\\left. {{f_1}\left( u \right) = {a_1},{a_2}, \cdots ,{f_n}\left( u \right) = {a_n}} \right\}\end{array}$ | (4) |

式中R叫作因素

显然有,

定义5多用于定性因素,其中的a是指性状颗粒。但定义5也可用于连续情形,此时a细化为一个实数点。

背景关系是因素空间的核心概念,下面会看到它既可以决定概念的自动生成,又可决定概念之间的一切推理,由它可以建立知识描述的确定性理论框架。但现实中的背景关系多带有不确定性。原因有二:1) 性状粒度往往过大,说一个人的性状容易,说一群人的性状就不确定了,存在着抽样的随机性;2) 定性因素相的划分不明确,例如年龄这个因素,究竟怎样划分青年、中年和老年?存在着模糊性。为此,要引入背景分布和模糊背景关系的概念,为了节省篇幅,本文只介绍背景分布。

设论域

定义6 设论域

背景分布是背景关系的随机化。随机化后的因素都可视为广义的随机变量,特别对定性因素而言,因素可以叫作随机词。为了方便,我们常将因素的记号改为随机变量的记号,甚至约定:

为了简便,我们以后讲可测因素空间就是指定义6中所说的带有可测结构的因素空间而且所有元都是从

背景分布

| $R = \left\{ {a \in X|p\left( a \right) > 0} \right\}$ | (5) |

由此,可以将背景分布的概念推广到定量因素的情形。

定义7 对定量因素而言,背景分布密度函数

| $R = \cap \left\{ {B \in {\mathit{\boldsymbol{B}}}\left| {{{\smallint}}_B {P\left( x \right)} {\rm{d}}{\mathit{\boldsymbol{x}}} = 1} \right.} \right\}$ | (6) |

数据工作者熟知信息系统和形式背景理论,它们为数据建立了表格,为非数值信息找到了初步的符号表示。因素空间理论正是它们的提升,为信息系统建立坐标框架,把一张形式系统表可视化地变为因素性状空间的一组样本点,背景关系就成为它们的母体。背景关系是因素空间的形骸,塑造这个形骸的工具就是背景基。

将按因素空间思想组织起来的数据叫作因素数据库,主要的库表叫作因素表,具表头

定义8[4] 记

因素库中首先考虑样本怎样表现背景关系。很明显的事实是,当样本逼近母体时,相样本就变成背景关系。

设

| $R = \cup \left\{ {S|S{\text{是相样本}}} \right\}$ | (7) |

只要表头相同,对相样本不断地求并,就可以单调递增地逼近目标。同表头的相样本求并就是行的叠加。这个过程是可以并行处理的。因素库的目标是要将数据培育成背景关系,形成认知包以产生知识。要使这一思想得以实现,关键在于信息压缩。

定义9[4] 若每个元性状空间

背景基可以生成背景关系,它是背景关系的无信息损失的压缩,对因素库的实际应用具有重要的意义。无论数据多大,样本背景基的数量始终保持在低维度上。在网上吞吐数据时,每输入一个新的数据,都要判断它是否是样本背景基的内点,若是,则删除此数据,否则将它纳入样本背景基,此时,要逐一检验原有的基点,它若在新基点中变成内点,则淘汰删除之。

给定整值样本

夹角判别法[4]

例1 在图2中,

解

| $(o - d,a - d) = (1.7, - 1)(0, - 3) = 3 > 0$ |

| $(o - d,b - d) = (1.7, - 1)\left( {2,1} \right) = 2.4 > 0$ |

都是非负,d不是S的内点。

| $(o - e,a - e) = \left( {0.7,{\rm{ }}1} \right)( - 1, - 1) = - 1.7 < 0$ |

一旦出现负数就是内点,e是S的内点。

|

Download:

|

| 图 2 背景基内点的夹角判别法 Fig. 2 The angle criterion for inner points of background base | |

这个判别法虽然是近似的,正有改进研究,但此方法却有应用价值。计算量很小,复杂度是

因素空间是一个概念划分单元,不同单元联结起来形成因素藤。刘增良[6]提出了因素神经网络,使因素空间理论和神经网络方法结合起来,把学习机制引入因素空间。因素藤又与因素神经网络相对应,呈现新的活力。黄崇福[7]提出了智联网,把因素空间作为智联网的数学刻画工具,进一步上升到网络数学,具有比笔者更加广阔的视野和更加宏伟的历史使命。

因素空间是信息系统和形式背景理论的提升,能为客体提供一个可以存放其形式信息和效用信息的坐标系统,把关系数据库中的数据变成可视的样本点,它们的母体所形成的背景分布,乃是因素空间的形骸,塑造它的工具是背景基。

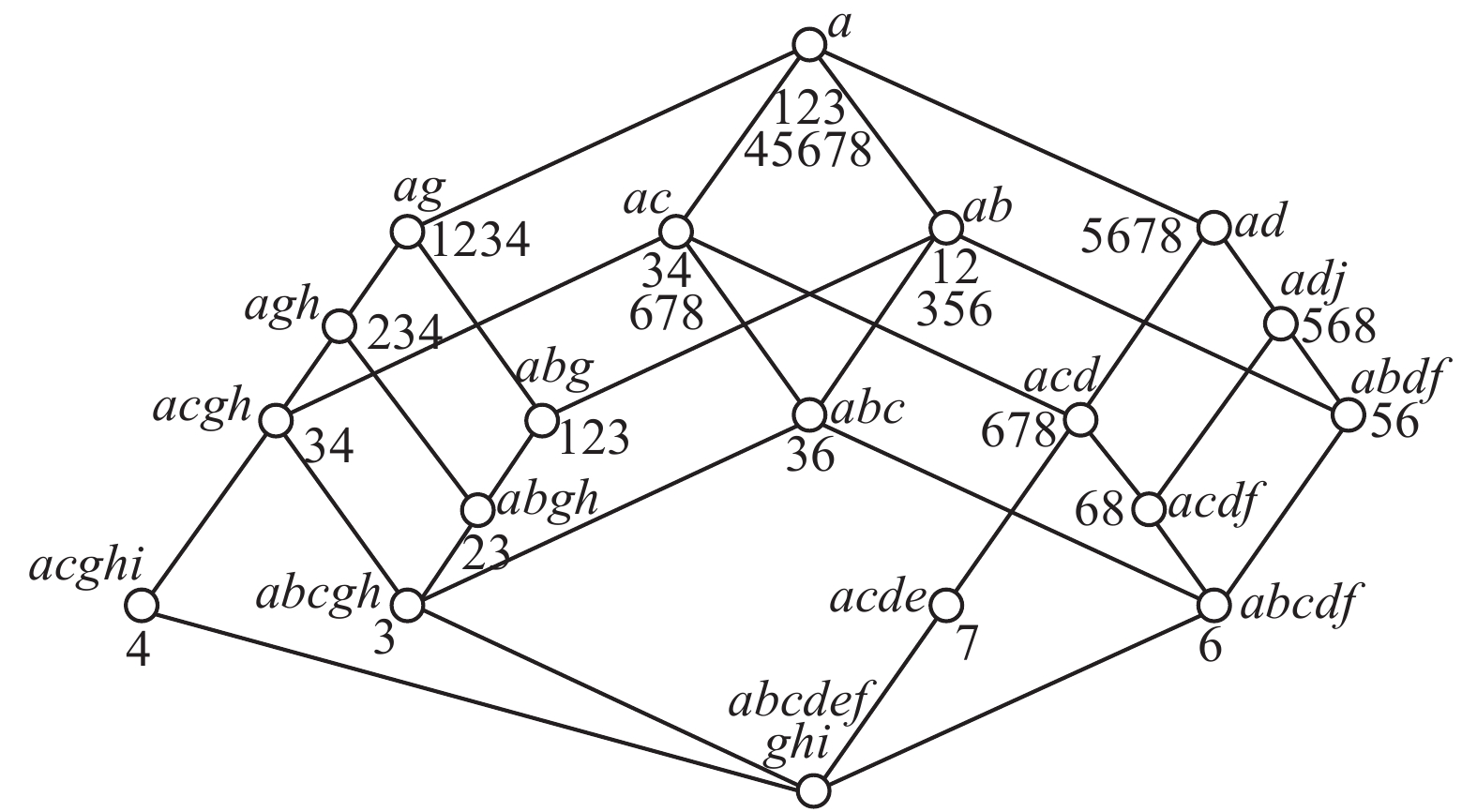

2 形式概念的生成与基本概念半格的提取1982是不平凡的一年,在这一年中同时出现了3个数学分支,公开宣称以知识和智能作为自己的数学研究对象。在这3个分支中,首先要介绍的是德国数学家R. Wille所提出的形式概念分析(normal concept analysis)[8]。在他以前,数学家们认为,任何概念的外延都是集合,而任何集合都是概念的外延。Wille明确地对后一句话说不。他提出了内涵和外延的对合性准则,认为只有满足对合性,才能把一个集合视为一个概念的外延。给定对象集

他以科教电影《生物与水》的资料制作了1张形式背景表(见表1),其中有8类生物和9种属性:

| 表 1 科教电影“生物与水”的背景 Tab.1 The background of science and education film "biology and water" |

|

Download:

|

| 图 3 “生物与水”的‘概念格’图 Fig. 3 The concept lattice of "biology and water" | |

需要强调两点:1)Wille第一次给概念下了一个严格的数学定义,强调了内涵与外延的对合性。内涵是使概念得到统一认识的语义信息,外延是检验信息传递是否符合客观实际的关口。若内涵与外延不对合,信息传递就不可能可靠地反映客观现实,信息科学的根基便会动摇,所有的信息实践活动都将缺乏根据。2)自从他的论文发表以后,计算机就开始自动生成概念,这是人工智能的一大飞跃。机器早就可以证明定理,但机器却从未生成概念。定理只能在已有的概念之间兜圈子,人的智能却能从对比中产生新的概念,为定理制造新的猜想。Wille必定明白:我们不可能也不需要使机器像人脑一样真正地感知世界,但只要机器能机械地按他的算法构建概念体系,又能保证这个体系能随时回归联通到人脑,就能帮助人类大大加速智力建设!因为,信息科学虽与脑学科紧密相连,但却有独立于人脑的特色,其中存在着用数学可以描述的规律。概念体系无需全部浸泡在感知的海洋里,它可以有间歇地脱离实际,脱离大脑,就像我们自己的知识并非每一步都要亲眼见到或经过大脑(理解)一样。关键是,只有坚持内涵与外延的对合性,机器自动生成的概念才能向人脑回归和联通。没有回归联通人脑能力的机器概念体系所具有的功效和价值为零。

Wille的工作缺陷在于:1)他的形式背景表以属性来分列,制造了列表困难,由此导致他的算法复杂。为了寻找对合的概念,从每一行或列开始搜索,再每两行或两列

在此,我们要介绍1982年由以Pawlak为代表的波兰学派所提出的粗糙集(rough sets)[9]。粗糙集明确地以数据库为研究对象,他们的学派也是KDD(数据知识发现)的倡导者。粗糙集把重点从属性值转为属性名。用属性名列表,避免了Wille的列表困难。所列的表叫作信息系统,称为关系数据库的库表。他们用数学描述知识,用内外夹逼的思想来刻画概念,提出了决策的一般模型。粗糙集是关系数据库的数学基础。

形式概念分析虽然与粗糙集同年提出,但却隐藏了十余年,后来才引起粗糙集学者们的广泛重视。Wille的严谨性触动了粗糙集作者的粗犷风格,曾在粗糙集文献中说过:划分就是知识。按此说法,任一集合与其余集就是一个划分,就是知识,就有概念,这集合就应当是某个概念的外延,这就直接违反了Wille的对合性原则。在这一点上,粗糙集是有缺点的。然而粗糙集突出了属性名,就是突出了因素,比起形式概念分析,是一个重大的进步,可惜的是,他们并没有把属性名提到因素的高度。粗糙集在人工智能的应用热点是属性约简,靠的是区分矩阵,每一个矩阵方格中放置的是一组属性名。由这个矩阵要造就一个区分函数,中间必须涉及属性名的运算,可是,粗糙集没有定义属性名的运算,把它与属性值的逻辑运算混杂在一起,出现数学描述的漏洞,所提出的算法也过于繁杂,并没有取得应用的实效。尽管存在着这些问题,粗糙集仍取得了重要的发展[10-11]。

因素空间也在1982年由笔者提出[12],早期曾用于模糊智能的研究,直到2012年才与形式概念分析及粗糙集合流。因素空间为概念生成提供了贴切的数学描述。人靠什么分男女?靠的是性别。靠什么分中外?靠的是国籍。靠什么分老少?靠的是年龄。性别、国籍和年龄都是因素。同一个人群按照不同的因素可以做出不同的划分。它们又可以综合起来形成更细的划分。因素是概念的划分器,要讲概念,必须从因素讲起。概念产生于比较,比较发现异同。但是世界上没有绝对的异,也没有绝对的同,所谓异同都是相对于一定因素而言的。因素是比较的角度和依据。风马牛不相及的东西不能进行比较,因为它们之间没有可比较的基础。因素就是比较基。若

新因素对上位概念团粒划分的贡献可以用分辨度来刻画,把

定义10[4] 设

| ${d_f} = 1 - [n\left( 1 \right)(n\left( 1 \right) - 1) + \cdots + n\left( K \right)(n\left( K \right) - 1)]/m(m - 1)$ | (8) |

叫作因素

现在让我们回到前面所说的背景关系

定义11[4] 给定定性因素空间

这个定义告诉我们,对于定性因素空间而言,原子概念的提取是不需要计算的,只要背景关系知道了,它的每一个性状颗粒就决定一个原子概念。

由原子概念用“且”字连接起来,可以生成其他的所有概念,形成布尔代数,这在计算机上就可实现概念的自动生成,理论上极其简单。自动生成的概念不是怕少而是怕多,设原子概念的个数是

定义12 内涵能表为合取范式的概念叫作基本概念。

所谓合取范式就是形如

定义13 给定因素空间和背景关系。包含所有原子概念的基本概念子半格叫作粒子半格。

通过粒子半格的建立,能在给定因素下将上位概念团粒细化到所有原子概念。在实际运用中,基本概念半格中的概念还嫌多。粒子半格中不一定有最小的半格,要找的是到达原子分割步数尽可能少的粒子半格。下面是所要求的一种基本算法,其复杂度是

基本算法1 最短粒子半格算法[13]

1) 给定U,计算每个因素对U中对象的分辨度;

2) 选对U分辨度最大的因素f来实现f对U的分类: 置换对象足码即(行足码)使同类对象连接在一起;

3) 用所分出的子类U′取代U, 重复步骤1)和2),直到所有的子类都变成粒子为止,总结出粒子半格。

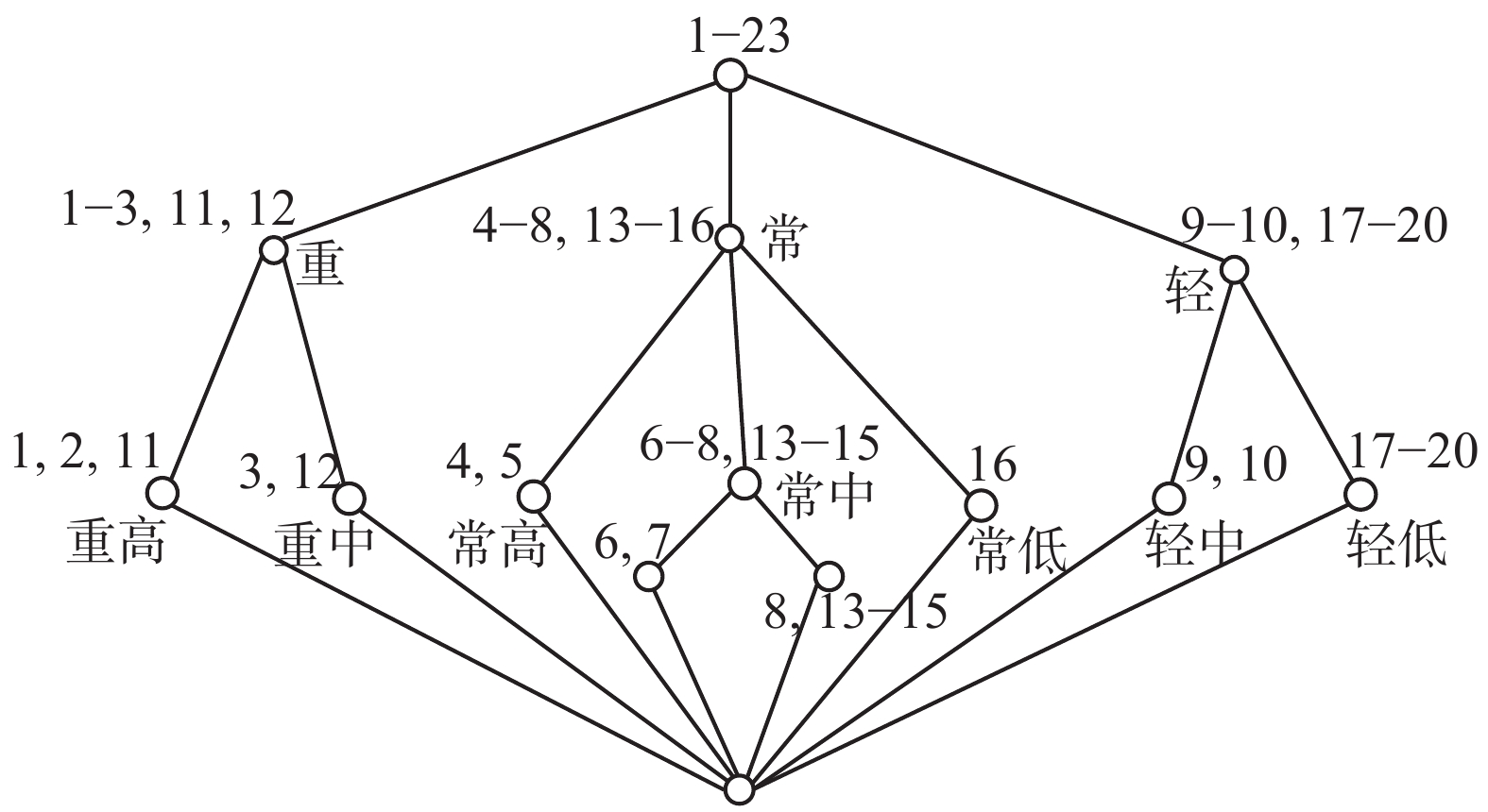

例2 给定表2:

| 表 2 成员状况因素表 Tab.2 Member status factors |

表2中由20个人组成的论域

解 将3个因素分别表示为

共有8个原子内涵,这8个原子内涵将U分成8块:

[男高重]={1, 2, 3}, [男高常]={4, 5}, [男中常]={6, 7, 8}, [男中轻]={9, 10}, [女中重]={11, 12}, [女中常]={13, 14, 15}, [女低常]={16}, [女低轻]={17, 18, 19, 20}

于是,对合性地生成8个原子概念:

由这8个原子概念任意取并,可以生成全部概念。例子说明,从背景关系提取概念代数的方法是直接方法,是自然对合的算法,是无需计算的算法。

布尔代数中的概念并不都是对合的,例如:

其内涵与外延不满足对合性,取并以后就不应该再谈对合。

共有28–9=247个非空的新概念,太多,需要寻找基本概念,这时才需要基本算法1。

1) 计算分辨度:

| $\begin{array}{c} {f_1} = {\text{性别}},\;n\left( 1 \right) = 10,\;n\left( 2 \right) = 10,\\{c_f}_1 = 1 - (10 \times 9 + 10 \times 9)/\left( {20 \times 19} \right) = \\ 1 - 180/380 = 1 - 9/19 = 10/19 \end{array}$ |

| $\begin{array}{c} {f_2} = {\text{身高}},\;n\left( 1 \right) = 5,\;n\left( 2 \right) = 10,\;n\left( 3 \right) = 5,\\{c_f}_2 = 1 - (5 \times 4 + 10 \times 9 + 5 \times 4)/\left( {20 \times 19} \right) = \\ 1 - 130/380 = 25/38 \end{array}$ |

| $\begin{array}{c} {f_3} = {\text{体重}},\;n\left( 1 \right) = 5,\;n\left( 2 \right) = 9,\;n\left( 3 \right) = 6,\\{c_f}_3 = 1 - (5 \times 4 + 9 \times 8 + 6 \times 5)/\left( {20 \times 19} \right) = \\ 1 - 112/380 = 268/380 \end{array}$ |

有

2) 按因

此时,对象已经按体重排好,得到分类:

| $\begin{array}{*{20}{c}}{U = {C_1}\left\{ {1,2,3,11,12} \right\} + {C_2}\left\{ {4,5,6,7,8,13,14,15,16} \right\}} + \\{{C_3}\left\{ {9,10,17,18,19,20} \right\}}\end{array}$ |

各类分别与内涵重、常、轻对合,得到3个基本概念

3) 再就因素

此时,

两类分别与内涵“重高”和“重中”对合,得到两个基本概念

同时,

| ${C_2} = {C_{21}}\left\{ {4,5} \right\} + {C_{22}}\left\{ {6,7,8,13,14,15} \right\} + {C_{23}}\left\{ {16} \right\}$ |

3类分别与内涵常高、常中、常低对合,得到3个基本概念

同时,C3中的对象未经置换就已经按性别排好,于是得到分类:

| ${C_3} = {C_{31}}\{ 9,10\} + {C_{32}}\{ 17,18,19,20\} $ |

各子类分别与内涵轻中、轻低对合,得到两个基本概念

4) 再就因素

5) 画出基本概念半格图(见图4)

|

Download:

|

| 图 4 成员状况粒子半格 Fig. 4 Member state particle semi-lattice | |

在此半格中共有13个基本概念,即

基本概念半格的提取,得到的原子概念是相同的,但中间的基本概念半格不是唯一的,与因素划分的先后次序有关。好的排序会加快实现原子分割,排除冗余的因素最大分辨度原则提供了一种较好的排序。这个算法强调的是对象的足码置换,就是士兵集合按营、连、排、班站队的方法. 具有大数据所要求的快捷性。

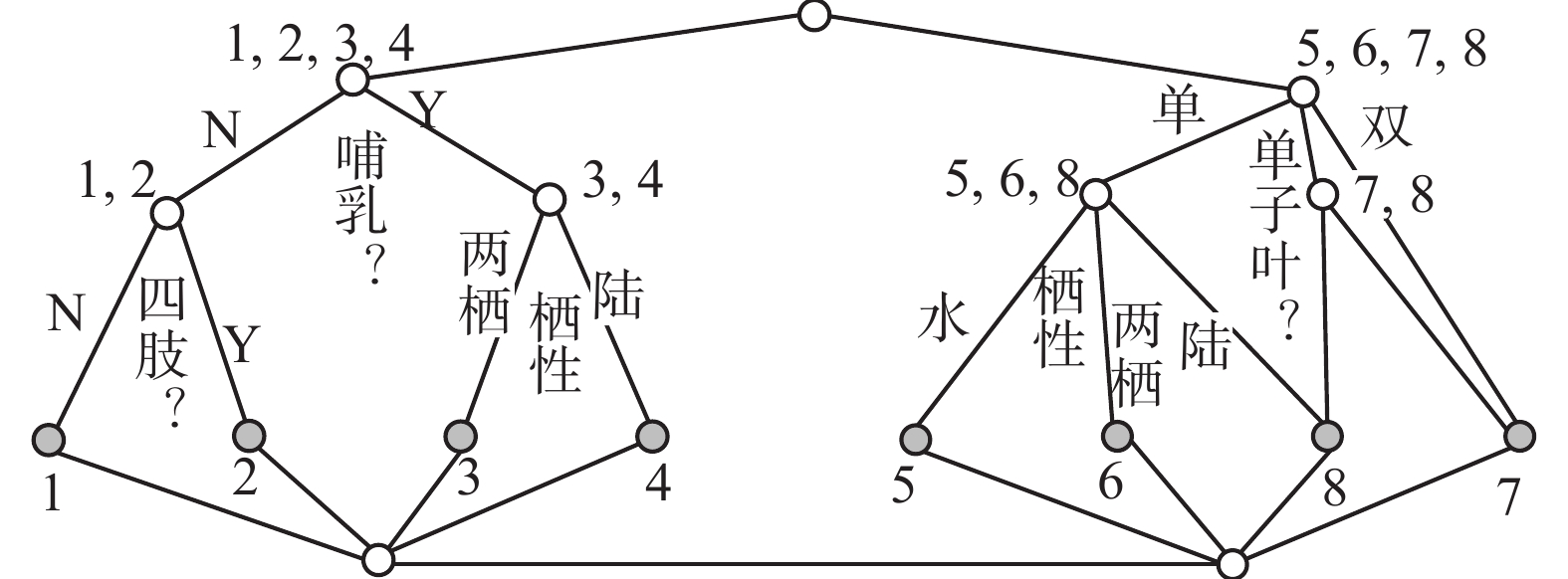

回到Wille的例子,怎样用因素空间理论来处理同样的问题呢?

首先,要将以属性值分列的表,改为以因素分列的因素表。它有9个属性,分属于7个因素:

| 表 5 将形式背景表按因素并列 Tab.5 Juxtaposition of formal background tables by factors |

蓄水性这个因素对所有对象的呈相都一样,没有变化的因素失去了存在价值,我们把这一列从表中删除。同一因素空间中所有因素必须对所有对象都有意义,因而我们必须分成两个因素空间来处理,对表5的左列进行适当变换,得到了表5的右列,就可以分开了。得到表6,表6的左右两个表,各是一个因素空间。可以有交集,如栖性在两个表中都有。

| 表 6 将形式背景表分解成两个因素性状表 Tab.6 Form background table is decomposed into two factor traits |

我们把不起变化的因素删除得到表7。

| 表 7 两个因素性状表的化简 Tab.7 Simplification of the table of two factors |

按照因素空间的概念生成理论很容易得到简捷的粒子半格(见图5)。经过适当处理,可以得到清晰的概念体系。动物因素空间生成4个原子概念:1)无肢非哺水动物(NN水,蚂蟥);2)有肢非哺水动物(YN水,鱼);3)哺肢两栖动物(YY水,蛙);4)哺肢陆动物(NN水,蚂蟥)。还生成两个非原子的基本概念:1)非哺水动物(N水,{蚂蟥,鱼});2)哺肢动物(YY,{蛙,狗})。植物因素空间生成4个原子概念:1)水单植物(水单,水草);2)两栖单植物(两单,芦苇);3)陆双子叶植物(陆双,豆);4. 陆单子叶植物(陆单,豆玉米)。还生成两个非原子的基本概念:1)单子叶植物 (单,{水草,;芦苇,玉米});2)陆植物 (陆,{豆,玉米})。例毕。

|

Download:

|

| 图 5 因素空间对生物与水的形式概念分析图 Fig. 5 Formal concept analysis for biological and water based on factors space | |

因为Wille关于科教事物的“概念格”不能直接翻译成为一张因素表,所以我们不能用因素空间的结果来和它进行直接的比较。但可以看出,概念格中缺少了几个原子概念,这是不符合实际的。其原因是,对合性与同因素的不同属性值之间的对等性有时会发生冲突。因素空间用性状颗粒来分类的方法可以避免这种冲突。

回顾一下本节的内容,Wille从内涵和外延的对合性出发,给概念下了严格的数学定义,以保障信息传递能可靠地反映现实。他大胆地谱写了计算机自动生成概念的新篇章,使机械制造的概念能随时向人脑回归与联通,这是人工智能的一大飞跃。他的形式背景表以属性来分列,导致算法复杂,无法摆脱N-hard陷阱。他说的概念格也不准确,应该改为基本概念半格。因素空间继承他的理论,把形式背景提升为因素空间的核心理论,用因素统帅属性值,用背景关系来定义原子概念,自然对合,无需计算。对于基本概念也有3次幂以下的简捷算法。

Wille不知道机制主义的人工智能理论,对形式(语法)信息、效用信息和语义全信息不加区分,他所举的例子都是语法信息。所以,本节可以视为形式信息的提取。至于如何用因素空间将形式信息与效用信息向语义信息,提升,是我们在下一节要做的事情。

3 因素之间的关联,语义信息的提升在介绍语义信息提升之前,先介绍因素之间的关联特性。

定义14 给定可测因素空间,因素

| $R = X\left( {{f_1}} \right) \times X\left( {{f_2}} \right) \times \cdots \times X\left( {{f_n}} \right)$ | (9) |

则称因素

不难证明,相互独立一定相对独立,反之不尽然。不相对独立的一组因素,它们的背景关系不能涵盖整个笛卡尔乘积空间,这说明它们的性状搭配是受到制约的,这种制约反映了它们之间是相互关联的。

定义15 若

取

对于定性因素而言,记

记

对于定性因素而言,若存在一个

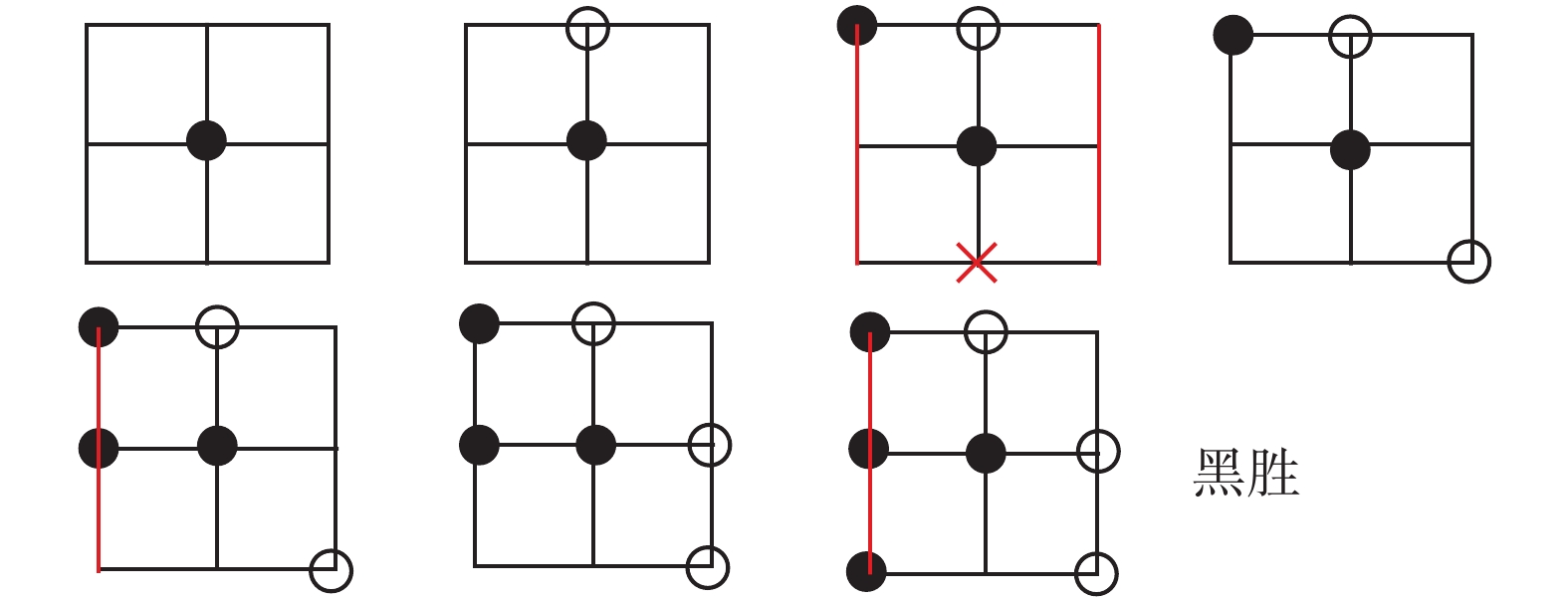

因素间互为因果,若将因素

基本定理[14]

| $\left( {E \times Y} \right) \cap R \subseteq \left( {X \times {\rm E}'} \right) \cap R$ | (10) |

注意,

这个定理证明的思路很简单,在图6中把

| $(E \times Y){ \subseteq _R}(X \times E')$ | (11) |

符号

怎样从表头为

|

Download:

|

| 图 6 背景关系决定因果 Fig. 6 Determinants of background relations | |

定义16 如果

条件因素

基本算法2 因果关联

给定以表头

1) 计算各个因素

2)选决定度最大的因素对

因果关联规则的提取,是一种有用的归纳方法,具有很高的概括性,是归纳、学习、分类、评价、预测、控制等高级思维活动的统一算法。以它为基础可以向任何领域精细化。该法与决策树的算法很相似,只是用决定度取代了信息增益。在这方面已经发表了很多关于因素空间的文章[15-19] 。

有了以上的准备,让我们来处理语义信息的提升问题。状态与效用是有紧密关联的两个或两组因素。利用这两组因素的数据可以提取从状态到效用的因果关联,得到一组因果规则作为知识储备起来,当要从形式信息推测效用信息的时候,就要利用状态效用因果关联所提供的一组规则。看看我们所面对的对象,其状态和那条规则的前件相匹配,就推断它有哪种效用。若硬匹配不行,就用相似性测度,选最贴近的一个作为推断,最后将形式信息与效用信息结合起来,得到语义信息,这就是从形式信息向语义信息的提升过程。

例3 服务对象状况到服务效用的因果关联

表8给出了用户(服务对象)的状况和服务效用之间的关联数据,把用户状况看作形式信息,把购买力看作服务效用信息,我们要来分析从形式信息到效用信息的因果关联。具体地说,要提取从用户状况来判断其购买力。表达形式信息有4个因素:f1=年龄,具有性状空间X(f1)={老,中,青};f2=职业,X(f2)={师,生,商};f3=信贷,X(f3)={好,可,差};f4=收入,X(f4)={高,平,低};效用形式的因素是g=购买力,具有性状空间X(g)={购买,不买}。

| 表 8 因果关联分析表 Tab.8 Causal association analysis table |

先看因素f1与因素g之间的因果关系。按年龄可把9个用户分成老、中、青3类,从表8中可以看到这3类分别是:[老]={1, 5, 6},[中]={2, 4, 9}, [青]={3, 7, 8}。这3类有哪一类是对购买的决定类呢?在3个老年用户中,用户1和5是不买,用户6是购买,他们的购买情况不一致,就不是对购买的决定类。再看中年用户2、4和9,他们都是购买,于是[中]就可以钻入[购买],[中]就是g的一个决定类。青年用户不是决定类。所以年龄对g的决定度是3/9。

类似地,对因素职业来说,[师]={1, 2, 9}, [生]={3, 7, 8},[商]={4, 5, 6},他们都不是决定类f2对g的决定度=0;对因素还贷来说,[好]={2, 6, 9},[可]={3, 4, 5}, [差]={1, 7, 8},还贷好的用户类[好]钻入[购买],还贷差的用户类[差]钻入[不买],都是决定类,f3对g的决定度是 6/9;对因素收入来说,只有收入高的用户类[高]是决定类,f4对g的决定度是2/9。

选取决定度最高的因素“信贷”,它有两个决定类,由这两个决定类的钻入情况分别得到两个因果推理句:

因果规则1:信贷好购买。

因果规则2:信贷差不买。

从论域中删除这两个决定类,得到新的论域,取U′=[可]={3,4,5},得表9。

按表9重新计算各个因素对g的决定度。取决定度最大的因素f1,它有3个决定类:[老]={5},[中]={4},[青]={3},分别写成下列推理句:

因果规则3:信贷可且年龄不老→购买。

因果规则4:信贷可且年龄老→不买。

因果规则5:信贷可且年龄青→购买。

删除表中的用户3、4和5,表9被删空,因果规则提取完毕。最后共得到五条因果规则。面对一个新用户,只需先查他的信贷状况,再补充考虑其年龄,就可以判断其购买倾向。例毕。

因果规则的可靠性依赖于样本的大小和准确性,还要随时间场合的变化而不断调整。

本节介绍了因素空间如何将形式信息与效用信息关联起来,提升为全面的语义信息。以上两节为机制主义人工智能的信息转化第一定律提供了有用的数学理论。

4 用因素空间下九宫棋在实现信息向知识的转化中,需要有更好的搜索工具。因素是启发指引搜索的关键词。本节将介绍如何用因素思维实现目标因素与场景因素的对接和搜索,为信息转化的第二定律从数学上作一点探索性的思考。传统人工智能教科书上以九宫棋来讲述搜索策略,为了说明思想,本节特以九宫棋为例来进行阐述。要想使用因素空间理论进行信息的智能化处理,先要在思维上习惯于因素分析。随时随处都要问:“我思考的目标是什么?我面临的对象是什么?要使二者合笼,最为关键的因素是什么?”下面以下九宫棋为例来说明这个问题。

1) 确立目标,选定目标因素

智能是一个目标驱动的活动,下棋也是这样,在任何比赛中,棋手的目标是赢得比赛。获胜是棋手的目标因素。

2) 注意对象,确定对象因素

目标因素的实现离不开对象描述。九宫棋的对象描述依赖于两个对象因素:棋盘和游戏规则。

棋盘。九宫棋的棋盘是由3条横线和3条竖线绘制的9点阵。在人工智能书中,也被描述成3行3列的九宫格。

游戏规则。分别由执黑白两色棋子的棋手交替放子于棋盘未被占用的格子点上,黑子先手。如果一方在1条线(水平、垂直或对角线)上连接放上了3个棋子,该方就赢;如果在棋盘的所有格点都被占用时仍没有赢家,那就成和棋。这两种结局都叫作下完了一盘棋。

一盘棋在下完第t步棋时,黑白子在棋盘上的分布状态可以描述为一个3×3的矩阵

3) 目标因素与对象因素的对接

因素空间在哪里?因素空间在目标因素与对象因素对接的过程中出现。设

有了因素空间,就可以应用因素空间的理论。将

| 表 10 一字棋的因果关联分析表 Tab.10 A causal link analysis table for Chinese characters |

应用因素空间的因果分析算法2,可以从表10中提取因果规则:如果

4) 精细化与棋谱

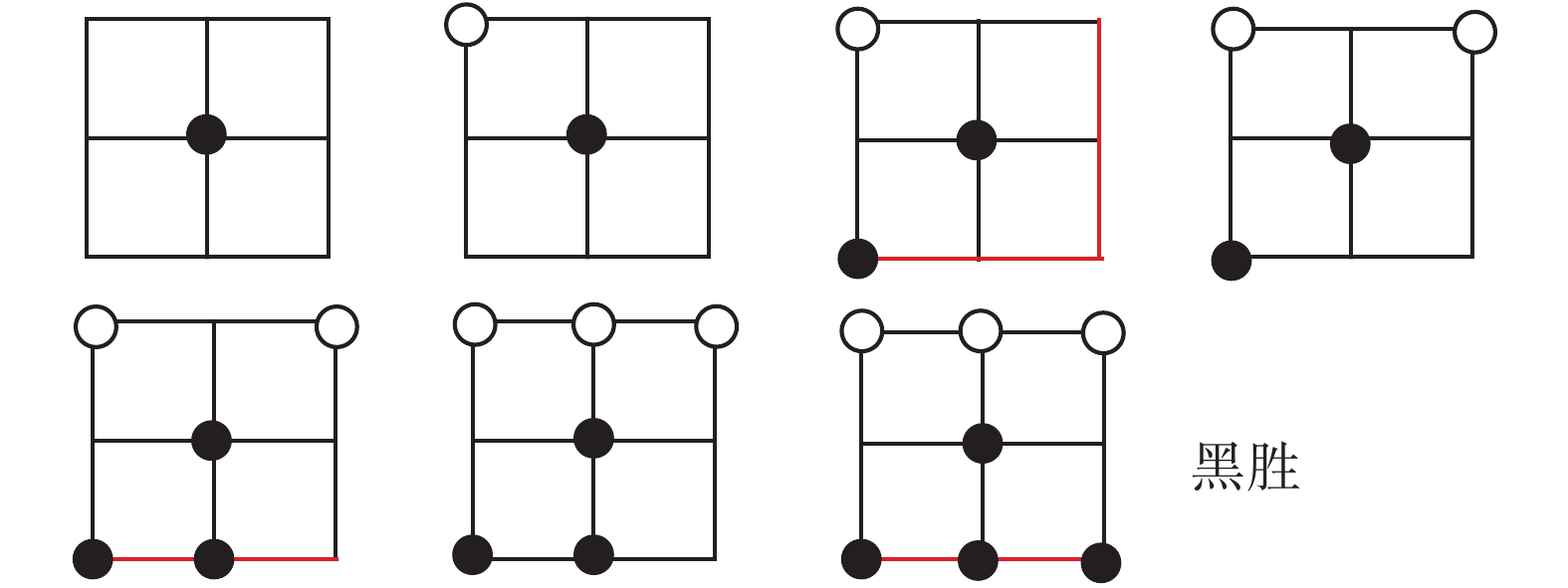

为了使这一规则更加确切,需要分析黑棋不能取胜的原因。要区分情况就要增加因素。当黑子占中心点以后,再下一子,无论下在何处,必与中心相连而构成一字的胜利威胁。此时白子必在对称点上堵截。黑子求胜必须在被围堵的情况下形成一字?在图1的第三局势中,画了两条一字线,只要第二枚黑子下在这两条红线(但不包括右下角)上,黑棋就能取胜,否则下和。这就形成一个棋谱(见图7)。

|

Download:

|

| 图 7 棋谱1的图示 Fig. 7 Chess 1 Icon | |

在这个棋谱中有一个关键词,就是希望线。

定义17 当

棋谱1 若取

如果白棋堵在边上,在图2的第3局势中,画了两条一字线,第2黑子下在这两条红线的任何一条上,黑棋就能取胜,否则下和。这就形成一个棋谱(见图8)。

|

Download:

|

| 图 8 棋谱2的图示 Fig. 8 Chess 2 Icon | |

定义18 当

棋谱2 若取

当黑棋失误被白棋抢占了中心以后,白棋取胜的细节可以进一步引进新的因素

早在20世纪60年代,笔者参与了在我国高校设立概率论课程的工作。在那时,笔者就用因素空间来处理柯尔莫戈洛夫所提出的概率基本空间[20]。一枚硬币在一次投掷中可能出现两个基本事件,得到基本空间

不充分的条件也是条件,它虽不能决定结果但却能制约结果的发生频率,体现这种内在必然性联系的就是概率,概率是广义的因果律。概率论是一种广义的因果论,这就注定了概率统计会在人工智能中占有重要的地位,我们现在能对概率论有这样一种较为深刻的认识,是因为有了因素空间。

用因素空间来构造基本空间,可以实现决定性向随机性的逼进。概率论不仅要研究概率的逻辑规律,更应实现随机性向确定性的转化。虽然,大数定律和贝叶斯概率都体现这种转化,但还有很大的发展空间。笔者所提的构架是,将基本空间的因素分为两个部分,可观察、可控的因素算第1部分,这部分因素所导引的变量是非随机变量,余下的因素算第2部分,统归为一个余因素[12] ,它所引导的变量是随机性的。从中挑选出少数几个特别突出的因素作为精细处理的对象,剩下那些影响微弱且相互独立的众多因素,都归顺于中心极限定理。这样一来,随机变量的一般分解式为

| $\xi = f\left( x \right) + {f^ \wedge}\left( x \right) + \delta $ | (12) |

式中:

1965年,Zadeh教授提出了模糊集合论[21],这是人工智能在数学上取得突破的重要历史进展。他把模糊集定义成从论域

模糊数学与概率论都需要因素空间的理论,借用因素空间可以探讨随机性与模糊性这两种不确定性之间的联系与区别。在随机试验中,事件

2012年以后,笔者将因素空间的研究重点转向数据智能化的数学理论,与形式概念分析及粗糙集结缘。现有的关系数据库所面临的大数据的挑战是因素空间所要迎头解决的首要问题。因素空间对形式信息的处理对象囊括了非结构化数据。以因素空间为基础的机制主义人工智能是数据智能化的灵魂,它不俯首听命于大数据的摆布,而是要设计、制造、运用和培育数据,用数据来营造信息生态和知识生态,建立信息、知识与神经结构的同构体。它要改变当今世界人工智能自下而上的手工式格局,代之以自上而下与自下而上相结合的发展理念。有许多文章可以参考[25-50],尽管作者们在写作的时候还没有形成自己思维的大局。

6 结束语因素是信息描述的关键词,因素空间是描写事物和信息的普适性框架,它把数据变成可视的样本点,形成背景分布的母体,据以自动概念生成和因果规则,由此可以产生学习、预测、评价和决策控制等一系列的数学操作。因素空间能将形式信息与效用信息关联起来,提升为全面的语义信息,为机制主义人工智能的信息转化第一定律提供了坚实的数学理论。用因素思维实现目标因素与场景因素的对接和搜索,可为信息转化的第二定律提供手段。以因素空间为基础的机制主义人工智能是数据智能化的灵魂,它将要设计、制造、运用和培育数据,用数据来营造信息生态和知识生态,建立信息、知识与神经结构的同构体。总之,因素空间的发展前景巨大,对信息科学和人工智能的发展有重要作用。

| [1] |

钟义信. 高等人工智能原理: 观念•方法•模型•理论[M]. 北京: 科学出版社, 2014.

( 0) 0)

|

| [2] |

钟义信. 信息科学与技术导论[M]. 3版. 北京: 北京邮电大学出版社, 2015.

( 0) 0)

|

| [3] |

何华灿. 泛逻辑学原理[M]. 北京: 科学出版社, 2001. HE Huacan. Universal logics principle[M]. Beijing: Science Press, 2001. (  0) 0)

|

| [4] |

WANG Peizhuang, HE Ouyan, ZHONG Yixin, et al. Cognition math based on factor space[J]. Annals of data science, 2016, 3(3): 281-303. DOI:10.1007/s40745-016-0084-x ( 0) 0)

|

| [5] |

汪培庄, 李洪兴. 知识表示的数学理论[M]. 天津: 天津科学技术出版社, 1994.

( 0) 0)

|

| [6] |

刘增良. 因素神经网络理论[M]. 北京: 北师大出版社, 1990.

( 0) 0)

|

| [7] |

HUANG Chongfu. Principle of internet of intelligences and development of its core technology[J]. Journal of risk analysis and crisis response, 2017, 7(3): 146-155. DOI:10.2991/jrarc.2017.7.3.5 ( 0) 0)

|

| [8] |

WILLE R. Restructuring lattice theory: an approach based on hierarchies of concepts[M]//RIVAL I. Ordered Set. Dordrecht: Springer, 1982: 445–470.

( 0) 0)

|

| [9] |

PAWLAK Z. Rough sets[J]. International journal of computer and information sciences, 1982, 11(5): 341-356. DOI:10.1007/BF01001956 ( 0) 0)

|

| [10] |

WANG Guoyin, WANG Yan. 3DM: domain-oriented data-driven data mining[J]. Foundamenta informaticae, 2009, 90(4): 395-426. ( 0) 0)

|

| [11] |

LIANG Jiye, BAI Liang, DANG Chuangyin, et al. The k-means-type algorithms versus imbalanced data distributions[J]. IEEE transactions on fuzzy systems, 2012, 20(4): 728-745. DOI:10.1109/TFUZZ.2011.2182354 ( 0) 0)

|

| [12] |

汪培庄, SUGENOM. 因素场与Fuzzy集的背景结构[J]. 模糊数学, 1982(2): 45-54. ( 0) 0)

|

| [13] |

汪培庄. 因素空间与因素库[J]. 辽宁工程技术大学学报: 自然科学版, 2013, 32(10): 1297-1304. WANG Peizhuang. Factor spaces and factor data-bases[J]. Journal of Liaoning technical university: natural science, 2013, 32(10): 1297-1304. (  0) 0)

|

| [14] |

WANG Peizhen. Rules detecting and rules-data mutual enhancement based on factors space theory[J]. International journal of information technology and decision making, 2002, 1(1): 73-90. DOI:10.1142/S0219622002000087 ( 0) 0)

|

| [15] |

汪培庄, 郭嗣琮, 包研科, 等. 因素空间中的因素分析法[J]. 辽宁工程技术大学学报: 自然科学版, 2014, 33(7): 865-870. WANG Peizhuang, GUO Sicong, BAO Yanke, et al. Causality analysis in factor spaces[J]. Journal of Liaoning technical university: natural science edition, 2014, 33(7): 865-870. (  0) 0)

|

| [16] |

刘海涛, 郭嗣琮. 因素分析法的推理模型[J]. 辽宁工程技术大学学报: 自然科学版, 2015, 34(1): 124-128. LIU Haitao, GUO Sicong. Reasoning model of causality analysis[J]. Journal of Liaoning technical university: natural science, 2015, 34(1): 124-128. (  0) 0)

|

| [17] |

曲国华, 李春华, 张强. 因素空间属性简约的区分函数[J]. 智能系统学报, 2017, 12(6): 890-894. QU Guohua, LI Chunhua, ZHANG Qiang. The differential function for attributes reduction in factors SPACE[J]. Journal of intelligent systems, 2017, 12(6): 890-894. (  0) 0)

|

| [18] |

包研科, 茹慧英, 金圣军. 因素空间中知识挖掘的一种新算法[J]. 辽宁工程技术大学学报: 自然科学版, 2014, 33(8): 1141-1144. BAO Yanke, RU Huiying, JIN Shengjun. A new algorithm of knowledge mining in factor space[J]. Journal of Liaoning technical university: natural science, 2014, 33(8): 1141-1144. (  0) 0)

|

| [19] |

曾繁慧, 郑莉. 因素分析法的样本培育[J]. 辽宁工程技术大学学报: 自然科学版, 2017, 36(3): 320-323. ZENG Fanhui, ZHENG Li. Sample cultivation in factorial analysis[J]. Journal of Liaoning technical university: natural science, 2017, 36(3): 320-323. (  0) 0)

|

| [20] |

汪培庄. 随机过程[M]//郝柏林, 于渌, 孙鑫, 等. 统计物理学进展. 北京: 科学出版社, 1981.

( 0) 0)

|

| [21] |

ZADEH L A. Fuzzy sets[J]. Information and control, 1965, 8(3): 338-357. DOI:10.1016/S0019-9958(65)90241-X ( 0) 0)

|

| [22] |

汪培庄. 模糊集与随机集落影[M]. 北京: 北京师范大学出版社, 1985.

( 0) 0)

|

| [23] |

唐旬. 国内首台模糊推理机分立元件样机研制成功[N]. 光明日报, 1988-05-07. TANG Xun. The first prototype of a fuzzy inference machine in China was successfully developed by[N]. Guangming Daily, 1988-05-07. (  0) 0)

|

| [24] |

汪培庄, 李洪兴. 模糊系统理论与模糊计算机[M]. 北京: 科学出版社, 1995.

( 0) 0)

|

| [25] |

欧阳合. 不确定性理论的统一理论: 因素空间的数学基础(特约报告)[C]//东方思维与模糊逻辑—纪念模糊集诞生五十周年国际会议. 中国, 大连, 2015. OUYANG He, The unified theory of uncertainty theory: the mathematical foundation of factor space (special report)[C]//Oriental Thinking and Fuzzy Logic-the 50th Anniversary International Conference to Commemorate the Birth of Fuzzy Sets. Dalian, China, 2015. (  0) 0)

|

| [26] |

冯嘉礼. 思维与智能科学中的性质论方法[M]. 北京: 原子能出版社, 1990.

( 0) 0)

|

| [27] |

YUAN Xuehai, WANG Peizhuang, LEE F S. Factor space and its algebraic representation theory[J]. Journal of mathematical analysis and applications, 1992, 171(1): 256-276. DOI:10.1016/0022-247X(92)90388-T ( 0) 0)

|

| [28] |

袁学海, 汪培庄. 因素空间和范畴[J]. 模糊系统与数学, 1995, 9(2): 25-33. YUAN Xuehai, WANG Peizhuang. Factor spaces and categories[J]. Fuzzy systems and mathematics, 1995, 9(2): 25-33. (  0) 0)

|

| [29] |

PENG X T, KANDEL A, WANG P Z. Concepts, rules, and fuzzy reasoning: a factor space approach[J]. IEEE transactions on systems, man, and cybernetics, 1991, 21(1): 194-205. DOI:10.1109/21.101149 ( 0) 0)

|

| [30] |

WANG P Z. A factor spaces approach to knowledge representation[J]. Fuzzy sets and systems, 1990, 36(1): 113-124. DOI:10.1016/0165-0114(90)90085-K ( 0) 0)

|

| [31] |

汪培庄. 因素空间与概念描述[J]. 软件学报, 1992, 3(1): 30-40. WANG Peizhuang. Factor space and description of concepts[J]. Journal of software, 1992, 3(1): 30-40. (  0) 0)

|

| [32] |

WANG P Z, LOE K F. Between mind and computer: fuzzy science and engineering[M]//Singapore: World scientific Publishing, 1994.

( 0) 0)

|

| [33] |

WANG Peizhuang, LIU Zeng-liang, SHI Yong, et al. Factor space, the theoretical base of data science[J]. Annals of data science, 2014, 1(2): 233-251. DOI:10.1007/s40745-014-0017-5 ( 0) 0)

|

| [34] |

金智新. 安全结构理论[M]. 北京: 科学出版社, 2012.

( 0) 0)

|

| [35] |

CHENG Q F, WANG T T, GUO S C, et al. The logistic regression from the viewpoint of the factor space theory[J]. International journal of computers communications and control, 2017, 12(4): 492-502. DOI:10.15837/ijccc.2017.4 ( 0) 0)

|

| [36] |

YU Fusheng, HUANG Chongfu. Building intelligent information systems in factors space[J]. 2002.

( 0) 0)

|

| [37] |

ZENG Wenyi, FENG Shuang. An improved comprehensive evaluation model and its application[J]. International journal of computational intelligence systems, 2014, 7(4): 706-714. DOI:10.1080/18756891.2013.857151 ( 0) 0)

|

| [38] |

李德清, 冯艳宾, 王加银, 等. 两类均衡函数的结构分析与一类状态变权向量的构造[J]. 北京师范大学学报: 自然科学版, 2003, 39(5): 595-600. LI Deqing, FENG Yanbin, WANG Jiayin, et al. Structure analysis of two classes of balance functions and construction of a family of state variable weight vectors[J]. Journal of Beijing normal university: natural science, 2003, 39(5): 595-600. (  0) 0)

|

| [39] |

李德清, 李洪兴. 变权决策中变权效果分析与状态变权向量的确定[J]. 控制与决策, 2004, 19(11): 1241-1245. LI Deqing, LI Hongxing. Analysis of variable weights effect and selection of appropriate state variable weights vector in decision making[J]. Control and decision, 2004, 19(11): 1241-1245. DOI:10.3321/j.issn:1001-0920.2004.11.009 (  0) 0)

|

| [40] |

李德清, 崔红梅, 李洪兴. 基于层次变权的多因素决策[J]. 系统工程学报, 2004, 19(3): 258-263. LI Deqing, CUI Hongmei, LI Hongxing. Multifactor decision making based on hierarchical variable weights[J]. Journal of systems engineering, 2004, 19(3): 258-263. (  0) 0)

|

| [41] |

LI Deqing, ZENG Wenyi, LI Junhong. New distance and similarity measures on hesitant fuzzy sets and their applications in multiple criteria decision making[J]. Engineering applications of artificial intelligence, 2015, 40: 11-16. DOI:10.1016/j.engappai.2014.12.012 ( 0) 0)

|

| [42] |

余高锋, 刘文奇, 李登峰. 基于折衷型变权向量的直觉语言决策方法[J]. 控制与决策, 2015, 30(12): 2233-2240. YU Gaofeng, LIU Wenqi, LI Dengfeng. Compromise type variable weight vector based method Intuitionistic linguistic making decision[J]. Control and decision, 2015, 30(12): 2233-2240. (  0) 0)

|

| [43] |

余高锋, 刘文奇, 石梦婷. 基于局部变权模型的企业质量信用评估[J]. 管理科学学报, 2015, 18(2): 85-94. YU Gaofeng, LIU Wenqi, SHI Mengting. Credit evaluation of enterprise quality based on local variable weight model[J]. Journal of management sciences in China, 2015, 18(2): 85-94. (  0) 0)

|

| [44] |

岳磊, 孙永刚, 史海波, 等. 基于因素空间的规则调度决策模型[J]. 信息与控制, 2010, 39(3): 302-307. YUE Lei, SUN Yonggang, SHI Haibo, et al. Rule-based scheduling decision-making model based on factor spaces[J]. Information and control, 2010, 39(3): 302-307. (  0) 0)

|

| [45] |

何清, 童占梅. 基于因素空间和模糊聚类的概念形成方法[J]. 系统工程理论与实践, 1999, 19(8): 99-104. HE Qing, TONG Zhanmei. The concept formation method based on factor spaces and fuzzy clustering[J]. System engineering-theory & practice, 1999, 19(8): 99-104. (  0) 0)

|

| [46] |

米洪海, 闫广霞, 于新凯, 等. 基于因素空间的多层诊断识别问题的数学模型[J]. 河北工业大学学报, 2003, 32(2): 77-80. MI Honghai, YAN Guangxia, YU Xinkai, et al. The mathematical model of multi-layer diagnosis-type recognition problem[J]. Journal of Hebei university of technology, 2003, 32(2): 77-80. (  0) 0)

|

| [47] |

何平. 犯罪空间分析与治安系统优化[M]. 北京: 中国书籍出版社, 2013.

( 0) 0)

|

| [48] |

崔铁军, 马云东. 连续型空间故障树中因素重要度分布的定义与认知[J]. 中国安全科学学报, 2015, 25(3): 23-28. CUI Tiejun, MA Yundong. Definition and cognition of factor important degree distribution in continuous space fault tree[J]. China safety science journal, 2015, 25(3): 23-28. (  0) 0)

|

| [49] |

崔铁军, 马云东. 因素空间的属性圆定义及其在对象分类中的应用[J]. 计算机工程与科学, 2015, 37(11): 2169-2174. CUI Tiejun, MA Yundong. Definition of attribute circle in factor space and its application in object classification[J]. Computer engineering and science, 2015, 37(11): 2169-2174. DOI:10.3969/j.issn.1007-130X.2015.11.026 (  0) 0)

|

| [50] |

崔铁军, 马云东. 基于因素空间的煤矿安全情况区分方法的研究[J]. 系统工程理论与实践, 2015, 35(11): 2891-2897. CUI Tiejun, MA Yundong. Research on the classification method about coal mine safety situation based on the factor space[J]. Systems engineering-theory and practice, 2015, 35(11): 2891-2897. DOI:10.12011/1000-6788(2015)11-2891 (  0) 0)

|

2018, Vol. 13

2018, Vol. 13