经典物质科学的研究形成了一套完整的科学观和方法论,即以“物质”为基本研究对象的机械唯物科学观和以“分而治之”为特征的机械还原方法论。在整个近代科学研究历程中,这种科学观和方法论获得了极其普遍的成功应用,使近代科学的研究领域越分越细致、研究越来越深入,促成了近代科学的大发展与大繁荣。

20世纪中叶以来,信息科学(智能科学是它的核心、前沿和制高点)在世界范围内迅猛崛起,成为信息时代的标志性学科[1]。

信息对象与物质对象既有联系又有原则性的不同,因此信息科学应当遵循信息科学的科学观和方法论进行研究。但是由于意识通常落后于存在,方法论通常落后于实际研究的需要,而且研究信息科学的人员都是在机械唯物科学观和机械还原方法论熏陶下成长起来的,因此,面对人工智能这类开放的复杂信息系统研究的时候,人们自然就按照“分而治之”的方法论思想来处理:把复杂的智能系统分解为“结构、功能、行为”3个侧面,展开结构模拟(人工神经网络)[2-7]、功能模拟(物理符号系统)[8-17]和行为模拟(感知动作系统)[18-20]的研究,形成了人工智能研究的三大途径和流派。

经过数十年的研究与发展,人工智能研究的3种途径各自都取得了不少意义重大的进展,产生了一批阶段性的重要成果。但是与此同时,人工智能的研究也面临着十分严峻的挑战:虽然3种研究途径的目标都是探讨智能的人工实现,然而,它们之间却互不认可[18, 21-22],坚持各自为战,未能形成研究的合力,妨碍了人工智能统一理论和通用方法的形成;而且,三者都严重忽视了智能的重要基础——信息、意识和情感的研究。可见,人工智能的研究虽然取得了不少耀眼的成果,但整体上并未真正成熟。

面对这种情况,一批有识之士积极推动人工智能研究的改革,试图建立人工智能的统一理论。其中最有代表性的是Russell 、Norvig和Nilsson等人的工作。Russell和Norvig[23]于1995年出版了篇幅超过1 000页的长篇巨著Artificial intelligence: a modern approach,Nilsson[24]也在1998年出版了新著Artificial intelligence: a new synthesis。前者试图提出新的研究途径(modern approach)来实现3种人工智能理论的统一,后者希望利用新的集成方法(new synthesis)来建立人工智能的统一理论。遗憾的是,他们只是把3种人工智能的研究成果直接地“拼接”在Agent的身上,而没有找到实现统一的理论路径。

因此,创建“结构–功能–行为”和谐融通、“意识–情感–理智”三位一体的通用人工智能理论,是一个尚未完成而又必须完成的重大研究任务。这是一个内涵深刻、意义深远,需要从源头出发而且贯通全程的巨大的创新研究任务。

1 通用人工智能理论的创新研究思路面对一个熟悉而具体的研究课题,人们通常可以采取“轻车熟路,依规而行”的惯常做法。但是,面对一项创新性极强的研究课题,这种做法就不再可行了。在这种情况下,人们必须研究和发展一套正确清晰而且系统完整的创新研究纲领。

鉴于当前人工智能研究存在的主要问题是:1)在研究广度上碎片化;2)在研究深度上浅层化;3)在研究体系上封闭化。所有这些问题共同的根源是“分而治之”机械还原方法论,后者是机械唯物科学观在宏观研究方法上的反映。因此,人工智能理论的创新研究无法回避科学观和方法论的问题,需要采取表1所示的“顶天立地”的研究纲领。

| 表 1 研究纲领 Tab.1 The research programs |

智能(无论是人类智能还是人工智能)是一个极其深刻的研究对象,触及人类思维能力的深层奥秘;人的大脑是一类堪称“小宇宙”的系统,很少有能够与之比肩的复杂对象。这样一种十分深刻异常复杂的研究,必须从科学观和方法论这个研究的源头和驾驭全局的龙头展开深入研究。只有高屋建瓴,才能势如破竹,而且一览无余[25]。

另一方面,人工智能研究之所以形成“三方割据”的碎片化、浅层化和封闭化的格局,根本的原因也正是因为人们遵循了“分而治之”所体现的机械唯物科学观和机械还原方法论。因此,为了有效变革人工智能理论研究的现状,就必须从反思人工智能研究的“科学观和方法论”这个科学研究的“源头”和“龙头”做起,才有成功的可能。

1.2 在中层,创新“研究模型和研究途径”:洞察通用人工智能的全局和进路正确的科学观可以启迪正确的方法论,有了正确的科学观和方法论的导引,就可以确保研究工作的大方向不会发生重大偏差。但是,要想真正获得创新研究的重要成果,还必须认真考问:原有人工智能研究所采用的基本模型和基本路径是否合理,是否需要做出必要而充分的变革?

这是因为,“研究模型”就是“总体蓝图”,代表了研究者对于研究对象性质和各种关系的全面认识,而“研究路径”则是研究工作的“总体方向和路线”,表达了研究者对于解决问题所要采取的方法路径的理解。因此,研究模型与研究途径的正确与否,将在很大程度上决定研究工作是否真的能够获得意义重大的结果。

我们看到,现有人工智能理论研究的研究模型基本局限于脑模型,研究途径主要围绕大脑的物质结构和功能展开,从而忽视了源头信息的理解和利用,导致诸多盲区和误解。智能的生成是一个复杂的生态演化过程[26],必须在信息生态方法论指导下构建人工智能研究的研究模型,选择科学合理的研究途径,避免“一叶障目,不见泰山”的局限。

1.3 在底层,创新“基本概念和基本原理”:重构人工智能理论的基础和体系同其他领域的研究一样,人工智能理论的研究必须落实到“基本概念和基本原理”上面。因此,在把握了正确的科学观和方法论,又廓清了研究对象的基本模型和基本路径之后,进一步的研究事项就是要认真叩问:原有人工智能研究所建立的基本概念和基本原理是否准确和完备,是否需要进行重大的革新和重建?

不难预料,在新的科学观和方法论的导引之下,研究的基本模型发生了显著的变化,而且研究的路径也发生了重大的改变,那么,人工智能理论研究的原有概念体系和原理体系肯定不能适应新的需要。因此,深化和重构人工智能理论研究所必需的基本概念就成为不可避免的工作,相应的基本原理也因而必须重新探讨和建构。事实上,现有人工智能理论的信息、知识、智能等基础概念都存在严重的表面性和局限性[1, 25];不仅如此,基础意识、情感、理智及其综合决策等基础概念和人工智能系统各个分系统之间相互转换的原理基本没有得到应有的关注[27]。

总之,从研究的源头(科学观和方法论)出发,到研究的全局展开(研究模型和研究路径),再到研究结果的扎实落地(基本概念和基本原理),进行全方位的反思、突破、发现和创新,逐层递进,重新构筑“通用人工智能”的基本理论。这就是本文的研究纲领。

本文将循着这个纲领,叙述通用人工智能理论研究所取得的重要进展。

2 顶层研究:创新科学观和方法论科学观要回答的基本问题是:科学研究的对象是什么?这种研究对象的宏观性质是什么?在此基础上,方法论要回答的基本问题是:按照科学观的宏观理解,研究这类对象的宏观思路和原则方法是什么?可见,科学研究的科学观和方法论确实是科学研究的源头和驾驭科学研究全局的龙头。

显然,不同的研究对象需要运用不同的科学观来理解,因而也需要运用不同的方法论来处置。

迄今,主要存在两类不同(虽然互有联系)的研究对象:物质对象和信息对象。与此相应,也存在两种不同的科学观和方法论:经典物质科学的科学观和方法论,信息科学的科学观和方法论。

经典物质科学的科学观认为:它所研究的具体对象是有限时空中的物质,这种物质对象是客观的存在,不因主观意志而改变。经典物质科学的方法论认为:对于复杂的物质对象,可以通过“分而治之”的方法来研究。这就是机械还原方法论。

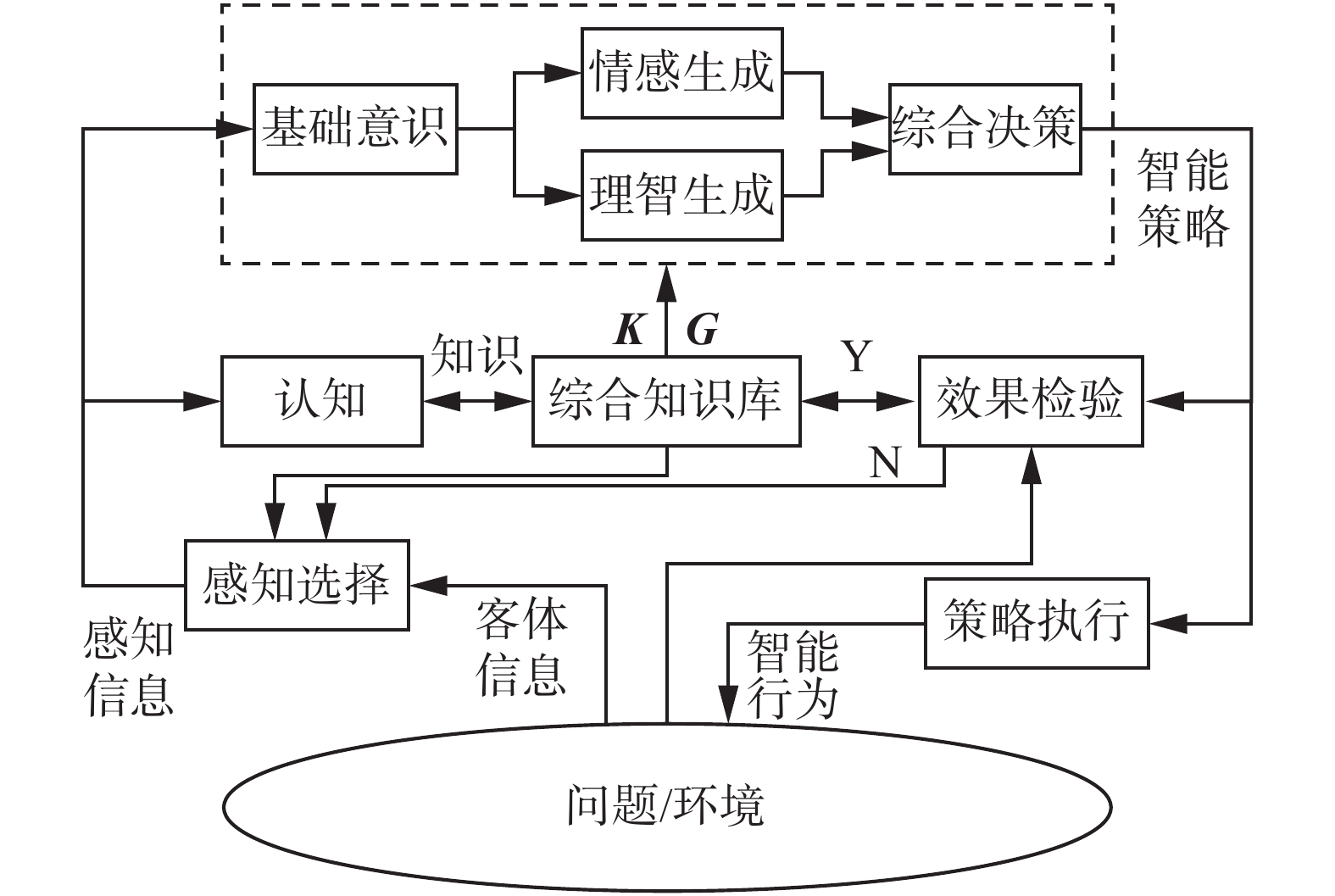

智能,是(生物,特别是人类)主体认识环境(认识世界)与改造环境(改造世界)的过程中所表现出来的高级能力。这个过程的宏观表现是:首先,环境中的客体信息作用于主体;然后,主体凭借自己的目的与知识产生智能行为反作用于客体。这种作用与反作用的过程也许要进行多个回合,如图1的模型所示。

|

Download:

|

| 图 1 智能的抽象模型 Fig. 1 Abstract model of intelligence | |

根据图1所表示的抽象模型,人们就可以更具体地说:智能,乃是主体在与环境客体相互作用的过程中,为了成功应对自己所面临的生存与发展的挑战而对客体信息进行深度加工演化从而生成智能行为的能力。因此,智能是在主体目的和知识的制约下由客体信息激发生长起来的,是信息生态演进过程的高级产物[26-27]。

有鉴于此,现代信息科学的科学观认为:它的研究对象是信息,信息对象也是一类存在,能够在主体与客体相互作用的过程中逐渐生长演化成为有用的智能(表现为智能策略和智能行为)。于是,现代信息科学的方法论认为:信息(智能是信息的高级产物)研究,需要特别关注它的生长演化过程,研究各个生长环节之间的相互关系、信息生长系统与环境之间的相互关系,以保障信息能够生长成为智能。我们把这个科学研究方法论命名为“信息生态方法论”。

表2给出了两种科学观和方法论的简明对照。

| 表 2 两类科学的科学观与方法论对比 Tab.2 Comparison of the scientific view and methodology between the two kinds of science |

从表2的对比可以看出,两类科学观和方法论的作用存在很大的差异:如果遵循机械还原方法论来进行研究,信息学科必然被分解为若干分支(碎片),产生若干分支的理论,而且由于各个碎片之间互相独立和封闭,必然丢失各个分支之间的相互联系,因而也必然丢失整个学科的总体联系和规律;而信息生态方法论则关注各个分支之间相互关系的研究,关注学科系统与其环境相互关系的研究,于是就可以恢复学科原有的总体面貌,进而可以揭示学科的总体规律。

迄今人工智能理论遵循的是“机械唯物科学观”和“机械还原方法论”;本文人工智能理论研究所遵循的是“辩证唯物科学观”和“信息生态方法论”。

这个结果,是研究对象的历史性转变(由物质对象转变为信息对象)所使然。由此导致了经典物质科学时代向信息科学时代的转变,或者更简练地说,导致了工业时代向信息时代的转变。这是一个划时代的伟大转变。

3 中层研究:创新研究模型和路径按照机械还原方法论的精神,迄今的人工智能研究模型通常都是某种孤立的人类大脑模型:或者是大脑的新皮层结构模型(人工神经网络),或者是大脑的逻辑思维功能模型(专家系统)。这是造成人工智能理论浅层化、碎片化和封闭化的重要原因。

3.1 信息生态:通用人工智能理论的研究模型按照信息生态方法论的精神,智能是认识主体(典型的代表是人类主体)在与其环境客体相互作用的过程中对客体信息进行复杂加工所生成的高级产物(体现为智能策略和智能行为)。于是,就可以得到图1所示的智能宏观研究模型。

任何客体都会呈现自己的“状态及其变化方式”。按照后面5.1节的定义1,这便是图1模型中的“客体信息”。所谓“主体与客体的相互作用”是指:一方面,客体信息作用于主体;另一方面,主体会据此生成智能行为反作用于客体。这是两者相互作用的一个基本回合。需要强调的是,主体反作用于客体的行为不能随心所欲,而必须具有足够的智能水平:一方面,这种行为应当能够实现主体所追求的目的,否则就算失败;另一方面,这种行为又应当遵循客观规律而不破坏环境,否则,主体自身的生存发展就会面临风险。这就是说,智能行为必须是能够保证“主客双赢”的行为。

那么,当受到环境中客体信息作用(刺激)的时候,人类主体应当怎样做才能生成足以实现“主客双赢”的智能行为呢?

这显然是一个十分复杂的过程。但是,无论这个过程怎样复杂,图1的宏观模型还是给出了清晰的启示:主体收到的是“客体信息”,而它要生成的是“智能行为”,因此,这必定是一个由“客体信息”到“智能行为”的转换。

问题于是就变为:主体应当怎样做才能完成这个转换?图1的模型也给出了另一个启发:主体具有明确的目的,也具有相应的知识,因此,这个复杂过程一定是“在主体目的的牵引下,在主体知识的支持下,把客体信息转换为智能行为的过程”。

如果把这个复杂的转换过程具体地展开,就可以得到图2所示的智能生成模型。

|

Download:

|

| 图 2 智能生成:人工智能系统的通用模型 Fig. 2 Intelligence generation: a general model of artificial intelligence system | |

注意,图2的“综合知识库”存储了主体的目的G和知识K(这是任何主体都必须具备的属性)。可以看出,图2其实就是图1的深化:不仅表现了“客体信息”对主体施加的作用和“智能行为”对客体施加的反作用;而且把主体生成智能行为这个复杂过程都表现出来了。熟悉脑科学和认知科学的研究者都可以做出判断:无论对人工智能还是对人类智能,图2的模型都是科学合理的。

不能不指出的是,由于受到“分而治之”方法论的影响,现有人工智能理论的研究模型只把图2的“理智生成”和“综合知识库”部分地分割出来研究,而对模型中的感知选择、认知、基础意识、情感生成、综合决策、策略执行这样一系列极其关键单元的作用原理和相互关系都未有涉足。可见,现有人工智能理论的研究模型多么局限!

那么,面对图2所示的研究模型,应当采取怎样的研究路径才能走向成功?

3.2 机制主义:通用人工智能理论的研究路径一个富有启发意义的例子是:飞机的设计并不是刻板地模仿飞鸟的具体结构,而是抓住了支持整个飞翔活动的“空气动力学原理”。同样,人工智能系统的研究也不应当刻意地模仿人脑的具体结构,而应当抓住支撑整个智能活动的“智能生长机制”。

有鉴于此,通用人工智能理论研究独树一帜采取了“机制主义”的研究路径,即着眼于“主体生成智能的共性机制”,这是因为:与智能系统的结构、功能、行为相比,生成智能的共性机制才是最本质的东西,而且是主宰智能系统全局的东西;而结构和功能则都是为机制服务的东西。这个共性的工作机制可以表示为:针对给定的问题、目标和领域知识,执行式(1)的复杂转换(对照图2):

| $\text{客体信息} \to \text{感知信息} \to \text{知识} \to \text{智能策略} \to \text{智能行为}$ | (1) |

图2表明,式(1)的每一个转换都对应着一类工作单元:“感知与选择”单元把客体信息转换成为感知信息;“认知”单元把感知信息转换成为知识;“基础意识–情感生成–理智生成–综合决策”单元在目的牵引下、在相关知识支持下把感知信息分别转换成为各种层次和侧面的智能策略成分(包括基础意识、情感、理智和最终综合形成的智能策略);“执行”单元则把智能策略转换成为智能行为。其中各个工作单元的基本概念和工作原理将在第5节分别阐述。

式(1)可以更简洁地表示为式(2)的转换系列:

| $\text{信息} \to \text{知识} \to \text{智能}$ | (2) |

转换系列式(1)、(2)可以称为“信息转换与智能创生”原理,即通过一定的信息转换实现智能策略和智能行为的创生。“信息转换与智能创生原理”乃是一切智能系统共有的核心工作机制,是一切智能系统共有的基本规律。

显然,假如不是采取了“机制主义”的研究路径,而是运用结构主义(神经网络)、功能主义(专家系统)或者行为主义(感知动作系统)的研究路径,那么,式(1)、(2)所表达的“智能系统共有的基本规律”就会被阉割和丢失,这正是现有人工智能研究所遭遇的情形。可见,正确的研究路径将揭示研究对象的深层规律;不恰当的研究路径将阉割和丢失研究对象的深层规律。这就是研究路径的重要意义。

现行人工智能理论的研究模型或者是“大脑的结构”,或者是“大脑的功能”,它的研究路径或者是“结构主义(模拟脑的结构),或者是功能主义(模拟脑的功能),或者是行为主义(模拟智能系统的行为)”,尚未实现统一。本文所述的人工智能理论的研究模型则是“主客相互作用过程的信息生态演进系统”,它的研究路径是“以信息–知识–智能转换为标志的机制主义”。这是人工智能由局部研究发展到全局研究、由分散研究发展到统一研究所发生的重要突破和转变。

4 底层研究:创新基础概念与原理如上所见,站在“辩证唯物科学观”这个信息科学研究的源头,抓住“信息生态方法论”这个信息科学研究的龙头,可以构建起通用人工智能理论的研究模型(总体蓝图),并沿着“信息→知识→智能的转换”这个机制主义的研究路径,就成功地揭示了人工智能理论的根本规律“信息转换与智能创生”。

按照“信息生态”这个方法论思想,信息领域的研究任务,远远不是仅仅研究信息现象本身,而应当研究信息的整体生态过程,即信息转换为知识并进而转换为智能策略和智能行为的完整过程。那么,上述“信息转换与智能创生”基本规律,就是管控整个信息领域的普适定律!

本节之所以要讨论基础概念和基本原理,目的就是使“信息转换与智能创生定律”能够落地生根。为此,以下将对照图2的模型逐一展开讨论。由于篇幅的缘故,以下的讨论基本上是结论性的,详细的内容可以参阅文献[1, 25-28]。

4.1 感知(语义信息生成):第一类信息转换原理如前所述,信息是智能生长的激励源泉,但是迄今信息概念局限于“通信信息”。后者仅仅是智能研究所需要的信息概念的表面(形式)层次。既然信息这个源头概念已经被浅层化了,就导致现有人工智能理论不会有深刻的理解能力。因此,我们必须重新审视信息的概念。

4.1.1 信息的概念和表示通信信息的概念:信息是用来为通信接收者消除“关于发送端所发信号波形”的随机不确定性的东西。这里只有波形的形式因素,没有内容因素,也没有价值因素。因此,这种信息概念适用于通信工程,不足以支持智能理论的研究。

对照图2的模型可以看到,实际存在两种互相联系又互不相同的信息概念:客体呈现的“客体信息”和主体所感知的“感知信息”。它们的基本定义如下。

定义1 客体信息。客体信息是指客体所呈现的关于其自身的“状态及其变化方式”。

定义1表明,事物X的客体信息可以用它呈现的状态及其变化方式来表示。例如,假设X是有限状态的事物,即x1, x2,

客体信息只与客体自身的性质和状况有关,而与主体的性质及主观意志无关。因此,客体信息又被称为“本体论信息”。客体信息是一切其他信息的源泉,其他信息都是客体信息通过相关转换所产生的结果。

定义2 感知信息。感知信息是指主体从客体信息所感知的客体状态及其变化方式的形式(称为语法信息)、内容(语义信息)和效用(语用信息)。

主体具有感觉能力和知觉能力。因此,主体对客体信息感知的结果就会产生“语法信息(形式)、语义信息(内容)、语用信息(效用)的三位一体”。如果X是有限(n)状态的事物,那么主体从X的客体信息得到的感知信息就要表示为一个矩阵:

| ${\mathit{\boldsymbol{X}}} = \left[ \begin{array}{l}{x_1}\quad{x_2} \quad \, \cdots \! \quad \,{x_n}\\{c_1}\quad{c_2} \quad \, \cdots \! \quad \,{c_n}\\{t_1}\quad \,\, {t_2} \quad \,\, \cdots \! \quad \,\,{t_n}\\{u_1}\quad{u_2} \quad \, \cdots \! \quad \,{u_n}\end{array} \right]$ | (3) |

式中:c1, c2,

更有创新意义且更为科学的客体信息和感知信息表示方法,是汪培庄教授创建和发展起来的因素空间理论[29]。当然,文献[1]的信息表示方法和文献[29]的信息表示方法之间是相通的,但是后者具有更多的优越性。

感知信息不仅与客体的性质和状况有关,而且与认识主体的目的和知识状况有关。因此,感知信息也称为“认识论信息”,代表了主体对于客体的主观认识。也正因为感知信息不仅与客体的因素有关而且与主体的因素有关,因此感知信息要比客体信息的内涵丰富得多复杂得多。

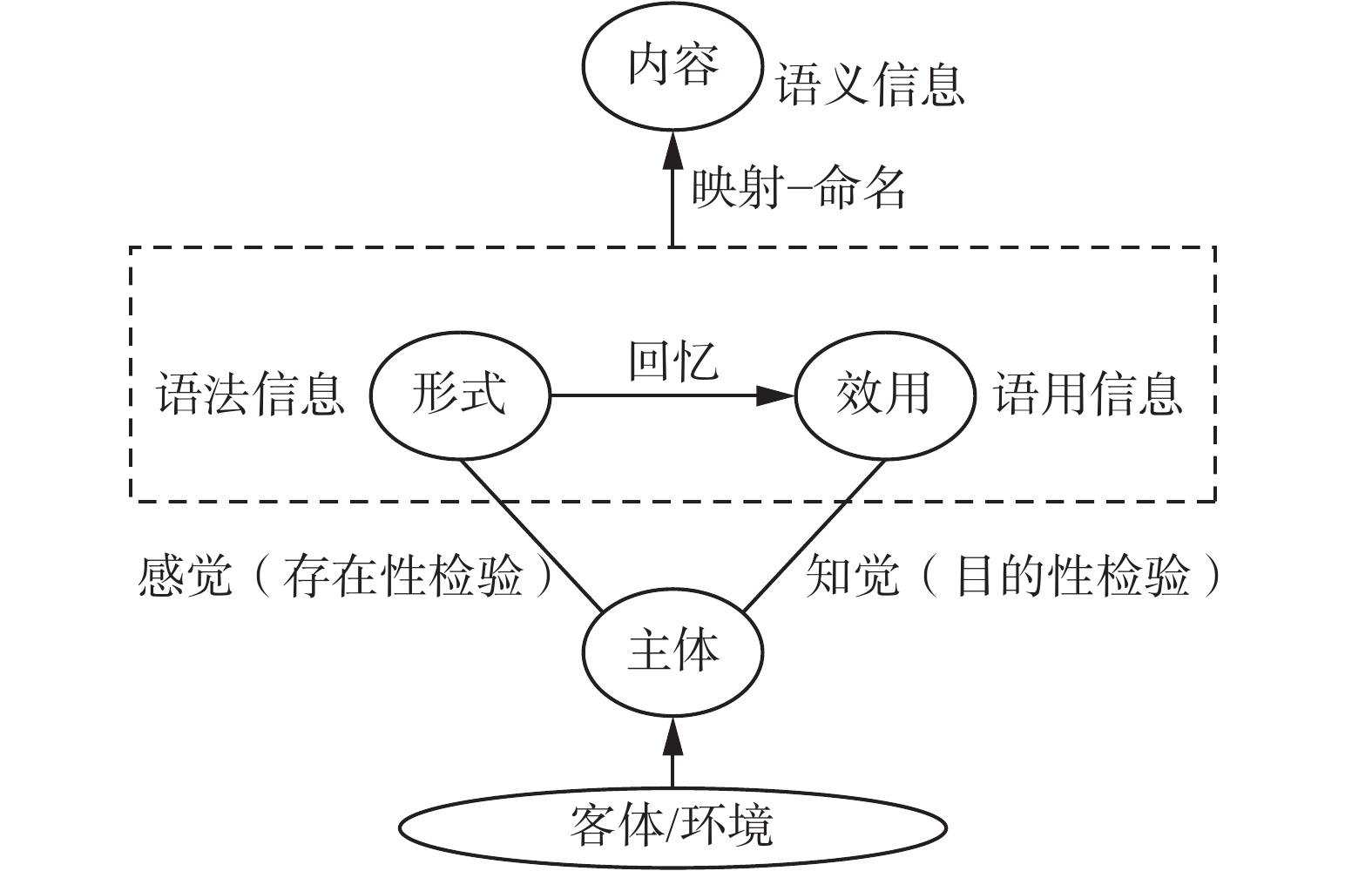

为了进一步理解感知信息的概念,需要考察图3的感知信息生成机理。

|

Download:

|

| 图 3 感知信息的生成机理 Fig. 3 Generation mechanism of perceived information | |

图3显示:1)通过主体的感觉器官(技术上就是传感系统)可以直接把客体呈现的客体信息转换为语法信息;2)通过主体的回忆和检验(技术上是检索和计算)可以由语法信息生成语用信息;3)通过对“语法信息与语用信息两者的联合体”的抽象化处理(技术上是映射与命名)就可以生成语义信息,三者共同构成感知信息。关于感知信息生成机理更详细的分析,还可以参见4.1.2节。

现有人工智能理论沿用的“通信信息”概念只相当于语法信息的概念,因此现行的人工智能理论只关注了信息的形式而没有关注信息的内容和价值,致使现有人工智能理论研究在起点(感知信息)上就存在了致命性缺陷,导致理解能力的丧失。

4.1.2 语义信息理论由客体信息转换为感知信息的原理称为第一类信息转换原理[1]。对照图3感知信息的生成机理,可以构造第一类信息转换原理的模型,如图4表示。

在图4的模型中,知识库代表了主体的记忆系统,它包含了主体的目标G、主体已经拥有的语法信息与语用信息的偶对集合{xn, zn}以及主体的逻辑处理能力(包括检索、运算、抽象化等)。模型表明,客体信息向感知信息的转换是在主体操作下完成的。具体的转换过程包括3个步骤(可以对照图4和图3):

1)生成相应的语法信息:客体信息(即图4中的本体论信息)S通过传感系统的感觉功能转换为语法信息X,这在数学上就是映射。

|

Download:

|

| 图 4 第一信息转换原理:客体信息→感知信息 Fig. 4 The first information conversion principle: object information→perceived information | |

2)生成相应的语用信息:分两种情况处理,即检索和计算。检索:以语法信息X为检索子,在知识库内对{xn, zn}进行检索,如能在其中找到与检索子匹配的语法信息项xn,则相应的zn就是X的语用信息Z。计算:如果无法在知识库内找到匹配项,说明S是一个新事物。这时就要采用新的方法:把语法信息矢量X与主体的目标矢量G进行相关性计算,所得到的相关性结果就是相应的语用信息Z。

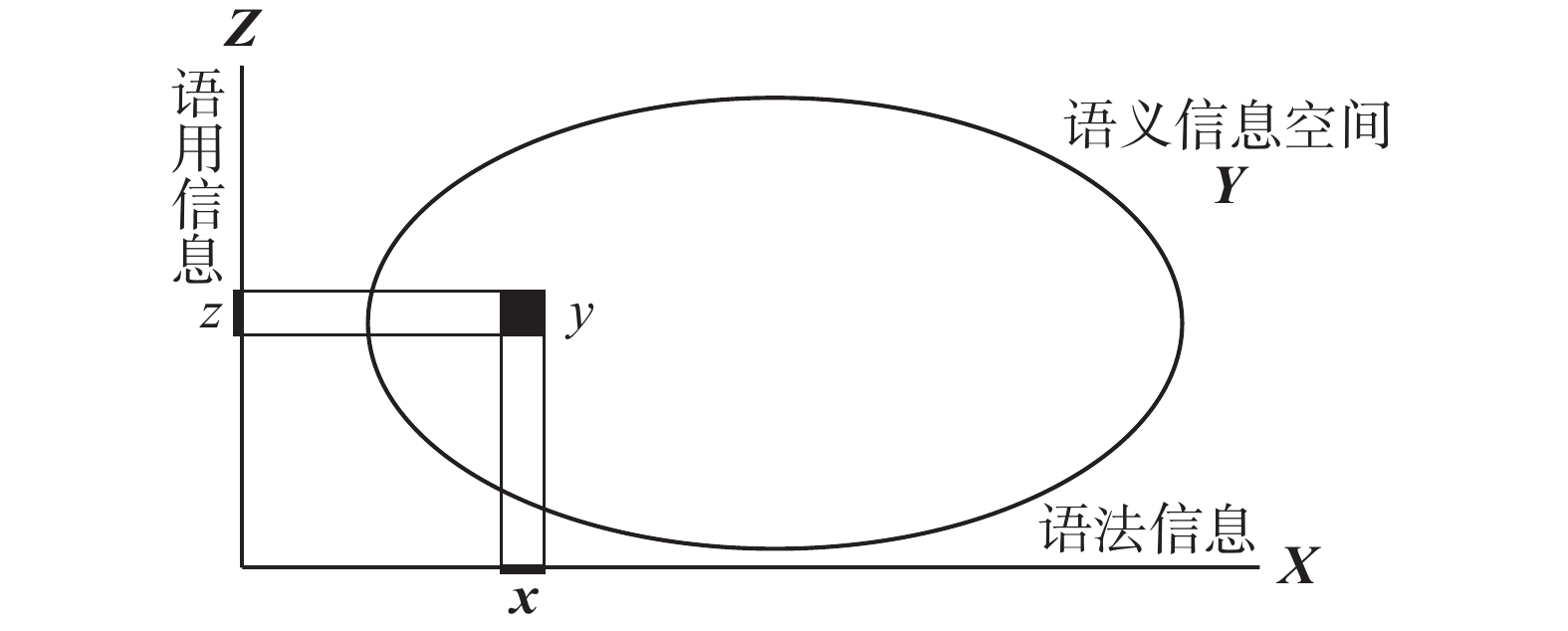

3)生成相应的语义信息:将偶对(X, Z)映射到语义信息空间并给映射的结果命名,就得到了相应的语义信息Y。这个操作也可通过图5来理解。

|

Download:

|

| 图 5 由(语法信息,语用信息)到语义信息 Fig. 5 From (syntactic information, pragmatic information) to semantic information | |

这样就完成了由客体信息S到感知信息(X, Y, Z)的转换。不难看出,第1类信息转换原理的全部信息转换过程,不但可以在人类主体系统内轻松实现(见图3),而且也可以在机器系统内方便实现(见图4)。

第1类信息转换原理揭示了1个重要的关系,这就是语法信息、语义信息、语用信息三者之间所存在的相互关系(对照图4和图5):

| ${\mathit{\boldsymbol{Y}}} = \lambda \left( {{\mathit{\boldsymbol{X}}}, {\mathit{\boldsymbol{Z}}}} \right)$ | (4) |

式中λ是“映射与命名”算子。式(4)表明,语义信息Y是语法信息X和语用信息Z两者的联合(X, Z)映射到语义信息空间(和命名)的结果。

式(4)关系的合理性:语法信息表达的是事物的形态,很具体,因此可以被直接感受到;语用信息表达的是事物对主体目标而言的效用,也很具体,因此可以通过回想或检验得到;而语义信息是抽象的,既不能直接感受到也不能直接体验到,只能通过对语法信息和语用信息的联合体进行抽象化处理(映射与命名)才能得到。

初看上去,式(4)似乎很抽象。其实,人们时刻都在熟练地运用这个方法,只是因为太熟练而不经意了。例如,“水杯”的语义信息(内容)Y是什么?实际就是给“具有水杯的语法信息(水杯的形态)X和语用信息(水杯的效用)Z的那种事物”所取的名字。“给某某取名”,就是“将它映射并命名”。读者不难由此而及其余。

历史上曾有很多关于语法信息、语义信息、语用信息的讨论,却从来没有阐明它们之间的关系,以至造成诸多混乱。本文总结的关系式(4)之所以十分重要,就在于,只有阐明了关系式(4),才能真正理解,为什么人们最关心的是语义信息,为什么只有语义信息能够代表语法信息和语用信息,从而也能代表整个感知信息。

本节讨论的结果,不但阐明了语法信息、语义信息、语用信息的准确含义以及它们之间的相互关系,而且还可以用来澄清几个重要而又常常被混淆的概念。

1)传感与感知

值得注意的是,信息的感知包含了“感”和“知”两个互有联系又互不相同的概念。所谓“感”,是指感受是否有某种客体信息的存在(即存在性检验),如果确实存在某种客体信息,那么,“感”的结果可以得到这个客体信息的形态(语法信息),但得不到这个信息的内容(语义信息)和价值(语用信息),参见图3与图4。所谓“知”,是指在“感”的基础上,通过把它所产生的语法信息与主体目的进行相关考察(即目的性检验),从而知道这个信息具有什么效用(语用信息),进而将这个语用信息与语法信息的偶对映射到语义信息空间并予以命名,才能得到相应的语义信息。全面获得了语法信息、语义信息和语用信息,才实现了“感知”。

可见,“感知”的概念比“感”的概念要复杂得多。现在受到普遍关注和广泛应用的传感器只具有“感”的功能,没有“知”的功能。人们把传感器理解为完整的“感知”单元,这是一个非常普遍而严重的误解!

2)数据与信息

参照图3与图4可以看出,一切传感系统(或者人的感觉系统)输出的是只有形态因素而没有内容和价值因素的语法信息,数据就属于语法信息。换一种说法,数据和其他各种传感器产生的信号一样,都是信息的载体;而语法信息也正是以自己的形态作为载荷信息的载体。因此,数据与语法信息是同一概念的不同名称。

那么,数据、信号、语法信息它们所载荷的“信息”又是什么呢?严格地说,这里所说的信息其实不是别的,正是“语义信息”。正如4.1.2节所阐明的,“语义信息”可以代表语法信息和语用信息,当然也就代表了语法信息、语用信息和语义信息。因此,只有“语义信息”才有资格简称为“信息”;而语法信息和语用信息都不能拥有这样的简称。可见,人们所说的“从数据中提炼信息”实际上说的应当是“从语法信息中提炼语义信息”。于是,数据只是信息的载体。这些概念就在信息科学概念体系中得到了很好的厘清。

进一步的问题是,怎么才能“从数据中提炼信息”?在数据科学中,这个问题似乎仍在探索之中。但是,既然“从数据中提炼信息”更准确地说就是“从语法信息中提炼语义信息”,那么,在信息科学理论体系中(如图3~5),这个问题已经得到非常清晰的解答。

由此可见,用信息科学的理论体系准确厘清“数据”和“信息”这类术语的真实含义之后,不但可以消除术语含义上的混乱,而且可以准确而清晰地找到解决问题的有效方法。

4.1.3 信息选择对照图2,信息选择的作用是,根据系统的目标G,针对作用于系统输入端的客体信息S(或由它映射得到的语法信息X),计算S相对于G的语用信息Z,并依据语用信息的大小做出决定:凡是与目的无关的客体信息都予以舍弃,只需关心与目的有关的新鲜信息。这相当于认知科学的“注意”功能。

这是智能系统的第一道关口:智能门户,根据系统目标对客体信息做出取舍。假如没有这道智能门户,智能系统就可能被汹涌澎湃、排山倒海而来的信息所淹没,变得手足无措自顾不暇,丧失信息处理的能力。因此,“信息选择”的作用极其重要。

在当代“大数据(big data)”的信息环境下,这个“智能取舍”的作用具有特别重大的意义。这是因为,按照学术界的定义,所谓“大数据”是指那些具有“巨大的规模(volume)、庞杂的种类(variety)、极高的速度( velocity)而又具有潜在价值 (value)的数据”,它的总体标志则是“现有信息技术的能力无法处理的数据”。然而,通过智能系统的“选择”和“舍弃”功能,就可以直接把现有信息技术无法处理的“大数据”转变为可以轻松处理的“小数据”。“有舍才有得”,如果不懂得舍弃,大数据就会因为系统无法处理而无所收获。这是普通的辩证法。与“云计算”和“云存储”方法相比,在系统输入端口的“智能取舍”可以节约巨量的储算资源!

4.2 认知(知识生成):第二类信息转换原理对照图2的模型可以知道,“感知单元”获得的是感知信息,相当于人类认识过程中的“感性认识”。为了成功应对系统的外来刺激,仅有感性认识是远远不够的,必须设法把“感性认识”提升为“理性认识”,即“知识”。因此,感知单元之后应当有认知单元,它的作用就是完成“感知信息→知识”的转换,即第二类信息转换原理。

目前,人们对“认知”存在许多不同的理解。本文的理解是:“感知”是获得感性认识的认识过程,“认知”是获得理性认识的认识过程,“决策”是获得求解问题的智能策略的过程。为此,这里给出本文的“认知”定义。

定义3 认知。认知是感知(语义)信息转换为知识的过程,“获得知识”是认知过程的目的。

那么,作为认知完成的标志,知识的定义又是什么?

定义4 知识。主体关于某类事物的知识,是指主体从该类事物的大量感知信息中提炼出来的关于“该类事物共有的状态及其变化规律的形式、内涵和价值”的认识。

知识与感知信息具有天然联系,它们都是认识论范畴的概念,是主体对客体信息的感知和认知。但知识与感知信息又有原则的不同:感知信息是对某个事物的状态及其变化方式的形式、内容和效用的感知,知识是对某类事物运动状态及其变化规律的形式、内涵和价值的认知。“变化方式”是具体的个别的,“变化规律”是抽象的普遍的。所以,感知信息属于浅表的“现象”层次,知识则属于深刻的“本质”层次。

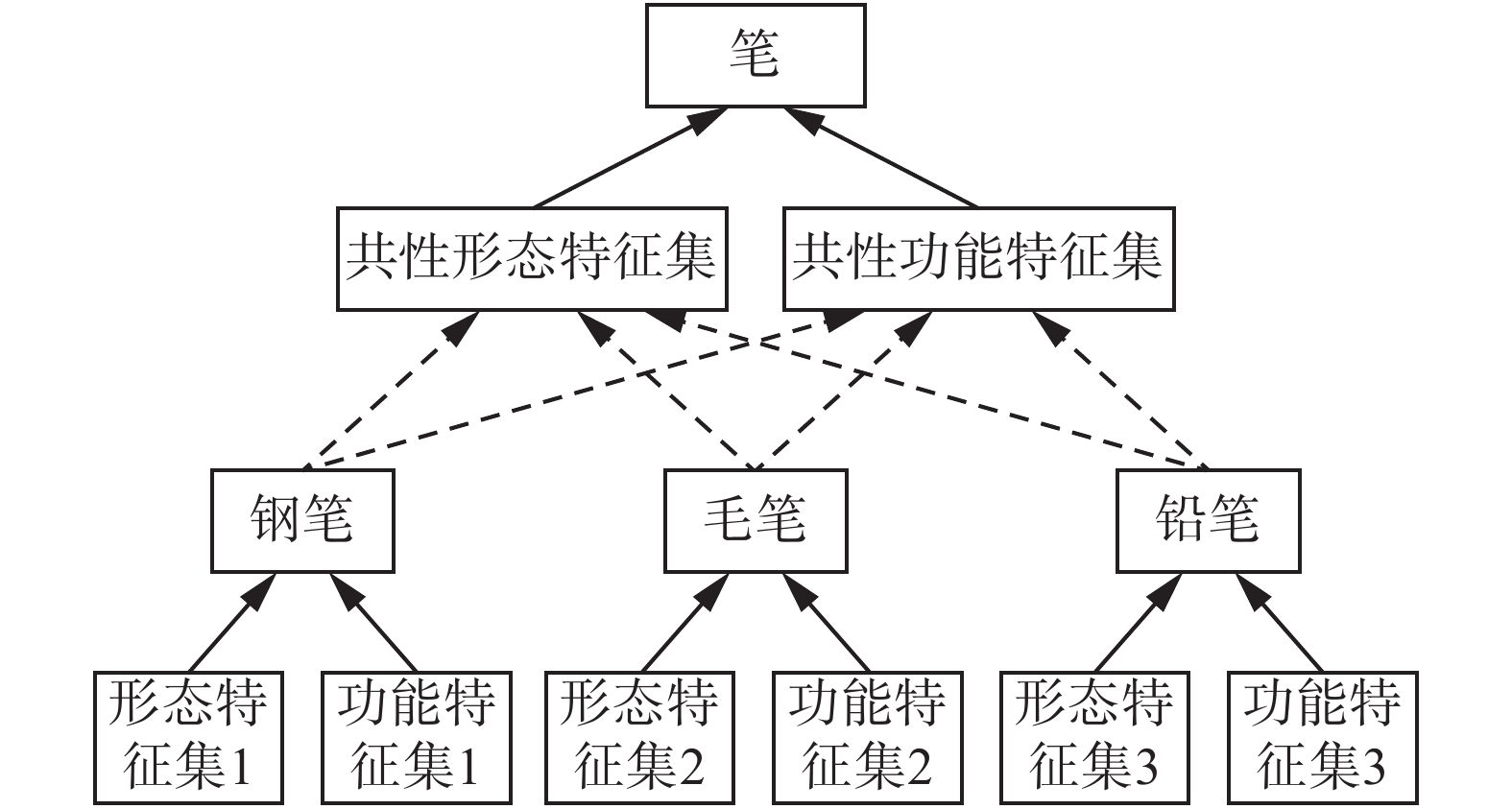

根据上述知识与认知的定义,“感知信息→知识”的转换其实就是要完成“由现象到本质”的转换。这就清楚地表明,完成“感知信息→知识”转换的方法,通常是归纳型算法。第二类信息转换原理:由感知信息到知识的转换,见图6。

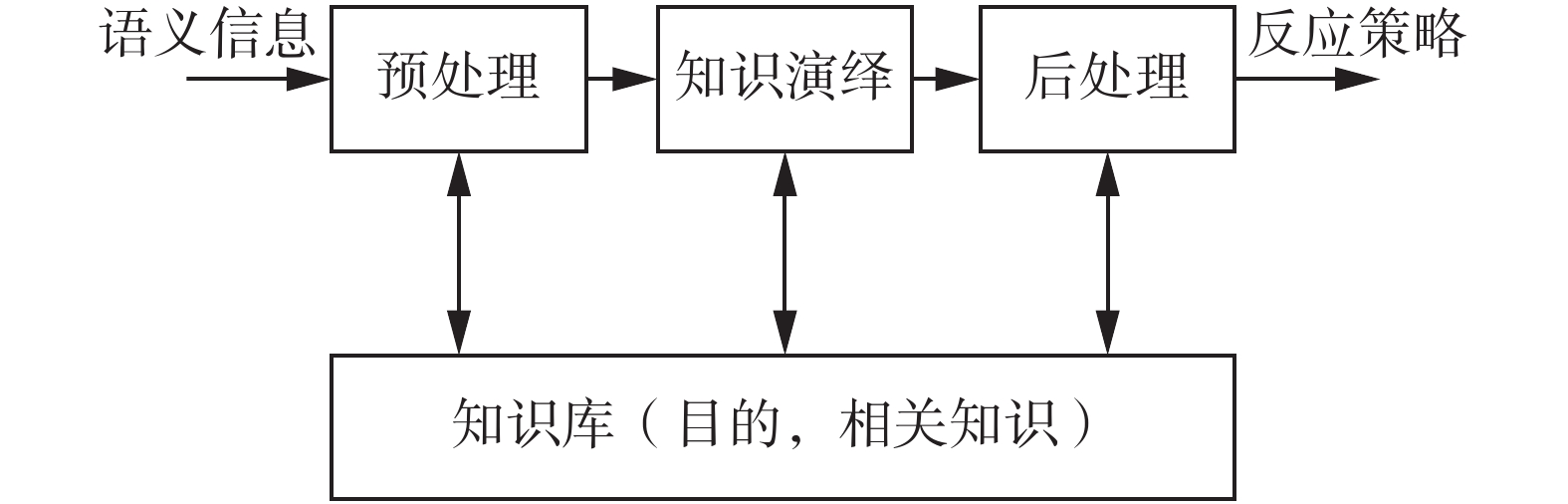

图6的输入是“语义信息”,代表了主体对“问题”的感性认识,是第一类信息转换的产物;输出是“知识”,代表了“认知(第二类信息转换)”所得到的结果。模型表明,“综合知识库”是认知系统的核心,它要包含信息的表示、知识的表示、认知的目的、归纳型的逻辑方法(包括归纳、类比、联想、分类、聚类、抽象化等)。没有这样的综合知识库,认知的任务就难以完成。图6中的预处理是为了使用归纳型算法所要采取的一些预备步骤,后处理则是为了规范“知识的表示”所需要的一些处理。

|

Download:

|

| 图 6 第二类信息转换原理模型示意图 Fig. 6 A schematic diagram of second type of information conversion principles | |

图7是“由语义信息转换为知识”的一个具体例子,即由钢笔、毛笔、铅笔这类具体的事物名称(语义信息)归纳出“笔”这个抽象概念(知识)的过程。从中可以看出,语义信息(由相应的语法信息和语用信息映射命名所确定)是生成知识(概念是知识的“原子”)的基础和前提:通过分别对具体事物(钢笔、毛笔、铅笔)的语义信息的共性形态特征和共性功能(效用)特征的提取,就归纳出抽象概念(笔)的共性形态特征和共性功能(价值)特征,从而抽象出了“笔”的概念(知识的一个原子)。

|

Download:

|

| 图 7 由语义信息转换为知识的例子 Fig. 7 An example of conversion from semantic information to knowledge | |

读者不难由此举一反三,分析更多“由语义信息归纳知识”的实际案例。所有的案例都会表明,如果没有语义信息这个前提,获得知识就会成为无源之水。知识还具有两个特别有用的性质,这就是知识的内生态规律和知识的外生态规律。

1) 知识的内生态规律

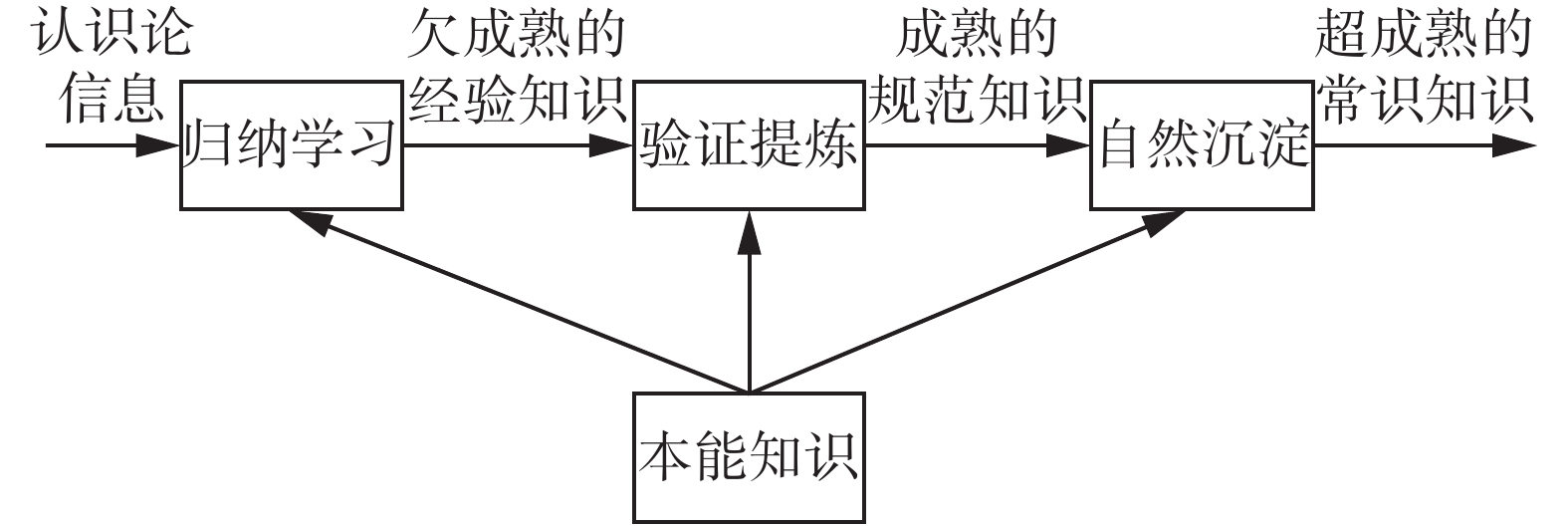

在先天的本能知识支持下,后天的经验知识才可以从语义信息(它是感知信息/认识论信息的代表)归纳出来,它是“欠成熟”的知识,可通过修正和提炼而生长成为“成熟”的规范知识,两者又可通过自然凝练生长成为“过成熟”的常识知识。本能知识、常识知识、经验知识、规范知识的概念易由图8获知。

2) 知识的外生态规律

图9给出了知识的外生态规律模型,即由语义信息通过归纳生长成为知识,后者通过演绎可以生长成为智能策略;图中的虚线联系表示,如果通过演绎过程不足以生成智能策略,就可以返回去要求归纳新的知识,以支持更好的演绎。

|

Download:

|

| 图 8 知识的内生态规律 Fig. 8 The internal ecological law of knowledge | |

|

Download:

|

| 图 9 知识的外部生态规律模型 Fig. 9 Model of external ecological law of knowledge | |

同信息的表示方法类似,也可以用因素空间理论有效地表示知识[29]。

4.3 决策(智能创生):第三类信息转换原理对照图2的模型可知,智能系统最为核心也是最复杂的任务是:针对主体所选定的具体问题(语义信息代表了主体对于“问题”的感性认识),在相关知识支持下,在目标牵引下,创生解决问题达到目标的智能策略。之所以这样说,是因为:智能策略是系统解决问题的“智能水平”的最集中体现,而生成智能策略的过程也是最为复杂的过程,包括基础意识的生成、情感的生成、理智的生成以及综合决策。

其中所说的“理智”,大体上相当于现行人工智能术语中的“智能”;不过,真正的智能应是基础意识(基础智能)、情感(感性智能)和理智(理性智能)的综合表现,因此,为了与“基础意识”和“情感”的名称形成和谐默契的关系,这里就把过去习惯上称为“智能”的这个术语专门规范为“理性智能”,简称“理智”。

另外,这里把智能生成称为“智能创生”,这是因为,由语义信息生成智能策略并非一般简单的逻辑演绎过程,其间存在许多不确定性:实际获得的语法信息和语用信息的非完善性,由此导致语义信息的不精准性以及知识的不充分性,预设目标的欠合理性等。因此,由语义信息生成智能策略的过程带有难以避免的误差性,需要通过不断学习来优化,其间也包含着“涌现”的复杂机制,是创造性生成,故曰“创生”。

如前所说,信息生态过程“源于信息,长于知识,成于智能”。因此,“智能创生”是人工智能理论的“集大成者”也是最精彩最复杂的环节,而且也是现行人工智能理论局限性最为突出的部分。

在展开具体的讨论之前,也有必要先明确意识、情感、理智等几个相关的基本概念。

注意到,智能是人类意识活动的表现;试想,如果一个人连意识能力都没有,怎么可能创生智能呢?换言之,意识是智能生长的前提;另一方面,智能又是意识的高级表现形态。同样,人类的情感也是智能的一种表现,也要以意识为前提。因此,为了研究智能的生成机理,意识和情感两者都是不可回避的概念。

以往的人工智能理论研究忽视和回避了意识和情感的要素,这是它的“片面性与失真性”的突出表现,是重大的失误。为了回到智能研究的正确轨道,我们必须正视意识和情感的研究以及意识、情感、理智集成融通的研究。

定义5 意识(哲学范畴的含义)。意识,是人的头脑对于客观物质世界的反映,是感觉、思维等各种心理过程的总和。存在决定意识,意识又反作用于存在。

哲学范畴的意识概念几乎是说:意识是物质以外的全部精神现象,非常宽泛,非常笼统,非常难以精准描述和模拟。因此,需要聚焦更具体更基础的意识定义。

定义6 意识(临床医学的含义)。一个人的意识主要指他对周围环境、自身状况、周围环境事物之间的关系以及自身与环境之间相互关系的觉察、理解与反应的能力。

显然,与哲学范畴的意识概念相比,医学范畴的意识概念就具体明确多了,不但比较容易理解和把握,而且容易检验和测试。不过,医学意义上的意识概念过于局限,而且几乎是一种纯粹现象学层面的定义,没有涉及意识的生成机制。因此,需要建立一种更合理更有用的意识定义——基础意识的定义。

定义7 基础意识(智能科学的含义)。基础意识是指主体在本能知识和常识知识支持下,在主体目标引导下,对来自外部环境和自身内部的刺激信息所产生的觉察、理解并做出合乎本能知识和常识知识及合乎目标的反应能力。

概言之,意识是指在一定的知识支持下和在目标牵引下对来自外部和内部的刺激信息所产生的觉察、理解和反应能力。由此可以确信:意识是智能的基础,智能则是意识的高级形态。

基础意识的定义规定:支持基础意识的知识范畴是本能知识和常识知识。虽然这样定义的“基础意识”没有覆盖全部的(宽泛而笼统的)意识概念,但它把意识的基础部分定义得明确而具体,不但给出了基础意识的概念内涵,而且揭示了基础意识的生成机理,即由“代表主体对问题的感性认识的语义信息Isem、本能知识和常识知识组成的知识体系Ka以及主体目标G组成的联合空间”到基础意识反应Ra的复杂映射Ca:

| ${{\mathit{\boldsymbol{C}}}_a}:\left( {{{\mathit{\boldsymbol{I}}}_{{\rm{sem}}}} \times {K_a} \times {\mathit{\boldsymbol{G}}}} \right) \to {{\mathit{\boldsymbol{R}}}_a}$ | (5) |

需要注意,正如语义信息Isem要由“语法信息和语用信息的联合”表示一样,这里生成的基础意识反应Ra也要由“基础意识反应的形态和效果的联合”来表示,这样才能把基础意识反应Ra的含义明确表达出来。

定义8 情感。情感是指主体在本能知识、常识知识和经验知识支持下,在目标引导下,对外来的和内部的刺激信息所产生的觉察、理解并做出合乎本能知识、常识知识和经验知识及合乎目标的反应能力。

可以看出,情感与基础意识之间存在密切联系,它们都是主体对客体信息所做出的觉察、理解和反应。但是,情感比基础意识利用了更多的知识(经验知识),情感只有在基础意识的基础之上才能发生,两者之间直接相通。因此,情感生成的机制也可以表示为由“代表主体对问题的感性认识的语义信息Isem、本能知识、常识知识和经验知识三者的知识集合Kb以及主体目标G组成的联合空间”到情感反应Rb的复杂映射:

| ${{\mathit{\boldsymbol{C}}}_b}:\left( {{{\mathit{\boldsymbol{I}}}_{{\rm{sem}}}} \times {{\mathit{\boldsymbol{K}}}_b} \times {\mathit{\boldsymbol{G}}}} \right) \to {{\mathit{\boldsymbol{R}}}_b}$ | (6) |

同样,系统所生成的情感反应Rb也要由“情感反应Rb的形态和情感反应Rb的效果的联合”来表示,只有这样才能把情感反应Rb的含义明确表达出来。

定义9 理智。理智是指主体在本能知识、常识知识、经验知识和规范知识支持下,在目标的引导下,对外来的刺激信息所产生的觉察、理解并做出合乎本能知识、常识知识、经验知识和规范知识及合乎目标的反应能力。

同样可以看出,理智与基础意识之间存在密切的联系,它们都是主体对客体信息所做出的觉察、理解和反应。但是,理智比基础意识利用了更多的知识(经验知识和规范知识),理智只有在基础意识的基础之上才能发生,且两者之间直接相通。于是也有

| ${{\mathit{\boldsymbol{C}}}_c}:\left( {{{\mathit{\boldsymbol{I}}}_{{\rm{sem}}}} \times {{\mathit{\boldsymbol{K}}}_c} \times {\mathit{\boldsymbol{G}}}} \right) \to {{\mathit{\boldsymbol{R}}}_c}$ | (7) |

式中:Kc表示本能知识、常识知识、经验知识和规范知识四者的集合;Rc表示理智反应;Isem为语义信息,G为目的。这里生成的理智反应Rc同样也要由“理智反应的形态和理智反应的效果的联合”来表示,这样才能把理智反应Rc的含义明确表达出来。

生理学特别是神经生理学已经证明,在人类大脑信息处理系统中存在两个并行的通路,一个是快通路,一个是慢通路。结合定义8、定义9和图2的人工智能通用模型可以判断,快通路支持的是情感生成过程,慢通路支持的是理智生成过程。这是因为,情感生成过程是关于相对比较浅层的本能知识、常识知识和经验知识的处理,通常只需要简洁的操作,因此可以比较快速完成;而理智生成过程是关于本能知识、常识知识、经验知识和比较复杂的规范知识的处理,往往需要比较复杂的深层推理,因而需要比较长的时间才能完成。

综合定义7、定义8和定义9,可以构造图10所示的基础意识生成、情感生成和理智生成的通用模型。

|

Download:

|

| 图 10 基础意识、情感、理智的通用生成模型 Fig. 10 A universal generation model of primary consciousness, emotion and reason | |

模型表明,无论是基础意识的生成,还是情感和理智的生成,它们的共同输入都是语义信息,它代表了主体对客体(问题)的感性认识,即代表了主体所认识的“需要求解的问题”。同样,无论是基础意识的生成,还是情感和理智的生成,共同的前提都是要事先给定求解问题的目的和相关知识,把它们恰当地表示出来并存储在知识库内备用。再者,无论是基础意识的生成,还是情感和理智的生成,在上述给定前提(待求问题、预设目标和相关知识)的基础上,关键的步骤都是“在相关知识的支持下,在目标的引导下,针对待求问题而展开的知识演绎处理”。

在不同情况下,知识演绎的不同特点在于:生成基础意识所需要的是对“本能知识和常识知识”的演绎处理,比较直截了当,它所生成的反应策略是“基础意识”表达;生成情感所需要的是对“本能知识、常识知识和经验知识”的演绎处理,只需要比较简洁的处理,它所生成的反应策略是情感表达;而生成理智所需要的是对“本能知识、常识知识、经验知识和规范知识”的演绎处理,需要比较复杂的深层演绎,它所生成的反映策略是“理智”表达。

那么,这些不同类型的“知识演绎”分别又是怎样实现的呢?

1)生成基础意识所需要的知识演绎

由于基础意识的生成只依赖于对本能知识和常识知识的演绎,其中本能知识的演绎基本上是“条件反射”式的过程,而且引起反射的“条件”也很明晰;常识知识所需要的知识演绎原则上就是“自动检索”的过程。因此,图9模型中的知识库所储存的本能知识和常识知识都可以表示为以下形式:

| $\left\{ {\text{若}\left( {\text{语法信息}, \text{语用信息}} \right)\text{则}\left( {\text{响应形态},\text{响应效果}} \right)} \right\}$ | (8) |

式(8)的含义是:假设输入的“刺激”是某种“语义信息(语法信息,语用信息)”,那么,如果这个语义信息(代表主体所认识的待求问题)是属于本能知识的范畴,系统就直接输出(响应形态,响应效果)的表述;如果输入的语义信息(语法信息,语用信息)属于常识知识的范畴,就要用输入的“语义信息(语法信息,语用信息)”作为检索子,在系统知识库的常识知识集合里进行搜索,试图在常识知识集合内发现与输入语义信息(语法信息,语用信息)相匹配的语义信息(语法信息,语用信息)。只要实现了匹配,就把常识知识集合内与该语义信息(语法信息,语用信息)对应的(响应形态,响应效果)作为系统输出的反应(响应),如图11所示。

|

Download:

|

| 图 11 基础意识(响应)知识演绎 Fig. 11 The knowledge deduction of the primary consciousness response | |

显然,这是最为简单的“知识演绎”。事实上,所有的本能知识和常识知识几乎都具有“收到这样的刺激,就生成那样的响应”这种一一对应结构,不需要推理演绎。唯一需要做的事情,就是在输入的“语义信息(语法信息,语用信息)”与图11知识库储存的“语义信息(语法信息,语用信息)”之间进行搜索和匹配(也就是检索)。

如何判断输入的语义信息(语法信息,语用信息)需要用本能知识处理还是需要用常识知识处理?其实,并不需要进行这样的判别。当语义信息输入到图11的本能知识库和常识知识库的时候,如果输入的语义信息(语法信息,语用信息)属于本能知识的范畴,本能知识库就会如同条件反射那样自动输出(响应形态,响应效果),而这时的常识知识库就不发生反应;如果输入的语义信息(语法信息,语用信息)属于常识知识的范畴,本能知识库就不会发生反应,在这种情况下,常识知识库就会通过检索程序而输出(响应形态,响应效果)。

2)生成情感所需要的知识演绎

生成情感所需要的知识演绎,通常比生成基础意识所需要的知识演绎复杂。因为这里所需要的知识除了必须包含体现情感特色的“经验知识”之外,还必须能够调用它的基础知识,即“本能知识和常识知识”,如图12所示。

|

Download:

|

| 图 12 情感响应的知识演绎 Fig. 12 Knowledge deduction of emotional response | |

注意到“经验知识”与“常识知识”具有一定的共同之处:只要识别出外来的刺激信息属于曾经经验过的类型,原则上就可以执行已有的经验来解决问题。因此,这里的知识演绎的特点与基础意识的“识别–执行”类似。不过,经验知识还具有如下特点:1)经验知识所能支持的活动大致都是一些“同类”的活动,而不支持“他类”活动;2)经验知识通常是主体所积累的比较浅层的知识;3)经验知识往往需要因时因地做出适当的调整才能成功。针对经验知识的这些特点,图12知识库的语义信息(语法信息,语用信息)与响应(响应形态,响应效果)的关系就不再是严格的一一对应的关系,而可能是“一多对应”,即一种语义信息(语法信息,语用信息)与多种响应(响应形态,响应效果)相对应。这时,就需要在多种响应(响应形态,响应效果)中选择“响应效果”与“目标”之间差异最小的响应作为系统输出的情感反应。另一方面,由于人类情感表达的分类本身的有限性:典型的情感分类是8类(兴奋、开心、厌恶、惊讶、害怕、愤怒、沮丧、羞耻),也有的分为6类(兴奋、温和、恐惧、愤怒、悲伤、快乐),所以(响应形态,响应效果)的选择比较粗略,不会太过复杂。综合以上情形,情感反应所需要的知识演绎特点就是“模糊分类–择优执行”。

如果输入的语义信息(语法信息,语用信息)是系统此前未曾经验过的,这时的处置比较困难。一种可能的处置方法是:不立即产生情感响应,等待理智响应的结果,这当然会使系统显得“尴尬”。但是,人类自己在这种情况下往往也会出现这种尴尬的局面,这是难以避免的情形。另一种处置的办法是:把输入的语义信息(语法信息,语用信息)尽量与曾经经验过的最接近的语义信息(语法信息,语用信息)相联系,从而产生“最接近的”响应(响应形态,响应效果)。在这种情况下,系统的响应有可能显得“勉强”。其实,人类自己也会出现这种“勉强(或不够自然)”响应的局面。

至于那些“伪装的情感响应”和“扭曲的情感响应”,虽然在人类活动中并不少见,但是,在机器系统的场合,属于过分复杂的情形。本文暂时不做讨论。

3)生成理智所需要的知识演绎

这是最复杂的情形,因为这里要面对的是求解问题所需要的规范知识的演绎,规范知识是一类比较深入和复杂的知识。具体地,这里的知识演绎可分3种情形讨论:

①如果问题简单规范,用本能知识、常识知识或经验知识就能解决,在这些情况下,生成理智所需要的知识演绎就只需要默认上面的结果即可。

②如果求解的问题比较复杂,远远超出本能知识、常识知识和经验知识的范畴,那就得靠生成理智来寻求恰当的答案。这时的知识演绎就要在规范知识范畴内动用深层的计算和推理。这部分工作,大体相当于现行人工智能理论(特别是专家系统)中的“问题求解”功能,这里可以继承。

③如果不仅问题复杂,而且具有各种不确定性,那么,这时所需要的知识演绎就不止是上述的“问题求解”,而是需要动用复杂的搜索技术和不确定性推理,需要高级的机器学习方法、柔性的和辩证的逻辑理论,详见何华灿教授的《泛逻辑学原理》和《论第2次数理逻辑革命》[30-31]。

总之,理智反应所需要的知识演绎一般来说非常复杂,还有大量的工作需要开发和研究。不过这种知识演绎的原理性模型,却可用图13表示。

|

Download:

|

| 图 13 理智响应的知识演绎 Fig. 13 Knowledge deduction of intellect response | |

值得指出,理智响应的知识演绎过程确实最为复杂,在目标牵引下,基于本能知识、常识知识、经验知识和规范知识的复杂推理包含着各种不确定性,有时推理的结果甚至不一定能够满意地达到目的。此时,往往就需要通过“反馈(把误差作为新的信息反馈到系统输入端)、学习(学习到新的知识)、优化(优化推理结果)”的措施循环往复逐次改进,在这种“反馈–学习–优化”的逐次迭代过程中,往往也包含“涌现”的机制和进程。

至此,还有必要讨论基础意识反应、情感反应、理智反应之间的协调机制。为了方便讨论,可以参照图2的模型把“基础意识生成单元”命名为下级单元,把“情感生成单元”和“理智生成单元”命名为上级单元。

上级单元与下级单元之间的协调机制 通常采用“正常–通过”和“求助–启动”的工作方式,具体包含以下两种不同的工作流程。

①如果下级单元能够生成正常的反应,它就向上级单元发出“正常”的信息,上级单元收到这个信息以后就将自己置于“通过”状态。这时,下级单元生成的反应表达就可以直接通过上级单元向前传递,成为整个系统的响应表达。

②如果下级单元不能生成正常的反应(输入的问题超出了该单元的知识范畴),它就向上级单元发出“求助”的信息,并把自己所收到的语义信息(语法信息,语用信息)直接转给上级单元。这时,上级单元就进入“启动”状态,针对下级单元送来的语义信息(语法信息,语用信息)启动自己的知识演绎过程。

通过这样的机制,可以保障上级单元与下级单元之间互相配合默契,使整体工作顺畅进行。至于“情感生成单元”与“理智生成单元”之间的协调,则有下面的论述。

定义10 智能策略。智能策略是指:面对具体问题(客体信息)的人工智能系统所生成的能够保障“主客双赢”的问题求解策略,它是基础意识响应、情感响应、理智响应三者综合协调的产物,是人工智能系统智能水平的最高体现。

上面的讨论和图2的模型都表明:面对客体信息,人工智能系统将生成基础意识的反应、情感反应和理智反应。显然,作为一个有机的整体,这三者必须协调一致。上面已经讨论过上级单元与下级单元之间的协调机制,这里还需要讨论情感单元和理智单元之间的协调机制。这两个协调机制的有机综合,就是人工智能系统的“综合决策”。它的产物,才是人工智能系统所生成的“智能策略”。

情感反应与理智反应之间的协调机制 一方面,由于情感反应生成得比较快,理智反应生成得比较慢,两者在时间上不同步;另一方面,由于情感反应比较简单粗旷(基于本能知识、常识知识和经验知识),理智反应比较深刻和全面(基于本能知识、常识知识、经验知识和规范知识),两者在科学合理性上不一致,因此,这里的协调存在一定的难度。通常的协调原则可以分为3种情形:

①在不太重要也不紧急的情况下,两者不协调也不会有损失。例如,与普通朋友相会的时候,首先做出一番友好的情感表示,然后见景生情或有的放矢地表达理智性的欢迎话语,这不会有什么不妥。

②在重要而不紧急的情况下,情感反应必须等待并服从理智反应。例如,在许多外交或社交场合,面对一些重大而非紧急的事件,就不应贸然唐突地表示自己的情感,而应当经过深思熟虑,有理有利有节地表达自己的立场。

③在重要而很紧急的情况下,情感反应无需等待理智反应。例如,在旅游的时候突然发现一只猛虎正朝着自己走来,这时首先就要“逃避”(逃生情感),然后再理性地思考如何采取有效的逃生策略躲过危险,而不能等到理智思考好了以后才逃避。

在这里,对于如何区分“重要性”和“紧急性”的情况,唯一的依据就是主体所生成的“语义信息(语法信息,语用信息)”。这是因为,语义信息的一个分量就是“语用信息”,它就表现了外部刺激(客体信息)对主体目标的实现而言是否重要(不管是正面意义上的重要还是负面意义上的重要),而其中的“语法信息”分量可以显示外部刺激对目标而言是否紧急(比如老虎离自己还有多远)。

以上就是“综合决策”的基本概念和理论。图2中“综合决策”所产生的结果应当就是能保障“主客双赢”的智能策略。

至于如何把“智能策略”转换为“智能行为”,原则上说,只要把智能策略恰当地描述出来,就可以找到方法把这种描述转换成为相应动作。不过,这部分工作属于比较常规的内容,读者可以很方便地在有关控制系统的资料中找到相关的阐述,这里就从略了。

到此,我们完成了“客体信息→感知信息→知识→智能策略→智能行为”的全部讨论(也就是“信息→知识→智能”的讨论),看到了在客体信息刺激下(人工)智能系统如何根据预设的系统目标,按照信息生态的规律转换创生解决问题达到目标的智能策略和智能行为,从而实现(人工)智能系统的基本功能。

4.4 系统的反馈、学习与优化如前所说,由于现实世界不可避免地存在各种不确定性因素,系统所生成的智能策略往往难以一次成功。这样,当系统生成的智能行为反作用于环境的客体的时候,结果就常常很难满意地使客体状态演变到系统预设的目标状态。换言之,客体受控所产生的实际状态与目标状态之间就会存在一定的误差。

在这种情况下,系统就应当把这个“误差”作为1种“新的客体信息”反馈到系统的输入端,并且根据这个新的信息通过学习获得“新的知识”,从而在新的知识支持下生成新的更为优秀的智能策略和智能行为,再以这个新的智能行为反作用于客体,就可能使客体的新状态比原来更接近于目标状态。这种“反馈–学习–优化”的过程可能需要重复多次,每次都离目标更近一点,直至满意为止。或许,在这种循环往复螺旋前进的过程中潜藏着“涌现”的机制,通过涌现而到达预设的目标。

万一“反馈–学习–优化”不能减小误差(有时甚至使误差变大),就要作出反思:当初主体所设定的“目标”是否合理?如果不合理,就要重新预设目标。当然,这个工作不是人工智能系统本身所能完成的,而是应当由人工智能系统的设计者来承担。这也是人工智能工作中“人机合作”的重要内容。

4.5 机制主义人工智能理论的融通性第4节的全部结果全面表现在图2的人工智能通用模型中,图2系统体现了人工智能研究的辩证唯物科学观和信息生态方法论,体现了立足于信息生态方法论所启迪的人工智能通用模型,以及沿着式(1)、(2)所展示的机制主义研究路径,重构了人工智能理论重要的基础概念,建立了转换原理、机制主义的人工智能理论。

机制主义人工智能理论的重要意义之一,就是可以证明:现有人工智能理论长期鼎足三分互不认可的三大学派 (即结构主义的人工神经网络理论学派、功能主义的物理符号系统/专家系统理论学派和行为主义的感知动作系统理论学派)恰好是机制主义人工智能理论的3个互补分支理论,如表3所示。

| 表 3 机制主义人工智能理论与结构主义、功能主义、行为主义人工智能理论的关系 Tab.3 The relationship between the theory of mechanism artificial intelligence and the theory of structuralism, functionalism and behaviorism artificial intelligence |

表3显示:机制主义人工智能理论的核心是“信息–知识–智能”的转换(见表3的第一行)。依据不同的知识进行求解的时候,它就分别退化为基于经验知识的A型、基于规范知识的B型、基于常识知识的C型这3种具体的型式。而机制主义人工智能理论的A型、B型、C型恰好分别对应于结构主义的人工神经网络(基于经验知识)、功能主义的物理符号系统/专家系统(基于规范知识)、行为主义的感知动作系统(基于常识知识)的研究。

这就说明,结构主义人工智能理论、功能主义人工智能理论和行为主义人工智能理论乃是机制主义人工智能理论在不同知识条件下的3个特例,而且是“和谐相生”的3个特例,这是因为,根据4.2节的知识内生态规律,经验知识可以被加工提炼成为规范知识,经验知识和规范知识又可以被沉淀成为常识知识。这就是说,人工神经网络的经验知识可以被提炼成为专家系统所需要的规范知识,而人工神经网络的经验知识和专家系统的规范知识又可能被凝聚为常识知识供感知动作系统应用。可见,过去数十年来互不认可、互不服气、各行其是的人工智能三大理论和方法之间其实存在某种“相生”而不是“相克”的关系。

这个事实说明,正确的科学观、方法论、研究模型和研究路径可以揭示智能的深层奥秘(包括结构主义方法、功能主义方法、行为主义方法之间的相互关系),建立起智能的理论大厦。而不恰当的科学观、方法论、研究模型和研究路径则可能模糊了甚至掩盖了智能的深层奥秘,掩盖了甚至丢失了不同研究方法之间的内在联系!由此,也反过来验证了科学观、方法论、研究模型、研究路径、基本概念和基本原理的重要性。

4.6 机制主义人工智能理论成功的最新旁证到此,本文不得不提及当今人工智能研究的一项最新发展,这就是著名的人工智能围棋程序AlphaGo。它的棋力已经众所周知,为了节约笔墨这里不再复述。为什么它能具有这么强大的棋力?这来源于它“不自觉地采纳了机制主义人工智能理论——人工智能3种方法应当互相和谐融合”作为自己的设计理念。

如前所述,在一定意义上,人工智能的历史就是结构主义、功能主义、行为主义三者之间互不认可各行其道的发展历史[18-22]。

但是,AlphaGo的设计者们却打破了这种陈规陋习,撇开了门户之见:本来,博弈是功能主义人工智能(专家系统)的分支,神经网络是结构主义人工智能的成果,但是他们却把结构主义人工智能(神经网络)的成果利用到功能主义人工智能分支来了,即一方面利用功能主义的博弈搜索技术去发现“可能的下步走法”;另一方面又用结构主义深层神经网络的深度学习方法(取代原来的“启发式估价函数”)来估算“这些可能走法之中何者胜算更大”。这一结合,就使AlphaGo的棋力得到极大提升!

显然,AlphaGo的胜利,就是机制主义人工智能理论的胜利!是机制主义人工智能理论成功的一个有力客观证据。虽然AlphaGo的设计者们并不知道“机制主义人工智能理论”,但是正确的理论和方法迟早会在不同的研究者之间产生共鸣和共行。

总之,本文遵循“只有高屋建瓴,才能势如破竹”的哲理,首先从人工智能理论研究的顶层(也是人工智能理论研究的“源头”和“龙头”)分析得出明确的结论:应当把物质科学的机械唯物科学观转变到信息科学的辩证唯物科学观,把物质科学的机械还原方法论转变到信息科学的信息生态方法论,才能实现人工智能理论研究的历史性转变与跨越。

进一步,本文遵循辩证唯物的科学观和信息生态方法论对人工智能的中层展开了研究,发现了体现信息生态规律(也正是智能生长机制)的“信息生态模型(也正是智能生长机制模型)”。据此得出结论:应当把“分而治之”的结构主义研究路径、功能主义研究路径、行为主义研究路径转变为统一的、以“信息–知识–智能”转换为标志的机制主义的研究路径,实现人工智能研究范式的根本性转变与突破。

最后,本文在辩证唯物科学观、信息生态方法论的指引下,依据所发现的智能研究的信息生态(智能生长机制)模型,沿着机制主义研究路径,重构了信息、感知、认知、知识、基础意识、情感、理智、决策等人工智能理论的基础概念,构建了“客体信息–语义信息”“语义信息–知识” “语义信息–智能策略”三大信息转换原理,建立了“感知–认知–决策”三者贯通且“基础意识–情感–理智”三位一体的崭新的机制主义人工智能理论,证明了原先互不沟通的结构主义人工智能理论(人工神经网络)、功能主义人工智能理论(物理符号系统/专家系统)、行为主义人工智能理论(感知动作系统/智能机器人)原来就是机制主义人工智能理论的3种和谐互补的特例,实现了人工智能理论的和谐统一。本文的创新研究结果与现有理论的相互对照也可简明列于表4。

表4中的对比清晰地显示,机制主义人工智能理论的建立,实现了对现有人工智能研究的颠覆性突破。具体地说:

1)颠覆了机械唯物科学观和机械还原方法论在人工智能研究中的统领地位;

| 表 4 颠覆性的突破、划时代的创新 Tab.4 Overturning breakthroughs and epoch-making innovations |

2)突破了现有人工智能研究模型(脑模型)的局限;

3)突破了现有人工智能研究路径(结构主义、功能主义和行为主义)的局限;

4)突破了现有人工智能基本概念(信息、知识和智能等基本概念)的局限;

5)从而突破了现有人工智能研究的“碎片化、浅层化、封闭化”的局限性。

与此同时,依据“辩证唯物科学观”,机制主义人工智能理论超越现有(基于工业时代物质科学的机械唯物科学观和机械还原方法论的)人工智能理论,创建了具有信息时代标志意义的以下成果:

1)人工智能的科学方法论 ——信息生态方法论;

2)人工智能的研究模型——主客互动演进模型;

3)人工智能的研究路径——机制主义研究路径;

4)人工智能的基础概念——语义信息、知识生态、基础意识、情感、综合决策等;

5)人工智能的基本原理——第一、第二、第三信息转换原理。

基于以上创新成果,本文的研究还发现和总结了意义重大的“信息转换与智能创生”定律,它是整个信息科学和智能科学领域通用的普适规律,即面对任何选定的问题和求解问题的目标,人工智能机器的任务就是执行“获取信息并通过相应的信息转换,生成解决问题的智能策略和智能行为”。这是与“质量转换与物质不灭定律”和“能量转换与能量守恒定律”同样重要(如果不是更为重要)的基本定律。

5 结束语必须指出,本文所建立的机制主义人工智能理论,在任何意义上都不局限于“人工”的智能理论,几乎所有的工作也都适合于“人类”的智能理论。只是限于目前国内外的科学研究水平,这里没有展开“人类发现问题和定义问题”能力的研究,这是“人类”智能理论特有的精彩篇章。因此,在人类选定问题的前提下,本文的理论既适用于人类智能,也适用于机器智能,是一种更深意义的“通用型”智能理论。

可以看出,现行人工智能理论(主要包括模式识别、自然语言处理、问题求解、博弈搜索、定理证明、检索咨询、机器学习等) 大体相当于本文4.3 节中3) 的①类的情形,既没有考虑(基础) 意识的反应,也没有考虑情感的反应,更没有考虑复杂的辩证问题求解,因此都是人工智能理论中相对容易处理的部分。而且,它的基础概念包括信息、知识和智能等,都存在巨大的局限性。

毋庸讳言,本文主要给出了通用人工智能理论的科学观、方法论、研究模型、研究路径、基础概念和基本原理体系,以此创建了机制主义人工智能理论基本体系,并没有解决通用人工智能研究的所有问题(特别是关于“如何发现问题和定义问题”的能力),同时也留下了难以计数的具体问题需要人们不断去研究和解决。可以肯定,随着人们对人工智能的研究越来越走向深入,新的更复杂更困难更有意义的问题还会接踵而至,对新的理论和方法也会产生越来越复杂的需求。所幸的是,有了正确的科学观、方法论、研究模型、研究路径、基础概念和基本原理,当面对那些层出不穷的新问题的时候就有了明确的科学观念、科学方法论、基本模型和路径以及坚实的理论基础去研究。

还要指出,在本文所论“主体客体互动演进模型”中,“客体”通常是“非生物”。如果“客体”是与“主体”具有同样等级的生物、甚至是多个具有同样等级的生物(比如都是人类),于是就构成了“社会”(比如人类社会)。在这种情况下,社会系统中的每个个体的模型依然可用本文所研究的“机制主义人工智能理论”来描述,但是在此基础上还需要考虑“各个个体之间的相互协调”,见涂序彦教授的著作《协调学》。

最后有必要强调,鉴于人工智能对于科学技术、经济社会、文化教育、国计民生以及国家安全的极度重要性,把发展智能科学技术作为国家整体发展的全局战略是完全必要的,也是十分紧迫的。

基于以上创新成果,本文的研究还发现和总结了意义重大的“信息转换与智能创生”定律,它是整个信息科学和智能科学领域通用的普适规律,即面对任何选定的问题和求解问题的目标,人工智能机器的任务就是执行“获取信息并通过相应的信息转换,生成解决问题的智能策略和智能行为”。这是与“质量转换与物质不灭定律”和“能量转换与能量守恒定律”同样重要(如果不是更为重要)的基本定律。

必须指出,本文所建立的机制主义人工智能理论,在任何意义上都不局限于“人工”的智能理论,几乎所有的工作也都适合于“人类”的智能理论。只是限于目前国内外的科学研究水平,这里没有展开“人类发现问题和定义问题”能力的研究,这是“人类”智能理论特有的精彩篇章。因此,在人类选定问题的前提下,本文的理论既适用于人类智能,也适用于机器智能,是一种更深意义的“通用型”智能理论。

可以看出,现行人工智能理论(主要包括模式识别、自然语言处理、问题求解、博弈搜索、定理证明、检索咨询、机器学习等)大体相当于本文4.3节中3)的①类的情形,既没有考虑(基础)意识的反应,也没有考虑情感的反应,更没有考虑复杂的辩证问题求解,因此都是人工智能理论中相对容易处理的部分。而且,它的基础概念包括信息、知识和智能等,都存在巨大的局限性。

毋庸讳言,本文主要给出了通用人工智能理论的科学观、方法论、研究模型、研究路径、基础概念和基本原理体系,以此创建了机制主义人工智能理论基本体系,并没有解决通用人工智能研究的所有问题(特别是关于“如何发现问题和定义问题”的能力),同时也留下了难以计数的具体问题需要人们不断去研究和解决。可以肯定,随着人们对人工智能的研究越来越走向深入,新的更复杂更困难更有意义的问题还会接踵而至,对新的理论和方法也会产生越来越复杂的需求。所幸的是,有了正确的科学观、方法论、研究模型、研究路径、基础概念和基本原理,当面对那些层出不穷的新问题的时候就有了明确的科学观念、科学方法论、基本模型和路径以及坚实的理论基础去研究。

还要指出,在本文所论“主体客体互动演进模型”中,“客体”通常是“非生物”。如果“客体”是与“主体”具有同样等级的生物、甚至是多个具有同样等级的生物(比如都是人类),于是就构成了“社会”(比如人类社会)。在这种情况下,社会系统中的每个个体的模型依然可用本文所研究的“机制主义人工智能理论”来描述,但是在此基础上还需要考虑“各个个体之间的相互协调”,见涂序彦教授的著作《协调学》。

最后有必要强调,鉴于人工智能对于科学技术、经济社会、文化教育、国计民生以及国家安全的极度重要性,把发展智能科学技术作为国家整体发展的全局战略是完全必要的,也是十分紧迫的。

| [1] |

钟义信. 信息科学原理[M]. 福州: 福建人民出版社, 1988.

( 0) 0)

|

| [2] |

MCCULLOCH W S, PITTS W. A logical calculus of the ideas immanent in nervous activity[J]. The bulletin of mathematical biophysics, 1943, 5(4): 115-133. DOI:10.1007/BF02478259 ( 0) 0)

|

| [3] |

ROSENBLATT F. The perceptron: a probabilistic model for information storage and organization in the brain[J]. Psychological review, 1958, 65(6): 386-408. DOI:10.1037/h0042519 ( 0) 0)

|

| [4] |

HOPFIELD J J. Neural networks and physical systems with emergent collective computational abilities[J]. Proceedings of the national academy of sciences of the United States of America, 1982, 79(8): 2554-2558. DOI:10.1073/pnas.79.8.2554 ( 0) 0)

|

| [5] |

KOHONEN T. The self-organizing map[J]. Proceedings of the IEEE, 1990, 78(9): 1464-1480. DOI:10.1109/5.58325 ( 0) 0)

|

| [6] |

KOSKO B. Adaptive bidirectional associative memories[J]. Applied optics, 1987, 26(23): 4947-4960. DOI:10.1364/AO.26.004947 ( 0) 0)

|

| [7] |

RUMELHART D E, MCCLELLAND J L. Parallel distributed processing[M]. Cambridge, MA, USA: MIT Press, 1986.

( 0) 0)

|

| [8] |

MCCARTHY J, MINSKY M L, ROCHESTER N, et al. Proposal for the Dartmouth summer research project on artificial intelligence[R]. Technology Report. Dartmouth: Dartmouth College, 1955.

( 0) 0)

|

| [9] |

SIMON H A. The sciences of the artificial[M]. Cambridge, MA, USA: MIT Press, 1969.

( 0) 0)

|

| [10] |

NEWELL A. Physical symbol systems[J]. Cognitive science, 1980, 4(2): 135-183. DOI:10.1207/s15516709cog0402_2 ( 0) 0)

|

| [11] |

TURING A M. Computing machinery and intelligence[J]. MIND, 1950, 59: 433-460. ( 0) 0)

|

| [12] |

NEWELL A, SIMON H A. GPS, a program that simulates human thought[M]//FEIGENBAUM E A, FELDMAN J. Computers and Thought. New York: McGraw-Hill, 1963: 279–293, .

( 0) 0)

|

| [13] |

FELGENBAUM E A. The art of artificial intelligence: themes and case studies of knowledge engineering[C]//Proceedings of the 5th International Joint Conference on Artificial Intelligence. Cambridge, USA, 1977: 1014–1029.

( 0) 0)

|

| [14] |

FEIGENBAUM E A, FELDMAN J. Computers and thought[M]. New York: McGraw-Hill, 1963.

( 0) 0)

|

| [15] |

NEWELL A, SIMON H A. Human problem solving[M]. Englewood Cliffs, NJ: Prentice-Hall, 1972.

( 0) 0)

|

| [16] |

NILSSON N J. Principles of artificial intelligence[M]. Berlin: Springer-Verlag, 1982.

( 0) 0)

|

| [17] |

MINSKY M. The society of mind[M]. New York: Simon and Schuster, 1986.

( 0) 0)

|

| [18] |

BROOKS R A. Intelligence without representation[J]. Artificial intelligence, 1991, 47(1/2/3): 139-159. ( 0) 0)

|

| [19] |

BROOKS R A. Elephant cannot play chess[J]. Autonomous robert, 1990, 6: 3015. ( 0) 0)

|

| [20] |

BROOKS R A. Engineering approach to building complete, intelligent beings[C]//Proceedings of the SPIE Intelligent Robots and Computer Vision VII. Boston, MA, United States, 1989: 618–625.

( 0) 0)

|

| [21] |

MINSKY M L, PAPERT S. Perceptron[M]. Cambridge: MIT Press, 1969.

( 0) 0)

|

| [22] |

PAPERT S. One AI or many?[J]. Daedalus, 1988, 117(1): 1-14. ( 0) 0)

|

| [23] |

RUSSELL S J, NORVIG P. Artificial intelligence: a modern approach[M]. Upper Saddle River: Pearson Education, Inc, 1995.

( 0) 0)

|

| [24] |

NILSSON N J. Artificial intelligence: a new synthesis[M]. San Francisco: Morgan Kaufmann Publishers, 1998.

( 0) 0)

|

| [25] |

钟义信. 高等人工智能原理——观念·方法·模型·理论[M]. 北京: 科学出版社, 2014.

( 0) 0)

|

| [26] |

钟义信. 信息科学与技术导论[M]. 第3版. 北京: 北京邮电大学出版社, 2015.

( 0) 0)

|

| [27] |

ZHONG Y X. The law of " information conversion and intelligence creation”[M]//BURGIN M HOFKIRCHNER W. Information Studies and the Quest for Transdisciplinarity. New York/London/Singapore: World Scientific, 2017: 165–190.

( 0) 0)

|

| [28] |

ZHONG Y X. A theory of semantic information[J]. China communications, 2017, 14(1): 1-17. ( 0) 0)

|

| [29] |

WANG P Z. A factor spaces approach to knowledge representation[J]. Fuzzy sets and systems, 1990, 36(1): 113-124. DOI:10.1016/0165-0114(90)90085-K ( 0) 0)

|

| [30] |

何华灿, 王华, 刘永怀, 等. 泛逻辑学原理[M]. 北京: 科学出版社, 2001. HE Huacan, WANG Hua, LIU Yonghuai, et al. Universal logics principle[M]. Beijing: Science Press, 2001. (  0) 0)

|

| [31] |

何华灿, 何智涛, 王华. 论第2次数理逻辑革命[J]. 智能系统学报, 2006, 1(1): 29-37. HE Huacan, HE Zhitao, WANG Hua. On the second revolution of mathematical logic[J]. CAAI transactions on intelligent systems, 2006, 1(1): 29-37. (  0) 0)

|

2018, Vol. 13

2018, Vol. 13