2. 北京交通大学 计算机与信息技术学院,北京 100044

2. School of Computer and Information Technology, Beijing Jiaotong University, Beijing 100044, China

近年来,随着互联网和信息行业的发展,全球已经进入了大数据时代。同时,数码设备的普及和社交网站的流行导致了社交图像爆炸式地增长,已经成为了一种重要的图像类型。Yahoo的社群图像分享网站Flickr、社交媒体网站Facebook、Google的社交视频分享网站、Youtube都是目前最具有代表性的社交网站。以Flickr为例,每分钟上传到网站上的图像超过两千张,每天上传到网站上的图像超过两百万张。据统计,社交网站Facebook平均每天新增图像数量超过1亿张,其总数量已经超过1 000亿张;Flickr图像总量超过了60亿张;图像分享移动应用Instagram图像数量超过10亿张。然而,相对于海量的图像数据,计算资源是有限的,如何对海量的图像进行有效的管理成了亟待解决的问题。显著性检测的相关研究和应用[1]带来了很好的解决方案。显著性检测就是让计算机模拟人类的视觉注意力机制,对处理的图像进行自动信息筛选,将有限的资源分配给重要信息,提高处理速度,提升资源利用率。显著性检测是多学科交叉的研究领域,涉及心理学、神经科学、生物视觉和计算机视觉等相关领域,有重要的理论价值和实际应用意义,是目前研究的热点。

本文关注社群图像的显著区域检测问题,目前对此领域的研究不多,主要贡献有:

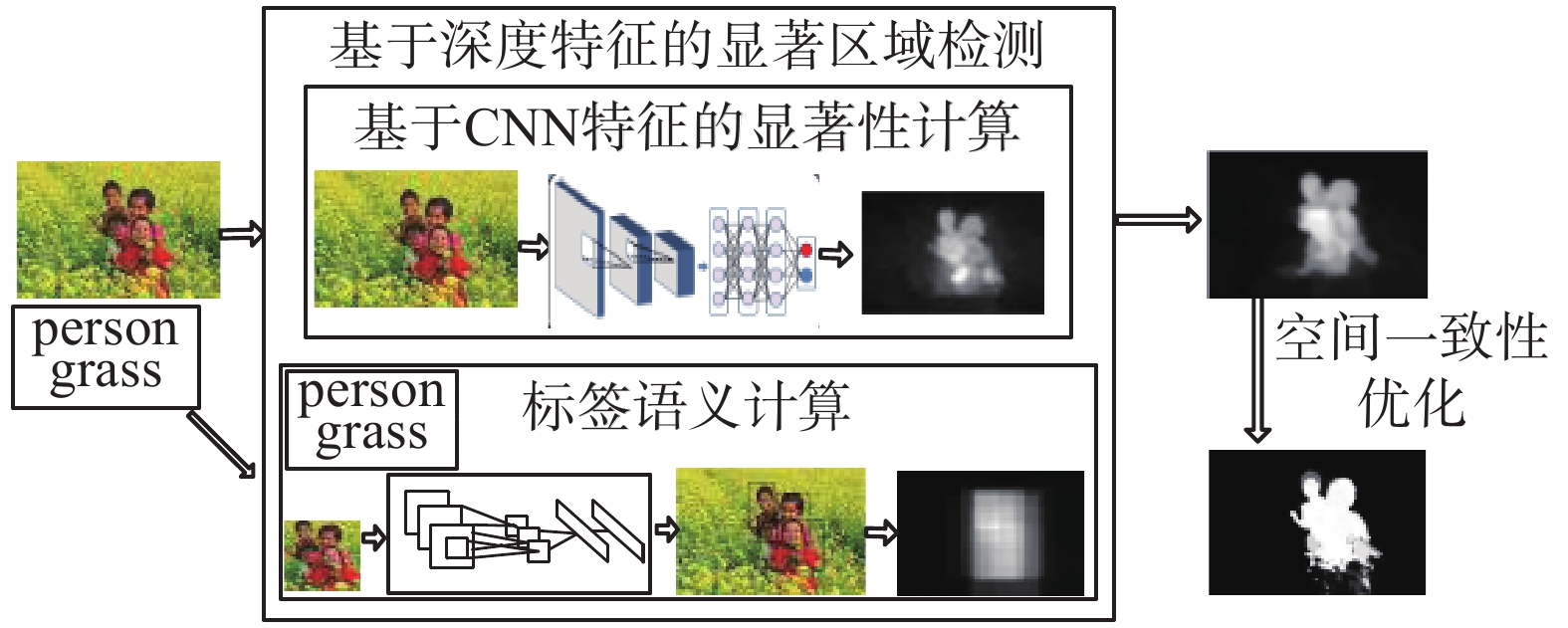

1) 提出了基于深度学习的显著区域检测方法。该方法针对社群图像带有标签的特点,采取两条提取线:基于CNN特征的显著性计算和基于标签的语义计算。较目前流行的检测方法,本文的检测精度有一定的提升。

2) 构建了面向社群图像的带有标签信息的显著性数据集,新建数据集来自于NUS-WIDE数据集中的多个类,包含多个标签、图像前景和背景差异性小,为面向社群图像的显著区域检测方法提供了新的实验数据。

1 相关工作在显著性快速发展的几十年里,涌现了大量的显著区域检测方法。随着GPU等硬件资源的发展和大规模训练图像集的涌现,基于深度神经网络的显著区域提取近年来受到广泛的关注。深度学习可以从大数据中自动学习特征的表示,学习得到的特征能够刻画问题内部本质结构,检测结果比基于人工设计特征的提取方法有较大的提高。伴随着显著区域检测方法的研究,也涌现了多个显著性数据集。就目前的研究现状来看,面向社群图像的显著区域检测方法目前的研究不多。

1.1 基于层次和深度结构的显著区域检测已有的研究显示了层次和深度体系结构对显著区域检测建模有重要的作用。文献[2]提出了层次结构进行显著区域检测,减少了小尺寸显著区域对检测结果的影响。文献[3]在检测显著区域之前将图像进行了多尺度分割,形成层次结构,取得了较好的检测效果。多层次显著性检测的优点是考虑了图像多尺度的特点,解决了单一分割的局限性,从一定程度上考虑了显著区域大小不一的现象。但是这些工作仍然存在缺陷,在计算显著性时采用的特征仍是人工设计的特征,并且划分层次的数量也很难有科学的解释。

随着研究的深入,研究人员将深度体系结构应用到显著区域检测中。文献[4]通过无监督的方法学习多个中层的滤波器集合进行局部的显著性检测,并且和卷积网络得到的中层检测结果进行融合。文献[5]采用卷积神经网络得到图像的多尺度特征,包括局部区域块、它的邻域区域块和整幅图像,进行显著区域的检测。文献[6]训练了两个深度卷积网络:一个用于检测局部显著图,另一个用于检测全局显著图,然后将两种显著图进行融合。文献[7]采用全局上下文信息和局部区域信息相融合的方法实现显著区域检测。深度学习除了具有层次结构之外,还能自动学习特征,学习到的特征明显优于人工设计的特征,正因如此,基于深度学习的方法已经在显著区域检测中取得了明显的效果。当然,基于深度学习的检测方法具有深度学习固有的缺点,比如网络结构尚且无法做出合理的解释、参数众多调节费时等缺点。

1.2 基于标签语义进行显著区域提取标签的语义虽然在图像标注领域已经得到了广泛应用,但是,标签信息通常和显著区域检测任务分开处理,在显著区域检测上的应用不多。

和本文工作最相关的是文献[8]和文献[9],均用到了标签信息。文献[8]将标签排序任务和显著区域检测任务整合在一起,迭代地进行标签排序和显著区域的检测任务;文献[9]提出Tag-Saliency模型,通过基于层次的过分割和自动标注技术进行标注。这两个工作的共同缺点是显著区域标注效果依赖于区域标注,采用的多示例学习方法不容易泛化;而且,二者均没有考虑标签之间的上下文关系。本文的工作和这两篇文献不同,是把标签的语义信息转化为RCNN特征。由于RCNN技术是基于卷积神经网络的,所以本文的方法更能改善检测性能。

1.3 显著性数据集从关于显著性数据集的相关文献来看,显著性数据集主要来自于两个领域:为了显著性研究而建立的数据集[2-3, 10-12];从图像分割领域延伸过来的显著性数据集[13-14]。这些数据集有的以矩形框方式进行显著区域标注,更多的是以像素级进行显著区域的标注,还有的通过眼动仪进行视点的标注。然而随着社群图像的快速增加,目前针对社群图像的带有标签信息的显著性数据集研究不多,本文针对此问题构建面向社群图像的显著性数据集。

2 基于深度学习的显著区域检测 2.1 方法流程本文提出的基于深度学习的显著区域检测方法针对社群图像带有标签的特点,系统框架中采取两条提取线:基于CNN特征的显著性计算和基于标签的语义计算,并将二者的结果进行融合,融合的显著图通过全连接的CRF模型进行一致性空间优化,获得最终显著图。主要处理流程如图1所示。

|

Download:

|

| 图 1 系统流程图 Fig. 1 System flow chart | |

在处理流程中,要解决的重点问题是如何提取图像的CNN特征、如何计算标签的语义特征。

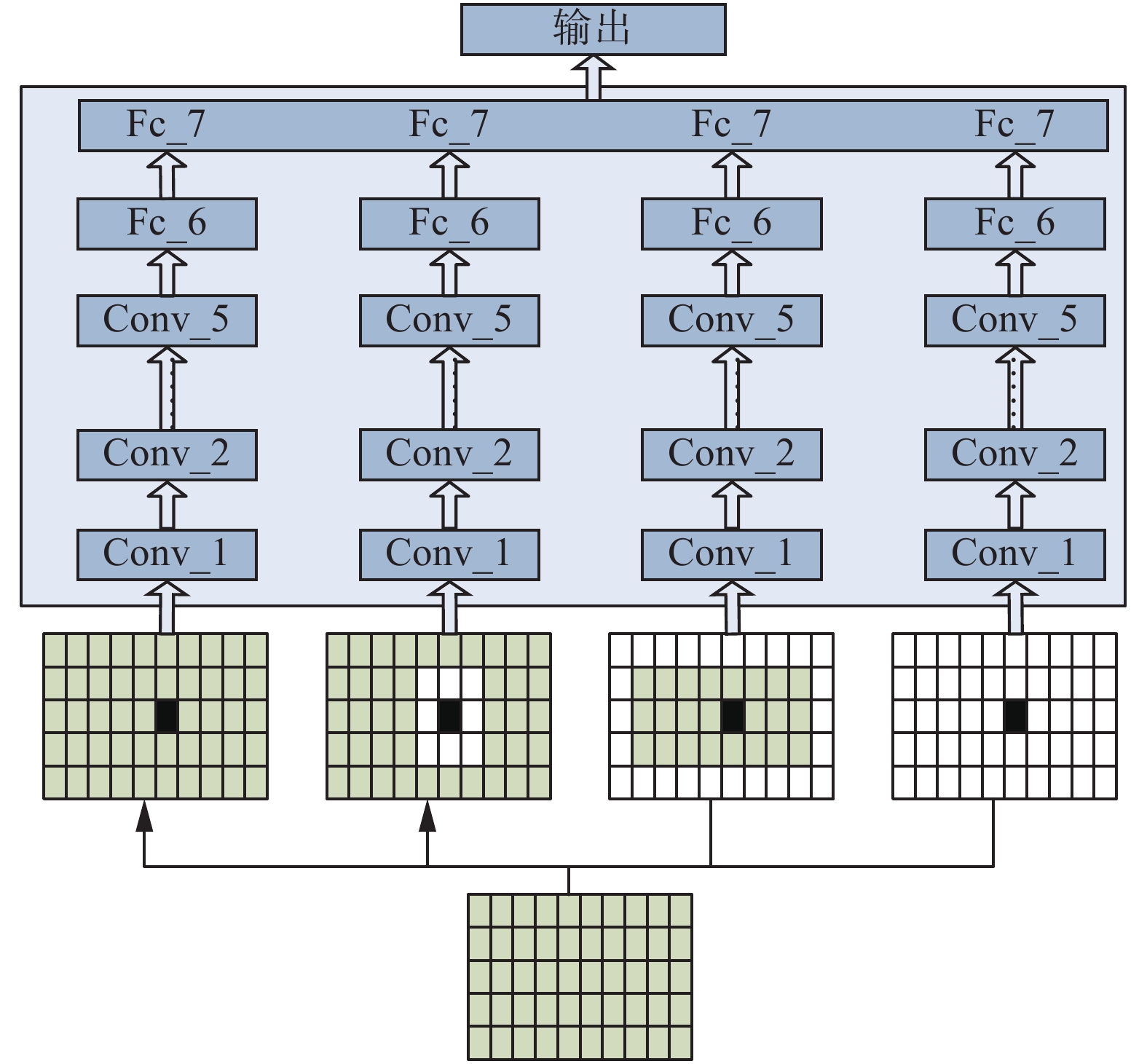

2.2 基于CNN特征的显著性计算 2.2.1 网络结构负责CNN特征提取的深度网络采用Hinton的学生Alex Krizhevsky在2012年ILSVRC竞赛中的8层卷积神经网络[15],包括5个卷积层、2个全连接层和1个输出层。网络结构如图2所示。网络的最下面为检测的图像,图像的上面表示要提取特征的区域。

|

Download:

|

| 图 2 网络结构 Fig. 2 Network structure | |

5个卷积层负责多尺度特征的提取,为了实现平移不变性,卷积层后面采用最大池化操作;特征自动学习的特征均包含4 096个元素;第1层全连接层和第2层全连接层后均通过修正线性单元ReLU(rectified linear units)进行非线性映射。修正线性单元ReLU[15]对每个元素进行如下操作:

| $R({x^i}) = \max (0,{x^i})$ | (1) |

式中

在输出层采用softmax回归模型得出图像块是否显著的概率。

2.2.2 网络训练与测试采用公开的Caffe[16]框架,利用研究工作[15]的网络参数进行初始化,然后利用来自目标数据集的图像对参数进行微调。

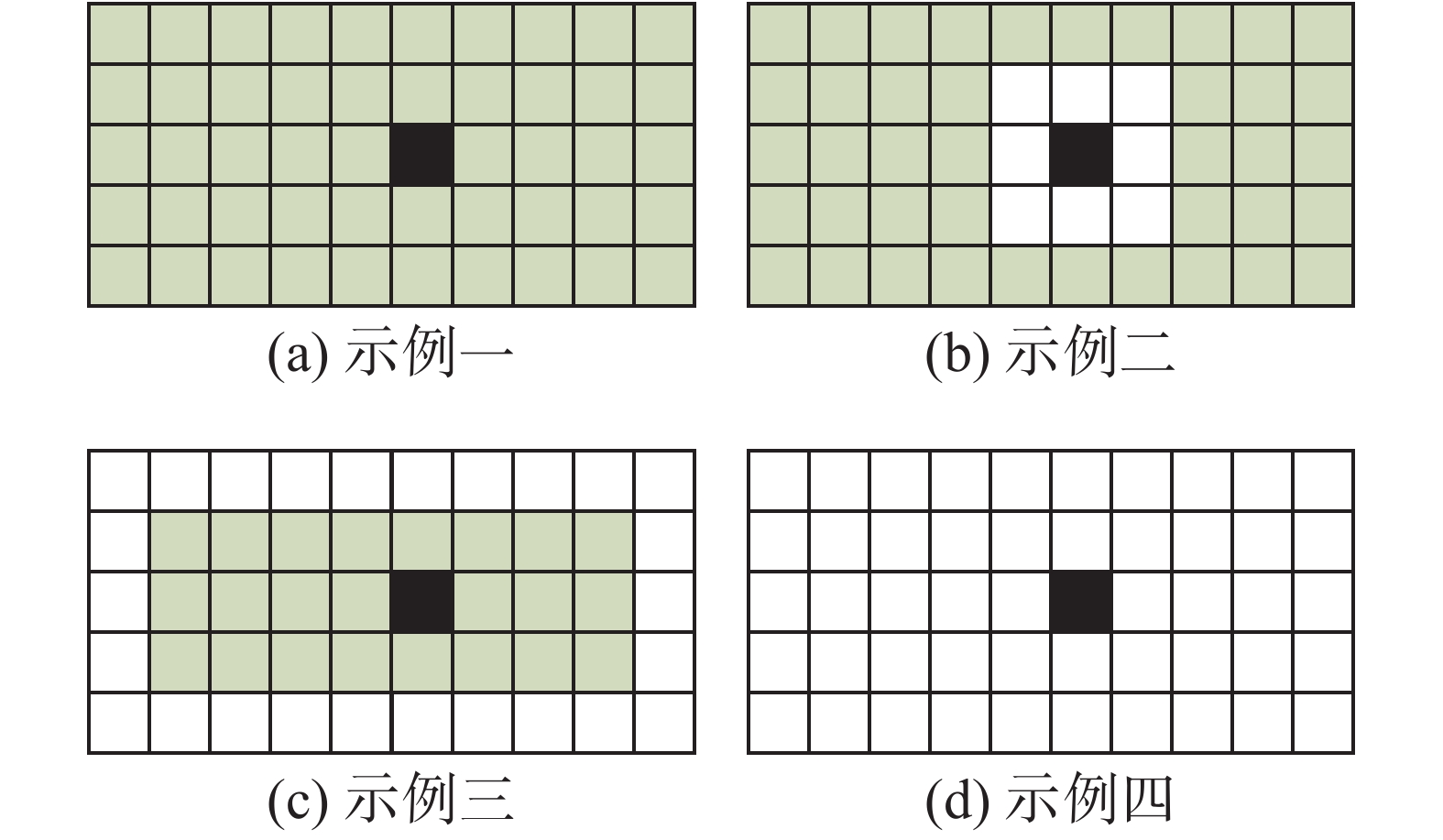

在图像中,显著区域具有独特性、稀缺性,和邻域具有明显差异的特点。受文献[5]启发,为了有效地计算显著性,本文考虑了3种图像区域块间的差异:图像块和邻域的差异;图像块和图像边界的差异;图像块和整幅图像的差异。在利用卷积神经网络特征提取时,提取了4种区域的特征:1)采样的矩形区域;2)矩形区域的邻接区域;3)图像的边界区域;4)图像中去除矩形区域的剩余区域。4种区域的示例图如图3所示。

|

Download:

|

| 图 3 4种区域示例图 Fig. 3 Four regional cases | |

图3(a)中的黑色区域代表当前区域;图3(b)中的白色区域代表黑色区域的相邻区域;图3(c)中的白色区域代表图像的边界区域;图3(d)中的白色色区域代表去掉黑色区域后的剩余区域。

对训练集中的每幅图像,采用滑动窗口方式进行采样,采样为51×51的区域块,采样步幅为10像素,得到用于网络训练的区域块,并采用和文献[4]相同的标注方法对采样区域块进行标注。如果图像块中至少70%的像素在基准二值标注中为显著,则这个图像块被标注为显著,否则标注为不显著。

利用这种标注策略,获得训练区域块的集合

| $L(\theta ) = - \frac{1}{m}\sum\limits_{i = 1}^m {\sum\limits_{j = 0}^1 {{{l}}\left\{ {{l_i} = j} \right\}} } \log P({l_i} = j|\theta ) + \lambda \sum\limits_{k = 1}^8 {\left\| {W_k^{}} \right\|} _F^2$ | (2) |

式中:

在测试的时候,通过卷积神经网络提取图像区域相关的4种特征,然后通过训练好的模型预测各个区域为显著区域的概率。

2.3 基于标签的语义特征计算图像的标签可以分为两大类:场景标签和对象标签。对象为图像中显著区域的可能性非常大。基于此,在基于标签的语义计算中关注对象标签。

估计一个区域属于特定对象的概率从一定程度上反映出此区域为显著区域的可能性。因此,区域属于特定对象的概率可看作显著性的先验知识。

RCNN技术是一种简单、可扩展的对象检测方法,基于卷积神经网络的,在图像分类、对象检测和图像分割等领域取得了优异的性能。本文采用RCNN[17]技术检测区域属于对象的概率。

标签语义特征计算的主要思路为利用RCNN抽取的特征计算每个像素的语义特征。

假设有X个对象检测子,对于第k个对象检测子,具体计算过程如下。

1) 选取最可能包含特定对象的N个矩形框;

2) 第i个矩形框包含特定对象的概率为

3) 第k个对象检测子检测完毕后,图像中的像素包含检测子对象的可能性

X个对象检测子都检测完毕后,每个像素得到X维特征。X维特征归一化后表示为

计算得到的基于标签的语义特征用于辅助显著性的计算。

2.4 显著图和标签语义图的融合假设基于CNN特征的显著图为SD,基于RCNN技术检测到的标签语义为T,二者融合如下。

| ${{ }}S = {S_{\!\!D}} \cdot \exp \left( T \right)$ | (3) |

式中S表示融合后的显著图。

在融合过程中,标签语义相当于先验,对显著值起到加权的作用。

2.5 空间一致性优化在图像分割领域,研究人员采用全连接的CRF模型对分割结果进行分割区域和边缘的平滑。借鉴文献[20]中的解决方法,本文采用全连接的CRF模型对显著图进行空间一致性优化。

能量函数定义如式(4):

| $S(L) = - \sum\limits_i {\log P({l_i})} + \sum\limits_{i,j} {{\theta _{ij}}} ({l_i} + {l_j})$ | (4) |

| $\begin{array}{c}{\theta _{i,j}} = u({l_i},{l_j})[{\omega _1}\exp ( - \displaystyle\frac{{{{\left\| {{{{p}}_i} - {{{p}}_j}} \right\|}^2}}}{{2\sigma _1^2}} - \displaystyle\frac{{{{\left\| {{{{I}}_i} - {{{I}}_j}} \right\|}^2}}}{{2\sigma _2^2}}) +\\{\omega _2}\exp ( - \displaystyle\frac{{{{\left\| {{{{p}}_i} - {{{p}}_j}} \right\|}^2}}}{{2\sigma _3^2}})]\end{array}$ | (5) |

当

本文从NUS-WIDE数据集采用如下筛选条件进行图像的筛选。

1) 显著区域和整幅图像的颜色对比度小于0.7;

2) 显著区域尺寸丰富,要求占整幅图像的比例覆盖10个等级,[0, 0.1)、[0.1, 0.2)、[0.2, 0.3)、[0.3, 0.4)、[0.4, 0.5)、[0.5, 0.6)、[0.6, 0.7)、[0.7, 0.8)、[0.8, 0.9)、[0.9, 1];

3) 至少有10%的图像中的显著区域和图像边界相连。

最终确定5 429幅图像作为数据集,来自于38个文件夹,包括carvings、castle、cat、cell_phones、chairs、chrysanthemums、classroom、cliff、computers、cooling_tower、coral、cordless cougar、courthouse、cow、coyote、dance、dancing、deer、den、desert、detail、diver、dock、close-up、cloverleaf、cubs、dall, dog、dogs、fish、flag、eagle、elephant、elk、f-16、facade、fawn。

3.2 图像标注矩形框级别的标注不能准确地定位对象边缘,标注结果不精确。本文采用像素级别的二值标注。

选取了5个观察者进行标注。不同用户标注结果通常存在不一致的现象。为了减少标注的不一致性,计算每个像素标注的一致性分值。

| ${{{s}}_{{x}}} = \frac{{\sum\limits_{p = 1}^N {} {{a}}_x^{(p)}}}{N}$ | (6) |

式中:

最后,两个观察者使用Adobe Photoshop手动从图像中分割出显著区域。

3.3 数据集的标签信息NUS-WIDE数据集提供了81个基准标签集。新构建的数据集标签来自于81个基准标签集,共78个标签。每幅图像包含1~9个标签。

4 实验 4.1 实验设置以本文构建的数据集为实验对象,选择20个对象标签,包括bear、birds、boats、buildings、cars、cat、computer、coral、cow、dog、elk、fish、flowers、fox、horses、person、plane、tiger、train、zebra;选取和对象标签相对应的20个对象检测子进行RCNN特征提取,选取2 000个包含对象概率最大的矩形框。

采用Cafffe框架[16]进行深度卷积神经网络的训练和测试。通过随机下降方法进行训练,每次迭代参与的样本数量(batch)为256;冲量值(momentum)为0.9;正则化项的权重为0.000 5;学习率初始值为0.01,当损失稳定的时候学习率以0.1的速度下降;对每层的输出采用比率为0.5的drop-out操作来防止过拟合;训练迭代次数为80次。

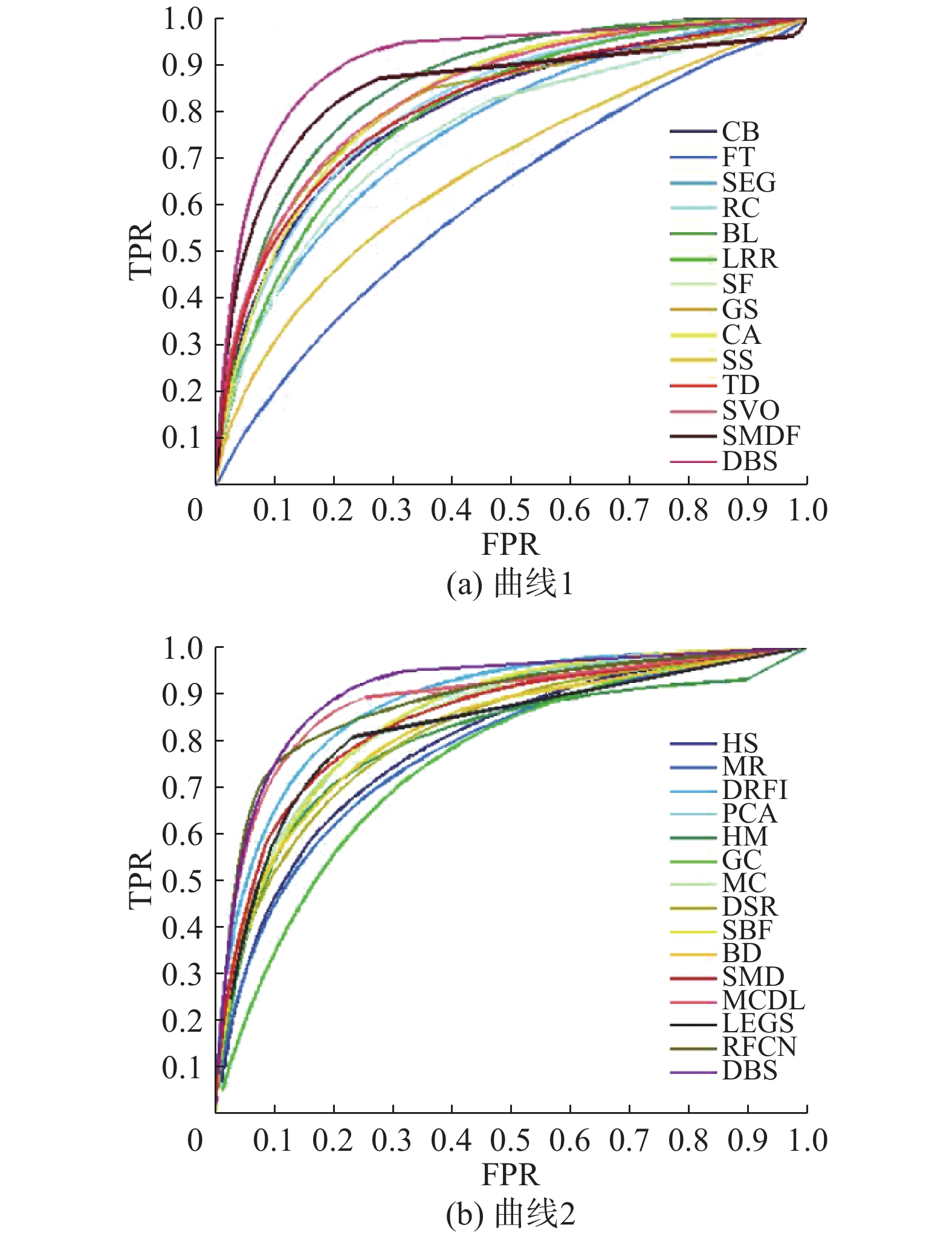

实验对比了27种流行的显著区域检测方法,包括HS[2]、DRFI[3]、SMDF[5]、LEGS[6]、MCDL[7]、FT[14]、BL[18]、RFCN[19]、CB[21]、SEG[22]、RC[23]、SVO[24]、LRR[25]、SF[26]、GS[27]、CA[28]、SS[29]、TD[30]、MR[31]、PCA[32]、HM[33]、GC[34]、MC[35]、DSR[36]、SBF[37]、BD[38]和SMD[37]。这些检测方法涵盖范围特别广泛。

本文的检测方法简称为DBS。

在定量的性能评价中,采用当前流行的性能评价指标:1)查准率和查全率曲线(PR曲线);2)F-measure值;3)受试者工作特征曲线(ROC Curve);4)AUC值(ROC曲线下面的面积);5)平均绝对误差(MAE)。

4.2 与流行方法的比较| 表 1 本文方法与27种流行方法的比较 Tab.1 Compare with 27 popular methods |

表1中,F_measure、AUC和MAE排在前3位的为4种目前流行的深度学习方法SMDF[5]、LEGS[6]、MCDL[7]、RFCN[19]和本文的DBS方法。在某种程度上可以说深度学习的检测方法超过了非深度学习的检测方法,精度上有所提高。其中,DBS方法的AUC值是最高的,DBS方法的F-measure值是最高的,DBS的MAE值是最低的,所以DBS方法的性能最佳。

PR曲线图和ROC曲线图如图4和5所示。DBS的PR曲线和ROC曲线均高于其他所有方法。

|

Download:

|

| 图 4 PR曲线图 Fig. 4 PR curves | |

|

Download:

|

| 图 5 ROC曲线图 Fig. 5 ROC curves | |

选择典型图像和27种流行方法进行视觉效果的对比,如图6所示。

27种流行方法的检测结果存在如下问题:1)存不完整的现象,如SMDF[5]、LRR[25]、GS[27];2)存在包含非显著区域的现象,如LEGS[6]、RFCN[19]、SS[29]、TD[30];3)存在边界模糊不清的现象,如SEG[22]、SVO[24]、SS[29];4)存在只高亮地显示边缘的现象,如CA[27]、PCA[31]。此外,流行的深度学习检测方法的检测性能也不尽相同,原因在于输入到到网络图像块的上下文信息不同,学习到的特征不一样,导致对比度的计算结果也不同。

本文方法综合考虑了CNN深度特征和标签语义特征,保证了本文方法得到的显著区域相对完整、均匀高亮。

|

Download:

|

| 图 6 DBS 方法与27种流行方法的视觉效果比较图 Fig. 6 Visual comparison between DBS with 27 popular methods | |

图6中图像出现的顺序为:原始图像、标准二值标注、BL[18]、CA[28]、CB[21]、DRFI[3]、DSR[36]、FT[14]、GC[34]、GS[27]、HM[33]、HS[2]、LEGS[6]、LRR[25]、MC[35]、MCDL[7]、MR[31]、PCA[32]、BD[38]、RC[23]、RFCN[19]、SBF[27]、SEG[22]、SF[26]、SMD[37]、SMDF[5]、SS[29]、SVO[24]、TD[30]、DBS。

5 结束语本文提出了基于深度学习的显著区域检测方法,该方法面向带有标签的社群图像,将标签信息纳入到显著区域的提取方法中。基于深度学习的特征包括CNN特征和标签特征。此外,随着社群图像的快速发展,文本构建了面向社群图像的带有标签信息的显著性数据集,为面向社群图像的显著区域检测研究提供了新的实验数据。大量的实验证明了所提方法的有效性。

| [1] |

XIAO Chuanmin, SHI Zelin, XIA Renbo, et al. Edge-detection algorithm based on visual saliency[J]. Information and control, 2014, 43(1): 9-13. ( 0) 0)

|

| [2] |

YAN Qiong, XU Li, SHI Jianping, et al. Hierarchical saliency detection[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Portland, OR, USA, 2013: 1155–1162.

( 0) 0)

|

| [3] |

JIANG Huaizu, WANG Jingdong, YUAN Zejian, et al. Salient object detection: a discriminative regional feature integration approach[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Portland, OR, USA, 2013: 2083–2090.

( 0) 0)

|

| [4] |

LIN Yuetan, KONG Shu, WANG Donghui, et al. Saliency detection within a deep convolutional architecture[C]//Workshops at the 28th AAAI Conference on Artificial Intelligence. Québec City, Canada, 2014.

( 0) 0)

|

| [5] |

LI Guanbin, YU Yizhou. Visual saliency based on multiscale deep features[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston, MA, USA, 2015: 5455–5463.

( 0) 0)

|

| [6] |

WANG Lijun, LU Huchuan, RUAN Xiang, et al. Deep networks for saliency detection via local estimation and global search[C]//Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston, MA, USA, 2015: 3183–3192.

( 0) 0)

|

| [7] |

ZHAO Rui, OUYANG Wanli, LI Hongsheng, et al. Saliency detection by multi-context deep learning[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA, 2015: 1265–1274.

( 0) 0)

|

| [8] |

WANG Wen, LANG Congyan, FENG Songhe. Contextualizing tag ranking and saliency detection for social images[M]//LI Shipeng, EL SADDIK A, WANG MENG, et al. Advances in Multimedia Modeling. Berlin Heidelberg, Germany: Springer, 2013: 428–435.

( 0) 0)

|

| [9] |

ZHU Guokang, WANG Qi, YUAN Yuan. Tag-saliency: combining bottom-up and top-down information for saliency detection[J]. Computer vision and image understanding, 2014, 118: 40-49. DOI:10.1016/j.cviu.2013.07.011 ( 0) 0)

|

| [10] |

LIU Tie, SUN Jian, ZHENG Nanning, et al. Learning to detect a salient object[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Minneapolis, Minnesota, USA, 2007: 1–8.

( 0) 0)

|

| [11] |

LI Jian, LEVINE M D, AN Xiangjing, et al. Visual saliency based on scale-space analysis in the frequency domain[J]. IEEE transactions on pattern analysis and machine intelligence, 2013, 35(4): 996-1010. DOI:10.1109/TPAMI.2012.147 ( 0) 0)

|

| [12] |

MARTIN D, FOWLKES C, TAL D, et al. A database of human segmented natural images and its application to evaluating segmentation algorithms and measuring ecological statistics[C]//Proceedings of the 8th IEEE International Conference on Computer Vision. Vancouver, BC, USA, 2001, 2: 416–423.

( 0) 0)

|

| [13] |

BATRA D, KOWDLE A, PARIKH D, et al. iCoseg: Interactive co-segmentation with intelligent scribble guidance[C]//Proceedings of the 2010 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). San Francisco, CA, USA, 2010: 3169–3176.

( 0) 0)

|

| [14] |

ACHANTA R, HEMAMI S, ESTRADA F, et al. Frequency-tuned salient region detection[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Miami, FL, USA, 2009: 1597–1604.

( 0) 0)

|

| [15] |

JIA Yangqing, DEVELOPER L, SHELHAMER E. Caffe [N/OL]. [2016-11-12]. http://caffe.berkeleyvision.org/, 2013.

( 0) 0)

|

| [16] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe, Nevada, USA, 2012: 1097–1105.

( 0) 0)

|

| [17] |

GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Columbus, OH, USA, 2014: 580–587.

( 0) 0)

|

| [18] |

TONG Na, LU Huchuan, RUAN Xiang, et al. Salient object detection via bootstrap learning[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston, MA, USA, 2015: 1884–1892.

( 0) 0)

|

| [19] |

WANG Linzhao, WANG Lijun, LU Huchuan, et al. Saliency detection with recurrent fully convolutional networks[C]//Proceedings of the 14th European Conference Computer Vision–ECCV 2016. Cham, Germany, 2016: 151–157.

( 0) 0)

|

| [20] |

KRÄHENBÜHL P, KOLTUN V. Efficient inference in fully connected CRFs with Gaussian edge potentials[C]//Proceedings of the 24th International Conference on Neural Information Processing Systems. Granada, Spain, 2012: 109–117.

( 0) 0)

|

| [21] |

JIANG Huaizu, WANG Jingdong, YUAN Zejian, et al. Automatic salient object segmentation based on context and shape prior[C]//Proceedings of the British Machine Vision Conference (BMVC). Dundee, Scotland, 2011: 1–12.

( 0) 0)

|

| [22] |

RAHTU E, KANNALA J, SALO M, et al. Segmenting salient objects from images and videos[C]//Proceedings of the 11th European Conference on Computer Vision (ECCV). Crete, Greece, 2010: 366–379.

( 0) 0)

|

| [23] |

CHENG Mingming, ZHANG Guoxin, MITRA N J, et al. Global contrast based salient region detection[C]//Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition. Providence, RI, USA, 2011: 409–416.

( 0) 0)

|

| [24] |

CHANG K Y, LIU T L, CHEN H T, et al. Fusing generic objectness and visual saliency for salient object detection[C]//Proceedings of the 2011 IEEE International Conference on Computer Vision (ICCV). Barcelona, Spain, 2011: 914–921.

( 0) 0)

|

| [25] |

SHEN Xiaohui, WU Ying. A unified approach to salient object detection via low rank matrix Recovery[C]//Proceedings of the 2012 IEEE International Conference on Computer Vision and Pattern Recognition (CVPR). Providence, Rhode Island, USA, 2011: 853–860.

( 0) 0)

|

| [26] |

PERAZZI F, KRÄHENBUHL P, PRITCH Y, et al. Saliency filters: contrast based filtering for salient region detection[C]//Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Providence, Rhode Island, USA, 2012: 733–740.

( 0) 0)

|

| [27] |

WEI Yichen, WEN Fang, ZHU Wangjiang, et al. Geodesic saliency using background priors[C]//Proceedings of the 12th European Conference on Computer Vision (ECCV). Florence, Italy, 2012: 29–42.

( 0) 0)

|

| [28] |

GOFERMAN S, ZELNIK-MANOR L, TAL A. Context-aware saliency detection[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR). San Francisco, CA, USA, 2010: 2376–2383.

( 0) 0)

|

| [29] |

HOU Xiaodi, HAREL J, KOCH C. Image signature: highlighting sparse salient regions[J]. IEEE transactions on pattern analysis and machine intelligence, 2012, 34(1): 194-201. DOI:10.1109/TPAMI.2011.146 ( 0) 0)

|

| [30] |

SCHARFENBERGER C, WONG A, FERGANI K, et al. Statistical textural distinctiveness for salient region detection in natural images[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Portland, Oregon, USA, 2013: 979–986.

( 0) 0)

|

| [31] |

YANG Chuan, ZHANG Lihe, LU Huchuan, et al. Saliency detection via graph-based manifold ranking[C]//Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Portland, OR, USA, 2013: 3166–3173.

( 0) 0)

|

| [32] |

MARGOLIN R, TAL A, ZELNIK-MANOR L. What makes a patch distinct?[C]//Proceedings of 2013 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Portland, OR, USA, 2013: 1139–1146.

( 0) 0)

|

| [33] |

LI Xi, LI Yao, SHEN Chunhua, et al. Contextual hypergraph modeling for salient object detection[C]//Proceedings of the 2013 IEEE International Conference on Computer Vision (ICCV). Sydney, NSW, Australia, 2013: 3328–3335.

( 0) 0)

|

| [34] |

CHENG Mingming, WARRELL J, LIN Wenyan, et al. Efficient salient region detection with soft image abstraction[C]//Proceedings of the 2013 IEEE International Conference on Computer Vision (ICCV). Sydney, Australia, 2013: 1529–1536.

( 0) 0)

|

| [35] |

JIANG Bowen, ZHANG Lihe, LU Huchuan, et al. Saliency detection via absorbing Markov chain[C]//Proceedings of the 2013 IEEE International Conference on Computer Vision (ICCV). Sydney, NSW, Australia, 2013: 1665–1672.

( 0) 0)

|

| [36] |

LI Xiaohui, LU Huchuan, ZHANG Lihe, et al. Saliency detection via dense and sparse reconstruction[C]//Proceedings of the 2013 IEEE International Conference on Computer Vision. Washington, DC, USA, 2013: 2976–2983.

( 0) 0)

|

| [37] |

PENG H, LI B, LING H, et al. Salient object detection via structured matrix decomposition[J]. IEEE transactions on pattern analysis & machine intelligence, 2017, 39(4): 818-832. ( 0) 0)

|

| [38] |

ZHU Wangjiang, LIANG Shuang, WEI Yichen, et al. Saliency optimization from robust background detection[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Columbus, OH, USA, 2014: 2814–2821.

( 0) 0)

|

2018, Vol. 13

2018, Vol. 13