人脸识别作为一项日趋成熟的生物特征识别技术,广泛应用于安防、金融、教育、交通、行政等领域。在人脸识别中,光照变化一直是影响人脸识别结果的重要因素之一。不同光照条件下的同一个人的图像差异巨大,有时甚至大于两个不同的人的图像。传统方法如主成分分析[1](principal component analysis, PCA)、局部Gabor特征匹配[2]、支持向量机[3]等,无法消除光照带来的图像差异[4]。

为了解决这个问题,人们提出了许多方法,大致可分为4类。第1类方法使用传统的图像处理方法,如直方图均衡[5](histogram equalization, HE)、Gamma校正、对数变换、同态滤波等方法,来消除光照差异。这类方法不考虑物理光照模型,因此效果有限。第2类方法从图像中提取对光照不敏感的特征作为人脸图像的特征,如局部二值模式[6]、局部三值模式[7]、梯度方向直方图[8]、增强局部纹理特征[9]。第3类方法尝试利用不同光照下的人脸图像样本来建立人脸模型,如光照锥模型法[10]、3-D形变模型[11]以及球面谐波模型法[12]。第4类方法尝试寻找光照不变的人脸图像表征方法,如单尺度Retinex方法[13]、Gradientface[14]、自商图[15](self-quotient image,SQI)、Weber-face[16]以及基于小波变换的方法[17-18]。C. Chen等[19]将引导滤波[20](guided image filter)引入人脸图像的光照补偿中,提出了边缘弱化引导滤波(edge-weakening guided image filter,EWGIF),并将人脸图像经EWGIF处理后的图像作为自商图中平滑图,利用自商图得到光照补偿图像,取得了良好的效果。

本文在C. Chen等工作的基础上,提出了一种基于加权EWGIF的人脸图像光照补偿方法。首先构造一个可区分边缘细节的惩罚项来代替引导滤波中的常数惩罚项;接着以正面光照下的训练样本的类间平均脸作为正面光照模型,使用该光照模型生成一个加权系数对惩罚项进行加权;最终通过自商图获得在人脸识别过程中更具区分度的人脸图像。

1 基于EWGIF的人脸光照补偿本节首先简要介绍文献[19]中获得光照补偿图像的自商图[15]方法,然后介绍引导滤波[20],文献[19]在该方法的基础上提出了EWGIF,用以计算自商图中的平滑图,最后介绍EWGIF方法,并分析了其中的不足之处。

1.1 自商图自商图是一种简单而高效的图像光照补偿方法,它是指输入图像及其平滑图的比值,即

| $Q = \frac{I}{{\hat I}}$ | (1) |

式中:

引导滤波是一种局部线性图像滤波,在实现平滑滤波的同时具有良好的边缘保持性能。引导滤波建立在两个模型的基础上。

模型1 假设输出图像

| $Z(i) = {\alpha _k}G(i) + {\beta _k},\forall i \in {\omega _r}(k)$ | (2) |

式中:

模型2 假设输出图像

| $Z(i) = I(i) - n(i)$ | (3) |

式中

为了在维持式(2)成立的同时最小化

| $E({\alpha _k},{\beta _k}) = \sum\limits_{i \in {\omega _r}(k)} {\left[ {{{\left( {{\alpha _k}G(i) + {\beta _k} - I(i)} \right)}^2} + \varepsilon \alpha _k^2} \right]} $ | (4) |

式中

由于每个像素点都被多个窗所覆盖,故每个像素点都对应多组线性变换系数

| $Z(i) = {\bar \alpha _i}G(i) + {\bar \beta _i}$ | (5) |

其中

| ${\bar \alpha _i} = \frac{1}{{\left| {{\omega _r}(i)} \right|}}\sum\limits_{q \in {\omega _r}(i)} {{\alpha _q}} $ | (6) |

| ${\bar \beta _i} = \frac{1}{{\left| {{\omega _r}(i)} \right|}}\sum\limits_{q \in {\omega _r}(i)} {{\beta _q}} $ | (7) |

文献[19]中使用引导滤波的输出图像

| $E({\alpha _k},{\beta _k}) = \sum\limits_{i \in {\omega _r}(k)} {\left[ {{{\left( {{\alpha _k}G(i) + {\beta _k} - I(i)} \right)}^2} + \lambda (k)\alpha _k^2} \right]} $ | (8) |

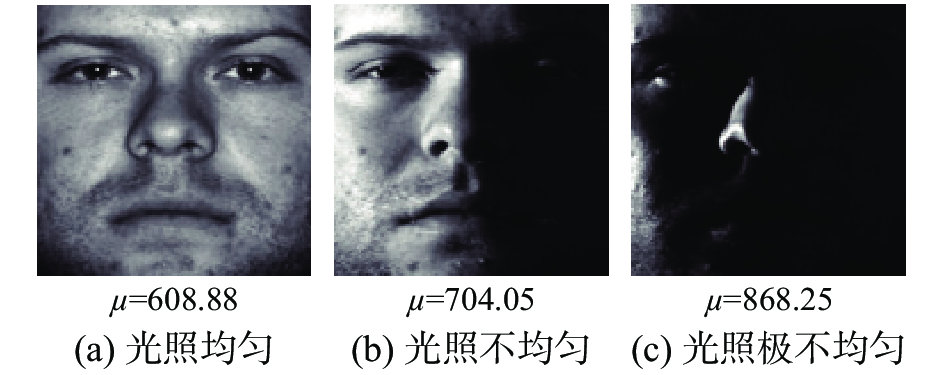

这使得引导滤波能根据图像的局部方差,自动调节平滑等级。EWGIF虽然具有区分边缘的能力,但并不是所有的边缘细节都能被看作人脸特征,算法对于不属于人脸特征的边缘细节不做特殊处理。如图1所示,圆圈标记出的明暗交界处是光照影响产生的,应归为噪声,但因其局部方差较大,也会被算法视作边缘细节。这会在一定程度上影响人脸识别的准确率。

|

Download:

|

| 图 1 EWGIF将光照产生的噪声视作边缘细节 Fig. 1 EWGIF with regard to the noise caused by the illumination as edge | |

为了解决这个问题,本文提出加权EWGIF算法来弥补EWGIF的不足。

2 加权EWGIF 2.1 加权惩罚项同文献[19]一样,本文方法在使用引导滤波时,假设输入图像

| $\xi (k) = W(k)\mu \sigma _1^2(k)$ | (9) |

此时式(4)变为

| $E({\alpha _k},{\beta _k}) = \sum\limits_{i \in {\omega _r}(k)} {\left[ {{{\left( {{\alpha _k}G(i) + {\beta _k} - I(i)} \right)}^2} + \xi (k)\alpha _k^2} \right]} $ | (10) |

式(10)是一个线性岭回归模型[21],易得其解

| ${\alpha _k} = \frac{{\sigma _r^2(k)}}{{\sigma _r^2(k) + \xi (k)}}$ | (11) |

| ${\beta _k} = (1 - \,{\alpha _k}){\mu _r}(k)$ | (12) |

式(9)第1项

| $\mu = \frac{1}{N}\sum\limits_{q = 1}^N {\left( {\frac{1}{{\sigma _1^2(q) + c}}} \right)} $ | (13) |

式中

|

Download:

|

|

图 2 光照条件不同时对应式(9)中

|

|

式(9)第3项

|

Download:

|

|

图 3 一幅图像中不同区域对应式(9)中

|

|

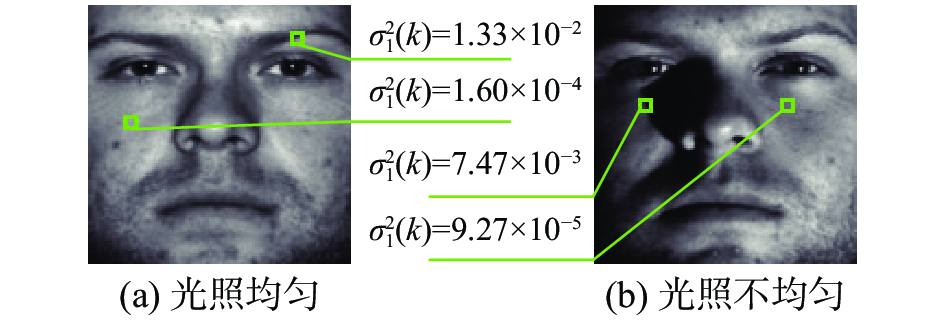

式(9)中第2项

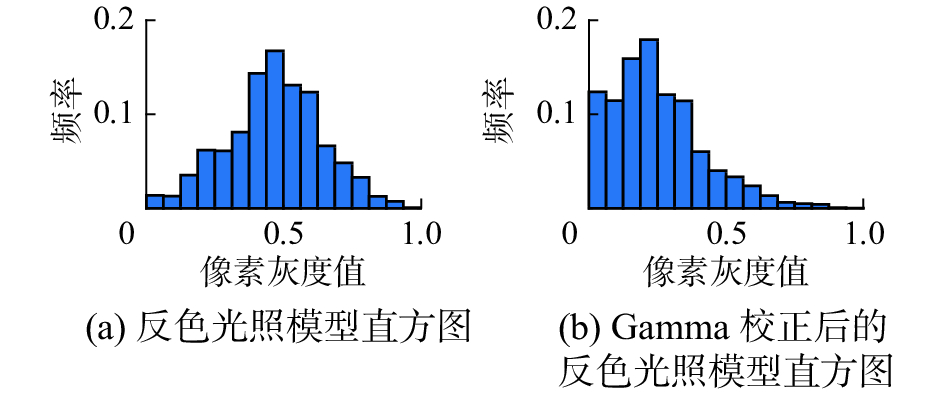

本文使用人脸在正面光照条件下图像的光照部分

| $L(k) = {\rm{gaussian}}\left( {\frac{1}{M}\sum\limits_{m = 1}^M {{T_m}} (k)} \right)$ | (14) |

式中:

|

Download:

|

| 图 4 光照模型 Fig. 4 Illumination model | |

在滤波过程中,某一区域的惩罚项越大,其平滑等级越高,经过自商图方法处理后该区域的边缘细节也越明显;该区域惩罚项越小,其平滑等级越低,经过自商图方法处理后该区域更趋向于平滑。故为了弱化光照造成的人脸平滑部分图像的细节噪声,需减小滤波过程中这些区域的平滑等级,即减小这些区域的惩罚项。同时,为了维持人脸特征不被弱化,对于包含人脸特征的细节区域,其惩罚项需要增大或维持不变。

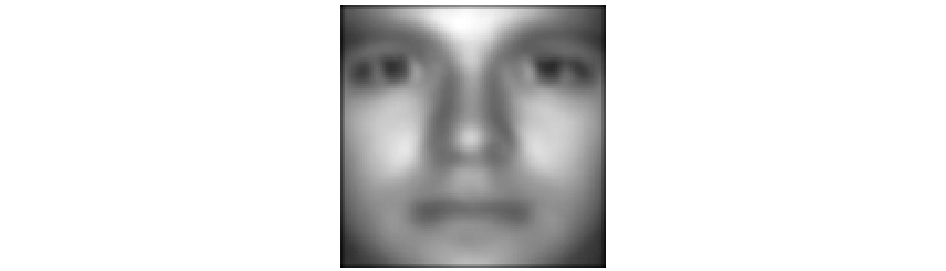

为了满足上述条件,加权系数

|

Download:

|

|

图 5 对L分别作反色和反色+Gamma校正后图像的直方图

Fig. 5 Histogram of

|

|

最终根据如上分析,本文构造加权系数

| $W(k) = \delta {\left( {1 - L(k)} \right)^2}$ | (15) |

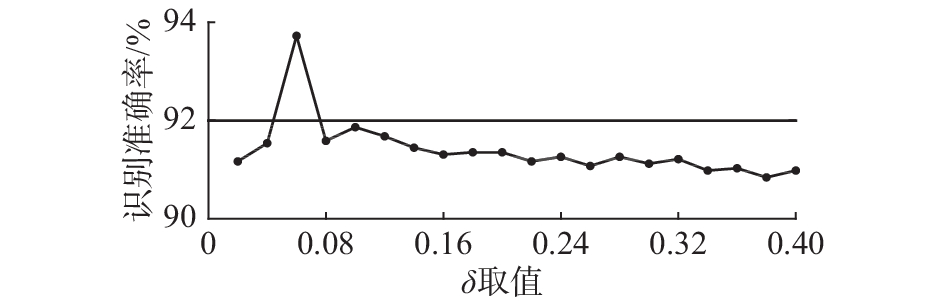

式中

本文算法的具体流程如下。

输入 正面光照人脸图像

输出 光照补偿后图像

1) 按式(14)由

2) 取窗口半径为1,计算

3) 将

4) 将

5) 将算法的输入图像

上述算法的时间复杂度为

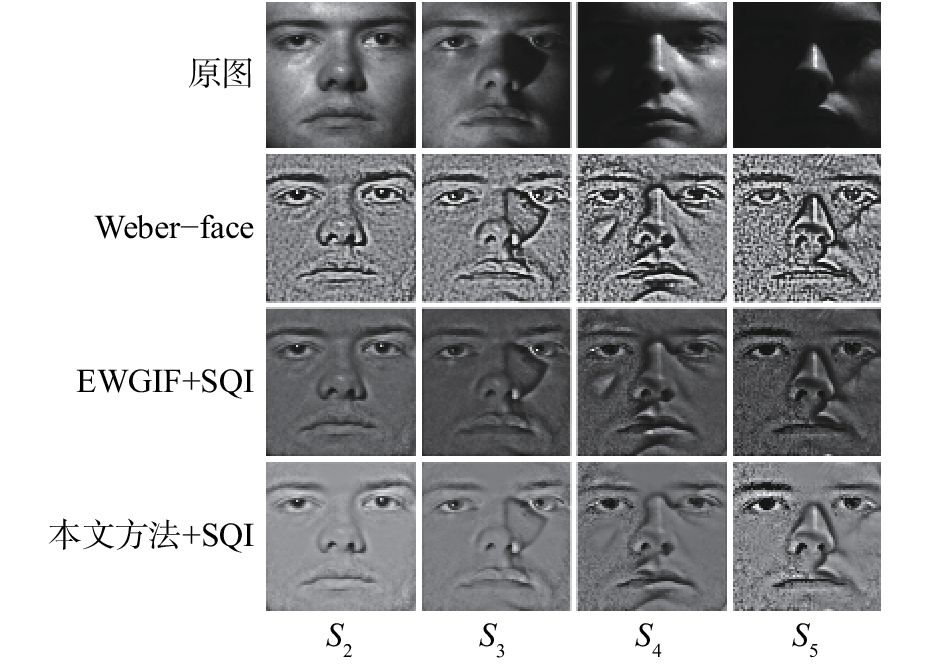

本文首先在Extended Yale B数据库上进行了光照补偿实验,并与EWGIF+SQI方法[19]做了对比。接着在CMU-PIE和Extended Yale B这两个数据库上进行了人脸识别实验,并与原图、HE[5]、Weber-face[16]、EWGIF+SQI做对比。Weber-face方法使用文献[16]推荐参数,EWGIF中的常数系数

Extended Yale B中包含了38张人脸在64种光照条件下的图像,本文按照拍摄时光源方向与摄像机方向的夹角,将数据库分为5个子集(S1~S5):0°~12°为S1,13°~25°为S2,26°~50°为S3,51°~77°为S4,大于78°为S5。

图6展示了本文方法和EWGIF分别结合的SQI方法,以及Weber-face对Extended Yale B数据库进行光照补偿后的结果。由图6可以看到,S3、S4、S5样本中由光照造成的明暗交界区域,在EWGIF和Weber-face中没有做特别处理;而在本文方法中,这些区域被弱化,在S4中体现尤为明显。S2图像由于光照比较接近正面光照,本文方法和EWGIF方法的实验结果相近。

|

Download:

|

| 图 6 不同方法对Extended Yale B数据库做光照补偿的结果 Fig. 6 Illumination compensation result with different approaches on the face images in the Extended Yale B database | |

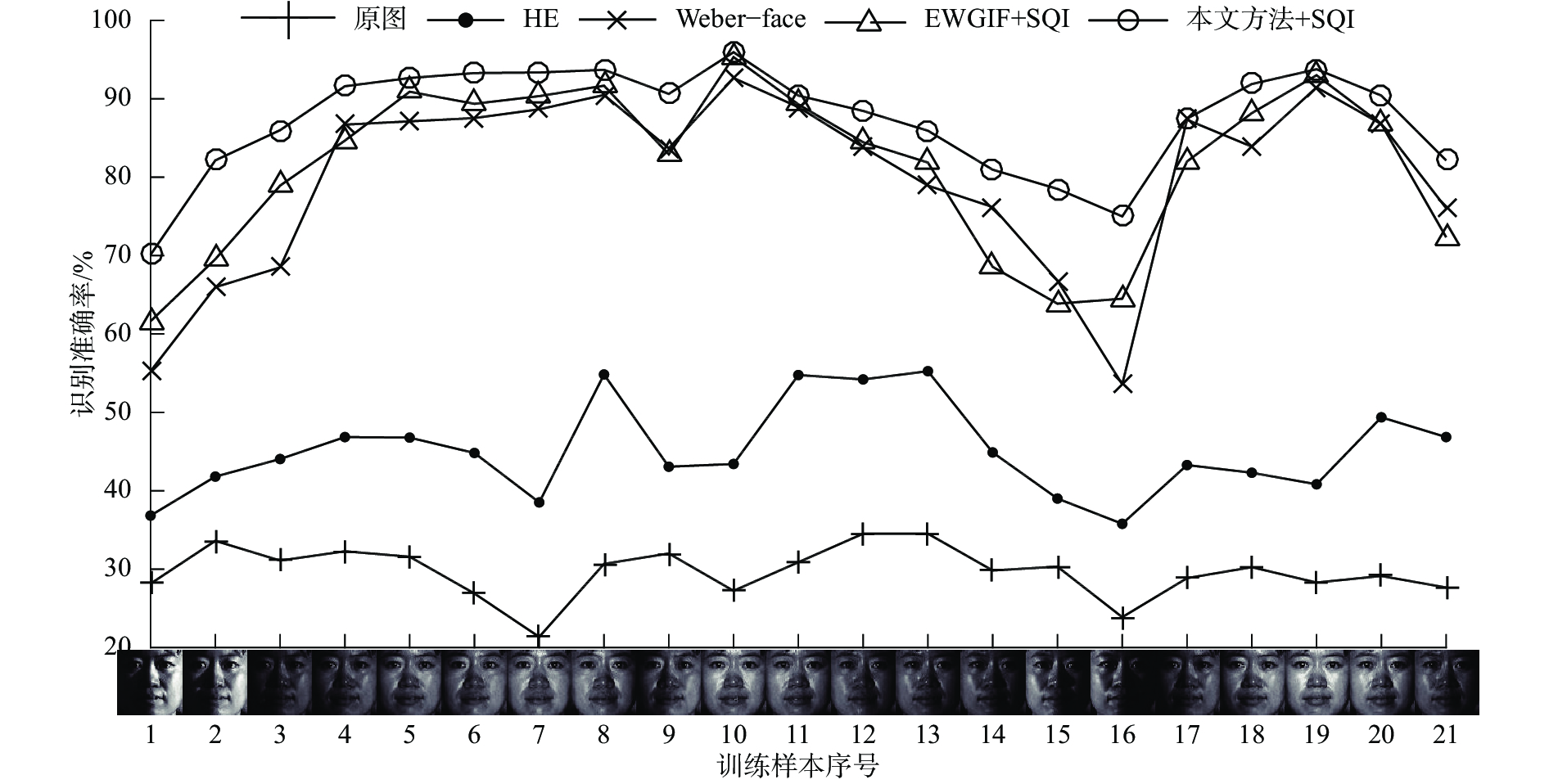

本文在CMU-PIE的光照子集(“C27”)上进行测试,其中包含了68个人脸在21种光照条件下的图像。本文每次使用1种光照下的图像作为训练样本,其余20种光照下的图像作为测试样本。

图7展示了不同方法在CMU-PIE上的识别准确率,可以看到,本文方法明显优于原图和HE,较Weber-face提升了约7.3%的平均识别准确率;且在不同光照条件的图片作为训练样本时,相较于EWGIF,本文方法的识别准确率都得到了不同程度的提升。从表1可以看出,本文方法的平均识别准确率在EWGIF+SQI的基础上提升了约5.9%。

|

Download:

|

| 图 7 不同方法在CMU-PIE上的识别准确率 Fig. 7 Recognition rates on CMU-PIE with different approaches | |

| 表 1 不同方法在CMU-PIE上的平均识别准确率 Tab.1 Average recognition rates on CMU-PIE with different approaches |

本文使用Extended Yale B中的子集S1作为训练样本,另外4个子集作为测试样本,进行人脸识别实验。

图8展示了穷举搜索常数系数

表2展示了不同方法在Extended Yale B中的每个子集(不包含作为训练集的S1)上的识别准确率及平均识别准确率,可以看到,本文方法在各个子集上的识别准确率明显高于原图和HE,在S3、S4、S5上的识别准确率高于Weber-face。由于S2与训练集的光照差异不大,本文方法在S2上的识别准确率与EWGIF、Weber-face相差不大;另外3个子集与训练集的光照差异大,本文方法相较于EWGIF+SQI,在S3、S4、S5上分别提升了约6.1%、7.6%、2.1%,平均识别率提升了约3.7%。

|

Download:

|

|

图 8 |

|

表3对比了不同方法的运行时间。实验使用CPU主频3.2 GHz、内存8 GB的PC机,所有代码均为MATLAB实现。由表3可见,本文方法的运行时间虽然超过HE、Weber-face,但相较于EWGIF仅增加了微量的运行时间。算法具有一定的实时性,可进一步应用于实时视频的人脸识别中。

| 表 2 不同方法在Extended Yale B上的识别准确率 Tab.2 Recognition rates on the Extended Yale B with different approaches % |

| 表 3 不同方法在Extended Yale B上对一幅图像的平均处理时间 Tab.3 Average processing time per image on the Extended Yale B with different approaches ms |

本文针对人脸识别中的光照变化问题,提出了一种基于加权EWGIF的人脸光照补偿方法。使用正面光照样本的类间平均脸生成加权系数,作为引导滤波损失函数惩罚项的加权系数,配合自商图,弱化了最终得到的光照补偿图像中人脸平滑区域由光照造成的边缘细节噪声。实验结果表明,本文方法能有效提高人脸识别准确率。未来的工作将深入研究引导滤波的惩罚项,改进加权系数,优化光照模型,从而进一步提升光照补偿的效果和人脸识别的准确率。

| [1] |

LIAN Zhichao, ER M J. Illumination normalisation for face recognition in transformed domain[J]. Electronics letters, 2010, 46(15): 1060-1061. DOI:10.1049/el.2010.1495 ( 0) 0)

|

| [2] |

ZOU Jie, JI Qiang, NAGY G. A comparative study of local matching approach for face recognition[J]. IEEE transactions on image processing, 2007, 16(10): 2617-2628. DOI:10.1109/TIP.2007.904421 ( 0) 0)

|

| [3] |

GUO Guodong, LI S Z, CHAN K. Face recognition by support vector machines[C]//Proceedings of the 4th IEEE International Conference on Automatic Face and Gesture Recognition. Grenoble, France: IEEE, 2000: 196–201.

( 0) 0)

|

| [4] |

叶剑锋, 王化明. AdaBoost检测结合SOM的自动人脸识别方法[J]. 哈尔滨工程大学学报, 2018, 39(1): 129-134. YE Jianfeng, WANG Huaming. An automatic face recognition method using AdaBoost detection and SOM[J]. Journal of Harbin engineering university, 2018, 39(1): 129-134. (  0) 0)

|

| [5] |

SHAN Shiguang, GAO Wen, CAO Bo, et al. Illumination normalization for robust face recognition against varying lighting conditions[C]//IEEE International Workshop on Analysis and Modeling of Faces and Gestures. Nice, France: IEEE, 2003: 157–164.

( 0) 0)

|

| [6] |

AHONEN T, HADID A, PIETIKAINEN M. Face description with local binary patterns: application to face recognition[J]. IEEE transactions on pattern analysis and machine intelligence, 2006, 28(12): 2037-2041. ( 0) 0)

|

| [7] |

TAN Xiaoyang, TRIGGS B. Enhanced local texture feature sets for face recognition under difficult lighting conditions[J]. IEEE transactions on image processing, 2010, 19(6): 1635-1650. DOI:10.1109/TIP.2010.2042645 ( 0) 0)

|

| [8] |

DÉNIZ O, BUENO G, SALIDO J, et al. Face recognition using histograms of oriented gradients[J]. Pattern recognition letters, 2011, 32(12): 1598-1603. DOI:10.1016/j.patrec.2011.01.004 ( 0) 0)

|

| [9] |

LUO Yong, GUAN Yepeng. Enhanced facial texture illumination normalization for face recognition[J]. Applied optics, 2015, 54(22): 6887-6894. DOI:10.1364/AO.54.006887 ( 0) 0)

|

| [10] |

GEORGHIADES A S, BELHUMEUR P N, KRIEGMAN D J. From few to many: illumination cone models for face recognition under variable lighting and pose[J]. IEEE transactions on pattern analysis and machine intelligence, 2001, 23(6): 643-660. DOI:10.1109/34.927464 ( 0) 0)

|

| [11] |

BLANZ V, VETTER T. Face recognition based on fitting a 3D morphable model[J]. IEEE transactions on pattern analysis and machine intelligence, 2003, 25(9): 1063-1074. DOI:10.1109/TPAMI.2003.1227983 ( 0) 0)

|

| [12] |

ZHANG Lei, SAMARAS D. Face recognition from a single training image under arbitrary unknown lighting using spherical harmonics[J]. IEEE transactions on pattern analysis and machine intelligence, 2006, 28(3): 351-363. DOI:10.1109/TPAMI.2006.53 ( 0) 0)

|

| [13] |

JOBSON D J, RAHMAN Z, WOODELL G A. Properties and performance of a center/surround retinex[J]. IEEE transactions on image processing, 1997, 6(3): 451-462. DOI:10.1109/83.557356 ( 0) 0)

|

| [14] |

ZHANG Taiping, TANG Yuanyan, FANG Bin, et al. Face recognition under varying illumination using gradientfaces[J]. IEEE transactions on image processing, 2009, 18(11): 2599-2606. DOI:10.1109/TIP.2009.2028255 ( 0) 0)

|

| [15] |

WANG Haitao, LI S Z, WANG Yangsheng. Generalized quotient image[C]//Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington, DC, USA: IEEE, 2004, 2: II-498–II-505.

( 0) 0)

|

| [16] |

WANG Biao, LI Weifeng, YANG Wenming, et al. Illumination normalization based on Weber's law with application to face recognition[J]. IEEE signal processing letters, 2011, 18(8): 462-465. DOI:10.1109/LSP.2011.2158998 ( 0) 0)

|

| [17] |

BARADARANI A, WU Q M J, AHMADI M. An efficient illumination invariant face recognition framework via illumination enhancement and DD-DT WT filtering[J]. Pattern recognition, 2013, 46(1): 57-72. ( 0) 0)

|

| [18] |

HU Haifeng. Illumination invariant face recognition based on dual-tree complex wavelet transform[J]. IET computer vision, 2015, 9(2): 163-173. DOI:10.1049/iet-cvi.2013.0342 ( 0) 0)

|

| [19] |

CHEN Chao, SHEN Haibin. Illumination compensation method using edge-weakening guided image filter for face recognition[J]. Electronics letters, 2015, 51(19): 1495-1497. DOI:10.1049/el.2015.1667 ( 0) 0)

|

| [20] |

HE Kaiming, SUN Jian, TANG Xiaoou. Guided image filtering[J]. IEEE transactions on pattern analysis and machine intelligence, 2013, 35(6): 1397-1409. DOI:10.1109/TPAMI.2012.213 ( 0) 0)

|

| [21] |

DRAPER N R, SMITH H. Applied regression analysis[M]. New York: John Wiley and Sons, 2014.

( 0) 0)

|

2018, Vol. 13

2018, Vol. 13