在运动目标跟踪方面,实时性和鲁棒性是衡量跟踪效果必不可少的2个因素。传统方法在实时性和鲁棒性存在或大或小的缺陷。ZhangKaihua等2012年在ECCV会议上提出了基于压缩感知的目标跟踪算法(compress tracking)[1],该算法在实时性和鲁棒性有了很大的提高,但复杂背景下效果欠佳。文献[2]在压缩感知目标跟踪的基础上结合了运动估计算法,较好地抑制了跟踪漂移,但在较复杂背景下算法效果不容乐观。文献[3]和文献[4]都引用了特征加权的思想,但都是基于压缩感知跟踪原始特征,故在复杂背景下鲁棒性较差。文献[5]和文献[6]分别将光流法和SIFT特征点融入到压缩感知目标跟踪中,在复杂背景下,这2种算法均能够较准确进行目标跟踪,但是由于计算量的增加,实时性差。文献[7]提出了基于HOG特征的压缩感知目标跟踪,但由于特征误差的累积也容易产生跟踪漂移。本文摈弃了经典HOG特征描述中对HOG特征的等权值串联的理念,弥补了HOG特征的在特征描述上的不足。将HOG特征和HOG特征权值融合形成W-HOG压缩特征,以此进行运动手势跟踪和对分类器进行更新,以提高算法在复杂背景下的鲁棒性。

1 经典压缩感知目标跟踪简介Donoho等于2006年首次提出了压缩感知理论,该理论指出,通过一个满足约束等距性条件的稀疏测量矩阵对原图像特征空间做投影,会把保留高维特征的信息压缩到低维特征子空间。文献[1]中的Zhang Kaihua等将压缩感知理论运用到运动目标跟踪中去(compressive tracking),此后,该跟踪算法在视频跟踪领域得到广泛应用。

该算法低维特征提取公式为

其后的目标跟踪就是通过迭代运算寻找与目标特征最相似的候选区域,文献[7]中首先在后续帧中遍历目标位置临近区域,然后在候选区域选用贝叶斯分类器计算其分类分数,以得分数值最大的候选区域作为目标位置,判别公式 [8]如下:

HOG特征是用梯度和方向来表现局部目标的表象和形状,其优点是具有旋转和平移不变性、局部光照不变性。文献[7]提出的基于HOG特征的压缩感知目标跟踪,虽然使用HOG特征代替原来的灰度特征,但是由于每个HOG图像块特征对整体手势跟踪效果的影响存在差异,若等权值相加每个图像块的HOG特征,必会对手势跟踪造成较大影响。故在背景信息中含有噪声点、背景灰度变化较大以及背景中含有类肤色信息时,容易发生跟踪偏离和漂移。本文使用HOG特征和特征权重代替原来的灰度特征,从而避免了等权值相加对进行运动手势跟踪所造成的累计误差。

2.1 W-HOG压缩特征空间的生成采用W-HOG特征代替原来的灰度特征后,原始的高维特征为不同尺度的矩形滤波器与原图像卷积后的结果提取HOG特征。为了增加算法对复杂背景的鲁棒性,需要对HOG特征和特征权值进行特征融合,形成W-HOG特征,该特征为压缩后的低维特征。

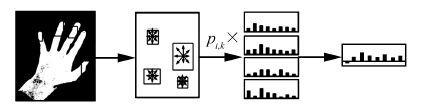

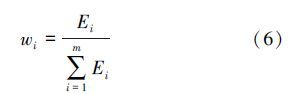

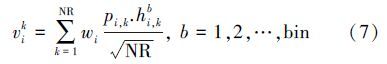

2.1.1 梯度方向直方图的构建与特征计算对于候选区域随机选择不同大小的2~4个矩形图像块 Ri,k,统计每个图像块的梯度方向直方图 Hi,k。将梯度方向分成bin块,块内的每个像素点向该方向进行投票加权,运用积分直方图[9]快速计算该方向上的梯度幅值,继而得到子块的梯度方向直方图,总的梯度方向直方图特征为子块特征的加权和。最终特征[10]为

|

| 图 1 低维HOG特征生成示意图 Fig. 1 Schematic diagram of low dimensional HOG feature generating |

手势图像中不同图像块中所包含的特征信息量是不同的,信息熵反映了图像中所带信息量的大小,信息熵越大,该图像块所包含信息量就越大,则对手势跟踪的影响也就越大。本文对压缩后的矩形块进行信息熵计算来构造HOG加权系数。首先把该手势图像转换成灰度图像,则第 i个子块信息熵的计算公式如下[12]:

1) 初始化分类器

a)视频序列的第一帧运用坐标信息选择运动手势图像。

b)正负样本的采集:在0 <‖l (x)-l‖<α范围内取正样本;在β<‖ l(x)-l‖<γ范围内取负样本,并计算0<‖l(x)- l‖<γ范围内的积分直方图并保存。

c)利用积分直方图,快速计算运动手势目标和背景的梯度直方图[14]。

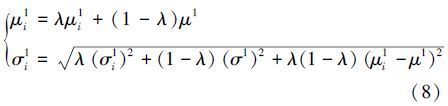

继而按照式(7)计算融合低维W-HOG特征,按照式(8)更新分类器的均值和方差。

2)运动手势目标跟踪

读取下一图像帧,在0<‖l (x)-l‖<γ周围采集手势样本,并根据算式(7)计算候选区域样本的低维 W-HOG特征,继而代入算式(3),取其最大值作为运动手势目标区域。

3)分类器的更新

在所确定的运动手势目标周围采集正负样本[15],并计算正负样本HOG特征,根据算式(8)分别更新分类器。

4)跳转到步骤2)进行下一帧的处理。

3 实验结果和分析本实验背景选择为复杂静态背景,背景中含有多个类肤色物体的存在,自行拍摄的运动手势视频约为 9秒,经拆帧视频拆分为260帧,另外本实验还对该视频分别进行CT跟踪以及基于HOG特征的CT跟踪进行对比实验。实验中,更新率取值为0.6、α=4、β=8、γ=20 。实验环境为Intel Core i5 CPU 3.0GHZ,安装内存:2.0GB,Window7操作系统,使用MATLAB 2014b进行仿真实验。经仿真实验后,视频序列第95帧仿真结果如图 2所示,视频序列第197帧仿真结果如图 3所示。

|

| 图 2 第95帧仿真结果 Fig. 2 Simulation results of Video sequence frame95 |

|

| 图 3 第197帧仿真结果 Fig. 3 Simulation results of Video sequence frame197 |

经对比实验可以看出,基于W-HOG 的压缩感知目标跟踪算法在背景复杂、背景中含有类肤色物体等情况下能够准确地检测出运动手势。表 1为3种跟踪算法运动手势跟踪准确率的统计结果,其中总帧数为260。

| 算法 | 正确跟踪的帧数 | 正确率/% |

| CT | 197 | 76 |

| HOG-CT | 223 | 86 |

| W-HOG-CT | 239 | 92 |

从表格数据统计可以看出:较其他2种手势跟踪算法,基于W-HOG的压缩感知运动手势跟踪算法手势跟踪正确率较高。特征对每个图像块的HOG特征进行加权处理,摈弃了经典HOG特征描述中对HOG特征的等权值串联的理念,弥补了HOG 特征在特征描述上的不足。为验证该算法的实时性,本文对该算法的运行时间进行统计,统计结果如表 2所示,其中总帧数数为260。

| 算法 | 运行时间/s | 运行速率/(frame·s) -1 |

| CT | 13.70 | 19 |

| HOG-CT | 23.70 | 11 |

| W-HOG-CT | 25.90 | 10 |

从表格数据统计可以看出:基于W-HOG的压缩感知运动手势跟踪运行时间较其他两种算法运行时间稍长,造成该现象的主要原因是W-HOG特征的计算增加了对图像块特征权值的计算。虽然HOG特征的计算过程中增加了积分直方图以加快特征的计算,但较经典HOG特征,计算复杂程度较高。从手势跟踪对算法实时性的要求来看,该速率已经能够满足基本要求,不会造成跟踪延迟等问题的发生。

4 结束语本文将压缩感知运动目标跟踪运用到了运动手势跟踪中,并且将HOG特征替代原来的类Harr特征,同时运用HOG特征权值进行特征融合,确定运动手势的位置,最后进行分类器的更新,完成了运动手势跟踪。该算法摈弃了经典HOG特征描述中对HOG特征的等权值串联的理念,有效减少了HOG特征等权值相加对手势跟踪所造成的累积误差,并且能够在较复杂环境下准确地进行运动手势跟踪,本算法还运用积分直方图减少运算量,但是手势跟踪的实时性有待提高。在尺度方面,该算法不能够有效地满足运动手势跟踪在尺度自适应方面的要求,手势发生形变时,手势跟踪产生一定的误差。因此,在实时性的提高和尺度自适应方面是以后研究工作的重点。

| [1] | ZHANG Kaihua, ZHANG Lei, YANG M H. Real-time compressive tracking[C]//Proceedings of the 12th European Conference on Computer Vision. Florence, Italy, 2012:866-879. |

| [2] | WU Jiayun, CHEN Daquan, YI Rui. Real-time compressive tracking with motion estimation[C]//Proceedings of IEEE International Conference on Robotics and Biomimetics (ROBIO). Shenzhen, China, 2013:2374-2379. |

| [3] | ZHU Jianzhang, MA Yue, ZHENG Chen, et al. Adaptive weighted real-time compressive tracking[J]. IET computer vision, 2014, 8(6):740-752. |

| [4] | 王松林, 项欣光. 基于压缩感知的多特征加权目标跟踪算法[J]. 计算机应用研究, 2014, 31(3):929-932. WANG Songlin, XIANG Xinguang. Real-time tracking using multi-feature weighting based on compressive sensing[J]. Application research of computers, 2014, 31(3):929-932. |

| [5] | 刘丹, 窦勇. 基于光流和压缩感知的目标跟踪[J]. 计算机技术与自动化, 2013, 32(4):84-87. LIU Dan, DOU Yong. Object tracking based on optical flow and compressive sensing[J]. Computer technology and automation, 2013, 32(4):84-87. |

| [6] | 钟权, 周进, 崔雄文. 融合SIFT特征的压缩跟踪算法[J]. 光电工程, 2015, 42(2):66-72. ZHONG Quan, ZHOU Jin, CUI Xiongwen. Compressive tracking algorithm based on SIFT[J]. Opto-Electronic Engineering, 2015, 42(2):66-72. |

| [7] | 孙晓燕, 常发亮. 梯度特征稀疏表示目标跟踪[J]. 光学精密工程, 2013, 21(12):3191-3197. SUN Xiaoyan, CHANG Faliang. Object tracking based on sparse representation of gradient feature[J]. Optics and precision engineering, 2013, 21(12):3191-3197. |

| [8] | LIU Jin, HAN Chongzhao, HAN Feng. A novel compressed sensing based track before detect algorithm for tracking multiple targets[C]//Proceedings of the 16th International Conference on Information Fusion (FUSION). Istanbul, the Republic of Turkey, 2013:1514-1519. |

| [9] | LI Hanxi, SHEN Chunhua, SHI Qinfeng. Real-time visual tracking using compressive sensing[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Providence, USA, 2011:1305-1312. |

| [10] | 张雷, 王延杰, 何舒文. 基于相位一致性的实时压缩跟踪方法[J]. 光子学报, 2014, 43(8):124-131. ZHANG Lei, WANG Yanjie, HE Shuwen. Real-time compressive tracking method based on phase congruency[J]. Acta photonica sinica, 2014, 43(8):124-131. |

| [11] | 张洁玉, 武小川. 加权局部二值模式的人脸特征提取[J]. 中国图象图形学报, 2014, 19(12):1794-1801. ZHANG Jieyu, WU Xiaochuan. Feature extraction of faces based on a weighted local binary pattern[J]. Journal of image and graphics, 2014, 19(12):1794-1801. |

| [12] | 朱秋平, 颜佳, 张虎, 等. 基于压缩感知的多特征实时跟踪[J]. 光学精密工程, 2013, 21(2):437-444. ZHU Qiuping, YAN Jia, ZHANG Hu, et al. Real-time tracking using multiple features based on compressive sensing[J]. Optics and precision engineering, 2013, 21(2):437-444. |

| [13] | 王梅, 屠大维, 周许超. SIFT特征匹配和差分相乘融合的运动目标检测[J]. 光学精密工程, 2011, 19(4):892-899.WANG Mei, TU Dawei, ZHOU Xuchao. Moving object detection by combining SIFT and differential multiplication[J]. Optics and precision engineering, 2011, 19(4):892-899. |

| [14] | HASAN H S, KAREEM S A. Human computer interaction for vision based hand gesture recognition:a survey[C]//Proceedings of International Conference on Advanced Computer Science Applications and Technologies. Kuala Lumpur, Malaysia, 2012:55-60. |

| [15] | 宋海东, 陈二虎, 边敏. 基于HOG-LBP特征的自适应实时手掌检测算法[J]. 计算机与数字工程, 2013, 41(11):1826-1828. SONG Donghai, CHEN Erhu, BIAN Min. HOG-LBP feature adaptive real-time palm detecting algorithm[J]. Computer and digital engineering, 2013, 41(11):1826-1828. |