运动目标检测是计算机视觉的基础步骤,而提取运动目标最常用的技术是背景减除法,该技术的思想是将当前帧与背景模型进行比较,从而区分出前景和背景像素。现实场景中由于光照变化,背景扰动,相机抖动等因素,使建立一个好的背景模型变的尤为关键。

背景建模分为参数法和非参数法。参数法背景建模最经典的为单高斯[1]和混合高斯模型[2]。其中,单高斯适用于单模态背景情形其计算简单,采取参数迭代方式,不用每次都进行建模处理。而实际中,背景信息复杂,光照变化、树叶扰动等都属于多模态情形,混合高斯模型对复杂的背景更具鲁棒性,因此很多研究者致力于改进混合高斯模型[3, 4],但混合高斯的缺点是计算量大,对光照敏感。非参数建模有核密度估计法,如文献[5]中提出将每个像素的颜色、梯度和Haar-like特征综合起来,利用核密度估计建立背景模型。除此之外,近年来基于样本一致性的非参数方法得到越来越广泛的研究,该方法计算简单,大量实验证明效果显著。文献[6]根据时域特性,提取视频前N帧进行采样,通过对每个像素进行样本一致性计算估算背景模型。Maddalena等[7, 8]提出一种自组织神经网络的背景差分算法,将背景模型的每个像素映射到多个位置,并按一定权值更新最匹配点及邻域信息。文献[9]提出随机更新和邻域传播机制的vibe算法,内存占用少,背景模型及时初始化,但易产生鬼影。Hofmann等[10]结合了SACON和vibe算法的优势,提出像素判断阈值的自适应和背景模型更新的自适应的PBAS算法,检测效果得到进一步提高,但不能处理间歇动态变化。上述这些方法都仅仅采用颜色单一特征,纹理特征更能体现像素之间的空间相关性,文献[11]利用LBP特征进行背景建模。文献[12]提出一种新的尺度不变局部三元模式(scale invariant local ternary pattern,SILTP)纹理表示方法进行背景建模。但仅使用纹理特征不能有效处理当前景与背景纹理存在一致性的情况。文献[13]将颜色特征与LBP特征相结合,但此方法将颜色特征与纹理特征同等对待,不能有效发挥特征之间的互补作用。

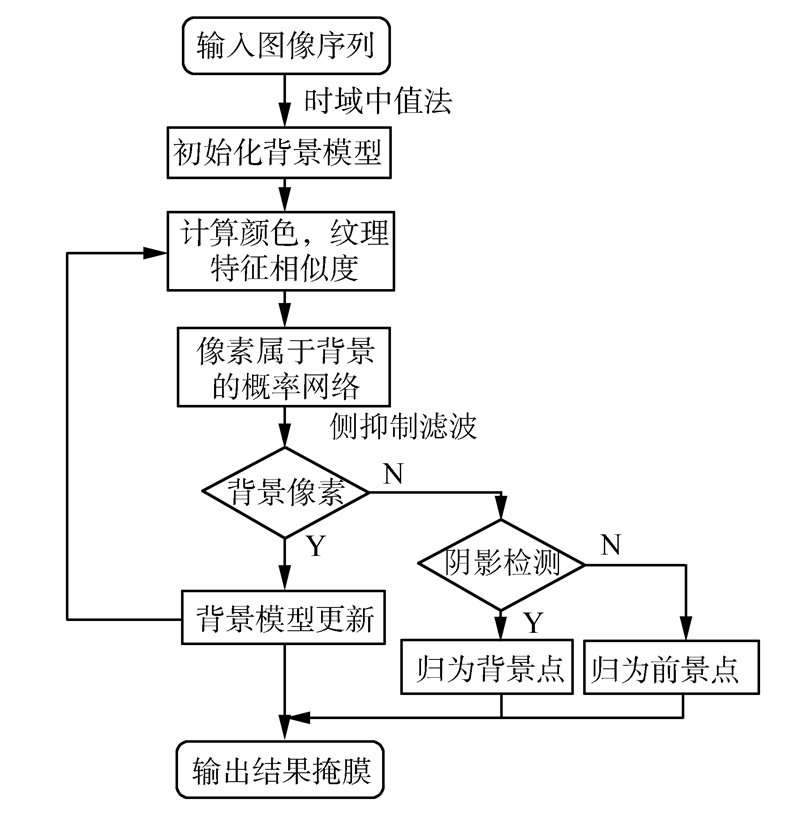

本文提出将rgb颜色特征与SILTP特征通过各自的置信度相融合,有效弥补各自在前景检测上的不足。利用估算背景图像快速初始化背景模型,分别计算出当前像素点与背景模型颜色特征与纹理特征的相似性,并融合得出背景概率网络。利用侧抑制滤波提高对比度分类出前景与背景像素。不断将检测出的背景像素用于背景模型更新,使其能有效处理动态背景,光照变化等复杂情况。前景像素则进一步进行阴影检测,将阴影点归为背景点,但不用于模型更新。

1 背景建模文献[6, 7, 8]通过一系列图像帧进行背景建模,提取同一位置不同时刻像素点的信息来估计背景像素的时域分布。然而这样的建模方法对视频序列的帧数有一定要求,并且不能检测学习序列中的前景目标。为了快速初始化背景模型,做出文献[14]中同样的假设:相邻的像素间共用相似的时域分布。这样的假设也在vibe算法[9]中得到检验。在用于背景建模的图像帧中,往往把初始值全部看做背景像素点。但在实际应用中,却往往不能成立,因此后序的检测中易产生鬼影。本文实验中先采用时域中值法估算背景图像,这样能有效减少前景点对背景模型的作用,避免鬼影,即对于L帧的图像子序列I1,I2,…,IL,B=median(I1,I2,…IL)。

将背景图像B中每个像素点p快速初始化背景模型

C(p)如下:

式中:D1p,Dp2,…,Dmp为背景采样点的信息。本文m取值为9,即当前像素点与其8邻域点。图像包含丰富的信息,包括灰度、颜色、纹理、边缘、轮廓等。如果能将多个信息结合起来,前景目标的分割将更具鲁棒性。文献[13]的实验结果表明颜色和纹理特征能互相弥补各自的不足,但LBP对噪声敏感。因此,本文提出将RGB颜色特征和SILTP特征相融合来进行前景检测。

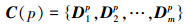

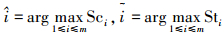

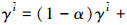

1.1 尺度不变局部三元模式LBP[15]是一个有效的图像局部纹理描述符,但对噪声敏感。SILTP是对LBP的改进,首次在文献[12]中提出,其在一定程度上能有效抵抗噪声,并且对尺度变换亦具有不变性,如图 1所示。在第2行中,一些加粗像素表示被噪声影响了,第3行每个像素灰度值均为原来的2倍,但SILTP描述符均能在一定程度上抵抗这些情况,描述符为‘1000000000000110’。

|

| 图 1 SILTP描述符 Fig. 1 SILTP descriptor |

对于任意位置(xc,yc)的像素,SILTP编码如下式所示:

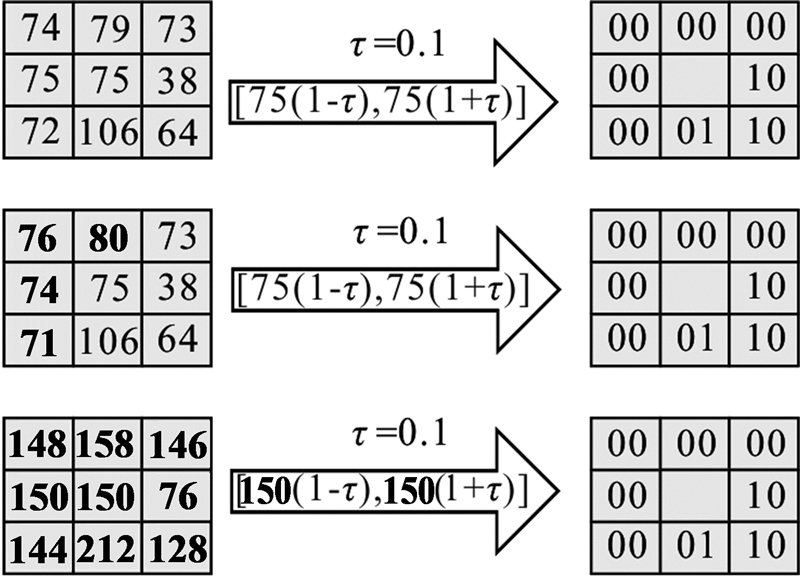

式中:Ic为中心像素点的灰度值,Ik为半径为R的邻域像素,⊕为二值字符串的连接操作,τ为预示着比较范围的尺度因子。Sτ为分段函数,定义如下:

本文τ=0.1,R=1,N=8,这样对每一个像素点可以得到一个16字节的二值字符串。

1.2 背景模型表示及更新在由时域中值法得到的估算背景图像B中,分别提取颜色和纹理特征,每个背景采样点包含5类信息即Dip=Ii,texi,ηi,γi,ωi,i=1,2,…,m。其中,Ii为像素点的RGB颜色分量Ri,Gi,Bi,texi为像素点的SILTP纹理描述符。ηi和γi分别代表颜色成分Ii和纹理成分texi作为背景的置信度,初始值都为0.1,其值越大,代表所属的成分在决定标签时所起的作用越大。ωi∈[0,1]作为权重因子代表采样点属于背景的可能性,初始值取为0.01。

随着时间的推移,视频中的背景也会发生变化,如树叶的摇摆,光照的变化。如果背景模型不及时更新,就会导致检测的结果产生大量的噪声以及误检或漏检。为了满足背景的实时变化,背景模型必须实时更新。传统算法采用样本“先进先出”的更新思想,即随着背景模型中新样本的加入,停留时间最长的旧样本将被替换,故而容易提前删除有用的旧样本。本文选择背景像素对背景模型进行更新算法如下。

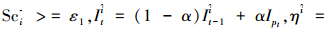

假如当前帧像素pt跟背景模型Ct-1比较判定为背景点,其RGB颜色特征为Ipt,SILTP描述符为texpt。θmin=0.1,θmax=0.6,α=0.005,θmin和θmax分别为最小和最大的置信水平,α为学习因子。

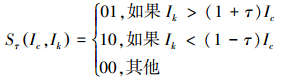

根据 寻找最佳匹配样本。Sc、St分别为颜色、纹理特征相似度,在本文第2部分会详细解释。

寻找最佳匹配样本。Sc、St分别为颜色、纹理特征相似度,在本文第2部分会详细解释。

基于颜色信息的最佳匹配样本:

若

否则颜色特征不变,

否则颜色特征不变,

基于纹理信息的最佳匹配样本:

若 ,仅更新其置信值,

,仅更新其置信值, αθmax否则

αθmax否则 若

若 且

且 ε2,背景模型权值最小的样本将被替换,置信值和权值都为初始值。

ε2,背景模型权值最小的样本将被替换,置信值和权值都为初始值。

最后通过ωi=(1-α)ωi+απ更新所有样本的权重。其中π为指示变量,若样本颜色与纹理信息都最佳匹配,则为1;若二者之一有匹配,则取为0.5;否则为0。

2 运动目标检测本文方法与其他的样本一致性算法相似,都是通过当前像素点与背景模型的比较来进行前景背景像素点分类。

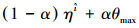

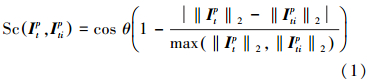

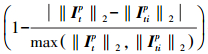

对于2个颜色特征Itp、Itip的颜色相似性度量如式(1)所示[16]:

式中:Itp为时刻t像素点p的RGB颜色特征,Itip为时刻t像素点p所对应的背景模型中第i个样本点的RGB颜色特征。cos θ=(Itp)ΤItip/‖Itp‖2,‖Itip‖2为利用余弦相似定理表示2个颜色特征色调相似度, 代表亮度相似度。将色调和亮度的差异结合起来使像素对光照的变化更具有鲁棒性。为了减少计算量,式(1)可进一步简化为

代表亮度相似度。将色调和亮度的差异结合起来使像素对光照的变化更具有鲁棒性。为了减少计算量,式(1)可进一步简化为

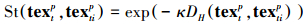

对于2个纹理描述符textp,textip的相似性度量公式如下:

式中:textp为时刻t像素点p的SILTP纹理描述符,如图 1中的16字节0-1字符串,textip为时刻t像素p所对应的背景模型中第i个样本点的SILTP的纹理描述符。DHtextp,textip代表 0-1字符串textp,textip之间的归一化汉明距离。κ为控制因子,控制纹理相似度的伸展范围。可知,DHtextp,textip∈0,1,St(textp,textip)∈[e-κ,1],在本文实验中,κ=2。

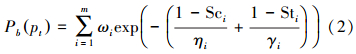

综上,对于时刻t的给定像素pt,计算其属于背景的可能性Pb(pt):

式中:权重因子ωi,颜色和纹理的置信度ηi、γi都在不断地更新。因此,在估计像素属于背景的可能性时,其颜色和纹理所起的作用也不断得到调整,融合起来进行前景分割。

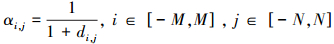

通过式(2)得到时刻t视频帧的概率网络,由于前景像素本身具有空间相关性,本文将概率网络进行侧抑制滤波来提高对比度,减少低频噪声。Duan等[17]首次将侧抑制滤波用于图像处理中,其滤波模型如式(3)所示。

式中:I0(m,n)为像素点的原始值,αi,j为抑制系数,R(m,n)为经过侧抑制滤波后像素点对应的值。(2M+1)×(2N+1)表示感受域。

基于式(3)可以得到抑制系数的计算公式:

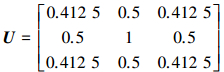

式中:di,j为周围像素点到感受域中心像素点的距离。本文选择感受域大小为3×3,因此可以计算出响应的卷积模板U为

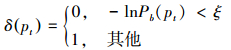

通过滤波处理后,利用分类器δ(pt)来进行前景分割,定义为

式中:ξ为阈值,若δ(pt)输出为0,代表其所对应的像素为背景,否则被视为前景像素。

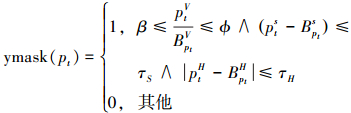

3 阴影检测由于大量的阴影,会引起运动目标粘连。本文采用文献[18]提出的基于HSV彩色空间的阴影检测方法,其阴影掩膜可以表示如下:

式中:阴影掩膜ymask(pt)的值为1时,表示像素点pt为阴影点,否则不是阴影点。ptH、ptS、ptV分别是时刻t像素点p在HSV彩色空间的3个分量,BptH、BptS、BptV分别是所对应的估算背景图像B中像素点在HSV彩色空间的3个分量。下限β∈[0,1]的值取决于光照强度,光照越强, 就越小,则β取较小值。上限φ∈[0,1]用于排除因噪声扰动产生的伪阴影点,τS和τH的取值依据阴影区色度和饱和度变化较小的特性。该阴影检测法利用阴影像素点的物理性质,能较好的检测出分布均匀的弱阴影。

就越小,则β取较小值。上限φ∈[0,1]用于排除因噪声扰动产生的伪阴影点,τS和τH的取值依据阴影区色度和饱和度变化较小的特性。该阴影检测法利用阴影像素点的物理性质,能较好的检测出分布均匀的弱阴影。

本文结合颜色和纹理特征的运动目标检测实现如图 2所示。

|

| 图 2 本文算法实现流程 Fig. 2 Flow chart of the algorithm |

伪代码如下:

为了验证算法的可行性,对不同环境下的视频进行处理。选择的视频序列为变化检测数据库中baseline、dynamic background、camera jitter、intermittent object motion以及shadow 5大类图像序列。本文算法中,L=20,ε1=0.96,ε2=0.92,ξ=8.5。

实验环境为硬件采用i5-3 210 M,主频2.5 GHz的处理器,2 GB内存。软件平台使用的是Windows7操作系统,开发平台为MatlabR2012a。

分别与高斯混合模型(Gaussian mixture model,GMM)算法[2],空间相关的自组织背景减除(spatially coherent self-organization background subtraction,SC-SOBS)算法[8],自平衡的灵敏度分割(self-balanced sensitivity segmenter,SUBSENS)算法[13]进行比较。

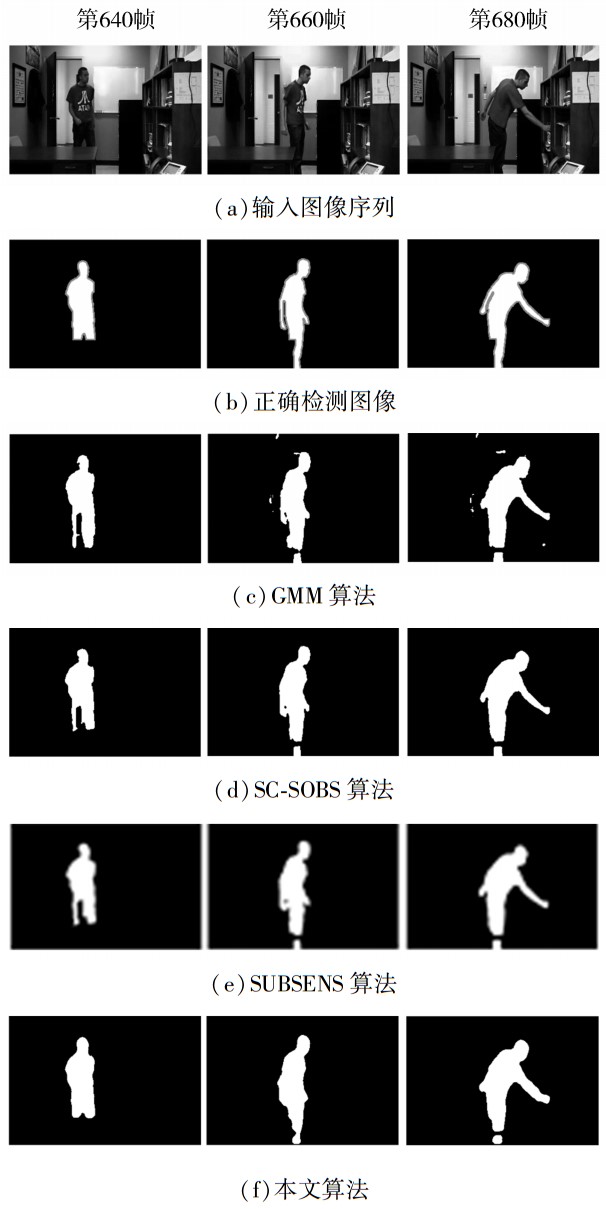

Baseline类目下的office序列由2 050帧图像构成,是一组室内办公室场景的图像序列,包含目标被部分遮挡与背景色相近等复杂情况。检测结果如图 3所示。

|

| 图 3 4种算法对Baseline_office图像序列的检测结果 Fig. 3 Detection results of the four algorithms in base-line_office image sequences |

从图 3可以看出GMM算法对噪声敏感,其他3种算法具有较好的检测率,且从连续3帧的检测结果证明本文的背景模型更新算法具有适应性。

Dynamic background类目下的canoe序列由1 189帧图像构成,场景中中水波荡漾且岸边树叶轻微晃动,用于检测算法处理动态背景的能力。Camera jitter类目下的boulevard序列由2 500帧图像构成,是一组室外林荫大道场景的图像序列,存在拍摄过程中相机抖动问题。Intermittent object motion类目下的sofa序列由2 750帧图像构成,是一组室内大厅沙发场景的图像序列,包含背景物移动,新增背景物和目标间歇性移动等复杂情况。Shadow类目下的cubicle序列由7 400帧图像构成,是一组室内场景的图像序列,场景中包含大量深色或浅色阴影。以上4类图像序列的检测结果如图 4所示。

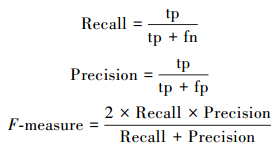

本文采用文献[7]方法进行算法评估,包括检测率(Recall)、准确率(Precision)和算法的综合性能F-measure。

|

| 图 4 4种算法分别对4类图像序列的检测结果 Fig. 4 Detection results of the four algorithms in four image sequences |

式中:tp(true positives)表示正确检测为前景点的像素个数,fn(false negatives)表示错误检测为背景点的像素个数。fp(false positives)表示错误检测为前景点的像素个数。表 1和2给出了5类图像序列在四种算法下检测性能。表 3通过对office序列的检测来比较时间复杂度。

| 算法 | Baseline_office | Dynamic background _canoe | ||||

| Recall | Precision | F-Measure | Recall | Precision | F-Measure | |

| GMM | 0.507 5 | 0.929 0 | 0.654 1 | 0.853 3 | 0.919 4 | 0.887 2 |

| SC-SOBS | 0.919 3 | 0.931 3 | 0.925 1 | 0.879 8 | 0.585 6 | 0.643 9 |

| SUBSENS | 0.957 6 | 0.956 1 | 0.956 8 | 0.688 5 | 0.991 7 | 0.812 8 |

| 本文算法 | 0.968 6 | 0.858 2 | 0.910 1 | 0.837 2 | 0.832 2 | 0.8347 |

| 算法 | Camera jitter-boulevard | Intermittent object motion_sofa | Shadow_cubicle | ||||||

| Recall | Precision | F-Measure | Recall | Precision | F-Measure | Recall | Precision | F-Measure | |

| GMM | 0.797 7 | 0.437 9 | 0.565 4 | 0.514 1 | 0.892 5 | 0.652 4 | 0.786 1 | 0.551 1 | 0.647 9 |

| SC-SOBS | 0.801 4 | 0.616 2 | 0.696 7 | 0.520 1 | 0.832 5 | 0.640 2 | 0.875 4 | 0.616 3 | 0.723 3 |

| SUBSENS | 0.739 4 | 0.751 8 | 0.745 6 | 0.743 7 | 0.926 4 | 0.825 1 | 0.965 7 | 0.800 8 | 0.875 6 |

| 本文算法 | 0.681 2 | 0.901 9 | 0.776 1 | 0.821 9 | 0.832 2 | 0.827 5 | 0.944 2 | 0.863 4 | 0.902 0 |

| 算法 | 图像属性 | 图像大小 | 平均运行时间/s |

| GMM | RGB | 240×360 | 1.92 |

| SC-SOBS | RGB | 240×360 | 1.27 |

| SUBSENS | RGB | 240×360 | 1.63 |

| 本文算法 | RGB | 240×360 | 1.51 |

从表 1和2可以看出,本文算法在绝大多数情况下表现出优秀的性能,其能有效处理动态背景,间歇运动,阴影等复杂情况。F-measure最多提高了0.2。其中,GMM算法是基于概率的模型,算法复杂,对噪声敏感,不利于动态背景下检测。SC-SOBS算法强烈依赖于第一帧图像,如果存在运动目标,在后期的处理中总会在运动目标区域存在空洞现象。SUBSENS算法将颜色特征和LBP特征结合起来,取得了比前2个算法更好的性能,但本文算法采用SILTP描述符比LBP对于噪声和动态背景更具有鲁棒性,且采用了融合机制,充分弥补了颜色和纹理特征各自的缺陷。表 3可以看出本文算法时间复杂度并非最优,SC-SOBS算法由于仅使用图像的灰度特征,时间消耗更小,但在背景扰动,相机抖动等复杂情况下的性能均低于本文算法,本文算法的时间消耗仅比其多0.24 s,但F-measure最多可提高29.06%。因此,本文算法的时间复杂度在可接受范围内,使其获得优良的性能。

6 结束语针对运动场景复杂多变,单一的特征描述往往不能应对,因此本文提出一种结合RGB颜色特征与SILTP纹理特征的运动目标检测算法,将颜色特征与纹理特征相结合,互相弥补各自的不足。将本文算法与GMM、SC-SOBS、SUBSENS算法进行比较,实验结果表明,本文算法在满足实时性的同时稳定性也较好。运动目标检测是目标识别的基础,因此本文的下一步工作为对检测出的运动目标进行识别。

| [1] | WREN C R, AZARBAYEJANI A, DARRELL T, et al. Pfinder:real-time tracking of the human body[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1997, 19(7):780-785. |

| [2] | ZIVKOVIC Z. Improved adaptive Gaussian mixture model for background subtraction[C]//Proceedings of the 17th International Conference on Pattern Recognition. Cambridge,UK, 2004:28-31. |

| [3] | HERAS EVANGELIO R H, PATZOLD M, KELLER I, et al. Adaptively splitted GMM with feedback improvement for the task of background subtraction[J]. IEEE Transactions on Information Forensics and Security, 2014, 9(5):863-874. |

| [4] | LI Xingliang, WU Yubao. Image objects detection algorithm based on improved Gaussian mixture model[J]. Journal of Multimedia, 2014, 9(1):152-158. |

| [5] | HAN B, DAVIS L S. Density-based multifeature background subtraction with support vector machine[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(5):1017-1023. |

| [6] | WANG Hanzi, SUTER D. Background subtraction based on a robust consensus method[C]//18th International Conference on Pattern Recognition. Hong Kong, China, 2006:223-226. |

| [7] | MADDALENA L, PETROSINO A. A self-organizing approach to background subtraction for visual surveillance applications[J]. IEEE Transactions on Image Processing, 2008, 17(7):1168-1177. |

| [8] | MADDALENA L, PETROSINO A. The SOBS algorithm:what are the limits?[C]//2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. Providence, 2012:21-26. |

| [9] | BARNICH O, VAN DROOGENBROECk M. ViBe:A universal background subtraction algorithm for video sequences[J]. IEEE Transactions on Image Processing, 2011, 20(6):1709-1724. |

| [10] | HOFMANN M, TIEFENBACHER P, RIGOLL G. Background segmentation with feedback:The pixel-based adaptive segmenter[C]//2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. Providence, USA, 2012:38-43. |

| [11] | BILODEAU G A, JODOIN J P, SAUNIER N. Change detection in feature space using local binary similarity patterns[C]//2013 International Conference on Computer and Robot Vision. Providence, America, 2013:106-112. |

| [12] | LIAO Shengcai, ZHAO Guoying, KELLOKUMPU V, et al. Modeling pixel process with scale invariant local patterns for background subtraction in complex scenes[C]//2010 IEEE Conference on Computer Vision and Pattern Recognition. San Francisco, 2010:1301-1306. |

| [13] | ST-CHARLES P L, BILODEAU G A, BERGEVIN R. Flexible background subtraction with self-balanced local sensitivity[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA, 2014:414-419. |

| [14] | JODOIN P M, MIGNOTTE M, KONRAD J. Statistical background subtraction using spatial cues[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2007, 17(12):1758-1763. |

| [15] | OJALA T, PIETIKÄINEN M, MÄENPÄÄ T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(7):971-987. |

| [16] | JI Zhangjian, WANG Weiqiang. Detect foreground objects via adaptive fusing model in a hybrid feature space[J]. Pattern Recognition, 2014, 47(9):2952-2961. |

| [17] | DUAN Haibin, DENG Yimin, WANG Xiaohua, et al. Small and dim target detection via lateral inhibition filtering and artificial bee colony based selective visual attention[J]. PLoS One, 2013, 8(8):e72035. |

| [18] | CUCCHIARA R, GRANA C, PICCARDI M, et al. Detecting moving objects, ghosts, and shadows in video streams[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2003, 25(10):1337-1342. |