2. 清华大学计算机科学与技术系 智能技术与系统国家重点实验室, 北京 100084;

3. 石家庄铁道大学 电气与电子工程学院, 河北 石家庄 050043

2. State Key Lab of Intelligent Technology and Systems, Department of Computer Science and Technology, Tsinghua University, Beijing 100084, China;

3. School of Electrical and Electronics Engineering, Shijiazhuang Tiedao University, Shijiazhuang 050043, China

目前,随着灵巧手在各个方面的应用越来越广泛,对灵巧手的研究越来越深入,尤其对控制系统投入了大量的研究,但是对控制的研究也是以鉴别出目标物体为前提的。因此,对目标识别的智能识别研究也成为了研究热点之一。

目标识别的智能识别研究就是在计算机领域内模拟生物的视觉系统功能对目标物体进行辨认。目标识别是利用摄像机对场景的记录,获取到环境状态信息,通过信息、数据的变化采集到运动区域,通过对数据的分析寻找到感兴趣的范围。近年来,学者们一直在努力探索,在文献[1, 2, 3]中阐述了目标识别近年来在军事上和民间的发展和应用。文献[4]中采用了双目系统对目标物体进行识别,文献[5]采用了多传感器对目标物体的识别,文献[6]主要提出了有效的地标视觉提取和识别的方法,这些研究极大地促进了目标识别的发展,为后续任务打造了坚实的基础。

本文提出了将背景相减法和帧差法相结合[7]的方法将目标物体识别出来。然后利用T-S模糊逻辑方法[8]确定出目标物体的属性,进而,灵巧手根据不同物体对应不同力值的方法对目标物体施加恰当的力值,使灵巧手能够对目标物体进行控制。

1 目标识别目标识别实际上是将一个目标物体从一个特定的环境中提取出来的过程。从而判定目标物体的类别和类型[9]。

针对固定摄像机的拍摄,可以采取很多方法检测识别出目标物体。对于颜色较明显的物体可以采用抓取颜色处理的办法进行处理,对于其他的没有颜色特征的物体,常用的目标检测方法有3种:背景相减法、帧间差分法、光流法[10]。

在摄像机[11]是固定的,目标物体运动到特定环境中静止的情况下,背景相减法只能大体上确定出目标物体的运动范围,不能判定出目标物体是否已经停止。帧差法[12]只能确定相邻图像之间的区别,对动态环境有很好的适应性,但是位置不准确,不能完全提取出运动目标的所有相关点。

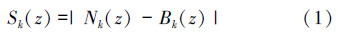

面对上述传统的目标检测方法的不足,文中做如图1算法改进。

|

| 图 1 算法流程Fig. 1 Algorithm flow |

图1中将背景相减法和帧差法相结合并且加入深度信息,首先利用帧差法确保提取出来目标物体为运动的目标,最后根据目标物体的深度信息判定出目标物体的类别和类型。

1.1 前景提取本文将背景相减和帧差法相结合的方法避免了两者方法的缺点,将优点结合在一起获得了极好的效果。背景相减法可以快速地检测到运动物体,并且容易实现,效果也较好。

背景相减法的研究内容包括背景初始化、背景更新、目标物体相关点的检测、噪音等虚假影响等等。“背景初始化”研究的是关于背景模型初始参数获取问题: “目标物体相关点的检测”研究的是如何在相关范围内检测出目标物体运动的序列,从而检测出运动的对象;“噪音等虚假影响”研究的是在检测出来的结果中剔除不是目标物体的像素,提高检测目标物体的准确率。

背景相减法可以分4部分。

背景初始化 检测环境中最原始的环境参数;背景更新:在检测目标物体时上一时刻的视频序列帧;目标物体:在检测的环境范围内感兴趣的目标物体;假象:由噪声等引起的图像变化,例如:边缘深度浮动等。

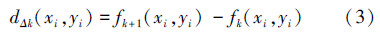

系统将背景初始化为没有放入物体的背景深度数值。根据式(1)确定目标物体的区域:

但是当人手将目标物体放入环境中时运动的物体有没有停止,人手有没有影响到检测目标物体的精确性等等,在这种情况下,背景相减法就不能够满足需要。因此,文中在此基础上添加了帧差法和深度的元素。

帧差法是计算相邻2帧图像fk(xi,yi)和fk+1(xi,yi)的差值,通过差分图像来快速检测到目标物体。具体算法描述如下:

设当前图像序列为fk(xi,yi),其中(xi,yi)为图像中像素点的位置坐标。当下一帧图像出现时获取图像的序列fk+1(xi,yi),得到差值图像dΔk(xi,yi),将其二值化后得到二值化图像bΔk(xi,yi):

用背景相减和帧插法相结合的方法只能检测出目标物体的形状、大小、位姿,却不能具体说明此目标物体的属性。因此,可以利用目标物体的形状、大小、位姿建立T-S模糊逻辑,从而判断出目标物体的属性和类别。

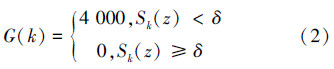

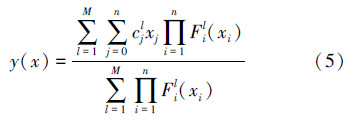

T-S模糊逻辑的基本原理是:若模糊规则为Rl:如果x1为F1l,…,且xn为Fnl,则y1为Bl;l=1,2,…,M,则模糊系统的输出为yl=c0l+c0lx1+…+cnlxn,则T-S系统为

T-S模糊逻辑的基本框图如图2所示。

|

| 图 2 T-S逻辑的基本框图Fig. 2 Basic block diagram of T-S logical |

本文采用的是美国BarrettHand公司生产的BH8系列中的BH8-280。灵巧手总共有4个触觉传感器[13, 14, 15],每个传感器上有24个电容细胞。它的测量范围可以达到10 N/m。为了能够抓取各种大小、形状的物体,本文选用饮料杯子、QQ宠物、手机盒、小龙、圆口杯子作为代表性的物体进行建模。

灵巧手的触觉传感器上对目标物体最大的力值如表1所示。

| 目标物体 | 灵巧手种类 | 灵巧手状态 | 单个单元需要力的最大值/N |

| 饮料瓶子 | BH8-280 | 正常 | 70 |

| QQ宠物 | BH8-280 | 正常 | 78 |

| 手机盒 | BH8-280 | 正常 | 65 |

| 小龙 | BH8-280 | 正常 | 500 |

| 圆口杯子 | BH8-280 | 正常 | 60 |

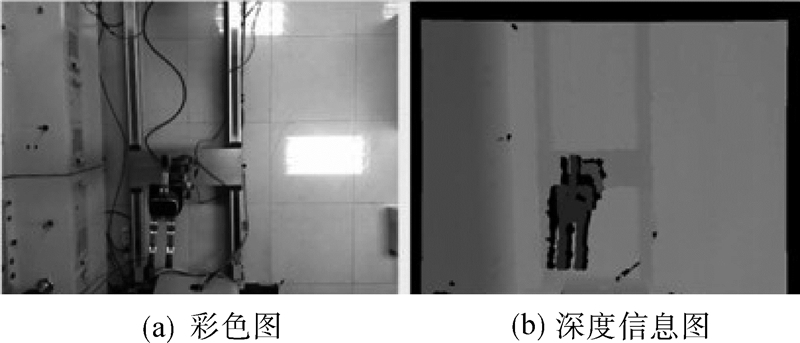

文中采用的摄像机是微软公司生产的Kinect[16],Kinect拥有分辨率为320×240,16位色深,30FPS的彩色摄像机和分辨率为640×480,32为色深,30FPS的深度摄像机。将Kinect放置到天花板上,从上面俯视地面,如图3所示,显示了Kinect摄像的背景图,图像的左半边是Kinect彩色摄像机显示的彩色图,右半边是深度摄像机获取环境的深度信息。图4是背景初始化时的图像显示。当有目标物体出现时,检测出来的图像如图5所示。

|

| 图 3 背景图Fig. 3 Background image |

|

| 图 4 背景初始化Fig. 4 Background initialization |

|

| 图 5 检测出来的目标物体Fig. 5 Detected objects |

利用目标识别原理需要识别出备用的目标物体饮料杯子、QQ宠物、手机盒、小龙、圆口杯子,如图6。

|

| 图 6 备用目标物体Fig. 6 The target object |

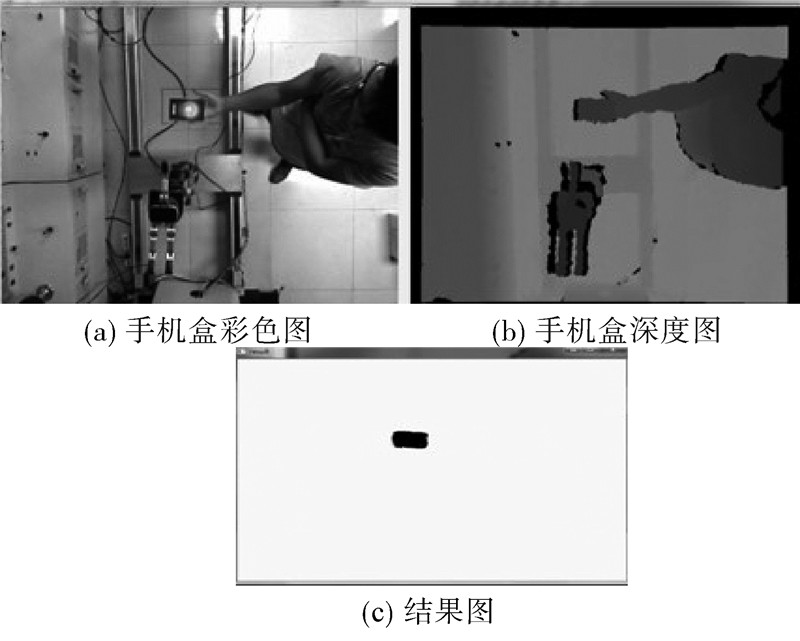

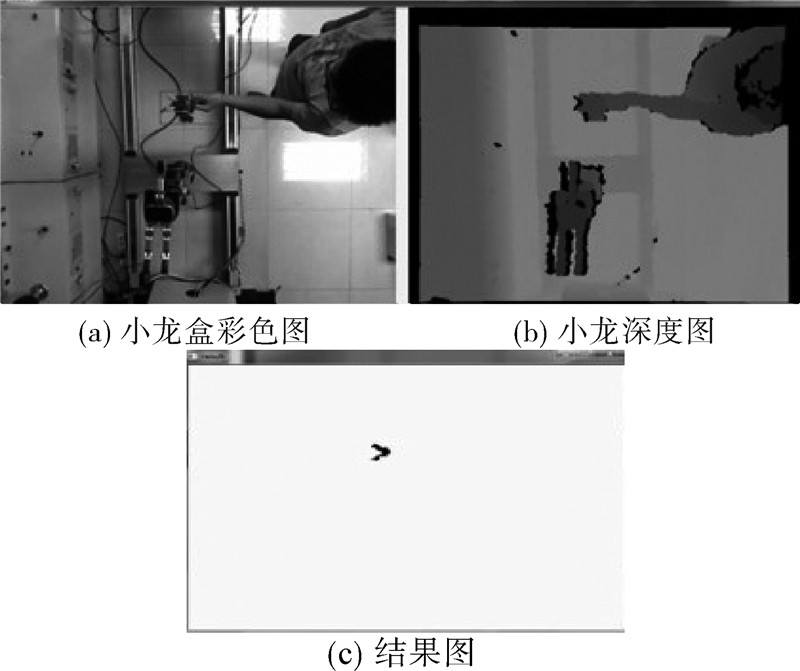

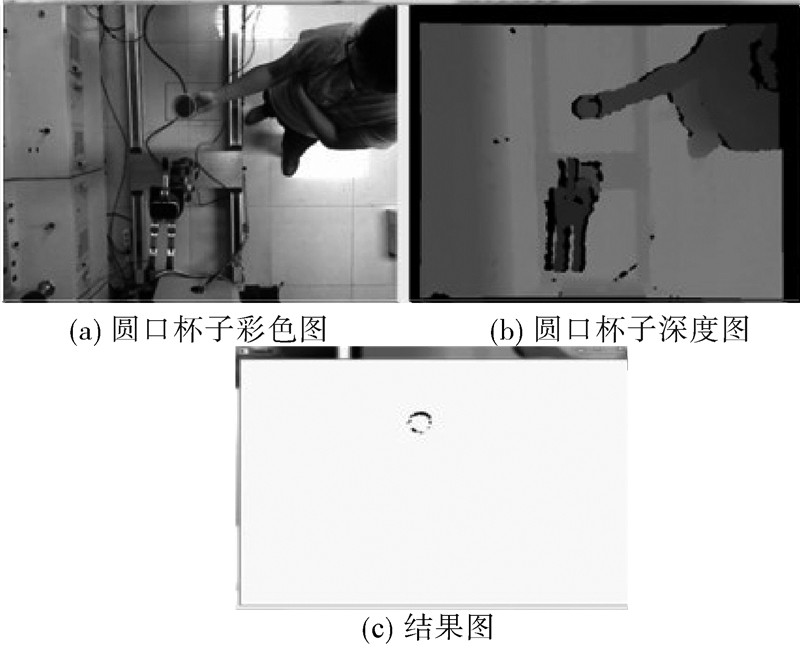

本文利用Kinect检测出的5种目标物体的效果图如图7~11所示。深度图像通过IR感应器采集到连续光,然后通过解码产生。因此,目标物体放置位置与Kinect的距离不同,检测出来的目标形状大小也不同。图7~11是以目标物体距离Kinect摄像机107 cm为例的效果图。

|

| 图 7 检测饮料瓶子Fig. 7 Detection of the bottle |

|

| 图 8 检测QQ宠物Fig. 8 Detection of the QQ pet |

|

| 图 9 检测手机盒Fig. 9 Detection of the phone box |

|

| 图 10 检测小龙Fig. 10 Detection of the dragon |

|

| 图 11 检测圆口杯子Fig. 11 Detection of the round cup |

根据实际情况,目标物体放置位置距离传感器的距离为127、117、107 cm。分析检测出来的差值图像,将检测出来的目标物体画上最小外接矩阵。可以得出最小外接矩阵的周长和面积范围,如表2所示。

| 目标物体 | 检测出来的形状 | 目标物体离传感器的距离/cm | 检测目标物体的周长/cm | 检测目标物体的面积/cm2 |

| 饮料瓶子 | 圆形 | 127117107 | 52.064.468.0 | 169.0259.2288.0 |

| QQ宠物 | 圆形 | 127117107 | 120.0142.0159.6 | 896.01 258.01 590.6 |

| 手机盒 | 长方形 | 127117107 | 152.0176.4190.0 | 1 363.01 848.52 146.0 |

| 小龙 | 不规则形状 | 127117107 | 89.1110.9113.6 | 495.997 2753807 |

| 圆口杯子 | 环形 | 127117107 | 108.5150.0172.3 | 735.21 406.01 855.3 |

因此,结合T-S模糊逻辑,有表1可以得出当检测的目标物体的周长为52~68 cm,面积为169~288 cm2,并且检测出来的形状为圆形时就认定此目标物体为饮料瓶子;周长为120~159.6 cm,面积为896~1590.6 cm2,检测出来的形状为圆形的目标物体认定为QQ宠物;周长为152~190 cm,面积为1 363~2 146 cm2,检测出来的形状为长方形的目标物体可以认定为手机盒;周长为89~113.6 cm,面积为495.997 2~807 cm2,检测出来的形状为不规则的形状,则认定目标物体为小龙;周长为108.5~172.3 cm,面积为735.2~1 855.3 cm2,检测出来的形状为环形,则认定目标物体为图6中的圆口杯子。

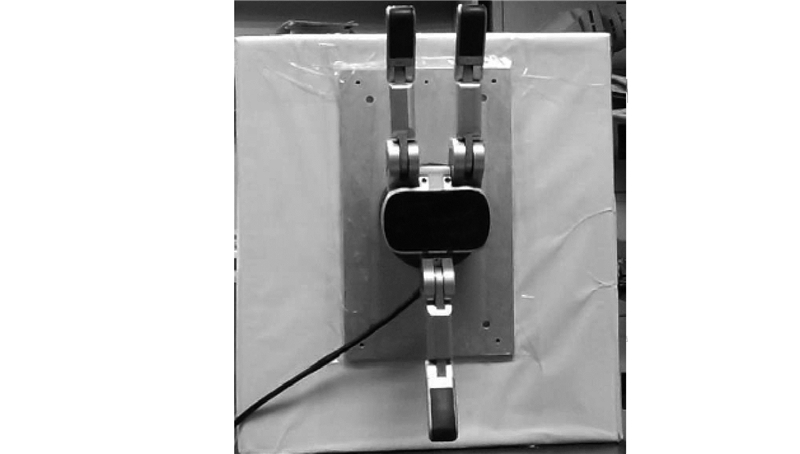

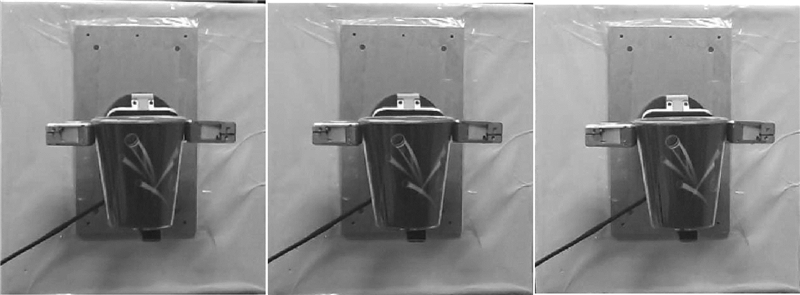

经过上述分析,可以以圆口杯子为例,当识别出来物体之后,采用美国Barrett Technology公司生产的BH8-280进行抓取,针对不同的物体,灵巧手使用不同的力值进行精细控制,参考文献[17]利用PID控制可以实现BH8-280对目标物体进行操作,其效果图(以圆口杯子为例)如图12、13所示。

|

| 图 12 灵巧手初始化Fig. 12 Dexterous hand initialization |

|

| 图 13 灵巧手抓取杯子Fig. 13 Dexterous hand is grasping the cup |

为了能够实现灵巧手抓取目标物体对应的力值操作问题,本文研究了一种利用Kinect检测出目标物体,在帧差法的基础上对获取的深度值进行背景相减,获取出目标物体的运动点,在此基础上利用获取的目标物体的特征采用T-S模糊逻辑判断出目标物体的方法,使得BH8-280灵巧手抓取目标物体时能够更加智能和类人手化。利用T-S模糊逻辑为目标物体判断提供了理论基础,并且提高了目标物体的准确率。本文所提供的目标识别物体的方法更加智能化,扩充了目标识别的应用范围,为灵巧手更加智能化的发展提供了基础。

| [1] | 陈春玉.目标识别技术的现状与发展[J].声学技术,1999, 18(4): 185-188.CHEN Chunyu. The present situation and developing trend of target discrimination techniques[J]. Technical Acoustics, 1999, 18(4): 185-188. |

| [2] | 丛敏,金善良,罗翌.自动目标识别技术的发展现状及其应用[J].飞航导弹, 1999(12): 1-9.CONG Min, JIN Shanliang, LUO Yi. The present situation and developing trend of target automatic recognition techniques[J]. Winged Missiles Journal, 1999(12): 1-9. |

| [3] | 舒海燕.图像目标识别技术的研究与应用[D].西安:西北工业大学, 2002: 1-65.SHU Haiyan. The research and application of image target recognition technology[D]//Xi’an: Northwestern Polytechnical University, 2002: 1-65. |

| [4] | 施雷,胡文俊.基于主动形状模型的双目识别系统的设计与实现[J].计算机应用与软件, 2009, 26(3): 223-225.SHI Lei, HU Wenjun. Design and implementation of binocular visual recognition system based on the active shape model[J]. Computer Applications and Software, 2009, 26(3): 223-225. |

| [5] | 孙涛,张宏建.目标识别中的信息融合技术[J].自动化仪表, 2001, 22(2): 1-4.SUN Tao, ZHANG Hongjian. The technology of information merging in object recognition[J]. Process Automation Instrumentation, 2001, 22(2): 1-4. |

| [6] | LEE L K, AN S Y, OH S. Efficient visual salient object landmark extraction and recognition[C]//IEEE/SMC International Conference on Systems, Man, and Cybernetics. Anchorage, Alaska, 2011: 1351-1357. |

| [7] | 方帅,薛方正,徐新和.基于背景建模的动态目标检测算法的研究与仿真[J].系统仿真学报, 2005, 17(1): 159- 165.FANG Shuai, XUE Fangzheng, XU Xinhe. Moving object detection based on self-adaptive background modeling[J]. Journal of System Simulation, 2005, 17(1): 159-165. |

| [8] | QUANG V D, Van BAN D, HA H C. A method of object identification based on fuzzy object functional dependencies in fuzzy object-oriented databases[C]//IEEE/KES Fourth International Conference on Knowledge and Systems Engineering. Danang, Vietnam, 2012: 46-53. |

| [9] | 孙红岩,毛士艺.多传感器目标识别的数据融合[J].电子学报, 1995, 23(10): 188-192.SUN Hongyan, MAO Shiyi. Multisensor data fusion for target identification[J]. Chinese Journal of Electronics, 1995, 23(10): 188-192. |

| [10] | 韩峥,刘华平,黄文炳,等.基于Kinect的机械臂目标抓取[J].智能系统学报, 2013, 8(2): 149-155.HAN Zheng, LIU Huaping, HUANG Wenbing, et al. Service robot desktop cleaning based on Kinect[J]. CAAI Transactions on Intelligent Systems, 2013, 8(2): 149-155. |

| [11] | AMER A. Voting-based simultaneous tracking of multiple video objects[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2005, 15(11): 1448-1462. |

| [12] | 崔学超.基于减背景和混合差分的运动目标检测算法[J].电子科技, 2010, 23(10): 85-88.CUI Xuechao. Moving objects detection algorithm based on background subtraction and hybrid difference methods[J]. Electronic Science & Technology, 2010, 23(10): 85-88. |

| [13] | BEKIROGLU Y, LAAKSONEN J, JORGENSEN J A, et al. Assessing grasp stability based on learning and haptic data[J]. IEEE Transactions on Robotics, 2011, 27(3): 616-629. |

| [14] | STEFFEN J, HASCHKE R, RITTER H. Experience-based and tactile driven dynamic grasp control[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA, 2007: 2938-2943. |

| [15] | BEKIROGLU Y, DETRY R, KRAGIC D. Learning tactile characterizations of object- and pose-specific grasps[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA, 2011: 1554-1560. |

| [16] | EL-LAITHY R A, HUANG J, YEH M. Study on the use of Microsoft Kinect for robotics applications[C]/ /IEEE/ION Position Location and Navigation Symposium. Myrtle Beach, USA, 2012: 1280-1288. |

| [17] | 刘金琨.先进PID控制及其MATLAB仿真[M]. 北京:电子工业出版社, 2003: 67-80. |