2. 东华大学 服装·艺术设计学院,上海 200051

2. Fashion·Art Design Institute, Donghua University, Shanghai 200051, China

1872年达尔文[1]指出非口语线索是人类信息交流的基础。体态语言主要通过非口语线索传达情感状态,占人类信息交流的55%[2]。其中,表情、头部运动和姿势是体态语言情感表达的主要形式[3]。

近年来,体态语言的情感识别已成为人机交互的研究热点[3]。大量的研究集中在如何有效识别高兴、悲伤、吃惊、恐惧、愤怒和厌恶这6种基本情感[4]。除基本情感外,人的情感还包括如同意、不同意,思考与兴趣等社会态度,在日常生活中的发生频率远远高于6种基本情感[5]。其中“同意”与“不同意”被视为最常见的社会态度之一,由点头与摇头这2种典型的头部体态语言表达[6]。同表情与姿势相比,头部运动能够灵活、准确和自发地传递人的情感与态度,几乎完全是潜意识的[7]。本文针对头部体态语言表达的“同意”与“不同意”情感态度进行识别。常用的方法主要基于计算机视觉[8],但识别结果依赖图像和视频的质量,易受相机视角、背景与光照等环境因素的影响[9]。

由于表面肌电(surface electromyography,sEMG)在一定的程度上能反映神经肌肉的活动[10],近年来被视为人机交互的一种新兴输入源[11],已在手势[12]与表情[13]等体态语言识别中取得了一定进展。与计算机视觉的方法相比,该方法具有感知动作直接、检测动作敏感等优点,受到角度与距离的影响较小,能提供非视觉线索[9, 12]。然而,有关头部体态语言sEMG识别的文献很少,可能的原因在于头部体态语言的表达与颈部肌肉活动密切相关,但头-颈运动系统具有高度复杂性[14],有关颈部肌肉正常活动与肌力变化缺乏系统研究[15]。

针对上述问题,本文提出基于贪心遗传算法(greedy genetic algorithm,GGA)优化的Elamn神经网络(GGA-Elman)的头部体态语言sEMG识别方法。通过实验分析头夹肌、胸锁乳突肌和斜方肌在表达“同意”与“不同意”时sEMG信号的幅值变化;利用Wilcoxon秩和检验提取时域指标的特征值,进而采用GGA-Elman网络建立了识别模型,并与标准Elman模型以及BP模型进行性能比较,验证本文方法的有效性。

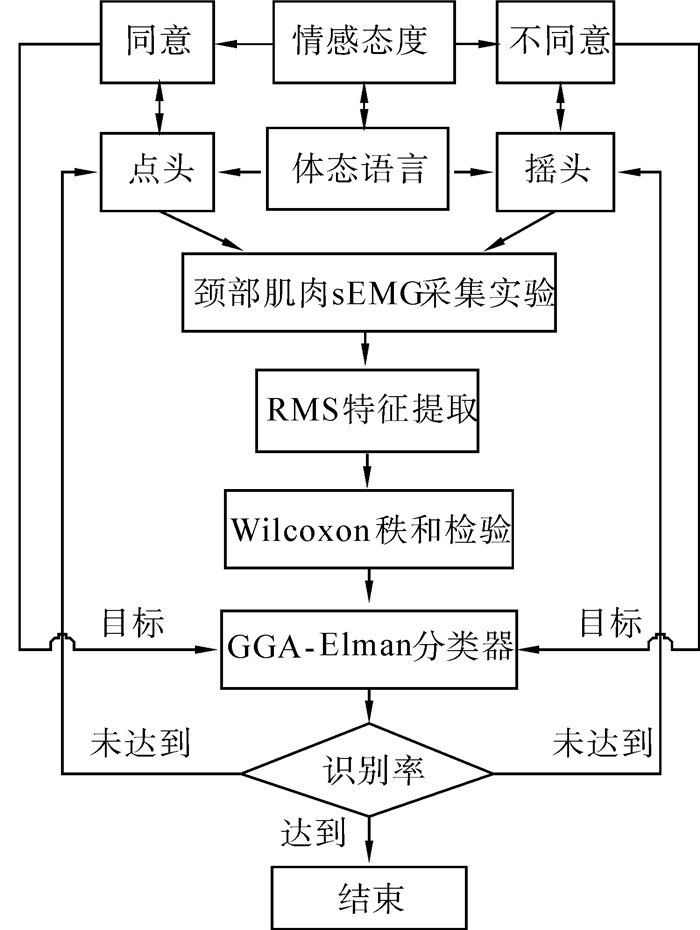

1 头部体态语言识别方法 1.1 概念框架本文方法的概念框架如图 1所示。其中,表达头部体态语言的颈部肌肉sEMG特征提取与识别算法的选取,对模型的准确性和可靠性起关键作用。

|

| 图 1 模型的概念框架 Fig. 1 Conceptual framework of the model |

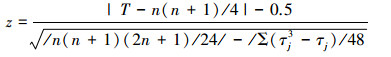

基于电生理学原理,提取完成一次点头与摇头动作时,颈部肌肉sEMG的均方根值(root means quare,RMS)作为时域指标,RMS能够在时间维度上反映sEMG振幅的变化特征,常被用于实时、无损伤地反映肌肉活动状态[10],算法如下:

|

(1) |

式中:EMG(t)为第t时刻EMG信号的采样值,T为一个采样时间段中的时间长度。本文采用RMS的最大值RMSMAX、值平均RMSMEAN以及方差RMSVAR作为特征值。它们的计算量小,可以在采样的间隙完成特征提取,近似反映统计特征随时间的变化规律[16]。

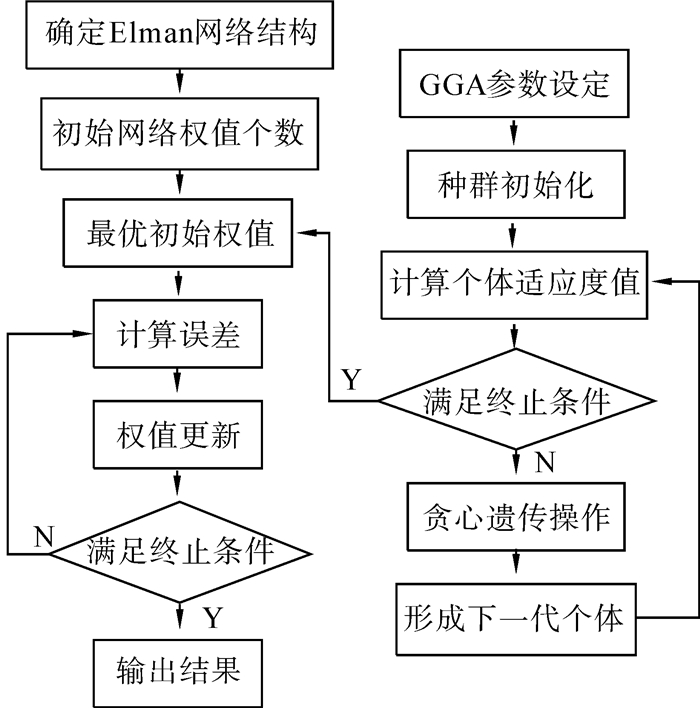

通过Wilcoxon秩和检验,比较执行点头与摇头的头夹肌、胸锁乳突肌和斜方肌的各3项RMS指标的差异性是否具有统计学意义,从中提取能够表征“同意”与“不同意”体态语言的特征,作为构建识别模型的输入值向量。Wilcoxon秩和检验是用秩和作为统计量进行假设检验的非参数统计方法,算法原理详见文献[17],基本步骤为:

1)建立假设。H0:差值的总体中位数Md=0;H1:Md ≠ 0;α=0.05。

2)求差值并编秩。按差数的绝对值大小由小到大编秩,再由差值的符号给秩次加符号。

3)求样本数最小组的秩和作为检验统计量T。

4)以样本含量较小组的个体数n1、2组样本含量之差n2-n1及T值查检验界值表。

5)确定p值并做出统计推断。

当样本含量n > 50时,用正态近似法作z检验;当相同秩次较多时,用校正公式计算z值如下:

|

(2) |

式中:τj为第j个相同秩次的个数。

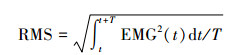

1.3 基于GGA-Elman网络的识别模型Elman神经网络是一种典型的局部回归网络,它在前馈式网络的隐藏层中增加了一个承接层,赋予其动态记忆功能,使其具备适应时变特性的能力,具有识别率高、鲁棒性好等优点。一方面,考虑到sEMG信号的动态特性及个体差异;另一方面,Elman网络存在局部极小问题,初始值的选择影响算法的收敛速度。因此,本文提出基于GGA-Elman网络构建体态语言的sEMG识别模型,模型结构主要由Elman神经网络和GGA算法组成,如图 2所示,力求得到最优网络权值,提高识别效果。

|

| 图 2 算法流程图 Fig. 2 Algorithm flow chart |

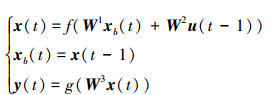

本文的Elman神经网络非线性状态空间的表达式为

|

(3) |

式中:输入向量u为r维RMS特征;y为二维输出值,映射“同意”与“不同意”态度;t为迭代次数;x为k维隐藏层节点单元向量;xb为k维反馈向量。W1为承接层与隐藏层的连接权值;W2为输入层到隐藏层的连接权值;W3为隐藏层到输出层的连接权值;f (·)与g (·)分别为隐藏层和输出层神经元的活化函数,f (·)采用Sigmoid函数,g (·)采用TanH函数。使用梯度下降算法,由式(3)得

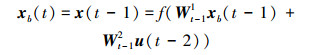

|

式中:xb(t)依赖于不同时刻的权值Wt-11和Wt-12,从而实现动态记忆过程。采用BP算法,以误差平方和函数进行权值修正。

1.3.2 GGA算法优化遗传算法(genetic algorithm,GA)是模拟生物进化过程和机理演化而来的随机化搜索最优解的方法。贪心算法是一种常用的求解最优化问题的简单、迅速的方法。为解决GA在运算过程中早熟收敛和封闭竞争问题,用贪心算法作为遗传操作的确定性选择原则,以一系列局部最优解得到近似整体最优解,即GGA算法[18-19]。本文采用GGA优化Elman网络的初始权值,算法的基本步骤如下:

1)参数设定,包括个体编码串长度L、群体大小M、终止遗传代数G、贪心交叉算子Pc和贪心变异算子Pm。

2)个体二进制编码,生成初始种群。

3)通过适应度函数计算个体适应度值。

4)若最优个体适应度值达到期望误差,停止遗传,转7);否则,转5)。

5)通过贪心选择、贪心交叉与贪心变异等遗传操作[19-20],产生下一代种群。

6)第G代内最优个体的适应度值达到期望误差,算法终止;否则转3)。

7)把最优个体赋予本文Elman网络W1、W2与W3的初始权值。

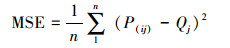

1.3.3 模型的评价指标采用均方误差(mean squared error,MSE)、相关系数R和准确率(accuracy rate,AR)来评价模型的识别效果,它们的计算公式如下:

|

式中:P(ij)是样本i中个体j的预测值,Qj是个体j的期望。MSE越小,模型的精度越高。

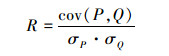

|

式中:cov(P, Q)为协方差, σP、σQ分别为P和Q的标准方差。一般认为R达到0.85以上,模型的泛化能力较好。

|

式中:c为正确识别的样本数,C为总样本数。

2 实验设计与方法 2.1 实验对象根据前导实验方法,招募了8名男性被试,保证颈部均无骨骼肌肉损伤与疾病。他们的基本信息如表 1所示。实验选取了脊柱两侧的头夹肌、胸锁乳突肌和斜方肌上部作为目标肌肉[21],采集sEMG信号,这些肌肉与头部伸、侧屈与旋转运动相关。

| 参数 | 最小值 | 最大值 | 平均值 | 标准差 |

| 年龄/岁 | 26.000 | 30.000 | 27.125 | 1.356 |

| 身高/cm | 172.000 | 178.000 | 174.000 | 2.000 |

| 体重/kg | 65.000 | 75.000 | 69.250 | 3.370 |

| 颈围/mm | 340.000 | 370.000 | 355.000 | 11.952 |

2.2 实验材料

硬件使用FlexComp Infinity 10通道生物反馈仪和MyoScan EMG传感器,采样率为2 048样本/s,输入范围:0~2 000 μV;软件为BioNeuro Infiniti V5.1。颈部两侧分别对称使用3通道sEMG传感器,根据头夹肌、胸锁乳突肌和斜方肌的解剖位置,去除皮肤表面的油脂和角质,将50 mm×30 mm的一次性电极片沿肌腹方向,以中心相隔30~40 mm距离粘贴。

2.3 实验流程首先,告知实验目的与要求,被试依次签订自愿参加实验协议。其次,设置6通道sEMG传感器,请被试完成自发表达“同意”态度时的点头动作20次,同时采集sEMG信号。

以防肌肉疲劳,休息15 min,期间停止sEMG信号采集。休息结束后,请该被试完成自发表达“不同意”时的摇头动作20次,同时采集sEMG信号,如图 3所示。下1名被试重复上述实验步骤

|

| 图 3 摇头动作的sEMG采集 Fig. 3 sEMG collected from nod |

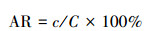

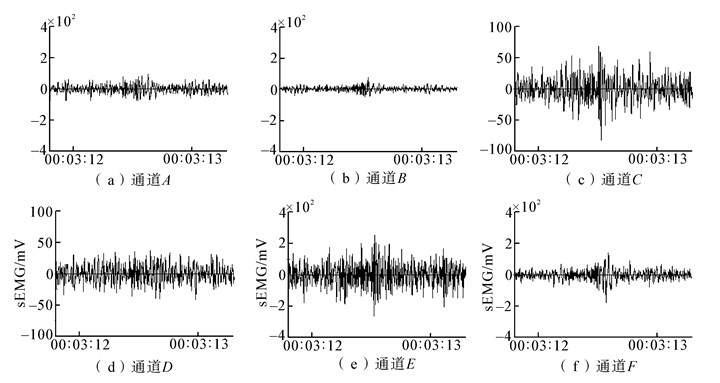

实验最终采集了点头与摇头动作各160次。通过BioNeuro Infiniti软件对sEMG原始信号进行滤波与降噪等预处理。截取被试每次表达“同意”与“不同意”情感态度的点头与摇头动作的肌电图,如图 4、5所示。

|

| 图 4 一次点头动作的肌电图 Fig. 4 Electromyography of once nod |

|

| 图 5 一次摇头动作的肌电图 Fig. 5 Electromyography of once head shaking |

表 2为18组sEMG时域指标进行Wilcoxon秩和检验后z值和p值的计算结果。其中,点头与摇头的配对样本在通道A(左侧头夹肌)与通道B(右侧头夹肌)的RMSMAX、RMSMEAN与RMSVAR指标上,p=0.000,p<α,应拒绝零假设H0,表明它们之间均具有显著性差异;通道E(左侧胸锁乳突肌)、通道F(右侧胸锁乳突肌)的RMSMAX与RMSMEAN也具有显著性差异。然而,通道E与通道F的RMSVAR对应的p值分别为0.093与0.136,通道C(左侧斜方肌)与通道D(右侧斜方肌)所有RMS指标的p > 0.05。实验结果表明,斜方肌的RMS指标不能充分表征点头与摇头动作表达的“同意”与“不同意”情感态度,胸锁乳突肌RMS的最大值与均值能够表征点头与摇头动作,但离散程度相似,而头夹肌的RMS指标的配对样本差异性最显著。

| 通道 | RMSMAX | RMSMEAN | RMSVAR | |||||

| z | p | z | p | z | p | |||

| A | -10.972 | 0.000 | -10.972 | 0.000 | -8.521 | 0.000 | ||

| B | -10.972 | 0.000 | -10.972 | 0.000 | -10.974 | 0.000 | ||

| C | 0.000 | 1.000 | 0.000 | 1.000 | 0.000 | 1.000 | ||

| D | -1.486 | 0.137 | -1.342 | 0.179 | -0.762 | 0.446 | ||

| E | -10.367 | 0.000 | -10.972 | 0.000 | -2.064 | 0.093 | ||

| F | -9.735 | 0.000 | -9.866 | 0.000 | -1.489 | 0.136 | ||

根据p < 0.05的规则,最终提取通道A与B的RMSMAX、RMSMEAN与RMSVAR,通道E的RMSMAX与RMSMEAN,通道F的RMSMAX与RMSMEAN,作为本文模型的特征向量。

3.2 模型识别结果分析在Windows 7系统上构建GGA-Elman神经网络结构。Elman网络的输入层为上述10个RMS特征向量;隐藏层数为1,隐藏层节点数为21,神经元采用Sigmoid作为活化函数;输出层为“同意”与“不同意”2个类别,采用TanH作为活化函数;设最大迭代次数为1 000。W1与W2的权值个数分别为210个,W3的权值个数为42,设定GGA的L=462、M=50、G=100、Pc=0.9、Pm=0.1,期望误差为0.001。选取总体样本的80%作为训练集,20%作为测试集,随机排列并编号。

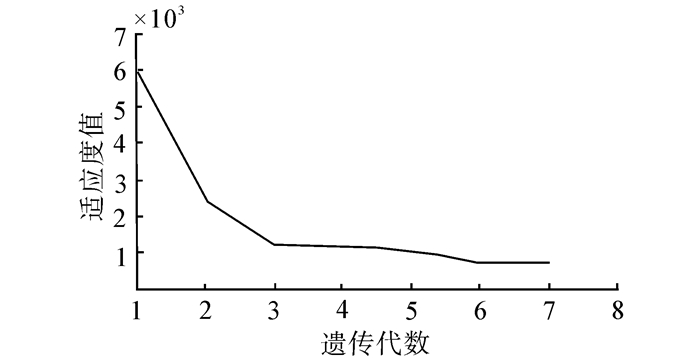

GGA经过7代遗传,最优个体适应度值为0.000 74,小于期望误差,算法停止,如图 6所示。

|

| 图 6 最优个体适应度值的变化情况 Fig. 6 Change of the optimal individual fitness value |

将GGA优化得到最优初始权值赋予Elman网络,经过1 000次迭代后网络成功收敛。计算训练集输出值与期望值的MSE为0.001 3,R为0.999 4,对“同意”与“不同意”的AR均达到100%;模型对测试集64个样本输出值与期望值的MSE=0.001 8,R=0.999 1,AR=100%。实验结果表明该模型的学习效果极佳,泛化性极好。

3.3 算法比较分析为比较GGA-Elman模型的识别效果,采用标准Elman和BP神经网络建模,输入层、输出层和隐藏层的设置与GGA-Elman网络相同。3个模型的训练与测试效果如表 3所示。对训练集的识别上,Elman模型的MSE与R均优于BP神经网络,两者对表达“同意”与“不同意”态度的点头与摇头动作的识别率均达到100%。对测试集的识别上,Elman模型的性能高于BP模型,但它们对“同意”均有一次未能有效识别,且是同一个样本。相比之下,GGA-Elman模型对该样本却能有效识别,MSE与R均优于这2个模型,对测试集的识别率高出3.22%以上,在本文头部体态语言的sEM识别中表现出优越性。

| 参数 | 训练集 | 测试集 | |||||

| GGA-Elman | Elman | BP | GGA-Elman | Elman | BP | ||

| MSE | 0.001 8 | 0.006 2 | 0.011 7 | 0.014 9 | 0.034 2 | 0.042 3 | |

| R | 0.999 1 | 0.998 9 | 0.997 3 | 0.987 4 | 0.982 0 | 0.978 9 | |

| AR同意/% | 100 | 100 | 100 | 100 | 96.875 | 96.875 | |

| AR不同意/% | 100 | 100 | 100 | 100 | 100 | 100 | |

4 结束语

为了准确地识别头部体态语言表达的“同意”与“不同意”情感态度,首先从点头与摇头的颈部夹肌、胸锁乳突肌和斜方肌活动中采集sEMG信号,通过Wilcoxon秩和检验,提取了具有显著性差异的时域指标作为输入向量;然后,基于GGA-Elman网络构建了sEMG识别模型,该模型能准确地识别表达“同意”与“不同意”时的点头与摇头动作;最后,与标准Elman神经网络与BP神经网络模型进行性能比较。实验结果表明,本文提出的GGA-Elman模型的性能均高于Elman和BP模型,能有效提高正确识别率,验证了方法的可靠性。今后的工作将开发穿戴式肌电传感器,进一步扩大的样本数量,提高模型的通用性和实际应用价值。

| [1] | DARWIN C. The expression of the emotions in man and animals[M]. 3rd ed New York: Oxford University Press, 1998 : 28 -68. |

| [2] | MEHRABIAN A. Nonverbal communication[M]. Chicago: Aldine-Atherton, 1972 : 1 -15. |

| [3] | FRAGOPANAGOS N, TAYLOR J G. Emotion recognition in human-computer interaction[J]. Neural Networks , 2005, 18 (4) : 389-405 DOI:10.1016/j.neunet.2005.03.006 |

| [4] | EKMAN P. An argument for basic emotions[J]. Cognition and Emotion , 1992, 6 (3/4) : 169-200 |

| [5] | COHEN S. A computerized scale for monitoring levels of agreement during a conversation[J]. University of Pennsylvania Working Papers in Linguistics , 2003, 8 (1) : 57-70 |

| [6] | BOUSMALIS K, MEHU M, PANTIC M. Towards the automatic detection of spontaneous agreement and disagreement based on nonverbal behavior: a survey of related cues, databases, and tools[J]. Image and Vision Computing , 2013, 31 (2) : 203-221 DOI:10.1016/j.imavis.2012.07.003 |

| [7] | VINCIARELLI A, PANTIC M, BOURLARD H. Social signal processing: survey of an emerging domain[J]. Image and Vision Computing , 2009, 27 (12) : 1743-1759 DOI:10.1016/j.imavis.2008.11.007 |

| [8] | MURPHY-CHUTORIAN E, TRIVEDI M M. Head pose estimation in computer vision: a survey[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 2009, 31 (4) : 607-626 DOI:10.1109/TPAMI.2008.106 |

| [9] | ZHAO Yisu. Human emotion recognition from body language of the head using soft computing techniques[D]. Ottawa, Canada: University of Ottawa, 2012: 14-30. |

| [10] | 王健. sEMG信号分析及其应用研究进展[J]. 体育科学 , 2000, 20 (4) : 56-60 WANG Jian. Some advances in the research of sEMG signal analysis and its application[J]. Sport Science , 2000, 20 (4) : 56-60 |

| [11] | AHSAN M R, IBRAHIMY M I, KHALIFA O O. EMG signal classification for human computer interaction: a review[J]. European Journal of Scientific Research , 2009, 33 (3) : 480-501 |

| [12] | 张旭.基于表面肌电信号的人体动作识别与交互[D].合肥:中国科学技术大学, 2010: 8-13. ZHANG Xu. Body gesture recognition and interaction based on surface electromyogram[D]. Hefei: University of Seience and Teehnology of China, 2010: 8-13. |

| [13] | FRIDLUND A J, SCHWARTZ G E, FOWLER S C. Pattern recognition of self-reported emotional state from multiple-site facial EMG activity during affective imagery[J]. Psychophysiology , 1984, 21 (6) : 622-637 DOI:10.1111/psyp.1984.21.issue-6 |

| [14] | KAMIBAYASHI L K, RICHMOND F J R. Morphometry of human neck muscles[J]. Spine , 1998, 23 (12) : 1314-1323 DOI:10.1097/00007632-199806150-00005 |

| [15] | 陈谦. sEMG技术在颈部肌肉活动评价中的应用[J]. 北京体育大学学报 , 2008, 31 (2) : 226-228 CHEN Qian. Surface electromyography utilized in neck muscle activity evaluation[J]. Journal of Beijing Sport University , 2008, 31 (2) : 226-228 |

| [16] | 吴剑锋.基于肌电信号的人体下肢运动信息获取技术研究[D].杭州:浙江大学, 2008: 48-49. WU Jianfeng. Research on human lower-limb motion information acquisition technology based on EMG[D]. Hangzhou: Zhejiang University, 2008: 48-49. |

| [17] | 杨钟亮.基于主客观联合测评的动态人机接触面工效学研究[D].杭州:浙江大学, 2012: 68-70. YANG Zhongliang. Ergonomics study of dynamic human-product contact surface based on subjective and objective evaluation[D]. Hangzhou: Zhejiang University, 2012: 68-70. |

| [18] | LEE Z J, SU S F, LEE C Y. Efficiently solving general weapon-target assignment problem by genetic algorithms with greedy eugenics[J]. IEEE Transactions on Systems, Man, and Cybernetics, Part B: Cybernetics , 2003, 33 (1) : 113-121 DOI:10.1109/TSMCB.2003.808174 |

| [19] | 张海兵, 徐诚, 李世永. 贪心遗传算法及其在武器目标分配问题中的应用[J]. 弹道学报 , 2007, 19 (2) : 40-43 ZHANG Haibing, XU Bing, LI Shiyong. GGA and its application to weapon target assignment[J]. Journal of Ballistics , 2007, 19 (2) : 40-43 |

| [20] | 魏英姿, 赵明扬, 张凤, 等. 贪心遗传算法求解组合优化问题[J]. 机械科学与技术 , 2005, 24 (1) : 10-13 WEI Yingzi, ZHAO Mingyang, ZHANG Feng, et al. An effcient greedy genetic algorithm for combination optimization problems[J]. Mechanical Science and Technology , 2005, 24 (1) : 10-13 |

| [21] | 陈谦, 杨红春, 王健. 不同负荷水平颈部肌肉等长收缩的平均肌电变化特征[J]. 浙江体育科学 , 2010, 32 (5) : 91-95 CHEN Qian, YANG Hongchun, WANG Jian. The changes of AEM G of Neck muscles under isometric contraction at different load levels[J]. Zhejiang Sport Science , 2010, 32 (5) : 91-95 |