2. High Speed Circuit and Neural Network Laboratory, Institute of Semiconductors, Chinese Academy of Sciences, Beijing 100083, China

视频跟踪是计算机视觉中一个重要研究分支,十几年来,一直是最热门的研究课题之一。视频跟踪的主要任务是检测视频场景中出现的目标,并对其运动状态(该状态包括物体的尺度、位置、速度、物体特征等信息)进行记录、理解和预测。目前,视频跟踪作为一项关键技术主要应用在导航制导、自动驾驶、监控视频分析、医学影像分析等领域。现阶段视频跟踪的研究面临的主要问题是:视频场景的光照变化,摄像头运动目标形状、外观、姿态和尺度的变化,同时目标的遮挡、背景杂乱、摄像头抖动、传感器噪声、相似物体的干扰也给目标检测和识别带来了困难,导致目标运动状态的获取存在误差,跟踪漂移后难以再获取目标恢复跟踪。

近些年,国内外学者们对多目标的视频跟踪做了很多研究。与传统的只采用已知运动状态预测未知运动状态[1-2]的跟踪模式不同,多方法或多特征融合的方法得到了学者们的普遍认可。文献[3]和[4]虽很好地证明了特征和运动预测跟踪融合的方法要比传统仅采用特征或者运动状态预测的跟踪效果好,但需手动标定跟踪目标。文献[5-6]采用了运动目标检测和运动状态预测结合的方法获得了不错的效果,但无法应对光照和目标遮挡带来的影响,同时其计算量偏大,无法保证实时处理。文献[7]提出了一种基于目标检测与SIFT特征融合的方法,该方法可以自动地进行目标匹配和跟踪,但对每一帧的SIFT特征匹配需要消耗大量的计算时间。本文方法是在文献[7]的基础上提出的基于多特征融合的视频目标跟踪方法,主要着眼于运动目标的自动检测和匹配跟踪,由于无需每帧都采用SIFT特征完成目标匹配,因此可以节省部分计算时间。首先,应用码本的背景建模方法检测运动目标,获得目标图像。其次,对目标的跟踪采取的是连续帧间的位置关系,对于帧间位移判断失效的情况下采用图像的SIFT特征和彩色直方图特征库完成对目标的匹配。最后,记录同一目标出现、消失或重现时间及位置等运动状态信息,实现目标的跟踪。实验结果表明,算法很好地实现了监控视频的跟踪任务。

1 背景建模与运动目标检测运动目标的检测是视频跟踪的关键步骤,本文采用背景剪除的方式检测视频前景目标。文献[3-4]讨论了视频背景建模的方法,其中高斯混合模型[5]和基于码本的背景模型[6]在运用中取得了比较好的效果。本文采用的背景建模方法为实时更新的双层码本建模方法[7],双层码本分为主码本模型和缓存码本模型,主码本模型用于对不变背景的建模,而缓存码本模型用于应对临时背景的出现,并且双层码本可以根据背景场景的变化进行实时的更新,真实而快速地反应出背景的变化。运动目标的检测采用的是背景差分法,是将当前帧与背景模型相减,根据像素采样值与其码本是否匹配来判断,如果新输入的像素值与背景码本匹配,则判断为背景,否则判断为目标。基于码本的背景建模方法,输出是二进制掩码,这正好适用于对运动目标的提取。该过程不像混合高斯模型方法或非参核密度估计方法[8],无需计算概率,检测速度快,并且可以应对多种背景的变化,对运动目标的检测简便灵活,能达到实时分析视频内容的目的。

2 建立特征库为了应对复杂多变的情况,需要一种稳定的方式表示运动目标,本文采取的方法是对每个运动目标建立一个独有的特征库。在运动目标第1次被检测到时,则利用目标出现的前几帧建立此运动目标的特征库;当多目标距离相近或者重合时,则需要利用建立好的特征库实现实时的匹配运动目标,对匹配成功后的运动目标,同时需要更新其特征库的信息。因此,特征的选择将变得非常重要,本文采取的特征为彩色颜色直方图和SIFT(scale invariant feature transform)特征。

2.1 彩色颜色直方图根据文献[9],图像的彩色直方图是对各颜色级在图像中出现频率和次数的统计,在一定程度上反映了目标的特征和表象,对于目标在颜色上的突出特征有较好的识别效果。因此,将目标的彩色直方图信息作为目标特征库中的一个特征。

首先利用目标检测方法,在视频中分离出运动目标,然后对分离出的运动目标图像进行彩色图像的直方图统计,分别为RGB 3个通道做直方图统计。在需要特征库进行目标匹配时,采用的是三通道的颜色直方图Bhattacharyya距离进行判断。

2.2 SIFT特征SIFT算子是Lowe于1999年提出[10-11],又在2004年[12]完善的一种提取局部特征的算法,在尺度空间寻找极值点,提取位置、尺度、旋转不变量。算法的主要特点为:1)稳定性:对旋转、尺度缩放、亮度变化保持不变性,对视角变化、仿射变换、噪声也保持一定程度的鲁棒性;2)独特性:信息量丰富,适用于在海量特征数据库中进行快速、准确地匹配;3)多量性:即使少数的几个物体也可以产生大量SIFT特征向量;4)高速性:经优化的SIFT匹配算法甚至可以达到实时的要求;5)可扩展性:可以很方便地与其他形式的特征向量进行联合。因此,算法将SIFT特征作为目标特征库的另一个特征。

SIFT特征的本质是在高斯差分金字塔各层图像中寻找局部极值点目标,然后通过窗口的方式进行向量化表示。在高斯差分金字塔中,检测出的一个极值点又被称为特征点,是由128维特征向量表示的。在剪切出目标区域后对目标图像提取SIFT特征用做后续目标匹配的特征。

3 目标跟踪在完成对目标的检测,建立好多目标的特征库后,需要完成对多目标的跟踪。首先,当运动目标被检测出现在视频中的第1帧时,算法需要判断此目标是否为重出现目标,在检测到运动目标后,提取其颜色直方图特征和SIFT特征与特征库中的目标信息进行判断,如是重出现目标,则更新其特征库和出现时间,如是新加入目标则建立新目标的特征库和出现时间。

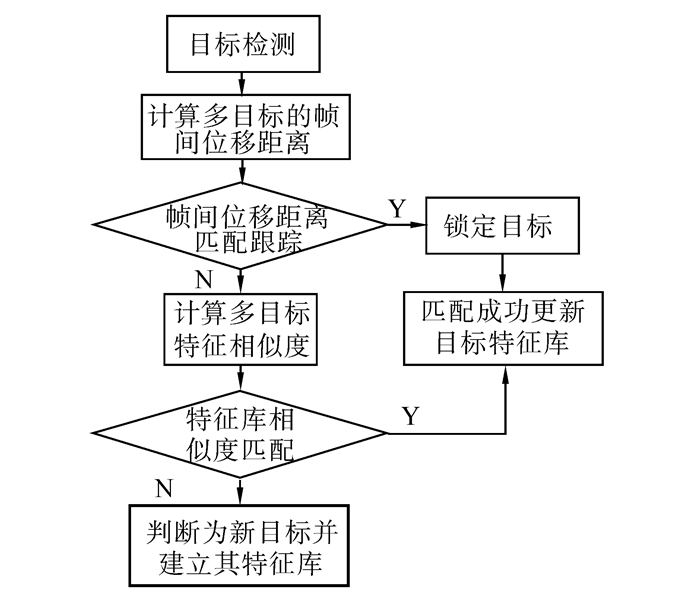

在后续运动目标出现的帧中,无论目标是否为重出现目标,均采用帧间位移信息进行跟踪,由目标的运动速度自动确定帧间位移阈值,从而完成目标的匹配跟踪。其次,如果帧间移动距离匹配跟踪失败,则通过多目标的特征库来寻找相应的匹配目标,具体流程如图 1所示。从流程图中可以看出,本算法在文献[7]的基础上,引入了帧间位移距离跟踪和多特征匹配跟踪。以帧间位移距离判断跟踪为主,以多特征融合的匹配方法为辅,采用更多更丰富的方法完成对目标的匹配。

|

| 图 1 目标跟踪算法流程图 Fig. 1 Video tracking flow chart |

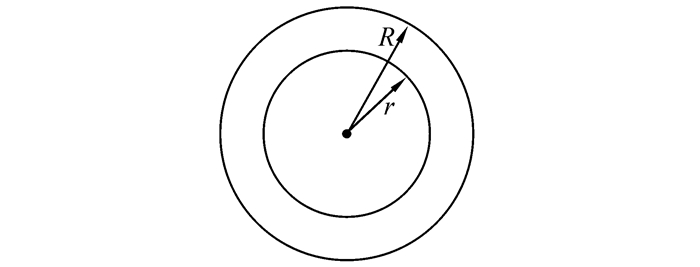

目标在视频中的移动在连续帧间表现为目标位置的变化,通过目标在画面中的位置和目标的移动速度即可判断目标可能的运动范围。对每一帧图像,检测出目标位置后,用该位置坐标与前一帧出现过的所有目标求相对距离,如果该距离小于阈值则判断为可能匹配的目标。此处的阈值通过被测试目标的速度动态确定。首先,应考虑到目标会突然加速的情况,在确定阈值时,目标可能的移动范围应该为平均位移加上加速距离,平均位移信息可以通过多帧的位移距离平均值得到,每帧的位移为当前帧与前一帧的位置差值来确定,加速距离表示目标加速产生的距离,计算时选取为0.3倍的平均位移。如图 2所示,R为目标可能的运动范围,R=r+a,r为目标的平均位移距离,a为目标的加速距离。如果可能匹配的目标有且仅有一个,则认为该目标即为匹配目标;如果没有发现匹配目标或者产生多个匹配目标,则判断帧间位移跟踪失败,需要使用特征库完成对待检测目标的匹配跟踪。

|

| 图 2 目标移动范围图示 Fig. 2 Range of target movement |

在目标的具体跟踪过程中,需要确定目标的具体位置,对于检测出的运动目标,本文采用运动目标的外接矩形几何中心点和4个角点来代表运动目标的位置信息,并且作为跟踪对象进行判断。在匹配跟踪过程中,也采用了双层匹配模式,运动目标几何中心点为第1层匹配对象,外接矩阵的4个角点作为第2层匹配的对象。首先,判断第1层的几何中心点是否满足以上帧间的位移阈值,如果在阈值范围内则可锁定目标,完成跟踪;如果几何中心点不满足阈值范围,则需对2层的外接矩形四角点信息进行判断,如2个相邻角点或者3个角点满足阵间位移阈值则可锁定目标,完成跟踪。相邻角点是指在外接矩形组成边框的2个角点。角点的合理选择有利用解决对运动目标遮挡问题,3个角点的判断避免了目标的小部分遮挡造成的运动目标不匹配,而两相邻角点的判断则解决了大面积遮挡造成的不匹配问题。此帧间位移判断匹配方法,计算复杂度低,条件判断简易,不仅可以快速的完成对运动目标的匹配跟踪而且可以解决运动目标在遮挡情况下的匹配问题。在匹配跟踪完成之后,每一帧都实时更新运动目标当前的位置信息,主要包括运动目标的中心点和多角点信息,以便后续完成对运动目标轨迹的记录和排查。

3.2 特征跟踪目标当帧间距离跟踪判断未找到匹配目标或者找到多个匹配目标时,就会造成帧间距离跟踪失效,而此时就需要启用各目标特征库信息完成对目标的匹配跟踪。本文采用的是目标图像的SIFT特征(表示为T)和目标图像的彩色直方图特征(R、G、B三通道的颜色直方图分别表示为HR、HG、HB)。在判断目标1与目标2是否匹配时,进行以下过程操作:

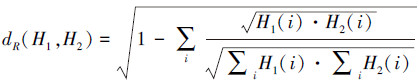

首先,分别计算两个目标彩色直方图在各颜色分量上的Bhattacharyya距离:

|

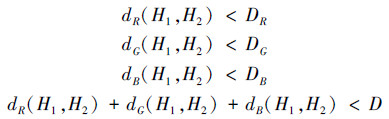

其次,在特征匹配过程中,首先,判断目标的彩色直方图各分量上的Bhattacharyya距离是否小于某一给定阈值D,即判断以下各式是否成立:

|

式中:DR、DG、DB分别为R、G、B颜色通道直方图的Bhattacharyya距离阈值,实验中均取值为0.5,D为三通道之和的总阈值,实验取值为1.0。

然后,对于满足上述条件的被测目标进行SIFT特征相似度判断,不满足条件的目标判断为新出现目标。

运用SIFT特征对目标图像匹配,首先在目标特征库中选定某个关键点,并找出其与分割出的目标图像中欧式距离最近的前两个关键点,如果最近的距离与次近的距离的比值小于某个阈值,则认为两者是一对匹配点,试验中,一般阈值取值为0.8。在特征库中搜索待匹配目标,如果当前目标与特征库中目标匹配点个数超过所有SIFT关键点的60%,则当前目标识别为满足该条件的匹配点对数最多的目标。

在跟踪过程中,目标的特征更新可以使算法及时且更完整地描述目标。因此,对于特征库中的每一个被匹配的目标,在匹配跟踪完成后需要对其特征库信息进行更新,对运动目标特征库内的彩色颜色直方图进行替换,对匹配成功的SIFT特征点进行保留,新出现的特征点进行添加。而文献[7]中并未体现出对跟踪目标的特征更新。

4 目标轨迹计算为了得到一个目标的连续轨迹和其在视频中出现的时间信息,需要在检测出视频前景运动目标后,记录每帧中目标出现的时间和其运动的轨迹。由于采用了双层码本的背景建模技术,每一个出现在视频中的运动目标可直接被检测。对于检测出的运动目标,首先判断目标是否为连续出现目标,如是连续出现目标,则需要将此目标的位置信息加入轨迹序列,并更新其最近一次出现的时间;对于未找到匹配的目标,则认为是新出现目标,标记当前时间为该目标的出现时间,并记录其起始运动位置。相比传统算法[13],本轨迹计算方法计算简单,执行效率高。

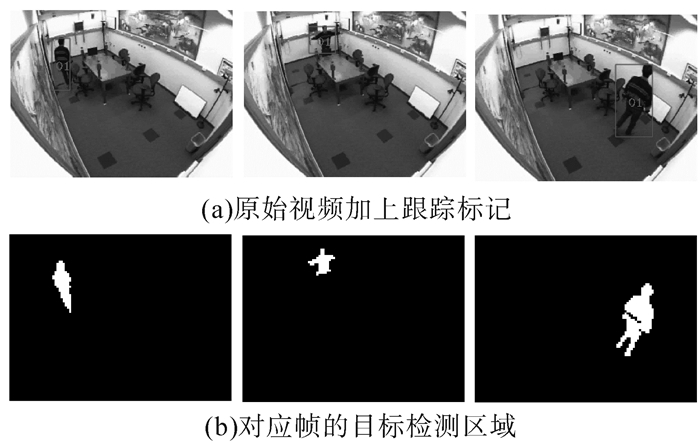

5 实验结果分析实验所用测试视频均是用固定摄像头拍摄的室内场景,2个测试视频为IntelligentRoom.avi和TwoCars.avi,分别用来测试单目标的检测跟踪和多目标的匹配跟踪。实验的环境为Windows 7操作系统下的Microsoft Visual Stuidio,并配置有OpenCV计算机视觉数据库。在测试实验中,首先,对测试视频IntelligentRoom.avi背景场景进行建模,利用背景差分法实现视频运动目标的检测,用二值图像表示,目标区域用高像素值,背景区域用低像素值,目标检测结果如图 3所示,图 3(a)为原始视频加上跟踪标记后的画面,图 3(b)画面白色区域为对应帧的目标检测的目标区域。从图 3(b)目标的检测中可以明显看出,双层码本模型可以较完整的检测出运动目标,并且对噪声有一定的鲁棒性。

|

| 图 3 目标检测结果 Fig. 3 Target detection result |

其次,需要记录其相应运动目标的运动轨迹,所用测试视频的运动目标轨迹如图 4所示。从图 4可以看出,此轨迹较好地反应了目标的行走路线并且没有出现断点,证明了算法可以有效地跟踪运动目标,并且完成对目标轨迹的记录。

|

| 图 4 目标运动轨迹 Fig. 4 Target trajectory |

为了验证算法可应对多目标的检测和跟踪,采用测试视频TwoCars.avi,视频中2辆小车从不同方向行驶进入视频画面,在图中央位置经过交叉后,分别驶出视频画面。实验结果如图 5所示,算法可以准确地定位运动目标并完成对多目标的匹配。

|

| 图 5 多运动目标的跟踪结果 Fig. 5 Multi-target tracking result |

从图 6可以看出,本文算法可以很好地实现目标跟踪,对于动态目标在视频中发生自身转动、尺度变化、部分遮挡等情况,也具有很好的识别效果。目标跟踪过程很好地实现了目标运动状态的记录,完整地记录了目标的运动轨迹。另外,可以对目标运动状态建立数据库,用以查询不同目标的运动状态,其中包含目标的轨迹、出现时间、目标的图像等信息。由此,可以满足一般监控视频针对车、人等目标活动情况的跟踪和记录。

6 结束语一般监控视频的跟踪任务只要求记录视频中目标的客观运动状态,包括目标出现时间、活动路径,目标图像等信息,因此,不需要考虑复杂的目标运动状态的预测。不同于传统由目标检测、预测、识别所构成的视频跟踪方法,本文的视频跟踪处理仅由目标检测和目标匹配识别构成,省去了预测的计算复杂度,用以处理一般监控视频。实验证明,本文方法可以很好地完成一般监控视频的目标运动状态的跟踪与记录,并可以克服目标遮挡和光照问题所带来的匹配跟踪问题。

由于不用建立复杂的预测模型,本文方法计算复杂度较低,由于动态目标是从原视频画面分割而来,目标图像尺寸较小,一个目标的SIFT特征点一般不会很多,因而,特征匹配速度较为理想,整个流程可以完成低帧率视频的实时处理。

由于采用了背景减除法自动得到运动目标,所以本算法不能应对移动摄像头的情景,只能局限在固定摄像头的目标跟踪。并且,由于引入了CodeBook的背景建模方法,在具体情况下还需要SIFT特征完成匹配,需要占用大量计算时间,实时性不高,无法处理30帧以上的视频。因此,本算法目前还只能适用于固定场景多目标缓慢变化的监控视频,在应用场景上有一定的局限性。未来的工作主要集中在对于视频中运动目标的旋转、尺度变化等问题,可以在运动目标的匹配方面深入探索新的特征表达和匹配方法。对运动目标的运动状态可以单独建立数据库,记录和查询目标的运动信息。另外,可以引入像ViBe一样的背景建模方法,不仅可以提高监控视频算法的鲁棒性,而且可以大幅度提高算法实时性。

| [1] | 李锴.基于粒子滤波与半监督多分类器的视频跟踪[D].上海:复旦大学, 2012: 6-8. LI Kai. Video tracking based on particle filter and semi-supervised multiple classifiers[D]. Shanghai:Fudan University, 2012: 6-8. http://cdmd.cnki.com.cn/article/cdmd-10246-1013101975.htm |

| [2] | 杨戈, 刘宏. 视觉跟踪算法综述[J]. 智能系统学报 , 2010, 5 (2) : 95-105 YANG Ge, LIU Hong. Survey of visual tracking algorithms[J]. CAAI Transactions on Intelligent Systems , 2010, 5 (2) : 95-105 |

| [3] | FAZLI S, POUR H M, BOUZARI H. Particle filter based object tracking with SIFT and color feature[C]//Second International Conference on Machine Vision. Dubai, UAE, 2009: 89-93. |

| [4] | ZHOU H, YUAN Y, SHI C. Object tracking using SIFT features and mean shift[J]. Computer Vision and Image Understanding , 2009, 113 (3) : 345-352 DOI:10.1016/j.cviu.2008.08.006 |

| [5] | BEYAN C, TEMIZEL A. Adaptive mean-shift for automated multi object tracking[J]. Computer Vision , 2012, 6 (1) : 1-12 DOI:10.1049/iet-cvi.2011.0054 |

| [6] | JIANG M, LI M, WANG H. A robust combined algorithm of object tracking based on moving object detection[C]//Intelligent Control and Information Processing. Dalian, China, 2010: 619-622. |

| [7] | RAHMAN M S, SAHA A, KHANUM S. Multi-object tracking in video sequences based on background subtraction and SIFT feature matching[C]//Fourth International Conference of Computer Sciences and Convergence Information Technology. Seoul, Korea, 2009: 457-462. |

| [8] | WREN C R, AZARBAYEJANI A, DARRELL T. Real-time tracking of the human body[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence , 1997, 19 (7) : 780-785 DOI:10.1109/34.598236 |

| [9] | PAKORN K, BOWDEN R. An improved adaptive background mixture model for real-time tracking with shadow detection[M]. New Youk: Springer, 2002 : 135 -144. |

| [10] | ZIVKOVIC Z. Improved adaptive Gaussian mixture model for background subtraction[C]//Proceedings of the 17th International Conference of Pattern Recognition. Cambridge, UK, 2004, 2: 28-31. |

| [11] | KIM K, CHALIDABHONGSE T H. Real-time foreground-background segmentation using codebook model[J]. Real-time Imaging , 2005, 11 (3) : 172-185 DOI:10.1016/j.rti.2004.12.004 |

| [12] | SIGARI M H, FATHY M. Real-time background modeling /subtraction using two-layer codebook model[C]//Proceedings of the International Multi-Conference of Engineers and Computer Scientists. Hong Kong, China, 2008: 19-21. |

| [13] | ZHU Y, LIANG Y, ZHU Y. The improved Gaussian mixture model based on motion estimation[C]//Proceedings of Third International Conference on Multimedia Information Networking and Security. Shanghai, China, 2011: 46-50. |

| [14] | 邹煜.基于轮廓提取和颜色直方图的图像检索[D].重庆:西南大学, 2011:28-29. ZOU Yu. Image retrieval method based on color histogram and contour extraction[D]. Chongqing:Southwest University, 2011: 28-29. http://cdmd.cnki.com.cn/article/cdmd-10635-1011112095.htm |

| [15] | LINDEBERG T. Scale-space theory: a basic tool for analyzing structures at different scales[J]. Journal of Applied Statistics , 1994, 21 (1/2) : 225-270 |

| [16] | LOWE D G.Object recognition from local scale-invariant features[C]//The Proceedings of the Seventh IEEE International Conference of Computer Vision.Kerkyra, Greece, 1999, 2: 1150-1157. |

| [17] | LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision , 2004, 60 (2) : 91-110 DOI:10.1023/B:VISI.0000029664.99615.94 |

| [18] | 赵雷, 陈万忠, 韩双双. 一种改进的运动目标跟踪与轨迹记录算法[J]. 智能系统学报 , 2008, 3 (2) : 145-149 ZHAO Lei, CHEN Wanzhong, HAN Shuangshuang. An improved algorithm for tracking and recording moving targets[J]. CAAI Transactions on Intelligent Systems , 2008, 3 (2) : 145-149 |