2. 吉林大学 计算机科学与技术学院, 吉林 长春 130012

2. College of Computer Science and Technology, Jilin University, Changchun 130012, China

设计类问题在科学研究和工业设计等领域无处不在.例如:编程人员通过选择恰当的算法来优化系统性能; 环境学家通过设计传感器部署位置来监控环境状况; 化学家通过设计实验来获取新的物质; 制药厂商通过设计新型药物来抵抗疾病; 食品厂商通过设计新的食谱来生产优质食品等等.通常, 将这些设计问题考虑成如下最优化问题加以求解(本文只考虑最小化问题, 最大化问题可简单通过取负号操作转换成最小化问题):

| $ {{\mathit{\boldsymbol{x}}}^{*}}=\arg {{\min }_{x\in \mathcal{X}\subseteq {{\mathbb{R}}^{d}}}}f(\mathit{\boldsymbol{x}}) $ | (1) |

其中, x表示d维决策向量,

近年来, 大数据应用的发展给物理学、生物学、环境生态学、计算机科学等领域以及军事、金融、通信等行业带了巨大的生机.这些大数据应用通常都存在以下特点:大规模用户量、极其复杂的软件系统、大规模异构计算和分布式存储架构.这些复杂应用包含大量的设计决策, 并且更为复杂, 其优化目标不仅具有多峰、非凸、高维、决策空间巨大等常见特征, 通常还具有黑箱和评估代价高昂等新特点.优化目标不存在明确的数学表达, 并且需要花费高额代价才能观测到目标函数的返回值.例如:在研制某癌症的有效药物问题中, 药物配方可以作为决策空间, 药物效果(药物效果用药物能够治愈病人的概率大小来描述)作为函数输出, 临床实验作为评估药物效果的手段, 目标是找到一种药物配方, 使得药物能够最大概率地治愈病人.在该问题中, 目标函数很难写成一个明确的数学表达式, 评估函数过程可能会导致病人死亡.显然, 这样的评估代价是巨大的.

针对具有以上特征的复杂设计问题, 贝叶斯优化(Bayesian optimization, 简称BO)是一种有效的解决方法[1].贝叶斯优化在不同的领域也称作序贯克里金优化(sequential Kriging optimization, 简称SKO)、基于模型的序贯优化(sequential model-based optimization, 简称SMBO)、高效全局优化(efficient global optimization, 简称EGO).该方法是一种基于模型的序贯优化(即, 在一次评估之后才进行下一次评估)方法, 能够在很少的评估代价下得到一个近似最优解.贝叶斯优化已经应用于网页[2-4]、游戏[5]和材料设计[6]、推荐系统[7, 8]、用户界面交互[9, 10]、机器人步态[11]、导航[12]和嵌入式学习系统[13]、环境监控[14]、组合优化[15, 16]、自动机器学习[17-22]、传感器网络[23, 24]等领域, 展示出令人瞩目的发展前景.

本文主要综述了贝叶斯优化方法的研究和应用领域.第1节引入贝叶斯优化的主要框架, 并深入分析其优化原理.第2节从模型选择角度介绍贝叶斯优化中两个核心组成部分:概率代理模型和采集函数.第3节介绍贝叶斯优化过程中涉及的近似和优化技术.第4节综述贝叶斯优化方法的扩展及当前应用领域.第5节讨论其在未来发展中将面临的问题与挑战.第6节对其进行总结.

1 贝叶斯优化概率模型已经成为当前人工智能、机器人学、机器学习等领域的主流方法[25].机器能够根据概率框架预测未来数据, 并且根据预测数据给出决策.这些问题的主要难点在于观测值具有不确定性, 而概率模型能够对不确定性进行建模, 有效地解决观测噪声问题.Ghahramani指出, 贝叶斯优化是在概率机器学习和人工智能领域中几种最先进、最有希望的技术之一[25].

1.1 贝叶斯优化框架贝叶斯优化是一种十分有效的全局优化算法, 目标是找到公式(1)中的全局最优解.贝叶斯优化有效地解决了序贯决策理论中经典的机器智能(machine-intelligence)问题:根据对未知目标函数f获取的信息, 找到下一个评估位置, 从而最快地达到最优解[26].例如:若已经评估得到3个不同输入x1, x2, x3的目标函数值y1, y2, y3, 则如何选择下一个评估点?贝叶斯优化框架能够在少数次评估下得到复杂目标函数的最优解, 本质上, 因为贝叶斯优化框架使用代理模型拟合真实目标函数, 并根据拟合结果主动选择最有“潜力”的评估点进行评估, 避免不必要的采样, 因此, 贝叶斯优化也称作主动优化(active optimization).同时, 贝叶斯优化框架能够有效地利用完整的历史信息来提高搜索效率.

贝叶斯优化之所以称作“贝叶斯”, 是因为优化过程中利用了著名的“贝叶斯定理”:

| $ p(f|{{D}_{1:t}})=\frac{p({{D}_{1:t}}|f)p(f)}{p({{D}_{1:t}})} $ | (2) |

其中, f表示未知目标函数(或者表示参数模型中的参数); D1:t={(x1, y1), (x2, y2), …, (xt, yt)}表示已观测集合, xt表示决策向量, yt=f(xt)+εt表示观测值, εt表示观测误差; p(D1:t|f)表示y的似然分布, 由于观测值存在误差, 所以也称为“噪声”; p(f)表示f的先验概率分布, 即, 对未知目标函数状态的假设; p(D1:t)表示边际化f的边际似然分布或者“证据”, 由于该边际似然存在概率密度函数的乘积和积分, 通常难以得到明确的解析式, 该边际似然在贝叶斯优化中主要用于优化超参数(hyper-parameter); p(f|D1:t)表示f的后验概率分布, 后验概率分布描述通过已观测数据集对先验进行修正后未知目标函数的置信度.

贝叶斯优化框架主要包含两个核心部分——概率代理模型(probabilistic surrogate model)和采集函数(acquisition function).

● 概率代理模型包含先验概率模型和观测模型:先验概率模型即p(f); 观测模型描述观测数据生成的机制, 即似然分布p(D1:t|f).更新概率代理模型意味着根据公式(2)得到包含更多数据信息的后验概率分布p(f|D1:t).

● 采集函数是根据后验概率分布构造的, 通过最大化采集函数来选择下一个最有“潜力”的评估点.同时, 有效的采集函数能够保证选择的评估点序列使得总损失(loss)最小.损失有时表示为regret:

| $ {{r}_{t}}=|{{y}^{*}}-{{y}_{t}}| $ | (3) |

或累计regret:

| ${{R}_{t}}=\sum\nolimits_{i=1}^{t}{{{r}_{i}}} $ | (4) |

其中, y*表示当前最优解.

贝叶斯优化框架是一个迭代过程, 主要包含3个步骤:第1步, 根据最大化采集函数来选择下一个最有“潜力”的评估点xt; 第2步, 根据选择的评估点xt评估目标函数值yt=f(xt)+εt; 第3步, 把新得到的输入-观测值对{xt, yt}添加到历史观测集D1:t-1中, 并更新概率代理模型, 为下一次迭代作准备.算法1为贝叶斯优化框架伪代码.

算法1.贝叶斯优化框架.

1: for t=1, 2, … do

2: 最大化采集函数, 得到下一个评估点:

3: 评估目标函数值yt=f(xt)+εt;

4: 整合数据:Dt=Dt-1∪{xt, yt}, 并且更新概率代理模型;

5: end for

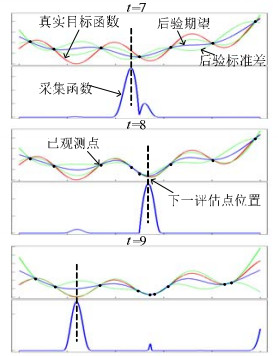

图 1为贝叶斯优化框架应用在一维函数f(x)=(x-0.3)2+0.2×sin(20×x)上3次迭代的示例.

|

Fig. 1 An example of using Bayesian optimization on a 1D function f(x)=(x-0.3)2+0.2×sin(20×x) 图 1 贝叶斯优化在一维函数f(x)=(x-0.3)2+0.2×sin(20×x)上的示例 |

图 1中:横坐标表示决策空间, 即x取值范围; 迭代子图的上方曲线包含:真实目标函数、加入信息的后验期望(即, 预测的函数曲线)以及加减两倍后验标准差(即, 不确定性); 子图下方曲线表示采集函数; 竖虚线表示采集函数最大化位置, 即下一评估点位置; 实心点表示已观测点, 从上到下依次为第7次~第9次迭代.从图中可以看到, 每次迭代选择的评估点都是上次迭代采集函数最大化的位置.在迭代过程中, 预测函数形状和采集函数形状都在变化, 这是因为, 概率代理模型接收新数据后在不断更新.

1.2 贝叶斯优化原理当优化危险化学试剂成分时, 错误的试剂成分融合可能发生毁灭性的爆炸; 当优化药物配方时, 潜在致命的药物配方可能导致临床病人死亡; 当优化航天飞机零部件配置时, 不科学的零部件尺寸、结构配置可能导致航天飞机的运行不稳定甚至发生严重的航天事故.由于对这些优化目标进行评估时会花费大量的时间、费用乃至危害生命, 因此, 在优化时通常希望在少量评估代价下得到满意解.相比其他无模型(model-free)优化算法(如进化计算和局部搜索等)关注于对求解效率的提升, 贝叶斯优化更侧重于减少评估代价, 保证其能够仅经过少数次目标函数评估即可得到近优解.

在最优化采集函数的前提下, 贝叶斯优化能够在理论上保证最终收敛[1].直观上, 这是因为迭代过程中每次迭代都采样最有“潜力”的点进行评估, 只要保证足量的迭代次数, 算法最终一定会收敛到全局最优解.当贝叶斯优化选择高斯过程代理黑箱函数, 并使用置信边界主动选择策略时, Srinivas等人证明, 该方法能够保证公式(4)对迭代次数t是亚线性的, 即:当迭代次数t趋于无穷时, 公式(4)趋于0[23].具体见第2.2.2节.

表 1为贝叶斯优化与其他优化算法特点的比较.进化计算、局部搜索等无模型优化算法也能优化黑箱函数.这些方法通过选择、交叉、变异等操作模拟生物进化和群体智能过程, 或者根据邻域信息探索最优解.相比于此, 贝叶斯优化利用概率模型代理复杂黑箱函数.概率模型中引入了待优化目标的先验知识, 使模型能够更准确地满足黑箱函数的行为, 有效地减少不必要的采样.K摇臂赌博机等需要利用各决策之间相互独立等强假设, 与之相比, 贝叶斯优化在使用高斯过程代理黑箱函数时, 能够仅通过一致连续或利普希茨连续(Lipschitz continuity)等局部平滑性弱假设, 即可得到满意结果.局部平滑性等弱假设更符合实际问题, 并且能够使贝叶斯优化有效地利用局部邻近信息进行更准确的推断, 从而更准确地选择“潜力”点.贝叶斯优化为参数引入不确定性, 通过样本修正参数先验, 并且在参数优化时利用贝叶斯方法, 考虑参数的先验分布, 通过平均得到参数, 因此相比使用最大似然估计拟合参数等方法, 该方法不易发生“过拟合”.贝叶斯优化通过主动选择策略来确定下一个最有“潜力”的评估点.相比无模型优化方法的随机跳转或邻域搜索策略, 主动选择策略利用历史信息和不确定性, 通过最大化根据模型后验分布构造的采集函数, 能够有效地平衡宽度搜索(探索不确定性区域获取更多未知信息)与深度搜索(利用已有信息寻找当前最优)之间的关系, 从而减少不必要的目标函数评估.

| Table 1 Features of optimization algorithms 表 1 几种优化算法特点对比 |

虽然贝叶斯优化具有多方面的优势, 但该方法仍存在以下局限性.

1) 无模型优化算法不需要考虑模型更新问题, 而贝叶斯优化在更新概率代理模型时需要高昂的计算开销.如:在使用高斯过程代理黑箱函数时, 模型更新的时间复杂度为立方阶.一些研究采用近似技术和并行方法降低模型复杂度, 提高计算效率, 以缓解更新概率模型计算开销大的问题, 具体见第3.1节和第4.1.2节;

2) 相比无模型的优化方法, 贝叶斯优化需要谨慎地选择模型和先验.在使用贝叶斯方法解决具体问题时, 需要根据问题背景和专家知识选择合适的概率模型来代理黑箱函数.为贝叶斯优化选择合适的概率代理模型, 甚至比选择恰当的采集函数更为重要.目前, 还不存在一种通用的方法为贝叶斯优化选择合适的代理模型和先验分布, 都是采取具体问题具体分析的策略.

根据以上特点分析, 贝叶斯优化适合求解优化目标存在多峰、非凸、黑箱、存在观测噪音并且评估代价高昂等特点的问题, 例如危险化学试剂实验、危害生命的药物测试、航空航天测试等等.但这些需要我们根据具体问题选择合适的模型代理模型和采集策略, 才能充分发挥贝叶斯优化方法的潜力.

2 模型选择贝叶斯优化框架有两个关键部分:(1)使用概率模型代理原始评估代价高昂的复杂目标函数; (2)利用代理模型的后验信息构造主动选择策略, 即采集函数.在实际应用中, 需要针对具体问题选择合适的模型.本节介绍贝叶斯优化中常用的概率代理模型和采集函数.在本节最后, 汇总常用概率代理模型和采集函数, 并系统地介绍各自方法的优劣及适用范围.

2.1 概率代理模型概率代理模型用于代理未知目标函数, 从假设先验开始, 通过迭代地增加信息量、修正先验, 从而得到更加准确的代理模型.概率代理模型根据模型的参数个数是否固定可分为:参数模型和非参数模型.

2.1.1 参数模型参数个数固定的概率模型称作参数模型.该模型在数据量增加和优化过程中, 参数个数始终保持不变.使用w表示概率代理模型中的参数.由于w是模型中的隐变量, 假设其服从先验概率分布p(w).在参数w条件下观测数据的似然分布为p(D1:t|w).根据“贝叶斯”定理, 可以得到:

| $ p(\mathit{\boldsymbol{w}}|{{D}_{1:t}})=\frac{p({{D}_{1:t}}|\mathit{\boldsymbol{w}})p(\mathit{\boldsymbol{w}})}{p({{D}_{1:t}})} $ | (5) |

p(w|D1:t)表示经过观测数据D1:t修正后w的后验概率分布.注意到, 边际似然p(D1:t)与w无关, 通常用于优化超参数或为常量.由于公式(5)的分子是两个概率密度函数的乘积, 且分母是分子在参数w上的积分形式, 所以后验概率分布一般难以得到封闭解.通常的解决方法是:为参数w选择一个针对似然分布的共轭先验分布, 使得到的后验概率分布与先验分布具有相同的表达形式, 便于计算.下面给出贝叶斯优化中几种常见的参数模型.

1) 贝塔-伯努利(Beta-Bernoulli)模型

首先讨论最简单的概率代理模型:贝塔-伯努利模型.再次用药物设计问题举例, 假设存在K种药物, 希望治愈患者, 但前提是不知道哪种药物是有效的, 并且药物的有效性只能通过临床实验评估.目标是识别有效药物去治愈患者.这里, 首先假设所有药物的有效性相互独立, 即, 不能通过观察一种药物的有效性推断出另一种药物的有效性.定义参数w为药物的有效概率.让患者服用一种药物后, 假设能够观测到的y值只有两个状态, 即y∈ {0, 1}.亦即观测模型p(D1:t|w)为伯努利分布.为方便计算, 假设w的先验分布p(w)为贝塔分布(伯努利分布与贝塔分布是共轭的):

| $ p(\mathit{\boldsymbol{w}}|\alpha, \beta )=\prod\nolimits_{i=1}^{K}{Beta({{w}_{i}}|\alpha, \beta )} $ | (6) |

其中,

概率分布为

| $ p(\mathit{\boldsymbol{w}}|{{D}_{1:t}})=\prod\nolimits_{i=1}^{K}{Beta({{w}_{i}}|\alpha +{{n}_{i, 1}}, \beta +{{n}_{i, 0}})} $ | (7) |

其中, ni, 1表示服用第i种药物成功治愈人数, ni, 0表示服用第i种药物导致死亡人数.

贝塔-伯努利模型不仅可以应用于药物设计问题, 也可以应用于A/B测试[3]、推荐系统[4]等领域.

2) 线性(linear)模型

在许多应用中, 通常假设各决策之间相互独立.如在网页设计中, 考虑页面布局、字体大小、颜色、按钮样式等5种因素, 并且每种因素包含5种选择, 因此, 总共有625种页面配置.若使用贝塔-伯努利模型, 需要假设每种配置相互独立, 因此, 为保证有效性, 每种配置都需要至少一次评估.因此, 该方法不适合解决决策空间庞大的问题.然而, 通过建立线性模型捕获各配置之间的关系, 根据一种配置的表现来推断其他配置的表现, 能够达到减少评估次数的目的[1].

在线性模型中, 首先假设每种配置i都存在一个d维的特征向量mi∈

| $ {{f}_{\mathit{\boldsymbol{w}}}}({{\mathit{\boldsymbol{m}}}_{i}})=\mathit{\boldsymbol{m}}_{i}^{T}\mathit{\boldsymbol{w}} $ | (8) |

其中, w表示权值向量.观测量yi=fw(mi)+εi, 观测模型的形式取决于具体数据性质.假设噪声εi满足独立同分布:

| $ p({{y}_{i}}|\mathit{\boldsymbol{w}}, \sigma )=\mathcal{N}(\mathit{\boldsymbol{m}}_{i}^{T}\mathit{\boldsymbol{w}}, \sigma _{i}^{2}) $ | (9) |

定义y为t维观测向量.由于高斯似然, 方便起见, 假设参数w, σ服从Normal-Inverse-Gamma分布:

| $ \begin{array}{l} p(\mathit{\boldsymbol{w}}, \sigma |{\mu _0}, {\mathit{\boldsymbol{V}}_0}, {\alpha _0}, {\beta _0}) = {\cal N}{\cal I}{\cal G}({\mathit{\boldsymbol{\mu }}_0}, {\mathit{\boldsymbol{V}}_0}, {\alpha _0}, {\beta _0}) = |2\pi {\sigma ^2}{V_0}{|^{ - \frac{1}{2}}} \times \frac{{\beta _0^{{\alpha _0}}}}{{\mathit{\Gamma }({\alpha _0}){\sigma ^{2{\alpha _0} + 2}}}} \times \\ \exp \left( { - \frac{{{{(\mathit{\boldsymbol{w}} - {\mathit{\boldsymbol{\mu }}_0})}^T}\mathit{\boldsymbol{V}}_0^{ - 1}(\mathit{\boldsymbol{w}} - {\mathit{\boldsymbol{\mu }}_0}) + 2{\beta _0}}}{{2{\sigma ^2}}}} \right) \end{array} $ | (10) |

其中, μ0, V0, α0, β0为超参数, μ0为d维向量, V0为d×d的矩阵.由于Normal-Inverse-Gamma分布与高斯分布共轭, 容易得到w, σ的后验分布:

| $ p(\mathit{\boldsymbol{w}}, \sigma |{D_{1:t}}) = {\cal N}{\cal I}{\cal G}({\mathit{\boldsymbol{\mu }}_t}, {\mathit{\boldsymbol{V}}_t}, {\alpha _t}, {\beta _t}) $ | (11) |

其中,

| $ {\mathit{\boldsymbol{\mu }}_t} = {\mathit{\boldsymbol{V}}_t}(\mathit{\boldsymbol{V}}_0^{ - 1}{\mathit{\boldsymbol{\mu }}_0} + {\mathit{\boldsymbol{M}}^T}\mathit{\boldsymbol{y}}) $ | (12) |

| $ {\mathit{\boldsymbol{V}}_t} = {(\mathit{\boldsymbol{V}}_0^{ - 1} + {\mathit{\boldsymbol{M}}^T}\mathit{\boldsymbol{M}})^{ - 1}} $ | (13) |

| $ {\alpha _t} = {\alpha _0} + \frac{t}{2} $ | (14) |

| $ {\beta _t} = {\beta _0} + \frac{1}{2}(\mathit{\boldsymbol{\mu }}_0^T\mathit{\boldsymbol{V}}_0^{ - 1}{\mathit{\boldsymbol{\mu }}_0} + {\mathit{\boldsymbol{y}}^T}\mathit{\boldsymbol{y}} - \mathit{\boldsymbol{\mu }}_t^T\mathit{\boldsymbol{V}}_t^{ - 1}{\mathit{\boldsymbol{\mu }}_t}) $ | (15) |

公式(8)仅考虑线性关系, 然而在大多数实际问题中, mi与fw(mi)通常存在非线性关系.此时, 可以通过使用K个非线性基函数

| $ {f_\mathit{\boldsymbol{w}}}\left( {{\mathit{\boldsymbol{m}}_i}} \right) = ({\varphi _1}\left( {{\mathit{\boldsymbol{m}}_i}} \right), {\varphi _2}\left( {{\mathit{\boldsymbol{m}}_i}} \right), \ldots, {\varphi _K}\left( {{\mathit{\boldsymbol{m}}_i}} \right))\mathit{\boldsymbol{w}} $ | (16) |

其中, 权重参数w为K维向量.比较常用的基函数有径向基函数

3) 广义线性(generalized linear)模型

上面提到的线性模型能够捕获决策之间的关系, 但仅考虑了实数型的观测量.为了推广线性模型处理其他类型的观测量(如整型), Neider等人提出了广义线性模型(GLMs), 通过link function把观测量从观测量空间映射到实数空间, 使得能够处理的观测量类型更加灵活[27].

2.1.2 非参数模型在机器学习中, 高度灵活的模型通常能够得到满意的预测效果.这是因为这些模型具有高可扩展性等特点.一般有两种方法扩展模型的灵活性.

(1) 使参数模型拥有比数据集更多的参数.例如:目前用于翻译英语和法语的神经网络拥有3亿8千4百万个参数[28];

(2) 使用非参数模型.在非参数模型中, 模型的参数随着数据量的增加而增加, 甚至存在无限多个参数.因此, 相比参数固定的参数模型, 非参数模型更加灵活, 并且使用贝叶斯方法不易发生“过拟合”[25].

1) 高斯过程

高斯过程(Gaussian processes, 简称GPs)是常用的一种非参数模型, 目前, 高斯过程已被广泛应用在回归、分类以及许多需要推断黑箱函数的领域中[29].GaussianFace[30]是高斯过程在人脸识别上的应用, 该应用在人脸识别领域的表现胜过其他深度学习方法甚至人类.通常情况下, 神经网络和高斯过程之间有这样一个联系:存在无限多个隐层单元的神经网络等价于高斯过程[31].

高斯过程是多元高斯概率分布的范化[29].一个高斯过程由一个均值函数m:

| $f\left( \mathit{\boldsymbol{x}} \right) \sim {\cal G}{\cal P}(m\left( \mathit{\boldsymbol{x}} \right), k(\mathit{\boldsymbol{x}}, \mathit{\boldsymbol{x'}})) $ | (17) |

其中, 均值函数m(x)=

高斯过程是一个随机变量的集合, 存在这样的性质:任意有限个随机变量都满足一个联合高斯分布[29].首先假设一个0均值的先验分布p(f|X, θ):

| $ p(\mathit{\boldsymbol{f}}|\mathit{\boldsymbol{X}}, \mathit{\boldsymbol{\theta }}) = {\cal N}(0, \mathit{\boldsymbol{ \boldsymbol{\varSigma} }}) $ | (18) |

其中, X表示训练集{x1, x2, …, xt}, f表示未知函数f的函数值集合{f(x1), f(x2), …, f(xt)}, Σ表示k(x, x')构成的协方差矩阵(Σi, j=k(xi, xj)), θ表示超参数.

当存在观测噪声时, 即y=f(x)+ε, 且假设噪声ε满足独立同分布的高斯分布:p(ε)=

| $ p\left( {\mathit{\boldsymbol{y}}|\mathit{\boldsymbol{f}}} \right) = {\cal N}(\mathit{\boldsymbol{f}}, {\sigma ^2}\mathit{\boldsymbol{I}}) $ | (19) |

其中, y表示观测值集合{y1, y2, …, yt}.

根据公式(18)和公式(19), 可以得到边际似然分布:

| $ p(\mathit{\boldsymbol{y}}|\mathit{\boldsymbol{X}}, \mathit{\boldsymbol{\theta }}) = \int {p(\mathit{\boldsymbol{y}}|\mathit{\boldsymbol{f}})p(\mathit{\boldsymbol{f}}|\mathit{\boldsymbol{X}}, \mathit{\boldsymbol{\theta }}){\rm{d}}\mathit{\boldsymbol{f}}} = {\cal N}(\mathit{\boldsymbol{0}}, \mathit{\boldsymbol{ \boldsymbol{\varSigma} }} + {\sigma ^2}\mathit{\boldsymbol{I}}) $ | (20) |

通常, 通过最大化该边际似然分布优化超参数θ.

根据高斯过程的性质, 存在如下联合分布:

| $ \left[{\begin{array}{*{20}{c}} \mathit{\boldsymbol{y}}\\ {{\mathit{\boldsymbol{f}}_*}} \end{array}} \right] \sim N\left( {{\bf{0}}, \left[{\begin{array}{*{20}{c}} {\mathit{\boldsymbol{\Sigma }} + {\sigma ^2}\mathit{\boldsymbol{I}}}&{{K_*}}\\ {K_*^T}&{{K_{**}}} \end{array}} \right]} \right) $ | (21) |

其中, f*表示预测函数值, X*表示预测输入,

根据公式(21), 容易得到如下预测分布:

| $ p({\mathit{\boldsymbol{f}}_*}|\mathit{\boldsymbol{X}}, \mathit{\boldsymbol{y}}, {\mathit{\boldsymbol{X}}_*}) = {\cal N}\left( {\left\langle {{\mathit{\boldsymbol{f}}_*}} \right\rangle, {\rm{cov}}({\mathit{\boldsymbol{f}}_*})} \right) $ | (22) |

| $ \langle {\mathit{\boldsymbol{f}}_*}\rangle = K_*^T{[\mathit{\boldsymbol{ \boldsymbol{\varSigma} }} + {\sigma ^2}\mathit{\boldsymbol{I}}]^{ - 1}}\mathit{\boldsymbol{y}} $ | (23) |

| $ {\mathop{\rm cov}} ({\mathit{\boldsymbol{f}}_*}) = {K_{**}} - K_*^T{[\mathit{\boldsymbol{ \boldsymbol{\varSigma} }} + {\sigma ^2}\mathit{\boldsymbol{I}}]^{ - 1}}{K_*} $ | (24) |

其中, 〈f*〉表示预测均值, cov(f*)表示预测协方差(若f*为标量, 则〈f*〉表示均值, cov(f*)表示协方差; 若f*为向量, 则〈f*〉表示均值向量, cov(f*)表示协方差矩阵).

先验均值函数表示目标函数期望的偏移量.为了增加模型的解释性同时方便先验信息的表达, 可以明确地指定先验均值函数m(x).这时, 预测协方差与公式(24)相同, 预测均值变为

| $ \langle {\mathit{\boldsymbol{f}}_*}\rangle = m({\mathit{\boldsymbol{X}}_*}) + K_*^T{[\mathit{\boldsymbol{ \boldsymbol{\varSigma} }} + {\sigma ^2}\mathit{\boldsymbol{I}}]^{ - 1}}(\mathit{\boldsymbol{y}} - m({\mathit{\boldsymbol{X}}_*})) $ | (25) |

然而, 在实际应用中, 指定一个明确的、合理的先验均值函数十分困难[29].所以, 为了简便, 通常假设先验均值函数为恒0函数, 即m(x)=0.注意到:当m(x)=0时, 通过数据修正后的后验均值(见公式(23))并不限制为0, 因此, 该假设对后验准确性几乎不影响.

在高斯过程中存在这样一致连续或利普希茨连续的平滑性假设:当输入点xi和xj之间距离特别近时, 相应的观测值yi和yj是相似的.因此, 预测样本附近的训练样本能够提供更多信息.协方差函数是高斯过程中计算两个数据点之间相似性的函数, 它指定了未知目标函数的平滑性和振幅.因此, 对协方差函数的选择直接影响着高斯过程与数据性质之间的匹配程度.

在实际应用中, 只有选择合适的协方差函数才能保证得到理想的预测效果.协方差函数一般分为平稳(stationary)协方差函数(平稳的协方差函数满足k(x, x')=k(x-x'))和非平稳协方差函数.若目标函数具有非平稳性, 可以直接使用非平稳协方差函数[32]或者通过把目标函数分离成多个平稳区域, 并在每个区域内使用平稳协方差函数[33]的方法来处理.

常用的平稳协方差函数有平方指数(squared exponential)协方差函数、指数(exponential)协方差函数和Matérn协方差函数等等.

Matérn协方差函数簇是一类高灵活性的协方差函数, 具体函数表达式如下:

| $ {k_{Mat\acute{e} rn - v}}(r) = \frac{{{2^{1 - v}}}}{{\Gamma (v)}}{\left( {\frac{{\sqrt {2v} r}}{l}} \right)^v}{K_v}\left( {\frac{{\sqrt {2v} r}}{l}} \right) $ | (26) |

其中, r=|x-x'|, v为平滑参数, l为尺度参数, Kv为第二类变形贝塞尔函数[34].

从使用Matérn协方差函数的高斯过程中采样的目标函数f(x)是

| Table 2 Common Matérn covariance functions 表 2 常用Matérn协方差函数 |

当v=1/2时, Matérn协方差函数也称作指数协方差函数, 对应的过程均方连续但不满足均方可微, 所以局部存在较大波动.当v→∞时, 对应的协方差函数也称作平方指数协方差函数或者高斯协方差函数, 对应的过程无限均方可微, 高度平滑.

当x为d维时, 可以为每个维度指定一个尺度参数lj, 其中, 1≤j≤d.这样的协方差函数实现了自动相关确定(automatic relevance determination, 简称ARD)[31].因为尺度参数的倒数决定了该维度的相关性, 即:若lj很大, 则该维度几乎独立, 这样能够有效地识别并去除不相关维度.

当x属于离散类型或分类类型时, 使用汉明(Hamming)协方差函数的高斯过程通常具有良好的表现; 并且当x为二元维度时, 使用带自动相关确定的高斯协方差函数能够有效地计算二元维度之间的加权汉明距离.

也可根据问题特性使用有效协方差组合.更多的协方差函数在文献[29]中有详细介绍.

2) 随机森林

随机森林回归是一种十分适合并行化的回归方法[35], 该方法属于集成学习, 即, 通过组合多个弱学习器来提高预测精度.随机森林回归构造多棵决策树, 每棵决策树通过从训练数据中有放回的采样进行训练.当需要预测时, 把采样点输入到每棵决策树中, 并得到每棵树的预测均值, 然后通过投票机制得到最终预测结果.

与高斯过程高昂的更新代价相比, 随机森林方法具有极其优秀的计算效率.由于其计算的高效性和对大规模数据集的有效性, 该方法已成功地应用于自动算法配置领域[33].

虽然随机森林回归在训练数据附近能够快速得到高精度预测, 但在远离训练数据时的预测效果通常很差, 并且该方法的响应面是非连续、不可微的, 因此不能对其使用基于梯度的优化方法.

3) 深度神经网络

深度神经网络通常是指层数超过2层的神经网络, 虽然具有无限多个隐层单元的神经网络等价于高斯过程, 但该神经网络具有无穷多个参数, 无法训练.为了减少参数个数, 一种常用的方法就是增加神经网络的深度.

近年来, 由于其优越的性能, 深度神经网络已成功应用于语音识别[36]、机器视觉[37]等领域.在贝叶斯优化领域中, 深度神经网络同样得到重视.一些研究者通过使用深度神经网络代理未知目标函数, 以提升模型处理大规模数据的能力[38, 39].然而, 若想得到理想效果的函数近似, 需要合理地设计神经网络架构, 如层数、每层的神经元个数等.如何设计合理的神经网络架构, 仍是具有挑战性的问题.

2.2 采集函数前一节介绍了代理复杂黑箱目标函数的概率模型, 并介绍了如何结合新样本进行模型更新.本节介绍在贝叶斯优化中, 选择下一个评估点的主动策略:采集函数.所谓采集函数就是从输入空间

| $ {\mathit{\boldsymbol{x}}_{t + 1}} = {\max _{\mathit{\boldsymbol{x}} \in \chi }}{\alpha _t}(\mathit{\boldsymbol{x}};{D_{1:t}}) $ | (27) |

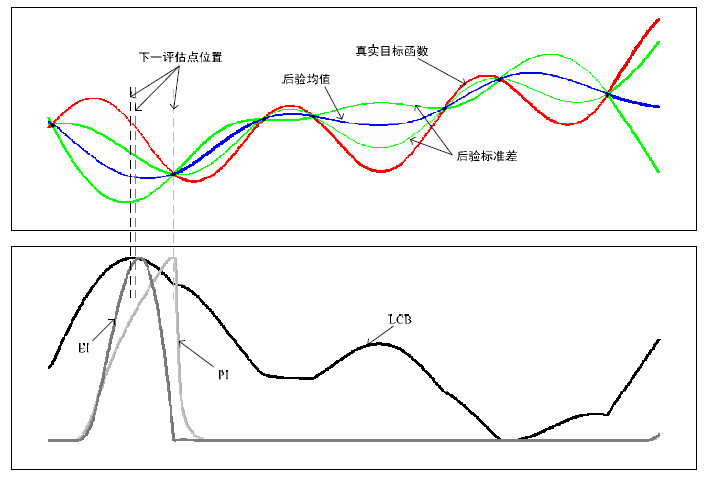

为方便描述, 本节不考虑采集函数对超参数的依赖, 对超参数的优化将在第3.2.1节加以介绍.图 2所示为几种常用采集函数对比.

|

Fig. 2 Comparison of several common acquisition functions 图 2 几种常用采集函数对比 |

2.2.1 基于提升的策略

基于提升的策略偏好选择对于当前最优目标函数值有所提升(这里的提升是指比当前目标函数值要小)的位置作为评估点.

PI(probability of improvement)量化了x的观测值可能提升当前最优目标函数值的概率[40].PI的采集函数为

| $ {\alpha _t}(\mathit{\boldsymbol{x}};{D_{1:t}}) = p(f(\mathit{\boldsymbol{x}}) \le {v^*} - \xi ) = \phi \left( {{{{{v^*} - \xi - {\mu _t}(\mathit{\boldsymbol{x}})} \over {{\sigma _t}(\mathit{\boldsymbol{x}})}}}} \right) $ | (28) |

其中, v*表示当前最优函数值, ϕ(·)为标准正态分布累积密度函数, ζ为平衡参数(用于平衡局部和全局搜索之间关系的参数, 一般人为设定).如图 2所示:在当前最优解附近时, 公式(28)的取值很大, 并且在远离当前最优解时取值很小.对参数ζ的调整, 能够在一定程度上解决陷入局部最优的问题.当ζ较大时, f(x)≤v*-ζ在决策空间上的概率都较小, 公式(28)整体平缓, 此时, PI策略更针对全局检索; 反之, 当ζ较小时, 公式(28)整体相对挺拔, PI策略更针对局部检索[41].

虽然PI策略能够选择提升概率最大的评估点, 但是PI策略把所有提升看成是等量的, 只反映了提升的概率而没有反映提升量的大小.

Močkus等人提出了一种新的基于提升的策略:EI(expected improvement)[42], EI策略的采集函数为

| $ {\alpha _t}(\mathit{\boldsymbol{x}};{D_{1:t}}) = \left\{ {\begin{array}{*{20}{l}} {({v^*} - {\mu _t}(\mathit{\boldsymbol{x}}))\phi \left( {{{{{v^*} - {\mu _t}(\mathit{\boldsymbol{x}})} \over {{\sigma _t}(\mathit{\boldsymbol{x}})}}}} \right) + {\sigma _t}(\mathit{\boldsymbol{x}})\phi \left( {{{{{v^*} - {\mu _t}(\mathit{\boldsymbol{x}})} \over {{\sigma _t}(\mathit{\boldsymbol{x}})}}}} \right), {\rm{ }}{\sigma _t}(\mathit{\boldsymbol{x}}) > 0}\\ {0, \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ {\sigma _t}(\mathit{\boldsymbol{x}}) = 0} \end{array}} \right. $ | (29) |

其中, ϕ(·)为标准正态分布概率密度函数.如图 2所示:EI策略选择的x与PI策略有所不同, 因为EI策略的采集函数包含公式(28), 既整合了提升概率又体现了不同的提升量.当然, EI策略同样可以包含平衡参数ζ, 以进一步处理局部和全局之间的关系[43]:

| $ {\alpha _t}(\mathit{\boldsymbol{x}};{D_{1:t}}) = \left\{ {\begin{array}{*{20}{l}} {({v^*} - \xi - {\mu _t}(\mathit{\boldsymbol{x}}))\phi \left( {{{{{v^*} - \xi - {\mu _t}(\mathit{\boldsymbol{x}})} \over {{\sigma _t}(\mathit{\boldsymbol{x}})}}}} \right) + {\sigma _t}(\mathit{\boldsymbol{x}})\phi \left( {{{{{v^*} - \xi - {\mu _t}(\mathit{\boldsymbol{x}})} \over {{\sigma _t}(\mathit{\boldsymbol{x}})}}}} \right), {\rm{ }}{\sigma _t}(\mathit{\boldsymbol{x}}) > 0}\\ {0, \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ {\sigma _t}(\mathit{\boldsymbol{x}}) = 0} \end{array}} \right. $ | (30) |

置信边界策略已在K摇臂赌博机领域中广泛应用[44].Srinivas等人在2010年提出一种针对高斯过程的置信边界策略:GP-UCB[23].UCB表示置信上界, 在求解目标函数最大值时, UCB策略的采集函数为

| $ {\alpha _t}(\mathit{\boldsymbol{x}};{D_{1:t}}) = {\mu _t}(\mathit{\boldsymbol{x}}) + \sqrt {{\beta _t}} {\sigma _t}(\mathit{\boldsymbol{x}}) $ | (31) |

然而, 当求解目标函数的最小值时, 使用置信下界策略LCB:

| $ {\alpha _t}(\mathit{\boldsymbol{x}};{D_{1:t}}) = - \left( {{\mu _t}(\mathit{\boldsymbol{x}}) + \sqrt {{\beta _t}} {\sigma _t}(\mathit{\boldsymbol{x}})} \right) $ | (32) |

其中, 参数βt平衡了期望和方差.

Srinivas等人给出了相对于不同协方差函数参数βt的具体表达式, 同时, 理论证明了在bt取这些值时公式(4)对迭代次数t是亚线性的[23].从公式(31)和公式(32)可以看出:当不确定性较大时, 采集函数取值同样很大, 如图 2所示, LCB采集函数在不确定性大的地方存在波峰, 并且最大化LCB采集函数的x偏向置信下边界的最小值, 这个偏向程度取决于参数bt的大小.

2.2.3 基于信息的策略首先定义在未知目标函数全局最优解x*上的后验分布为p*(x|D1:t).

汤普森采样(Thompson sampling, 简称TS)[45]是一个随机策略:从后验分布p*(x|D1:t)中采样一个收益(reward)函数, 然后选择具有最大收益的x作为下一个评估点.

考虑药物设计问题, 参数w为药物有效概率.汤普森采样的采集函数为

| $ {a_t}\left( {\mathit{x};{D_{1:t}}} \right) = {\mathit{\boldsymbol{w}}_x} $ | (33) |

其中, x表示第x种药物, wx表示第x种药物的有效概率, w~p(w|D1:t).因此, 下一个评估点选取使公式(33)最大化的第x种药物进行评估.直观来讲, 就是根据已观测数据集选择有效概率最大的药物进行临床实验.这样, 相比较每种药物做同样多的临床实验再统计有效概率而言, 若某种药物具有高致死率, 则统计方法会导致大量不必要的死亡, 而汤普森采样能够避免这一情况的发生, 明显地减少临床实验的代价.

汤普森采样策略存在如下几个优势:(1)没有多余的参数并且容易实现; (2)由于根据后验分布随机采样选取最优, 该方法很自然地平衡了寻找当前最优与探索新区域之间的关系; (3)特别适合批量或延迟的反馈情形[1].但是, 汤普森采样由于其随机性导致具有强宽度搜索性质, 因此在处理高维度问题时, 经常导致很差的性能[46].

前面提到的汤普森采样针对搜索空间是离散的, 当搜索空间

熵搜索策略(entropy search, 简称ES)[46]的主要思想是减少全局最优解x*的不确定性, 不同于汤普森采样, 不是从p*(x|D1:t)中采样, 而是针对其不确定性进行检索.换句话说, ES策略主要偏好选取能够对最优解x*提供最多信息的x.ES策略的采集函数为

| $ {{\alpha }_{t}}(\mathit{\boldsymbol{x}};{{D}_{1:t}})=H(p({{\mathit{\boldsymbol{x}}}^{*}}|{{D}_{1:t}}))-{{\mathbb{E}}_{p(y|x, {{D}_{1:t}})}}[H(p({{\mathit{\boldsymbol{x}}}^{*}}|{{D}_{1:t}}\cup \{\mathit{\boldsymbol{x}}, y\}))] $ | (34) |

其中,

公式(34)在实际中是不能精确计算的, 因为计算p(x*|D1:t∪{x, y})需要取大量不同的x, y对, 并且微分熵本身难以计算.因此, 计算公式(34)需要使用近似技术, 如蒙特卡洛采样技术[48].

Hernándezlobato等人在2014年提出熵预测搜索(predictive entropy search, 简称PES)[49].该方法利用x*与y之间互信息(mutual information)的对称性重写公式(34)为

| $ {{\alpha }_{t}}(\mathit{\boldsymbol{x}};{{D}_{1:t}})=H(p(y|{{D}_{1:t}}))-{{\mathbb{E}}_{p({{\mathit{\boldsymbol{x}}}^{*}}|{{D}_{1:t}})}}[H(p(y|{{D}_{1:t}}, \mathit{\boldsymbol{x}}, {{\mathit{\boldsymbol{x}}}^{*}}))] $ | (35) |

相比公式(34)依赖p(x*|D1:t∪{x, y}), 公式(35)依赖预测分布的熵.因预测分布容易近似甚至精确计算, 故PES策略更方便计算.Hernándezlobato等人通过实验验证了PES策略是目前熵搜索策略中最先进的技术之一[49].

2.2.4 组合策略采用单一采集函数的贝叶斯优化算法不可能在所有问题上都表现出最好的性能[50], 因此, 为了得到一个具有强鲁棒性的方法, Brochu等人提出一种使用对冲策略组合多种采集函数(如PI、EI、UCB等等)的贝叶斯优化算法:GP-Hedge[50].GP-Hedge算法在每次迭代中, 把从每种采集函数得到的候选点组成候选点集合, 然后根据对冲策略从候选点集合中选取评估点.所谓对冲策略就是根据每个采集函数i的有效概率p(i)选取评估点, 概率p(i)根据采集函数i的累计收益计算得到.该方法本质上是通过采集函数的历史效果来预测将来的效果.GP- Hedge算法与使用单一采集函数的贝叶斯优化算法相比, 能够表现出更强的鲁棒性.

Shahriari等人提出一种基于信息的组合策略ESP(entropy search portfolio)[46].ESP策略与GP-Hedge的不同之处在于, 该方法通过基于熵搜索方法选择可为全局最优解提供最多信息的候选点为评估点.ESP策略同样具有高鲁棒性, 并且相比对冲策略, 该方法能够容忍组合中存在表现差的采集函数.这是因为, 对冲策略初期可能做出错误选择, 从而影响整体优化效率, 而ESP策略克服了这一缺点.

2.3 常用模型汇总利用贝叶斯优化解决实际问题时, 选择合适的概率代理模型和采集函数是十分重要的.然而在贝叶斯优化领域中没有统一而明确的选择标准, 这仍是具有挑战性的开放问题.为了从总体上更加清晰地认识常用的代理模型和采集函数, 我们总结了各自方法的优势、劣势以及其代表性应用和文献, 希望为相关研究者提供有益的参考, 帮助他们在采用贝叶斯优化解决实际问题时选择合适的模型.表 3汇总了常用的概率代理模型以及各自的优势、劣势、适用范围和代表性应用.表 4汇总了常用的采集函数以及各自的优势、劣势和代表性文献.

| Table 3 A summary of common probabilistic surrogate models 表 3 常用概率代理函数汇总 |

| Table 4 A summary of common acquisition functions 表 4 常用采集函数汇总 |

3 近似与优化技术

上节介绍了多种常用的概率代理模型和采集函数.选择合适的模型之后, 需要考虑如何对概率模型进行更新推断以及如何优化超参数和采集函数.本节介绍贝叶斯优化过程中涉及到的近似和优化技术.

3.1 近似技术在贝叶斯优化中, 概率代理模型更新是迭代优化过程中的核心步骤.概率代理模型更新是指根据整合的新样本推断出模型后验.

当模型先验与似然分布非共轭时, 难以得到后验分布的封闭解.该情况可以采用变分贝叶斯(variational Bayesian, 简称VB)近似推断[51]或蒙特卡洛近似方法得到近似后验分布.并且, 这两种近似方法的好处在于能够处理任意类型的模型先验与似然, 十分灵活.

当概率代理模型为高斯过程时, 由于在推断后验分布时需要计算t×t协方差矩阵的逆, 因此, 高斯过程的精确推断需要的时间复杂度为立方阶.高斯过程的精确推断不适用于当训练样本数t特别大的情况.在实际应用中, 计算协方差矩阵的逆通常使用Cholesky分解方法[29].该方法十分稳定, 并且在超参数未更新时, 只需计算并存储一次计算复杂度为O(t3)的H矩阵, 而预测的时间复杂度仅为O(t2).但是超参数在每次迭代时都有可能更新, 进而需要重新计算H矩阵.因此, 在处理大数据集时, 需要通过使用近似技术来权衡精度和计算复杂度之间的关系.

表 5列出几种针对高斯过程的常用近似技术和对应时间复杂度.

| Table 5 Common approximation techniques 表 5 常用近似技术 |

SPGP(sparse Gaussian process using pseudo-inputs)方法属于降秩近似方法, 引入m < t个伪输入使得协方差矩阵的秩近似降为m, 从而明显减少求解协方差矩阵逆的计算量[52, 53].文献[52]与文献[53]中的算法虽然时间复杂度相同, 但在文献[52]的方法中, m个伪输入的位置是固定的; 而文献[53]方法中的m个伪输入位置是改变的, 即, 把m个伪输入的位置也当成参数, 在优化超参数时一同进行优化, 使得伪输入的位置能够根据当前数据集进行学习, 增加了模型弹性.但当数据集较小时, 由于参数相对较多, 容易产生“过拟合”现象.SSGP(sparse spectrum Gaussian process)方法的关键思想是稀疏化高斯过程的谱表示[47].博赫纳定理指出, 任何平稳的协方差函数都能表示成有限测度的傅里叶变换:

| $ k(\mathit{\boldsymbol{x}}, \mathit{\boldsymbol{{x}'}})=k(\mathit{\boldsymbol{r}})=\int{\exp (2\pi i{{\mathit{\boldsymbol{s}}}^{T}}(\mathit{\boldsymbol{x}}-\mathit{\boldsymbol{{x}'}}))S(\mathit{\boldsymbol{s}}){\rm{d}}\mathit{\boldsymbol{s}}} $ | (36) |

之后, 通过蒙特卡洛方法采样m个样本频率(spectral points)近似公式(36)的积分, 从而得到近似的协方差函数.当数据集较小时, SSGP同样易产生“过拟合”现象.更多的高斯过程近似方法参考文献[29]中的第8章.

3.2 优化技术 3.2.1 超参数优化概率代理模型中, 超参数的取值直接影响模型的预测效果.对这些超参数的优化是必要的.极端情况下, 每次迭代都根据当前的数据重新学习所有超参数.这样的方法虽然能够保证模型的准确率, 但是对超参数的学习需要高昂的计算量, 效率低下.当前常用的贝叶斯优化实现(如BayesOPT[54])通常采用的方法是多次迭代之后(如20次迭代)重新学习超参数.

贝叶斯优化过程中, 一般对超参数处理有两种方法:点估计和近似边际化估计.

点估计方法有:

1) 通过第Ⅱ类极大似然估计(type Ⅱ maximum likelihood, 简称ML)对边际似然(见公式(20))最大化, 得到

2) 为超参数赋予先验p(θ), 然后通过“贝叶斯定理”得到:

| $ p(\mathit{\boldsymbol{\theta }}|{D_{1:t}}) = \frac{{p({D_{1:t}}|\mathit{\boldsymbol{\theta }})p(\mathit{\boldsymbol{\theta }})}}{{p({D_{1:t}})}} $ | (37) |

最后, 通过最大后验估计(maximum a posteriori, 简称MAP)最大化公式(37), 得到

3) 最大化留一法交叉验证得到的似然均值(称作leave-one-out likelihood或pseudo-likelihood), 得到超参数估计

根据上面估计出的

| $ {\hat \alpha _t}(\mathit{\boldsymbol{x}}) = \alpha (\mathit{\boldsymbol{x}};{\mathit{\boldsymbol{\theta }}_t}) $ | (38) |

在贝叶斯优化过程中, 不确定性在指导宽度搜索时起着重要作用.然而, 上面提到的点估计方法本质上不能捕获这些不确定性.因此, 为了处理这一问题, 通常对θ进行边际化处理:

| $ {\alpha _t}(\mathit{\boldsymbol{x}}) = \int {p(\mathit{\boldsymbol{\theta }}|{D_{1:t}})\alpha (\mathit{\boldsymbol{x}};\mathit{\boldsymbol{\theta }}){\rm{d}}\mathit{\boldsymbol{\theta }}} $ | (39) |

通常使用蒙特卡洛方法近似得到公式(39)中的积分.即, 首先从后验分布p(θ|D1:t)中采样M个θ的样本, 然后通过公式(40)得到近似积分:

| $ {\alpha _t}(\mathit{\boldsymbol{x}}) \approx \sum\nolimits_{i = 1}^M {\alpha (\mathit{\boldsymbol{x}};\mathit{\boldsymbol{\theta }}_t^{(i)})} $ | (40) |

Osborne等人[55]使用贝叶斯蒙特卡洛技术[56]近似公式(39)中的积分.该方法中, θ的样本不是从后验分布p(θ|D1:t)中选取的, 而是选取使得预测分布均值(见公式(23))和方差(见公式(24))不同的M个样本, 然后对这M个样本加权求和近似:

| $ {\alpha _t}(\mathit{\boldsymbol{x}}) \approx \sum\nolimits_{i = 1}^M {{\rho ^{(i)}}\alpha (\mathit{\boldsymbol{x}};\mathit{\boldsymbol{\theta }}_t^{(i)})} $ | (41) |

其中, 权值ρ(i)在文献[57]中有详细描述.

3.2.2 采集函数优化第2.2节介绍了几种常用采集函数, 注意到:在贝叶斯优化中, 当通过这些采集函数选取下一个评估点时, 需要通过最大化公式(27).然而, 采集函数通常是非凸、多峰的, 甚至在本质上比目标函数更难优化.但是相比较目标函数, 采集函数的评估代价通常很小.因此, 为了不影响求解效率, 通常需要尽量简单地设计采集函数.优化采集函数的方法称作辅助优化器.目前, 在贝叶斯优化研究中常用的辅助优化器有离散化方法[18]、多启动拟牛顿爬山方法[18]、网格搜索[58]、无利普希茨常量的利普希茨优化(DIRECT)[59]、自适应协方差矩阵进化策略(CMA- ES)[60]和多启动局部搜索[31].这些辅助优化器通常存在如下缺点:(1)很难判定这些辅助优化器是否能够找到采集函数的全局最优解, 只有当选择的下一个评估点是采集函数的全局最优时, 才能在理论上保证贝叶斯优化的收敛性[1]; (2)在两次连续的贝叶斯优化迭代中, 采集函数可能没有显著的变化, 因此, 每次都从头优化采集函数会浪费大量的计算资源.Wang等人提出一种不需要精确地优化采集函数即可理论保证贝叶斯优化收敛的方法[61].该方法将乐观(所谓乐观是指算法在每一轮扩展叶子节点时都有可能包含最优解)优化算法与概率代理模型加以结合, 忽略计算复杂黑箱函数的后验分布过程, 通过扩展函数值增大或者为上界的叶子节点构造一个空间分割树, 以解决辅助优化器的上述缺点.

4 方法扩展与当前应用领域本节对贝叶斯优化方法扩展研究和当前主要应用领域进行总结.

4.1 贝叶斯优化方法扩展对贝叶斯优化方法扩展可分为两类:对概率代理模型的扩展和对采集函数的扩展.

4.1.1 概率代理模型扩展1) 高维度扩展

维数灾难(curse of dimensionality)是机器学习、数据挖掘等多领域涉及的现象.随着维度的增加, 搜索空间x会以指数形式急剧增长.然而, 许多高维度问题都存在低有效维度(low effective dimensionality)的性质, 即:仅少数维度决定目标函数, 而存在大量对目标函数影响细微或无关的维度.许多研究者应用自动相关确定技术去掉无关维度, 或者通过稀疏的方法近似求解.Wang等人通过使用随机嵌入方法把贝叶斯优化从高维度空间映射到低维度空间进行求解, 该方法能够求解近10亿维的低有效维度问题(有效维度为2)[16].Qian等人提出一种连续的随机嵌入方法, 即:在每次迭代时随机乘以一个低维嵌入矩阵, 使得原始维度映射到较低维度, 同时放松了问题低有效维度的假设[62].Li等人提出一种适用于高维度的贝叶斯优化, 该方法范化了低有效维度的假设, 使用projected-additive的高斯过程求解高维度问题, 并取得不错的效果[63].Wang等人通过概率图模型学习变量之间潜在的关系来减少不必要的评估, 以解决高维度问题[64].Gardner等人通过MCMC方法从高维度中发现互相独立的累加结构并进行模型选择(如高斯过程中的协方差函数), 然后同时优化各部分, 以达到加速优化的目的[65]. Li等人受到神经网络优化加速技术dropout的启发, 利用该技术在每次迭代中随机丢弃固定维度, 仅优化剩余维度, 以达到降维的目的[66].该方法虽然简单、有效, 但需预先定义被抛弃维度的补全方案.

2) 多任务扩展

前面提到的贝叶斯优化仅适用于单个任务的情形, 然而许多情况下, 希望同时优化多个相关的任务.解决这一问题的本质方法是通过一个任务提供的信息应用到其他相关任务上.Swersky等人通过使用多输出的高斯过程[29]将贝叶斯优化扩展成多任务方法[19], 该方法的核心是通过公式(42)协方差函数来捕获任务之间的关联性:

| $ k\left( {\left( {\mathit{\boldsymbol{x}}, \mathit{\boldsymbol{m}}} \right), (\mathit{\boldsymbol{x'}}, \mathit{\boldsymbol{m'}}))} \right) = {k_x}(\mathit{\boldsymbol{x}}, \mathit{\boldsymbol{x'}}) \otimes {k_f}(\mathit{\boldsymbol{m}}, \mathit{\boldsymbol{m'}}) $ | (42) |

其中, kx表示x之间的协方差函数, kf表示任务之间的协方差函数, ⊗表示克罗内克积.

Bonilla等人提出的多任务扩展方法是将公式(42)中的m看作附加信息(如与任务相关的特征), 从而引入其他源信息, 增加任务关联性[67].而之后, Bonilla等人又提出一种自由形式的多任务高斯过程, 即公式(42)中kf构成的协方差矩阵中所有元素皆为参数, 通过数据学习任务之间的关联性, 增加模型的灵活性[68].

3) 冻融(freeze-thaw)扩展

在实验设计时, 传统的贝叶斯优化在完全训练后才能对模型的性能进行评估.然而模型训练需要花费大量的时间, 因此希望在训练模型的同时能够预先评估模型的性能.Swersky等人提出一种冻融贝叶斯优化[69].“冻”表示挂起未完全训练的模型, “融”表示继续训练某个未完全训练的模型.该方法可在训练过程中预测模型性能, 使其能挂起表现相对不好的实验并恢复表现相对好的实验.同时, 该方法构造了一个非稳定性的协方差函数来预测模型的性能:

| $ {k_t}(t, t') = \frac{{{\beta ^\alpha }}}{{{{(t + t' + \beta )}^\alpha }}} $ | (43) |

并且通过基于熵搜索的采集函数选择继续训练的模型.

4.1.2 采集函数扩展1) 约束和代价敏感性

在优化现实生活中的实际问题时, 有时需要满足某些预先定义的约束.例如:食品工厂生产一种饼干, 目标是使饼干具有最低的卡路里, 同时需要满足大多数人的口味.实际优化问题中的这些约束有时也是黑箱的.针对这一问题, Gelbart等人提出一种解决带黑箱约束的贝叶斯优化[70].该方法假设约束之间相互独立, 并提出一种结合约束的采集函数:

| $ {\alpha _t}(\mathit{\boldsymbol{x}};{D_{1:t}}) = EI(\mathit{\boldsymbol{x}})\prod\nolimits_{k = 1}^K {p({C_k}(\mathit{\boldsymbol{x}}))} $ | (44) |

其中, EI(x)表示EI采集函数, p(Ck(x))表示x满足约束k的概率.由于评估目标函数和约束同样需要大量的饼干制作、卡路里及口味测试过程, 花费高昂的代价, 因此, 该方法把目标函数和约束看作多任务处理, 即, 在每次迭代时仅选择一个任务(目标函数或约束)进行评估.选择任务的方法是基于熵搜索的方法, 选择可以提供最多信息的任务进行评估.

如果优化过程中需要考虑时间消耗或存储量有明确预算等, 并且每个x的评估代价存在差异, 那么选择策略需要考虑评估的代价敏感性.针对这一问题, Snoek等人提出一种具有代价敏感性的采集函数[18]:

| $ \alpha \left( {\mathit{\boldsymbol{x}};{D_{1:t}}} \right) = EI\left( \mathit{\boldsymbol{x}} \right)/c\left( \mathit{\boldsymbol{x}} \right) $ | (45) |

其中, c(x)表示x配置所需要的代价.公式(45)可以简单理解为单位时间的期望提升(若时间敏感), 即偏向选择单位时间提升最大的x进行评估, 从而在指定预算下得到理想解.

Kandasamy等人[71]和Marco等人[72]均考虑了多精度评估情形(例如, 模拟的精度低但代价低, 而实际实验精度高但代价高), 并分别使用基于置信区间的策略和熵搜索策略自动平衡模拟和实验之间的选择, 从而达到最小代价的目的.

2) 基于距离的采集函数

Marchant等人提出一种基于距离的采集函数[14].基于距离的采集函数如下:

| $ \alpha \left( {\mathit{\boldsymbol{x}};{D_{1:t}}} \right) = s\left( \mathit{\boldsymbol{x}} \right) - r \times d(\mathit{\boldsymbol{x}}|{\mathit{\boldsymbol{x}}^ - }) $ | (46) |

其中, s(x)表示任意的采集函数, d(x|x-)表示当前采样点与上一次采样点的距离, r > 0表示惩罚参数.

这类采集函数可以应用于距离敏感的采样过程, 如在环境监控中, 需要通过飞行器飞行到达某一位置去采样当地污染物浓度, 利用基于距离的采集函数不仅保证通过少量采样找到污染物浓度最大的地区, 而且保证飞行距离最小.

3) 并行化扩展

贝叶斯优化本质上是一个序贯模型, 但是为了加快贝叶斯优化的求解效率, 可同时进行多次函数评估, 即并行化扩展.Ginsbourger等人提出一种并行化方法[73], 该方法的主要思想是结合使用已观测的数据集D1:t和正在观测且尚未结束的数据集

Snoek等人提出一种并行化的采集函数[18]:

| $ {{\alpha }_{t}}(\mathit{\boldsymbol{x}};{{D}_{1:t}}, {{D}_{1:p}})=\int{{{\alpha }_{t}}(\mathit{\boldsymbol{x}};{{D}_{1:t}}\cup {{{{D'}}}_{1:p}})p({{{{y'}}}_{1:p}}|{{D}_{1:t}}){\rm{d}}{{{{y'}}}_{1:p}}}\approx \frac{1}{S}\sum\nolimits_{s=1}^{S}{{{\alpha }_{t}}(\mathit{\boldsymbol{x}};{{D}_{1:t}}\cup {D'}_{1:p}^{(s)})} $ | (47) |

其中,

为方便相关领域研究者对当前贝叶斯优化的扩展方法有一个清晰的认识, 本节对上述扩展方法进行分类、总结和对比, 并列出其最具代表性的扩展方法.表 6和表 7分别对比了概率代理模型和采集函数的扩展方法.

| Table 6 Comparison of extension methods of probabilistic surrogate models 表 6 概率代理模型扩展方法对比 |

| Table 7 Comparison of extension methods of acquisition function 表 7 采集函数扩展方法对比 |

4.2 当前应用领域

作为优化复杂黑箱问题的有效手段, 贝叶斯优化已被应用于许多领域.本节将详细地总结其当前应用领域.

1) A/B测试、游戏与材料设计

Google和Microsoft等公司在广告与网页优化设计方面[2-4]应用了贝叶斯优化.解决的问题是, 在一定查询预算的前提下, 如何择优选择用户进行查询(这里的查询是指一个用户对某版本的产品进行评测, 返回点击率或其他测度), 帮助设计和改善产品.利用广告、网页、应用程序途径等得到的用户反馈, 开发者可通过贝叶斯优化对产品的配置进行优化调整.Khajah等人利用贝叶斯优化设计出最大化用户参与度的游戏[5].他们通过调整游戏中的设置, 如敌人个数、出现频率、开枪次数等, 来控制游戏难度, 将玩家参与游戏的时间作为反馈, 优化出用户参与度最高的游戏配置.Frazier等人应用贝叶斯优化进行材料设计, 选取合适的化学结构、组成成分和处理条件等构造理想的材料[6].

2) 推荐系统

Google和Microsoft等公司应用贝叶斯优化技术, 根据订阅者订阅的网站、视频、音乐等方面的内容为订阅者推荐相关的新闻文章[7, 8].A/B测试与游戏设计每次迭代只能给出一个网页或者游戏配置, 然而推荐系统可以一次性地为任意订阅者推荐多个新闻或者商品.

3) 机器人学、嵌入式系统及系统设计

对两足或多足机器人的步态优化十分具有挑战性.Lizotte等人应用贝叶斯优化解决传统步态优化方法容易陷入局部最优和需要大量评估的缺点[11].该方法采用高斯过程作为概率代理模型, 采用PI采集函数实现了更快、更平稳、评估次数更少的机器人步伐评估过程.Martinez-Cantin等人提出一种在有限视野和局部观测下的基于模拟的主动策略学习算法(高斯过程代理模型, EI采集函数), 应用于机器人导航和不确定性地点探索[12]. Schneider讨论了嵌入式学习系统的挑战和贝叶斯优化应用到嵌入式学习系统的发展前景[13].Akrour等人利用局部环境的贝叶斯优化, 在高维度空间(70维)中控制机器人臂运动[75].Torun等人提出一种两阶段贝叶斯优化方法(第1阶段注重不确定性区域探索, 第2阶段根据当前探索区域寻找最优)优化集成系统设计[76].

4) 环境监控与传感器网络

传感器设备用于测量速度、温度、湿度、空气质量、污染物含量等环境指标.由于不能在所有区域布置传感器, 再加上噪声的干扰, 传感器测量的数据常常存在不确定性.此外, 激活传感器设备进行环境感知都会消耗能量, 如电量和传输流量.Srinivas等人使用高斯过程代理的贝叶斯优化, 通过仅激活少量的传感器, 便可找到室内温度极值位置或高速公路上最堵位置[23].Garnett等人使用贝叶斯优化选择最优传感器子集, 使其根据这些子集得到最优的预测效果[24].Marchant等人把贝叶斯优化扩展到环境监控中, 利用可移动机器人在环境中进行主动采样, 得到对周围环境的精确感知[14].Morere等人结合贝叶斯优化和部分观测的马尔可夫决策过程, 以优化无人机采样策略监测周围环境[77].Colopy等人利用贝叶斯优化调整基于个体的个性化监测模型, 以个性化地监控病人生命体征[78].Candelieri等人利用贝叶斯优化来优化控制给水管网系统中的泵, 以达到在少量能量消耗的情况下得到理想的泵调度方案的目的[79].

5) 偏好学习与交互界面

在处理计算机图形与动画领域中的问题时, 通常需要专业人员手动调整大量棘手的参数.例如, 构造烟雾场景的粒子系统, 需要调整速度、半径、涡环大小、长度尺度、旋度噪音等参数.通常情况下, 这些参数十分复杂, 非专业人员难以理解.Brochu等人提出一种使用贝叶斯优化的迭代选择方法.该方法在处理图片时不需要专业人员手动调参, 只需在每次迭代时从生成的两张对比图片(两张对比图片具有不同的参数配置)中选取与目标更像的图片作为反馈(此时, 用户知道最终想要的图片效果), 不需要用户理解复杂参数的具体含义.该方法通过返回的对比偏好信息更新代理模型, 并根据完全随机、EI等策略生成下一次迭代的两张对比图片, 直到找到满足需求的目标图片[9, 10].

6) 自动算法配置

构造一种优秀的算法通常需要经过大量的参数调节实验.若算法的参数调节都需要人工干预, 将花费大量的时间和人力, 甚至做无用功.因此, 自动算法配置十分必要.这样不仅能减少人工干预, 使得人们能够更专注于新模型构建等高层次问题, 还能缩短大量的训练时间.相比人工经验或穷举, 优化算法会自动选择合适的参数配置进行训练验证.贝叶斯优化能够胜任这类问题, 并已取得了令人瞩目的成果.Bergstra等人应用贝叶斯优化自动地调整神经网络和深度信念网络中的超参数[17].Snoek等人应用贝叶斯优化自动调整卷积神经网络中的超参数[18, 19].Mahendran等人提出一种基于贝叶斯优化的自适应马尔可夫链蒙特卡洛算法[20].Thornton等人应用贝叶斯优化提出一种针对分类算法的自动模型选择和超参数调节的方法:Auto-WEKA[21].Zhang等人使用贝叶斯优化对卷积神经网络中的参数进行调整, 解决目标识别问题[15].Wang等人通过贝叶斯优化调整混合整数规划求解器的参数来提升求解器的效率[16].Klein等人提出一种快速贝叶斯优化方法, 能够调节大规模数据集上的机器学习算法的超参数[80].Xia等人应用贝叶斯优化调节决策树中的超参数, 提高信用评价精度[81].

7) 自然语言与文本处理

Wang等人使用贝叶斯优化对文本进行术语提取(term extraction)[61].Yogatama等人利用贝叶斯优化为不同类问题选择合适的文本表示, 其实验结果表明, 该方法能够使优化后的线性模型与未优化的复杂模型在主题分类问题上具有可比的效率[82].

8) 生物、化学及晶体学

贝叶斯优化同样可以胜任在生物、化学及晶体学等领域中的高代价优化任务.Carr等人应用贝叶斯优化技术在晶体表面上寻找分子最稳定的吸附位置[83].Krivák等人用贝叶斯优化提升配体成键位置的预测质量[84]. Tanaka等人利用贝叶斯优化进行全基因组选择, 能够在少量的模拟代价下找到较理想的基因型[85].在脑年龄分类预测任务中, Lancaster等人利用贝叶斯优化调节对神经影像预处理时所采用重采样技术的参数, 进而达到提高分类精度的目的[86].

9) 迁移学习

Ruder等人在迁移学习过程中, 利用贝叶斯优化技术从多源或多领域数据中自动地选择有效数据作为训练集, 以达到增强模型能力的目的, 且与具体学习模型无关[87].

5 问题与挑战前面详细地介绍了贝叶斯优化的研究现状.然而, 随着大数据应用的发展, 待优化目标的规模和复杂程度将会有所增加.作为处理评估代价大的复杂黑箱问题的有效解决方法, 贝叶斯优化在未来发展中将面临下列问题与挑战.

一.实时性和自适应性

贝叶斯优化每次迭代需要对概率代理模型进行更新, 当问题维度高或存在大量历史数据时, 更新概率模型需要高昂的计算量, 尤其不能满足对实时性要求高的实际任务.针对该问题, 研究者已经提出了一些解决策略.

1) 降维映射, 见第4.1.1节.当贝叶斯优化处理高维度问题时, 需要从高维度空间映射到低维度空间进行优化, 虽然该方法加快了求解效率, 但是需要假设问题存在低有效维度的性质;

2) 近似方法, 见第3.1节.当模型的先验不为共轭先验时, 需要使用变分贝叶斯近似推断或蒙特卡洛采样方法得到模型近似后验分布.当使用高斯过程代理目标函数时, 精确推断需要O(t3)的时间复杂度, 可使用Cholesky分解、SPGP、SSGP等方法对高斯过程进行近似推断.虽然这些近似方法能够加快求解效率, 但却具有求解精度不足的缺点;

3) 并行化, 见第4.1.2节.通过对贝叶斯优化进行并行化扩展, 能够同时评估多次目标函数, 加快求解效率.该策略选择评估点时, 根据部分未完成评估的采样点返回的虚拟观测值, 而不是真实观测值, 会在一定程度上影响求解精度;

4) 时间敏感性, 见第4.1.2节.时间敏感性主动选择策略能够选择单位时间期望提升最大的点进行评估.但该方法在相同迭代预算下, 与传统方法相比, 存在精度差异.在提高贝叶斯优化求解效率时, 难点在于如何解决精度和计算开销之间的平衡关系.

此外, 贝叶斯优化在处理优化目标动态变化的问题时, 应该具有自适应的调整能力.在已有规划解的基础上, 针对问题变化, 动态调整现有策略, 而不需要推倒重来, 从头计算.例如:在交通领域中, 当车辆前方发生不可预测的事件(如车祸)造成拥堵时, 需要优化程序能够自适应地、增量地调整规划路线.

二.分布式

随着数据量的增加, 复杂应用很难在一台终端上高效执行.因此, 贝叶斯优化还需要具有分布式处理数据的能力.贝叶斯优化的分布式扩展应具有以下特点.

1) 负载均衡.能够有效地利用计算资源, 避免资源过于集中和浪费;

2) 具有高效的计算效率.目前, 贝叶斯优化并行技术是为了加快其求解效率, 同时进行多次函数评估, 本质上是对采集函数的并行化扩展(见第4.1.2节).该方法仍存在集中环节, 即集中回收评估点返回的观测值集合, 然后整合更新概率模型决策候选点集合;

3) 高容错性和强健壮性.分布式计算中一个任务往往存在多个备份, 一个备份所在终端失效后, 其余备份仍可继续执行, 从而实现任务的健壮性.与之不同的是, 贝叶斯优化过程所要求的高容错性和强健壮性应能有效处理没有备份的任务, 根据需要动态地进行优化策略调整.例如:在无人机对抗情景中, 将每个无人机看作节点, 这些无人机基于自组织、不可靠的通信网进行协同作战.当一架无人机被击落时, 该小组应能动态调整队形, 继续执行作战任务.这种去中心化的优化策略可以避免出现击毁中心机使整个小组瘫痪的情况;

4) 多策略分布式协同求解.贝叶斯优化的分布式扩展可同时存在多个不同的策略(不同的概率模型和采集函数), 并像深度学习中的对抗网络一样, 各个策略相互促进、相互影响, 从而达到理想的学习效果.然而, 对贝叶斯优化分布式扩展的难点在于分布式概率代理模型和采集函数的构建, 并且需要处理各个分散节点之间的信息交互问题.

三.多目标

贝叶斯优化的多任务扩展能够处理多个相关任务, 根据相关性, 将一个任务的信息应用到其他相关任务上, 从而达到迁移学习的目的.例如:第4.1.1节中, Swersky等人使用高斯过程同时处理多个相关的超参数优化任务, 为每一个任务得到最优的超参数配置, 从而使系统性能最大化.该方法的优化目标是最优化所有任务的平均性能.但在实际应用中, 许多问题需要同时优化多个目标, 这些目标可能会存在“冲突”关系.例如:在智能交通应用中, 既要规划出最短路径, 又要尽量多地收集未知区域的道路情况, 但这两个目标很难同时满足.第4.1.2节中介绍的约束扩展方法将两个目标中的一个作为优化目标, 另一个作为约束处理.当目标间存在冲突时, 不存在绝对最优解, 只存在有效解集合.当把多目标转换成带约束的单目标优化时, 求得的优化解仅是单目标的最优解, 忽略了转化为约束的目标的重要程度.Tesch等人提出一种面向多目标的贝叶斯优化方法, 尽管该方法能够得到帕累托集, 但忽略了目标之间的依赖关系[88].多目标贝叶斯优化的难点在于处理多个目标之间的关系.为了保证所有目标的重要性并利用目标之间的依赖关系, 贝叶斯优化在求解多目标问题时可考虑同时拥有多个概率代理模型和采集函数, 在优化过程中, 这些概率模型和采集函数相互促进、相互影响, 达到优化学习的目的.

四.模型选择问题

模型选择一直是贝叶斯方法面临的棘手问题.贝叶斯优化涉及的模型选择有观测模型选择、(非)参数模型先验选择以及超参数先验选择.观测模型需根据领域知识指导选择.合理的观测模型需对错误假设具有鲁棒性, 即:当真实数据与模型假设不相符时, 其仍具有良好的表现.不同问题具有不同的性质, 因而具有不同的先验形式.例如:在监测城市道路状况时, 由于人们有早出晚归的习惯, 通常道路状况会出现早晚高峰周期性的表现, 因此, 可以选择存在周期性质的协方差函数构造先验模型.然而, 极端环境监测问题不具备这样的周期性质, 因此需要选择其他合适的先验模型.当使用贝叶斯方法估计超参数时, 需要选择合理的超参数先验, 增加超参数估计精度, 提升模型预测准确率.

在贝叶斯优化中, 选择合适的概率代理模型甚至比采集函数的选择还要关键.在一些领域中, 如制药和传染病控制, 需要更加谨慎地选择合适的模型, 提高概率模型预测的准确度, 降低评估过程的代价.尽管目前存在一些模型选择的方法[29], 但这些方法都不具有通用性, 仍需针对具体问题具体分析, 运用领域专家的经验知识指导模型的选择.在贝叶斯优化研究和应用领域, 如何针对具体问题选择合适的概率代理模型, 仍是具有很大挑战性的问题.

6 总结作为求解非凸、多峰、评估代价高昂、黑箱的复杂优化问题的有效解决方案, 贝叶斯优化近年来在多领域获得了广泛关注.本文综述了贝叶斯优化的研究现状.

● 首先, 从其优化框架和优化原理入手, 详细分析其优势与劣势, 以帮助相关领域研究者深入理解贝叶斯优化; 然后, 从模型选择的角度介绍了贝叶斯优化两个核心部分:概率代理模型和采集函数, 旨在为建模求解复杂优化问题进行模型选择时提供参考;

● 其次, 介绍了贝叶斯优化涉及的近似与优化技术, 并深入到技术细节;

● 最后, 总结了贝叶斯优化的方法扩展和当前主要应用领域.

同时, 本文也关注随着待优化目标的规模和复杂程度的增加, 贝叶斯优化将面临实时性和自适应性、分布式、多目标以及模型选择等问题与挑战.此外, 相比于其他优化技术, 贝叶斯优化还存在一些局限性.本文通过对贝叶斯优化的详细分析和讨论, 希望为相关领域的研究者予以帮助.

| [1] |

Shahriari B, Swersky K, Wang Z, Adams RP, Freitas ND. Taking the human out of the loop:A review of Bayesian optimization. Proc. of the IEEE, 2016, 104(1): 148–175.

[doi:10.1109/JPROC.2015.2494218] |

| [2] |

Kohavi R, Longbotham R, Dan S, Henne RM. Controlled experiments on the Web:Survey and practical guide. Data Mining and Knowledge Discovery, 2009, 18(1): 140–181.

[doi:10.1007/s10618-008-0114-1] |

| [3] |

Scott SL. A modern Bayesian look at the multi-armed bandit. Applied Stochastic Models in Business and Industry, 2010, 26(6): 639–658.

[doi:10.1002/asmb.v26.6] |

| [4] |

Chapelle O, Li L. An empirical evaluation of Thompson sampling. Advances in Neural Information Processing Systems, 2011: 2249–2257.

http://www.wanfangdata.com.cn/details/detail.do?_type=perio&id=CC0212698341 |

| [5] |

Khajah MM, Roads BD, Lindsey RV, Liu YE, Mozer MC. Designing engaging games using Bayesian optimization. In: Proc. of the ACM Conf. on Human Factors in Computing Systems. 2016. 5571-5582.http://dl.acm.org/citation.cfm?id=2858253 |

| [6] |

Frazier PI, Wang J. Bayesian optimization for materials design. In: Proc. of the Mathematics. 2015.http://link.springer.com/10.1007/978-3-319-23871-5_3 |

| [7] |

Li L, Chu W, Langford J, Schapire RE. A contextual-bandit approach to personalized news article recommendation. In: Proc. of the Int'l Conf. on World Wide Web. 2010. 661-670.http://portal.acm.org/citation.cfm?doid=1772690.1772758 |

| [8] |

Vanchinathan HP, Nikolic I, Bona FD, Krause A. Explore-Exploit in top-n recommender systems via Gaussian processes. In: Proc. of the ACM Conf. on Recommender Systems. 2014. 31.http://dl.acm.org/citation.cfm?id=2645710.2645733 |

| [9] |

Brochu E, Brochu T, Freitas ND. A Bayesian interactive optimization approach to procedural animation design. In: Proc. of the ACM SIGGRAPH/Eurographics Symp. on Computer Animation. 2010. 103-112.http://dl.acm.org/citation.cfm?id=1921443 |

| [10] |

Brochu E, Cora VM, Freitas ND. A tutorial on Bayesian optimization of expensive cost functions, with application to active user modeling and hierarchical reinforcement learning. In: Proc. of the Computer Science. 2010.http://cn.arxiv.org/abs/1012.2599 |

| [11] |

Lizotte D, Wang T, Bowling M, Schuurmans D. Automatic gait optimization with Gaussian process regression. In: Proc. of the Int'l Joint Conf. on Artifical Intelligence. 2007. 944-949.http://dl.acm.org/citation.cfm?id=1625428 |

| [12] |

Martinez-Cantin R, Freitas ND, Doucet A, Castellanos JA. Active policy learning for robot planning and exploration under uncertainty. In: Proc. of the Robotics: Science and Systems Ⅲ. 2007. 321-328.http://ieeexplore.ieee.org/xpls/abs_all.jsp?arnumber=6280104 |

| [13] |

Schneider J. Bayesian optimization and embedded learning systems. In: Proc. of the ACM SIGKDD Int'l Conf. on Knowledge Discovery and Data Mining. 2016. 413-413.http://dl.acm.org/citation.cfm?id=2945367 |

| [14] |

Marchant R, Ramos F. Bayesian optimisation for intelligent environmental monitoring. In: Proc. of the IEEE/RSJ Int'l Conf. on Intelligent Robots and Systems. 2012. 2242-2249.http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=6385653 |

| [15] |

Zhang Y, Sohn K, Villegas R, Pan G, Lee H. Improving object detection with deep convolutional networks via Bayesian optimization and structured prediction. In: Proc. of the IEEE Conf. on Computer Vision and Pattern Recognition. 2015. 132-132.http://doi.ieeecomputersociety.org/10.1109/CVPR.2015.7298621 |

| [16] |

Wang Z, Zoghi M, Hutter F, Matheson D, Freitas ND. Bayesian optimization in a high dimensions via random embeddings. In: Proc. of the Int'l Joint Conf. on Artificial Intelligence. 2013.http://dl.acm.org/citation.cfm?id=2540383 |

| [17] |

Bergstra J, Bardenet R, Bengio Y, Kégl B. Algorithms for hyper-parameter optimization. Advances in Neural Information Processing Systems, 2011, 24(24): 2546–2554.

http://dl.acm.org/citation.cfm?id=2986743 |

| [18] |

Snoek J, Larochelle H, Adams RP. Practical Bayesian optimization of machine learning algorithms. Advances in Neural Information Processing Systems, 2012, 4: 2951–2959.

http://d.old.wanfangdata.com.cn/OAPaper/oai_arXiv.org_1206.2944 |

| [19] |

Swersky K, Snoek J, Adams RP. Multi-Task Bayesian optimization. Advances in Neural Information Processing Systems, 2013: 2004–2012.

http://d.old.wanfangdata.com.cn/Conference/WFHYXW359738 |

| [20] |

Mahendran N, Wang Z, Hamze F, Freitas ND. Adaptive MCMC with Bayesian optimization. In: Proc. of the Int'l Conf. on Artificial Intelligence and Statistics. 2010.http://www.cs.ox.ac.uk/projects/BO/ |

| [21] |

Thornton C, Hutter F, Hoos HH, Leyton-Brown K. Auto-WEKA: Combined selection and hyperparameter optimization of classification algorithms. In: Proc. of the Computer Science. 2013. 847-855.http://dl.acm.org/citation.cfm?id=2487629 |

| [22] |

Hoffman MW, Shahriari B, Freitas ND. On correlation and budget constraints in model-based bandit optimization with application to automatic machine learning. In: Proc. of the Int'l Conf. on Artificial Intelligence and Statistics. 2014. 365-374. |

| [23] |

Srinivas N, Krause A, Kakade SM, Seeger M. Gaussian process optimization in the bandit setting: No regret and experimental design. In: Proc. of the Int'l Conf. on Machine Learning. 2010.http://cn.arxiv.org/abs/0912.3995 |

| [24] |

Garnett R, Osborne MA, Roberts SJ. Bayesian optimization for sensor set selection. In: Proc. of the Int'l Conf. on Information Processing in Sensor Networks. 2010. 209-219.http://dl.acm.org/citation.cfm?id=1791238 |

| [25] |

Ghahramani Z. Probabilistic machine learning and artificial intelligence. Nature, 2015, 521: 452–459.

[doi:10.1038/nature14541] |

| [26] |

Jones DR, Schonlau M, Welch WJ. Efficient global optimization of expensive black-box functions. Journal of Global Optimization, 1998, 13(4): 455–492.

[doi:10.1023/A:1008306431147] |

| [27] |

Nelder JA, Baker RJ. Generalized linear models. Journal of the Royal Statistical Society, 1972, 135(3): 370–384.

[doi:10.2307/2344614] |

| [28] |

Sutskever I, Vinyals O, Le QV. Sequence to sequence learning with neural networks. Advances in Neural Information Processing Systems, 2014, 4: 3104–3112.

http://d.old.wanfangdata.com.cn/OAPaper/oai_arXiv.org_1211.3711 |

| [29] |

Rasmussen CE, Williams CKI. Gaussian Processes for Machine Learning. The MIT Press, 2006.

|

| [30] |

Lu C, Tang X. Surpassing human-level face verification performance on LFW with GaussianFace. In: Proc. of the Computer Science. 2014. |

| [31] |

Neal RM. Bayesian learning for neural networks[Ph.D. Thesis]. Toronto: University of Toronto, 1996.https://link.springer.com/book/10.1007%2F978-1-4612-0745-0 |

| [32] |

Paciorek CJ, Schervish MJ. Nonstationary covariance functions for Gaussian process regression. Advances in Neural Information Processing Systems, 2003, 16: 273–280.

http://dl.acm.org/citation.cfm?id=2981380 |

| [33] |

Hutter F, Hoos HH, Leyton-Brown K. Sequential model-based optimization for general algorithm configuration. In: Proc. of the Conf. on Learning and Intelligent Optimization. 2011. 507-523.http://dl.acm.org/citation.cfm?id=2177404 |

| [34] |

Watson, G N. A Treatise on the Theory of Bessel Functions. 2nd ed. London: Cambridge University Press, 1966.

|

| [35] |

Breiman L. Random forests. Machine Learning, 2001, 45(1): 5–32.

[doi:10.1023/A:1010933404324] |

| [36] |

Zhang Y, Chan W, Jaitly N. Very deep convolutional networks for end-to-end speech recognition. In: Proc. of the Int'l Conf. on Acoustics, Speech and Signal Processing. 2017.http://cn.arxiv.org/abs/1610.03022 |

| [37] |

Karpathy A, Li FF. Deep visual-semantic alignments for generating image descriptions. IEEE Trans. on Pattern Analysis and Machine Intelligence, 2014, 39(4): 664–676.

http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=7298932 |

| [38] |

Snoek J, Rippel O, Swersky K, Kiros R, Satish N, Sundaram N, Patwary MMA, Prabhat, Adams RP. Scalable Bayesian optimization using deep neural networks. In: Proc. of the Statistics. 2015. 1861-1869. |

| [39] |

Springenberg JT, Klein A, Falkner S, Hutter F. Bayesian optimization with robust Bayesian neural networks. Advances in Neural Information Processing Systems, 2016.

http://papers.nips.cc/paper/6117-bayesian-optimization-with-robust-bayesian-neural-networks |

| [40] |

Kushner HJ. A new method of locating the maximum point of an arbitrary multipeak curve in the presence of noise. Journal of Fluids Engineering, 1963, 86(1).

|

| [41] |

Jones DR. A taxonomy of global optimization methods based on response surfaces. Journal of Global Optimization, 2001, 21(4): 345–383.

[doi:10.1023/A:1012771025575] |

| [42] |

Mockus J, Tiesis V, Zilinskas A. The application of Bayesian methods for seeking the extremum. In: Proc. of the Towards Global Optimisation 2. 1978. 117-129.http://www.ams.org/mathscinet-getitem?mr=688830 |

| [43] |

Lizotte DJ. Practical Bayesian optimization[Ph.D. Thesis]. Alberta: University of Alberta, 2008.http://dl.acm.org/citation.cfm?id=1626686 |

| [44] |

Lai TL, Robbins H. Asymptotically efficient adaptive allocation rules. Advances in Applied Mathematics, 1985, 6(1): 4–22.

[doi:10.1016/0196-8858(85)90002-8] |

| [45] |

Thompson WR. On the likelihood that one unknown probability exceeds another in view of the evidence of two samples. Biometrika, 1933, 25(3-4): 285–294.

[doi:10.1093/biomet/25.3-4.285] |

| [46] |

Shahriari B, Wang Z, Hoffman MW, Bouchard-Côté A. An entropy search portfolio for Bayesian optimization. In: Proc. of the Conf. on Neural Information Processing Systems: Workshop on Bayesian Optimization in Academia and Industry. 2014.http://cn.arxiv.org/abs/1406.4625 |

| [47] |

Lázaro-Gredilla M, QuiñOnero-Candela J, Rasmussen CE, Figueiras-Vidal AR. Sparse spectrum Gaussian process regression. Journal of Machine Learning Research, 2010, 11(9): 1865–1881.

http://d.old.wanfangdata.com.cn/NSTLQK/NSTL_QKJJ0227426549/ |

| [48] |

Villemonteix J, Vazquez E, Walter E. An informational approach to the global optimization of expensive-to-evaluate functions. Journal of Global Optimization, 2009, 44(4): 509–534.

[doi:10.1007/s10898-008-9354-2] |

| [49] |

Hernándezlobato JM, Hoffman MW, Ghahramani Z. Predictive entropy search for efficient global optimization of black-box functions. In: Proc. of the Conf. on Neural Information Processing Systems: Workshop on Bayesian Optimization in Academia and Industry. 2014.http://dl.acm.org/citation.cfm?id=2968929 |

| [50] |

Brochu E, Hoffman M, Freitas ND. Portfolio allocation for Bayesian optimization. In: Proc. of the Conf. on Uncertainty in Artificial Intelligence. 2011.http://dl.acm.org/citation.cfm?id=3020587 |

| [51] |

Tzikas DG, Likas CL, Galatsanos NP. The variational approximation for Bayesian inference. IEEE Signal Processing Magazine, 2008, 25(6): 131–146.

[doi:10.1109/MSP.2008.929620] |

| [52] |

Seeger M, Williams CKI, Lawrence ND. Fast forward selection to speed up sparse Gaussian process regression. In: Proc. of the Conf. on Artificial Intelligence and Statistics. 2003. |

| [53] |

Snelson E, Ghahramani Z. Sparse Gaussian process using pseudo-inputs. Advances in Neural Information Processing Systems, 2006, 18(1): 1257–1264.

http://d.old.wanfangdata.com.cn/NSTLHY/NSTL_HYCC026236234/ |

| [54] |

Martinez-Cantin R. BayesOpt:A Bayesian optimization library for nonlinear optimization, experimental design and bandits. Journal of Machine Learning Research, 2014, 15: 3735–3739.

http://d.old.wanfangdata.com.cn/OAPaper/oai_arXiv.org_1309.0671 |

| [55] |

Osborne MA, Garnett R, Roberts SJ. Gaussian processes for global optimization. In: Proc. of the Int'l Conf. on Learning and Intelligent Optimization. 2009. |

| [56] |

Rasmussen CE, Ghahramani Z. Bayesian Monte Carlo. Advances in Neural Information Processing Systems, 2002.

http://d.old.wanfangdata.com.cn/Periodical/jxgcxb201004024 |

| [57] |

Osborne MA, Roberts SJ, Rogers A, Ramchurn SD, Jennings NR. Towards real-time information processing of sensor network data using computationally efficient multi-output Gaussian processes. In: Proc. of the Int'l Conf. on Information Processing in Sensor Networks. 2008. 109-120.http://dl.acm.org/citation.cfm?id=1371607.1372727 |

| [58] |

Bardenet R, Kégl B. Surrogating the surrogate: Accelerating Gaussian-process-based global optimization with a mixture crossentropy algorithm. In: Proc. of the Int'l Conf. on Machine Learning. 2010. |

| [59] |

Jones DR, Perttunen CD, Stuckman BE. Lipschitzian optimization without the Lipschitz constant. Journal of Optimization Theory and Applications, 1993, 79(1): 157–181.

[doi:10.1007/BF00941892] |

| [60] |

Hansen N, Ostermeier A. Completely derandomized self-adaptation in evolution strategies. IEEE Trans. on Evolutionary Computation, 2001, 9(2): 159–195.

[doi:10.1162/106365601750190398] |

| [61] |

Wang Z, Shakibi B, Jin L, Freitas ND. Bayesian multi-scale optimistic optimization. In: Proc. of the Int'l Conf. on Artificial Intelligence and Statistics. 2014. 1005-1014.http://cn.arxiv.org/abs/1402.7005 |

| [62] |

Qian H, Hu YQ, Yu Y. Derivative-Free optimization of high-dimensional non-convex functions by sequential random embeddings. In: Proc. of the Int'l Joint Conf. on Artificial Intelligence. 2016. |

| [63] |

Li CL, Kandasamy K, Poczos B, Schneider J. High dimensional Bayesian optimization via restricted projection pursuit models. In: Proc. of the Int'l Conf. on Artificial Intelligence and Statistics. 2016.High dimensional Bayesian optimization via restricted projection pursuit models. |

| [64] |

Wang Z, Li C, Jegelka S, Kohli P. Batched high-dimensional Bayesian optimization via structural kernel learning. In: Proc. of the Int'l Conf. on Machine Learning. 2017.http://cn.arxiv.org/abs/1703.01973 |

| [65] |

Gardner JR, Guo C, Weinberger KQ, Garnett R, Grosse R. Discovering and exploiting additive structure for Bayesian optimization. In: Proc. of the Int'l Conf. on Artificial Intelligence and Statistics. 2017.http://proceedings.mlr.press/v54/gardner17a.html |

| [66] |

Li C, Gupta S, Rana S, Nguyen V, Venkatesh S, Shilton A. High dimensional Bayesian optimization using dropout. In: Proc. of the Int'l Joint Conf. on Artificial Intelligence. 2017.http://cn.arxiv.org/abs/1802.05400 |

| [67] |

Bonilla EV, Agakov FV, Williams CKI. Kernel multi-task learning using task-specific features. In: Proc. of the Int'l Conf. on Artificial Intelligence and Statistics. 2007. |

| [68] |

Bonilla EV, Chai KMA, Williams CKI. Multi-Task Gaussian process prediction. Advances in Neural Information Processing Systems, 2007.

http://d.old.wanfangdata.com.cn/NSTLQK/NSTL_QKJJ0227916650/ |

| [69] |

Swersky K, Snoek J, Adams RP. Freeze-Thaw Bayesian optimization. Eprint Arxiv, 2014.

http://cn.arxiv.org/abs/1406.3896 |

| [70] |

Gelbart MA, Snoek J, Adams RP. Bayesian optimization with unknown constraints. In: Proc. of the Computer Science. 2014.http://cn.arxiv.org/abs/1403.5607 |

| [71] |

Kandasamy K, Dasarathy G, Oliva J, Schneider J, Poczos B. Gaussian process bandit optimisation with multi-fidelity evaluations. Advances in Neural Information Processing Systems, 2016.

http://papers.nips.cc/paper/6118-gaussian-process-bandit-optimisation-with-multi-fidelity-evaluations |

| [72] |

Marco A, Berkenkamp F, Hennig P, Schoellig AP, Krause A, Schaal S, Trimpe S. Virtual vs. real: Trading off simulations and physical experiments in reinforcement learning with Bayesian optimization. In: Proc. of the Int'l Conf. on Robotics and Automation. 2017. |

| [73] |

Ginsbourger D, Riche RL, Carraro L. Kriging is well-suited to parallelize optimization. In: Proc. of the Computational Intelligence in Expensive Optimization Problems. 2010. 131-162.http://link.springer.com/10.1007/978-3-642-10701-6_6 |

| [74] |

Hutter F, Hoos HH, Leyton-Brown K. Parallel algorithm configuration. In: Proc. of the Int'l Conf. on Learning and Intelligent Optimization. 2012. 55-70.http://dl.acm.org/citation.cfm?id=2427402 |

| [75] |

Akrour R, Sorokin D, Peters J, Neumann G. Local Bayesian optimization of motor skills. In: Proc. of the Int'l Conf. on Machine Learning. 2017.http://eprints.lincoln.ac.uk/27902/ |

| [76] |

Torun HM, Swaminathan M, Davis AK, Bellaredj MLF. A global Bayesian optimization algorithm and its application to integrated system design. IEEE Trans. on Very Large Scale Integration Systems, 2018: 1–11.

|

| [77] |

Morere P, Marchant R, Ramos F. Sequential Bayesian optimization as a POMDP for environment monitoring with UAVs. In: Proc. of the Int'l Conf. on Robotics and Automation. 2017. 6381-6388.http://cn.arxiv.org/abs/1703.04211 |

| [78] |

Colopy GW, Roberts SJ, Clifton DA. Bayesian optimization of personalized models for patient vital-sign monitoring. IEEE Journal of Biomedical and Health Informatics, 2018, 22(2): 301.

[doi:10.1109/JBHI.2017.2751509] |

| [79] |

Candelieri A, Perego R, Archetti F. Bayesian optimization of pump operations in water distribution systems. Journal of Global Optimization, 2018.

http://link.springer.com/10.1007/s10898-018-0641-2 |

| [80] |

Klein A, Falkner S, Bartels S, Henning P, Hutter F. Fast Bayesian optimization of machine learning hyperparameters on large datasets. In: Proc. of the Int'l Conf. on Artificial Intelligence and Statistics. 2017. |

| [81] |

Xia Y, Liu C, Li YY, Liu N. A boosted decision tree approach using Bayesian hyper-parameter optimization for credit scoring. Expert Systems with Applications, 2017, 78: 225–241.

[doi:10.1016/j.eswa.2017.02.017] |

| [82] |

Yogatama D, Kong L, Smith NA. Bayesian optimization of text representations. In: Proc. of the Conf. on Empirical Methods in Natural Language Processing. 2015. 2100-2105.http://cn.arxiv.org/abs/1503.00693 |

| [83] |

Carr S, Garnett R, Lo C. BASC: Applying Bayesian optimization to the search for global minima on potential energy surfaces. In: Proc. of the Int'l Conf. on Machine Learning. 2016. |

| [84] |

Krivák R, Hoksza D, Škoda P. Improving quality of ligand-binding site prediction with Bayesian optimization. In: Proc. of the Int'l Conf. on Bioinformatics and Biomedicine. 2017. 2278-2279.http://ieeexplore.ieee.org/document/8218024/ |

| [85] |

Tanaka R, Iwata H. Bayesian optimization for genomic selection:A method for discovering the best genotype among a large number of candidates. Theoretical and Applied Genetics, 2017, 131(1): 1–13.

http://link.springer.com/10.1007/s00122-017-2988-z |

| [86] |

Lancaster J, Lorenz R, Leech R, Cole JH. Bayesian optimization for neuroimaging pre-processing in brain age classification and prediction. In: Proc. of the Frontiers in Aging Neuroscience. 2018. |

| [87] |

Ruder S, Plank B. Learning to select data for transfer learning with Bayesian optimization. In: Proc. of the Conf. on Empirical Methods in Natural Language Processing. 2017. 372-382.http://cn.arxiv.org/abs/1707.05246 |

| [88] |

Tesch M, Schneider J, Choset H. Expensive multiobjective optimization and validation with a robotics application. In: Proc. of the Conf. on Neural Information Processing Systems: Workshop on Bayesian Optimization and Decision Making. 2012.http://riweb-backend.ri.cmu.edu/publication_view.html?pub_id=7375 |