文章信息

- 李英杰, 张广群, 汪杭军

- Li Yingjie, Zhang Guangqun, Wang Hangjun

- 基于自学习特征的林业业务图像分类方法

- A Method for Forestry Business Images Classification Based on Auto-Learning Features

- 林业科学, 2018, 54(5): 78-86.

- Scientia Silvae Sinicae, 2018, 54(5): 78-86.

- DOI: 10.11707/j.1001-7488.20180509

-

文章历史

- 收稿日期:2016-09-05

- 修回日期:2017-02-22

-

作者相关文章

2. 浙江农林大学信息工程学院 临安 311300

2. School of Information Engineering, Zhejiang A & F University Lin'an 311300

林业具有巨大的生态、经济和社会功能,是应对经济全球化发展过程中造成的生态危机和气候变化问题的有效途径(杨帆等, 2016),因此加强森林资源监管以促进生态环境建设受到各级政府部门的高度重视。护林员是林业工作的骨干力量,其将林业现场情况通过手机拍摄后上传到服务器,根据图像数据,按照林业业务需求快速分类,并发送给相关林业管理部门,可以对相关事件进行及时、有效的处理(张罡, 2018)。这种森林资源监管模式,摒弃了传统管理手段无法准确及时了解现场状况和动态的问题。要使林业各个管理部门,包括林业执法机构和执法队伍能够全面配合、相互协调,增强决策支持和应急处理能力,其核心和基础就是实现林业业务图像的自动分类(张广群等, 2017)。

图像分类是机器视觉领域中的重要和基础问题之一,其任务是根据图像具有的某种属性将其划分到预先设定的不同类别中(亓晓振等,2012)。广义上,可以将图像分类分为图像物体分类和图像场景分类,其中,图像物体分类即根据图像中包含的主要目标对图像进行分类,如包含飞机的图像、包含小鸟的图像等;而图像场景分类则侧重于对图像场景的整体认识和表达,如风景图像、灾难图像和会议图像等(黄凯奇等,2014)。图像分类的本质是通过计算机对图像进行理解,其过程一般从底层特征开始。幸泽峰等(2016)提取遥感图像中的植被指数特征,用于识别和提取农田防护林区域;刘子豪等(2013)利用木材横切面微观构造图像,基于核主成分分析法提取其中的高维空间特征识别木材类别;王雪峰等(2013)利用图像处理方法,查找柑橘糖度与图像色彩的关系。图像底层一般应具有良好的尺度不变和旋转不变特征,如SIFT、SURF和HOG等(顾广华等,2016),以获得较好的表达能力;但是底层特征因缺少语义解释而泛化性差,对于图像场景分类问题,图像的中高层语义也是图像分类的研究要点(金泰松等,2013),如Bag of Words(BoW,词袋)及其衍生方法就是图像分类中近年来普遍采用的高层特征方法。BoW应用图像场景的整体统计信息,将量化后的图像底层特征视为视觉单词,通过图像的视觉单词分布来表达图像场景内容(黄凯奇等,2014)。

传统“底层特征+BoW”图像分类方法的问题在于,人们并不能确定什么样的特征和什么样的抽象方法对什么样的业务图像分类有效,研究工作主要通过尝试不同的特征和不同的抽象方法来确定适合不同业务图像的分类方法。近年来,突飞猛进发展的深度学习方法在图像分类研究中一定程度上解决了这些问题,并在许多图像分类数据集上取得了成功(Zhou et al., 2014)。深度学习是含多隐层的多层感知器学习网络,其通过反馈、优化自动学习适合的底层特征,并自动在高层组合和抽象底层特征形成高层表示。深度卷积神经网络(deep convolutional neural networks, deep CNNs)目前是深度学习方法中应用最为广泛的方法(LeCun et al., 2015)。Krizhevsky等(2012)利用深度卷积神经网络在图像分类竞赛中取得了较好效果,证明了深度卷积神经网络在获取图像分类特征方面的有效性;Girshick等(2014)、Girshick(2015)提出了基于区块的深度卷积神经网络R-CNN(regions with CNN features),有效解决了目标定位和分割问题;Najibi等(2016)提出了G-CNN,识别精度与R-CNN相当,但进一步提高了学习速度;Zhang等(2014)提出了一种结合CNN和Part-base的人体属性分类算法,通过将图像划分为小块,从而使得CNN能够更加方便地训练,从较小的数据集中就可学习到强大的形态归一化特征;Lin等(2016)利用2套深度卷积神经网络分别获取图像块的位置和形态特征,提高了图像识别精度。当然,深度学习算法一般需要大量的训练样本和精细的参数优化,需要机器有大内存,运行时间也很长(Chen et al., 2018)。

本研究提出一种3层的深度学习网络:第1层为线性稀疏自动编码器,第2层为卷积与池化,第3层为softmax,用于林业业务图像分类。其中,第1、2层相当于特征提取功能,第2层借助第1层的自动学习功能,最终提取的特征向量是自适应的;第3层softmax以前2层获得的特征向量为基础进行分类建模。

1 材料与方法 1.1 材料准备林业业务范围广泛,涉及图像种类繁多,林业业务图像分类目前还没有统一标准。本研究从林业业务角度出发,综合林业管理部门建议,确定了研究用林业业务图像的4个类别:动物死亡、森林火灾、采伐和森林病虫害。将收集到的4类图像进行预处理,截取中间子区域至240×240像素大小。为了保持图像固有比例,图像预处理过程中未进行缩放,原始图像长或宽不足240像素的删除,最终获得355幅图像,其中,动物死亡图像95幅、森林火灾图像109幅、采伐图像89幅、森林病虫害图像62幅。4类图像样本如图 1所示(经过缩放),其中每行为一类图像的样本,从上到下4行样本类别分别为动物死亡、森林火灾、采伐和森林病虫害。

|

图 1 4类林业业务图像样本 Figure 1 Image samples of four forestry business categories |

林业业务图像分类属于图像场景分类问题,相比一般的图像场景分类,林业业务图像分类面临更大的挑战。以“动物死亡”类为例,动物本身就千差万别,加之背景不同、拍摄距离和角度不同以及是否有人出现,都使得图像类内的相似性较弱,极大提高了图像分类特征的选取难度。

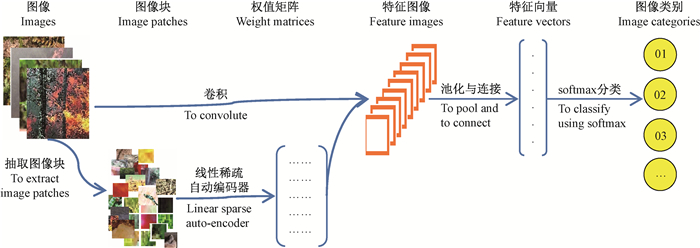

本研究采用局部特征与全局语义相结合的方法进行图像识别。首先,将所有图像分块,对图像块采用线性稀疏自动编码器进行自动学习,获取局部特征的权值矩阵,该矩阵反映了局部图像块的特征提取方法;之后,利用权值矩阵对图像进行卷积,获取各种局部特征在图像中的映射,再进行池化与连接形成特征向量;最后,利用特征向量,采用softmax分类方法进行图像类别建模与识别。该方法整体流程如图 2所示,其中,线性稀疏自动编码器是一层自动学习网络,加上卷积和池化层及softmax层,构成了一个3层深度学习网络。

|

图 2 试验方法整体流程 Figure 2 The overview of our experimental method |

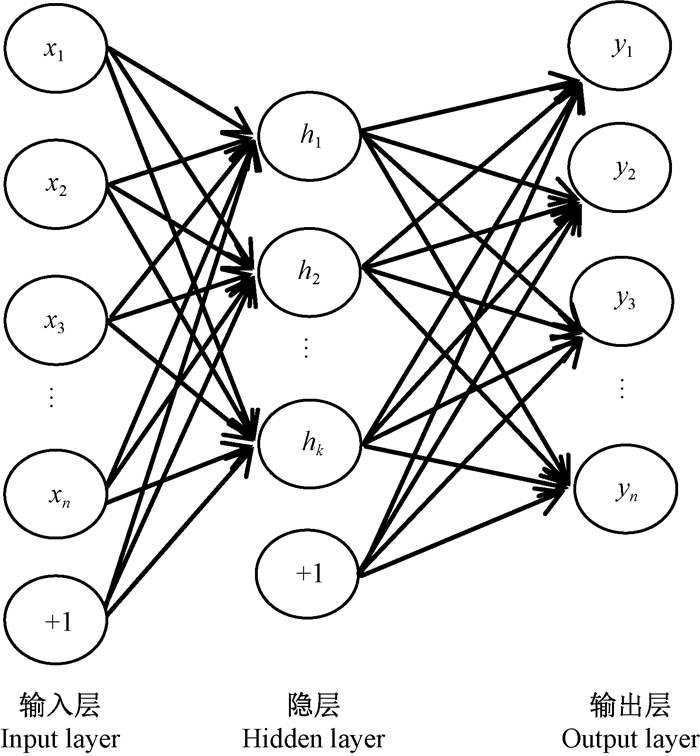

线性稀疏自动编码器是一种基于人工神经网络的无监督学习方法。对人工神经网络设置一个隐层,同时让其输出y等于输入x(均为向量表示),通过反向传播学习,可以得到一个自动编码的学习网络,如图 3所示(Ng et al., 2016)。图 3中,从输入层到隐层的变换需学习权值矩阵W(1)(大小为k×n)和偏置向量b(1)(大小k×1),隐层节点的估计值按式(1)计算:

| $ \hat h{\rm{ = }}{f_1}({W^{(1)}}x + {b^{(1)}}){\rm{。}} $ | (1) |

|

图 3 单隐层的人工神经网络示意 Figure 3 A diagram of artificial neural network |

同样,从隐层到输出层的变换需学习权值矩阵W(2)(大小为n×k)和偏置向量b(2)(大小为n×1),输出节点的估计值按式(2)计算:

| $ \hat y = {f_2}({W^{(2)}}h + {b^{(2)}}){\rm{。}} $ | (2) |

式中:f1(·)和f2(·)为激活函数。

为了增加网络的非线性功能,f1(·)选用sigmoid函数,如式(3)所示:

| $ f\left(z \right) = \frac{1}{{1 + {\rm{exp}}\left({ - z} \right)}}{\rm{。}} $ | (3) |

sigmoid是人工神经网络中常用的激活函数,具有连续、光滑、严格单调的特点。sigmoid函数输出值在(0, 1)之间,因此隐层节点的值也在(0, 1)之间。由于输出y等于输入x,而x不一定在(0, 1)范围,所以f2(·)选用恒等函数,得到一个非线性的自动编码学习网络。

给定m个学习样本(x(i),y(i)),其中x(i)等于y(i)。采用误差的均方差作为损失函数,如式(4)所示:

| $ \begin{array}{*{20}{c}} {J({W^{(1)}},{b^{(1)}},{W^{(2)}},{b^{(2)}}) = \frac{1}{m}\sum\limits_{i = 1}^m {(\frac{1}{2}{{\left\| {{{\hat y}^{(i)}} - {y^{(i)}}} \right\|}^2})} + }\\ {\frac{\lambda }{2}[\sum\limits_{i = 1}^k {\sum\limits_{j = 1}^n {{{(W_{ij}^{(1)})}^2}} } + \sum\limits_{i = 1}^n {\sum\limits_{j = 1}^k {{{(W_{ij}^{(2)})}^2}} } ]{\rm{。}}} \end{array} $ | (4) |

式(4)的第1项为均方差项,其目的是使网络计算输出尽量接近实际输出;第2项为权重衰减项,由权重值的平方和构成,其目的是减小权重幅度,防止过拟合。网络利用反向传导算法,最小化损失函数,学习到适合的W(1)、b(1)、W(2)和b(2)。

在网络隐层加上稀疏性限制,使得隐层节点大部分时间都是被抑制的(需设置稀疏系数,如0.05),即得到线性稀疏自动编码器。在学习好的网络中将隐层节点的值作为输入数据的特征值,就可以按式(1)计算输入x的特征。如果输入有300个节点,那么输出就是同样的300个节点。假设隐层的节点数为50,则网络学习得到的特征相当于输入的300维向量压缩到50维的表示,而网络会从这50维空间中重构出300维与输入相同或相似的向量。如果设置隐层的节点数大于输入节点数,则网络在隐层将输入数据在更高维的空间进行重构。

本研究取图像块大小为10×10像素。由于采用彩色图像,所以每个图像块的像素维度为10×10×3=300个,将其作为线性稀疏自动编码器的输入,同时输出也是相同维度。如果隐层节点设置为400,相当于希望从300个输入像素中获取400点的特征值,那么计算特征时需要权值矩阵W(1)的大小为400×300,偏置向量b(1)的大小为400×1。

1.4 图像卷积与池化在图像处理中,一个大的图像与一个小的模板进行卷积(用“×”表示)是一个扫描和加权求和的过程,如式(5)所示:

| $ M = A \times B{\rm{。}} $ | (5) |

式中:A为被卷积的图像,大图像;B为模板,小图像;M为卷积结果。

卷积是一个滤波过程,可以看作探查图像在空间上对模板激活的过程。设大图像大小为r×r,卷积模板大小为d×d,则卷积后得到的特征图像大小为(r-d+1)×(r-d+1)。

利用获取的特征权值为卷积模板对图像进行卷积。仍以隐层节点数为400为例,获取的权值矩阵大小为400×300,即400个卷积模板,每个模板大小是10×10的3通道彩色小图像。试验中用每个模板的3通道分别对图像的3个彩色通道进行卷积,将3通道卷积结果相加,之后加偏置向量b(1),再经sigmoid函数变换。因此,每幅图像(240×240)与所有模板卷积可得到400幅特征图像,每幅特征图像的大小为(240-10+1)×(240-10+1)=231×231。

这样,每幅图像获取的特征维数就是400×231×231。为了降低维数同时尽量保持原特征的内容和结构,试验采用平均池化方法(average pooling),如式(6)所示:

| $ F = \frac{1}{{l \times l}}\sum\limits_{i = 1}^l {\sum\limits_{j = 1}^l {{A_{ij}}} } {\rm{。}} $ | (6) |

式中:l为池化维度;A为图像中l×l的一个子块;F为池化结果。

设池化维度为19,即将特征图像(231×231)以19×19的图像块取一均值进行滑动,图像块无重叠。这样,每幅特征图像被池化为12×12大小,最终每幅图像(240×240)提取的特征数为400×12×12=57 600。

1.5 分类方法按前述参数设置,现在面对的是4类355幅图像和每幅图像中提取出的57 600维特征向量,可以采用多种模式识别方法来建立分类器,如神经网络方法、支持向量机方法和Fisher判别方法等,本研究采用softmax方法。softmax是多类回归的分类算法,适用于各类样本无重叠的多分类问题。采用留一法(leave-one-out)进行多次交叉验证,在1次试验中,为每个类别图像随机留下1幅作为测试用,共保留4幅测试图像。剩余的351幅图像作为训练图像,训练一个softmax的分类器。之后,对保留的4幅图像进行分类,记录识别精度。

2 结果与分析本研究的硬件环境为:AMD FX8350、4.2 GHz、8核CPU、8 GB内存的计算机;运行的软件环境为:Windows 7和Matlab R2012a。试验采用留一法交叉验证,取所有分类精度的平均值作为识别精度。

2.1 基本试验结果设线性稀疏自动编码器的隐层节点数为400,稀疏系数为0.035,池化维度为19,采用留一法进行10次试验,获得的平均识别精度为77.5%,具体结果如表 1所示。

|

|

从表 1可以看出,采伐类和动物死亡类图像的识别精度较低。为了考察测试图像被正确识别或错误判断的可能原因,选择2幅动物死亡类图像作为示例,如图 4所示。图 4中第1幅图像被误判为森林火灾类图像,对比图 1中火灾图像样例,可以看到这幅图像上部死亡羚羊倒地部分与火灾图像中火的颜色和形状均相像,而图像下部又与浓烟颜色相似,误判可以理解。图 4中第2幅图像被正确识别为动物死亡类,图中是一只死老虎,能被正确识别可能是因为在训练图像中有其他与死老虎相似的图像。为此,将训练图像中动物死亡类图像内所有老虎死亡的图像找出来,还有另外的第3、4、5幅图像。第3、4、5幅图像中老虎为主体,几乎是全身图像,而第2幅图像中老虎只有头部,其余的遮布和人占了大部幅面,这说明本研究方法能有效提取图像的局部特征,并联合局部特征做出整体识别。森林火灾类图像均有明显的火特征,森林病虫害类图像均有较近距离的树叶和虫类的斑纹,其类内相似性较高,所以识别精度较高。

|

图 4 动物死亡类判别图像样本 Figure 4 Image samples of animal death for identifying |

除了最终的识别精度外,本研究还对比了网络中第1层和第2层的结果。从每幅图像中(图像大小240×240)随机提取10×10的图像块3 000个,355幅图像共提取出1 065 000个图像块。对于图像集中的灰度图像增加2个通道(从其原有的1通道内容中复制过来),这样所有图像统一到3个通道,每个图像块可转化为300×1的向量。由于隐层节点数(400)大于一个图像块的维数(300),相当于在更高维的空间中重构图像块特征,而稀疏系数(0.035)则限制了隐层空间中同时被激活的节点数。试验中,提取出的图像块样本(10×10,经过缩放)和利用线性稀疏自动编码器学习到的权值矩阵样本(矩阵中的行样本,20×20,经过缩放)如图 5所示。从图 5右图可以看到明显的色彩特征、局部色彩变化特征及不同方向和不同位置的梯度特征等。

|

图 5 提取出的图像块样本(左)和学习到的权值矩阵样本(右) Figure 5 Samples of extracted patches (left) and samples of learned weight matrices (right) |

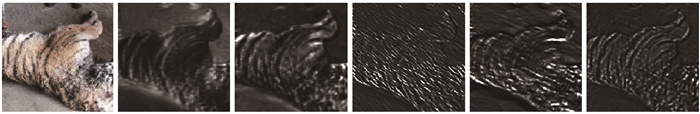

网络的第2层利用第1层的权值矩阵和偏置向量对图像进行卷积操作,提取卷积后的特征图像样例如图 6所示,其中第1幅图像是原图(240×240,经过缩放),第2~6幅图像是从第1幅图像的400幅特征图像中抽取的样例(231×231,经过缩放)。从图 6中可以看到,第2幅特征图像主要是原图中的黑色部分被激活了,反映在图中亮的部分,虽然不能精确说出每幅特征图像到底激活了原图中的什么特征(用于卷积的特征模板是自动学习得到的),但是可以明显观察到每幅特征图像都激活了原图中的不同特征,从而可以准确地对图像进行分类。

|

图 6 一幅图像与其特征图像样例 Figure 6 An image and samples of its feature maps |

池化是一种低损降维的方法,其方法简单,同时保持了原数据的结构特征。在前述试验中的池化维度为19,即将特征图像中每19×19的图像块取一均值,相当于将361维直接降到1维,降维幅度很大,信息损失可想而知。减小降维幅度是否可以进一步提高最终识别精度呢?为探索此问题的答案,在其他参数不变的情况下,将池化维度减少为15×15、11×11和7×7,并采用均值池化方法进行测试,结果如表 2所示。由表 2可知,降低池化维度后保留的信息增多了,获取的特征向量维度变高了,但识别精度反而降低了。在线性稀疏自动编码时隐层节点数为400、稀疏系数为0.035的情况下,每个图像块被激活的特征只有最重要的一小部分。以这样的权值矩阵卷积图像时,整个图像中被激活的点较零散(反映在图 6中第2~6幅图像以黑灰色为主,亮点较少),所以可能忍受较大的池化维度。当然,池化维度变大时噪声的影响也变小了。

|

|

线性稀疏自动编码器的隐层节点数反映的是对每个小图像块提取的特征数,是图像块在不同维度空间的映射,其数量也是在卷积层的卷积模板数。设置不同的隐层节点数相当于在卷积时换成了另外一套模板,可能会影响到最终的识别精度。同样,稀疏系数抑制了隐层空间中的大部分节点,稀疏系数不同也可能会影响到最终的识别精度。为了考察隐层节点数和稀疏系数对最终识别精度的影响,本研究采用10次留一测试,其平均识别精度如表 3所示,其中“300_0.06”表示在线性稀疏自动编码层中的隐层节点数设置为300,稀疏系数设置为0.06。

|

|

由表 3可知,本研究方法的最高识别精度为80% (再改变这些参数进行试验,精度没有突破该值)。结合前述试验结果可知,隐层节点数降低时,高识别精度出现在池化维度更低的试验中。稀疏系数小范围改变对识别精度影响不大,虽然不能严格证明,但可以理解为,原始图像中含有一定量的信息,当以适当方法采集到的特征信息符合这个量时,识别精度较高,而采集到的特征信息高于或低于这个量时,识别精度均会降低。

2.4 试验时间效率分析依前述试验方法,本研究包括图像预处理过程、线性稀疏编码过程、卷积与池化过程、softmax模型训练过程及利用softmax模型进行分类过程。图像预处理是将原图像切割为240×240大小,处理355幅图像耗时9.217 s。第1层线性稀疏编码最先完成,也是整个试验中耗时最长的过程,其运行时间与输入图像数和隐层节点数相关;编码过程是个迭代过程,运行时间与最大迭代次数相关;另外,输入图像的特征会影响收敛速度,从而影响运行时间。本试验中的图像色彩、纹理和梯度均复杂,规律性弱,收敛速度慢。将全部355幅图像作为输入,设置隐层节点数为225,最大迭代次数为400,编码过程运行时间为103.36 h;其他参数不变,若设置隐层节点数为300,则运行时间为122.65 h;同样,若设置隐层节点数为400,则运行时间为172.37 h。

第2层卷积与池化过程是利用第1层的隐层权值矩阵与输入图像卷积,再池化为特征向量,其运行时间与卷积模板个数与池化维度相关。以表 3中识别精度高的参数为依据,利用隐层节点为225的权值矩阵并设池化维度为15,卷积与池化355幅图像耗时931.613 s。第3层可分成softmax训练过程和softmax测试过程。以在第2层生成的特征向量为输入,以351幅图像特征输入,按softmax模型分类耗时39.158 s;以4幅图像特征输入,按softmax模型分类耗时0.028 s。

将前述运行时间按训练过程和分类过程重新整理。训练过程包括图像预处理、线性稀疏编码、卷积与池化及softmax模型训练4个阶段。以隐层节点数225为例,训练355幅图像耗时约103.63 h。训练过程虽然耗时,但在实际应用中可以提前完成;并且,训练中线性稀疏编码过程是最耗时的,其目标训练图像中的局部特征提取模板,当训练样本达到一定规模后,新的训练中不需重复。分类过程包括图像预处理、卷积与池化及softmax分类3个阶段。在参数与训练一致的情况下,分类4幅图像耗时约10.629 s。按前述时间分析,若新收到100幅图像,利用本研究方法将其全部分类需要265.725 s,分类时间基本可以满足实际应用的需要。相对于人工分类,自动分类时间和财务成本节省很多,而且其结果与后续处理系统衔接更为方便。

3 结论林业业务图像分类属于图像场景分类问题,其同一类图像的类内相似性较弱,利用传统的“特征提取+分类建模”方法进行分类,其分类特征的选取难度较大。本研究提出了一种基于自学习特征的林业业务图像分类方法,该方法联合局部特征,形成全局语义,识别精度较高,并且:

1) 相比传统的“特征提取+分类建模”方法,本研究方法底层局部特征是通过自动学习得到的,泛化性更好;

2) 相比目前流行的基于深度卷积神经网络的图像分类方法,本研究方法只有3层,没有全部层的反馈学习过程,算法效率较高;

3) 本研究方法可以学习到样例图像中的局部特征,并进行全局判别;当累积的样本图像增多、更加全面时,可以期望获得更高的识别精度。

林业业务图像自动分类具有广阔的应用前景,对于森林资源监管也具有十分重要的意义。本研究初步证明了“自动学习的局部特征+全局语义”分类方法对林业业务图像分类的可行性,可为今后更大规模的林业业务图像研究及更加高效和高精度的算法研究奠定基础。

顾广华, 韩晰瑛, 陈春霞, 等. 2016. 图像场景语义分类研究进展综述[J]. 系统工程与电子技术, 38(4): 936-948. (Gu G H, Han X Y, Chen C X, et al. 2016. Survey on semantic scene classification research[J]. System Engineering and Electronics, 38(4): 936-948. [in Chinese]) |

黄凯奇, 任伟强, 谭铁牛. 2014. 图像物体分类与检测算法综述[J]. 计算机学报, 37(6): 1225-1240. (Huang K Q, Ren W Q, Tan T N. 2014. A review on image object classification and detection[J]. Chinese Journal of Computers, 37(6): 1225-1240. [in Chinese]) |

金泰松, 李玲玲, 李翠华. 2013. 基于全局优化策略的场景分类算法[J]. 模式识别与人工智能, 26(5): 440-446. (Jin T S, Li L L, Li C H. 2013. Scene classification based on global optimized framework[J]. Pattern Recognition and Artifical Intelligence, 26(5): 440-446. [in Chinese]) |

刘子豪, 祁亨年, 张广群, 等. 2013. 基于横切面微观构造图像的木材识别方法[J]. 林业科学, 49(11): 116-121. (Liu Z H, Qi H N, Zhang G Q, et al. 2013. Wood identification method based on microstructure images in cross-section[J]. Scientia Silvae Sinicae, 49(11): 116-121. [in Chinese]) |

亓晓振, 王庆. 2012. 一种基于稀疏编码的多核学习图像分类方法[J]. 电子学报, 40(4): 773-779. (Qi X Z, Wang Q. 2012. An image classification approach based on sparse coding and multiple kernel learning[J]. Acta Electronica Sinia, 40(4): 773-779. [in Chinese]) |

王雪峰, 李晓冬, 平藤雅之. 2013. 基于彩色图像的柑橘糖度无损分析[J]. 林业科学, 49(10): 88-92. (Wang X F, Li X D, Hirafuji M. 2013. Orange brix's nondestructive analysis based on color image[J]. Scientia Silvae Sinicae, 49(10): 88-92. [in Chinese]) |

幸泽峰, 李颖, 邓荣鑫, 等. 2016. 基于ZY-3影像的农田防护林自动提取[J]. 林业科学, 52(4): 11-20. (Xing Z F, Li Y, Deng R X, et al. 2016. Extracting farmland shelterbelt automatically based on ZY-3 remote sensing images[J]. Scientia Silvae Sinicae, 52(4): 11-20. [in Chinese]) |

杨帆, 曾维忠, 张维康, 等. 2016. 林农森林碳汇项目持续参与意愿及其影响因素[J]. 林业科学, 52(7): 138-147. (Yang F, Zeng W Z, Zhang W K, et al. 2016. Foresters' constant participation willingness and affecting factors in forest carbon Ssequestration project[J]. Scientia Silvae Sinicae, 52(7): 138-147. [in Chinese]) |

张罡. 2018. 大连市护林员队伍体系建设措施及建议[J]. 现代农业科技, 2(1): 144-145. (Zhang G. 2018. Measures and suggestions on the construction of the forest guard team in Dalian[J]. Modern Agricultural Science and Technology, 2(1): 144-145. [in Chinese]) |

张广群, 李英杰, 汪杭军. 2017. 基于词袋模型的林业业务图像分类[J]. 浙江农林大学学报, 34(5): 791-797. (Zhang G Q, Li Y J, Wang H J. 2017. Classification of forestry images based on the BoW model. 2017[J]. Journal of Zhejiang A & F University, 34(5): 791-797. DOI:10.11833/j.issn.2095-0756.2017.05.004 [in Chinese]) |

Chen F C, Jahanshahi M R. 2018. NB-CNN: deep learning-based crack detection using convolutional neural network and naive bayes data fusion[J]. IEEE Transactions on Industrial Electronics, 65(5): 4392-4400. DOI:10.1109/TIE.2017.2764844 |

Girshick R, Donahue J, Darrell T, et al. 2014. Rich feature hierarchies for accurate object detection and semantic segmentation. IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 580-587.

|

Girshick R. 2015. Fast R-CNN. IEEE International Conference on Computer Vision(ICCV), 1440-1448.

|

Krizhevsky A, Sutskever I, Hinton G. 2012. Imagenet classification with deep convolutional neural networks. International Conference on Neural Information Processing Systems (NIPS), 1097-1105.

|

LeCun Y, Bengio Y, Hinton G. 2015. Deep learning[J]. Nature, 521: 436-444. DOI:10.1038/nature14539 |

Lin T, Chowdhury A R, Maji S. 2016. Bilinear CNN models for fine-grained visual recognition. IEEE International Conference on Computer Vision(ICCV), 1449-1457.

|

Najibi M, Rastegari M, Davis L S. 2016. G-CNN: an iterative grid based object detector. Computer Vision and Pattern Recognition(CVPR), 2369-2377.

|

Ng A, Ngiam J, Yu C F, et al. 2016. Unsupervised feature learning and deep learning. http://deeplearning.stanford.edu/wiki/index.php/UFLDL_Tutorial.

|

Zhang N, Paluri M. 2014. PANDA: pose aligned networks for deep attribute modeling. IEEE Conference on Computer Vision and Pattern Recognition(CVPR), 1637-1644.

|

Zhou B, Lapedriza A, Xiao J, et al. 2014. Learning deep features for scene recognition using places database. International Conference on Neural Information Processing Systems (NIPS), 487-495.

|

2018, Vol. 54

2018, Vol. 54