文章信息

- 张睿珂, 陈梅香, 李明, 杨信廷, 温俊宝

- Zhang Ruike, Chen Meixiang, Li Ming, Yang Xinting, Wen Junbao

- 基于机器视觉的蛾类三维姿态中前翅间夹角计算方法

- Method of Extracting Forewings Angle of 3D Pose for the Moth Based on Machine Vision

- 林业科学, 2017, 53(11): 120-130.

- Scientia Silvae Sinicae, 2017, 53(11): 120-130.

- DOI: 10.11707/j.1001-7488.20171114

-

文章历史

- 收稿日期:2017-01-05

- 修回日期:2017-06-11

-

作者相关文章

2. 国家农业信息化工程技术研究中心 农业部农业信息技术重点开放实验室 北京市农业物联网工程技术研究中心 北京 100097

2. National Engineering Research Center for Information Technology in Agriculture Key Laboratory for Information Technologies in Agriculture, Ministry of Agriculture Beijing Engineering Research Center for Agricultural IOT Beijing 100097

蛾类害虫种类识别是农林害虫测报与防治工作的基础。随着计算机技术的发展,基于图像的害虫自动识别技术具有省时省力、智能化等优点,有助于提高害虫识别效率(姚青等,2011)。目前广泛应用二维图像技术进行害虫的自动监测识别,但由于获取到的二维图像仅对图像中虫体的颜色、几何形状(于新文等,2003)等进行描述与利用,忽略了虫体姿态问题,造成识别算法的普适性受到影响,导致识别准确率降低。为了克服害虫姿态对识别效果造成的影响,邱道尹等(2007)设计的基于机器视觉的农田灯诱害虫实时检测系统,使害虫姿态减少为正面和背面2种。李文勇(2014a;2014b)等通过获取二维图像信息,开展了基于机器视觉的多姿态害虫特征提取与分类方法,在实验室条件下取得了较好的识别效果。以往对多姿态害虫的识别主要基于单一或正反面机器视觉进行图像获取,所获取的害虫图像信息受到限制(Wen et al., 2012),仅获得二维姿态信息,基于二维图像技术难以准确估计蛾类虫体实际空间位置对害虫特征的量化影响,导致单一基于二维图像的害虫识别算法的普适性受到一定的影响(杨红珍等,2013;Ashaghathra et al., 2007)。三维姿态信息是反映目标物体空间位置的重要参数(陈娟等,2008),所以,提取蛾类虫体的三维姿态信息以确定虫体的空间位置有助于提高蛾类害虫分类识别的准确率。

鳞翅目害虫是数量仅次于鞘翅目的主要农林害虫,是害虫监测的重点对象。一般通过黑光灯诱集监测,其死亡时虫体体色及结构基本保持一致但会出现多种死亡姿态,具体表现在两翅膀的空间相对位置不尽相同,存在较大差异。因虫体翅膀间形成不同大小的夹角,致使获取到的同种虫体的二维特征相差较远,增加了识别难度,降低了识别准确率(Nguyen et al., 2013)。张志刚等(2005)进行了人脸的三维姿态估计,对多姿态的人脸识别提供了一定基础的、有效的获取人脸偏转角度的方法。吕丹等(2015)提出有效获取目标三维姿态的方法,能够简化识别复杂性,提高识别速率。Nguyen等(2014)通过构建昆虫的真彩色3D模型用于昆虫物种的鉴定,但其是针对鞘翅目虫体并通过高精准的测量而构建得到虫体的三维模型,具有一定的复杂度,且对鳞翅目蛾类害虫的适用性较低。所以,通过机器视觉计算鳞翅目蛾类虫体前翅间夹角的角度以量化虫体的三维姿态,可避免构建复杂的虫体三维模型,从而提高鳞翅目蛾类害虫的识别效果及效率。

机器视觉(machine vision)是于20世纪60年代中期由美国学者L. R.罗伯兹在研究多面体组成的积木世界开始的,20世纪80年代至今对机器视觉的研究成为全球性热潮(胥磊, 2016)。机器视觉主要用计算机模拟人的视觉功能从客观事物的图像提取信息并进行处理,最终用于测量和判断(Milan et al., 2016)。机器视觉技术现已在工业检测、机器人导航和视觉伺服系统、医学以及农林业等方向均有广泛的应用。尤其在农林业中,利用机器视觉根据农产品的颜色、形状、大小等特征参数进行农产品的自动分级(唐向阳等,2016);使用机器视觉采集树木的实时图像为分离施药目标与非施药目标提供依据(向海涛等, 2004);以机器视觉为基础的农林业害虫的自动识别提高了害虫识别的准确率同时也减少了人工识别的劳动强度(朱莉等, 2016)。机器视觉的应用提高了生产自动化水平,具有广泛的应用范围及良好的应用前景。

目前,空间实体的角度测量方法应用较为广泛的是光学角度测量,主要包括自准直法(Machtovoi,1993)、光栅法(Torroba et al., 1998)、激光干涉法(Masajada, 2004;Fan et al., 2013)、环形激光法(Bournachev et al., 1998;Filatov et al., 1997)等。正交自准直测角装置可以进行三维角度的测量,但需同时提供2个正交的光学轨道,占用空间大;光栅法中的正交组合光栅测角法是三维空间角为数不多的测量方法之一,但是其测量范围较小;激光干涉法的测量精度较高,但其结构精密复杂、稳定性弱且只能进行一维角度测量并不适用于三维角度;环形激光法可以精确地测量动态角度以及角速度却无法实现静态角度的测量。以上的角度测量方法均不适用于棉铃虫(Helicoverpa armigera)两前翅间夹角的测量。此外,通过三坐标仪获取实体坐标点计算得到空间位置信息的描述也是常见的角度测量方法之一。三坐标仪分为接触型与非接触型,其中接触型三维测量仪的探针会对虫体翅膀造成损害,但专门的非接触型三维激光坐标仪价格昂贵,安装调试不便,应用推广较难(张国雄,2000)。

综上,目前利用机器视觉进行蛾类害虫虫体前翅间夹角的获取,还鲜有报道。本文提出一种简单易操作的基于机器视觉的方法而非构建具体的三维模型,对复杂的蛾类害虫三维姿态进行量化的方法:通过对图像在颜色空间的转换,利用Harris角点提取法进行特征点的提取并获得特征点坐标进而计算得到虫体前翅间夹角,来准确获取蛾类害虫三维姿态信息数据,以克服二维形态识别的信息缺失、不具有较强鲁棒性的问题,提高蛾类害虫种类识别的准确率,为蛾类害虫的自动识别与计数提供基础。

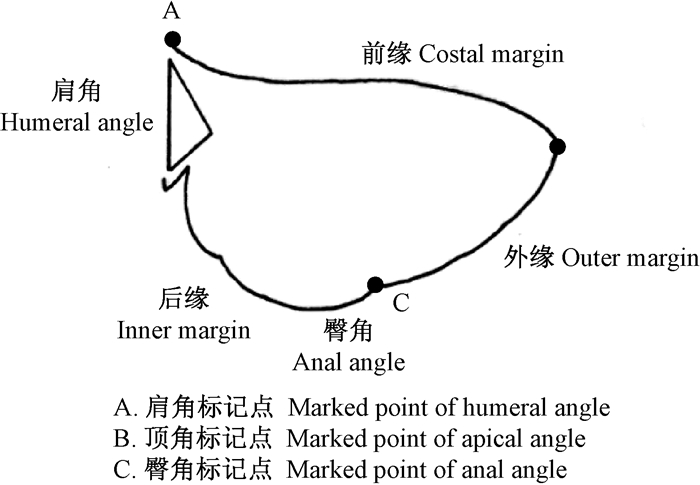

1 材料与方法 1.1 虫体三维姿态夹角的定义鳞翅目蛾类害虫姿态变化主要是由于翅膀绕肩角发生旋转产生的形变。根据虫体姿态变化的特点、害虫姿态信息的求解,重在选取能代表姿态信息的部位,而蛾类害虫在立体空间中两翅膀在虫体背侧形成的夹角是虫体三维姿态的一种表现形式,故所求解的蛾类害虫三维姿态信息可以通过计算蛾类虫体两前翅翅面间夹角获得。蛾类虫体的翅膀一般近三角形,翅膀三个顶点分别为肩角、顶角和臀角,选取这些具有代表性的部位进行颜色标记,图 1所示,判断这些标记点(marked points)所处的空间位置并确定标记点所组成的面,通过计算获取得到虫体的三维姿态信息。

|

图 1 蛾类虫体翅膀标记点(仿Snodgrass,1935) Figure 1 Marked point of moth pest forewing (Snodgrass, 1935) |

选取对农林业均有危害的鳞翅目夜蛾科害虫棉铃虫成虫作为供试虫体(包括棉铃虫成虫雌、雄个体)。棉铃虫寄主广泛,包括苹果(Malus pumila)、泡桐(Paulownia sp.)等林木及棉花(Gossypium spp.)、玉米(Zea mays)等农作物,试验虫体于北京市昌平小汤山精准农业示范基地通过黑光灯装置诱捕获取。

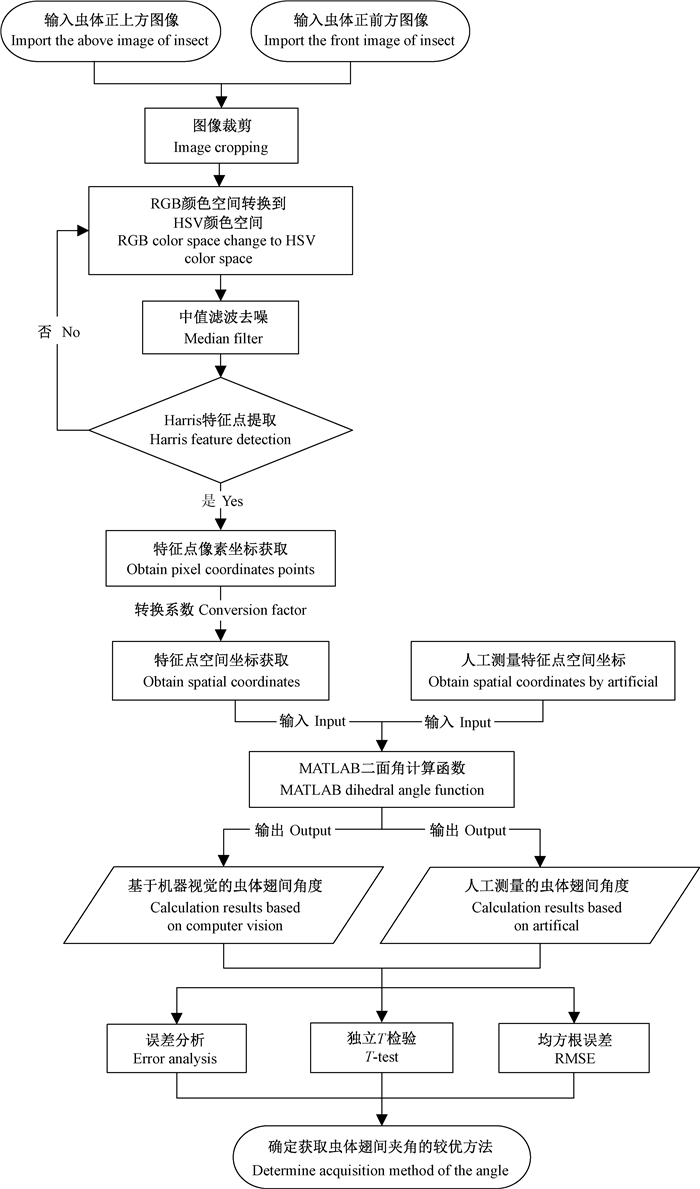

1.3 虫体前翅间夹角提取流程棉铃虫前翅间夹角的提取方法的总体流程如图 2所示。首先,进行图像的采集,获取棉铃虫虫体试验样本图像;其次,对获取到的样本图像进行预处理操作:图像的裁剪、灰度化、图像的平滑去噪等处理,使获取到的图像后期更易于处理与操作;然后将预处理得到的图像进行角点提取处理,从而获取到棉铃虫前翅上的关键标记点,进而提取标记点空间坐标,进行虫体前翅间夹角计算;最后将得到的棉铃虫虫体前翅间夹角进行数据验证和误差分析。

|

图 2 虫体前翅间夹角计算处理流程 Figure 2 Calculation and processing of forewings angle |

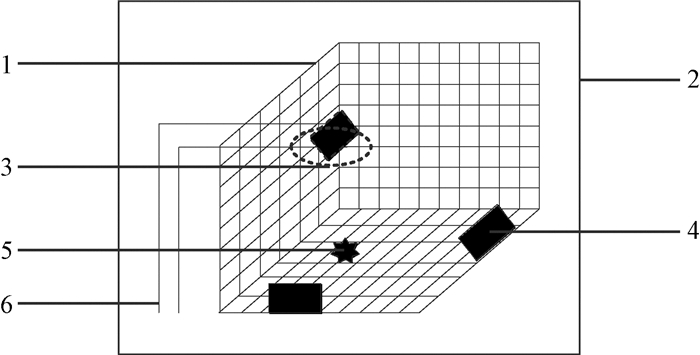

图像获取是在实验室内自主构建的拍照环境中利用图像获取系统对选取的试验虫体棉铃虫进行图像采集。图像获取环境系统包括双色温环状光源、密闭箱体,以及标准1 cm×1 cm方格的白色背景坐标纸板。将白色坐标纸板构建成三角立体坐标板并放置于密闭箱体内,箱体内部上方固定环状光源,构成亮度较为稳定的环境,如图 3所示。相机型号是SONY DSC-W710,光圈f/5.1,焦距12 mm,设置微距模式,采集图像大小为4 608像素×3 546像素,3台相机的缩放一致。

|

图 3 图像采集装置示意 Figure 3 Diagram of image acquisition device 1.三维坐标板3D coordinate plate;2.密闭箱体Closed box;3.环状光源Light source;4. SONY相机SONY camera;5.棉铃虫样本H. armigera sample;6.固定支架Fixed bracket. |

将1.0 cm×1.0 cm×1.0 cm的软塑料正方体置于分别距离三角立体直角坐标板X-Z平面40 mm且距离Y-Z平面40 mm位置处,利用1#昆虫针将棉铃虫虫体固定于坐标板正方体中心处(棉铃虫虫体置于昆虫针顶端),其中一台相机伸入环状光源中间进行垂直角度图像获取,距离X-Y平面20 cm;另外2台相机置于虫体正前方且分别垂直距X-Z平面、Y-Z平面20 cm。在自构建的图像获取环境中,每次放置1只棉铃虫,根据害虫的原有姿态,调节光源且保持光源亮度不变,分别获取棉铃虫虫体的上方、正面及侧面的图像,保存。图 4a是由机器视觉获取到的虫体上方原始图像。

虫体夹角的激光测量参考值即通过激光测距仪分别测得虫体标记点与固定点的距离并换算成虫体在空间内的实际坐标点后加以计算获得并作为虫体两前翅间夹角的参考值。

本文方法基于MATLAB R2012b编程环境实现,PC处理器是Inter Core i5-3470,CPU 3.20 GHz。

1.5 图像预处理图像的预处理主要是将图片中的干扰物去除以及最大限度地提取出目标虫体,是对于虫体进行特征点提取的有效前提。预处理部分主要包括:

1.5.1 图像裁剪同一个种的昆虫,也存在一定的个体差异,目标虫体会大小不同,但是个体差异会在一定范围之内。所以,为突出目标个体首先要对原始图像进行有效裁剪,去除不必要的背景,以便后期处理。

1.5.2 图像分割由相机获取到的图像都为真彩色图像,彩色图像相比于灰度图像提供了更多的信息,对彩色图像进行分割需要选取适合的颜色空间(阮秋琦,2001)。彩色图像最常见的是用RGB颜色空间进行表示,但是RGB颜色空间符合显示系统却与人眼感知具有较大的差异(林开颜等,2005),并且RGB是同时对彩色图像进行描述,三分量(即R、G、B, 取值范围分别是0~255)具有高度相关性,而HSV模型是一种复合主观感觉的颜色模型。其中,H、S、V分别代表的是色调(hue)、饱合度(saturation)和亮度(value),H分量表示颜色的种类,S分量表示所选色彩的纯度与该色彩的最大纯度比例,V分量表示颜色的明暗程度,3个分量的取值范围归一化后为0~1。H、S、V 3个分量具有不相关性,且由RGB颜色空间转化到HSV颜色空间是一个快速的非线性变换。由RGB到HSV转换的表达式(包全磊,2010):

| $ V = \max \left( {R,G,B} \right), $ | (1) |

| $ \begin{array}{*{20}{c}} {S = \left[ {\max \left( {R,G,B} \right) - \min \left( {R,G,B} \right)} \right]/}\\ {\max \left( {R,G,B} \right)。} \end{array} $ | (2) |

对于式(1)、(2),若V=0,则S=0。若V=R,则H=60(G-B)/[V-min(R, G, B)],若V=G,则H=120+60(B-R)/[V-min(R, G, B)], 若V=B,则H=240+60(R-G)/[V-min(R, G, B)],

| $ 若\;H < 0,则\;H = H + 360。$ | (3) |

经由RGB到HSV颜色空间的转换,分别获得H分量、S分量、V分量的灰度图像,根据获取的分量灰度图像得到最后的分割图像。

1.5.3 图像去噪数字图像的噪声主要来源于图像采集以及传输过程,在进行虫体图像采样时,光照强度不仅会对图像产生杂质干扰,同时在颜色通道转换过程中亦产生一定的噪声。噪声具有不可预测性,故对图像进行噪声去除以提高原图像的质量。本试验选取中值滤波进行图像去噪,中值滤波不仅可以去除孤点噪声,且能保持图像的边缘特性,不会使图像产生明显的模糊。中值滤波是基于排序统计理论的一种能有效抑制噪声的非线性图像增强处理技术,它是将数字序列中一点的值用该点的一个邻域中几个点值的中值代替,使周围值更接近真实值,从而对消除孤立点和线性脉冲等噪声效果佳。中值滤波去噪如式(4)所示:

| $ g\left( {x,y} \right) = {\rm{med}}\left[ {f\left( {x - k,y - l} \right),\left( {k,l \in \mathit{\boldsymbol{W}}} \right)} \right]。$ | (4) |

式中:f(x, y), g(x, y)分别为原始图像和处理后的图像。W为二维模板,通常为2×2,3×3区域。

1.6 基于Harris的特征点提取本试验中棉铃虫虫体的特征点即为虫体前翅的标记点,标记点选取红色颜料在虫体前翅特定位置进行标记,同时标记点也是极值点,指二维图片中图像的边界曲率有极大变化的点或者是灰度变化很大的点。Harris角点检测算法(stephens, 1988)是在Moravec算法上发展得到的目前一种经典且热门的图像特征点提取算法。Harris角点检测具有定位准确、计算稳定和强鲁棒性的特点,其原理是通过图像局部的小窗口观察图像特征,窗口向任意方向移动都能够检测到图像灰度明显变化,即角点。具体提取过程如下:

设图像窗口平移量为(u, v),产生的灰度变化为E(u, v),

| $ \begin{array}{l} 有\;\mathit{\boldsymbol{E}}\left( {u,v} \right) = \\ {\rm{sum}}\left[ {w\left( {x,y} \right){{\left[ {I\left( {x + u,y + v} \right) - I\left( {x,y} \right)} \right]}^2}} \right] \end{array} $ | (5) |

式中:w(x, y)为窗口函数,I(x+u, y+v)为平移后的灰度值,I(x, y)为平移前的灰度值。根据泰勒公式展开得:

| $ \begin{array}{*{20}{c}} {I\left( {x + u,y + v} \right) = }\\ {I\left( {x,y} \right) + {I_x}u + {I_y}v + O\left( {{u^2},{v^2}} \right)。} \end{array} $ | (6) |

式中:Ix, Iy分别为偏微分,在图像中为图像的方向导数。因此,

| $ \begin{array}{*{20}{c}} {\mathit{\boldsymbol{E}}\left( {u,v} \right) = }\\ {{\rm{sum}}\left[ {w\left( {x,y} \right){{\left[ {{I_x}u + {I_y}v + O\left( {{u^2},{v^2}} \right)} \right]}^2}} \right]。} \end{array} $ | (7) |

可以近似得到:

| $ \mathit{\boldsymbol{E}}\left( {u,v} \right) = {\rm{sum}}\left[ {w\left( {x,y} \right){{\left[ {{I_x}u + {I_y}v} \right]}^2}} \right], $ | (8) |

即

| $ \mathit{\boldsymbol{E}}\left( {u,v} \right) = \left[ {u,v} \right]\left[ {I_x^2,{I_x}{I_y};{I_x}{I_y},I_y^2} \right]{\left[ {u,v} \right]^T}, $ | (9) |

令

| $ \mathit{\boldsymbol{M = }}\left[ {I_x^2,{I_x}{I_y};{I_x}{I_y},I_y^2} \right]。$ | (10) |

因此最后对角点的检测成了对矩阵M的特征值的分析,令M的特征值为x1, x2:

当x1>>x2或者x2>>x1,则检测到的是边缘部分;

当x1,x2都很小时,图像窗口在所有移动的方向上移动灰度级都无明显变化;

当x1,x2都很大且相当时,检测到的是特征点。

由于计算2个特征点比较耗时,Harris给出角点判别不需要计算出x1和x2,而是通过计算角点响应函数R:

| $ R = \det \left( \mathit{\boldsymbol{M}} \right) - k{\rm{trac}}{{\rm{e}}^2}\left( \mathit{\boldsymbol{M}} \right)。$ | (11) |

式中:det(M)为矩阵M的行列式,trace(M)为矩阵M的迹,式中R即为特征点。

1.7 空间坐标获取在Harris角点提取的过程的同时也获取到了每一个标记点的像素坐标,并将其存储在MATLAB的workspace中。其中,由上方获取到的虫体背面图像中可得图像每一标记点的像素坐标即表示为该标记点在自构建的实际坐标系中X-Y平面坐标,像素坐标原点在图像左上角,水平方向为X轴,竖直方向为Y轴,与实际坐标相同;由正前方获取的图像中也可获得相同标记点的像素坐标,但是其像素坐标中X-Y平面则表示为该角点在自构建的实际坐标系中X-Z平面的坐标,水平向右为X轴,竖直向下为Z轴,像素坐标原点在左上角,但实际坐标原点在左下角,Z轴相反。

由MATLAB获取到的标记点坐标为像素坐标,需要与实际坐标进行换算,以获取虫体特征点的空间实际坐标。

1.8 夹角角度的计算根据空间几何原理(苏步青,1991),将获取到的虫体的特征点的空间坐标点进行整合,由已知的左右翅膀平面上的6个非共线空间坐标点A1、B1、C1;A2、B2、C2分别构建2个平面方程:

| $ \begin{array}{*{20}{c}} {{\rm{Plane1:}}{A_1}x + {B_1}y + {C_1}z + {D_1} = 0}\\ {\left( {A_1^2 + B_1^2 + C_1^2 \ne 0} \right),} \end{array} $ | (12) |

| $ \begin{array}{*{20}{c}} {{\rm{Plane2:}}{A_2}x + {B_2}y + {C_2}z + {D_2} = 0}\\ {\left( {A_2^2 + B_2^2 + C_2^2 \ne 0} \right)。} \end{array} $ | (13) |

设两平面的法向量坐标分别为

| $ \overrightarrow {{n_1}} \times {\rm{Plane1}} = 0, $ | (14) |

| $ \overrightarrow {{n_2}} \times {\rm{Plane2}} = 0。$ | (15) |

求解方程得到n1、n2坐标,进一步求解得到两向量之间的夹角θ的余弦值为:

| $ {\rm{cos}}\theta = {\rm{cos}}\left\langle {\overrightarrow {{n_1}} ,\overrightarrow {{n_2}} } \right\rangle = \frac{{\overrightarrow {{n_1}} \times \overrightarrow {{n_2}} }}{{\left| {\overrightarrow {{n_1}} } \right|\left| {\overrightarrow {{n_2}} } \right|}}。$ | (16) |

根据空间几何原理并在MATLAB中自主构建函数,可求解获得棉铃虫虫体前翅间夹角。

由此求得空间虫体前翅间的夹角,由异面直线所构成的角,一定是锐角或直角,不可能是钝角,但二面角可能存在锐二面角、直二面角和钝二面角3种情况,故棉铃虫虫体前翅间夹角实际度数需要利用原始图像通过试验者肉眼观察其角度是否大于直角90°进行综合判定分析。利用棉铃虫虫体前翅间夹角提取方法,获取本次样本虫体前翅间夹角测量值。

2 结果与分析 2.1 图像预处理图像裁剪是图像分割的前提条件,获取到的原始图像如图 4a所示,但图中目标区域较小,为保证图像后期处理的速度与质量,将其裁剪后(图 4b)保存。对比图 4a与4b,裁剪后的图像目标更为明显且图像质量保持良好。

|

图 4 目标虫体的图像预处理 Figure 4 Image preprocessing of target insect A、B、C:左前翅标记点The left forewing marked points;A1、B1、C1:右前翅标记点The right forewing marked points. a.原始图像Original image; b.裁剪图像Split image; c.S分量灰度图像S component gray level image; d.中值滤波图像Median filter image. |

利用本文方法中阐述的颜色空间转换的方法,将RGB空间的图像转换为HSV空间的图像,分别得到H、S、V 3个分量的灰度图。相比较之,S分量灰度图具有较好的分割性,能保持图像兴趣目标部位的完整性及明显性,如图 4c所示,可以很明显将虫体与背景板有所区分,同时,在虫体的前翅上的标记点也可以很明显地显现于虫体翅膀之上。

中值滤波有效地去除了孤立噪声点同时也保持了兴趣目标轮廓的完整性,如图 4d。

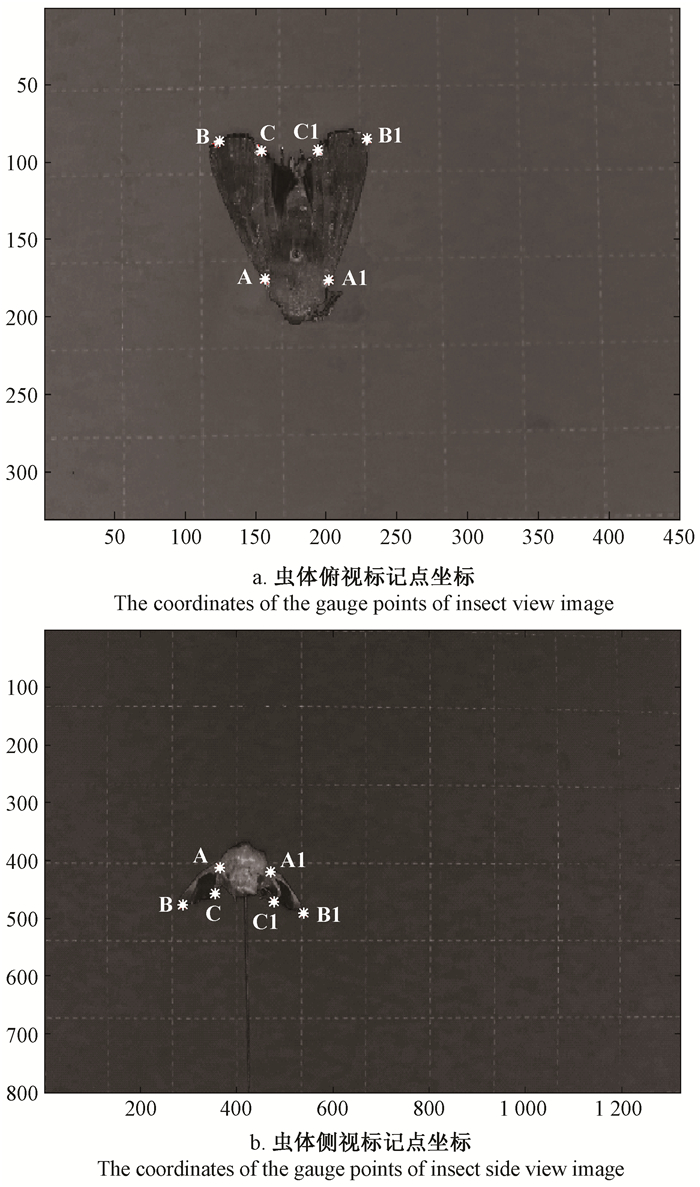

2.3 特征点提取及坐标获取根据Harris角点提取原理,对获取到的图像进行特征点提取,选择[9, 9]高斯窗口以减少伪角点的出现,从而获得曲率变化及灰度变化的极值点,同时获取极值点的像素坐标。虫体角点提取结果如图 5a、b所示。

|

图 5 棉铃虫虫体标记点坐标(像素) Figure 5 The coordinate graphs of gauge points on cotton bollworm(pixel) A、B、C:左前翅标记点The left forewing marked points; A1、B1、C1:右前翅标记点The right forewing marked points. |

将获取到的像素坐标转化为实际空间坐标用以后期计算,试验中采用图像中每1 cm方格所具有的像素点进行参考,利用1 cm方格的实际长度与1 cm长度中所包含的像素点之比,计算得到每一像素点在该幅图像中的实际长度,图像中标准1 cm方格的像素大小为366 pixels,即标定系数为1/366 cm·pixel-1,从而由标定系数计算得到实际坐标点。最终,完整获取到1只虫体上6个标记特征点的空间实际坐标(X,Y,Z)。

2.4 角度测量精度分析为了验证本文提出的虫体前翅间夹角计算方法的可行性及可靠程度,本文用激光测量方法分别测量每标记点的空间相对距离并计算试验虫体前翅间夹角作为参考值,并将本文方法得到的测量值与参考值进行比较分析,同时,本文方法计算每个样本虫体夹角角度所需时间也由表 1给出。根据每个样本的计算时间可得本文中方法运行完成平均所需时间为14.596 7 s(Win7操作系统下基于MATLAB测试得到),但激光测量时间分为测量与计算时间,所需基本时间都大于1 min,故本文方法在计算效率上有所提高。

|

|

针对已获取的数据,根据统计学原理由测量值与参考值进行比较,计算绝对误差(absolute error)以及相对误差(relative tolerance),计算公式如下:

| $ E = X - {X^T}, $ | (17) |

| $ \sigma = \left| E \right|/{X^T} \times 100\% 。$ | (18) |

式中:E为绝对误差,X和XT分别代表测量值与参考值;σ是相对误差,|E|/XT是绝对误差的绝对值与参考值之比。

计算结果如表 1所示,最小相对误差为0.10%,最大相对误差3.96%。平均相对误差1.02%。根据统计学原理,相对误差在100%±5%之内,数据均为可靠数据,故此方法所得结果在允许的误差范围之内。

为了检验2种方法是否存在差异,针对2组数据进行了检验。由于配对样本是指同一样本不同时间做了2次试验,或者具有2个类似的试验记录,从而比较其差异。本文将所有虫体看成1个样本,2种方法相当于对样本做了2次试验,故2种方法的2组数据是配对的,满足配对样本T检验的条件,可以采用配对样本T检验对数据进行分析。其计算原理如下:

| $ T = \frac{{{{\bar X}_1} - {{\bar X}_2}}}{{{S_d}/\sqrt N }}, $ | (19) |

| $ {S_d} = \sqrt {\frac{{\sum {d_i^2} - {{\left( {\sum {{d_i}} } \right)}^2}/N}}{{N - 1}}} 。$ | (20) |

式中,di=X1i-X2i,其中X1i、X2i分别是激光测量方法和本文方法的第i个样本值;Sd是di的标准差,N是样本量,X1、X2分别是2组样本的平均值。

表 2为12头棉铃虫虫体前翅间夹角参考值与测量值进行配对T检验的结果,P=0.277 > 0.05,表明夹角参考值与测量值之间没有显著差异,说明本文方法可用。

|

|

为了检验本文计算方法的精确度,衡量计算偏差,计算均方根误差(RMSE)(又称标准误差)(郭秀明等,2012)。设di1表示利用本文方法测得的夹角,di2表示激光测得的夹角,所以,均方根误差计算公式如下:

| $ \begin{array}{*{20}{c}} {{\rm{RMSE}} = \sqrt {\frac{{\sum\limits_{i = 1}^n {{{\left( {{d_{i1}} - {d_{i2}}} \right)}^2}} }}{{n - 1}}} }\\ {i = 1,2,3, \cdots ,12。} \end{array} $ | (21) |

式中:n表示此次试验中角度的测量次数,本文中n=12。

根据式(21),RMSE=1.421 6°,RMSE的结果越小,越靠近于0,精确度越高。说明本文方法具有一定的精确度。

3 讨论试验的核心计算方法是基于立体几何学中关于二面角的相关算法,本文首次尝试将其应用在蛾类虫体两前翅间夹角上。但是,计算过程中也存在不足,为了避免虫体其他突出部位如触角、足等在角点检测过程中形成的伪角点,影响计算的精确性,则对虫体进行了前翅特征点标记,为同时确定虫体正面图像和侧面图像能的唯一特征点提供保证。同时为提高特征点坐标获取的精确性,避免图像中出现的其他干扰成分,构建了单纯的图像获取环境,以保证虫体前翅特征点坐标的准确获取。

鳞翅目蛾类昆虫种类繁多,但大部分蛾类成虫前翅结构相似,本文中选取棉铃虫为代表进行试验,但所得前翅膀间夹角计算方法适用于一般蛾类成虫;对雌雄成虫前翅结构差异不大的种类也有普适性;但对具有明显性二型现象的蛾类成虫,其不同性别成虫前翅间夹角计算方法值得深入探讨。对于蛾类昆虫中具有丰富鳞片及鳞毛的虫体,在其不影响虫体前翅标记特征点的前提下,本文方法也是适用的,但若鳞片及鳞毛覆盖了特征点,本文算法有待改进。获得的棉铃虫成虫试验虫体,其前翅覆于后翅上,所以在本文中仅计算其前翅间夹角,对于前后翅分离的蛾类虫体,其后翅空间位置与前翅有一定的差距,前后翅夹角计算则会有所不同,但其夹角计算原理相同,本文方法也适用于蛾类成虫后翅间夹角计算,但其准确率、精确度及前翅是否对后翅角度计算有影响都需要继续探讨。为进一步提高本文计算方法的普适性,今后的研究重点是对鳞翅目蛾类害虫虫体自然环境下的三维姿态提取,无需构建单纯的图像获取环境,通过害虫自动监测诱捕装置在野外直接获取虫体图像;同时,将其他能引起伪角点的部位与虫体进行有效分割提取,减少对前翅特征点的准确定位的影响,无需人工标记特征点的辅助作用,直接提取虫体的三维姿态参数,加快其实用化的步伐。

基于三维姿态的蛾类虫体自动识别过程中,可以直接利用虫体三维姿态信息即虫体两前翅间夹角,作为识别参数直接输入识别系统,结合图像形态学技术和专家系统技术,通过对蛾类图像的采集、图像数字转化以及姿态信息的提取,并结合虫体其他特征参数,从而完成对虫体的形态特征参数提取,进而智能识别虫体种类,同时自动计数虫体数量,最终构成一个完备的蛾类虫体自动识别系统。这样可以有效避免在对蛾类虫体整姿、取翅等行为过程中引起的识别准确率下降的问题,为今后农林害虫自动识别与计数技术的发展奠定基础。

4 结论以鳞翅目夜蛾科棉铃虫成虫为代表,提出了基于机器视觉的标记特征点虫体前翅间夹角角度的获取方法,可以精确、简便地对蛾类虫体前翅间角度进行提取。将激光测量结果与本方法得到的结果进行比较,相对误差0.10%~3.96%,平均相对误差1.02%,在所允许的误差范围之内(100%±5%)。本文的角度计算方法与激光测量计算方法进行配对T检验,P=0.277 > 0.05,2种方法无显著差异,利用本方法计算得到的结果均方根误差为1.421 6,体现了该方法的可行性。本文方法在计算效率上也有较大提升,完成一只蛾类虫体的前翅间角度计算平均仅用时14.6 s,小于激光测量所需的1 min。

包全磊. 2010. 基于HSV空间的彩色图像分割[J]. 软件导刊, 9(7): 171-172. (Bao Q L. 2010. Color image segmentation based on HSV[J]. Software Guide, 9(7): 171-172. [in Chinese]) |

陈娟, 陈乾辉. 2008. 空间目标三维姿态估计方法综述[J]. 长春工业大学学报:自然科学版, 29(3): 323-327. (Chen J, Chen Q H. 2008. Summary of the 3D pose estimations for the space targets[J]. Journal of Changchun University of Techology:Natural Science Edition, 29(3): 323-327. [in Chinese]) |

郭秀明, 赵春江, 杨信廷, 等. 2012. 苹果园中2[J]. 4GHz无线信道在不同高度的传播特性.农业工程学报, 28(12): 195-200. (Guo X M, Zhao C J, Yang X T, et al. 2012. Propagation characteristics of 2[J]. 4 GHz wireless channel at different heights in apple orchard. Transactions of the Chinese Society of Agricultural Engineering, 28(12): 195-200. [in Chinese]) |

李文勇, 陈梅香, 李明, 等. 2014. 基于姿态描述的果园靶标害虫自动识别方法[J]. 农业机械学报, 45(11): 54-57. (Li W Y, Chen M X, Li M, et al. 2014. Orchard pest automated identification method bases on posture description[J]. Transaction of the Chinese Society for Agricultural Machinery, 45(11): 54-59. DOI:10.6041/j.issn.1000-1298.2014.11.009 [in Chinese]) |

李文勇, 李明, 陈梅香, 等. 2014. 基于机器视觉的作物多姿态害虫特征提取与分类方法[J]. 农业工程学报, 30(14): 154-162. (Li W Y, Li M, Chen M X, et al. 2014. Feature extraction and classification method of multi-pose pests using machine vision[J]. Transactions of the Chinese Society of Agricultural Engineering, 30(14): 154-162. DOI:10.3969/j.issn.1002-6819.2014.14.020 [in Chinese]) |

林开颜, 吴军辉, 徐立鸿. 2005. 彩色图像分割方法综述[J]. 中国图象图形学报, 10(1): 1-10. (Lin K Y, Wu J H, Xu L H. 2005. A survey on color image segmentation techniques[J]. Journal of Image and Graphics, 10(1): 1-10. [in Chinese]) |

吕军, 姚青, 刘庆杰, 等. 2012. 基于模板匹配的多目标水稻灯诱害虫识别方法的研究[J]. 中国水稻科学, 16(5): 619-623. (Lü J, Yao Q, Liu Q J, et al. 2012. Identification of multi-objective rice light-trap pests based on template matching[J]. Chinese Journal of Rice Science, 16(5): 619-623. [in Chinese]) |

吕丹, 孙剑锋, 李琦, 等. 2015. 基于激光雷达距离像的目标3D姿态估计[J]. 红外与激光工程, 44(4): 1115-1120. (Lü D, Sun J F, Li Q, et al. 2015. 3D pose estimation of target based on ladar range image[J]. Infrared and Laser Engineering, 44(4): 1115-1120. [in Chinese]) |

邱道尹, 张红涛, 刘新宇, 等. 2007. 基于机器视觉的大田害虫检测系统[J]. 农业机械学报, 38(1): 120-122. (Qiu D Y, Zhang H T, Liu X Y, et al. 2007. Design of detection system for agriculture field pests based on machine vision[J]. Transaction of the Chinese Society for Agricultural Machinery, 38(1): 120-122. [in Chinese]) |

阮秋琦. 2001. 数字图像处理学[M]. 北京: 电子工业出版. (Ruan Q Q. 2001. Digital Image Processing[M]. Beijing: Electronic Industry Pres. [in Chinese]) |

SonkaM, HlavacV, BoyleR. 2016. 图像处理、分析与机器视觉.4版.兴军亮, 艾海舟[M]. 北京: 清华大学出版社. (Sonka M, Hlavac V, Boyle R. 2016. Image Processing, Analysis, and Machine Vision.4th ed.Xing J L, Ai H Z[M]. Beijing: Tsinghua University Press. [in Chinese]) |

苏步青. 1991. 高等几何学五讲[M]. 上海: 上海教育出版社: 15-32. (Su B Q. 1991. Five Lessons of Higher Geometry[M]. Shanghai: Shanghai Educational Publishing House: 15-32. [in Chinese]) |

唐向阳, 张勇, 李江有, 等. 2004. 机器视觉关键技术的现状及应用展望[J]. 昆明理工大学学报:自然科学版, 29(2): 36-39. (Tang X Y, Zhang Y, Li J Y, et al. 2004. Present situation and application of machine vision's key techniques[J]. Journal of Kunming University of Science and Technology:Science and Technology, 29(2): 36-39. [in Chinese]) |

向海涛, 郑加强, 周宏平. 2004. 基于机器视觉的树木图像实时采集与识别系统[J]. 林业科学, 40(3): 144-148. (Xiang H T, Zheng J Q, Zhou H P, et al. 2004. Real-time tree image acquisition and recognition system based on machine vision[J]. Scientia Silvae Sinicae, 40(3): 144-148. DOI:10.11707/j.1001-7488.20040325 [in Chinese]) |

胥磊. 2016. 机器视觉技术的发展现状与展望[J]. 设备管理与维修, (9): 7-9. (Xu L. 2016. The present situation and prospect of machine vision technology[J]. Equipment Management and Maintenance, (9): 7-9. [in Chinese]) |

杨红珍, 蔡小娜, 李湘涛, 等. 2013. 几何形态计量学在昆虫自动鉴定中的应用与展望[J]. 四川动物, 32(3): 464-469. (Yang H Z, Cai X N, Li X T, et al. 2013. Application of geometric morphometrics in insect identification[J]. Sichuan Journal of Zoology, 32(3): 464-469. [in Chinese]) |

姚青, 吕军, 杨保军, 等. 2011. 基于图像的昆虫自动识别与计数研究进展[J]. 中国农业科学, 44(14): 2886-2899. (Yao Q, Lü J, Yang B J, et al. 2011. Progress in research on digital image processing technology for automatic insect identification and counting[J]. Scientia Agricultura Sinica, 44(14): 2886-2899. DOI:10.3864/j.issn.0578-1752.2011.14.005 [in Chinese]) |

于新文, 沈佐锐, 高灵旺, 等. 2003. 昆虫图像几何形状特征的提取技术研究[J]. 中国农业大学学报, 8(3): 47-50. (Yu X W, Shen Z R, Gao L W, et al. 2003. Feature measuring and extraction for digital image of insects[J]. Journal of China Agricultural University, 8(3): 47-50. [in Chinese]) |

张国雄. 2000. 三坐标测量机的发展趋势[J]. 中国机械工程, 11(2): 222-226. (Zhang G X. 2000. The development trend of three coordinate measuring machine[J]. China Mechanical Engineering, 11(2): 222-226. [in Chinese]) |

张志刚, 周明全, 耿国华. 2007. 基于单幅图像的人脸三维姿态估计[J]. 计算机应用, 27(5): 1138-1140. (Zhang Z G, Zhou M Q, Geng G H. 2007. 3D pose estim ation based on single face in age[J]. Computer Applications, 27(5): 1138-1140. [in Chinese]) |

朱莉, 罗靖, 徐胜勇, 等. 2016. 基于颜色特征的油菜害虫机器视觉诊断研究[J]. 农机化研究, 38(6): 55-58. (Zhu L, Luo J, Xu S Y, et al. 2016. Machine vision recognition of rapeseed pests based on color feature[J]. Journal of Agricultural Mechanization Research, 38(6): 55-58. [in Chinese]) |

Ashaghathra S M A, Weckler P, Solie J, et al. 2007. Identifying Pecan Weevils through image processing techniques based on template matching[J]. American Society of Agricultural and Biological Engineering, Annual meeting, Mineapolis, Minnesota, June: 17-20, 2007. |

Bournachev M N, Filatov Y V, Kirianov K E, et al. 1998. Precision angle measurement in a diffractional spectrometer by means of a ring laser[J]. Measurement Science & Technology, 9(7): 1067-1071. |

Fan K C, Liao B H, Cheng F. 2013. Ultra-precision angle measurement based on Michelson interferometry[J]. Journal of the Chinese Society of Mechanical Engineers, Transactions of the Chinese Institute of Engineers-Series C, 34(1): 39-44. |

Filatov Y V, Loukianov D P, Probst R. 1997. Dynamic angle measurement by means of a ring laser[J]. Metrologia, 34(4): 343-351. DOI:10.1088/0026-1394/34/4/7 |

Machtovoi I A. 1993. High-precision real-time measurement of large angular displacements of structures[J]. Soviet Journal of Optical Technology, 60(1): 73-74. |

Masajada J. 2004. Small-angle rotations measurement using optical vortex interferometer[J]. Optics Communications, 239(4-6): 373-381. DOI:10.1016/j.optcom.2004.05.051 |

Nguyen C, Lovell D, Oberprieler R, et al. 2013. Virtual 3D Models of Insects for Accelerated Quarantine Control[J]. The IEEE International Conference on Computer Vision (ICCV) Workshops: 161-167. |

Nguyen C V, Lovell D R, Adcock M, et al. 2014. Capturing natural-colour 3D models of insects for species discovery and diagnostics[J]. Plos One, 9(4): e94346-e94346. DOI:10.1371/journal.pone.0094346 |

Stephens M. 1988. A combined comer and edge detector[J]. Proceedings of 4th Alvey Vision Conference, Manchester, UK: 189-192. |

Torroba R, Tagliaferri A A. 1998. Precision small angle measurements with a digital moiré technique[J]. Optics Communications, 149(4-6): 213-216. DOI:10.1016/S0030-4018(98)00021-2 |

Wen C, Guyer D. 2012. Image-based orchard insect automated identification and classification method[J]. Computers and Electronics in Agriculture, 89(1): 110-115. |

2017, Vol. 53

2017, Vol. 53