刘成林,中国科学院自动化研究所研究员,模式识别国家重点实验室主任,中国人工智能学会常务理事

刘成林:从模式识别到类脑研究

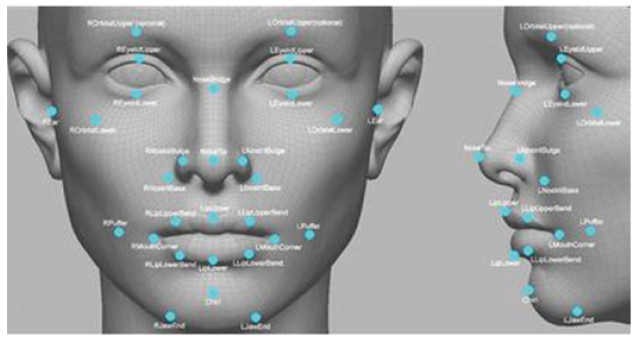

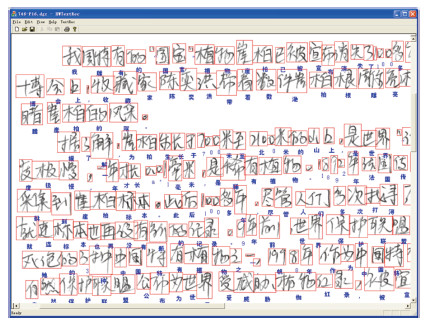

近年来,人工智能发展迅速,但要警惕“人工智能热”,以冷静的头脑看待科学发展的问题。——刘成林 “人工智能”(artificial intelligence)概念最早由JohnMcCarthy等在1956年的达特矛斯会议(DartmouthConference)上提出:人工智能就是通过计算机编程使机器实现类人智能行为。在60年的发展中,人工智能取得了巨大进步,现如今,人工智能技术应用在现实生活中的方方面面。在过去20多年中,互联网搜索、视频监控、交通调度、语音识别、人脸识别、人机交互、机器翻译等技术应用的背后都有人工智能做支撑。虽然大数据的出现和计算能力的提高不断推动着人工智能向前发展,但面对时下盛行的“人工智能热”,保持头脑的冷静非常必要,因为人工智能虽然发展迅速,但还有巨大的进步空间,还有很多挑战性问题有待解决。 《科技导报》邀请中国科学院自动化研究所研究员、模式识别国家重点实验室主任刘成林对人工智能领域的模式识别和类脑智能研究进行全方位解读。 模式识别:“慧眼”看世界随着20世纪40年代计算机出现,50年代人工智能兴起,(计算机)模式识别在20世纪60年代初迅速发展并成为一门新学科。模式识别是指对表征物体或现象的各种形式数据(主要是感知数据,如图像、视频、语音等)进行处理和分析,以对物体或现象进行描述、分类和解释的过程,是信息科学和人工智能的重要组成部分。“随着计算机硬件的发展,模式识别的关注度不断提高,模式识别技术发展也日臻完善,在许多领域中已有成功应用。”多年来一直从事模式识别研究的刘成林介绍称,金融、安全、医学、航空、互联网、工业产品检测等领域中都渗透着模式识别技术。 刘成林指出,模式识别有2个层面的含义:一是生物体(主要是人脑)感知环境的模式识别能力与机理,属于心理学和认知科学范畴;二是面向智能模拟和应用,研究计算机实现模式识别的理论和方法,属于信息科学和计算机科学领域的范畴。模式识别基础理论(模式表示与分类、机器学习等)、视觉信息处理(图像处理和计算机视觉)、语音语言信息处理(语音识别、自然语言处理、机器翻译等)是模式识别领域的三大主要研究方向。刘成林解释,模式识别是人工智能的一个分支领域。人工智能是通过计算使机器模拟人的智能行为,主要包括感知、思维(推理、决策)、动作、学习,而模式识别主要研究的就是感知行为。在人的5大感知行为(视觉、听觉、嗅觉、味觉、触觉)中,视觉、听觉和触觉是人工智能领域研究较多的方向。模式识别领域主要研究的是视觉和听觉,而触觉主要是跟机器人结合。文字识别、互联网有害信息检测、语音识别、生物特征识别(虹膜识别、指纹识别、掌纹识别、人脸识别等)都是目前发展较为成熟的模式识别技术。

模式识别和人工智能在20世纪60年代分离为不同的领域,21世纪以来出现重新融合的迹象。近年来,深度学习和大数据的出现推动了模式识别的快速发展,但刘成林认为这一领域还有巨大进步空间,一方面基础理论研究进展不大,另一方面有很多挑战性应用问题有待解决。谈及模式识别的未来,他表示,目前以深度学习为代表的主流方法有3个明显的不足:一是需要大量的标记样本进行监督学习,这势必增加模式识别系统开发中的人工成本;二是模式识别系统的自适应能力差,不像人的知识和识别能力是随着环境不断进化的;三是模式识别一般只进行分类,没有对模式对象的结构解释。

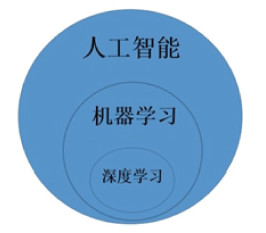

机器学习是人工智能的一个重要方面,简单来讲,它是使机器通过从数据学习获得模型和知识(也就是获得智能)的过程。深度学习(deep learning)是机器学习的一个新的分支和一类重要方法,其主要思想是对多层人工神经网络进行学习获得自动特征提取和模式识别能力。在刘成林看来,深度学习快速发展和广泛应用主要得益于3方面的基础:一是深度学习理论和算法的提出,二是计算能力(主要是GPU并行计算)快速提高,三是大数据的出现。

2006年,神经网络领域泰斗级人物Geoffrey Hinton在《Science》上发文首次提出深度学习的概念,掀起了一股新的研究浪潮。“简单说来,深度学习就是深度神经网络的学习。”刘成林说,在近几年的发展过程中,深度学习在图像识别和语音识别领域取得了巨大的成功。通过类脑神经系统结构的神经网络,深度学习可以解决许多实际问题。深度学习发展的10年时间中,随着Google、Facebook、Amazon、微软、百度等的加入更是加速了深度学习的发展,目前深度学习已经广泛应用到网络搜索、图像识别、语音识别、文字识别、无人驾驶等领域并且带给人类前所未有的体验。深度学习在许多领域带来机器智能水平的突破性提高,让人觉得机器智能通过图灵测试不是那么可望而不可及了。 2016年3月与围棋九段李世乭进行对战的谷歌围棋软件AlphaGo就是应用了深度学习的技术;在计算机视觉领域里面,最前沿的是对视频内容的理解(人物、目标、行为的分析和理解),刘成林说,这里面也用到了深度学习的方法;语音和语言信息处理领域目前性能最好的方法也是利用了深度学习。

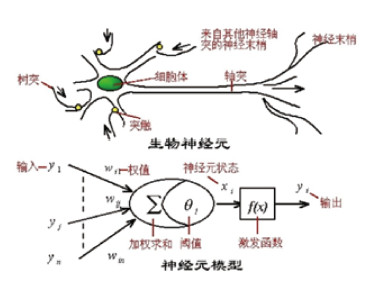

近年来,随着计算机科学、神经科学和神经网络理论的发展,面对大数据时代对智能计算的需求,以及传统人工智能速度学习方法的不足,科学家开始将研究重点投向类脑智能,即脑启发的智能(brain-inspired intelligence)。刘成林说,从目前研究情况来看,人类对大脑神经结构和功能的研究有了很大的进步,同时认知科学领域对人的智能行为(包括学习、记忆、注意、推理、决策等)机理有深入研究。这使得从大脑神经系统结构和认知行为机理获得启发,研制具有更强信息表示、处理和学习能力的智能计算模型与算法成为可能。类脑智能就是以计算建模为手段,受脑神经机理和认知行为机理启发,并通过软硬件协同实现的机器智能。类脑智能系统在信息处理机制上类脑,认知行为和智能水平上类人,其目标是使机器以类脑的方式实现各种人类具有的认知能力及其协同机制,最终达到或超越人类智能水平。 用人工神经网络模拟大脑的智能计算功能,早在20世纪40年代就开始了研究。刘成林说,人工神经网络可以算是类脑计算的一个模型,它是对大脑神经系统的一种粗糙的模拟,建立的分层神经网络系统与实际大脑的结构有一定差距,但是这种粗糙的模拟在人工智能领域已经发挥了巨大的作用。现在建立的神经网络系统层数比较多,算法与过去相比也复杂很多。20世纪80年代,随着多层神经网络训练的误差反向传播算法(BP算法)得到推广,人工神经网络已经是模式识别和人工智能领域应用较为广泛的方法,其研究和应用形成了一个热潮。在20世纪90年代,随着泛化能力更强的支撑向量机出现,神经网络再次走向低潮。2006年,凭借深度学习的提出和广泛应用,人工神经网络再次跻身人工智能领域最前沿之列。 从大方向讲,类脑智能研究主要有硬件和软件2个方面。”刘成林说,软件研究又有2个角度,一是使智能计算模型在结构上更加类脑,另外一方面是在认知和学习行为上更加类人。2个角度的研究都会产生有益的模型和方法。比如,模拟人的少样本和自适应学习,可以使智能系统具有更强的小样本泛化能力和自适应性。

硬件方面的研究主要是研发类脑新型计算芯片,如神经网络计算芯片,目标是相比当前的CPU和GPU计算架构,提高计算效率和降低能耗。目前人工神经网络主要在通用计算机上编程来实现,能耗比较高。例如一台计算机的功率大概是200~300 W,一台GPU服务器的能耗至少是2000 W,而人脑的功耗只有20 W。所以刘成林说,计算机实现大规模人工神经网络的能耗非常高,因此研发新型的神经网络计算芯片,降低能耗,具有重要的现实意义。 提到未来的类脑智能研究,刘成林认为应该在结构类脑和行为类人方面更加深入。目前不管是神经结构模拟还是学习行为模拟都是比较粗浅的。以学习为例,当前主流的监督学习是比较“粗暴”的学习方式,即一次性给予大量的类别标记数据对人工神经网络进行训练,而要收集大量标记数据是要付出很大代价的。人脑的学习具有很强的灵活性,从小样本开始,不断地随环境自适应。这种学习灵活性应该是未来机器学习的一个主要研究目标。 谈及目前中国即将上马的“中国脑计划”(“脑科学与类脑研究”),刘成林透露,中国脑计划的基本框架是一体两翼:一体是脑认知功能研究,从脑科学和神经科学角度研究脑神经结构和认识功能;两翼是脑科学应用研究,一是脑疾病的诊断、预测、治疗,另一方面是类脑智能研究。刘成林还展望,将来类脑智能和当前主流的基于传统计算的人工智能方法将并行发展,相互取长补短。另外,从应用的角度,人与机器协同工作,人的智能与机器智能互补也是一个必然趋势。 文/祝叶华(《科技导报》编辑部) |