2. 中国科学院沈阳自动化研究所机器人学国家重点实验室, 辽宁 沈阳 110016

2. The State Key Laboratory of Robotics, Shenyang Institute of Automation, Chinese Academy of Sciences, Shenyang 110016, China

脊柱手术广泛应用于脊柱疾病的治疗中,脊柱外科手术对手术的精确性、安全性要求更高,一旦操作失误将导致如椎动脉、神经根、脊髓神经和内脏等人体重要组织结构的灾难性损伤[1]。目前,脊柱手术主要依赖术中X射线对人体病灶部位进行穿透,X射线穿透不具有连续性,因此医生无法在术中连续地对手术器械的入路规划进行调整。此外,需要医生不断地参照术中X射线透视影像来预估手术器械的位置,在手术期间可能需要进行多次穿插,给患者带来二次伤害,同时在术中也对医生和患者造成了多次辐射、消耗医生体力和增加手术的风险。

随着计算机辅助技术的发展,手术导航技术被广泛应用于外科脊柱手术当中。脊柱微创手术作为目前临床手术应用中的最新研究进展,其主要优势在于:术中可以尽可能地减小手术创口,最大程度地减轻患者的病痛以及对肌体的损伤,从而降低术后创口感染的概率。目前,微创脊柱外科技术主要用于神经减压、脊柱稳定与融合、脊柱畸形矫正等方面,已经基本能够完成脊柱外科方面的所有手术[2]。

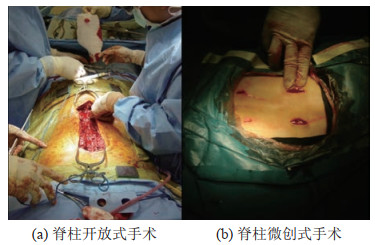

目前,手术治疗脊柱疾病的方案分为开放式手术和微创式手术。开放式手术创口面积较大,患者术后一般至少需要卧床休息2个月,在术后一些中老年患者耐受性不佳,需对伤口进行护理以减小并发症出现的概率。相比之下,微创式手术具有创口面积较小、术后恢复较快、术后并发症发生概率较低等优点。开放式脊柱手术和微创式脊柱手术对比如图 1所示。

|

图 1 开放式手术和微创式手术对比 Fig.1 Open surgery vs minimally invasive surgery |

传统的医疗影像技术主要包括:计算机断层扫描(CT)、超声波(US)[3]和磁共振成像(MRI)[4]等。它们都是医学领域中最基本的信息来源和诊断依据,但是这些医疗影像技术都受到了传统2D图像的限制,使得医生只能通过2维图像信息和手术经验来推断具体的病灶位置进而进行手术操作,增加了手术的不安全性,不利于医生的术中操作。随着新兴技术的崛起,增强现实(AR)、人工智能(AI)、计算机视觉(CV)和图像处理等学科的发展,对手术导航系统提出了更高的安全性和精度要求,手术导航系统也在随着新兴技术的发展而不断迭代更新。其中增强现实是基于虚拟现实的新型影像技术,它通过计算机视觉、空间识别等技术将现实世界和虚拟世界进行了联通,实现了虚拟影像与现实物体的“共存”、虚拟影像和现实物体的精准匹配以及虚拟影像和现实物体的动态交互等。但是,该技术目前还不能实现对触觉的模拟和增强。

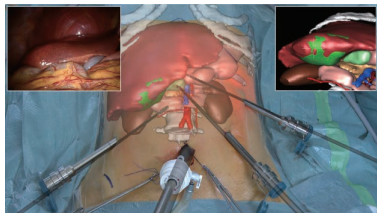

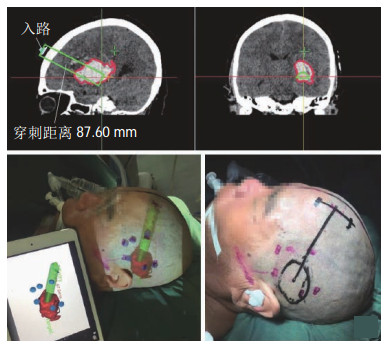

2015年,Pessaux等[5]基于手术导航系统完成人体肝部肿瘤切除,通过远程人工配准的方式实现了对患者病灶的3维重建,将病灶模型投射到患者体表,手术场景如图 2所示。该系统的不足之处就是远程操控只能通过若干个显示屏观察手术场景,使得术中的视野受限并且采用人工配准方式容易造成误差,影响术中的精准度。Shekhar等[6]提出了一种连续低辐射剂量的CT补偿方法,在术中结合CT图像实时对影像配准结果进行修正,提高手术导航精度。2019年,崔冬强等[7]采用增强现实技术辅助神经内镜手术,通过3D-Slicer图像重建软件定位血肿并建模,再导入智能手机或平板电脑,通过KiwiViewer三维图像浏览软件在患者体表投影,于头皮标记血肿范围和穿刺路径,具有手术通道小、可清晰定位残留血肿部位、明确穿刺道出血、在人为创造的空间内可靠止血等优点,从而减少手术损伤、缩短手术时间、提高血肿清除率、降低术后再出血发生率,如图 3所示。

|

图 2 基于增强现实导航的术中效果图[5] Fig.2 Intraoperative renderings based on augmented\\ reality navigation |

|

图 3 基于增强现实的血肿体表投影[7] Fig.3 An augmented reality based projection of the hematoma on the surface |

基于增强现实的手术导航系统可以为未来的临床手术发展提供更多的技术支持,为解决术前规划、术中导航和术后教学提供了更多的新手段和新方法。

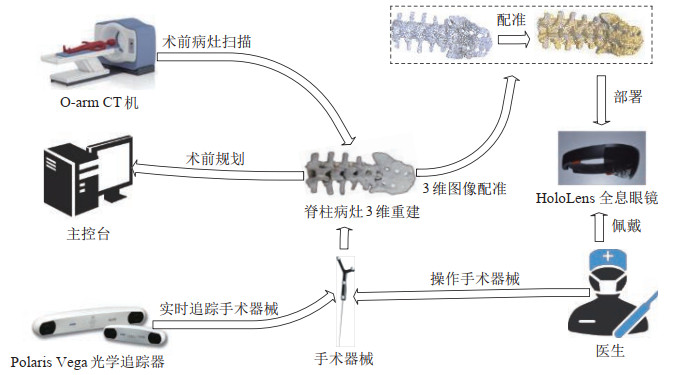

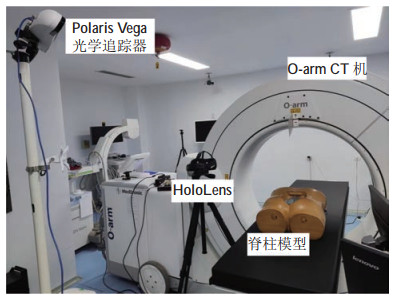

2 系统总述(Overview of the system)设计并实现了一种基于增强现实技术的脊柱微创手术导航系统,该系统主要包括O-arm CT机、Polaris Vega光学追踪器、HoloLens全息眼镜、手术器械和标定球等。术前采用CT机对患者脊柱病灶部位进行3维扫描,获得患者病灶的3维数据集;以Polaris Vega光学追踪器作为术中全局的监测点和数据输入来源之一,负责对术中Polaris Vega光学追踪器视野范围内的标定球和手术器械进行识别和实时追踪,底层通过TCP协议将坐标信息传输到主控台中,由主控台完成坐标系变换等计算任务;采用手眼标定实现手术器械和HoloLens全息眼镜在Polaris Vega光学追踪器坐标系下的配准和标定;HoloLens设备负责对患者的病灶模型进行3维渲染,为医生提供术中入路规划和手术器械的导航。

脊柱微创手术导航系统突破了2维图像的视野限制,利用全息影像引导医生实现术前规划和术中导航,从眼的维度扩展了医生的视野。脊柱微创手术导航系统的结构如图 4所示。

|

图 4 手术导航系统结构图 Fig.4 Structural diagram of the surgical navigation system |

系统的执行主要分为2个阶段。

1) 术前准备

在术前,首先第1步使用O-arm CT机对患者脊柱病灶部位进行3维扫描生成CT图像。由于CT图像为逐层扫描的2维图像,因此需要对其进行3维重建处理。在每张CT图像上设置灰度闸值,将超过闸值的像素视为骨组织点,然后对骨组织点云集进行三角化生成3维模型。

第2步,将重建好的3维模型导入Unity-3D平台,为模型选定可视化方案并进行分割。根据患者病灶模型的实际尺寸选择合适的模型体积。目前,手术导航应用场景主要有2种导航显示方案,不同的显示方案下会采用不同的模型体积。一种是同步显示:将患者真实的病灶与模型病灶进行同步叠加显示。因为需要病灶全息影像与真实病灶重合叠加,因此在同步显示方案中一般采用的是等比例建模。然而,Marcus等[8]的研究结果表明:增强现实模型叠加在术区对手术视野有遮挡作用,会影响手术操作及降低手术安全性。因此,有时也会根据不同的需求调整为异步显示。异步显示方案将患者真实的病灶与模型病灶进行非重叠式显示。一般情况下也采用等比例建模;在一些特殊的手术场景中有时候需要将某处病灶模型结构进行放大。例如在穿刺类手术中需要将穿刺部位放大,以便医生获得更多的细节信息。在可视化方案选定结束后,利用PointNet

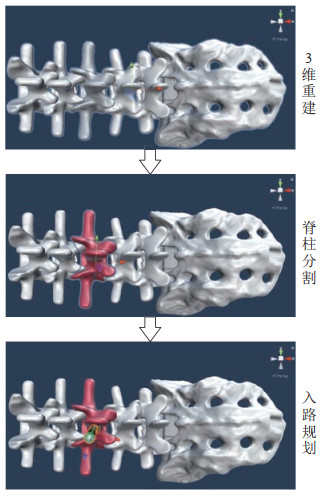

第3步,医生根据手术方案规划入路,设置入路标志物来引导手术,辅助术中导航,见图 5。

|

图 5 3维重建和术前规划 Fig.5 3-dimensional reconstruction and preoperative planning |

第4步,对所使用的手术器械进行标定,采用Polaris Vega光学追踪器实时追踪手术器械。通过Polaris Vega光学追踪器收集标定球信息,基于TCP通信协议实现端到端可靠的数据传输,将Polaris Vega光学追踪器采集到的标定球数据发送到主控机中的Qt Creator进程中。由Qt Creator提取标定球的距离特征完成手术器械的识别,并将识别到的手术器械相对于Polaris Vega光学追踪器的位置姿态信息发送到HoloLens设备中,从而实现手术器械实时跟踪和患者病灶医疗影像实时显示。

2) 术中导航

第5步,在术中医生通过佩戴HoloLens全息眼镜,可以透过患者的人体组织器官清晰地看到患者体内脊柱病灶模型的3维解剖结构,从而实现一种直观的术中“透视”导航效果,以便于医生在术中更加精准地进行操作。

3 场景踪追(Scene tracking) 3.1 系统硬件平台为了实现在术中对手术器械的实时跟踪,系统采用Polaris Vega光学追踪器对手术器械进行实时定位追踪。Polaris Vega光学追踪器采用被动追踪方式,因此手术器械在Polaris Vega光学追踪器的视野范围内可以任意移动,但要求在手术器械的移动过程中标定球始终面向Polaris Vega光学追踪器且不能有遮挡。

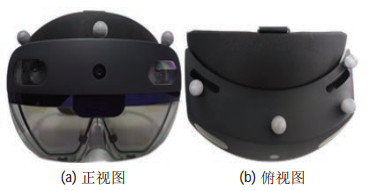

采用头戴式的HoloLens作为术中的可视化终端设备。HoloLens全息眼镜是微软推出的一款可穿戴式的独立PC设备,搭载了Windows10操作系统,内置高端CPU、GPU、全息处理芯片、4个环境感知摄像头、1个深度摄像头、1个惯性测量单元。系统硬件平台如图 6所示。

|

图 6 系统硬件平台 Fig.6 System hardware platform |

首先在粘贴标定球之前需要在待标定物体上进行选点,根据Polaris Vega光学追踪器的识别特性,需要满足以下的选点特性:

1) 一个标定件工具至少需要3个标定球去确定待标定物体;

2) 在选点时,标定点两两之间的间距应至少大于50 mm(也可以存在间距小于50 mm的情况,间距大于50 mm时标定误差最小);

3) 标定件至少包括3个共面的标定球;

4) 标定球面无污垢等遮挡或划痕。

3.2.2 制作标定工具件因为HoloLens设备和Polaris Vega光学追踪器之间没有直接的坐标联系,为了建立HoloLens与Polaris Vega光学追踪器之间的关联关系,需自制在Polaris Vega坐标系下可识别的标定件,并用胶水将标定球和HoloLens设备进行粘贴固定,因此它们两者之间的转换矩阵

|

图 7 标定球与HoloLens设备的粘贴效果图 Fig.7 Paste renderings of the calibration ball and HoloLens device |

在完成以上标定点预处理之后,需对附着在HoloLens设备上的标定球进行数据采集,本文采用NDI 6D Architect 3.0软件采集标定球的位置数据。

步骤 1:将待标定的HoloLens放入Polaris Vega光学追踪器的视野范围内,开启Polaris Vega光学追踪器对标定球进行识别和采样。当Polaris Vega光学追踪器识别到4个标定点的位置后,拍摄一次位置快照(用以保存一个初值,作为后期标定的参照值,并在标定过程中根据初值进行拟合迭代)。

步骤 2:获取到标定初值之后,开始采集300帧的位置信息并保存。

步骤 3:为了保证采集标定点数据的准确性,在每次采集过程中都需要不断改变HoloLens设备的位置和姿态,让Polaris Vega光学追踪器从不同角度采集标定球的静态位置信息。为了保证HoloLens的标定精度,需至少重复10次以上步骤2。

将采集到的坐标点信息整理后进行计算,得出各标定球间的距离,由标记算法求出标定点集合所表示的物体和位姿信息。计算结果如表 1所示。

|

|

表 1 标定球球心之间的距离 Tab. 1 Distances between the calibration ball centers |

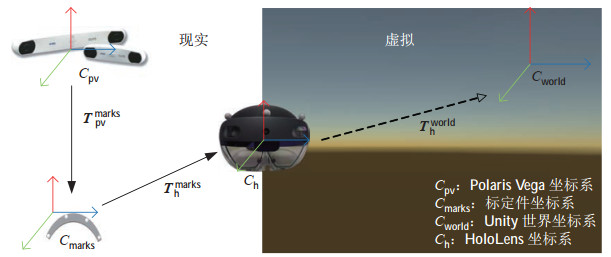

借鉴传统的机器人手眼标定方法的思路来建立HoloLens设备与Polaris Vega光学追踪器之间的坐标转换关系。相对于传统手眼标定方法:存在相机畸变问题,使得标定精度无法保证;本文采用的标定方法使用Polaris Vega光学追踪器替换了相机,省去了相机内参标定步骤,并且该系统识别精度可达亚毫米级别,避免了相机畸变问题所导致的标定误差;在整个系统中为了方便坐标转换,采用Polaris Vega光学追踪器坐标系作为整个手术场景的世界坐标系。在建立坐标系过程中通过标定球将手术场景中的设备或仪器与Polaris Vega光学追踪器进行关联。例如通过固定在HoloLens上的标定球可以间接得到HoloLens世界坐标系与Polaris Vega光学追踪器坐标系之间的转换关系。

如图 8所示,在该场景下存在2个变量

|

图 8 坐标系转换关系图 Fig.8 Coordinate system conversion diagram |

基于HoloLens设备和Polaris Vega光学追踪器的空间定位方法,其特征在于:在HoloLens上粘贴标定件,该标定件包括至少3个共面标定球。方法包括以下步骤:

步骤 1:以任意一个标定球为坐标原点,建立工具坐标系

步骤 2:求解从HoloLens标定球到Polaris Vega光学追踪器的变换矩阵

步骤 3:利用TCP通信读取HoloLens设备在世界坐标系下的旋转矩阵

步骤 4:记录不同姿态标定球的坐标,采用手眼标定法求解从

使用机器人手眼标定公式

| $ {\boldsymbol{T}}_{\text{world}}^{\rm pv} ={\boldsymbol{T}}_{\text{marks}}^{\rm pv} \times {\boldsymbol{T}}_{\rm h}^{\text{marks}} \times {\boldsymbol{T}}_{\text{world}}^{\rm h} $ | (1) |

要将其变形为

| $ {\boldsymbol{T}}_{\text{world}}^{\rm pv} ={\boldsymbol{T}}_{\text{marks}_{1}}^{\rm pv} \times {\boldsymbol{T}}_{\rm h}^{\text{marks}} \times {\boldsymbol{T}}_{\text{world}_{1}}^{\rm h} $ | (2) |

| $ {\boldsymbol{T}}_{\text{world}}^{\rm pv} ={\boldsymbol{T}}_{\text{marks}_{2}}^{\rm pv} \times {\boldsymbol{T}}_{\rm h}^{\text{marks}} \times {\boldsymbol{T}}_{\text{world}_{2}}^{\rm h} $ | (3) |

将两式联立可得:

| $ ({{\boldsymbol{T}}_{\text{marks}_{2}}^{\rm pv}})^{-1}\times {\boldsymbol{T}}_{\text{marks}_{1}}^{\rm pv} \times {\boldsymbol{T}}_{\rm h}^{\text{marks}} \notag \\ = {\boldsymbol{T}}_{\rm h}^{\text{marks}} \times {\boldsymbol{T}}_{\text{world}_{2}}^{\rm h} \times ({{\boldsymbol{T}}_{\text{world}_{1}}^{\rm h}})^{-1} $ | (4) |

该等式满足

| $ \min \sum\limits_{i=1}^n d( {\boldsymbol{A}}_{i} {\boldsymbol{X}}, {\boldsymbol{XB}}_{i}) $ | (5) |

根据上述方法,可以求解出空间中的任意点相对于HoloLens设备的位置关系,从而将虚拟病灶模型显示在手术靶位区域中的任意位置。

3.4 结果分析HoloLens设备的标定精度受到了自身SLAM导航的影响,其对周围环境的感知主要依赖于硬件和软件算法的补偿。受硬件和算法特性的影响,HoloLens在外界环境中开展SLAM时,在某些场景下不可避免地会出现误差。其误差源主要有:1) 刷新率。HoloLens的刷新频率为60 Hz,要求全息影像的生成频率与HoloLens的刷新频率同步,否则相同的全息影像会多次显示使得纠正量变多,导致不必要的跳动,从而影响数据采集的准确性。2) 场景复杂度。环境色彩过于单调,会影响HoloLens进行特征匹配;场景过于复杂,会增大SLAM难度,容易出现定位误差。3) 场景物体冗余度。场景内存在多个重复或者相似的物体,同样也会影响HoloLens对周围环境的感知。4) 光照因素。场景内部的环境光过强或过暗都会干扰HoloLens深度摄像头的识别;同样一些反光的物体也会造成SLAM算法出现幻像。5) 标定时,需改变HoloLens的位姿,这样会引起设备抖动,此外改变HoloLens位姿后会有短暂曝光不足,导致SLAM算法出错。随着采样数量越来越多,HoloLens位姿变换引起的误差也在不断积累。6) 设备硬件自身无法避免的误差。

在测试时,先将HoloLens用三脚架固定摆放,采集若干组数据将其均值作为真值代入计算,此处HoloLens的标定误差主要是由HoloLens自身视觉SLAM与惯性导航结合所产生的。标定的过程中发现标定环境越复杂,视觉SLAM的精度越高,越不容易发生定位丢失的情况。反之,容易发生自身定位漂移的问题。此外,产生误差的主要原因是在视觉SLAM定位过程中需要一定的参照物,环境越复杂,越容易形成特征参照物,有助于HoloLens计算当前位置[9];同样,环境过于复杂也不利于HoloLens的自身定位。

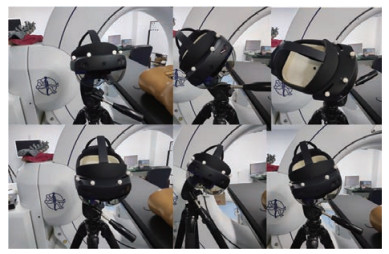

在Polaris Vega光学追踪器下采集若干组HoloLens相对于世界坐标系的坐标信息和标定球坐标信息,每次采集都需要变换HoloLens的位姿,以确保求得的误差和转换矩阵更加接近真值且具有鲁棒性。HoloLens定位数据的采集如图 9所示。

|

图 9 HoloLens定位数据采集 Fig.9 Acquisition of HoloLens localization data |

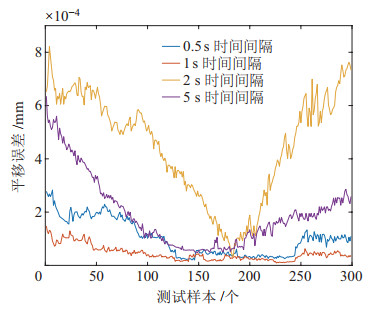

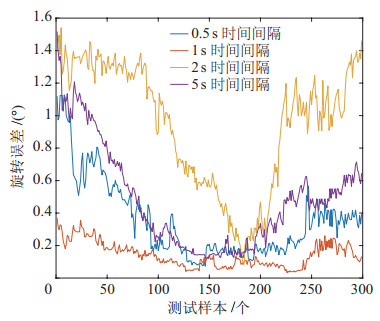

在标定过程中分别记录了HoloLens在0.5 s、1 s、2 s、5 s时间间隔下的定位精度,如图 10、图 11所示。HoloLens自身的定位精度为毫秒级,平均标定旋转误差为0.9463

|

图 10 HoloLens在不同时间间隔下的平移误差结果分析 Fig.10 Analysis on the translation error results of HoloLens device at different time intervals |

|

图 11 HoloLens在不同时间间隔下的旋转误差结果分析 Fig.11 Analysis on the rotation error results of HoloLens device at different time intervals |

通过采集标定球的位置数据,可以计算追踪误差,结果如表 2所示。实验结果表明,追踪的平均平移误差为2.8 mm,平均旋转误差为0.6222

|

|

表 2 追踪误差 Tab. 2 Tracking error |

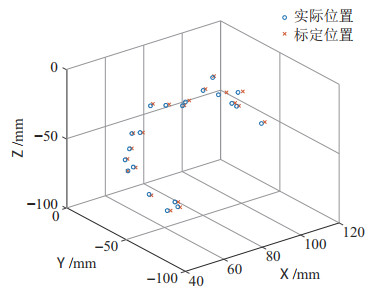

对HoloLens标定后的定位精度进行了分析,如图 12所示。其中,蓝色

|

图 12 HoloLens标定误差结果分析 Fig.12 Analysis on the HoloLens calibration error results |

图像配准的目的是将手术靶位与脊柱病灶模型进行配准。术中图像配准是手术导航系统的关键步骤,需要实时对模型的空间位置数据进行采集,根据采集结果对模型位置进行空间变换,使其与真实模型同步或异步地显示。

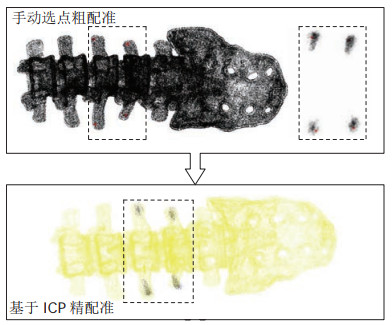

此外,手术系统对术中精度要求极高,需要通过在术前、术中进行图像配准实现虚拟模型和真实病灶部位的同步显示。为防止基于ICP的点云配准结果陷入局部最优解,采用粗配准与精配准结合的方式[10]。首先手动选点粗略计算一次旋转矩阵

在Polaris Vega光学追踪器的视野范围内利用手术器械尖端在脊柱病灶模型表面进行贴合式刮取,同时记录和保存刮取过程中的针尖坐标信息。之后,分别在完整的脊柱点云图和刮取点云图中选取4个配准参照点进行配准。基于ICP算法的点云配准结果如图 13所示。

|

图 13 基于ICP点云的配准结果 Fig.13 Registration results based on ICP point cloud |

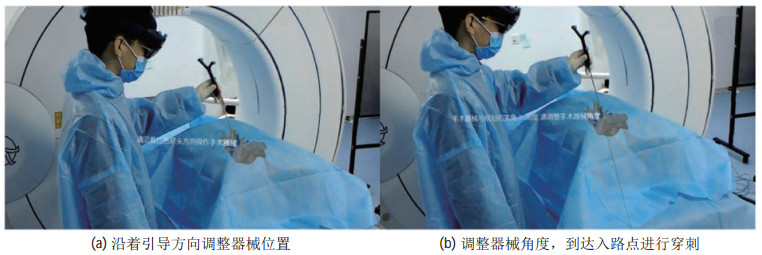

图 14是操作者佩戴HoloLens设备的显示效果图。图 14(a)为操作者沿着引导方向调整器械位置;图 14(b)为操作者调整器械角度,使其到达入路点进行穿刺。当手术器械到达穿刺点附近时,设备上会显示一条虚拟的延长线。在操作过程中HoloLens会提示操作者当前夹角的具体偏差,操作者根据提示进行角度调整,当夹角处于应允误差范围内时,可以由操作者进行穿刺。

|

图 14 术中导航效果图 Fig.14 Intraoperative navigation renderings |

实现了一种基于增强现实技术的脊柱微创手术导航系统。采用头戴式的HoloLens作为术中影像渲染设备,在术前通过粗配准与精配准的结合实现了多模态医疗影像的融合与配准。在脊柱微创手术导航系统的引导下,外科医生可以准确定位到脊柱病灶具体的位姿、偏移量等信息,进而辅助医生进行手术入路操作,加速手术整体进程,降低手术风险。

| [1] |

殷鹏, 齐金蕾, 刘韫宁, 等. 2005~2017年中国疾病负担研究报告[J]. 中国循环杂志, 2019, 34(12): 1145-1154. Yin P, Qi J L, Liu Y N, et al. Burden of disease in the Chinese population from 2005 to 2017[J]. Chinese Circulation Journal, 2019, 34(12): 1145-1154. DOI:10.3969/j.issn.1000-3614.2019.12.001 |

| [2] |

周跃. 微创脊柱外科手术的发展与展望[J]. 中华医学信息导报, 2013, 28(22): 11. Zhou Y. Development and prospect of minimally invasive spine surgical operation[J]. China Medical News, 2013, 28(22): 11. |

| [3] |

Jeyabalan A, Medford A R L. Endobronchial ultrasound-guided transbronchial needle aspiration: Patient satisfaction under light conscious sedation[J]. Respiration, 2014, 88(3): 244-250. DOI:10.1159/000363063 |

| [4] |

Desselle M R, Brown R A, James A R, et al. Augmented and virtual reality in surgery[J]. Computing in Science & Engineering, 2020, 22(3): 18-26. |

| [5] |

Pessaux P, Diana M, Soler L, et al. Towards cybernetic surgery: Robotic and augmented reality-assisted liver segmentectomy[J]. Langenbeck's Archives of Surgery, 2015, 400: 381-385. DOI:10.1007/s00423-014-1256-9 |

| [6] |

Shekhar R, Dandekar O, Bhat V, et al. Live augmented reality: A new visualization method for laparoscopic surgery using continuous volumetric computed tomography[J]. Surgical Endoscopy, 2010, 24(8): 1976-1985. DOI:10.1007/s00464-010-0890-8 |

| [7] |

崔冬强, 冯铭, 束旭俊, 等. 增强现实技术辅助神经内镜与小骨窗开颅血肿清除术治疗高血压脑出血疗效分析[J]. 中国现代神经疾病杂志, 2019, 19(9): 654-660. Cui D Q, Feng M, Shu X J, et al. Comparision of curative effect of augmented reality assisted neuroendosope and small bone window craniotomy for hypertensive cerebral hemorrhage[J]. Chinese Journal of Contemporary Neurology and Neurosurgery, 2019, 19(9): 654-660. |

| [8] |

Marcus H J, Pratt P, Hughes-Hallett A, et al. Comparative effectiveness and safety of image guidance systems in surgery: A preclinical randomised study[J]. Lancet, 2015, 385(S1): S64. |

| [9] |

Rieder J S I, von Tol D H, Aschenbrenner D. Effective closerange accuracy comparison of Microsoft HoloLens Generation one and two using Vuforia ImageTargets[C]//IEEE Conference on Virtual Reality and 3D User Interfaces Abstracts and Workshops. Piscataway, USA: IEEE, 2021: 552-553.

|

| [10] |

张英豪, 李维全, 陈家禾, 等. 机器人辅助微创全膝关节置换手术系统[J]. 机器人, 2021, 43(4): 386-394. Zhang Y H, Li W Q, Chen J H, et al. Robot-assisted minimally invasive total knee arthroplasty system[J]. Robot, 2021, 43(4): 386-394. |

2023, Vol. 45

2023, Vol. 45