2. 农业农村部设施农业装备与信息化重点实验室, 浙江 杭州 310058

2. Key Laboratory of Equipment and Informatization in Environment Controlled Agriculture, Ministry of Agriculture, Hangzhou 310058, China

全球粮食需求正在快速增长,人类急需增加粮食供应,而过度开垦扩充耕地面积会导致环境的恶化并破坏生物的多样性[1],因此人们将目光投向了海洋生物资源与淡水渔业资源的开发。我国海域总面积约4.7

但渔业在高速发展的同时也面临着来自资源与环境生态的压力[2]。为了突破资源、环境与劳动力等因素的制约,需要运用现代高新技术来推动产业的转型升级。传统依靠人力的粗放式生产方式已经不符合渔业现代化发展的要求,现代渔业是多学科交叉应用、融合发展的技术系统。我国农业农村部在2020年11月印发的《关于加快水产养殖机械化发展的意见》[3]中明确提出要指导各地着力补齐水产养殖机械化中的短板,到2025年水产养殖机械化水平总体要达到50%以上,显著提高重点生产环节的信息化水平。日本农林水产省则将水产业机器人技术研究开发事业列为其重点科技计划项目[4]。为了加快渔业的现代化进程,渔业智能装备的科技创新得到了大力的推进,发展渔业水下机器人的时机已经成熟。

当前计算机技术、微电子机械系统技术、自动控制技术、人工智能技术的进步使机器人在各行业中的应用逐渐增多,其中以工业领域为代表的应用更是日臻完善。在除工业机器人之外的特种机器人中,服务型机器人、军用机器人、医疗机器人等也实现了较快发展,而农业机器人的起步则相对较晚[5]。另外,因受渔业生产模式、智能装备应用成本、装备作业环境适应性等因素制约[6],我国自主研发的用于渔业实际生产的水下机器人鲜有报道。

水下机器人涉及到机构学、水动力学、控制科学、传感器技术、通信技术与人工智能等多门学科技术,在渔业实际应用方面又有具体的技术要求。本文首先对国内外应用于渔业的水下机器人的研究历程、应用现状作系统归纳,对水下机器人在辅助渔业生产中的环境智能监控、水下渔情视察、水生动物视觉识别与捕获、生长环境清洁等环节进行阐述。然后从机器人结构组成与外形优化、水生动物视觉识别、水下运动、环境信息感知4个方面论述渔业水下机器人的关键技术。最后分析水下机器人在渔业中应用时所面临的挑战,并提出未来研究的趋势,为未来开发更多适用、专用于渔业的水下机器人的研究提供参考,从而为未来海洋牧场、智慧渔业的建设发展赋能。

2 水下机器人在渔业中的应用现状(Appli- cations status of underwater robots in fishery)目前,对于不同的渔业模式和生产特性,国内外研究人员设计了不同的水下机器人来辅助渔业生产,根据作用不同主要可分为渔业环境监测与水生动物行为监视机器人、水生动物识别与捕获机器人、水生动物生存环境维护机器人3种。以下对3种水下机器人在海洋渔业与淡水渔业中的应用现状按作业类型展开论述。

2.1 渔业环境监测与水生动物行为监视渔业养殖水体的温度、浊度、溶氧量(DO)、pH值、非离子氨(NH

自主式水下机器人(AUV)的体积、最小转弯半径一般较大,多用于深远海渔业环境,国内外均有研究者使用AUV对深远海的水生动物及其生存环境进行研究。有研究者使用美国Hydroid公司与伍兹霍尔海洋研究所(WHOI)研发的REMUS-100远程环境监测AUV[8](图 1)配合电子标签对棱皮龟、姥鲨进行跟踪监视[9-10],并根据REMUS-100的传感器与视频流数据获得了水生动物的行为及其栖息地信息,但该AUV的有效载荷(传感器组件质量)较小。Eichhorn等[11]使用德国弗劳恩霍夫(Fraunhofer)应用研究促进协会开发的CWolf型AUV搭载模块化水质传感器组件(图 2)对挪威东部渔场附近海域的水质参数进行了实时监测,CWolf的有效载荷达到15 kg,但其本体质量为135 kg,实际使用时至少需要3人协作布放。

|

图 1 REMUS-100自主式水下机器人 Fig.1 The REMUS-100 AUV |

|

图 2 CWolf自主式水下机器人及传感器组件 Fig.2 The CWolf AUV and its sensors suit |

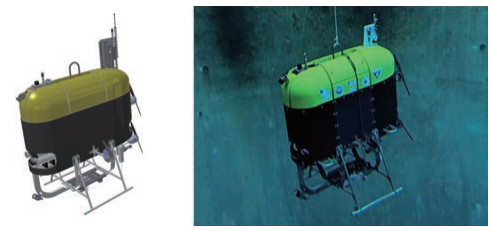

多数AUV在进行渔业环境监测时,因配备有螺旋桨推进器、舵翼或电子标签等,会对环境及水生动物产生较大干扰[12]。WHOI的Yoerger等[13]研制的名为Mesobot的水下机器人(图 3)配备了大直径、慢转速的螺旋桨,可以将其对水体的扰动降到最低,它同时配备的海洋探测传感器组件可以对海洋“暮光带”中层水域(深度介于200~1000 m之间)进行环境监测,Mesobot机器人还能对移动缓慢的水生动物进行跟踪监视(图 4)。另外,东京大学Maki等[14]开发了使用多波束成像声呐对水生动物进行跟踪的AUV,免除了电子标签对水生动物的影响。

|

图 3 Mesobot的3维模型及在水下状态 Fig.3 3D model of Mesobot and its underwater state |

|

图 4 Mesobot跟踪水生动物示意图 Fig.4 Diagram of Mesobot tracking aquatic animals |

|

图 5 麻省理工学院研制的AMOUR V Fig.5 AMOUR V developed by MIT |

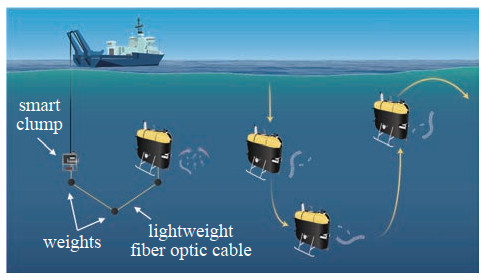

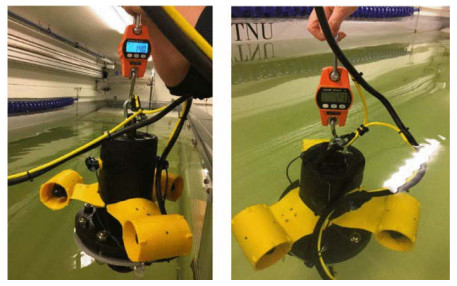

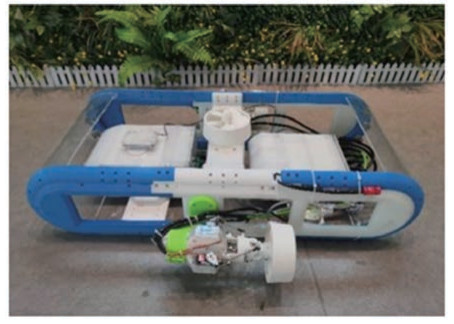

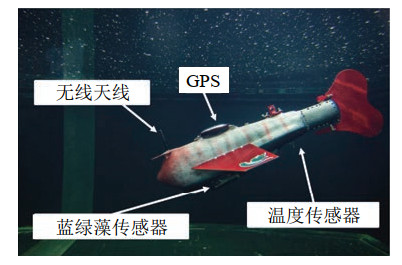

遥控式水下机器人(ROV)适用于近浅海渔业环境和结构化、工业化的淡水渔业环境[15]。麻省理工学院(MIT)计算机与人工智能实验室Vasilescu等[16]研制了用于近浅海、淡水渔业环境的圆柱形ROV——AMOUR V(图 5),AMOUR V通过调节浮力与总重力间的平衡来实现悬停,其有效载荷变化范围为0~1 kg。针对近浅海网箱养殖水体大、养殖密度高(往往超过20万尾)的问题,挪威科技大学(NTNU)的Osen等[17]制作了低成本的ROV(图 6),使用3个小型螺旋桨推进器实现了横移(sway)、进退(surge)与偏航(yaw)3自由度(DOF)的运动,对近浅海渔业的水下环境实现了多因子的感知。Huang等[18]研制了适用于4~5 m水深环境的ROV(图 7),该ROV专用于淡水渔业环境监测。

|

图 6 挪威科技大学的水下机器人 Fig.6 An underwater robot from NTNU |

|

图 7 西北农林科技大学渔业环境监测ROV Fig.7 fishery environment monitoring ROV from Northwest A & F University |

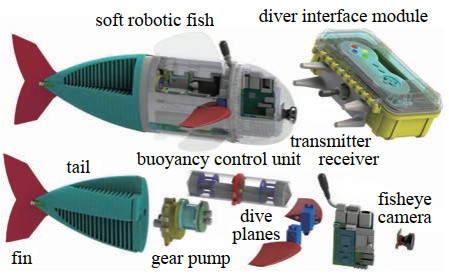

考虑到AUV与ROV会惊吓水生动物的问题,有研究者开发了具有仿生外形或基于仿生运动机理的水下环境调查与水生动物监视专用机器人。图 8为中国科学院自动化研究所(CASIA)研制的服务于水生态环境建设的仿豹鲂鮄BUV(biomimetic underwater vehicle),该机器人可定点悬停并对多点水质参数进行监测[19]。图 9为麦吉尔大学设计的名为AQUA的第一代两栖环境监测BUV,通过6片扁平脚蹼扑动实现水下浮游[20]。图 10为麻省理工学院设计的基于声学通信模块控制的软体机器鱼SoFi,SoFi头部安装有鱼眼摄像机,可对水深处于0~18 m范围内的鱼类进行观察而不造成惊扰,SoFi已对太平洋珊瑚礁附近的鱼类进行了实地跟踪监视[21]。多数BUV体积较小,较AUV、ROV更容易融入生物环境,能更好地适应渔业生产环境。

|

图 8 中国科学院自动化研究所研制的仿生水下机器人RobDact Fig.8 BUV RobDact developed by the CASIA |

|

图 9 AQUA两栖监测机器人 Fig.9 An amphibious environmental monitoring robot AQUA |

|

图 10 oFi软体机器鱼的3维模型 Fig.10 The 3D model of the SoFi soft robotic fish |

表 1归纳了当下国内外具有代表性的用于环境监测的水下机器人。

|

|

表 1 国内外具代表性的环境监测水下机器人(“—”表示未见报道) Tab. 1 Representative underwater robots for environmental monitoring at home and abroad ("—" means not been described) |

除了直接对水质参数进行监测和对水生动物进行监视之外,还有研究者开发了一类对特定水质参数敏感的机器人,此类机器人通过模仿水生动物对于某一异常的环境因子做出的应激反应来间接地反映水质的恶化。佛罗伦萨大学的Ravalli和马德里理工大学的Rossi等[22]联合研制了一种专用于水产养殖场所的、对于氢离子(H

|

图 11 氢离子(H+)敏感水下机器人 Fig.11 An underwater robot sensitive to hydrion (H+) |

总体而言,使用各种水下机器人搭载各类水质、图像传感器对环境与水生动物进行观测是水下机器人在渔业中应用的研究热点,相关样机较多。但目前能实际应用的具有较高智能程度的水下机器人仍然较少,很难兼顾水下环境精确传感的高技术性与规模化应用的经济性,这是制约环境监测型水下机器人普及应用的重要原因。

2.2 水生动物视觉识别与捕获在传统的渔业生产中,常用人工潜水捡拾的方式采捕鲍鱼、海参与海胆等海珍品,为了防止渔业资源枯竭,常需要对已捕获的水生动物的尺寸进行人工测量,以便进行尺寸分级与筛选放生。国内外均有研究者尝试利用水下机器人配合视觉系统、机械手来替代人工完成对水生动物的识别与捕获。

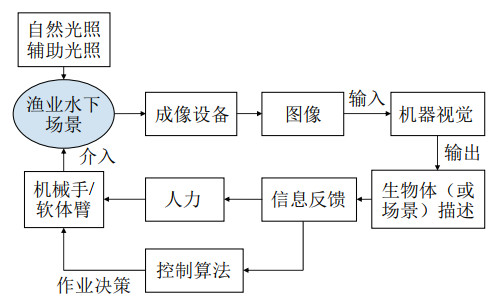

2.2.1 水下视觉系统在捕获中的应用现状水下视觉系统通过图像识别、模式分类、语义分割和场景分析,提取图像信息或描述性信息反馈给人、机,通过人类脑力或控制算法完成对机械手或软体臂的驱动控制,使之介入渔业场景,包括捕获水生动物(图 12)。

|

图 12 水下视觉系统辅助捕获 Fig.12 Underwater vision system aided capture |

按照对机器人的控制方式划分,用于对水生动物识别与捕获的水下视觉系统的发展主要经历了3个阶段:(1) 基于静态图像实现开环控制捕获的视觉反馈系统;(2) 基于视觉信息连续反馈的视觉伺服控制系统;(3) 基于自学习的具有自主检测、跟踪、捕获能力的智能视觉控制系统。

第1阶段的水下视觉系统通过水下摄像机获得水生动物的尺寸与位置信息后反馈给控制系统,以开环控制的方式驱动机械手或通过人工操纵机械手的方式来捕获目标。日本岩手大学的Takagi等[24]设计了计算鲍鱼尺寸的水下机器人,将尺寸数据反馈给渔民进行捕、放决策;九州工业大学的Ahn等[25]通过水下机器人获取水生动物的位置信息,并反馈给操作者遥控机械手以对目标进行抓取。基于此种视觉系统的水下机器人的捕获自动化程度较低[26],捕获过程中需要人力介入,无法自主捕获移动目标。

第2阶段的水下视觉系统可实时、连续地将各种图像处理算法获得的水生动物种类、尺寸与位置等信息反馈给控制系统,工作前需对视觉系统的参数进行标定,工作中通过视觉伺服的方式,结合系统动力学模型的逆运动学求解方法来驱动机械手捕获目标。此阶段的视觉伺服系统主要是手眼系统(hand-eye system),当摄像机随机械手移动时被称为“eye-in-hand”式手眼系统,北京航空航天大学Gong等[27]研制的用于近浅海渔业环境的海参捕获机器人即基于“eye-in-hand”式手眼系统。当摄像机固定于机器人本体时为“eye-to-hand”式手眼系统,如哈尔滨工程大学周浩等[28]研制的用于近海水产养殖的海生物吸纳式捕获ROV,可对水下目标进行主动吸取。基于此种视觉系统的水下机器人多是对已知存在的目标进行识别检测并捕获,在实际应用中仍需要通过对目标进行搜索与跟踪才有可能趋近完全自动化的机器捕获。

将视觉系统与深度强化学习、逆向强化学习等自主学习方法结合是机器人学习的热门学术研究方向。第3阶段的水下视觉系统具有自学习能力,可在机器人运动过程中获得周围水下环境、目标状态信息来辅助控制系统对机器人进行实时控制,是未来智能化捕获发展的方向。目前达到水下视觉系统的第3阶段的水下捕获机器人仍鲜有报道。

大宗水产品或大范围内的水产品捕获,多以拖网方式进行。水下视觉系统在拖网捕获中亦有辅助应用,已有研究者利用水下机器视觉技术针对鱿鱼的喷射游离行为改进拖网设计[29]。

当前,将水下视觉系统应用于渔业场景时的主要应用层面仍是将其作为拓展人类目力能及范围的手段。多数的基于人工智能视觉系统的水下机器人仍处于在机器人操作系统(ROS)等机器人二次开发平台上模拟的阶段,实际应用中需要在环境、硬件条件和系统稳定性之间作出权衡。

2.2.2 水生动物捕获机器人应用现状现代机电系统捕获作业的对象主要是鱼类与底栖型海珍品。对鱼类的捕获主要使用拖网方式,现有的水下捕获机器人捕获对象以具有高附加值的海珍品与科考探索生物为主。

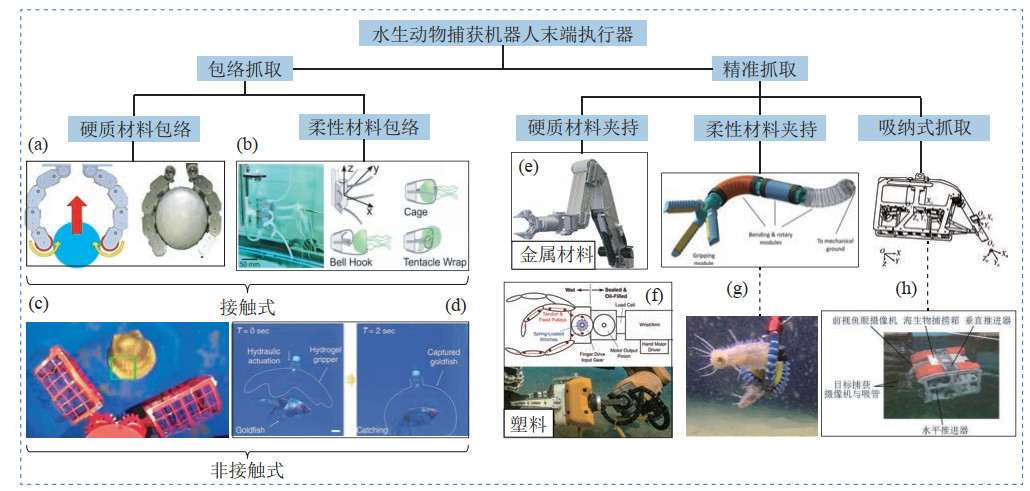

按照水下机器人末端执行器捕获水生动物的动作形式来划分,可以将捕获形式分为包络抓取与精准抓握[30]。结合末端执行器动力来源及材料的不同,目前在渔业场景中已经有探索性应用的捕获方式包括:(1) 使用开式链[31](图 13(a))、可变形连续体[32](图 13(b))、网笼状[33](图 13(c))和容器状结构[34](图 13(d))实现对水生动物的接触式或非接触式包络围拢;(2) 使用电动机驱动金属材料[26](图 13(e))或塑料[35](图 13(f))等抗压强度较高的硬质材料对水生动物进行夹持抓握;(3) 通过液压、气压驱动柔性材料实现对水生动物的包络、夹持[36-37](图 13(g));(4) 通过液压泵、气压泵[38]制造压力差,实现对水生动物的吸纳[28](图 13(h))。

|

图 13 水生动物捕获机器人应用现状 Fig.13 Application status of aquatic animals capturing robots |

多数用于捕获水生动物的水下机器人采用以齿轮、铰链、连杆、钳和镊等刚性结构为基础的机械手对目标进行抓取,近年来研究者研制了捕获水生动物的柔性抓手,采用柔性材料来降低或去除抓取过程对水生动物造成的伤害。文[27]报道了一种用于近浅海渔业环境的柔性抓手,将该抓手安装于ROV上可实现对海珍品的较高效、无损的精准抓取。但柔性抓手的抓取动作的重复定位精度与控制的稳健性会降低,与水下机器人本体间的耦合关系在水下环境中变得异常复杂,难以根据目标位置进行运动学反解[39],而且柔性抓手抓取的灵活性往往以牺牲载荷能力为代价[40]。如何提高柔性抓手的可靠性与载荷能力是未来实现对易损目标抓取的研究热点之一。

除了研制柔性抓手之外,有研究者在刚性机械手的抓取执行器中加入力觉/力矩传感器、滑觉传感器等触觉反馈传感器或电流/电压反馈单元[41],以防过大的抓取力对动物目标造成伤害。开发具有主动顺应性(抓取力控制)和被动顺应性的低惯性、自适应机械手是满足水生动物无损抓取需求的重要方法。

相较于工业机器人,渔业场景下机器人的作业对象最大的特点是其会对周围刺激做出反应游离动作,故目前多数水下捕获机器人只适用于捕获移动较为缓慢的底栖型水产品动物,且主要聚焦于具有高附加值的海珍品或水生动物科学探索。

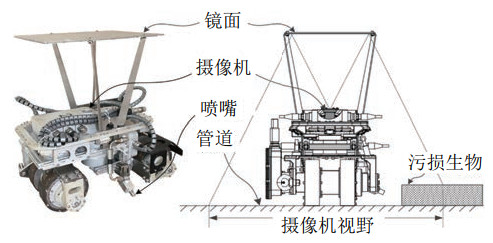

2.3 水生动物生存环境维护近年来海洋网箱养殖发展迅速,截至2019年,我国海洋网箱已达1.94万只。但网箱网衣因具有多孔、表面积大的特点而特别适合藻类、藤壶等污损生物的附着[42],若不及时清除将会影响水体交换,导致渔业资源品质下降。而在工业化循环水养殖中,鱼池底部存在残饵与鱼类固体排泄物等沉积物,溶于水中会导致养殖水体中的氨氮含量增加而使养殖环境恶化,因此需要及时去除。对水生动物的生存环境进行定期维护是提高水产品质量的重要措施。此外,网衣巡检、补漏、提升等也是水生动物生存环境维护的重要内容。

相比于渔业环境监测机器人、水生动物行为监视机器人以及识别与捕获机器人,用于水生动物生存环境维护的水下机器人的研究较少。有研究者针对目前仍无高度自主化的渔业环境清洁水下机器人的问题,编写了相关水下机器人的设计准则与技术要求[43],指出用于网箱网衣清洗的水下机器人应为轮式、履带式机器人,在清洗方式上应采用高压水射流进行冲洗。一种典型的利用高压水射流清理污损生物的水下轮式机器人[44]见图 14。

|

图 14 水下喷洗机器人 Fig.14 Underwater spray-washing robot |

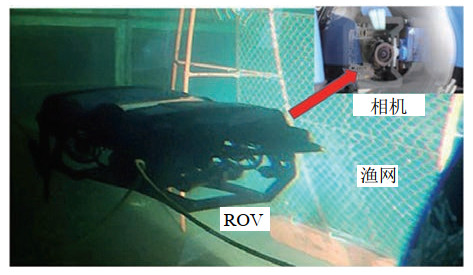

在海洋渔业中,网衣巡检是一项重要的工作,网衣破损不仅会造成经济的损失,甚至会带来生物入侵的严重后果。针对网箱网衣清洗的水下机器人,总体上仍处在对清洗射流与机器人本体的水动力学模型进行理论设计的阶段。国内有研究者对清洗网衣射流的喷嘴关键参数进行理论分析,为水下机器人利用高压旋转水射流清洗网衣提供了理论基础[45]。为使机器人在水下清洗作业中能实现平稳运动,国内有研究者提出利用三角履带轮及射流反冲装置实现机器人网箱贴附行走的方法[46],有研究者对使用螺旋桨与喷射水流的水下机器人进行水动力学平衡分析[47],还有研究者提出计算水动力系数的方法,为建立完整的复杂水下清洗机器人的水动力学模型提供了更快捷准确的方法[48]。所述研究为水下机器人在水下清洗作业中应用提供了设计理论基础。

目前已有可实际使用的网衣污损检测水下机器人,可对网衣破洞及污染情况进行巡检,为后续网衣维护补漏提供参考[49](图 15)。已商品化的较为成熟的水下机器人有日本洋马(Yanmar)公司开发的遥控式网衣清洁机器人,该机器人可对海洋网箱养殖中的网衣进行遍历清刷。

|

图 15 网衣巡检ROV Fig.15 Net inspecting ROV |

对于工业化循环水养殖环境维护,在清理方式上多采用清洁毛刷进行接触式清刷,同时用水泵吸除废水,相关机器人多处于实验室研制阶段。Koyama等[50]针对陆基水产养殖水箱底部沉积物的清除开发了一种轻质无缆束缚的自主式水下机器人,该机器人前端配备吸污螺旋桨,将沉积物吸入集污箱中,移动路径通过预编程设定。胡勇兵等[51]设计了一种鱼池清刷机器人,通过内螺旋路径规划使清洗面积平均覆盖率达85%以上。Mahmud等[52]基于路线图算法设计了水箱清洁机器人,有效提高了水箱底部清洁的效率与自主化程度。而关于自然湖泊的渔业环境维护,我国首个渔业水下清污机器人已于2019年在新疆天蕴三文鱼养殖基地投入使用。

除了对水生动物的外部生存环境进行维护外,还需对水生动物自身进行护理,利用水下机器人对水生动物进行产中护理是渔业发展的重要内容。挪威Stingray Marine Solutions公司研制了利用激光束杀死附着于鲑鱼身上的海虱等体外寄生虫的水下机器人,该机器人通过图像识别扫描附近鲑鱼,当发现附着于鲑鱼体表的海虱时便发出激光束将其杀死,在北欧渔业中获得了良好应用[53]。

2.4 存在问题综合对3种渔业水下机器人应用现状的分析,目前渔业水下机器人在发展中还存在以下问题:(1) 对动物生长环境的侵入性过大。在机动灵活性、低噪声、低流体扰动与动物低惊扰方面仍存在不足,与渔业场景较难相容;(2) 在弱可视条件下难以获取水下环境中的视觉信息。机器视觉的应用多需要较为理想的条件,通常要求视觉系统部署在具有清澈水体、恒定光源与简洁背景的环境中,或要求水下机器人具有较好的硬件资源,而这些条件在自然渔业环境中往往难以满足;(3) 机动控制困难。受水流与非结构化复杂环境影响,水下机器人难以保持平稳运动,难以运动至目标区域展开作业;(4) 传感器难以精准获取渔业生产、机器人位姿信息。在多因素干扰下,机载内、外部传感器没有达到渔业实际生产的智能需求。

3 关键技术(Key technologies)根据对水下机器人的典型样机、作业类型与应用现状的分析,渔业水下机器人的研究涉及到机构学、控制理论、仿生学、图像处理、传感器与通信原理等多领域的技术。综合已述及的水下机器人,其共同的主要关键技术包含:结构的设计与优化技术、水下机器视觉与图像增强技术、水下定位与运动规划技术和水下信息获取与传输技术。

3.1 水下结构设计与生物环境融入优化结构是水下机器人的硬件底层,是执行机构、传感器等的载体。对水下机器人的外形与系统结构进行分析,并从机动性和水动力性能上进行优化,是设计符合渔业场景下工作要求的水下机器人的关键。

3.1.1 水下系统结构组成典型的应用于渔业的水下机器人有外形呈鱼雷状的AUV[54](图 16(a))、开放式框架结构的ROV[55](图 16(b))、兼具AUV与ROV特征的混合式水下机器人[13](ARV,图 16(c))、配备机械手的水下机器人-机械手系统[41](UVMS,图 16(d))、具有自然生物外形的BUV[19](图 16(e))及非移动式水下机器人[56](图 16(f))6种,各类型水下机器人适用的渔业作业场景见表 2。

|

图 16 渔业水下机器人结构划分 Fig.16 Structure division of underwater robots in fishery |

|

|

表 2 各类型水下机器人的特点及其适用的渔业作业场景 Tab. 2 Characteristics of underwater robots and their applications in the fishery scenarios |

从系统整体上剖析,为适应渔业作业场景,水下机器人的典型系统结构见图 17,其包含水上、水下两部分,即上位系统与下位系统(下位系统为水下机器人本体),其中下位系统中包括:(1) 外部环境感知与通信模块;(2) 执行机构控制与电源管理模块;(3) 内部位姿状态感知模块。对渔业外部环境进行感知的单元包含各类水质传感器、图像传感器、声呐、辅助照明灯具等,执行器有由舵机、直流电机等驱动的螺旋桨推进器、履带行进机构、机械手等,内部位姿状态感知传感器有包含加速度计、电子罗盘和陀螺仪等在内的惯性测量单元(IMU),主、协控制器有各类嵌入式单片机、微控制器、微型电脑主板与专业的工业控制计算机,各硬件单元间通过各种串口协议实现通信。

|

图 17 渔业水下机器人典型系统结构 Fig.17 A typical system structure of underwater robots used in fishery |

研究者应采用可重构、模块化设计准则,如将机械手安装于传统意义上的ROV[27]或BUV[59],AUV可由复合电缆施加一定的控制,ROV也应具有一定的自主能力。AUV的自主观测能力与ROV的作业能力具有很强的互补性[60],将AUV与ROV结合可实现多种模式间的切换[13],如此可实现各种水下机器人间的作业内容互补,提高水下机器人子部件间的互换性和通用性,拓展渔业作业的类型,提高渔业专用程度。

3.1.2 水下驱动机构设计与水动力性能优化为将水下机器人用于渔业场景,传统的使用直流电动机驱动螺旋桨推进器、舵翼等刚性机构以实现水下运动的方式需要改进[61]。水下机器人有广阔的运动空间,为高效地、灵活地运动至目标区域并进行观测、作业,水下机器人的机动性应尽可能提高。提高水下机器人机动性主要从两个方面着手,一是设计驱动机构以增加运动自由度和优化驱动力性能,二是提高水动力性能以减小水动阻力和降低对生物环境的侵扰。

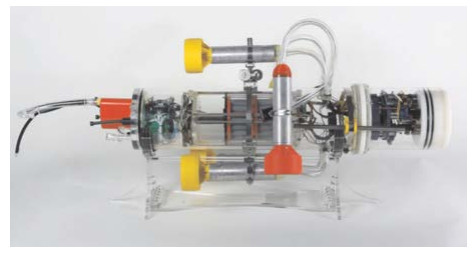

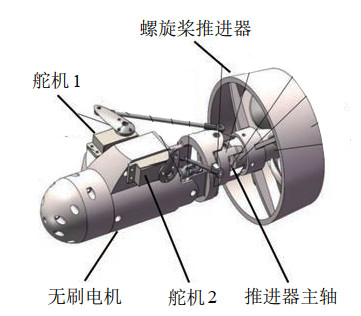

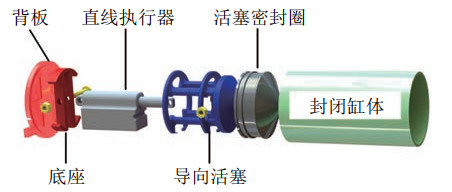

为增加水下运动的自由度,文[18]中使用2个舵机改变推进器主轴方向,设计了简易的矢量推进机构(图 18),增加了机器人的俯仰与偏航2个自由度。为使水下机器人能定点悬停并测量某处水质,需要对潜浮(heave)运动加以控制,部分样机采用浮力控制单元(BCU)实现深度控制,多数BCU通过活塞改变浮筒、缸体的空气体积来调节浮力,文[21]使用的BCU见图 19。以BCU取代传统的推进器,不仅降低了深度控制的难度,同时还能去除螺旋桨尾流对生物环境的侵扰,进而优化了动力性能。

|

图 18 矢量推进机构 Fig.18 propulsion mechanism |

|

图 19 SoFi的浮力控制单元 Fig.19 The BCU of SoFi |

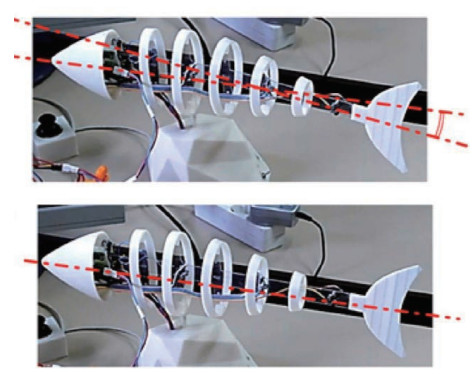

除了单纯从传统机械原理角度进行驱动机构设计外,近年研究热点主要集中在基于仿生学设计的推进驱动机构,通过模仿水生动物的器官、形态构造或运动模式来提高水下机器人的机动性。Zhang等[62]制作了滑翔式仿生水下机器人(图 20),能对多点水质参数进行取样测量。文[19]中的仿生水下机器人创造性地结合了鱼类的身体/尾鳍推进(BCF)和中央鳍/对鳍推进(MPF)2种推进模式,因此该机器人兼有2种推进模式的优点,即在大范围水体中可快速游动,而在低速游动时又具有良好的稳定性。仿生水下机器人对驱动机构的运动控制一般通过使用中枢模式发生器(CPG)自动产生稳定的生物节律信号作为运动控制器[63]。这些驱动机构基于仿生运动机理而设计,多是使用原动机带动搭建在刚性机架基础上的连杆机构、齿轮齿条等来实现驱动,对水生动物生存环境的侵入性较普通驱动机构低。

|

图 20 滑翔式仿生水下机器人 Fig.20 The gliding BUV |

使用基于运动机理仿生的机器人开展渔业任务有利于降低乃至从根源上消除噪声、机械振动与水激波对水生动物造成的压力,基于新型智能柔性材料驱动器的水下机器人是未来重要研究课题[64-65]。

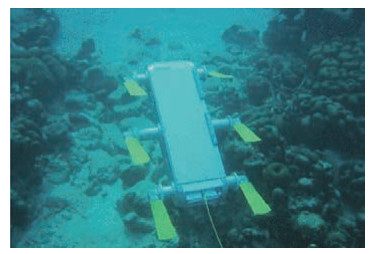

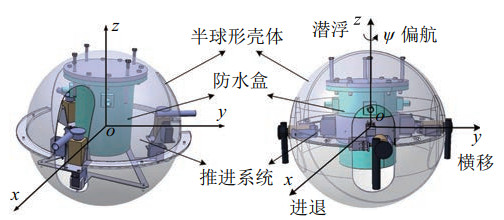

为使水下机器人能更好地与渔业环境相容,需要对水下机器人外形的水动力性能进行优化,减小其在运动中所受的阻力,并降低对水体的扰动及对水生动物的侵扰。韩国海洋水产部资助设计的UUV(无人水下航行器)将外形设计为扁平椭球状,降低了海流对其的影响[66](图 21)。Gu等[67]设计的球形水下机器人具有较好的动力、减阻性能,可作为水下环境监测机器人(图 22)。

|

图 21 椭球状水下航行器 Fig.21 The ellipsoidal UUV |

|

图 22 球形水下机器人 Fig.22 The spherical underwater robot |

另外,渔业生产的直接对象是脆弱敏感的生物,使水下机器人融入自然环境和生物群落中才能使其更好地实施作业。已有研究表明具有自然生物外形的水下机器人对水生动物的侵扰比潜水员和普通的水下机器人低[68](图 23)。

|

图 23 水下活动对水生动物的侵扰 Fig.23 Intrusion of underwater activities on aquatic animals |

总体而言,最常用的外形水动力性能优化设计方法是以流体运动控制N-S(Navier-Stokes)方程为基础的计算流体力学(CFD)方法。该法提供不受外界环境、试验设备精度影响的理想仿真环境[48]。使用试验装置进行实物模拟的实验方法主要是基于光流显示的数字粒子图像测速法(digital particle image velocimetry)[69],但此方法的试验时间较长,成本较高。

3.2 水下机器视觉与图像增强技术机器视觉与图像增强在渔业中具有广阔的应用场景,可用于生物目标位置信息与特征获取、行为监控、种类识别、渔业资源调查和疾病诊断等。近年来人工智能技术发展迅速,作为人工智能重要子领域的机器视觉技术也获得了研究者的广泛关注,加上其对水生动物的检测具有非提取性与无损性[70],机器视觉与图像增强技术业已成为水下机器人辅助渔业智能化作业的关键技术之一。

3.2.1 水生动物图像数据集与水下识别技术对水生动物进行识别是水下机器人进行渔业资源管理、采收捕获决策的前提。但大型的水生动物公开图像数据集很少,人工构建图像数据集的工作量又庞大,且水下图像处理面临着多种因素的干扰,诸多障碍使水下图像处理变得非常困难。为了兼顾对水生动物识别的准确率与识别速度,水下机器人移动端需要非常高的硬件配置,对硬件算力的要求很高,适用于陆基型移动机器人的图像处理算法、人工智能模型往往又因泛化能力弱而不适用于水下环境。为了将机器视觉技术应用于水下渔业环境,国内外学者做了相关研究。

国内外均有研究机构尝试构建大型的水生动物图像数据集。大连理工大学水下机器人团队建立了具有59万张预处理图像的UDD图像数据集[71],该数据集专用于开发捕获海珍品的水下机器人。UDD数据来源于真实的开放海域,因此具有较大的实用意义。另外,有研究者利用数据增广的方法来提高数据集的可用性,Yuan等[72]为了获得有效的水下图像训练数据集,提出了一种基于深度卷积生成式对抗网络(DCGAN)的数据增广方法。Chen等[73]构建了评估水下机器人视觉检测器效果的基准数据集。未来仍需要相关研究机构通力协作,针对主要水产品动物目标、各种训练目的构建公共、大型的渔业专用图像数据集,并同时开展针对渔业水生动物的小样本图像目标识别技术的研究。

获得了训练识别模型的图像数据集后,需要将识别模型、算法迁移到水下机器人中。目前面向水生动物识别检测的深度学习算法包括基于端到端(end-to-end)学习和基于区域提议网络(RPN)的算法。基于端到端学习的算法有YOLO(you only look once)算法、SSD(single-shot detector)算法,基于RPN的算法有Faster-RCNN(region-based convolutional neural network)算法与R-FCN(region-based fully convolutional network)算法等[74]。但识别模型、算法往往因为运行速度未达到在移动设备上流畅运行的程度而未能切实落地。

国内外研究者针对如何将渔业场景的水下识别模型及其计算载体轻量化、落地部署做了研究。赵德安等[75]使用基于深度卷积神经网络的YOLOv3模型对河蟹目标进行识别,准确率达到96.65%,但该方法需要较高的硬件配置,不便应用于移动装备上,于是赵德安等[76]又设计了利用较少硬件资源便能运行的轻量化检测器;为了开发适用于嵌入式设备的轻量级水生动物实时识别分类方法,Liu等[77]利用水生动物图像训练集建立了基于迁移学习(transfer learning)与轻量级神经网络结构MobileNetV2的识别分类模型,经实验证明该模型对验证集的准确率达到92.89%,仅需40 MB的存储空间;孙龙清等[78]则提出基于窗口打分的对象提议算法,并利用主成分分析(PCA)数据降维算法提取鱼体骨架和边缘特征,实现了对多目标鱼体的精确检测;Qiao等[79]提出了基于PCA与支持向量机(SVM)的算法以用于水下机器人在真实环境中快速、准确地识别海参;俞伟聪等[80]基于轻量化的Mobilenet-SSD网络模型建立了海胆、扇贝的检测方法,为搭载于低功率水下设备创造了条件;Cao等[81]提出了一种基于MobileNetV2与特征金字塔网络(FPN)的实时、轻量级的单目多目标检测算法来检测水下图像中的活蟹,用于实现生物量统计与投喂机器人智能投喂,该方法不仅能快速有效地检测到池塘中的活蟹,而且对硬件算力开销、内存消耗和存储空间均无严格要求。

综上所述,多数基于人工智能的识别算法对水下机器人进行智能作业均具有一定的积极意义,但在实用性、通用化、硬件算力节约方面仍有欠缺。针对水下目标的视觉应用研究与目前应用于陆基型移动机器人的视觉研究相比仍然处于较低水平。

3.2.2 水下图像增强技术因水中悬浮颗粒物、非结构化养殖环境、水体对光线的散射与吸收效应等因素的干扰,水下图像会出现模糊、偏色、畸变、低对比度与低分辨率等问题,不利于水下机器人对目标进行识别,给其任务的完成带来极大干扰,所以有必要对水下视觉系统获得的图像进行去雾、降噪、恢复等增强处理[82]。水下图像增强技术按实现原理划分主要可分为基于像素校正的水下图像增强技术、基于物理成像模型修正的水下图像增强技术与基于深度学习的水下图像增强技术3种[83]。

(1) 基于像素校正的水下图像增强技术。像素的色彩数值直接决定了图像的总体呈现效果,因此对像素色彩进行校正是最为直接的方法。常用的像素校正方法有限制对比度的自适应直方图均衡化、白平衡、Retinex算法和灰度变换操作的对比度拉伸等。Ahn等[25]使用Retinex算法来增强水下图像并利用高斯滤波降噪的方法解决光照不均的问题,可用于SAUV(sampling AUV,取样自主水下机器人)采集水生动物样本。袁红春等[84]则利用在Retinex算法基础上做了极大改进的带色彩恢复的多尺度视网膜增强算法来提高水下图像质量,从而为水下机器人对捕获目标进行精确识别与定位创造可能。

(2) 基于物理成像模型修正的水下图像增强技术。这类技术从成像机理上研究图像退化的原因,通过建立数学模型来描述现实环境中图像形成时的退化模型,再对退化模型进行逆运算,得到理想的高质量图像。典型的方法有暗通道先验(DCP)、改进暗通道先验(IDCP)、红色暗通道先验(RDCP)等。经典的水下成像模型有Jaff-McGlamery模型[85]、大气散射模型[86]。有研究者在经典成像模型的基础上做了修正,林森等[87]利用红通道的逆通道对红光进行补偿,修正了水下成像模型。王丹等[88]提出利用HSI(hue色调、saturation饱和度、intensity亮度)颜色模型的I分量来反映场景亮度并据此估计场景深度,从而结合修正的水下成像模型来实现图像增强。Akkaynak等[89]为了提高水下成像质量以帮助解决海洋污染与过度捕捞的问题,通过已知的场景深度信息,增加额外参数并利用水下RGB-D图像来建立精确的物理成像修正模型,获得了去除水体影响的良好成像效果,但预先得到场景深度信息在实际应用中需要做一定的准备工作,不利于实时处理。这类技术需要理想的高质量水下图像的先验模型,在移动设备上实际应用较为困难。

(3) 基于深度学习的水下图像增强技术。这类技术由数据驱动,通过水下图像数据集来建立图像退化模型并以学习到的模型对图像进行增强,需要大量的数据作支撑。较为典型的方法有水下生成式对抗网络(UGAN)、融合生成式对抗网络(FGAN)[90]等。文[27]中的水下捕获机器人即使用基于GAN的图像增强算法,使用单步检测器检测目标,以提高计算效率[91]。

除以上3种方法外,近年利用图像融合技术增强水下图像是研究的热点之一,Guo等[92]提出基于人类视觉系统与拉普拉斯融合的多尺度图像增强算法,有效提高了海参水下图像质量,为智能化捕获创造了可能。

多数水下图像增强技术难以兼顾增强效果与实时性[93]。在水下环境的作业中,要求图像处理算法能具备较高的实时性,尤其是对于遥控作业的ROV,为了操作者能观看到较为流畅的水下观测画面,帧率需要在24帧/s以上。

对于无需高质量水下图像的作业类型,例如以视觉伺服控制为主的水下捕获机器人,可通过牺牲对图像质量的高要求来提高图像处理与传输的实时性。还可利用图像压缩技术提高传输速度[94],文[25]中的SAUV将24位/像素(bpp)的图像压缩为4 bpp以减小传输中图像信息包的大小,压缩后仍满足应用要求。

轻量化人工智能(tiny AI)技术是突破硬件瓶颈的重要方法。提高系统处理能力仍是提高实时性的关键,包括使用并行计算(parallel computing)提高计算资源利用效率。Aguirre-Castro等[95]为了利用水下机器人探索水下环境,通过并行计算获得了42帧/s的高质量水下实时画面。

3.2.3 水生动物状态的视觉辨别技术水生动物的形状、尺寸、体色、纹理、姿态、行为等视觉属性是辅助渔业生产精细化管理、水下机器人作业智能化决策的关键信息。水生动物的状态包括其在养殖周期中所处的阶段、应激状态、福利水平、健康状况(包括生、死)等,对水生动物状态进行辨别具有重要的生产指导意义,可为何时分级分池及捕获上市、科学精准投喂控制、病死水产品无害化处理和防疫处置等环节提供有效信息。

目前,利用已建立的水生动物的视觉属性及其反映的状态间的映射关系的先验知识,结合机器视觉对水生动物的状态进行辨别已在鱼类、贝类、虾、蟹等水生动物的养殖、捕获、加工中得到了应用[96-98],部分水生动物的视觉属性、关键特征点及状态间的关系见表 3。

|

|

表 3 部分水生动物的视觉属性及其所反映的状态 Tab. 3 Visual attributes of some aquatic animals and their reflected states |

机器视觉赋予水下机器人以“看”的能力,在提高水下机器人“看得清”的能力的同时,未来的研究应同时着重于提升机器人“看得懂”的能力,即将人工智能程序集成于水下机器人数字化系统中,加深水下机器人对自然渔业场景的理解能力。进一步开展主要大宗水产品培育种类的水生动物行为学研究、形态学参数回归分析研究,建立高稳健性的水生动物状态预测、辨别方法,扩充渔业知识库,提高所获水生动物信息的可靠性,建立从视觉感兴趣区域(ROI)到状态辨别的高映射能力。

3.3 水下定位导航与运动规划技术无论是作业型还是观测型的渔业水下机器人,都需要具备一定的定位与运动规划能力。水下运动的规划和控制存在4大难点:(1) 复杂渔业环境中的浪、水流等未知因素时刻影响着水下机器人的运动;(2) 水下机器人6个自由度之间交叉耦合,其运动方程具有非线性、高维度的特征[99];(3) 水下机器人的运动是时变的,建立运动学模型非常困难,尤其是水动力模型与本体及作业机构间的互相制约影响[100];(4) 自然渔业环境中可能存在障碍物。

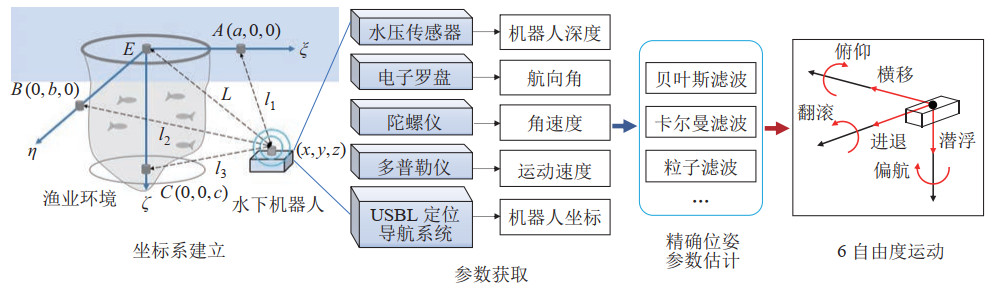

3.3.1 水下定位导航技术目前的水下定位导航技术主要基于声学定位。较成熟的声学定位系统有短基线(SBL)、超短基线(USBL)定位导航系统。另外基于牛顿力学定律的惯性导航系统(INS)在水下机器人定位导航中也有广泛应用,其定位导航过程具有无源性的特点,即定位导航不依赖于外部视觉信息,也不必向外界辐射能量(声波、电磁波),因此具有自主性的优点,但随工作时间的增长,该方法的定位导航累积偏差较大。为实现水下机器人的更为精确的定位导航,可对从水压传感器、电子罗盘、陀螺仪、多普勒仪和USBL定位导航系统等机载设备获取的深度、航向角、角速度、运动速度及坐标等参数进行参数估计,即结合贝叶斯滤波、卡尔曼滤波、粒子滤波等算法对机载传感器的观测值进行最优估计,从而获得更为精确的机器人位姿状态信息,进而对机器人的6自由度运动进行导航与控制(图 24)。

|

图 24 渔业环境定位与导航 Fig.24 Positioning and navigation in the fishery environment |

依赖单一方法难以实现较高精度的定位导航精度,通过将水声定位系统、惯性导航系统、激光雷达导航系统、视觉导航系统等多种定位导航系统相结合,进行组合导航,可在一定程度上提高水下定位导航的精度。

3.3.2 水下运动规划水下运动规划涉及到路径规划、运动控制和动态避障的问题。路径规划需要考虑空间遍历性、路径平滑性、最优性和能源节约等因素[101],尤其要解决动态避障和流场适应性的问题,水流扰动会使水下机器人偏离已规划的路径,如何抗干扰地进行路径规划是未来需要解决的核心问题[102]。

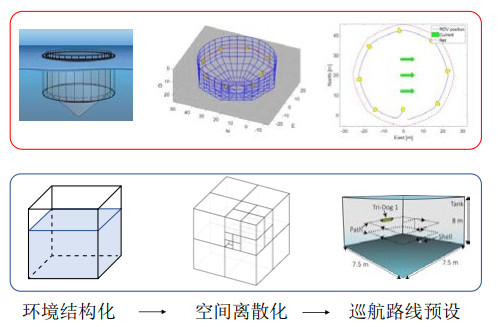

渔业水下机器人的路径规划应以使机器人实用、有效工作作为主要考虑因素。目前遗传算法、蚁群算法、粒子群算法等基于仿生群智能的全局路径规划算法已在预知地图的场景下获得了广泛应用。为实现这些规划算法用于渔业环境,必须建设结构化的渔业环境。通过建造具有特定规格的网箱、鱼笼,使养殖空间结构化,再将养殖空间离散化分割,建立养殖环境水体地图,设定工作目标区域使之作为导向,对水下机器人的巡航、巡检路线进行预设(图 25),供水下机器人进行路径规划[103]。

|

图 25 渔业环境建图 Fig.25 Mapping of the fishery environment |

在完全非结构化的开放水域、近浅海渔业环境和无法预设巡航路线的捕获作业中,水下机器人无法对外部环境进行全局预构图,需要通过SLAM(同步定位与地图创建)算法来创建地图并进行路径规划。但水下环境的特殊性导致路标环境特征提取相当困难,前端涉及到机器视觉与场景匹配,后端涉及到非线性系统的状态估计,对环境稳定性与硬件算力的要求都很高,SLAM在开阔环境中使用时的高阶计算复杂度是限制SLAM实际应用的因素之一。因此在渔业应用中应该针对机器人特定的工作区域、具体的作业任务,考虑采用新的地图表示方法,展开对环境相对稳定、空间范围相对较小的SLAM的研究。

有缆拖曳式ROV的运动控制可通过缆控方式加以辅助进行,而自主式AUV的运动控制则较为困难,对运动控制的智能程度要求较高,尤其是对于需要开展水下捕获作业、环境清洁任务的作业型水下机器人。运动控制的方法包含PID(比例-积分-微分)控制、滑模控制、鲁棒控制、自适应控制、模糊控制和神经网络控制等算法,每种算法均有其局限性,在实际应用中应结合具体工作任务、场景进行融合控制[6].

3.4 水下环境信息获取与传输技术精确获取水下环境信息后作进一步数字化处理并传输既是渔业生产过程中的必要环节,也是水下机器人进行有效、精准的水下应用层作业的关键。如何实现高可靠的水下环境信息获取与传输是实现水下机器人在渔业中应用的关键技术之一。

3.4.1 水下信息感知技术难点因渔业环境的特殊性,水下信息感知的技术难点包括:(1) 感知层难点。水下环境对传感器的感知能力提出了极高要求,信息感知层面临来自水流、光照、温度、压力、水生动物与污损生物附着等多方因素的共同影响。各参数具有时变性,而且参数间存在很强的耦合关系又进一步加大了信息感知的难度。(2) 传输层难点。在不使用脐带缆进行无线传输时,多采用水声通信(underwater acoustic communication)进行信息传输,但水声通信的信道带宽有限,已感知的信息在UAC中又受多径效应[104]、多普勒频移、湍流效应、环境噪声等的干扰而出现信号衰减的情况,包括信号失真、缺失、冗余等异常情况。使用有线传输则又束缚了水下机器人的运动。

3.4.2 水下智能传感器与多传感器融合技术水下机器人自身的智能化依赖于传感器的智能化,提高传感器智能程度可提高水下机器人的环境信息获取能力[105]。目前基于微处理单元(MPU)的水下智能传感器已具备自动采集、自动校准[106]、综合补偿、自寻故障的预处理能力,同时还具有自动滤波降噪、参数预测[107]、双向传输的加工处理能力。未来应加大力度研制微型水下智能传感器与传感器模块并集成于水下机器人中。

在提高单一传感器、传感器模块智能程度的同时,为了获取更为准确的、完整的水下环境信息,需要对多个乃至多种传感器获取的水下环境信息进行参数最优估计,对各传感器观测值取得一致性解释,从而实现多源信息的深度融合[108],以此提高水下机器人内、外信息获取的准确性。

目前实现多传感器信息融合的方法主要有基于概率统计意义上的平稳随机过程的方法与基于人工智能的方法。基于平稳随机过程的多传感器信息融合方法包含贝叶斯估计、卡尔曼滤波[109]、D-S(Dempster-Shafer)证据理论[110]等方法,基于人工智能的方法有模糊理论、粗糙集理论、神经网络等方法。通过多传感器信息在数据层、特征层和决策层上的融合[111],使不完整的信息实现互补,可在最大程度上提高感知的容错性、可靠性。

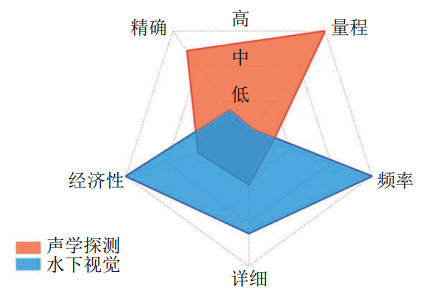

目前已有研究者将多传感器融合技术具体用于渔业水下机器人中。有研究者提出将声学、视觉传感器融合的方法来实现更稳定的水下生物目标识别检测[112]。有研究者提出将加速度计、电子罗盘、陀螺仪等机器人内部位姿传感器进行融合以提高水下定位和姿态估计的准确性,实现传感器间的优缺点互补[113](图 26)。对于监测溶解氧等渔业环境因子的传感器,应将多种测量方法集成于传感器中,将不同监测方法的优势进行加权整合。

|

图 26 声学、视觉传感器的优势互补 Fig.26 Complementation between acoustic sensors and vision sensors |

目前水下机器人与上位系统间的信息传输主要是使用复合电缆实现,开发零浮力、多功能的新型复合电缆是实现信息、能源稳定传输的较为现实的途径。

水下无线传输是科学界、工程界公认的难题。目前的无线通信技术主要是水声通信,而水声通信时延大,仍无法实现兆位每秒级(Mbps级)的信息传输,且在机器人运动中受干扰很大,仅适用于具有清洁水质的结构化渔业环境中。稳定、低功耗、高传输速率的水下无线传输技术是实现水下机器人无约束、高效精准作业的关键技术,也是亟需提高的技术。

4 总结与展望(Conclusions and prospects)渔业作业属于典型的“4d”(枯燥-肮脏-危险-精细)工作,2020年渔业人口同比减少了107.44万。随着从业人口的逐年减少,未来急迫需要面向渔业服务的水下机器人来辅助人类进行渔业生产及管理。

复杂的水下环境导致对水下机器人实现高稳健性的运动控制非常困难,水下机器人难以准确感知内、外部信息,建立本体与上位系统、操作者间实时高效的通信也十分艰难。此外,因直接面向的对象为脆弱的水生动物,这又进一步加大了水下机器人的研制难度,多方因素共同制约了其作为人类综合智力工具载体的发展。

纵观已有研究成果,目前国内外对用于渔业的观测型水下机器人的研究较多,相关应用较为成熟,而多数用于捡拾、捕获和清洁等作业的水下机器人未达到实际应用的水平,专用于渔业实际生产的水下机器人很少。国际机器人联合会(IFR)按照国际标准产业分类(ISIC)体系标准,将服务于渔业的水下机器人划归到与农业机器人同属一类的服务机器人中,未来面向渔业服务的水下机器人仍有较大的发展空间。

各种渔业模式对作业装备的自主化、智能化的要求日益提高,养殖环境的复杂性与作业任务的多样化也对智能作业装备提出了高要求,当前仍有诸多技术问题限制着水下机器人在渔业中的应用。

未来应重点发展水质环境监测机器人、起捕采收机器人、智能增氧机器人,以实现渔业精准管控、高效捕获,并开启防疫处置水下机器人的研究,实现对病死水产品无害化处理。未来同时具备环境监测和作业能力的水下机器人是发展的趋势。

渔业环境是水生动物的生存环境,为实现对环境、生物的干涉最小化,未来的水下机器人首先在硬件上应实现小型化、在外形上应趋于仿生化、在机动上应达到轻柔化,可从生物学、环境学中汲取丰富的启示用于机构学中,以使其能自然地融入到环境中。其次,作为智能作业装备,未来研究应着重实现在感知上智能化、在软件上轻量化,实时高效地对广阔水体开展渔业任务,这需要传感、信号处理、通信、计算机等科学、工程领域提供底层支持。最后,借鉴舰船设计中的母型设计法,对专用于渔业的水下机器人的较为成功的原理样机从外形结构上进行划分,提高模块化、通用化设计效率,使之具备可重构性、互换性与功能可拓展性,降低智能装备开发应用的成本。

针对淡水渔业与近浅海渔业,除了从机器人技术上进行推进外,应同时推进水下机器人作业环境的标准化、宜机化建设,以此优化渔业生产空间布局,降低外部条件的复杂性,满足水下机器人的机动、作业应用需求。

总而言之,水下机器人对渔业起的是辅助作用。将渔业水下生产全环节交由水下机器人来执行的实用效益性不高,在目前的技术上也不现实。应力求渔业水下机器人实用、有效,以行业实际应用为导向,以切实落地为目标,将人工经验作为水下机器人智能决策的基础,利用水下机器人延伸渔业从业人员体力能及的空间,通过深度的人机共融来实现智慧渔业。

| [1] |

Costello C, Cao L, Gelcich S, et al. The future of food from the sea[J]. Nature, 2020, 588: 95-100. DOI:10.1038/s41586-020-2616-y |

| [2] |

巩沐歌, 孟菲良, 黄一心, 等. 中国智能水产养殖发展现状与对策研究[J]. 渔业现代化, 2018, 45(6): 60-66. Gong M G, Meng F L, Huang Y X, et al. Research on development status and countermeasures of intelligent aquaculture in China[J]. Fishery Modernization, 2018, 45(6): 60-66. DOI:10.3969/j.issn.1007-9580.2018.06.010 |

| [3] |

中华人民共和国农业农村部. 关于加快水产养殖机械化发展的意见[EB/OL]. (2020-11-10)[2021-08-14]. http://www.njhs.moa.gov.cn/tzggjzcjd/202011/t20201110_6356101.htm. Ministry of Agriculture and Rural Affairs of the People's Republic of China. Opinions on accelerating the mechanization development of aquaculture[EB/OL]. (2020-11-10)[2021-08- 14]. http://www.njhs.moa.gov.cn/tzggjzcjd/202011/t20201110_6356101.htm. |

| [4] |

甄子健, 刘进长. 日本最新机器人研发计划及其发展战略[J]. 机器人技术与应用, 2016(5): 14-19. Zhen Z J, Liu J C. Japan's latest robot R&D plan and its development strategy[J]. Robot Technique and Application, 2016(5): 14-19. DOI:10.3969/j.issn.1004-6437.2016.05.001 |

| [5] |

赵静娟, 郑怀国, 董瑜, 等. 全球农业机器人研发趋势预测及对我国的启示[J]. 中国农机化学报, 2021, 42(4): 157-162. Zhao J J, Zheng H G, Dong Y, et al. Forecast research and development trend of international agricultural robot and its suitability to China[J]. Journal of Chinese Agricultural Mechanization, 2021, 42(4): 157-162. |

| [6] |

夏英凯, 朱明, 曾鑫, 等. 水产养殖水下机器人研究进展[J]. 华中农业大学学报, 2021, 40(3): 85-97. Xia Y K, Zhu M, Zeng X, et al. Progress of underwater robot for aquaculture[J]. Journal of Huazhong Agricultural University, 2021, 40(3): 85-97. |

| [7] |

Su X D, Sutarlie L, Loh X J. Sensors, biosensors, and analytical technologies for aquaculture water quality[J]. Research, 2020. DOI:10.34133/2020/8272705 |

| [8] |

WHOI. Oceanographic system lab (OSL)[EB/OL]. (2020-09-15)[2021-08-18]. https://www2.whoi.edu/site/osl/vehicles/remus-100.

|

| [9] |

Dodge K L, Kukulya A L, Burke E, et al. TurtleCam: A "smart" autonomous underwater vehicle for investigating behaviors and habitats of sea turtles[J]. Frontiers in Marine Science, 2018, 5. DOI:10.3389/fmars.2018.00090 |

| [10] |

Hawkes L A, Exeter O, Henderson S M, et al. Autonomous underwater videography and tracking of basking sharks[J]. Animal Biotelemetry, 2020, 8. DOI:10.1186/s40317-020-00216-w |

| [11] |

Eichhorn M, Ament C, Jacobi M, et al. Modular AUV system with integrated real-time water quality analysis[J]. Sensors, 2018, 18(6). DOI:10.3390/s18061837 |

| [12] |

Renda F, Giorgio-Serchi F, Boyer F, et al. A unified multi-soft-body dynamic model for underwater soft robots[J]. International Journal of Robotics Research, 2018, 37(6): 648-666. DOI:10.1177/0278364918769992 |

| [13] |

Yoerger D R, Govindarajan A F, Howland J C, et al. A hybrid underwater robot for multidisciplinary investigation of the ocean twilight zone[J]. Science Robotics, 2021, 6(55). DOI:10.1126/scirobotics.abe1901 |

| [14] |

Maki T, Horimoto H, Ishihara T, et al. Autonomous tracking of sea turtles based on multibeam imaging sonar: Toward robotic observation of marine life[J]. IFAC-PapersOnLine, 2019, 52(21): 86-90. DOI:10.1016/j.ifacol.2019.12.288 |

| [15] |

Rohit M H, Barua S, Akter I, et al. IOT based submersible ROV for pisciculture[C]//28th IEEE International Conference on Robot and Human Interactive Communication. Piscataway, USA: IEEE, 2019: 1-6.

|

| [16] |

Vasilescu I, Detweiler C, Doniec M, et al. AMOUR V: A hovering energy efficient underwater robot capable of dynamic payloads[J]. International Journal of Robotics Research, 2010, 29(5): 547-570. DOI:10.1177/0278364909358275 |

| [17] |

Osen O L, Sandvik R I, Trygstad J B, et al. A novel low cost ROV for aquaculture application[C]//OCEANS. Piscataway, USA: IEEE, 2017.

|

| [18] |

Huang L W, Li Z W, Li S R, et al. Design and application of a free and lightweight aquaculture water quality detection robot[J]. Journal Européen des Systèmes Automatisés, 2020, 53(1): 111-122. DOI:10.18280/jesa.530114 |

| [19] |

Zhang T D, Wang R, Wang Y, et al. Design and locomotion control of a dactylopteridae-inspired biomimetic underwater vehicle with hybrid propulsion[J]. IEEE Transactions on Automation Science and Engineering, 2022, 19(3): 2054-2066. DOI:10.1109/TASE.2021.3070117 |

| [20] |

Dudek G, Giguere P, Prahacs C, et al. AQUA: An amphibious autonomous robot[J]. Computer, 2007, 40(1): 46-53. DOI:10.1109/MC.2007.6 |

| [21] |

Katzschmann R K, Delpreto J, Maccurdy R, et al. Exploration of underwater life with an acoustically controlled soft robotic fish[J]. Science Robotics, 2018, 3(16). DOI:10.1126/scirobotics.aar3449 |

| [22] |

Ravalli A, Rossi C, Marrazza G. Bio-inspired fish robot based on chemical sensors[J]. Sensors and Actuators B: Chemical, 2017, 239: 325-329. DOI:10.1016/j.snb.2016.08.030 |

| [23] |

程淑红, 刘洁, 李雷华. 基于鱼类运动行为的水质异常评价因子研究[J]. 仪器仪表学报, 2015, 36(8): 1759-1766. Cheng S H, Liu J, Li L H. Study on anomaly water quality assessment factor based on fish movement behavior[J]. Chinese Journal of Scientific Instrument, 2015, 36(8): 1759-1766. DOI:10.3969/j.issn.0254-3087.2015.08.010 |

| [24] |

Takagi M, Mori H, Yimit A, et al. Development of a small size underwater robot for observing fisheries resources -- Underwater robot for assisting abalone fishing[J]. Journal of Robotics and Mechatronics, 2016, 28(3): 397-403. DOI:10.20965/jrm.2016.p0397 |

| [25] |

Ahn J, Yasukawa S, Sonoda T, et al. An optical image transmission system for deep sea creature sampling missions using autonomous underwater vehicle[J]. IEEE Journal of Oceanic Engineering, 2020, 45(2): 350-361. DOI:10.1109/JOE.2018.2872500 |

| [26] |

Sivčev S, Coleman J, Omerdić E, et al. Underwater manipulators: A review[J]. Ocean Engineering, 2018, 163: 431-450. DOI:10.1016/j.oceaneng.2018.06.018 |

| [27] |

Gong Z Y, Fang X, Chen X Y, et al. A soft manipulator for efficient delicate grasping in shallow water: Modeling, control, and real-world experiments[J]. International Journal of Robotics Research, 2021, 40(1): 449-469. DOI:10.1177/0278364920917203 |

| [28] |

周浩, 姜述强, 黄海, 等. 基于视觉感知的海生物吸纳式水下机器人目标捕获控制[J]. 机器人, 2019, 41(2): 242-249, 275. Zhou H, Jiang S Q, Huang H, et al. Vision based target capture control for sea organism absorptive underwater vehicle[J]. Robot, 2019, 41(2): 242-249, 275. |

| [29] |

Bayse S M, He P G, Pol M V, et al. Quantitative analysis of the behavior of longfin inshore squid (Doryteuthis pealeii) in reaction to a species separation grid of an otter trawl[J]. Fisheries Research, 2014, 152: 55-61. DOI:10.1016/j.fishres.2013.03.018 |

| [30] |

Cutkosky M R. On grasp choice, grasp models, and the design of hands for manufacturing tasks[J]. IEEE Transactions on Robotics and Automation, 1989, 5(3): 269-279. DOI:10.1109/70.34763 |

| [31] |

Takeuchi K, Nomura S, Tamamoto T, et al. Development of multi-joint gripper for underwater operations[C]//OCEANS. Piscataway, USA: IEEE, 2018. DOI: 10.1109/OCEANSKOBE.2018.8558849.

|

| [32] |

Sinatra N R, Teeple C B, Vogt D M, et al. Ultragentle manipulation of delicate structures using a soft robotic gripper[J]. Science Robotics, 2019, 4(33). DOI:10.1126/scirobotics.aax5425 |

| [33] |

Huang H, Tang Q R, Li J Y, et al. A review on underwater autonomous environmental perception and target grasp, the challenge of robotic organism capture[J]. Ocean Engineering, 2020, 195. DOI:10.1016/j.oceaneng.2019.106644 |

| [34] |

Yuk H, Lin S T, Ma C, et al. Hydraulic hydrogel actuators and robots optically and sonically camouflaged in water[J]. Nature Communications, 2017, 8. DOI:10.1038/ncomms14230 |

| [35] |

Stuart H, Wang S Q, Khatib O, et al. The Ocean One hands: An adaptive design for robust marine manipulation[J]. International Journal of Robotics Research, 2017, 36(2): 150-166. DOI:10.1177/0278364917694723 |

| [36] |

Galloway K C, Becker K P, Phillips B, et al. Soft robotic grippers for biological sampling on deep reefs[J]. Soft Robotics, 2016, 3(1): 23-33. DOI:10.1089/soro.2015.0019 |

| [37] |

Phillips B T, Becker K P, Kurumaya S, et al. A dexterous, glove-based teleoperable low-power soft robotic arm for delicate deep-sea biological exploration[J]. Scientific Reports, 2018, 8. DOI:10.1038/s41598-018-33138-y |

| [38] |

Chaloux N, Phillips B T, Gruber D F, et al. A novel fish sampling system for ROVs[J]. Deep Sea Research, Part I: Oceanographic Research Papers, 2021, 167. DOI:10.1016/j.dsr.2020.03428 |

| [39] |

陈言壮, 张奇峰, 田启岩, 等. 水下多指手研究现状[J]. 机器人, 2020, 42(6): 749-768. Chen Y Z, Zhang Q F, Tian Q Y, et al. Research status of underwater multi-fingered hands[J]. Robot, 2020, 42(6): 749-768. |

| [40] |

谢哲新, 龚哲元, 王田苗, 等. 可控三维运动的软体驱动器仿真与试验[J]. 机械工程学报, 2018, 54(21): 11-18. Xie Z X, Gong Z Y, Wang T M, et al. Simulation and experiments of a controllable soft spatial fluidic elastomer manipulator[J]. Journal of Mechanical Engineering, 2018, 54(21): 11-18. |

| [41] |

Cai M X, Wang Y, Wang S, et al. Grasping marine products with hybrid-driven underwater vehicle-manipulator system[J]. IEEE Transactions on Automation Science and Engineering, 2020, 17(3): 1443-1454. |

| [42] |

石建高, 余雯雯, 赵奎, 等. 海水网箱网衣防污技术的研究进展[J]. 水产学报, 2021, 45(3): 472-485. Shi J G, Yu W W, Zhao K, et al. Progress in research of antifouling technology of offshore cage netting[J]. Journal of Fisheries of China, 2021, 45(3): 472-485. |

| [43] |

Ohrem S J, Kelasidi E, Bloecher N. Analysis of a novel autonomous underwater robot for biofouling prevention and inspection in fish farms[C]//28th Mediterranean Conference on Control and Automation. Piscataway, USA: IEEE, 2020: 1002-1008.

|

| [44] |

Chen Y H, Liu S Y, Fan J C, et al. Novel online optimized control for underwater pipe-cleaning robots[J]. Applied Sciences, 2020, 10(12). DOI:10.3390/app10124279 |

| [45] |

庄集超, 庞洪臣, 刘子浪, 等. 一种新型深海网箱网衣清洗机器人设计[J]. 机械, 2018, 45(1): 72-75. Zhuang J C, Pang H C, Liu Z L, et al. Design of a new deep-sea net cage cleaning robot[J]. Machinery, 2018, 45(1): 72-75. |

| [46] |

刘冠灵, 卫泓宇, 李志鹏, 等. 履带式深海网箱清洗机器人的设计[J]. 机械制造, 2019, 57(4): 11-14. Liu G L, Wei H Y, Li Z P, et al. Design of crawler-type deep-sea cage cleaning robot[J]. Machinery, 2019, 57(4): 11-14. DOI:10.3969/j.issn.1000-4998.2019.04.004 |

| [47] |

房熊. 一种新型水下网箱清洗机器人的设计探索[J]. 机电设备, 2020, 37(6): 57-60, 64. Fang X. Design of a new type of underwater cage cleaning robot[J]. Mechanical and Electrical Equipment, 2020, 37(6): 57-60, 64. |

| [48] |

闫银坡, 于福杰, 陈原. 开架式水下机器人水动力系数计算与动力学建模[J]. 兵工学报, 2021, 42(9): 1972-1986. Yan Y B, Yu F J, Chen Y. Hydrodynamic coefficients calculation and dynamic modeling of an open-frame underwater robot[J]. Acta Armamentarii, 2021, 42(9): 1972-1986. DOI:10.3969/j.issn.1000-1093.2021.09.018 |

| [49] |

Zhao Y P, Niu L J, Du H, et al. An adaptive method of damage detection for fishing nets based on image processing technology[J]. Aquacultural Engineering, 2020, 90. DOI:10.1016/j.aquaeng.2020.102071 |

| [50] |

Koyama T, Yonekura T. Development and experimental results of underwater robot for land aquaculture use[C]//OCEANS. Piscataway, USA: IEEE, 2018. DOI: 10.1109/OCEANSKOBE.2018.8559059.

|

| [51] |

胡勇兵, 黄达, 李金刚. 鱼池清刷机器人控制系统设计与试验[J]. 南方农机, 2021, 52(10): 7-10. Hu Y B, Huang D, Li J G. Design and experiment of the control system of fish tank cleaning robot[J]. China Southern Agricultural Machinery, 2021, 52(10): 7-10. DOI:10.3969/j.issn.1672-3872.2021.10.003 |

| [52] |

Mahmud M S A, Abidin M S Z, Buyamin S, et al. Multi-objective route planning for underwater cleaning robot in water reservoir tank[J]. Journal of Intelligent & Robotic Systems, 2021, 101. DOI:10.1007/s10846-020-01291-0 |

| [53] |

Dumiak M. Lice-hunting underwater drone protects salmon[News][J]. IEEE Spectrum, 2017, 54(4): 9-10. DOI:10.1109/MSPEC.2017.7880444 |

| [54] |

Kukulya A, Plueddemann A, Austin T, et al. Under-ice operations with a REMUS-100 AUV in the Arctic[C]//IEEE/OES Autonomous Underwater Vehicles. Piscataway, USA: IEEE, 2010: 1-8.

|

| [55] |

房熊, 林礼群, 沈熙晟, 等. 一种渔业水下机器人的系统设计及模型研究[J]. 渔业现代化, 2018, 45(2): 36-41. Fang X, Lin L Q, Shen X S, et al. System design and model research of a fishery underwater robot[J]. Fishery Modernization, 2018, 45(2): 36-41. DOI:10.3969/j.issn.1007-9580.2018.02.006 |

| [56] |

Kirchner F, Straube S, Kühn D, et al. AI technology for underwater robots[M]. Cham, Switzerland: Springer, 2020.

|

| [57] |

李道亮, 包建华. 水产养殖水下作业机器人关键技术研究进展[J]. 农业工程学报, 2018, 34(16): 1-9. Li D L, Bao J H. Research progress on key technologies of underwater operation robot for aquaculture[J]. Transactions of the Chinese Society of Agricultural Engineering, 2018, 34(16): 1-9. DOI:10.11975/j.issn.1002-6819.2018.16.001 |

| [58] |

张奇峰, 张运修, 张艾群. 深海小型爬行机器人研究现状[J]. 机器人, 2019, 41(2): 250-264. Zhang Q F, Zhang Y X, Zhang A Q. Research status of benthic small-scale crawling robots[J]. Robot, 2019, 41(2): 250-264. |

| [59] |

Wang Y, Wang R, Wang S, et al. Underwater bioinspired propulsion: From inspection to manipulation[J]. IEEE Transactions on Industrial Electronics, 2019, 67(9): 7629-7638. |

| [60] |

黄琰, 李岩, 俞建成, 等. AUV智能化现状与发展趋势[J]. 机器人, 2020, 42(2): 215-231. Huang Y, Li Y, Yu J C, et al. State-of-the-art and development trend of AUV intelligence[J]. Robot, 2020, 42(2): 215-231. |

| [61] |

Luong J, Glick P, Ong A, et al. Eversion and retraction of a soft robot towards the exploration of coral reefs[C]//2nd IEEE International Conference on Soft Robotics. Piscataway, USA: IEEE, 2019: 801-807.

|

| [62] |

Zhang F T, Ennasr O, Litchman E, et al. Autonomous sampling of water columns using gliding robotic fish: Algorithms and harmful-algae-sampling experiments[J]. IEEE Systems Journal, 2016, 10(3): 1271-1281. DOI:10.1109/JSYST.2015.2458173 |

| [63] |

谢广明, 王伟, 李亮. 智能仿生鱼设计与关键技术[M]. 北京: 国防工业出版社, 2020: 57-60. Xie G M, Wang W, Li L. Design and key technologies for intelligent biomimetic robotic fish[M]. Beijing: National Defense Industry Press, 2020: 57-60. |

| [64] |

王延杰, 郝牧宇, 张霖, 等. 基于智能驱动材料的水下仿生机器人发展综述[J]. 水下无人系统学报, 2019, 27(2): 123-133. Wang Y J, Hao M Y, Zhang L, et al. Progress of biomimetic underwater robot based on intelligent actuating materials: A review[J]. Journal of Unmanned Undersea Systems, 2019, 27(2): 123-133. |

| [65] |

梁艺鸣, 曹许诺, 陈祥平, 等. "刚-柔"共融型仿生机器鱼[J]. 中国科学: 技术科学, 2018, 48(12): 1295-1301. Liang Y M, Cao X N, Chen X P, et al. Bio-inspired rigid-soft coexisting robotic fish[J]. Scientia Sinica Technologica, 2018, 48(12): 1295-1301. |

| [66] |

Li J H, Kim M G, Kang H J, et al. Development of UUV platform and its control method to overcome strong currents: Simulation and experimental studies[J]. IFAC-PapersOnLine, 2018, 51(29): 268-273. |

| [67] |

Gu S X, Guo S X, Zheng L. A highly stable and efficient spherical underwater robot with hybrid propulsion devices[J]. Autonomous Robots, 2020, 44: 759-771. |

| [68] |

Kruusmaa M, Gkliva R, Tuhtan J A, et al. Salmon behavioural response to robots in an aquaculture sea cage[J]. Royal Society Open Science, 2020, 7(3). DOI:10.1098/rsos.191220 |

| [69] |

Thandiackal R, White C H, Bart-Smith H, et al. Tuna robotics: Hydrodynamics of rapid linear accelerations[J]. Proceedings of the Royal Society B, 2021, 288(1945). DOI:10.1098/rspb.2020.2726 |

| [70] |

Li D L, Hao Y F, Duan Y Q. Nonintrusive methods for biomass estimation in aquaculture with emphasis on fish: A review[J]. Reviews in Aquaculture, 2020, 12(3): 1390-1411. |

| [71] |

Wang Z H, Liu C W, Wang S J, et al. UDD: An underwater open-sea farm object detection dataset for underwater robot picking[EB/OL]. (2021-07-28)[2021-08-11]. https://arxiv.org/abs/2003.01446v1.

|

| [72] |

Yuan H C, Zhang S, Qin E Q, et al. Aquatic animal image classification technology based on transfer learning and data augmentation[J]. Journal of Coastal Research, 2020, 105(S1): 129-133. |

| [73] |

Chen L, Tong L, Zhou F X, et al. A benchmark dataset for both underwater image enhancement and underwater object detection[EB/OL]. (2020-06-29)[2021-08-14]. https://arxiv.org/abs/2006.15789.

|

| [74] |

Huang H, Zhou H, Yang X, et al. Faster R-CNN for marine organisms detection and recognition using data augmentation[J]. Neurocomputing, 2019, 337: 372-384. |

| [75] |

赵德安, 刘晓洋, 孙月平, 等. 基于机器视觉的水下河蟹识别方法[J]. 农业机械学报, 2019, 50(3): 151-158. Zhao D A, Liu X Y, Sun Y P, et al. Detection of underwater crabs based on machine vision[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(3): 151-158. |

| [76] |

赵德安, 曹硕, 孙月平, 等. 基于联动扩展神经网络的水下自由活蟹检测器研究[J]. 农业机械学报, 2020, 51(9): 163-174. Zhao D A, Cao S, Sun Y P, et al. Small-sized efficient detector for underwater freely live crabs based on compound scaling neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(9): 163-174. |

| [77] |

Liu X F, Jia Z Q, Hou X K, et al. Real-time marine animal images classification by embedded system based on mobilenet and transfer learning[C]//OCEANS. Piscataway, USA: IEEE, 2019. DOI: 10.1109/OCEANSE.2019.8867190.

|

| [78] |

孙龙清, 刘婷, 陈帅华, 等. 多目标鱼体对象提议检测算法研究[J]. 农业机械学报, 2019, 50(12): 260-267. Sun L Q, Liu T, Chen S H, et al. Multi-target fish detection algorithm based on object proposals[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(12): 260-267. |

| [79] |

Qiao X, Bao J H, Zhang H, et al. Underwater sea cucumber identification based on principal component analysis and support vector machine[J]. Measurement, 2019, 133: 444-455. |

| [80] |

俞伟聪, 郭显久, 刘钰发, 等. 基于轻量化深度学习Mobilenet-SSD网络模型的海珍品检测方法[J]. 大连海洋大学学报, 2021, 36(2): 340-346. Yu W C, Guo X J, Liu Y F, et al. Detection method of high value marine food organisms based on lightweight deep learning Mobilenet-SSD network[J]. Journal of Dalian Ocean University, 2021, 36(2): 340-346. |

| [81] |

Cao S, Zhao D A, Liu X Y, et al. Real-time robust detector for underwater live crabs based on deep learning[J]. Computers and Electronics in Agriculture, 2020, 172. DOI:10.1016/j.compag.2020.105339 |

| [82] |

Han M, Lyu Z, Qiu T, et al. A review on intelligence dehazing and color restoration for underwater images[J]. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2020, 50(5): 1820-1832. |

| [83] |

于红. 水产动物目标探测与追踪技术及应用研究进展[J]. 大连海洋大学学报, 2020, 35(6): 793-804. Yu H. Research progress on object detection and tracking techniques utilization in aquaculture: A review[J]. Journal of Dalian Ocean University, 2020, 35(6): 793-804. |

| [84] |

袁红春, 张硕. 基于Faster R-CNN和图像增强的水下鱼类目标检测方法[J]. 大连海洋大学学报, 2020, 35(4): 612-619. Yuan H C, Zhang S. Detection of underwater fish based on Faster R-CNN and image enhancement[J]. Journal of Dalian Ocean University, 2020, 35(4): 612-619. |

| [85] |

McGlamery B L. A computer model for underwater camera systems[C]//Ocean Optics VI. Bellingham, USA: SPIE, 1980. DOI: 10.1117/12.958279.

|

| [86] |

Narasimhan S G, Nayar S K. Vision and the atmosphere[J]. International Journal of Computer Vision, 2002, 48: 233-254. |

| [87] |

林森, 白莹, 李文涛, 等. 基于修正模型与暗通道先验信息的水下图像复原[J]. 机器人, 2020, 42(4): 427-435, 447. Lin S, Bai Y, Li W T, et al. Underwater image restoration based on the modified model and dark channel prior[J]. Robot, 2020, 42(4): 427-435, 447. |

| [88] |

王丹, 张子玉, 赵金宝, 等. 基于场景深度估计的自然光照水下图像增强方法[J]. 机器人, 2021, 43(3): 364-372. Wang D, Zhang Z Y, Zhao J B, et al. An enhancement method for underwater images under natural illumination based on scene depth estimation[J]. Robot, 2021, 43(3): 364-372. |

| [89] |

Akkaynak D, Treibitz T. Sea-thru: A method for removing water from underwater images[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2019: 1682-1691.

|

| [90] |

Anwar S, Li C Y. Diving deeper into underwater image enhancement: A survey[J]. Signal Processing: Image Communication, 2020, 89. DOI:10.1016/j.image.2020.115978 |

| [91] |

Chen X Y, Yu J Z, Kong S H, et al. Towards real-time advancement of underwater visual quality with GAN[J]. IEEE Transactions on Industrial Electronics, 2019, 66(12): 9350-9359. |

| [92] |

Guo P F, Zeng D L, Tian Y B, et al. Multi-scale enhancement fusion for underwater sea cucumber images based on human visual system modelling[J]. Computers and Electronics in Agriculture, 2020, 175. DOI:10.1016/j.compag.2020.105608 |

| [93] |

Islam M J, Xia Y Y, Sattar J. Fast underwater image enhancement for improved visual perception[J]. IEEE Robotics and Automation Letters, 2020, 5(2): 3227-3234. |

| [94] |

Krishnaraj N, Elhoseny M, Thenmozhi M, et al. Deep learning model for real-time image compression in Internet of Underwater Things (IoUT)[J]. Journal of Real-Time Image Processing, 2020, 17: 2097-2111. |

| [95] |

Aguirre-Castro O A, Inzunza-González E, García-Guerrero E E, et al. Design and construction of an ROV for underwater exploration[J]. Sensors, 2019, 19(24). DOI:10.3390/s19245387 |

| [96] |

段延娥, 李道亮, 李振波, 等. 基于计算机视觉的水产动物视觉特征测量研究综述[J]. 农业工程学报, 2015, 31(15): 1-11. Duan Y E, Li D L, Li Z B, et al. Review on visual attributes measurement research of aquatic animals based on computer vision[J]. Transactions of the Chinese Society of Agricultural Engineering, 2015, 31(15): 1-11. |

| [97] |

徐建瑜, 崔绍荣, 苗香雯, 等. 计算机视觉技术在水产养殖中的应用与展望[J]. 农业工程学报, 2005, 21(8): 174-178. Xu J Y, Cui S R, Miao X W, et al. Application and prospect of computer vision technology in aquaculture[J]. Transactions of the Chinese Society of Agricultural Engineering, 2005, 21(8): 174-178. |

| [98] |

郑金存, 赵峰, 林勇, 等. 基于近红外深度图的游泳型鱼类摄食强度实时测量[J]. 上海海洋大学学报, 2021, 30(6): 1067-1078. Zheng J C, Zhao F, Lin Y, et al. Evaluation of fish feeding intensity in aquaculture based on near-infrared depth image[J]. Journal of Shanghai Ocean University, 2021, 30(6): 1067-1078. |

| [99] |

徐玉如, 李彭超. 水下机器人发展趋势[J]. 自然杂志, 2011, 33(3): 125-132. Xu Y R, Li P C. Developing tendency of unmanned underwater vehicles[J]. Chinese Journal of Nature, 2011, 33(3): 125-132. |

| [100] |

Cai M X, Wang S, Wang Y, et al. Coordinated control of underwater biomimetic vehicle-manipulator system for free floating autonomous manipulation[J]. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2021, 51(8): 4793-4803. |

| [101] |

Niu H L, Ji Z, Savvaris A, et al. Energy efficient path planning for unmanned surface vehicle in spatially-temporally variant environment[J]. Ocean Engineering, 2020, 196. DOI:10.1016/j.oceaneng.2019.106766 |

| [102] |

王梓强, 胡晓光, 李晓筱, 等. 移动机器人全局路径规划算法综述[J]. 计算机科学, 2021, 48(10): 19-29. Wang Z Q, Hu X G, Li X X, et al. Overview of global path planning algorithms for mobile robots[J]. Computer Science, 2021, 48(10): 19-29. |

| [103] |

Sandoy S S, Hegde J, Schjolberg I, et al. Polar map: A digital representation of closed structures for underwater robotic inspection[J]. Aquacultural Engineering, 2020, 89. DOI:10.1016/j.aquaeng.2019.102039 |

| [104] |

Petillot Y R, Antonelli G, Casalino G, et al. Underwater robots: From remotely operated vehicles to intervention-autonomous underwater vehicles[J]. IEEE Robotics & Automation Magazine, 2019, 26(2): 94-101. |

| [105] |

赵小川, 罗庆生, 韩宝玲. 机器人多传感器信息融合研究综述[J]. 传感器与微系统, 2008, 27(8): 1-4, 11. Zhao X C, Luo Q S, Han B L. Review of robot multi-sensor information fusion[J]. Transducer and Microsystem Technologies, 2008, 27(8): 1-4, 11. |

| [106] |

聂鹏程, 张慧, 耿洪良, 等. 农业物联网技术现状与发展趋势[J]. 浙江大学学报(农业与生命科学版), 2021, 47(2): 135-146. Nie P C, Zhang H, Geng H L, et al. Current situation and development trend of agricultural Internet of Things technology[J]. Journal of Zhejiang University (Agriculture and Life Sciences), 2021, 47(2): 135-146. |

| [107] |

Hu Z H, Zhang Y R, Zhao Y C, et al. A water quality prediction method based on the deep LSTM network considering correlation in smart mariculture[J]. Sensors, 2019, 19(6). DOI:10.3390/s19061420 |

| [108] |

Deng Y. Uncertainty measure in evidence theory[J]. Science China: Information Sciences, 2020, 63(11). DOI:10.1007/s11432-020-3006-9 |

| [109] |

Shaukat N, Ali A, Iqbal M J, et al. Multi-sensor fusion for underwater vehicle localization by augmentation of RBF neural network and error-state Kalman filter[J]. Sensors, 2021, 21(4). DOI:10.3390/s21041149 |

| [110] |

Xiao F Y. A new divergence measure for belief functions in D-S evidence theory for multisensor data fusion[J]. Information Sciences, 2020, 514: 462-483. |

| [111] |

赵炳巍, 曹岩, 贾峰, 等. 移动机器人多传感器信息融合方法综述[J]. 电子测试, 2020(18): 68-69. Zhao B W, Cao Y, Jia F, et al. Survey of multi-sensor information fusion methods for mobile robots[J]. Electronic Test, 2020(18): 68-69. |

| [112] |

Terayama K, Shin K, Mizuno K, et al. Integration of sonar and optical camera images using deep neural network for fish monitoring[J]. Aquacultural Engineering, 2019, 86. DOI:10.1016/j.aquaeng.2019.102000 |

| [113] |

Remmas W, Chemori A, Kruusmaa M. Diver tracking in open waters: A low-cost approach based on visual and acoustic sensor fusion[J]. Journal of Field Robotics, 2021, 38(3): 494-508. |

2023, Vol. 45

2023, Vol. 45