2. 上海交通大学船舶海洋与建筑工程学院,上海 200240

2. School of Naval Architecture, Ocean & Civil Engineering, Shanghai Jiao Tong University, Shanghai 200240, China

受生物特性的启发,具有高度灵活性和强变形能力的柔性机器人在学界得到广泛研究[1-3]。尤其是在非结构化和复杂环境中[4],相比基于传统电机驱动的刚体机器人,受益于柔性材料,柔性机器人具有较强的弯曲能力和伸缩能力,能够更好地处理复杂任务。柔性机器人是一个新颖且高速发展的领域,涉及机器硬件、柔性材料和集成系统等领域。其中,柔性材料在柔性机器人的发展中,尤其是驱动器(例如仿生肌肉、形状记忆合金等)和变形能力上起着重要作用。柔性材料对仿生机器人学的机器和结构设计至关重要,将柔性材料“肌肉”驱动器与中枢神经系统结合才能构建完整的神经机器控制系统。

目前,已有多种受生物启发的仿生机器人面世,其中“Oct Arm”是一种仿章鱼设计的柔性机器人[5],如图 1(a)所示。该柔性机器人使用一种嵌入了合金的柔性材料作为执行器,具有多自由度运动能力,并可在水中自由变形和弯曲伸缩。另一类仿生机器人GoQBot是仿毛虫机器人[6],如图 1(b)所示。该柔性机器人模仿毛毛虫蠕动,并将形状记忆材料和信号线嵌入在类似毛毛虫的结构内。另外还有多步态软体机器人[7],如图 1(c)所示,由电活性聚合物(EAP)材料(弹性体聚合物)和相对坚硬的内部骨架组成。这种软体机器人的特殊之处在于它无需额外的驱动器,仅需5个执行器就可以完成机器人驱动。另一种仿蚯蚓的软体机器人[8-9]通过模拟蚯蚓蠕动的方式进行移动,如图 1(d)所示。合金驱动机器人[10]采用镍钛合金作为执行器,可以在运动过程中通过温度、压力等操作量控制仿蚯蚓机器人的运动状态。另一种新的仿海星柔性机器人设计采用硅胶柔性材料和气动网络[11],使得该柔性机器人可以产生各种各样的抓取动作和驱动形态,如图 1(e)所示。

|

图 1 仿生柔性机器人实例 Fig.1 Examples of bionic soft robots |

特殊材料的柔性致动器能为机器人提供驱动动力,因此在柔性机器人结构中十分重要。如现有的EAP[12-14]是一种可通过变换电场来改变尺寸或形状的软质材料。此外,电缆驱动器[15-16]被广泛用于超冗余机器人中,可嵌入机器人体内进行变形驱动。流体致动器[17-19]也是一种具有快速变形能力的致动材料,使用压缩空气或加压液体产生压力差达到致动目的。目前,SMA [5-6, 20]因具有相对较大的形变力和较短的响应时间,近年来在柔性机器人结构设计中得到了广泛应用。本文所介绍的柔性机器人GS-Bot(great soft robot)结合了生物体骨关节扭动和形变弯曲的特性,利用了镍钛柔性SMA受热形变的物理、化学特性,大大提升了GS-Bot机器人的形变能力和操控能力。

本文的主要贡献如下:

1) 提出了一种具有高形变和耦合弯曲能力的新型柔性机器人结构,设计建造了一种仿生柔性GS-Bot机器人原型样机。利用镍钛SMA作为驱动器,使得GS-Bot机器人具有相对较高的形变和驱动力。同时通过实物实验验证了其具有可操控能力。

2) 设计了一种针对GS-Bot机器人的Q学习方法,并在仿真环境中验证了GS-Bot机器人仿真模型在训练后能够自主智能地完成目标任务。

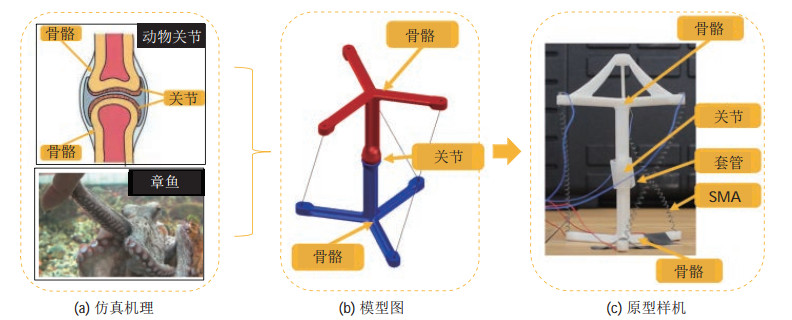

2 GS-Bot柔性机器人系统组成(Composi- tion of the GS-Bot soft robot system)柔性机器人GS-Bot受2种生物的机体特性启发制成,其仿生机理和原型如图 2所示。躯体结构模仿生物“尺蠖”的骨关节,该骨关节可以提供承重作用以及实现多自由度运动。另一仿生对象为“蛇”的肌肉,使得机器人能够像“蛇”一样弯曲并使躯体朝向目标物体运动。这种设计使得机器人在空间在轨非结构化环境中能够有效抵抗外界冲击并完成高自由度复杂形变运动。

|

图 2 机器人仿生机理和原型样机 Fig.2 Bionic mechanism and prototype of GS-Bot |

GS-Bot原型样机如图 2(c)所示,每节关节由2个光敏树脂材料制成的骨架连接构成,3根SMA弹簧连接在相邻2节之间用于提供驱动力。同时,为了达到骨关节扭转效果,骨架连接处被设计为“球窝”结构,并使用橡胶管来约束偏转角的范围。GS-Bot机器人能够在传统刚体机器人扭转操作受限的非结构化空间和限制空间中发挥重要的作用。

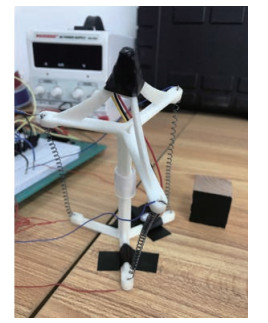

2.1 GS-Bot系统架构组成整个GS-Bot系统可分为3部分:上位机与下位机控制器、硬件电路和GS-Bot机器人原型样机。下位机由MCU(micro control unit)组成,通过串行通信与上位机进行控制数据的通信。硬件电路将根据时控电信号给GS-Bot机器人输送电流。GS-Bot机器人样机见图 3,原型样机模块通过加热单根或多根SMA弹簧来驱动GS-Bot机器人改变运动状态。另外,在GS-Bot机器人顶端安装一个微型摄像机用于提供视觉反馈,视觉系统集成了YOLO(you only look once)[21]目标检测算法。

|

图 3 机器人样机 Fig.3 GS-Bot prototype |

SMA弹簧相对其他柔性材料具有相对较高的变形性能、高功重比和可恢复性,常被选为驱动器。SMA弹簧加热时会收缩,冷却后可由外力拉伸恢复到初始形状。为了测试SMA物理性能和材料的可重复性,本文使用立式和卧式橡胶拉伸试验机验证SMA弹簧受温度影响的伸缩特性及在驱动电压和不同温度方面的恢复特性。当驱动电压为3 V时,SMA弹簧对不同室温的敏感程度不大,对于不同驱动电流大小表现十分敏感,20 s以后才开始产生较大形变。当驱动电压为6 V时,SMA从第10 s开始急剧变化,直到第20 s趋于稳定。以上结果表明SMA的形变性质对于电压变化更加敏感。

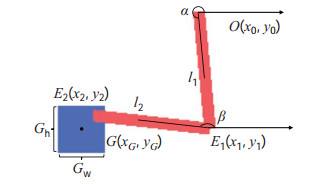

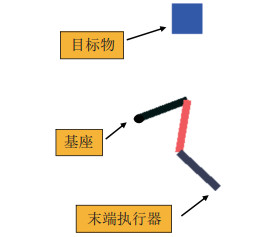

3 GS-Bot机器人智能规划仿真(Simulation of GS-Bot intelligent planning)GS-Bot机器人的姿态与运动规划控制主要通过SMA弹簧的伸缩带动骨节间的角度偏转来实现,实际运动具有非常大的非线性。因此将GS-Bot机器人简化为2维平面中的机器臂连杆模型进行自主规划仿真,如图 4所示。利用机器臂的关节角度控制机器臂的位置和姿态。图 4中红色部分代表 2根机器臂连杆,通过连杆间的角度变化控制机器臂姿态和端点位置。2维平面内设置一个蓝色目标物,用于表示机器臂被期望到达的目标位置。仿真模型中

|

图 4 简化仿真模型示意图 Fig.4 The schematic diagram of GS-Bot simplified simulation model |

为描述仿真环境中机器臂的姿态和位置,本文选用2维物理量进行定量分析:机器臂长度和旋转角度。因此可得到3个端点的点坐标关系式如下:

| $ \begin{equation} \begin{aligned} (x_{1}, y_{1}) &=(l_{1} \cos \alpha, l_{1} \sin \alpha) +(x_{0}, y_{0}) \\[-3pt] (x_{2}, y_{2}) &=(l_{2} \cos \beta, l_{2} \sin \beta) +(x_{1}, y_{1}) \end{aligned} \end{equation} $ | (1) |

通过3个端点

本文采用Q学习智能规划方法对机器臂进行自主学习和驱动,通过所建立的奖励函数对仿真智能体进行训练,并最终达到机器臂自主规划和驱动的目的。在Q学习中,针对被控对象智能体,定义在

|

图 5 基于Q学习的规划算法 Fig.5 Planning algorithm based on Q-learning |

一般地,用神经网络反映状态到动作的映射关系,对应于智能体在环境中

| $ \begin{equation} P_{{\rm r}} = \begin{cases} \pi ( {a_{t}} |s_{t}) <1 \\ \sum \pi ( {a_{t}} |s_{t}) =1 \\ \end{cases} \end{equation} $ | (2) |

和确定性策略

| $ \begin{equation} P_{{\rm d}} =\pi ( {a_{t}} |s_{t}): s\to a \end{equation} $ | (3) |

确定性策略在特定状态

| $ \begin{equation} V_{\pi} (s)=E_{s_{t}, s_{t+1}, \cdots } \left({\sum\limits_{k=0}^T {\gamma ^{k}r_{t+k} (s_{t+k}) }} \right) \end{equation} $ | (4) |

其中,衰减因子

| $ \begin{equation} Q_{\pi} (s, a)=E_{s_{t}, a_{t}, s_{t+1}, a_{t+1}, \cdots} \left( {\sum\limits_{k=0}^T {\gamma^{k}r_{t+k} (s_{t+k}) }} \right) \end{equation} $ | (5) |

该函数表示在策略

| $ a=\underset{a\sim \pi (a\mid s)}{\mathop{\arg \max }}\,{{Q}_{\pi }}\left( {{s}_{t}},{{a}_{t}} \right) $ | (6) |

式(6) 表明智能体会在

| $ \begin{equation} J(\pi) =E_{s_{0}, a_{0}, s_{1}, \cdots } \left({\sum\limits_t^T {\gamma ^{t}r(s)}} \right) \end{equation} $ | (7) |

在Q学习中,另一个要素为设计奖励函数

| $ \begin{equation} r=\begin{cases} 1, &t_{\rm a} <10, (x_{2}, y_{2}) \in M \\ 10, & t_{\rm a} \geqslant 10, (x_{2}, y_{2}) \in M \\ f(d), & \rm{其他} \\ \end{cases} \end{equation} $ | (8) |

其中

| $ \begin{equation} M=\begin{cases} x_{G} -\dfrac{G_{{\rm w}}} {2}<x_{2} <x_{G} +\dfrac{G_{{\rm w}}} {2} \\[4pt] y_{G} -\dfrac{G_{{\rm h}}} {2}<y_{2} <y_{G} +\dfrac{G_{{\rm h}}} {2} \\ \end{cases} \end{equation} $ | (9) |

式中,

| $ \begin{equation} F=\begin{cases} \rm{True}, &r=10 \\ \rm{False}, &T^{'}=T^{'}_{\rm m} \\ \end{cases} \end{equation} $ | (10) |

式中,

| $ \begin{equation} R_{t+1} \leftarrow R_{t} +L\cdot a_{t} \end{equation} $ | (11) |

学习率的设定决定了智能体的收敛速率,学习率过大容易越过全局最优点,过小容易陷入局部最优点。通过在仿真环境中加入学习速率,能让智能体在环境中不断试错并修正自身的行动策略,从而在完成目标任务时达到自主规划和学习的效果。

4 GS-Bot机器人验证实验与仿真结果(GS-Bot experimental verification and simulation results)本节阐述GS-Bot系统可操控性验证实验和仿真实验结果。

4.1 GS-Bot机器人可操控性验证实验为验证GS-Bot机器人具有扭转和弯曲形变能力,本文通过实物原型样机实验和可视化控制界面对验证结果进行阐释。在相对理想的实验条件下,将GS-Bot机器人的基座固定在实验平台上,开启电源对SMA驱动器供电,实验过程记录了0~30 s中GS-Bot机器人的形态随时间的变化,其中4个姿态轨迹如图 6所示。

|

图 6 GS-Bot机器人实验图 Fig.6 Experimental images of GS-Bot |

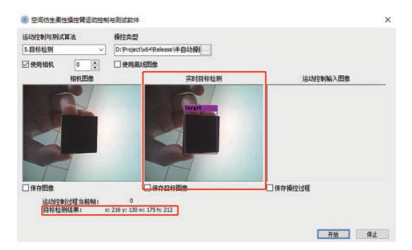

GS-Bot机器人可操控性验证实验总时长约30 s,通过高帧率图片可以发现,GS-Bot机器人的姿态改变主要集中在实验后10 s,形变趋势与图 4中SMA的形变特性相吻合。另外,将一个微型摄像机固定在机器人顶端用于观测外界环境并进行反馈,编写可视化模块对机器人进行实时状态反馈,并集成到目标检测软件中。

如图 7所示,在软件中点击“测试1号SMA”按钮并点击“开始”,可观测到1号SMA驱动器开始弯曲变形。点击“目标检测”按钮,软件图形界面即显示实时的摄像机图像,“运动控制输入图像”显示实时目标检测结果和检测信息

|

图 7 GS-Bot软件可视化界面图 Fig.7 Visual interface of GS-Bot software |

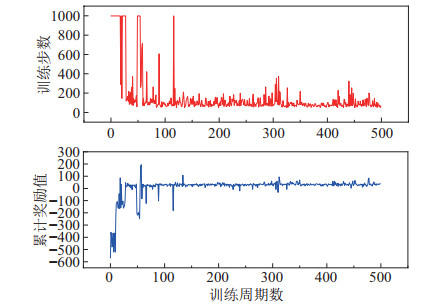

在仿真实验中,设定最大训练步数

仿真过程中机器臂运动轨迹如图 8所示,各子图分别表示机器臂在不同时刻的位置和姿态。其中图 8(a)和图 8(b)表示机器臂末端不断试探触碰蓝色目标物体,图 8(c)表示经过一定时间的探索和学习,末端在到达并停留于目标物固定时长后,结束本回合训练。智能体通过式(10) 判断当前状态是否符合回合结束的设定条件。该仿真模型还可拓展至3节或多节机器人,如图 9所示。

|

图 8 简化GS-Bot模型仿真运动示意图 Fig.8 Simulated motion diagram of the simplified GS-Bot model |

|

图 9 三节模型仿真运动示意图 Fig.9 Simulated motion diagram of the three-section model |

在实验结果中,为反映出智能体在仿真环境中的收敛趋势,本文给出了智能体在每个训练回合

|

图 10 仿真训练中奖励和训练步数曲线 Fig.10 Curves of reward and training steps in training simulation |

分别随机选取5次训练结果,定义在最大训练步数

|

|

表 1 不同隐藏层数的5次训练回合成功率 Tab. 1 Success rate after 5 rounds of training with different hidden layers |

由表 1结果可知,隐藏层单元数为1024时回合成功率最高;隐藏层单元数为128时回合成功率最低,原因是模型单元数过少,训练欠拟合;而隐藏层单元数增至2048时,将出现训练过拟合,导致效果变差。

仿真实验结果表明,基于Q学习的规划方法可使GS-Bot机器人简化模型快速学习最优策略,完成指定目标任务,并且网络隐藏层数对训练效果有一定的影响。这为软体机器人自主智能规划控制提供了一个有效思路。

5 结论(Conclusion)本文设计了一种类“尺蠖”脊椎骨关节和“蛇”躯体结构的空间仿生软体机器人GS-Bot,GS-Bot采用柔性材料镍钛SMA作为驱动器,并装配一套视觉系统与环境进行交互,SMA特殊的性质使得机器人具有更强的形变能力和更高的自由度。对GS-Bot机器人原型样机进行了可操控性验证,证明了其具有较快的形变能力和较好的可操控性。搭建了GS-Bot机器人简化结构模型,设计了一种基于Q学习的智能规划方法及其奖励函数。在仿真环境中的训练结果表明GS-Bot机器人的仿真模型能够快速收敛到最优策略,并以最优路径完成目标任务。未来将在本文的研究基础上,优化躯体结构设计与操控方法,并研究更高效的基于形状记忆合金的柔性驱动方式。

| [1] |

Kim S, Laschi C, Trimmer B. Soft robotics: A bioinspired evolution in robotics[J]. Trends in Biotechnology, 2013, 31(5): 287-294. DOI:10.1016/j.tibtech.2013.03.002 |

| [2] |

Boyraz P, Runge G, Raatz A. An overview of novel actuators for soft robotics[J]. Actuators, 2018, 7(3). DOI:10.3390/act7030048 |

| [3] |

Pfeifer R, Lungarella M, Iida F. Self-organization, embodiment, and biologically inspired robotics[J]. Science, 2007, 318(5853): 1088-1093. DOI:10.1126/science.1145803 |

| [4] |

Jing Z L, Qiao L F, Pan H, et al. An overview of the configu-ration and manipulation of soft robotics for on-orbit servicing[J]. Science China: Information Sciences, 2017, 60. DOI:10.1007/s11432-016-9033-0 |

| [5] |

Laschi C, Cianchetti M, Mazzolai B, et al. Soft robot arm inspired by the octopus advanced robotics[J]. Advanced Robotics, 2012, 26(7): 709-727. DOI:10.1163/156855312X626343 |

| [6] |

Lin H T, Leisk G G, Trimmer B. GoQBot: A caterpillar-inspired soft-bodied rolling robot[J]. Bioinspiration & Biomimetics, 2011, 6(2). DOI:10.1088/1748-3182/6/2/026007 |

| [7] |

Shepherd R F, Ilievski F, Choi W, et al. Multigait soft robot[J]. Proceedings of the National Academy Sciences of the United States of America, 2011, 108(51): 20400-20403. DOI:10.1073/pnas.1116564108 |

| [8] |

Fang H B, Zhang Y T, Wang K W. Origami-based earthworm-like locomotion robots[J]. Bioinspiration & Biomimetics, 2017, 12(6). DOI:10.1088/1748-3190/aa8448 |

| [9] |

Kim B, Park S, Jee C Y, et al. An earthworm-like locomotive mechanism for capsule endoscopes[C]//IEEE/RSJ International Conference on Intelligent Robots and Systems. Piscataway, USA: IEEE, 2005. DOI: 10.1109/IROS.2005.1545608.

|

| [10] |

Seok S, Onal C D, Wood R, et al. Peristaltic locomotion with antagonistic actuators in soft robotics[C]//IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2010. DOI: 10.1109/ROBOT.2010.5509542.

|

| [11] |

Ilievski F, Mazzeo A D, Shepherd R F, et al. Soft robotics for chemists[J]. Angewandte Chemie, 2011, 50(8): 1890-1895. DOI:10.1002/anie.201006464 |

| [12] |

Bar-Cohen Y. Electroactive polymer (EAP) actuators as artificial muscles: Reality, potential, and challenges[M]. 2nd ed. Bellingham, USA: SPIE, 2004.

|

| [13] |

Liu L W, Li J R, Lü X F, et al. Progress in constitutive theory and stability research of electroactive dielectric elastomers[J]. Scientia Sinica: Technologica, 2015, 45(5): 450-463. |

| [14] |

Lampani L, Gaudenzi P. Finite element modeling for dielectric elastomer actuators (DEA)[C]//19th International Conference on Adaptive Structures and Technologies. Piscataway, USA: IEEE, 2008: 65-83.

|

| [15] |

Daerden F, Lefeber D. Pneumatic artificial muscles: Actuators for robotics and automation[J]. European Journal of Mechanical and Environmental Engineering, 2002, 1: 11-21. |

| [16] |

Boblan I, Bannasch R, Schwenk H, et al. A human-like robot hand and arm with fluidic muscles: Biologically inspired construction and functionality[M]. Lecture Notes in Computer Science, Vol. 3139. Berlin, Germany: Springer, 2004: 160-179.

|

| [17] |

Mosadegh B, Polygerinos P, Keplinger C, et al. Pneumatic networks for soft robotics that actuate rapidly[J]. Advanced Functional Materials, 2014, 24(15): 2163-2170. |

| [18] |

Li C Q, Rahn C D. Design of continuous backbone, cable-driven robots[J]. Journal of Mechanical Design, 2002, 124(2): 265-271. |

| [19] |

Camarillo D B, Milne C F, Carlson C R, et al. Mechanics mode-ling of tendon-driven continuum manipulators[J]. IEEE Transactions on Robotics, 2008, 24(6): 1262-1273. |

| [20] |

Follador M, Cianchetti M, Arienti A, et al. A general method for the design and fabrication of shape memory alloy active spring actuators[J]. Smart Materials and Structures, 2012, 21(11). DOI:10.1088/0964-1726/21/11/115029 |

| [21] |

Redmon J, Farhadi A. YOLOv3: An incremental improvement[DB/OL]. (2018-04-08)[2020-03-21]. https://arxiv.org/abs/1804.02767.

|

2022, Vol. 44

2022, Vol. 44