人体动作预测是计算机视觉领域的经典任务,该任务通过观察输入的人体动作序列来预测未来动作序列。随着机器人技术发展逐渐成熟,大量人体动作预测算法被用在护理机器人[1]、虚拟现实等应用场景中,完成如跌倒、握手等动作的预判以及辅助人与机械臂交互[2] 等任务。

目前实现人体动作预测的方法多种多样,基于深度学习的人体运动建模方法取得了非常显著的预测效果[3-4]。随着LeNet[5]、AlexNet[6]、ResNet[7]、GoogleNet[8] 等卷积网络的提出及深度学习技术的发展,网络呈现出卷积尺度越来越丰富、深度越来越深、残差结构越来越复杂的特点。常见的人体动作预测模型,主要为基于卷积神经网络(CNN)的模型与基于图卷积网络(GCN)的预测模型。

很多工作[9-12] 都采用了图结构建模人体骨架点的空间信息。其中Zhou等[9] 设计了多尺度图卷积网络,利用各子网络分别学习了人体关节、骨骼、肢体3种不同尺度的动态特征。Lebailly等[10] 采用多路卷积网络学习人体各关节运动轨迹特征,通过图卷积网络融合特征中的全局动态规律。然而,图神经网络以节点为单位建模人体动态信息,难以充分建模人体某一关节与其他各关节之间的关联性,导致例如“行走”动作中手腕关节与距离较远的脚踝关节所存在的关联摆动没有被网络充分捕捉。因此定义合适深度的网络来覆盖所有关节点特征是利用图卷积网络对人体动作预测进行建模的难点。

仅由卷积层构成的编码-解码结构的卷积网络与包含图结构的卷积网络相比,前者在深度与参数量上更为灵活。Liu等[13] 提出的Multi-GAN构建了多个基于编码-解码结构的子GAN(生成式对抗网络),分别学习人体各肢体的动态信息,并通过对抗式训练策略利用融合特征实现动作迁移。Hernandez等[14] 通过GAN沿着时间维度对预测姿态进行填充,实现了更长时间的动作预测。其提出的编码器中采用多个残差连接并引入浅层特征,这一做法有效丰富了建模过程中的运动信息。Liu等[15] 提出的TrajectoryNet构建了多个轨迹模块逐渐提取动作序列的高维特征,然而该轨迹模块覆盖的感受野未达到最大化,在每个模块尚未完全提取人体姿态特征时就引入了浅层特征信息,削弱了网络建模能力。

ResNet[7] 是一种引入残差连接的方法。当残差为0时,它进行恒等映射(identity mapping),其网络性能不会下降;而当实际残差不为0时,它能够帮助网络学习到新的特征。文[16]从网络的前向传播和反向传播的角度分别证明残差连接有效解决了深度网络的退化及梯度消失的问题。ResNet[7] 通过增加网络深度提升网络性能,但随着网络深度增加,网络参数总量增大。Huang等[17] 提出了DenseNet并认为残差连接方式是一种特征保留方法,提出尽可能添加残差连接来最大程度丰富各卷积层的输入特征信息,达到特征重用,并取得了比ResNet[7] 更优的结果。DenseNet[17] 最大化实现了信息在网络中流动,从而提升了参数利用率,降低了参数总量。Martinez等[18] 为解决第一帧预测结果与最后一帧输入姿态之间的不连续性问题,在网络输出端通过残差连接引入了输入姿态,将网络的任务由预测人体位置信息变为预测位移差值信息,有效提高了预测精度。

本文提出一种基于编解码结构的对称残差网络(SRNet),该网络从特征重用角度,在有限深度及参数量下,设计了一种新的对称残差连接结构。本文探讨了在保持网络深度一定的情况下,如何由有限残差连接构成一个高效的、能捕捉全部空间信息的人体动作预测网络。本工作从“感受野越大,包含的信息越丰富”出发,设计了感受野最大化的对称残差连接块(symmetric residual block,SRB),该模块通过对称的首尾相连的残差连接方式,实现了高效重用浅层特征。通过对多种不同结构SRB进行测试,结果显示,感受野最大化的SRB测试效果最优。

本文完成的主要工作可概括为如下2方面:(1) 提出一种基于对称残差连接的SRB,从网络深度、特征信息重用方面考察了不同结构的SRB对关节点空间的建模能力。(2) 构建了基于2个SRB的SRNet,在保持参数量与深度基本一致的情况下取得了精度超过基准方法的预测结果。

2 对称残差网络(Symmetric residual network) 2.1 网络结构在人体动作预测任务中,网络通过对输入观察序列

|

|

表 1 符号与定义 Tab. 1 Notations and definitions |

本文提出的对称残差网络结构如图 1所示,网络的输入输出均为3D空间骨架点序列,通过2个对称残差块(SRB)所构成的编码器学习输入序列中的动态表征,每个SRB内部由11层3

|

图 1 对称残差网络 Fig.1 Symmetrical residual network |

ResNet[7]、DenseNet[17] 及本文提出的SRNet所采用的残差连接方式如图 2所示,图中为了保持恒等映射使用了短路连接(shortcut connection)表示残差连接。ResNet[7] 中多个残差连接之间采用了等跨度方式,DenseNet[17] 中多个残差连接之间采用了密集方式,本文提出的SRB残差采用首尾相连的对称连接方式。研究表明[17],如果卷积网络在靠近输入和靠近输出之间包含更短的连接,则卷积网络可以更深、更准确,训练更高效。与ResNet[7] 的等跨度连接相比,本文采用的对称残差连接使用的残差连接个数更少,输出和输入之间的距离更近,在网络末端引入了更丰富的动态信息。

|

图 2 不同的残差连接方式 Fig.2 The different residual connections |

人体动作预测中为了获得与输入尺寸相同的输出骨骼序列,并对浅层特征进行重构,SRB中采用了经过1

| $ \begin{align} \mathit{\boldsymbol{F}}_{n} =\begin{cases} {C_{n} ({\mathit{\boldsymbol{F}}_{n-1}}), } & 0<n\leqslant \dfrac{l-1}{2} \\[9pt] {C_{n} ({\mathit{\boldsymbol{F}}_{n-1} +R_{l-n+1} ({\mathit{\boldsymbol{F}}_{l-n+1}})}), } & \dfrac{l-1}{2}<n\leqslant l \end{cases} \end{align} $ | (1) |

|

图 3 SRB- |

其中

卷积深度是设计每个模块的重要因素。在卷积网络对人体动作进行建模的过程中,卷积核以时间维度为通道对骨架点位置信息进行卷积操作。为了充分建模全局空间信息,即覆盖全部关节点位置信息,卷积层的感受野应覆盖全部输入关节点,从而在特征层上给出动态信息较为明显的关节点所在位置。面对人体动作预测任务,每个SRB存在一个最优网络深度来建模人体动作信息。VGG算法[19] 中2个连续的3

本文采用MPJPE(mean per joint position error)[20] 作为训练阶段的损失函数,MPJPE是姿态估计以及动作预测等任务中常用的评价指标,损失函数如式(2) 所示。

| $ \begin{align} \mathcal{I } =\frac{1}{L \times N}\sum\limits_{l = 1}^{L} \sum\limits_{k = 1}^{N} \| \hat{{\mathit{\boldsymbol{ J }}}}_{l, k} - {{\mathit{\boldsymbol{ J }}}}_{l, k} \|^{2} \end{align} $ | (2) |

其中

在人体动作捕捉方面的公开数据集Human3.6M和CMU-Mocap上进行了人体动作预测实验。

Human3.6M数据集因包含360万个人体动作帧得名,动作种类包含走路、交谈等总计15个日常动作,由7位动作捕捉演员专业录制,本文沿用文[21]的数据处理方法,将数据集中的角度空间坐标转换为3D空间坐标,并统一将对象为S1、S5、S6、S7、S8的动作序列作为训练集样本,S9、S11的动作序列作为测试集样本。

CMU-Mocap数据集共包含了2235个人体动作序列,与Human3.6M数据集相似,均由演员专业录制,本文沿用文[21]实验设置,选取其中包括原地动作、体育运动、情感交流等8个动作种类,并采用了一致的训练集与测试集划分方式。

3.2 实验设置本文所有的模型搭建都是基于TensorFlow框架进行,训练阶段采用Adam优化器,SRB内每个3

本文使用LearnTrajDep[21]、TrajectoryNet[15]、LPJP 3D[22] 三项工作作为基准,其中LearnTraj\-Dep[21] 采用图卷积网络以时间为图节点建模人体动态信息,TrajectoryNet[15] 采用卷积网络建模人体各关节运动轨迹,并以模块堆叠的方式加深网络,本文采用了相近的网络深度与其进行对比。LPJP 3D[22] 在递归循环网络架构中引入了Transformer[23] 结构,由人体中心关节点逐步迭代建模边缘关节点位置。

3.4 实验结果 3.4.1 定量分析本节展示Human3.6M数据集以及CMU-Mocap数据集上的实验结果。

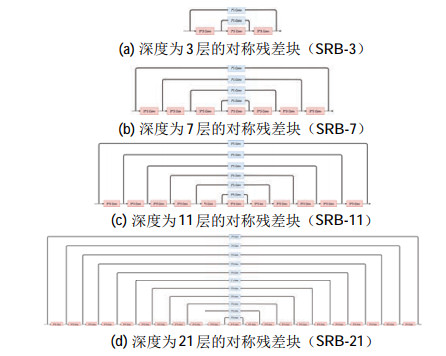

在保持SRNet网络深度不变的基础上,为验证残差连接的有效性,进行了移除残差连接实验(记为“W/O-res”)。此外,本文还设计了4种不同结构的对称残差块(SRB)进行实验,如图 4所示。其中图 4(a)(b)(c)(d) 显示了采用3、7、11、21层3

|

图 4 4种不同深度的SRB Fig.4 The 4 SRBs with different depths |

在Human3.6M数据集上15类动作的平均预测实验结果如表 2所示,由2个SRB-11构成的SRNet的短时预测平均误差最小,预测精度超过了基准方法,证明了在多个不同的对称残差块结构中,确实存在一个最优残差连接结构。实验结果显示,移除残差连接后的W/O-res网络模型预测精度差,SRB-3与TrajectoryNet的结果较为接近,而SRB-7与SRB-21相对于TrajectoryNet误差较高,故在网络深度一定的情况下(同为21层),不同结构的SRB有不同的动态信息建模能力。此外,SRB-11能取得最优结果是因为11层以上深度的卷积模块感受野最大化,可覆盖人体的全部骨架点,故各模块内部都能完整接收并提取人体动态特征;SRB-21虽然也能实现感受野最大化,但由于整体网络首尾残差连接过多,导致在网络深处引入了过多的浅层特征,网络建模的动态信息被削弱,故效果不如SRB-11。其中各模块的实际建模效果会在3.4.2节定性分析部分继续给出可视化结果并展开讨论。

|

|

表 2 在Human3.6M数据集上的短时预测结果 Tab. 2 Short-term prediction results on dataset Human3.6M |

Human3.6M数据集上的长时实验结果如表 3所示,由2个SRB-11构成的SRNet在560 ms和1000 ms时取得了最优预测结果,进一步证明了基于SRB-11的SRNet模型的有效性。去掉残差连接的W/O-res模型在560 ms和1000 ms时实验效果都不理想,而其他结构的SRB构成的网络模型与TrajectoryNet相比,在1000 ms时预测误差较大。

|

|

表 3 在Human3.6M数据集上的长时预测结果 Tab. 3 Long-term prediction results on dataset Human3.6M |

由表 4可见,由2个SRB-11构成的SRNet同样在CMU-Mocap数据集的短时预测和长时预测上取得了最优结果,体现了SRB-11的有效性以及对全局空间信息的建模能力。

|

|

表 4 在CMU-Mocap数据集上的长短时预测结果 Tab. 4 Short-term and long-term prediction results on dataset CMU-Mocap |

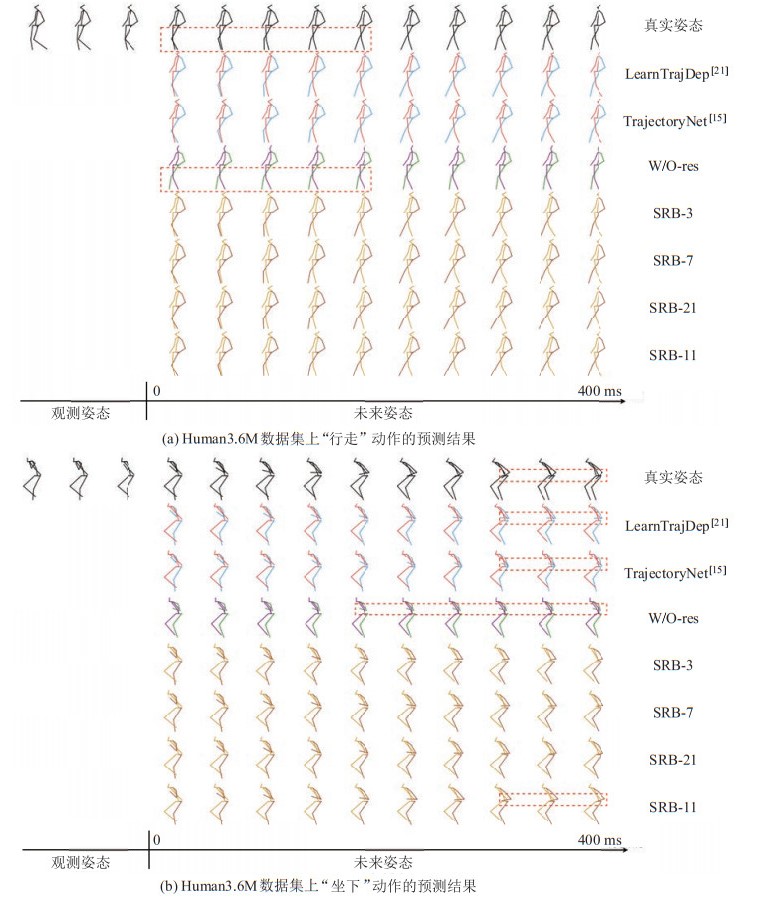

本节通过可视化的预测结果和SRB模块的特征热图开展定性分析。图 5展示了在Human3.6M数据集上对“行走”“坐下”两种动作进行预测的可视化结果,其中第1行是真实姿态,第2、3行是基准方法的结果,第4行是W/O-res网络的结果,最后4行是4种SRB的结果,其中SRB-11取得最优预测结果。由图 5(a) 可见,不同结构的SRB对动态规律较简单的“行走”动作的预测结果与基准方法相比并没有较大差异,但移除残差连接的网络输出的是完全静止的序列,腿部与真实姿态有较大差异,说明残差连接有效传递了人体的动态信息。

|

图 5 预测结果可视化 Fig.5 Visualization of prediction results |

如图 5(b) 所示,由2个SRB-11构成的SRNet对“坐下”动作的手部活动敏感。在“坐下”动作的真实序列中,其主要特点在于人体小臂在腰部存在上下伸展,SRB-11预测的伸展幅度最接近真实序列。可证明由2个SRB-11构成的SRNet捕捉到了更多肢体末端的动态信息,即有效建模了人体全局空间信息。此外,由SRB-3、SRB-7、SRB-21构成的SRNet的预测结果尽管细节上表现不如由2个SRB-11构成的SRNet,但也取得了不错的预测效果。而W/O-res输出为静止序列,再次验证了在编码器中,残差连接可以多尺度地引入浅层模块建模的动态信息,丰富人体局部与全局的动态特征。

图 6为各SRB-11模块在“行走”动作实验时输出的热图。图中纵坐标代表人体的22个骨骼关节点,参考TrajectoryNet[15] 的骨架排列方式,第14~21关节代表人体双腿,横坐标代表隐含层3D特征,实验中隐含层通道数设为64,故横坐标长度为64

|

图 6 “行走”动作实验中SRB-11输出的热图,其中第2个SRB-11提取到更清晰的腿部动态特征(关节14~21) Fig.6 The heatmap of the output using SRB-11 in the "walking" action, and the 2nd SRB-11 extracts clearer dynamic features of the legs (joint 14 |

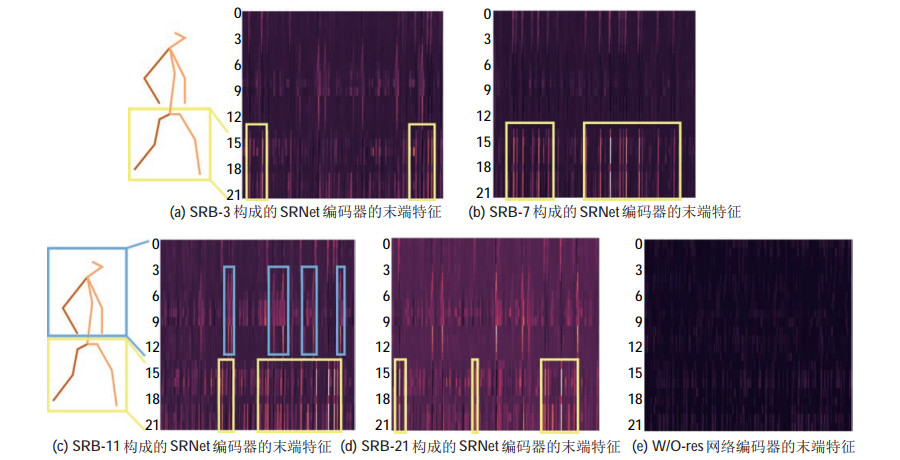

图 7显示了不同结构的SRB构成的SRNet编码器输出特征热图。不难看出,SRB-7与SRB-11构成的编码器均提取到了较丰富的腿部动态信息,如图 7(b)(c) 所示。然而由SRB-7构成的编码器的输出特征缺失了手臂的动态信息,这是因为SRB-7中最后1个卷积层的感受野最大仅为15

|

图 7 提出的4种基于SRB的SRNet以及W/O-res网络的编码器末端特征热图 Fig.7 The encoder end feature heatmap of the 4 proposed SRB-based SRNets and W/O-res net |

从事人体动作预测的网络模型在深度、连接方法以及特征尺度上多种多样,本文对不同残差连接方式构成的人体动作预测网络进行了建模和测试,提出了基于感受野最大化的对称残差建模模块SRB-11。该模块在结构上采用数量最多的首尾相连的残差连接来传递浅层特征,充分利用了人体全局空间信息。实验结果表明,由2个SRB-11构成的SRNet在人体动作预测中取得了最低的预测误差,具有最优的建模能力。

| [1] |

刘今越, 李顺达, 陈梦倩, 等. 面向移乘搬运护理机器人的人体姿态视觉识别[J]. 机器人, 2019, 41(5): 601-608. Liu J Y, Li S D, Chen M Q, et al. Visual recognition of human pose for the transfer-care assistant robot[J]. Robot, 2019, 41(5): 601-608. |

| [2] |

林安迪, 干旻峰, 葛涵, 等. 基于模糊模型参考学习控制的手术机器人人机交互[J]. 机器人, 2019, 41(4): 543-550. Lin A D, Gan M F, Ge H, et al. Human-robot interaction for surgical robot based on fuzzy model reference learning control[J]. Robot, 2019, 41(4): 543-550. |

| [3] |

马淼, 李贻斌. 基于多级动态模型的2维人体姿态估计[J]. 机器人, 2016, 38(5): 578-587. Ma M, Li Y B. 2D human pose estimation using multi-level dynamic model[J]. Robot, 2016, 38(5): 578-587. |

| [4] |

谭嘉崴, 丁其川, 白忠玉. 基于视频帧连贯信息的3维人体姿势优化估计方法[J]. 机器人, 2021, 43(1): 9-16. Tan J W, Ding Q C, Bai Z Y. Optimal estimation method of 3-dimensional human pose based on video frame coherent information[J]. Robot, 2021, 43(1): 9-16. |

| [5] |

Lecun Y, Bottou L, Bengio Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324. DOI:10.1109/5.726791 |

| [6] |

Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[C]//25th International Conference on Neural Information Processing Systems, Vol. 1. New York, USA: ACM, 2012: 1097-1105.

|

| [7] |

He K M, Zhang X Y, Ren S Q, et al. Deep residual learning for image recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2016: 770-778.

|

| [8] |

Szegedy C, Liu W, Jia Y Q, et al. Going deeper with convolutions[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2015: 1-9.

|

| [9] |

Zhou H H, Guo C L, Zhang H, et al. Learning multiscale correlations for human motion prediction[DB/OL]. (2021-05-19)[2021-07-12]. https://arxiv.org/pdf/2103.10674.pdf.

|

| [10] |

Lebailly T, Kiciroglu S, Salzmann M, et al. Motion prediction using temporal inception module[M]//Lecture Notes in Computer Science, Vol. 12623. Berlin, Germany: Springer, 2020: 651-665.

|

| [11] |

Li B, Tian J, Zhang Z F, et al. Multitask non-autoregressive model for human motion prediction[J]. IEEE Transactions on Image Processing, 2020, 30: 2562-2574. |

| [12] |

Li M S, Chen S H, Zhao Y H, et al. Dynamic multiscale graph neural networks for 3D skeleton based human motion prediction[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2020: 211-220.

|

| [13] |

Liu Z G, Lyu K, Wu S, et al. Aggregated multi-GANs for controlled 3D human motion prediction[DB/OL]. (2021-03-17)[2021-03-23]. https://arxiv.org/abs/2103.09755.

|

| [14] |

Hernandez A, Gall J, Moreno F. Human motion prediction via spatio-temporal inpainting[C]//IEEE/CVF International Conference on Computer Vision. Piscataway, USA: IEEE, 2019: 7133-7142.

|

| [15] |

Liu X L, Yin J Q, Liu J, et al. TrajectoryCNN: A new spatio-temporal feature learning network for human motion prediction[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2021, 31(6): 2133-2146. DOI:10.1109/TCSVT.2020.3021409 |

| [16] |

He K M, Zhang X Y, Ren S Q, et al. Identity mappings in deep residual networks[M]//Lecture Notes in Computer Science, Vol. 9908. Berlin, Germany: Springer, 2016: 630-645.

|

| [17] |

Huang G, Liu Z, van der Maaten L, et al. Densely connected convolutional networks[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2017: 2261-2269.

|

| [18] |

Martinez J, Black M J, Romero J. On human motion prediction using recurrent neural networks[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2017: 4674-4683.

|

| [19] |

Karen S, Andrew Z. Very deep convolutional networks for large-scale image recognition[DB/OL]. (2015-04-10)[2020-10-20]. https://arxiv.org/abs/1409.1556.

|

| [20] |

Ionescu C, Papava D, Olaru V, et al. Human3.6M: Large scale datasets and predictive methods for 3D human sensing in natural environments[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 36(7): 1325-1339. DOI:10.1109/TPAMI.2013.248 |

| [21] |

Mao W, Liu M, Salzmann M, et al. Learning trajectory dependencies for human motion prediction[C]//IEEE/CVF International Conference on Computer Vision. Piscataway, USA: IEEE, 2019: 9488-9496.

|

| [22] |

Cai Y J, Huang L, Wang Y W, et al. Learning progressive joint propagation for human motion prediction[M]//Lecture Notes in Computer Science, Vol. 12352. Berlin, Germany: Springer, 2020: 226-242.

|

| [23] |

Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[C]//31st International Conference on Neural Information Processing Systems. New York, USA: ACM, 2017: 6000-6010.

|

2022, Vol. 44

2022, Vol. 44