2. 中国科学院自动化研究所复杂系统管理与控制国家重点实验室, 北京 100190

2. State Key Laboratory of Management and Control for Complex Systems, Institute of Automation, Chinese Academy of Sciences, Beijing 100190, China

海洋蕴藏有丰富的生物与矿产资源,是人类经济社会发展的动力源泉,同时攸关国家战略安全[1]。近年来,遥控式水下机器人(remotely operated vehicle,ROV)和自主式水下机器人(autonomous underwater vehicle,AUV)的不断涌现[2-3]为人类探索海洋、开发海洋、经略海洋开辟了全新途径[4]。随着人类对海洋探索与开发的不断深入,诸如海底观测站部署与维护、海底管道电缆监视与检修、海底矿藏调查与采样、海底遗失物搜寻与打捞、海底古迹测绘与重建等任务对水下机器人的智能作业能力提出了更高的要求[5-6]。其中,高效的水下环境感知能力是实现水下机器人自主运动与智能作业的关键所在[7]。

目前,根据基础传感设备的不同,水下环境感知的方法可分为两大类,即水下声学环境感知与水下视觉环境感知[9]。其中,水下声学环境感知主要利用声呐等设备,对水下声波信息进行接收与处理,生成声呐图像,进而实现水下远距离目标的定位与探测[10]。特别地,水下机器人作业主要依靠近距离环境信息,对感知的实时性与精细度要求较高,因而水下视觉环境感知技术在水下机器人作业领域有着声学环境感知不可比拟的优势。总体而言,与水下声学环境感知相比,水下视觉环境感知在水下机器人近距离作业方面的优势可归纳为如下3点:(1) 设备价廉小巧:与声呐相比,一般的可见光传感设备(如摄像机等)往往价格低廉且体积较小,通过防水处理后可在几乎不增加机器人本体运载负担的前提下实现水下视觉环境感知。(2) 感知反馈迅速:由于光的传播速度远远高于声波,视觉传感设备可以更加实时地获取水下环境信息。(3) 视觉信息精细:与声学传感设备相比,视觉传感器不受反射噪声的干扰,图像细节丰富,所生成的图像符合人眼观测习惯,便于利用人工智能的方法进行深层次的分析与处理。

在实际应用方面,王晓鸣等[11]以“观海ROV”为载体,利用单目视觉进行水下位姿测量,在干扰环境下,使机器人与作业对象保持相对稳定;周浩等[12]设计了一种海生物吸纳式水下机器人,基于深度神经网络算法对海底作业目标进行实时检测,并可采用视觉伺服控制实现自主海洋生物吸纳作业;Li等[13]利用快速区域卷积神经网络(Fast R-CNN)提取鱼的深度特征信息,实现了鱼类的精准识别;Sun等[14]对多个摄像头拍摄的游鱼图像进行加速鲁棒特征(speeded up robust feature,SURF)分析,并根据鱼类的外表差异构建分类模型,最终实现了对游鱼的分类跟踪;Chen等[15]设计了一种双重改良网络,实现了水下时序目标的精准实时检测,并将该网络成功应用于水下软体机械臂自主目标抓取。由上述应用实例可知,水下视觉环境感知技术已逐渐成为人类探索海洋世界不可或缺的重要利器之一[16]。

2 水下视觉环境感知的共性问题(General problems of underwater visual perception)由于水下环境复杂多样,水下视觉成像会受到各种不利因素的影响因而降低质量[17]。需要特别指出的是,视觉图像退化与折射畸变是水下视觉成像中两大突出的共性问题。其中,图像退化会导致水下图像色彩失真、特征信息模糊、感兴趣区域细节缺失等问题[18],而折射畸变会直接降低水下3维位置测量的精度[19],同时缩减有效的视野面积。下文将对两大水下环境感知共性问题的成因和影响展开详细介绍。

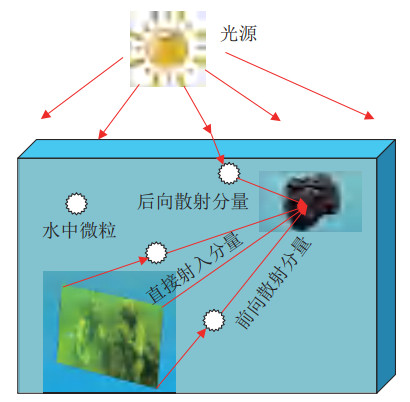

2.1 水下成像模型与视觉退化原理自然水体是一种溶质非常复杂的混合物,通常包含有大量的悬浮物和有机混合物[20]。当光线在水中传播时,一方面会受到水体的吸收作用而发生能量损失,另一方面会因为微粒和杂质的散射而发生小角度的偏转现象[21]。最终,在两者共同作用下光线将产生强烈的衰减。根据Jaffe-McGlamery提出的图像生成模型(image formation model,IFM),如图 1所示,到达相机的光是由直接射入、前向散射以及后向散射三部分的光线通过线性叠加而成[22],具体表达形式为

| $ \begin{align*} A_{\rm T}^{c} (x, y)=A_{\rm d}^{c} (x, y)+A_{\rm f}^{c} (x, y)+A_{\rm b}^{c} (x, y), \; c\in \{{\rm R, G, B}\} \end{align*} $ |

|

图 1 水下成像模型示意图 Fig.1 Schematic of the underwater image formation model |

式中,

具体地,直接射入分量的光强可以由如下衰减形式表示:

| $ \begin{align*} A_{\rm d}^{c} (x, y)=A^{c}(x, y){\rm e}^{-a(c)d(x, y)} \end{align*} $ |

式中,

另外,后向散射分量的光强表达形式为

| $ \begin{align*} A_{\rm b}^{c} (x, y)=J_{\infty} (c)(1-{\rm e}^{-a(c)d(x, y)}) \end{align*} $ |

式中,

通过上述分析可知,光在水中传播时,吸收作用会导致直接摄入分量的衰减,使得水下图像颜色失真;而散射现象将会使采集的水下图像模糊与雾化[23]。因此,水下图像存在色彩失真与模糊雾化等质量退化现象,从而导致图像信息缺失严重,难以进行后续的特征提取与目标检测流程。

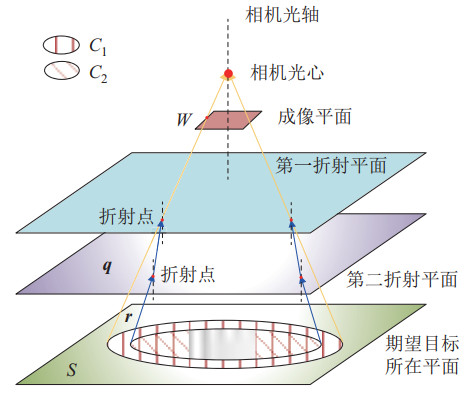

2.2 水下成像中的折射畸变在水下环境中使用相机时,一般将相机置于防水舱内,由于防水舱表面、空气、水3种介质的折射率不同,光线从目标物体到达相机光心时会发生两次折射[24],如图 2所示。经分析可知,直接利用未考虑折射效应的经典小孔成像相机模型,可计算出成像平面边界点

|

图 2 水下相机成像过程中的折射畸变 Fig.2 Refractive distortion in underwater camera imaging |

此外,假设期望目标在与相机光轴垂直的平面

水下机器人面临两种最主要的视觉退化问题,一是由于光在水环境中传播所导致的静态图像颜色失真与对比度低的问题[25],二是由于机器人自身运动导致的视觉抖动问题。针对以上两种退化问题,分别延伸出水下视觉质量恢复方法与水下视觉增稳方法。

3.1 水下视觉质量恢复方法水下视觉质量恢复主要包括基于图像生成模型的方法、基于信息融合的方法以及基于对抗学习的方法。

3.1.1 基于图像生成模型的方法根据2.1节所描述的IFM模型,可以利用退化后的光强信息对目标光强信息进行求解,从而恢复水下视觉质量[26-27]。在这一过程中,BL与TM函数发挥了关键性的作用,但却难以通过常规手段直接测量,因而延伸出了一系列的估计方法。

暗通道先验(dark channel prior,DCP)是一种常用的估计方法[28-29]。根据DCP理论,BL可由暗通道中亮度前0.1% 的像素的集合表示,且对于无雾化的图像,TM函数值可认定为1。然而基于DCP理论的恢复方法极易受光照条件影响。为此,Peng等[30]基于光吸收与图像模糊理论,提出了一套水下图像质量恢复方法用于深度估计。汤忠强等[31]在传统DCP理论的基础上,增加了自适应比例因子选择策略,提高了图像的对比度,并采用颜色校正方法消除残余色偏,提升了图像恢复后的整体亮度。Li等[32]基于IFM模型提出了一套水下图像去雾以及对比度增强的算法,为了消除噪声对BL的影响,采用四叉树方法对BL进行分层估计;为了最小化信息损失,采用R通道局部图像块对TM函数进行估计。针对水下图像颜色失真的问题,Chiang等[33]提出了一种波长补偿与去雾算法,通过建立深度图进行水下图像的背景分割,在减轻色散的同时实现了色彩平衡。此外,借助神经网络强大的数据拟合能力,Shin等[34]利用卷积神经网络同时估计BL和TM函数,实现水下图像去雾。整体而言,基于IFM模型的方法理论性强,但是由于参数估计的复杂性,此类方法的环境适应能力普遍较弱[35-37]。

3.1.2 基于信息融合的方法基于信息融合的图像质量恢复方法不需要图像生成模型与水下场景的结构信息。此类方法以退化的水下图像为基础,通过派生出的一系列输入图与权重图进行图像质量的恢复[38-40]。Ancuti等[38]以退化图像的噪声抑制与白平衡版本为输入图,并设计了拉普拉斯对比度、局部对比度、显著性、曝光量等权重,最终以加权求和的方式实现水下图像的恢复。这类方法对信息融合的权重十分敏感,环境适应能力较差。此外,图像派生与权重图的计算复杂度较高,使其难以实现真实场景下的实时推理。

3.1.3 基于对抗学习的方法近年来,深度学习与对抗学习已广泛应用于各类图像生成任务中。部分学者开始尝试利用对抗生成网络处理水下图像数据。针对水下图像的去噪样本难以直接获取的问题,Li等[41]设计了WaterGAN,利用包含深度信息的自然图像生成大量的具备水下属性的合成图像样本,进而利用合成数据训练颜色修正与深度估计网络用于平衡水下图像的颜色。针对水下图像的颜色修正问题,相关学者提出了一种弱监督的对抗生成方法,并设计了结构相似性损失函数用于保存图像内容[42-43]。Chen等[44]提出了一种基于对抗评价学习的水下图像恢复框架GAN-RS,该框架使用多个判别器来指导生成器,在保存图像内容的同时有效抑制了水下噪声;进一步地,将暗通道相似度损失与多阶段损失策略应用到对抗-评价训练过程中,实现了实时自适应的水下视觉质量恢复。

3.2 水下视觉增稳方法水下机器人的视觉抖动是外界水流干扰与自主运动共同作用的结果。常见的视觉增稳方法包括机械增稳和电子增稳两大类。

机械增稳方法根据运动测量信息利用各类机械装置稳定整体相机平台。搭建云台系统是最典型的机械增稳手段。Sagara等[45]针对水下目标的测量追踪问题,设计了一种适用于双目视觉的4自由度云台。不同于螺旋桨推进的水下航行器,仿生机器鱼的视觉抖动问题具有明显的周期性特征。为此,文[46-47]先后提出了单自由度与2自由度的伺服云台系统,用于减缓机器鱼的节律性运动所带来的视觉抖动问题。

电子增稳方法广泛应用于各类水上视觉系统中,与之相关的水下应用研究相对较少。Pan等[48]基于改进的LADRC(linear active disturbance rejection control)控制器,提出了一种单自由度云台与惯性测量单元(IMU)结合的机械电子混合增稳方法,用于增强仿生机器鲨鱼的视觉稳定性。

4 水下3维视觉感知(Underwater 3D visual perception)水下3维视觉感知在水下目标3维位置测量与水下感兴趣场景数字重建等方面应用广泛。水下3维视觉感知包括水下相机标定、基于结构光的水下3维数据获取以及水下视觉同时定位与建图(SLAM)等。特别指出,克服水下折射畸变造成的测量不准确问题是各项水下3维视觉感知技术需解决的关键问题之一。

4.1 水下相机标定通过对水下相机标定方法的探究,可以洞悉水下场景中图像坐标系与世界坐标系之间的复杂映射关系[49]。同时,标定后的水下相机可为水下3维定位与重建提供可靠的测量数据[50-51]。一些研究人员不考虑水下折射畸变的影响,直接将空气中的小孔成像模型应用于水下。例如,Sánchez-Ferreira等[52]在不考虑折射影响的前提下进行了水下3维重建,实验结果显示忽略折射的影响会产生很大的测量偏差。针对折射引起成像畸变的问题,相关领域研究人员大致提出了5类水下相机标定方法,各方法的特点如表 1所示。第1类方法为物理辅助法,通过设计一个特殊的光学部件,将相机的透镜成像中心转移到发生折射的平面处,即水下相机的防水外壳处,然后通过光学部件的特殊形状抵消发生的折射现象[53-54];第2类方法为辅助平面相机标定法,通过增加一个辅助标定板来确定光线入射前的方向向量,利用这一增加的已知量对相机参数进行标定[55];第3类方法为焦距补偿折射法,假设入射光线延长线与成像平面的交点和折射后光线与光轴的交点相同,那么相机成像平面会发生后移,这相当于拉长了相机焦距,根据斯涅耳折射定律,可以计算出相机焦距变化情况与入射角度的关系[56];第4类方法为折射吸收法,将折射产生的像素偏移误差近似看作由镜头本身畸变产生的误差,通过标定出摄像机的畸变参数并对图像进行矫正操作来消除折射带来的影响[57-58];第5类方法为几何折射校正法,通过几何分析,建立水下折射成像模型,将折射影响显式地展现出来,从理论层面保证了标定方法的精准性[59-68]。

|

|

表 1 常见的水下相机标定方法 Tab. 1 Mainstream calibration methods for underwater cameras |

具体地,作为第5类方法的先驱性工作,Li等[59]在对水下成像过程进行定量摄影几何分析的基础上,提出了两阶段水下相机标定法。Treibitz等[60]基于成像平面与折射平面平行的一般性假设,以单次折射的水下成像过程为例进行分析,确定了有利于改进水下相机测量精度的标定参数。Jordt-Sedlazeck等[61]基于优化的思想对折射平面的法向量以及距离相机中心的距离等重点参数进行标定,但是该方法需要提前赋予合适的初始值;此外,该团队还提出了一种基于合成分析方法的演化计算方法,来标定水下光学传播模型参数[62]。Agrawal等[63]对多层介质条件下的多次折射成像过程进行了分析与建模,并且将第5类算法用于求取各介质折射率、每层折射平面的法向量、第1层折射平面距离相机中心的距离等参数。该方法由于模型复杂、计算过程繁琐,不适用于机器人平台。Chen等[64]提出了一种用于双目水下相机的标定方法,该方法利用由同一目标点进入双目相机的两条入射光线在同一平面上的几何特征,通过3维点重映射的方法对待标定参数进行优化。Yau等[65]提出了一种基于不同频率光线折射率相异原理的方法对水下相机进行标定,该方法设计了一种可以主动发出2种不同频率光线的标定板,通过计算标定板在同一位置发出的不同频率光线在成像平面上成像位置的偏移量,标定出了水下相机的参数。然而,该标定方法所使用的标定板造价昂贵,应用范围受到了限制。Telem等[66]在几何折射校正方法的基础上,提出了透视中心移位和虚拟投影中心方法对水下相机进行标定。Dolereit等[67]采用虚拟目标点的方法对水下相机进行标定,为第5类方法提供了新思路。为了消除水下球面折射引起的测量误差,Qiu等[68]借助综合几何球面折射模型,提出了一种基于先进的非支配排序遗传算法的水下标定算法,将所提标定算法与柔性云台相机结合,大大提高了水下环境感知和视觉测量的性能。

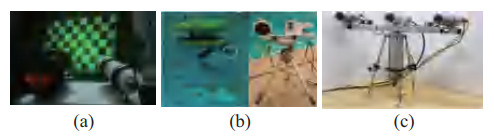

4.2 基于结构光的水下3维数据获取激光与相机结合组成的结构光系统经常应用于水下3维数据获取[69]。如图 3(a)所示,激光按照一定的模式投射在被测目标物体表面,在其表面上形成由被测物体表面形状所调制的3维光条图像;相机采集该3维图像,形成畸变的2维光条图像。基于光学三角法测量原理,当激光发射器与相机的相对位置关系确定时,利用畸变的2维光条图像便可重现物体表面的3维轮廓[70]。基于激光的结构光测量系统的优越性主要体现在如下两个方面[71]:一方面,激光作为单色光,可通过设置其颜色来减弱水体对光线的吸收作用,进而保持较高的成像清晰度;另一方面,由于激光在水体中的照明体积较小,与连续光照明和闪光灯相比,散射程度较低,因此成像质量较高。

|

图 3 水下结构光成像设备 Fig.3 Underwater structured light imaging equipment |

Bleier等[72]设计了一种十字线激光扫描仪,其中相机可捕获激光投影的十字线并通过射线平面三角测量的方法计算出3D点云。Palomer等[73]设计了一种激光发射器可旋转的水下场景扫描传感器,其中步进电机使激光发射器在视场中快速旋转,实现短耗时的水下3D场景重建。Massot-Campos等[69]设计了一种模块化的基于激光的水下结构光系统,可在高浊度条件下进行水下近距离3维重建。由于水下折射畸变的存在,激光会发生两次折射,无法用平面方程来描述激光平面。为此,Palomer等[74]将激光平面表示为椭圆锥,并通过射线锥三角测量方法获得了更高的3D重建精度,最终将设计的激光扫描仪安装在水下机器人上服务于水下抓取作业,如图 3(b)所示。类似地,Gu等[75]对介质中的折射影响进行显式建模,并基于此设计了相应的水下结构光传感系统,如图 3(c)所示,最终实现了高精度的3D重建性能。

4.3 水下视觉SLAMSLAM能够同时估计机器人位姿和重建3D场景结构。由于水下环境存在复杂的影响因素(例如,散射、吸收、浑浊和折射等),水下视觉SLAM是一个极具挑战性的技术问题[76]。为方便科研人员开展水下视觉SLAM的技术研究,Ferrera等[77]为水下视觉SLAM任务制作了多个水下数据集,其中的参考轨迹由基于运动的3维重建(structure from motion,SfM)方法生成。近年来,针对水下视觉SLAM中的主要技术问题,涌现出了许多颇具价值的研究工作。

Amarasinghe等[78]侧重于应对水下环境浑浊度高且动态多变的复杂挑战,在SLAM算法框架的前端增加了一系列图像预处理机制,其中包括关键帧优化校正、混合特征描述算子以及帧间特征跟踪策略。该方法在水下数据集中进行了测试,结果表明改进后的方法在轨迹定位精度方面提升了5%~10%。

Burguera等[79]为提升水下视觉SLAM算法的鲁棒性,提出了一种基于轨迹的多区段视觉SLAM及地图连接方法。该方法在前端实现了区段间和区段内的循环回环检测搜索,在后端实现了单次和全局的综合优化,并通过在地中海进行成规模的实验,验证了该方法的鲁棒性。

针对水下视觉SLAM中相机成像畸变的问题,张阳等[80]分析了水下机器人相机成像的畸变原理,构建了纠正模型来计算畸变系数,最终获得了准确的像素坐标。实验结果表明,使用当前实验水体标定所得的畸变系数可以在该水体中实现精准定位与建图。

针对水下环境复杂、非结构化的特点,结合水下3维激光与3维视觉可提升目标定位精度与地图恢复质量[81]。Fan等[82]提出了一种将水下相机成像与水下激光三角测量相结合以提高水下光学3维重建性能的方案。首先,采用水下激光三角测量值作为参考,用于校正由非均匀近距离照明引起的全局表面形状失真;其次,使用水下相机折射模型来消除非线性折射失真;再次,设计了一套结合水下相机与水下激光的设备,用于3维海床重建。实验结果表明,所提方法能够在水下环境中得到准确的3维重建结果。

在实际应用中,利用ROV和AUV实现水下大规模长航时的视觉SLAM困难重重[83]。其原因在于,在负载能力受限的水下机器人上,有限的电池容量和硬件计算能力分别制约了机器人的续航能力和数据处理能力。为应对上述问题,单机器人多次SLAM和多机器人多次SLAM等工作方式应运而生。其中,回环检测是必不可少的技术环节。Burguera等[84]针对水下回环检测中有效数据少、传输带宽受限等问题,提出了一种基于无监督学习的神经网络回环检测候选图像生成方法。该方法利用全局描述子之间的相互比较减轻了视觉回环检测固有的计算负担,同时利用存储量远小于图像信息的编码技术降低了多机器人传输时的带宽需求,并最终实现了鲁棒的回环检测。该方法在收集于马略卡岛附近海域的真实水下数据集中进行了测试,结果表明该方法可以应用于实际的水下视觉SLAM中。

5 水下机器人视野增强方法(Visual field enhancement methods for underwater robots)折射带来的另一视觉感知问题便是水下视场角的缩窄。这大大限制了普通光学相机在水下的感知范围。而目前主要通过两类方法来应对这一问题。一是采用多相机系统进行水下图像拼接,二是采用具有极端超广角能力的鱼眼镜头。

5.1 基于多相机系统与图像拼接的视野增强方法Alay等[85]对于水下多相机系统进行了系统性的研究。他们首先解决了水下场景中多相机的设计与标定问题,而后提出了一种多相机图像的在线拼接方法,最后面向实际水下场景,将该多相机系统成功应用于高精度的水下目标位姿估计中。为扩大水下机器人的视觉操作范围,Qiu等[68]设计了一种紧凑型线牵驱动的双目相机云台。针对水下球面折射问题,他们提出了一套基于改进的排序遗传算法的相机标定方案。Bosch等[86]基于商用的陆上六相机系统,提出了一套面向水下场景的标定方案,用于同时处理广角镜头与无重叠图像。此外,针对折射所带来的针孔相机模型失效问题,提出了一种光线追踪方法,用以创建水下相机的视场模拟器。Jiang等[87]为实现水下清洁机器人的全景导航,建立了六相机系统的转换矩阵库,提出了一种高效的图像融合方案。为消除多相机系统的视差效应,提升图像拼接效率,Li等[88]提出了一种自适应的多相机转换矩阵搜索方法,实现了高效的实时图像拼接。多相机系统在很大程度上缓解了水下视场缩窄的问题,但相机数量的增加势必带来成本上升及安装空间增大。

部分学者致力于利用单相机系统进行多视角的水下图像拼接以增大水下机器人的视觉感知面积[89-90]。Sheng等[91]构建了一种级联神经网络框架以实现水下全景图像拼接。首先,利用基于对称卷积与逆卷积的神经网络实现水下图像增强;其次,提出了一种基于VGGNet-16框架的改进卷积神经网络随机抽样一致性(RANSAC)方法,以生成精度更高的图像匹配特征点;再次,利用基于拉普拉斯金字塔的融合方法,消除人工拼接痕迹,优化拼接缝位置。实验结果表明,所提框架可还原水下图像的颜色和细节信息,并为水下序列图像拼接生成足够多可靠的匹配特征点。Jatmiko等[92]设计了一种用于水下图像拼接性能评价的二元鲁棒不变可扩展关键点(BRISK)机制,以应对由运动模糊和曝光不足等现象引起的图像特征缺乏以及图像噪声的挑战。基于该机制制定了一种鲁棒的水下图像拼接算法,由获取图像帧、使用BRISK获取关键点、使用RANSAC进行特征匹配、单应性估计和透视扭曲等阶段组成。实验结果表明该算法在可检测关键点较少的条件下能够实现水下图像匹配拼接。

5.2 基于鱼眼相机的视野增强方法区别于普通光学相机,鱼眼相机凭借其紧凑的布局以及出色的超广角能力,正越来越多地应用于各类机器人系统中,以扩大其视觉感知范围。

5.2.1 鱼眼相机原理现代绝大多数相机采用透镜系统,遵循着基本的“相似成像”原则[93]。“相似成像”较好地保持了景物的相对位置关系,符合人类直觉,但难以覆盖较大的视野范围。普通超广角镜头也只能记录中间视角,且边缘处存在较大变形。

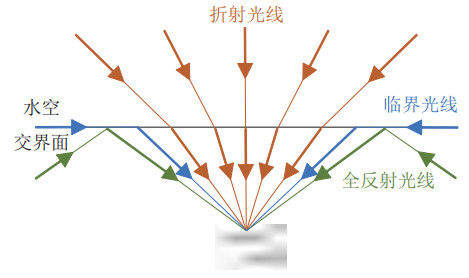

注意到多数鱼类是高度近视,却可以感知水面上近乎180

|

图 4 斯涅耳窗口原理示意图 Fig.4 Illustration of Snell's law of window |

普通相机基于针孔相机模型,遵从射影变换与相似成像原则。鱼眼相机为了将尽可能大的场景投影到有限的平面内,允许畸变的存在,并按照一定的投影函数设计。常用的投影函数模型包括4种:等距投影模型、等立体角投影模型、正交投影模型及体视投影模型[95]。与此同时,需要对鱼眼图像进行校正,去除失真以满足实际应用的需要。常用的矫正方法包括基于球面投影、抛物面投影、对数极限等模型的矫正算法以及基于射影不变性和透视投影的矫正算法[96]。

5.2.2 基于鱼眼相机的机器人成像应用基于鱼眼相机的水上环境感知的研究已较为成熟。这类研究多依托于无人车以及无人机平台。研究内容从简单的深度估计、避障任务到复杂的建图、定位、视觉里程计以及完整的SLAM系统都有涉及。研究方法涵盖了传统的基于投影模型的方法以及新型的基于深度学习的端到端方法[97-99]。值得注意的是,与传统的自动驾驶数据集类似,目前已经出现了基于多鱼眼镜头的自动驾驶数据集WoodScape[100]。

鱼眼镜头在水下场景中的应用研究则相对较少。目前仅有少数ROV和AUV平台搭载了鱼眼相机系统。Berlinger等[101]基于鱼眼视觉感知,对机器鱼的3维集群行为进行了研究。Billings等[102]基于鱼眼相机提出了一种自适应感兴趣区域的水下目标6维姿态估计方法,并贡献了水下鱼眼图像数据集UWHandles,其中收集了具有6维相机姿态及2维边界框标注的水下自然环境图像。Sakamoto等[103]利用立体鱼眼视觉和固定标记,提出了一种液体折射率的估计方法。Meng等[104]开发了一套水下无人机系统,搭载了一对鱼眼相机,并基于深度学习进行鱼类识别,达到了87% 的识别精度。另外,可进行水下7000 m作业的日本KAIKO系列ROV也搭载了鱼眼视觉系统[105]。

尽管鱼眼相机仍面临水下视场缩窄的问题,但相较于普通镜头,其在水下场景中的视野已经得到了极大的提升,同时大大减少了相机的使用数量,具有十分广阔的应用前景。

6 未来研究趋势(Future research tendency)通过对水下视觉环境感知方法的总结分析,本文展望水下视觉环境感知技术研究趋势为:

(1) 水下视觉算法与光学传感器的一体化深度融合

水下光学环境的特殊性给水下视觉环境感知带来了一系列挑战性问题,而当前的解决方案多依赖于软件层面复杂耗时的图像后处理操作。为此,针对水下环境感知的共性问题,利用FPGA(现场可编程门阵列)等技术将光学传感器与水下视觉算法进行硬件层面的一体化深度融合,有望节省机器人通用处理器的计算资源,大大增强水下视觉感知计算的实时性,从而提升水下机器人系统的工作效率。

(2) 基于水下多机器人系统的集群视觉感知

面对单机器人难以胜任的复杂任务,多机器人系统的研究受到愈加广泛的关注。而复杂多变的水下环境不仅对多机器人的运动能力带来了极大干扰,还严重影响其视觉感知能力。如何利用分布式的视觉信息,指导水下机器人完成灵活高效的协同建图、搜索、追踪等任务具有重要的研究意义与广阔的应用前景。

(3) 多模态信息融合的水下环境感知研究

在水下环境中,视觉传感器的优势在于可以获取细致的局部纹理信息,但对于光条件敏感且探测范围有限。而声呐系统方向性强,能量集中,可以获得粗粒度的远距离信息。此外,压力、温度等传感器都对水下环境进行了不同维度的描绘。借助机器人的多传感器系统,进行水下多模态信息融合研究,有利于提高整体的环境认知与决策能力,助力水下机器人完成各类智能化作业。

(4) 面向水空跨介质机器人的自适应视觉感知

水空跨介质机器人可自主调整构形以适应不同介质环境(水环境和空气环境),是实现多维态势感知、立体空间信息交互的重要工具。除机械构型与运动控制的多介质适应能力以外,水空跨介质机器人应当具有适应介质变化的视觉环境感知能力。具体地,在水下航行时,可以克服视觉退化与折射畸变的影响;在空气中飞行或滑翔时,可以实现高速运动漂移导致的图像模糊与光影变化;在跨介质过渡阶段,可以防止水体剧烈波动条件下的视觉目标丢失。同时,研究水空跨介质机器人的自适应视觉感知方式切换策略,实现基于视觉的跨介质主动感知。

(5) 水下视觉感知算法的轻量级优化

受到水下通信能力不足的限制,水下机器人在执行任务时,无法像陆地机器人一样将数据实时传输到基站并接入大规模运算服务器中实现数据处理,多数情况下只能依靠机载小型运算单元进行数据处理。其中,水下视觉数据存储空间大、特征维度高,在感知算法运行过程中容易造成严重时延,不利于机器人作业。为此,通过巧妙设计轻量化特征提取网络,建立网络内部高效的信息提取与传递机制,并利用多尺度与多样化的模型训练方法,是对水下视觉感知算法进行轻量级优化的主要研究方向。

(6) 面向极端水下环境的主动视觉感知

强风浪、弱光照等一系列极端水环境使得传统的视觉感知技术难以有效应用。研发高抗扰、环境光主动补偿的水下视觉感知技术有助于拓展传统视觉感知技术的水下应用场景,进一步扩大水下智能机器人的作业范围。

(7) 针对水下场景的视觉压缩感知技术

由于水下场景稀疏、重复等特性,水下图像具有区别于陆上图像的信号特点。此外,水下无线通信带宽也受到严重制约。因此,针对水下场景进行视觉信号压缩研究有利于提高水下机器人系统间的视觉信息传递速率,进而更好地完成智能化协同作业。

(8) 水下仿生视觉系统研究

水生生物经过上亿年的自然选择,进化出了高度适用于水下环境的视觉系统。研究水生生物视觉系统的构造与信息处理机制,有助于开发新一代高效水下视觉传感器与感知算法。

7 结论(Conclusion)围绕水下视觉环境感知这一主题,阐述了水下视觉感知技术面临的核心共性问题,即水下图像退化与水下折射畸变。以应对共性问题为出发点,对水下视觉质量恢复、水下3维成像以及水下视野增强3个方面的研究现状展开了综述。总体而言,水下视觉环境感知的有效实现因水下场景复杂度高而困难较大,与水下机器人进行有机结合、深度融合以提升水下作业的自主性与智能性是进一步研究的热点方向。

| [1] |

侯建平, 戴娟娟, 蔡灵, 等. 21世纪美国国家海洋政策变化分析[J]. 环境与生活, 2014, 16: 99, 101. Hou J P, Dai J J, Cai L, et al. An analysis of the changes in U.S. national ocean policy in the 21st century[J]. Green Living, 2014, 16: 99, 101. |

| [2] |

Gong Z Y, Fang X, Chen X Y, et al. A soft manipulator for efficient delicate grasping in shallow water: Modeling, control, and real-world experiments[J]. International Journal of Robotics Research, 2021, 40(1): 449-469. DOI:10.1177/0278364920917203 |

| [3] |

Cai M X, Wang Y, Wang S, et al. Grasping marine products with hybrid-driven underwater vehicle-manipulator system[J]. IEEE Transactions on Automation Science and Engineering, 2020, 17(3): 1443-1454. |

| [4] |

顾临怡, 宋琦, 殷宏伟, 等. 基于ROV等载体的水下搜救流程综述[J]. 中国科学: 信息科学, 2018, 48(9): 1137-1151. Gu L Y, Song Q, Yin H W, et al. An overview of the underwater search and salvage process based on ROV[J]. Scientia Sinica: Informationis, 2018, 48(9): 1137-1151. |

| [5] |

刘妹琴, 韩学艳, 张森林, 等. 基于水下传感器网络的目标跟踪技术研究现状与展望[J]. 自动化学报, 2021, 47(2): 235-251. Liu M Q, Han X Y, Zhang S L, et al. Research status and prospect of target tracking technologies via underwater sensor networks[J]. Acta Automatica Sinica, 2021, 47(2): 235-251. |

| [6] |

吴杰, 王志东, 凌宏杰, 等. 深海作业型带缆水下机器人关键技术综述[J]. 江苏科技大学学报(自然科学版), 2020, 34(4): 1-12. Wu J, Wang Z D, Ling H J, et al. Review on technologies of work-class ROV in deep-water industry[J]. Journal of Jiangsu University of Science and Technology (Natural Science Edition), 2020, 34(4): 1-12. |

| [7] |

Cong Y, Gu C J, Zhang T, et al. Underwater robot sensing technology: A survey[J]. Fundamental Research, 2021, 1(3): 337-345. DOI:10.1016/j.fmre.2021.03.002 |

| [8] |

黄琰, 李岩, 俞建成, 等. AUV智能化现状与发展趋势[J]. 机器人, 2020, 42(2): 215-231. Huang Y, Li Y, Yu J C, et al. State-of-the-art and development trends of AUV intelligence[J]. Robot, 2020, 42(2): 215-231. |

| [9] |

张伟, 高赛博, 李子轩, 等. 基于散射模型的水下浑浊图像增强方法[J]. 哈尔滨工程大学学报, 2021, 42(8): 1209-1216. Zhang W, Gao S B, Li Z X, et al. Underwater turbidity image enhancement method based on scattering model[J]. Journal of Harbin Engineering University, 2021, 42(8): 1209-1216. |

| [10] |

郭银景, 吴琪, 苑娇娇, 等. 水下光学图像处理研究进展[J]. 电子与信息学报, 2021, 43(2): 426-435. Guo Y J, Wu Q, Yuan J J, et al. Research progress on underwater optical image processing[J]. Journal of Electronics & Information Technology, 2021, 43(2): 426-435. |

| [11] |

王晓鸣, 吴高升. 基于单目视觉的水下机器人相对位姿精确控制[J]. 水下无人系统学报, 2021, 29(3): 299-307. Wang X M, Wu G S. Relative position and attitude precise control of underwater robot based on monocular vision[J]. Journal of Unmanned Undersea Systems, 2021, 29(3): 299-307. |

| [12] |

周浩, 姜述强, 黄海, 等. 基于视觉感知的海生物吸纳式水下机器人目标捕获控制[J]. 机器人, 2019, 41(2): 242-249, 275. Zhou H, Jiang S Q, Huang H, et al. Vision based target capture control for sea organism absorptive underwater vehicle[J]. Robot, 2019, 41(2): 242-249, 275. |

| [13] |

Li X, Shang M, Qin H W, et al. Fast accurate fish detection and recognition of underwater images with Fast R-CNN[C]//OCEANS. Piscataway, USA: IEEE, 2015. DOI: 10.23919/OCEANS.2015.7404464.

|

| [14] |

Sun N, Nian R, He B, et al. Consistent fish tracking via multiple underwater cameras[C]//OCEANS. Piscataway, USA: IEEE, 2014. DOI: 10.1109/OCEANS-TAIPEI.2014.6964366.

|

| [15] |

Chen X Y, Yu J Z, Kong S H, et al. Joint anchor-feature refinement for real-time accurate object detection in images and videos[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2021, 31(2): 594-607. DOI:10.1109/TCSVT.2020.2980876 |

| [16] |

Yu J Z, Chen X Y, Kong S H. Visual perception and control of underwater robots[M]. Boca Raton, USA: CRC Press, 2021.

|

| [17] |

Lu H M, Li Y J, Zhang Y D, et al. Underwater optical image processing: A comprehensive review[J]. Mobile Networks and Applications, 2017, 22: 1204-1211. DOI:10.1007/s11036-017-0863-4 |

| [18] |

Zhang W D, Pan X P, Xie X W, et al. Color correction and adaptive contrast enhancement for underwater image enhancement[J]. Computers & Electrical Engineering, 2021, 91. DOI:10.1016/j.compeleceng.2021.106981 |

| [19] |

Shortis M, Harvey E, Abdo D. A review of underwater stereoimage measurement for marine biology and ecology applications[M]//Oceanography and Marine Biology: An Annual Review, Vol. 47. 1st ed. Boca Raton, USA: CRC Press, 2009: 257-292.

|

| [20] |

Bonin-Font F, Burguera A, Oliver G. Imaging systems for advanced underwater vehicles[J]. Journal of Maritime Research, 2011, 8(1): 65-86. |

| [21] |

徐岩, 曾祥波. 基于红色暗通道先验和逆滤波的水下图像复原[J]. 激光与光电子学进展, 2018, 55(2): 221-228. Xu Y, Zeng X B. Underwater image restoration based on reddark channel prior and inverse filtering[J]. Laser & Optoelectronics Progress, 2018, 55(2): 221-228. |

| [22] |

Farbman Z, Fattal R, Lischinski D, et al. Edge-preserving decompositions for multi-scale tone and detail manipulation[J]. ACM Transactions on Graphics, 2008, 27(3): 1-10. |

| [23] |

代成刚, 林明星, 王震, 等. 基于亮通道色彩补偿与融合的水下图像增强[J]. 光学学报, 2018, 38(11): 86-95. Dai C G, Lin M X, Wang Z, et al. Color compensation based on bright channel and fusion for underwater image enhancement[J]. Acta Optica Sinica, 2018, 38(11): 86-95. |

| [24] |

Kong S H, Fang X, Chen X Y, et al. A NSGA-Ⅱ-based calibration algorithm for underwater binocular vision measurement system[J]. IEEE Transactions on Instrumentation and Measurement, 2020, 69(3): 794-803. DOI:10.1109/TIM.2019.2906974 |

| [25] |

Kong S H, Fang X, Chen X Y, et al. A real-time underwater robotic visual tracking strategy based on image restoration and kernelized correlation filters[C]//Chinese Control and Decision Conference. Piscataway, USA: IEEE, 2018: 6436-6441.

|

| [26] |

Schechner Y Y, Karpel N. Clear underwater vision[C]//IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2004. DOI: 10.1109/CVPR.2004.1315078.

|

| [27] |

Çelebi A T, Ertürk S. Visual enhancement of underwater images using empirical mode decomposition[J]. Expert Systems with Applications, 2012, 39(1): 800-805. DOI:10.1016/j.eswa.2011.07.077 |

| [28] |

He K M, Sun J, Tang X O. Single image haze removal using dark channel prior[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(12): 2341-2353. DOI:10.1109/TPAMI.2010.168 |

| [29] |

林森, 白莹, 李文涛, 等. 基于修正模型与暗通道先验信息的水下图像复原[J]. 机器人, 2020, 42(4): 427-435, 447. Lin S, Bai Y, Li W T, et al. Underwater image restoration based on the modified model and dark channel prior[J]. Robot, 2020, 42(4): 427-435, 447. |

| [30] |

Peng Y T, Cosman P C. Underwater image restoration based on image blurriness and light absorption[J]. IEEE Transactions on Image Processing, 2017, 26(4): 1579-1594. DOI:10.1109/TIP.2017.2663846 |

| [31] |

汤忠强, 周波, 戴先中, 等. 基于改进DCP算法的水下机器人视觉增强[J]. 机器人, 2018, 40(2): 222-230. Tang Z Q, Zhou B, Dai X Z, et al. Underwater robot visual enhancements based on the improved DCP algorithm[J]. Robot, 2018, 40(2): 222-230. |

| [32] |

Li C Y, Guo J C, Cong R M, et al. Underwater image enhancement by dehazing with minimum information loss and histogram distribution prior[J]. IEEE Transactions on Image Processing, 2016, 25(12): 5664-5677. DOI:10.1109/TIP.2016.2612882 |

| [33] |

Chiang J Y, Chen Y C. Underwater image enhancement by wavelength compensation and dehazing[J]. IEEE Transactions on Image Processing, 2012, 21(4): 1756-1769. DOI:10.1109/TIP.2011.2179666 |

| [34] |

Shin Y S, Cho Y, Pandey G, et al. Estimation of ambient light and transmission map with common convolutional architecture[C]//OCEANS. Piscataway, USA: IEEE, 2016. DOI: 10.1109/OCEANS.2016.7761342.

|

| [35] |

Galdran A, Pardo D, Picón A, et al. Automatic red-channel underwater image restoration[J]. Journal of Visual Communication and Image Representation, 2015, 26: 132-145. DOI:10.1016/j.jvcir.2014.11.006 |

| [36] |

Zhao X W, Jin T, Qu S. Deriving inherent optical properties from background color and underwater image enhancement[J]. Ocean Engineering, 2015, 94: 163-172. DOI:10.1016/j.oceaneng.2014.11.036 |

| [37] |

Peng Y T, Zhao X Y, Cosman P C. Single underwater image enhancement using depth estimation based on blurriness[C]//IEEE International Conference on Image Processing. Piscataway, USA: IEEE, 2015: 4952-4956.

|

| [38] |

Ancuti C, Ancuti C O, Haber T, et al. Enhancing underwater images and videos by fusion[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2012: 81-88.

|

| [39] |

Bennett E P, Mason J L, McMillan L. Multispectral bilateral video fusion[J]. IEEE Transactions on Image Processing, 2007, 16(5): 1185-1194. DOI:10.1109/TIP.2007.894236 |

| [40] |

Ancuti C O, Ancuti C, de Vleeschouwer C, et al. Color balance and fusion for underwater image enhancement[J]. IEEE Transactions on Image Processing, 2018, 27(1): 379-393. DOI:10.1109/TIP.2017.2759252 |

| [41] |

Li J, Skinner K A, Eustice R M, et al. WaterGAN: Unsupervised generative network to enable real-time color correction of monocular underwater images[J]. IEEE Robotics and Automation Letters, 2018, 3(1): 387-394. |

| [42] |

Zhu J Y, Park T, Isola P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]//IEEE International Conference on Computer Vision. Piscataway, USA: IEEE, 2017: 2242-2251.

|

| [43] |

Li C Y, Guo J C, Guo C L. Emerging from water: Underwater image color correction based on weakly supervised color transfer[J]. IEEE Signal Processing Letters, 2018, 25(3): 323-327. DOI:10.1109/LSP.2018.2792050 |

| [44] |

Chen X Y, Yu J Z, Kong S H, et al. Towards real-time advancement of underwater visual quality with GAN[J]. IEEE Transactions on Industrial Electronics, 2019, 66(12): 9350-9359. DOI:10.1109/TIE.2019.2893840 |

| [45] |

Sagara S, Ambar R B, Takemura F. A stereo vision system for underwater vehicle-manipulator systems-Proposal of a novel concept using pan-tilt-slide cameras[J]. Journal of Robotics and Mechatronics, 2013, 25(5): 785-794. DOI:10.20965/jrm.2013.p0785 |

| [46] |

Yang X, Wu Z X, Liu J C, et al. Design of a camera stabilizer system for robotic fish based on feedback-feedforward control[C]//35th Chinese Control Conference. Piscataway, USA: IEEE, 2016: 6044-6049.

|

| [47] |

Zhang P F, Wu Z X, Wang J, et al. 2-DOF camera stabilization platform for robotic fish based on active disturbance rejection control[C]//IEEE 9th Annual International Conference on CYBER Technology in Automation, Control, and Intelligent Systems. Piscataway, USA: IEEE, 2019: 283-288.

|

| [48] |

Pan J, Zhang P F, Liu J C, et al. A novel visual sensor stabilization platform for robotic sharks based on improved LADRC and digital image algorithm[J]. Sensors, 2020, 20(14). DOI:10.3390/s20144062 |

| [49] |

Sedlazeck A, Koch R. Perspective and non-perspective camera models in underwater imaging-Overview and error analysis[M]//Lecture Notes in Computer Science, Vol. 7474. Berlin, Germany: Springer, 2012: 212-242.

|

| [50] |

Boutros N, Shortis M R, Harvey E S. A comparison of calibration methods and system configurations of underwater stereovideo systems for applications in marine ecology[J]. Limnology and Oceanography: Methods, 2015, 13(5): 224-236. DOI:10.1002/lom3.10020 |

| [51] |

Shortis M. Calibration techniques for accurate measurements by underwater camera systems[J]. Sensors, 2015, 15(12): 30810-30826. DOI:10.3390/s151229831 |

| [52] |

Sánchez-Ferreira C, Mori J Y, Llanos C H, et al. Development of a stereo vision measurement architecture for an underwater robot[C]//IEEE 4th Latin American Symposium on Circuits and Systems. Piscataway, USA: IEEE, 2013: 1-4.

|

| [53] |

Schechner Y Y, Karpel N. Recovery of underwater visibility and structure by polarization analysis[J]. IEEE Journal of Oceanic Engineering, 2005, 30(3): 570-587. DOI:10.1109/JOE.2005.850871 |

| [54] |

Treibitz T, Schechner Y Y. Active polarization descattering[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2009, 31(3): 385-399. DOI:10.1109/TPAMI.2008.85 |

| [55] |

Kwon Y H, Casebolt J B. Effects of light refraction on the accuracy of camera calibration and reconstruction in underwater motion analysis[J]. Sports Biomechanics, 2006, 5(2): 315-340. DOI:10.1080/14763140608522881 |

| [56] |

Ferreira R, Costeira J P, Santos J A. Stereo reconstruction of a submerged scene[M]//Lecture Notes in Computer Science, Vol. 3522. Berlin, Germany: Springer, 2005: 102-109.

|

| [57] |

Meline A, Triboulet J, Jouvencel B. A camcorder for 3D underwater reconstruction of archeological objects[C]//OCEANS. Piscataway, USA: IEEE, 2010. DOI: 10.1109/OCEANS.2010.5664572.

|

| [58] |

Menna F, Nocerino E, Troisi S, et al. A photogrammetric approach to survey floating and semi-submerged objects[C]//Videometrics, Range Imaging, and Applications XⅡ; and Automated Visual Inspection. Bellingham, USA: SPIE, 2013. DOI: 10.1117/12.2020464.

|

| [59] |

Li R X, Li H H, Zou W H, et al. Quantitative photogrammetric analysis of digital underwater video imagery[J]. IEEE Journal of Oceanic Engineering, 1997, 22(2): 364-375. DOI:10.1109/48.585955 |

| [60] |

Treibitz T, Schechner Y, Kunz C, et al. Flat refractive geometry[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(1): 51-65. DOI:10.1109/TPAMI.2011.105 |

| [61] |

Jordt-Sedlazeck A, Koch R. Refractive structure-from-motion on underwater images[C]//IEEE International Conference on Computer Vision. Piscataway, USA: IEEE, 2013: 57-64.

|

| [62] |

Jordt-Sedlazeck A, Koch R. Refractive calibration of underwater cameras[M]//Lecture Notes in Computer Science, Vol. 7576. Berlin, Germany: Springer, 2012: 846-859.

|

| [63] |

Agrawal A, Ramalingam S, Taguchi Y, et al. A theory of multilayer flat refractive geometry[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2012: 3346-3353.

|

| [64] |

Chen X D, Yang Y H. Two-view camera housing parameters calibration for multi-layer flat refractive interface[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2014: 524-531.

|

| [65] |

Yau T, Gong M L, Yang Y H. Underwater camera calibration using wavelength triangulation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, USA: IEEE, 2013: 2499-2506.

|

| [66] |

Telem G, Filin S. Photogrammetric modeling of underwater environments[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2010, 65(5): 433-444. DOI:10.1016/j.isprsjprs.2010.05.004 |

| [67] |

Dolereit T, von Lukas U F, Kuijper A. Underwater stereo calibration utilizing virtual object points[C]//OCEANS. Piscataway, USA: IEEE, 2015. DOI: 10.1109/OCEANS-Genova.2015.7271593.

|

| [68] |

Qiu C L, Wu Z X, Kong S H, et al. An underwater micro cabledriven pan-tilt binocular vision system with spherical refraction calibration[J]. IEEE Transactions on Instrumentation and Measurement, 2021, 70: 1-13. |

| [69] |

Massot-Campos M, Oliver-Codina G. Underwater laser-based structured light system for one-shot 3D reconstruction[C]//SENSORS. Piscataway, USA: IEEE, 2014: 1138-1141.

|

| [70] |

许丽, 周永昊, 张帆, 等. 基于光平面约束的水下三维视觉测量系统[J]. 中国激光, 2020, 47(9). Xu L, Zhou Y H, Zhang F, et al. Underwater three-dimensional measurement vision system using light-plane constraint[J]. Chinese Journal of Lasers, 2020, 47(9). DOI:10.3788/CJL202047.0904004 |

| [71] |

Massot-Campos M, Oliver G, Bodenmann A, et al. Submap bathymetric SLAM using structured light in underwater environments[C]//IEEE/OES Autonomous Underwater Vehicles. Piscataway, USA: IEEE, 2016: 181-188.

|

| [72] |

Bleier M, van der Lucht J, Nüchter A. Scout3D-An underwater laser scanning system for mobile mapping[J]. The International Archives of Photogrammetry, Remote Sensing and Spatial Information Sciences, 2019, XLⅡ-2/W18: 13-18. |

| [73] |

Palomer A, Ridao P, Ribas D. Inspection of an underwater structure using point-cloud SLAM with an AUV and a laser scanner[J]. Journal of Field Robotics, 2019, 36(8): 1333-1344. DOI:10.1002/rob.21907 |

| [74] |

Palomer A, Ridao P, Forest J, et al. Underwater laser scanner: Ray-based model and calibration[J]. IEEE/ASME Transactions on Mechatronics, 2019, 24(5): 1986-1997. DOI:10.1109/TMECH.2019.2929652 |

| [75] |

Gu C J, Cong Y, Sun G. Three birds, one stone: Unified laser-based 3-D reconstruction across different media[J]. IEEE Transactions on Instrumentation and Measurement, 2020, 70: 1-12. |

| [76] |

Köser K, Frese U. Challenges in underwater visual navigation and SLAM[M]//Intelligent Systems, Control and Automation: Science and Engineering, Vol. 96. Berlin, Germany: Springer, 2020: 125-135.

|

| [77] |

Ferrera M, Creuze V, Moras J, et al. AQUALOC: An underwater dataset for visual-inertial-pressure localization[J]. International Journal of Robotics Research, 2019, 38(14): 1549-1559. DOI:10.1177/0278364919883346 |

| [78] |

Amarasinghe C, Ratnaweera A, Maitripala S. Monocular visual SLAM for underwater navigation in turbid and dynamic environments[J]. American Journal of Mechanical Engineering, 2020, 8(2): 76-87. DOI:10.12691/ajme-8-2-5 |

| [79] |

Burguera A, Bonin-Font F. A trajectory-based approach to multi-session underwater visual SLAM using global image signatures[J]. Journal of Marine Science and Engineering, 2019, 7(8). DOI:10.3390/jmse7080278 |

| [80] |

张阳, 欧阳犬平, 李进军, 等. 水下视觉SLAM相机成像畸变纠正研究[J]. 海洋技术学报, 2019, 38(6): 24-29. Zhang Y, Ouyang Q P, Li J J, et al. Research on image distortion correction of underwater vision SLAM camera[J]. Journal of Ocean Technology, 2019, 38(6): 24-29. |

| [81] |

Yin J Y, Wang Y, Lü J Q, et al. Study on underwater simultaneous localization and mapping based on different sensors[C]//IEEE 10th Data Driven Control and Learning Systems Conference. Piscataway, USA: IEEE, 2021: 728-733.

|

| [82] |

Fan H, Qi L, Chen C H, et al. Underwater optical 3-D reconstruction of photometric stereo considering light refraction and attenuation[J]. IEEE Journal of Oceanic Engineering, 2022, 47(1): 47-58. |

| [83] |

Cho Y, Kim A. Visibility enhancement for underwater visual SLAM based on underwater light scattering model[C]//IEEE International Conference on Robotics and Automation. Piscataway, USA: IEEE, 2017: 710-717.

|

| [84] |

Burguera A, Bonin-Font F. An unsupervised neural network for loop detection in underwater visual SLAM[J]. Journal of Intelligent & Robotic Systems, 2020, 100: 1157-1177. |

| [85] |

Alay J B. Underwater navigation and mapping with an omnidirectional optical sensor[D]. Girona, Spain: University of Girona, 2018.

|

| [86] |

Bosch J, Gracias N, Ridao P, et al. Omnidirectional underwater camera design and calibration[J]. Sensors, 2015, 15(3): 6033-6065. DOI:10.3390/s150306033 |

| [87] |

Jiang P, Wei Q X, Chen Y H, et al. Real-time panoramic system for underwater cleaning robot[C]//IEEE 9th International Conference on Mechanical and Intelligent Manufacturing Technologies. Piscataway, USA: IEEE, 2018: 155-159.

|

| [88] |

Li Q Z, Zhang Y, Zang F N. Fast multicamera video stitching for underwater wide field-of-view observation[J]. Journal of Electronic Imaging, 2014, 23(2). DOI:10.1117/1.JEI.23.2.023008 |

| [89] |

Bosch J, Ridao P, Ribas D, et al. Creating 360° underwater virtual tours using an omnidirectional camera integrated in an AUV[C]//OCEANS. Piscataway, USA: IEEE, 2015. DOI: 10.1109/OCEANS-Genova.2015.7271525.

|

| [90] |

王昕平, 张森林, 刘妹琴, 等. 基于多尺度图像融合和SIFT特征的水下图像拼接研究[J]. 计算机应用与软件, 2021, 38(5): 213-217, 230. Wang X P, Zhang S L, Liu M Q, et al. Underwater image stitching based on multi-scale image fusion and SIFT feature[J]. Computer Applications and Software, 2021, 38(5): 213-217, 230. DOI:10.3969/j.issn.1000-386x.2021.05.034 |

| [91] |

Sheng M W, Tang S Q, Cui Z, et al. A joint framework for underwater sequence images stitching based on deep neural network convolutional neural network[J]. International Journal of Advanced Robotic Systems, 2020, 17(2). DOI:10.1177/1729881420915062 |

| [92] |

Jatmiko D A, Prini S U. Study and performance evaluation binary robust invariant scalable keypoints (BRISK) for underwater image stitching[C]//IOP Conference Series: Materials Science and Engineering, Vol. 879. Bristol, UK: IOP Publishing, 2020. DOI: 10.1088/1757-899X/879/1/012111.

|

| [93] |

胡晓阳. 鱼眼镜头的水下双目视觉定位系统研究[D]. 秦皇岛: 燕山大学, 2017. Hu X Y. The research of underwater positioning in fisheye stereovision system[D]. Qinhuangdao: Yanshan University, 2017. |

| [94] |

Lynch D K. Snell's window in wavy water[J]. Applied Optics, 2015, 54(4): B8-B11. DOI:10.1364/AO.54.0000B8 |

| [95] |

魏利胜, 周圣文, 张平改, 等. 基于双经度模型的鱼眼图像畸变矫正方法[J]. 仪器仪表学报, 2015, 36(2): 377-385. Wei L S, Zhou S W, Zhang P G, et al. Double longitude model based correction method for fish-eye image distortion[J]. Chinese Journal of Scientific Instrument, 2015, 36(2): 377-385. |

| [96] |

冯为嘉. 基于鱼眼镜头的全方位视觉及全景立体球视觉研究[D]. 天津: 天津大学, 2012. Feng W J. Study on omnidirectional vision and panoramic stereo sphere vision based on fish-eye lens[D]. Tianjin: Tianjin University, 2012. |

| [97] |

Delibasis K K, Plagianakos V P, Maglogiannis I. Real time indoor robot localization using a stationary fisheye camera[M]//IFIP Advances in Information and Communication Technology, Vol. 412. Berlin, Germany: Springer, 2013: 245-254.

|

| [98] |

Choi Y W, Kwon K K, Lee S I, et al. Multi-robot mapping using omnidirectional-vision SLAM based on fisheye images[J]. ETRI Journal, 2014, 36(6): 913-923. |

| [99] |

Ji S P, Qin Z J, Shan J, et al. Panoramic SLAM from a multiple fisheye camera rig[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2020, 159: 169-183. |

| [100] |

Yogamani S, Hughes C, Horgan J, et al. WoodScape: A multi-task, multi-camera fisheye dataset for autonomous driving[C]//IEEE/CVF International Conference on Computer Vision. Piscataway, USA: IEEE, 2019: 9307-9317.

|

| [101] |

Berlinger F, Gauci M, Nagpal R. Implicit coordination for 3D underwater collective behaviors in a fish-inspired robot swarm[J]. Science Robotics, 2021, 6(50). DOI:10.1126/scirobotics.abd8668 |

| [102] |

Billings G, Johnson-Roberson M. SilhoNet-fisheye: Adaptation of a ROI based object pose estimation network to monocular fisheye images[J]. IEEE Robotics and Automation Letters, 2020, 5(3): 4241-4248. |

| [103] |

Sakamoto K, Moro A, Fujii H, et al. Three-dimensional measurement of objects in liquid with an unknown refractive index using fisheye stereo camera[C]//IEEE/SICE International Symposium on System Integration. Piscataway, USA: IEEE, 2014: 281-286.

|

| [104] |

Meng L, Hirayama T, Oyanagi S. Underwater-drone with panoramic camera for automatic fish recognition based on deep learning[J]. IEEE Access, 2018, 6: 17880-17886. DOI:10.1109/ACCESS.2018.2820326 |

| [105] |

Nakajoh H, Miyazaki T, Sawa T, et al. Development of 7000m work class ROV "KAIKO Mk-IV"[C]//OCEANS. Piscataway, USA: IEEE, 2016. DOI: 10.1109/OCEANS.2016.7761063.

|

2022, Vol. 44

2022, Vol. 44