在复杂多变的海洋环境中,船舶避碰是保证航行安全的核心任务之一。传统的船舶避碰决策主要依赖于船员的经验和判断,然而这种方法受限于人为因素,如疲劳、判断失误等,可能导致避碰决策的失误,进而引发严重的海难事故[1]。船舶自主避碰决策系统通过集成传感器、雷达、卫星定位等多源信息,实现船舶周围环境的实时感知和动态监测[2],为船舶提供准确的避碰决策支持。然而,海洋环境复杂多变,船舶感知到的信息具有多样性、不确定性和动态性等特点,如何有效地处理这些光视觉信息,提高避碰决策的准确性和实时性[3],是船舶自主避碰决策系统面临的重要挑战。

关巍等[4]采用长短时记忆网络(LSTM)对近端策略优化(PPO)避碰决策框架进行优化,使其能够学习并理解通过激光雷达等传感器设备收集的船舶航行环境信息。在精心设计的奖励函数引导下,该框架能够输出最优的避碰动作,确保船舶在航行过程中实现自主避碰。然而,面对复杂多变的海洋环境,特别是当传感器受到干扰时,避碰效果可能会受到显著影响。Zheng等[5]研究了基于改进文化粒子群优化算法的船舶避碰决策方法,该方法首先通过卡尔曼滤波器预测船舶轨迹并计算碰撞风险,然后根据《国际海上避碰规则公约》确定转向角方向,并利用改进的文化粒子群算法在给定范围内搜索最优转向角,从而自动实现与其他船舶的避碰。该方法根据导航系统数据预测船舶轨迹和碰撞风险,可能无法全面捕捉船舶周围环境的动态变化。谢鸿伟等[6]提出的模型预测控制方法,以其深厚的理论基础和实用性,在船舶自主避碰领域展现出显著的优势。该方法基于船舶动力学模型,通过预测船舶在未来一段时间内的运动轨迹和状态,为船舶提供最优的避碰方案。然而,这一方法的局限性在于其高度依赖于船舶自身的传感器和物理模型,导致信息来源相对单一,可能在一定程度上影响避碰决策的精确性和可靠性。近年来,随着计算机视觉技术的飞速发展,光视觉信息在船舶自主避碰领域的应用逐渐受到重视。徐茂竹等[7]利用单个摄像机捕捉无人艇航行环境图像或视频,利用YOLO网络追踪航行环境中的目标物,通过改进向量场直方图算法实现航向角的更新,使其避开目标物。该方法因依赖单一视角,导致其深度感知能力受到限制。

将多个视觉信息源整合成一个统一的视觉感知,从而生成更准确、全面的视觉感知结果,对降低船舶碰撞风险具有重要意义。因此,本文提出视觉信息自适应聚合的船舶自主避碰决策方法,增强航行环境感知能力,提高船舶航行安全。

1 船舶自主避碰决策 1.1 多源光视觉图像配准与自适应聚合本文通过安装在船首以及船舷两侧的Kinect多模态视觉相机对船舶航行环境进行感知,实现RGB、深度、红外图像的同时获取。

为简化图像处理和分析流程,首先需使多源光视觉图像分辨率保持一致,本文通过转换矩阵方式实现多源图像配准。红外图像与RGB图像配准操作具体为:设定

| $ \left[ \begin{gathered} X \\ Y \\ 1 \\ \end{gathered} \right] = T\left[ \begin{gathered} x \\ y \\ 1 \\ \end{gathered} \right] = \left[ \begin{gathered} {a_1}\mathop {}\nolimits^{} {a_2}\mathop {}\nolimits^{} {a_3} \\ {a_4}\mathop {}\nolimits^{} {a_5}\mathop {}\nolimits^{} {a_6} \\ {a_7}\mathop {}\nolimits^{} {a_8}\mathop {}\nolimits^{} 1 \\ \end{gathered} \right]\left[ \begin{gathered} x \\ y \\ 1 \\ \end{gathered} \right] 。$ | (1) |

式中:

对相同船舶航行场景下的多源光视觉图像进行自适应聚合,能够形成一个更全面、更准确的航行场景描述,有助于理解船舶的航行状态、周围环境以及潜在风险,为后续的船舶导航、避碰决策等提供更为可靠的数据支持。通过式(2)~式(5)实现配准后多源光视觉图像聚合:

| $ F = C \cup D \cup I = \left( {x,y,r,g,b,d,i} \right) ,$ | (2) |

| $ C = \left( {x,y,r,g,b} \right) ,$ | (3) |

| $ D = \left( {x,y,d} \right) ,$ | (4) |

| $ I = \left( {x,y,i} \right) 。$ | (5) |

式中:

利用图像处理技术,对船舶感知到的光视觉信息进行配准和自适应融合,形成对船舶周围环境的全面感知。由此,可根据感知结果和船舶的航行状态,制定准确的避碰决策。

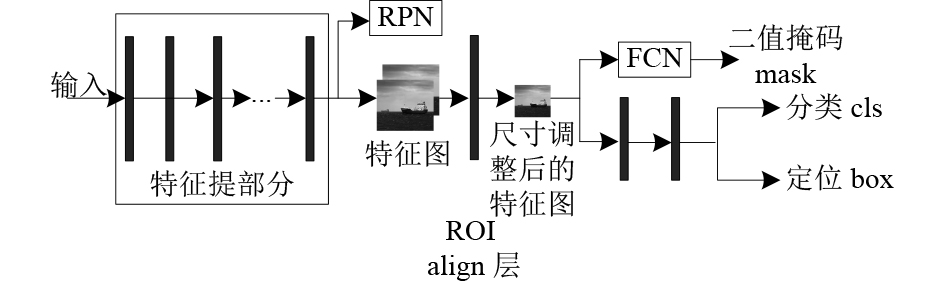

1.2 基于Mask RCNN的目标追踪本文构建基于Mask RCNN[8]的目标追踪流程,其基本结构如图1所示。输入为多源光视觉图像的自适应聚合结果。输出包括目标类型、位置坐标及二值掩码。流程中,Faster R-CNN的Region Proposal Network(RPN)生成候选ROI,经卷积与全连接层分类并微调边界框坐标。引入FCN对ROI进行像素级预测,生成二值掩码实现精确分割。ResNet-101自动学习图像特征,通过多层次卷积和池化捕获不同尺度特征,输入RPN生成ROI。ROI Align确保特征精确提取,特征向量分别处理于上下分支。上层FCN上采样生成掩码,下层全连接层识别目标并定位。该流程实现了高效、精确的目标追踪与分割,提升了船舶航行环境的感知能力。训练损失函数定义为:

|

图 1 基于Mask RCNN的目标追踪流程 Fig. 1 Target tracking process based on Mask RCNN |

| $ L = {L_{\rm{cls}}} + {L_{\rm{box}}} + {L_{\rm{mask}}} 。$ | (6) |

式中:

为提高Mask RCNN网络运行效率,本文基于共享卷积方式确定ROI,即将ResNet-101网络提取的最后一层特征图应用到RPN中,RPN利用3×3卷积核处理其输入特征图,为了捕捉不同尺寸、形状目标,本文将检测框大小分别设置为128×128、256×256、512×512,同时配置了1∶1、1∶2、2∶1这3种长宽比。采用非极大值抑制法进行重叠ROI筛选,得到一组置信度较高、相互不重叠且存在目标的候选区域,在其上完成目标分割。

1.3 目标物运动态势参数获取对得到的目标定位结果进行空间坐标转换,确保能够准确反映目标在真实世界中的位置和动态,为后续的碰撞风险评估和避障决策提供可靠依据。

在完成坐标转换后,根据船舶航行操纵知识,需对以下运动态势参数进行确定。

1)目标位置。确定目标中心点坐标,将其视作目标的实际位置。

2)目标大小。对得到的目标分割图像中各个像素点进行坐标转换,确定其空间坐标后,通过绘制其矩形框对目标进行标记。设定

3)航向角

4)目标运动速度。通过式

基于获得目标物的空间位置后,结合得到的船舶自身的航行状态(包括位置、大小、速度、航向角等),通过计算碰撞相关指标(船舶与目标之间的距离、失控漂移距离等)来评估船舶与目标物之间的碰撞风险等级。

将船舶碰撞风险精细划分为C1、C2、C3这3个等级。其中,C1为“碰撞危险”,C2为“紧迫局面”,C3为“紧迫危险”,每一级都准确反映了碰撞风险的递增严重性。不同级别船舶碰撞风险判断依据与避障决策具体如下:

1)C1级别碰撞风险判断依据。当船舶实际运行轨迹与预设航迹发生显著偏离,风流压差角过大。同时,船舶与目标之间的距离

| $ {S_c} = {v_0} \cdot {T_{st}}\left( {1 - {e^{\frac{{ - T}}{{{T_{st}}}}}}} \right)\cos \alpha + U \cdot T \cdot \cos \alpha 。$ | (7) |

式中:

2)C2级别碰撞风险判断依据为。船舶倒车冲程

| $ {S_{RE}} = 0.01201 \times \Delta \cdot v_1^2/{R_1}。$ | (8) |

式中:

3)C3级别碰撞风险判断依据为:当船舶满舵旋回进距

为验证方法的避碰决策性能,以某航行船舶为实验对象,通过安装在船首以及船舷两侧的Kinect多模态视觉相机对不同天气条件下的航行环境信息进行采集,得到

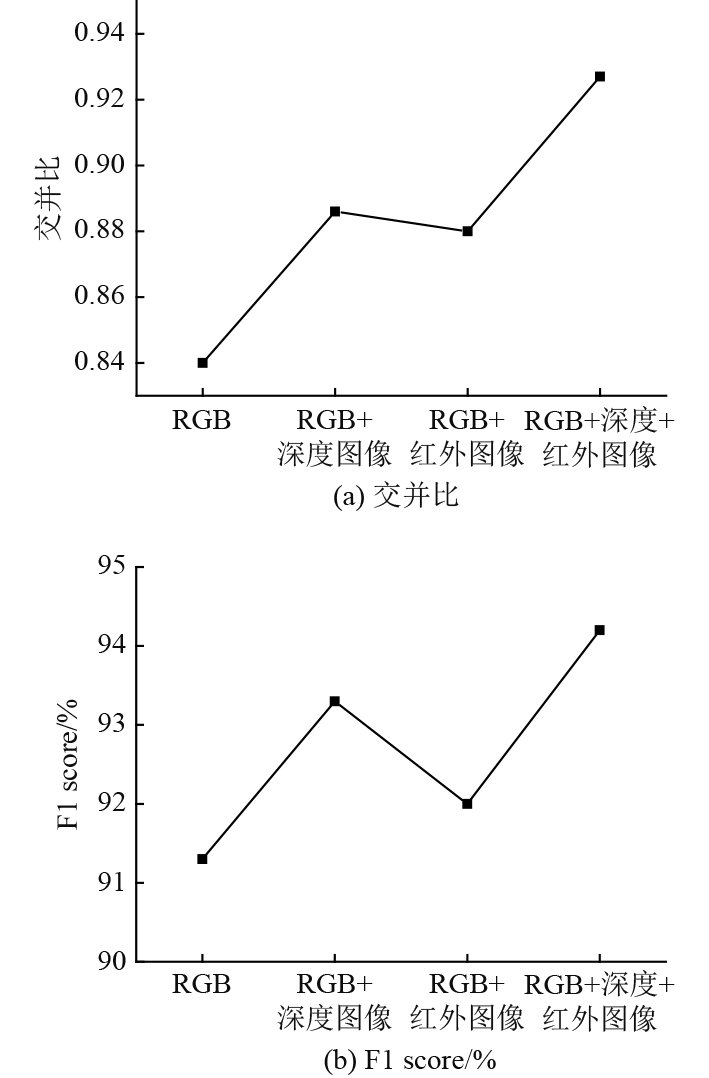

为分析光视觉图像自适应聚合对船舶航行目标追踪效果的影响,分别将RGB图像、RGB+深度图像、RGB+红外图像、RGB+深度+红外图像作为研究方法所用目标识别定位网络的输入,通过交并比指标、F1 score指标衡量目标追踪效果,实验结果如图2所示。

|

图 2 光视觉图像自适应聚合对目标追踪性能的影响分析 Fig. 2 Analysis of the impact of adaptive aggregation of light vision images on target tracking performance |

可知,光视觉图像自适应聚合技术对于船舶航行目标追踪效果具有显著影响。单独使用RGB图像时,目标追踪的交并比和F1 score分别为84%和91.3%。在RGB图像基础上,结合深度图像和红外图像后,目标追踪性能得到显著提升,特别是当RGB图像、深度图像和红外图像同时使用时,交并比提升至0.927,F1 score也增加到94.2%,目标追踪效果达到最优水平。这表明光视觉图像聚合对于船舶航行中的目标追踪具有重要应用价值。

应用研究方法对不同船舶航行环境下的目标进行追踪,9组样本下的虚警率、F1 score指标差异如表1所示。

|

|

表 1 各组样本目标追踪结果分析 Tab.1 Analysis of target tracking results for each group of samples |

分析可知,在晴朗但水波较大的航行环境中,样本的虚警率普遍较高,尽管F1 score指标整体较高,但虚警率的波动反映了图像方差对目标追踪稳定性的影响。在雨天但水波较小的航行环境下,样本D、E和F的虚警率相对较低,且F1 score均为1,说明在较为平静的水面条件下目标追踪性能更为稳定。在雾天环境下,虽然部分样本如G和I的虚警率有所上升,但H样本显示出较好的追踪效果,表明即使在恶劣天气条件下,通过光视觉图像自适应聚合技术仍能实现较为准确的目标追踪。

为分析研究方法的避碰决策性能,对多种真实航行场景进行模拟,特别聚焦在交叉相遇、追越和近距离相遇这3种典型避碰情况,同时考虑了大风浪、夜间航行和船舶设备故障等多种因素。在不同场景中设置不同数量、大小、速度的虚拟障碍物,根据船舶实际性能设定排水量、速度等运动态势参数,确保模拟场景真实性和准确性,实验结果如表2所示。

|

|

表 2 不同航行场景下的避碰决策性能分析 Tab.2 Analysis of collision avoidance decision performance in different navigation scenarios |

可知,在模拟的5种航行场景中,应用研究方法能够在较短时间内作出正确避碰决策,并保持了一定的最小安全距离。这表明研究方法可在复杂航行环境下展现出良好的避碰决策性能。虽然在大风浪条件下决策时间稍长,但系统仍然能够正确判断并避免碰撞风险,显示了其对恶劣环境的适应能力。

3 结 语为增强船舶自主航行能力,本文提出了光视觉信息自适应聚合的船舶自主避碰决策方法,该方法能够自适应地聚合光视觉信息,有效识别并定位航行中的障碍物目标。在此基础上,根据障碍物的运动态势参数以及相关碰撞距离计算结果,评估船舶碰撞风险等级,并采取相应的策略确保船舶在复杂环境中安全航行。未来,将继续深化光视觉信息自适应聚合技术的研究,探索更先进的算法和模型,以适应更复杂的航行条件,提高船舶自主避碰决策的准确性和可靠性。

| [1] |

杨琪森, 王慎执, 桑金楠, 等. 复杂开放水域下智能船舶路径规划与避障方法[J]. 计算机集成制造系统, 2022, 28(7): 2030-2040. |

| [2] |

徐言民, 律建辉, 刘佳仑, 等. 基于CSSOA的多船智能避碰决策研究[J]. 中国舰船研究, 2023, 18(6): 88-96. XU Yanmin, LV Jianhui, LIU Jialun, et al. Multi-vessel intelligent collision avoidance decision-making based on CSSOA[J]. Chinese Journal of Ship Research, 2023, 18(6): 88-96. |

| [3] |

庹玉龙, 康彩霞, 王莎莎, 等. 未知干扰下多船相邻交叉耦合同步编队避障控制[J]. 交通运输工程学报, 2023, 23(6): 314-326. TUO Yulong, KANG Caixia, WANG Shasha, et al. Adjacent cross-coupling synchronous formation control with collision avoidance for multiple ships under unknown disturbances[J]. Journal of Traffic and Transportation Engineering, 2023, 23(6): 314-326. |

| [4] |

关巍, 崔哲闻, 罗文哲. 基于改进PPO算法的船舶自主避碰决策[J]. 大连海事大学学报, 2023, 49(4): 28-36. GUAN Wei, CUI Zhewen, LUO Wenzhe. Ship autonomous collision avoidance decision based on improved PPO algorithm[J]. Journal of Dalian Maritime University, 2023, 49(4): 28-36. |

| [5] |

ZHENG Yisong, ZHANG Xiuguo, SHANG Zijing, et al. A decision-making method for ship collision avoidance based on improved cultural particle swarm[J]. Journal of Advanced Transportation, 2021, 2021(1): 1-31. |

| [6] |

谢鸿伟, 张英俊, 邢胜伟, 等. 基于模型预测控制的船舶自主避碰方法[J]. 船舶工程, 2021, 43(8): 23-28+95. XIE Hongwei, ZHANG Yingjun, XING Shengwei, et al. A method for ship autonomous collision avoidance based on model predictive control[J]. Ship Engineering, 2021, 43(8): 23-28+95. |

| [7] |

徐茂竹, 李弘, 李亚光, 等. 单目视觉引导下的无人艇局部避障方法[J]. 重庆邮电大学学报(自然科学版), 2023, 35(4): 732-741. |

| [8] |

张芯睿, 赵清华, 王雷, 等. 基于Mask R-CNN的雾天场景目标检测[J]. 电光与控制, 2022, 29(12): 83-88. |

2024, Vol. 46

2024, Vol. 46