随着人工智能、无人控制等技术的迅速发展,无人系统将作为有人系统的重要补充力量,以更加隐蔽、高效、低廉的方式完成多种复杂任务[1]。无人水面艇(Unmanned Surface Vessel, USV)作为无人系统的重要组成部分,以其独特的优势在渔业监测、海上安全、海洋科考等领域发挥着重要作用,通过各类传感器作为信息感知系统实现环境感知或目标探测识别等功能。然而随着水下航行器推进装置和水下仿生技术的不断进步,目前已经可以实现通过正弦波推进法模拟鱼类水下游动方式并以接近静默状态行驶数百英里,水面作业时自噪声与海洋背景噪声越来越接近[2],极大地增加了雷达类和声呐类传感器的探测难度。因此通过光电设备进行水下图像目标检测获取伪装目标特征成为环境感知的重要组成部分。

目前,关于水下图像目标检测的研究主要围绕图像增强和通用目标检测(Generic Object Detection,GOD)。其中水下通用目标检测研究主要以算法改进为主。杨婷等[3]针对水下环境存在光线差、噪声大而导致检测精度低漏检率高的问题,通过借鉴PANet的思想提出一种双向特征提取网络PAFPN,并采用自动色阶和Soft-NMS算法进行图像增强和修正候选目标区域提高水下目标检测的准确率;陈小毛和曹建荣等[4 − 5]对YOLOv5进行改进,分别提出水下暗通道优先的图像增强方法和引入自适应空间特征融合方法,之后通过引入注意力机制提升检测精度。针对水下目标小而密集的特点,袁明阳等[6]提出GA-RetinaNet,通过引入分组卷积、上下文特征金字塔模块和注意力机制以捕获更多特征信息提升检测精度;周华平等[7]在此基础上考虑到水下设备性能有限的问题,对ShuffleNetV2网络结构进行轻量化改进,提出一种利用多尺度图像信息和双分支注意力机制的水下目标检测算法SG-NET。上述方法都对水下显著目标的检测精度有明显提升,而关于轻量化水下伪装目标检测的研究依然较少,在算法精度和复杂度平衡上仍有改进空间。

为了提高无人水面艇在复杂背景中对水下伪装目标的检测能力,提出一种基于多任务学习策略的轻量型伪装目标检测方法。首先针对海洋环境中的伪装目标,提出一种分割识别方法,通过梯度感知任务补充无人水面艇对水下伪装目标的视觉感知能力,同时为避免在光照和天气引起的低照度环境条件下引入的梯度噪声,采用自上而下的特征修正机制进一步保证检测的精确度。紧接着针对水下检测数据实时传送的需求,在保证检测精度的情况下,对检测模型框架和特征融合策略进行轻量化设计,提出多尺度通道注意力(Multi-Scale Channel Attention,MSCA)模块,以更小的代价生成准确的初始预测。最后通过对比实验和消融实验对算法性能进行验证。

1 基于多任务学习策略的伪装目标检测伪装目标检测(Camouflaged Object Detection,COD)[8]面向在复杂背景中检测出嵌入其中的伪装目标,与其他视觉任务(如通用目标检测、显著目标检测等)相比,伪装目标通常表现为通过伪装策略试图隐藏自身存在或欺骗物种感知和认知机制,使待测目标在形状、颜色、纹理等与背景高度相似,导致检测伪装目标更具有挑战性。

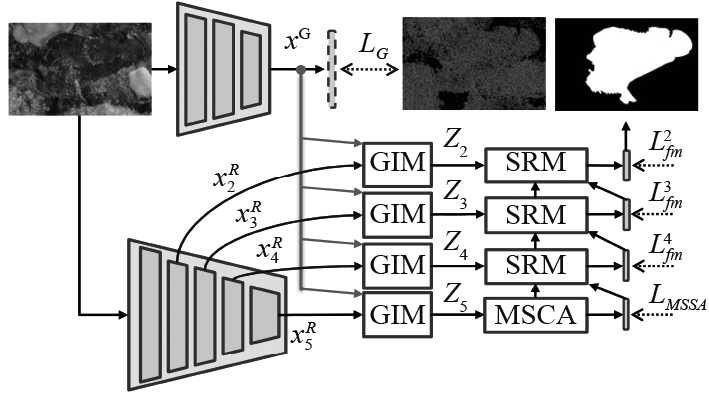

多任务学习策略是伪装目标检测领域中的一种特征增强策略,通过引入常见的分类、定位或其他检测任务来辅助二值分割主任务以提升伪装目标的检测性能,通过多种任务的协同工作挖掘更加丰富的伪装目标信息[9]。水下目标检测面临蓝绿色调、海洋雪和低分辨率等降质因素[10],仅仅依靠像素间的上下文关系很难在水下环境的多种噪声下准确将伪装目标与背景分离。为了解决上述问题,本文提出MFLNet,通过利用图像梯度特征具有旋转不变性以及抗噪能力强的特点,使用梯度感知任务来补充上下文信息,网络整体流程图如图1所示。

|

图 1 MFLNet整体流程图 Fig. 1 Overall pipeline of MFLNet |

MFLNet采用MobileViT[11]作为主干网络(Backbone)对输入图像提取5层不同尺度特征,特征图分别为

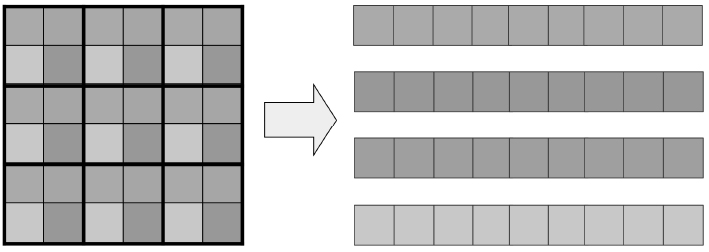

MobileViT提供了一个高效的综合全局和局部特征提取能力的主干网络,然而在进行全局特征提取时,如图2所示,其独特的像素划分策略会降低对临近像素相关性的关注,特别是在进行分割任务时容易为目标边缘区域引入噪声,在面对采取伪装策略的目标时将更进一步降低检测精度,对于无人艇在执行军事、科考或监测任务时对目标的错误预测将严重影响无人作业的效率和范围。因此,通过引入梯度注入模块(Gradient-Infused Module,GIM),以分组引导[13 − 14](Group Guidance Operation)的方式融合纹理特征和上下文特征(Contextual Feature),减少目标边缘特征信息的损失,增强模型对目标纹理的感知。

|

图 2 MobileViT中的像素划分策略 Fig. 2 Pixel partitioning strategy in MobileViT |

首先,将4个上下文特征{

| $ {\left\{{X}_{i,m}^{R}\right\}}_{m=1}^{M}\in {R}^{{K}_{i}\times {H}_{i}\times {W}_{i}}\leftarrow {X}_{i}^{R}\in {R}^{{K}_{i}\times {H}_{i}\times {W}_{i}},$ | (1) |

| $ {\left\{{X}_{m}^{G}\right\}}_{m=1}^{M}\in {R}^{{K}_{g}\times {H}_{g}\times {W}_{g}}\leftarrow {{X}_{}^{G}\in {R}^{{K}_{g}\times {H}_{g}\times {W}_{g}}}_{}^{} 。$ | (2) |

式中:

上下文特征组和梯度特征组沿通道维度串联得到重组后的特征

| $ {Q}_{i}^{}\in {R}^{\left({K}_{g}+{K}_{I}\right)\times {H}_{g}\times {W}_{g}}=({X}_{i,m}^{R};{X}_{m}^{G}) 。$ | (3) |

然后,再将重组后的特征

| $ {Z}_{i}^{}={X}_{i}^{R}\oplus \sum {F}_{g}\left({Q}_{i}\right) 。$ | (4) |

式中:

为了降低无人水面艇在光照和天气引起的低照度环境条件下引入的梯度噪声,将纹理增强后的最深层特征通过MSCA模块生成初始分割结果。然后利用多个特征修正模块逐步发现和去除假阳性和假阴性干扰,实现对目标的准确分割。

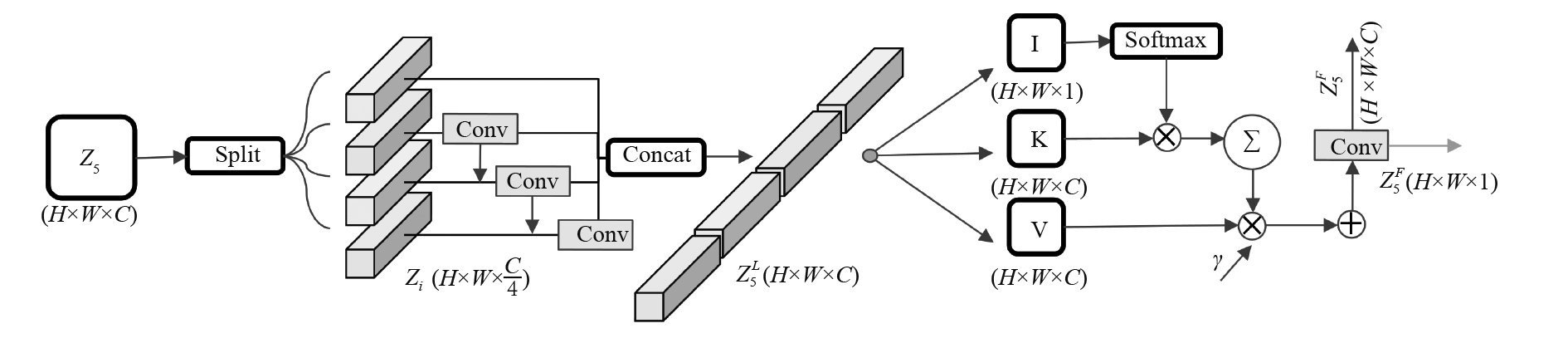

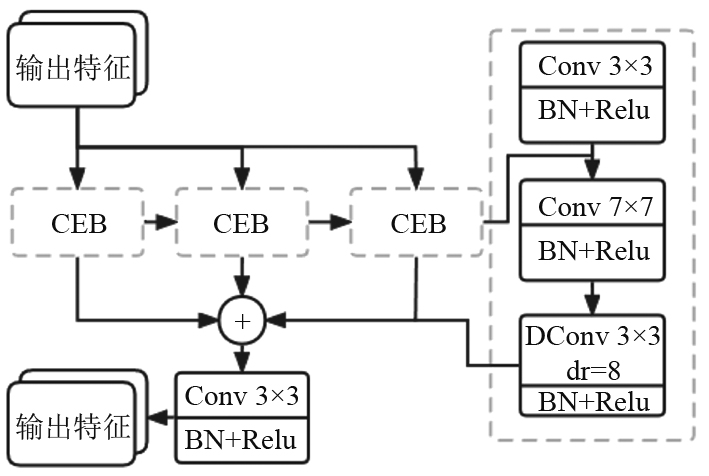

受到ViTblock[15]和分心挖掘[16 − 17]的启发,本文提出的MSCA模块如图3所示,由多尺度特征融合和可分离通道注意力2个部分组成,对输入特征进行局部特征建模和空间位置方面的长范围依赖关系,增强最深层特征的语义表达。具体实现步骤如下:首先将输入特征

|

图 3 MSCA模块结构图 Fig. 3 MSCA module structure diagram |

| $ {z}_{i+1}^{}={z}_{i}^{}+{Linear}_{G}\left(Linear\right(LN\left({D}_{w}\right({z}_{i}\left)\right)\left)\right) ,$ | (5) |

| $ {z}_{i}^{L}=\left\{\begin{array}{l}{z}_{i}^{},\\ {D}_{w}\left({z}_{i}\right),\\ {D}_{w}({z}_{i}+{z}_{i-1}^{L})。\end{array}\right. $ | (6) |

式中:

最后将得到的

| $ {Z}_{5}^{P}=\gamma \times SSA\left(I,K,V\right)+{Z}_{5}^{L} 。$ | (7) |

式中:I、K、V分别为输入特征的3个分支处理;SSA为可分离自注意力计算;

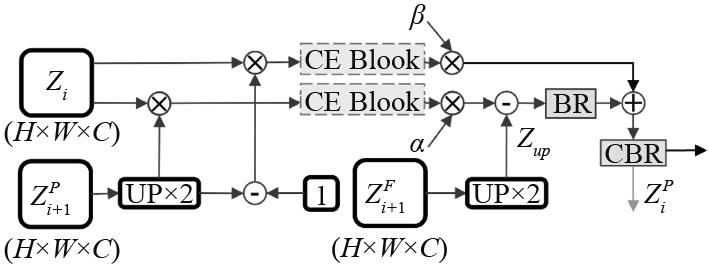

特征修正模块(Segmentation Refinement Module, SRM)的结构如图4所示,对上一层预测图进行上采样和归一化,然后归一化图及其取反版本与当前层纹理增强特征

|

图 4 SRM模块结构图 Fig. 4 SRM module structure diagram |

|

图 5 全局探索模块 Fig. 5 Context exploration block |

在发现假阳性和假阴性预测后,通过逐元素减法来去除假阳性预测(错误的前景预测)和逐元素加法来补足假阴性预测(错误的背景预测),

| $ {Z}_{up}^{}=U\left(CBR\right)\left({Z}_{i+1}^{F}\right) ,$ | (8) |

| $ {Z}_{r}^{}=BR({Z}_{up}^{}-\alpha {Z}_{i}^{f}),$ | (9) |

| $ {Z}_{i}^{P}=CBR({Z}_{r}^{}+\beta {Z}_{i}^{b})。$ | (10) |

式中:

本网络中有5个输出结果,1个来自梯度特征提取模块,1个来自MSCA模块,3个来自特征修正模块。总体损失函数定义为:

| $\begin{split} {\mathcal{L}}_{overall}^{}=&{\mathcal{L}}_{MSSA}^{}\left({Z}_{5}^{P},{G}_{C}^{}\right)+{\sum }_{i=2}^{4}{2}^{\left(4-i\right)}{\mathcal{L}}_{fm}^{i}\left({Z}_{I}^{P},{G}_{C}^{}\right)+\\ &{\mathcal{L}}_{G}^{}\left({X}_{}^{G},{G}_{G}^{}\right) 。\\[-1pt] \end{split}$ | (11) |

式中:

实验平台操作系统为Ubuntu 22.04.2 LTS,配置Python3.10环境。基于PyTorch框架实现网络模型,计算机显卡型号为Radeon RX

通过4个使用最广泛的评估指标对模型性能进行定量比较:S度量(

S度量(

| $ {S}_{\alpha }={\alpha S}_{s}+(1-\alpha ){S}_{p} 。$ | (12) |

E度量(

| $ E_\varphi =\frac{1}{W\times H}\sum _{I=1j=1}^{W}\sum _{S}^{H}{\varphi }_{S}(i,j) 。$ | (13) |

式中:

F度量(

| $ {F}_{\beta }=\frac{{PR}({\beta }^{2}+1)}{{\beta }^{2}P+R}。$ | (14) |

平均绝对误差MAE(M):用来计算预测值C和实际值G之间的绝对差值的平均,即每个像素的平均绝对误差,其定义式为:

| $ M=\frac{1}{W\times H}\sum _{I=1}^{W}\sum _{I=1}^{H}\left|{C}(x,y)-G(x,y)\right|。$ | (15) |

表1为本网络与其他7种方法在3个基准数据集上进行性能对比。可知,本网络的各项评估指标优于所有表中其他网络,在CAMO和NC4K数据集上

|

|

表 1 各模型在3个数据集上的指标值对比 Tab.1 Index value comparison of different networks on 3 datasets |

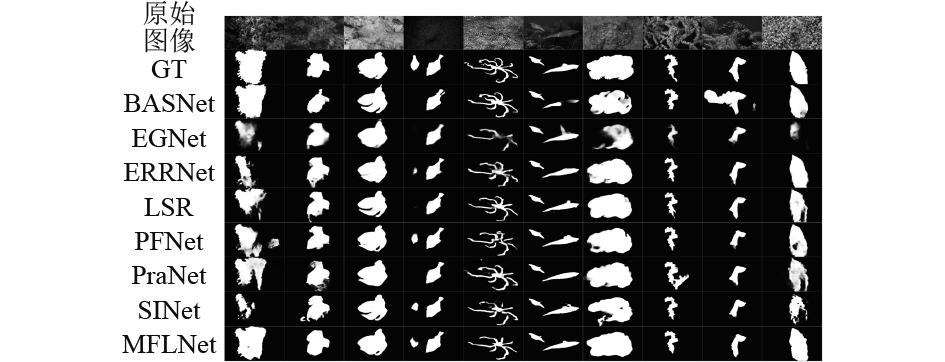

图6 为本方法与其他方法在不同水下图像典型降质现象的定性对比结果,展示结果包括色彩降维所引起的蓝绿色调、水下低亮度拍摄和平台抖动造成离焦模糊等条件下进行水下伪装目标检测。通过将本方法预测图像进行可视化可以看出,MFLNet网络的检测结果和真实标注之间具有更高的视觉一致性,在融合纹理特征后,对图像边缘细节有更强的分割预测能力。

|

图 6 不同方法预测图的视觉对比 Fig. 6 Visual comparison of detection maps produced by different methods |

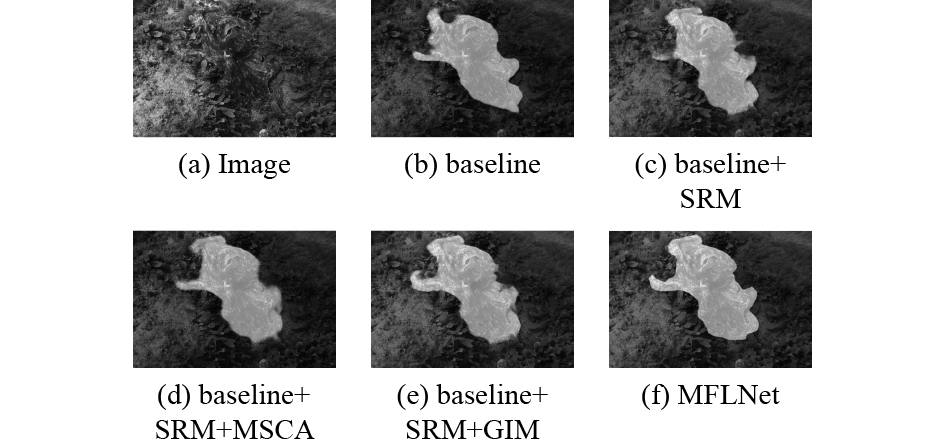

为验证MSCA模块与纹理特征融合模块的有效性进行消融实验,在上述同样实验环境的3个数据集下进行消融实验并将结果报告在表2中。

|

|

表 2 MSCA模块的消融实验结果 Tab.2 Ablation experiment results of MSCA module |

可知,在基础网络(baseline)上,通过单独增加SRM模块对网络性能有略微提升;利用GIM模块对后3层特征融合梯度信息后可以有效增加网络对目标纹理的感知能力,主要体现在被测目标边缘信息提取更加精确,

|

图 7 MSCA模块消融实验结果的视觉对比 Fig. 7 Visual comparison of ablation experiment results produced by MSCA module |

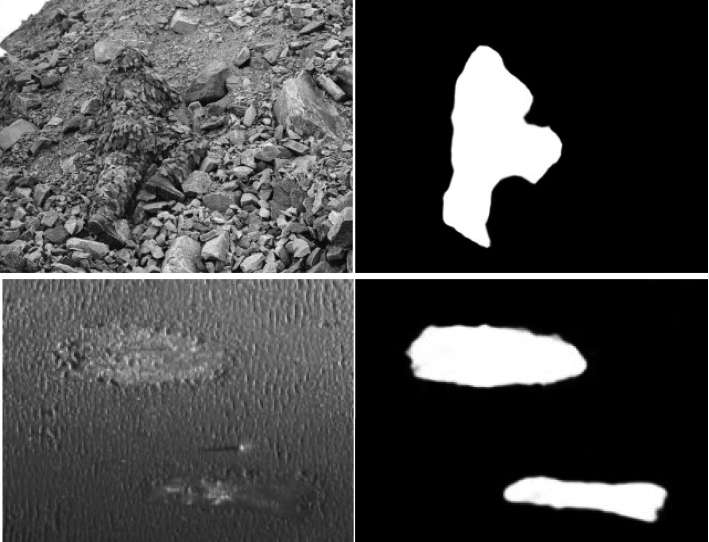

这项研究致力于实现无人水面艇对水下伪装目标的准确分割,通过在MFLNet的框架中借助图像纹理信息来增强检测网络对水下伪装目标边缘的分割预测能力,在3个数据集上实现了先进性能(State-of-the-art,SOTA),图8为MFLNet在军事迷彩目标检测和船舶钢板缺陷检测的潜在应用。

|

图 8 MFLNet的潜在应用 Fig. 8 Potential applications of MFLNet |

在未来,将继续探索该方法在非声探测领域的应用,与成熟的声学探测技术形成水下目标多模态探测模型,提高无人水面艇对水下伪装目标的感知和探测能力,以及该算法在海洋生物监测、船舶缺陷和迷彩伪装检测等其他船舶与海洋工程领域的潜在应用,并继续提高模型性能。

| [1] |

孙远, 姚元, 伍光新, 等. 无人艇信息感知系统发展分析与探讨[J]. 现代雷达, 2022, 44(9): 13-20. |

| [2] |

韩小溪, 盛立, 苏强, 等. 英国“鹦鹉螺”-100新概念潜艇研究[J]. 舰船科学技术, 2020, 42(13): 178-182. HAN Xiaoxi, SHENG Li, SU qiang, et al. Research on new concept submarine of British Nautilus-100[J]. Ship Science and Technology, 2020, 42(13): 178-182. |

| [3] |

杨婷, 高武奇, 王鹏, 等. 自动色阶与双向特征融合的水下目标检测算法[J]. 激光与光电子学进展, 2023, 60(6): 132-143. |

| [4] |

陈小毛, 王立成, 张健, 等. 融合YOLOv5与ASFF算法的海产品目标检测算法研究[J]. 无线电工程, 2023, 53(4): 824-830. |

| [5] |

曹建荣, 庄园, 汪明, 等. 基于ECA的YOLOv5水下鱼类目标检测[J]. 计算机系统应用, 2023, 32(6): 204-211. |

| [6] |

袁明阳, 宋亚林, 张潮, 等. 基于GA-RetinaNet的水下目标检测[J]. 计算机系统应用, 2023, 32(6): 80-90. |

| [7] |

周华平, 宋明龙, 孙克雷. 一种轻量化的水下目标检测算法SG-Det[J]. 光电子·激光, 2023, 34(2): 156-165. |

| [8] |

FAN D P, JI G P, SUN G, et al. Camouflaged object detection[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition, 2020: 2777-2787.

|

| [9] |

史彩娟, 任弼娟, 王子雯, 等. 基于深度学习的伪装目标检测综述[J]. 计算机科学与探索, 2022, 16(12): 2734-2751. |

| [10] |

陈炜玲, 邱艳玲, 赵铁松, 等. 面向海洋的水下图像处理与视觉技术进展[J/OL]. 信号处理: 1−17[2023-09-30].

|

| [11] |

MEHTA S, RASTEGARI M. Mobilevit: light-weight, general-purpose, and mobile-friendly vision transformer[J]. arXiv Preprint arXiv: 2110.02178, 2021.

|

| [12] |

KE Z, SUN J, LI K, et al. Modnet: real-time trimap-free portrait matting via objective decomposition[C]//Proceedings of the AAAI Conference on Artificial Intelligence, 2022, 36(1): 1140−1147.

|

| [13] |

FAN D P, JI G P, CHENG M M, et al. Concealed object detection[J]. IEEE transactions on Pattern Analysis and Machine Intelligence, 2021, 44(10): 6024-6042. |

| [14] |

JI G P, FAN D P, CHOU Y C, et al. Deep gradient learning for efficient camouflaged object detection[J]. Machine Intelligence Research, 2023, 20(1): 92-108. DOI:10.1007/s11633-022-1365-9 |

| [15] |

SANDLER M, HOWARD A, ZHU M, et al. Mobilenetv2: Inverted residuals and linear bottlenecks[C]//Proceedings of the IEEE conference on computer vision and pattern recognition, 2018: 4510−4520.

|

| [16] |

HUANG Q, XIA C, WU C, et al. Semantic segmentation with reverse attention[J]. arXiv Preprint arXiv: 1707.06426, 2017.

|

| [17] |

MEI H, JI G P, WEI Z, et al. Camouflaged object segmentation with distraction mining[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2021: 8772−8781.

|

| [18] |

MEHTA S, RASTEGARI M. Separable self-attention for mobile vision transformers[J]. arXiv preprint arXiv: 2206.02680, 2022.

|

| [19] |

SERGEY I, CHRISTIAN S. Batch normalization: Accelerating deep network training by reducing internal covariate shift. In ICML, 2015.

|

| [20] |

WEI J, WANG S, HUANG Q. F³Net: fusion, feedback and focus for salient object detection[C]//Proceedings of the AAAI conference on artificial intelligence, 2020, 34(7): 12321-12328.

|

| [21] |

LOSHCHILOV I, HUTTER F. Stochastic gradient descent with warm restarts[C]//Proceedings of the 5th Int. Conf. Learning Representations, 1−16.

|

| [22] |

KINGMA D P, BA J. Adam: A method for stochastic optimization[J]. arXiv preprint arXiv: 1412.6980, 2014.

|

| [23] |

LE T N, NGUYEN T V, NIE Z, et al. Anabranch network for camouflaged object segmentation[J]. Computer Vision and Image Understanding, 2019, 184: 45-56. DOI:10.1016/j.cviu.2019.04.006 |

| [24] |

LV Y, ZHANG J, DAI Y, et al. Simultaneously localize, segment and rank the camouflaged objects[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2021: 11591−11601.

|

| [25] |

FAN D P, CHENG M M, LIU Y, et al. Structure-measure: A new way to evaluate foreground maps[C]//Proceedings of the IEEE international conference on computer vision, 2017: 4548−4557.

|

| [26] |

FAN D P, GONG C, CAO Y, et al. Enhanced-alignment measure for binary foreground map evaluation[J]. arXiv Preprint arXiv: 1805.10421, 2018.

|

| [27] |

MARGOLIN R, ZELNIK-MANOR L, TAL A. How to evaluate foreground maps?[C]//Proceedings of the IEEE conference on computer vision and pattern recognition, 2014: 248−255.

|

| [28] |

PERAZZI F, KRÄHENBÜHL P, PRITCH Y, et al. Saliency filters: Contrast based filtering for salient region detection[C]//2012 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2012: 733−740.

|

| [29] |

FAN Dengping, JI Gepeng, ZHOU Tao, et al. "PraNet: Parallel Reverse Attention Network for Polyp Segmentation.[J]" ArXiv abs/2006.11392, 2020(3): 1−11.

|

| [30] |

QIN Xuebin, DENG Pingfan, HUANG Chenyang, et al. "Boundary-Aware Segmentation Network for Mobile and Web Applications." ArXiv abs/2101.04704, 2021(5): 1−19.

|

| [31] |

YUAN Li, TAYFEN, LI G, et al. Revisiting Knowledge Distillation via Label Smoothing Regularization, [C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) (2020): 3902−3910.

|

| [32] |

ZHAO Jiaxing, LIU J J, FAN D P, et al. EGNet: Edge Guidance Network for Salient Object Detection, [C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV) (2019): 8778−8787.

|

| [33] |

JI Gepeng, ZHU L, ZHU G M, et al. Fast Camouflaged Object Detection via Edge-based Reversible Re-calibration Network[J]. Pattern Recognit. 2022, 123: 108414.

|

2024, Vol. 46

2024, Vol. 46