船舶在航行过程中通过摄像机或者CCD可以获取周围环境的图像,通过对这些图像的识别及特征提取就可以对周围的目标进行判断,为船舶航行安全提供有效保障。但是船舶获取这些图像时,由于摄影镜头的景深限制或外部环境因素,捕获全聚焦画面往往难以实现。传统摄像机或者CCD在调整焦距时,需要依赖于适宜的自然条件来确保图像的完整拍摄,由于图像中各物体距离的差异,得到的照片中不可避免地会同时出现清晰和模糊的区域,如果不加以处理将导致融合后的图像效果较差,给后续的船舶目标识别带来极大的挑战。

为了解决这个问题,国内外学者开始提出多焦点图像融合技术,该技术能够从一系列拍摄的图片中抽取关键的浅层特征,并通过特定的算法整合这些清晰的特征,同时模糊化图片中清晰与模糊区域的界限,保留原始图像的核心信息,从而生成一张所有目标都清晰可见的全焦点图像。多聚焦图像融合方法一直是近年来的研究热点,通过文献检索可以发现,很多学者将多聚焦图像融合方法用于汽车识别、船舶识别、纹理特征提取等多个领域,陈施宇[1]利用Transformer架构的全面特征捕捉能力,设计了一种集成了两个鉴别器的生成对抗网络(GAN)策略,生成器采用端到端的方式执行多焦点图像的融合工作,利用Transformer来捕获图像的全局相关性和细节的低频空间特征。刘宏利[2]将改进后的SSD算法和多聚焦图像融合算法结合,并将其成功应用于车辆的目标识别。吴盼[3]将深度学习算法和多聚焦图像算法进行有效结合,通过对图像中长距离特征和局部特征的有效提取,强化了图像中的信息融合程度。本文首先对深度学习和多聚焦图像技术的原理进行研究,在此基础上提出一种基于深度学习和多聚焦图像技术的船舶多聚焦图像融合方法,以期解决在复杂环境中多聚焦图像融合中图像不清晰的问题。

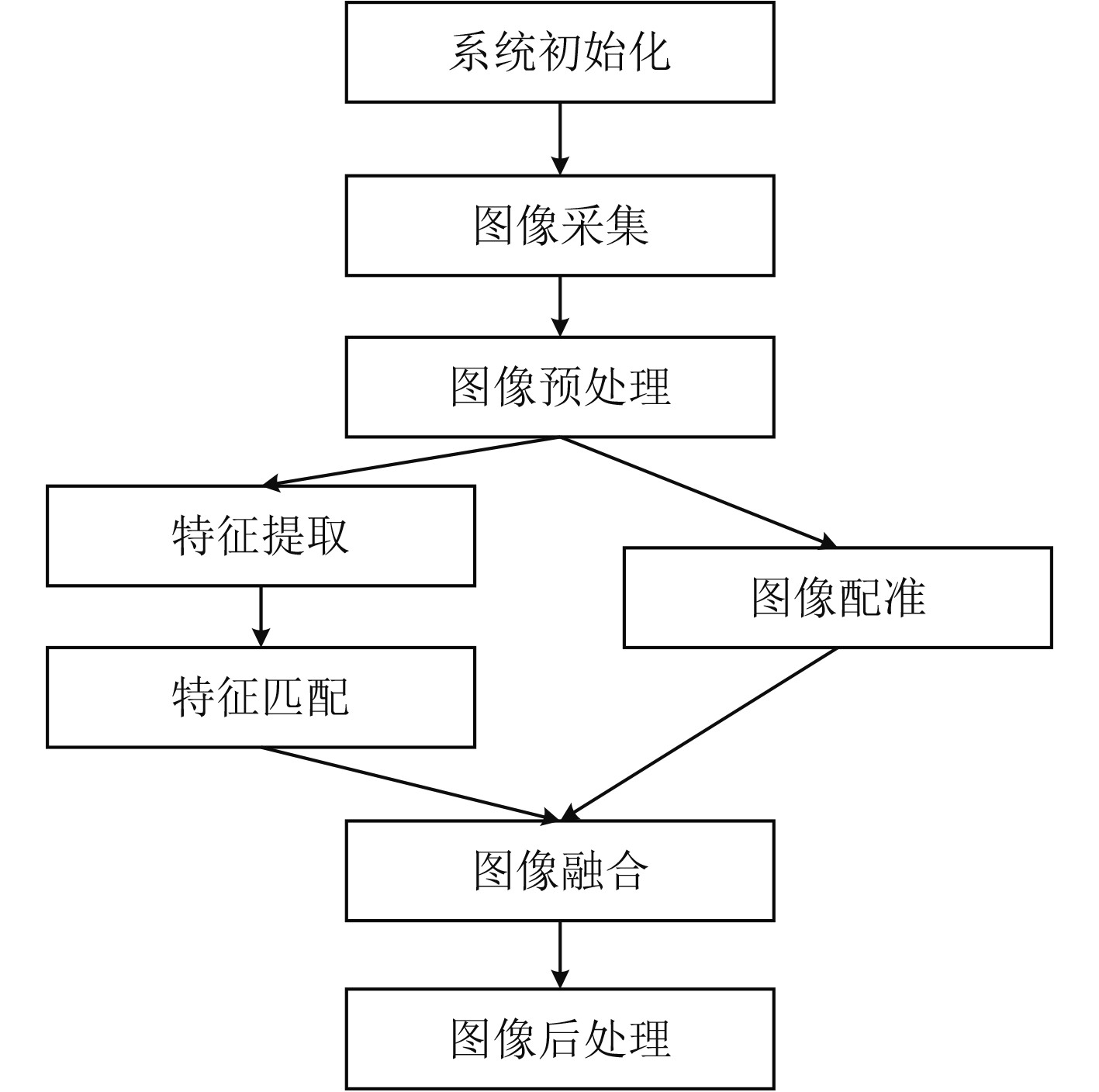

1 多聚焦图像融合实现 1.1 融合过程分析在获取的众多船舶环境图像中,如果单独提取一张出来后会发现其质量难以满足要求,这是由于船舶在行驶过程中布置在船体的摄像机经常会发生抖动,因而获取的静态图像难以使得所有景物都处于焦点上,最终在图像上有一部分是模糊的,一部分是清晰的。多聚焦图像融合(Multi-Focus Image Fusion,MFIF)通过结合多个不同聚焦点的图像来生成一个具有更大景深的单一图像,有效地选择和合并图像中的最佳部分,同时保持图像的自然性和一致性[4]。其基本流程如图1所示。

|

图 1 多聚焦图像融合过程 Fig. 1 Process of multi-focus image fusion |

1)系统初始化。在进行多聚焦图像融合过程前,需要将系统初始化,加载系统所需的配置文件,包括图像采集参数、处理算法的参数、融合策略等。

2)图像采集。需要拍摄一系列具有不同聚焦点的图像。这些图像通常在不同的焦距上拍摄,以确保每个图像都至少有一个区域清晰。

3)图像预处理。对采集到的图像进行预处理,包括去噪、对比度增强等,以提高后续处理的准确性。

4)特征提取。在所有图像中提取特征点,这些特征点可以是边缘、角点或任何其他显著的图像特征。这一步通常使用特征检测算法,如SIFT(尺度不变特征变换)、SURF(加速稳健特征)等。

5)特征匹配。在不同图像之间匹配相应的特征点。这涉及到计算特征描述符并使用匹配算法(如FLANN或KD-Tree)来找到最佳匹配。

6)图像配准。根据特征匹配的结果,确定图像之间的几何关系,这个过程包括图像的旋转、缩放/平移,以确保所有图像在空间上对齐。

7)图像融合。一旦图像对齐,就可以开始融合过程,将多张船舶图片中最清晰的部分合并到最终图像中。融合算法可以是简单的像素级复制,也可以是更复杂的方法,如基于梯度的融合或基于深度学习的融合[5]。

8)图像后处理。融合后的图像需要进一步的处理,如颜色校正、边缘平滑等,以提高最终图像的质量。

1.2 特征提取及匹配在多聚焦图像融合中,其核心技术是如何对图像的特征进行提取,并进行后续的特征匹配,以保证图像始终在空间上能够对齐。本文采用SIFT变换来进行特征提取,其主要思路是:

1)尺度空间极值检测

尺度空间是通过对原始图像应用不同尺度的高斯滤波器来构建,其计算方法为将原始图像与高斯核进行卷积操作,其表达式如下:

| $ L(x,y,\sigma)=G(x,y,\sigma)\cdot I(x,y)。$ |

式中:L为船舶尺度空间图像;G为高斯核;I为原始图像;σ为尺度参数。

SIFT算法在不同尺度的高斯模糊图像中寻找关键点。通过计算高斯差分(Difference of Gaussians, DoG)来实现,即在不同尺度的高斯模糊图像之间进行差分操作。通过DoG,可以在每个尺度上找到局部最大或最小点,这些点在图像的多个尺度上都保持稳定。

计算相邻图像的高斯差分

| $ D(x,y,\sigma)=L(x,y,k\sigma)-L(x,y,\sigma)\text{。} $ |

式中:k为尺度因子。

2)关键点的定位

确定关键点的位置,以确保它们对图像的微小变化具有鲁棒性。对于每个关键点,SIFT算法会分配一个主方向,通常是通过计算关键点邻域内的梯度方向直方图来实现的[6]。

3)关键点描述

SIFT算法为每个关键点生成一个描述符,该描述符是对关键点周围邻域内梯度方向和大小的统计。在每个像素位置上,检查DoG图像中的值是否是其3×3邻域内的局部极值。这包括比较当前像素点与其8个邻居以及在更大和更小尺度上的对应点。

4)直方图计算

计算关键点邻域内的梯度方向直方图,并选择直方图中的主要峰值作为关键点的主方向。

5)特征描述

为每个关键点生成一个描述符,通常是一个4×4的梯度方向直方图,每个方向直方图包含8个方向和4个尺度。

图2为获取的船舶图像SIFT特征点提取结果,对船舶特征进行计算,根据SIFT算法分配的主方向继续进行计算并判断极值,直到超出船舶图像边缘。

|

图 2 船舶SIFT特征点提取结果 Fig. 2 Extraction results of ship SIFT feature point |

卷积神经网络(CNN)是一种常见的深度学习模型,船舶多聚焦图像融合在特征提取后,如何基于这些特征将多个图像融合到一起,得到最佳输出图像一直是研究的热点。为了解决这个问题,就需要建立一种基于CNN算法的MFIF框架,设计一个网络架构,通过网络架构定义出不同焦距图像的融合规则以及学习方法。

1)问题定义

多聚焦图像融合的目标是将多个部分聚焦的图像I1,I2,I3,···In融合为一个全聚焦图像F。

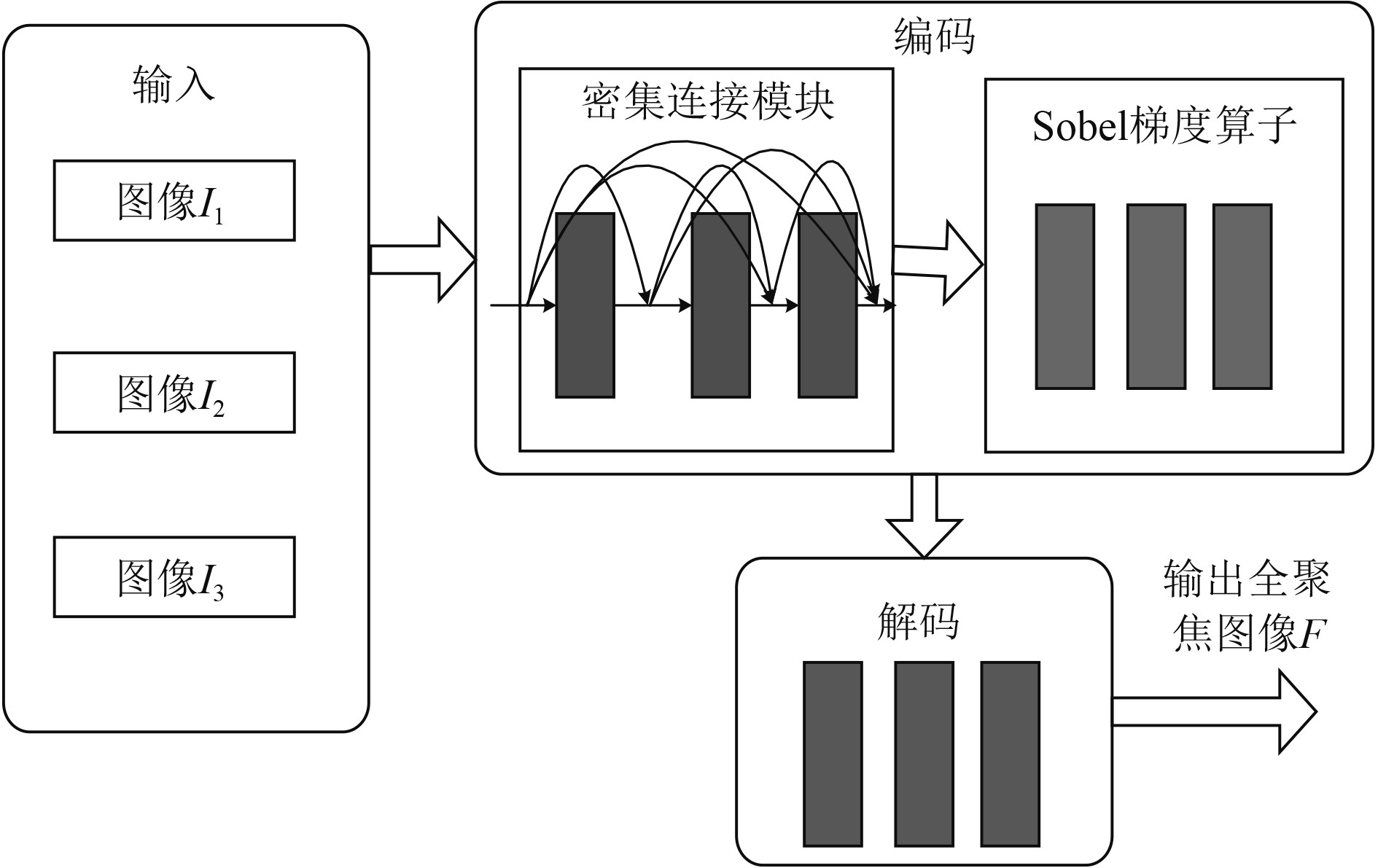

2)训练阶段网络框架

为了解决这个问题,设计一个CNN网络G(x),该网络接收多个输入图像并输出一个融合图像。网络包含输入层、特征提取层、融合层以及输出层。输入层接收n张图像作为系统输入,特征提取层使用CNN网络的卷积层和激活函数对图像特征进行提取,然后使用CNN网络对其进行训练,训练阶段的网络框架如图3所示。

|

图 3 训练阶段网络框架 Fig. 3 Network framework of training phase |

训练阶段分为编码和解码2个阶段,在编码阶段,使用密集连接模块和Sobel梯度算子来解决多聚焦图像的细粒度和深度特征融合问题。传统的密集连接模块的连接方式为顺序连接,本文建立的网络框架实现跨层连接,这种连接方式的优势在于使得不同层的特征图可以有效地融合,这有助于捕获多尺度和多级别的特征,增强网络的特征学习能力,同时减少了网络中的参数数量,相比于传统的卷积网络,它在参数数量上更加高效。

Sobel梯度算子增强了图像中的高频成分,有助于突出船舶图像的清晰度和边缘,同时有助于提取船舶图像的纹理特征,对图像中的局部变化更为敏感。Sobel梯度算子的定义如下:

梯度幅度

梯度方向

在编码阶段可以获取所有输入图像的低频和高频特征,并建立图像和特征值之间的映射关系,为后续多聚焦图像融合做好准备。

3)图像融合网络框架

图像融合框架在很大程度上决定了最终获得的图像的质量,图4为图像融合网络框架,在编码阶段已经获得特征值和图像之间的映射,并将其分为低频部分和高频部分,此时使用离散小波变换来获取不同频段上图像的基本特征信息,此时获取的信息具有高度的独立性,不会互相影响。在解码模块中,使用逆离散小波变换还原这些低频和高频信息,并将不同频段的信息进行融合。

|

图 4 图像融合网络框架 Fig. 4 Network framework of image fusion |

以本文为例,本文采用了3张图片作为输入,在融合时需要赋予这3张图片的低频分量和高频分量不同的权值,其权重计算方法为:

| $ Q_{L\mathit{{ow}}-i}(x,y)=\frac{P(L_{Low-i}(x,y))}{\displaystyle\sum_{i=1}^3P(L_{Low-i}(x,y))}\text{。} $ |

式中:

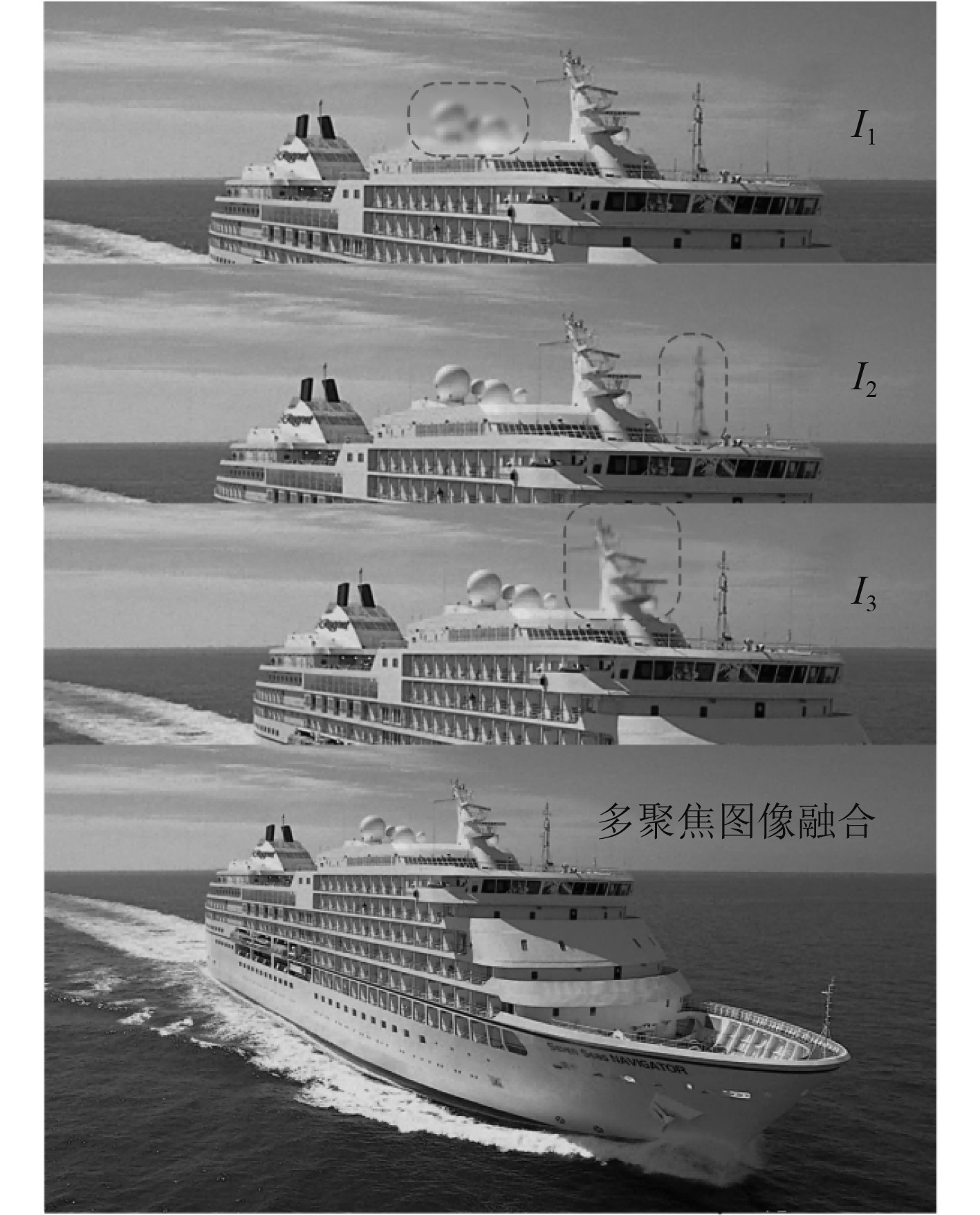

使用本文建立的基于CNN的MFIF框架,对图5中的I1、I2、I3进行融合,可以发现,由于焦点不一,图5中的前3张图中均有一部分模糊(图中方框部分),而其他部分则清晰,在进行多聚焦图像融合后,对不同图像中的清晰部分进行有效提取,并在空间坐标上进行统一,使得最终输出的船舶图像非常清晰。

|

图 5 多聚焦图像融合效果 Fig. 5 Effect of multi-focus image blending |

由于焦点不一,船舶采集的图像经常会出现模糊的情况,多聚焦融合可以有效解决这种问题,本文提出了一种基于CNN的多聚焦图像融合方法,得到的结论主要有:

1)分析了多聚焦图像融合的过程,阐述了SIFT变换用于特征提取的原理;

2)提出了基于CNN的多聚焦图像融合训练阶段网络框架和图像融合网络框架,并使用多张图片进行图像融合,结果发现通过多聚焦图像融合实现了每张图片清晰部分的有效提取,并在空间尺度上实现了坐标统一。

| [1] |

陈施宇, 金鑫, 习修良, 等. 基于Transformer和生成对抗网络的多聚焦图像融合[J]. 云南大学学报(自然科学版), 2024(6): 1-11. CHEN Shiyu, JIN Xin, XI Xiuliang, et al. Multi-focus image fusion based on transformer and generative adversarial network[J]. Journal of Yunnan University (Natural Science Edition), 2024(6): 1-11. DOI:10.7540/j.ynu.20230364 |

| [2] |

刘宏利, 王健, 邵磊, 等基于改进SSD和多聚焦图像融合的车辆目标识别[J]. 天津理工大学学报, 2024(6): 1−9. LIU Hongli, WANG Jian, SHAO Lei, et al. Vehicle target recognition based on improved SSD and multi-focus image fusion [J]. Journal of Tianjin University of Technology, 2024 (6): 1−9. |

| [3] |

吴盼. 基于深度学习的多聚焦图像融合方法研究[D]. 烟台: 山东工商学院, 2023.

|

| [4] |

刘丽丽, 赵玉. 多聚焦图像焦深扩展分解融合算法仿真[J]. 计算机仿真, 2023, 40(4): 195-198+218. LIU Li-Li, ZHAO Yu. Simulation of multi-focus image depth extension decomposition fusion algorithm[J]. Computer Simulation, 2023, 40(4): 195-198+218. DOI:10.3969/j.issn.1006-9348.2023.04.038 |

| [5] |

谢明, 曲怀敬, 张志升, 等. 基于导向滤波和聚焦区域局部标准差的多聚焦图像融合[J]. 计算机与数字工程, 2023, 51(2): 348-354. XIE Ming, QU Huaijing, ZHANG Zhisheng, et al. Multi-focus image fusion based on guided filtering and local standard deviation of focus area[J]. Computer and Digital Engineering, 2023, 51(2): 348-354. DOI:10.3969/j.issn.1672-9722.2023.02.014 |

| [6] |

张弼晗, 许东辉, 丁德锐, 等. 一种基于形态学梯度的多聚焦图像融合方法[J]. 信息技术, 2023, 47(1): 22-26. ZHANG Bihan, XU Donghui, DING Derui, et al. A multi-focus image fusion method based on morphological gradient[J]. Information Technology, 2023, 47(1): 22-26. |

2024, Vol. 46

2024, Vol. 46