舰船在航行过程中需要不断对周围环境进行探查,探查对象包括其他舰船、障碍物、浮漂等,而在复杂环境中仅仅依靠雷达、AIS等则无法完全识别一些陌生目标,视觉图像处理方案是通过使用高清晰摄像头来获取目标图像,使用特征提取和匹配的方式来完成对目标的识别,将视觉图像处理方案获得的结果和雷达以及AIS获取的结果进行综合比对,即可准确识别目标。单一视觉图像处理方案由于获取目标图像的角度较为固定,因而在目标识别上受到很大局限,单一角度的图像并不能最大程度上反映出目标舰船、障碍物的基本特征,极易造成误判,这就给舰船的安全航行以及战时作战能力带来极大困扰。在这种情况下,多方位视觉图像处理方案就可以有效解决这种问题。多方位视觉图像特征深度提取系统(Multi-view Visual Image Feature Depth Extraction System)是利用计算机视觉技术从多个角度捕获的图像中提取深层次特征的系统。这种系统能够分析和处理来自不同视角的图像数据,以识别、分类和理解场景中的对象和环境。

国内对多方位视觉图像处理技术的主要研究方向是双目视觉系统和多目视觉系统,郝亚楠[1]使用双目视觉对物体进行识别和测距。王行洲[2]提出了一种多目视觉识别系统,并将系统应用到电芯自动上料设备中,取得了良好的效果。雷洁等[3]使用双目视觉技术对无人船的轨迹跟踪进行了研究,通过视觉图像技术完成目标的识别和位置估计。张啸尘等[4]利用SURF算法和视觉图像技术对目标船舶进行匹配和定位,可以为船舶避碰提供有效辅助。此基础上,提出一种多方位视觉图像特征提取方案,通过在舰船的不同位置上设置高清摄像头,获取不同角度的目标图像,并对这些图像进行特征的深度提取,最终完成对目标的精确识别。

1 系统设计建立的舰船多方位视觉图像特征深度提取系统主要包括多方位图像捕获、图像预处理、特征提取、特征融合、目标识别和分类。多方位视觉图像深度提取系统的优势在于能够提供比单一视角更丰富的信息,增强了对复杂场景的理解和处理能力。通过综合利用多个视角的数据,可以提高识别的准确性和鲁棒性,从而在各种视觉任务中取得更好的性能[5 − 6]。

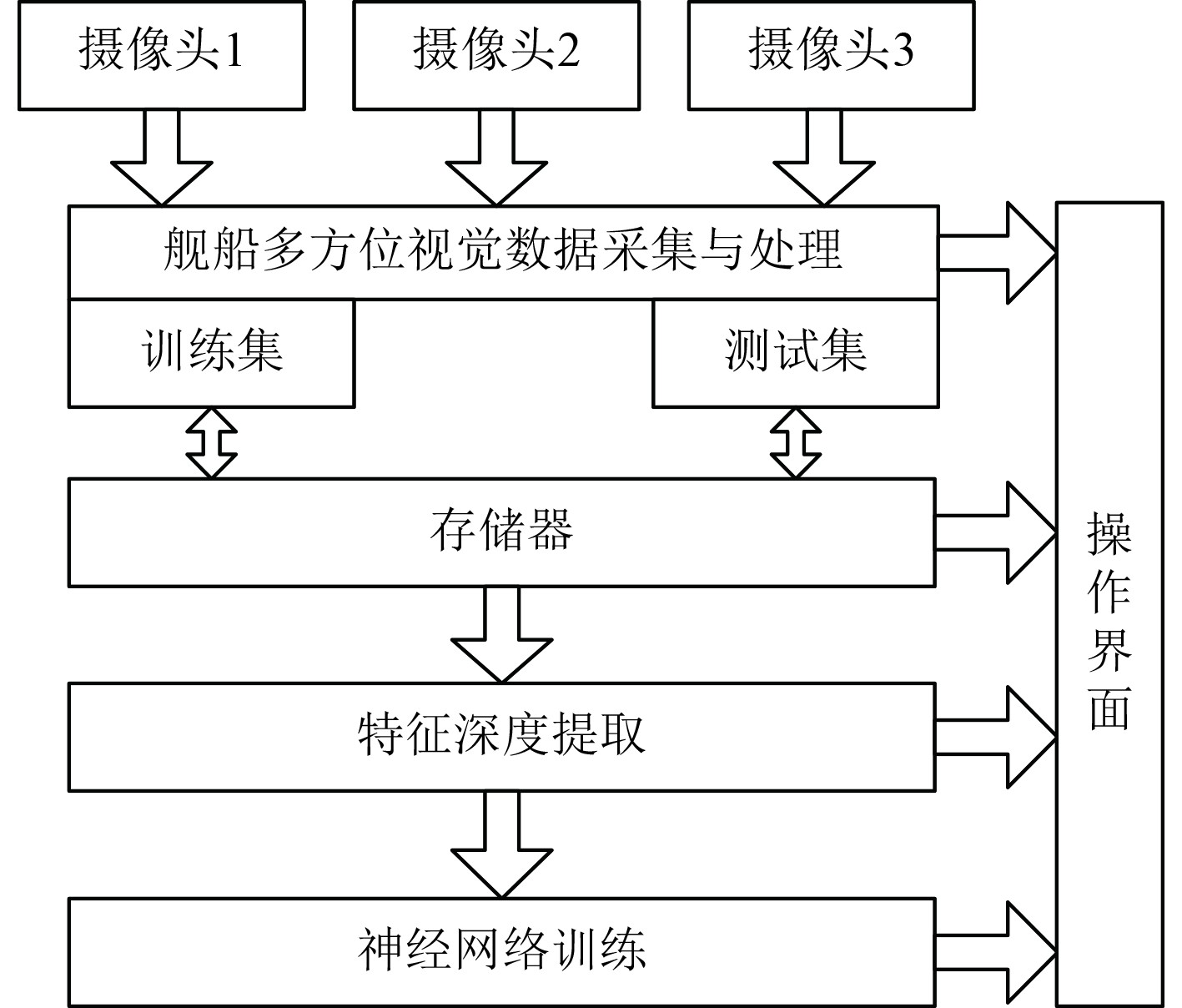

设计的舰船多方位视觉图像特征深度提取系统包括多个摄像头、舰船多方位视觉数据采集与处理模块、存储器、特征深度提取、神经网络训练以及操作界面,系统结构框图如图1所示。

|

图 1 系统结构框图 Fig. 1 System architecture diagram |

1)摄像头解决的是图像捕获的问题,多方位图像捕获中有几个关键问题需要解决,一方面是合适的图像获取设备,其分辨率、防水性、支持360°旋转都是关键考虑因素,使其满足军用舰船使用标准,能够在复杂海洋环境中获取高质量图像。为了实现全方位覆盖,摄像头和其他传感器需要被安置在舰船的关键位置,如舰桥、桅杆、船舷等。设计时应考虑到设备的防护措施,确保其在恶劣海洋环境中的稳定性和耐用性。

舰船多方位视觉数据采集与处理模块是将摄像头中的模拟信号转换成离散的数字信号,在模块中可以设置采集模式,包括采集频率、采集角度等,这些采集的数据最终可以分为两类,一类用于卷积神经网络的训练集,另外一类作为测试集。

2)存储器是用于储存所有采集到的图像,特征深度提取首先从存储器中读取所有采集到的图像,然后根据目标特征进行提取,这些特征包括形状、轮廓等。

3)神经网络训练是使用卷积神经网络对建立的训练集进行训练,在完成训练后可以对测试集进行测试,并得到对应分类结果,最终完成目标的识别分类。

4)操作界面可以对各个模块发出指令进行对应操作,并将所有过程和结果加以显示。

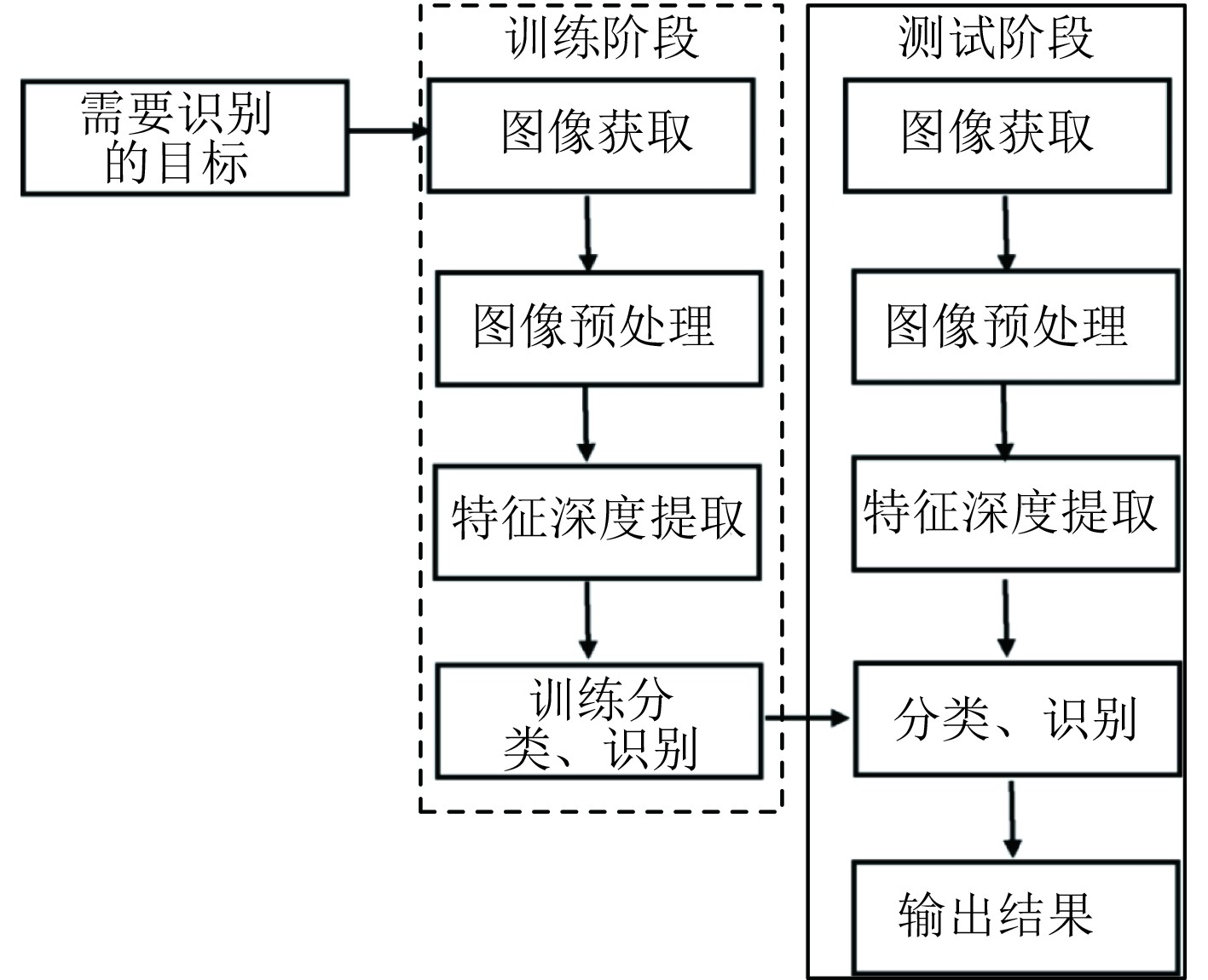

舰船多方位视觉图像特征深度提取是为了航行中的目标识别,这些目标包括礁石、浮标、舰船以及其他船舶,其工作流程如图2所示,包括训练阶段和测试阶段,这2个阶段中都需要获取图像、对图像进行预处理、特征深度提取以及分类识别等,不同的是在训练过程中分类识别的对象是训练集,而测试阶段识别的对象是测试集,虽然两者数据都来源于多方位视觉数据采集系统,但是在训练阶段可以设定训练次数来提升系统的识别正确率。

|

图 2 多方位视觉图像识别流程 Fig. 2 Multi-directional visual image recognition process |

在图像预处理阶段,获取的图像可能受到各种干扰,如海浪、云雾、光照变化等。因此需要对图像进行预处理,包括去噪、对比度增强、畸变校正等,以提高图像质量,为后续的特征提取做好准备。

利用计算机视觉算法从多个角度的目标图像中提取关键特征,如边缘、角点、纹理、颜色直方图等。深度特征提取涉及使用深度学习模型,如卷积神经网络(CNN),将图像的基本特征和目标类型实现映射关系。同时为了获得更全面的视角,可以将来自不同方位的视觉图像特征进行融合处理,可以提高在夜间或恶劣天气条件下的目标检测能力。

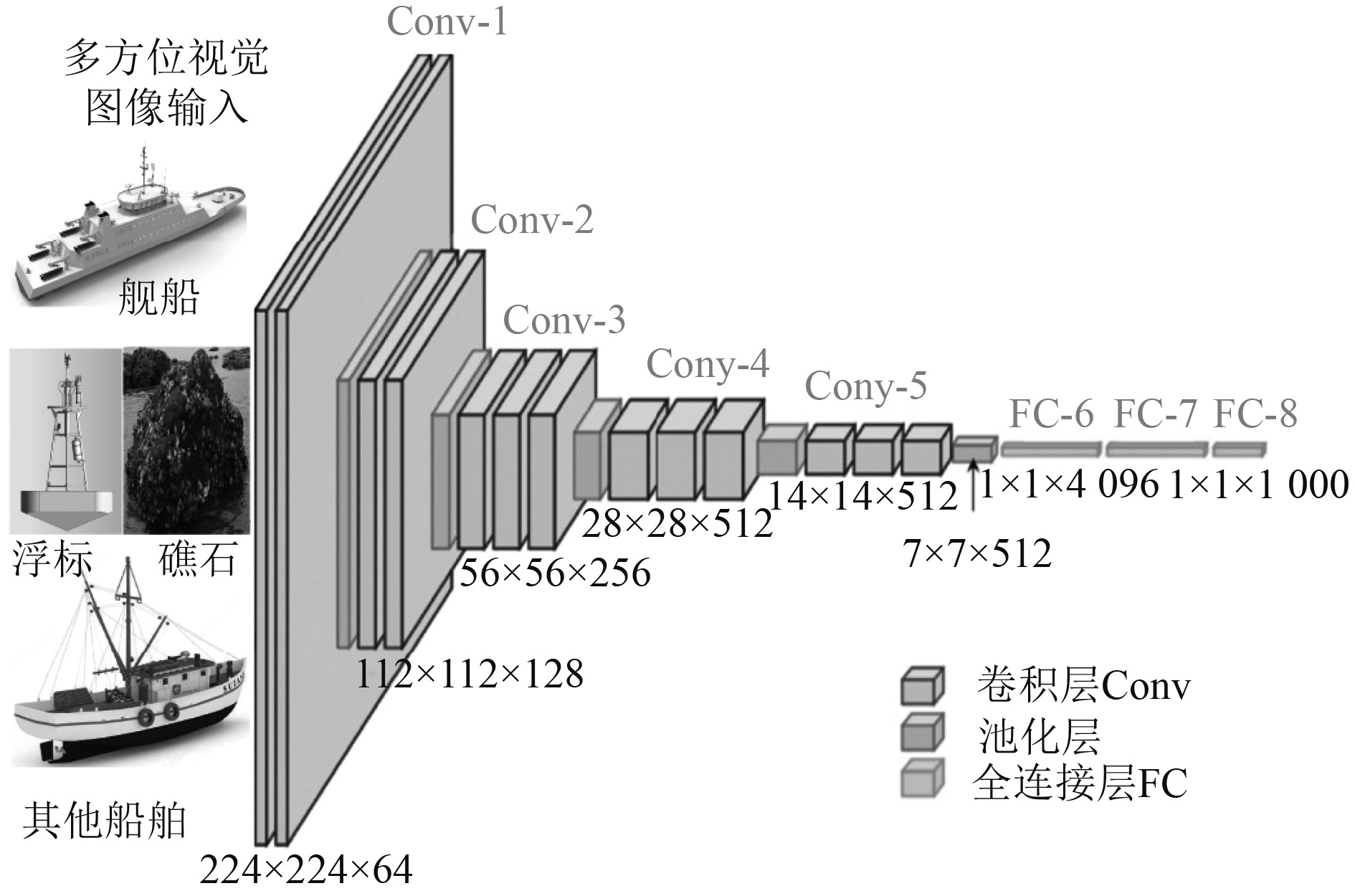

2 图像特征深度提取的实现 2.1 基于CNN的特征深度提取CNN(Convolutional Neural Network)通过使用多层神经网络结构能够自动学习图像数据中的复杂模式和特征,从而在多种图像分析任务中取得了显著的成果。卷积神经网络通常需要大量的标记数据进行训练,通过反向传播算法和梯度下降等优化技术,网络能够调整其权重,最小化预测输出和实际标签之间的差异。CNN网络中包含多个卷积层(Conv)、池化层(max pooling)以及全连接层(FC),其结构如图3所示。

|

图 3 基于CNN的特征深度提取 Fig. 3 Feature deep extraction based on CNN |

将所有多方位视觉图像输入尺寸确定为224×224×64,其中224×224代表图像的宽度和高度,64代表输入图像的通道数。Conv-1:第1层卷积层使用64个3×3的卷积核进行卷积操作,输出的特征图(feature maps)尺寸为112×112×64,由于输入图像尺寸是224×224,经过卷积后尺寸减小,步长stride为1。Conv-2:第2层卷积层继续提取更深层次的特征,使用不同数量和大小的卷积核,输出的特征图尺寸可能进一步减小,同时通道数可能增加。Conv-3到Conv-5:后续的卷积层继续进行类似的操作,每一层都可能使用不同数量和大小的卷积核,以及不同的激活函数(如ReLU),来提取越来越抽象的特征。随着网络层次的加深,特征图的尺寸逐渐减小,通道数逐渐增加,CNN网络开始捕捉多方位视觉图像中更复杂的特征。

池化层跟在卷积层之后,用于降低特征图的空间尺寸(即宽度和高度),减少参数数量和计算量。图中未明确指出池化层,但通常VGG-16会在每个卷积层之后使用2×2的最大池化操作。

经过多个卷积和池化层之后,特征图被展平(flatten),并输入到第一个全连接层。FC-6层通常具有大量神经元,这里假设为4096个,并通过ReLU激活函数进行非线性变换。随后的全连接层继续进行特征的组合和抽象,这里假设有1000个神经元。最后一个全连接层输出最终预测结果,在图像分类任务中,输出的尺寸对应于分类的类别数。最后通过softmax函数或其他分类器,将网络的输出转换为概率分布,从而确定输入图像属于各个类别的概率。

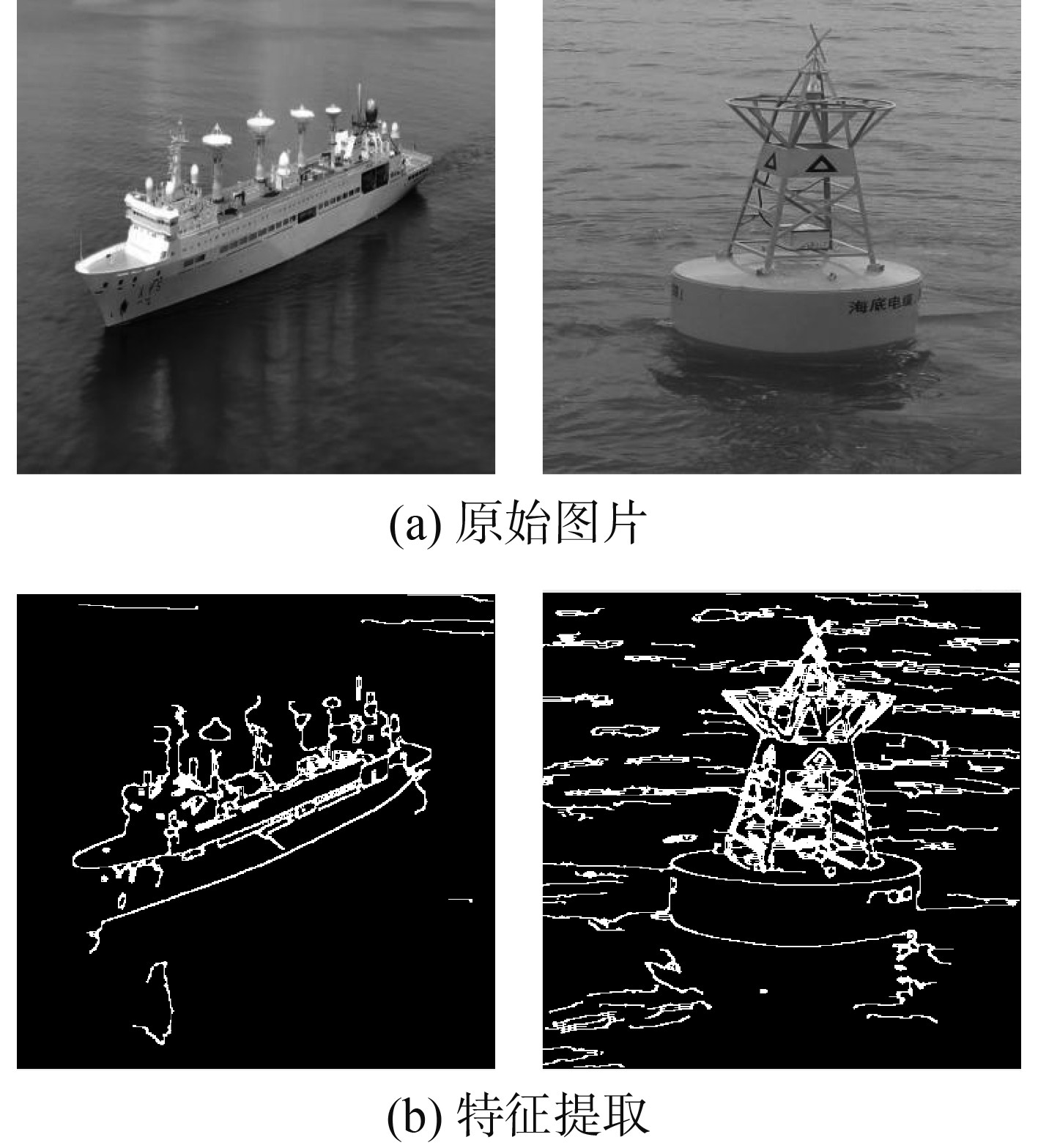

对某船舶图像和浮标图像特征进行提取,其效果如图4所示。可以发现,对船舶目标的识别中图像受到环境背景、获取图像的角度以及图像光线的对比度等影响,船舶前端轮廓有部分未加以正确识别,而背景环境中有一些波浪的特征也被识别出来。对于浮标而言,由于背景颜色和浮标颜色有较大相似,因而在背景中有很多波浪被误识别,但是浮标的整体轮廓仍然被正确识别。对于这样2种情况可以通过调整目标和背景之间的阈值即可将图像中的误识别部分加以去除。

|

图 4 视觉图像特征深度提取结果对比 Fig. 4 Comparative results of deep feature extraction from visual images |

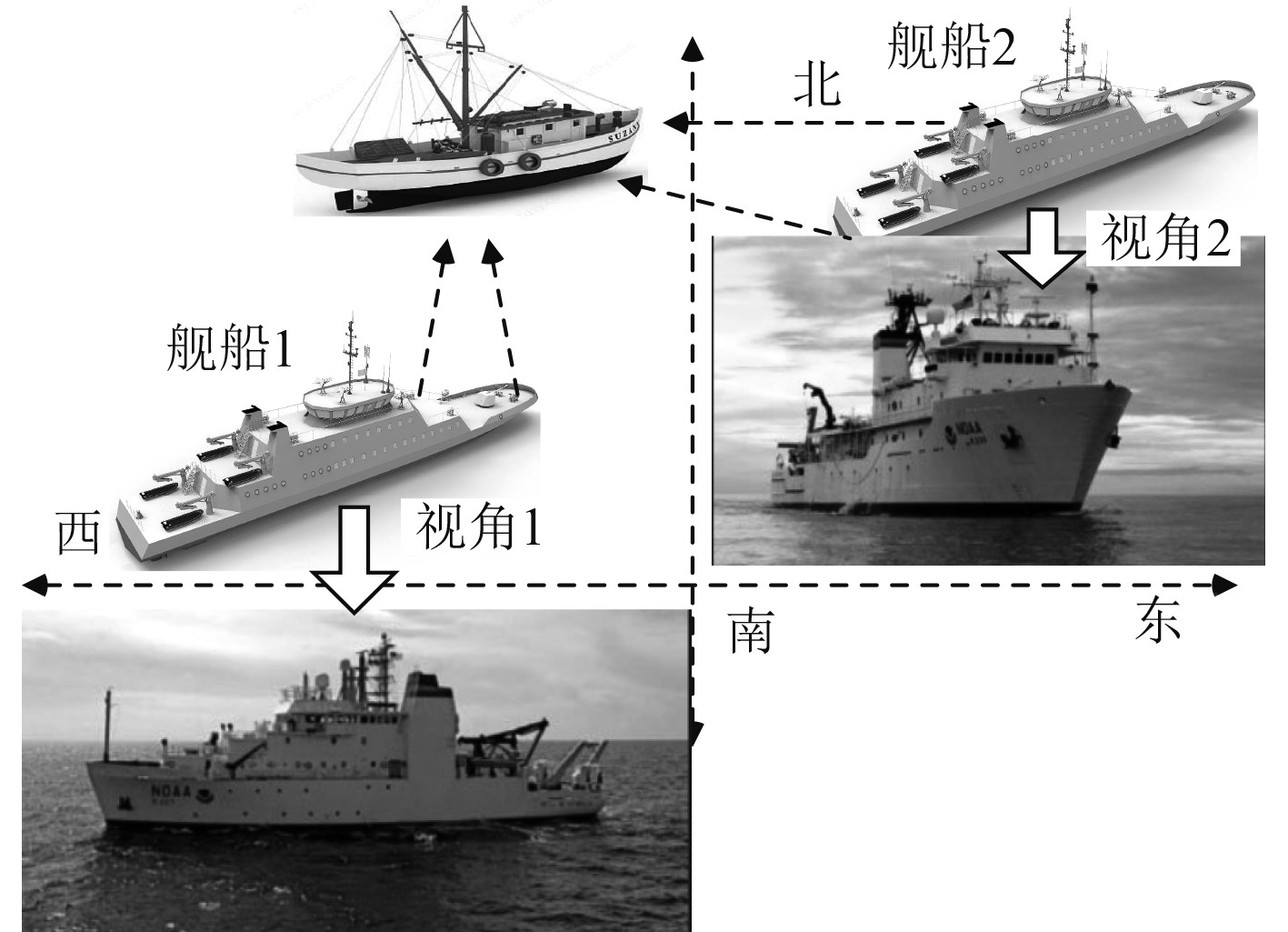

由于从不同方位获取的图像质量存在差别,同时从某个方向获取的图像还有可能存在误差,因而在获取多方位视觉图像后,不仅需要使用CNN算法进行特征的深度提取,同时还需要将多个方位图像进行多尺度融合。融合策略应该能够最大化地利用各个感知源的互补信息,提高特征表示的丰富性和准确性。本文提出将协同感知策略应用于舰船多方位视觉图像特征深度提取中,此时图像来源不仅可以为单一舰船上设置的不同摄像头,同时还可以是舰队中的不同摄像头,通过这种方式可以有效提升图像融合效果,图5为不同舰船上不同视角图像获取示意图。

|

图 5 不同视角图像获取 Fig. 5 Acquisition of images from different perspectives |

在图像融合策略上,使用拉普拉斯金字塔融合方式,其原理是基于图像的多尺度表示和信息的层次结构。通过构建拉普拉斯金字塔,可以将图像的细节信息与背景信息分离开来。在融合过程中,不同图像的细节信息被保留并结合起来,而背景信息则通过高斯金字塔进行平滑处理。这样,融合后的图像既保留了丰富的细节,又具有平滑的背景,从而提高了图像的整体质量,通过逐渐降低图像的分辨率并使用高斯滤波器来实现图像的平滑,每一层的图像都代表了不同的空间分辨率和模糊程度。

在高斯金字塔的基础上,计算每一层的拉普拉斯金字塔。拉普拉斯金字塔是通过从上一层的图像中减去下一层的图像来得到的,这可以看作是一种细节的增强。拉普拉斯金字塔的每一层都包含了图像在对应尺度下的细节信息。在融合不同视角的图像之前,需要确保这些图像在空间上对齐,这意味着所有图像都需要具有相同的尺寸和坐标系统,此时就需要对获取的目标图像进行裁剪、缩放或变换以实现配准。对于每一层的拉普拉斯金字塔,将对应层的图像进行融合,这通常通过加权求和、最大值合成或其他融合规则来实现。融合后的拉普拉斯金字塔包含了所有输入图像的细节信息,使用融合后的拉普拉斯金字塔和原始的高斯金字塔来重构融合图像。

3 结 语为了保证舰船航行安全,需要不断对环境进行探测,传统的雷达、AIS在实际应用中仍然存在一些限制,本文提出一种多方位视觉图像特征深度提取系统,通过设置多个高清晰摄像头来获取目标的多方位图像,并使用CNN算法对特征进行深度提取,在此基础上,对多尺度图像融合进行研究,使用拉普拉斯金字塔融合将不同舰船上获取的图像进行深度融合,提高了特征表示的丰富性和准确性。

| [1] |

郝亚楠. 双目视觉物体测距和识别的管理系统设计与实现[J]. 山西大同大学学报(自然科学版), 2024, 40(2): 25-28. HAO Ya-nan. Design and implementation of management system for binocular vision object distance measurement and recognition[J]. Journal of Shanxi Datong University (Natural Science Edition), 2024, 40(2): 25-28. |

| [2] |

王行洲, 秦立宇, 陈亮宏, 等. 多目视觉系统在电芯自动上料设备中的应用[J]. 机械研究与应用, 2024, 37(1): 150-152+156. WANG Xing-zhou, QIN Li-yu, CHEN Liang-hong, et al. Application of multi-vision system in automatic battery loading equipment[J]. Mechanical Research & Application, 2024, 37(1): 150-152+156. |

| [3] |

雷洁, 徐文华, 许国冬, 等. 基于双目视觉定位技术的无人船航迹跟踪控制室内模型实验[J]. 无人系统技术, 2022, 5(1): 43-50. LEI Jie, XU Wen-hua, XU Guo-dong, et al. Indoor model experiment of unmanned boat trajectory tracking control based on binocular vision localization technology[J]. Unmanned System Technology, 2022, 5(1): 43-50. |

| [4] |

张啸尘, 赵建森, 王胜正, 等. 基于YOLOv3算法的船舶双目视觉检测与定位方法[J]. 上海海事大学学报, 2021, 42(1): 26-32. ZHANG Xiao-chen, ZHAO Jian-sen, WANG Sheng-zheng, et al. Ship binocular vision detection and positioning method based on YOLOv3 algorithm[J]. Journal of Shanghai Maritime University, 2021, 42(1): 26-32. |

| [5] |

刘东辉, 柳飞, 刘奇. 基于激光与视觉融合的船舶扫描和吊具防撞系统及方法[J]. 起重运输机械, 2024(3): 33-37. LIU Dong-hui, LIU Fei, LIU Qi. Ship scanning and gantry anti-collision system and method based on laser and vision fusion[J]. Lifting and Transporting Machinery, 2024(3): 33-37. |

| [6] |

刘小飞, 李明杰, 喻佳. 无人机立体视觉识别船舶航行风险仿真[J]. 计算机仿真, 2024, 41(2): 29-33. LIU Xiao-fei, LI Ming-jie, YU Jia. Unmanned aerial vehicle stereo vision recognition of ship navigation risk simulation[J]. Computer Simulation, 2024, 41(2): 29-33. |

2024, Vol. 46

2024, Vol. 46