舰船模型三维重建主要目的是从二维图像中恢复出舰船的三维结构,为船舶的智能化监控和管理提供可靠依据[1],可以更有效地监控船舶的运行状态和安全状况[2]。除此之外,舰船的三维重建可以帮助军事领域进行模拟训练、战术分析和战场模拟。通过重建真实的舰船模型[3],可以模拟复杂的战场环境,提高军事行动的效率和安全性。但是在三维重建过程中,对于舰船数据的精准性要求较高[4],传统的重建方法无法满足当下的高精度需求。何鑫睿等[5]为实现三维重建,将多尺度和注意力机制引入Pix2Vox网络中,提升网络的多尺度特征分析能力,以此保证目标的三维重建效果;但是该方法在应用过程中,仅对单图像进行重建,导致重建结果的多视角效果较差。白静等[6]为保证三维重建效果,以输入图像为依据,获取视图中的空间结构信息,保证重建效果;但是该方法在应用过程中,定义同一个区域内的像素完全一致,导致图像细节的感知存在一定不足。

计算机视觉是利用计算机完成图像或者视频处理以及分析的技术,在处理过程中能够充分分析图像、视频的信息、状态,以此实现目标的识别、跟踪等。其在目标识别、目标监控以及跟踪等领域中具有较好的应用效果。

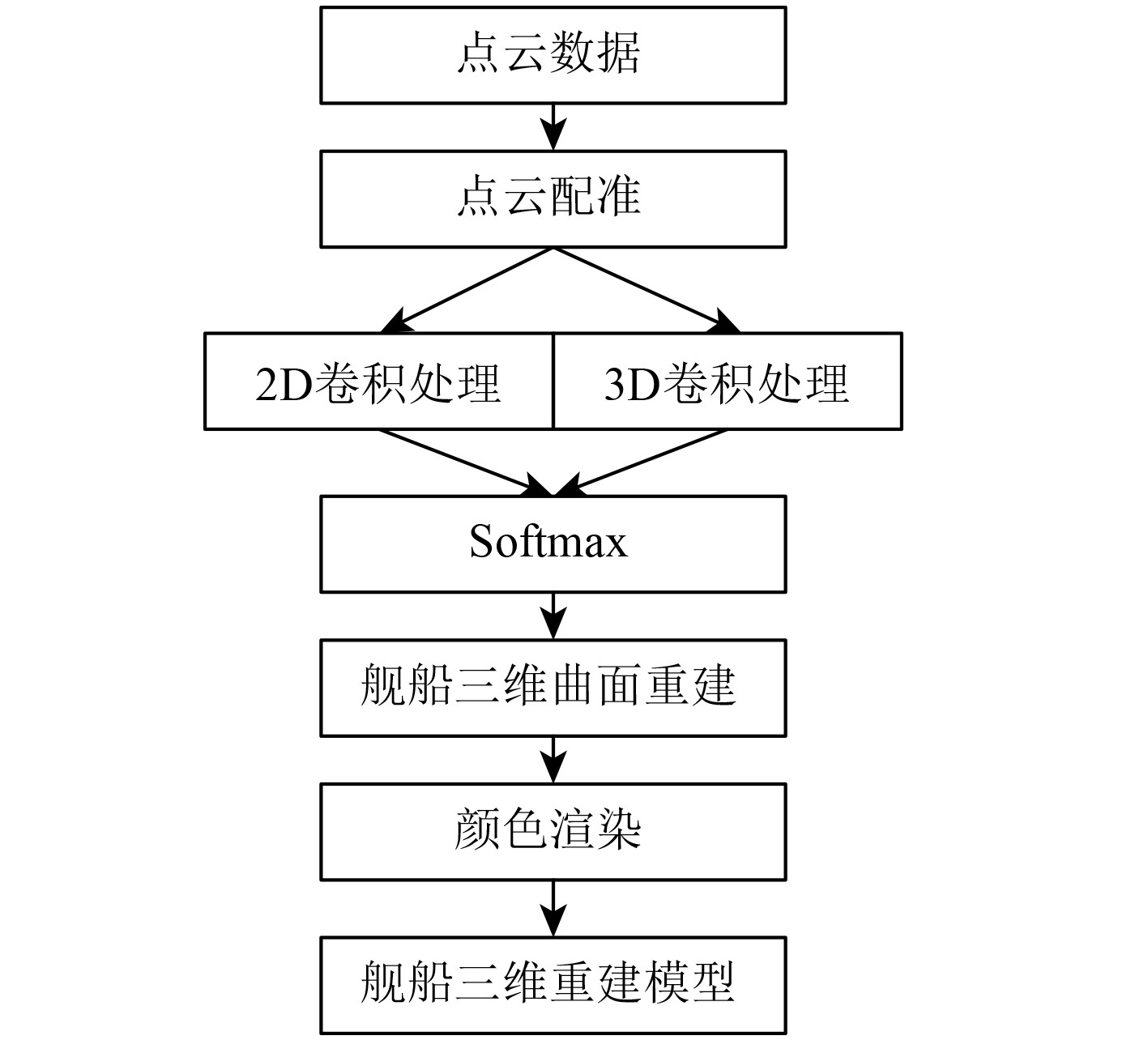

1 舰船模型三维重建 1.1 三维重建方法整体架构为实现舰船模型三维重建,并保证模型的重建效果,提出基于计算机视觉的舰船模型三维重建方法,该方法共包含多个模块,分别为舰船结构数据获取、数据处理、深度图生成以及颜色渲染,以此实现舰船模型的三维重建,并给保证重建后模型的细节完整性以及多角度呈现效果。该方法的整体架构如图1所示。舰船结构数据获取主要是依据多相机系统采集舰船全局的三维点云数据,获取舰船三维几何信息;数据处理主要是对采集的三维信息进行多视角配准,以此提升三维信息的精准性;深度图生成主要是利用机器学习中的神经网络模型进行舰船深度图生成,进行三维模型初步构建,并对构建的模型进行颜色渲染,以此实现舰船模型的三维重建。

|

图 1 基于计算机视觉的舰船模型三维重建方法架构 Fig. 1 Architecture of 3D reconstruction method for ship models based on computer vision |

为保证舰船模型的三维重建效果,需获取舰船多视角数据,因此,采用多相机系统获取舰船多视角点云数据。多相机系统以立体视觉为核心,通过多个相机从不同的角度获取舰船的多幅二维图像,利用三角定理计算舰船三维几何信息。本文主要采用2台相机的双目立体视觉进行舰船二维图像的采集,每个相机均对应舰船的不同视角,获取该视角下的结构数据,最后将2个相机获取的数据统一至同一个坐标系下,以此生成舰船的全局三维点云数据。双目立体视觉三角定理指的是将2台相机的光心和空间中的三维点之间形成一个三角形,并且保证2个相机之间呈现光轴平行状态,并且确定双目子系统内外参数以及2者之间的特征点对应关系,在此基础上,计算舰船空间点在世界坐标下的坐标值,其计算公式为:

| $ \left\{ \begin{gathered} {X_l} = \frac{{{x_l}\left( {{f_l}{t_x} - {x_r}{t_z}} \right)}}{{\left( {{r_7}{x_l} + {r_8}{y_l} + {r_9}{f_l}} \right){x_r} - {f_r}\left( {{r_1}{x_l} + {r_2}{y_l} + {r_3}{f_l}} \right)}},\\ {Y_l} = \frac{{{y_l}\left( {{f_l}{t_x} - {x_r}{t_z}} \right)}}{{\left( {{r_7}{x_l} + {r_8}{y_l} + {r_9}{f_l}} \right){x_r} - {f_r}\left( {{r_1}{x_l} + {r_2}{y_l} + {r_3}{f_l}} \right)}},\\ {Z_l} = \frac{{{z_l}\left( {{f_l}{t_x} - {x_r}{t_z}} \right)}}{{\left( {{r_7}{x_l} + {r_8}{y_l} + {r_9}{f_l}} \right){x_r} - {f_r}\left( {{r_1}{x_l} + {r_2}{y_l} + {r_3}{f_l}} \right)}}。\\ \end{gathered} \right. $ | (1) |

式中:

| $ \left[ {\begin{array}{*{20}{c}} {{X_g}} \\ {{Y_g}} \\ {{Z_g}} \end{array}} \right] = R_{1,j}^{\mathrm{T}}\left[ {\left( {\begin{array}{*{20}{c}} {{X_{kj}}} \\ {{Y_{kj}}} \\ {{Z_{kj}}} \end{array}} \right) - {T_{1j}}} \right]。$ | (2) |

式中,

将计算的所有目标点云位置进行集成,形成舰船全局点云集

完成全局舰船目标点云获取后,为提升电源数据的精准性,采用多视角点云配准方法进行点云配准。该配准的主要目的是处理不同图像之间对应点的匹配状态,依据深度相机彩色图像RGB值和深度数据同步对其的特点,对

| $ {S'_j} = {R_j} \times {S_j} + {T_j} 。$ | (3) |

式中:Rj和Tj分别表示旋转变换矩阵和平移变换矩阵;

完成多视角舰船点云配准后,为保证舰船三维重建后的完整性以及细节性,采用多尺度特征递归卷积的稠密点云重建网络模型完成。依据配准后的点云数据进行舰船深度图生成,在该过程中考虑邻域像素和中心像素位于不同表面的情况,为避免发生跨表面边界聚合现象,通过2D卷积神经网络计算相同平面内邻域像素的坐标偏移结果,在此基础上计算邻域像素坐标和深度权重后,采用3D卷积神经网络计算邻域和中线2个像素特征之间的相似性,其计算公式为:

| $ \xi \left( {p,j} \right) = \frac{{\displaystyle\sum\limits_{k = 1}^{{K_e}} {{w_k}{d_k}\xi \left( {p + {p_k} + \Delta {p_{k,j}}} \right)} }}{{\displaystyle\sum\limits_{k = 1}^{{K_e}} {{w_k}{d_k}} }}。$ | (4) |

式中:wk为特征相似性权重;dk为深度相似性权重;

依据

| $ f\left( p \right) = \sum\limits_{j = 0}^{M - 1} {{d_j} \times P\left( {p,j} \right)}。$ | (5) |

式中:f(p)为舰船图像深度值;P(p,j)为像素

依据深度回归计算后即可输出舰船模型深三维深度图,深度图在生成时为保证其在像素级别上的深度质量,沿着概率体的深度方向、将深度期望结果定义为该像素的深度估计结果,以此保证生成的舰船深度图整体的平滑度。

1.4.2 舰船三维曲面重建以及颜色渲染由于舰船表面为不规则曲面,不是平整状态,因此,获取舰船的深度图像后,需进行舰船三维曲面重建;重建后进行模型色彩渲染,即完成舰船三维重建。采用运动结构法完成舰船三维曲线重建,通过该方法获取

完成曲面三维重建后,则进行舰船模型的颜色渲染,渲染时依据渲染原理可知,物体上的颜色是沿着光线传递的方向进入计算机,依据神经体积渲染获取符号距离函数和颜色场的结果,在此基础上,沿着相机射线的方向进行离散采样,最终获取舰船模型的颜色,并完成舰船模型的颜色渲染,输出舰船模型三维重建结果。

2 结果分析选择某海域真实海域场景中的舰船作为测试对象,采用文中方法对其进行多视角图像采集,共计采集任一艘舰船不同视角下的50组2维图像,将其作为文中测试图像,采集的图像像素分辨率是1600×1200。随意抽取一组舰船全局的三维点云数据,采用文中方法对其进行多视角配准,获取点云数据的配准结果,如图2所示。可知,采用文中方法进行舰船点云数据配准后,能够完成不同图像之间对应点的可靠匹配,确定各点的坐标位置,呈现舰船的初步三维图。

|

图 2 点云数据配准结果 Fig. 2 Point cloud data registration results |

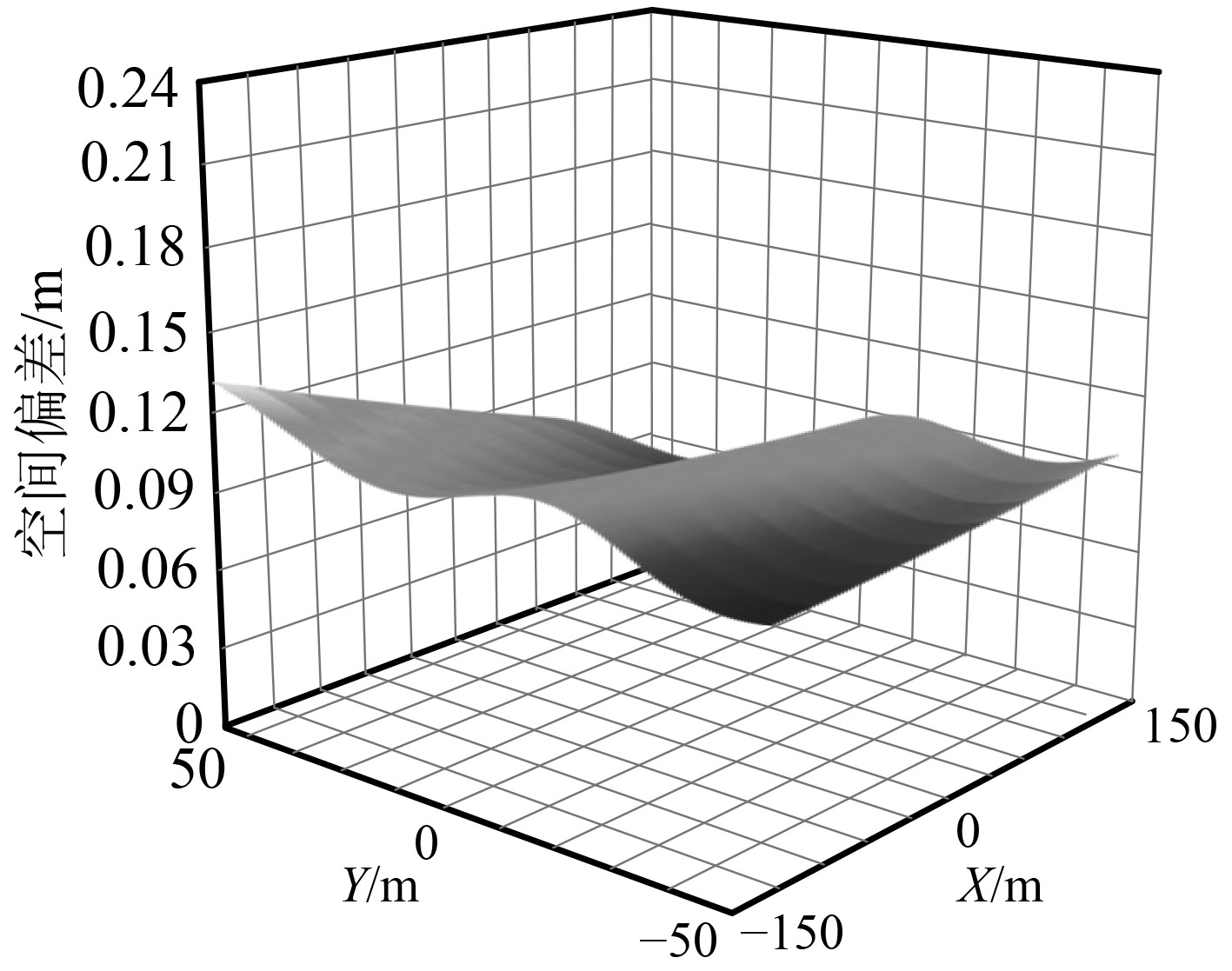

为验证文中方法的舰船模型三维重建效果,依据采集的舰船图像进行三维重建,获取重建后舰船模型的空间误差结果,如图3所示。可知,采用文中方法进行舰船模型三维重建后,模型的空间偏差较小,均在0.15 m以下。在重建过程中,结合深度图生成以及舰船曲面三维重建完成舰船模型的三维重建,因此能够更好地保证重建效果。

|

图 3 舰船模型三维重建空间误差 Fig. 3 Spatial error in 3D reconstruction of ship model |

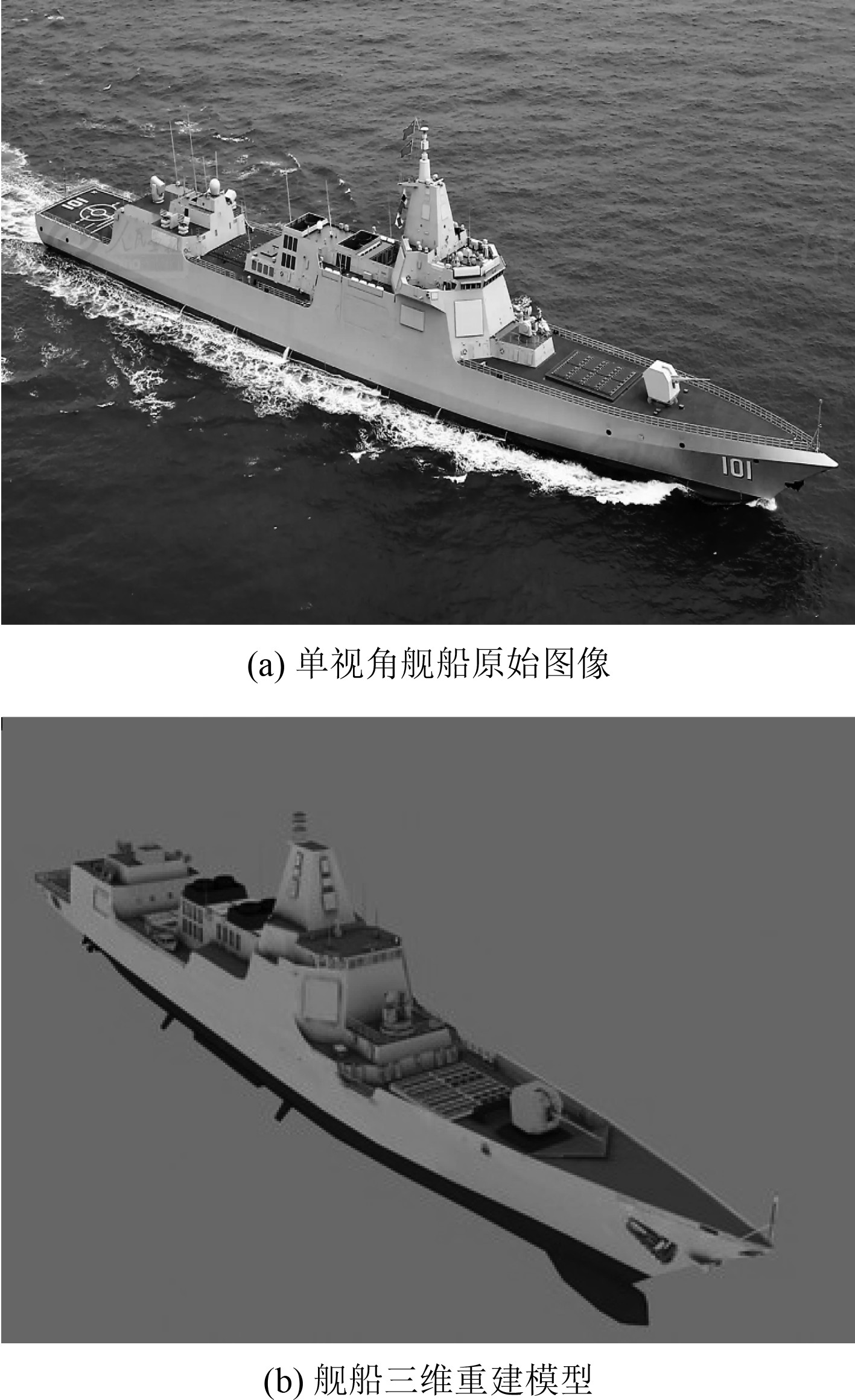

随意选择一组舰船图像,采用文中方法对其进行三维重建,获取重建结果,如图4所示。可知,采用文中方法进行舰船模型三维重建后,能够较好地完成舰船结构的重建,并且各个细节部分较为清晰,模型整体颜色视觉效果较好,满足舰船模型三维重建需求。

|

图 4 舰船模型三维重建效果 Fig. 4 3D reconstruction effect of ship model |

舰船模型三维重建是舰船航行管理以及功能模拟的重要依据,为保证舰船模型三维重建效果,本文提出基于计算机视觉的舰船模型三维重建方法。对该方法的应用效果展开相关测试后得出:该方法具备较好的应用效果,能够精准匹配舰船电点云数据,重构的舰船三维模型完整性较好,并且空间偏差较小。

| [1] |

肖世龙, 张德育, 张甜田. 基于虚拟现实技术的舰船航行三维图像重建[J]. 舰船科学技术, 2021, 43(2): 76-78. XIAO Shi-long, ZHANG De-xue, ZHANG Tian-tian. 3D image reconstruction of ship navigation based on virtual reality technology[J]. Ship Science and Technology, 2021, 43(2): 76-78. DOI:10.3404/j.issn.1672-7649.2021.02.016 |

| [2] |

段渝, 杨青, 李中余, 等. 基于短时FrFT的双基雷达舰船成像最优时间段选取方法[J]. 现代雷达, 2023, 45(1): 18-25. DUAN Yu, YANG Qing, LI Zhong-yu, et al. Optimal imaging time selection method based on short-time FrFT for bistatic radar ship target imaging[J]. Modern Radar, 2023, 45(1): 18-25. |

| [3] |

张云, 化青龙, 姜义成, 等. 基于混合型复数域卷积神经网络的三维转动舰船目标识别[J]. 电子学报, 2022, 50(5): 1042-1049. ZHANG Yun, HUA Qing-long, JIANG Yi-cheng, et al. Recognition of 3D rotating ship based on Mix-CV-CNN[J]. Acta Electronica Sinica, 2022, 50(5): 1042-1049. |

| [4] |

柏正尧, 许祝, 张奕涵. 一种使用伪对应点生成的3D点云配准方法[J]. 计算机科学, 2023, 50(9): 210-219. BAI Zheng-yao, XU Zhu, ZHANG Yi-han. Deep artificial correspondence generation for 3D point cloud registration[J]. Computer Science, 2023, 50(9): 210-219. |

| [5] |

何鑫睿, 李秀梅, 孙军梅, 等. 基于改进Pix2Vox的单图像三维重建网络[J]. 计算机辅助设计与图形学学报, 2022, 34(3): 364-372. HE Xin-rui, LI Xiu-mei, SUN Jun-mei, et al. Improved Pix2Vox based 3D reconstruction network from single image[J]. Journal of Computer-Aided Design & Computer Graphics, 2022, 34(3): 364-372. |

| [6] |

白静, 孟庆亮, 徐昊, 等. ST-Rec3D: 基于结构和目标感知的三维重建[J]. 图学学报, 2022, 43(3): 469-477. BAI Jing, MENG Qing-liang, XU Hao, et al. ST-Rec3D: a structure and target-aware 3D reconstruction[J]. Journal of Graphics, 2022, 43(3): 469-477. |

2024, Vol. 46

2024, Vol. 46