水下探测需求日益增长,声呐图像不受能见度影响的特性已经被证明特别适用于探测水下人造物体,同时也可以提供较大的成像范围。近年来,多波束测深声呐(MSS)、侧扫声呐(SSS)、前视声呐(FLS)成为了ROV、ASV、AUV等装备经常选择搭载的作业设备,实现了对水下物体的基本探测能力。但声呐图像由于水声信道的不均匀性及其边界的不规则及声呐设备性能限制,具有图像斑点噪声明显、边缘模糊、亮度不均匀和分辨率低等特点,限制了其在水下探测场景下的效能发挥。同时由于水声通信难题,水下AUV装备在使用图像声呐设备时对平台的图像处理提出了更高要求,因此研究声呐图像的处理技术(图像增强、目标检测、实例分割等)具有重要意义[1]。

本文针对前视声呐在AUV装备应用中的图像增强与目标检测问题展开研究。对于AUV装备来说,前视声呐不仅可以用于避障,而且可以在发现感兴趣的目标时,可以利用前视声呐对其进行跟踪,甚至分类识别[3 − 9]。针对前视声呐图像斑点噪声明显的问题,采用高斯平滑滤波进行干扰剔除。针对前视声呐图像目标检测的问题,综合速度和精度考虑,采用One-stage的YOLOv4系列目标检测算法[10 − 13],YOLOv4由YOLO目标检测架构的基础上发展而来,相较YOLOv3采用了很多优化策略,在数据处理、主干网络、网络训练、激活函数、损失函数等方面都有不同程度的优化。声呐数据来源于2022年10月在千岛湖新安江大坝试验期间,双AUV水面与水下跟踪工况试验时由跟踪AUV搭载的M750D前视声呐采集获得,并进行目标标注。开展基于前视声呐图像的AUV目标检测方法研究,对采用扇形灰度图、矩形灰度图、扇形伪彩图、矩形伪彩图对YOLOv4目标检测算法的在数据集上的检测精度与速度进行了比较。本文基于YOLOv4目标检测算法相比传统的阈值检测、轮廓检测方法具有较大的精度优势,更适合用于水下AUV装备应用。

1 M750D前视声呐数据获取与图像处理 1.1 声呐数据获取试验数据采用英国Blueprint Subsea公司的Oculus M750d多波束图像声呐采集,该款声呐使用750 kHz/1 200 kHz作为其工作频率,探测距离分别达到120 m/40 m。其声学参数如表1所示。

|

|

表 1 M750d前视声呐声学参数 Tab.1 Acoustic parameters of the M750d forward looking sonar |

试验中跟踪AUV与领航AUV的距离设定值为45 m,前视声呐采用低频模式,设置探测距离设置75 m,声速设定1500 m/s(若搭载声速仪设备修正声速数据,可获得质量更高的声呐数据),自动增益调整。水面跟踪采用无线电通信,水下跟踪采用水声通信。采用pc104总线SCM9602板卡计算机记录跟踪工况的声呐数据。

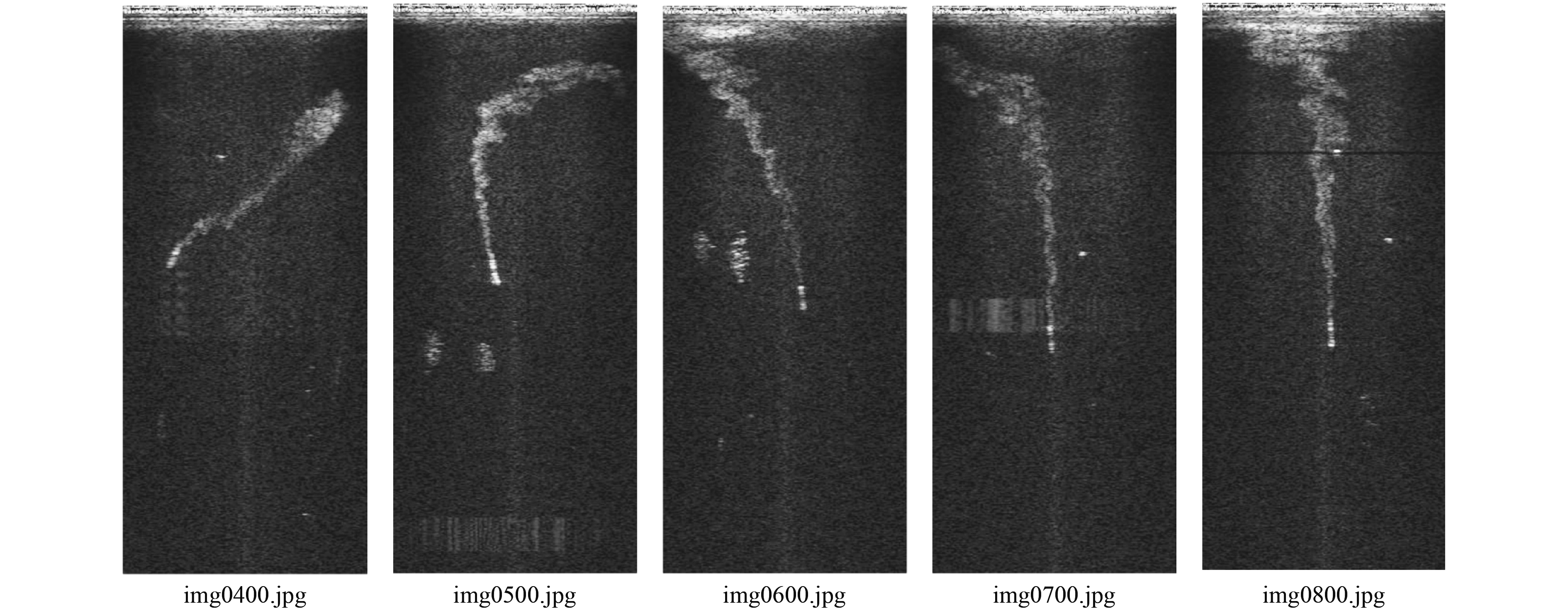

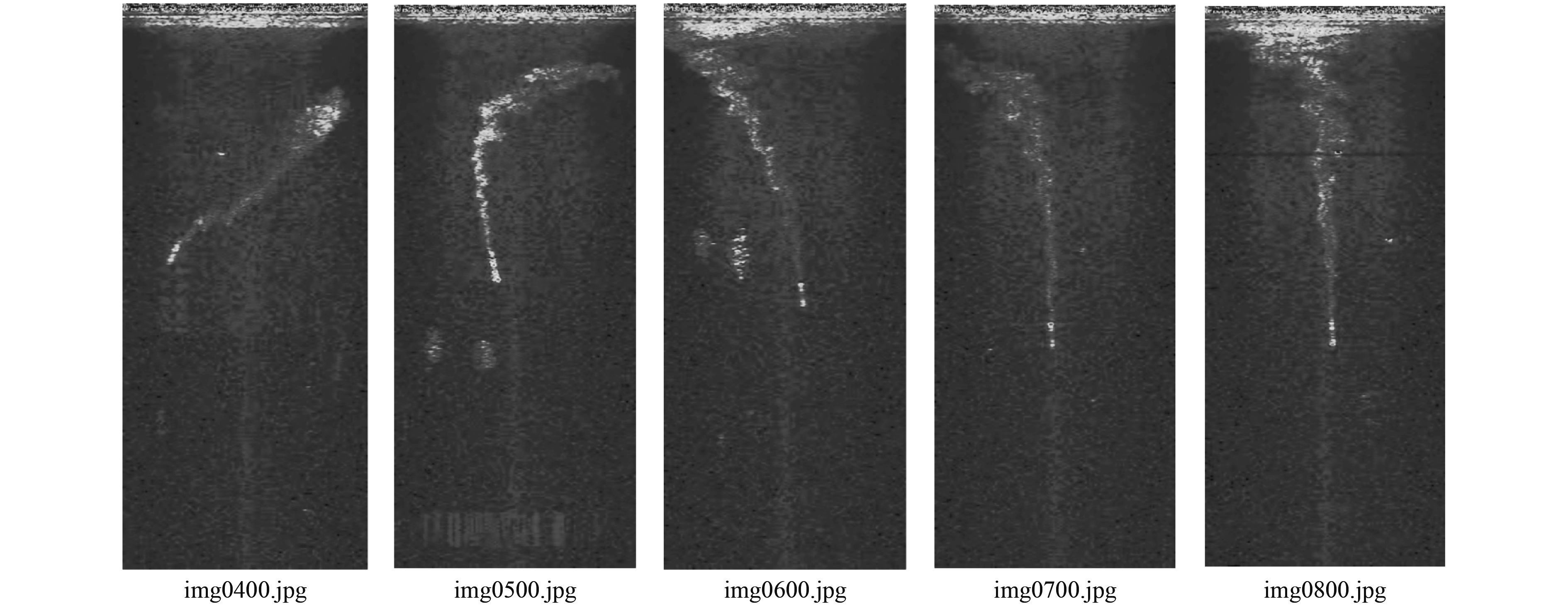

2 数据集制作 2.1 原始数据提取与伪彩色数据集制作根据.oculus文件协议,编写数据提取程序,解析并生成原始数据的灰度图像(见图1)。为了更高效的进行声呐图像数据的目标标注,对原始的灰度图像进行了伪彩色化。伪彩色图可以帮助数据标注者提升对于图像细节的理解能力,更有效直观地识别出数据中的目标,提高数据标注效率和标注精度。本文采用计算机视觉中常用的颜色映射算法Jet,Jet映射具有较高的对比度,可以有效突出图像中的细节(见图2)。为提高训练精度,一共提取有效图像2500张,并进行了数据标注。

|

图 1 前视声呐原始数据图像 Fig. 1 Raw data of forward-looking sonar images in jpg format |

|

图 2 前视声呐原始数据伪彩色图像(Jet映射) Fig. 2 Pseudo-color forward-looking sonar images in jpg format(Jet mapping) |

考虑前视声呐的成像原理,其成像区域为扇面,但采集的原始数据为采样点数目与波束数排列形成的矩阵数据。因此,在矩形的灰度图像中的目标物体由于角度和距离的不同,存在极坐标到直角坐标系的转换关系,造成同一物体在原始矩形灰度图中更多的差异,丢失了一些形状特征信息。但同时重新映射生成的扇形显示图像,由于其插值操作,并无法提供更多的数据用于特征提取,甚至会引入一定的精度损失。

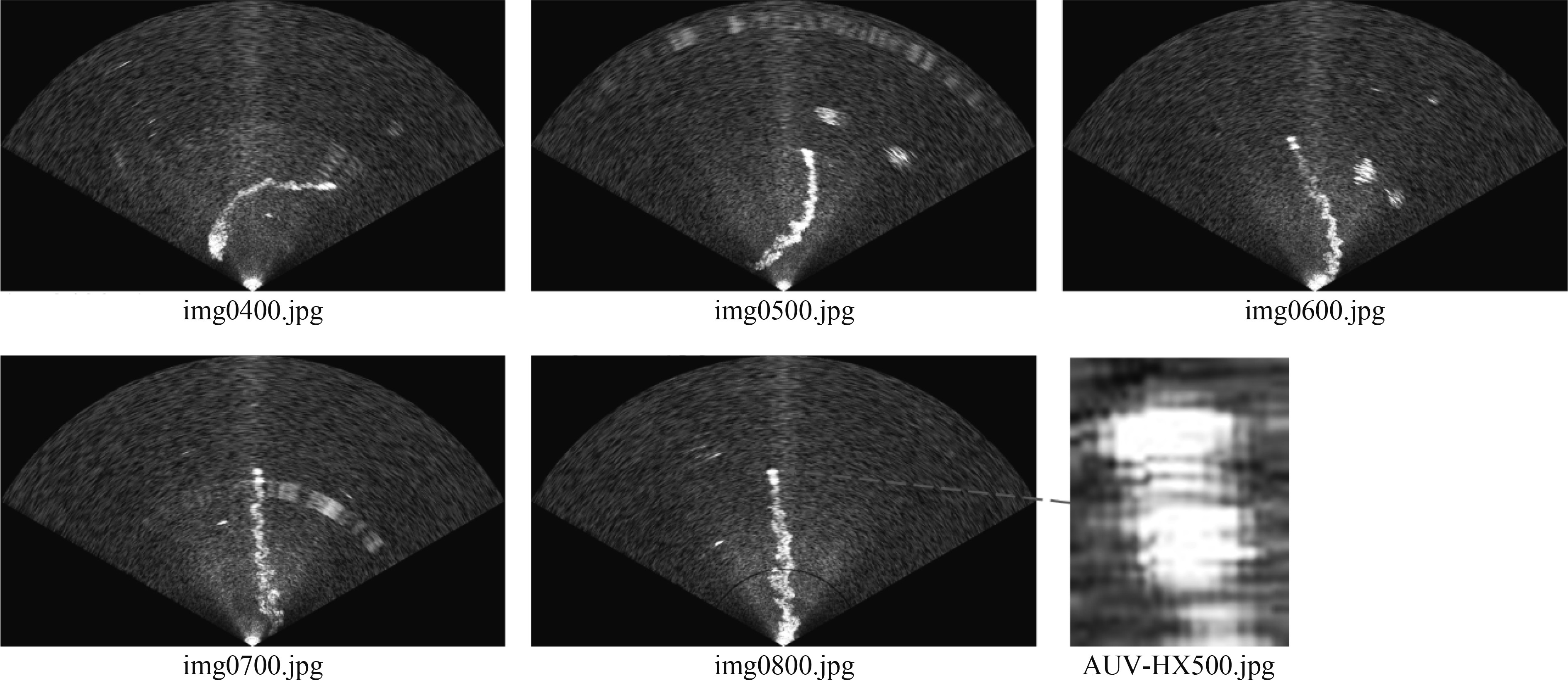

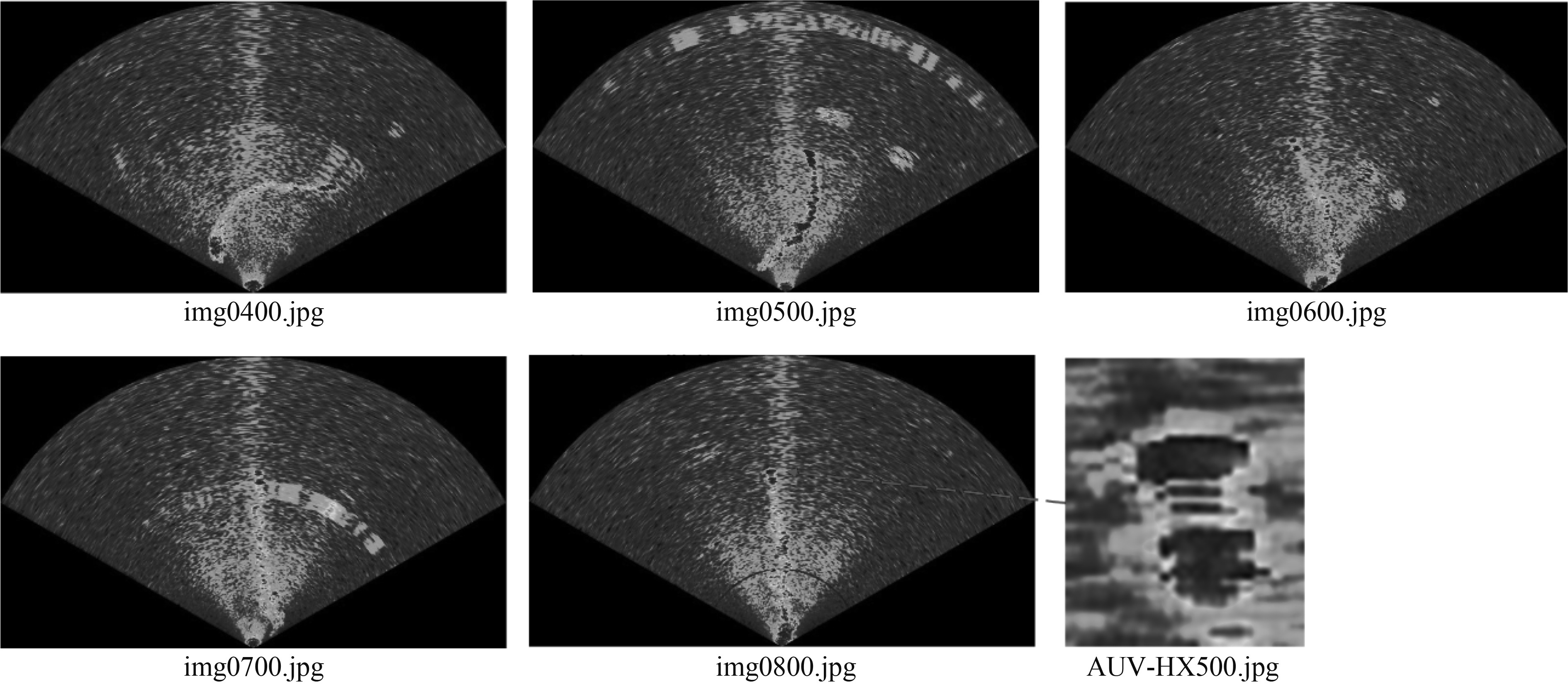

为了对比,将原始数据映射为扇形显示图像进行比较,低频工况下M750D图像声呐的视角为120°,波束数为256。采用二次样条插值进行扇形转换。同样对扇形灰度图像进行了伪彩色化,提高数据标注效率和标注精度,如图3和图4所示。

|

图 3 前视声呐扇形灰度图像 Fig. 3 Fan gray images of forward-looking sonar in jpg format |

|

图 4 前视声呐扇形伪彩色图像 Fig. 4 Fan Pseudo-color images of forward-looking sonar |

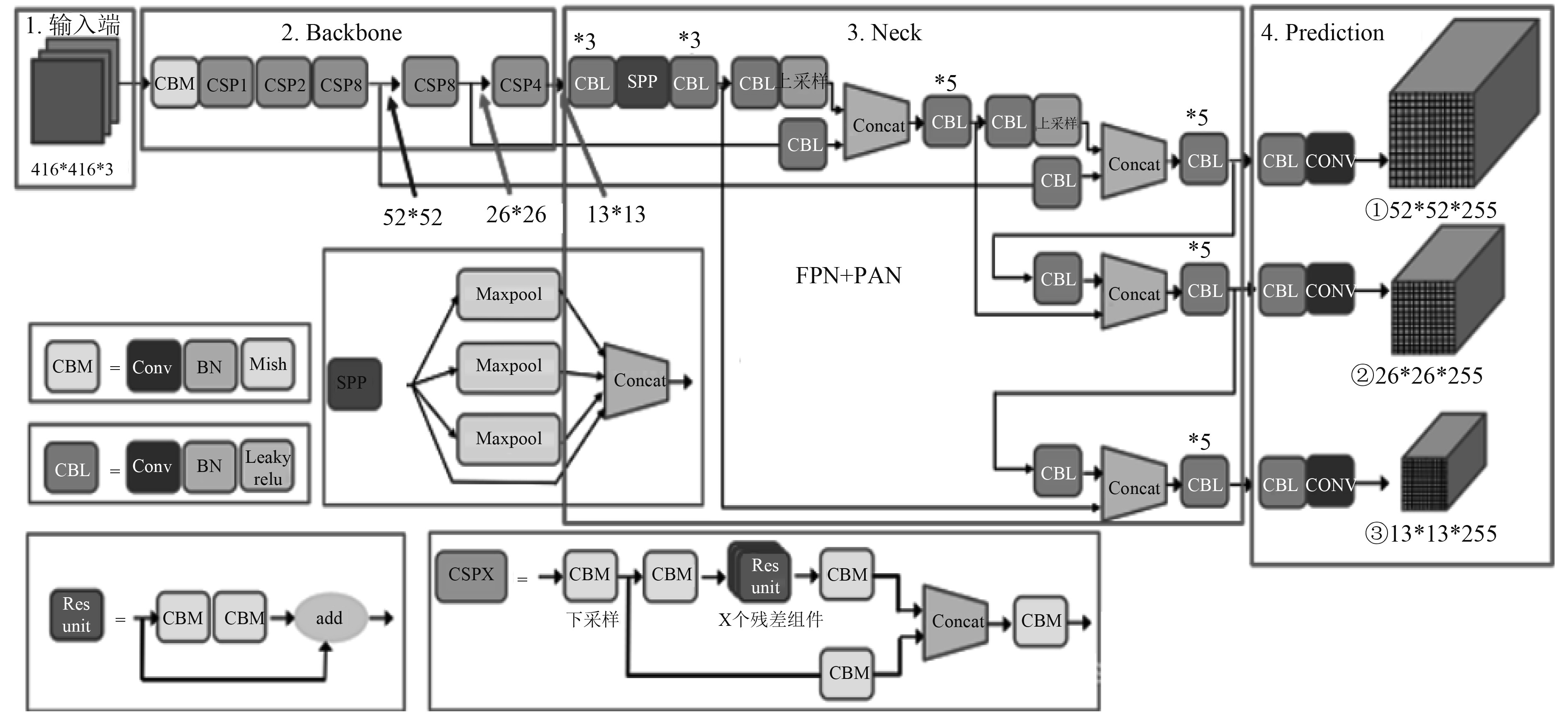

YOLO是在2016年提出的一种基于回归思想的CNN目标检测模型,相关成果发表在计算机视觉顶会CVPR上。原作者Joseph Redmon在YOLO v3版本推出后退出了YOLO的后续开发。2020年4月,俄罗斯学者Alexey Bochkovskiy在得到Joseph Redmon认可的基础上,开源了新一代YOLO检测器:YOLOv4。其结合了多种方法技巧,包括SPDarknet53、Mish激活函数、SPP模块、FPN+PAN结构,改进了训练回归框损失函数及预测框筛选方法。YOLOv4的网络结构如图5所示。考虑后续在采用pc104总线SCM9602板卡运行计算能力较弱,因此采用YOLOv4的精简版、轻量化模型YOLOv4-tiny。网络参数相当于原来的1/10,检测速度更快,YOLOv4-tiny的FPS(每秒帧数)约为YOLOv4的8倍。其整体网络结构共38层,目标的分类与回归改为使用2个特征层,合并有效特征层时使用了特征金字塔(FPN)网络。相较于其他版本的轻量化模型性能优势显著。

|

图 5 YOLOv4的网络结构图 Fig. 5 Network structure diagram of YOLOv4 |

模型训练采用YOLO原作者Joseph Redmon开发的Darknet框架,该框架是完全使用C语言进行编程,依赖CUDA运算平台的开源框架。体积较小,结构明晰,安装简单方便,可以不选择任何依赖项(包括OpenCV)。同时具备更好的移植性,使用者可以灵活的选择CPU和GPU两种计算方式来配合自己的硬件使用。

声呐图像数据集2500张,训练数据集1857张,测试数据集643张,图像类别分文3类:AUV、尾流、工作小艇。电脑配置为Intel(R) i5-10300H CPU @ 2.50 GHz,16 G内存,NVIDIA GeForce GTX 1650 with Max-Q Design显卡。为提高训练速度,训练检测类别为1,仅检测图像中的AUV目标。分别采用扇形灰度图、矩形灰度图、扇形伪彩图、矩形伪彩图对YOLOv4目标检测算法在数据集上的检测精度与速度进行了比较。基于伪彩图的检测精度相比采用灰度图像有一定提升,在矩形输入数据,IOU门限0.50情况下平均精度分别达到92.68%和94.17%,平均检测速度分别为46.91FPS和22.52FPS。采用扇形彩色图像输入数据时,检测精度略微提高,IOU门限0.50情况下平均精度达到94.43%,但检测速度下降明显,为15.61FPS。综合而言直接采用矩形彩色的前视声呐图像,具有输入图像小速度快的优势,且标注精度更高优点。

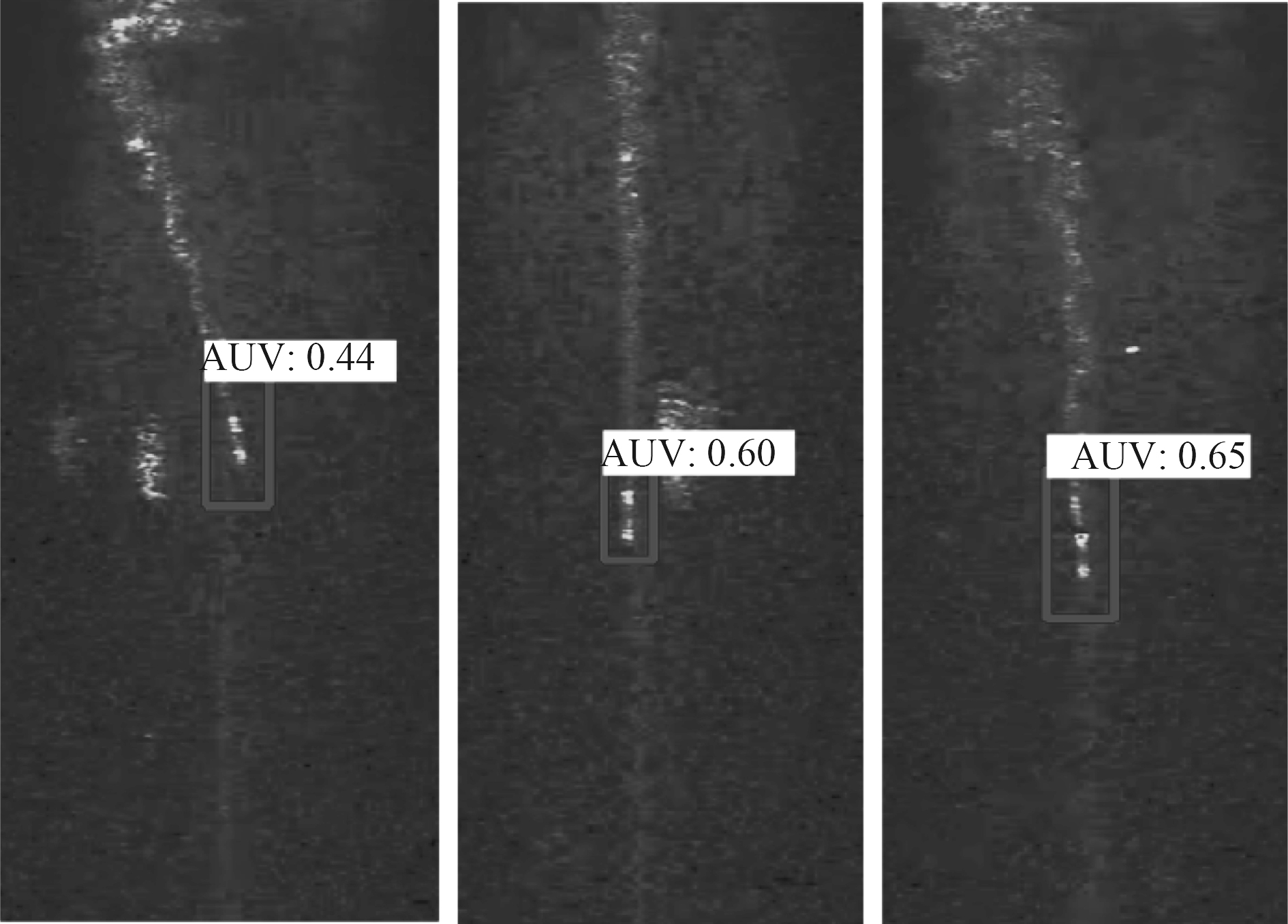

以矩形彩色的前视声呐图像测试数据集为例,检测数据集653张,检测出真值546张(TP=546),误检测6张(FP=6),平均IoU为74.78%,IOU门限0.50,平均精度达到94.17%(mAP@0.50=0.941681)。检测物体框的置信度0.25的情况下,精度达到99%,召回率达到0.84。可以看到该方法具有较好的使用效果,且FPS与前视声呐频率相当,非常适合用于水下目标检测跟踪。同时由于AUV目标相对较小,标注框精度有限(标注框较大)导致检测物体框的置信度较低,可通过提高标注精度和采用小的先验框Anchor box改善。基于YOLOv4的AUV目标检测效果如图6所示。

|

图 6 基于YOLOv4的AUV目标检测效果 Fig. 6 Detection result of AUV object based on YOLOv4 |

本文采用高斯平滑滤波对前视声呐图像噪声进行了干扰剔除,采用Jet映射将前视声呐灰度图像映射为彩色图像提高标注效率和标注精度,采用YOLOv4目标检测算法,开展了基于前视声呐图像的AUV目标检测方法研究。研究结果表明该方法能高效提取声呐图像中的特征,对声呐图像目标快速检测。同时对YOLOv4目标检测算法在对扇形灰度图像、矩形灰度图像、扇形彩色图像、矩形彩色图像上的检测效果进行比较,综合而言直接采用矩形彩色的前视声呐图像,具有输入图像小、标注快捷高效的优点。

| [1] |

檀盼龙, 吴小兵, 张晓宇. 基于声呐图像的水下目标识别研究综述[J]. 数字海洋与水下攻防, 2022, 5(4): 342-353. TAN Pan-long, WU Xiao-bing, ZHANG Xiao-yu. Review on underwater target recognition based on sonar image[J]. Digital Ocean & Underwater Warfare, 2022, 5(4): 342-353. |

| [2] |

王凯, 秦丽萍, 卢丙举. 大噪声环境下前视声呐图像目标识别方法研究[J]. 舰船科学技术, 2022, 44(1): 125-130. WANG Kai, QIN Li-ping, LU Bing-ju. Research on target recognition method of forward-looking sonar image in large noise environment[J]. Ship Science and Technology, 2022, 44(1): 125-130. DOI:10.3404/j.issn.1672-7649.2022.01.024 |

| [3] |

乔鹏飞, 邵成, 覃月明. 基于多波束前视声呐的水下静态目标的探测识别技术[J]. 数字海洋与水下攻防, 2021, 4(1): 46-52. QIAO Peng-fei, SHAO Cheng, QIN Yue-ming. Detection and recognition technology of underwater static target based on multi-beam forward-looking sonar[J]. Digital Ocean & Underwater Warfare, 2021, 4(1): 46-52. |

| [4] |

李宝奇, 任露露, 陈发, 等. 基于前视三维声呐的轨条砦识别方法[J]. 水下无人系统学报, 2022, 30(6): 747-753. LI Bao-qi, REN Lu-lu, CHEN Fa, et al. A method of erect rail barricade recognition based on forward-looking 3D sonar[J]. Journal of Unmanned Undersea Systems, 2022, 30(6): 747-753. DOI:10.11993/j.issn.2096-3920.2022-0016 |

| [5] |

张家铭, 丁迎迎. 基于深度学习的声呐图像目标识别[J]. 舰船科学技术, 2020, 42(23): 133-136. ZHANG Jia-ming, DING Ying-ying. Sonar image target recognition based on deep learning[J]. Ship Science and Technology, 2020, 42(23): 133-136. |

| [6] |

刘昊搏, 刘铁军, 汪海林, 等. 一种基于前视声呐的目标检测与跟踪方法[J]. 舰船科学技术, 2021, 43(21): 143-148. LIU Hao-bo, LIU Tie-jun, WANG Hai-lin, et al. A target detection and tracking method based on forward looking sonar[J], Ship Science and Technology , 2021, 43(21): 143-148. |

| [7] |

ZHANG Tie-dong, LIU Shu-wei, et al. Underwater target tracking using forward-looking sonar for autonomous underwater vehicles[J]. Sensors (Basel, Switzerland), 2019, 20(1).

|

| [8] |

QUIDU I, JAULIN L, BERTHOLOM A, et al. Robust multitarget tracking in forward-looking sonar image sequences using navigational data[J]. IEEE Journal of Oceanic Engineering, 2012, 37(3): 417-430. DOI:10.1109/JOE.2012.2190572 |

| [9] |

GALCERAN E, DJAPIC V, CARRERAS M, et al, A real-time underwater object detection algorithm for multi-beam forward looking sonar[J]. IFAC Proceedings Volumes, 2012, 45(5): 306-311.

|

| [10] |

REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[J]. IEEE, 2016. DOI: 10.1109/CVPR.2016.91

|

| [11] |

REDMON J, FARHADI A. YOLO9000: Better, Faster, Stronger[J]. IEEE, 2017: 6517-6525. DOI:10.1109/CVPR.2017.690.

|

| [12] |

REDMON J, FARHADI A. YOLOv3: An Incremental Improvement[J]. arxive-prints, 2018.

|

| [13] |

BOCHKOVSKIY A, WANG C Y, LIAO H . YOLOv4: Optimal Speed and Accuracy of Object Detection[J]. arxiv 2020(4).

|

2024, Vol. 46

2024, Vol. 46