2. 大连大学 通信与网络重点实验室,辽宁 大连 116622

2. Communication and Network Laboratory, Dalian University, Dalian 116622, China

传统的水下目标图像识别方式都是通过进行人工采样提取图像特征,然后再通过传感器与水下目标图像数据分析比对或者通过采用图像分类器对目标特征图像信息进行分类。这样分类的技术方法会在很大程度上受到人工采集提取出来的目标特征所影响,若图像的像素较少或者特征提取的不够准确,识别效果就很不理想[1]。

基于深度机器学习原理的图像处理算法是目前计算机视觉领域应用的比较热门新技术之一[2 − 4],该识别方法无论是在目标识别的速度上还是目标识别的精度上均已超过了传统的目标识别检测的方法[5]。目前最常用的目标识别方法可大致分为One-Stage和Two-Stage这2类。其中,One-Stage主要包括SSD[6]、YOLO[7]、FCN[8]、DeepLabV3+[9]等,这种目标识别方法的优点是目标识别的速度比较快,但对于中小型目标的识别效果不好,无法满足水下复杂场景对于目标的识别要求;Two-Stage主要包括Faster-RCNN[10]、Mask R-CNN[11]等,这种目标识别方法是先在图像特征图上卷积生成建议区域,然后对生成的建议区域进行回归分类计算,得出最终输出的识别结果。这种目标识别方法的优点是识别精度高,并且对大中小的物体目标都有很好的识别结果。

针对上述2个问题,本文设计一种改进的Mask R-CNN网络,采用改进后的金字塔切分注意力模块PAS代替RestNet50中所使用的3×3卷积模块,对金字塔切分后生成的通道特征图上的目标信息进行不用尺度特征信息的提取,提高了对模型中目标特征空间信息的提取分析能力。通过改进FPN卷积结构,促进不同特征之间的信息融合。最后,通过多组实验对比,以及对不同模型识别后的结果进行比对,改进后模型的识别准确率有明显的提升。

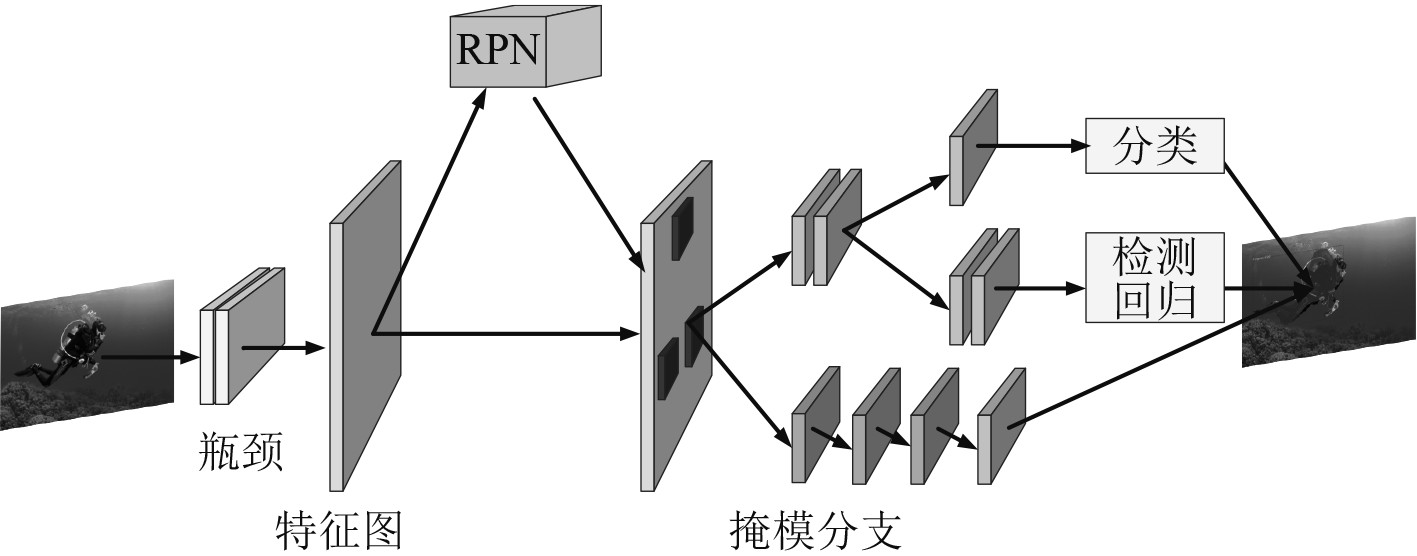

1 Mask R-CNN 检测框架Mask R-CNN是在Faster R-CNN技术的基础上将图像的分割处理和多目标的检测分析融合在一起,实现实例级的图像分割处理的网络模型,如图1所示。Mask R-CNN以ResNet50或ResNeXt为骨干网络来提取目标特征,骨干网络生成特征层之后,由特征金字塔FPN对不同特征层中的信息进行不同组合,实现特征融合[12]。RPN模块对输入特征图的检测目标和背景信息进行二值分类,生成候选框,通过ROI Align操作与其相对应的特征图中的像素对应。最后,将处理后的特征图输入一个分支用于计算分类,输入另一个分支用于计算生成实例分割Mask。

|

图 1 Mask R-CNN网络结构 Fig. 1 Mask R-CNN network structure |

Mask R-CNN网络模型虽然在识别精度和速度上都达到了较高水平,但在水下复杂环境中,尤其是在水下昏暗环境中,模型对目标特征的提取能力还有提高空间。本文对Mask R-CNN网络模型做出以下改进:首先,在残差网络ResNet50的基础上进行调整,引入金字塔切分注意力模块PAS[13]来替换网络ResNet50模块中的3×3卷积模块,并将金字塔切分注意力模块PAS中的SE Weight Module模块[14]替换为更加高效的ECANet道注意力模块,提高网络对图片信息的提取能力。其次,为了加强特征金字塔不同特征层之间信息的融合,增加了2条含有ECANet通道注意力模块[15]的通道,并在每次特征层进行上采样后增加ECANet通道注意力模块,提升目标特征在高底层之间传递能力的同时,抑制因特征层进行上采样可能出现的噪声传播,并突出显示正确的语义特征区域。本文仅对目标识别进行研究,故将Mask R-CNN模型中的Mask分支删除。

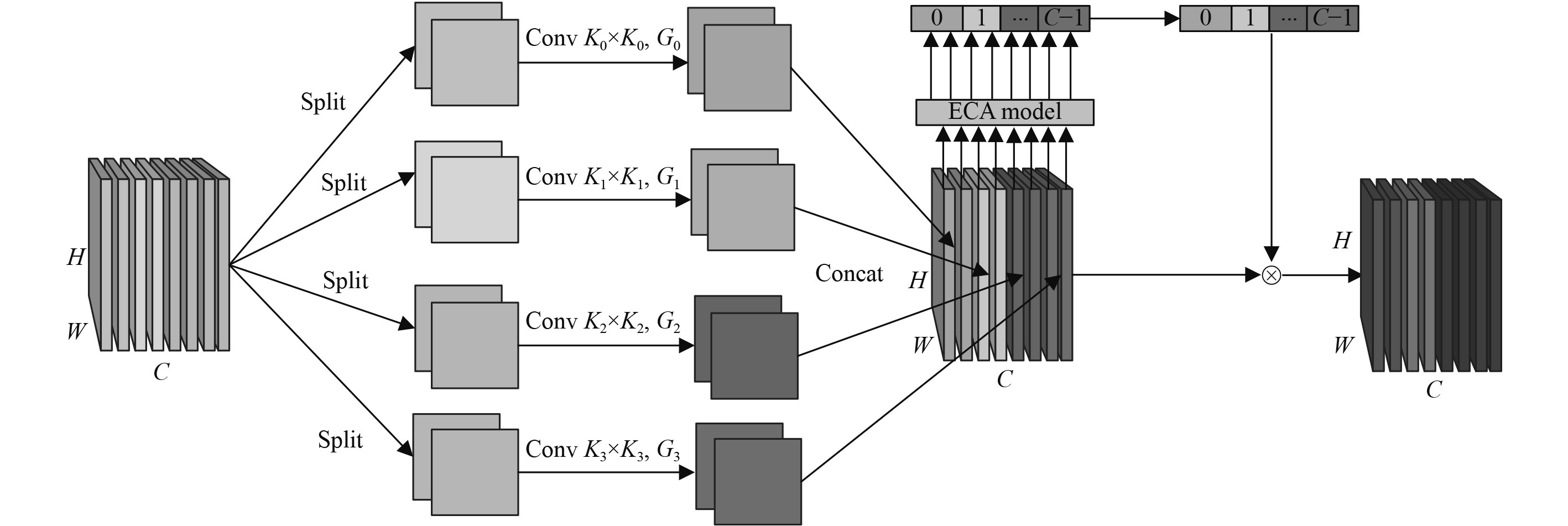

2.1 主干网络的改进Mask R-CNN模型的ResNet-50主干网络在实际检测中表现出很好的检测效果,但是在水下环境中,昏暗的环境、复杂的目标、目标的遮挡等对模型的识别准确率造成巨大的影响。因此需对模型进行改进,提高模型在复杂水下环境中对目标特征的提取能力。Zhang等[13]提出的基于金字塔切分的通道注意力模块PAS,能够快速高效地获取并有效整合和利用在不同空间尺度内特征图中存在的空间信息,并且同样能够快速且有效地建立多空间尺度通道注意力模型间的一种长期的依赖关系,如图3所示。

|

图 3 金字塔切分注意力模块PAS Fig. 3 Pyramid segmentation attention module PAS |

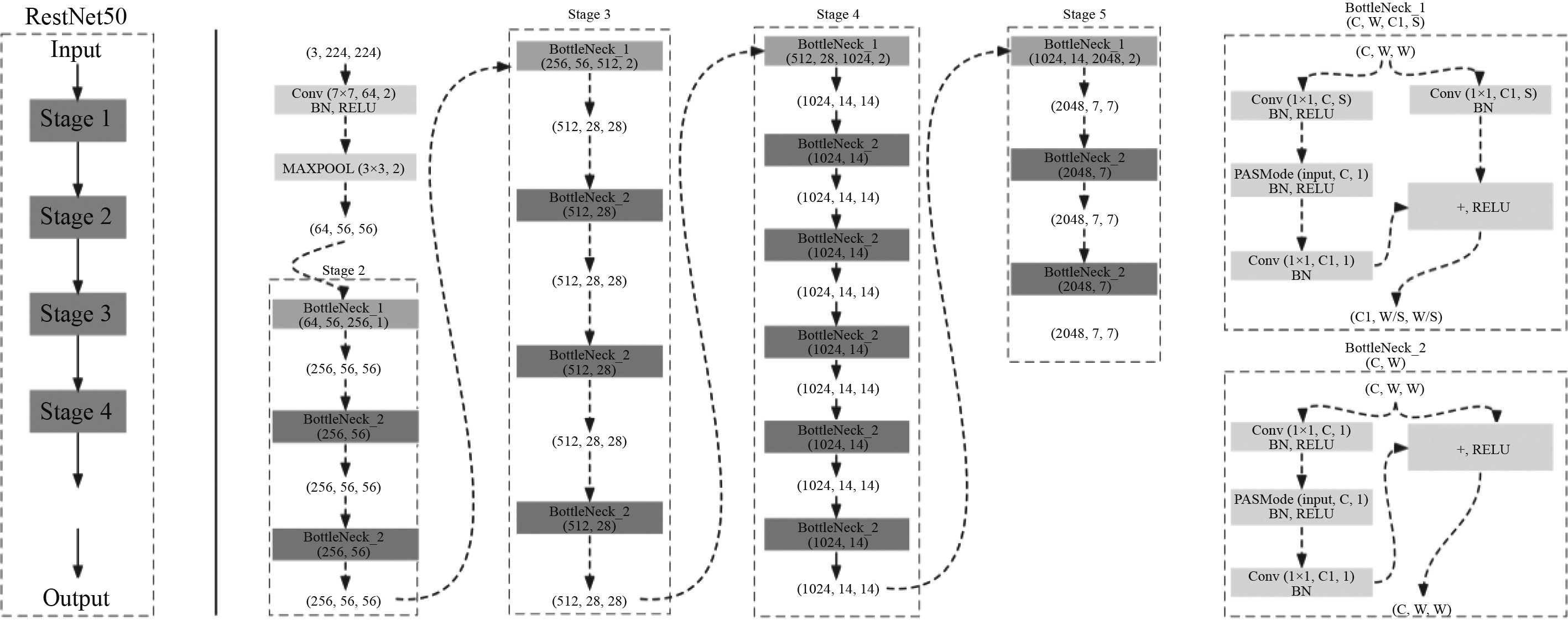

首先,可直接使用金字塔切分注意力模块PAS来直接替换ResNet50中的3×3卷积,同时又可尝试采用另外一种功能更加全面稳定和高效实用的ECANet通道注意力模块来完全代替PAS中的SE Weight Module模块,如图4所示。PAS模块首先对输入的图像进行通道切分,将切分后的图像通道分为多组,然后再对每组通道上的空间信息,分别用不同大小的卷积核对通道信息进行特征提取,之后,再依次将卷积处理之后的信息进行通道拼接。最后,利用ECANet通道注意力模块对输出的特征图信息进行局部的跨通道的注意力交互加权处理后,输出一个多尺度特征信息的通道特征图。

|

图 4 改进后RestNet50网络结构 Fig. 4 Improved Restnet50 Network structure |

金字塔切分注意力模块PAS采用多分支的方式提取输入特征图的空间信息,从而获得更丰富的输入张量位置信息,并在多个尺度上进行并行处理。相应地,在金字塔切分注意力模块结构中,使用不同尺度的卷积核也可产生不同空间分辨率值和空间深度,从而可更加有效提取出每个通道特征图上不同尺度空间信息,使特征图的多元尺度信息的表示能力更强,增强判断准确率。

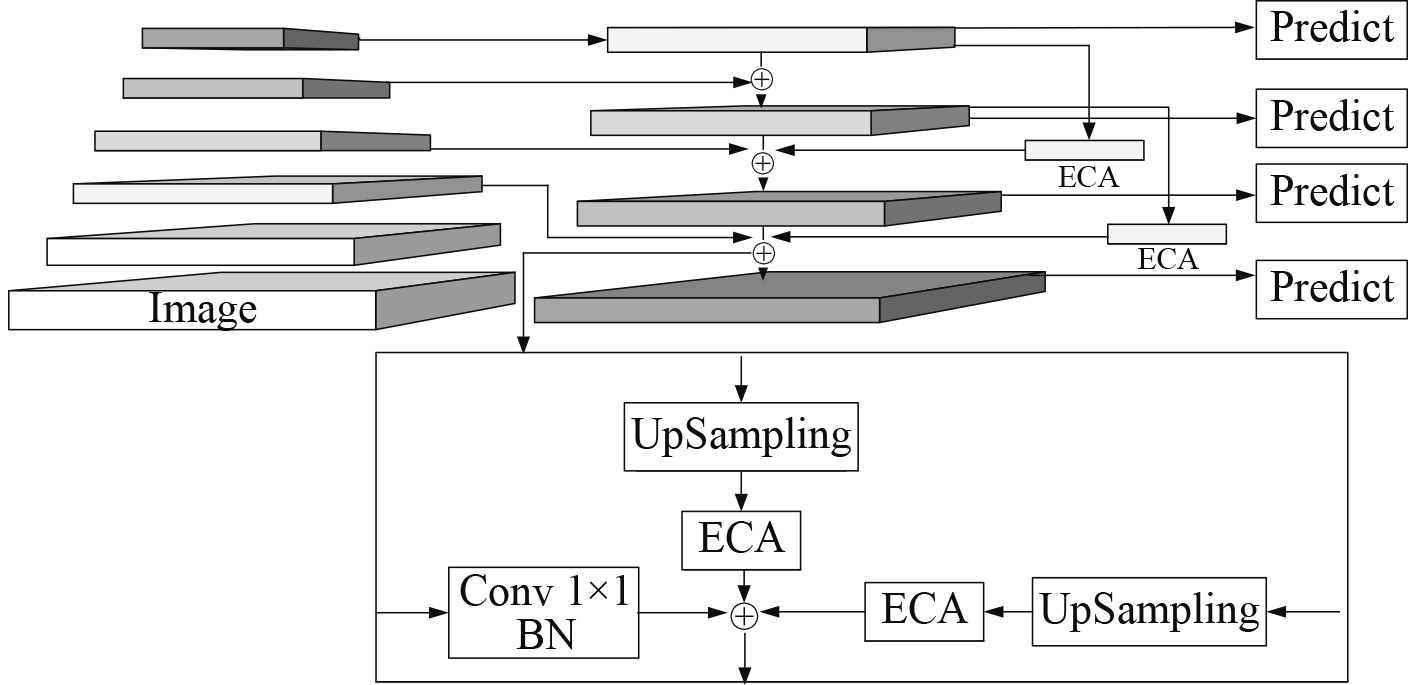

2.2 特征金字塔网络FPN改进在特征金字塔FPN中,特征层越深尺寸就会越小,但其包含的语义信息却变得更加丰富。特征金字塔网络FPN在各个特征层之间建立了纵向连接,并由上至下进行上采样融合。但是,经过上采样后,深层特征层的尺寸变大,会直接损害特征层所蕴含的信息。由于深层特征层中所蕴含的信息极为丰富,因此当深层特征所蕴含的信息结构受损时,在特征金字塔FPN向上融合过程中,深层特征中受损的信息也会干扰到浅层特征层中所蕴含的信息,影响目标识别的精度。另一方面,经过多次融合后,深层特征层对浅层特征层的影响会逐渐减小甚至基本消失。针对上述问题,提出1种结合ECANet通道注意模块的多通道FPN,如图5所示。

|

图 5 改进特征金字塔FPN结构 Fig. 5 Improved feature pyramid FPN structure |

首先,在原始FPN网络基础上,增加2条分别连接从上往下第1层和第3层、第2层和第4层带有ECANet注意力模型的通路,使不同特征层之间充分融合;然后在每一层特征层上采样之后增加ECANet注意力模型,对多维度的通道注意力权重进行特征重标定,抑制特征层进行上采样时空间结构损坏所产生的影响。

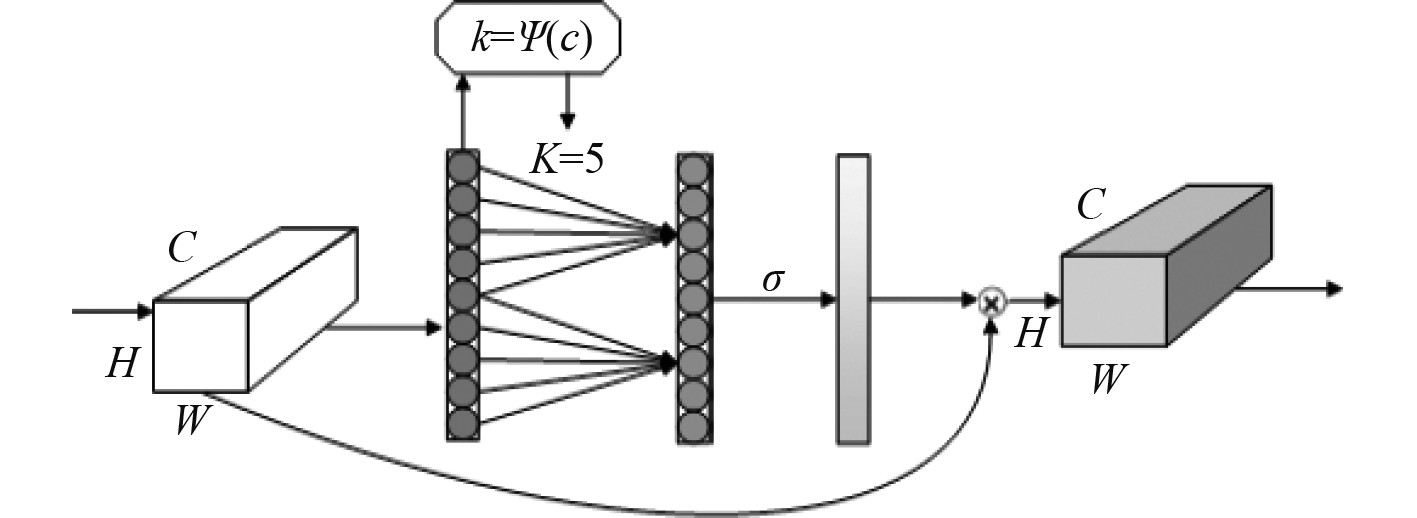

在特征金字塔FPN中引入ECANet注意力模块,这能够使FPN抑制特征层进行上采样时空间结构损坏所产生的影响,增强特征层的有效信息,抑制无效信息,提高网络模型的判断准确率。如图6所示,输入的信息在经过通道级全局平均池化后,每个通道和其相邻的k个通道进行局部跨通道交互来获取信息。其中,K值是由通道数C的函数自适应确定,二者为正比例关系,避免了固定超参数的产生。由于通道数通常为2的倍数,因此可表示为:

|

图 6 ECANet通道注意模块 Fig. 6 ECANet channel attention module |

| $ c=\phi(k)=2^{\gamma\times k-b}。$ | (1) |

可知,在通道维数C已知的情况下,卷积核大小k的表达式为:

| $ {k}=\psi (c)={\left|\frac{\mathrm{log}(c)}{\gamma }+\frac{b}{\gamma }\right|}_{odd}。$ | (2) |

实验使用自制的实景图像,作为训练用网络数据集,图像分辨率在1280×720。样本类别涵盖水下场景中出现的蛙人、海龟、水下机器人等目标。其中训练样本集,验证样本集,测试样本集的占比分别为70%、20%、10%。

3.2 实验环境配置本文Mask R-CNN网络模型的训练在Ubuntu操作系统中完成;CPU为Xeon E5-2672 V3,系统内存8 GB,GPU为NVIDIA 1070Ti;在训练中训练轮数(epoch)设为1000,学习率设置为0.001;训练基础软件环境为 CU-DA 10.5,cuDNN 7.6.5,Cuda 10.1,OpenCV 4.5.5,Tensorflow 1.14.0,Keras 2.2.5。

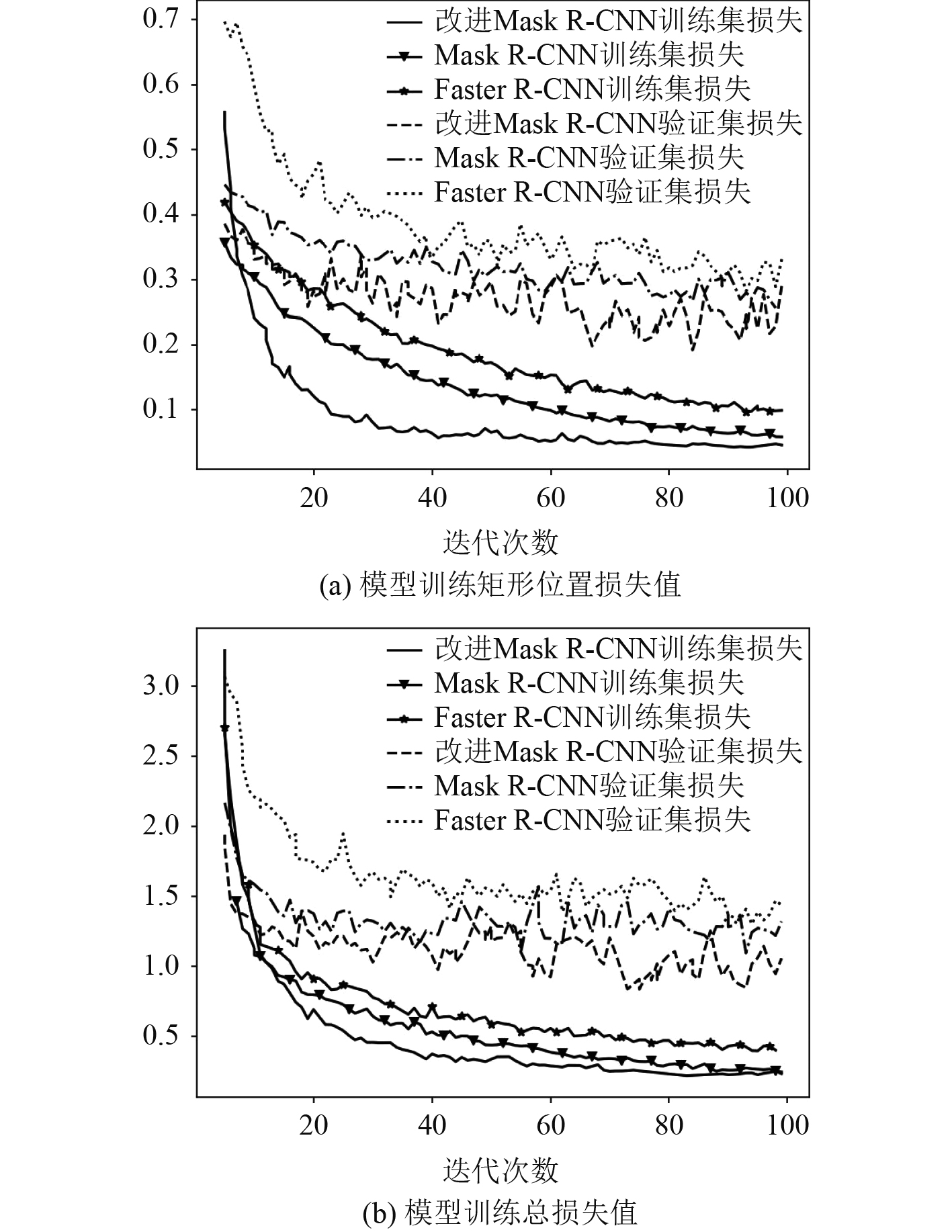

3.3 实验结果选取相同的数据集,在FasterR-CNN、Mask R-CNN以及改进Mask R-CNN网络上进行训练后,分别对模型输出矩形框位置损失,以及模型训练总损失进行对比,如图7所示。分别对3种模型的准确率及召回率进行对比,如表1所示。

|

图 7 模型损失曲线 Fig. 7 Model loss curve |

|

|

表 1 不同模型性能对比 Tab.1 Performance comparison of different models |

从图7可看出,改进后的Mask R-CNN网络模型训练损失值变化波动比较平缓,并且较快达到稳定,验证集损失与其他模型相比始终保持在较低位,反映了改进后网络的特征提取能力更强,泛化能力更好,更能适应水下复杂的训练环境。Faster R-CNN和Mask R-CNN网络虽然训练集损失曲线波动较小,但是验证集损在迭代20次之后保持在较高位,反映网络特征提取能力弱于改进后的网络,模型泛化能力弱于改进后Mask R-CNN网模型。

由表1可看出,在准确率方面改进后的Mask R-CNN网络模型比Faster R-CNN提高了13.1%;比改进前Mask R-CNN网络别提高了7.8%。在召回率方面,改进后的Mask R-CNN网络模型比Faster R-CNN、Mask R-CNN网络模型分别提高了9.3%、5.2%。分析不同模型性能对比可知,本文提出的改进模型较其他模型在检测精度和召回率上都有较大的提升。

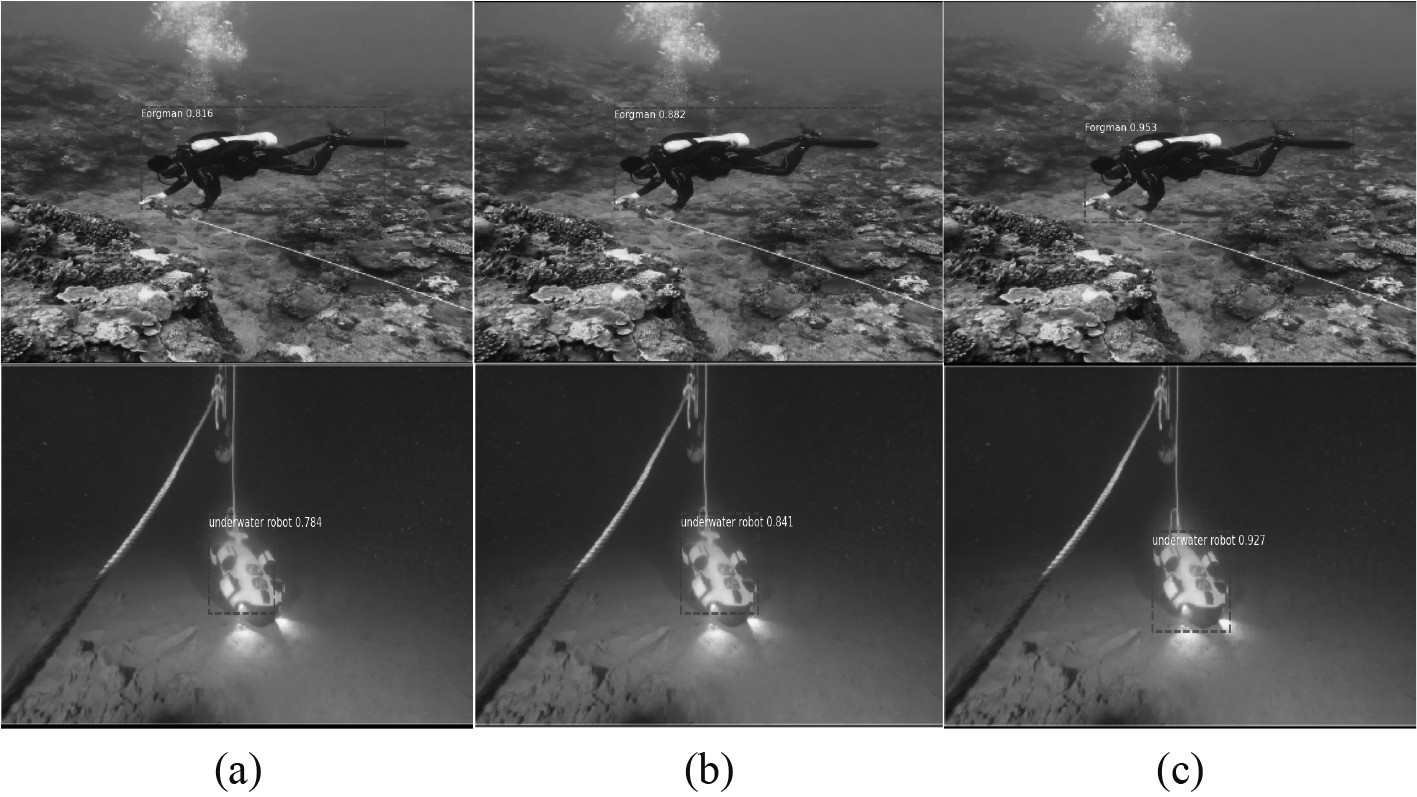

为了进一步体现改进后网络模型的优越性,使用同一组数据分别对Faster R-CNN、Mask R-CNN和改进后的Mask R-CNN模型作对比,如图8所示。可看出,Faster R-CNN网络模型对目标轮廓边缘处理较差,矩形位置偏差较大,识别准确率最低;Mask R-CNN网络模型虽然对目标轮廓处理较Faster R-CNN好,但识别准确率一般;改进Mask R-CNN网络模型的识别结果,相比于前2种方法,其对于目标轮廓的处理更为精准,矩形位置更为准确,且识别准确率相较其他2种模型最高。通过上述论证,能够证明改进Mask R-CNN网络模型的优越性。

|

图 8 检测结果对比 Fig. 8 Comparison of test results |

本文提出一种改进的Mask R-CNN 算法用于水下目标识别任务。通过引入改进后的金字塔切分注意力模块PAS ,用多分支的方式提取输入特征图的空间信息,从而获得更丰富的输入张量位置信息;通过改进FPN结构,增加了2条含有ECANet通道注意力模块的通道,提升目标特征在高底层之间的传递能力。通过自制6000张水下图像的数据集,分别在Faster R-CNN、Mask R-CNN和改进后的Mask R-CNN模型对同一测试数据对比。实验结果表明,改进后的网络模型特征提取能力和泛化能力得到较大提升,模型的识别精度得到了明显提高。

| [1] |

张弓. 基于卷积网络的水下目标识别研究[D]. 镇江: 江苏科技大学, 2020.

|

| [2] |

FEIZENSZWALB P F, GIRSHICK R B, MCALLESTER D, et al. Object detection with discriminatively trained part-based models[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(9): 1627-1645. DOI:10.1109/TPAMI.2009.167 |

| [3] |

LECUN Y, BOTTOU L, BENGIO Y, et al. Gradient-base learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86,(11): 2278-2324. DOI:10.1109/5.726791 |

| [4] |

李旭冬, 叶茂, 李涛. 基于卷积神经网络的目标检测研究综述[J]. 计算机应用研究, 2017, 34(10): 2881-2886. DOI:10.3969/j.issn.1001-3695.2017.10.001 |

| [5] |

AGARWAL S, DU TERRAIL J O, JURIE F. Recent advances in object detection in the age of deep convolutional neural networks[J]. Computer Vision and Pattern Recognition 2018, ar- Xiv: 1809. 03193.

|

| [6] |

LIU W, ANGUELOV D, ERHAN D, et al. SSD: Single shot multibox detector [C]// Proceedings of the 2016 European Conference on Computer Vision, 2016: 21−37.

|

| [7] |

REDMON J, DIVVALA S, CIRSHICK R, et al. You only look once: Unified, real-time object detection [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition, 2016: 779−788.

|

| [8] |

LIU W, ANGUELOV D, ERHAN D, et al. Ssd: Single shot multibox detector[C]// European Conference on Computer Vision, 2016: 21-37.

|

| [9] |

CHEN L C, PAPANDREOU G, KOKKINOS I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFs[J]. Computer Vision and Pattern Recognition, 2016, arXiv: 1412. 7062.

|

| [10] |

REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN: towa- rds reatime object detection with region proposal netwoks[C]// Proceedings of the 28th International Conference on Neural In- formation Processing Systems, 2015: 91−99.

|

| [11] |

SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]// IEEE Conference on Computer Vision and Pattern Recognition, 2015.

|

| [12] |

赵丹, 刘洁瑜, 沈强. 一种改进的多门控特征金字塔网络[J]. 光学学报, 2019, 39(8): 235−244

|

| [13] |

ZHANG Hu, ZU KeKe, LIU Jian, et al. EPSANet: an efficient pyramid split attention block on convolutional neural network network[J]. Computer Vision and Pattern Recognition, 2021, 2105. 14447.

|

| [14] |

HU Jie, SHEN Li, ALBANIE S, et al. Squeeze-and- excitation network[J]. IEEE Transactions on Pattern Analysis & MachineIntelligence, 2020, 42(8): 2011−2023.

|

| [15] |

WANG Qilong, WU Banggu, ZHU Pengfei, et al. ECA -Net: Efficient channel attention for deep convolutional neural networks[C]//2020 IEEE/CVF Conference on Computer Vision Pattern Recognition, Seattle, USA, 2020: 115311−11539.

|

2024, Vol. 46

2024, Vol. 46