2. 中国船舶集团有限公司第七〇五研究所,陕西 西安 710077

2. The 705 Research Institute of CSSC, Xi′an 710077, China

水声目标识别是水声学信号处理中最重要的研究方向之一,它对于现代海洋设备目标探测尤为关键,因此成为水声领域研究的热点[1]。由于水下环境较为复杂,使得水声目标识别问题相较于普通语音识别具有更大的挑战性[2]。水声目标识别主要包括主动声呐识别和被动声呐识别。主动声呐识别主要通过回声信号识别目标,而被动声呐识别则通过舰船目标辐射的信号识别。本文主要研究被动声呐目标识别,即通过研究舰船目标辐射的信号来对目标进行识别。

深度学习通过从大数据中自动学习特征极大地提高模式识别系统的性能。因此,越来越多的学者开始将深度学习引入水声目标识别领域并取得了突破性进展[3]。张少康等[4]提出一种基于长短时记忆网络(Long Short Term Memory Network,LSTM)的水下目标识别方法,该方法首次应用LSTM对水下目标的梅尔倒谱系数(MeI-scale Freguency CeptraI Coefficients,MFCC)进行深层次特征提取与识别,识别结果表明该方法可有效区分不同水声目标。王升贵等[5]提出一种基于二维卷积网络(2D-CNN)的水下目标识别方法,该方法通过傅里叶变化获取水下目标信号的二维时频谱图,然后将其作为2D-CNN的输入进行识别。结果表明,将二维时频谱图与2D-CNN相结合可以有效降低原始信号噪声的影响,从而可有效提高识别精度。然而上述研究大多是基于时域的音频信号或者频域的二维时频谱图提取水声信号的特征,考虑的角度比较单一,并没有同时从时域和频域角度出发,挖掘时域音频信号和频域的二维频谱图所对应的时频互补信息,而时频互补信息对提高水声目标识别的精度是有帮助的。

本文同时从时域和频域角度出发,提出一种基于时频联合特征和加权决策的水声目标识别方法。该方法首先采用LSTM对水声信号的MFCC特征进一步提取时域特征并识别,然后采用2D-CNN对水声信号的二维时频谱图提取频域特征并识别。最后,为了更好地融合2种方式下提取到的时频信息,将2种方式下的识别结果进行加权决策融合,以实现高精度的目标识别。

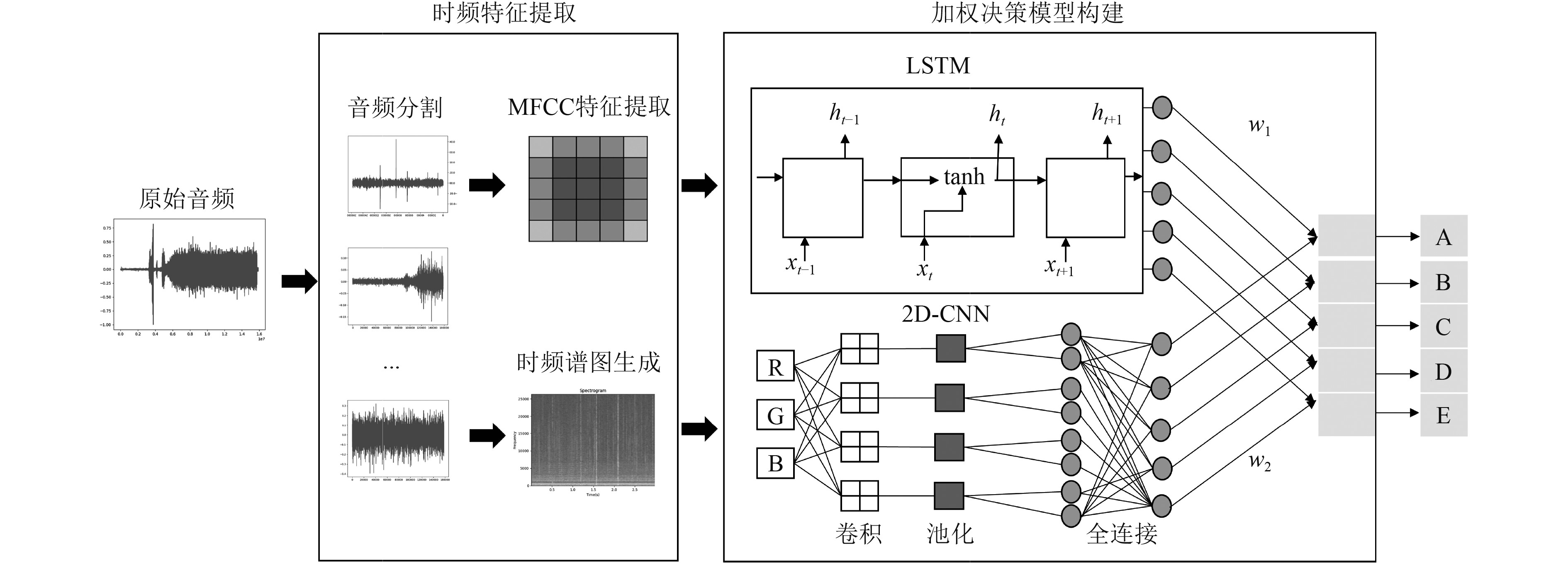

1 基于时频联合和加权决策的水声目标识别 1.1 整体框架本文提出方法的整体框架如图1所示。该框架主要包括2个阶段:时频特征提取(MFCC特征的提取以及二维时频谱图的生成)和加权决策模型构建(LSTM与2D-CNN识别结果的加权决策)。

|

图 1 本文提出方法的整体框架 Fig. 1 The overall framework of our proposed method |

梅尔倒谱系数(MeI-scale Freguency CeptraI Coefficients,MFCC)是最常见的语音特征之一,是在Mel标度频率域提取出来的倒谱系数[6]。MFCC特征在高噪环境下具有较好的鲁棒性,因此在水声识别中表现出更大的优势。MFCC特征提取的过程如图2所示。

|

图 2 MFCC特征的提取过程 Fig. 2 Extraction process of MFCC features |

具体过程为:

1)预加重。对音频信号的高频部分增强。

2)分帧。将信号分成小段,保证输入信号平稳。

3)加窗。对每一帧加窗,增加帧两端的连续性。

4)离散傅里叶变换。用来得到频谱上的能量分布。

5)梅尔滤波器组,将能量频谱进一步平滑化,并消除谐波。

6)对数计算。

7)离散余弦变换。用于去除不同阶数信号值之间具有的相关性。

最后将信号再映射到低维的空间中,从而得到可用于识别、分类的MFCC特征。

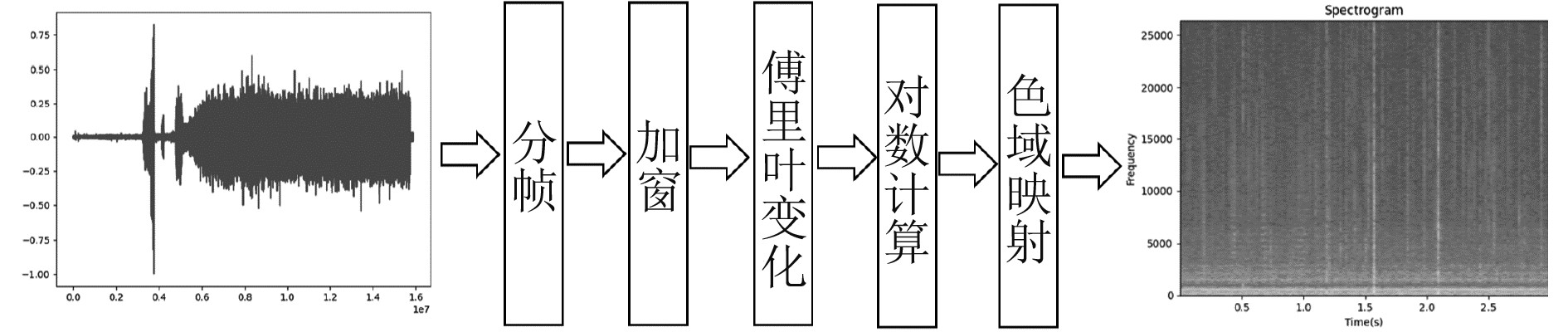

1.2.2 二维时频谱图生成二维时频谱图是通过对原始音频信号进行傅里叶转换生成的一种谱图,包含了丰富的时频域信息。将水声信号转换为二维时频图谱可有效降低噪声影响,因此可有效提高分类识别性能。二维时频谱图的生成过程如图3所示。

|

图 3 二维时频谱图的生成过程 Fig. 3 The process of generating two-dimensional time-frequency spectrograms |

具体过程为:

1)分帧。将整段信号切割成片段进行分析,以解决舰船类信号具有不平稳性以及时变性问题。

2)加窗。用于解决傅里叶变换造成的频谱泄露问题。

3)傅里叶变换。将时域信号转换为频域信号。

4)对数计算。使得能量更加紧凑。

5)色域映射。能量谱值经过离散化后转换为RGB色值。

最后,将离散后的离散色值依据时间顺序进行堆叠就可获得最终的二维时频谱图。依据二维时频谱图可进行目标识别等应用。

1.3 加权决策模型构建加权决策模型主要由两部分构成,第1部分是子网络的构建,该部分主要是搭建LSTM以及2D-CNN并利用时域音频信号和频域的二维频谱图进行水声识别;第2部分是子网络识别结果的加权决策融合,该部分通过对LSTM以及2D-CNN的识别结果进行加权决策融合来获得更好的时频信息。

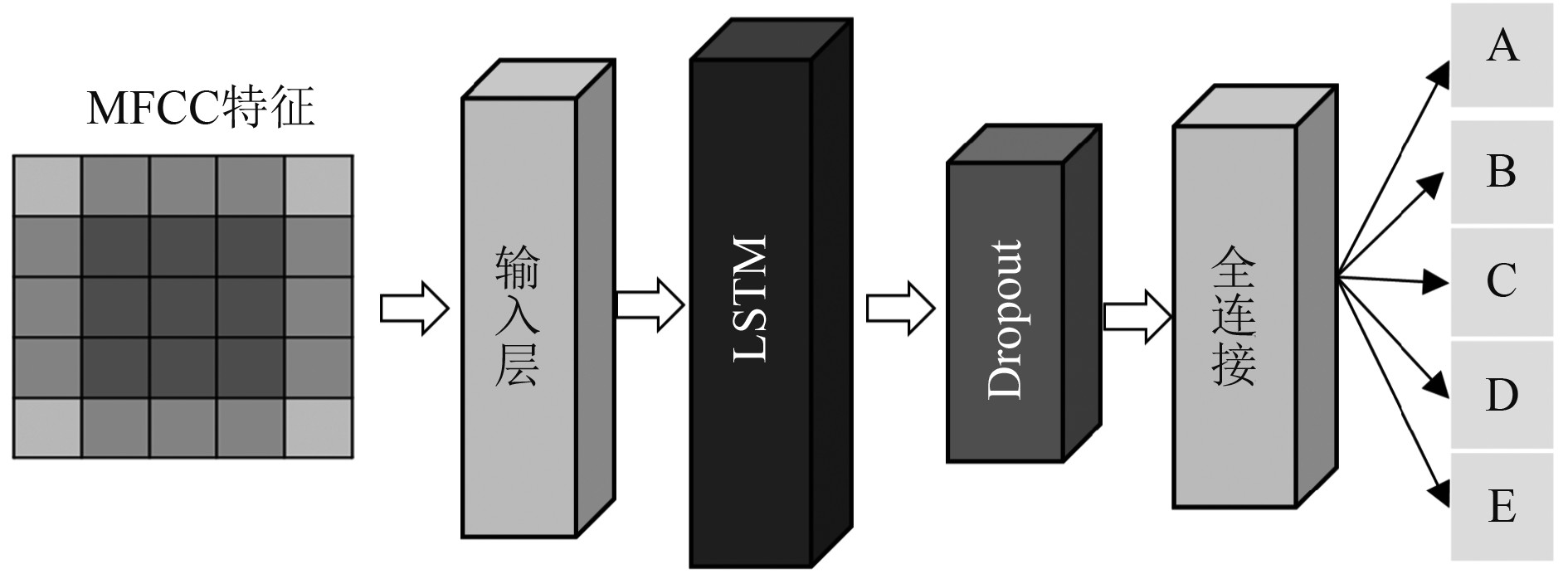

1.3.1 LSTM子网络长短时记忆网络(Long Short Term Memory Network,LSTM)[7]是基于循环神经网络(Recurrent Neural Network, RNN)改进的一种网络,可以解决长序列训练过程中出现的梯度消失和梯度爆炸问题,相比普通的RNN,LSTM能够在更长的序列中有更好的表现。LSTM内部主要包含忘记、选择记忆、输出3个阶段,通过这3个阶段可选择性地增加或去除每个时间结点的信息。音频的MFCC特征具有时序连续特性,因此本文基于水声信号的MFCC特征采用LSTM网络进一步提取深度时序特征用于识别。构建的LSTM网络结构如图4所示。

|

图 4 LSTM模型结构 Fig. 4 LSTM model structure |

构建的LSTM共4层,包含1个输入层、1个LSTM层、1个dropout层以及全连接层。输入层是一个长度为1、维度为40的时序向量;LSTM层的隐藏单元个数设置为128;为了防止LSTM在训练集上过拟合,引入了dropout层来降低模型在训练过程的计算量,丢失率设置为0.2;最后作为输出的全连接层包含5个节点,分别表示预测样本为不同水声目标的概率。

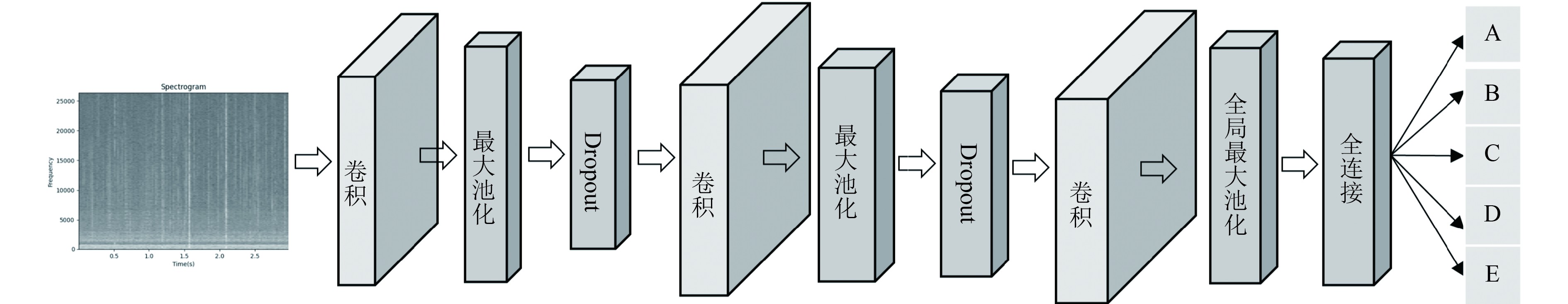

1.3.2 2D-CNN子网络卷积神经网络(Convolutional Neural Network,CNN)是一类包含卷积计算的神经网络,通常由卷积层、池化层、全连接层3个部分构成,主要用于处理图像相关的任务[8]。本文基于由原始语音信号生成的二维时频谱图采用二维卷积神经网络(2D-CNN)进行目标识别。构建的2D-CNN结构如图5所示。

|

图 5 二维卷积模型结构 Fig. 5 2D-CNN model structure |

设计的2D-CNN网络总共为10层,包含1个输入层、3个卷积层、3个池化层、2个dropout层以及1个全连接层。输入层接受的是大小为224×224、RGB三通道的时频谱图,最后输出预测样本属于不同水声目标的概率。详细的网络参数如表1所示。

|

|

表 1 2D-CNN网络层参数 Tab.1 2D-CNN network layer parameters |

本文采取直接平均加权法对LSTM以及2D-CNN的识别结果加权决策。该方法通过赋予LSTM和2D-CNN一样的权重,然后将每个模型的预测结果乘以对应的权重并进行求和来获得最终预测结果。加权决策模型如下:

| $ F=\sum_{i=1}^N w_{i} F_{i}。$ | (1) |

式中:F为加权决策模型的最终预测结果;N为子模型的个数;

| $ w_{i}=\frac{1}{N}。$ | (2) |

本文中,加权的子模型分别为LSTM以及2D-CNN,因此N为2,所以每个模型权重均为0.5。

2 实验数据 2.1 数据集本文使用的数据集来源于公开数据集ShipEar[9],均为海洋实测数据。该数据集收集于2012−2013年间,采集地点为西班牙海岸地区。该数据集总共包含90条音频,时长在15 s~10 min,音频类别包含11种船舶以及环境噪声。该数据集可进一步分为A、B、C、D、E五个类别,其中,A、B、C、D代表舰船种类的4个大类,E为环境噪声。

2.2 数据预处理原始音频数据只有90条且不同类别的音频之间数量差距较大,可能会导致模型出现欠拟合现象。为了解决该问题,将原始的音频数据切割成3 s的片段进行数据集扩充。切割后总音频数为3824,详情如表2所示。

|

|

表 2 数据集分类结果 Tab.2 Data set classification results |

分别对每条音频做如下预处理:

1)提取MFCC特征。提取的MFCC特征维度为(40,309);对特征的列向量进行均值压缩,MFCC特征最终维度为(40,1)。

2)生成二维时频谱。通过对原始音频进行傅里叶变换得二维时频谱图,二维时频谱图的尺寸大小为569×435,RGB三通道。对于网络而言,输入的图像尺寸较大会导致计算量也更大,为了方便网络处理通常会对输入图像进行裁剪,剪裁的尺寸太小会导致信息丢失太严重,裁剪为224×224通常是一个比较好的平衡。因此,本文将生成的二维时频谱图reshape为224×224×3。

将3824个样本按照 6∶2∶2 的比例划分为训练集、验证集与测试集,其中训练集2292个,验证集765个,测试集767个。

3 实验结果分析 3.1 实验设置使用Keras平台进行代码编写,在配置Intel(R) Xeon(R) Silver 4216 CPU@2.10GHz和NVIDIA GeForce GTX 1080 Ti GPU的服务器上进行实验。对于LSTM模型,学习率设为0.001,优化器设为Adam,损失函数设为Categorical_crossentropy,评价函数设为Accuracy,批训练大小设为64,训练代数设为200。对于2D-CNN模型,训练参数与LSTM模型相同。为了避免过拟合,在网络训练的时候引入了Early stopping策略监控val_loss,patience设置为20。

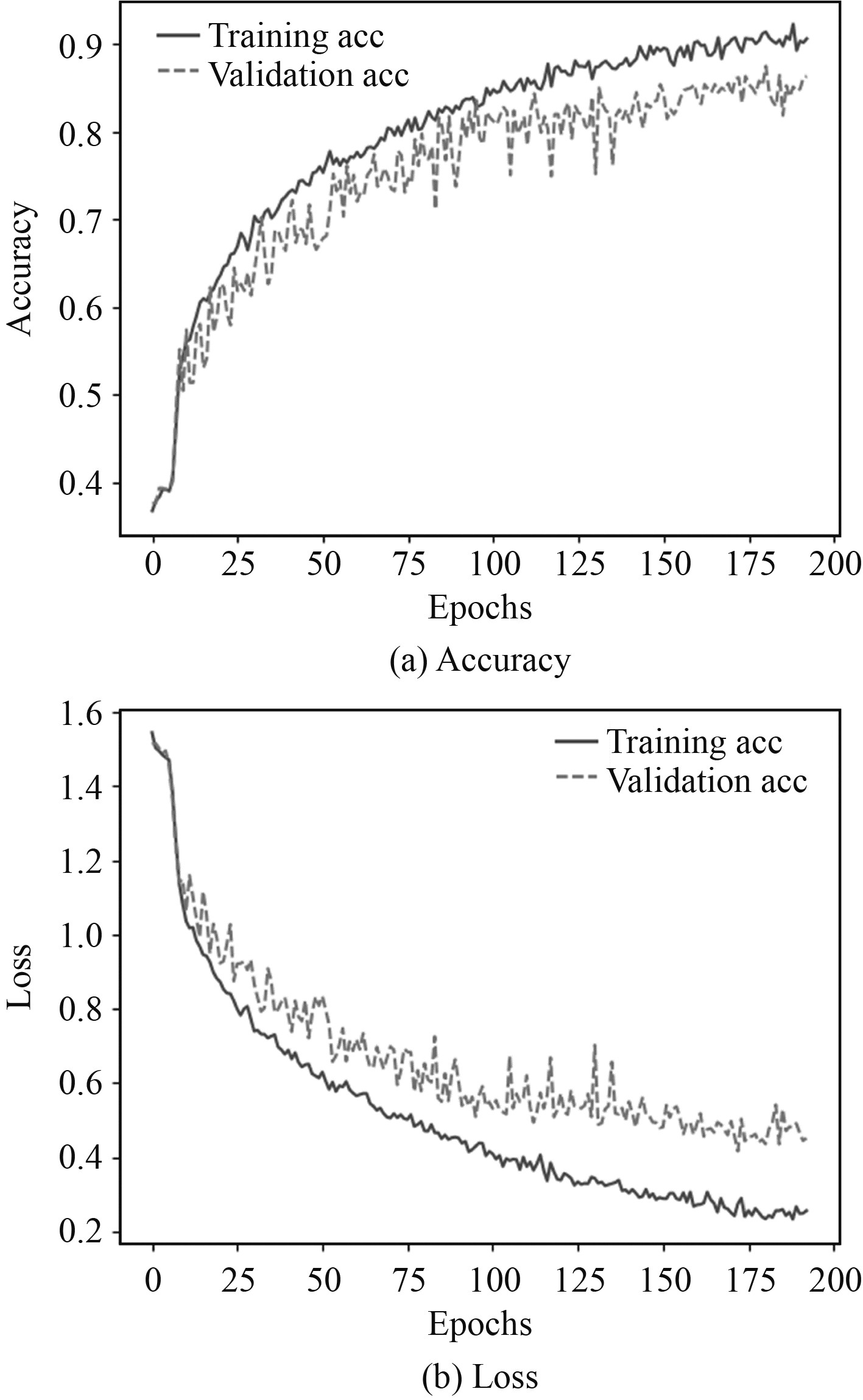

3.2 识别结果LSTM以及2D-CNN训练过程中识别正确率与损失值的变化过程分别如图6和图7所示。可知,加入Early stopping策略后,LSTM经过56个epochs训练后快速收敛,有效避免了过拟合。2D-CNN则经过193个epochs训练后完成收敛。

|

图 6 LSTM准确率以及损失值的变化过程 Fig. 6 The variation process of LSTM accuracy and loss |

|

图 7 2D-CNN准确率以及损失值的变化过程 Fig. 7 The variation process of 2D-CNN accuracy and loss |

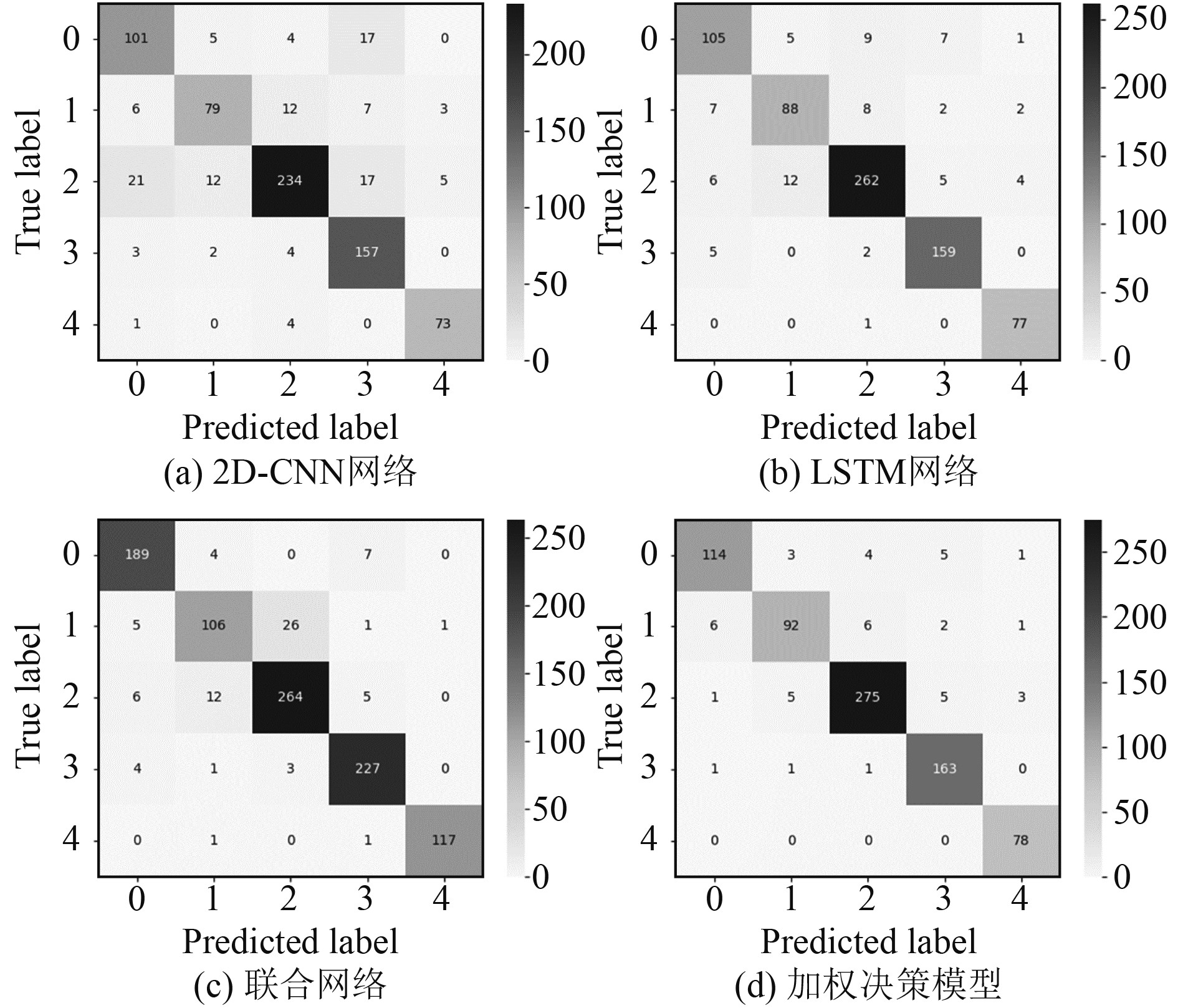

为了验证本文提出的加权决策模型性能的优越性,将本文方法与单一子网络2D-CNN、单一子网络LSTM 以及任晨曦等提出的联合网络[10]在测试集上的识别准确率(Acc)、召回率(Recall)、精确率(Precision)、F1分数(F1-score)进行比较,结果如表3所示。

|

|

表 3 4种方式识别结果对比 Tab.3 Comparison of recognition results of four methods |

可知,本文提出的加权决策模型在水声数据测试集上的分类Acc、Recall、Precision、F1-score分别为0.9413、0.9381、0.9363、0.9368,相比于单一2DCNN、单一LSTM和联合网络的表现,在Acc上分别提高了10.17%、3.91%、1.99%,在Recall上分别提高了9.32%、3.64%、2.28%,在Precision上分别提高了10.19%、4.37%、1.32%,在F1-score上分别提高了9.94%、4.01%、1.78%。由此可看出,加权决策模型在测试集上的表现不仅优于单一网络还优于现有的方法。

为了更加直观地对比每个方法在测试集的表现,将测试集上的识别结果混淆矩进行可视化展示,结果如图8所示。其中,横纵坐标的0~5分别代表预测目标类别A~E。可看出,单一2DCNN容易将A类目标错误的识别为D类目标,单一LSTM容易将C类目标错误的识别为B类目标,联合网络容易将B类目标错误的识别为C类目标,而加权决策模型则可以很好地缓解这些问题。

|

图 8 4种方法识别结果的混淆矩阵 Fig. 8 Confusion matrix for 4 methods identification results |

通过混淆矩阵可进一步计算出4种方法对于5类预测目标的具体识别精度,如表4所示。可知,提出的加权决策模型对A、B、C、D、E的识别率分别为89.76%、85.98%、95.16%、98.19%、100%。相比于单一2DCNN,分别提升10.23%、12.15%、14.19%、3.61%、6.41%。相比于单一LSTM,分别提升6.3%、3.74%、4.5%、2.41%、1.28%。相比于联合网络,分别提升−4.74%、9.72%、3.17%、1.59%、1.68%。由对比结果可知,将LSTM和2D-CNN的识别结果加权决策后不仅可以有效提升整体识别率而且可以有效提升对5类目标的具体识别正确率。任晨曦等[10]提出的联合网络只考虑了时域音频信号并没有考虑到频域的二维时频谱图,但是本文同时考虑了二者。由此可推出,单一的考虑时域音频信号或频域的二维时频谱图会遗漏部分时频信息,导致识别精度存在上升空间。通过同时考虑时域音频信号和频域的二维时频谱图的时频信息,则可以有效地提升水声目标识别的精度。

|

|

表 4 4种方法对各类别识别结果对比 Tab.4 Comparison of recognition results of three methods for each category |

为了提高水声识别精度,本文提出一种基于时频联合和加权决策的水声目标识别方法。该方法考虑了船舶的时域音频信号和频域的二维时频谱图存在时频信息的互补关系,采用LSTM对水声信号的MFCC特征提取时域特征和采用2D-CNN对水声信号的二维时频谱图提取频域特征,并对LSTM和2D-CNN网络的识别结果进行加权决策融合。通过实验验证,在ShipEar数据集上,本文提出的识别方法识别正确率相比于现有方法提升了1.99%,这不仅证明了本文方法在解决水声识别任务性能的优越性,而且为水声目标识别方法发展提供了新的思路。但是本文使用的数据集较为单一,因此网络的泛化能力还需进一步验证,未来可通过扩充数据集来充分训练以及测试网络。

| [1] |

黄海宁, 李宇. 水声目标探测技术研究现状与展望[J]. 中国科学院院刊, 2019, 34(3): 264-271. HUANG H N, LI Y, et al. Underwater acoustic detection: current status and future trends[J]. Bulletin of Chinese Academy of Sciences, 2019, 34(3): 264-271. DOI:10.16418/j.issn.1000-3045.2019.03.003 |

| [2] |

李兰瑞, 李鹏, 刘天宇, 等. 水声信号检测与识别技术研究现状[J]. 通信技术, 2020, 53(12): 2904-2907. LI L R, LI P, LIU T Y, et al. Research status of hydroacoustic signal detection and identification technology[J]. Communications Technology, 2020, 53(12): 2904-2907. DOI:10.3969/j.issn.1002-0802.2020.12.004 |

| [3] |

岳成海, 王旭, 宫俊玲, 等. 基于深度学习的水下目标声学识别与定位技术研究[J]. 数字海洋与水下攻防, 2021, 4(6): 492-497. YUE C H, WANG X, GONG J L, et al. Research on underwater target recognition and location technique based on deep learning[J]. Digital Ocean & Underwater Warfare, 2021, 4(6): 492-497. DOI:10.19838/j.issn.2096-5753.2021.06.009 |

| [4] |

张少康, 王超, 田德艳, 等. 长短时记忆网络水下目标噪声智能识别方法[J]. 舰船科学技术, 2019, 41(12): 181-185. ZHANG S K, WANG C, TIAN D Y, et al. Intelligent recognition of underwater target noise based on long short-term memory networks[J]. Ship Science and Technology, 2019, 41(12): 181-185. DOI:10.3404/j.issn.1672-7649.2019.12.035 |

| [5] |

王升贵, 胡桥, 陈迎亮, 等. 基于深度学习的水下目标识别方法研究[J]. 舰船科学技术, 2020, 42(12): 141-145. WANG S G, HU Q, CHEN Y L, et al. Research on underwater target recognition method based on deep learning[J]. Ship Science and Technology, 2020, 42(12): 141-145. DOI:10.3404/j.issn.1672-7649.2020.12.028 |

| [6] |

TIWARI V. MFCC and its applications in speaker recognition[J]. International Journal on Emerging Technologies, 2010, 1(1): 19-22. |

| [7] |

YU Y, SI X, HU C, et al. A review of recurrent neural networks: LSTM cells and network architectures[J]. Neural Computation, 2019, 31(7): 1235-1270. DOI:10.1162/neco_a_01199 |

| [8] |

O'SHEA K, Nash R. An introduction to convolutional neural networks[J]. arXiv preprint arXiv: 1511.08458, 2015.

|

| [9] |

SANTOS-DOMÍNGUEZ D, TORRES-GUIJARRO S, CARDENAL-LÓPEZ A, et al. ShipsEar: An underwater vessel noise database[J]. Applied Acoustics, 2016, 113: 64-69. DOI:10.1016/j.apacoust.2016.06.008 |

| [10] |

任晨曦, 王黎明, 韩星程, 等. 基于联合神经网络的水声目标识别方法[J]. 舰船科学技术, 2022, 44(1): 136-141. REN C X, WANG L M, HANG X C, et al. Underwater acoustic target recognition method based on joint neural network[J]. Ship Science and Technology, 2022, 44(1): 136-141. DOI:10.3404/j.issn.1672-7649.2022.01.026 |

2024, Vol. 46

2024, Vol. 46