舰船在航行过程中,利用导航系统对周围环境进行实时监测,这里的环境包括地面(海岸线、港口等)、海洋、航道中的障碍物(其他舰船、海上航标等)以及海洋天气情况等。根据监测结果,舰船驾驶人员能够随时对航行路线进行调整、规划,以避免危险。

张哲卿等[1]为了解决海上船舶目标不清晰导致检测准确率低的问题,提出一种基于深度学习框架的船舶红外与红外偏振图像的融合方法来增强海面船舶弱目标,提高检测准确率。段仕浩[2]利用机器视觉技术获取船舶航行图像数据,结合像素平滑滤波和帧间差分法去除原始图像所含噪声,通过获取的图像的显著性均值与阈值作比较,实现了船舶航行危险区域识别。吴勇等[3]提出一种基于综合因素模糊评判算法的AIS与视频图像融合方法,设计了分布式框架融合模型,实现了视频图像中目标的识别与跟踪。

本文基于视觉传达的空间模型,结合导航系统检测到的舰船航行图像数据,进行相应的图像处理研究,增强了图像检测效果,对舰船的安全航行提供可靠保障。

1 关键技术视觉传达本质上来讲就是用机器代替人眼获取信息,也就是计算机视觉技术,是指通过光学的装置和非接触的传感器,自动接收和处理真实物体的图像,以获取所需信息。相对于人眼来说,计算机视觉具有速度快、精度高、可适应性强等特点,因此被广泛应用于自主导航等系统中。

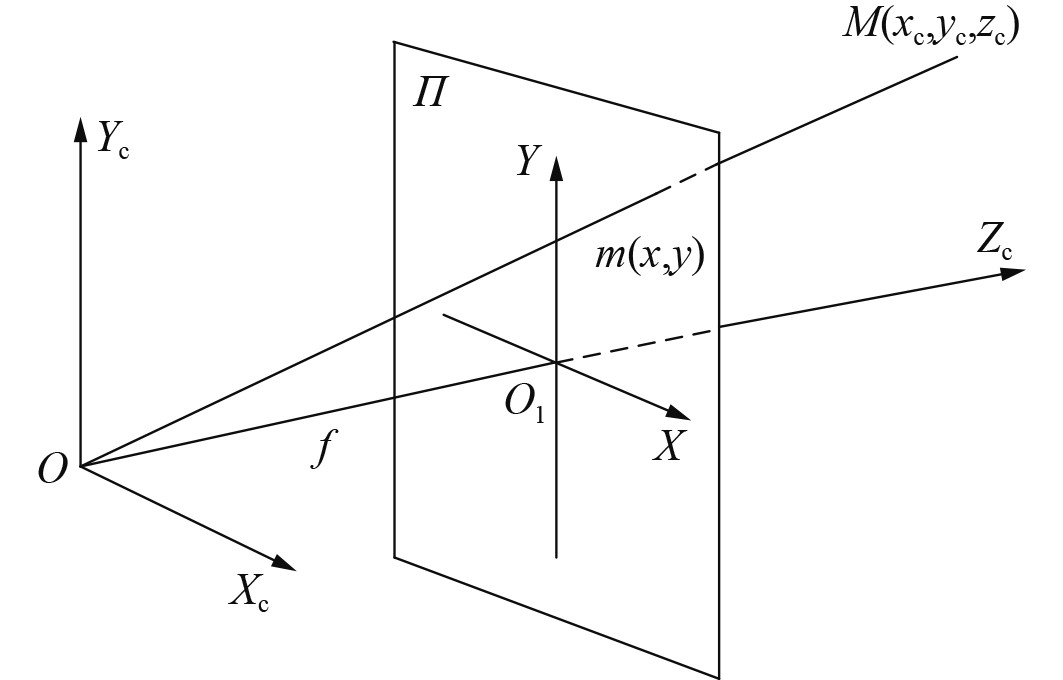

在计算机视觉中,图像是指空间物体通过成像系统反映在像平面上的投影。这些投影之间的关系也就是成像模型,理想的成像模型是针孔模型,而摄像机成像系统和针孔模型具有相同的成像关系,因此,可以用针孔模型直接作为摄像机成像模型,其坐标系如图1所示。

|

图 1 摄像机坐标系 Fig. 1 Camera coordinate system |

根据三角形相似原理,可以得到

| $ {z_c}m = \left[ \begin{gathered} f{x_c} \\ f{y_c} \\ {z_c} \\ \end{gathered} \right] = \left[ {\begin{array}{*{20}{c}} f&0&0&0 \\ 0&f&0&0 \\ 0&0&1&0 \end{array}} \right]{X_c} 。$ | (1) |

其中,

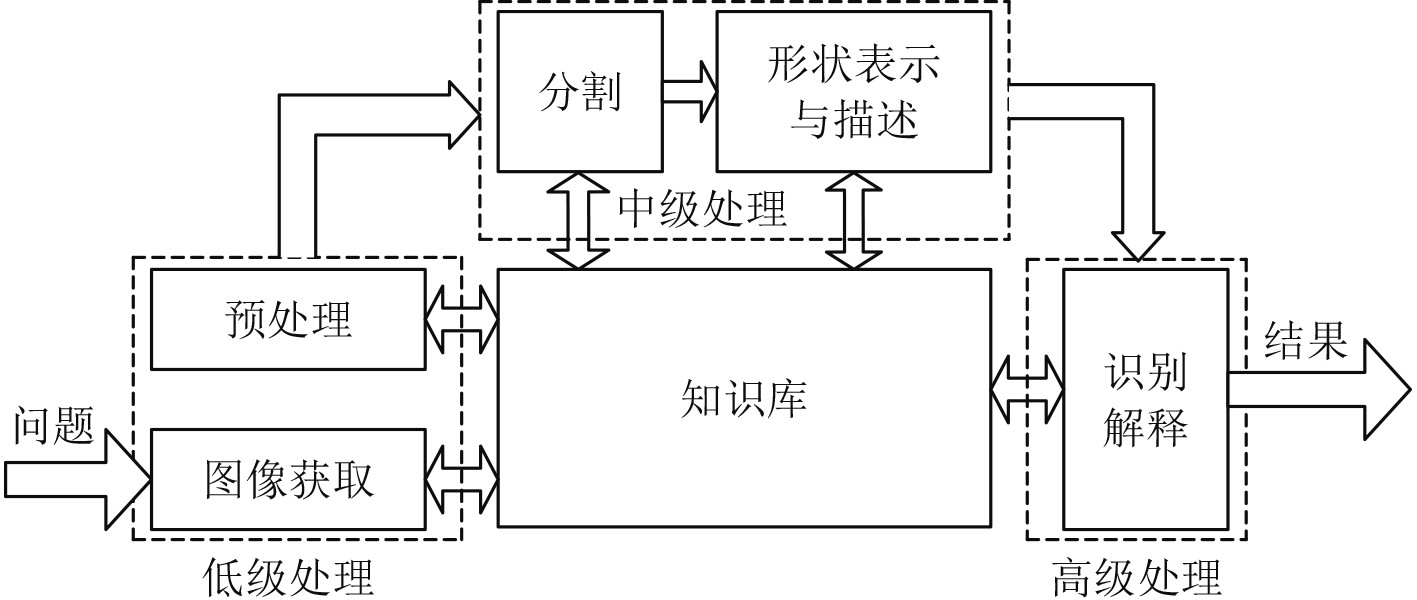

计算机视觉中,视觉信息的处理技术主要依赖于图像处理方法,包括平滑、锐化、边缘检测、特征提取等。经过这些处理后,目标图像的质量得到改善,便于后续的处理和识别,一个常见的图像处理、分析过程如图2所示。

|

图 2 图像处理分析过程 Fig. 2 Image processing and analysis process |

图像处理主要有2个目的,改善(增强或恢复)像质和图像分析(对图像内容作出描述)。根据这两个目的,在获取图像后,需要对图像进行预处理,主要是按需进行适当的变换,突出有用信息,去除或者减弱无用信息,比如对比度增强、去噪、边缘提取等。分割则是将一幅图像划分为互不重叠区域的一种处理。最后则是对图像中的不同对象进行分类、描述和解译。

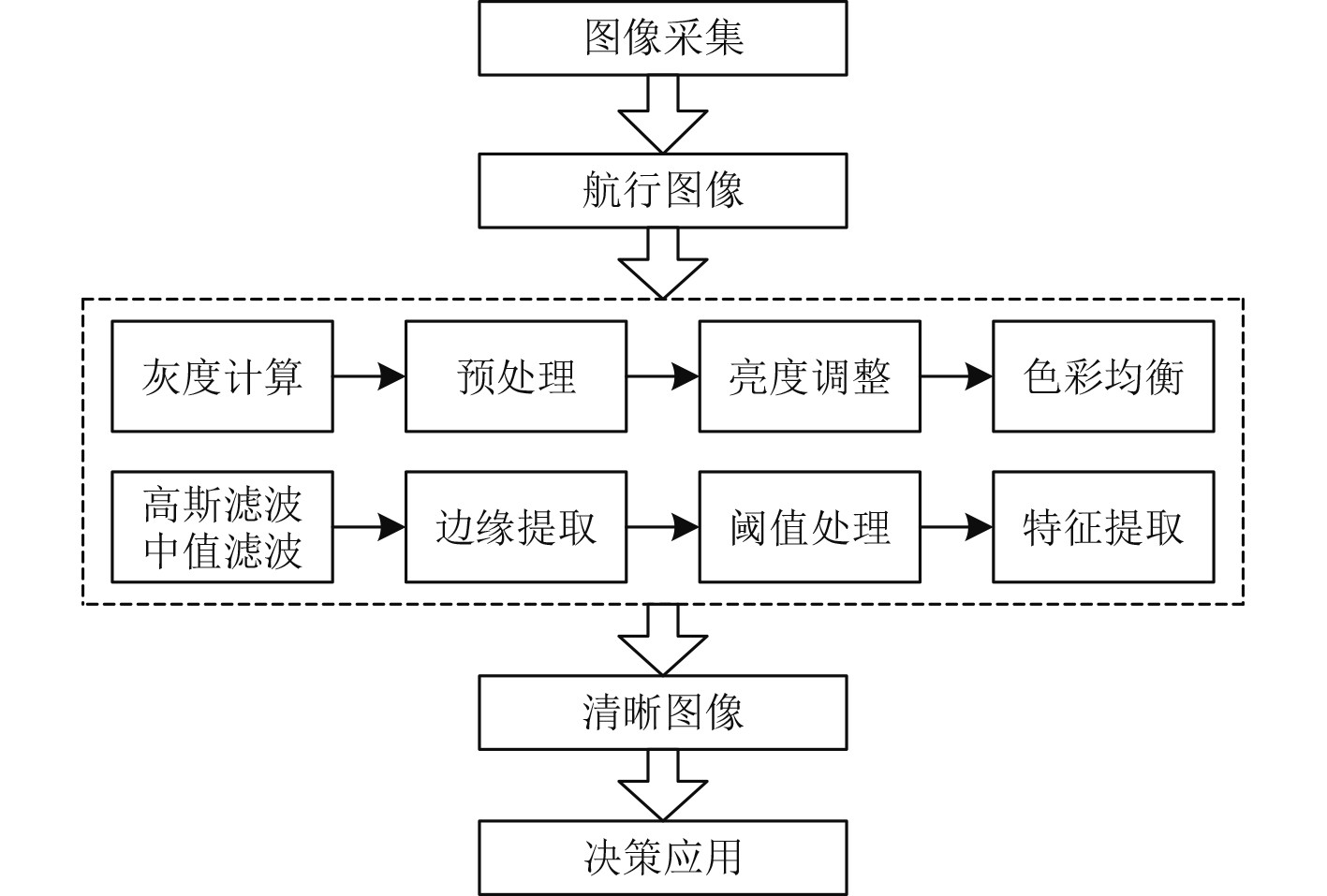

2 基于视觉传达的航行图形图像处理研究基于视觉传达,综合考虑舰船航行的特殊环境,本文采用如图3所示的图像处理流程。

|

图 3 基于视觉传达的航行图形图像处理流程图 Fig. 3 Navigation graphics image processing flow chart based on visual communication |

图像采集工作主要由舰载摄像机完成,或者直接从存储介质中读取所需图像、视频文件。灰度计算后会根据灰度值进行图像增强[4]。考虑到舰船航行的特殊环境,在进行图像预处理时需要考虑到天气情况,相应地需要进行类似去雾、去雨的工作。图像增强则是进一步地改善图像的质量,使得图像更容易被观察和分析,常见的方法包括灰度变换、直方图均衡化、空间滤波等。

高斯滤波和中值滤波消除了图像噪声,平滑了图像,减少了复杂环境对图像的影响。边缘提取主要针对于舰船航行过程中对目标物的识别检测,提取特征后得到质量更高、更清晰的图像,以便作出相应决策。

2.1 舰船航行中图像去雾、去雨处理由于舰船航行的特殊环境,在海上经常会遇到恶劣天气,图像采集设备获取的图像数据质量也受到严重的影响,重点介绍在雨雾天气中对图像进行去雾、去雨处理的方法。

2.1.1 图像去雾处理传统的图像去雾方法主要分为基于图像处理的增强方法和基于物理模型的复原方法,传统方法的特点是根据图像的退化机制,利用相关物理模型尽可能地去除更多的噪声,其缺点是计算量庞大,图像会出现局部失真的现象。

目前,最常用的去雾方法是基于卷积神经网络的算法,这个方法不需要分析退化机制,而是直接根据图像间的内在联系进行学习,与传统的方法相比,此类方法计算量少,去雾性能更强。

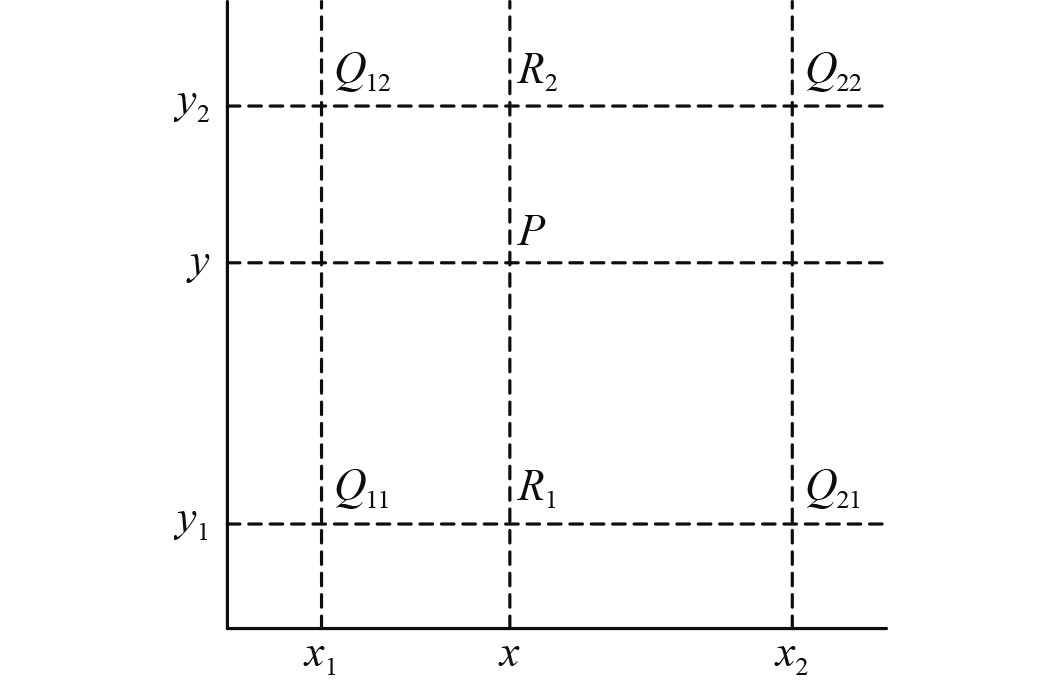

本文采用在FCTF-Net基础上改进的双通道双阶段图像去雨网络(DTDNet),以便获得不同深度的图像特征。由于采用了上下双通道采样模块,因此利用双线性差值上采样计算方法,如图4所示。

|

图 4 双线性差值上采样计算方法 Fig. 4 Method of bilinear difference up-sampling |

图中,特征值被分解为

| $ f\left( {{R_2}} \right) = \frac{{{x_2} - x}}{{{x_2} - {x_1}}}f\left( {{Q_{12}}} \right) + \frac{{x - {x_1}}}{{{x_2} - {x_1}}}f\left( {{Q_{22}}} \right) \text{,} $ | (2) |

| $ f\left( {{R_1}} \right) = \frac{{{x_2} - x}}{{{x_2} - {x_1}}}f\left( {{Q_{11}}} \right) + \frac{{x - {x_1}}}{{{x_2} - {x_1}}}f\left( {{Q_{21}}} \right) \text{,} $ | (3) |

| $ f\left( P \right) = \frac{{{y_2} - y}}{{{y_2} - {y_1}}}f\left( {{R_1}} \right) + \frac{{y - {y_1}}}{{{y_2} - {y_1}}}f\left( {{R_2}} \right) 。$ | (4) |

在去雾网络中使用较为广泛的是损失函数,其定义如下:

| $ {L_{MSE}} = \frac{1}{N}{\sum\limits_{i = 1}^N {\left( {{Y_{true}} - {Y_{pred}}} \right)} ^2} 。$ | (5) |

其中:

但由于有时会存在异常点,该函数会产生错误的差值,影响计算结果,因此,引入感知函数来降低MSE函数出现异常的可能性,计算公式如下:

| $ {L_A} = \frac{1}{{CWH}}\sum\limits_{C = 1}^C {\sum\limits_{W = 1}^W {\sum\limits_{H = 1}^H {\left\| {V\left( {{Y_{true}}} \right) - V\left( {{Y_{pred}}} \right)} \right\|} } } _2^2 。$ | (6) |

其中:

主要的图像去雨方法包括视频图像去雨和单幅图像去雨,由于视频图像去雨受到视频质量的影响,导致效果不可控,目前主要采用单幅图像去雨,相对于前者而言,后者能够进行更精确的去雨,恢复的图像特征更多。而在单幅图像去雨中,目前的研究热点同样也是基于卷积神经网络的算法。

图像去雾的目的是去除图像中比较明显、集中的雾霾或雾团,而图像去雨的目的则是去除图像中随机出现且相对比较分散的雨滴,二者在本质上是完全不同的。由于2种情况下,基于卷积神经网络的算法原理基本相似,因此可以将去雾网络运用于图像去雨[5]。

在去雾网络的基础上,引入通道注意力机制,对关键信息的特征进行加强。同时,考虑到雨滴在图像中的分布特点,为了避免信息丢失,利用金字塔多尺度池化层对输出进行处理。

为了降低图像中相邻像素值之间的差异,引入TV Loss函数再次对损失函数进行改进,TV Loss函数的表达式如下:

| $ {L_{TV}} = {\sum\limits_{i,j} {\left( {{{\left( {{x_{i,j - 1}} - {x_{i,j}}} \right)}^2} + {{\left( {{x_{i + 1,j}} - {x_{i,j}}} \right)}^2}} \right)} ^{\frac{\beta }{2}}}。$ | (7) |

其中:

本文主要采用对数和指数变换,对图像的亮度和色彩进行增强。图像灰度的对数变化为

自动色彩均衡(Automatic Color Enhancement,ACE)是在Retinex基础上提出的,该算法的原理是计算目标图像中的像素点和周围像素点的明暗程度,产生和视网膜相似的色彩均衡,从而达到图像增强效果。其计算公式为:

| $ Y = \frac{{\displaystyle\sum {\left( {g\left( {I\left( {{x_0}} \right) - I\left( x \right)} \right)w\left( {{x_0},x} \right)} \right)} }}{{\displaystyle\sum {\left( {w\left( {{x_0},x} \right)} \right)} }} 。$ | (8) |

其中:

通过上述方法,使得图像得到增强,明暗程度得到了改善,同时也保留了图像的真实性。

2.3 图像融合在实际的舰船航行中,获取信息的途径并不是单一的。对于同一个目标,任意一个途径获得的数据都不可能全面地描述目标特征及信息,这就需要将多个途径获取的图像进行融合,目的在于提高图像的信息可用度,同时也增加了对研究对象识别的可靠性。

图像融合分为三级别,像素像元级融合、特征级融合、决策级融合。像素级融合尽管是最低层次的融合,由于其基于最原始的图像数据,能够更多地保留图像的真实性和细微信息。

采用加权融合的方法对图像进行融合,对于2幅图像

| $ {I'_{ij}} = A\left( {{P_i}{I_i} + {P_j}{I_j}} \right) + B 。$ | (9) |

其中:

根据图像处理流程及重要过程中的相应处理方法,对雾天中的图像数据进行一系列处理,实验结果如图5所示。

|

图 5 图像处理对比结果 Fig. 5 Comparison results of image processing |

可以看出,原始图像中存在较大面积的雾团,影响了对舰船前方目标的观测。根据的图像处理方法,进行去雾处理,同时拉伸了低灰度区,调整图像的明暗程度,对图像进行了增强。处理后的图像中,前方船只的轮廓和形状更加清晰,便于后续对该船只的监测和跟踪,也为舰船的航行路线调整提供可靠的数据。

以峰值信噪比(PSNR)、相似度(SSIM)和处理时间为评价指标,对去雾网络算法进行对比实验,实验结果如图6所示。

|

图 6 不同方法的对比 Fig. 6 Comparison of different methods |

可以看出,在几种不同的算法中,本文采用的算法在信噪比上优于其他方法,同时,图像的相似度上也是最高的,说明在增强了图像的同时,更大程度地保留了原始图像中的信息。不过,在算法执行时间上的优势并不明显,在后续的研究中,可以再进行适当改进。

3 结 语本文基于计算机视觉传达技术,对舰船航行中的图像数据设置处理流程,进行分析和处理。重点研究对恶劣天气中的图像去雾、去雨的算法,在FCTF-Net的基础上对算法进行改进,并对几种算法进行了对比实验。同时,根据图像处理流程和方法,完成了对含噪图像的处理。结果表明,在改善图像的同时,最大程度地保证了图像的真实性。

| [1] |

张哲卿, 朱志宇, 魏莱, 等. 复杂海面背景下船舶红外偏振图像融合方法[J]. 电光与控制, 2023, 30(7): 68-72. |

| [2] |

段仕浩. 基于机器视觉技术的船舶航行危险区域自动识别方法[J]. 舰船科学技术, 2023, 45(3): 157-160. DOI:10.3404/j.issn.1672-7649.2023.03.030 |

| [3] |

吴勇, 初秀民, 刘兴龙, 田国昊. 船舶AIS与视频图像信息融合方法研究[J]. 武汉理工大学学报(交通科学与工程版), 2023, 47(3): 575-581. |

| [4] |

解宇虹, 谢源, 陈亮, 李翠华, 曲延云. 真实有雾场景下的目标检测[J]. 计算机辅助设计与图形学学报, 2021, 33(5): 733-745. |

| [5] |

王道累, 张天宇. 图像去雾算法的综述及分析[J]. 图学学报, 2020, 41(6): 861-870. |

2023, Vol. 45

2023, Vol. 45