2. 大连大学 信息工程学院,辽宁 大连 116622

2. College of Information Engineering, Dalian University, Dalian 116622, China

水下图像作为水下信息的载体,其对深海环境感知与资源探索发挥着重要作用。水下成像环境复杂光的散射导致了雾霾效应,光的衰减导致了颜色偏色。这些问题对进一步的水下研究(目标识别、目标检测等)造成严重影响,所以需要对所采集到的图像进行处理。图像处理是为了改善图像的视觉效果,而改善图像质量最有效的方法是图像增强。图像增强可提高图像的分辨率和质量,将图像变得更加清晰,方便计算机对图像的分析和处理。

针对水下成像特点,存在3类方法可增强水下图像清晰度,分别为:基于物理模型方法、基于非物理模型方法、基于深度学习方法[1]。基于物理模型的方法主要依据Jaffe-McGlamey[2]水下成像模型,通过求解水下成像模型的逆运算以获得清晰的水下图像[3-4]。这列方法建立在假设的基础上,所以与实际存在一定偏差,对图像恢复程度很有限。非物理模型的方法参考于传统图像处理方法,直接调整图像像素取值[5-6]。由于未考虑水下图像成像特点,单一使用无法解决图像偏色和对比度低的问题。另外,这2种方法使用的数据量不大,泛化能力难以保证,也难以移植于水下视频增强等领域。基于深度学习的方法根据主体结构的不同可分为两大类,即基于卷积神经网络的(CNN)方法和基于生成对抗网络(GAN)方法。Wang等[7]提出了一种基于卷积神经网络(CNN)的水下图像增强方法,该方法提高了水下图像的亮度和对比度,但红色过度增强在颜色矫正上还有待改善。Islam等[8]提出一种基于生成对抗网络的实时水下图像增强模型,该方法增强后的图像呈现出暗黑色,整体视觉效果较差。

针对上述问题,本文结合特征融合思想,提出一种基于色彩均衡和生成对抗网络的水下图像增强算法。该算法由生成网络和判别网络2个模块组成。其中在生成网络中引入色彩均衡模块,通过去偏色算法解决水下图像偏色问题。判别网络通过学习区分生成图像与参考图像,判断数据是否为真。此外,通过构建包含结构相似性和最小绝对值偏差的多项损失函数,进一步提升模型性能。结果表明,本文算法能够更有效地改善水下图像的颜色失真与偏色问题。

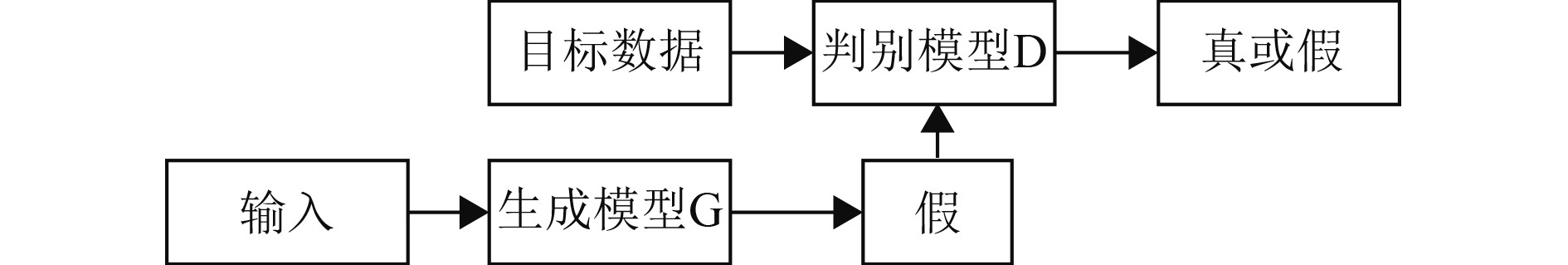

1 基本原理GAN需要训练2个模型,一个生成模型D负责负责凭空捏造数据出来,一个判别模型G 负责判别网络通过学习区分生成图像与参考图像。2个网络相互博弈,其网络结构如图1所示。

|

图 1 GAN原理图 Fig. 1 Schematic diagram of GAN |

首先向G中输入随机噪声,G根据一串随机数据捏造假图像用于欺骗D,D负责判别真假图并且给出一个结果。G的目标是生成几乎与原图相似的假图从而使得D判断错误的概率增大。而D的目标是有效区分真假图。GAN的原理公示可表示为:

| $\begin{split}\underset{G}{\min}\underset{D}{\max}V\left(G,D\right)=&E\left[{\rm{log}}D\left(x\right)\right]+\\ &E\left[{\rm{log}}\left(1-D\left(G\left(Z\right)\right)\right)\right]。\end{split}$ | (1) |

式中,x为目标数据,z为G端输入的随机噪音。在对抗训练中模型在训练G的同时也会训练D,训练G使

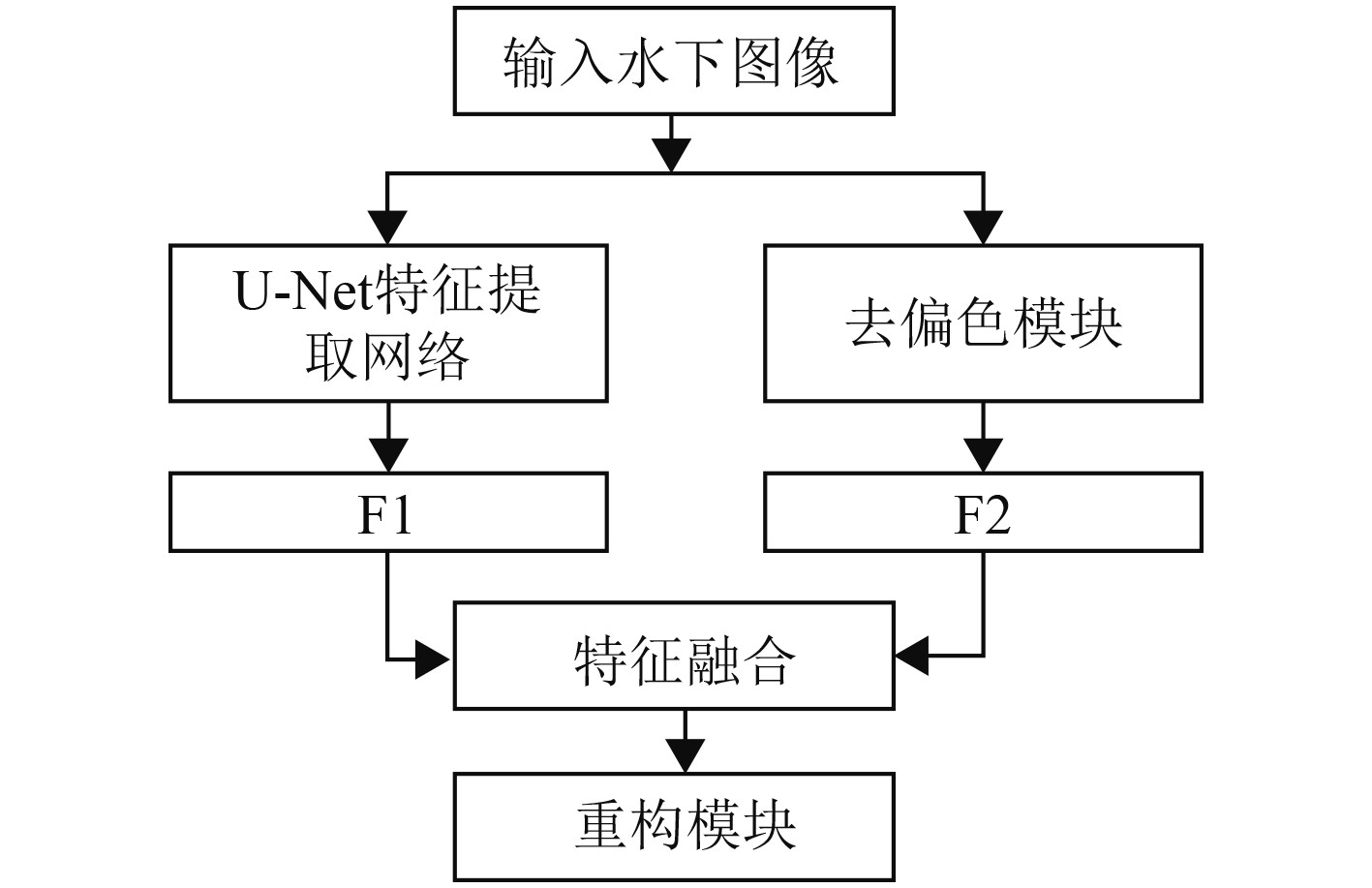

本文提出一种特征提取的GAN模型。其特点在于G中分为2个模块,将U-Net[9]提取的特征与偏色校正图像的特征融合,通过卷积神经网络完成增强后的图像重构。相比普通GAN算法,能够更有效地改善水下图像的偏色问题。所提算法的执行过程如下:首先通过U-Net网络提取图像特征F1,然后使用去偏色算法解决水下图像偏色问题,通过卷积网络提取特征F2,将其与F1以对应元素相乘的方式融合,最后以卷积网络完成特征到增强图像的重构。D采用全卷积网路结构,来实现对生成图像与其对应的参考图像的判别。本文算法的网络结构及数据流动方向如图2所示。

|

图 2 本文网络结构 Fig. 2 The network structure of this paper |

在G中添加去偏色模块,基于U-Net网络提取到的特征F1与通过卷积网络提取的去偏色图像特征F2,通过对应元素相乘进行特征融合,最后通过卷积网络完成重构。其流程如图3所示。

|

图 3 G流程图 Fig. 3 G flow chart |

使用U-Net网络进行特征提取,其结构如图2所示,采用了对称编码器解码器,该模块主要由下采样和上采样部分组成。其中,下采样单元中包含一个卷积步长为1和一个卷积步长为2的卷积层,而上采样单元中包含一个卷积步长为1的卷积层和一个卷积步长为2的反卷积层。对提取到的特征使用批归一化(BN)处理,同时使用LeakyRe LU函数作激活函数。水下图像经过特征提取后被映射为

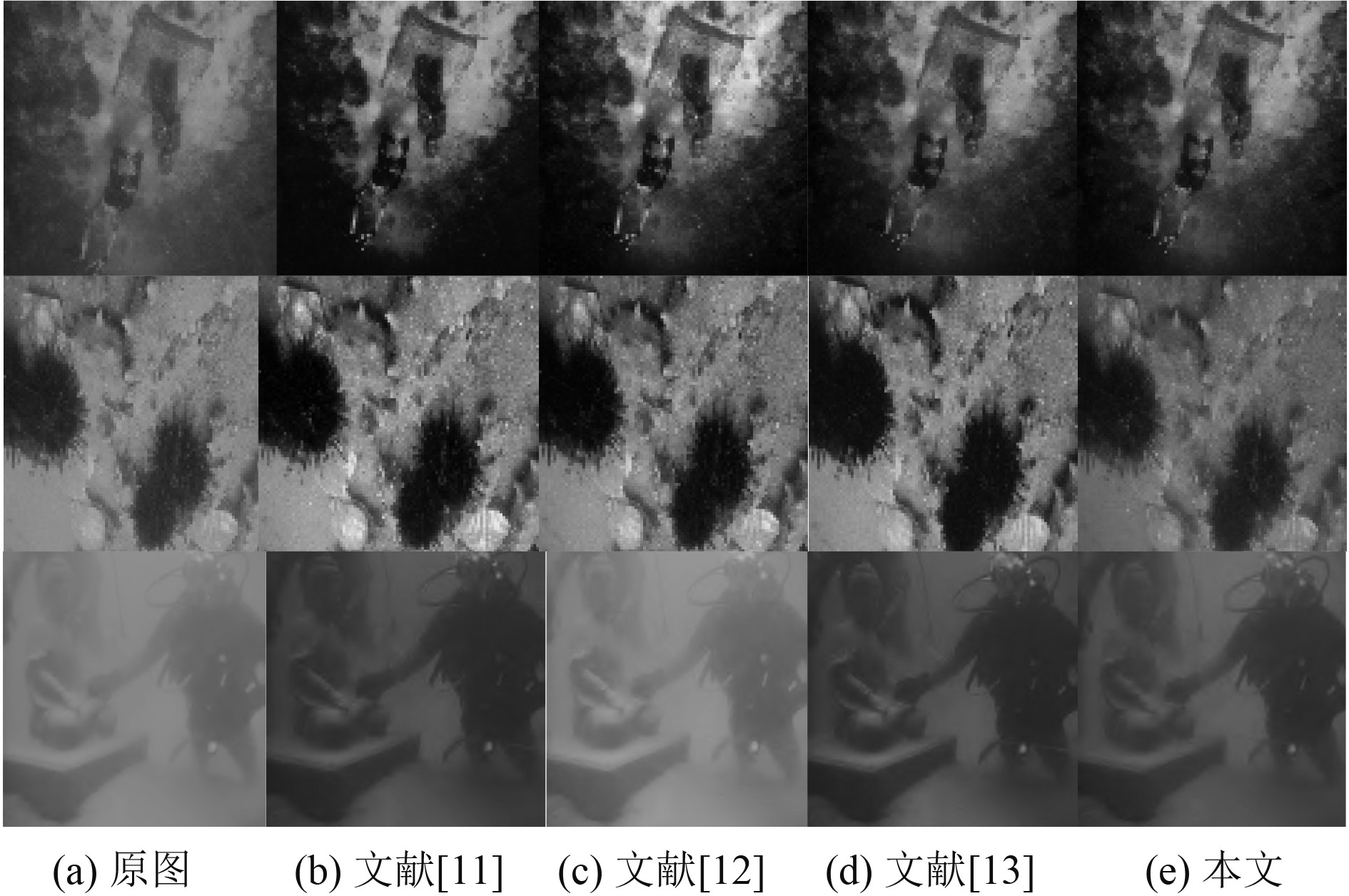

光的衰减程度在水下环境中是不同的,其中红光衰减最快,蓝绿光衰减相对较慢,导致获得的水下图像会出现呈现偏蓝或偏绿特性[10]。为了提高网络的水下修复效果,在生成器G中添加了去偏色模块。颜色校正的传统算法有灰度世界算法[11]和完美反射算法[12]。它们的处理水下图像的效果如图4所示。可以看出,灰度世界算法在处理偏色问题时有明显作用。同时复杂度较低,但其对红色通道像素强度显著区域会出现过度补偿。原因是水对红色光的衰减最为明显,使得红色通道的均值较小,灰度世界算法对红色通道部分像素值显著区域出现过度补偿的问题。

|

图 4 不同颜色校正算法结果对比 Fig. 4 Comparison of the results of different color correction algorithms |

针对以上问题,Ancuti等[13]在2018年提出一种新的白平衡算法,该算法提出基于各个通道的像素差值对红通道和蓝通道进行补偿,然后用灰度世界算法对颜色补偿后的图像进行颜色校正。其红色通道补偿格式为:

| $ \begin{array}{c}{I}_{rc}={I}_{r}+\alpha \times \left(\bar{{I}_{g}}- \bar{{I}_{r}}\right)\times\left(1-{I}_{r}\right)\times{I}_{g}。\end{array} $ | (2) |

式中:

本文在文献[13]的基础上进行改进。在对红通道进行补偿时,由于灰度世界假设所有通道的均值相同,而红通道均值和绿通道均值的差值体现红、绿通道衰减的不平衡性,因此基于该差值对红通道进行补偿。补偿后的红通道像素值为:

| $ \begin{array}{c}{I}_{rc}={I}_{r}+\left(\bar{{I}_{b}}-\bar{{I}_{r}}\right)\times \left(1-{I}_{r}\right)\times{I}_{b} 。\end{array} $ | (3) |

式中:

在使用改进过的去偏色算法对水下图像进行初步处理后,设计一个特征提取网络来提取去偏色图像的特征F2该网络结构由2个卷积层构成。使用大小为3、卷积长为1的卷积核,并在卷积层后添加批归一化BN层和Leaky ReLU激活层。

2.1.4 特征重构在G的最后,通过对应元素相乘的方式融合颜色校正图像的特征和原始水下图像的特征,并通过卷积层将融合的特征映射为增强后的水下图像。

2.2 判别器在本算法中,D使用的马尔可夫判别器[14],完全由卷积层构成,输出的是一个n×n矩阵,接着取输出矩阵的均值作为True/False的输出。若输出为True,则代表清晰的水下图像,False则代表生成器G所生成的水下图像。

2.3 损失函数为了保证输入图像与输出图像的相似度,采用损失函数的线性组合,将结构相似性损失值纳入到目标函数中,以提高图像结构相似性。当2张图像趋近相同时,则SSIM的值趋近于1。所以这种类 SSIM 的损失函数可表示为:

| $ {\mathcal{L}}_{SSIM}=1-\frac{1}{m}\sum _{i=1}^{m}SSIM 。$ | (4) |

此外,引入L1损失函数,也被称为最小绝对值偏差,有着很好的鲁棒性,损失函数为:

| $ {\mathcal{L}}^{ı1}\left({\rm X}\right)=\frac{1}{{\rm N}}\sum _{\chi \in {\rm X}}\left|g\left(x\right)-r\left(x\right)\right| 。$ | (5) |

式中:x为X范围内单个像素的坐标,X为输入图像的所有像素的坐标集合,N为输入图像像素数量的总和,g(x)为模型输出的图像坐标x处的像素值,r(x)为真值图像坐标x处的像素值。最后的损失函数可表示为:

| $ L=\alpha \cdot {\mathcal{L}}^{SSIM}+\left(1-\alpha \right)\cdot {\mathcal{L}}^{\mathcal{L}1} 。$ | (5) |

在几次实验和对最佳重建结果的观察后,将

为验证算法的有效性,将本文算法与几种经典的水下图像增强算法进行对比。

3.1 实验设置及数据仿真实验是在i5-11400H处理器,16GB RAM,NVIDIA 3060Ti 8GB显卡配置的计算机上运行。本文选用的水下数据集包含从海洋生物养殖场收集的真实世界水下图像,大致可分为两类,一类包含近场绿色调图像,另一类包含远场场景的蓝绿色调图像。在训练过程中,G和D的优化交替进行。根据 Adam 优化器,学习速率设置为 0.0001,训练过程中生成模型更新一次,判别模型更新5次。

3.1.1 算法有效性验证为了验证本算法的有效性,本文从数据集中选取了部分偏蓝和偏绿程度不同场景不同的图片。将本文所提出的算法与传统算法文献[15]UCM算法、文献[16]UDCP算法和深度学习算法文献[17]UGAN、WGAN[18]算法进行对比。不同方法在数据集上实验结果对比结果如图5所示。

|

图 5 不同方法在数据集上实验结果对比 Fig. 5 Comparison of experimental results of different methods on data sets |

从图5可看出,文献[15]可以增强图像的亮度和对比度,但在颜色恢复方面不太均匀,并且在图像的某些区域似乎过度增强。文献[16]的结果似乎具有合适的色调,但缺乏足够的饱和度和对比度。对于绿色调图像,不能很好地恢复,它们使图像更暗,但增强了图像的对比度。文献[17]和文献[18]可增强图像的对比度,但它们不能很好地恢复颜色并产生一些伪影,从而破坏图像的结构信息。相比之下本文所提出的方法可在保持适当亮度和对比度的同时恢复退化水下图像的颜色。

3.2.2 客观评价为使实验对比的结果更加客观,采用非参考指标UIQM[19]来定量评估数据集上的水下图像质量。UIQM是一种基于人眼视觉系统激励的无参考水下图像质量评价指标,其针对水下图像的退化机理与成像特点,采用色彩测量指标(UICM),清晰度测量指标(UISM),对比度测量指标(UIConM)作为评价依据,将UIQM表示为三者的线性组合。其值越大,表示图像的颜色平衡、清晰度、对比度越佳。表1展示了不同算法处理之后的图像在指标UIQM上的结果。可以看出,在经过本文算法的增强后大部分结果较为优异,与其他4种算法评价指标的平均值对比,UIQM有一定提升,证明了本文算法能够有效地还原图像真实色彩、提高图像对比度和清晰度。

|

|

表 1 不同算法的UIQM评价指标结果对比 Tab.1 Comparison of UIQM evaluation index results of different algorithms |

另外,还选择了全参考评估指标PSNR峰值信噪比和SSIM结构相似性指数进行客观评测。PSNR值取决于原始雾图与生成图像对应像素间的误差,其值越大,恢复得到的无雾图像清晰度越高。SSIM从亮度、对比度、结构3个方面对图像相似性进行评估,其值越大,代表图像失真越小。结果表明,本文提出的算法在峰值信噪比和结构相似性上取得了较好结果。

|

|

表 2 不同算法的PSNR和SSIM结果对比 Tab.2 Comparison of PSNR and SSIM evaluation index results of different algorithms |

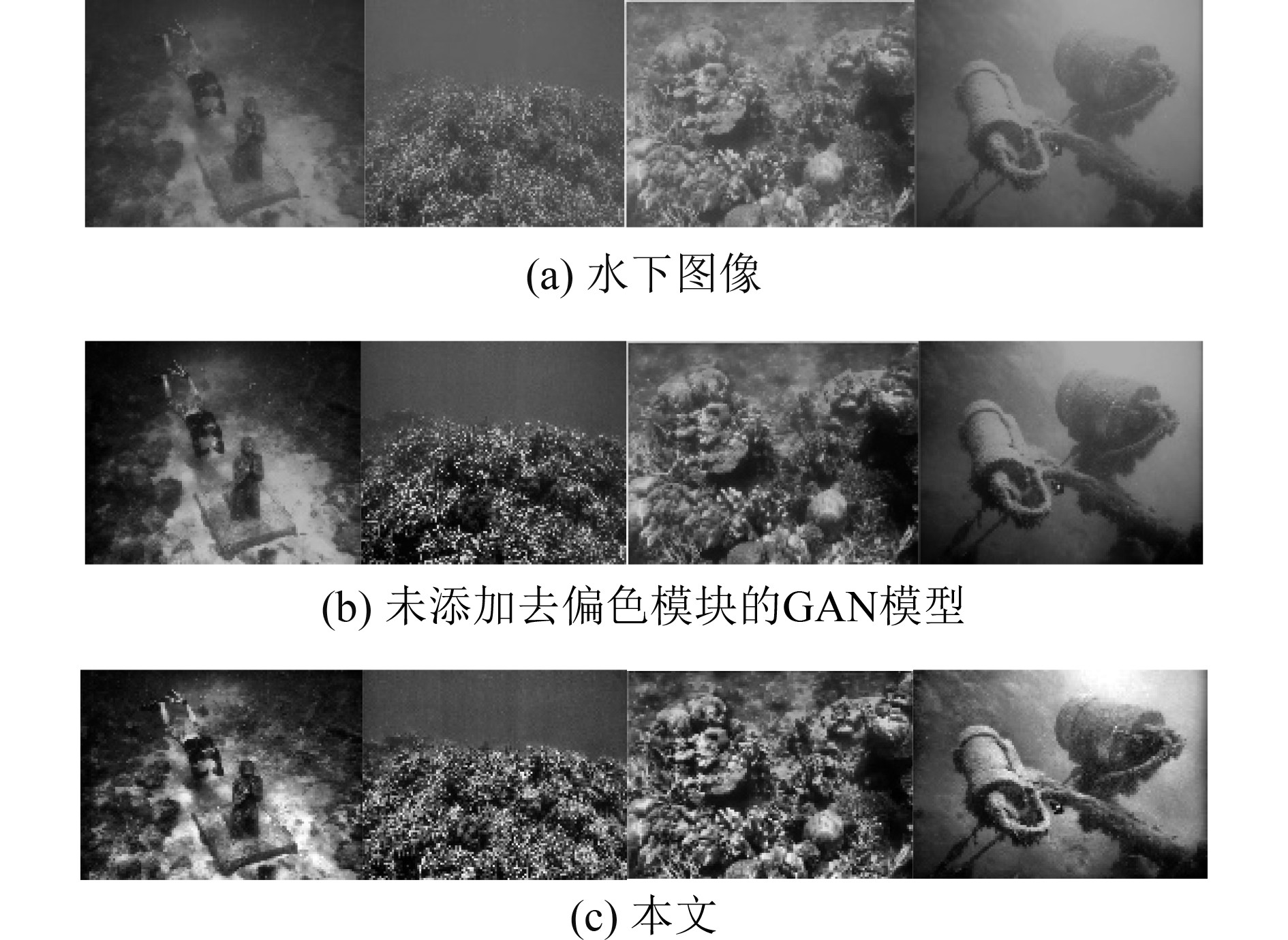

为了更好地验证本文特征融合算法的有效性,分别对本文算法和未采用去偏色模块的GAN模型进行实验对比,结果如图6所示。可以看出,未采用去偏色模块的GAN模型虽大致可矫正退化水下出现的蓝绿色调,但矫正效果欠佳,图像整体视觉感知效果较差。而本文算法采用特征融合,有效提升了模型的性能,使得增强后的图像在清晰度、对比度和颜色矫正方面均表现良好。

|

图 6 未添加去偏色模块的GAN模型与本文算法结果对比 Fig. 6 Comparison between GAN model without adding depigmentation module and the algorithm results in this paper |

针对对水下图像出现的颜色失真和对比度低的问题,本文结合深度学习,提出了一种基于GAN的特征融合图像增强算法。采用U-Net网络结构结合改进的白平衡算法,引入损失函数L-SSIM和L1的线性组合实现水下图像的增强,能够有效地还原图像真实色彩,提升图像的对比度和清晰度。实验结果表明,与不同算法相比,本文算法在UIQM、PSNR和SSIM指标上的平均值为5.071、25.310和0.996,分别比第二名提升了1%、7%和5%。表明本文算法在清晰度、颜色校正和对比度方面均表现良好,能有效增强图像。

| [1] |

徐岩, 孙美双. 基于卷积神经网络的水下图像增强方法[J]. 吉林大学学报(工学版), 2018, 48(6): 1895-1903. DOI:10.13229/j.cnki.jdxbgxb20170815 |

| [2] |

TRUCCO E and OLOOS-ANTILLON A T. Self-tuning underwater image restoration[J]. IEEE Journal of Oceanic Engineering, 2006, 31(2):511−519.

|

| [3] |

BERMAN D, LEVY D, AVIDAN S, et al. Underwater single image color restoration using haze-lines and a new quantitative dataset[J]. IEEE Transactions on Pattern Analysis and Machine Inteelligence, 2022, 43(8): 2822−2837.

|

| [4] |

DENG X, WANG H, LIU X. Underwater Image enhancement based on removing light source color and dehazing[J], IEEE Access, 2019(7):114297−11439.

|

| [5] |

GÜRAKSIN G E, KÖSEU, DEPERLIOĞLU Ö. Underwater image enhancement based on contrast adjustment via differential evolution algorithm[J], 2016 International Symposium on INnovations in Intelligent SysTems and Applications (INISTA), 2016, 1–5

|

| [6] |

代成刚, 林明星, 王震, 等. 基于亮通道色彩补偿与融合的水下图像增强[J]. 光学学报, 2018, 38(11): 86-95. |

| [7] |

WANG Y, ZHANG J, CAO Y., et al, Adeep CNN method for underwater image enhancement[C]//2017 IEEE International Conference on Image Processing (ICIP), 2017, 1382–1386.

|

| [8] |

ISLAM M J, XIA Y, SATTAR J, Fast underwater image enhancement for improved visual perception[J]. IEEE Robotics and Automation Letters, 2022,5(2):3227J. 3234.

|

| [9] |

RONNEBERGER O, FISCHER P, BROX T. U-net: Convolutional networks for biomedical image segmentation[C]//International Conference on Medical image computing and computer-assistedintervention. Springer, Cham, 2015: 234–241.

|

| [10] |

郭继昌, 李重仪, 郭春乐, 等. 水下图像增强和复原方法研究进展[J]. 中国图象图形学报, 2017, 22(3): 273-287. |

| [11] |

BUCHSBAUM G. A spatial processor model for object colour perception[J]. Journal of the Franklin Institute, 1980, 310(1): 1-26. DOI:10.1016/0016-0032(80)90058-7 |

| [12] |

LAND E H. The retinex theory of color vision[J]. Scientific american, 1977, 237(6): 108-129. DOI:10.1038/scientificamerican1277-108 |

| [13] |

ANCUTI C O, ANCUTI C, DE VLEESCHOUWER C, et al. Color balance and fusion for underwater image enhancement[J]. IEEE Transactions on image processing, 2017, 27(1): 379-393. |

| [14] |

ISOLA P, ZHU J Y, ZHOU T, et al. Image-to-image translation with conditional adversarial networks[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2017: 1125–1134.

|

| [15] |

IQBAL K, ODETAYO M, JAMES A, et al. Enhancing the low quality images using unsupervised colour correction method[C]//2010 IEEE International Conference on Systems, Man andCybernetics. IEEE, 2010: 1703–1709.

|

| [16] |

DREWS P, NASCIMENTO E, Moraes F, et al. Transmission estimation in underwater single images[C]//Proceedings of the IEEE international conference on computer vision workshops. 2013: 825–830

|

| [17] |

FABBRI C, ISLAM M J, SATTAR J. Enhancing underwater imagery using generative adversarial networks[C]//2018 IEEE International Conference on Robotics and Automation (ICRA). IEEE, 2018: 7159–7165.

|

| [18] |

ANWAR S, LI C. Diving deeper into underwater image enhancement: A survey[J]. Signal Processing:Image Communication, 2020, 89: 115978. DOI:10.1016/j.image.2020.115978 |

| [19] |

PANETTA K, GAO C, AGAIAN S. Human-visual-system-inspired underwater image quality measures[J]. IEEE Journal of Oceanic Engineering, 2015, 41(3): 541-551. |

2023, Vol. 45

2023, Vol. 45