2. 中国石油大学(华东)海洋与空间信息学院,山东 青岛 266580

2. College of Oceanography and Space Informatics, China University of Petroleum (East China), Qingdao 266580, China

近年来,无人船被广泛用于执行多种军事及非军事任务,代替作业人员执行危险或耗时耗力的任务[1]。为执行水质检测、环境保护和紧急搜救等多样化任务,要求无人船具备在复杂环境下准确检测到前方障碍物的能力。而由于智能船舶功能需求的多样性和水面环境的复杂性,仅依靠单一传感器不能保证信息的准确性和可靠性。

现阶段将多传感器数据融合技术应用于无人船平台已成为研究热点,其中主要有毫米波雷达与视觉系统融合以及激光雷达与视觉系统融合。在毫米波雷达与视觉系统融合方面,Hermann等[2]首先利用视觉系统检测出海天线,通过纵摇和横摇信息过滤船的位置和姿态,并利用视觉系统检测雷达视场之外的障碍物,当目标位于2个传感器重合检测范围内时融合传感器信息。针对内河水域,Cheng等[3]提出了一种新的融合方式,将RGB图像和雷达数据进行多尺度融合,提高了水面小目标检测的精度和鲁棒性。相较于前者,激光雷达与视觉融合系统有着更加精确的检测性能。Zhang等[4]利用激光雷达筛选可疑目标,然后通过SVM分类器对船只进行图像识别,最后通过交叉验证的方法确定目标船只所在位置。Liu等[5]提出了一种应用于无人船避碰检测的多模态传感器系统,首先利用深度学习对激光雷达和相机进行在线校准,将RGB图像与点云数据相融合,能够准确检测三维目标。除此之外,还有学者将航海雷达用于融合,获取远距离障碍物的信息。Liu等[6]将交互多模型卡尔曼滤波器(IMMKF)与双阶段模糊逻辑数据关联方法相结合,分别对多目标的进行检测、跟踪,然后通过计算AIS与航海雷达航迹的隶属度完成航迹关联,最后得到更加准确的目标航迹信息。Chen等[7]将航海雷达与立体视觉的目标通过加权ELM训练的二元分类器进行相互验证,并首次解决了立体视觉和航海雷达在世界参考系下的融合问题,结果显示该方法对1km范围内的障碍物具有比较好的检测效果。

上述方法主要依靠2种传感器融合检测,且现阶段应用于无人船的三传感器融合检测方法较少,而对毫米波雷达、激光雷达与视觉系统进行融合,可以将各传感器的性能优势互补,达到检测准确度高和检测障碍物信息丰富等效果。本文提出一种基于毫米波雷达、激光雷达与视觉传感器的决策级数据融合方法,考虑不同传感器对不同距离及不同尺寸障碍物的检测效果存在差异,利用证据理论对各传感器检测信任度进行融合,有效降低了各传感器的虚警率及漏检率,提高了融合系统的鲁棒性。

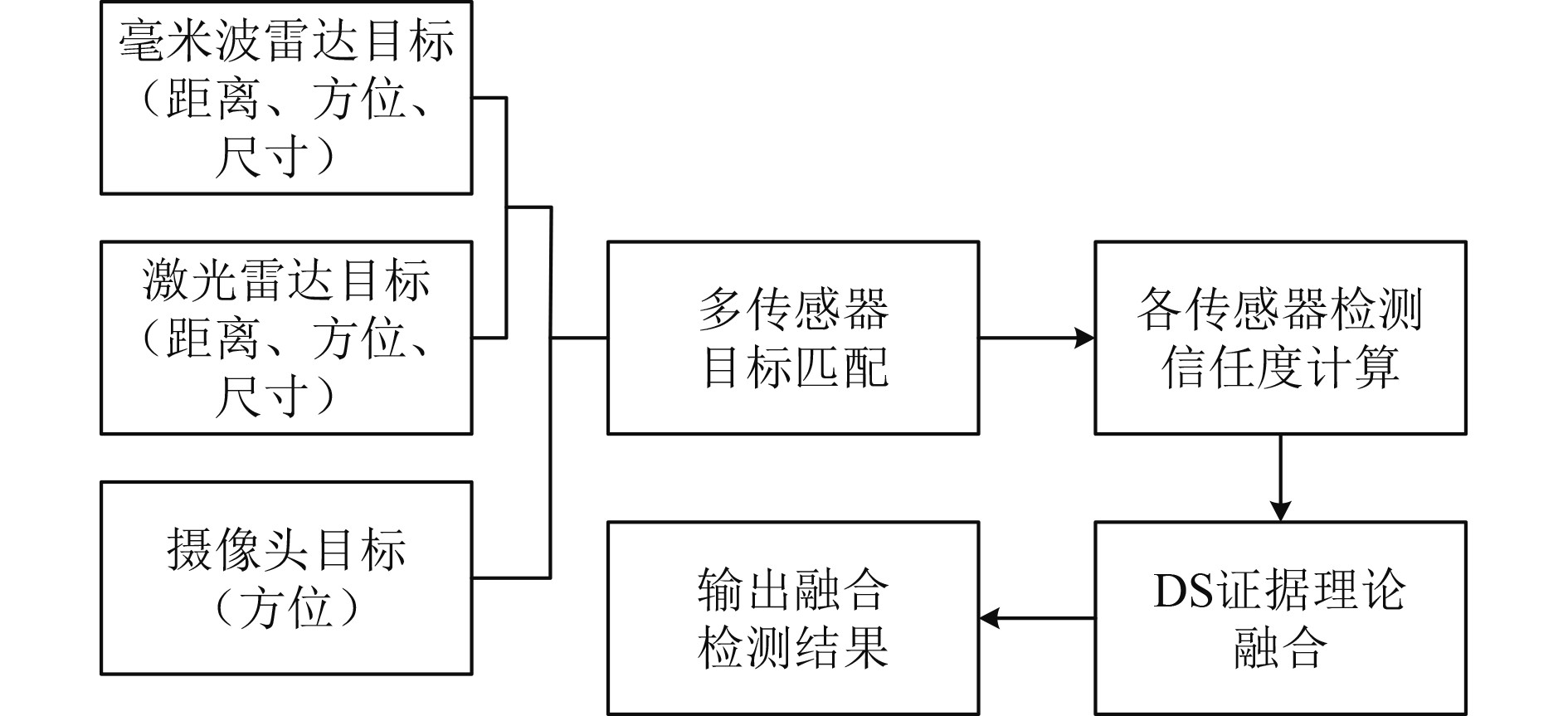

1 多传感器障碍物融合检测方法图1为本文多传感器融合检测方法流程图。首先,通过串联式的目标匹配方法,找出各传感器检测结果中同属于一个目标的数据信息;其次,利用目标距离及尺寸因子计算各传感器的检测信任度,并通过证据理论对各传感器检测信任度进行融合。最后,筛选出真实存在的目标,输出融合检测结果。

|

图 1 多传感器融合检测方法流程图 Fig. 1 Flow chart of multi-sensor fusion detection method |

通过相关聚类算法能够得到毫米波雷达与激光雷达的目标数据,包括毫米波雷达目标距离

|

图 2 多传感器目标匹配流程图 Fig. 2 Flow chart of multi-sensor target matching |

为了找到同一时刻下

| $ \begin{aligned} dif(ij) = &{\omega _{{d}}}\frac{{{d_{{R}}}(i) - {d_{{L}}}(j)}}{{{\mu _{{d}}}}} + {\omega _{{a}}}\frac{{{a_{{R}}}(i) - {a_{{L}}}(j)}}{{{\mu _{{a}}}}} + \\& {\omega _{{s}}}\frac{{\sqrt {{{({l_{{R}}}(i) - {l_{{L}}}(j))}^2} + {{({w_{{R}}}(i) - {w_{{L}}}(j))}^2}} }}{{{\mu _{{s}}}}},\\ \end{aligned} $ | (1) |

式中:

| $ {{\boldsymbol{S}}_{{{RL}}}} = {\boldsymbol{I}} - {{\boldsymbol{D}}_{{{RL}}}} = {\left[ {\begin{array}{*{20}{c}} {1 - di{f_{11}}}& \cdots &{1 - di{f_{1n}}} \\ \vdots & \ddots & \vdots \\ {1 - di{f_{m1}}}& \cdots &{1 - di{f_{mn}}} \end{array}} \right]_{m\times n}} 。$ | (2) |

通过用于求解任务分配的匈牙利算法[8]完成对目标相似度矩阵

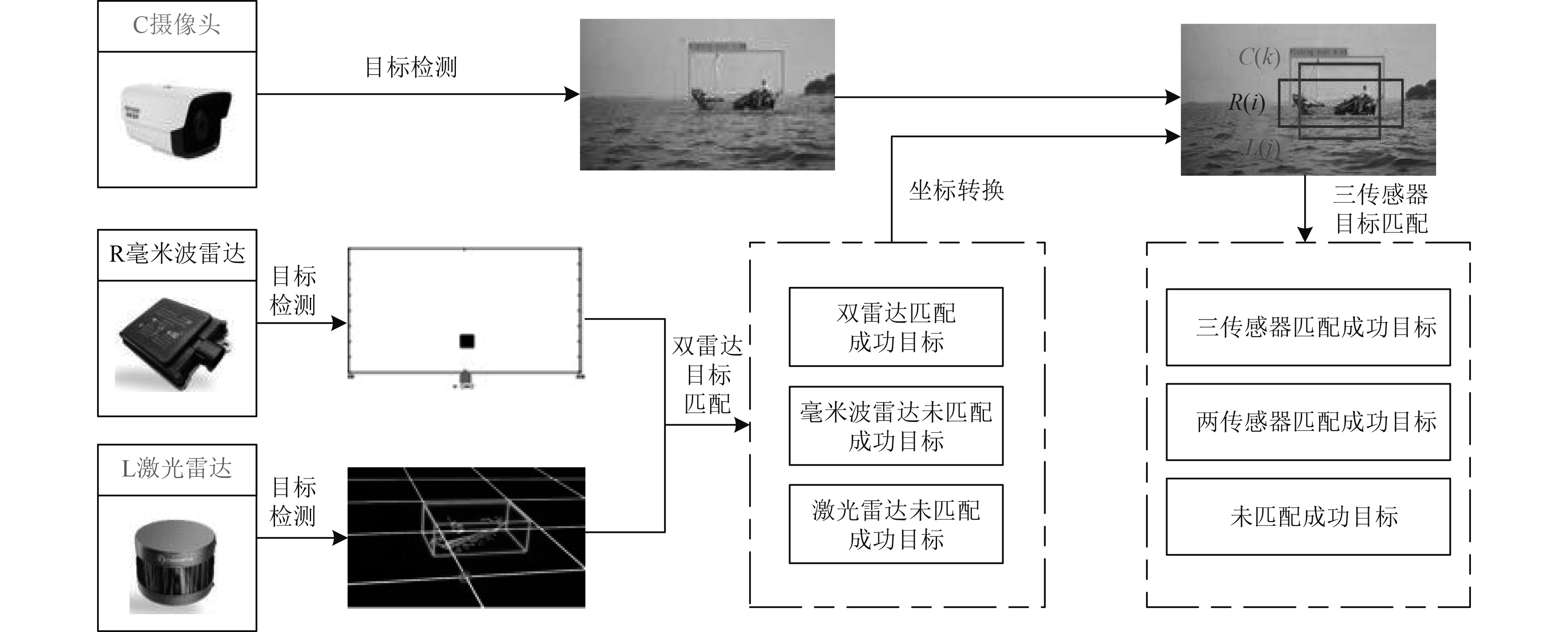

相较于毫米波雷达与激光雷达,摄像头对船舶、浮漂等水面障碍物有较强的分辨能力。采用Yolov3算法实现基于摄像头的目标检测。但是单目摄像头无法准确获取目标距离信息,仅依靠目标方位信息无法与双雷达目标进行准确匹配,所以需要通过式(3)将双雷达目标从雷达坐标系转换到像素坐标系中。同时毫米波雷达无法获取障碍物的高度信息,根据普通船舶长高比5∶1,此处设置毫米波雷达目标高度

| $\begin{split} {Z_C} =& \left[ {\begin{array}{*{20}{c}} u \\ v \\ 1 \end{array}} \right] = \left[ {\begin{array}{*{20}{c}} {\dfrac{1}{{{\text{d}}x}}}&0&0 \\ 0&{\dfrac{1}{{{\text{d}}y}}}&0 \\ 0&0&1 \end{array}} \right]\left[ {\begin{array}{*{20}{c}} f&0&0&0 \\ 0&f&0&0 \\ 0&0&1&0 \end{array}} \right]\times\\ & \left[ {\begin{array}{*{20}{c}} {\boldsymbol{R}}&{\boldsymbol{T}} \\ {\vec 0}&1 \end{array}} \right]\left[ {\begin{array}{*{20}{c}} {{X_{\text{W}}}} \\ {{Y_{\text{W}}}} \\ {{Z_{\text{W}}}} \\ 1 \end{array}} \right] = \left[ {\begin{array}{*{20}{c}} {{f_x}}&0&{{u_0}}&0 \\ 0&{{f_y}}&{{v_0}}&0 \\ 0&0&1&0 \end{array}} \right]\times\\ & \left[ {\begin{array}{*{20}{c}} {\boldsymbol{R}}&{\boldsymbol{T}} \\ {\vec 0}&1 \end{array}} \right]\left[ {\begin{array}{*{20}{c}} {{X_{\text{W}}}} \\ {{Y_{\text{W}}}} \\ {{Z_{\text{W}}}} \\ 1 \end{array}} \right] 。\end{split}$ | (3) |

式中:

通过计算摄像头目标与经过坐标转换之后的双雷达目标之间的广义交并比

通过上述过程,最终可得到3类目标匹配结果,分别为三传感器匹配成功目标,两传感器匹配成功目标和未匹配成功目标。

1.2 多传感器单帧融合检测 1.2.1 各传感器检测信任度不同传感器对不同距离及不同尺寸的障碍物的检测准确率是不同的。根据毫米波雷达检测原理、性能以及实测数据分析,当障碍物尺寸越小或者障碍物距离越远时,毫米波雷达的检测准确性逐渐降低,且满足一种非线性关系。由此,制定毫米波雷达检测信任度计算公式如下:

| $\begin{aligned} & {S_{{R}}} = \left[ {1 - \log (1 + \frac{{{d_{{R}}}}}{{\lambda _{{R}}^{{d}}}})} \right]\times{{f}}_{{R}}^{{d}} + \frac{{{l_{{R}}}}}{{\lambda _{{R}}^{{l}}}}\times{{f}}_{{R}}^{{l}} {,} \lambda _{{R}}^{{d}} = 90,\\ & \lambda _{{R}}^{{l}} = \left\{ {\begin{array}{*{20}{c}} {12,}&{3 \leqslant {l_R} < 12} ,\\ {{l_R}}&{{l_R} \geqslant 20} 。\end{array}} \right. \end{aligned}$ | (4) |

式中:

激光雷达对于60 m范围内的障碍物有较高的检测准确率,但是当障碍物超过60 m范围后,会出现较高的漏检率。根据实测数据分析,制定激光雷达检测信任度计算公式如下:

| $ {S_{{L}}} = \alpha \times{f}_{{L}}^{{d}} + \frac{{{l_{{L}}}\times{w_{{L}}}}}{{\lambda _{{L}}^{{s}}}}\times{f}_{{L}}^{{s}}。$ | (5) |

式中:

| $ \lambda _{{L}}^{{s}} = \left\{ {\begin{array}{*{20}{c}} {20,}&{0 < {s_{{L}}} \leqslant 12} ,\\ {25,}&{12 < {s_{{L}}} \leqslant 25} ,\\ {{l_{{L}}}\cdot {w_{{L}}}}&{{s_{{L}}} > 25} 。\end{array}} \right. $ | (6) |

| $ \alpha = \left\{ {\begin{array}{*{20}{c}} {1 - \dfrac{{0.01\times {d_{{L}}}}}{6},}&{0 < {d_{{L}}} \leqslant 30},\\ {1 - \dfrac{{0.01\times {d_{{L}}}}}{4},}&{30 < {d_{{L}}} \leqslant 60} ,\\ {1 - \dfrac{{0.01\times {d_{{L}}}}}{2},}&{60 < {d_{{L}}} \leqslant 90} 。\end{array}} \right. $ | (7) |

摄像头通过Yolov3算法检测海面障碍物,可满足无人船实时检测海上障碍物及自主避障需求,同时该算法还可以提供障碍物检测结果的信任度。

由于各传感器均存在漏检的可能性,即当某个传感器没有检测到目标时,不能认为目标是确定不存在的。所以根据实测数据并结合各传感器的检测性能,对只有两传感器匹配成功和未匹配成功的目标分配未与之匹配传感器的最小检测信任度。

1.2.2 DS证据理论融合DS证据理论[10]是一种不精确推理理论,具有处理不确定信息的能力,现阶段广泛应用多传感器数据融合领域。在DS证据理论中,令

| $ m(A) = \frac{{\displaystyle\sum\limits_{{A_1} \cap {A_2} \cap \cdots \cap {A_n} = A} {{m_1}({A_1}){m_2}({A_2}) \cdots {m_n}({A_n})} }}{{1 - K}} 。$ | (8) |

式中,K为mass函数的冲突项,定义为:

| $ K = \sum\limits_{{A_1} \cap {A_2} \cap \cdots \cap {A_n} = \emptyset } {{m_1}({A_1}){m_2}({A_2}) \cdots {m_n}({A_n})}。$ | (9) |

将3种传感器的目标检测信任度作为基本赋值函数,并利用Dempster组合规则对其进行融合,从而得到目标融合检测信任度。若其大于设定的阈值

| $ F(d,a,l,w) = \frac{{{S_{{R}}}}}{{{S_{{R}}} + {S_{{L}}}}}\times R(d,a,l,w) + \frac{{{S_{{L}}}}}{{{S_{R} } + {S_{{L}}}}}\times L(d,a,l,w)。$ | (10) |

为了验证本文多传感器融合检测方法的有效性,通过实船试验,分别采集不同场景下毫米波雷达、激光雷达与摄像头的试验数据,采用本文多方法对试验数据进行处理,并与各单传感器检测结果进行比较与分析。

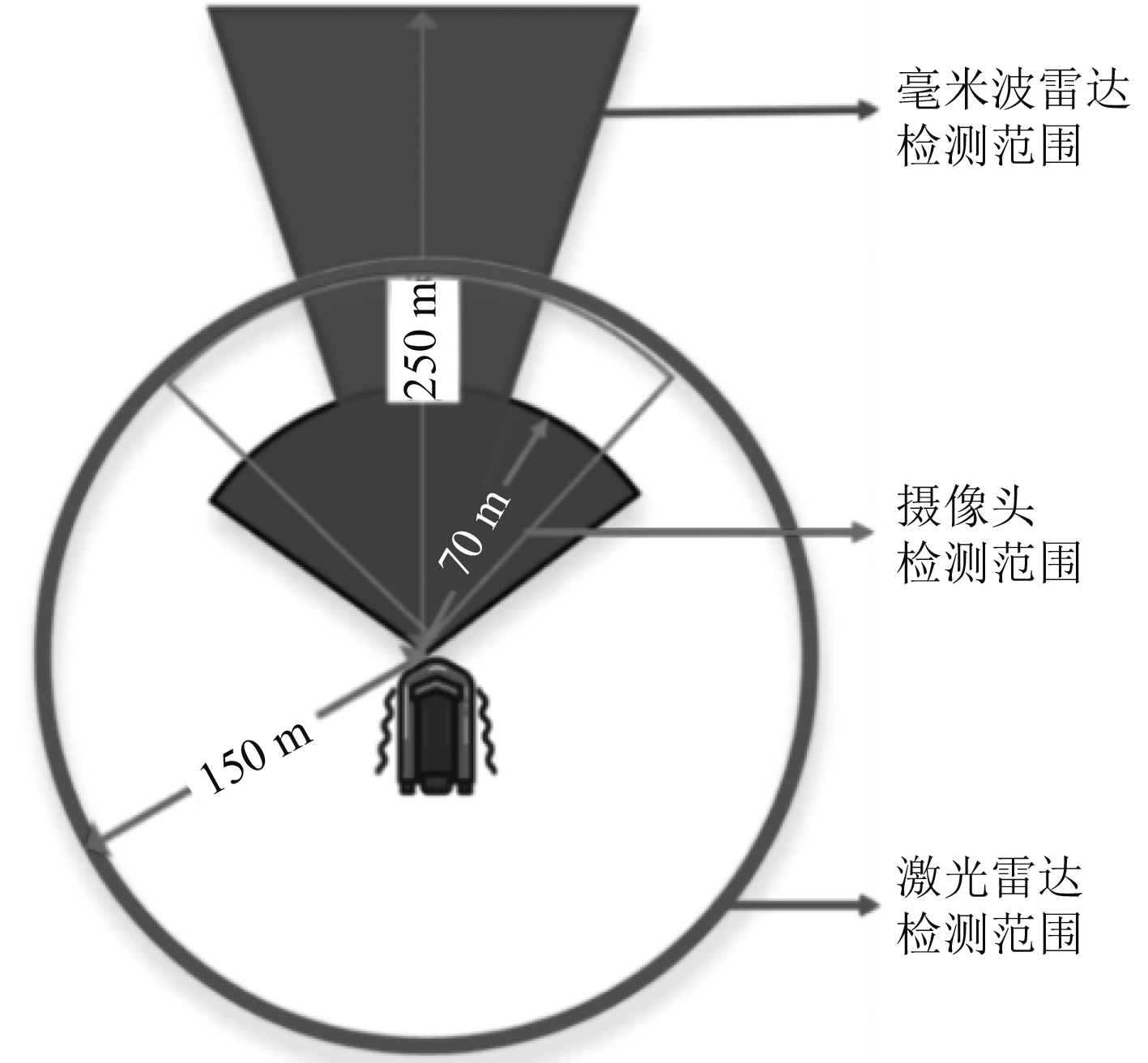

2.1 试验设备及过程试验平台为1.7米级无人船,同时搭载毫米波雷达、激光雷达和摄像头3种障碍物检测设备,其各项性能参数说明如表1所示。各传感器在无人船上的安装位置及检测范围如图3所示。

|

|

表 1 各传感器性能参数 Tab.1 Performance parameters of each sensor |

共选取3种试验场景,包括近距离单目标、远距离单目标和多目标场景。同时为保证试验数据的可靠性,试验过程中无人船保持相对静止状态,以获取试验数据。

|

图 3 各传感器检测范围示意图 Fig. 3 Schematic diagram of detection range of each sensor |

场景1:被测目标为无人船前方的一艘匀速行驶的渔船,该渔船从距离无人船约16 m处运动到距无人船35 m处,共用时20 s。

场景2:被测目标同样为无人船前方的一艘匀速行驶的渔船,该渔船从距离无人船约70 m处运动到距无人船100 m处,共用时12 s。

场景3:被测目标分别为两艘渔船和一个浮标,其中左侧1号渔船从无人船左前方约70 m处运动至无人船右前方约65 m处,右侧2号渔船从无人船右前方约60 m处依次运动至无人船正前方约50 m处和右前方40 m处,而浮标位于无人船正前方约30 m处。期间共用时15 s。

2.2 试验结果分析首先对涉及的各个阈值参数进行设定,

在获取各场景中目标的毫米波雷达与激光雷达原始数据后,分别用变尺寸栅格地图法和基于欧氏距离的点迹凝聚方法[11]对其进行聚类处理,同时利用Yolov3算法对摄像头的视频图像进行障碍物检测。表2为各传感器最小检测信任度分配结果。

|

|

表 2 各传感器最小检测信任度分配结果 Tab.2 The minimum confidence distribution results of each sensor |

利用本文方法对3个场景中不同目标的运动过程进行融合检测。结果显示,在渔船运动过程中,各传感器均能有效检测到目标,但受环境因素及自身检测性能影响,均存在着不同程度的虚警及漏检现象。

在场景1中,毫米波雷达、激光雷达与摄像头均能有效检测到目标,但是受到海面晃动及海杂波等影响,毫米波雷达和激光雷达分别出现4次和5次虚警,各出现1次漏检。通过本文方法融合检测结果可以看出,该方法能够显著降低障碍物位于近距离处时各传感器的虚警率和漏检率。

在场景2中,受传感器自身检测性能等因素影响,各传感器的检测准确率都有所下降,其中激光雷达的漏检次数大幅增加,但本方法仍能较为准确的判断目标是否真实存在。

在场景3中,激光雷达对于小型浮标和距离无人船60 m之外渔船的漏检次数及毫米波雷达的虚警次数均较高,且受逆光环境影响,摄像头在检测过程中也出现了较多的漏检现象。但根据本文所提方法的融合检测结果显示,本方法能正确将虚假目标剔除,且有效降低激光雷达和摄像头的漏检次数,提高障碍物检测准确度。具体检测结果如图3所示。

|

图 4 检测结果 Fig. 4 The detection results |

表3为3个场景中各单传感器和通过本文多传感器融合方法检测后的虚警率(FAR)和漏检率(MDR)。其中FAR是错误检测为障碍物的点迹数与总点迹数的比值,MDR为未检测到的点迹数与总点迹数的比值。

|

|

表 3 多传感器融合检测结果 Tab.3 Multi-sensor fusion detection results |

可以看出,本文方法相较于其他单传感器均有着较小的虚警率和漏检率,且在不同场景下都有着较可靠的检测性能。

由于当障碍物距离无人船接近100 m时,受激光雷达自身检测性能限制,导致漏检次数增加,而本文方法对于2个场景中双雷达出现虚警情况的改善效果显著。

当毫米波雷达或激光雷达出现虚警时,通过本文方法仍能够对虚假目标进行剔除,并得到真实目标融合检测结果。

3 结 语本文提出一种基于目标距离及尺寸的多传感器融合检测方法。首先对各传感器的目标进行匹配,并根据不同传感器对不同距离和不同尺寸障碍物的检测准确率不同的特点,设置各传感器的检测信任度函数,并利用DS证据理论进行融合决策。通过3种海上试验场景对本文方法的有效性进行验证,结果表明通过本文方法,可以显著降低各单传感器对于不同距离处目标的虚警率和漏检率,有效提高无人船障碍物检测能力,验证了本文方法的有效性。

| [1] |

朱健楠, 虞梦苓, 杨益新. 无人水面艇感知技术发展综述[J]. 哈尔滨工程大学学报, 2020, 41(10): 1486-1492. |

| [2] |

HERMANN D, GALEAZZI R, ANDERSEN J C, et al. Smart sensor based obstacle detection for high-speed unmanned surface vehicle[J]. IFAC-Papers Online, 2015, 48(16): 190-197. DOI:10.1016/j.ifacol.2015.10.279 |

| [3] |

CHENG Y W, XU H and LIU Y M. Robust small object detection on the water surface through fusion of camera and millimeter wave radar[C]//2021 IEEE/CVF International Conference on Computer Vision (ICCV). Montreal, QC, Canada: IEEE, 2021: 15243–15252.

|

| [4] |

ZHANG X L, WANG H S, CHENG W D. Vessel detection and classification fusing radar and vision data[C]//7th International Conference on Information Science and Technology (ICIST), Da Nang, VIETNAM: IEEE, 2017: 474–479.

|

| [5] |

LIU H, NIE J, LIU Y J, et al. A multi-modality sensor system for unmanned surface vehicle[J]. Neural Processing Letters, 2020, 52(2): 977-992. DOI:10.1007/s11063-019-09998-4 |

| [6] |

LIU W W, LIU Y C, GUNAWAN B A, et al. Practical moving target detection in maritime environments using fuzzy multi-sensor data fusion[J]. International Journal of Fuzzy Systems, 2020: 1–19.

|

| [7] |

CHEN J Y, WANG H A. Obstacle detection method for usv by fusing of radar and motion stereo[C]//2020 IEEE 16th International Conference on Control & Automation (ICCA). Singapore: IEEE, 2020: 159–164.

|

| [8] |

柳毅, 佟明安. 匈牙利算法在多目标分配中的应用[J]. 火力与指挥控制, 2002, 27(4): 34–37.

|

| [9] |

张翠文, 张长伦, 何强, 等. 目标检测中框回归损失函数的研究[J]. 计算机工程与应用, 2021, 57(20): 97−103.

|

| [10] |

韩德强, 杨艺, 韩崇昭. DS证据理论研究进展及相关问题探讨[J]. 控制与决策, 2014, 29(01): 1−11.

|

| [11] |

李瑞伟, 李立刚, 金久才, 等. 基于欧氏距离的无人艇载毫米波雷达点迹凝聚方法[J]. 水下无人系统学报, 2020, 28(6): 604−610.

|

2023, Vol. 45

2023, Vol. 45