大型船舶识别是海上监测的主要内容之一,对于海域管理与船舶管理具有重要意义[1]。而图像融合是图像识别的重要环节,高质量的图像融合能够显著提升船舶识别的准确性[2],因此研究船舶图像对于海域管理与船舶管理具有重要意义。贺欣等[3]采用基于ResNet的方法进行图像融合处理,但大型船舶航行过程中外界环境的复杂性导致该方法的实际融合效果较差。蒋一纯等[4]基于图像退化模型实现图像融合目的,但该方法应用过程较为复杂,实时性能较差。罗迪等[5]利用生成对抗网络融合图像,但该方法融合后的图像存在显著细节信息丢失问题。因此研究基于视觉传达的大型船舶航行图像融合方法,为海域管理等研究提供新的方向。

1 大型船舶航行图像融合方法 1.1 基于视觉传达的大型船舶航行图像去模糊处理针对大型船舶航行图像

| $ \mathop {\min }\limits_{x,k} \lambda \left\| {x \otimes k - y} \right\|_2^2 + \frac{{{{\left\| x \right\|}_1}}}{{{{\left\| x \right\|}_2}}} + \beta {\left\| k \right\|_1}。$ | (1) |

式中:

式(1)中第一个“+”前部分为保真项,第一个“+”与第二个“+”后部分分别为关于x和关于k的正则项,前者的主要目的是在大型船舶航行图像重建过程中提升尺度不变的稀疏性,后者的主要目的是降低

式(1)可由初始

| $ \mathop {\min }\limits_f \frac{\;1\;}{\;2\;}\left\| {f \otimes k - g} \right\|_2^2 + \phi TV\left( f \right)。$ | (2) |

式中:

利用快速总变分图像复原算法对式(2)进行求解,该算法在求解过程中具有运算效率高以及对模糊核较差误差具备较强鲁棒性的优势[7],由此能够获取较高质量的去模糊大型船舶航行图像。

1.2 基于视觉传达的大型船舶航行图像亮度调整对大型船舶航行图像进行去模糊处理后,通常会使航行图像的亮度发生变化,为了校正去模糊后航行图像的亮度,采用伽马校正算法对其进行校正。该算法经由调整参数

| $ T\left( l \right) = {l_{\max }}{\left( {\dfrac{l}{{{l_{\max }}}}} \right)^\gamma }。$ | (3) |

式中:T(l)和

在

针对2幅去模糊与亮度调整后的航行图像,可通过以下过程进行图像融合处理:

步骤1 确定2幅航行图像的熵值,对比2幅图像熵值结果,以A图像和B图像分别描述熵值较大的图像和熵值较小的图像。通过基于二维局部均值分解算法获取A图像的残余分量,令其同B图像具有显著相关性。

步骤2 通过基于方向滤波的二维局部均值分解法分解A图像残余分量与B图像的频率,得到高频方向子带与低频子带。

步骤3 分别对高频子带与低频子带进行融合,由此获取高频系数与低频系数。

步骤4 基于所获取的高频系数与低频系数,通过基于方向滤波的二维局部均值分解法的逆运算实施变化,将逆变换所获取的结果与步骤1中A图像提取残余分量后剩余的部分结合,即可获取融合后的大型船舶航行图像。

1.3.1 高频系数计算大型船舶航行图像的高频部分包含图像的主要特征与细节信息,为保障这些特征与信息不丢失,可选取基于多判据的高频系数融合标准,经由比较区域能量与区域清晰度的不同获取航行图像融合过程中的高频系数。

1)基于区域能量不同的融合标准

R1表示区域能量的对比差异,利用式(4)确定R1:

| $ {R_1}\left( {x,y} \right) = \dfrac{{\dfrac{{{E_A}\left( {x,y} \right)}}{{{E_A}}}}}{{\dfrac{{{E_B}\left( {x,y} \right)}}{{{E_B}}}}}。$ | (4) |

式中:EA(x,y)和EB(x,y)均表示高频系数的区域能量,EA和EB分别表示对应窗口A图像与B图像的能量和。

若R1(x,y)>1,则说明A图像的区域能量对插差异值高于B图像,因此可选择A图像高频系数;相反选择B图像的高频系数。

2)基于区域清晰度差异的融合标准

R2表示区域清晰度对比差异,利用下式确定:

| $ {R_2}\left( {x,y} \right) = \dfrac{{\dfrac{{{C_A}\left( {x,y} \right)}}{{{C_A}}}}}{{\dfrac{{{C_B}\left( {x,y} \right)}}{{{C_B}}}}} 。$ | (5) |

式中:CA(x,y)和CB(x,y)均表示高频系数的区域清晰度,CA和CB分别表示对应窗口A图像与B图像的清晰度和。

若R2(x,y)>1,则说明A图像的区域清晰度对比差异值高于B图像,则选取A图像的高频系数;相反选取B图像的高频系数。

基于以上计算结果,依照R(x,y)获取最终的高频系数为:

| $ R\left( {x,y} \right) = \max \left[ {{R_1}\left( {x,y} \right),{R_2}\left( {x,y} \right)} \right]。$ | (6) |

即最终的高频系数R(x,y)为R1(x,y)与R2(x,y)中的较大值。

1.3.2 低频系数计算大型船舶航行图像的低频部分中包含其主要能量,可通过自适应加权平均法对图像低频系数进行融合,公式为:

| $ {C_F}\left( {i,j} \right) = {\eta _\xi }\left( {i,j} \right){C_A}\left( {i,j} \right) + {\eta _\psi }\left( {i,j} \right){C_B}\left( {i,j} \right) 。$ | (7) |

式中:CF(i, j)表示低频系数融合结果,

式(7)中的里隶属度可通过高斯隶属度函数确定,公式为:

| $ \left\{ \begin{gathered} {\eta _\xi }\left( {i,j} \right) = \exp \left[ { - \frac{{{{\left( {{C_B}\left( {i,j} \right) - \mu } \right)}^2}}}{{2{{\left( {k\sigma } \right)}^2}}}} \right] ,\\ {\eta _\psi }\left( {i,j} \right) = 1 - {\eta _\xi }\left( {i,j} \right)。\\ \end{gathered} \right. $ | (8) |

式中:

本文研究基于视觉传达的大型船舶航行图像融合方法,为验证本文方法的实际应用性能,以某数据库中的船舶航行图像数据集为研究对象,研究对象中包含不同大型船舶在不同海洋环境与空气环境下以及不同成像区域、成像距离、成像时间成像角度下所采集的航行图像。采用本文方法对研究对象中的航行图像进行融合测试。

2.1 图像视觉传达处理效果分析 2.1.1 直观效果分析在研究对象中随机选取一艘大型船舶航行图像(见图1),采用本文方法对其进行去模糊处理与亮度调整,结果如图2和图3所示。可知,采用本文方法对所选图像进行去模糊处理后,与初始图像相比,图像的内容更为全面,细节更为清晰。采用本文方法进行亮度调整后,图像的亮度也显著提升,进一步提升了目标细节度。由此说明采用本文方法对能够有效提升大型船舶航行图像的细节清晰度,令图像的视觉传达效果增强。

|

图 1 原始图像 Fig. 1 Original image |

|

图 2 去模糊处理后图像 Fig. 2 Image after deblurring processing |

|

图 3 亮度调整后图像 Fig. 3 Image after brightness adjustment |

为客观分析本文方法对大型船舶航行图像的视觉增强效果,在图1的基础上,另外选择2幅图像进行去模糊与亮度调整处理。选取标准偏差(用于分析图像对比度,其值越大图像对比度越大)、峰值信噪比(用于分析图像的保真性,其值越大图像失真越小)和信息熵(用于分析图像信息量,其值越大图像中细节信息量越大)3个评价指标对本文方法的视觉传达处理效果实施客观评价,结果如表1所示。可知,采用本文方法对研究对象实施视觉增强处理后,航行图像的标准差提升24.5%以上,峰值信噪比提升18.3%以上,信息熵提升5.4%以上。由此说明本文方法能够显著提升大型船舶航行图像的视觉传达效果。

|

|

表 1 图像视觉传达增强效果分析 Tab.1 Analysis of image visual communicationenhancement effect |

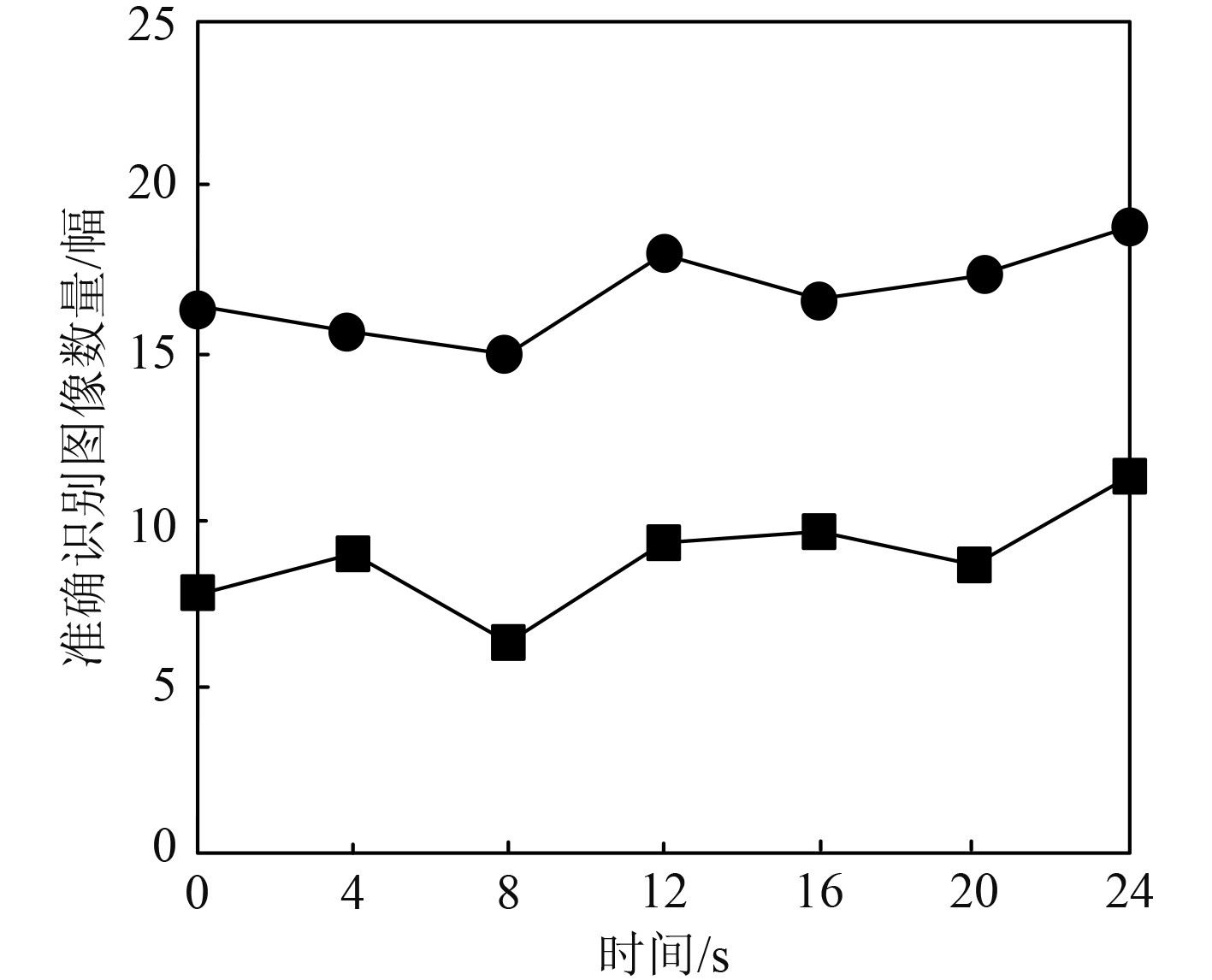

图像融合是图像识别的关键环节,高质量的图像融合能够显著提升图像识别精度。采用本文方法对大型船舶航行图像实施融合处理,为验证本文方法的图像融合性能,对比基于采用本文方法融合图像前后的船舶图像识别性能,结果如图4所示。可知,采用本文方法对图像融合处理后,能够显著提升图像识别的准确度,由此说明本文方法具有较高的图像融合效果。

|

图 4 船舶图像识别性能 Fig. 4 Performance of ship image recognition |

本文研究基于视觉传达的大型船舶航行图像融合方法,通过去模糊处理与亮度调整提升大型船舶航行图像的视觉传达效果。在此基础上,通过基于方向滤波的二维局部均值分解法实现图像融合。实验结果显示,本文方法能够较好地增强视觉效果,基于本文方法融合后的图像进行图像识别,准确率显著提升。

| [1] |

徐志京, 黄海. 基于多重连接特征金字塔的SAR图像船舶目标检测[J]. 激光与光电子学进展, 2021, 58(8): 287-294. |

| [2] |

刘万军, 高健康, 曲海成, 等. 多尺度特征增强的遥感图像船舶目标检测[J]. 自然资源遥感, 2021, 33(3): 97-106. |

| [3] |

贺欣, 周建, 张华. 基于ResNet的红外与低照度可见光图像融合方法[J]. 激光与红外, 2022, 52(11): 1723-1728. |

| [4] |

蒋一纯, 刘云清, 詹伟达, 等. 基于图像退化模型的红外与可见光图像融合方法[J]. 电子与信息学报, 2022, 44(12): 4405-4415. |

| [5] |

罗迪, 王从庆, 周勇军. 一种基于生成对抗网络与注意力机制的可见光和红外图像融合方法[J]. 红外技术, 2021, 43(6): 566-574. |

| [6] |

张浩, 马佳义, 樊凡, 等. 基于特征空间多分类对抗机制的红外与可见光图像融合[J]. 计算机研究与发展, 2023, 60(3): 690-704. |

| [7] |

雷大江, 杜加浩, 张莉萍, 等. 联合多流融合和多尺度学习的卷积神经网络遥感图像融合方法[J]. 电子与信息学报, 2022, 44(1): 237-244. |

2023, Vol. 45

2023, Vol. 45