2. 重庆邮电大学 通信与信息工程学院,重庆 400065

2. Institute of Communication and Information Engineering, Chongqing University of Posts and Telecommunications, Chongqing 400065, China

基于LBT(Listen before Talk, LBT)机制的LAA(Licensed Assisted Access,LAA)或者MultiFire[1]可使LTE工作在免授权频段上。一个LAA节点使用LTE-A(LTE-Advanced)载波聚合的特性可使LTE同时工作在授权和免授权频段。LAA(3GPP Rel.13[2])专注于DL数据传输的操作规范,而eLAA和MulteFire(3GPP Rel.14[3])规定了UL和DL2种传输方式的操作规范。

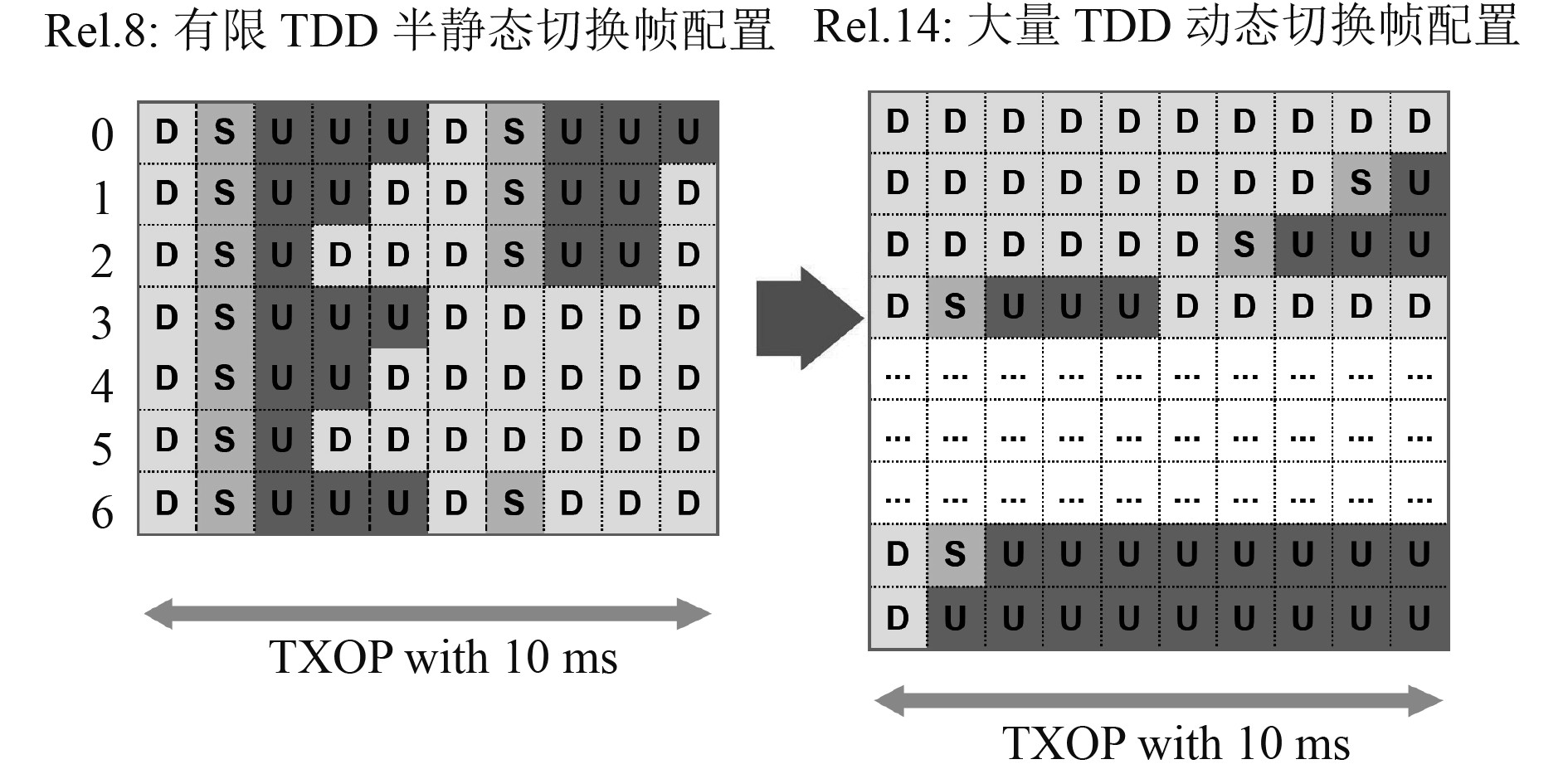

LTE-TDD模式中,每1个无线帧的长度共计10 ms,由10个1 ms的子帧组成。在新发布的type-3结构中[1],除第一个子帧为DL帧以外,其他位置的子帧可任意组合,不再局限于传统LTE中的7种固定配置,如图1所示。eLAA节点使用免授权频谱资源服务其用户,因而需要与免授权频段中的其他用户,如WiFi等进行竞争。当邻近节点占用信道时,WiFi设备不得不执行退避程序,进而导致时延过长。另外,在竞争的过程中,帧配置不当可能导致基站及其用户设备eUES(User Equipments,eUEs)接入信道过程产生冲突,进而导致丢包等情况发生。然而,若帧配置合理,WiFi在接入信道时会节省不必要的退避时间,减低时延,到达“即来即用”的效果。同时也很大程度减少了用户碰撞的概率,因此合理灵活的帧配置在实际应用中十分有必要。

|

图 1 帧配置 Fig. 1 Message configuration |

文献[4-6]提出了自适应TDD机制,并使用可能的框架结构来减少传输冲突。然而这些传输机制没有利用新引入的UL/DL灵活配置的帧结构type-3,也没有考虑由于WiFi的存在导致的冲突。文献[7]在认知无线电领域使用局部利他博弈,通过合理地分配使用时间,减少争用期,达到降低碰撞概率的目的。文献[8]通过使用局部利他博弈实现了分布式和集中式2种算法分配时间,同时使用最新的type-3进行帧配置。然而这些算法没有考虑到实际使用过程DL数据远多于UL数据的情况,单纯追求接入概率而不考虑公平性并不符合实际。文献[9]通过QL算法实现了femtocell网络中多智能体分布式学习帧配置,达到了降低干扰,满足不对称流量的目的。文献[10]提出了基于QL的动态帧选择方法,该方法根据WiFi的负载来适应帧结构和传输功率,但该方法并没有利用新引入的UL/DL灵活配置的帧结构type-3,并且未考虑到上下行流量不对称的问题。文献[11]为了实现超可靠低延迟通信(ulTrareliable and Low-latency Communications,URLLC)停机性能和信令开销大小之间的平衡,提出了一种TDD机制下的帧自适应配置算法。

结合海上编队勤务通信使用场景,采用eLAA和WiFi共存场景中的帧配置算法应用十分必要。在岸基和海上舰船部署基站,基站被视为一个智能体,并将吞吐时间和公平性的不同组合定义为智能体状态,不同帧配置定义为智能体行为。智能体基于获取到的网内其他基站的帧配置和WiFi的平均传输时长,通过不断地与环境交互,学习到最优的帧配置,从而实现编队勤务通信网络大带宽、高可靠、低时延传输效果。

本文采用QL算法在eLAA和WiFi共存场景中实现了基于type-3帧结构的动态帧配置;提出的机制不仅能够提高信道接入概率(免授权频段资源充分利用),而且还能同时实现WiFi与eLAA之间的公平信道接入;考虑实际使用过程中UL数据远少于DL数据的流量不对称情况,在满足WiFi需求的同时尽可能多地为基站配置DL数据。

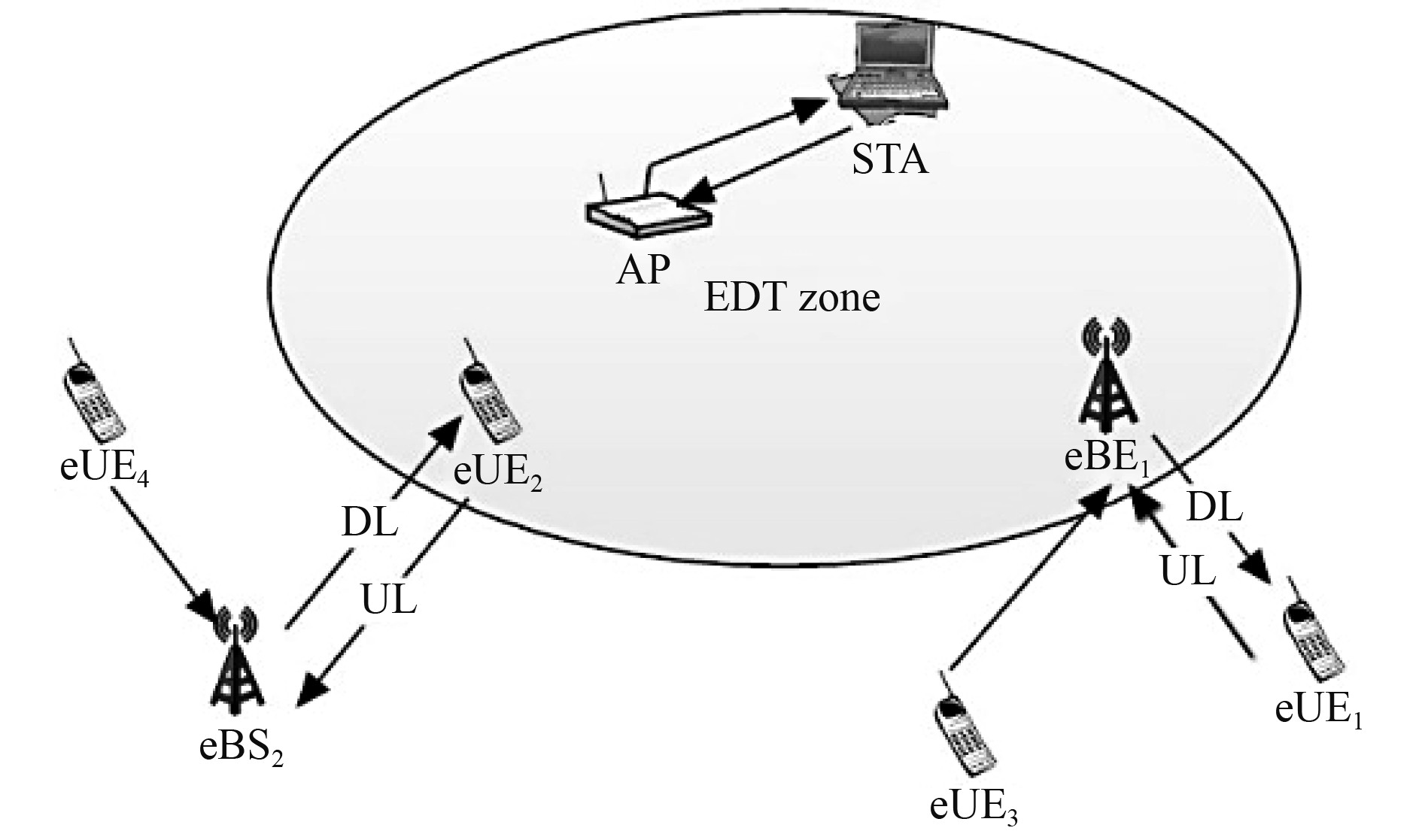

1 系统模型本文考虑的场景如图2所示。在场景中,WiFi AP、eUE2和eBS1处于同一能量检测阈值(Energy Detection Threshold,EDT)区域内。因此,同一时刻三者只能有其中一个接入信道传输数据,否则会产生冲突。然而,若eBS2和eUE2配置为DL传输,BS1与eUE1配置为UL传输,此时免授权频段可用于3个网络,即eBS1,eBS2和WiFi节点,这种帧配置将免授权频段的利用率提高了3倍。

|

图 2 eLAA/MulteFire和WiFi之间的UL-DL交叉干扰 Fig. 2 UL-DL cross Interference between eLAA/MulteFire and WiFi |

由于eLAA没有7个固定的UL/DL TDD配置的限制,因而可以自由决定每一个eBS与其eUES是UL还是DL。基于这种新的帧结构,本文提出的基于QL的DFC机制通过考虑WiFi、eBSs及其eUEs的无冲突传输时间以及当前WiFi的需求,同时注重自身上下行流量需求和参与用户的公平性,动态地配置UL/DL帧。

定义

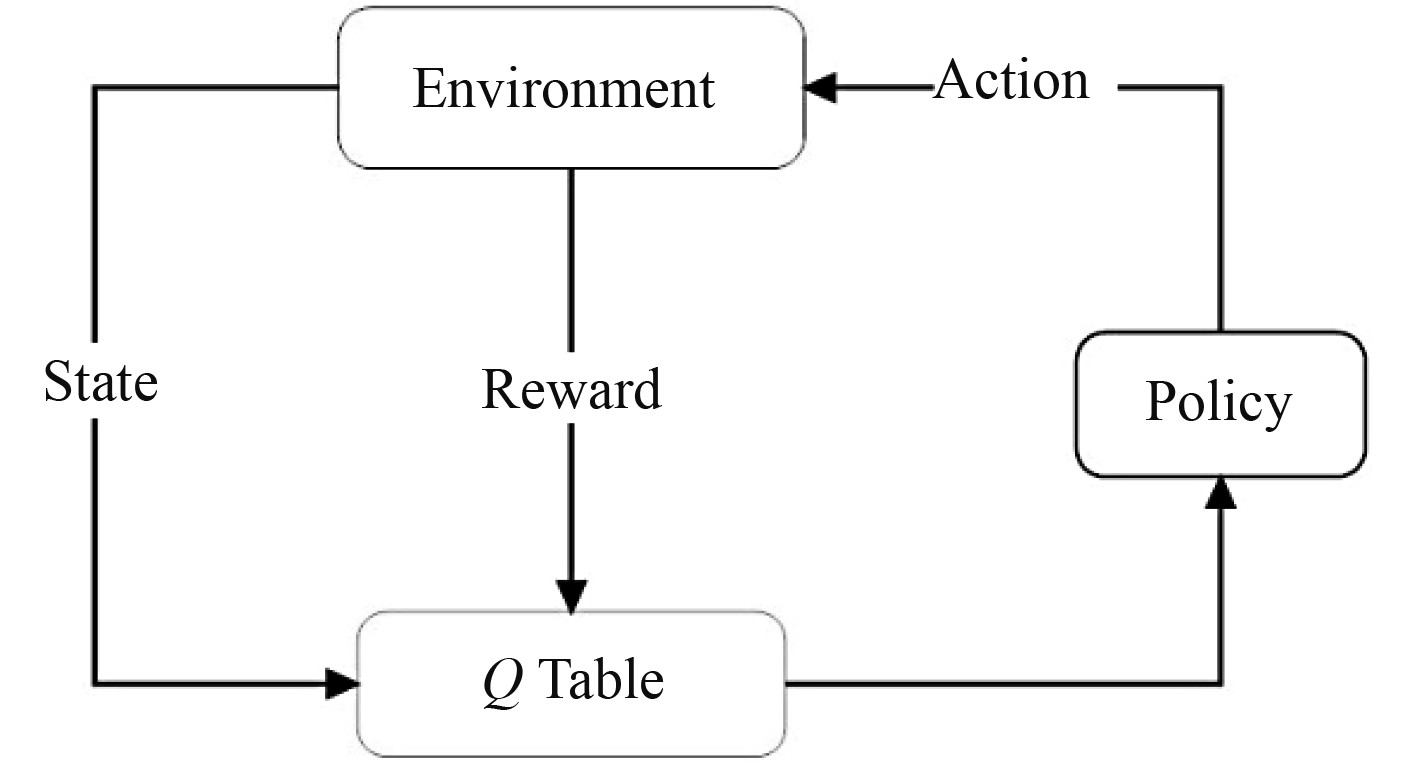

通过强化学习(Reinforce Learning,RL),智能体感知其周围环境并选择动作来达到预设目标。QL是一种无模型的强化学习。QL模型可以被定义为一个集合

智能体和环境之间交互过程如图3所示,其发生顺序如下:

|

图 3 学习曲线 Fig. 3 Learning curve |

1)智能体感知其周围环境,并且获取当前状态

2) 智能体在当前状态

3)当智能体在状态

4) 重复上述过程。

智能体的任务在于根据当前状态选择动作,

| $ Q(s,a)\leftarrow Q(s,a)+\alpha r+\gamma {\mathrm{m}\mathrm{a}\mathrm{x}}_{{a}{{'}}}Q\left({s}{{'}},{a}{{'}}\right)-Q\left(s,a\right) \text{。} $ | (1) |

状态的划分主要取决于算法的实现目标,即公平性和吞吐量。这是共存场景的2个主要性能指标。然而,这2个指标是矛盾的。公平性的提高必然导致总吞吐量的下降,反之亦然。因此,需要在公平性和总吞吐量之间进行权衡。在本文提出的Q学习框架中,智能体的状态被进一步分为9个状态,分别为低公平性低吞吐时间,低公平性中吞吐时间,低公平性高吞吐时间,中公平性低吞吐时间,中公平性中吞吐时间,中公平性高吞吐时间,高公平性低吞吐时间,高公平性中吞吐时间,高公平性高吞吐时间,表达式如下:

| $ S=\left\{\begin{array}{l}{S}_{1},Th < {\text{TH}}_{\text{1}}F < {{F}}_{1},\\ {S}_{2},{\text{TH}}_{1}\leqslant Th < {\text{TH}}_{2}F < {{F}}_{1},\\ {S}_{3},Th\geqslant {\text{TH}}_{2}F < {t{F}}_{1},\\ {S}_{4},Th < {\text{TH}}_{\text{1}}{{F}}_{1}\leqslant F < {{F}}_{2},\\ {S}_{5},{\text{TH}}_{1}\leqslant Th < {\text{TH}}_{2}{{F}}_{1}\leqslant F < {{F}}_{2},\\ {S}_{6},{\text{TH}}_{2}\leqslant Th{\mathrm{F}}_{1}\leqslant F < {{F}}_{2},\\ {S}_{7},Th < {\text{TH}}_{\text{1}}F\geqslant {{F}}_{2},\\ {S}_{8},{\text{TH}}_{1}\leqslant Th < {\text{TH}}_{2}F\geqslant {{F}}_{2},\\ {S}_{9},Th\geqslant {\text{TH}}_{2}F\geqslant {{F}}_{2}。\end{array}\right. $ | (2) |

其中,

| $ {\text{Jain}} '{\text{s}}{\text{ Index}}=\frac{{\left({\displaystyle\sum }_{i=1}^{n}{x}_{i}\right)}^{2}}{n{\displaystyle\sum }_{i=1}^{n}{x}_{i}2}。$ | (3) |

因此系统的公平性可定义为

在提出的QL算法中,智能体的动作为不同的帧配置。

2.2.2 奖励函数智能体的主要目标是在不同状态下做出最优帧配置,其目标是奖励函数最大化,同时使WiFi延迟和任务损失概率最小化。因此,定义在状态

| $ R(s,a)=U(s,a)-C(s,a),$ | (4) |

| $ U(s,a)={\omega }_{1}\varPhi +{\omega }_{2}{F+}{\omega }_{3}N 。$ | (5) |

式中:

在奖励函数中,

| $ C(s,a)={\omega }_{4}\frac{\theta }{{l}_{\text{WiFi}}}+{\omega }_{5}\frac{{D}}{{l}_{\text{WiFi}}} 。$ | (6) |

式中:

在决策时刻

初始化

初始化Q表为0,初始化学习速率

学习过程

选择一个初始状态s开始学习;

对于学习过程中的每次迭代

随机选择动作

执行动作

更新Q值

Q(s, a)←Q(s, a)+α[r+γmaxaQ(s', a')−Q(s, a)];

s←s'

一直学习到s状态是目标状态之一后进入下一个学习目标;

完成所有的学习次数停止。

3 性能仿真 3.1 仿真场景在仿真场景中,设置一个EDT区域,智能体eBS1处于该区域内,其10个eUES处于EDT区域外;普通基站eBS2处于EDT区域外,其eUES无规律分布在EDT区域内外。在此,从无冲突总传输时长、参与用户公平性、WiFi时延、WiFi传输损耗和DL流量等方面评价该算法的性能。表1为仿真参数。

|

|

表 1 仿真参数 Tab.1 Simulation parameter |

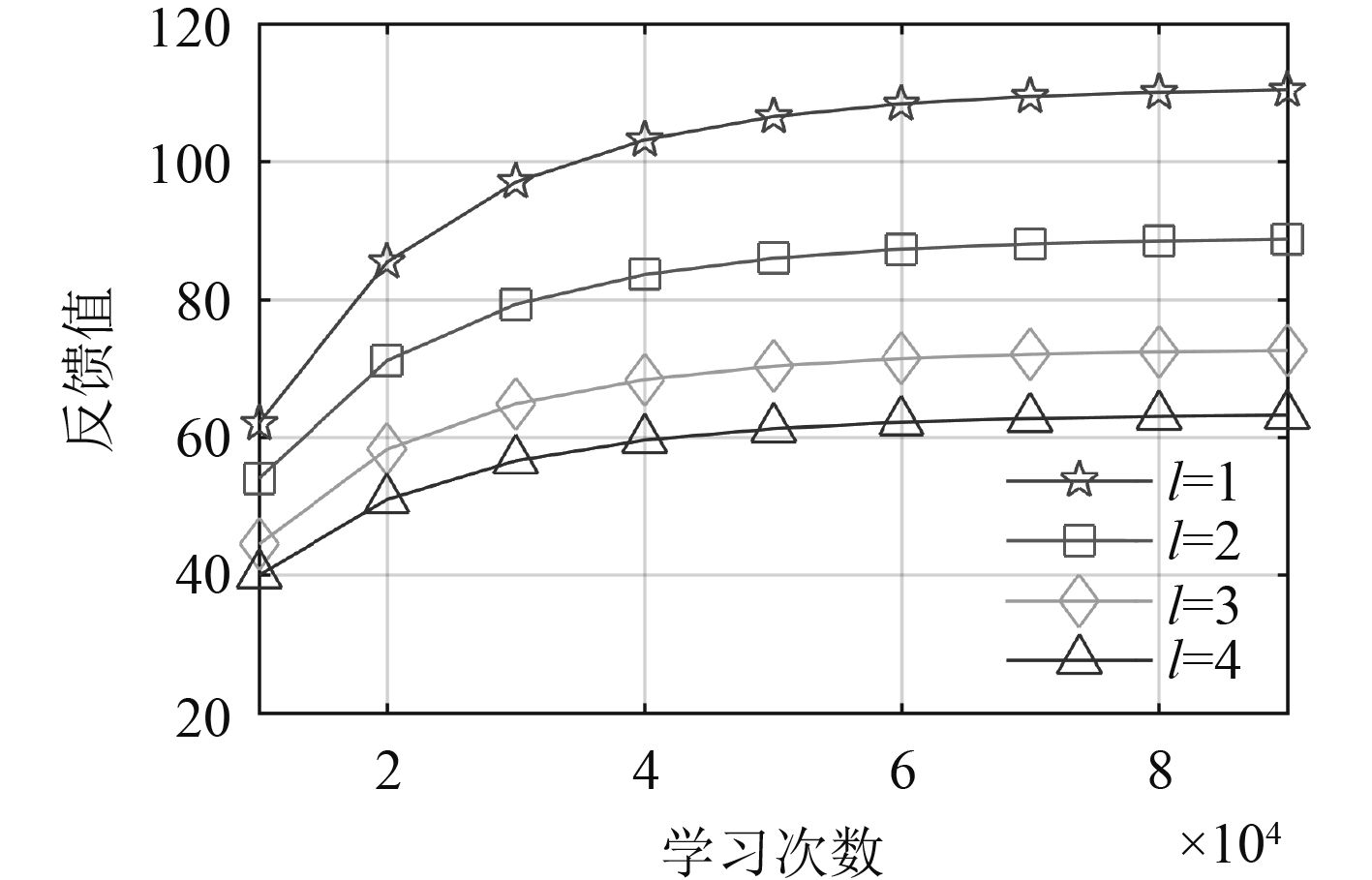

图4为

|

图 4 学习曲线 Fig. 4 Learning curve |

将本文算法与3种算法进行比较:RFC(Random Frame Configuration), SFC(Same Frame Configuration), AFC(Alternating Frame Configuration)。RFC算法即智能体基站每次获取信息后随机选择一种帧配置;SFC算法先随机产生一种帧配置,在获得使用信道机会后无论其他基站帧配置及WiFi长度如何变化都不再改变自身的帧配置;AFC算法即智能体基站随机选择选择5个eUES执行UL策略,剩余5个eUES执行DL策略。

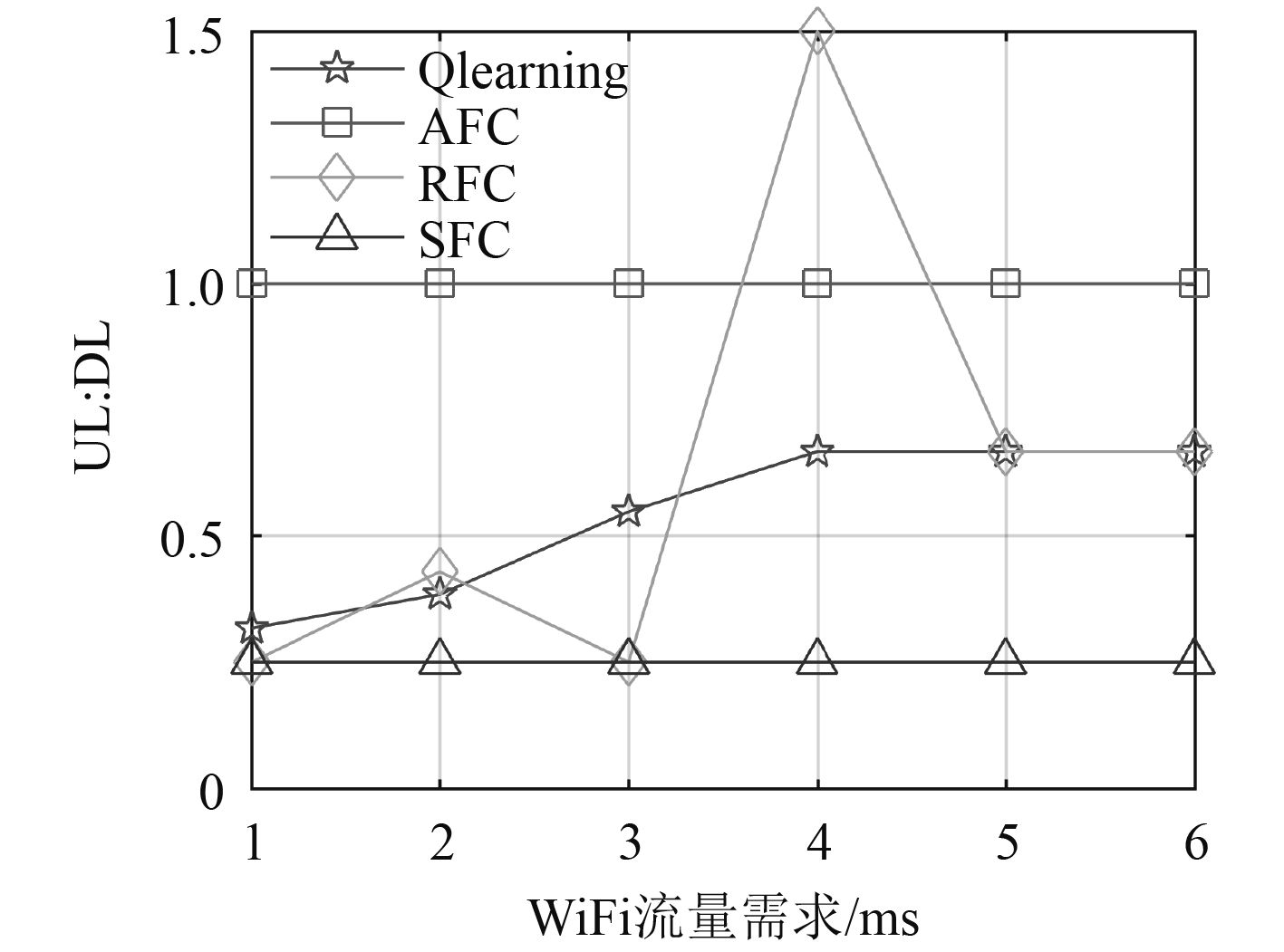

图5为各算法上下行数据对比图(UL:DL)。可以看出,智能体eBS1上下行数据的比例随WiFi流量需求提高而增加。这是由于基站eBS1配置更多的UL帧可以为处于EDT区域的WiFi提供更多的传输机会。在实际使用过程中,UL流量需求明显小于DL数据的需求。因此,在WiFi流量需求少的时候,在满足WiFi流量需求的情况下,基站尽可能多地配置DL帧。当WiFi流量需求提高时,基站牺牲一部分DL数据改为UL数据为WiFi提供传输时隙,但当eBS1中UL帧数目达到4时便不再牺牲。SFC算法随机产生的帧配置固定,其上下行配置比值很低。AFC算法中上下行帧比值过高,实际使用过程中则会产生浪费。RFC算法的上下行帧比值由于随机选择,数值变化不一。除本文算法外,AFC、SFC和RFC不能随WiFi流量的变化动态调整UL/DL值,导致了总吞吐量和公平性的损失。

|

图 5 UL:DL Fig. 5 UL:DL |

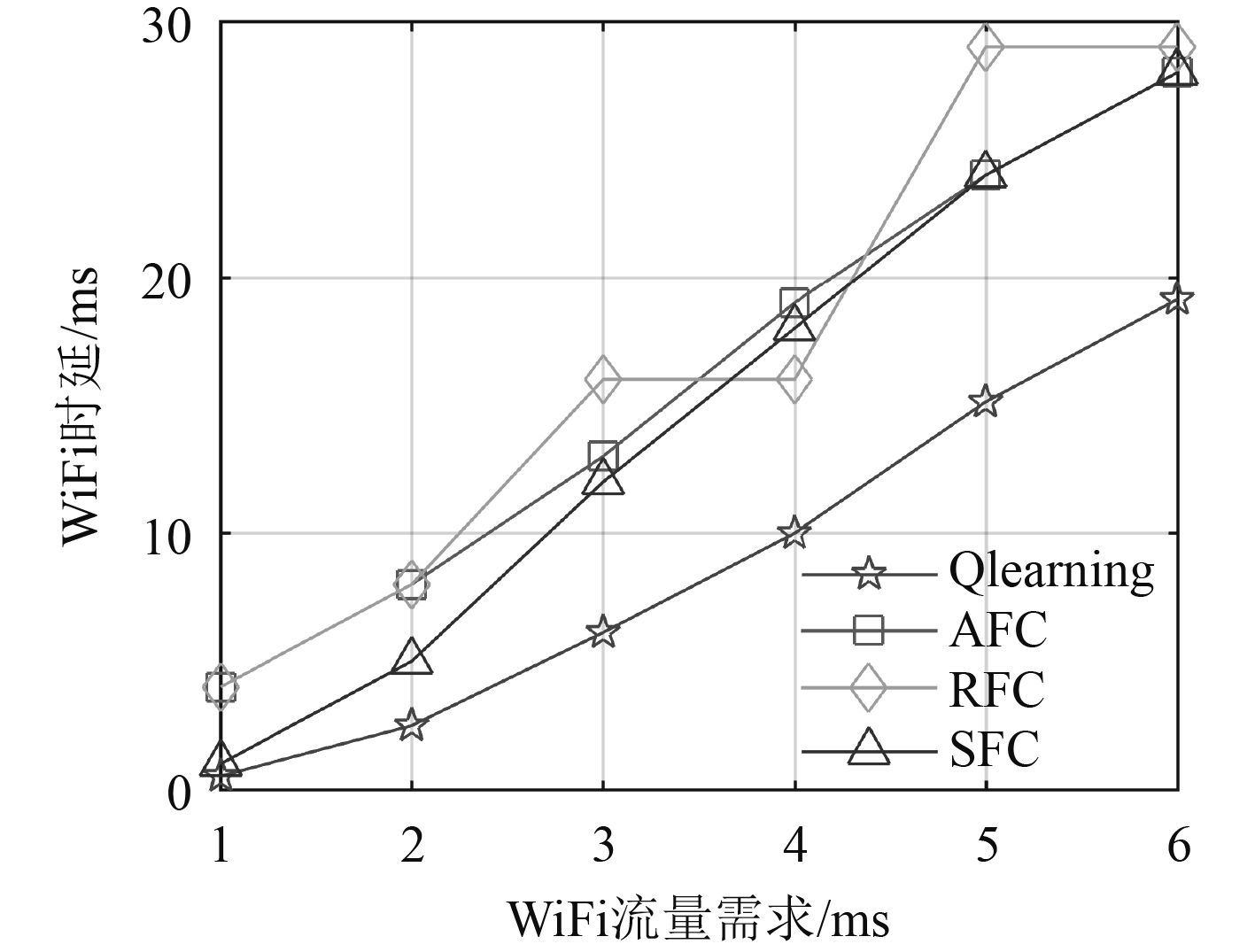

图6为各个算法WiFi时延的对比图。可以看出,各算法的WiFi时延皆随WiFi流量需求的增加而增加。然而,本文算法WiFi时延最低。这是因为本文算法,帧配置可随WiFi流量变化而改变。

|

图 6 时延对比 Fig. 6 Time delay comparison |

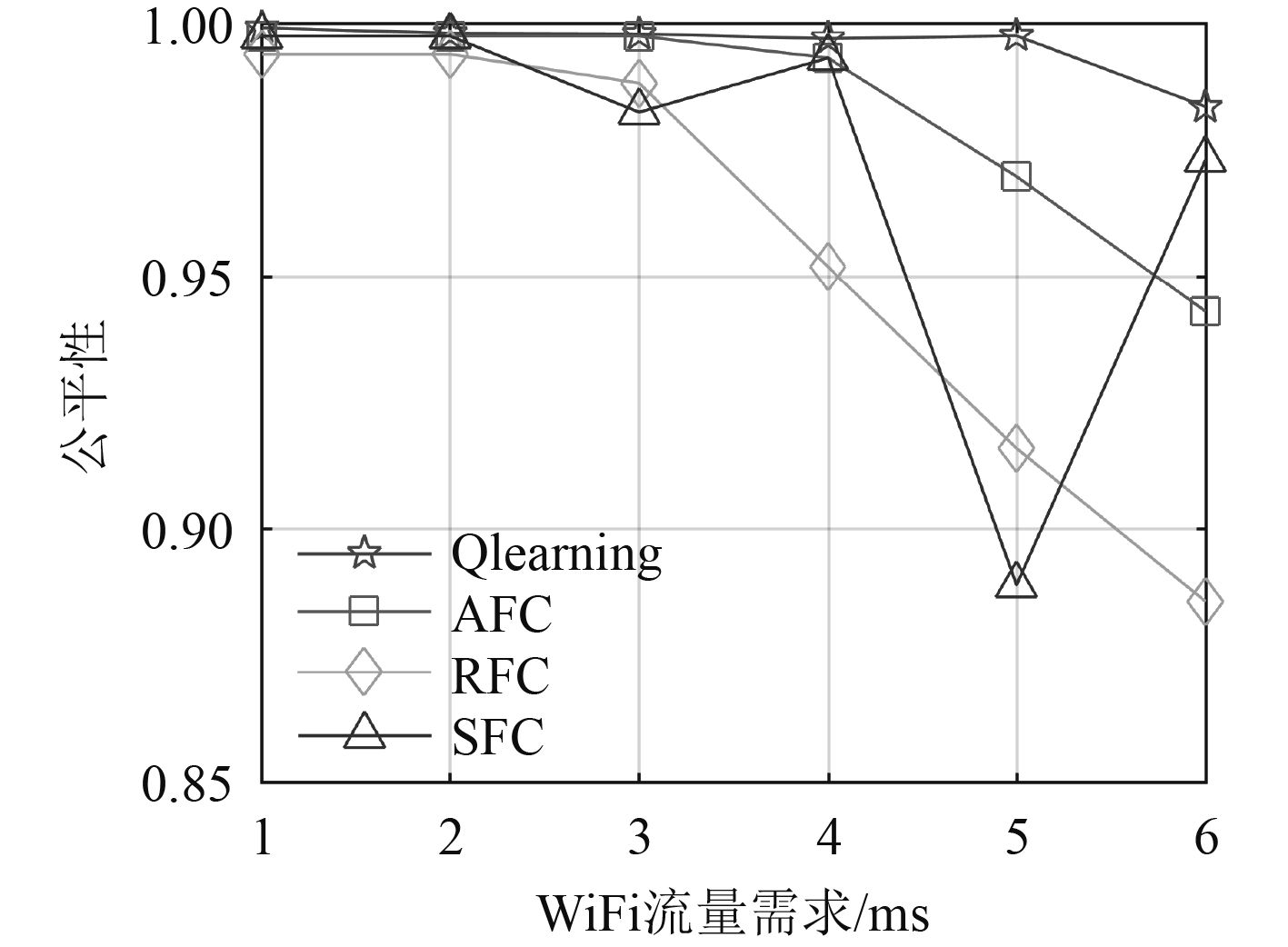

图7为各算法的公平性对比图。可以看出,SFC算法由于帧配置固定导致公平性很差;RFC算法由于其随意为当前环境挑选帧配置,导致其公平性忽高忽低;AFC算法上下行数据比值为1:1;本文算法公平性最好。

|

图 7 公平性对比 Fig. 7 Comparison of fairness |

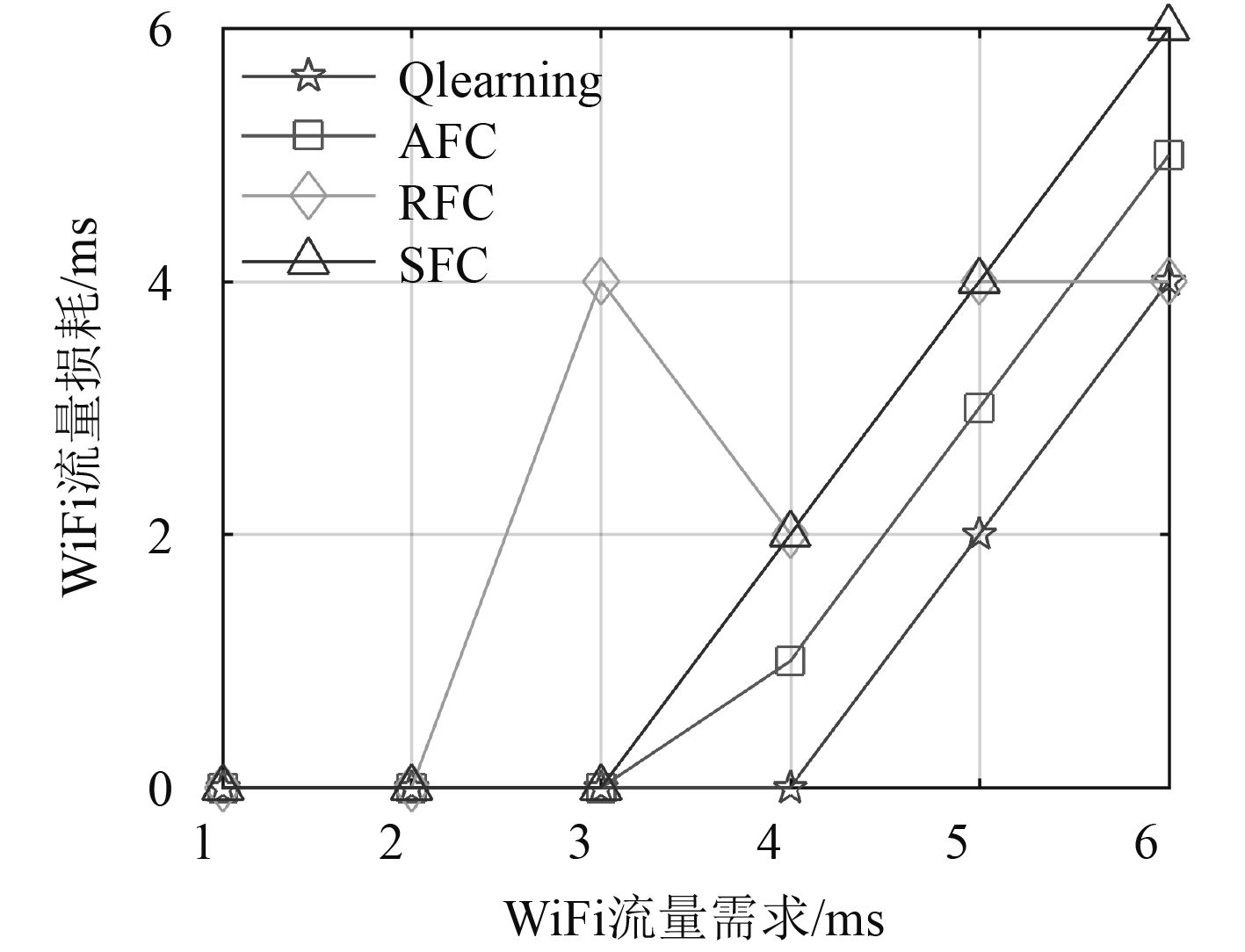

图8为各算法WiFi流量损耗比较图。本文帧配置以满足WiFi流量需求为首要目标,因此WiFi流量需求长度在4ms及以下时都能满足。当超过4 ms时,基站不再为WiFi传输提供机会,WiFi流量损耗增加。可以看出,本文算法WiFi流量损耗最小。

|

图 8 WiFi流量损耗 Fig. 8 WiFi traffic loss |

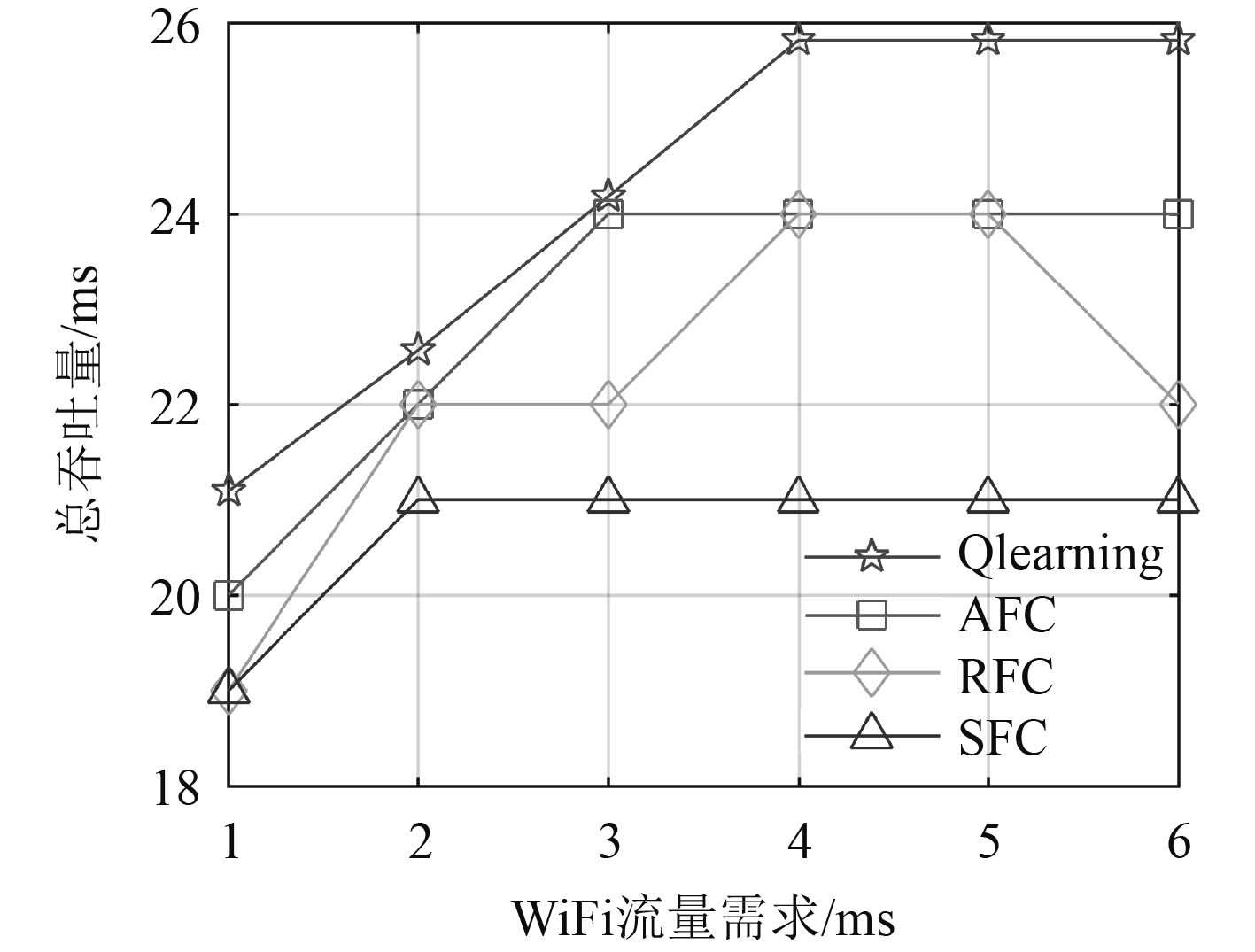

图9为各算法的总吞吐量对比图。可以看出,本文算法当WiFi流量需求超过4

|

图 9 总吞吐时间 Fig. 9 Total throughput time |

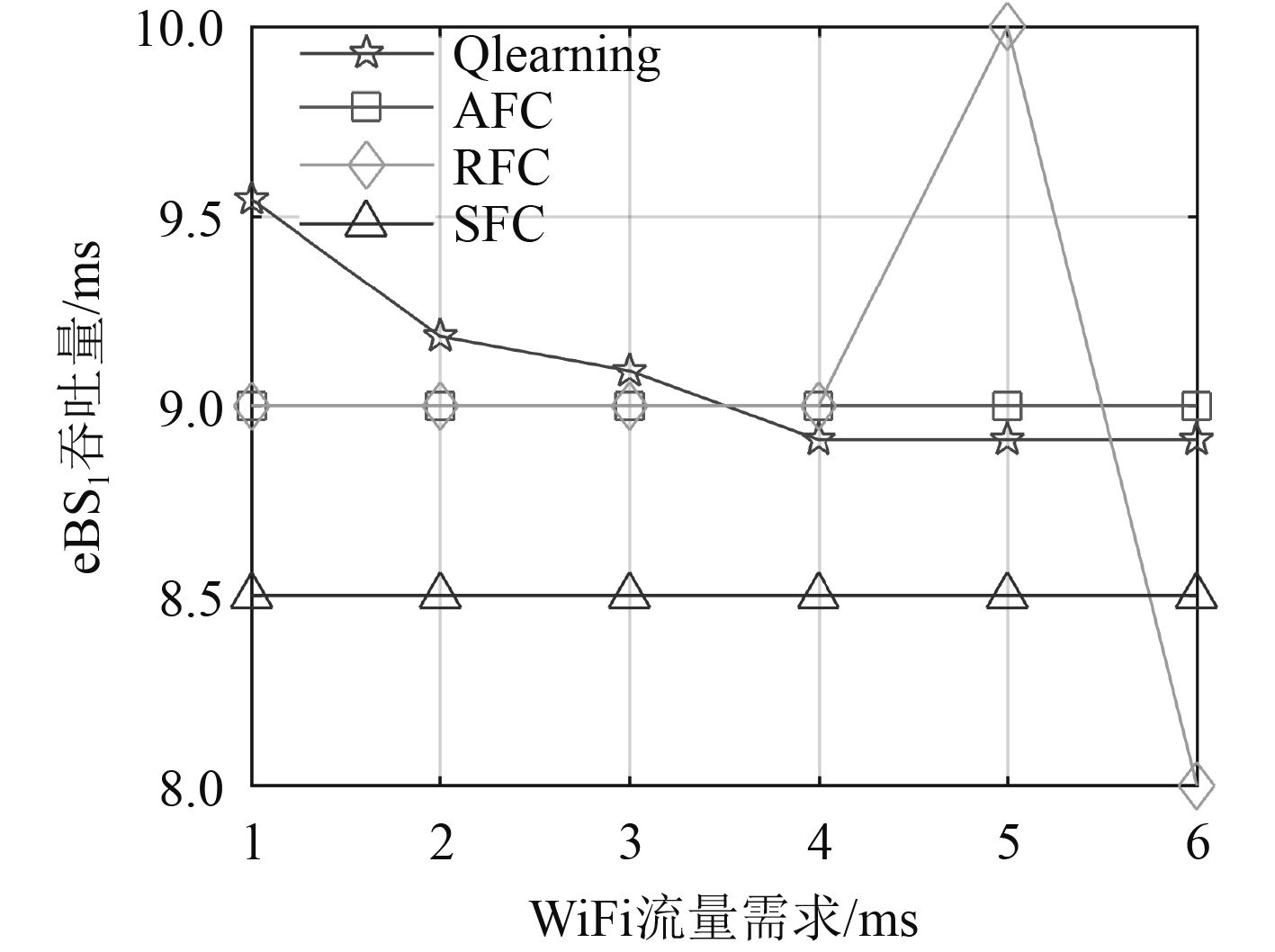

图10为不同算法下eBS1的吞吐量随WiFi流量需求的变化趋势对比图。当WiFi流量需求低时,eBS1满足WiFi、eBS2及其eUES的流量需求压力小,因而自身吞吐量高。随着WiFi流量需求的增加,为满足WiFi和eBS2流量需求,eBS1的吞吐量随之下降。当基站达到牺牲阈值时,便不再为WiFi流量传输提供时隙,WiFi传输受阻,基站传输却不受影响,因此eBS1的吞吐量不再改变。

|

图 10 eBS1吞吐量 Fig. 10 eBS1 throughput |

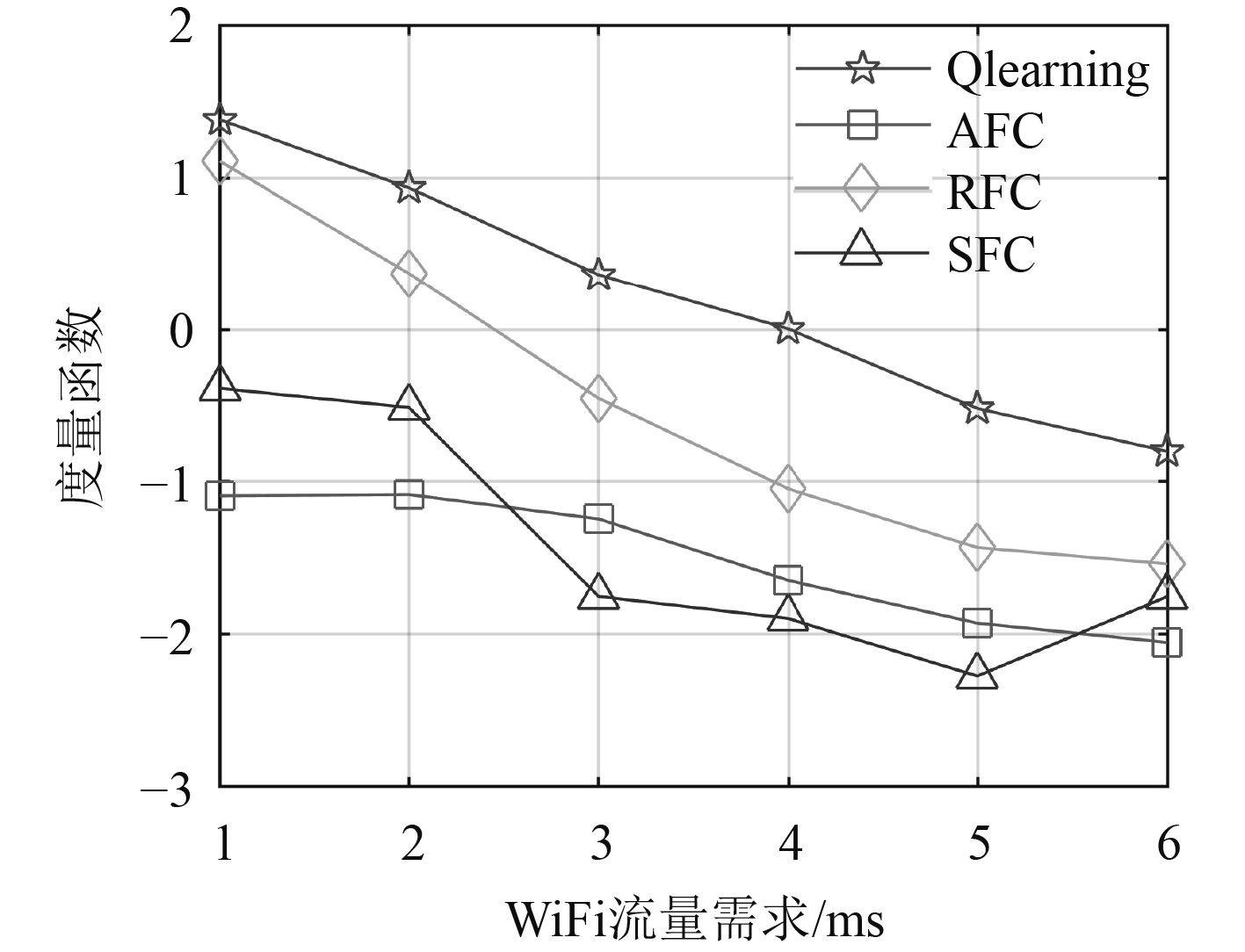

采用度量函数对提出的算法进行评估。采用的度量函数定义为:

| $ {H}={\Phi }^{{'}}+{F}^{{'}}-{C}^{{'}}-{D}^{{'}}-{L}^{{'}} 。$ | (7) |

其中,

基于提出的度量函数,各算法综合性能比较如图11所示。可以看出,本文提出的基于QL帧配置算法性能最好。

|

图 11 度量函数 Fig. 11 Metric function |

本文提出一种基于QL的动态UL/DL帧配置方法。在这个算法中,eBS被视为智能体,并且智能体状态被定义为吞吐量和公平性的不同组合,智能体行为被定义为不同的帧配置,共存系统的公平性以及奖励函数都被重新定义。基于提出的QL框架,智能体能够通过与环境的反复交互学习获得最优帧配置。仿真结果表明,本文提出的算法在公平性、吞吐量、时延、UL/DL比例以及WiFi流量损耗方面具有明显的优势。

| [1] |

MULTEFIRE A. Understanding MulteFire’s Radio Link [OL]. https://www. multefire. org/, 2017.

|

| [2] |

3GPP TR 36.889 V13.0. 0, Feasibility Study on Licensed-Assisted Access to Unlicened Spectrum[S]. 2015.

|

| [3] |

3GPP TS 36.211 V14.0. 0, TSGRAN; E-UTRA; Physical channels and modulation[S]. 2017.

|

| [4] |

CHENG M, WANG Y, HWANG W, WU Y and LIN C. Adaptive adjustment of TDD uplink-downlink configuration based on cluster classification in Beyond LTE Heterogeneous networks[C]//International Conference on Applied System Innovation (ICASI), 2017: 1312–1315.

|

| [5] |

LEE K, PARK Y, NA M, WANG H and HONG D. Aligned Reverse Frame Structure for Interference Mitigation in Dynamic TDD Systems[J]. IEEE Transactions on Wireless Communications, 2017, 16(10): 6967-6978. DOI:10.1109/TWC.2017.2735398 |

| [6] |

LIN Yi-Ting, CHAO Cheng-Chih and WEI Hung-Yu. Dynamic TDD interference mitigation by using Soft Reconfiguration [C]//International Conference on Heterogeneous Networking for Quality, Reliability, Security and Robustness (QSHINE), Taipei, China, 2015: 352–357.

|

| [7] |

MULAY A K, BASWADE A M, TAMMA B R and FRANKLIN A A. DFC: Dynamic UL–DL Frame Configuration Mechanism for Improving Channel Access in eLAA[J]. IEEE Networking Letters, 2019, 1(3): 116-119. DOI:10.1109/LNET.2019.2924697 |

| [8] |

XU Y, WANG J, WU Q, ANPALAGAN A. and YAO Y. Opportunistic Spectrum Access in Cognitive Radio Networks: Global Optimization Using Local Interaction Games[J]. IEEE Journal of Selected Topics in Signal Processing, 2012, 6(2): 180-194. DOI:10.1109/JSTSP.2011.2176916 |

| [9] |

WANG Y, TAO M. Dynamic uplink/downlink configuration using Q-learning in femtocell networks[C]//IEEE/CIC International Conference on Communications in China (ICCC), Shanghai, China, 2014: 53–58.

|

| [10] |

KUSHWAHA H, KOTAGI V J and MURTHY C Siva Ram . A Novel Reinforcement Learning Based Adaptive Optimization of LTE-TDD Configurations for LTE-U/WiFi Coexistence[C]//IEEE Annual International Symposium on Personal, Indoor and Mobile Radio Communications (PIMRC), Istanbul, 2019: 1–7.

|

| [11] |

ESSWIE A. A, PEDERSON K I and MOGENSEN P E. Semi-Static Radio Frame Configuration for URLLC Deployments in 5G Macro TDD Networks[C]//IEEE Wireless Communications and Networking Conference (WCNC), 2020: 1–6.

|

| [12] |

DZIEDZIC A, SATHYA V, ROCHMAN M I, GHOSH M and KRISHNAN S. Machine Learning Enabled Spectrum Sharing in Dense LTE-U/Wi-Fi Coexistence Scenarios[J]. IEEE Open Journal of Vehicular Technology, 2020, 1: 173–189.

|

| [13] |

JOHN I, KAMANCHI C and BHATNAGAR S. Generalized Speedy Q-Learning[J]. IEEE Control Systems Letters, 2020, 4(3): 524-529. DOI:10.1109/LCSYS.2020.2970555 |

| [14] |

LE D Van, THAM C. A deep reinforcement learning based offloading scheme in ad-hoc mobile clouds[C]//IEEE INFOCOM 2018 - IEEE Conference on Computer Communications Workshops (INFOCOM WKSHPS), 2018: 760–765.

|

2023, Vol. 45

2023, Vol. 45