人工检测这种耗费劳动成本,且随时间人为错误不断叠加的传统方法,已不适合对目标进行精准检测[1-3],亟需一种更为高效的特征提取方法进行自适应地智能分析与处理。目前学术上较为常见的特征提取方法,多是利用深度卷积神经网络展开,并在实践中取得了较为理想的成效。然而该方法在训练时,需要大量已标注的图像数据。同时,由于特征提取模型过度依赖庞大的数据集,其只能针对检测训练数据中出现的目标类别,对新类别目标的检测能力很低。

因此,为了实现舰船图像轮廓特征提取的高效性及准确性,需要对目标的类别判定与定位回归两方面进行优化改进。在舰船图像特征提取上,寻求一个准确的目标匹配方法与区域定位机制,由此提升舰船小样本特征提取模型的准确率和泛化性能,并在有干扰样本的检测环境中,使其仍能获得较为准确的检测结果。本文基于小样本学习的深度神经网络对舰船样本量较少的数据集进行训练,获得一个自适应、高效的小样本特征提取模型,并针对特征向量在度量过程产生的信息丢失与偏移问题,设计一种舰船图像轮廓特征投影提取的方法,由此实现对特定舰船目标的轮廓特征进行精准检测,满足小样本特征提取的现实需求[4-5]。

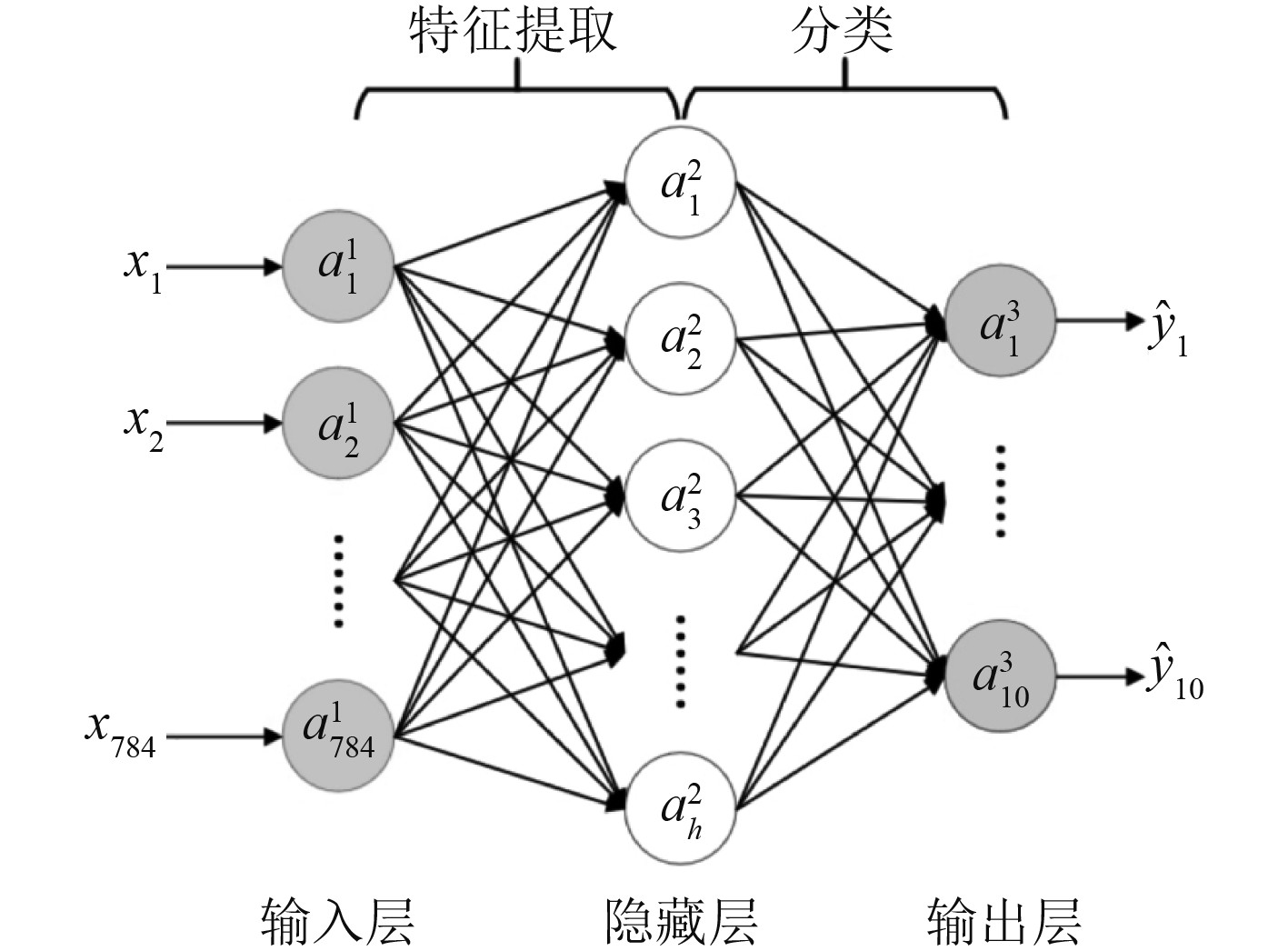

1 基于深度学习的特征提取算法基于深度学习的特征提取算法,如图1所示。按步骤输出待测图像的目标分类得分(通常为置信度得分和回归得分)与检测框图,一般可完成对待测图像的特征提取任务。双阶段特征提取流程包含特征提取、特征分类和输出等步骤,而单阶段特征提取流程直接进行特征提取与回归,利用NMS去除冗余框后输出目标的检测得分与位置框图。

|

图 1 基于深度学习的特征提取算法流程 Fig. 1 Target detection algorithm flow based on deep learning |

然后,再完成整个模型的训练与优化,使得模型的预测结果更加接近真实结果。

1.1 卷积神经网络的构建使用卷积神经网络对待测图像进行特征提取与分类回归任务,卷积神经网络主要由卷积(convolution)、激活(activation)和池化(pooling)3个部分构成,当前较为经典的特征提取算法都是由多个基础的卷积神经网络组合而成。

在计算机视觉中,对特征提取所使用的卷积一般为2D卷积,在x和y两个方向上进行滑动,且卷积核的深度等于输入特征的通道数。卷积即使用卷积核的权重与目标区域上对应数值进行乘积的和,卷积的数学表达式为:

| $ \operatorname{conv}=\sum_{i}^{a\cdot b} w_{i} x_{i}+y。$ | (1) |

式中:a和b分别为卷积核的大小,wi为卷积核对应第i个元素的权重,xi为输入图像对应第i个元素的值,y为卷积的偏置大小。卷积核的数量决定了待测图像进行卷积操作后输出的特征层数。同时,根据任务需求自行设定卷积核的尺寸与滑动步长,调控输出特征图的大小,输出特征图尺寸的数学表达式为:

| $ l_{ {est }}=\frac{l_{{m}}-k}{\text { stride }}+1 \text{。} $ | (2) |

当卷积核的尺寸大于1时,输出舰船图像轮廓特征的尺寸保持不变,可以使用尺寸为1×1的卷积核来改变特征图的通道数,也可使用填充(padding)方法对特征图外围补0值来扩充。其数学表达式更新为:

| $ l_{e{t}}=\frac{l_{ {m }}-k+2 \cdot \text { padding }}{\text { stride }}+1 \text{,} $ | (3) |

式中:padding为特征图外围补0的层数。卷积后通常使用非线性激活函数(activation function)激活卷积网络,激活结果为:

| $ f=h\left(\sum_{i}^{+t} w_{i} x_{i}+y\right) \text{,} $ | (4) |

式中,h为使用的激活函数。sigmoid函数输出范围为0~1,函数表达式为:

| $ h(x)=1 /\left(1+e^{-x}\right) \text{。} $ | (5) |

其输出中心不在0附近,会出现梯度弥散现象。Tanh函数输出范围为−1~1,函数表达式为:

| $ h(x)=\tanh (x) \text{。} $ | (6) |

其中心值在0附近仍存在梯度弥散的现象。ReLu函数输出范围为0到正无穷,函数表达式为:

| $ h(x)=\max (0, x) \text{。} $ | (7) |

较少的计算量与较宽的梯度响应区间使得ReLu函数得到广泛应用。

激活卷积网络后,通常使用池化(pooling)来降低特征图的空间尺寸,进而提取特征图中的主要信息,减小输出特征图的数据量,防止卷积网络出现过拟合现象。常用的池化方法有最大池化与均值池化。最大池化是保留一个空间内所有数值的最大值,均值池化是保留一个空间内所有数值的均值。

1.2 确定网络损失函数卷积神经网络的训练误差通常需要一个损失函数,衡量经卷积神经网络输出的结果和真实结果之间的差距。一般情况下,损失函数的数值越小表明其网络性能越符合预期。面向不同任务所使用的损失函数类型差异较大,分类任务常用的损失函数为交叉熵损失函数,其表达式如下:

| $ { {\rm{CrossEntropyLass}} } = -\left(y_{i} \log \left(\hat{y}_{i}\right) + \left(1-y_{i}\right) \log \left(1 - \hat{y}_{i}\right)\right) \text{。} $ | (8) |

交叉熵损失函数对置信度较高但分类错误的值进行更大的惩罚。回归算法中常用的损失函数为均方误差损失函数,其表达式如下:

| $ M S E=\frac{{\displaystyle\sum}_{i=1}^{n}\left(y_{i}-\hat{y}_{t}\right)^{2}}{n} \text{。} $ | (9) |

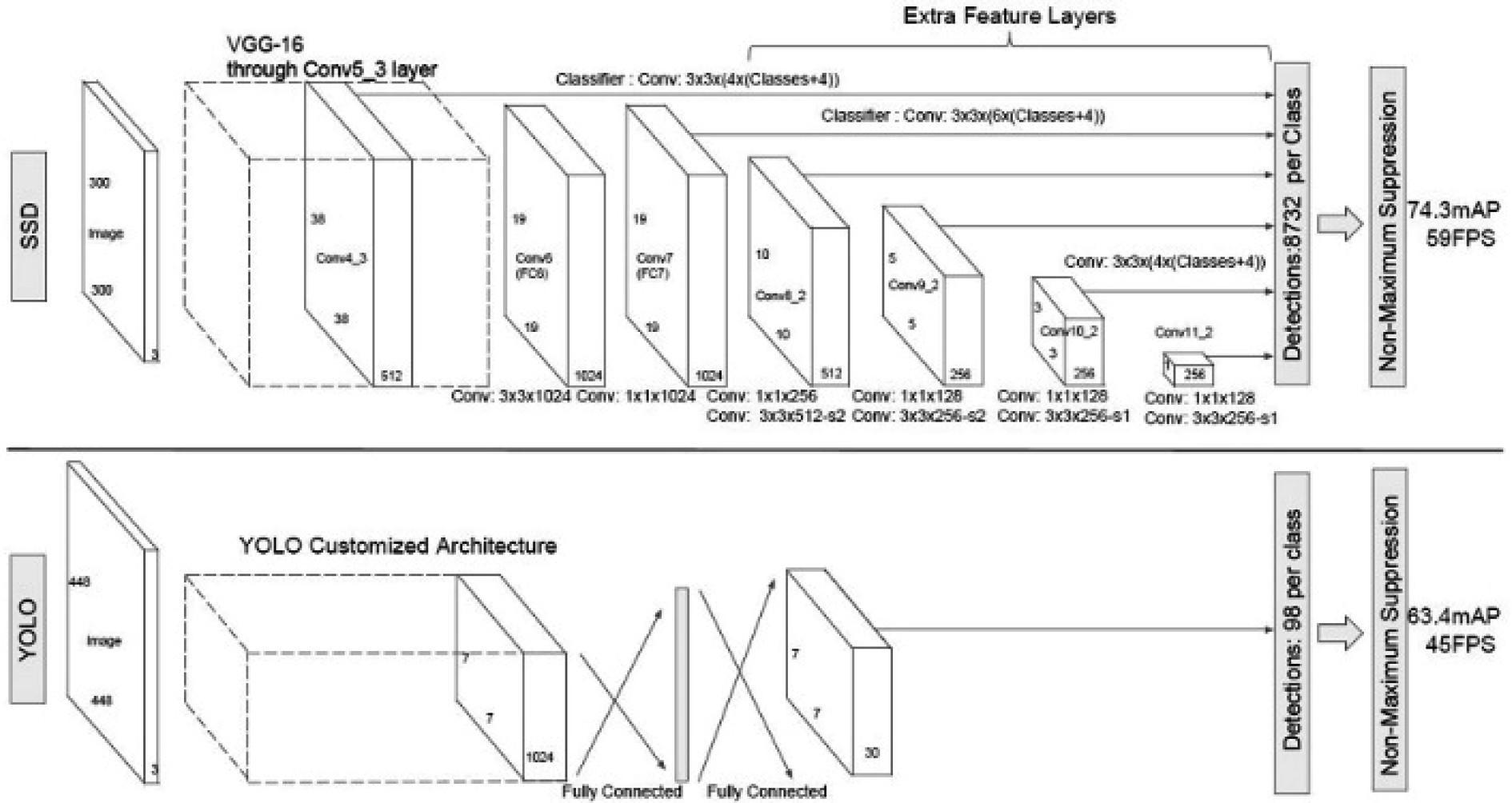

如图2所示,SSD使用VGG卷积神经网络提取图像特征,其网络可获取更多细节的语义信息,并提升模型对多尺度目标的检测性能。

|

图 2 SSD网络结构 Fig. 2 SSD Network Structure |

为测试样本量对特征提取模型的性能影响,通过实验验证SSD在不同样本量情况下的检测性能。实验使用控制变量法,只改变每次训练的图像数量,其他变量均保持不变。实验参数设置如下:学习率为0.0005,batch size为16,最大迭代轮数为50。实验共进行7轮,使用VOC2007数据集,选取不同数量的待测图像,且每幅图像标注的目标个数也不同。训练时,样本图像随机从数据集中选取。测试时,每一轮均选用相同的100幅图像进行测试,且测试图像均参与训练过程。实验使用的评价指标为mAP,准确地反映模型的检测性能。实验结果如表1所示。

|

|

表 1 SSD在不同图像数量训练下的检测性能 Tab.1 Detection performance of SSD in different image number training |

观察发现,当图像数量为10时,其实验结果mAP为0,说明模型在样本量极少的情况下,无法提取和学习到目标特征,故无法检测到目标。当图像数量从20逐渐增加时,mAP随样本量的增加逐渐增大,表明SSD的检测性能随样本量的增加而逐渐增强。

假设一任务中,最优解为S1,设计模型的理论最优解为S2,设计模型的实验最优解为S3,且在实际生活里的特征提取任务,其S1与S2均无法准确得到,只能通过实验获得最佳的S3。在样本量充足的情况下,训练得到的S3可近似看作S2;当样本量较少时,S3与S2的距离会逐渐拉大,表明较少的样本量会限制模型的检测性能,无法充分表现其检测效果。如何利用少量样本进行特征提取,是本文的研究重点。

2 基于动态子空间的小样本舰船图像轮廓特征提取方法 2.1 检测方法介绍语义分割任务,是将样本数据集分为支持集和查询集,再与查询样本的特征数据关联匹配,进而获得查询图像的类别信息。该算法通过不断增强分类的细粒度,提升网络的语义分割性能,获得良好的小样本特征提取性能。迁移学习算法利用源数据集充足的样本量,通过深度神经网络多次训练获得较好的特征提取性能,将训练完成的模型或知识迁移至小样本的新类数据集中,通过网络训练获得适应小样本新类的目标分类器。

基于以上检测方式,对舰船图像轮廓特征进行分类。

1)围绕30张舰船图像小样本进行轮廓特征的向量分析。在此过程中,为了规避出现诸如各舰船图像轮廓特征的相互干扰,特对搜集的样本量进行特征拆解,并基于相似性度量检测方法对其各投影子空间进行正交化处理。

2)通过对舰船图像轮廓特征的小样本模型进行反复训练,不断优化损失函数,在实际操作中可以迭代出舰船图像轮廓的特征相似性,并基于损失函数提升子空间的类间差异性,从而增强其检测类别概率,提升检测方法的抗干扰能力。

2.2 图像分类模型分类模型实现的具体步骤如下:

首先,将本次搜集的舰船图像轮廓特征导入到训练好的网络ResNet-18中,得到相对应的轮廓特征向量f(xi),并计算第m类舰船图像对应的轮廓特征均值:

| $ {\mu _{{m}}}{\text{ = }}\frac{1}{K}\sum\nolimits_{{x_i} \in {X_{{m}}}} {f\left( {{x_i}} \right)} \text{,} $ | (10) |

基于上式,获得第m类图像的去均值集合:

| $ {\overline X _m} = \left\{ {f({x_{m,1}}) - {\mu _m},f({x_{m,2}}) - {\mu _m}, \cdot \cdot \cdot ,f({x_{m,K}}) - {\mu _m}} \right\} \text{。} $ | (11) |

采用主成分分析法对全舰船图像轮廓特征样本进行分解,得到对应的映射矩阵与投影子空间的转换公式:

| $ {\widetilde X_m} = {P_m}{\overline X _m} \text{。} $ | (12) |

对舰船图像轮廓特征样本类别的投影子空间进行正交化处理,计算得出投影子空间的平方欧式距离:

| $ {d_m}\left( q \right) = {\left\| {\left( {{W_m} - {M_m}} \right)\left( {f(q) - {\mu _m}} \right)} \right\|^2} \text{,} $ | (13) |

| $ {W_m} = X_m^{\rm{T}}{X_m} \text{,} $ | (14) |

| $ {M_m} = {P_m}P_m^{\rm{T}} \text{。} $ | (15) |

式中,f(q)为查询图像的特征向量。在对图像的类别进行分析时,计算查询图像q与每个投影子空间的距离,并借助softmax函数计算出了舰船图像轮廓特征属于第m类图像的概率:

| $ {p_{m,q}} = p(m|q) = \frac{{\exp \left( { - {d_m}\left( q \right)} \right)}}{{\displaystyle\sum\nolimits_{m \in N} {\exp \left( { - {d_m}\left( q \right)} \right)} }} \text{。} $ | (16) |

最终,基于ResNet-18网络,实现对舰船的图像轮廓特征的动态子空间分类。

2.3 特征提取网络采用ResNet对搜集到的相关图像进行特征轮廓提取,经整理后,其网络结果如表2所示。

|

|

表 2 ResNet-18网络结构 Tab.2 ResNet-18 Network architecture |

按照图3所示的正交化处理方式,基于前文相关数据对舰船图像轮廓特征样本构建动态子空间,得出协方差矩阵公式。

|

图 3 动态子空间正交化示意图 Fig. 3 Diagram of orthogonalization of dynamic subspaces |

| $ C = \frac{1}{k}X{X^{\rm{T}}} \text{。} $ | (17) |

通过损失函数的参数回传与优化,借助格拉斯曼数对舰船图像轮廓特征各类子空间的差异性进行计算,得出距离度量公式:

| $ d\left( {{P_a},{P_b}} \right) = \left\| {{P_a}P_a^{\rm{T}} - {P_b}P_b^{\rm{T}}} \right\|_F^2 = 2n - 2\left\| {P_a^{\rm{T}}{P_b}} \right\|_F^2 \text{。} $ | (18) |

通过损失函数的迭代最大化,对舰船图像轮廓的各子空间差异化特性进行提取,由此提升特征提取方法的泛化能力。

2.5 损失函数关于交叉熵分类的损失函数为:

| $ S=- \frac{1}{N}\sum\limits_m {\log \left( {\frac{{\exp \left( {{d_m}\left( q \right)} \right)}}{{\displaystyle\sum\nolimits_{m \in N} {\exp \left( {{d_m}\left( q \right)} \right)} }}} \right)} \text{,} $ | (19) |

关于子空间的损失函数为:

| $ S'=\left\| {P_a^{\rm{T}}{P_b}} \right\|_F^2 。$ | (20) |

将二元损失函数视为总损失函数,通过平衡损失函数前后项的量级与收敛速度,得出最终的二元损失函数为:

| $ S F=- \frac{1}{N}\sum\limits_m {\log \left( {\frac{{\exp \left( {{d_m}\left( q \right)} \right)}}{{\displaystyle\sum\nolimits_{m \in N} {\exp \left( {{d_m}\left( q \right)} \right)} }}} \right)} {\text{ + }}\alpha \left\| {P_a^{\rm{T}}{P_b}} \right\|_F^2 。$ | (21) |

基于以上函数结果,将舰船图像的样本数据集进行训练与优化,得出其轮廓特征的高效分类模型。

3 结 语本文基于子空间投影对舰船图像轮廓特征进行提取,通过动态正交化处理,经验证可以提升子空间的特征差异性,完成对舰船图像的轮廓特征的提取。

| [1] |

卢鹏, 曹阳, 邹国良, 等. 改进Shufflenetv2_YOLOv5的轻量级SAR图像舰船目标实时检测[J]. 海洋测绘, 2023, 43(1): 58-62+82. LU Peng, CAO Yang, ZOU Guo-liang, et al. Improved Shufflenetv2_YOLOv5 for real-time detection of ship targets in lightweight SAR images[J]. Marine Surveying and Mapping, 2023, 43(1): 58-62+82. |

| [2] |

赵炜东, 郭鹏宇, 刘勇, 等. 基于可见光与红外卫星图像融合的舰船目标检测[J]. 上海航天(中英文), 2023, 40(1): 44-52. ZHAO Wei-dong, GUO Peng-yu, LIU Yong, et al. Ship target detection based on fusion of visible light and infrared satellite images[J]. Shanghai Aerospace, 2023, 40(1): 44-52. |

| [3] |

李海军, 孔繁程, 魏嘉彧, 等. 基于直觉模糊集和CLAHE红外舰船图像增强算法[J]. 兵器装备工程学报, 2022, 43(11): 88-94. LI Hai-jun, KONG Fan-cheng, WEI Jia-yu, et al. Infrared ship image enhancement algorithm based on intuitionistic fuzzy sets and CLAHE[J]. Journal of Ordnance Equipment Engineering, 2022, 43(11): 88-94. |

| [4] |

赵紫稷. 面向合成孔径雷达图像任意方向舰船检测的YOLOv3模型的改进[J]. 无线互联科技, 2022, 19(19): 111-113. ZHAO Zi-ji. Improvement of YOLOv3 model for ship detection in any direction of synthetic aperture radar image[J]. Wireless Internet Technology, 2022, 19(19): 111-113. |

| [5] |

周旗开, 张伟, 李东锦, 等. 基于改进YOLOv5s的光学遥感图像舰船分类检测方法[J]. 激光与光电子学进展, 2022, 59(16): 476-483. ZHOU Qi-kai, ZHANG Wei, LI Dong-jin, et al. Ship classification and detection method based on improved YOLOv5s in optical remote sensing image[J]. Progress in Laser and Optoelectronics, 2022, 59(16): 476-483. |

2023, Vol. 45

2023, Vol. 45