新一轮科技革命、产业革命和军事革命快速推进,以无人自主系统、人工智能为代表的战略前沿技术迅猛发展,无人艇、无人机、无人潜航器等无人作战系统走上战争舞台并发挥愈发重要的作用。无人化作战逐渐成为大国之间对抗的重要样式,在未来战争作战样式中,具体战术任务将由无人装备执行,人将从作战的各个任务和环节中解脱出来,聚焦到战术和战役指挥上。该方式具有作战人员零伤亡、作战持续能力强、规模化生产、全寿命周期成本低等特点,能够替代有人机执行“远程、高危、大规模、低烈度、长时、枯燥”等任务。

自主航行是无人艇遂行各项任务的基础,满足自主航行感知需求是无人感知系统主要功能。长距离自主航行作业对感知系统的需求按工作场景,可大致划分为复杂水域和开阔水域。其中,复杂水域包括:离靠泊阶段、进出港阶段的狭水道、海峡、近海繁忙水域场景。开阔水域为航渡和任务过程中的目标较少的区域。其中,复杂水域主要为进出港阶段港口码头受限水域和繁忙水域航行阶段。该阶段主要特点为船舶交通流量大,进出港水道航道狭窄但海况较为良好;开阔水域目标较少,但气象环境复杂多变,存在高海况、雨雪、大雾等不良天气。为保证自主航行系统在全航程的正常工作,无人艇感知系统应充分利用雷达和光电2个主要传感器,开展深度信息融合,解决海上全过程环境态势感知难题。

雷达目标识别是从目标的雷达信号回波特征中提取能反映目标属性信息的特征,由机器根据一定的判别准则对目标做出类别或型号判决。然而,水面目标密集分布、数量众多、种类繁杂、运动状态多样多变、海杂波干扰复杂等因素严重降低了目标特征提取的鲁棒性;雷达目标特性数据不完备、可信度低,人工设计的识别特征复杂环境、适应性差等问题进一步限制了目标识别算法的工程推广能力和性能提升。基于视觉的水面目标检测方法的研究主要集中于检测算子的优化以及图像增强等方面,以求对目标更准确的识别。然而,在实际应用场景下,视觉的目标检测方法无法获得目标的具体位置等信息,因此面对大范围的海上目标侦测,纯视觉的方法难以采集到关键目标,且识别出的目标信息对实际的导航等行为无法提供有效的帮助。

为了解决海面目标识别的难题,本文采用多模态融合的思想,将雷达探测与光电探测2种不同模态的信息融合处理,同时获得目标的位置信息和类型信息,在低信噪比的环境下降低雷达虚警率,从而提升水面目标检测的准确率和效率,经试验验证,在图像匹配准确率、目标与海杂波分类准确率和目标识别类型等方面均能满足应用需求。

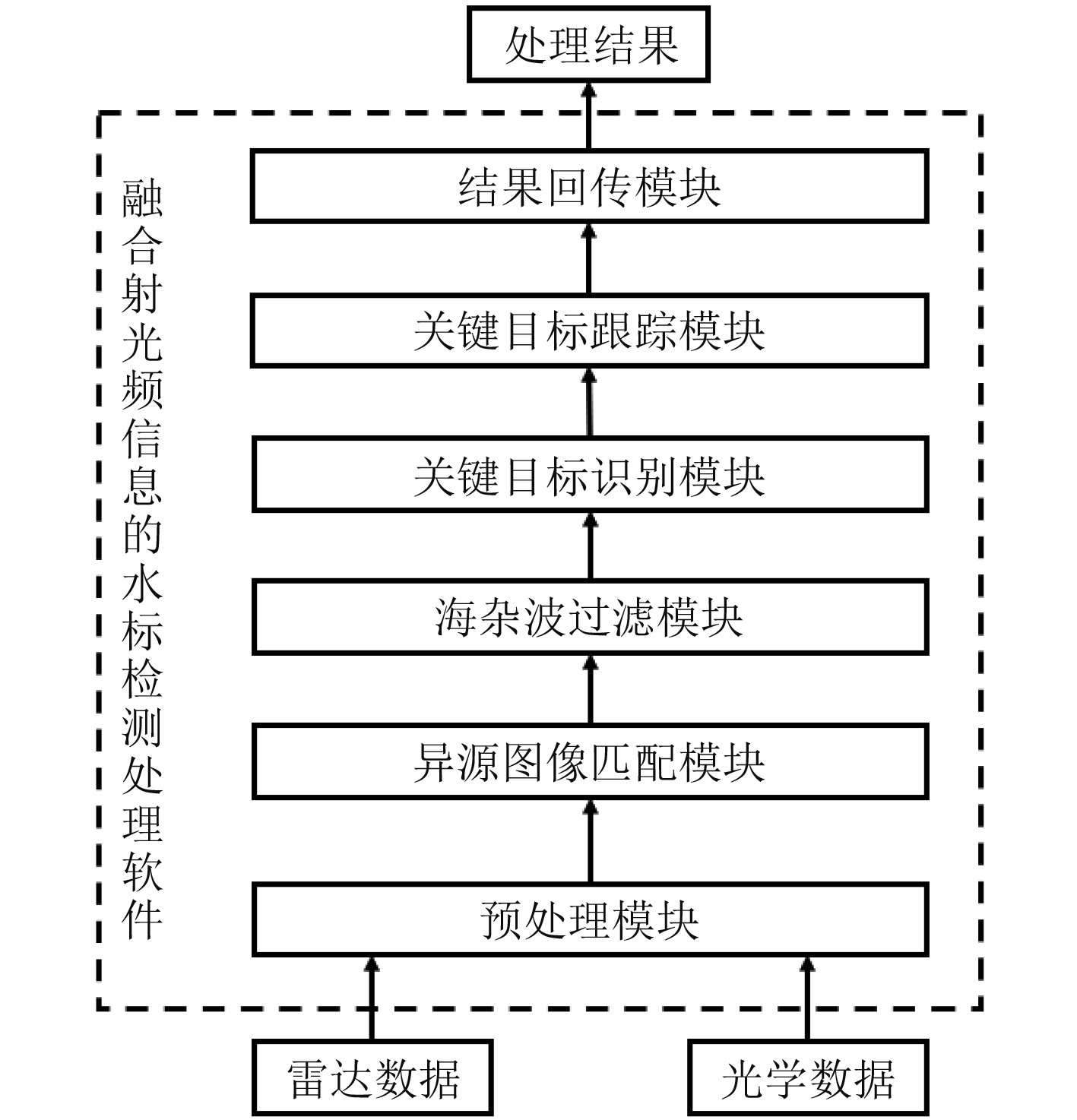

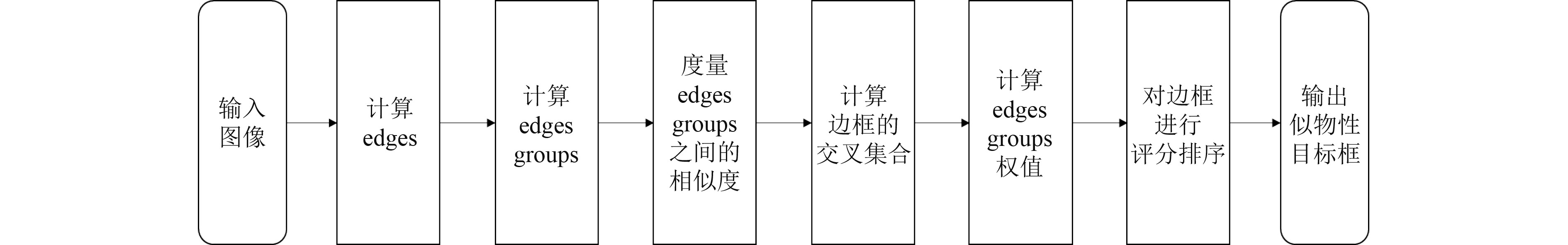

1 系统框架设计本文设计对融合射光频信息的水面目标检测处理软件。软件划分为6个模块,分别是:预处理模块、异源图像匹配模块、海杂波过滤模块、关键目标识别模块、关键目标跟踪模块、结果回传模块。系统的技术架构图如图1所示。

|

图 1 系统框架图 Fig. 1 System framework |

预处理模块负责对雷达视频数据和光学视频数据进行帧率对齐和采样,保证异源图像匹配模块对同一时刻的异源视频数据进行处理。

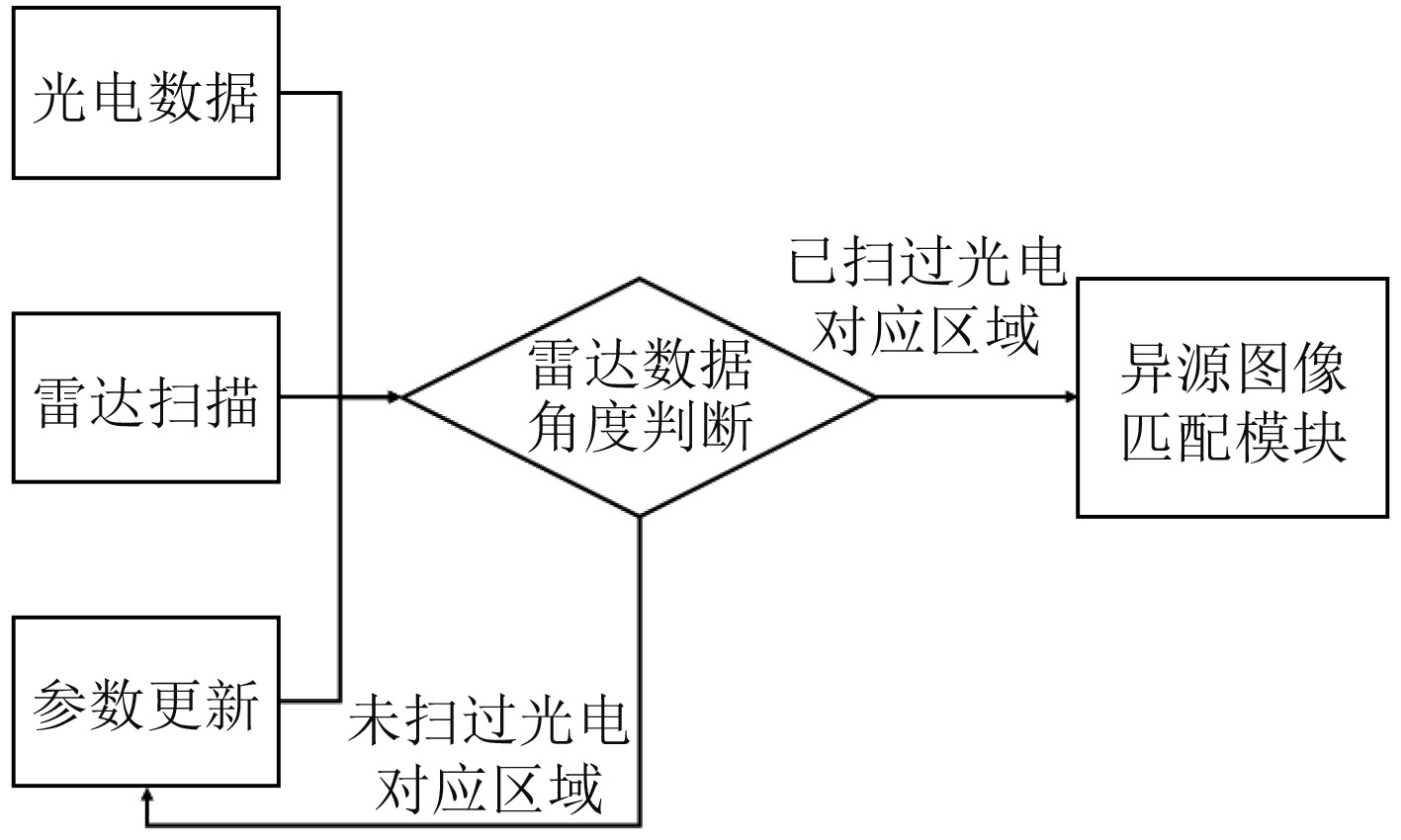

预处理模块在执行之前需要对雷达扫描的角度进行判断。雷达扫描角度为360°,扫描的方式是一条半径绕着圆心旋转,本模块对雷达扫描的角度进行判断,只有雷达半径刚刚扫过光电设备对应的区域才将雷达数据的物体点映射到光电图像上,雷达扫描其他区域时则通过物体追踪的方法确定物体位置。预处理模块的工作流程如图2所示。首先预处理模块从传感器获取光电数据和雷达数据以及其他的相关参数,包括圆心像素坐标、圆的像素直径等;通过对雷达扫描角度进行判断可知当前是否扫过了光电数据的检测区域;若扫过,则对区域进行矩形划分以及目标位置的提取,否则对参数进行相应更新。

|

图 2 预处理模块处理流程图 Fig. 2 Flow chart of pretreatment module processing |

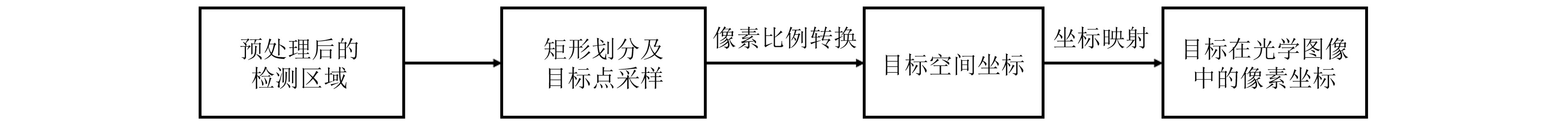

异源图像匹配模块负责雷达数据和光学数据的融合,结合雷达数据提供的目标位置信息和其他传入的位置参数,获得目标在真实世界的实际位置,根据世界坐标系和像素坐标系的转换,将雷达反映的目标和光学数据中反映具体物体对应起来。

对于本文研究来说,需要匹配的异源图像是雷达数据和光电图像,雷达数据可检测到大量疑似物体,用一些点表示这些物体的位置,并将这些点坐标映射到光电图像中,最后由后续的物体检测及物体追踪确定物体位置。流程图如图3所示。

|

图 3 异源图像匹配模块流程图 Fig. 3 Flow chart of heterogenous image matching module |

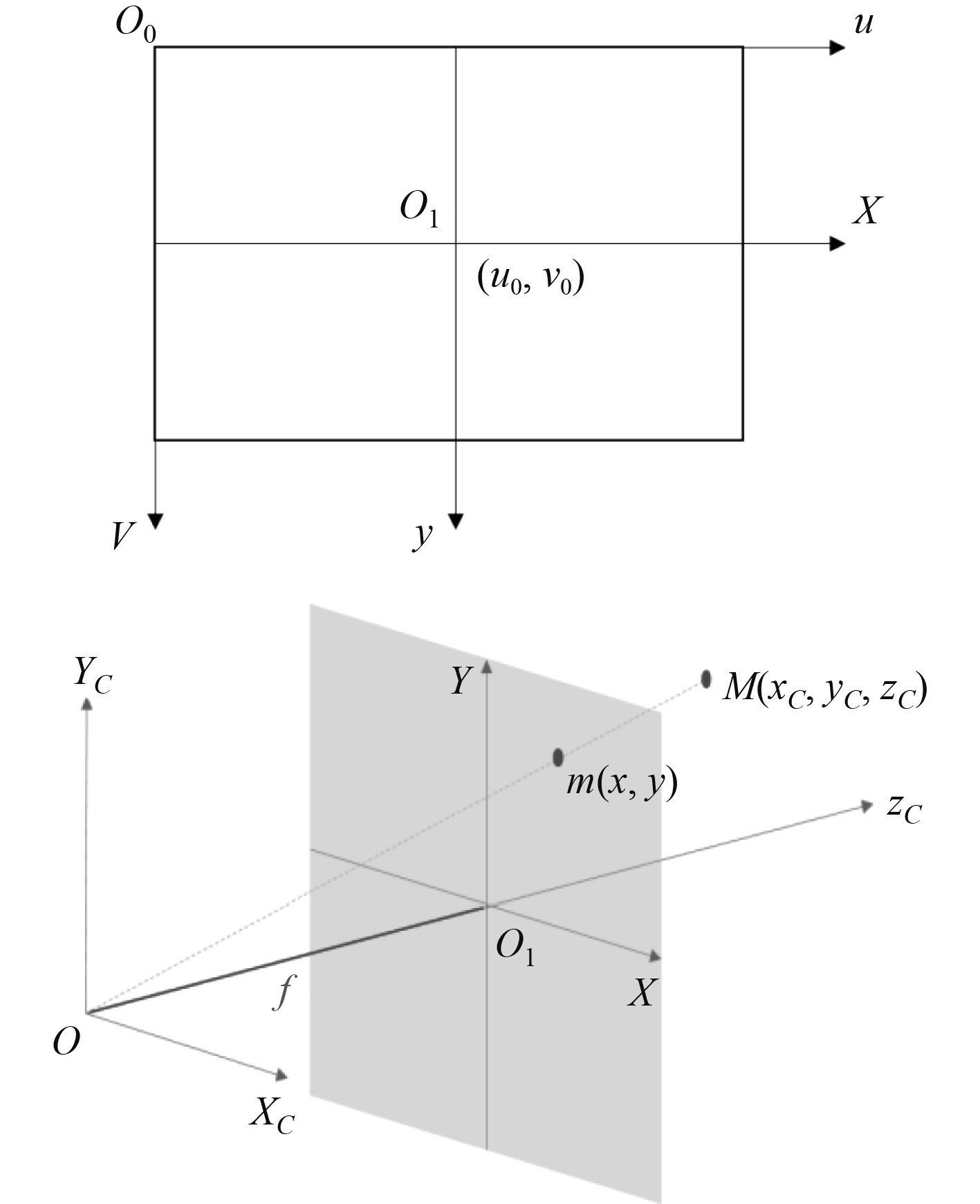

对雷达数据采用划分方格的方式采集特征点,并统计方格内黄色像素的数目,达到阈值后认为该方格有物体,取这些黄色像素坐标的中心作为这个方格中物体的坐标点。雷达图与光电图映射的技术是本模块的核心,其本质上是相机坐标系与像素坐标系的转换,需要先将相机坐标系转换为图像坐标系,再将图像坐标系转换为像素坐标系,如图4所示。

|

图 4 像素坐标系和图像坐标系 Fig. 4 Pixel coordinate system and image coordinate system |

像素坐标系和图像坐标系的转换关系为:

| $ \left\{\begin{array}{c}u=\dfrac{{x}}{{{\rm{d}}}{x}}+{{u}}_{0},\\ v=\dfrac{{y}}{{{\rm{d}}}{y}}+{{v}}_{0},\end{array}\right. $ | (1) |

图像坐标系和相机坐标系的转换关系如下:

| $ \left\{\begin{array}{c}\dfrac{x}{f}=\dfrac{{X}_{C}}{{Z}_{C}},\\ \dfrac{y}{f}=\dfrac{{Y}_{C}}{{Z}_{C}},\end{array}\right. $ | (2) |

用矩阵表示转换后,像素坐标系和相机坐标系的转换关系如下:

| $ \left[\begin{array}{c} {{u}}\\ {{v}}\\ 1\end{array}\right]=\dfrac{1}{{{Z}}_{{C}}}\left[\begin{array}{ccc}\dfrac{1}{{{\rm{d}}x}}& 0& {{u}}_{0}\\ 0& \dfrac{1}{{{\rm{d}}y}}& {{v}}_{0}\\ 0& 0& 1\end{array}\right] \left[\begin{array}{cccc}{{{f}}}& 0& 0& 0\\ 0& {{{f}}}& 0& 0\\ 0& 0& 1& 0\end{array}\right] \left[\begin{array}{c}{{X}}_{{C}}\\ {{Y}}_{{C}}\\ {{Z}}_{{C}}\\ 1\end{array}\right] 。$ | (3) |

像素坐标中的(u,v)正是光电图像中对应的像素坐标,即传给下一步物体检测的输入,因此匹配模块只需要获得物体在相机坐标系中的坐标即可。

1.3 海杂波过滤模块海杂波过滤模块在获得雷达数据中的疑似目标位置后,根据异源图像融合结果,获取其在光学数据对应的位置,对这些位置周围的光学数据进行采样,并对采样生成的区域进行似物性估计,判断该区域内是否存在物体,保留可能包含关键目标的候选区域,过滤不包含目标的其他区域。

由于物体在光学数据中与背景会有较为明显的边缘,可以通过检测目标区域是否有边缘存在判断目标区域内是否有物体,即若在雷达信号对应区域内检测到边缘,则认为该雷达信号为关键目标,反之则认为该信号为杂波信号。

Edge Boxes似物性估计算法由微软研究院的Piotr等在2014年ECCV上提出,其设计思路是基于图像中目标边缘所产生的轮廓信息,计算框内包含的以及与框边缘重叠的轮廓个数,如果目标框内包含的轮廓信息越多,则该框包含目标的可能性也越大,然后对所有的潜在目标框打分排序,实现目标区域的粗略估计。在现有的似物性估计方法中,Edge Boxes能够较好检测出多种形状的物体,具有一定的尺度自适应性,并具有较高的运算速度。其整体流程如图5所示。

|

图 5 Edge Boxes算法流程图 Fig. 5 Flowchart of Edge Boxes algorithm |

在关键目标识别模块中实现YOLOv3算法进行关键目标的识别。

YOLOv1发表于CVPR2016,其核心想法是将整张图像作为神经网络输入,创造性地将候选区域提取和分类结合,使用一个端到端的网络直接在输出层回归目标框的位置以及所属的类别。2017年,YOLOv2在YOLO的基础上进行改进,采用darknet-19作为基础网络,舍弃了原先使用的drop out策略,采用Batch Normalization降低过拟合,BN层的加入还可以提升模型的收敛速度。

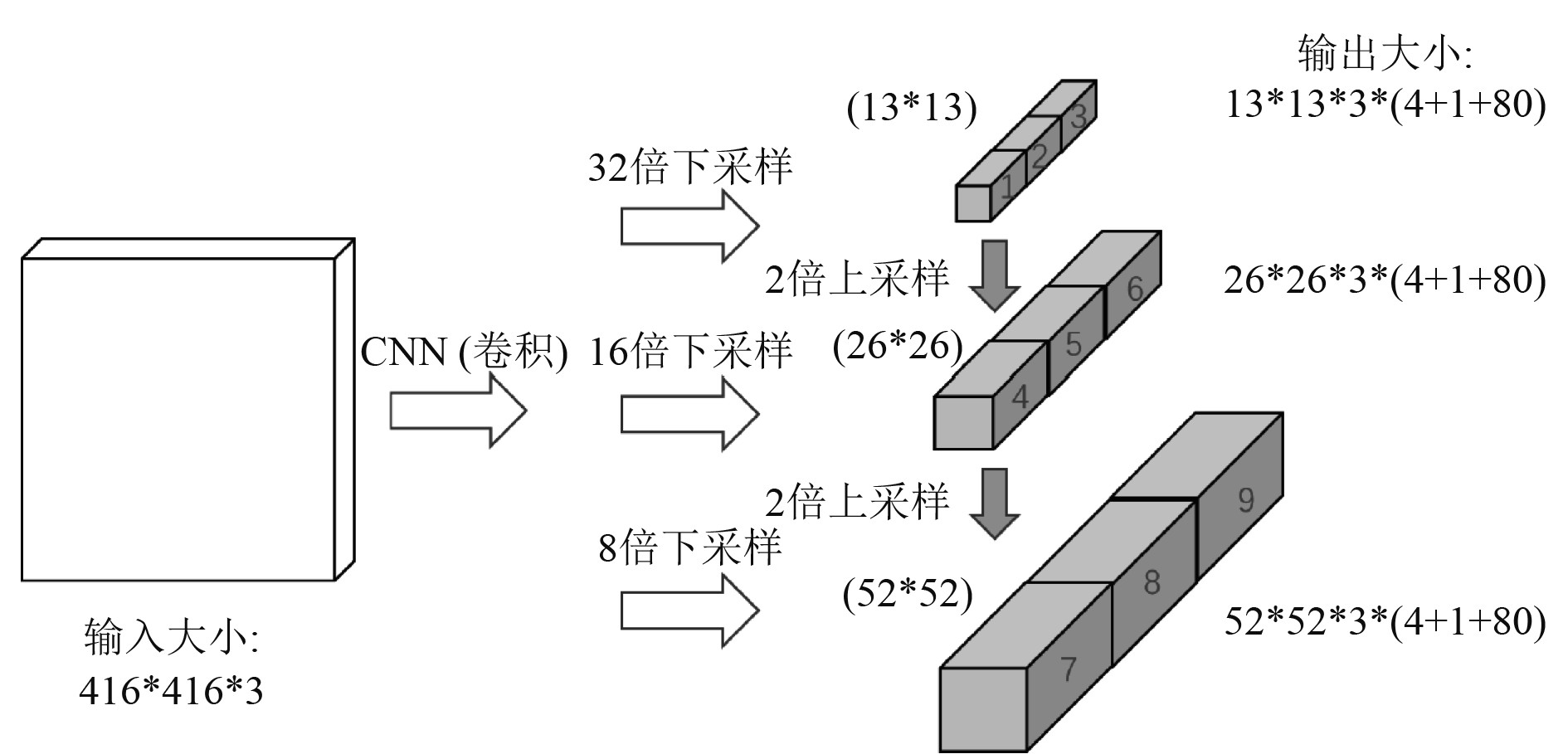

2018年,为了实现更好的分类性能,在先前实验和YOLOv2基础上提出了YOLOv3,图6为YOLOv3多尺度特征检测的映射关系图,设计3个不同的尺度,在特征图上进行多尺度检测,分别为32倍采样,16倍采样和8倍采样,每个对应不同的感受野,32倍降采样的感受野最大,适用于大目标检测,16倍降采样感受野适中,适用于一般大小的目标,8倍降采样感受野较小,适用于小目标检测。为了进一步提升算法性能,对于不同尺寸的特征图分别给出聚类得到的3个尺度先验框,共9个。

|

图 6 YOLOv3输入输出映射关系图 Fig. 6 YOLOv3 input output mapping relationship |

最后,通过上采样将不同深度的特征进行融合连接。其中损失函数改为logistic函数对输出进行预测,可以有效地支持多标签检测。

1.5 关键目标跟踪模块关键目标跟踪模块是在识别到准确的关键目标后跟踪目标在光学数据上的位置并展示。由于雷达数据是在360°的范围内顺时针旋转进行扫描,对某一个位置的数据无法做到实时更新。因此,在雷达2次扫描的间隔时间内,通过目标跟踪模型,实时展示光学数据中关键目标的位置,反映关键目标的实时状态,弥补雷达扫描间隔产生的侦测盲区。

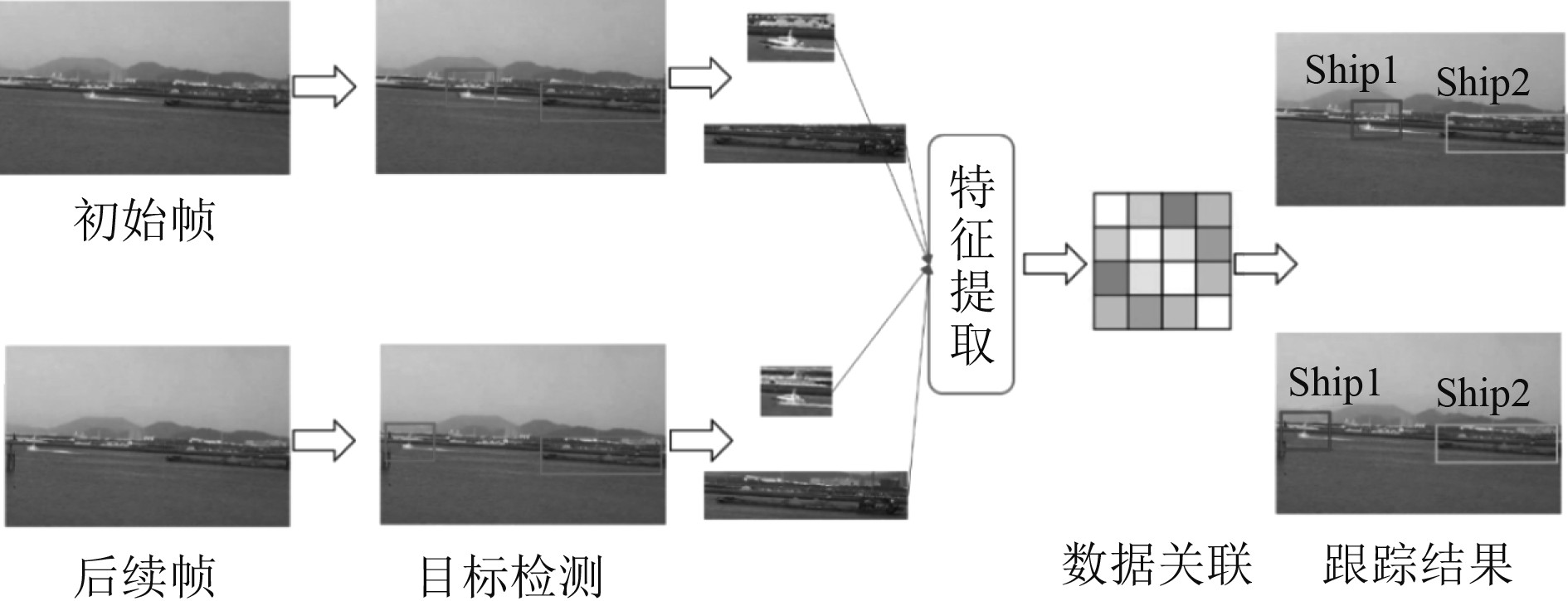

考虑到水面数据中包含多个同类目标,需要同时对多个船舶进行跟踪,所以选取多目标跟踪算法对本模块进行设计。多目标跟踪,初始框不由人为给定,让检测模型对第一帧进行检测,通常使用Tracking-by-Detection的跟踪方式,以检测的方式进行跟踪,即对每一帧或是间隔帧进行目标检测,对先前检测结果和当前结果进行数据关联,将前后帧的检测目标一一匹配,从而实现多目标跟踪,整体框架如图7所示。

|

图 7 多目标跟踪框架图 Fig. 7 Multi target tracking framework |

大致的工作流程如下:

1)标定视频序列的初始帧;

2)运用目标检测器获取对象的边界框;

3)对于每一个检测到的对象进行特征提取,包含视觉特征和运动信息;

4)计算2个对象的相似度,是同一个目标的概率;

5)进行数据关联,为每个对象分配特定的ID编号。

1.6 结果回传模块结果回传模块的功能主要是将处理得到的关键目标的位置、类型等信息进行整合和回传。其中,位置相关的信息主要通过雷达数据获取,目标的类型通过对光电数据进行识别得到,经过异源图像匹配模块的工作将两部分内容一一对应起来,由结果回传模块输出每一帧的处理结果。

结果回传模块中的信息以字典形式传输目标和信息的键值对,关键目标识别模块从异源图像匹配模块中获得目标的实际位置信息,在完成识别处理后获得目标的类型信息,这两类信息输出至结果回传模块。结果回传模块以每个目标的类别为键,以该目标对应的实际距离和方位信息为值将一帧图像中的所有目标存储为一个字典进行回传,并通过界面进行展示。

2 试验验证情况 2.1 图像匹配准确率测试在11个视频上进行,不计算重复出现的目标点,总计有322个待匹配目标点,将映射在对应相应目标上的点作为映射正确的匹配点,正确映射点的数量为301个,总体的识别准确率为93.48%。表1展示了每一段视频中包含的待匹配点数量和正确匹配的点的数量。

|

|

表 1 异源图像匹配模块在测试数据的匹配效果表 Tab.1 The matching effect of heterogenous image matching module in test data |

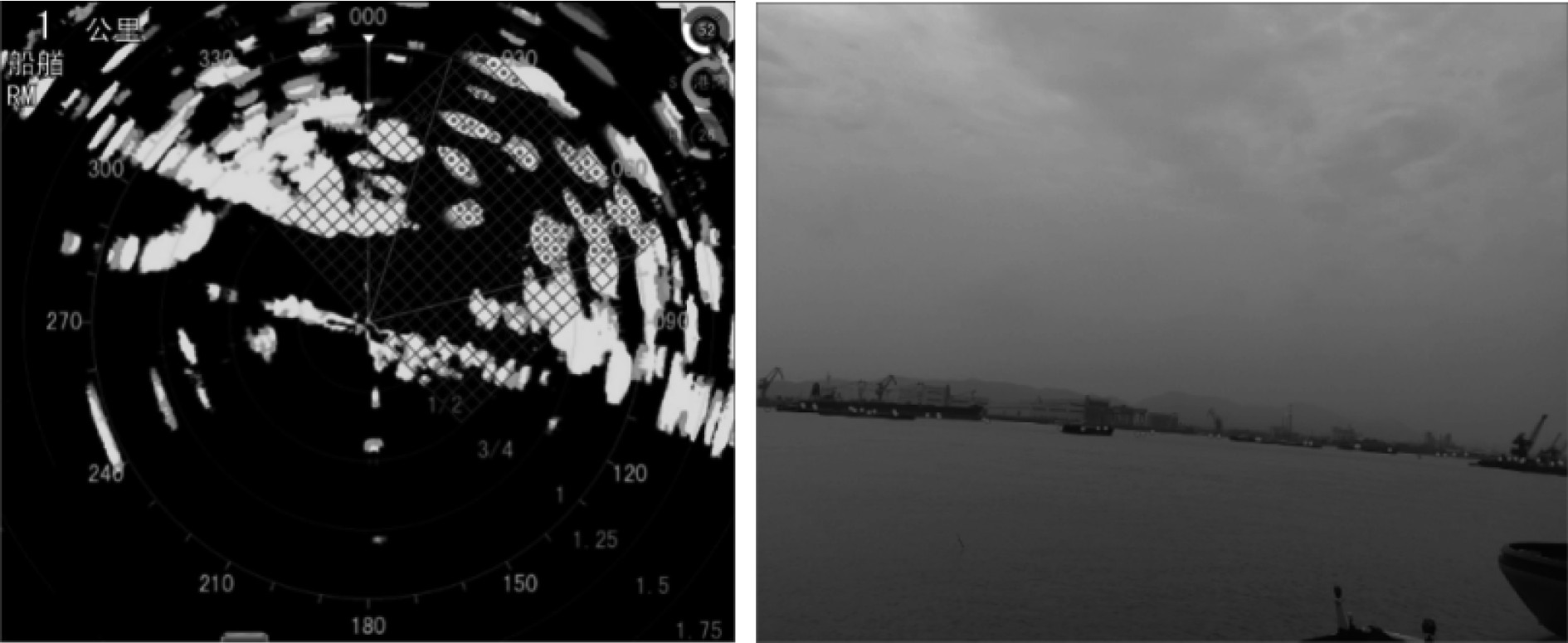

图8为异源图像匹配的效果示例。其中,左侧为从雷达图像中获得的待匹配目标点情况,右侧为目标点在光电图像上的映射效果。

|

图 8 1000 m量程下的异源图像匹配效果 Fig. 8 The matching effect of different source images in 1000 m range |

测试在11个视频上进行,通过目标点生成候选框并进行抑制,总计有322个似物性估计候选框,将目标与海杂波分类正确的候选框作为分类正确的数量,正确分类的数量为301个,总体的识别准确率为93.48%。表2展示了每一段视频中包含的候选框数量和分类正确的数量。

|

|

表 2 海杂波过滤模块在测试数据的匹配效果表 Tab.2 The matching effect of sea clutter filtering module in test data |

测试在11个视频上进行,总计有102个关键目标,将检测正确的次数占总检测次数50%以上的目标作为正确识别目标,正确识别的目标数量为82个,总体的识别准确率为80.39%。表3展示了每一段视频中包含的关键目标数量以及识别正确的关键目标数量。

|

|

表 3 测试数据的识别情况表 Tab.3 Identification of test data |

图9为关键目标识别的效果示例。其中,框内点为雷达图像中关键目标点迹在光电图像中映射的对应位置,存在框内点的位置表示疑似存在关键目标,检测成功的关键目标将使用不同颜色方框表示,未框出方框的点区域即为经过检测不存在关键目标。

|

图 9 海面目标识别效果图 Fig. 9 Treatment effect of sea clutter filtering |

本文以雷达回波信号为基础,结合光学数据,使用视觉方法将雷达数据和光学数据进行融合,利用两者提供的数据信息出去海杂波的干扰,并获得海面关键目标的类别和位置信息,通过实现三维空间到像素坐标系的映射方法,将雷达数据的目标位置转换为光学数据的像素坐标。实现了雷达数据和光学数据的异源图像匹配;采用似物性估计技术对雷达数据中疑似目标位置附近的光学数据进行分析,实现了海杂波过滤;对异源图像融合处理后保留的关键目标,由视觉方法进行识别,获得关键目标的类型信息,实现了关键目标的识别。集成以上各项功能,形成完整的融合射光频信息的水面目标检测方法,能够有效降低低信噪比环境下雷达虚警率,同时获得目标的位置信息和类型信息。经试验数据验证,本文方法可以提升水面目标检测的准确率和效率。

| [1] |

杨勇虎. 基于雷达信息的海上溢油与小目标识别方法[D], 大连: 大连海事大学, 2018.

|

| [2] |

高铮, 张安清. 海杂波典型幅度分布模型的仿真分析[J]. 舰船电子工程, 2018, 38(9): 76-78+94. |

| [3] |

LI Weibo, ZHANG Youzhi, ZHANG Guangyi. Sea Clutter Simulation Research based on Lognormal Distribution[C]. 信息化与工程国际学会: 计算机科学与电子技术国际学会(Computer Science and Electronic Technology International Society), 2016: 555–558.

|

| [4] |

宋希珍. 海杂波幅度分布参数矩估计和恒虚警检测[D], 西安: 西安电子科技大学, 2014.

|

| [5] |

张国栋. 基于海杂波混沌特性的杂波抑制的研究[D], 大连: 大连海事大学, 2019.

|

| [6] |

关泽文, 陈建文, 鲍拯. 一种改进的基于峰值信噪比-高阶奇异值分解的天波超视距雷达自适应海杂波抑制算法[J]. 电子与信息学报, 2019, 41(7): 1743-1750. |

| [7] |

CALLAGHAN D, BURGER J, MISHRA A K. A machine learning approach to radar sea clutter suppression[C]. IEEE Radar Conference, 2017.

|

2022, Vol. 44

2022, Vol. 44