2. 中国科学院 机器人与智能制造创新研究院,辽宁 沈阳 110169;

3. 中国科学院大学,北京 100049

2. Institutes for Robotics and Intelligent Manufacturing, Chinese Academy of Sciences, Shenyang 110169, China;

3. University of Chinese Academy of Sciences, Beijing 110049, China

岛岸地形构建是海洋调查的重要内容。水面无人艇因其体积小、重量轻、吃水浅、机动性强、可无人化作业等优点,非常适合在岛岸浅水区等复杂水域环境作业[1]。水面无人艇搭载感知传感器获取岛岸环境感知数据,雷达、视觉等传感器在水面无人艇环境感知中都有所应用。

4G宽频雷达因其感知范围广,具备全天候全时段感知能力,被广泛应用于水面无人艇的环境感知。但和激光雷达相比,其感知分辨率有限,感知精度低,仅为二维感知数据。同时,由于电磁波传播的特性和物体的非理想散射,4G宽频雷达感知数据易受海杂波、噪声、多径的影响,自身感知频率低,感知畸变严重。视觉和激光雷达可以获得丰富的环境纹理信息和三维环境结构,感知频率高,感知畸变小,但易受光照、天气的影响。因此基于多传感器的感知融合成为水面无人艇环境感知的研究热点。

LI等[2]为了解决波浪、雾、背景杂波等环境因素对目标检测的影响,基于小波变换采用平均融合策略对预处理后的视觉图像与雷达图像进行了融合处理。Chen等[3]采用加权ELM方法实现水面无人艇雷达感知信息与单目立体视觉系统感知信息的感知融合,该融合方法在总体精度下降相对较小的情况下,获得了较高的g均值。Hao等[4]采用改进的mv3d深度融合方法实现了激光雷达、深度摄像机和高分辨率摄像机的感知融合,提升了水面无人艇目标检测能力。Dai等[5]为了解决海上天气以及夜间环境等因素对水面无人艇目标检测的影响,将匹配矩阵加入到融合器中实现了可见光和红外目标图像的加权平均融合。

基于水面无人艇的多传感器感知融合通常用于提升水面目标检测能力,在岛岸地形构建、三维重建等方面的研究相对较少。Han等[6]在实现水面无人艇精确定位基础上,组合多帧激光雷达和声呐的水面水下环境感知数据实现了海上浮动平台的三维重建。Papadopoulos G等[7]基于ICP扫描匹配算法,采用激光雷达对静止防波堤进行了三维重建。Leedekerken JC等[8]采用基于图优化的SLAM架构,将ICP匹配结果集成到GPS/INS组合导航系统中,使用激光雷达和声呐传感器构建了浅水环境的三维地图。这些研究均未对感知数据进行融合处理。

本文针对岛岸地形构建的任务需求,提出一种基于4G宽频雷达和激光雷达的感知融合算法,该方法充分发挥2个感知传感器的感知特性,依次在数据级和决策级进行融合处理。

1 算法概述本文使用上标的大写字母代表坐标系,定义激光雷达扫描一周为一帧数据,

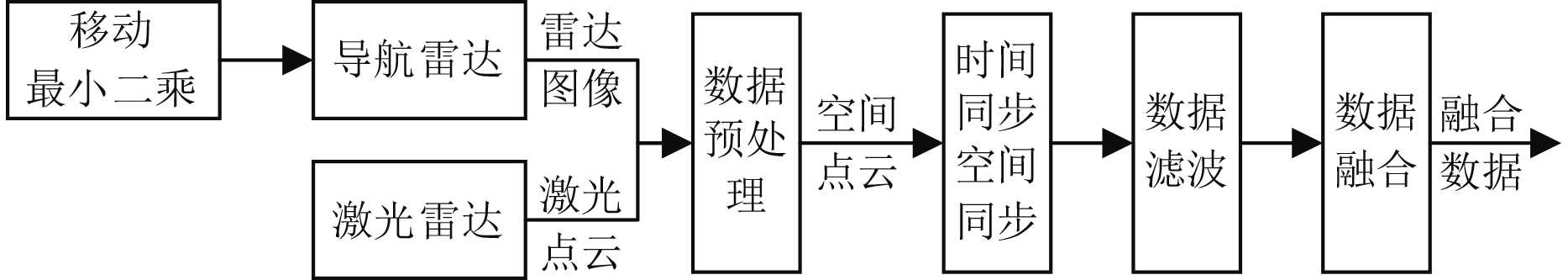

4G宽频雷达和激光雷达感知融合首先基于边缘检测,采用移动最小二乘优化4G宽频雷达感知结果,对雷达感知数据进行预处理,转换数据类型。结合2个雷达在载体平台的安装位置和工作机制,实现感知数据的时空统一。采用改进的多级滤波方法消减感知数据的环境干扰,根据提出的融合算法,融合处理感知数据。流程如图1所示。

|

图 1 多传感信息融合框图 Fig. 1 Block diagram of multi-sensor fusion |

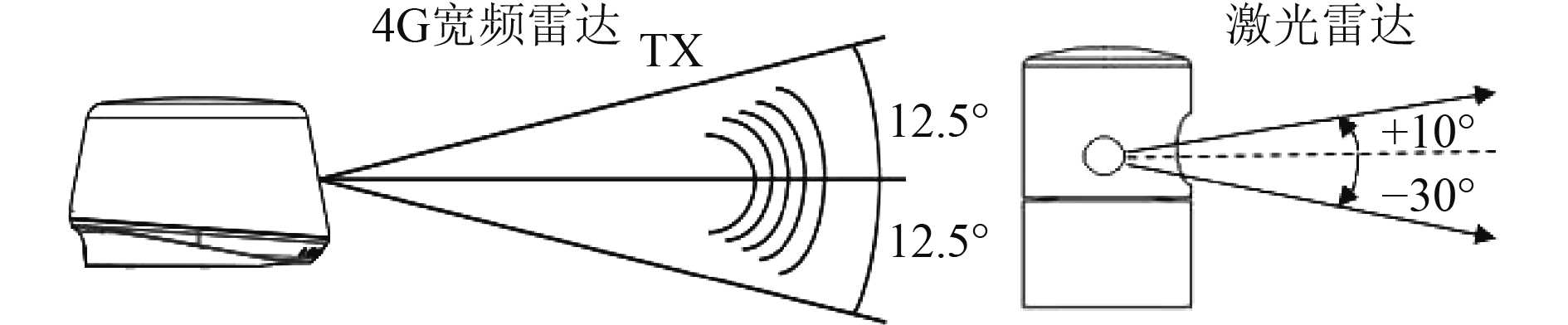

采用4G宽频雷达和激光雷达进行融合感知,2种雷达的具体参数如表1所示。4G宽频雷达和激光雷达通过固定的感知角度发射和接收感知信号,从而获取环境感知数据。图2为2种雷达的感知角度示意图。激光雷达感知角度较宽,其值域在−30°~+10°,4G宽频雷达感知角度较窄,为−12.5°~+12.5°。

|

|

表 1 4G宽频雷达和激光雷达具体参数 Tab.1 Specific parameters of broadband 4G radar and lidar |

|

图 2 雷达感知角度图 Fig. 2 Radar perception angle diagram |

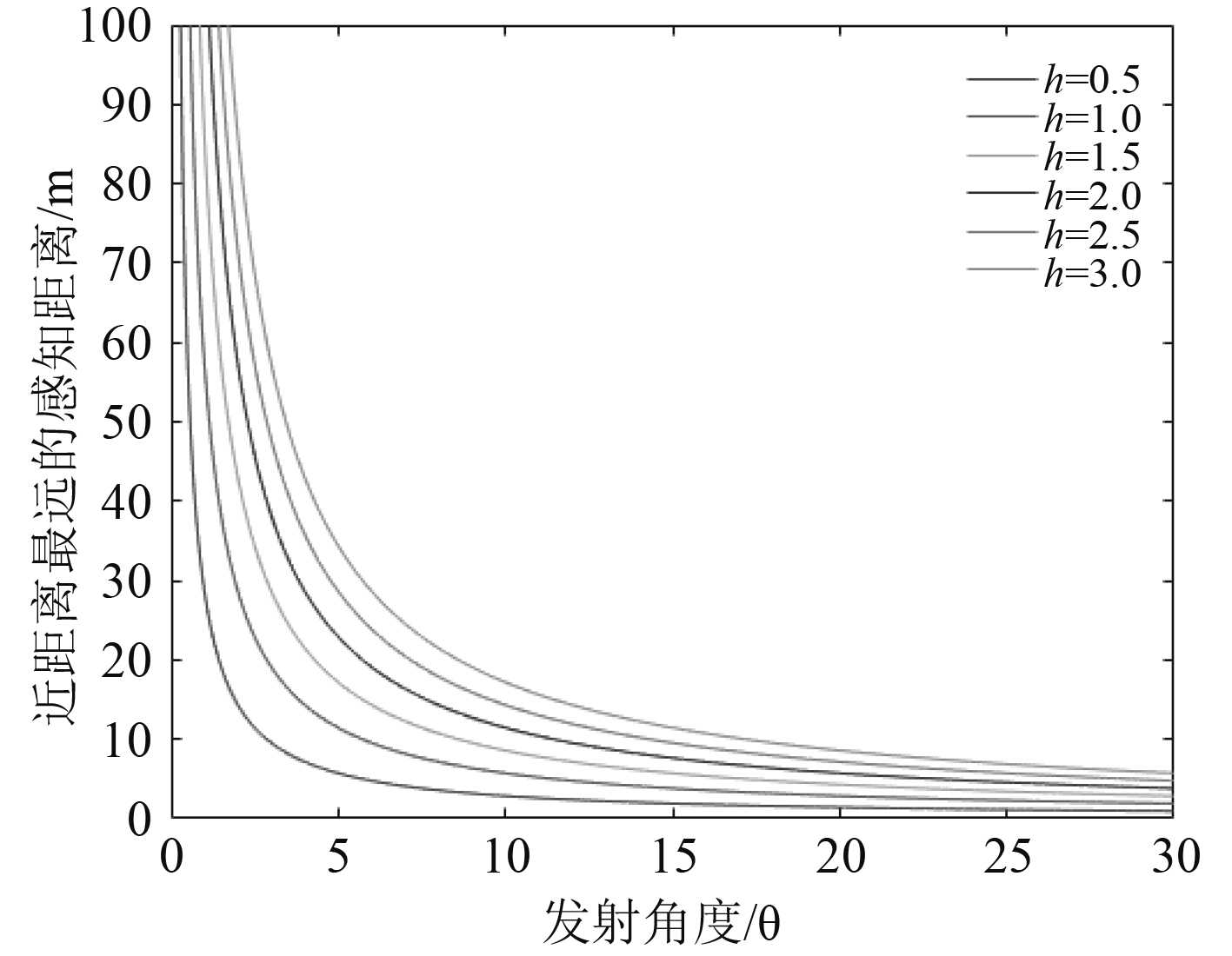

感知角度制约着雷达近距离感知能力。感知传感器固定在载体上,设其安装位置距离水面的高度为

| $ {d_{\max }} = \frac{h}{{\tan \theta }}。$ | (1) |

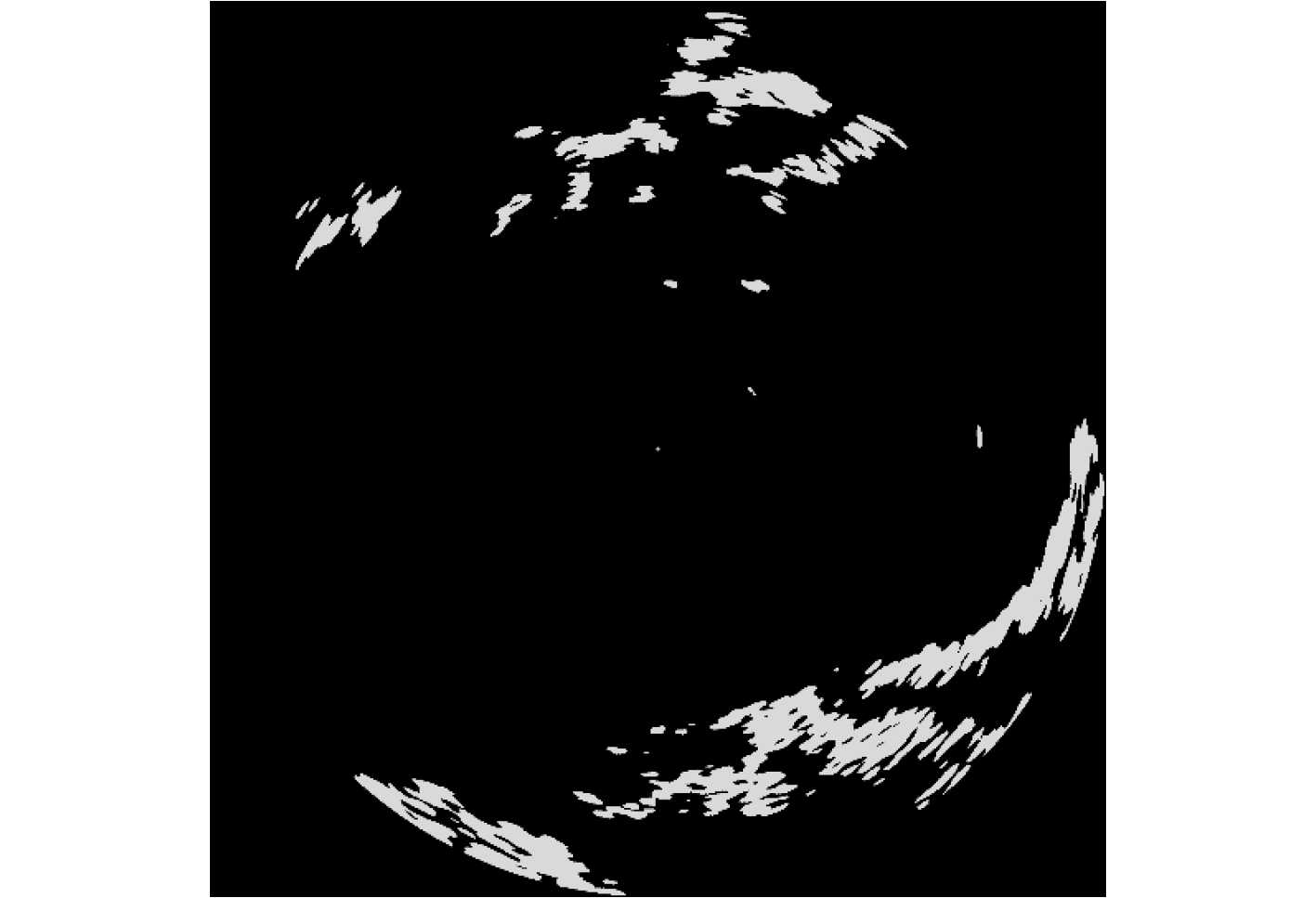

由图3可知,同一高度下,感知角度越宽,近距离感知能力越强,感知盲区越小,因此激光雷达比4G宽频雷达感知盲区小。同时4G宽频雷达感知范围比激光雷达广,但是远距离感知畸变严重,感知精度低,如图4所示。通过4G宽频雷达和激光雷达融合感知,弥补4G宽频雷达感知盲区大的不足,选择合适的融合方法和融合范围,充分发挥激光雷达感知精度高和4G宽频雷达感知范围广的特点,很好地应用于岛岸地形感知。

|

图 3 感知角度与近距离感知能力关系图 Fig. 3 Diagram of relationship between the perception angle and the short-distance perception ability |

|

图 4 4G宽频雷达感知图 Fig. 4 Broadband 4G radar perception map |

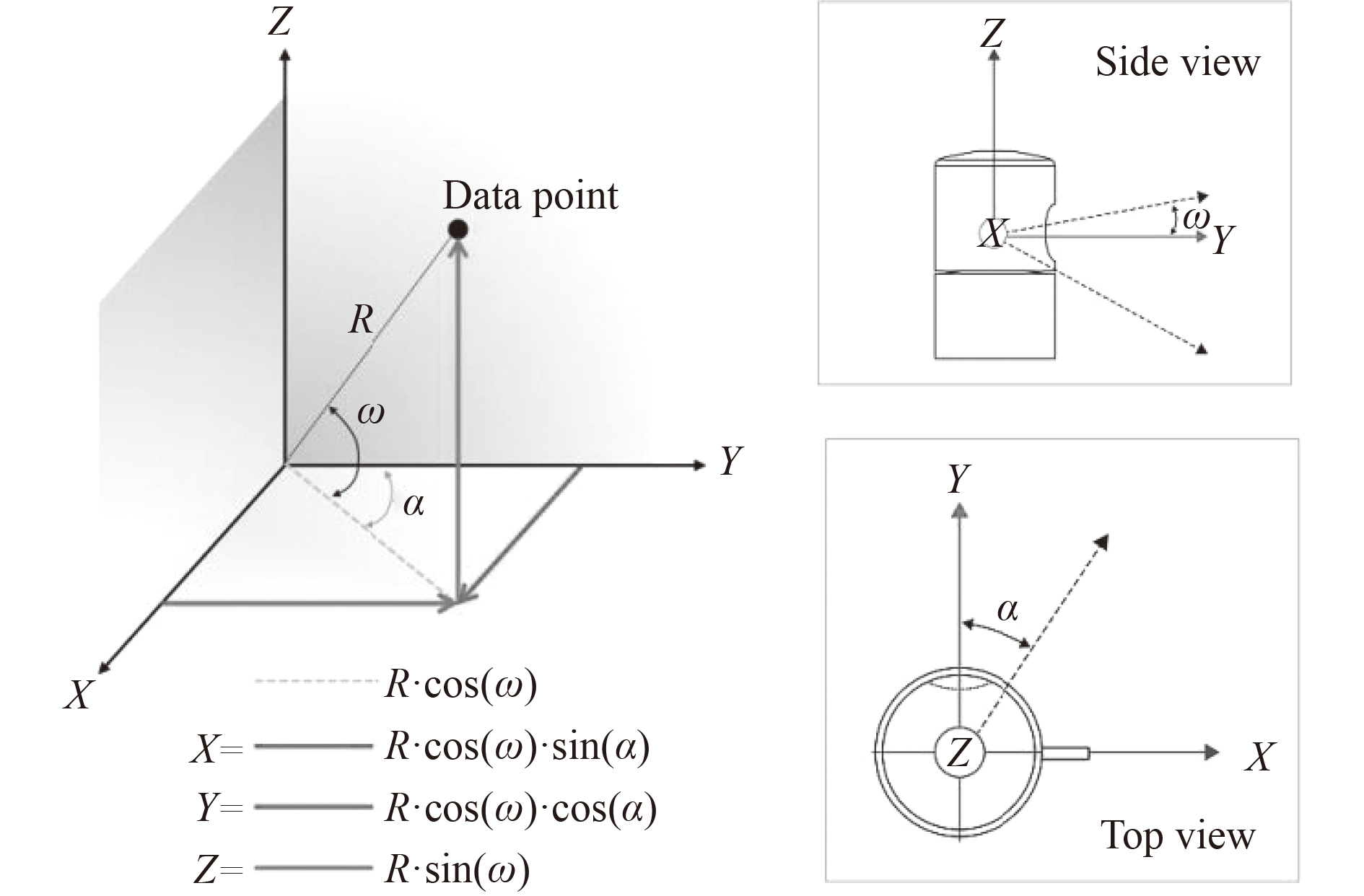

4G宽频雷达和激光雷达在数据类型以及感知精度上均存在较大差距,4G宽频雷达感知数据为二维图像数据,激光雷达感知数据为自身极坐标下的点云数据,如图5所示。两者感知数据均为空间的距离信息,采用点云化的方法实现感知数据类型的统一,既将激光雷达感知数据转化为直角坐标系下的点云数据,具体如式(2)所示,4G宽频雷达感知数据转化为空间的二维点云数据。

|

图 5 激光雷达极坐标系 Fig. 5 Lidar polar coordinate system |

| $ \left[ \begin{gathered} {x_L} \\ {y_L} \\ {z_L} \\ \end{gathered} \right] = \left[ \begin{gathered} R \cdot \cos \omega \cdot \sin \alpha \\ R \cdot \cos \omega \cdot \cos {\alpha _l} \\ R \cdot \sin \omega \\ \end{gathered} \right]。$ | (2) |

4G宽频雷达感知精度与激光雷达相差较大,点云化数据预处理导致4G宽频雷达点云数据相对离散。为了优化感知结果,通过边缘检测将4G宽频雷达感知图像数据分为轮廓内部点

| $ \left[ \begin{gathered} {x_{ic}} \\ {y_{ic}} \\ \end{gathered} \right] = \left[ \begin{gathered} {x_c} \pm i \cdot {d_l} \\ {y_c} \pm i \cdot {d_l} \\ \end{gathered} \right]。$ | (3) |

式中:

对于轮廓点

| $ {y_{i{c'}}} = f({x_{{c'}}} \pm i \cdot {d_l})。$ | (4) |

式中:

|

图 6 4G宽频雷达感知数据处理前后对比 Fig. 6 Comparison of Broadband 4G radar sensing data before and after processing |

在多传感器感知系统中,各传感器由于自身感知特点以及载体安装位置的不同,导致各传感器的感知数据存在时空的不一致性,需要将各传感器感知数据统一到同一时空坐标系下,既进行时空配准,时空配准是多传感器感知融合重要环节。

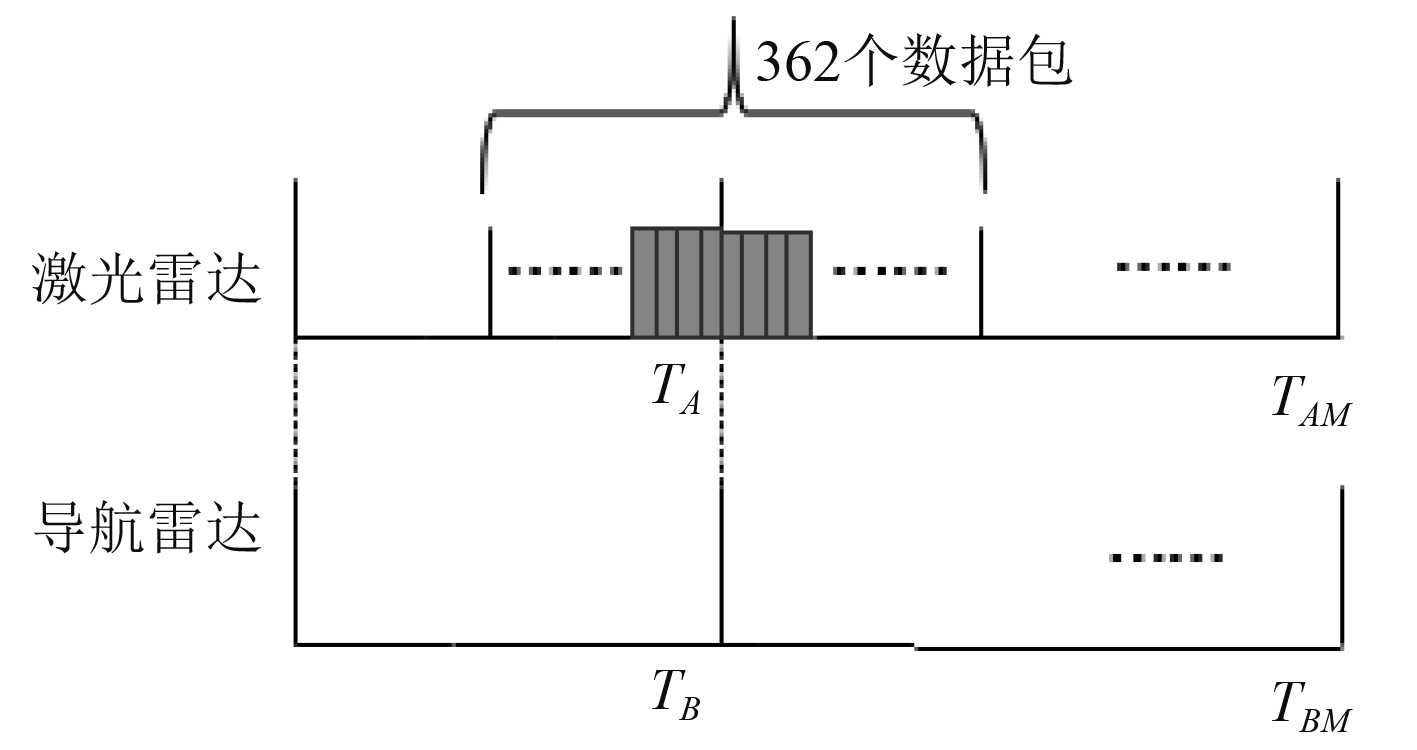

对于时间配准,基于多核CPU的硬件支撑,结合多线程并行机制,对4G宽频雷达和激光雷达感知数据进行同时接收。由于4G宽频雷达感知频率低于激光雷达,因此采用激光雷达向4G宽频雷达配准。2个雷达感知数据均保留了准确的感知时刻信息,且激光雷达感知数据由多个带有时间标签的感知数据包组成,根据时间信息,以4G宽频雷达感知时刻为基准,基于最小时间差,实现二者的时间同步,如图7所示。

|

图 7 时间同步示意图 Fig. 7 Time synchronization diagram |

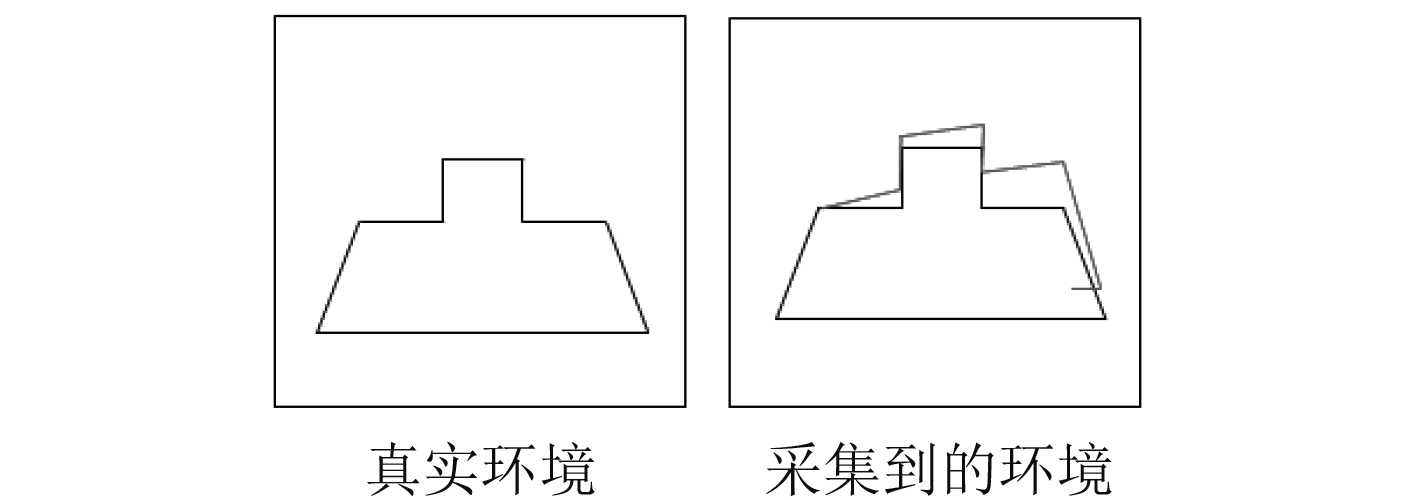

由于激光雷达的工作原理,每个激光点云数据均存在时间上的不同步性,同时雷达感知环境时伴随着载体的不断运动,使得感知数据产生感知畸变,如图8所示。

|

图 8 感知畸变 Fig. 8 Perceptual distortion |

采用运动补偿来修正激光雷达的感知畸变,将其分为位移补偿和方位补偿。设激光雷达相邻2个点云数据的感知时间差为

| $ \Delta l = \vartheta \cdot \Delta t,$ | (5) |

方位补偿为

| $ {X'} = X \cdot M(\omega \Delta t)。$ | (6) |

其中,

由于4G宽频雷达和激光雷达在载体上有固定的安装位置,可以很方便地获得变化矩阵。激光雷达感知精度高,将4G宽频雷达感知数据转化到激光雷达坐标系下,实现空间配准。

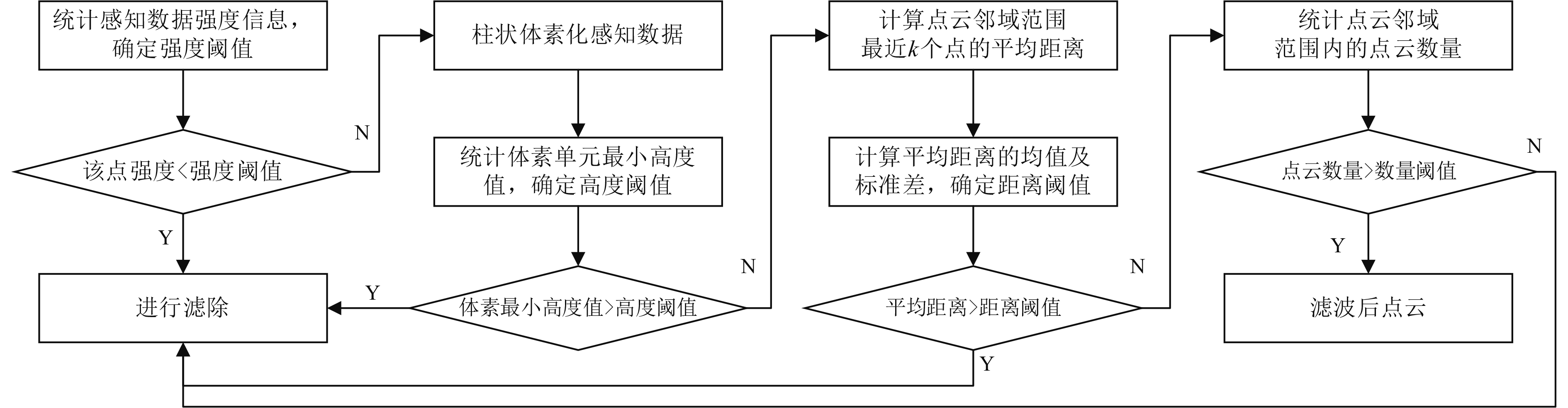

2.4 数据滤波4G宽频雷达感知水面环境易受海杂波、噪声等干扰的影响,激光雷达受到天气环境影响容易产生悬空点等干扰,因此需要对感知数据进行滤波处理。在数据预处理阶段,以边缘检测所提取的4G宽频雷达感知数据轮廓面积数据为依据,将检测到轮廓面积较小的目标判定为虚假目标进行去除。针对激光雷达点云数据,采用多级滤波的方法进行处理,以获得纯净的点云。

激光雷达数据包含点云的位置、距离、反射强度等信息,可以很好地应用于数据滤波处理。为了消除水浪对点云数据的影响,对感知数据的强度信息进行统计分析,确定强度阈值,完成初级滤波。

针对天气环境等因素导致激光雷达感知数据存在的悬空点,柱状体素化感知点云数据,统计每个柱状体素单元内点云数据的最小高度值,确定高度阈值,用于去除悬空点。由于噪声、杂波等因素的影响会产生位置上比较孤立且分散的点云,因此利用位置关系对点云数据进行再次滤波。搜索点云邻域范围内距离最近的

|

图 9 多级滤波流程图 Fig. 9 Multi-stage filtering flowchart |

通过多级滤波对一帧激光雷达数据进行处理,各级点云数量变化如表2所示。

|

|

表 2 点云数量变化表 Tab.2 Change table of the number of point clouds |

多传感器数据融合从融合的层次进行分类,可以分为数据级融合、特征级融合、决策级融合。数据级融合旨在通过原始数据组合,以生成更丰富的感知数据。特征级融合是指对原始数据进行特征或目标信息的提取,组合获得多方面的特征数据。决策级融合是在每个传感器做出决策的基础上,汇总所有决策确定执行方案。岛岸地形构建旨在通过感知数据对岛岸地形进行重构,重在感知数据的原始处理,因此采用数据级融合的方式实现4G宽频雷达和激光雷达的感知融合。4G宽频雷达以面的方式感知岛岸环境,相对于激光雷达点云数据,可能更接近真实的岛岸边界。为了进一步优化融合感知效果,结合激光雷达感知点云邻域范围内的4G宽频雷达感知数据,对激光雷达感知数据进行决策级的感知优化。

根据激光雷达和4G宽频雷达的感知特点、性能以及载体对感知数据的影响,确定2种传感器的融合范围

融合后的数据

| $ {X_F} = {X_{\left( {L,i} \right)}} + \frac{1}{N}\sum\limits_{j = 1}^N {\left( {1 - \frac{{{d_{diff}}}}{{{d_F}}}} \right)\left( {{X_{\left( {R,j} \right)}} - {X_{\left( {L,j} \right)}}} \right)} 。$ | (7) |

式中:

由于4G宽频雷达感知频率低,且工作时伴随着载体的运动,因此会产生感知畸变,使得感知到的岛岸环境存在较大的失真。为了解决该问题,在同一方位角度上,通过激光雷达感知数据对4G宽频雷达感知数据进行优化选择,在保证感知能力不变的情况下,对近距离感知数据进行优化。具体总结如下:

| $ X_Y^R = \left\{ \begin{gathered} \phi \;\;\;\;\;{\rm{if}}\;\;\;{d_p} < {d_{\min }} ,\\ {X_R}\;\;{\rm{if}}\;\;\;{d_p} \geqslant {d_{\min }} 。\\ \end{gathered} \right. $ | (8) |

式中:

为了验证本文算法的有效性,通过水面无人艇搭载4G宽频雷达和激光雷达在松花湖进行现场试验。试验区域如图10所示,通过手持GPS对试验区域的岛岸经纬度数据进行采集,如图11所示。

|

图 10 试验区域 Fig. 10 Test area |

|

图 11 岛岸经纬度数据采集 Fig. 11 Longitude and latitude data collection of island shore |

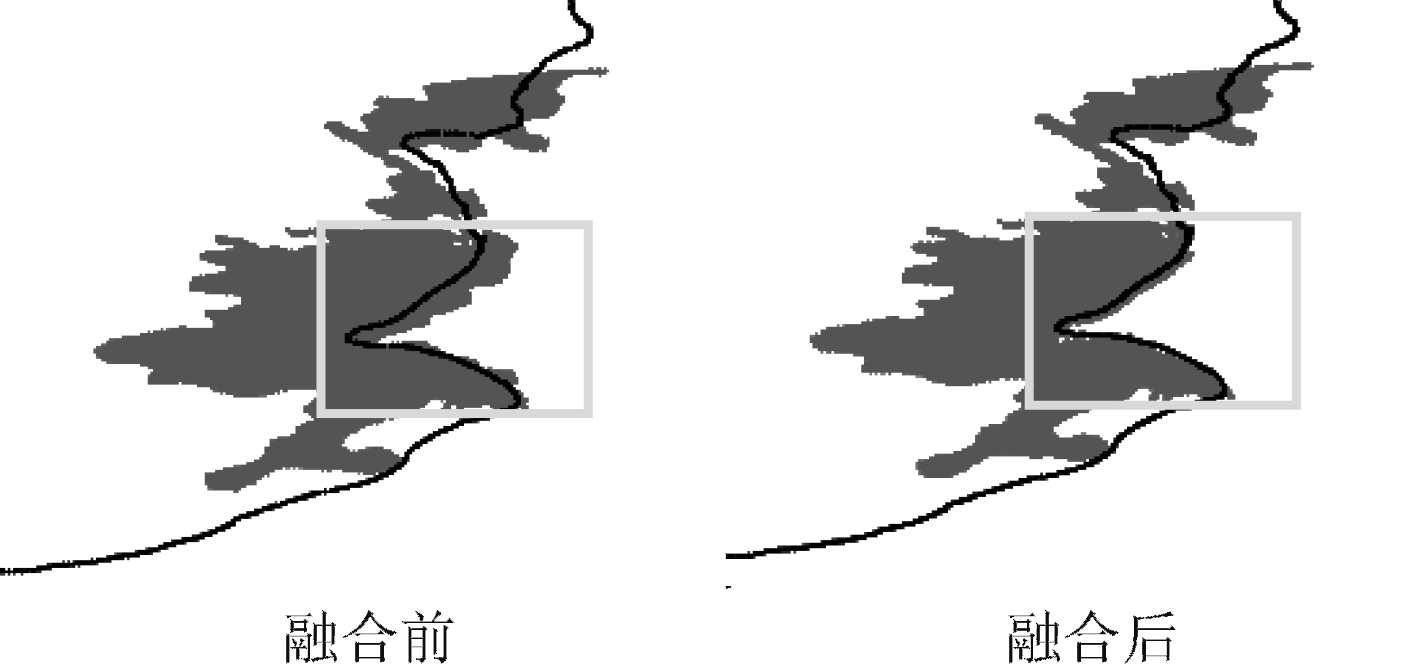

通过4G宽频雷达和激光雷达采集岛岸环境信息,如图12所示,进行感知数据的融合处理,融合前后对比如图13所示。图中线段为手持GPS采集的岛岸经纬度数据,点云为融合后的感知点云数据,方框标注的区域为兼具4G宽频雷达和激光雷达2种感知数据的岛岸区域。在2个雷达感知融合的交集区域,感知融合后的岛岸边界更加接近岛岸真实边界,同时4G宽频雷达较远的感知距离,也使得水面无人艇可以较早的感知到远距离的岛岸环境。

|

图 12 岛岸感知数据 Fig. 12 Island-shore perception data |

|

图 13 融合前后对比图 Fig. 13 Comparison chart before and after fusion |

为了定量分析融合结果,对感知交集区域融合前后的岛岸边界经纬度数据进行提取,采用绝对经纬度数据的均方根误差来评估融合前后的感知精度。

| $ RMSE = \sqrt {\frac{1}{N}\sum\limits_{i = 1}^N {{{\left( {{p_p} - {p_G}} \right)}^2}} } 。$ | (9) |

式中:

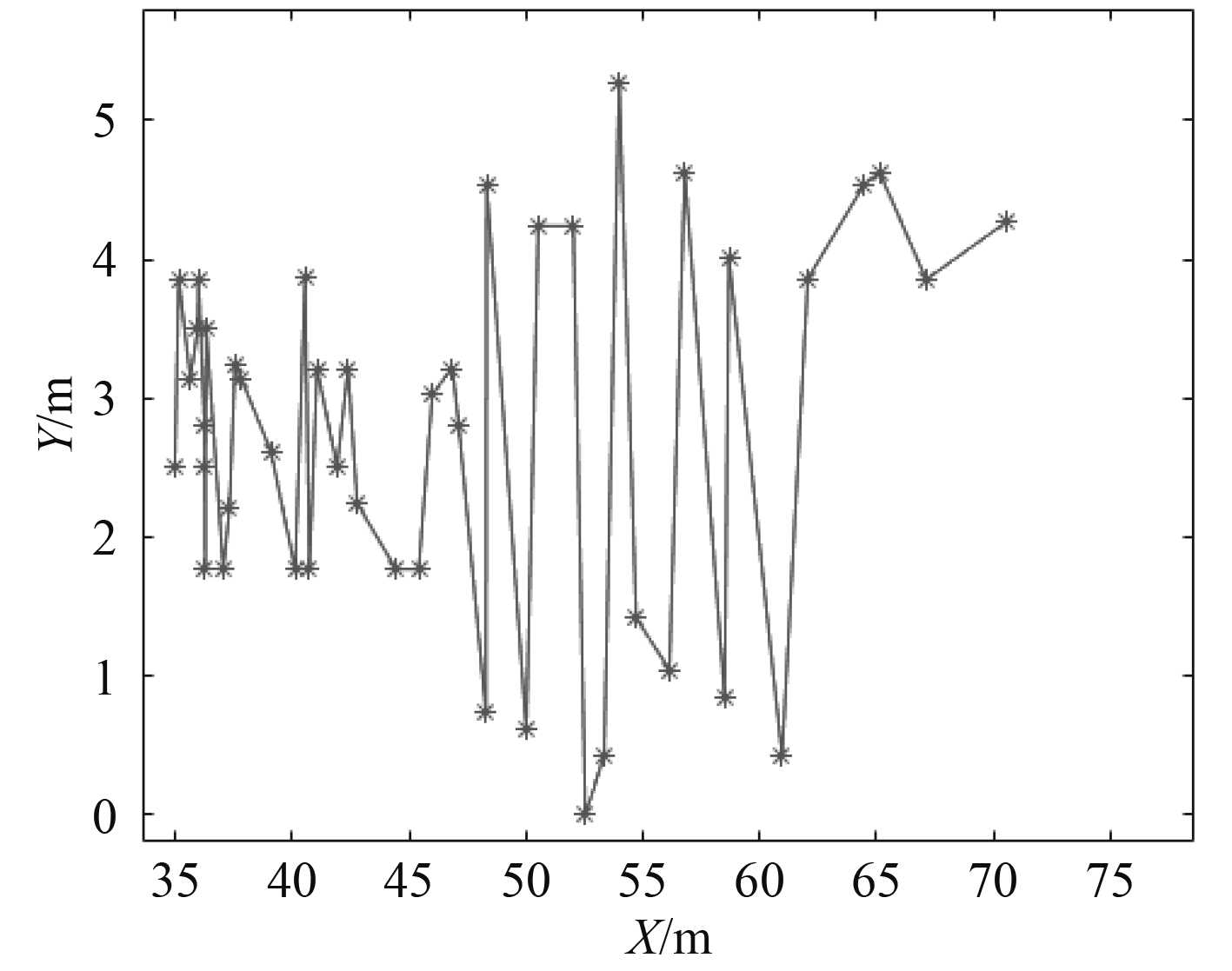

为了进一步评估融合感知的结果,对不同时刻感知数据中同一岛岸数据点的感知结果进行统计,计算感知数据点与岛岸数据点的距离差值,统计结果如图14所示。使用式(9)进行计算评估得到,点位误差为3.130 m。结合手持GPS的定位精度为5 m,水面无人艇自身定位精度为3 m,可以得出不同距离下,对同一点的定位精度在误差允许的范围内。

|

图 14 不同距离下同一岛岸点定位结果 Fig. 14 Location results of the same island shore point at different distances |

4G宽频雷达是水面无人艇主要的感知传感器,由于其自身感知能力和特点的限制,应用于岛岸地形构建时,感知构建精度低。激光雷达感知精度高,但感知距离近,通过将4G宽频雷达和激光雷达进行有效的感知融合,大幅度提升了水面无人艇岛岸地形感知的能力。基于多线程并发的机制实现时间同步,将移动最小二乘应用于感知数据的预处理阶段,优化4G宽频雷达的感知数据。通过改进的多级滤波机制,减少噪声、杂波等干扰对激光雷达感知数据的影响。通过本文提出的数据融合方法,实现感知传感器在数据级和特征级的多级融合,提升了岛岸感知能力。通过试验验证了融合算法的有效性,可以很好地应用于岛岸地形构建。

| [1] |

方中华, 褚宏宪, 冯京, 等. 无人船艇在海洋地质调查中的应用及展望[J]. 海洋地质前沿, 2020, 36(3): 72-77. |

| [2] |

LI Dahui, FAN Qi, CUI Jianzhao, et al. Research on target detection algorithm of radar and visible image fusion based on wavelet transform[J]. Tehnički vjesnik, 2020, 27(5).

|

| [3] |

CHEN J , WANG H. An obstacle detection method for USV by fusing of radar and motion stereo[C]//2020 IEEE 16th International Conference on Control & Automation (ICCA). IEEE, 2020.

|

| [4] |

HAO L, JIE N, LIU Y. A multi-modality sensor system for unmanned surface vehicle[J]. Neural Processing Letters, 2020, 52(2).

|

| [5] |

DAI Xuefeng, ZHAO Jianqi, LI Dahui. Effective detection by fusing visible and infrared images of targets for unmanned surface vehicles[J]. Automatika -Journal for Control Measurement Electronics Computing & Communications, 2018, 59(3): 324-331. |

| [6] |

HAN J, JINWHAN K. Three-dimensional reconstruction of a marine floating structure with an unmanned surface vessel[J]. IEEE Journal of Oceanic Engineering, 2018, 1-13. |

| [7] |

PAPADOPOULOS G, KURNIAWATI H, SHARIFF A. Experiments on surface reconstruction for partially submerged marine structures[J]. Journal of Field Robotics, 2014, 31(2): 225-244. DOI:10.1002/rob.21478 |

| [8] |

LEEDEKERKEN J C, FALLON M F, LEONARD J J. Mapping complex marine environments with autonomous surface craft[J]. Springer Tracts in Advanced Robotics, 2013, 79: 525-539. |

| [9] |

顾天奇, 罗祖德, 胡晨捷. 测量数据的曲线曲面拟合算法[J]. 东北大学学报: 自然科学版, 2021, 42(3): 408–413.

|

2022, Vol. 44

2022, Vol. 44