图神经网络(graph neural network,GNN)是一种流行的图形数据学习表示工具,包括但不限于社交网络、分子图和知识图[1]。GNN比传统的决策树的逻辑推理更具有效性[2-4]。基于图神经网络的水下无人系统智能决策,是针对水下无人系统集群实际应用的特殊需求,如通信受限、多任务、复杂多变环境等约束,为了满足水下无人系统集群智能的决策需求,采用认知推理理论,运用图神经网络方法解决水下无人系统集群智能实现过程中存在的智能决策问题。集群智能决策主要是基于“约束—集群—环境”的认知推理,并在实时交互环境中实现集群的任务分配策略、任务执行策略的推理决策。

人工智能强化学习(reinforcement learning,RL)领域是基于知识表示、认知学习实现智能推理决策的,当前的强化学习方法在关系型问题推理和约束动态推理上存在很多不足[5]。所以,根据领域最新的研究成果,基于图神经网络的强化学习方法是实现关系型问题推理和约束动态推理的研究方向之一[6]。

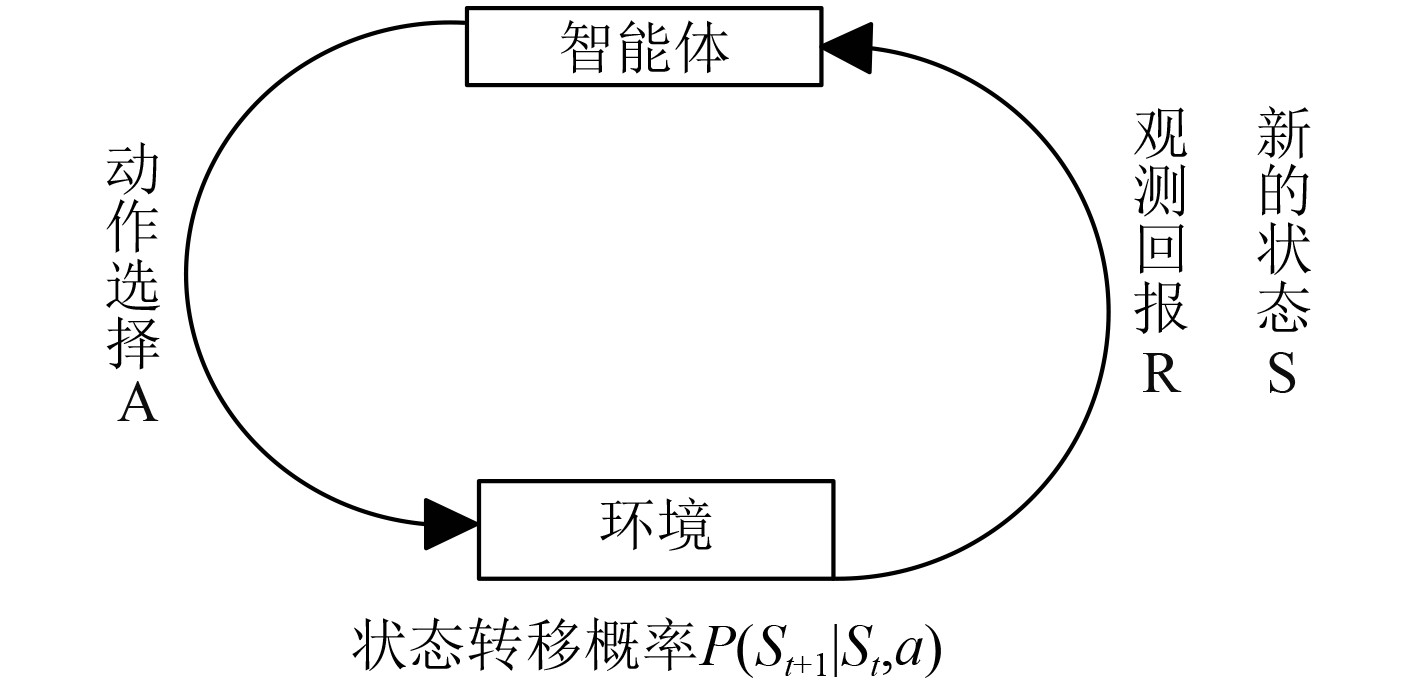

强化学习的基本思想是智能体(Agent)在与环境交互的过程中根据环境反馈得到的奖励不断调整自身的策略以实现最佳决策,主要用来解决决策优化类的问题。其基本要素有策略、回报函数、值函数、环境模型,学习过程可以描述为如图1所示的马尔科夫决策过程。强化学习基本学习模型首先智能体感知当前状态

| $\begin{split} & {{\pi} ^ * } = \arg {\max _{\text{π}} }E\left\{ {\sum\limits_{k = 0}^\infty {{\gamma ^k}{r_{t + k}}|{S_t} = S} } \right\}, \\ & \forall {S_t} \in S,\forall t \geqslant 0 \text{。} \end{split} $ | (1) |

|

图 1 强化学习基本框架 Fig. 1 The basic framework of Reinforcement learning |

其中π表示智能体的某个策略,γ∈[0,1]为折扣率,k为未来时间步骤,S为状态空间。

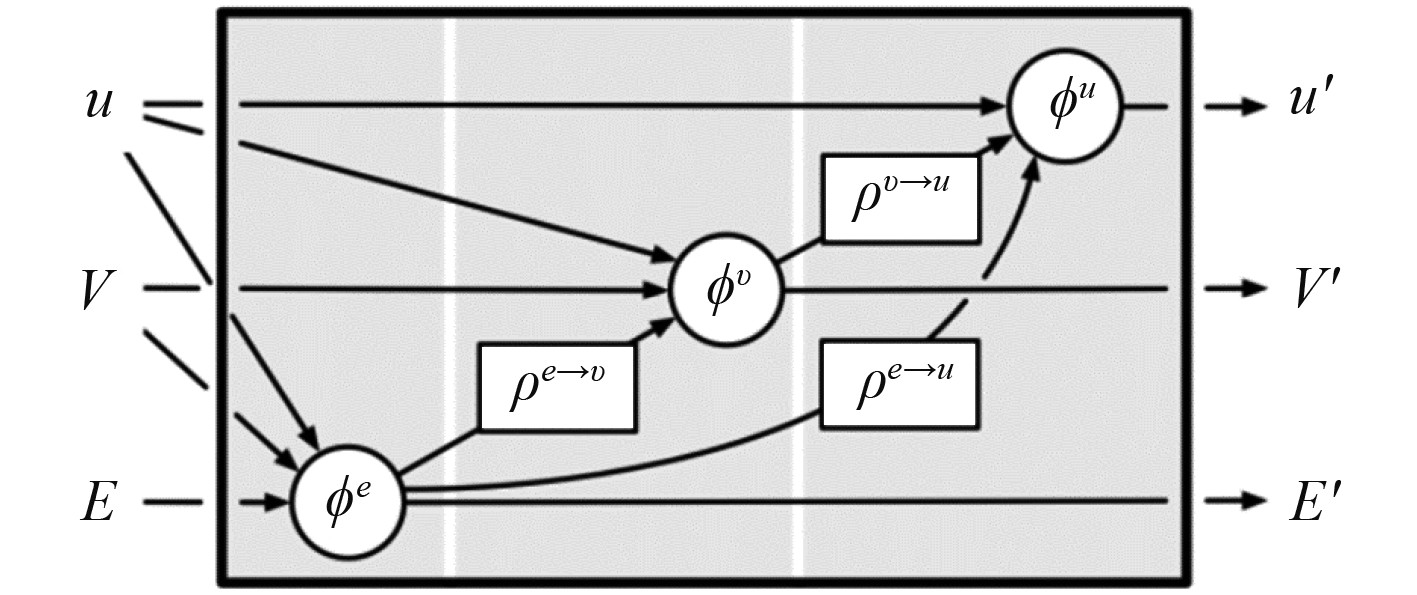

图神经网络算法理论是基于人脑认知推理决策的认知学科的推理决策模式[7]。基于GNN强化学习智能决策算法,是运用人工智能GNN算法来实现集群Agents的智能决策策略的求解,通过构建带有属性的图[顶点,边],继而通过顶点到边,边到顶点,边和顶点到全局图属性的迭代计算实现智能决策推理学习[3]。

图2为针对无人系统集群智能辅助决策系统作战应用的具体场景。首先,进行认知建模,将决策影响因素抽象成实体与关系的图。然后,根据GNN算法原理构建实体、关系,进行推理决策参数训练。

|

图 2 GNN理论模型 Fig. 2 GNN theoretical model |

基于图神经网络的无人系统集群智能强化学习研究,是在传统集群智能的基础上,将人工智能-强化学习技术融合进去,主要采用的是连结主义核心思想(见表1),采用最新的图神经网络算法理论,实现无人系统集群的智能的推理决策、模型训练、经验学习,进一步提高无人系统集群智能程度[8]。

|

|

表 1 人工智能实现方法主要流派 Tab.1 The main schools of artificial intelligence implementation methods |

航行器节点属性矩阵

顶点属性更新边的属性,边是有方向的,接收顶点矩阵与发出点矩阵通过对应回报计算函数给当前有向边属性进行赋值,表示当前逻辑连接关系的回报。通过对应的预先设定的回报计算函数来进行任务←

| ${G_t} = f\left( {{U_{t - 1}},{T_{t - 1}},{C_{t - 1}},{G_{t - 1}}} \right)\text{。}$ | (2) |

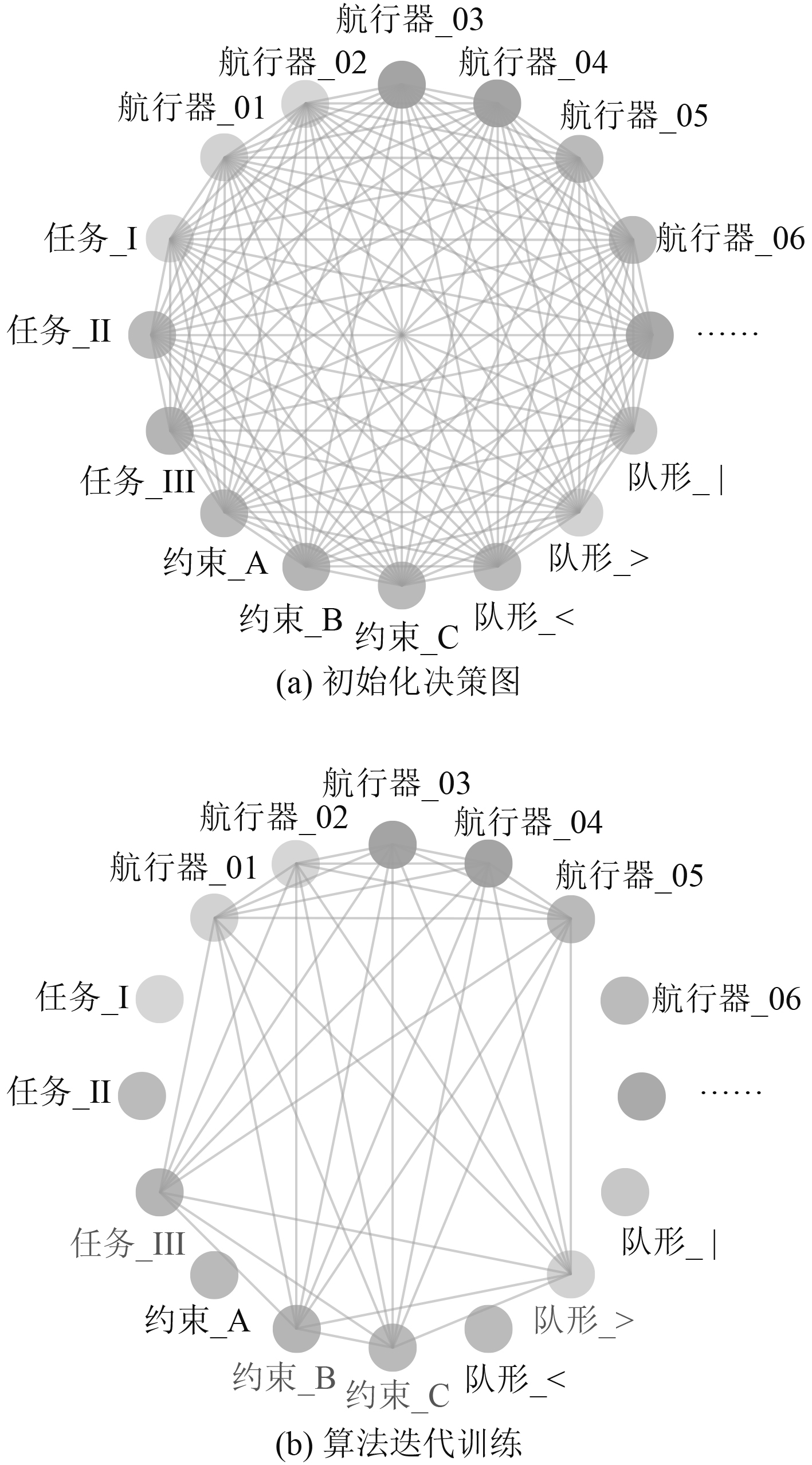

图3(a)为基于GNN的水下无人系统智能决策的决策表示,决策图中顶点分别表示在一次智能决策中所有的任务、约束、航行器、队形等需要进行决策和影响决策的信息。图3(b)为在初始化的决策图的基础上,通过决策算法1的强化学习迭代求解对决策图的顶点属性、边属性、全局图属性进行了一定程度的更新,直至最终算法迭代终止,完成一次基于GNN的水下无人系统智能决策的强化学习,并根据强化学习结果给出对应的最优智能决策的策略。

|

图 3 决策训练 Fig. 3 Decision training |

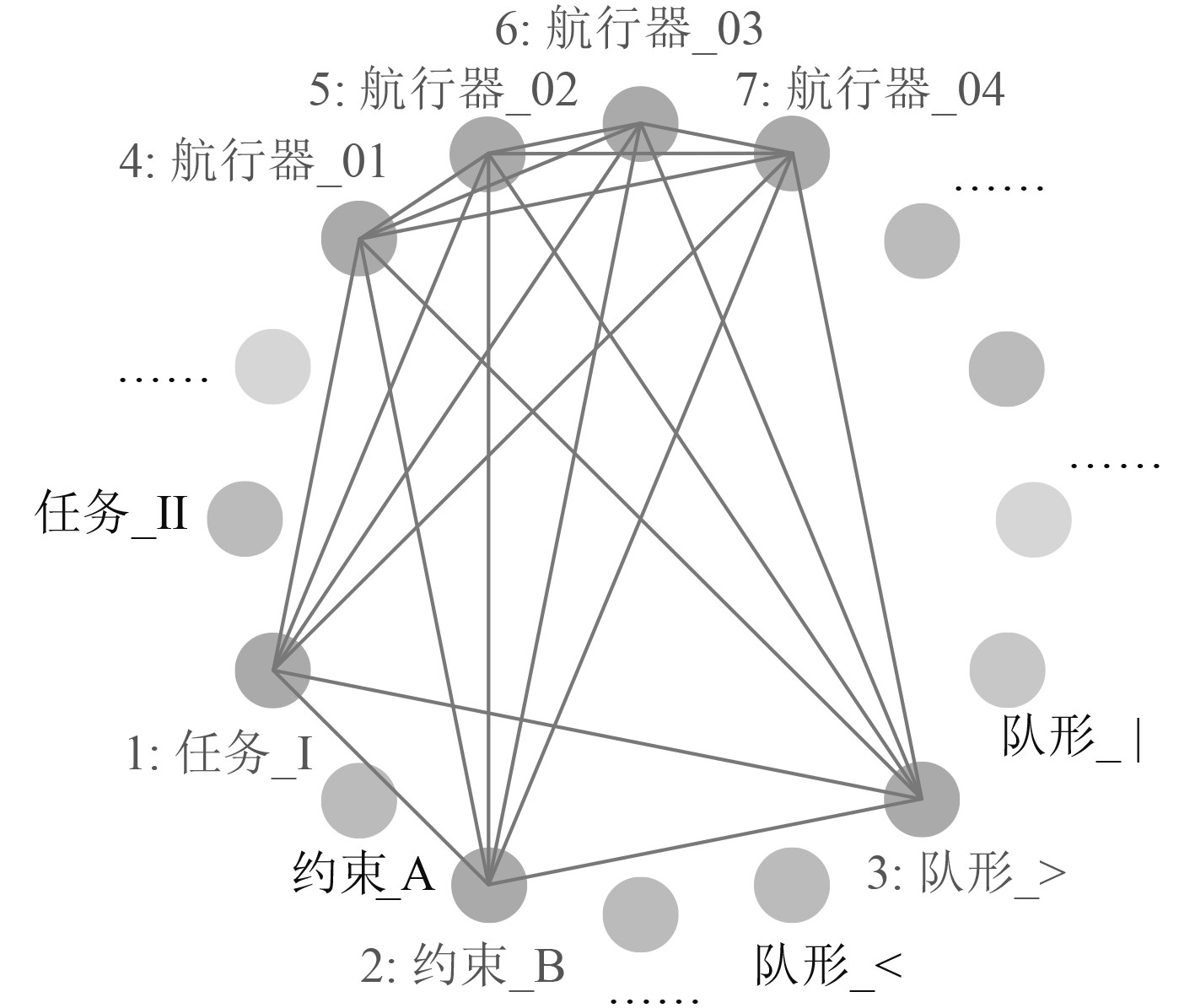

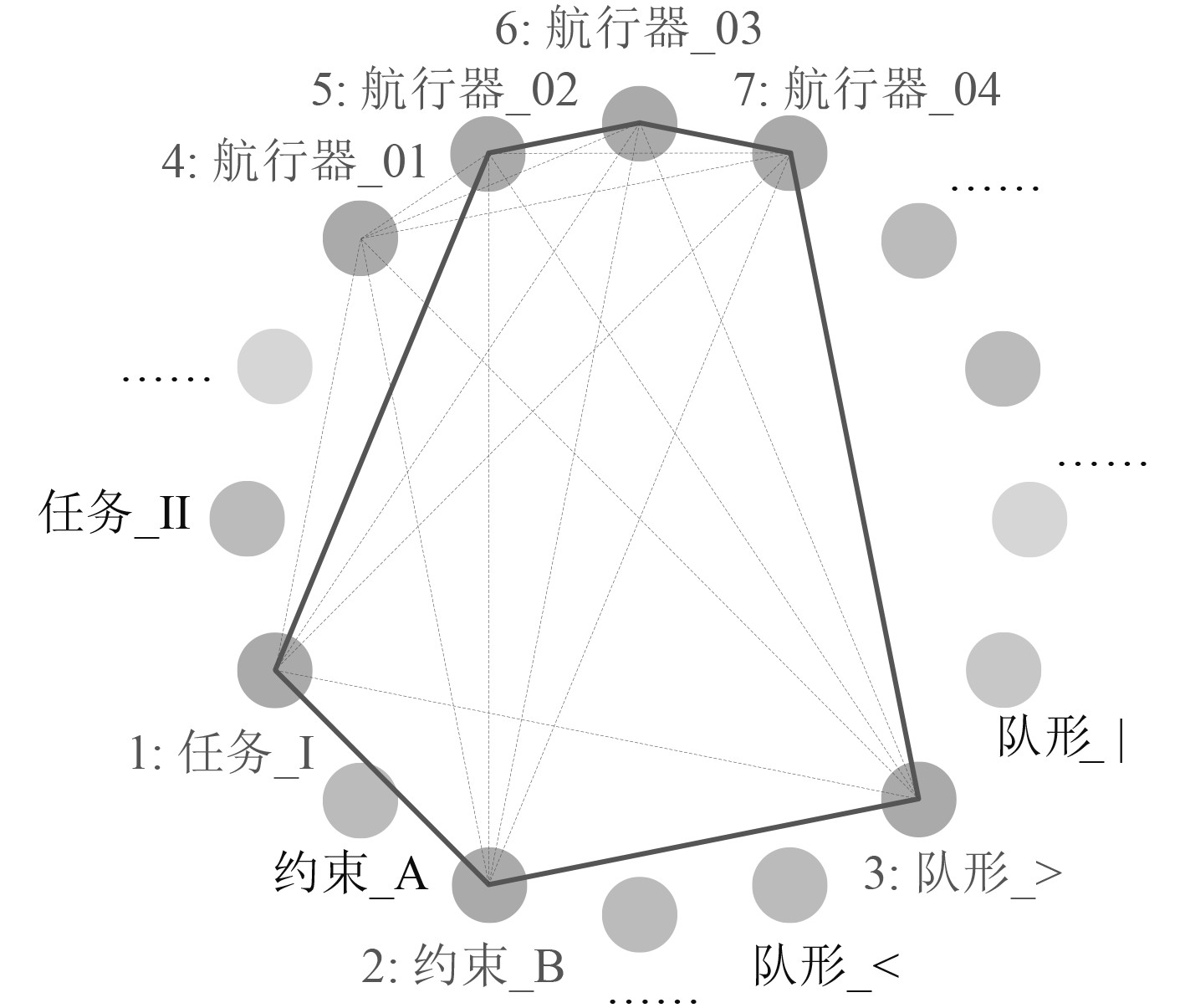

基于GNN的水下无人系统决策仿真试验验证,对1个任务、1个约束、1个队形约束、4台不同类型的水下无人航行器进行智能决策GNN图的强化学习,目的是从4台无人水下航行器中选择几台来执行满足该约束与队形的任务。图4为MDP强化学习的仿真GNN决策图。其中节点1表示搜索任务,节点2表示能量约束,节点3表示任务对应的队形约束,节点4~节点7表示可以选择来完成任务的航行器,每个航行器的最大速度、续航能力等都不相同。如果能够满足任务需求该航行器代表的顶点与约束顶点的边属性即强化学习回报为1,否则回报为0。同理,决策时能够满足任务需求的边属性回报值为1,否则为0。

|

图 4 MDP仿真模型GNN决策图 Fig. 4 Simulation GNN Decision Graph of MDP |

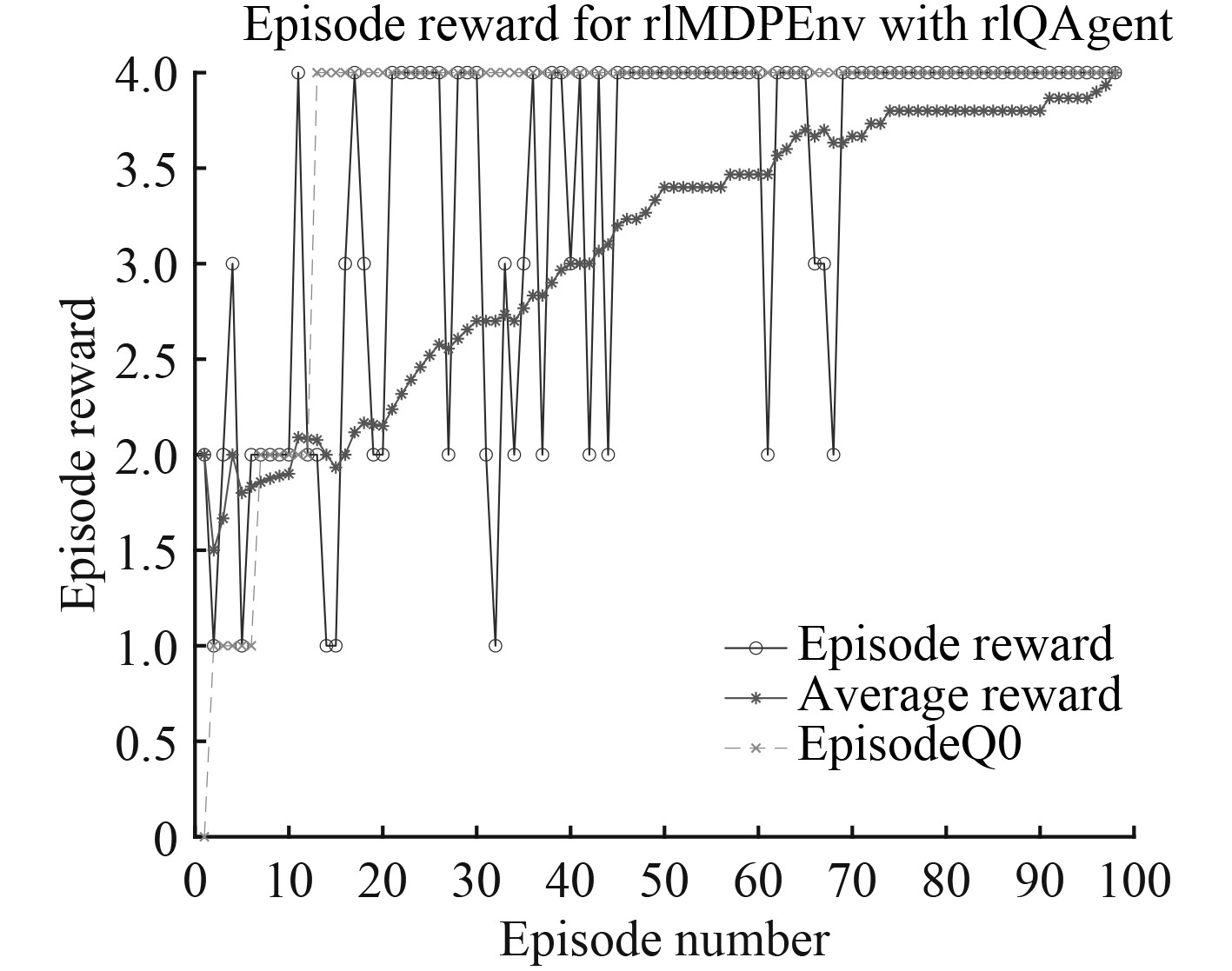

图5为基于图神经网络技术的水下无人系统智能决策Matlab仿真试验结果,其中纵坐标是决策图全局属性的总回报,横坐标是决策图进行强化学习训练的迭代步数。由图可知,在进行100次训练时就可以通过GNN决策图输出可以满足任务执行需求的决策结果。最优的决策图全局策略回报值为4,如果强化学习对决策图的训练结果总回报为4时即表示策略成功。

|

图 5 智能决策强化学习仿真结果 Fig. 5 Intelligent decision RL simulation results |

最终基于GNN的水下无人系统智能决策强化学习仿真给出的决策策略结果如图6所示。从备选UUV中选择航行器02,航行器03,航行器04即可顺利完成节点2、节点3约束下的节点1任务。

|

图 6 智能决策策略结果 Fig. 6 Intelligent Decision Policy Result |

所以,从该决策仿真试验的结果来看,水下无人系统能够基于图神经网络技术与人工智能强化学习方法有效结合,在较短的时间内提出智能决策策略,从而为指挥人员提供参考。

3 结 语本文的研究表明基于图神经网络的智能决策方法能够满足水下无人系统智能决策动态任务,动态约束,动态集群需求的智能决策,并且能够快速训练出最优的决策策略,为指挥人员提供智能决策建议。但是,本文的研究简化了决策图顶点属性及顶点间边属性的回报值计算。在后续的研究中,将结合实际应用场景进行决策边属性的更新计算,并探索不同决策图之间共性顶点的经验学习。

| [1] |

HAMRICK J B, ALLEN K R, BAPST V, et al. Relational inductive bias for physical construction in humans and machines[J]. arXiv: Learning, 2018.

|

| [2] |

WANG T, LIAO R, BA J, et al. NerveNet: Learning structured policy with graph neural networks[C]. International Conference on Learning Representations, 2018.

|

| [3] |

BATTAGLIA P W, HAMRICK J B, BAPST V, et al. Relational inductive biases, deep learning, and graph networks[J]. arXiv: Learning, 2018.

|

| [4] |

ZAMBALDI V, RAPOSO D, SANTORO A, et al. Relational deep reinforcement learning.[J]. arXiv: Learning, 2018.

|

| [5] |

SILVER D, HUBERT T, SCHRITTWIESER J, et al. A general reinforcement learning algorithm that masters chess, shogi, and go through self-play[J]. Science, 2018, 362(6419): 1140-1144. DOI:10.1126/science.aar6404 |

| [6] |

MNIH V, KAVUKCUOGLU K, SILVER D, et al. Human-level control through deep reinforcement learning[J]. Nature, 2015, 518(7540): 529-533. DOI:10.1038/nature14236 |

| [7] |

ZHANG Y, CHEN X, YANG Y, et al. Can graph neural networks help logic reasoning[J]. arXiv: Learning, 2019.

|

| [8] |

VINYALS O, BABUSCHKIN I, CZARNECKI W M, et al. Grandmaster level in StarCraft II using multi-agent reinforcement learning[J]. Nature, 2019, 575(7782): 350-354. DOI:10.1038/s41586-019-1724-z |

2020, Vol. 42

2020, Vol. 42