2. 中山大学数据科学与计算机学院,广东 广州 510275

2. Sun Yat-sen University, Guangzhou 510275, China

近年来,越来越多的海事平台被用于海上运输,生态监测,海洋安全等场景,海洋的探索受到广泛关注[1 – 2]。为了平台的安全,视觉目标跟踪技术被广泛用于跟踪潜在的感兴趣目标,例如船舶[3],浮标等。但是,在复杂环境中,并不容易完成准确稳定的跟踪任务。因此,开发用于跟踪船舶的视觉跟踪算法必须具有足够强的场景适应能力。

开发船舶视觉跟踪算法存在一些挑战。与地面车辆不同,船舶漂浮在水面上,其运动很复杂,无法准确预测。此外,海洋环境对天气和光照敏感。大海经常遭遇有雾或多雨等恶劣天气,海风会加剧船的摇晃。因此,由于船舶的不稳定运动,相邻帧图片中的目标状态可能有较大差别。此外,图像的质量可能受到水面反射的太阳光的影响。

针对海上视觉目标跟踪问题,研究人员也提出几种解决方法。Yang Z等[4]提出了一种基于非平稳平台的船舶视觉检测方法。利用基于DCT的特征向量作为输入[5],采用高斯混合模型(GMM)对海域进行建模。利用背景相减和前景分割方法实现了船舶检测[6]。滕飞等人[7]提出了一个鲁棒的内河CCTV(闭路电视监控)单船舶跟踪算法。Xiangyu K等[8]利用红外图像对海天线和小目标进行了探测。首先对海天线进行检测,缩小感兴趣区域,然后采用改进的互小波能量组合算法对小目标进行检测。虽然实验证明该方法比以往的一些方法有更好的效果,但作为一种基于生成的方法,它们只使用目标对象的信息,如RGB值,而忽略了背景信息,如波浪,只是在检测帧中随机搜索目标。因此,它们不能处理复杂的运动模式和海上常见的光照变化。近年来,基于深度学习的跟踪器在目标跟踪中越来越受欢迎,被广泛应用于地面物体跟踪[9 – 10],但对海洋环境的研究较少。

本文通过对陆地上表现比较好的Siamese RPN跟踪模型进行改进,以适应其在海上跟踪场景的应用。模型通过大量的数据训练挖掘到目标不同深度的特征,在不同天气环境下对各种类型的船舶实现了准确高效的跟踪。本模型在采集的海上跟踪数据中,跟踪平均准确率为58%,平均帧率达到了124.21 FPS。

1 概 述机载合成孔径雷达(SAR)[11]、常规舰载雷达(Lidars)[12 – 13]、机载光学传感器[14]等多种传感器均可实现对海上目标的跟踪。基于SAR的跟踪器可以覆盖更大的海域,在全天候条件下连续工作,但图像分辨率有限。雷达和激光雷达可以在极端条件下工作,提供稀疏和短距离信息。对于光学传感器,红外摄像机提供更长的视距,特别是在夜间或低能见度时。然而,红外相机的低分辨率成像和高功耗限制了其应用。相比之下,可见光图像不仅拥有高分辨率,而且具有更丰富的颜色和纹理信息。本文采用可见光图像进行船舶跟踪算法研究,具有成本低、安装方便、功耗低等优点,能在海洋目标跟踪领域更为普及。

现阶段单目标跟踪方法可分为生成类跟踪方法和判别类跟踪方法。生成方法在当前帧中构建目标区域的模型,然后在下一帧中用建立的模型搜索最相似的区域。作为传统的跟踪方法,它们被广泛用于跟踪各种目标。对于海洋实践应用的情况,大多数现有的跟踪算法属于生成方法。

1.1 生成类跟踪算法生成类跟踪方法的具体思路是先在当前帧中建立目标区域的模型,然后在下一帧中对与所建立模型最相似的区域进行搜索。该类方法被广泛应用于多目标跟踪场景。

现有的海洋环境跟踪算法大多属于生成类方法。Wu-ChihHu等[15]将跟踪问题表示为自适应边界框的计算,当前帧中的边界框对前一帧中的边界框进行自适应,以补偿当前帧与前一帧的背景不匹配,采用模板(区域)匹配方法实现跟踪任务。他们所提出的四连通分量标记方法,降低计算成本并对移除波浪涟漪也起到了作用。这个基于自适应模板块匹配的全搜索算法,可有效去除波纹并跟踪尺度变化的重叠船舶。Fei Teng等[16]提出一种跟踪内河闭路电视(CCTV)视频序列中一艘船的方法。该方法的先验信息只需给出单船在第一帧的位置。首先,基于压缩感知理论,利用2个随机测量矩阵提取2种互补的特征以实现目标船舶的跟踪。另外,为了同时获得跟踪目标的位置和尺度,该方法利用连续帧的时序与空间结构约束构造了随机测量矩阵,可方便地离线获取和记录目标位置。最后使用贝叶斯滤波判断像素块是属于前景还是背景。Szpak等[17]提出了一种跟踪动态目标的方法。该方法采用背景相减法,采用基于水平集的曲线演化的实时逼近方法,对海洋中运动船舶轮廓线进行标定。但当目标与海洋的对比度比较小时,背景差可能会导致错误检测。需要注意的是,基于水平集的系统需要先验形状知识,这在大多数情况下是难以实现的。Duncan等[18]意识到传统的基于水平集的方法存在问题,他们将目标轮廓提取为跟踪图像中的感兴趣对象,探索将船舶形状的先验知识分解到水平集分割中以提高分割结果的可能性,使得图像中目标受损也能正常跟踪。

虽然生成方法在上述大多数情况下都能正常工作,但计算成本较高,单帧处理时间较长,不能实现实时的视频追踪,而且这些方法大多只关注目标特征,忽略了目标与背景或其他非目标的相关特征,不足以应对海洋多变的天气状况。

1.2 判别类跟踪算法与生成方法不同,判别类跟踪方法是利用具有学习能力的分类器进行学习和跟踪,可以利用图像中目标和背景信息以及其他可用的相关信息对分类器进行训练。因此,判别类跟踪方法的跟踪性能普遍优于生成类跟踪方法。近年来,许多判别类方法被用于检测或跟踪地面上的物体,如车辆[19 – 20]、行人[21]等,尤其是深度学习方法,随着大数据时代的到来,神经网络的优势逐渐显现出来,从而成为主流方法,现阶段跟踪性能较好的跟踪方法大多数基于深度学习。但只有比较少的方法关注海洋环境的应用。

Bousetouane等[22]提出了一种基于卷积神经网络(CNN)的视频监控系统小目标检测模型。该方法结合手工设计的特征和深度网络学习得到的特征,从而实现船舶的检测和分类。候选目标边界框的深度CNN特征通过微调VGG16网络的卷积层的前向传播来计算获得。最后使用CNN特征和具有线性内核的支持向量机分类器进行细粒度分类以进行对象验证。实验结果表明,该模型在船舶检测分类上的性能优于Fast-R-CNN[23]。Leclerc等[24]部署了一个基于Inception[25]和ResNet架构[26]的预训练CNN进行微调以实现船舶分类。虽然实验证明分类精度得到了显著提高,但没有实现对跟踪性能的评估。

目前基于神经网络的船舶检测研究已取得了一定的成果,但应用于海事跟踪的方法却比较少。首先,海洋环境的开源数据集难以用于船舶追踪。现有效果较好的神经网络框架需要大量高质量的数据来支撑其训练(虽然Leclerc等使用了6个数据集进行测试,但只有MARVEL和VAIS的数据集是开源的。此外,都是野外非常少的与地面交通数据,如KITTI[27],VOT[28])。其次,动态背景下的海上物体特征与陆地上物体特征有较大的不同,将现有的在地面上表现良好的网络直接迁移到海事场景并不能得到较好的跟踪效果。

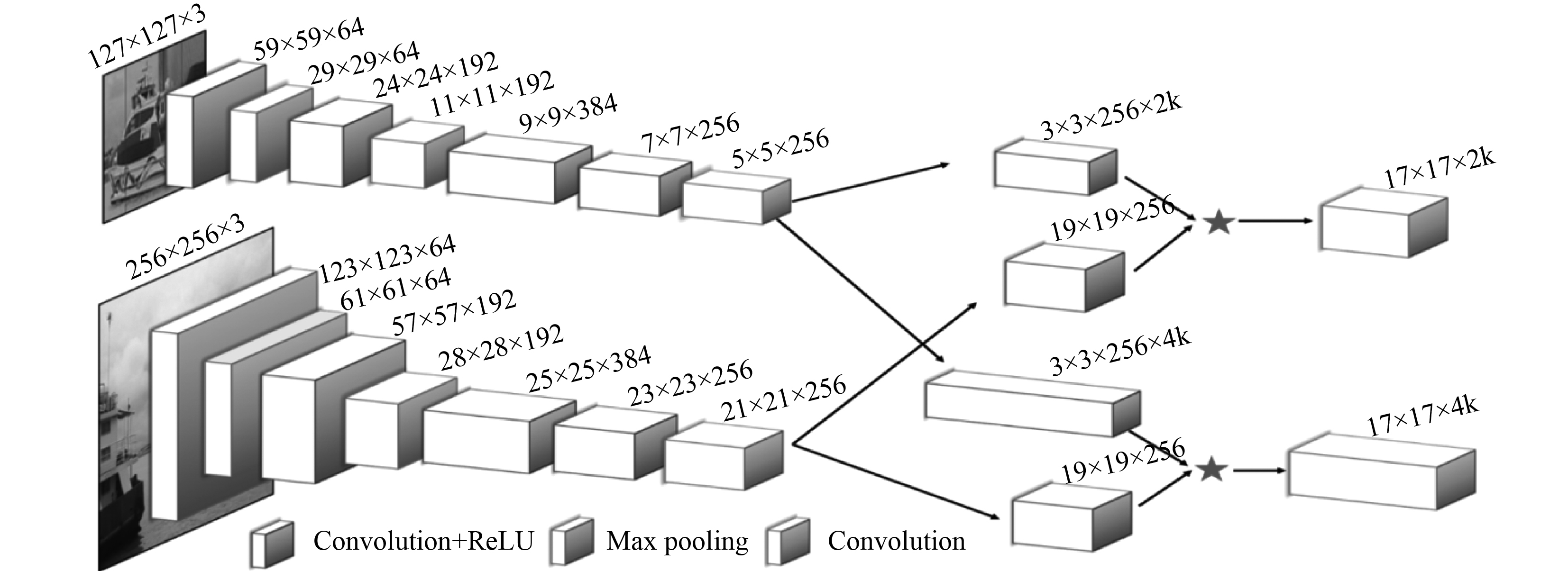

2 方法介绍对基于孪生网络和区域推荐网络的海上跟踪模型SiamRPN[29]进行改进,以适应海事跟踪场景,如图1所示。

|

图 1 跟踪器概览图 Fig. 1 An overview of our proposed tracker |

孪生网络中的特征提取模块为改进后的AlexNet,如图1所示。本专利去掉了AlexNet中的填充,并修改了卷积层中的深度,以适应设定的场景。孪生网络有2个分支:模板分支和检测分支。这2个分支分别实现模板帧和检测帧的特征提取,分别用φ(z)和φ(x)表示,z表示模板帧,x表示检测帧。

2.2 区域推荐网络与孪生网络对应,区域推荐网络也有2个分支:分类分支和回归分支。分类分支判断锚点框属于目标还是背景,对应的回归分支计算锚点框的位置偏移量。设锚点框的数目为k,分类分支的输出大小为2k,回归分支的输出为4k。φ(z)和φ(x)分别输入区域推荐网络计算对应的分类和回归值。

| $ {{A}}_{cls}^{{{w}} \times {{h}} \times 2{{k}}} = {\left[ {{{\varphi }}\left( {{x}} \right)} \right]_{cls}}{\rm{*}}{\left[ {{{\varphi }}\left( {{z}} \right)} \right]_{cls}}\text{,} $ |

| $ {{A}}_{reg}^{{{w}} \times {{h}} \times 4{{k}}} = {\left[ {{{\varphi }}\left( {{x}} \right)} \right]_{reg}}{\rm{*}}{\left[ {{{\varphi }}\left( {{z}} \right)} \right]_{reg}}\text{。} $ |

定义锚点框的表达式为:

| $ {{AN}}{{{C}}^{\rm{*}}} = \left\{ {\left( {{{x}}_i^{an},{{y}}_i^{an},{{w}}_l^{an},{{h}}_l^{an}} \right)} \right\}\text{。} $ |

从计算得到的回归框中先筛选出置信度最高的K个候选框,再加入大小形变等约束筛选出最优的目标边界框。

2.3 损失函数本模型的输出包括分类结果和回归结果,因此损失函数由两部分组成。首先,分类损失的计算方法如下式:

| $ {{{L}}_{cls}} = - \mathop \sum \limits_{i = 0}^1 {{{y}}_i}log{{{S}}_i}\text{。} $ |

其中:yi为分类的标签;Si为分类正确的概率。

对于回归分支,设预测框表示为(Ax,Ay,Aw,Ah),对应的真值框表示为(Gx,Gy,Gw,Gh),先对其进行归一化:

| $ \begin{array}{l} {{\delta }}\left[ 0 \right] = \dfrac{{{G_x} - {A_x}}}{{{A_w}}}\text{,}\\ {{\delta }}\left[ 1 \right] = \dfrac{{{G_y} - {A_y}}}{h}\text{,}\\ {{\delta }}\left[ 2 \right] = \ln \dfrac{{{G_w}}}{{{A_w}}}\text{,}\\ {{\delta }}\left[ 3 \right] = \ln \dfrac{{{G_h}}}{{{A_h}}}\text{。} \end{array} $ |

回归损失的计算公式如下:

| $ {L_{reg}} = - \mathop \sum \limits_{i = 0}^3 smoot{h_{{L_1}}}\left( {{{\delta }}\left[ i \right]} \right)\text{,} $ |

其中,smoothL1函数的计算方法如下:

| $ smoot{h_{{L_1}}}\left( x \right) = \left\{ {\begin{array}{*{20}{c}} {0.5{x^2},\left| x \right| \leqslant 1}\text{,}\\ {\left| x \right| - 0.5,{\rm {otherwise}}}\text{。} \end{array}} \right. $ |

总损失函数可表示为:

| $ Loss = {L_{cls}} + \gamma {L_{reg}}\text{。} $ |

其中,γ为超参数,用于平衡分类和回归损失。

2.4 候选框选择为从K个候选框中选出最优的目标边界框,采用2种策略。第1个策略是加入历史航行轨迹作为约束。考虑到目标运动具有连续性,选用了历史轨迹的前5帧采用最小二乘法预测目标在检测帧的位置,其中的距离计算选用的是曼哈顿距离。

| $ \begin{split} &Candidate\left( {pos,po{s_{predicted}}} \right) =\\ &\qquad \frac{1}{{Distance\left( {pos,po{s_{predicted}}} \right)}}\text{。}\end{split} $ |

其中,pospredicted为使用历史轨迹预测的目标位置,pos为神经网络预测的目标位置,Distance(pos,pospredicted)表示2个预测点之间的曼哈顿距离。第2个策略是考虑目标的大小形状变化。在视频流中,目标可认为在相邻两帧中的大小形状不会有太大变化,并对与前一帧大小变化较大的预测框进行惩罚:

| $ Penalty = {e^{k{\rm{*}}max\left( {\frac{{r'}}{r},\frac{r}{{r'}}} \right){\rm{*}}max\left( {\frac{{s'}}{s},\frac{s}{{s'}}} \right)}}\text{。} $ |

其中:k为人工设置的超参数,r为前一帧目标框的宽高比,r'为当前预测帧的候选框宽高比;s和s'分别为前一帧和当前帧目标框的面积。本网络使用Softmax函数计算每个候选框为目标框的置信度Score。加入约束后,目标框根据Score值大小重新排序:

| $\begin{split} Score =& Score{\rm{*}}\left( {1 - distanc{e_{influence}} - siz{e_{influence}}} \right) +\\& Penalty{\rm{*}}size\_influence +\\& Candidate{\rm{*}}distance\_influence \text{。}\\[-10pt] \end{split} $ |

其中:size_influence和distance_influence为人工设置的超参数。对重新排序后的候选框,再采用非极大值抑制算法合并重复候选框,最后选择置信度最高的候选框作为当前目标框。

3 实验 3.1 数据集由于船舶跟踪实验需要船舶在海面上航行的视频流数据,但是此场景下的公开数据集很少,而神经网络的训练和测试需要大量的视频流数据,因此到珠海九洲港附近海域采集船舶视频流数据用于网络的训练。本文将采集的视频根据跟踪目标进行剪辑、分类、整理后,共获得260多个视频段,共计有目标的图像有54 000多张。为了探索船舶类型对跟踪效果的影响,把数据集根据船型,货船、渔船、客船和快艇,分为4类(如图2所示),再根据天气状况分为晴天、阴天、雨天、雾天4类,分别探索船舶类型和多种天气情况对海上船舶跟踪的影响。

|

图 2 数据集中包含4种不同类型的船舶 Fig. 2 The dataset contains four different types of ships |

为扩大训练的数据集,获得更多的训练数据,本文使用数据增强的方法。在数据驱动的深度学习领域中,数据增强能有效增广数据集,使得深度学习模型获得更多的数据用于训练,提高模型的泛化能力。常用的数据增强方法可以分为两大类:基于空间的方法和基于颜色的方法。基于空间的方法有平移、旋转、翻转、裁剪、缩放等;而基于颜色的有调整图像的饱和度、亮度等。另外,为了加强模型对噪声的鲁棒性,也会在训练数据集上加入噪声,例如高斯噪声。本文主要采用了基于空间的数据增强方法,平移、旋转、翻转、裁剪和缩放这5个方法。

3.2 评价指标为衡量分析本专利所提出方法的性能,采用精确度、召回率、F值和帧率作为本次实验的性能衡量指标,具体计算方法如下:

设Ωt为目标在t时刻预测框与真值框的交并集,AtG表示在t时刻目标的真值框,AtT(θt),θt表示在t时刻的预测置信度,τθ是分类阈值,Ng真值框不为空的帧数,Nt为检测过程中预测框不为空的帧数,N为网络预测次数,PT(im(i))为编号为i的检测帧im的处理时间。4个衡量指标的计算公式如下:

| $ {{\varOmega _t} = \dfrac{{A_t^G \cap _{{t^T}}^A\left( {{\theta _t}} \right)}}{{A_t^G \cup _{{t^T}}^A\left( {{\theta _t}} \right)}}}\text{,} $ |

| $ {Pr\left( {{\tau _\theta }} \right) = \dfrac{1}{{{N_t}}}\sum\limits_{t \in \left\{ {t:A_t^T \ne \emptyset } \right\}} {{\varOmega _t}} }\text{,} $ |

| $ {Re\left( {{\tau _\theta }} \right) = \dfrac{1}{{{N_g}}}\sum\limits_{t \in \left\{ {t:A_t^G \ne \emptyset } \right\}} {{\varOmega _t}} }\text{,} $ |

| $ {F\left( {{\tau _\theta }} \right) = \dfrac{{2Pr\left( {{\tau _\theta }} \right){\rm{*}}Re\left( {{\tau _\theta }} \right)}}{{Pr\left( {{\tau _\theta }} \right) + Re\left( {{\tau _\theta }} \right)}}}\text{,} $ |

| $ {FPS = \dfrac{N}{{\sum\nolimits_{i = 1}^N P T\left( {im\left( i \right)} \right)}}}\text{。} $ |

分析实验结果可得,本文提出的海上跟踪模型可达到58%的平均跟踪准确率,运行帧率达到了124.21FPS,能实现海上船舶实时准确跟踪。在本实验中,采用原始的AlexNet和vgg16作为特征提取模块进行实验。结果表明,改进后的AlexNet的跟踪准确率相对于原模型有3%的提升,也比vgg16高1%,而且取得了124.21的高帧率。

|

|

表 1 不同CNN下跟踪模型性能效果 Tab.1 Tracking model performance under different CNNs |

为验证本模型在不同天气环境下对不同船舶跟踪的鲁棒性,根据天气情况和船舶类型设置实验。结果如表2~表4所示。

|

|

表 2 不同天气和船舶类型数据集上的准确率 Tab.2 Accuracy of our model in data sets of different weather and ship types |

|

|

表 4 不同天气和船舶类型数据集上的F值 Tab.4 F-measure of our model on different weather and ship type data sets |

由表2和表3可以看出,在恶劣天气条件下,跟踪器的平均精度达到56%,平均召回率为53%。其中雾天气对跟踪效果影响较大,因为它模糊了目标的大部分特征,对于不同类型的船舶,外观和速度将影响跟踪结果。通常,客船彼此之间具有更高的相似性,并且尺寸非常接近。此外,客船有固定的路线,以便顺利运行,因此客船的跟踪效果较好。相比之下,快艇的跟踪性能较差。快艇具有小尺寸和高速度,并且驾驶员随机地改变其路线,因此其位置偏移和外观变化是显著的,这对跟踪具有负面影响。在表4中,F值集成了精度和召回率,以证明所提出的跟踪器的优良性能。图3为跟踪效果展示,分别截取了视频中的第1,10和20帧。

|

|

表 3 不同天气和船舶类型数据集上的召回率 Tab.3 Recall of our model in data sets of different weather and ship types |

|

图 3 跟踪效果展示 Fig. 3 Tracking performancedisplay |

本文将深度学习方法应用于船舶跟踪,提出使用孪生网络和区域推荐网络的海上船舶跟踪方法。为进一步提高跟踪性能,参照AlexNet网络对孪生网络的CNN模块进行修改,并提出一种基于历史轨迹的自适应搜索区域提取方法,以适应不同的运动场景。利用数据集对所提出的跟踪器进行评估。结果表明,在使用Intel Xeon CPU E5-2620,GTX TITAN的PC机上可以达到58%的平均精度和124.21 FPS。

| [1] |

李晓飞. 基于视觉的船舶跟踪与三维定位技术研究与应用[D]. 广州: 广东工业大学, 2014.

|

| [2] |

闫雨石, 鞠文博. 船舶无人驾驶技术中的数据融合应用技术[J]. 舰船科学技术, 2019(20): 5-7. |

| [3] |

张彩虹, 胡彦军. 无人船远距离目标追踪与自动避障算法优化[J]. 舰船科学技术, 2019(16). |

| [4] |

ZHANG Y, LI Q Z, ZANG F N. Ship detection for visual maritime surveillance from non-stationary platforms[J]. Ocean Engineering, 2017, 141: 53-63. DOI:10.1016/j.oceaneng.2017.06.022 |

| [5] |

BLOISI D, IOCCHI L. Argos—a video surveillance system for boat traffic monitoring in venice[J]. International Journal of Pattern Recognition and Artificial Intelligence, 2009, 23(7): 1477-1502. DOI:10.1142/S0218001409007594 |

| [6] |

PRASAD D K, RAJAN D, RACHMAWATI L, et al. Video processing from electro-optical sensors for object detection and tracking in a maritime environment: a survey[J]. IEEE Transactions on Intelligent Transportation Systems, 2017, 18(8): 1993-2016. DOI:10.1109/TITS.2016.2634580 |

| [7] |

滕飞, 刘清, 朱琳. 一种快速鲁棒的内河CCTV系统船舶跟踪算法[J]. 武汉理工大学学报, 2014(5): 86-91. |

| [8] |

KONG X, LIU L, QIAN Y, et al. Automatic detection of sea-sky horizon line and small targets in maritime infrared imagery[J]. Infrared Physics & Technology, 2016, 76: 185-199. |

| [9] |

HELD D, THRUN S, SAVARESE S. Learning to track at 100 fps with deep regression networks[C]//European Conference on Computer Vision. Springer, Cham, 2016: 749–765.

|

| [10] |

TANG S, ANDRILUKA M, ANDRES B, et al. Multiple people tracking by lifted multicut and person re-identification[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2017: 3539–3548.

|

| [11] |

TELLO M, LÓPEZ-MARTÍNEZ C, MALLORQUI J J. A novel algorithm for ship detection in SAR imagery based on the wavelet transform[J]. IEEE Geoscience and remote sensing letters, 2005, 2(2): 201-205. DOI:10.1109/LGRS.2005.845033 |

| [12] |

ZHU C, ZHOU H, WANG R, et al. A novel hierarchical method of ship detection from spaceborne optical image based on shape and texture features[J]. IEEE Transactions on geoscience and remote sensing, 2010, 48(9): 3446-3456. DOI:10.1109/TGRS.2010.2046330 |

| [13] |

刘静, 刘以安, 杨新刚. 基于Kalman滤波的船舶跟踪技术[J]. 微计算机信息, 2007, 23(31): 187-189. DOI:10.3969/j.issn.1008-0570.2007.31.077 |

| [14] |

KÜNZNER N, KUSHAUER J, KATZENBEIßER S, et al. Modern electro-optical imaging system for maritime surveillance applications[C]//2010 International WaterSide Security Conference. IEEE, 2010: 1–4.

|

| [15] |

HU W C, YANG C Y, HUANG D Y. Robust real-time ship detection and tracking for visual surveillance of cage aquaculture[J]. Journal of Visual Communication and Image Representation, 2011, 22(6): 543-556. DOI:10.1016/j.jvcir.2011.03.009 |

| [16] |

TENG F, LIU Q. Robust multi-scale ship tracking via multiple compressed features fusion[J]. Signal Processing: Image Communication, 2015, 31: 76-85. DOI:10.1016/j.image.2014.12.006 |

| [17] |

SZPAK Z L, TAPAMO J R. Maritime surveillance: Tracking ships inside a dynamic background using a fast level-set[J]. Expert systems with applications, 2011, 38(6): 6669-6680. DOI:10.1016/j.eswa.2010.11.068 |

| [18] |

FROST D, TAPAMO J R. Detection and tracking of moving objects in a maritime environment using level set with shape priors[J]. EURASIP Journal on Image and Video Processing, 2013, 2013(1): 42. DOI:10.1186/1687-5281-2013-42 |

| [19] |

XIN J, DU X, ZHANG J. Deep learning for robust outdoor vehicle visual tracking[C]//2017 IEEE International Conference on Multimedia and Expo (ICME). IEEE, 2017: 613–618.

|

| [20] |

CAI Y, WANG H, SUN X, et al. Visual Vehicle Tracking Based on Deep Representation and Semisupervised Learning[J]. Journal of Sensors, 2017, 2017. |

| [21] |

BRUNETTI A, BUONGIORNO D, TROTTA G F, et al. Computer vision and deep learning techniques for pedestrian detection and tracking: A survey[J]. Neurocomputing, 2018, 300: 17-33. DOI:10.1016/j.neucom.2018.01.092 |

| [22] |

BOUSETOUANE F, MORRIS B. Fast CNN surveillance pipeline for fine-grained vessel classification and detection in maritime scenarios[C]//2016 13th IEEE International Conference on Advanced Video and Signal Based Surveillance (AVSS). IEEE, 2016: 242–248.

|

| [23] |

GIRSHICK R. Fast r-cnn[C]//Proceedings of the IEEE international conference on computer vision. 2015: 1440–1448.

|

| [24] |

LECLERC M, THARMARASA R, FLOREA M C, et al. Ship classification using deep learning techniques for maritime target tracking[C]//2018 21st International Conference on Information Fusion (FUSION). IEEE, 2018: 737-744.

|

| [25] |

SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2015: 1–9.

|

| [26] |

HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2016: 770–778.

|

| [27] |

GEIGER A, LENZ P, STILLER C, et al. Vision meets robotics: The KITTI dataset[J]. The International Journal of Robotics Research, 2013, 32(11): 1231-1237. DOI:10.1177/0278364913491297 |

| [28] |

KRISTAN M, LEONARDIS A, MATAS J, et al. The sixth visual object tracking vot2018 challenge results[C]//Proceedings of the European Conference on Computer Vision (ECCV). 2018: 0–0.

|

| [29] |

LI B, YAN J, WU W, et al. High performance visual tracking with siamese region proposal network[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018: 8971–8980.

|

2019, Vol. 41

2019, Vol. 41